إستبدال خادم OSPD UCS 240M4 - vEPC

خيارات التنزيل

-

ePub (954.8 KB)

العرض في تطبيقات مختلفة على iPhone أو iPad أو نظام تشغيل Android أو قارئ Sony أو نظام التشغيل Windows Phone

لغة خالية من التحيز

تسعى مجموعة الوثائق لهذا المنتج جاهدة لاستخدام لغة خالية من التحيز. لأغراض مجموعة الوثائق هذه، يتم تعريف "خالية من التحيز" على أنها لغة لا تعني التمييز على أساس العمر، والإعاقة، والجنس، والهوية العرقية، والهوية الإثنية، والتوجه الجنسي، والحالة الاجتماعية والاقتصادية، والتمييز متعدد الجوانب. قد تكون الاستثناءات موجودة في الوثائق بسبب اللغة التي يتم تشفيرها بشكل ثابت في واجهات المستخدم الخاصة ببرنامج المنتج، أو اللغة المستخدمة بناءً على وثائق RFP، أو اللغة التي يستخدمها منتج الجهة الخارجية المُشار إليه. تعرّف على المزيد حول كيفية استخدام Cisco للغة الشاملة.

حول هذه الترجمة

ترجمت Cisco هذا المستند باستخدام مجموعة من التقنيات الآلية والبشرية لتقديم محتوى دعم للمستخدمين في جميع أنحاء العالم بلغتهم الخاصة. يُرجى ملاحظة أن أفضل ترجمة آلية لن تكون دقيقة كما هو الحال مع الترجمة الاحترافية التي يقدمها مترجم محترف. تخلي Cisco Systems مسئوليتها عن دقة هذه الترجمات وتُوصي بالرجوع دائمًا إلى المستند الإنجليزي الأصلي (الرابط متوفر).

المحتويات

المقدمة

يصف هذا المستند الخطوات المطلوبة لاستبدال خادم معيب يستضيف مدير النظام الأساسي ل OpenStack (OSPD) في إعداد Ultra-M.

معلومات أساسية

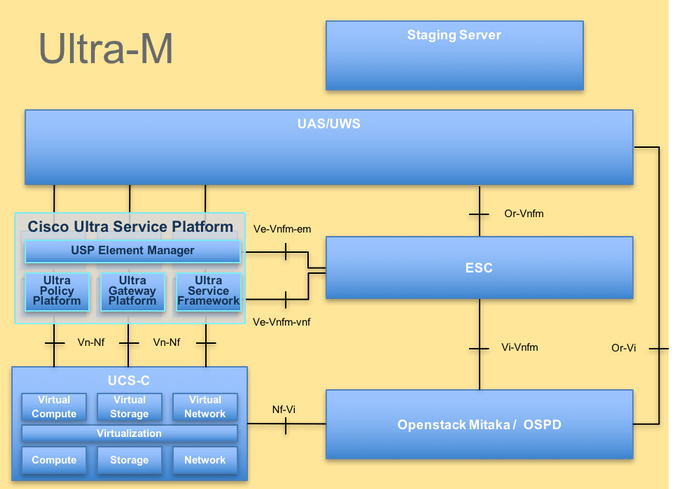

Ultra-M هو حل أساسي لحزم الأجهزة المحمولة تم تجميعه في حزم مسبقا والتحقق من صحته افتراضيا تم تصميمه من أجل تبسيط نشر شبكات VNF. OpenStack هو مدير البنية الأساسية الظاهرية (VIM) ل Ultra-M ويتكون من أنواع العقد التالية:

- حوسبة

- قرص تخزين الكائنات - الحوسبة (OSD - الحوسبة)

- ضابط

- OSPD

تم توضيح البنية المعمارية عالية المستوى لتقنية Ultra-M والمكونات المعنية في هذه الصورة:

بنية UltraM

بنية UltraM

هذا المستند مخصص لأفراد Cisco المطلعين على نظام Cisco Ultra-M الأساسي وهو يفصل الخطوات المطلوبة ليتم تنفيذها على مستوى OpenStack في وقت إستبدال خادم OSPD.

ملاحظة: يتم النظر في الإصدار Ultra M 5.1.x لتحديد الإجراءات الواردة في هذا المستند.

المختصرات

| VNF | وظيفة الشبكة الظاهرية |

| سي إف | دالة التحكم |

| SF | وظيفة الخدمة |

| ESC | وحدة التحكم المرنة في الخدمة |

| ممسحة | طريقة إجرائية |

| OSD | أقراص تخزين الكائنات |

| محرك الأقراص الثابتة | محرك الأقراص الثابتة |

| محرك أقراص مزود بذاكرة مصنوعة من مكونات صلبة | محرك أقراص في الحالة الصلبة |

| فيم | مدير البنية الأساسية الظاهرية |

| VM | جهاز ظاهري |

| إم | مدير العناصر |

| UAS | خدمات أتمتة Ultra |

| uID | المعرف الفريد العالمي |

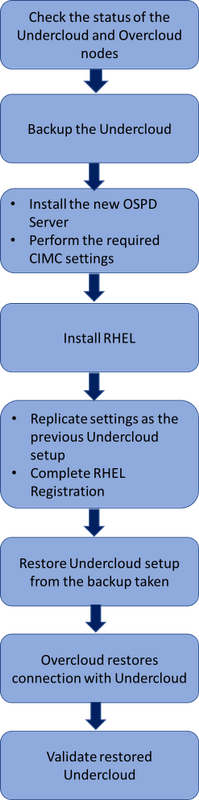

سير عمل مذكرة التفاهم

سير عمل عالي المستوى لإجراء الاستبدال

سير عمل عالي المستوى لإجراء الاستبدال

المتطلبات الأساسية

فحص الحالة

قبل إستبدال خادم OSPD، من المهم التحقق من الحالة الحالية لبيئة النظام الأساسي ل Red Hat OpenStack والتأكد من صحتها لتجنب المضاعفات عند تشغيل عملية الاستبدال.

تحقق من حالة مكدس OpenStack وقائمة العقد:

[stack@director ~]$ source stackrc

[stack@director ~]$ openstack stack list --nested

[stack@director ~]$ ironic node-list

[stack@director ~]$ nova list

تأكد من أن جميع خدمات الشبكة الفرعية في حالة تحميل ونشاط وتشغيل من عقدة OSP-D:

[stack@director ~]$ systemctl list-units "openstack*" "neutron*" "openvswitch*"

UNIT LOAD ACTIVE SUB DESCRIPTION

neutron-dhcp-agent.service loaded active running OpenStack Neutron DHCP Agent

neutron-openvswitch-agent.service loaded active running OpenStack Neutron Open vSwitch Agent

neutron-ovs-cleanup.service loaded active exited OpenStack Neutron Open vSwitch Cleanup Utility

neutron-server.service loaded active running OpenStack Neutron Server

openstack-aodh-evaluator.service loaded active running OpenStack Alarm evaluator service

openstack-aodh-listener.service loaded active running OpenStack Alarm listener service

openstack-aodh-notifier.service loaded active running OpenStack Alarm notifier service

openstack-ceilometer-central.service loaded active running OpenStack ceilometer central agent

openstack-ceilometer-collector.service loaded active running OpenStack ceilometer collection service

openstack-ceilometer-notification.service loaded active running OpenStack ceilometer notification agent

openstack-glance-api.service loaded active running OpenStack Image Service (code-named Glance) API server

openstack-glance-registry.service loaded active running OpenStack Image Service (code-named Glance) Registry server

openstack-heat-api-cfn.service loaded active running Openstack Heat CFN-compatible API Service

openstack-heat-api.service loaded active running OpenStack Heat API Service

openstack-heat-engine.service loaded active running Openstack Heat Engine Service

openstack-ironic-api.service loaded active running OpenStack Ironic API service

openstack-ironic-conductor.service loaded active running OpenStack Ironic Conductor service

openstack-ironic-inspector-dnsmasq.service loaded active running PXE boot dnsmasq service for Ironic Inspector

openstack-ironic-inspector.service loaded active running Hardware introspection service for OpenStack Ironic

openstack-mistral-api.service loaded active running Mistral API Server

openstack-mistral-engine.service loaded active running Mistral Engine Server

openstack-mistral-executor.service loaded active running Mistral Executor Server

openstack-nova-api.service loaded active running OpenStack Nova API Server

openstack-nova-cert.service loaded active running OpenStack Nova Cert Server

openstack-nova-compute.service loaded active running OpenStack Nova Compute Server

openstack-nova-conductor.service loaded active running OpenStack Nova Conductor Server

openstack-nova-scheduler.service loaded active running OpenStack Nova Scheduler Server

openstack-swift-account-reaper.service loaded active running OpenStack Object Storage (swift) - Account Reaper

openstack-swift-account.service loaded active running OpenStack Object Storage (swift) - Account Server

openstack-swift-container-updater.service loaded active running OpenStack Object Storage (swift) - Container Updater

openstack-swift-container.service loaded active running OpenStack Object Storage (swift) - Container Server

openstack-swift-object-updater.service loaded active running OpenStack Object Storage (swift) - Object Updater

openstack-swift-object.service loaded active running OpenStack Object Storage (swift) - Object Server

openstack-swift-proxy.service loaded active running OpenStack Object Storage (swift) - Proxy Server

openstack-zaqar.service loaded active running OpenStack Message Queuing Service (code-named Zaqar) Server

openstack-zaqar@1.service loaded active running OpenStack Message Queuing Service (code-named Zaqar) Server Instance 1

openvswitch.service loaded active exited Open vSwitch

LOAD = Reflects whether the unit definition was properly loaded.

ACTIVE = The high-level unit activation state, i.e. generalization of SUB.

SUB = The low-level unit activation state, values depend on unit type.

37 loaded units listed. Pass --all to see loaded but inactive units, too.

To show all installed unit files use 'systemctl list-unit-files'.

النسخ الاحتياطي

تأكد من توفر مساحة كافية على القرص قبل إجراء عملية النسخ الاحتياطي. ومن المتوقع أن لا تقل سعتها عن 3.5 جيجابايت.

[stack@director ~]$df -h

قم بتشغيل هذا الأمر كمستخدم جذري لنسخ البيانات إحتياطيا من عقدة الشبكة الفرعية إلى ملف يسمى undercloud-backup-[timestamp].tar.gz.

[root@director ~]# mysqldump --opt --all-databases > /root/undercloud-all-databases.sql

[root@director ~]# tar --xattrs -czf undercloud-backup-`date +%F`.tar.gz /root/undercloud-all-databases.sql

/etc/my.cnf.d/server.cnf /var/lib/glance/images /srv/node /home/stack

tar: Removing leading `/' from member names

تثبيت عقدة OSPD الجديدة

تثبيت خادم UCS

يمكن الرجوع إلى الخطوات الخاصة بتثبيت خادم UCS C240 M4 جديد بالإضافة إلى خطوات الإعداد الأولي من دليل خدمة وتثبيت الخادم Cisco UCS C240 M4.

قم بتسجيل الدخول إلى الخادم باستخدام CIMC IP.

قم بإجراء ترقية BIOS إذا لم تكن البرامج الثابتة متوافقة مع الإصدار الموصى به المستخدم سابقا. تم تقديم خطوات ترقية BIOS هنا: دليل ترقية BIOS للخادم المركب على حامل Cisco UCS C-Series.

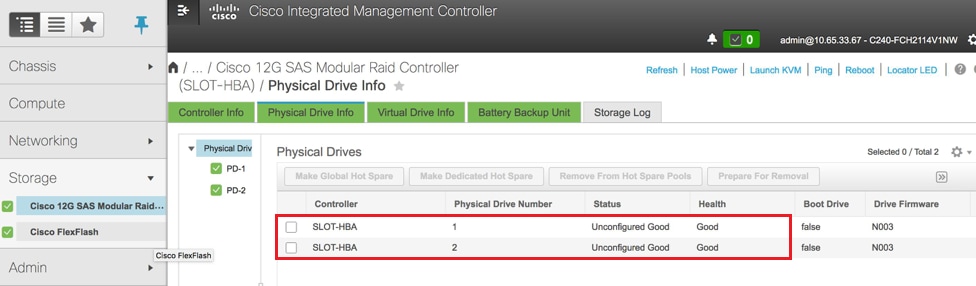

تحقق من حالة محركات الأقراص المادية. يجب أن يكون غير مكون جيدا:

انتقل إلى وحدة التخزين > وحدة التحكم RAID النمطية Cisco 12G SAS (slot-HBA) > معلومات محرك الأقراص المادية كما هو موضح هنا في الصورة.

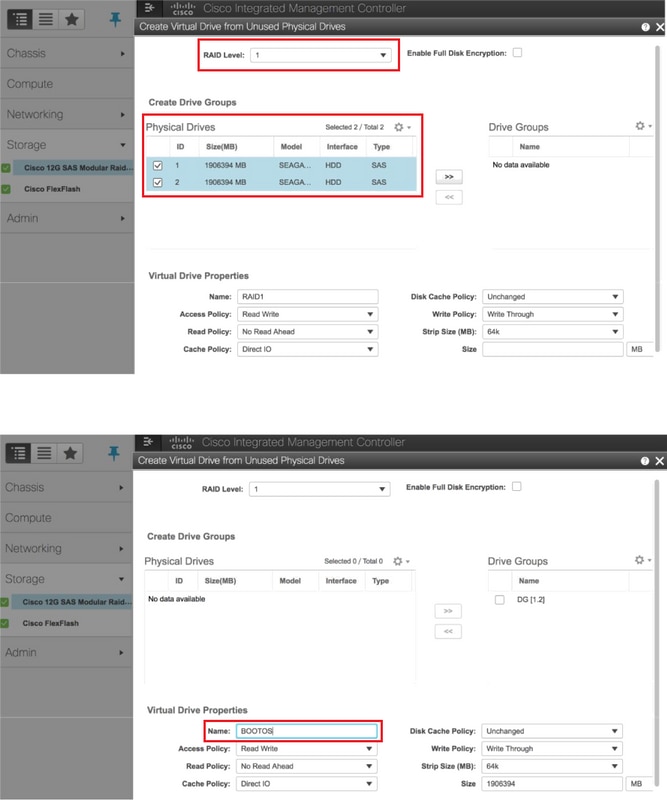

إنشاء محرك أقراص ظاهري من محركات الأقراص المادية باستخدام RAID المستوى 1:

انتقل إلى وحدة التخزين > وحدة التحكم RAID النمطية Cisco 12G SAS (slot-HBA) > معلومات وحدة التحكم > إنشاء محرك أقراص ظاهري من محركات الأقراص المادية غير المستخدمة كما هو موضح في الصورة.

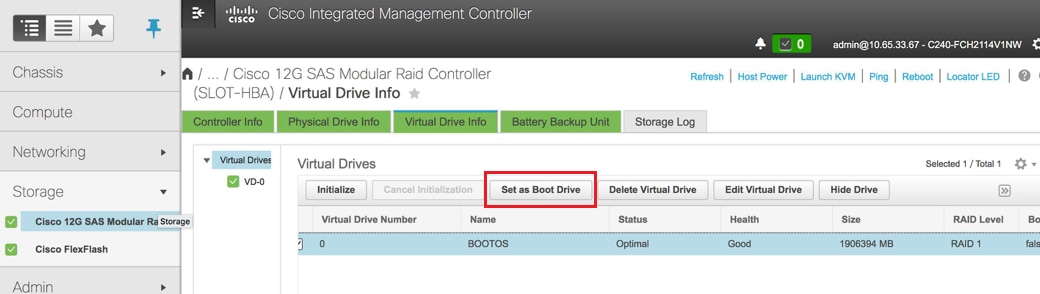

حدد معرف فئة المورد (VD) وقم بتكوين المجموعة كمحرك أقراص تمهيد كما هو موضح في الصورة.

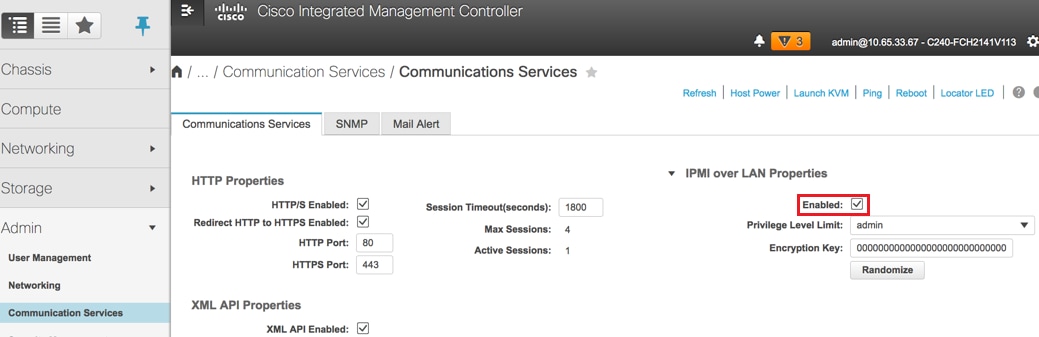

تمكين IPMI عبر LAN:

انتقل إلى Admin > Communication Services (خدمات الاتصالات) > Communication Services (خدمات الاتصالات) كما هو موضح في الصورة.

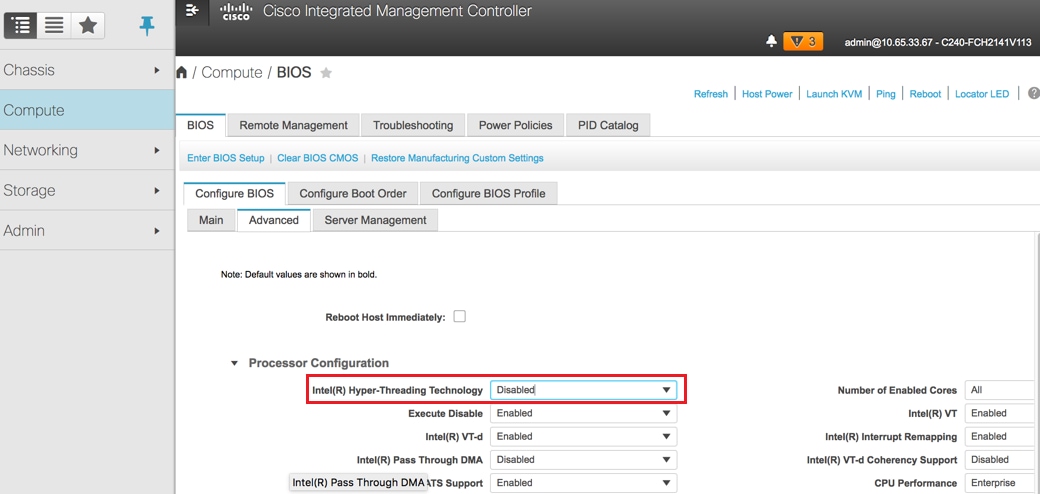

تعطيل الارتباط التشعبي:

انتقل إلى الحوسبة > BIOS > تكوين BIOS > متقدم > تهيئة المعالج كما هو موضح في الصورة.

ملاحظة: ترتبط الصورة الموضحة هنا وخطوات التكوين المذكورة في هذا القسم بالإصدار 3.0(3e) من البرنامج الثابت، وقد تكون هناك إختلافات طفيفة إذا كنت تعمل على إصدارات أخرى.

مؤسسة ريد هات

تركيب صورة Red Hat ISO

1. سجل الدخول إلى خادم OSP-D.

2. إطلاق وحدة تحكم لوحة المفاتيح والفيديو والماوس.

3. انتقل إلى الوسائط الظاهرية > تنشيط الأجهزة الظاهرية. قبول جلسة العمل وتمكين تذكر إعدادك للاتصالات المستقبلية.

4. تحديد وسائط افتراضية > تخطيط القرص المضغوط/قرص الفيديو الرقميوتخطيط صورة Red Hat ISO.

5. تحديد الطاقة > إعادة ضبط النظام (التمهيد الدافئ) لإعادة تشغيل النظام.

6. عند إعادة التشغيل، اضغط F6وحدد Cisco vKVM-Mapped vDVD1.22واضغط أدخل.

تثبيت Red Hat Enterprise Linux

ملاحظة: يمثل الإجراء الوارد في هذا القسم إصدارا مبسطا لعملية التثبيت يحدد الحد الأدنى لعدد المعلمات التي يجب تكوينها.

1. حدد الخيار لتثبيت Red Hat Enterprise Linux (RHEL) لبدء التثبيت.

2. حدد تحديد البرامج > الحد الأدنى للتثبيت فقط.

3. تكوين واجهات الشبكة (eno1 و eno2).

4. انقر على الشبكة و اسم المضيف.

- حدد الواجهة التي سيتم إستخدامها للاتصالات الخارجية (إما eno1 أو eno2)

- طقطقة يشكل

- حدد SetupStab ل IPv4، وحدد الأسلوب اليدوي وانقر فوق إضافة

- قم بتعيين هذه المعلمات كما تم إستخدامها سابقا: العنوان وقناع الشبكة والبوابة وخادم DNS

5. حدد التاريخ والوقت وحدد منطقتك ومدينتك.

6. تمكين وقت الشبكة وتكوين خوادم NTP.

7. حدد وجهة التثبيت واستخدم نظام ملفات ext4 .

ملاحظة: حذف /منزل/ وإعادة توزيع السعة تحت الجذر /.

8. تعطيل Kdump.

9. تعيين كلمة مرور الجذر فقط.

10. بدء التثبيت .

إستعادة السحابة السفلية

تجهيز تثبيت الشبكة الداخلية استنادا إلى النسخ الاحتياطي

بمجرد تثبيت الجهاز مع RHEL 7.3 ووضعه في حالة نظيفة، أعد تمكين كافة الاشتراكات/المستودعات اللازمة لتثبيت المدير وتشغيله.

تكوين اسم المضيف:

[root@director ~]$sudo hostnamectl set-hostname <FQDN_hostname>

[root@director ~]$sudo hostnamectl set-hostname --transient <FQDN_hostname>

تحرير ملف /إلخ/الأجهزة المضيفة:

[root@director ~]$ vi /etc/hosts

<ospd_external_address> <server_hostname> <FQDN_hostname>

10.225.247.142 pod1-ospd pod1-ospd.cisco.com

التحقق من صحة اسم المضيف:

[root@director ~]$ cat /etc/hostname

pod1-ospd.cisco.com

التحقق من تكوين DNS:

[root@director ~]$ cat /etc/resolv.conf

#Generated by NetworkManager

nameserver <DNS_IP>

تعديل واجهة بطاقة واجهة الشبكة (NIC) للإمداد:

[root@director ~]$ cat /etc/sysconfig/network-scripts/ifcfg-eno1

DEVICE=eno1

ONBOOT=yes

HOTPLUG=no

NM_CONTROLLED=no

PEERDNS=no

DEVICETYPE=ovs

TYPE=OVSPort

OVS_BRIDGE=br-ctlplane

BOOTPROTO=none

MTU=1500

إكمال تسجيل Red Hat

قم بتنزيل هذه الحزمة لتكوين مدير الاشتراك لاستخدام rh-satellite:

[root@director ~]$ rpm -Uvh http:///pub/katello-ca-consumer-latest.noarch.rpm

[root@director ~]$ subscription-manager config

سجل مع RH-satellite باستخدام هذا ActivityKey ل RHEL 7.3.

[root@director ~]$subscription-manager register --org="<ORG>" --activationkey="<KEY>"

لعرض الاشتراك:

[root@director ~]$ subscription-manager list –consumed

تمكين المستودعات المماثلة لعمليات إعادة توجيه OSPD القديمة:

[root@director ~]$ sudo subscription-manager repos --disable=*

[root@director ~]$ subscription-manager repos --enable=rhel-7-server-rpms --enable=rhel-7-server-extras-rpms --enable=rh

el-7-server-openstack-10-rpms --enable=rhel-7-server-rh-common-rpms --enable=rhel-ha-for-rhel-7-server-rpm

قم بإجراء تحديث على نظامك لضمان حصولك على أحدث حزم النظام الأساسية وأعد تمهيد النظام:

[root@director ~]$sudo yum update -y

[root@director ~]$sudo reboot

إستعادة UnderCloud

بعد تمكين الاشتراك، قم باستيراد ملف UnderCloud-backup-date +٪F'.tar.gz الذي تم نسخه إحتياطيا إلى الدليل الجذر/الجذر الجديد الخاص بخادم OSP-D.

قم بتركيب خادم بنك المريرة:

[root@director ~]$ yum install -y mariadb-server

إستخراج ملف تكوين MariaDB والنسخ الاحتياطي لقاعدة البيانات (DB). قم بإجراء هذه العملية كمستخدم جذري.

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz etc/my.cnf.d/server.cnf

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz root/undercloud-all-databases.sql

قم بتحرير /etc/my.cnf.d/server.cnf وأخرج مدخل الربط-العنوان إن كان موجودا:

[root@tb3-ospd ~]# vi /etc/my.cnf.d/server.cnf

بدء تشغيل خدمة MariaDB وتحديث إعداد max_allowed_packet مؤقتا:

[root@director ~]$ systemctl start mariadb

[root@director ~]$ mysql -uroot -e"set global max_allowed_packet = 16777216;"

تنظيف أذونات معينة (لإعادة الإنشاء لاحقا):

[root@director ~]$ for i in ceilometer glance heat ironic keystone neutron nova;do mysql -e "drop user $i";done

[root@director ~]$ mysql -e 'flush privileges'

ملاحظة: إذا تم تعطيل خدمة عداد الحدود القصوى مسبقا في الإعداد، فقم بتنفيذ هذا الأمر وقم بإزالة مقياس الحدود القصوى.

إنشاء حساب StackUser:

[root@director ~]$ sudo useradd stack

[root@director ~]$ sudo passwd stack << specify a password

[root@director ~]$ echo "stack ALL=(root) NOPASSWD:ALL" | sudo tee -a /etc/sudoers.d/stack

[root@director ~]$ sudo chmod 0440 /etc/sudoers.d/stack

إستعادة الدليل الرئيسي لمستخدم المكدس:

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz home/stack

قم بتركيب حزم قاعدة الوميض والسرعة، ثم قم باستعادة البيانات الخاصة بها:

[root@director ~]$ yum install -y openstack-glance openstack-swift

[root@director ~]$ tar --xattrs -xzC / -f undercloud-backup-$DATE.tar.gz srv/node var/lib/glance/images

تأكد من امتلاك المستخدم الصحيح للبيانات:

[root@director ~]$ chown -R swift: /srv/node

[root@director ~]$ chown -R glance: /var/lib/glance/images

قم باستعادة شهادات UnderCloud SSL (إختياري - يجب القيام به فقط إذا كان الإعداد يستخدم شهادات SSL).

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz etc/pki/instack-certs/undercloud.pem

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz etc/pki/ca-trust/source/anchors/ca.crt.pem

قم بإعادة تشغيل التثبيت تحت السحابة كمستخدم للمكدس وتأكد من تشغيله في الدليل الرئيسي لمستخدمي المكدس:

[root@director ~]$ su - stack

[stack@director ~]$ sudo yum install -y python-tripleoclient

تأكد من تعيين اسم المضيف بشكل صحيح في /وما إلى ذلك/البيئات المضيفة.

إعادة تثبيت الشبكة الداخلية:

[stack@director ~]$ openstack undercloud install

<snip>

#############################################################################

Undercloud install complete.

The file containing this installation's passwords is at

/home/stack/undercloud-passwords.conf.

There is also a stackrc file at /home/stack/stackrc.

These files are needed to interact with the OpenStack services, and must be

secured.

#############################################################################

إعادة اتصال UnderCloud التي تم استعادتها ب Overcloud

بعد اكتمال هذه الخطوات، يمكن توقع أن تقوم الشبكة الداخلية باستعادة إتصالها بالسحابة الزائدة تلقائيا. ستستمر العقد في إجراء إستطلاع للتزامن (الحرارة) للمهام المعلقة، باستخدام طلب HTTP بسيط يتم إصداره كل بضع ثوان.

التحقق من صحة الاستعادة المكتملة

استعملت هذا أمر in order to أنجزت تدقيق صحة من ال حديثا إستعادة بيئة:

[root@director ~]$ su - stack

Last Log in: Tue Nov 28 21:27:50 EST 2017 from 10.86.255.201 on pts/0

[stack@director ~]$ source stackrc

[stack@director ~]$ nova list

+--------------------------------------+--------------------+--------+------------+-------------+------------------------+

| ID | Name | Status | Task State | Power State | Networks |

+--------------------------------------+--------------------+--------+------------+-------------+------------------------+

| b1f5294a-629e-454c-b8a7-d15e21805496 | pod1-compute-0 | ACTIVE | - | Running | ctlplane=192.200.0.119 |

| 9106672e-ac68-423e-89c5-e42f91fefda1 | pod1-compute-1 | ACTIVE | - | Running | ctlplane=192.200.0.120 |

| b3ed4a8f-72d2-4474-91a1-b6b70dd99428 | pod1-compute-2 | ACTIVE | - | Running | ctlplane=192.200.0.124 |

| 677524e4-7211-4571-ac35-004dc5655789 | pod1-compute-3 | ACTIVE | - | Running | ctlplane=192.200.0.107 |

| 55ea7fe5-d797-473c-83b1-d897b76a7520 | pod1-compute-4 | ACTIVE | - | Running | ctlplane=192.200.0.122 |

| c34c1088-d79b-42b6-9306-793a89ae4160 | pod1-compute-5 | ACTIVE | - | Running | ctlplane=192.200.0.108 |

| 4ba28d8c-fb0e-4d7f-8124-77d56199c9b2 | pod1-compute-6 | ACTIVE | - | Running | ctlplane=192.200.0.105 |

| d32f7361-7e73-49b1-a440-fa4db2ac21b1 | pod1-compute-7 | ACTIVE | - | Running | ctlplane=192.200.0.106 |

| 47c6a101-0900-4009-8126-01aaed784ed1 | pod1-compute-8 | ACTIVE | - | Running | ctlplane=192.200.0.121 |

| 1a638081-d407-4240-b9e5-16b47e2ff6a2 | pod1-compute-9 | ACTIVE | - | Running | ctlplane=192.200.0.112 |

<snip>

[stack@director ~]$ ssh heat-admin@192.200.0.107

[heat-admin@pod1-controller-0 ~]$ sudo pcs status

Cluster name: tripleo_cluster

Stack: corosync

Current DC: pod1-controller-0 (version 1.1.15-11.el7_3.4-e174ec8) - partition with quorum

3 nodes and 22 resources configured

Online: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

Full list of resources:

ip-10.1.10.10 (ocf::heartbeat:IPaddr2): Started pod1-controller-0

ip-11.120.0.97 (ocf::heartbeat:IPaddr2): Started pod1-controller-1

Clone Set: haproxy-clone [haproxy]

Started: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

Master/Slave Set: galera-master [galera]

Masters: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

ip-192.200.0.106 (ocf::heartbeat:IPaddr2): Started pod1-controller-0

ip-11.120.0.95 (ocf::heartbeat:IPaddr2): Started pod1-controller-1

ip-11.119.0.98 (ocf::heartbeat:IPaddr2): Started pod1-controller-0

ip-11.118.0.92 (ocf::heartbeat:IPaddr2): Started pod1-controller-1

Clone Set: rabbitmq-clone [rabbitmq]

Started: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

Master/Slave Set: redis-master [redis]

Masters: [ pod1-controller-0 ]

Slaves: [ pod1-controller-1 pod1-controller-2 ]

openstack-cinder-volume (systemd:openstack-cinder-volume): Started pod1-controller-0

my-ipmilan-for-controller-0 (stonith:fence_ipmilan): Stopped

my-ipmilan-for-controller-1 (stonith:fence_ipmilan): Stopped

my-ipmilan-for-controller-2 (stonith:fence_ipmilan): Stopped

Failed Actions:

* my-ipmilan-for-controller-0_start_0 on pod1-controller-1 'unknown error' (1): call=190, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:45 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-1_start_0 on pod1-controller-1 'unknown error' (1): call=192, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:53:08 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-2_start_0 on pod1-controller-1 'unknown error' (1): call=188, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:23 2017', queued=0ms, exec=20004ms

* my-ipmilan-for-controller-0_start_0 on pod1-controller-0 'unknown error' (1): call=210, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:53:08 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-1_start_0 on pod1-controller-0 'unknown error' (1): call=207, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:45 2017', queued=0ms, exec=20004ms

* my-ipmilan-for-controller-2_start_0 on pod1-controller-0 'unknown error' (1): call=206, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:45 2017', queued=0ms, exec=20006ms

* ip-192.200.0.106_monitor_10000 on pod1-controller-0 'not running' (7): call=197, status=complete, exitreason='none',

last-rc-change='Wed Nov 22 13:51:31 2017', queued=0ms, exec=0ms

* my-ipmilan-for-controller-0_start_0 on pod1-controller-2 'unknown error' (1): call=183, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:23 2017', queued=1ms, exec=20006ms

* my-ipmilan-for-controller-1_start_0 on pod1-controller-2 'unknown error' (1): call=184, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:23 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-2_start_0 on pod1-controller-2 'unknown error' (1): call=177, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:02 2017', queued=0ms, exec=20005ms

Daemon Status:

corosync: active/enabled

pacemaker: active/enabled

pcsd: active/enabled

[heat-admin@pod1-controller-0 ~]$ sudo ceph status

cluster eb2bb192-b1c9-11e6-9205-525400330666

health HEALTH_OK

monmap e1: 3 mons at {pod1-controller-0=11.118.0.40:6789/0,pod1-controller-1=11.118.0.41:6789/0,pod1-controller-2=11.118.0.42:6789/0}

election epoch 58, quorum 0,1,2 pod1-controller-0,pod1-controller-1,pod1-controller-2

osdmap e1398: 12 osds: 12 up, 12 in

flags sortbitwise,require_jewel_osds

pgmap v1245812: 704 pgs, 6 pools, 542 GB data, 352 kobjects

1625 GB used, 11767 GB / 13393 GB avail

704 active+clean

client io 21549 kB/s wr, 0 op/s rd, 120 op/s wr

التحقق من عملية خدمة الهوية (Keystone)

تقوم هذه الخطوة بالتحقق من صحة عمليات خدمة الهوية عن طريق الاستعلام عن قائمة المستخدمين.

[stack@director ~]$ source stackrc

[stack@director ~]$ openstack user list

+----------------------------------+------------------+

| ID | Name |

+----------------------------------+------------------+

| 69ac2b9d89414314b1366590c7336f7d | admin |

| f5c30774fe8f49d0a0d89d5808a4b2cc | glance |

| 3958d852f85749f98cca75f26f43d588 | heat |

| cce8f2b7f1a843a08d0bb295a739bd34 | ironic |

| ce7c642f5b5741b48a84f54d3676b7ee | ironic-inspector |

| a69cd42a5b004ec5bee7b7a0c0612616 | mistral |

| 5355eb161d75464d8476fa0a4198916d | neutron |

| 7cee211da9b947ef9648e8fe979b4396 | nova |

| f73d36563a4a4db482acf7afc7303a32 | swift |

| d15c12621cbc41a8a4b6b67fa4245d03 | zaqar |

| 3f0ed37f95544134a15536b5ca50a3df | zaqar-websocket |

+----------------------------------+------------------+

[stack@director ~]$

[stack@director ~]$ source <overcloudrc>

[stack@director ~]$ openstack user list

+----------------------------------+------------+

| ID | Name |

+----------------------------------+------------+

| b4e7954942184e2199cd067dccdd0943 | admin |

| 181878efb6044116a1768df350d95886 | neutron |

| 6e443967ee3f4943895c809dc998b482 | heat |

| c1407de17f5446de821168789ab57449 | nova |

| c9f64c5a2b6e4d4a9ff6b82adef43992 | glance |

| 800e6b1163b74cc2a5fab4afb382f37d | cinder |

| 4cfa5a2a44c44c678025842f080e5f53 | heat-cfn |

| 9b222eeb8a58459bb3bfc76b8fff0f9f | swift |

| 815f3f25bcda49c290e1b56cd7981d1b | core |

| 07c40ade64f34a64932129175150fa4a | gnocchi |

| 0ceeda0bc32c4d46890e53adef9a193d | aodh |

| f3caab060171468592eab376a94967b8 | ceilometer |

+----------------------------------+------------+

[stack@director ~]$

تحميل الصور للإدخال للعقدة في المستقبل

قم بالتحقق من الصحة /httpboot وجميع هذه الملفات inspector.ipxe، agent.kernel، agent.ramdisk، إذا لم تقم بالمتابعة إلى هذه الخطوات.

[stack@director ~]$ ls /httpboot

inspector.ipxe

[stack@director ~]$ source stackrc

[stack@director ~]$ cd images/

[stack@director images]$ openstack overcloud image upload --image-path /home/stack/images

Image "overcloud-full-vmlinuz" is up-to-date, skipping.

Image "overcloud-full-initrd" is up-to-date, skipping.

Image "overcloud-full" is up-to-date, skipping.

Image "bm-deploy-kernel" is up-to-date, skipping.

Image "bm-deploy-ramdisk" is up-to-date, skipping.

[stack@director images]$ ls /httpboot

agent.kernel agent.ramdisk inspector.ipxe

[stack@director images]$

إعادة تشغيل السياج

سيكون السياج في حالة توقف بعد إستعادة OSPD. وسيمكن هذا الإجراء من إقامة سياج.

[heat-admin@pod1-controller-0 ~]$ sudo pcs property set stonith-enabled=true

[heat-admin@pod1-controller-0 ~]$ sudo pcs status

[heat-admin@pod1-controller-0 ~]$sudo pcs stonith show

معلومات ذات صلة

تمت المساهمة بواسطة مهندسو Cisco

- Padmaraj Ramanoudjamخدمات Cisco المتقدمة

- Partheeban Rajagopalخدمات Cisco المتقدمة

اتصل بنا

- فتح حالة دعم

- (تتطلب عقد خدمة Cisco)

التعليقات

التعليقات