Bereitstellung von EVPN VXLAN, mehrere Standorte über DCNM 11.2(1)

Download-Optionen

-

ePub (8.0 MB)

In verschiedenen Apps auf iPhone, iPad, Android, Sony Reader oder Windows Phone anzeigen

Inklusive Sprache

In dem Dokumentationssatz für dieses Produkt wird die Verwendung inklusiver Sprache angestrebt. Für die Zwecke dieses Dokumentationssatzes wird Sprache als „inklusiv“ verstanden, wenn sie keine Diskriminierung aufgrund von Alter, körperlicher und/oder geistiger Behinderung, Geschlechtszugehörigkeit und -identität, ethnischer Identität, sexueller Orientierung, sozioökonomischem Status und Intersektionalität impliziert. Dennoch können in der Dokumentation stilistische Abweichungen von diesem Bemühen auftreten, wenn Text verwendet wird, der in Benutzeroberflächen der Produktsoftware fest codiert ist, auf RFP-Dokumentation basiert oder von einem genannten Drittanbieterprodukt verwendet wird. Hier erfahren Sie mehr darüber, wie Cisco inklusive Sprache verwendet.

Informationen zu dieser Übersetzung

Cisco hat dieses Dokument maschinell übersetzen und von einem menschlichen Übersetzer editieren und korrigieren lassen, um unseren Benutzern auf der ganzen Welt Support-Inhalte in ihrer eigenen Sprache zu bieten. Bitte beachten Sie, dass selbst die beste maschinelle Übersetzung nicht so genau ist wie eine von einem professionellen Übersetzer angefertigte. Cisco Systems, Inc. übernimmt keine Haftung für die Richtigkeit dieser Übersetzungen und empfiehlt, immer das englische Originaldokument (siehe bereitgestellter Link) heranzuziehen.

Inhalt

Einführung

In diesem Dokument wird beschrieben, wie zwei einzelne EVPN VXLAN-Fabrics bereitgestellt werden und wie diese beiden Fabrics mithilfe von Cisco Data Center Manager (DCNM) 11.2(1) in einer EVPN Multi-Site Fabric-Bereitstellung zusammengeführt werden.

Multi-Site Domain (MSD), eingeführt in DCNM 11.0(1), ist ein Multi-Fabric-Container, der zur Verwaltung mehrerer Member-Fabrics erstellt wurde. Es ist ein zentraler Kontrollpunkt für eine Definition von Overlay-Netzwerken und Virtual Routing and Forwarding (VRF), die von allen Mitgliedern gemeinsam genutzt werden.

Hinweis: In diesem Dokument werden die Details zu den Funktionen/Eigenschaften der einzelnen Registerkarten in DCNM nicht beschrieben. Siehe Referenzen am Ende, die detaillierte Erläuterungen enthalten.

Voraussetzungen

Anforderungen

Cisco empfiehlt, über Kenntnisse in folgenden Bereichen zu verfügen:

-

vCenter/UCS für die Bereitstellung von DCNM Virtual Machine

-

Vertrautheit mit NX-OS und Nexus 9000

-

ToR für Nexus 9000, Leaf/Spine-Verbindungen für EoRs

Verwendete Komponenten

Die Informationen in diesem Dokument basieren auf der folgenden Software und Hardware:

- DCNM 11.2(1)

- NX-OS 7.0(3)I7(7) und NX-OS 9.2(3)

- Spines: N9K-C9508/N9K-X97160YC-EX und N9K-C9508/N9K-X9636PQ

- Broschüren: N9K-C9372TX, N9K-C93180YC-EX, N9K-C9372TX-E, N9K-C92160YC-X

- Grenz-Gateways: N9K-C93240YC-FX2 und N9K-C93180YC-FX

- 7K "Hosts": N77-C7709

Die Informationen in diesem Dokument wurden von den Geräten in einer bestimmten Laborumgebung erstellt. Alle in diesem Dokument verwendeten Geräte haben mit einer leeren (Standard-)Konfiguration begonnen. Wenn Ihr Netzwerk in Betrieb ist, stellen Sie sicher, dass Sie die potenziellen Auswirkungen eines Befehls verstehen.

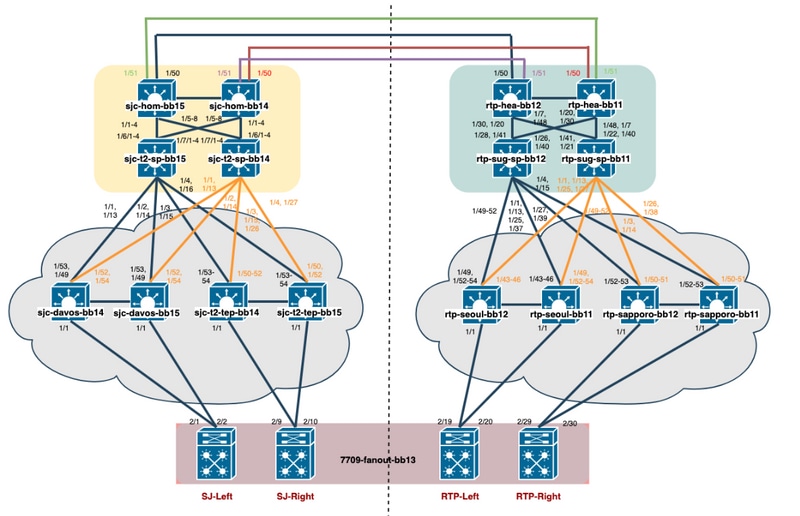

Aufbau physischer Topologie

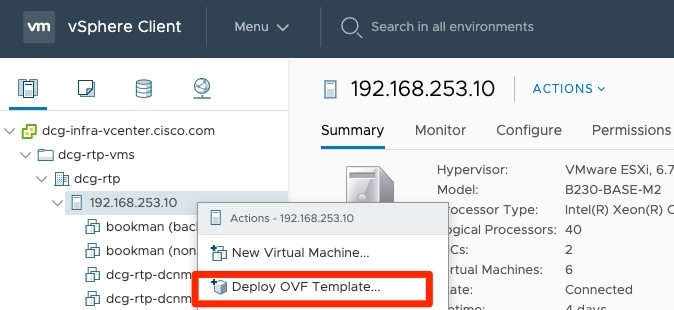

Bereitstellung von OVA/OVF in vCenter

Schritt 1: Stellen Sie unter vCenter die OVF-Vorlage (Open Virtualization Format) auf dem Server/Host Ihrer Wahl bereit, wie im Bild gezeigt.

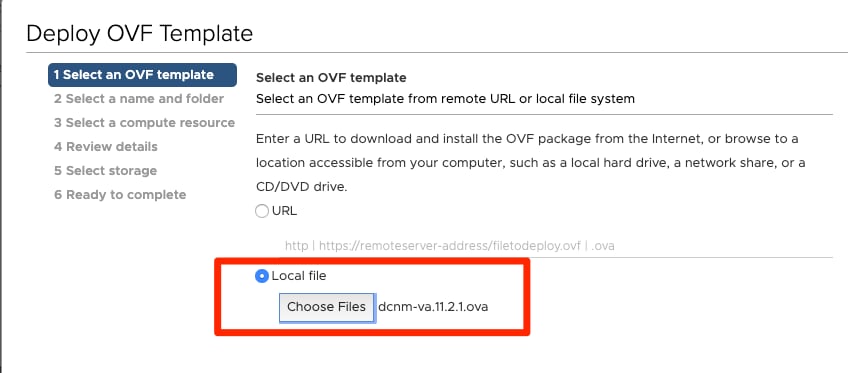

- Lokale OVA/OVF-Datei usw., Auswahl über Dateien auswählen, wie im Bild gezeigt:

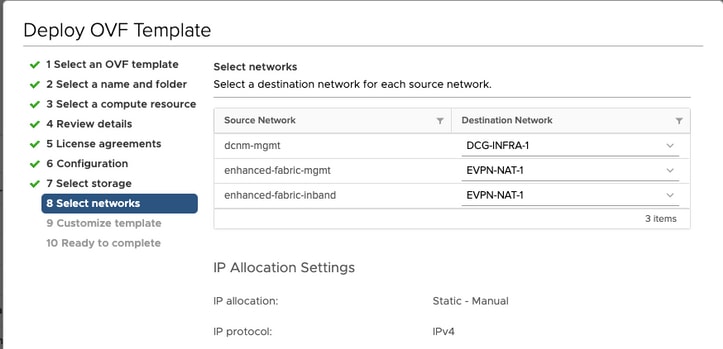

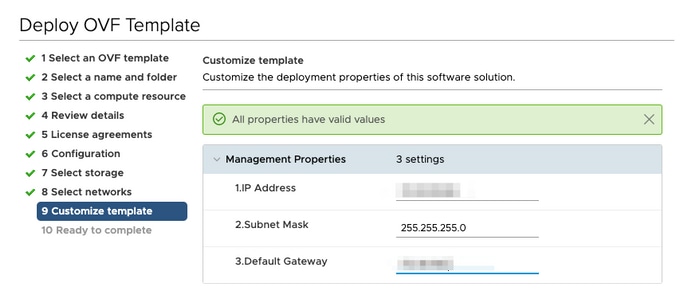

- Folgen Sie den Anweisungen (VM-Name, Host, Netzwerkeinstellungen, wie im Bild gezeigt) und klicken Sie auf Fertig stellen.

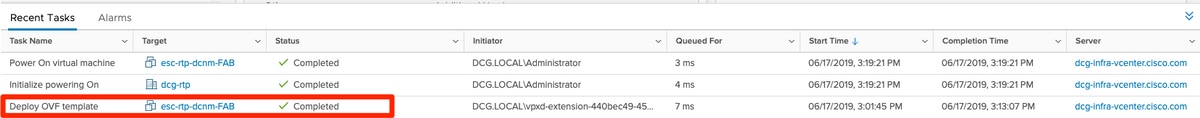

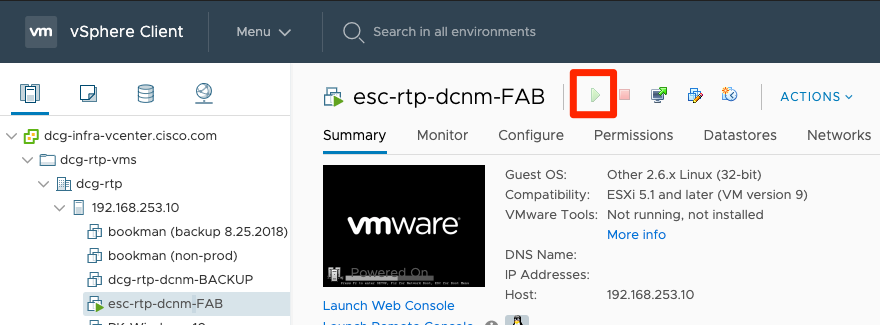

Schritt 2: Starten Sie nach Abschluss das DCNM VM, wie hier gezeigt.

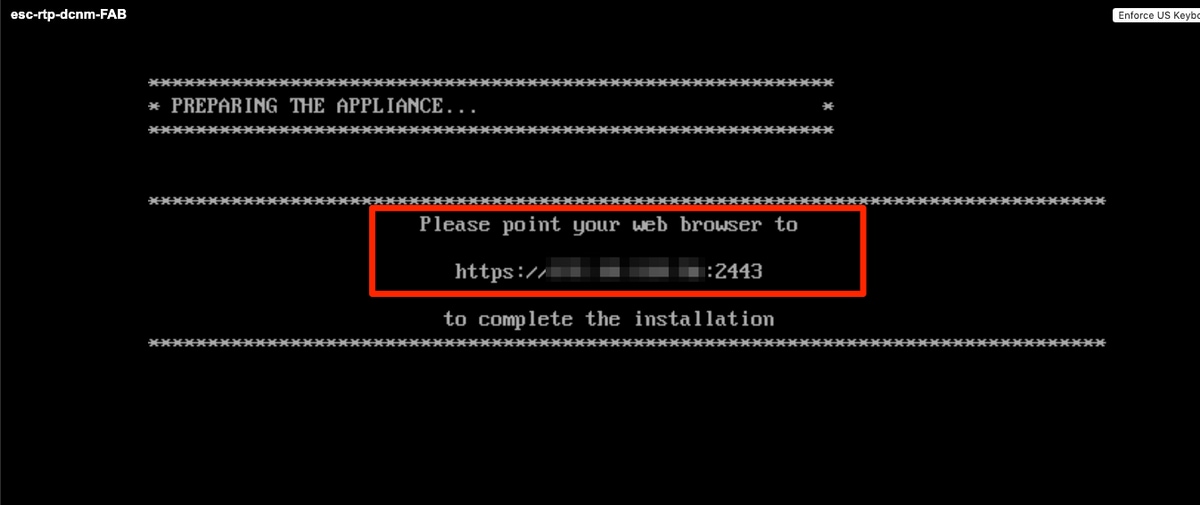

Schritt 3: Starten Sie die Web-Konsole, sobald Sie in der Konsole, sollten Sie diese Eingabeaufforderung sehen (IP unterscheidet sich, da dies spezifisch für Ihre Umgebung und Ihre Konfiguration ist):

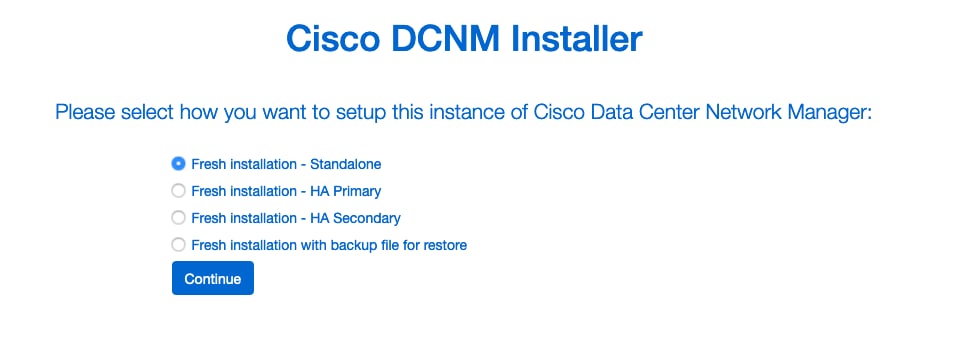

Schritt 4: Rufen Sie https://<Ihre IP>:2443 (Dies ist die IP-Adresse, die Sie zuvor während der OVA-Bereitstellung konfiguriert haben) auf, und klicken Sie auf Erste Schritte. In diesem Beispiel wird eine Neuinstallation behandelt.

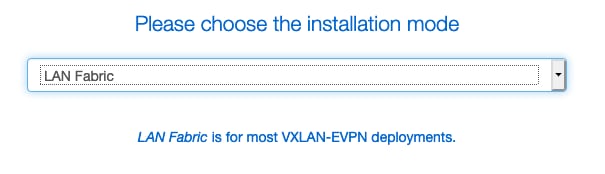

Schritt 5: Nachdem Sie das Administratorkennwort konfiguriert haben, müssen Sie den zu installierenden Fabric-Typ auswählen. Wählen Sie zwischen LAN oder FAB aus, da jeder Typ einen anderen Zweck hat. Achten Sie daher darauf, dass Sie ihn richtig verstehen und auswählen. In diesem Beispiel wird die LAN-Fabric verwendet. Dies gilt für die meisten VXLAN-EVPN-Bereitstellungen.

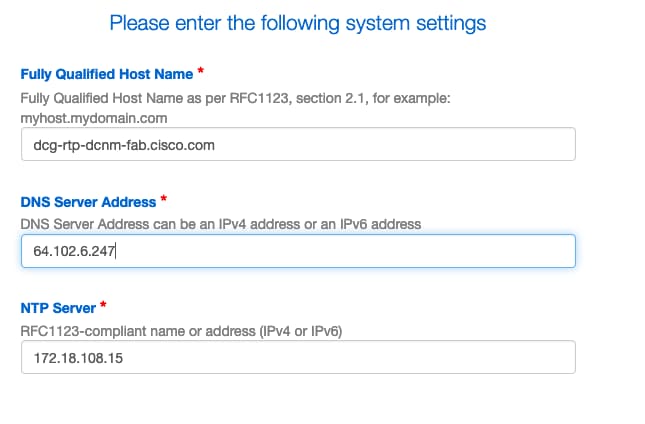

Schritt 6: Befolgen Sie die Anweisungen des Installationsprogramms mit DNS, NTP-Server (Network Time Protocol), DCNM-Hostnamen usw. Ihres Netzwerks.

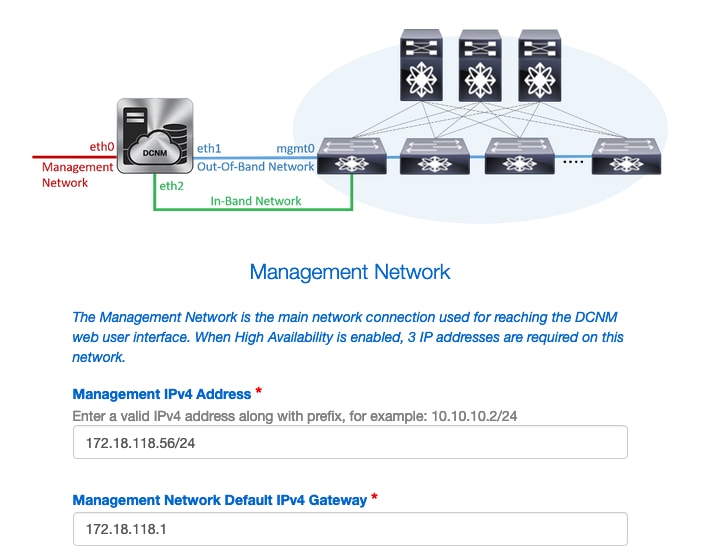

Schritt 7: Konfigurieren Sie die Verwaltungs-IP und das Management-Gateway. Das Managementnetzwerk stellt Verbindungen (SSH, SCP, HTTP, HTTPS) zum DCNM-Server bereit. Dies ist auch die IP, die Sie verwenden, um die GUI zu erreichen. Die IP-Adresse sollte von Ihnen aus der zuvor durchgeführten OVA-Installation vorkonfiguriert werden.

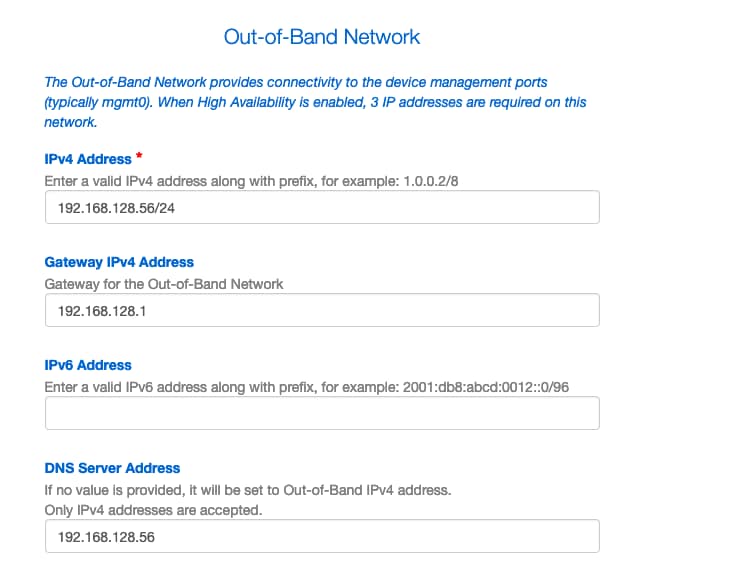

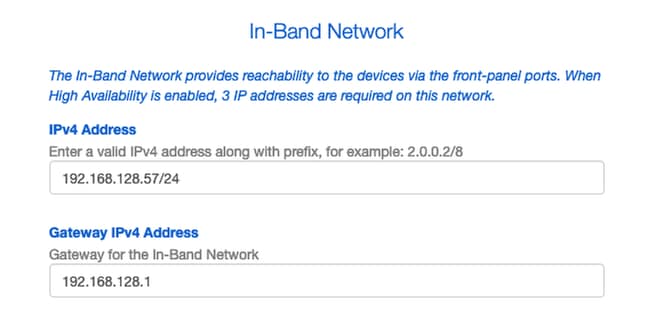

Schritt 8: Konfigurieren Sie das In-Band-Netzwerk. Das In-Band-Netzwerk wird für Anwendungen wie Endpoint Locator verwendet, der Port-Verbindungen an der Vorderseite mit den 9Ks in der Fabric erfordert, um als Border Gateway Protocol (BGP)-Sitzung zwischen DCNM und der 9K zu funktionieren.

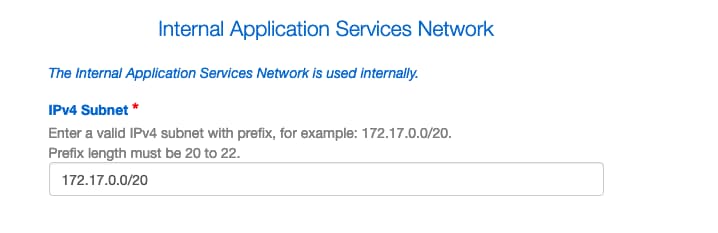

Schritt 9: Konfigurieren Sie das interne Anwendungsdienstnetzwerk —

Für den Anfang mit DCNM 11.0 unterstützt DCNM das Application Framework (AFW) mit DCNM LAN OVA/ISO Installation. Dieses Framework verwendet Docker für die Orchestrierung von Anwendungen als Mikroservices in geclusterten und nicht geclusterten Umgebungen, um eine Scale-Out-Architektur bereitzustellen.

Weitere standardmäßig mit dem DCNM ausgelieferte Anwendungen sind Endpoint Locator, Watch Tower, Virtual Machine Manager Plugin, Config Compliance usw. AFW übernimmt das Lifecycle-Management dieser Anwendungen, einschließlich Netzwerk-, Storage-, Authentifizierungs-, Sicherheits- usw. AFW verwaltet auch die Bereitstellung und den Lebenszyklus der Network Insights-Anwendungen, namentlich NIR und NIA. Dieses Subnetz gilt für Docker-Dienste, wenn NIA/NIR aktiviert ist.

Die Installation von NIA/NIR wird im Abschnitt "Day 2 Operations" (Day-2-Betrieb) behandelt.

Hinweis: Dieses Subnetz darf sich nicht mit den Netzwerken überschneiden, die den dem DCNM und den Rechenknoten zugewiesenen eth0/eth1/eth2-Schnittstellen zugewiesen sind. Darüber hinaus sollte dieses Subnetz nicht mit den IPs überlappen, die den Switches oder anderen von DCNM verwalteten Geräten zugewiesen sind. Das ausgewählte Subnetz sollte bei der Installation der primären und sekundären DCNM-Knoten konsistent bleiben (bei einer nativen HA-Bereitstellung).

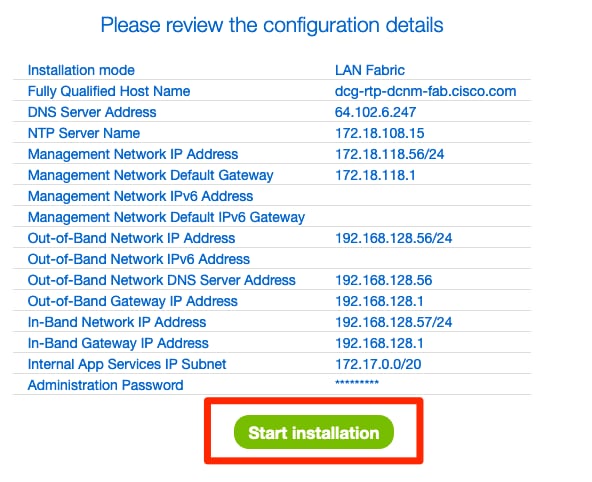

Schritt 10: Überprüfen und bestätigen Sie alle Konfigurationsdetails, und starten Sie die Installation.

Schritt 11: Melden Sie sich nach der vollständigen Installation von DCNM bei der GUI an (IP-Adresse oder Hostname, den Sie zuvor konfiguriert haben).

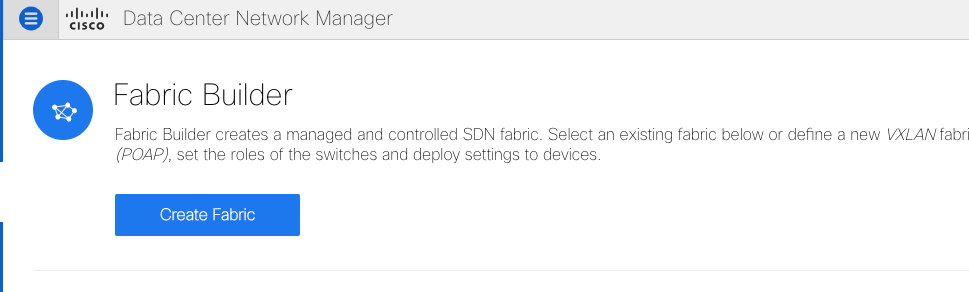

Bereitstellung der ersten Fabric - RTP-Fabric

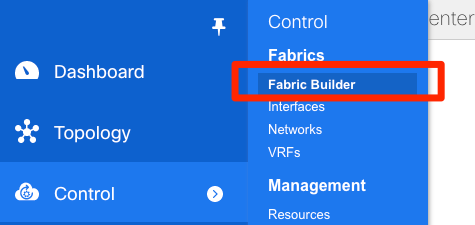

Schritt 1: Navigieren Sie in der DCNM-GUI zu Fabric Builder. Control > Fabrics > Fabric Builder, um Ihre erste Fabric zu erstellen.

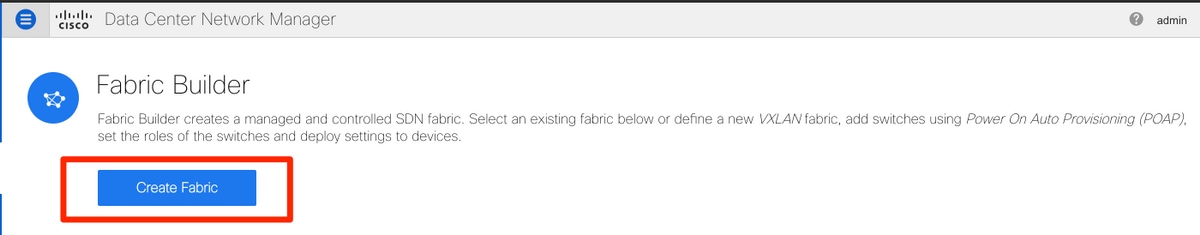

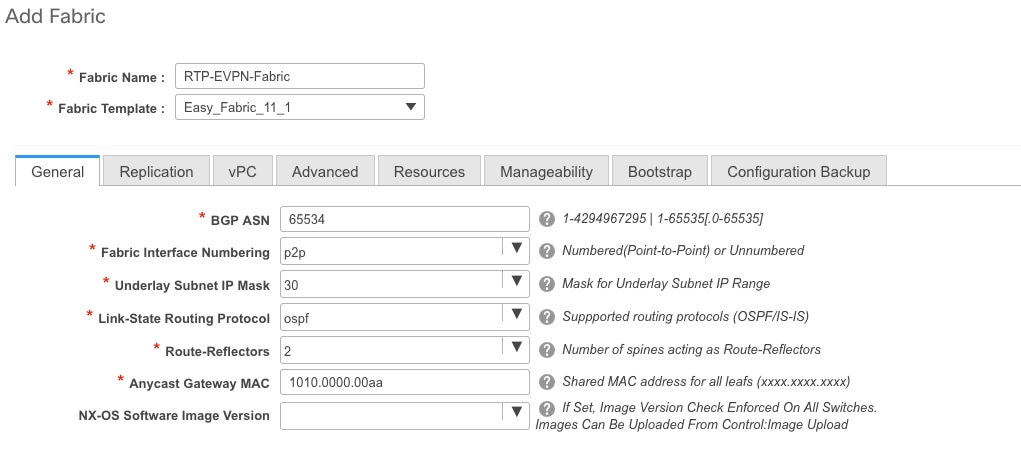

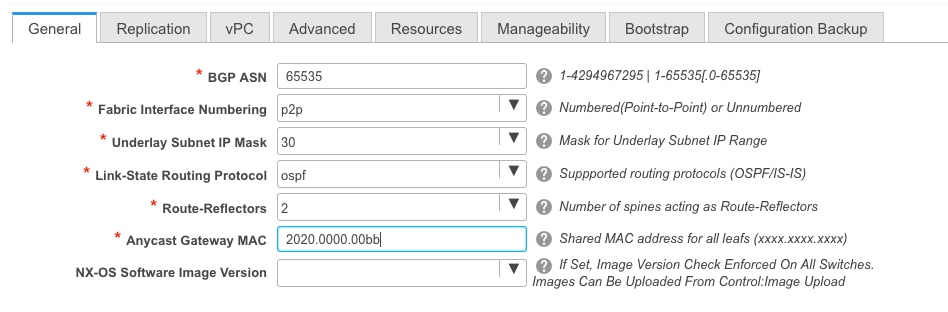

Schritt 2: Klicken Sie auf Create Fabric (Fabric erstellen), und füllen Sie die Formulare aus, die für Ihr Netzwerk erforderlich sind. Easy Fabric ist die richtige Vorlage für die lokale EVPN VXLAN-Bereitstellung:

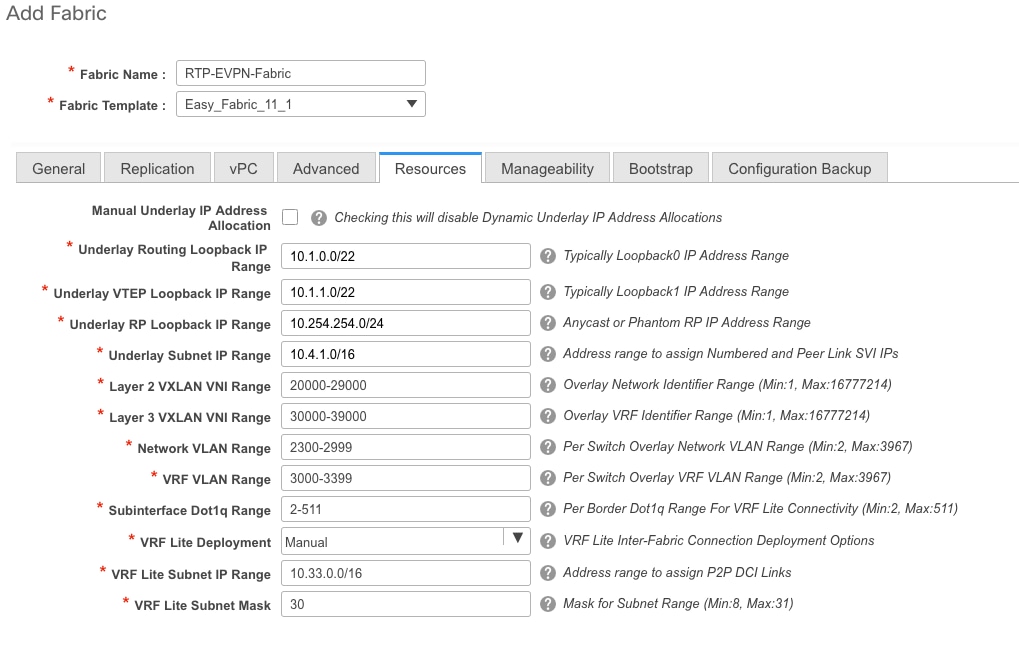

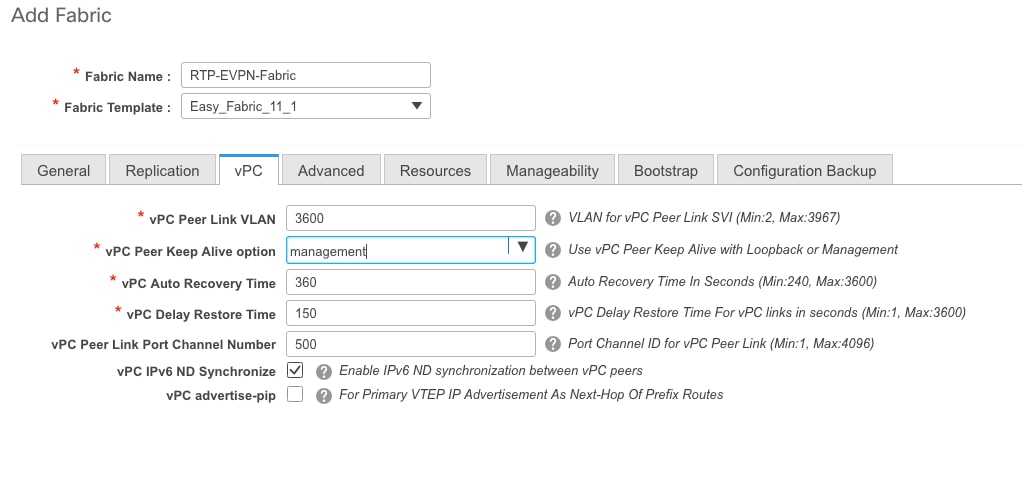

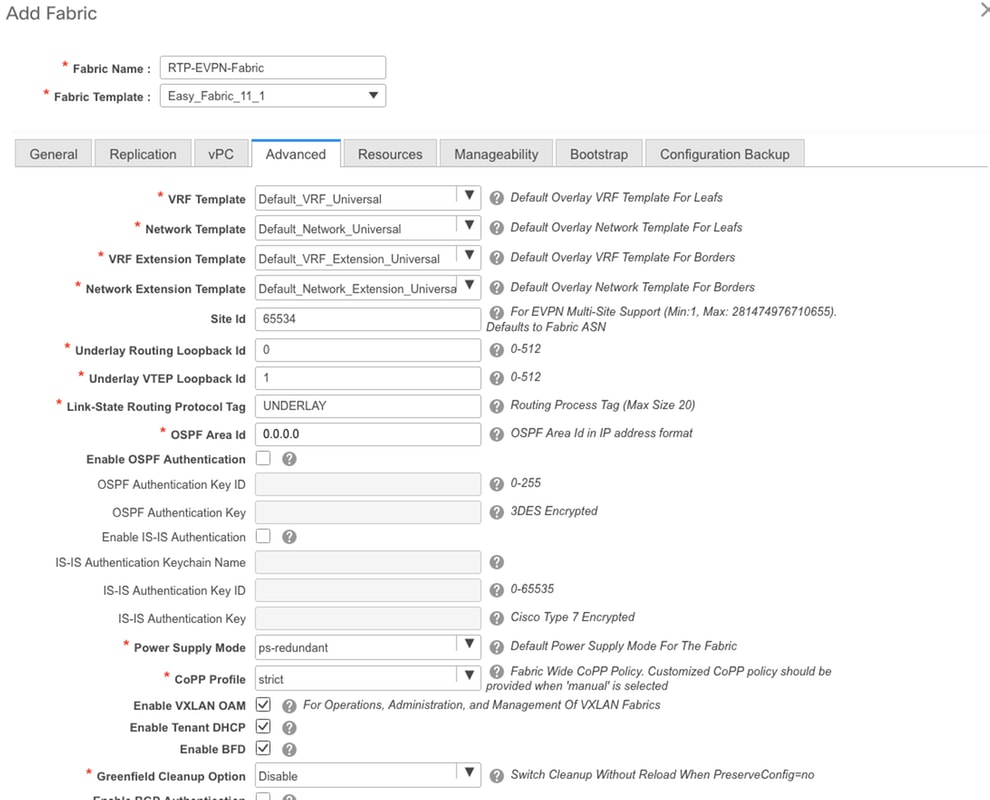

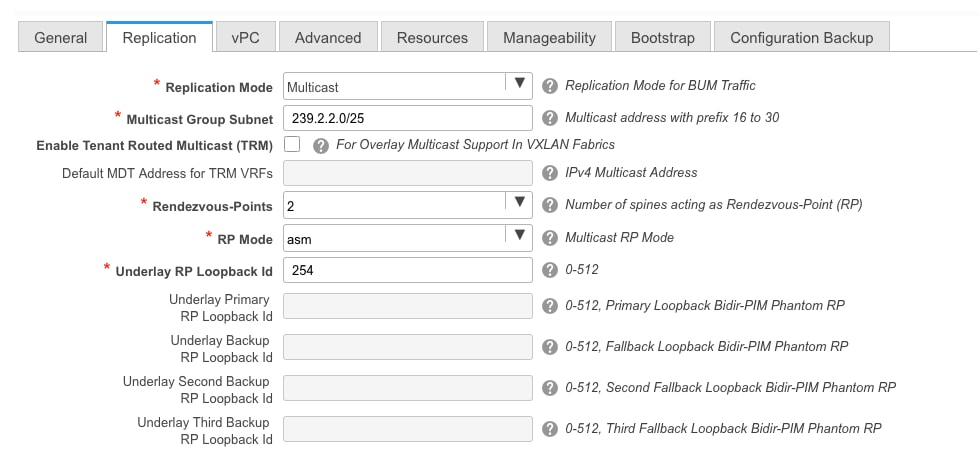

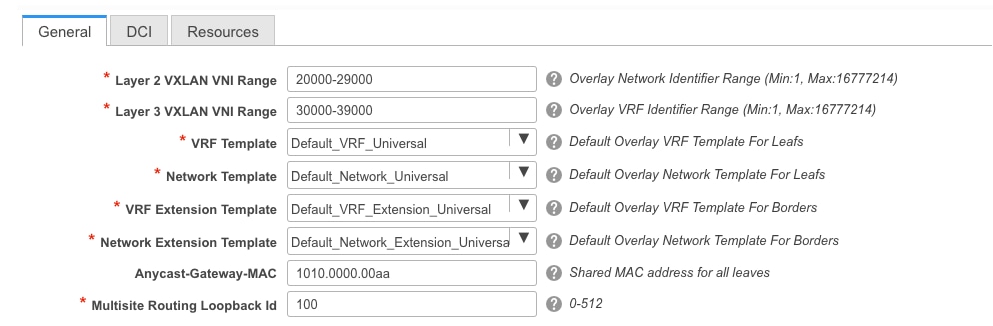

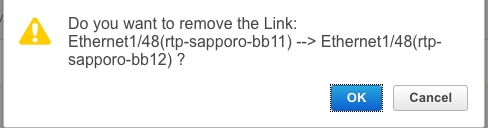

Schritt 3: Füllen Sie die Underlay-, Overlay-, vPC-, Replikations-, Ressourcen- usw.-Anforderungen von Fabric aus.

In diesem Abschnitt werden alle über DCNM erforderlichen Underlay-, Overlay-, vPC-, Replikations- usw. Einstellungen beschrieben. Dies hängt vom Netzwerkadressierungsschema, den Anforderungen usw. ab. In diesem Beispiel bleiben die meisten Felder als Standardwerte erhalten. L2VNI und L3VNI wurden so geändert, dass L2VNIs mit 2 und L3VNIs mit 3 beginnen, um später eine einfache Fehlerbehebung zu ermöglichen. BFD (Bidirectional Forwarding Detection) ist ebenfalls zusammen mit anderen Funktionen aktiviert.

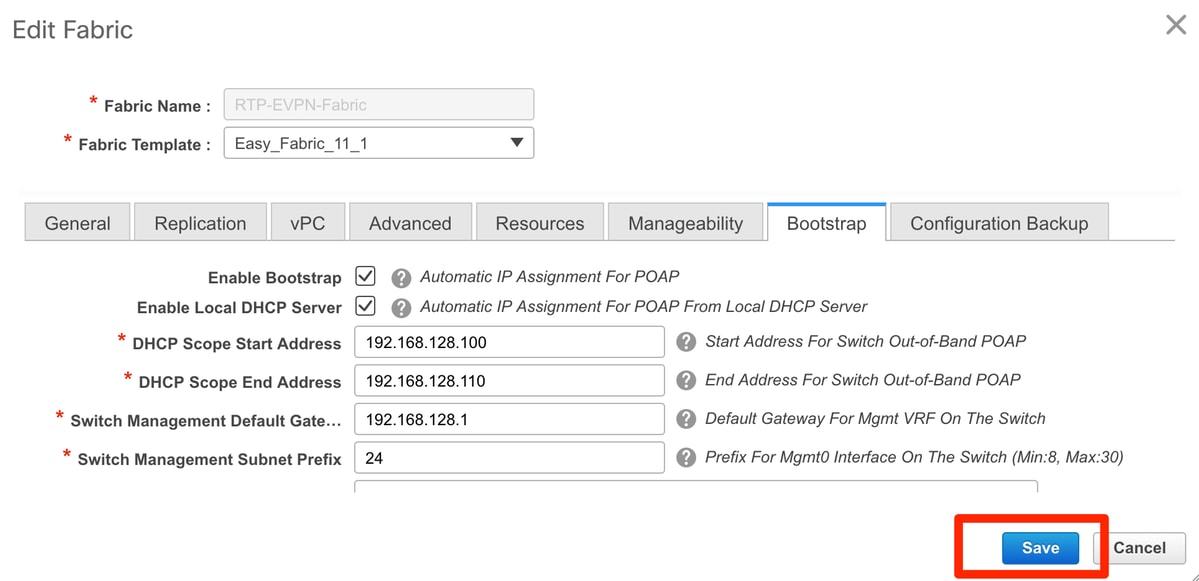

Schritt 4: Konfigurieren Sie unter der Bootstrap-Konfiguration den Bereich der DHCP-Adressen, die DCNM während des POAP-Prozesses an die Switches in der Fabric ausgeben soll. Konfigurieren Sie auch ein richtiges (vorhandenes) Standard-Gateway. Klicken Sie auf Speichern, sobald Sie fertig sind, und fügen Sie nun die Switches zur Fabric hinzu.

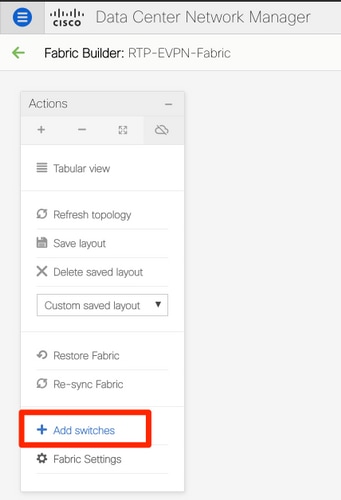

Hinzufügen von Switches zur Fabric

Schritt 1: Navigieren Sie zu Control > Fabrics > Fabric Builder, und wählen Sie dann Ihre Fabric aus. Klicken Sie im linken Bereich auf Switches hinzufügen, wie im Bild gezeigt.

Sie können Switches erkennen, indem Sie entweder eine Seed-IP verwenden (d. h. die mgmt0-IP-Adresse jedes Switches muss manuell konfiguriert werden), oder Sie können die Switches über POAP erkennen und DCNM alle mgmt0-IP-Adressen, VRF-Management usw. für Sie konfigurieren lassen. In diesem Beispiel wird POAP verwendet.

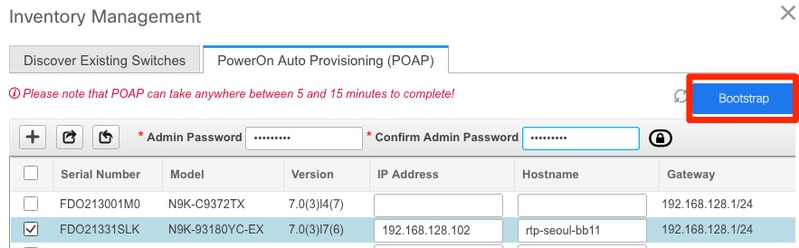

Schritt 2: Geben Sie nach Anzeige der gewünschten Switches die gewünschte IP-Adresse und den gewünschten Hostnamen für DCNM ein. Geben Sie Admin PW ein, und klicken Sie dann auf Bootstrap, wie im Bild gezeigt.

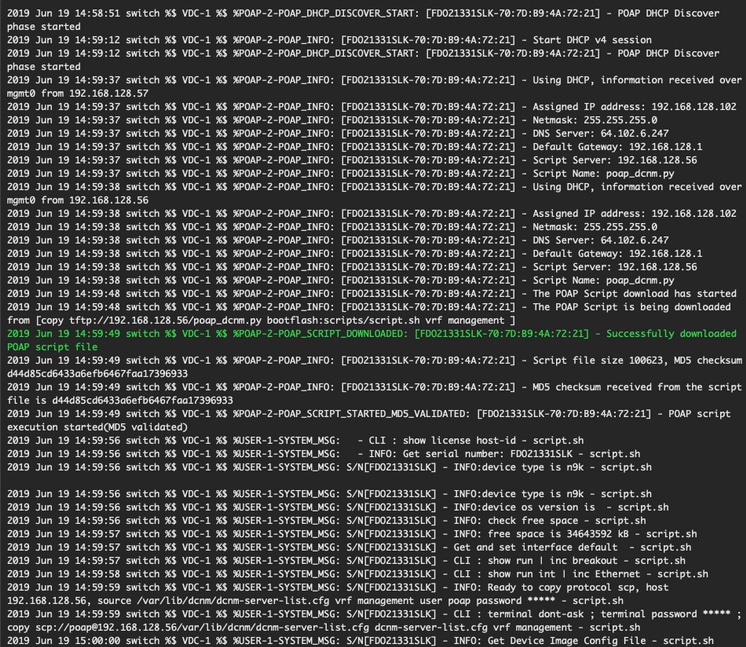

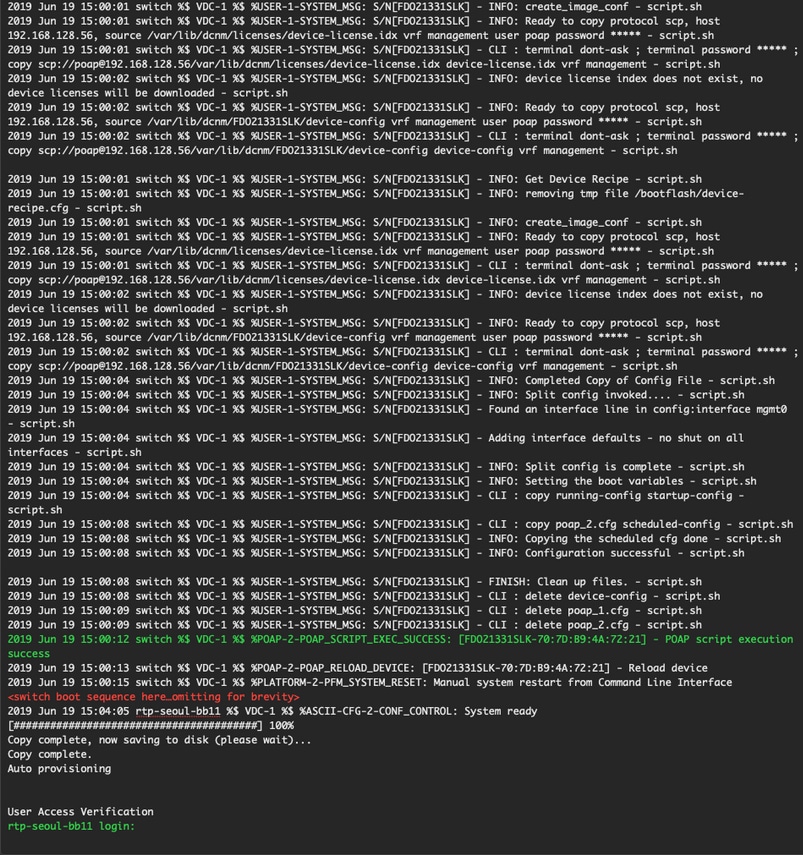

Ein erfolgreiches Startprotokoll sollte wie im Bild hier in der Switch-Konsole dargestellt aussehen.

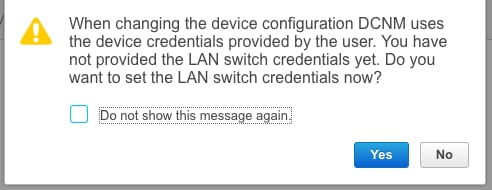

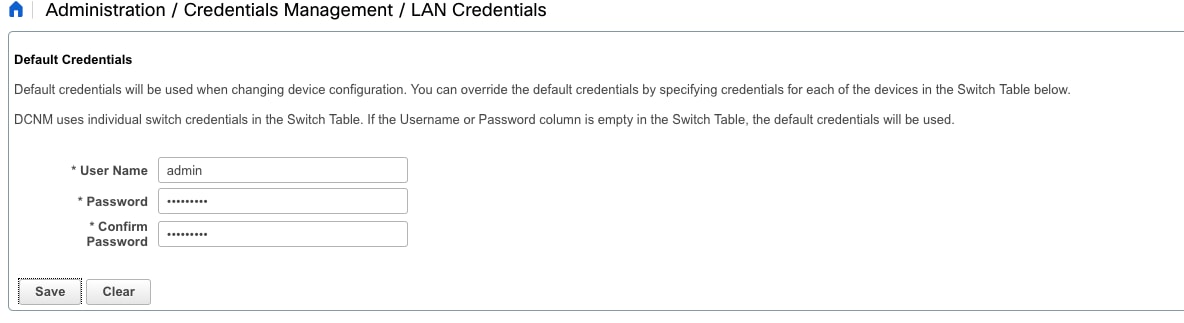

Schritt 3: Bevor Sie die Konfiguration für die gesamte Fabric bereitstellen, stellen Sie sicher, dass Sie DCNM zuvor mit den Geräteanmeldedaten konfiguriert haben. Während der Anmeldung sollte ein Popup in der GUI angezeigt werden. Sollte dies nicht der Fall sein, können Sie jederzeit über Administration > Credentials Management > LAN Credentials (Verwaltung der Anmeldeinformationen > LAN-Anmeldeinformationen) darauf zugreifen.

Hinweis: Wenn die Geräteanmeldeinformationen fehlen, kann DCNM die Konfiguration nicht auf die Switches übertragen.

Bereitstellung der Fabric-Konfiguration

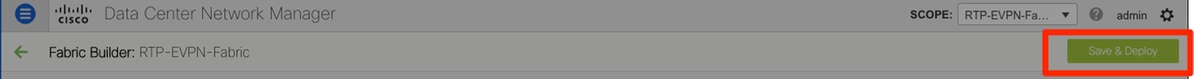

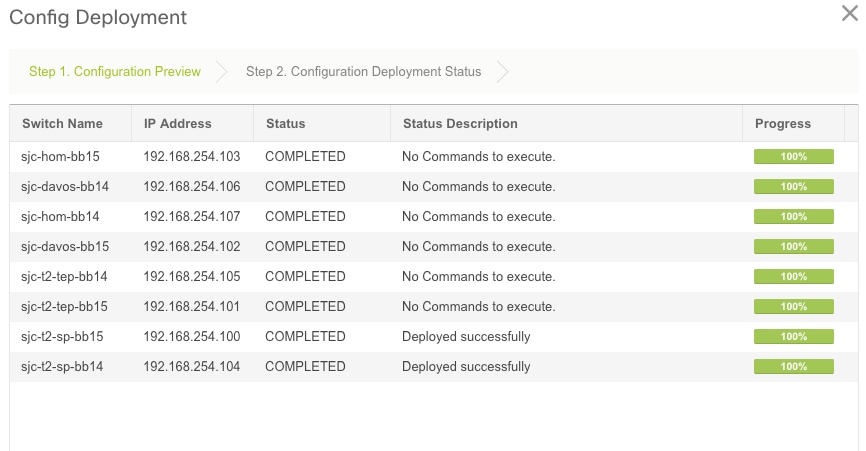

Schritt 1: Sobald Sie alle Switches für die jeweilige Fabric mithilfe der gleichen Schritte erkannt haben, navigieren Sie zu Control > Fabric > Fabric Builder > <Ihr ausgewähltes Fabric>. Hier sollten Sie Ihre Switches und alle zugehörigen Links sehen. Klicken Sie auf Speichern und Bereitstellen.

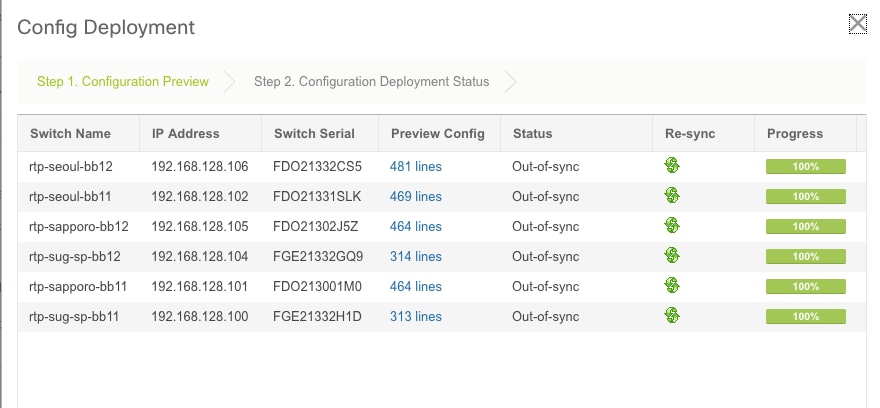

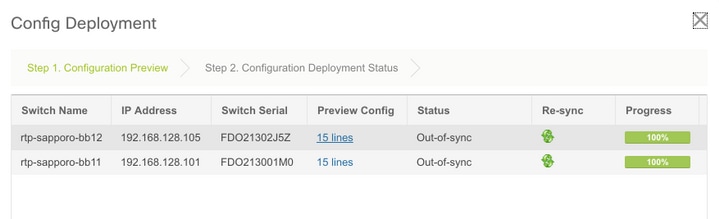

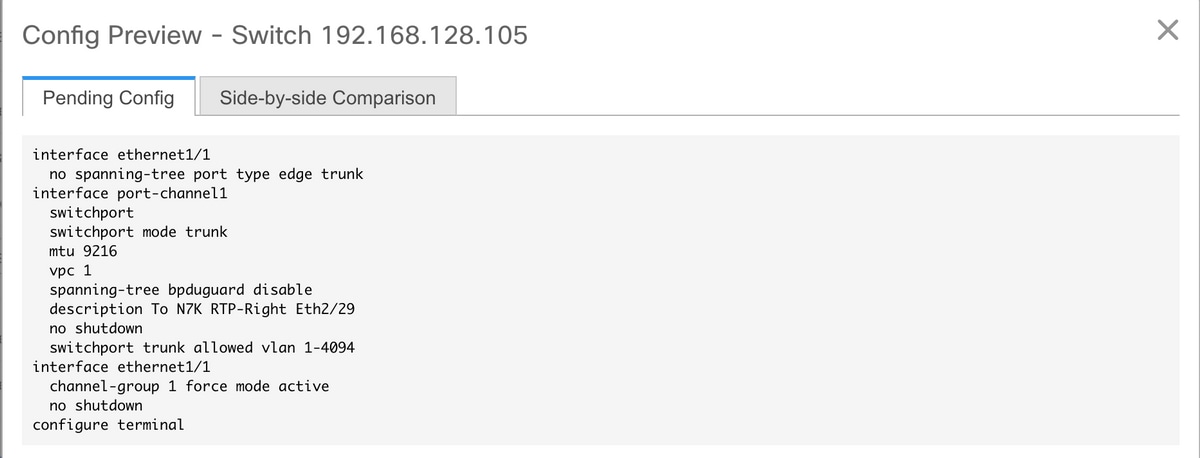

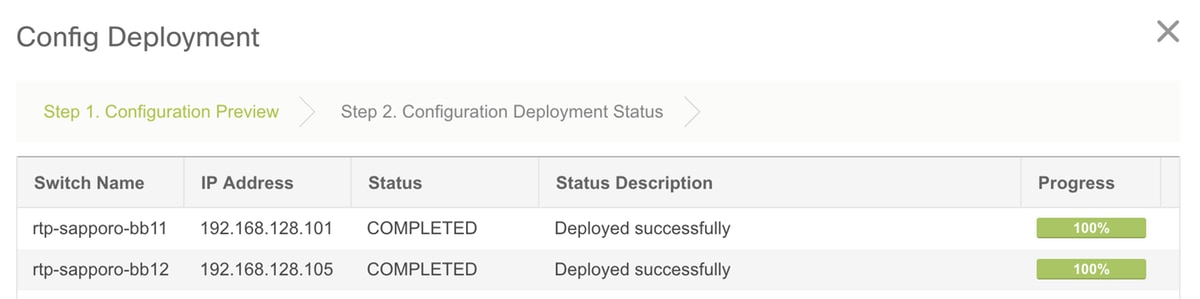

Schritt 2: Im Fenster Config Deployment (Konfigurationsbereitstellung) wird angezeigt, wie viele Konfigurationslinien für jeden Switch DCNM übertragen werden. Sie können die Konfiguration bei Bedarf auch vorab anzeigen und die Vor- und Nachher-Ergebnisse vergleichen:

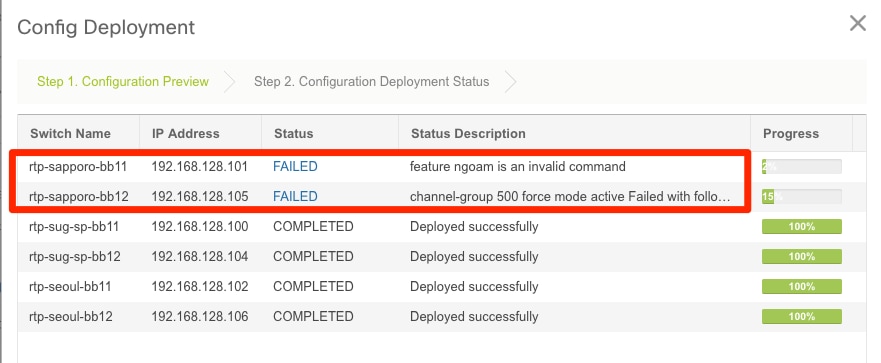

Stellen Sie sicher, dass alle Switches "COMPLETED" und "100 % ohne Fehler" anzeigen. Falls Fehler auftreten, sollten Sie diese nacheinander beheben (Beispiele finden Sie unter Probleme bei dieser Bereitstellung).

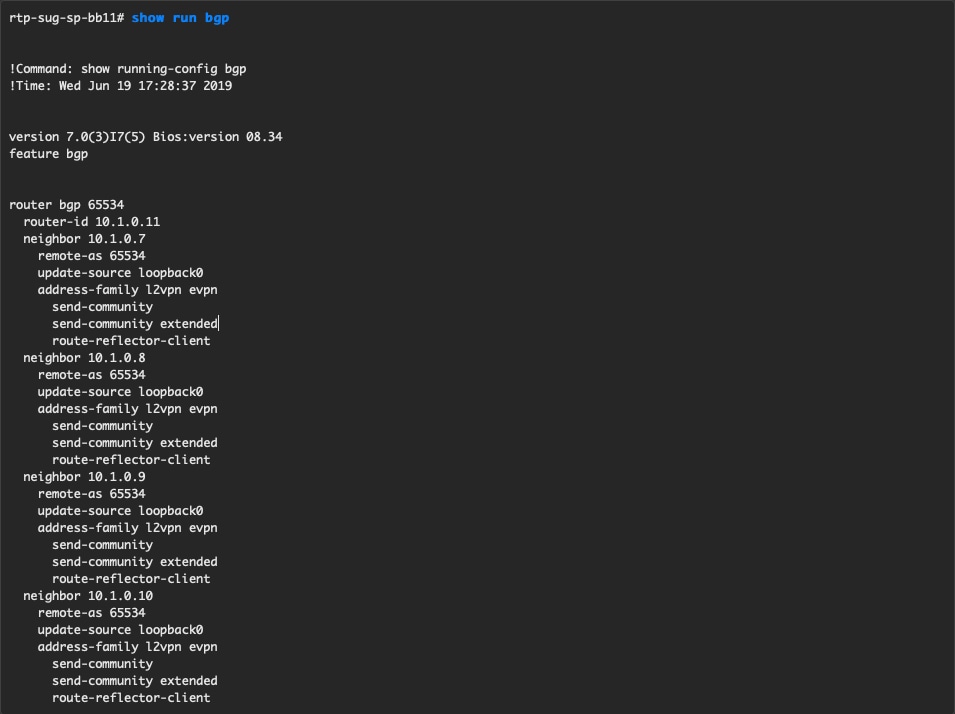

Schritt 3: (Optional) Sie können sich zu diesem Zeitpunkt bei den Geräten anmelden und show run CLIs ausgeben, um zu überprüfen, ob die Konfiguration erfolgreich von DCNM übernommen wurde.

Beispiel:

Bereitstellung der zweiten Fabric - SJ

Führen Sie die gleichen Schritte wie zuvor mit der RTP-Fabric durch, wobei Sie verschiedene Werte für BGP AS usw. verwenden.

Schritt 1: Navigieren Sie zu Control > Fabrics > Fabric Builder > Create Fabric > Name it!

In diesem Abschnitt werden alle erforderlichen Underlay-, Overlay-, vPC-, Replication- usw. Einstellungen beschrieben. Dies hängt vom Netzwerkadressierungsschema, den Anforderungen usw. ab.

Hinweis: Die MAC-Adresse des Anycast-Gateways hier sollte mit der anderen Fabric übereinstimmen, wenn Multi-Site verwendet wird. Später werden verschiedene MACs des Anycast-Gateways nicht unterstützt. Dies wurde später im Abschnitt zur Bereitstellung mehrerer Standorte korrigiert (nicht im Artikel zur Kursivität aufgeführt).

Schritt 2: Konfigurieren Sie den Bootstrap-Abschnitt wie zuvor beschrieben. Navigieren Sie erneut durch Switches hinzufügen. Klicken Sie nach der Erkennung auf Speichern und Bereitstellen, um die Konfiguration bereitzustellen. All dies wurde im Abschnitt zur RTP-Fabric-Bereitstellung behandelt (hier aus Gründen der Kürze weggelassen).

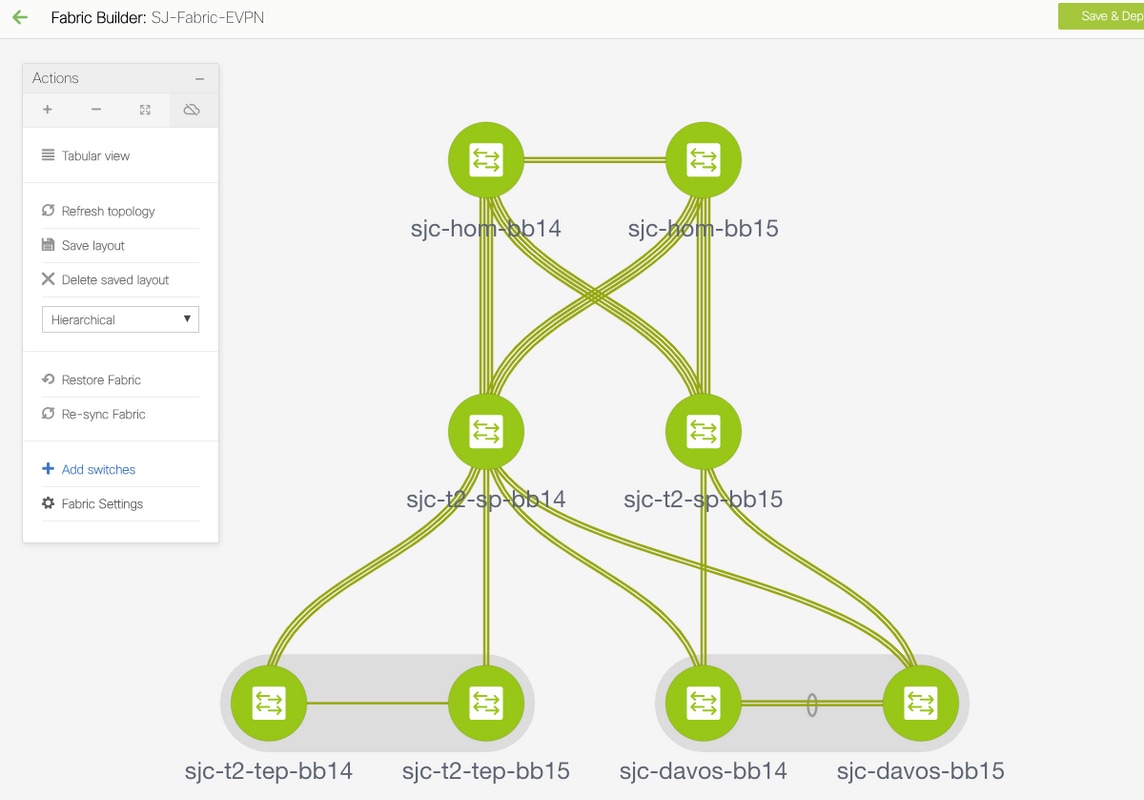

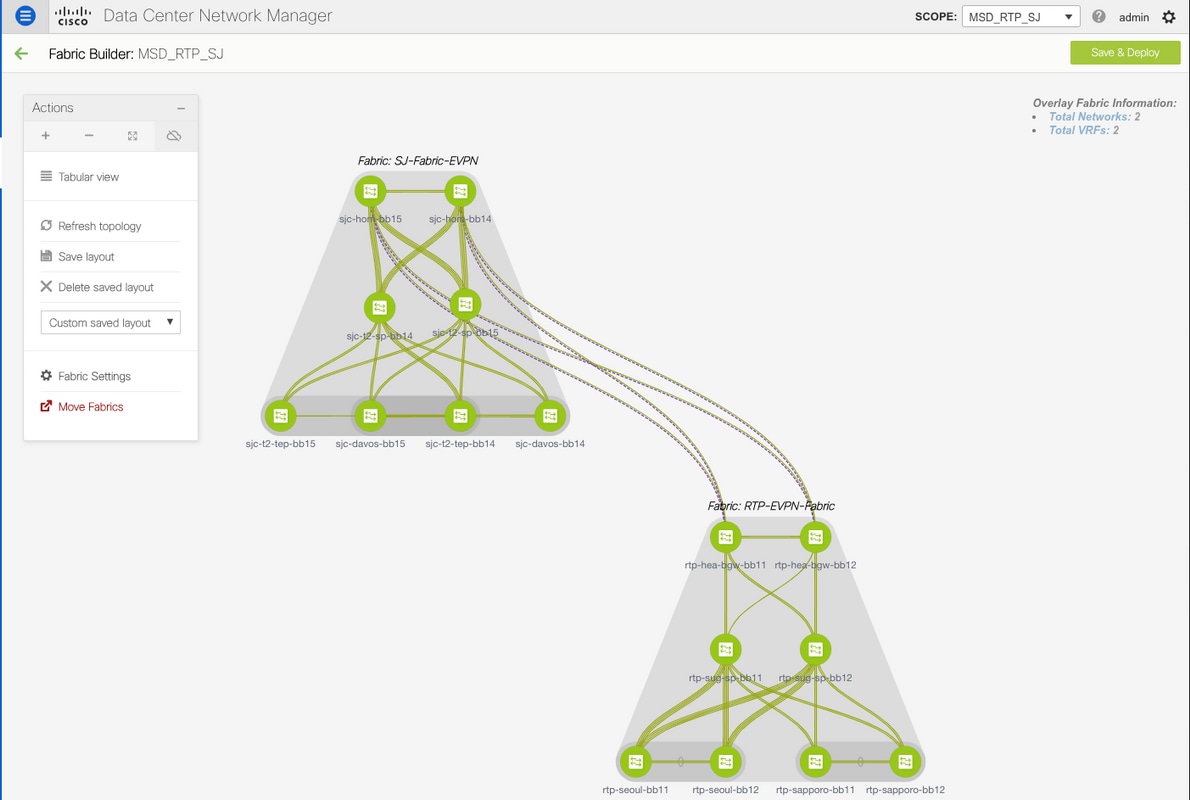

Am Ende eine Topologie aus Sicht von Fabric Builder.

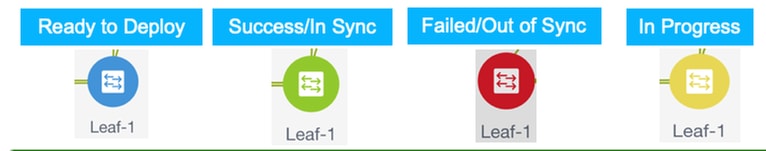

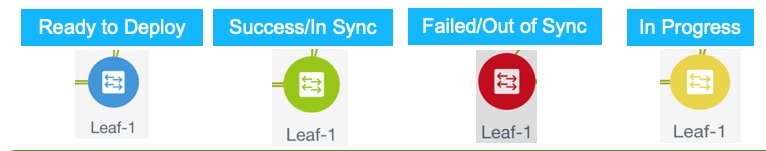

Im Idealfall sollten alle Switches zusammen mit ihren Links grün angezeigt werden. Dieses Bild zeigt die verschiedenen Statusfarben im DCNM-Format.

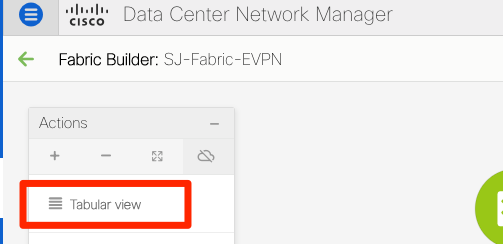

Schritt 3: Nachdem beide Fabrics konfiguriert und bereitgestellt wurden, müssen Sie die Konfiguration speichern und neu laden, damit die TCAM-Änderungen wirksam werden. Gehen Sie zu Controls > Fabrics > Fabric Builder > <your Fabric>, und navigieren Sie zu Tabellarische Ansicht, wie im Bild gezeigt.

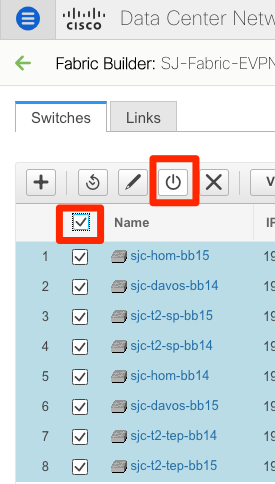

Schritt 4: Klicken Sie dann auf den Betriebsschalter (dieser lädt alle Switches gleichzeitig neu):

Erstellen eines Netzwerks (VLAN/L2VNI) und von VRFs (L3VNIs)

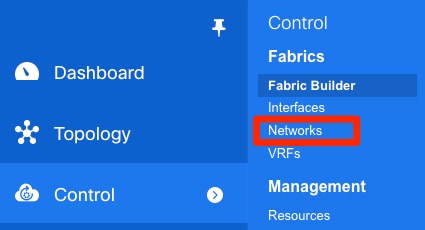

Schritt 1: Navigieren Sie zu Control > Fabrics > Networks, wie im Bild gezeigt.

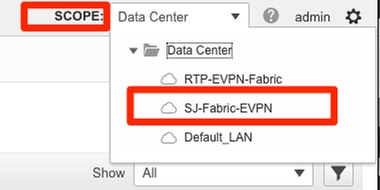

Schritt 2: Wählen Sie, wie im Bild gezeigt, den Bereich für die Änderung aus. Auf welche Fabric muss diese Konfiguration angewendet werden?

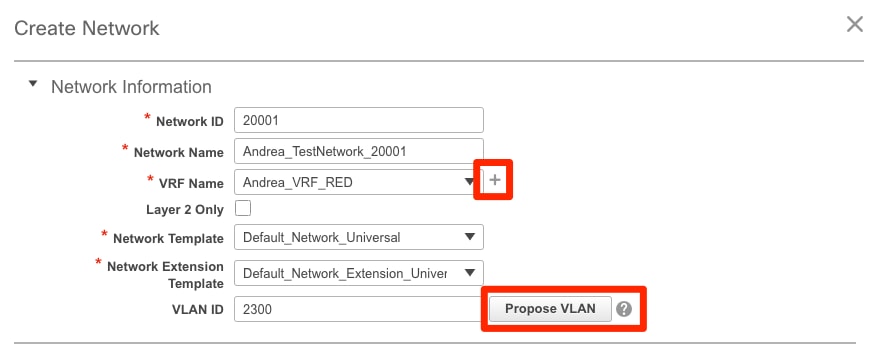

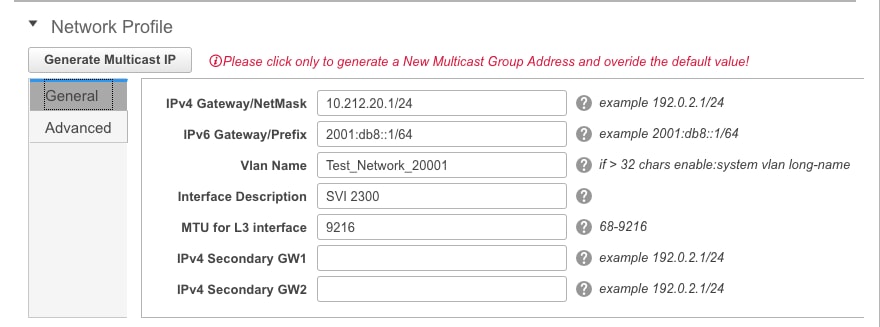

Schritt 3: Klicken Sie auf das + Zeichen, wie im Bild gezeigt.

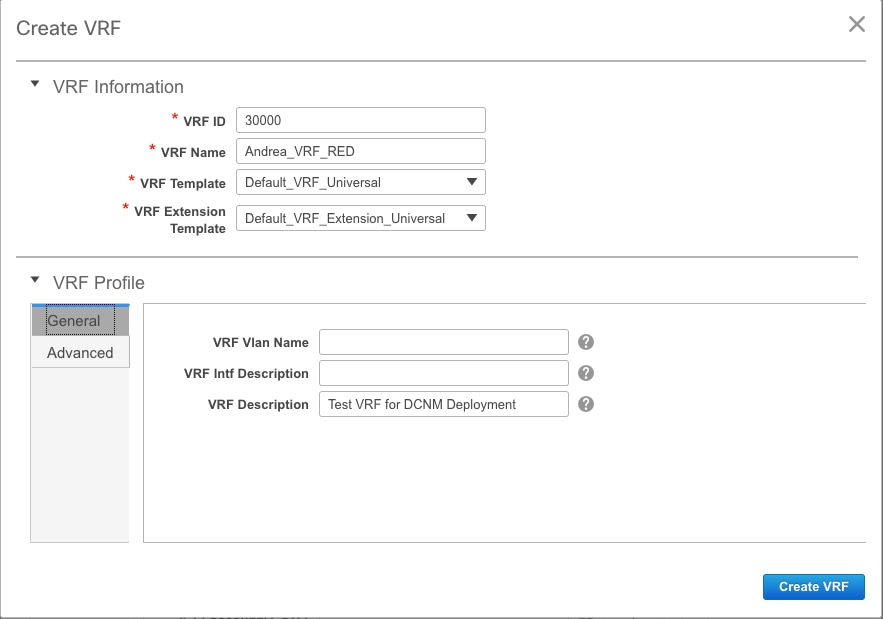

Schritt 4: DCNM führt Sie durch den Prozess zum Erstellen der Switch Virtual Interface (SVI) (oder des reinen L2-VLAN). Wenn zu diesem Zeitpunkt keine VRF-Instanzen erstellt werden, klicken Sie erneut auf die +-Schaltfläche, um vorübergehend zur Durchleitung der VRF-Instanzen zu gelangen, bevor Sie mit den SVI-Einstellungen fortfahren.

Diese Funktionen können auf der Registerkarte Erweitert konfiguriert werden:

- ARP-Unterdrückung

- Ingress-Replikation

- Multicast-Gruppe

- DCHP

- Routen-Tags

- TRM

- L2 VNI Route Target

- Aktivieren des L3-Gateways an der Grenze

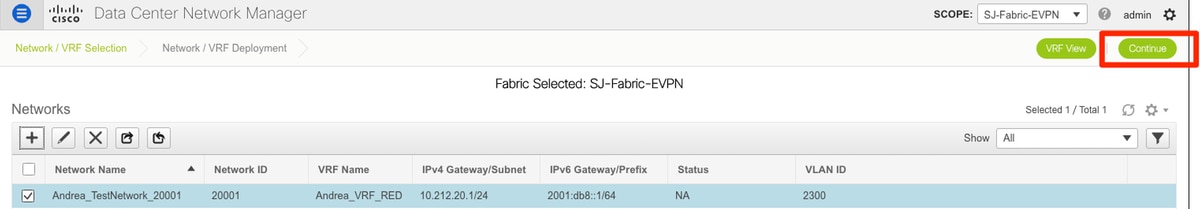

Schritt 5: Klicken Sie auf Weiter, um die Netzwerk-/VRF-Konfiguration bereitzustellen.

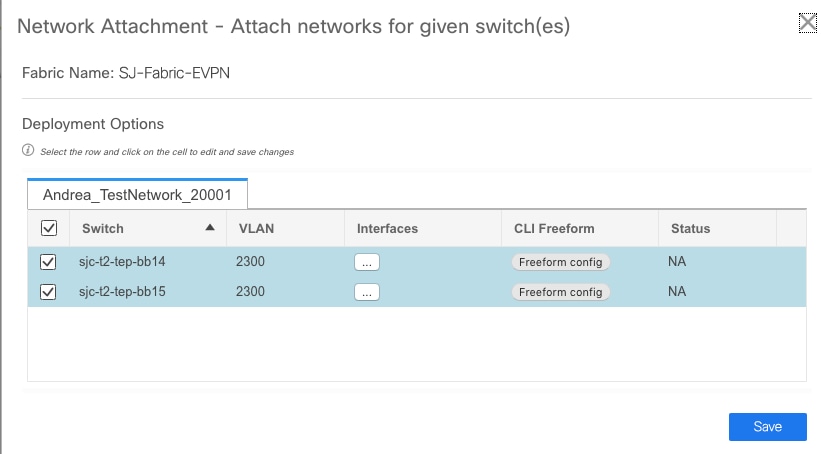

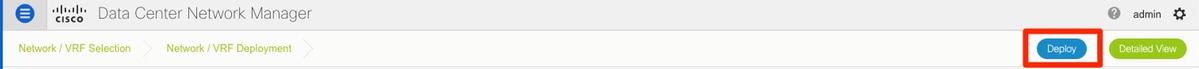

Schritt 6: Doppelklicken Sie in der Topologieansicht (DCNM führt Sie automatisch hierher) auf ein Gerät (oder Geräte), um diese für die entsprechende Konfiguration auszuwählen. Klicken Sie auf Speichern, wie im Bild gezeigt.

Schritt 7: Nach der Auswahl der Switches sollten die Switches blau (Bereit zur Bereitstellung) aussehen, wie in diesem Bild gezeigt.

Hinweis: Wenn Sie die Konfiguration für die CLI vor der Bereitstellung überprüfen möchten, können Sie auf Detailansicht statt Bereitstellen klicken und auf Vorschau im nächsten Bildschirm klicken.

Die Switches leuchten gelb, während die Konfiguration angewendet wird, und kehren nach Abschluss der Konfiguration zu Grün zurück.

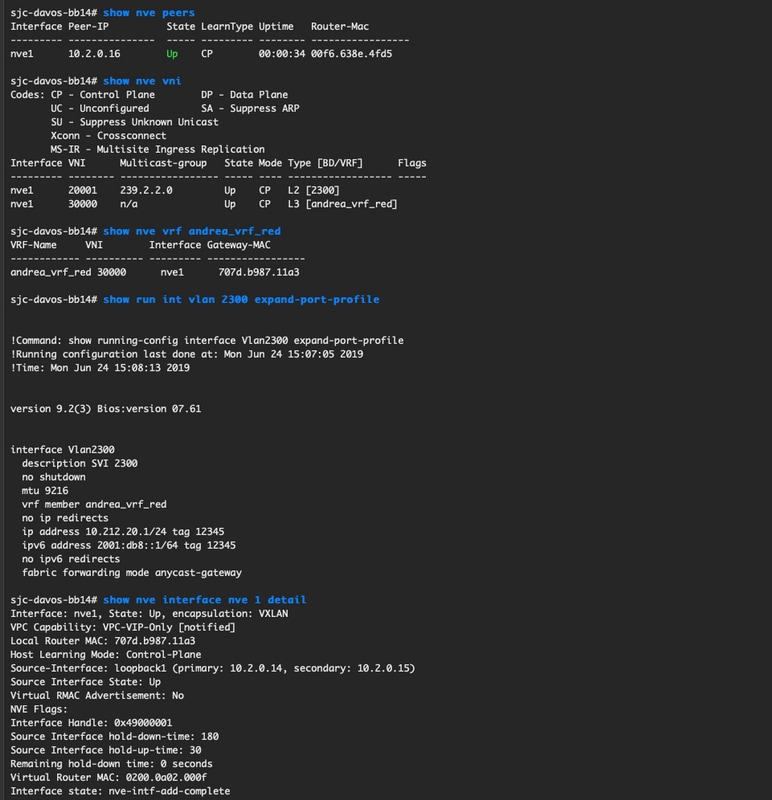

Schritt 8: (Optional) Sie können die CLI anmelden, um die Konfiguration zu überprüfen, falls erforderlich (denken Sie daran, die Option "Erweiterungsportprofil" zu verwenden):

Standortübergreifende Konfiguration

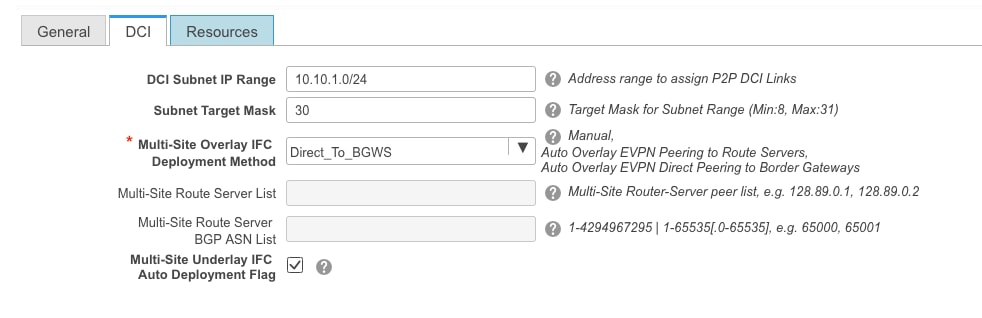

Bei dieser Greenfield-Bereitstellung wird MSD Fabric über das direkte Peering zwischen Border Gateways (BGWs) bereitgestellt. Eine Alternative ist die Verwendung eines zentralen Routing-Servers, der in diesem Dokument nicht behandelt wird.

Schritt 1: Navigieren Sie zu Control > Fabric Builder > Create Fabric (Fabric erstellen), wie im Bild gezeigt.

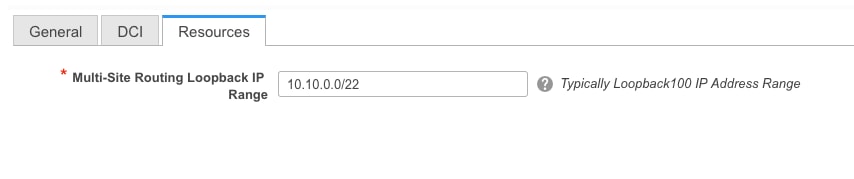

Schritt 2: Geben Sie Ihrem Multi-Site-Fabric einen Namen, und wählen Sie im Dropdown-Menü für Fabric-Vorlage MSD_Fabric_11_1.

Schritt 3: Stellen Sie unter Allgemein sicher, dass Ihr L2- und L3-VNI-Bereich mit dem übereinstimmt, was Ihre einzelnen Fabrics verwenden. Darüber hinaus muss die MAC-Adresse des Anycast-Gateways auf beiden Fabrics übereinstimmen (in diesem Beispiel RTP/SJ). DCNM gibt einen Fehler aus, wenn die Gateway-MACs falsch zugeordnet sind und vor der MSD-Bereitstellung korrigiert werden muss.

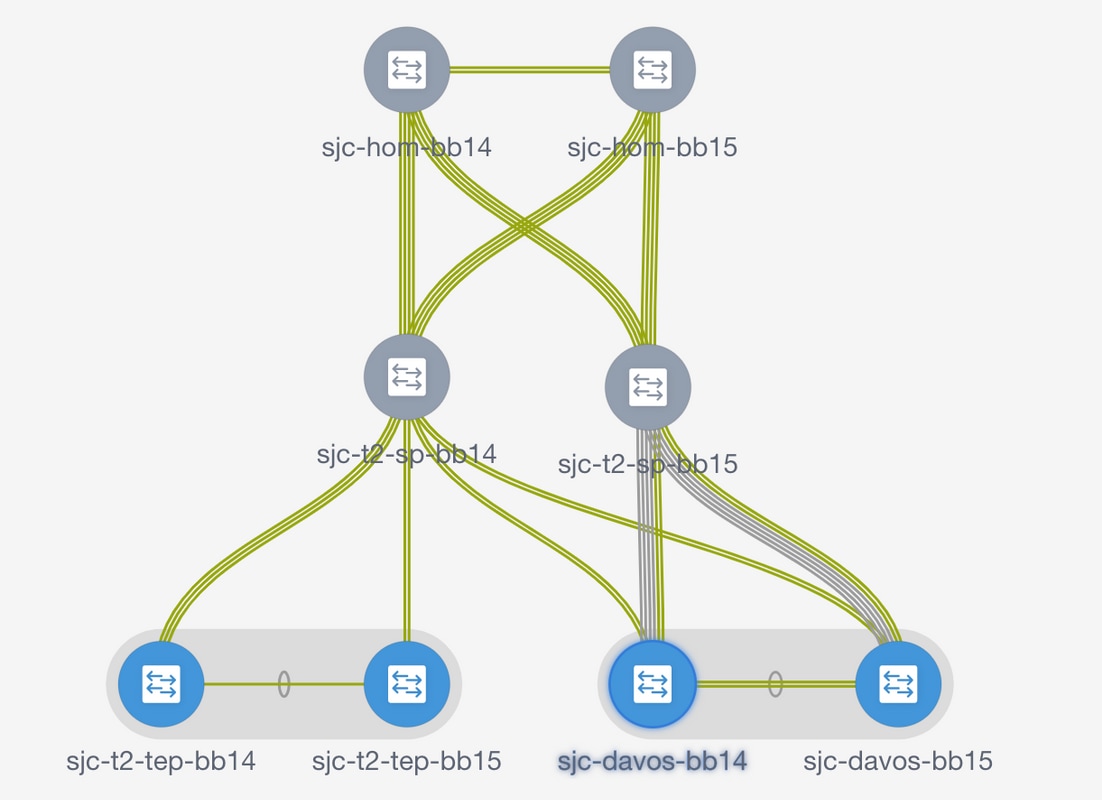

Schritt 4: Klicken Sie auf Speichern, navigieren Sie anschließend zur MSD-Struktur, und klicken Sie auf Speichern und Bereitstellen. Ihre Topologie sollte ähnlich aussehen wie diese (alle Switches + Links Grün), sobald sie erfolgreich abgeschlossen wurde:

Bereitstellung von Host-Zugriff/Trunk-Richtlinien

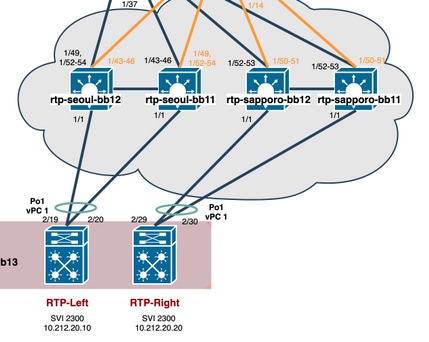

In diesem Beispiel werden vPC-Trunks von zwei verschiedenen VTEP-Paaren konfiguriert und die Verbindung innerhalb der lokalen RTP-Fabric getestet. Relevante Topologie, wie im Bild gezeigt:

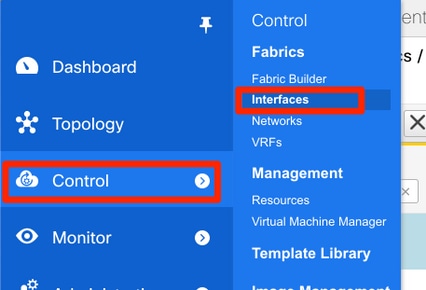

Schritt 1: Navigieren Sie zu Control > Fabrics > Interfaces, wie im Bild gezeigt.

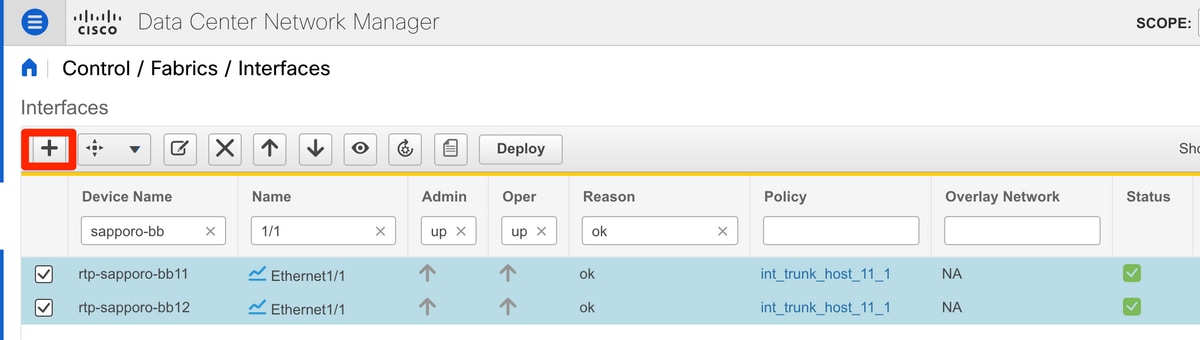

Schritt 2: Klicken Sie auf das + Zeichen, um den Schnittstellenassistenten hinzuzufügen, wie im Bild gezeigt.

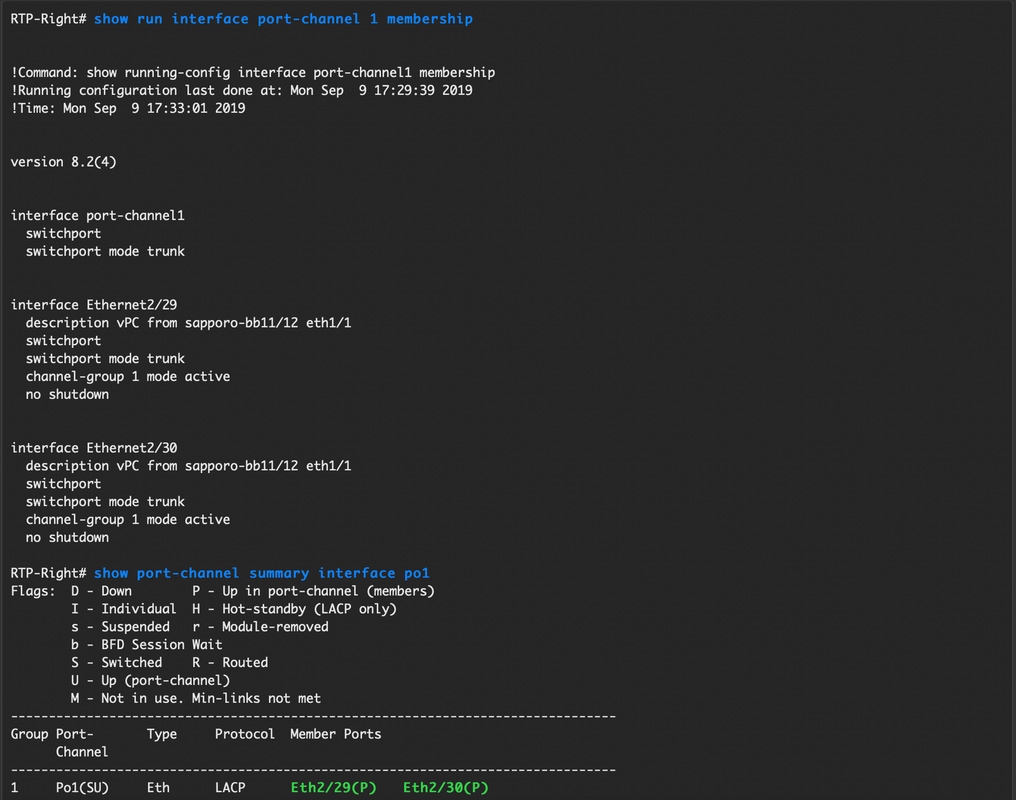

In diesem Beispiel wird ein vPC-Trunk unterhalb des N7K erstellt, der zum Pingen von Tests in diesem Durchgang verwendet wird.

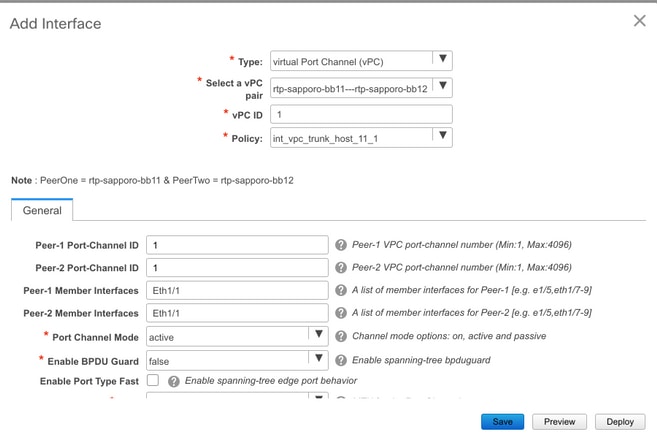

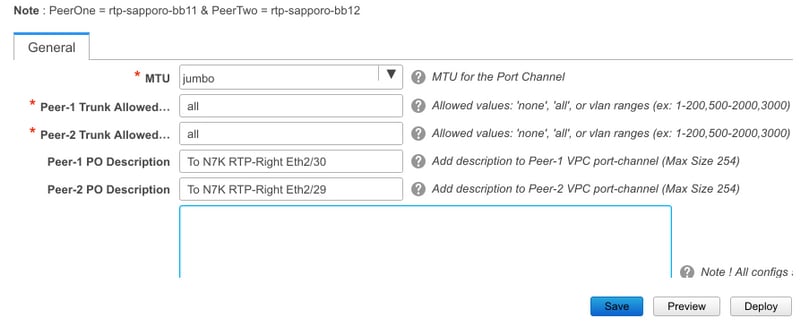

Schritt 3: Wählen Sie das entsprechende vPC-Paar, physische Schnittstellen, LACP ein/aus, BPDUGuard usw. aus.

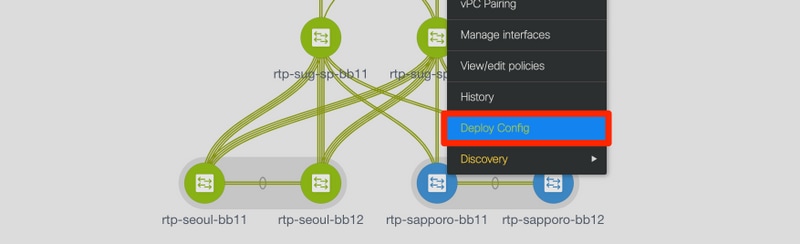

Schritt 4: Klicken Sie abschließend auf Speichern. Alternativ können Sie auch direkt bereitstellen, wie im Bild gezeigt.

Schritt 5: (Optional) Überprüfen Sie die anzuwendende Konfiguration.

Schritt 6: (Optional) Manuelle Konfiguration auf 7K:

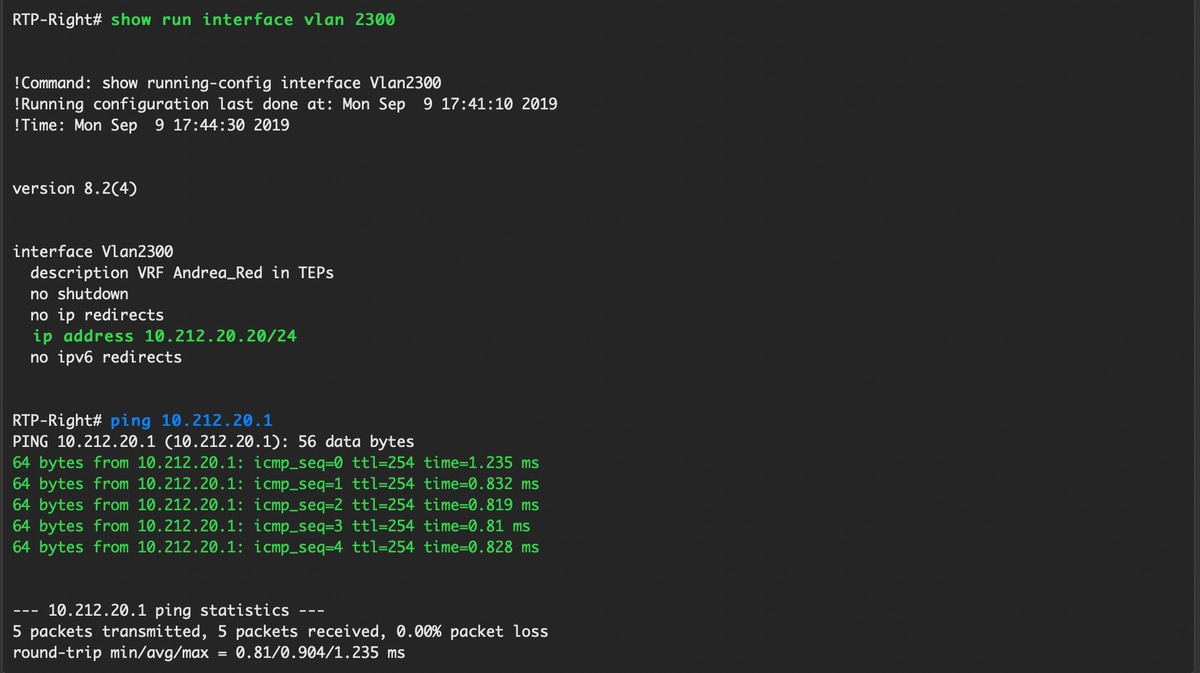

Schritt 7: (Optional) Erstellen einer Test-SVI auf N7K zum Pingen der VTEPs im RTP (VTEPs verfügen über Anycast Gateway 10.212.20.1 in VRF und rea_red):

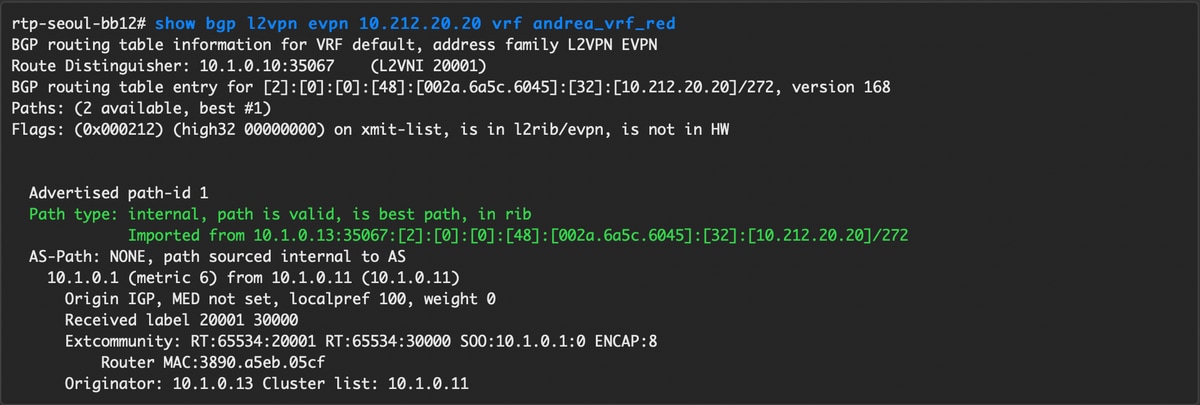

Schritt 8: (Optional) Überprüfen Sie, ob andere VTEPs innerhalb von RTP diesen Host über EVPN/HMM sehen:

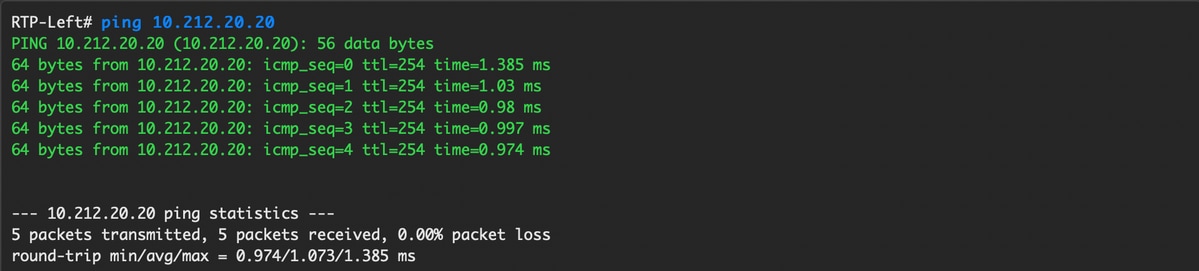

Schritt 9. (Optional) Wiederholen Sie den gleichen Prozess für seoul-bb11/12 (vPC-Port-Channel erstellen, SVI 2300 erstellen). Ping von RTP-Left zu RTP-Right, um die L2-Verbindung über EVPN in der RTP-Fabric zu bestätigen:

Ähnliche Schritte können ausgeführt werden, um Nicht-vPC-Port-Channels, Zugriffsschnittstellen usw. unter dem Kontext Schnittstellen hinzufügen zu erstellen.

Tagesbetrieb

Upgrade der NX-OS-Software über DCNM

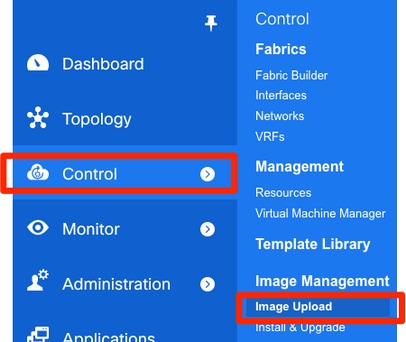

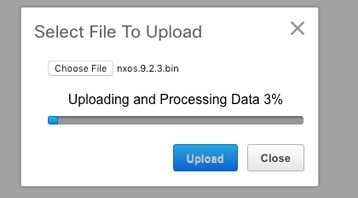

Schritt 1: Laden Sie ein Bild (oder eine Reihe von Bildern auf den DCNM-Server) hoch, und navigieren Sie dann zu Control > Image Management > Image Upload (Steuerung > Image-Management > Image-Upload, wie im Bild gezeigt).

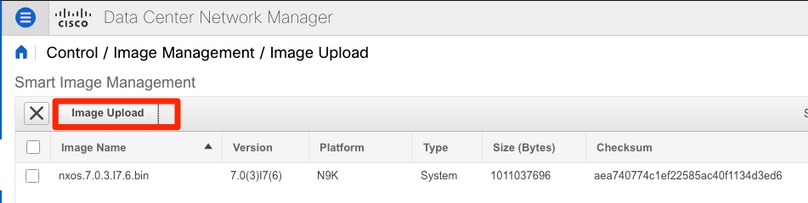

Schritt 2: Folgen Sie den Eingabeaufforderungen für einen lokalen Upload, dann sollten die Dateien wie in diesem Bild gezeigt angezeigt werden:

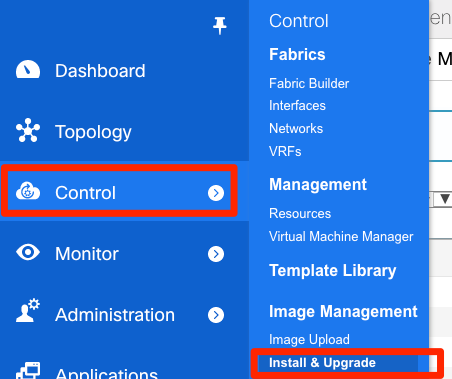

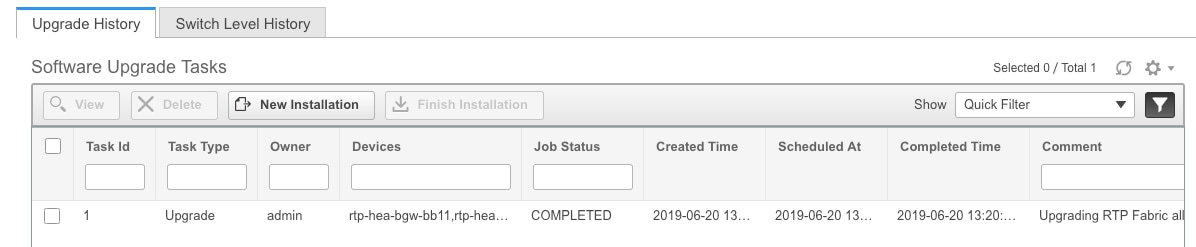

Schritt 3: Nach dem Hochladen der Datei(en) können Sie mit Installation und Upgrade fortfahren, wenn die Switches aktualisiert werden müssen. Navigieren Sie zu Control > Image Management > Install & Upgrade, wie im Bild gezeigt.

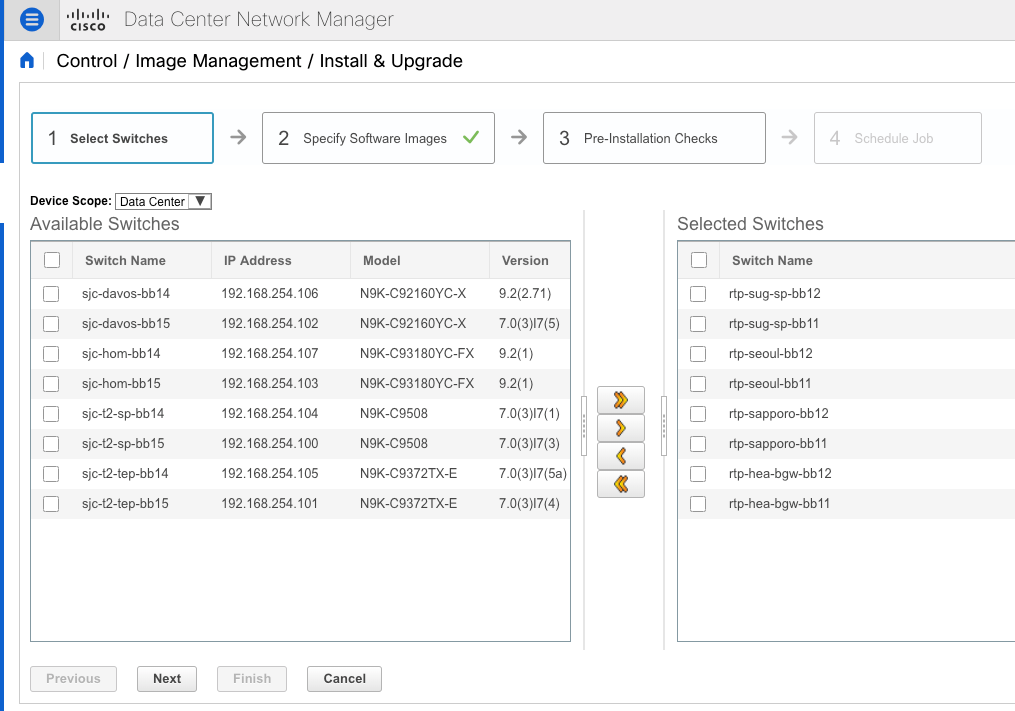

Schritt 4: Wählen Sie die Switches aus, die aktualisiert werden sollen. In diesem Beispiel wird die gesamte RTP-Fabric aktualisiert.

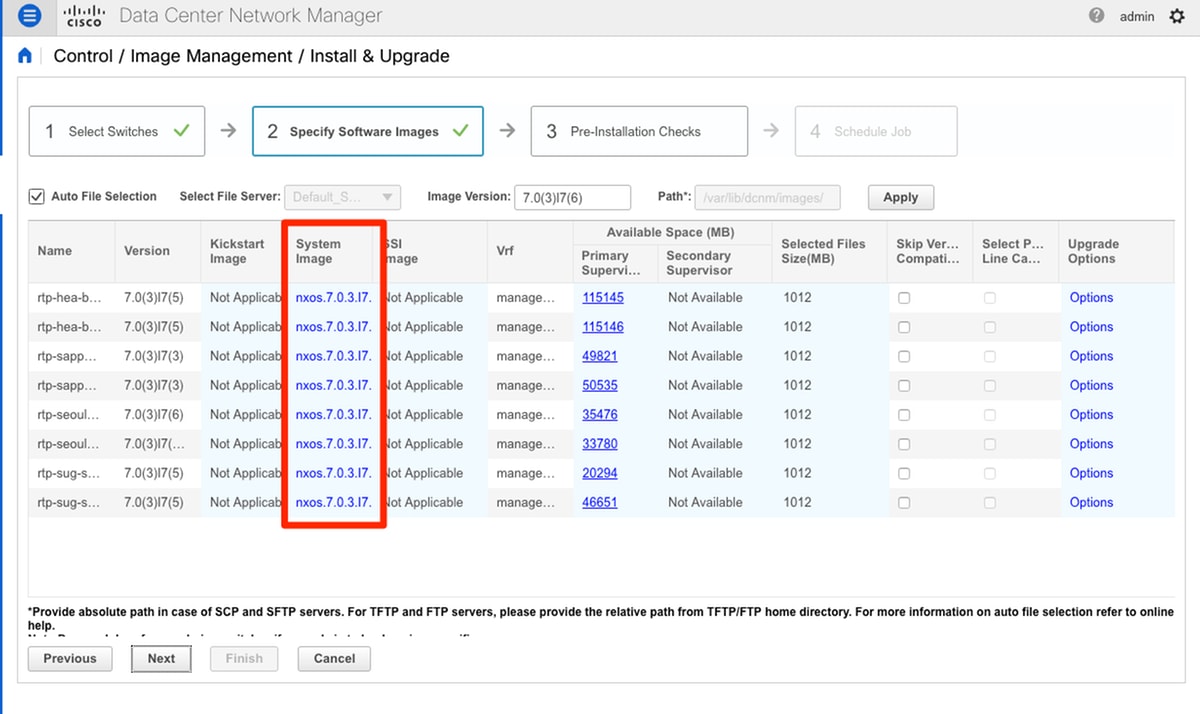

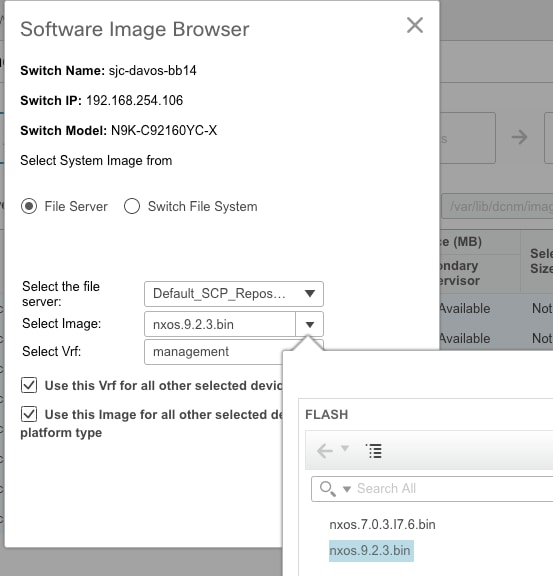

Schritt 5: Wählen Sie aus, auf welche NX-OS-Version die Switches aktualisiert werden sollen (als Best Practice sollten alle Switches auf dieselbe NX-OS-Version aktualisiert werden):

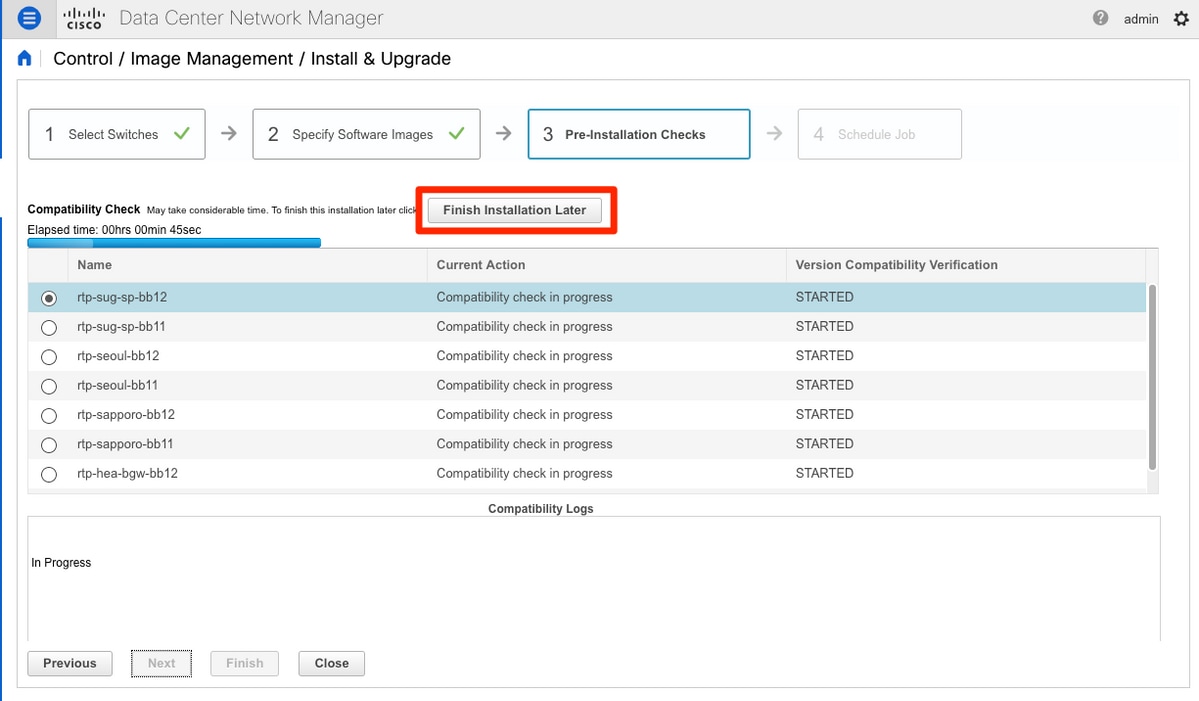

Schritt 6: Klicken Sie auf Weiter, und DCNM führt die Switches durch Prüfungen vor der Installation aus. Dieses Fenster kann einige Zeit in Anspruch nehmen. Sie können also Installation später beenden auswählen und das Upgrade ansetzen, während Sie nicht da sind.

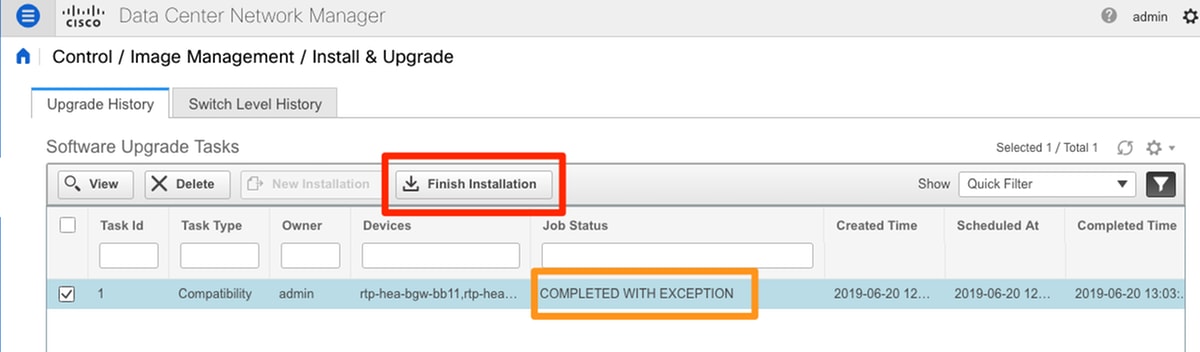

Diese Warteschlange führt die Aufgabe in eine Warteschlange ein und sieht ähnlich aus wie im Bild hier nach Abschluss.

Hinweis: Die Ausnahme im obigen Fall war, dass einer der RTP-Switches nicht über genügend Platz für das NX-OS-Image verfügte.

Schritt 7: Wenn die Kompatibilität hergestellt ist, klicken Sie im gleichen Fenster auf Installation beenden, wie im Bild gezeigt.

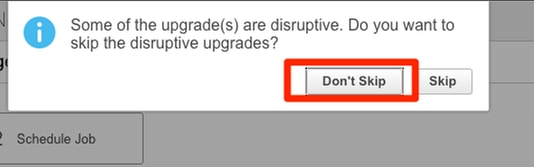

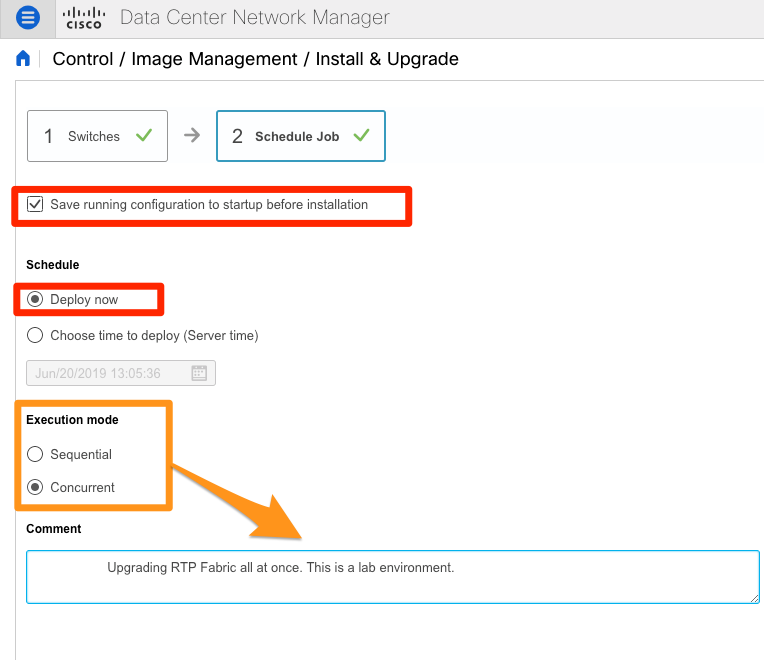

Schritt 8: Sie können die Upgrades auswählen, die gleichzeitig (alle gleichzeitig) oder nacheinander (jeweils einzeln) durchgeführt werden sollen. Da es sich um eine Laborumgebung handelt, wird eine gleichzeitige Auswahl ausgewählt.

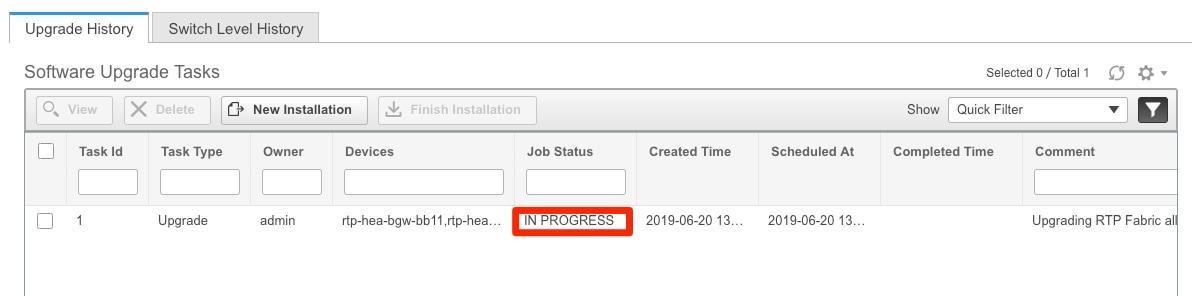

Die Aufgabe wird erstellt und IN FORTSCHRITT angezeigt, wie im Bild gezeigt.

Hier wird eine alternative Möglichkeit zur Auswahl des Bildes angezeigt.

Installation des Endpunkt-Locators

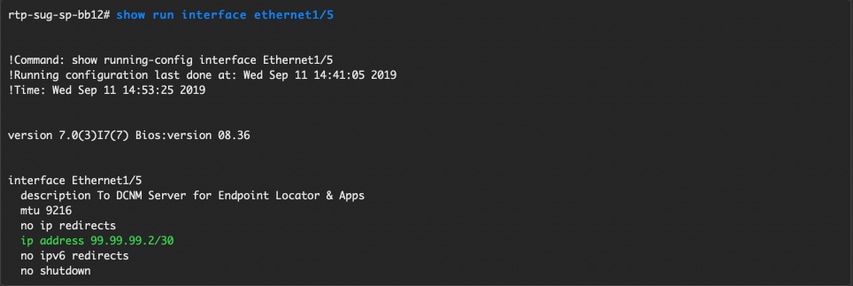

Damit DCNM-Apps ordnungsgemäß funktionieren, müssen Sie über eine In-Band-Verbindung zwischen dem DCNM-Server und einem Port an der Vorderseite mit einem der Nexus 9000 in der Fabric verfügen. In diesem Beispiel ist der DCNM-Server mit Ethernet1/5 einer der Spines in der RTP-Fabric verbunden.

Schritt 1: Diese CLI wird dem Nexus 9000 manuell hinzugefügt:

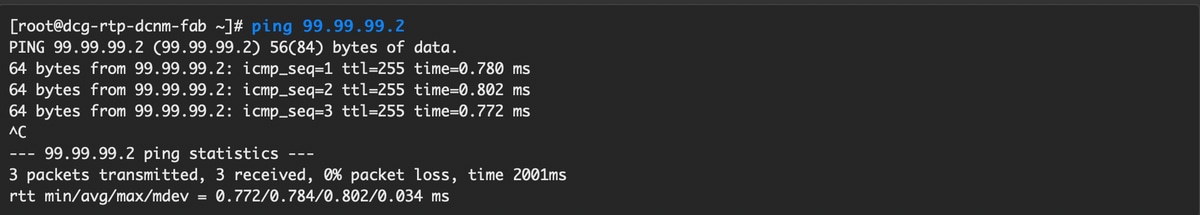

Schritt 2: Stellen Sie sicher, dass Sie für diese Punkt-zu-Punkt-Verbindung einen Ping an den DCNM-Server und umgekehrt senden können.

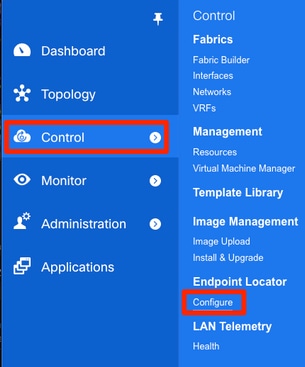

Schritt 3: Navigieren Sie zu DCNM GUI > Control > Endpoint Locator > Configure (DCNM-GUI > Steuerung > Endpunkt-Locator > Konfigurieren, wie im Bild gezeigt.

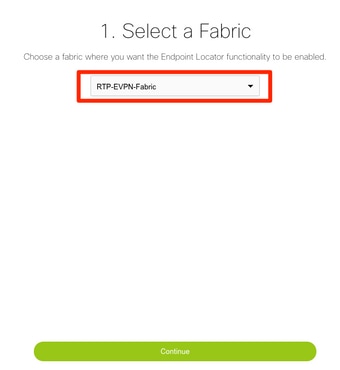

Schritt 4: Wählen Sie die Fabric aus, die am Endpunkt-Locator aktiviert werden soll, wie im Bild gezeigt.

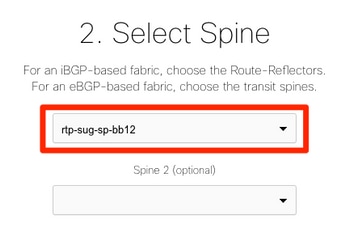

Schritt 5: Wählen Sie, wie im Bild gezeigt, einen Spine aus.

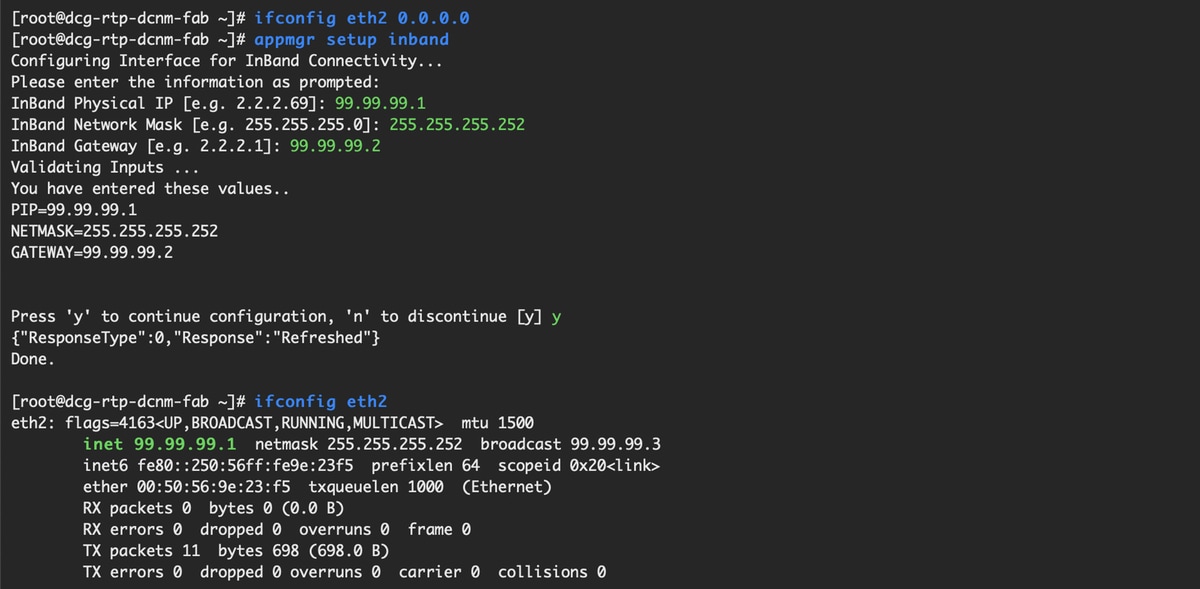

Schritt 6: (Optional) Bevor mit dem nächsten Schritt fortgefahren wird, wurde die IP-Adresse von eth2 von der ursprünglichen Bereitstellung über diese CLI auf dem DCNM-Server geändert (dieser Schritt ist nicht erforderlich, wenn die während der Neuinstallation des DCNM-Servers konfigurierte ursprüngliche IP korrekt bleibt):

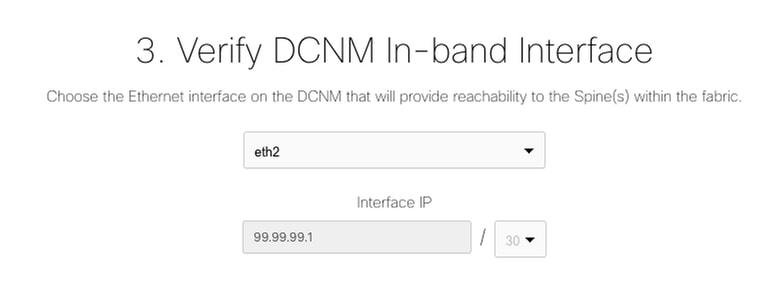

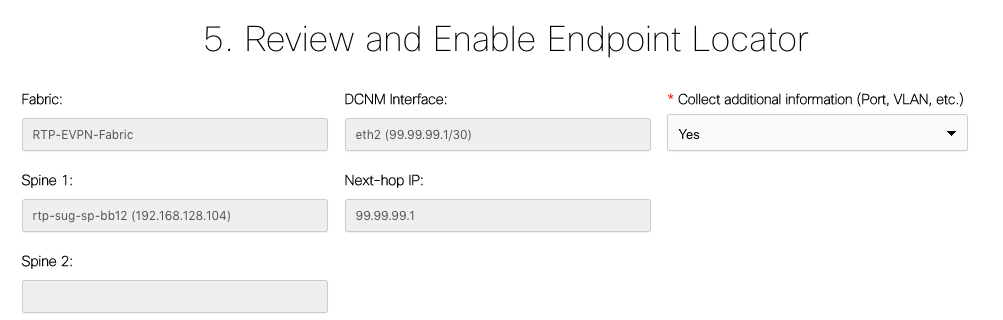

Schritt 7: Überprüfen der In-Band-Schnittstellenkonfiguration Dies sollte mit der Konfiguration im vorherigen Schritt übereinstimmen.

Schritt 8: Wenn Sie die Konfiguration überprüft haben, klicken Sie auf Konfigurieren. Dieser Schritt kann einige Minuten dauern:

Nach Abschluss dieses Vorgangs wird die Benachrichtigung angezeigt, wie im Bild gezeigt.

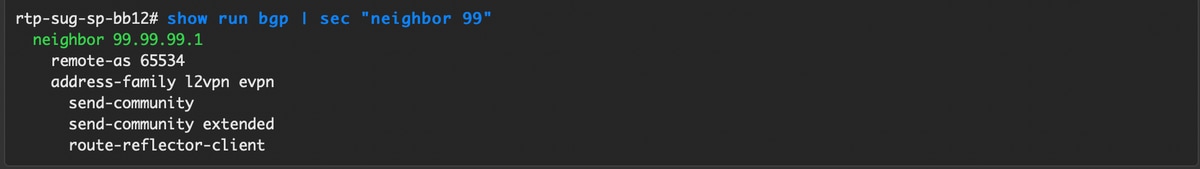

Notice DCNM hat einen BGP-Nachbarn auf der ausgewählten Spine der L2VPN EVPN-Familie konfiguriert.

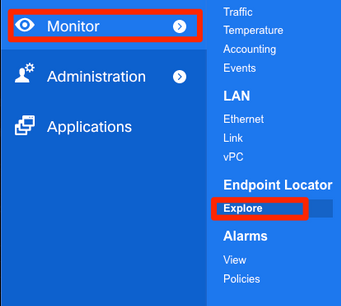

Schritt 9: Sie können jetzt Endpoint Locator verwenden. Navigieren Sie zu Monitor > Endpoint Locator > Explore.

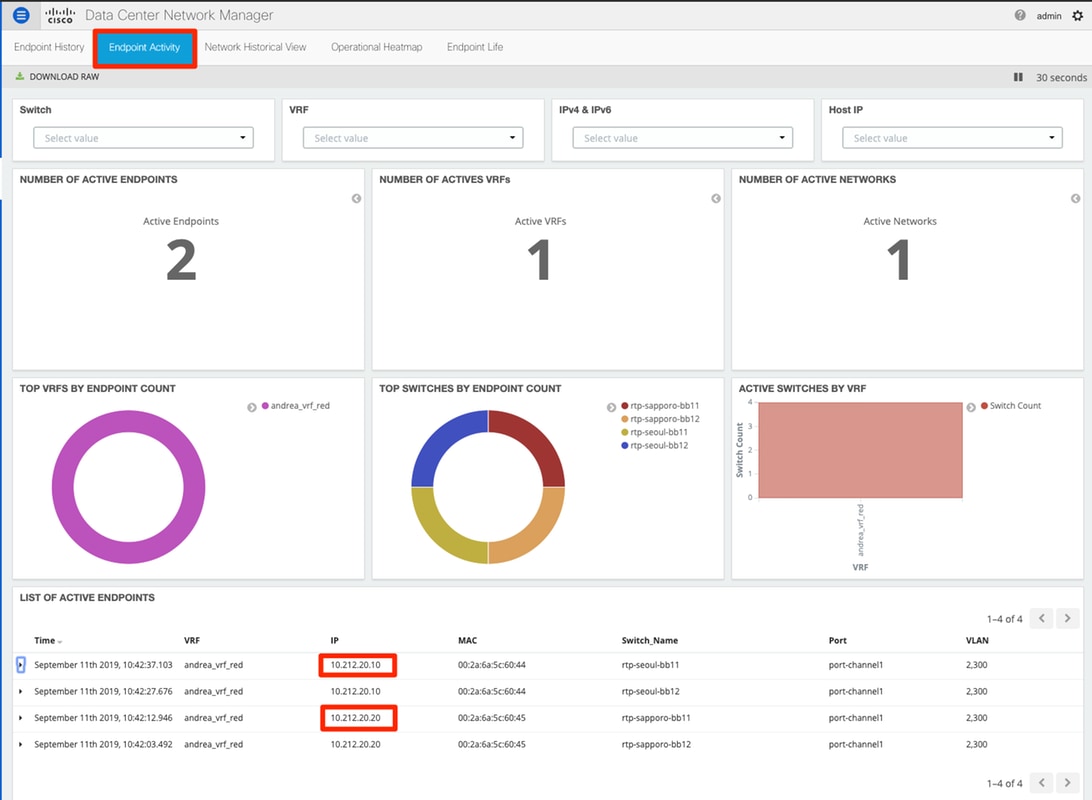

In diesem Beispiel sehen Sie die beiden Hosts, die für die lokalen Ping-Tests in der RTP-Fabric konfiguriert wurden:

Probleme bei dieser Bereitstellung

Schlechte Verkabelung

Ein Switch-Paar hatte eine fehlerhafte Verkabelung, die einen Paketfehler für den vPC Peer-Link Port-Channel 500 verursacht hat. Beispiel:

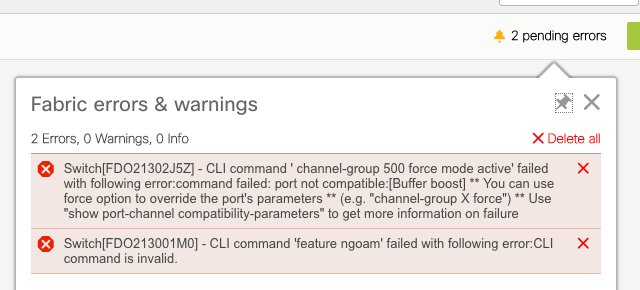

Schritt 1: Navigieren Sie zurück zu Control > Fabric Builder, und überprüfen Sie die Fehler:

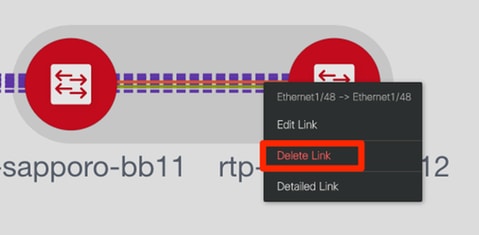

Schritt 2: Für den ersten Fehler bezüglich des Befehls "port-channel500": Über show cdp neighbors wurde überprüft, dass sich die Verbindung zum vPC-Peer auf einem 10G- und einem 40G-Port befindet (nicht kompatibel). 10G-Port physisch entfernt und Link aus DCNM gelöscht:

Funktion konnte nicht konfiguriert werden.

Für den zweiten Fehler bezüglich "feature ngoam" failure to configure — Der Switch wurde auf eine neuere NX-OS-Version aktualisiert, bei der "feature ngoam" unterstützt wird, und klicken Sie erneut auf Save & Deploy. Beide Fragen wurden gelöst.

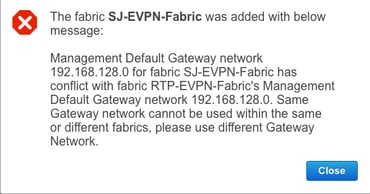

Überlappung der Management-Subnetze für verschiedene Fabrics

Bei der Bereitstellung der zweiten Fabric wurde SJ das gleiche Subnetz verwendet (wenn physisch getrennt, sollte dies in Ordnung sein). DCNM protokolliert jedoch einen Konflikt, und POAP schlägt fehl. Dies wird aufgelöst, da die SJ-Fabric in einem anderen Management-VLAN platziert wird und der Bereich der DHCP-Adressen geändert wird.

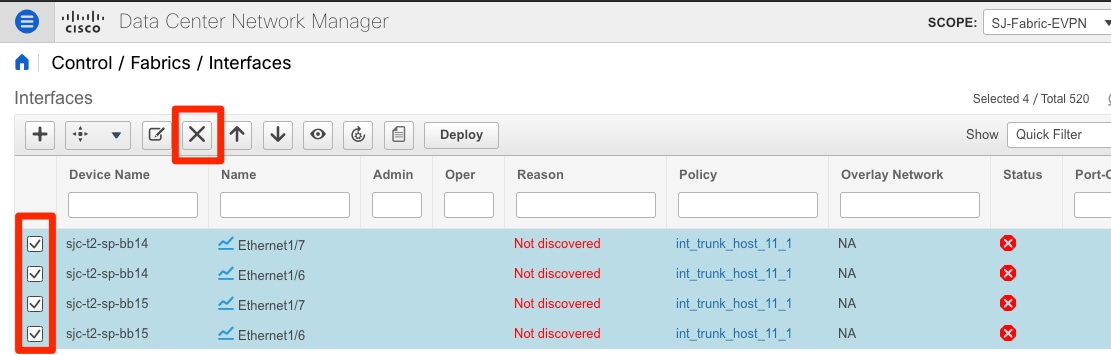

Breakout-Schnittstellen

Schritt 1: Für Breakout-Schnittstellen in einigen Switches (siehe Topologie) wurde diese CLI manuell für die T2-Spines hinzugefügt:

Schritt 2: Navigieren Sie zu Control > Interfaces, und löschen Sie die übergeordneten Schnittstellen:

Die tatsächlich verwendeten Schnittstellen sind Eth1/6/1-4 und Eth1/7/1-4. Wenn Sie dies nicht korrigieren, schlägt Save & Deploy später fehl. Sie können das Breakout auch über DCNM selbst durchführen (Schaltfläche neben dem +-Zeichen; jedoch nicht in diesem Artikel erfasst)

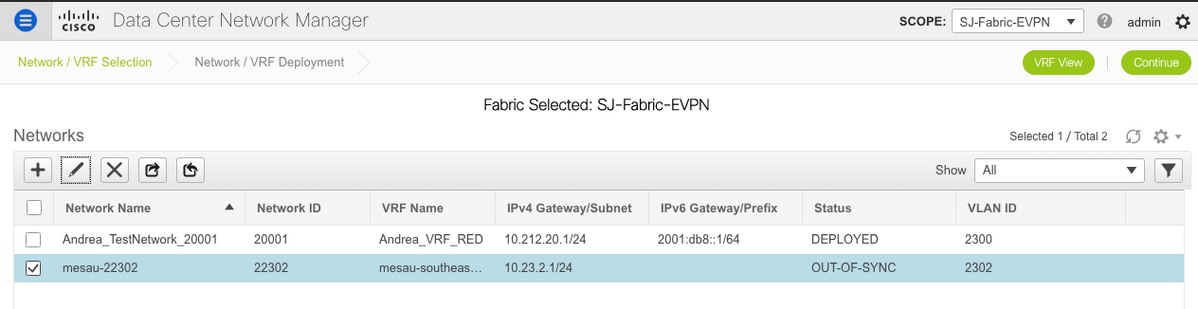

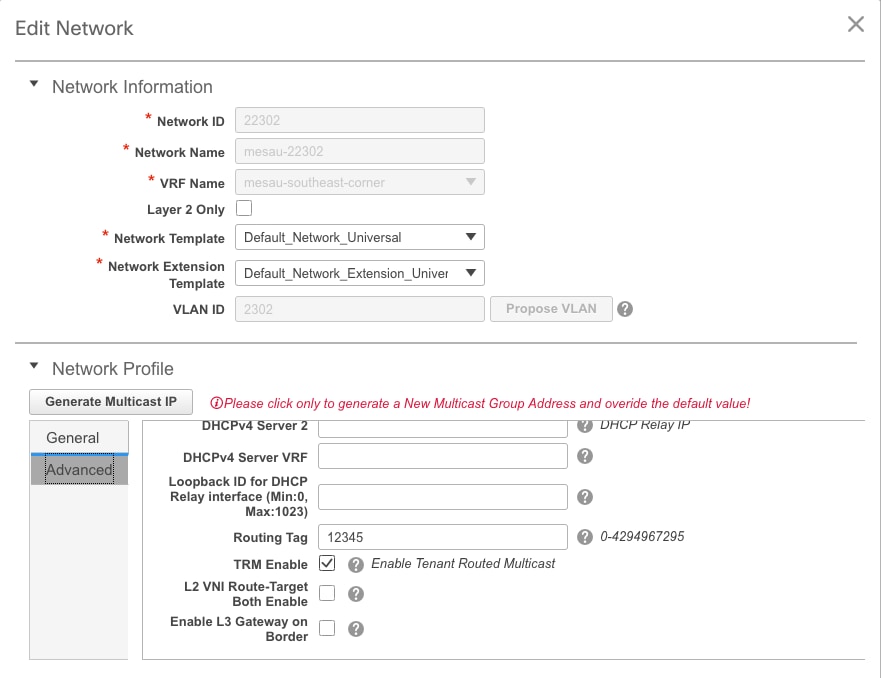

Fabric-Fehler bei Bereitstellung mit nicht unterstützten Funktionen

Einige Chassis (T2s) in SJ Fabric unterstützen TRM nicht. Als DCNM also versuchte, diese Konfiguration voranzutreiben, war es nicht möglich. TRM-Unterstützung hier: https://www.cisco.com/c/en/us/td/docs/switches/datacenter/nexus9000/sw/92x/vxlan-92x/configuration/guide/b-cisco-nexus-9000-series-nx-os-vxlan-configuration-guide-92x/b_Cisco_Nexus_9000_Series_NX-OS_VXLAN_Configuration_Guide_9x_chapter_01001.html#concept_vw1_syb_zfb

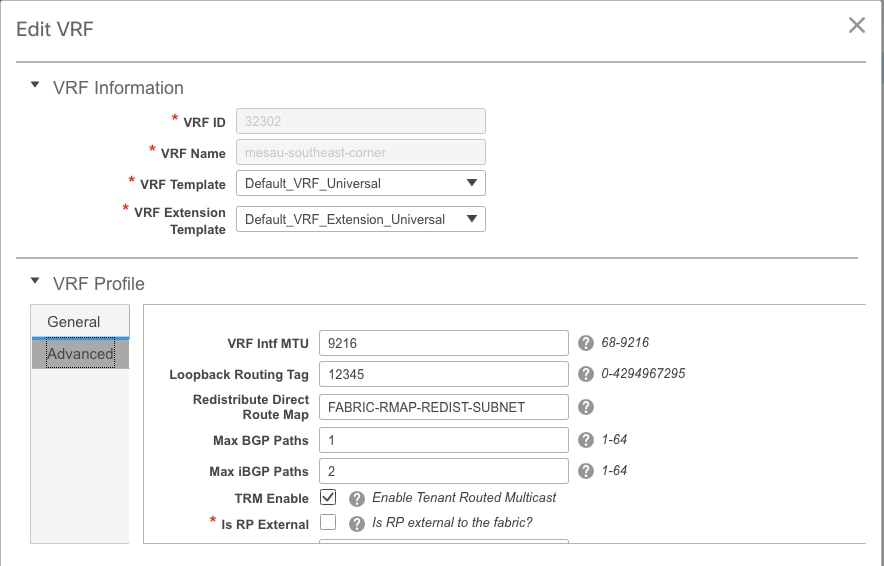

Im Bild wird das Kästchen TRM Enable (TRM-Aktivierung aktivieren) in den Fenstern Network (Netzwerk) und VRF Edit (VRF-Bearbeitung) angezeigt.

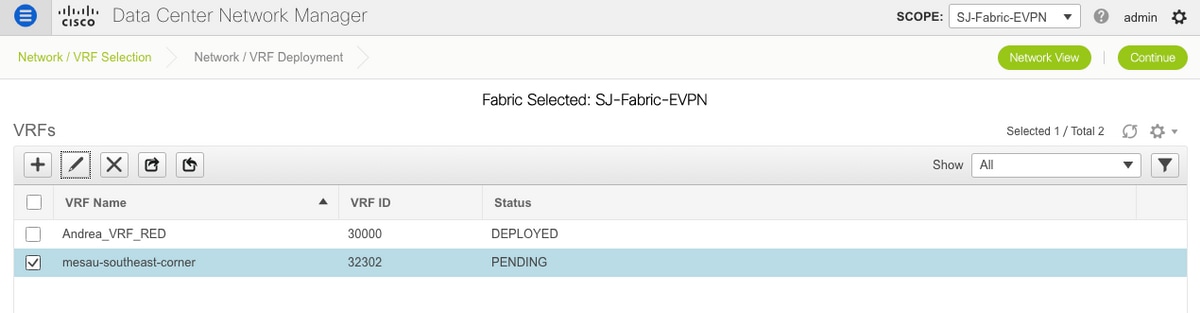

Wiederholen Sie den gleichen Vorgang unter Control > Fabric Builder > VRF.

Klicken Sie auf Weiter und dann wie zuvor auf Bereitstellen.

Neue Funktionen in DCNM 11.2

-

vPC-Fabric-Peering

-

eBGP-basierte Routed Fabrics

-

EVPN oben aktivieren

-

-

Einfache Erweiterung von Fabric Brownfield

-

Grenz-Spine/Grenz-GW-Spine

-

PIM-Bidir

-

Tenant-geroutetes Multicast

-

-

Day-0/Bootstrap mit externem DHCP-Server

Betrieb an Tag 2:

-

Ressourcen für Netzwerkeinblicke

-

Network Insights Advisor

-

IPv6-Unterstützung für externen Zugriff (eth0)

-

VMM Compute-Transparenz mit UCS-FI

-

Erweiterungen der Topologieansicht

-

Inline-Upgrade von 11.0/11.1

Wechsel von herkömmlichem vPC zu MCT-Less vPC mit DCNM:

Vorteile von MCT-less vPC:

-

Erweiterte Dual-Homing-Lösung ohne Verschwendung physischer Ports

-

Bewahrt herkömmliche vPC-Merkmale

-

Optimiertes Routing für Single-Homed-Endgeräte mit PIP

Zugehörige Informationen

- Cisco DCNM LAN Fabric Configuration Guide, Release 11.2(1)

https://www.cisco.com/c/en/us/td/docs/switches/datacenter/sw/11_2_1/config_guide/lanfabric/b_dcnm_fabric_lan/control.html - Kapitel: Anwendungsfall für die Grenzbereitstellung in VXLAN BGP-EVPN-Fabrics - mehrere Standorte

https://www.cisco.com/c/en/us/td/docs/switches/datacenter/sw/11_2_1/config_guide/lanfabric/b_dcnm_fabric_lan/border-provisioning-multisite.html - NextGen DCI mit VXLAN EVPN Multi-Site unter Verwendung von vPC Border Gateways Whitepaper

https://www.cisco.com/c/en/us/products/collateral/switches/nexus-9000-series-switches/whitepaper-c11-742114.html#_Toc5275096 - Kapitel: DCNM-Anwendungen

https://www.cisco.com/c/en/us/td/docs/switches/datacenter/sw/11_2_1/config_guide/lanfabric/b_dcnm_fabric_lan/applications.html

Beiträge von Cisco Ingenieuren

- Andrea TestinoCisco Engineering

Cisco kontaktieren

- Eine Supportanfrage öffnen

- (Erfordert einen Cisco Servicevertrag)

Feedback

Feedback