Einleitung

In diesem Dokument werden die Optionen zur Feinabstimmung der VNIC-Adapter im Intersight Managed Mode (IMM) mithilfe der Serverprofile beschrieben.

Voraussetzungen

Vom Betriebssystem empfohlene Einstellungen für Ethernet-Adapter:

Betriebsbereite Computing-, Storage- und Management-Richtlinien müssen zuvor konfiguriert werden.

Anforderungen

Cisco empfiehlt, dass Sie über Kenntnisse in folgenden Bereichen verfügen:

- Intersight-Managed-Modus

- Physische Netzwerkverbindungen

- Vom Betriebssystem empfohlene Ethernet-Adaptereinstellungen

- VNIC-Feinabstimmungselemente

Verwendete Komponenten

Die Informationen in diesem Dokument basierend auf folgenden Software- und Hardware-Versionen:

- UCS-B200-M5 Firmware 4.2(1a)

- Cisco UCS 6454 Fabric Interconnect, Firmware 4.2(1e)

- Intersight Software-as-a-Service (SaaS)

Die Informationen in diesem Dokument beziehen sich auf Geräte in einer speziell eingerichteten Testumgebung. Alle Geräte, die in diesem Dokument benutzt wurden, begannen mit einer gelöschten (Nichterfüllungs) Konfiguration. Wenn Ihr Netzwerk in Betrieb ist, stellen Sie sicher, dass Sie die möglichen Auswirkungen aller Befehle verstehen.

Konfigurieren

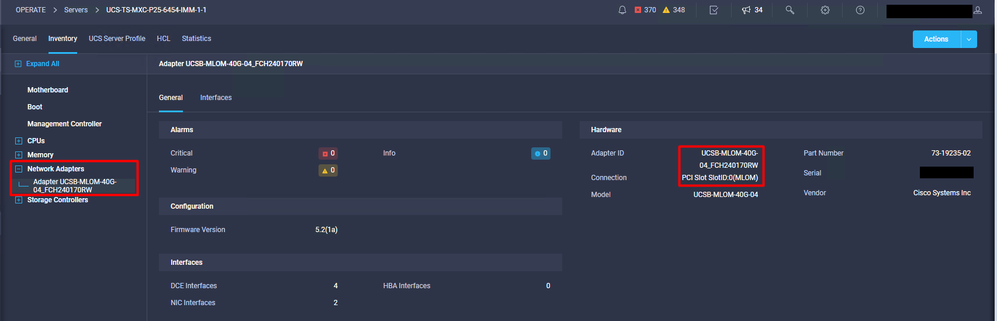

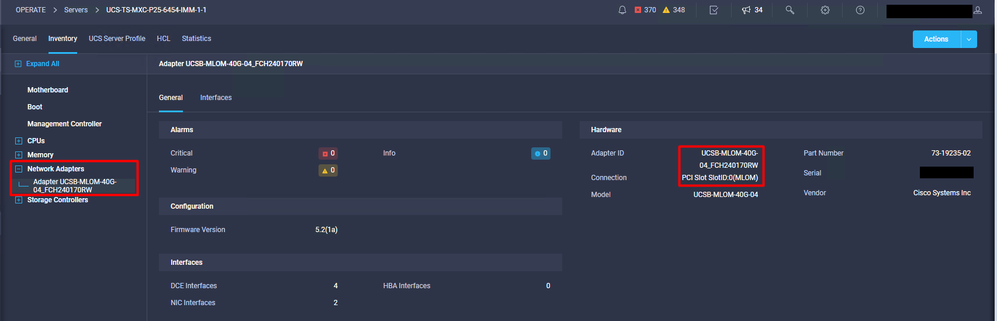

Schritt 1: Identifizieren der VIC-Adapter- und Steckplatz-ID auf dem Server

Navigieren Sie zur Registerkarte Server > Inventory > Select the Network Adapters option.

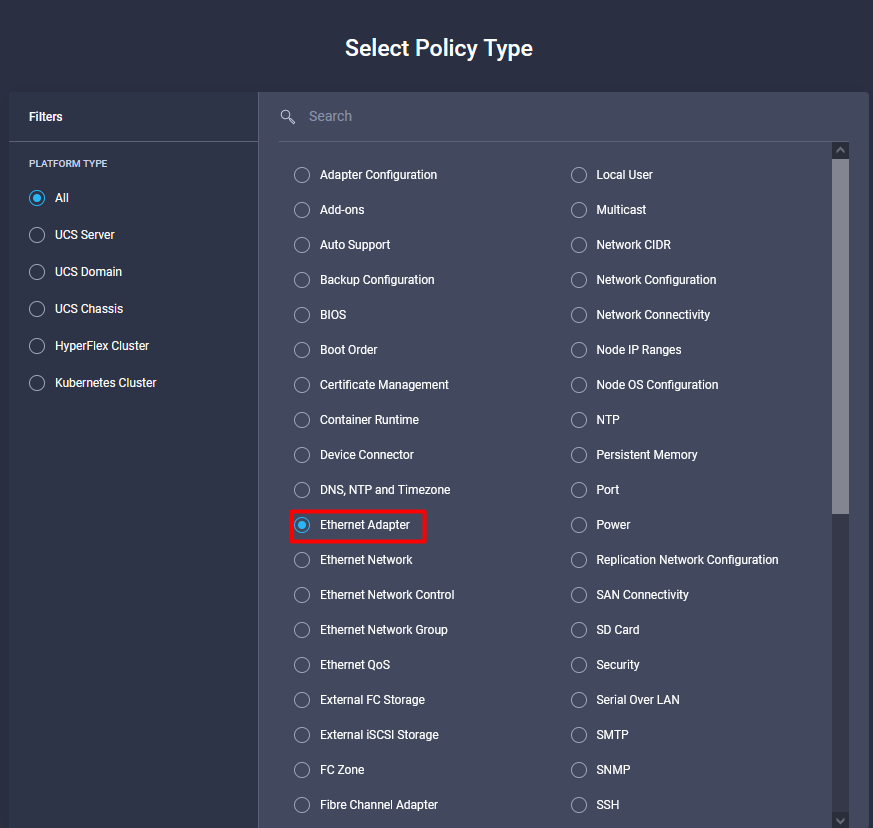

Schritt 2: Ethernet-Adapterrichtlinie erstellen

Erstellen Sie die Ethernet-Adapter-Richtlinie mit den vom Betriebssystemanbieter empfohlenen Werten.

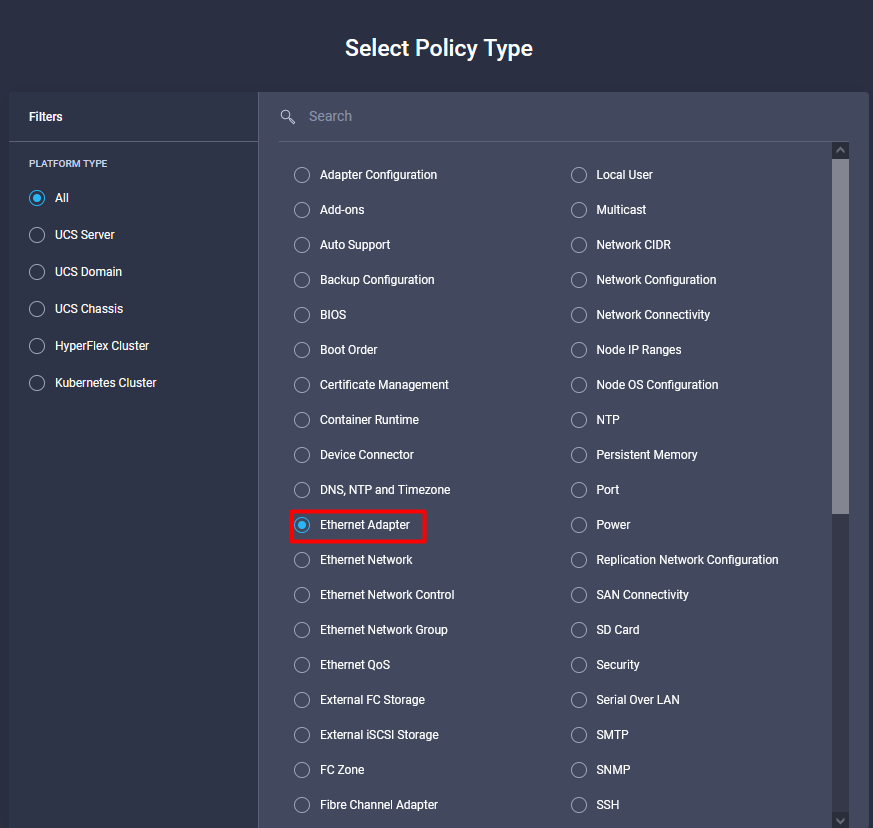

Navigieren Sie zur Registerkarte Policies (Richtlinien) > Create Policy (Richtlinie erstellen) > Select Ethernet Adapter (Ethernet-Adapter auswählen).

Wählen Sie im Menü Create Policy (Richtlinie erstellen) die Organisation aus, und geben Sie den Richtliniennamen an.

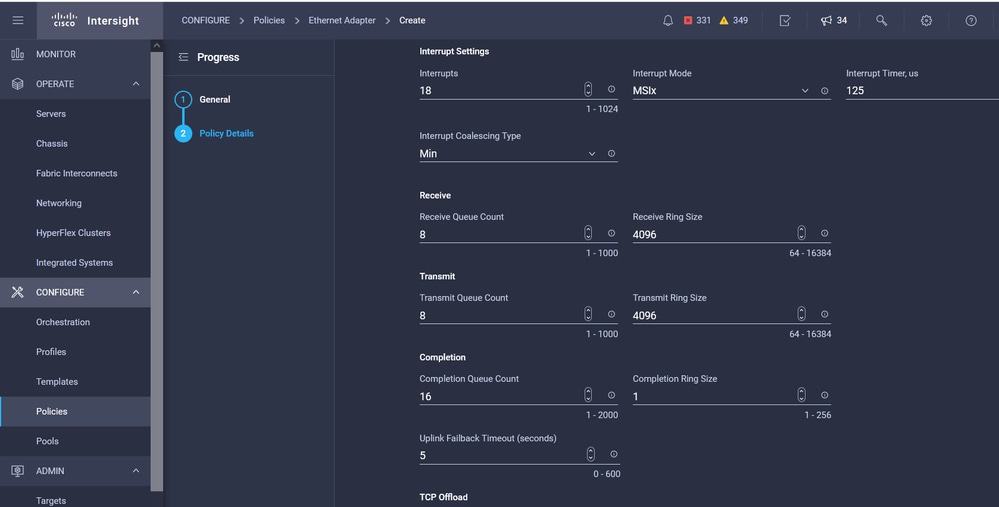

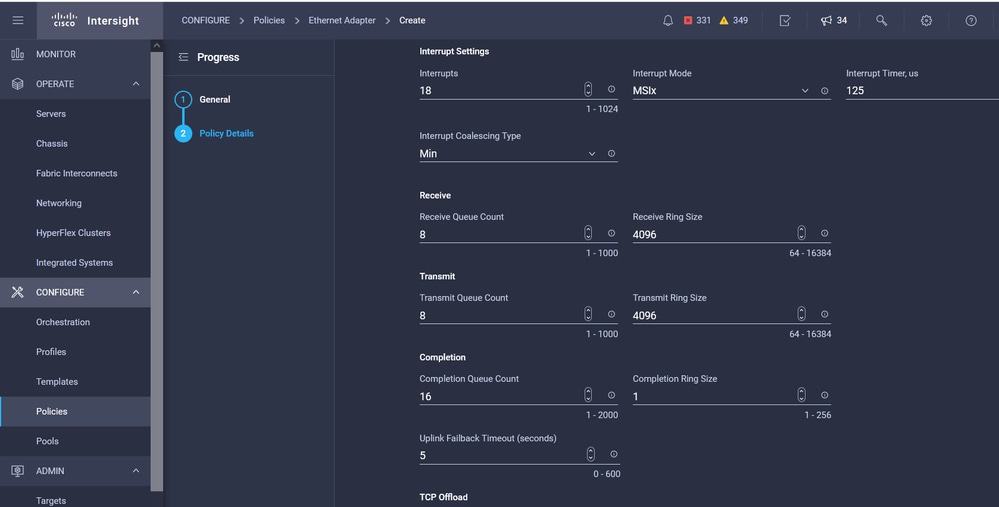

Schritt 3: Konfigurieren Sie die vom Betriebssystemlieferanten empfohlenen Einstellungen. In der Regel werden die aufgeführten Funktionen in der Ethernet-Adapter-Richtlinie konfiguriert:

- Empfangswarteschlangen

- Übertragungswarteschlangen

- Klingeltongröße

- Beendigungswarteschlangen

- Unterbrechungen

- RSS (Receive Side Scaling) oder ARFS (Accelerated Receive Flow Steering) aktivieren

Anmerkung: RSS und ARFS schließen sich gegenseitig aus, also konfigurieren Sie nur einen. Konfigurieren Sie nicht beide.

Weisen Sie nach dem Erstellen die Ethernet-Adapterrichtlinie einer LAN-Verbindungsrichtlinie zu.

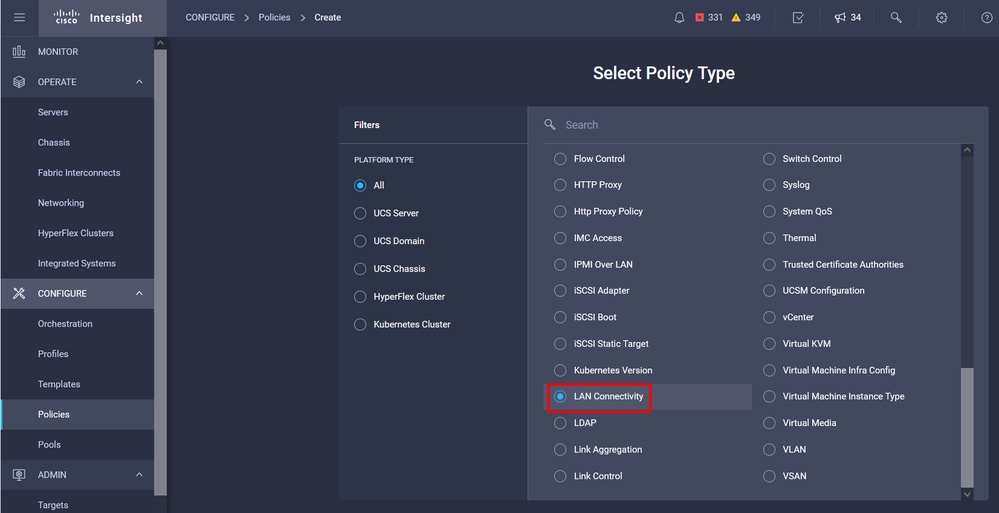

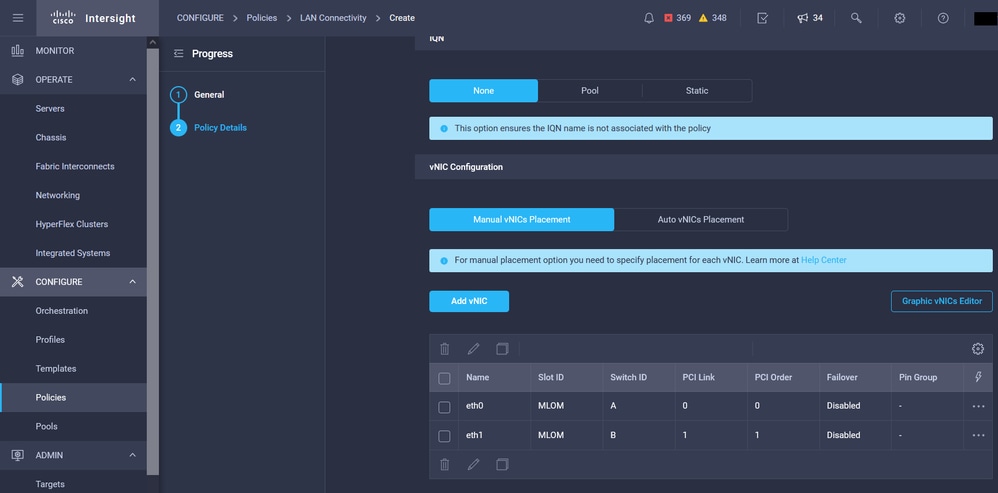

Schritt 4: Erstellen einer LAN-Verbindungsrichtlinie

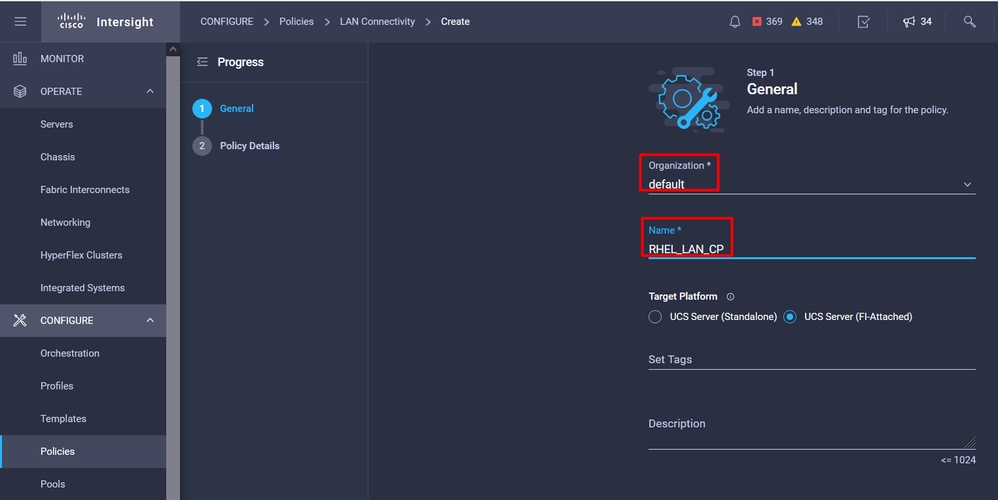

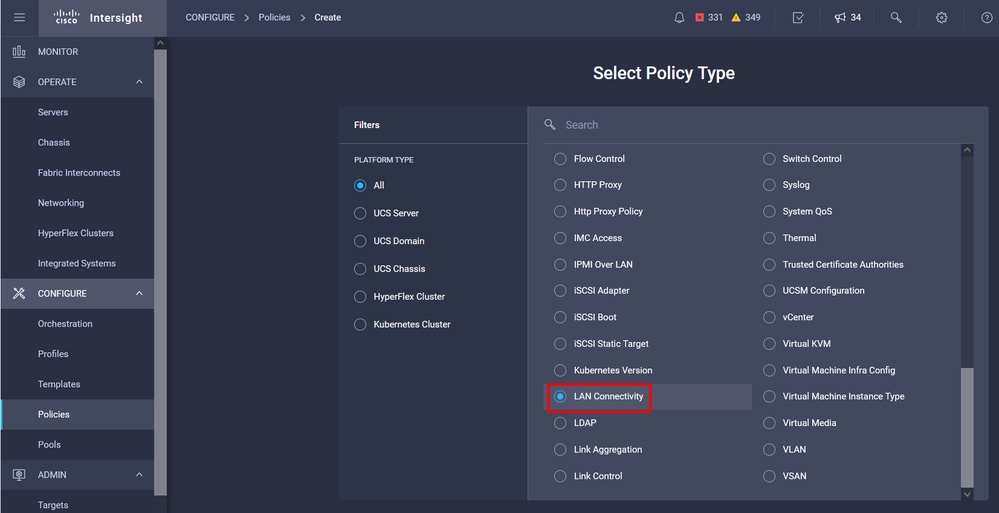

Navigieren Sie zur Registerkarte Policies (Richtlinien) > Create Policy (Richtlinie erstellen) > LAN Connectivity (LAN-Verbindung).

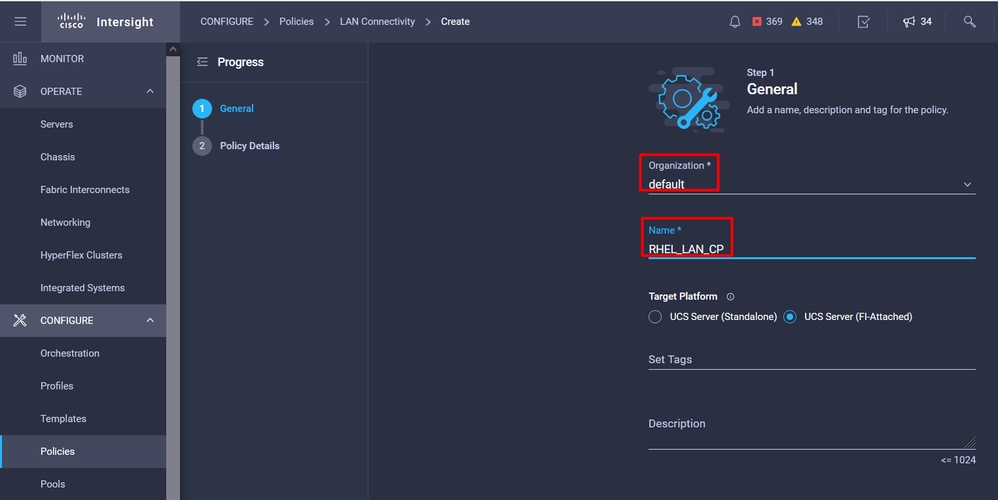

Wählen Sie die Organisation aus, und geben Sie den Richtliniennamen an.

Unter Ziel wählt die Plattform UCS Server (FI-Attached) aus.

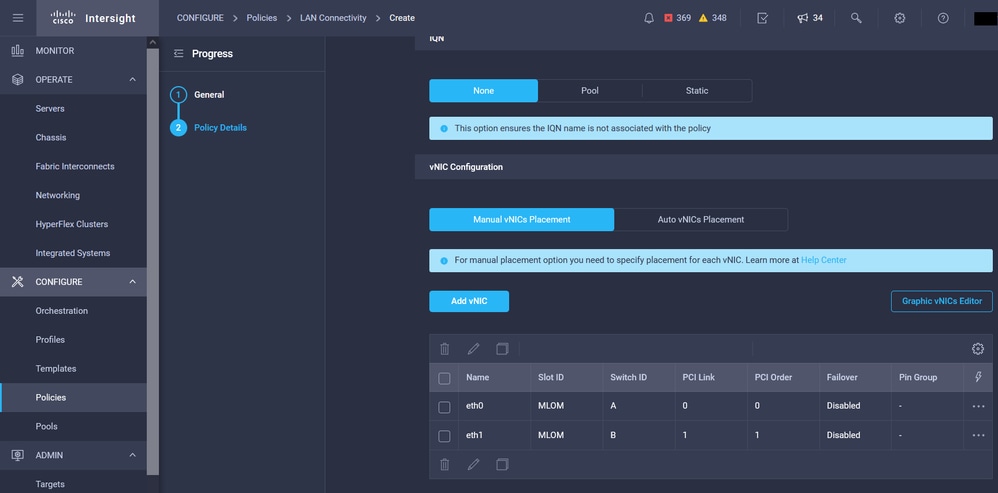

Navigieren Sie innerhalb der LAN-Verbindungsrichtlinie zum Abschnitt vNIC-Konfiguration, und konfigurieren Sie mindestens zwei Netzwerkschnittstellen. In diesem Beispiel werden eth0- und eth1-Schnittstellen erstellt.

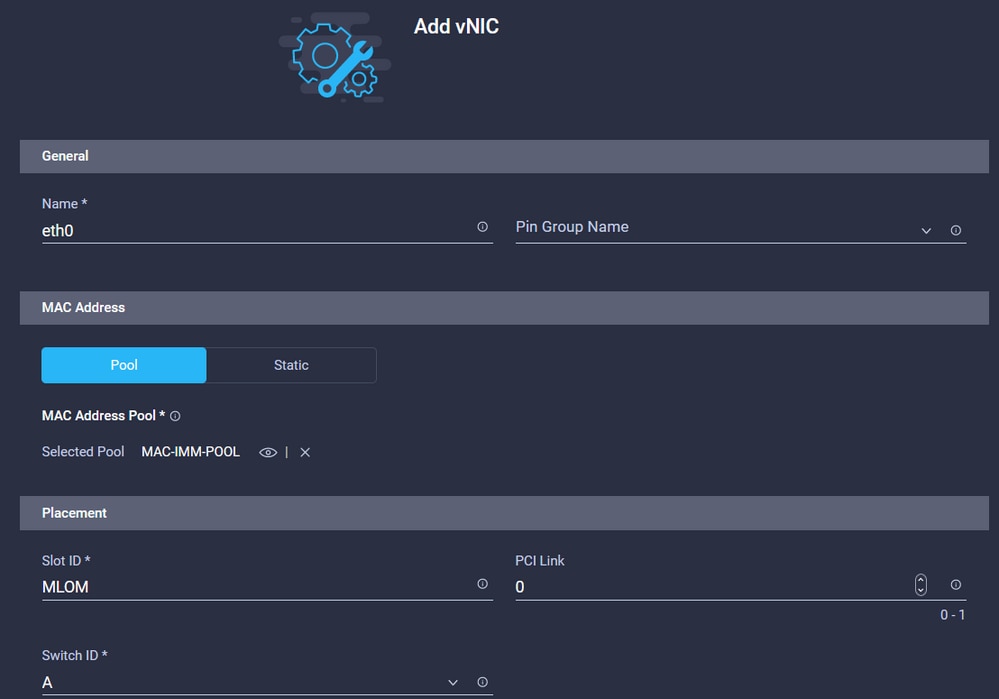

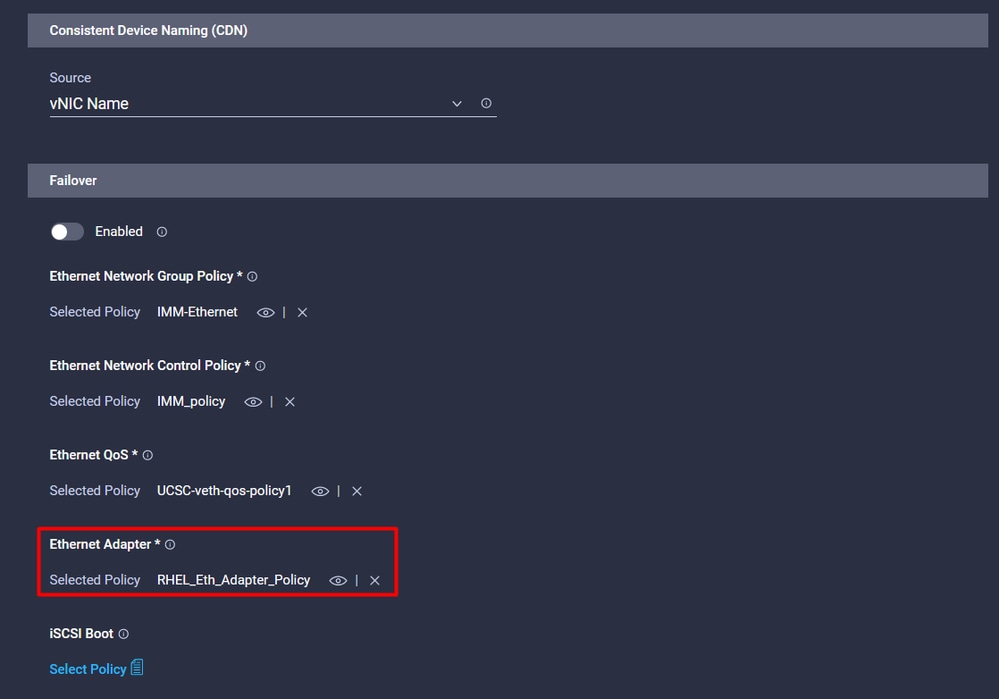

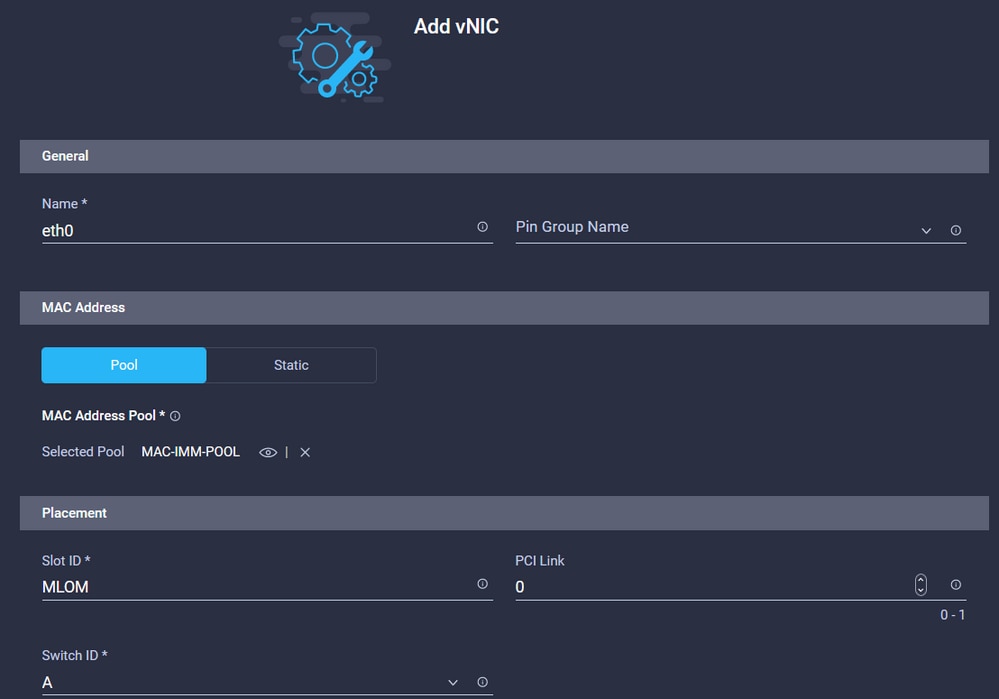

Geben Sie auf der Registerkarte Add vNIC configuration unter General (Allgemein) den Namen eth0 ein.

Wählen Sie im Abschnitt "MAC Address" (MAC-Adresse) den entsprechenden MAC Address Pool aus.

Konfigurieren Sie im Abschnitt "Placement" (Anordnung) die Steckplatz-ID als MLOM.

Belassen Sie die Optionen PCI Link und PCI Order mit dem Wert 0 und der Switch-ID mit der Option A unverändert.

Navigieren Sie zum Menü Consistent Device Naming (CDN), und wählen Sie VNIC Name aus.

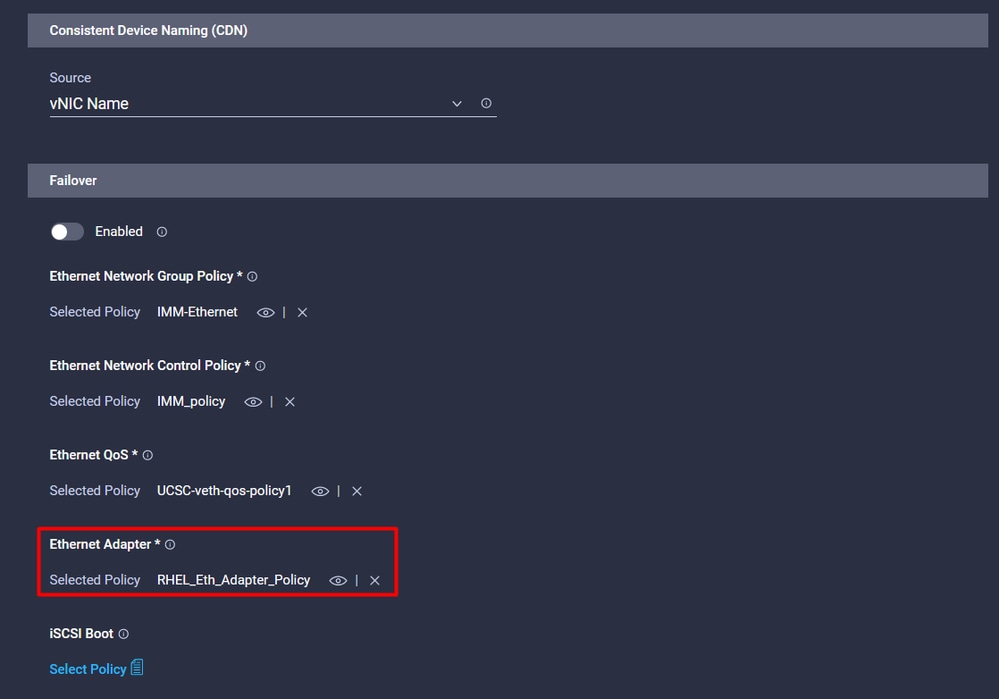

Fügen Sie die Ethernet-Netzwerkgruppenrichtlinie, die Ethernet-Netzwerksteuerungsrichtlinie, die Ethernet-QoS- und die Ethernet-Adapter-Richtlinien hinzu.FAQ:

Wiederholen Sie die gleichen Schritte, um die Schnittstelle eth1 zu erstellen, konfigurieren Sie die Werte für PCI Link, PCI Order und Switch ID entsprechend.

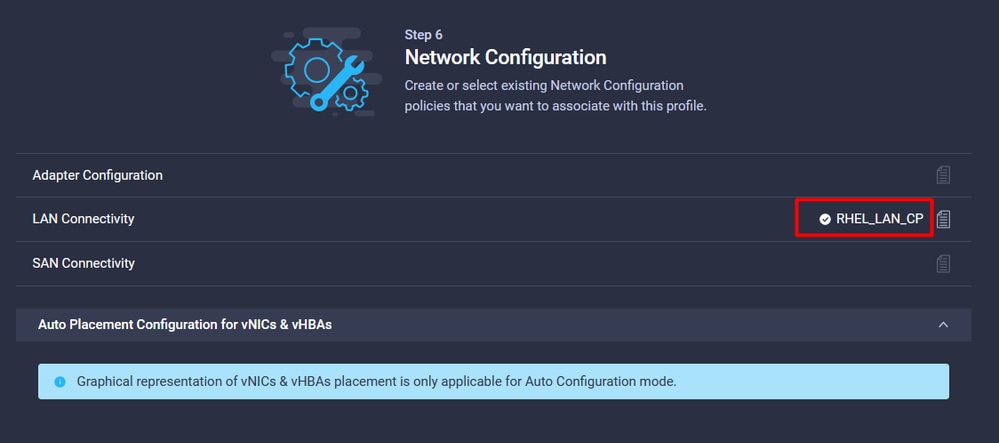

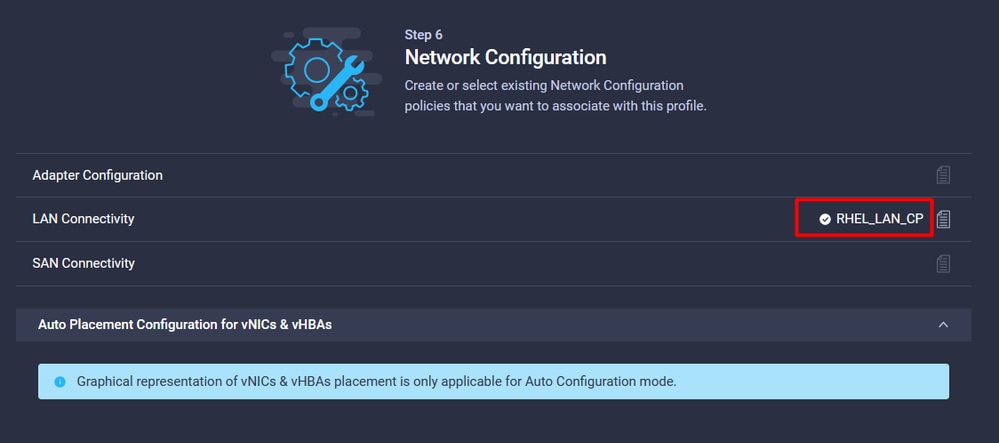

Erstellen Sie abschließend die LAN-Verbindungsrichtlinie. Weisen Sie sie anschließend einem UCS-Serverprofil zu.

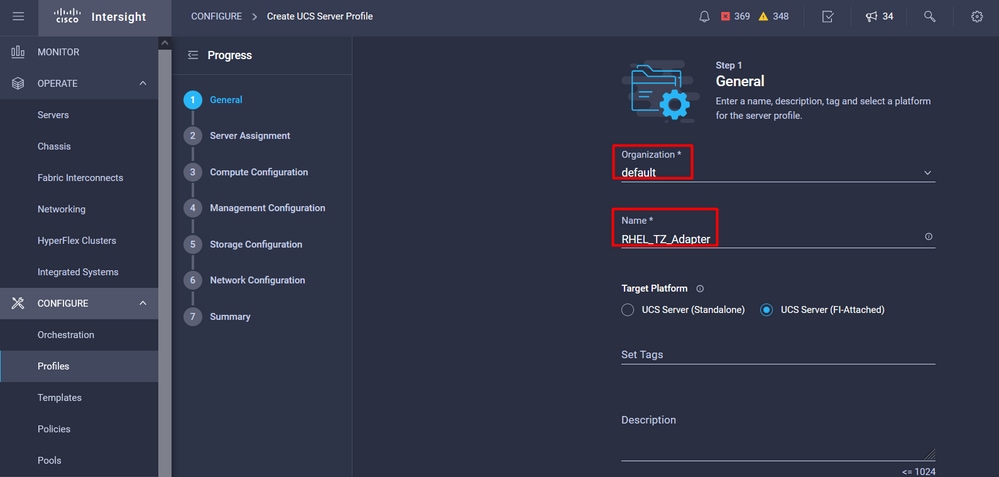

Schritt 5: Erstellen eines Serverprofils

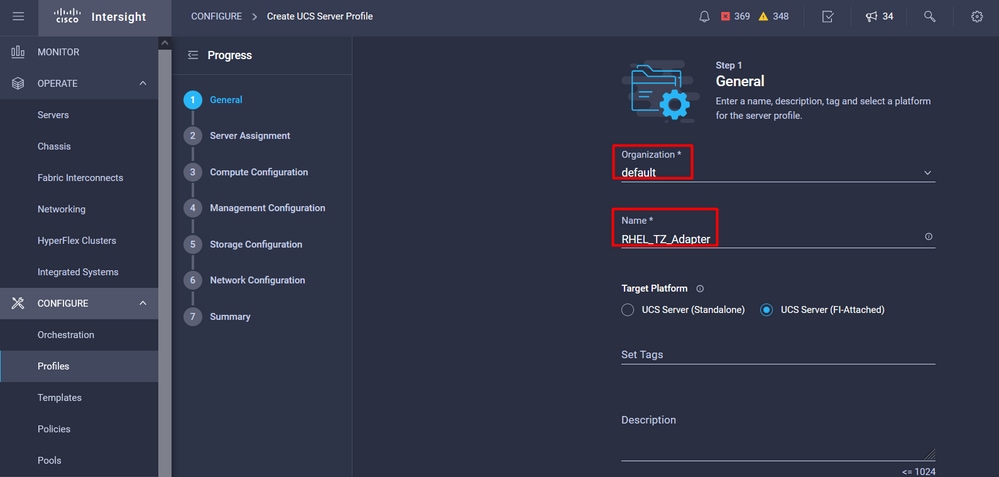

Navigieren Sie zur Registerkarte Profile, und wählen Sie Create UCS Server Profile (UCS-Serverprofil erstellen).

Geben Sie Details zur Organisation und zum Namen an.

Wählen Sie alle zugehörigen Konfigurationen aus, z. B. Computing-, Management- und Storage-Einstellungen.

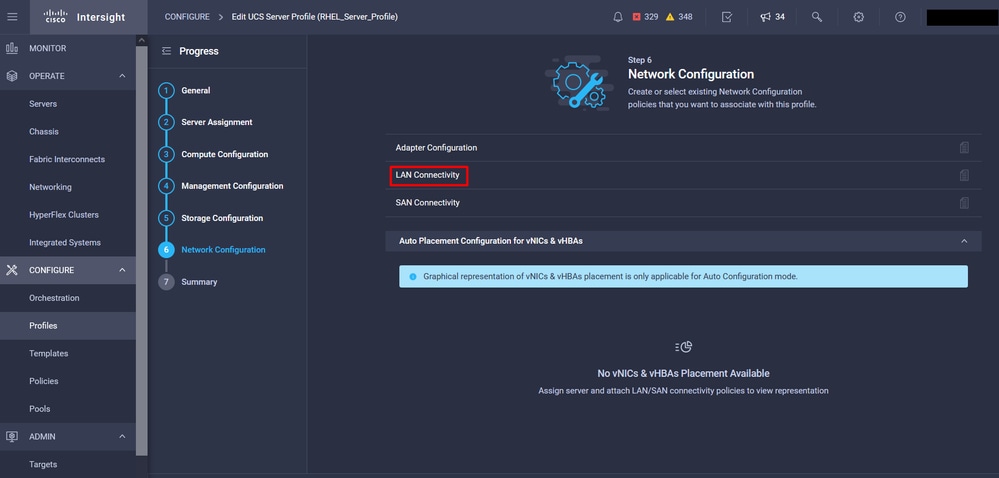

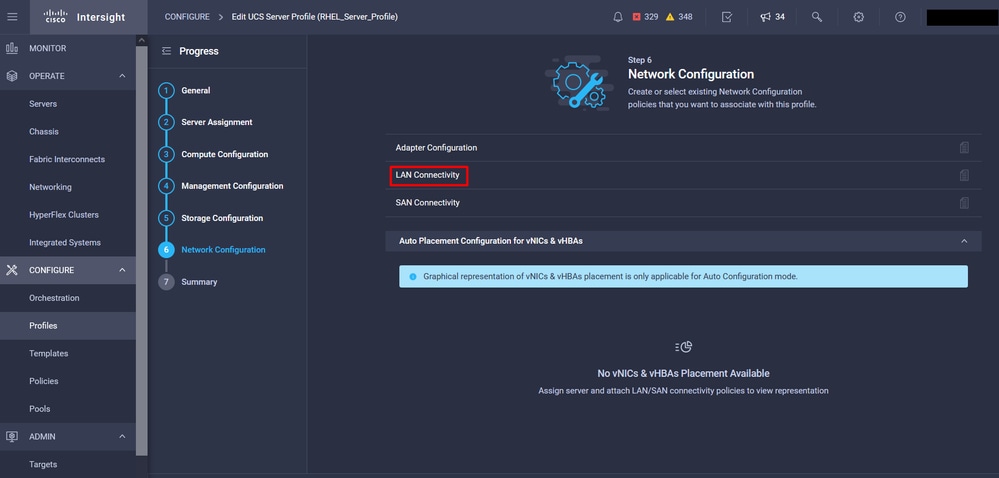

Wählen Sie unter "Network Configuration" (Netzwerkkonfiguration) die entsprechende Richtlinie für LAN-Verbindungen aus.

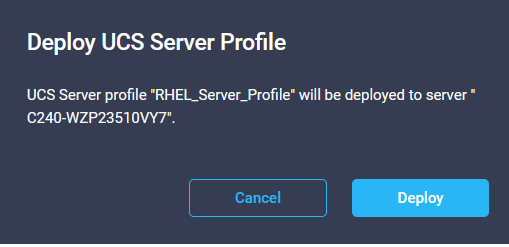

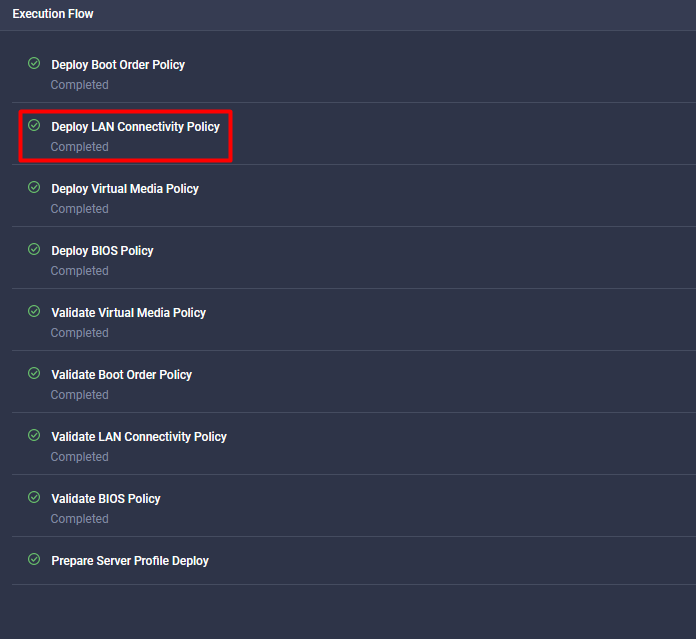

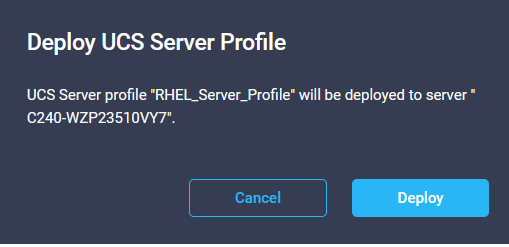

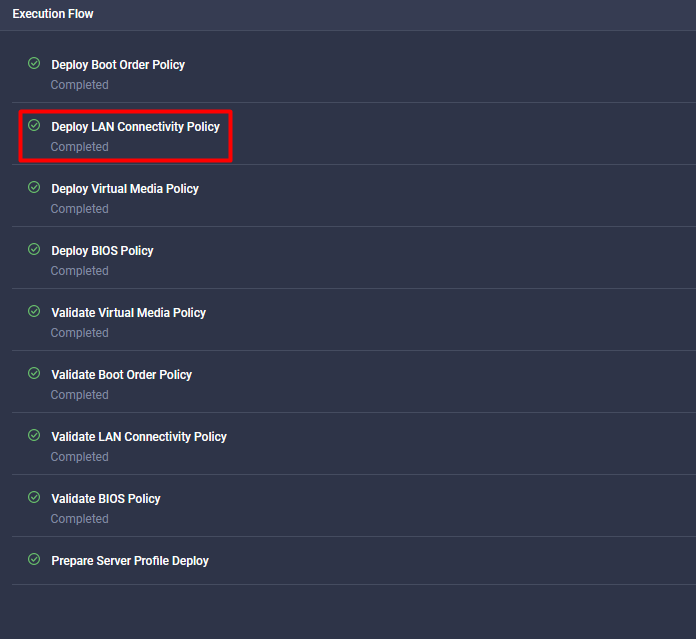

Wählen Sie Bereitstellen, um das Serverprofil zu konfigurieren und zu überprüfen, ob alle Schritte erfolgreich abgeschlossen wurden.

Überprüfung

Nutzen Sie diesen Abschnitt, um zu überprüfen, ob Ihre Konfiguration ordnungsgemäß funktioniert.

Überprüfen Sie die Adaptereinstellungen auf RHEL.

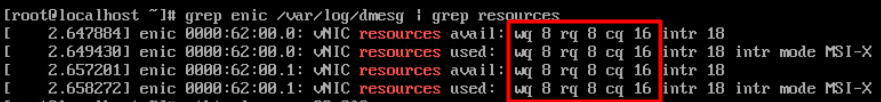

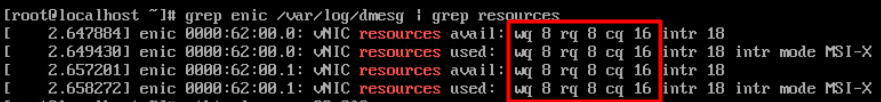

Um die aktuell verfügbaren Ressourcen zu überprüfen, die vom VIC-Adapter bereitgestellt werden, validieren Sie die Übertragungs- und Empfangswarteschlangen in der dmesg-Datei:

$ grep enic /var/log/dmesg | grep resources

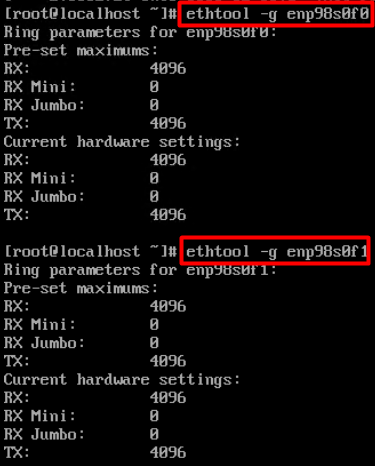

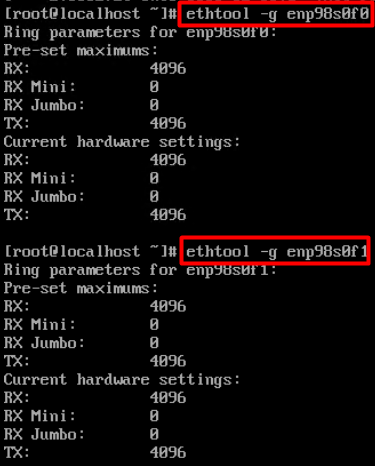

Validieren Sie die konfigurierte Klingeltongröße.

ethtool -g interface_name

Überprüfen Sie die Adaptereinstellungen auf VMware ESXi.

Um die aktuell verfügbaren Ressourcen zu überprüfen, die vom VIC-Adapter bereitgestellt werden, validieren Sie die Übertragungs- und Empfangswarteschlangen mit dem folgenden Befehl, wobei X die vmnic-Nummer ist.

vsish -e get /net/pNics/vmnicX/txqueues/info

vsish -e get /net/pNics/vmnicX/rxqueues/info

Führen Sie diesen Befehl aus, um die Klingelgröße zu überprüfen:

esxcli network nic ring current get -n vmnicX

Validieren Sie die Adaptereinstellungen direkt auf dem UCS.

Um die Einstellungen zu validieren, stellen Sie über SSH eine Verbindung zu einem der Fabric Interconnects her.

Stellen Sie über den Befehl connect adapter x/y/z eine Verbindung zum Server-Adapter her, wobei x die Gehäusenummer, y die Steckplatznummer und z die Adapternummer ist.

Wenn Sie mit dem Adapter verbunden sind, geben Sie bei der zusätzlichen Anmeldung dbgsh ein.

Führen Sie den Befehl attachment-mcp aus.

Führen Sie als Nächstes den Befehl vnicl aus, um die verfügbaren vnics aufzulisten.

Suchen Sie nach den entsprechenden vnic-Namen eth0 und eth1 und validieren Sie die Einstellungen.

UCS-IMM-A# connect adapter 1/1/1

Entering character mode

Escape character is '^]'.

(none) login: dbgsh

adapter (top):1#

adapter (top):4# attach-mcp

adapter (mcp):1# vnicl

adapter (mcp):19# vnicl

================================

vnicid : 18

name : eth0

type : enet

state : UP

adminst : UP

flags : OPEN, INIT, LINKUP, NOTIFY_INIT, ENABLE, USING_DEVCMD2

ucsm name : eth0

spec_flags : MULTIFUNC, TRUNK

mq_spec_flags :

slot : 0

h:bdf : 0:03:00.0

vs.mac : 00:25:b5:01:00:46

mac : 00:25:b5:01:00:46

vifid : 801

vifcookie : 801

uif : 0

portchannel_bypass : 0x0

cos : 0

vlan : 0

rate_limit : unlimited

cur_rate : unlimited

stby_vifid : 0

stby_vifcookie : 0

stby_recovery_delay : 0

channel : 0

stdby_channel : 0

profile :

stdby_profile :

init_errno : 0

cdn : eth0

devspec_flags : TSO, LRO, RXCSUM, TXCSUM, RSS, RSSHASH_IPV4, RSSHASH_TCPIPV4, RSSHASH_IPV6, RSSHASH_TCPIPV6

lif : 18

vmode : STATIC

encap mode : NONE

host wq : [11-18] (n=8)

host rq : [2010-2017] (n=8) (h=0x080107da)

host cq : [2002-2017] (n=16)

host intr : [3008-3025] (n=18)

notify : pa=0x10384de000/40 intr=17

devcmd2 wq : [19] (n=1)

================================

vnicid : 19

name : eth1

type : enet

state : UP

adminst : UP

flags : OPEN, INIT, LINKUP, NOTIFY_INIT, ENABLE, USING_DEVCMD2

ucsm name : eth1

spec_flags : MULTIFUNC, TRUNK

mq_spec_flags :

slot : 0

h:bdf : 0:03:00.1

vs.mac : 00:25:b5:01:00:45

mac : 00:25:b5:01:00:45

vifid : 800

vifcookie : 800

uif : 1

portchannel_bypass : 0x0

cos : 0

vlan : 0

rate_limit : unlimited

cur_rate : unlimited

stby_vifid : 0

stby_vifcookie : 0

stby_recovery_delay : 0

channel : 0

stdby_channel : 0

profile :

stdby_profile :

init_errno : 0

cdn : eth1

devspec_flags : TSO, LRO, RXCSUM, TXCSUM, RSS, RSSHASH_IPV4, RSSHASH_TCPIPV4, RSSHASH_IPV6, RSSHASH_TCPIPV6

lif : 19

vmode : STATIC

encap mode : NONE

host wq : [20-27] (n=8)

host rq : [2002-2009] (n=8) (h=0x080107d2)

host cq : [1986-2001] (n=16)

host intr : [2976-2993] (n=18)

notify : pa=0x1038e27000/40 intr=17

devcmd2 wq : [28] (n=1)

================================

Zugehörige Informationen

Technischer Support und Dokumentation für Cisco Systeme

Serverprofile in Intersight

Optimierungsrichtlinien für virtuelle Schnittstellenkarten des Cisco UCS (Whitepaper)

Optimierungsleitfaden für die Netzwerkleistung von Red Hat Enterprise Linux

Feedback

Feedback