Disjunkte Layer 2 in Hyperflex-Clustern konfigurieren

Download-Optionen

-

ePub (1.3 MB)

In verschiedenen Apps auf iPhone, iPad, Android, Sony Reader oder Windows Phone anzeigen

Inklusive Sprache

In dem Dokumentationssatz für dieses Produkt wird die Verwendung inklusiver Sprache angestrebt. Für die Zwecke dieses Dokumentationssatzes wird Sprache als „inklusiv“ verstanden, wenn sie keine Diskriminierung aufgrund von Alter, körperlicher und/oder geistiger Behinderung, Geschlechtszugehörigkeit und -identität, ethnischer Identität, sexueller Orientierung, sozioökonomischem Status und Intersektionalität impliziert. Dennoch können in der Dokumentation stilistische Abweichungen von diesem Bemühen auftreten, wenn Text verwendet wird, der in Benutzeroberflächen der Produktsoftware fest codiert ist, auf RFP-Dokumentation basiert oder von einem genannten Drittanbieterprodukt verwendet wird. Hier erfahren Sie mehr darüber, wie Cisco inklusive Sprache verwendet.

Informationen zu dieser Übersetzung

Cisco hat dieses Dokument maschinell übersetzen und von einem menschlichen Übersetzer editieren und korrigieren lassen, um unseren Benutzern auf der ganzen Welt Support-Inhalte in ihrer eigenen Sprache zu bieten. Bitte beachten Sie, dass selbst die beste maschinelle Übersetzung nicht so genau ist wie eine von einem professionellen Übersetzer angefertigte. Cisco Systems, Inc. übernimmt keine Haftung für die Richtigkeit dieser Übersetzungen und empfiehlt, immer das englische Originaldokument (siehe bereitgestellter Link) heranzuziehen.

Inhalt

Einleitung

In diesem Dokument wird beschrieben, wie aus UCS Manager- (UCSM) und ESXi-Perspektive eine separate Layer-2- (DL2)-Konfiguration auf einem HX-Cluster implementiert wird.

Voraussetzungen

Anforderungen

Cisco empfiehlt, dass Sie über Kenntnisse in folgenden Bereichen verfügen:

- Grundlegendes Verständnis der DL2-Konfiguration

- Grundkenntnisse von HyperFlex Cluster

- Empfohlene UCSM-Kenntnisse zu vNICs, Serviceprofilen und Vorlagen

Weitere Anforderungen sind:

- Mindestens ein verfügbarer Link auf jedem Fabric Interconnect und zwei verfügbare Links auf dem Upstream-Switch.

- Die Verbindungen zwischen den Fabric Interconnects und dem Upstream-Switch müssen aktiv sein, sie müssen als Uplinks konfiguriert sein. Wenn dies nicht der Fall ist, überprüfen Sie diese Option System Configuration - Configuring Ports to configure them on UCSM (Systemkonfiguration - Ports konfigurieren, um sie für UCSM zu konfigurieren).

- Die zu verwendenden VLANs müssen bereits auf UCSM erstellt werden. Andernfalls gehen Sie wie folgt vor: Netzwerkkonfiguration - Konfigurieren eines benannten VLANs.

- Die zu verwendenden VLANs müssen bereits auf dem Upstream-Switch erstellt werden.

- Die zu verwendenden VLANs können auf keiner anderen virtuellen NIC (vNIC) in den Serviceprofilen vorhanden sein.

Verwendete Komponenten

Dieses Dokument ist nicht auf bestimmte Software- und Hardware-Versionen beschränkt.

- 2 x UCS-FI-6248UP

- 2 x N5K-C5548UP

- UCSM Version 4.2(1f)

Die Informationen in diesem Dokument beziehen sich auf Geräte in einer speziell eingerichteten Testumgebung. Alle Geräte, die in diesem Dokument benutzt wurden, begannen mit einer gelöschten (Nichterfüllungs) Konfiguration. Wenn Ihr Netzwerk in Betrieb ist, stellen Sie sicher, dass Sie die möglichen Auswirkungen aller Befehle kennen.

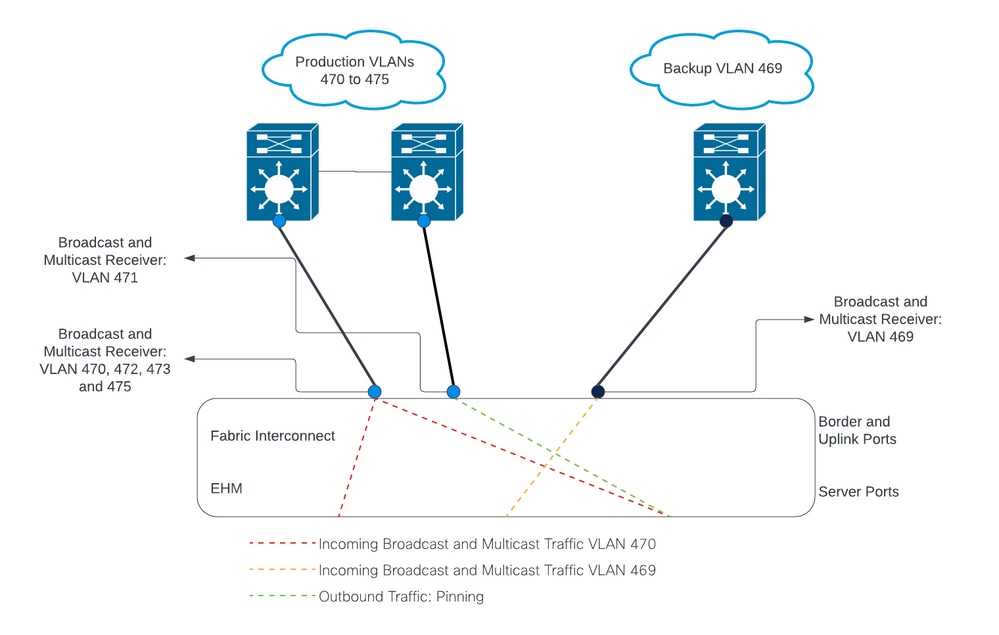

Netzwerkdiagramm

Konfigurationen

DL2-Konfigurationen werden verwendet, um den Datenverkehr auf bestimmten Uplinks zu den Upstream-Geräten zu trennen, sodass sich der VLAN-Datenverkehr nicht mischt.

Konfigurieren der neuen vNICs

Schritt 1: Melden Sie sich bei UCSM an, und klicken Sie im linken Bereich auf die Registerkarte LAN.

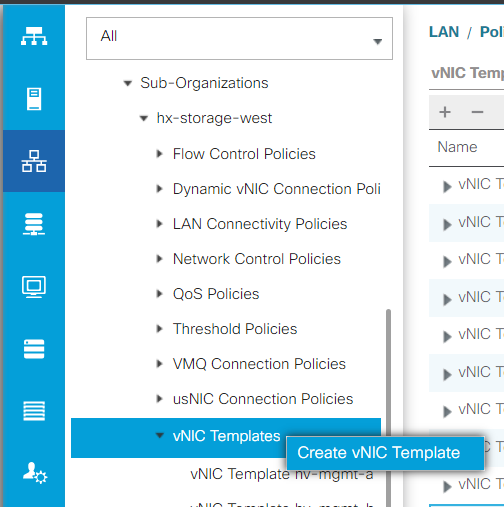

Navigieren Sie zu Richtlinien > Stamm > Unterorganisationen > Name der Unterorganisation > vNIC-Vorlagen. Klicken Sie mit der rechten Maustaste darauf, und klicken Sie auf vNIC-Vorlage erstellen.

Schritt 2: Nennen Sie die Vorlage, lassen Sie Fabric A ausgewählt, führen Sie einen Bildlauf nach unten durch, und wählen Sie die entsprechenden VLANs für die neue Verbindung aus. Die übrigen Einstellungen können nach Bedarf konfiguriert werden.

Wiederholen Sie dann denselben Vorgang, wählen Sie diesmal jedoch Fabric B aus.

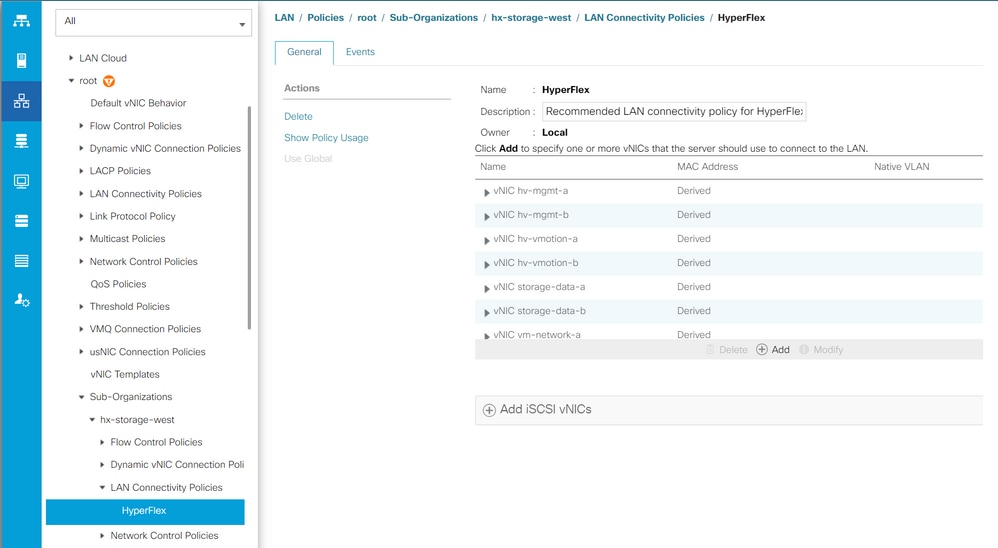

Schritt 3: Navigieren Sie auf der Registerkarte LAN zu Richtlinien > Stamm > Unterorganisationen > Name der Unterorganisation > LAN-Verbindungsrichtlinien > Hyperflex.

Schritt 4: Klicken Sie auf Hinzufügen, nennen Sie die vNIC, und wählen Sie einen MAC-Pool aus dem Dropdown-Menü aus.

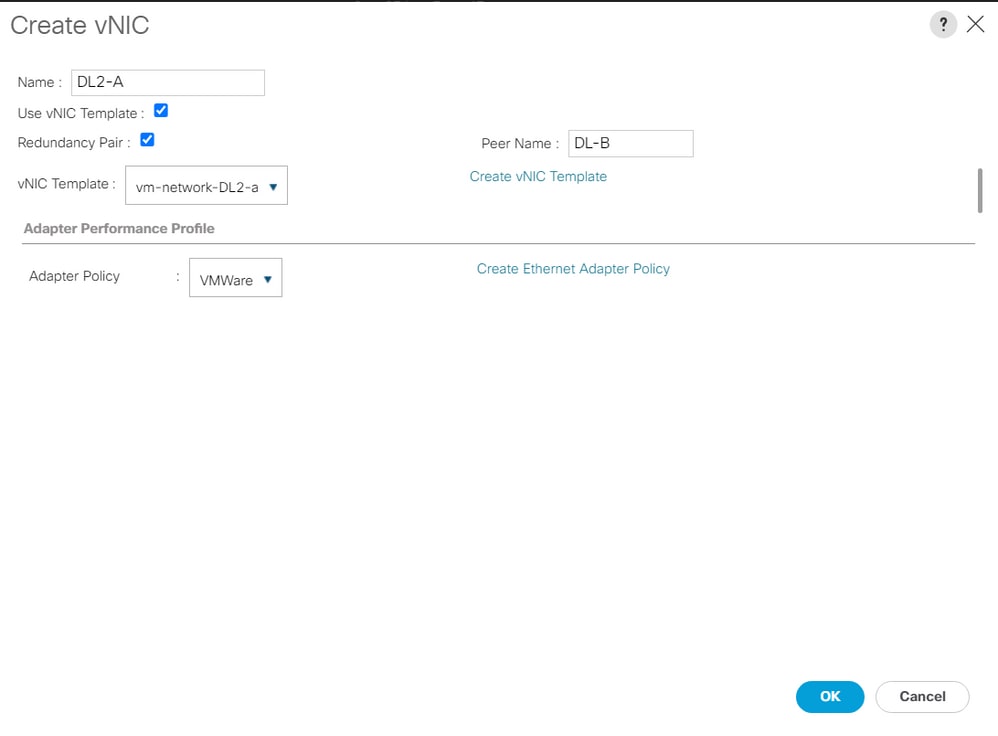

Aktivieren Sie die Kontrollkästchen vNIC-Vorlage verwenden und Redundanzpaar. Wählen Sie im Dropdown-Menü vNIC-Vorlage die neue Vorlage aus, und geben Sie neben ihr den Partnername.

Wählen Sie die gewünschte Adapterrichtlinie aus, und klicken Sie auf OK.

Schritt 5: Suchen Sie in der vNIC-Liste nach dem Peer des gerade erstellten, wählen Sie ihn aus, und klicken Sie auf Ändern.

Klicken Sie auf das Feld vNIC-Vorlage verwenden, und wählen Sie die andere Vorlage aus, die aus dem Dropdown-Menü erstellt wurde.

Klicken Sie unten auf Save Changes (Änderungen speichern). Dies löst ausstehende Aktivitäten für die zugehörigen Server aus.

Ausstehende Aktivitäten bestätigen

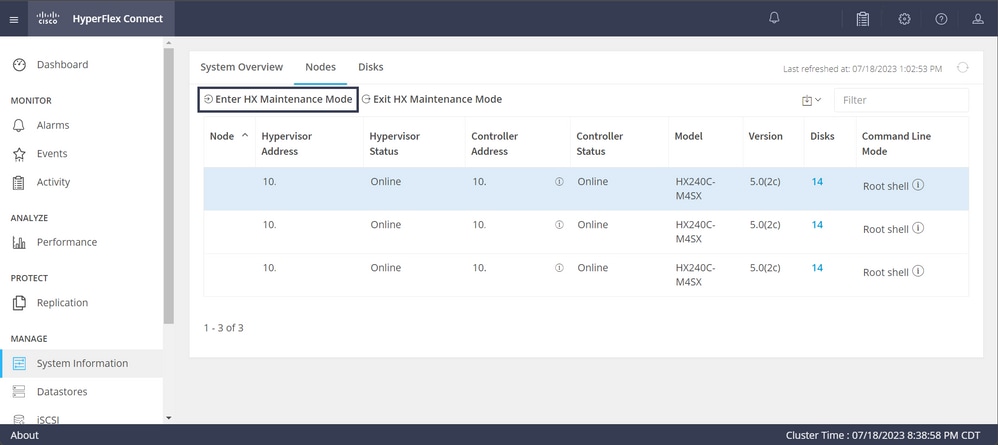

Schritt 1: Melden Sie sich bei HX Connect an, navigieren Sie zu Systeminformationen > Knoten, klicken Sie auf einen der Knoten, und klicken Sie dann auf HX-Wartungsmodus eingeben, und warten Sie, bis die Aufgabe abgeschlossen ist.

Schritt 2: Stellen Sie über vCenter sicher, dass der Knoten gewartet wird.

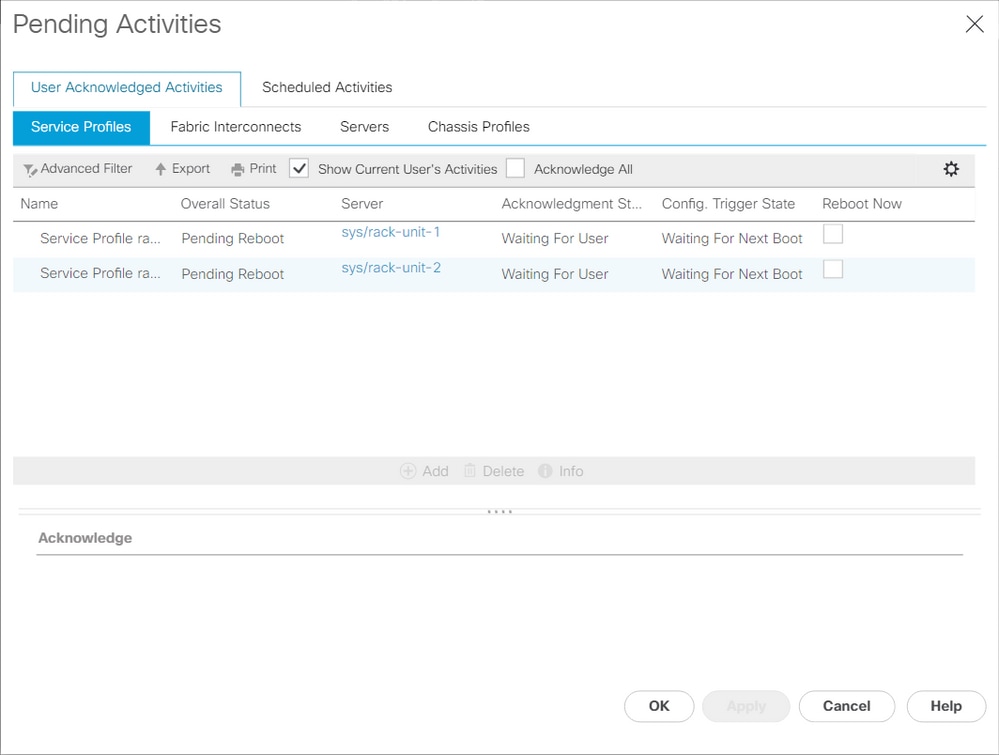

Schritt 3: Sobald der Knoten gewartet wird, kehren Sie zu UCSM zurück, klicken auf das Glockensymbol oben rechts und dann unter Jetzt neu starten.

Aktivieren Sie das Kontrollkästchen für den Server, der gerade gewartet wird, und klicken Sie dann auf OK.

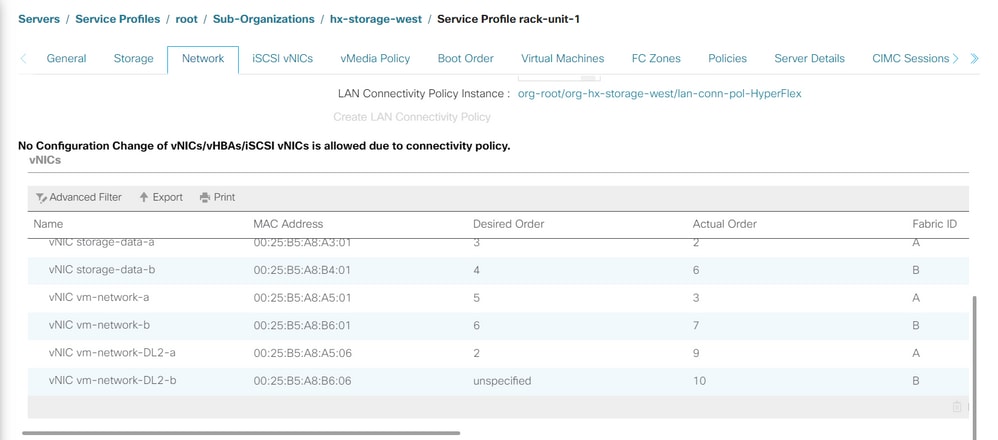

Schritt 4: Nachdem der Server gestartet wurde, stellen Sie sicher, dass die neuen vNICs vorhanden sind, indem Sie zu Server > Serviceprofile > Root > Sub-Organizations > Sub-Organization name > Service Profile name (Server > Serviceprofile > Root > Unterorganisationen > Name der Unterorganisation) navigieren.

Klicken Sie auf Netzwerk, scrollen Sie nach unten, und die neuen vNICs müssen dort sein.

Schritt 5: Nehmen Sie den Server über die HX Connect-Benutzeroberfläche aus dem Wartungsmodus.

Klicken Sie auf HX-Wartungsmodus beenden.

Sobald der Server außer Betrieb ist, wird die virtuelle Storage Controller-Maschine (SCVM) gestartet, und der Cluster startet den Wiederherstellungsprozess.

Um den Heilungsprozess zu überwachen, starten Sie SSH in die Hyperflex (HX) Cluster Manager IP und führen den folgenden Befehl aus:

sysmtool --ns cluster --cmd healthdetailCluster Health Detail:

---------------------:

State: ONLINE

HealthState: HEALTHY

Policy Compliance: COMPLIANT

Creation Time: Tue May 30 04:48:45 2023

Uptime: 7 weeks, 1 days, 15 hours, 50 mins, 17 secs

Cluster Resiliency Detail:

-------------------------:

Health State Reason: Storage cluster is healthy.

# of nodes failure tolerable for cluster to be fully available: 1

# of node failures before cluster goes into readonly: NA

# of node failures before cluster goes to be crticial and partially available: 3

# of node failures before cluster goes to enospace warn trying to move the existing data: NA

# of persistent devices failures tolerable for cluster to be fully available: 2

# of persistent devices failures before cluster goes into readonly: NA

# of persistent devices failures before cluster goes to be critical and partially available: 3

# of caching devices failures tolerable for cluster to be fully available: 2

# of caching failures before cluster goes into readonly: NA

# of caching failures before cluster goes to be critical and partially available: 3

Current ensemble size: 3

Minimum data copies available for some user data: 3

Minimum cache copies remaining: 3

Minimum metadata copies available for cluster metadata: 3

Current healing status:

Time remaining before current healing operation finishes:

# of unavailable nodes: 0Schritt 6: Wenn der Cluster fehlerfrei ist, wiederholen Sie die Schritte 1-6. Fahren Sie NICHT mit dem nächsten Schritt fort, bis alle Server mit den neuen vNICs ausgestattet sind.

Konfigurieren der VLANs

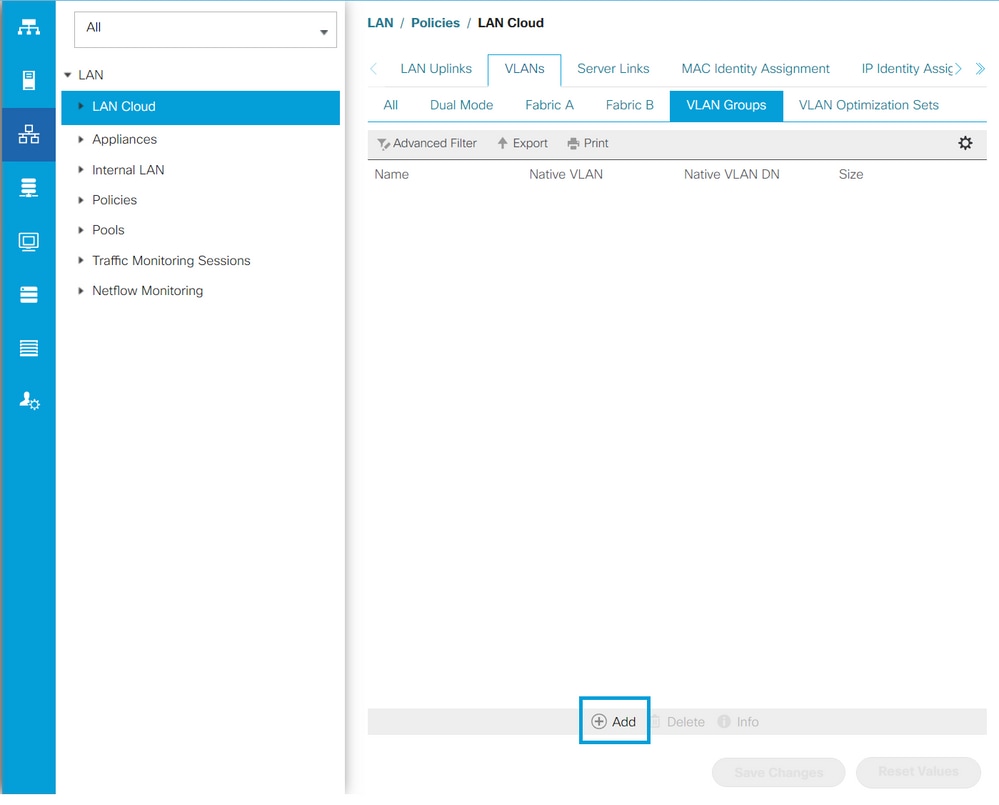

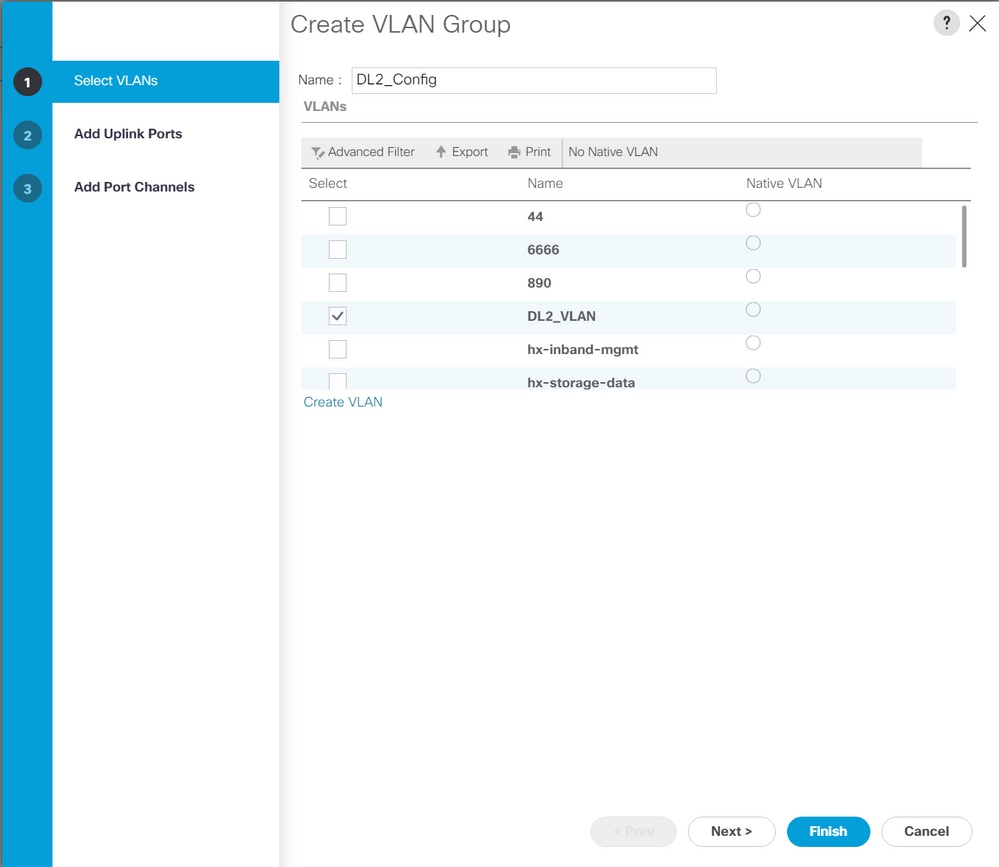

Schritt 1: Navigieren Sie in UCSM zu LAN > VLANs > VLAN Groups, und klicken Sie auf Add.

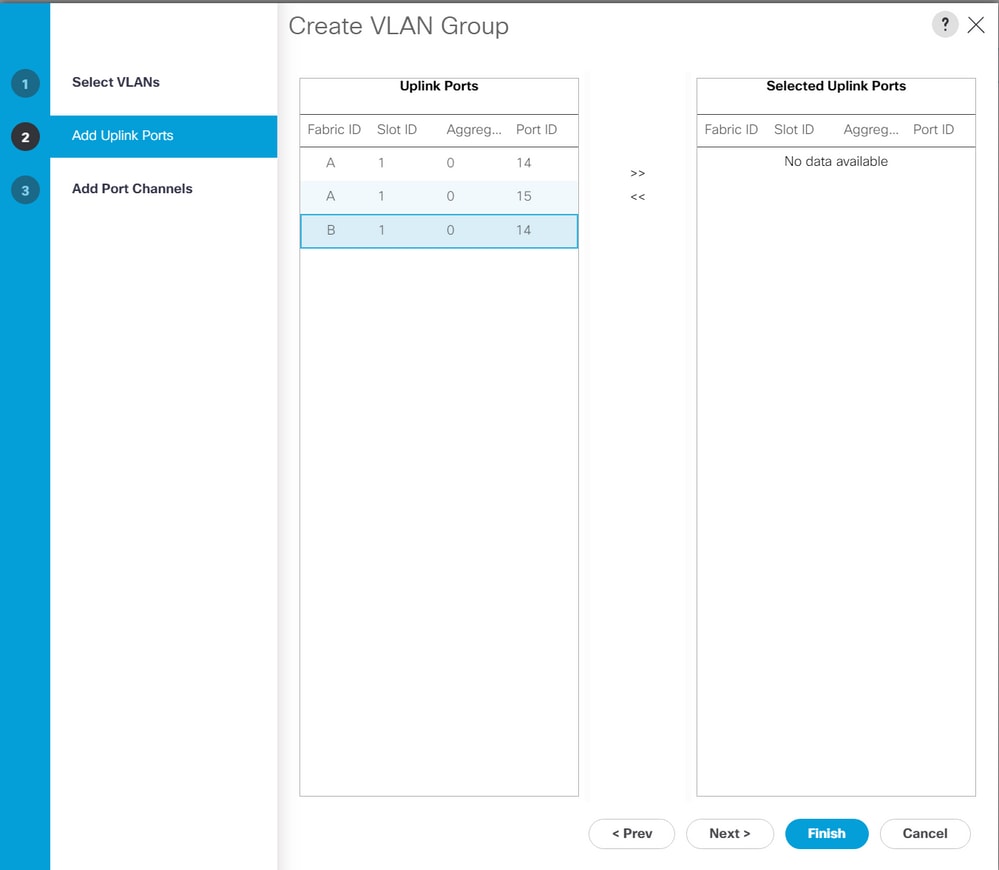

Schritt 2: Geben Sie der VLAN-Gruppe einen Namen, und wählen Sie unten die entsprechenden VLANs aus, klicken Sie auf Weiter, und fahren Sie dann mit Schritt 2 des Assistenten fort, um einzelne Uplinks-Ports hinzuzufügen, oder mit Schritt 3, um Port-Channels hinzuzufügen.

Schritt 3: Fügen Sie den Uplink-Port oder Port-Channel hinzu, indem Sie darauf klicken und auf das Symbol >> klicken. Klicken Sie unten auf Beenden.

ESXi-Konfiguration

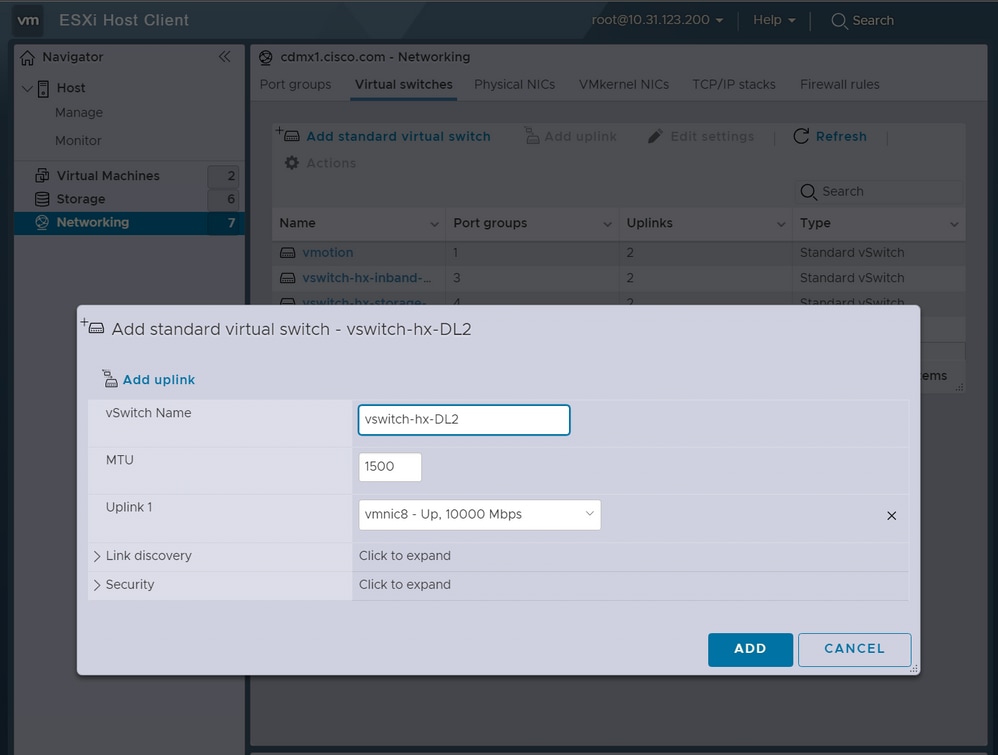

Schritt 1: Melden Sie sich bei der vSphere des ESXi-Hosts an, navigieren Sie zu Networking > Virtual Switches, und klicken Sie auf Hinzufügen eines standardmäßigen virtuellen Switches

Schritt 2: Benennen Sie den vSwitch, und eine der neuen vmnics ist bereits vorhanden. Klicken Sie auf Uplink hinzufügen, um die zweite hinzuzufügen. Klicken Sie auf Hinzufügen.

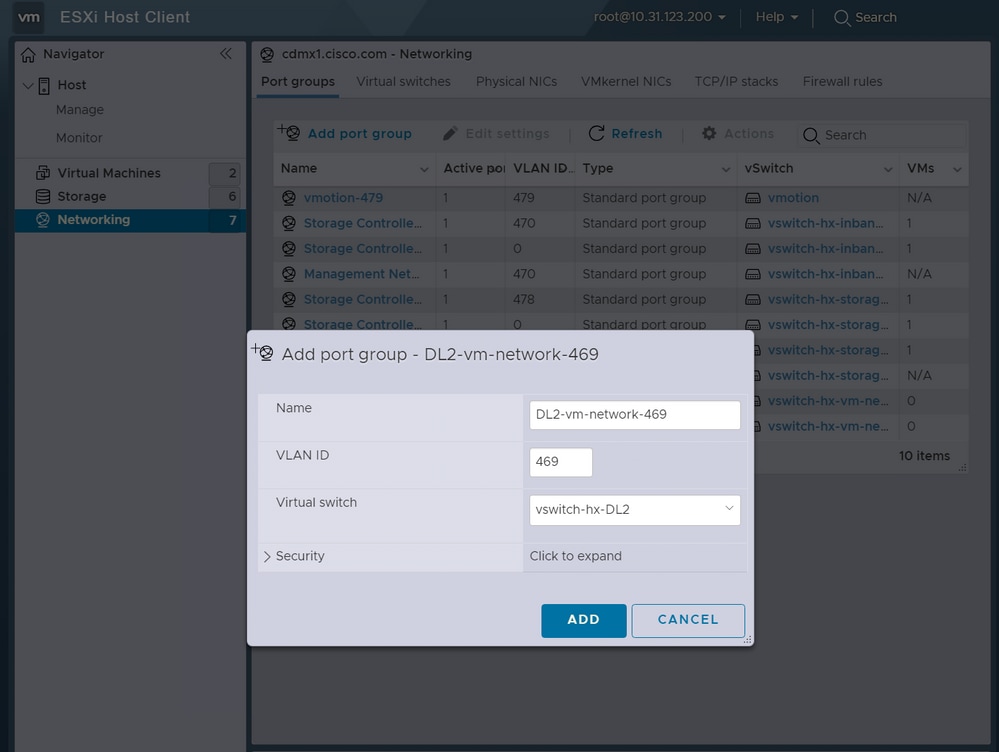

Schritt 3: Navigieren Sie zu Networking > Portgruppen, und klicken Sie auf Portgruppe hinzufügen

Schritt 4: Geben Sie der Portgruppe einen Namen, geben Sie das gewünschte VLAN ein, und wählen Sie den neuen virtuellen Switch aus dem Dropdown-Menü aus.

Schritt 5: Wiederholen Sie Schritt 4 für jedes VLAN, das durch die neuen Verbindungen fließt.

Schritt 6: Wiederholen Sie die Schritte 1-5 für jeden Server, der Teil des Clusters ist.

Überprüfung

UCSM-Verifizierung

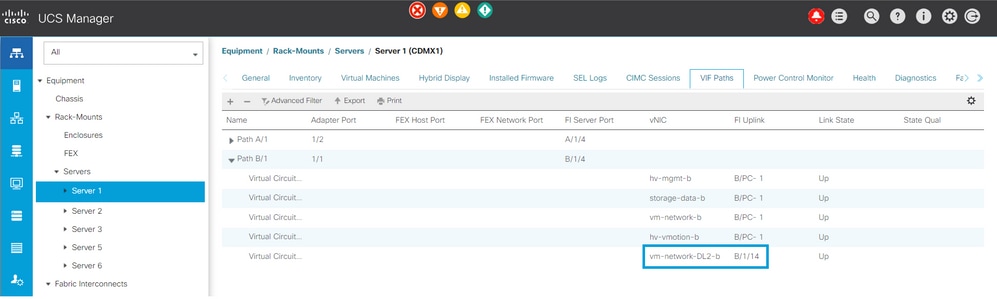

Navigieren Sie zu Equipment > Rack-Mounts > Servers > Server # > VIF Paths, und erweitern Sie Path A oder B unter der Spalte vNIC (vNIC). Suchen Sie nach der vNIC, die zur DL2 vNIC passt, und geben Sie an, dass Virtual Circuit an den Fabric Interconnect (FI) Uplink oder Port Channel angeheftet werden muss, der kürzlich konfiguriert wurde.

CLI-Überprüfung

VIF-Pfad (Virtual Interface)

Führen Sie in einer SSH-Sitzung mit den Fabric Interconnects den folgenden Befehl aus:

show service-profile circuit server <server-number>

Dieser Befehl zeigt die VIF-Pfade, die zugehörigen vNICs und die Schnittstelle an, an die sie angeheftet sind.

Fabric ID: A

Path ID: 1

VIF vNIC Link State Oper State Prot State Prot Role Admin Pin Oper Pin Transport

---------- --------------- ----------- ---------- ------------- ----------- ---------- ---------- ---------

966 hv-mgmt-a Up Active No Protection Unprotected 0/0/0 0/0/1 Ether

967 storage-data-a Up Active No Protection Unprotected 0/0/0 0/0/1 Ether

968 vm-network-a Up Active No Protection Unprotected 0/0/0 0/0/1 Ether

969 hv-vmotion-a Up Active No Protection Unprotected 0/0/0 0/0/1 Ether

990 network-DL2-a Up Active No Protection Unprotected 0/0/0 1/0/14 Ether

In der Spalte Oper Pin (Oper-Pin) muss der kürzlich konfigurierte FI-Uplink oder Port-Channel unter derselben Leitung wie die DL2 vNIC angezeigt werden.

An diesem Ausgang ist das VIF 990, das der vm-network-DL2-b vNIC entspricht, an die Schnittstelle 1/0/14 angeheftet.

Anheften an den Uplinks

Fabric-Interconnect-A# connect nx-os a

Fabric-Interconnect-A(nxos)# show pinning border-interfaces

--------------------+---------+----------------------------------------

Border Interface Status SIFs

--------------------+---------+----------------------------------------

Eth1/14 Active sup-eth2 Veth990 Veth992 Veth994Bei dieser Ausgabe muss die Veth-Nummer mit der VIF-Nummer der vorherigen Ausgabe übereinstimmen und sich in derselben Zeile wie die richtige Uplink-Schnittstelle befinden.

Designierter Empfänger:

Fabric-Interconnect-A# connect nx-os a

Fabric-Interconnect-A(nxos)# show platform software enm internal info vlandb id <VLAN-ID>

vlan_id 469

-------------

Designated receiver: Eth1/14

Membership:

Eth1/14

Bei dieser Ausgabe muss der richtige Uplink angezeigt werden.

Upstream-Switches

Bei einer SSH-Sitzung mit den Upstream-Switches kann die MAC-Adresstabelle überprüft werden, und die MAC-Adresse einer beliebigen virtuellen Maschine (VM) in diesem VLAN muss angezeigt werden.

Nexus-5K# show mac address-table vlan 469

Legend:

* - primary entry, G - Gateway MAC, (R) - Routed MAC, O - Overlay MAC

age - seconds since last seen,+ - primary entry using vPC Peer-Link

VLAN MAC Address Type age Secure NTFY Ports/SWID.SSID.LID

---------+-----------------+--------+---------+------+----+------------------

* 469 0000.0c07.ac45 static 0 F F Router

* 469 002a.6a58.e3bc static 0 F F Po1

* 469 0050.569b.048c dynamic 50 F F Eth1/14

* 469 547f.ee6a.8041 static 0 F F Router

In diesem Konfigurationsbeispiel ist VLAN 469 das separate VLAN. Die MAC-Adresse 0050:569B:048C gehört zu einer Linux-VM, die dem vSwitch vswitch-hx-DL2 und der Portgruppe DL2-vm-network-469 zugewiesen ist. Sie wird korrekt an der Schnittstelle angezeigt. Ethernet 1/14, die Schnittstelle des mit dem Fabric Interconnect verbundenen Upstream-Switches.

Von derselben Sitzung zum Upstream-Switch kann die VLAN-Konfiguration überprüft werden.

Nexus-5K# show vlan brief

VLAN Name Status Ports

---- -------------------------------- --------- -------------------------------

1 default active Eth1/5, Eth1/8, Eth1/9, Eth1/10

Eth1/11, Eth1/12, Eth1/13

Eth1/15, Eth1/16, Eth1/17

Eth1/19, Eth1/20, Eth1/21

Eth1/22, Eth1/23, Eth1/24

Eth1/25, Eth1/26

469 DMZ active Po1, Eth1/14, Eth1/31, Eth1/32

An diesem Ausgang wird Schnittstelle Ethernet 1/14 korrekt dem VLAN 469 zugewiesen.

Fehlerbehebung

UCSM-Konfigurationsfehler

Fehler: "Es wurde kein funktionierender Uplink-Port gefunden, der alle VLANs der vNIC(s) überträgt. Die vNIC(s) werden heruntergefahren, was zu einer Unterbrechung des Datenverkehrs in allen vorhandenen VLANs der vNIC(s) führt."

Der Fehler bedeutet, dass keine neuen Uplinks für den neuen Datenverkehr vorhanden sind, Probleme auf Layer 1 und Layer 2 auf den Schnittstellen verworfen werden und der Vorgang wiederholt wird.

Fehler: "ENM-Quellpinning fehlgeschlagen"

Der Fehler hängt mit den zugeordneten VLANs einer vNIC zusammen, die auf einem Uplink nicht gefunden wurde.

Mögliche falsche Verhaltensweisen

Die vorherigen Uplinks unterbrechen den Datenfluss, da die neuen VLANs bereits auf einer vNIC vorhanden sind und an die neuen Uplinks angeheftet werden.

Entfernen Sie alle doppelten VLANs aus der vorherigen vNIC-Vorlage. Navigieren Sie zu Policies > root > Sub-organizations > Sub-organisation name > vNIC templates, und entfernen Sie das VLAN aus der vm-network vNIC-Vorlage.

Zugehörige Informationen

Revisionsverlauf

| Überarbeitung | Veröffentlichungsdatum | Kommentare |

|---|---|---|

1.0 |

25-Jul-2023 |

Erstveröffentlichung |

Beiträge von Cisco Ingenieuren

- Ignacio JimenezCisco TAC Engineer

- Sergio MoraCisco TAC Engineer

Cisco kontaktieren

- Eine Supportanfrage öffnen

- (Erfordert einen Cisco Servicevertrag)

Feedback

Feedback