Fehlerbehebung: Fehler bei der Integritätsprüfung von Intersight für HX-Cluster

Inklusive Sprache

In dem Dokumentationssatz für dieses Produkt wird die Verwendung inklusiver Sprache angestrebt. Für die Zwecke dieses Dokumentationssatzes wird Sprache als „inklusiv“ verstanden, wenn sie keine Diskriminierung aufgrund von Alter, körperlicher und/oder geistiger Behinderung, Geschlechtszugehörigkeit und -identität, ethnischer Identität, sexueller Orientierung, sozioökonomischem Status und Intersektionalität impliziert. Dennoch können in der Dokumentation stilistische Abweichungen von diesem Bemühen auftreten, wenn Text verwendet wird, der in Benutzeroberflächen der Produktsoftware fest codiert ist, auf RFP-Dokumentation basiert oder von einem genannten Drittanbieterprodukt verwendet wird. Hier erfahren Sie mehr darüber, wie Cisco inklusive Sprache verwendet.

Informationen zu dieser Übersetzung

Cisco hat dieses Dokument maschinell übersetzen und von einem menschlichen Übersetzer editieren und korrigieren lassen, um unseren Benutzern auf der ganzen Welt Support-Inhalte in ihrer eigenen Sprache zu bieten. Bitte beachten Sie, dass selbst die beste maschinelle Übersetzung nicht so genau ist wie eine von einem professionellen Übersetzer angefertigte. Cisco Systems, Inc. übernimmt keine Haftung für die Richtigkeit dieser Übersetzungen und empfiehlt, immer das englische Originaldokument (siehe bereitgestellter Link) heranzuziehen.

Inhalt

Einleitung

In diesem Dokument wird beschrieben, wie häufige Intersight-Integritätsprüfungsfehler für Hyperflex-Cluster behoben werden.

Voraussetzungen

Anforderungen

Cisco empfiehlt, dass Sie über Kenntnisse in folgenden Bereichen verfügen:

- Grundlegendes Verständnis von Network Time Protocol (NTP) und Domain Name System (DNS)

- Grundlegendes Verständnis der Linux-Befehlszeile.

- Grundlegendes Verständnis von VMware ESXi

- Grundlegendes Verständnis des VI-Texteditors.

- Hyperflex-Cluster-Betrieb.

Verwendete Komponenten

Die Informationen in diesem Dokument basieren auf:

HyperFlex Data Platform (HXDP) 5.0.(2a) und höher

Die Informationen in diesem Dokument beziehen sich auf Geräte in einer speziell eingerichteten Testumgebung. Alle Geräte, die in diesem Dokument benutzt wurden, begannen mit einer gelöschten (Nichterfüllungs) Konfiguration. Wenn Ihr Netzwerk in Betrieb ist, stellen Sie sicher, dass Sie die möglichen Auswirkungen aller Befehle kennen.

Hintergrundinformationen

Cisco Intersight bietet die Möglichkeit, eine Reihe von Tests an einem Hyperflex-Cluster durchzuführen, um sicherzustellen, dass sich der Cluster-Status in einem optimalen Zustand für die täglichen Betriebs- und Wartungsaufgaben befindet.

Ab HX 5.0(2a) führt Hyperflex ein Diag-Benutzerkonto mit erweiterten Berechtigungen zur Fehlerbehebung in der Hyperflex-Befehlszeile ein. Stellen Sie eine Verbindung mit Hyperflex Cluster Management IP (CMIP) her, indem Sie SSH als Administratorbenutzer verwenden, und wechseln Sie dann zum Diag-Benutzer.

HyperFlex StorageController 5.0(2d)

admin@192.168.202.30's password:

This is a Restricted shell.

Type '?' or 'help' to get the list of allowed commands.

hxshell:~$ su diag

Password:

____ __ _____ _ _ _ _____

| ___| / /_ _ | ____(_) __ _| |__ | |_ |_ _|_ _____

|___ \ _____ | '_ \ _| |_ | _| | |/ _` | '_ \| __| _____ | | \ \ /\ / / _ \

___) | |_____| | (_) | |_ _| | |___| | (_| | | | | |_ |_____| | | \ V V / (_) |

|____/ \___/ |_| |_____|_|\__, |_| |_|\__| |_| \_/\_/ \___/

|___/

Enter the output of above expression: 5

Valid captcha

diag#Fehlerbehebung

Reparieren Sie die ESXi VIB-Prüfung "Einige der installierten VIBs verwenden veraltete vmkAPIs".

Bei einem Upgrade auf ESXi 7.0 und höher stellt Intersight sicher, dass die ESXi-Hosts in einem Hyperflex-Cluster nicht über Treiber verfügen, die mit Abhängigkeiten von älteren vmkapi-Versionen erstellt wurden. VMware stellt eine Liste der betroffenen vSphere-Installationspakete (VIBs) bereit und beschreibt dieses Problem in diesem Artikel: KB 78389

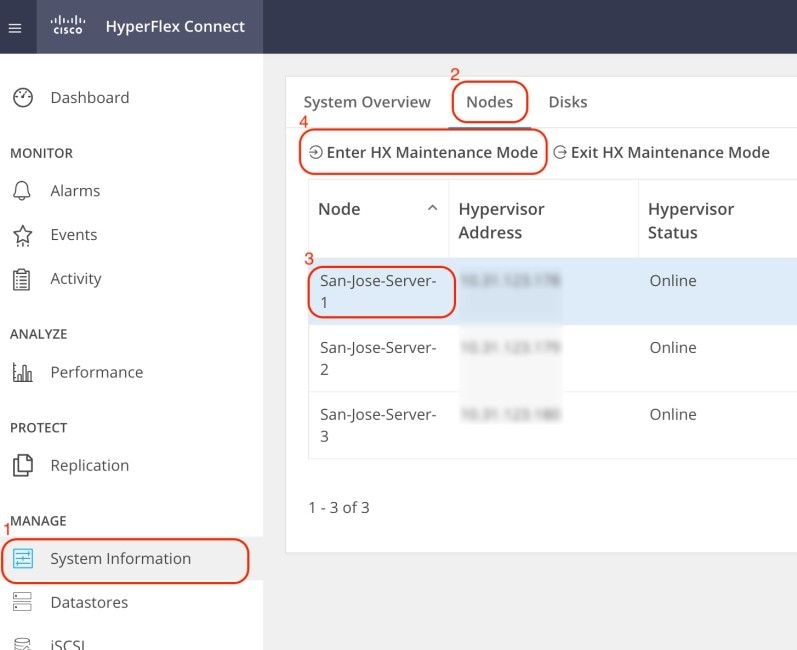

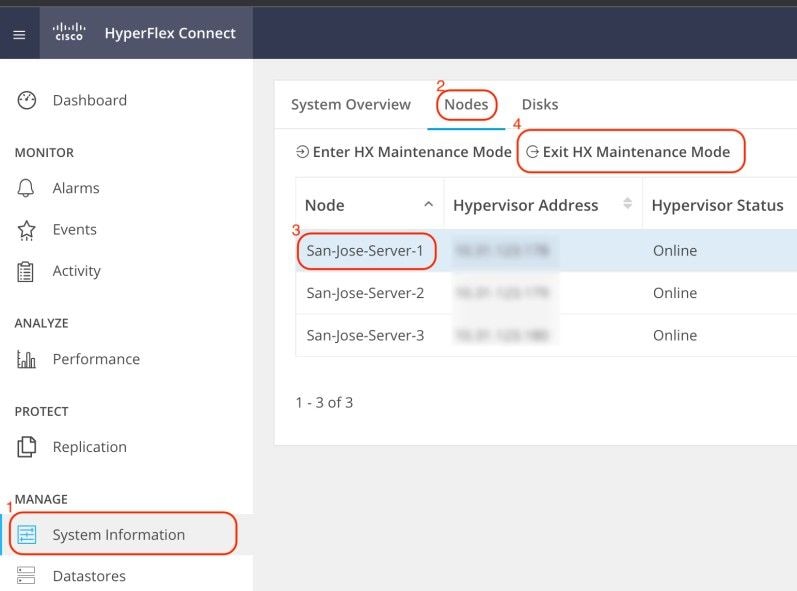

Melden Sie sich bei der Hyperflex Connect-Webbenutzeroberfläche an, und navigieren Sie zu "Systeminformationen". Klicken Sie auf Knoten, und wählen Sie den Knoten Hyperflex (HX) aus. Klicken Sie dann auf HX-Wartungsmodus aktivieren.

Verwenden Sie einen SSH-Client, um eine Verbindung zur Management-IP-Adresse des ESXi-Hosts herzustellen. Bestätigen Sie anschließend die VIBs auf dem ESXi-Host mit dem folgenden Befehl:

esxcli software vib listEntfernen Sie die VIB mit dem folgenden Befehl:

esxcli software vib remove -n driver_VIB_nameStarten Sie den ESXi-Host neu. Wenn er wieder online ist, wählen Sie über HX Connect den HX-Knoten aus, und klicken Sie auf HX-Wartungsmodus beenden.

Warten Sie, bis der HX-Cluster fehlerfrei ist. Führen Sie dann die gleichen Schritte für die anderen Knoten im Cluster aus.

Fix vMotion aktiviert "VMotion ist auf dem ESXi-Host deaktiviert"

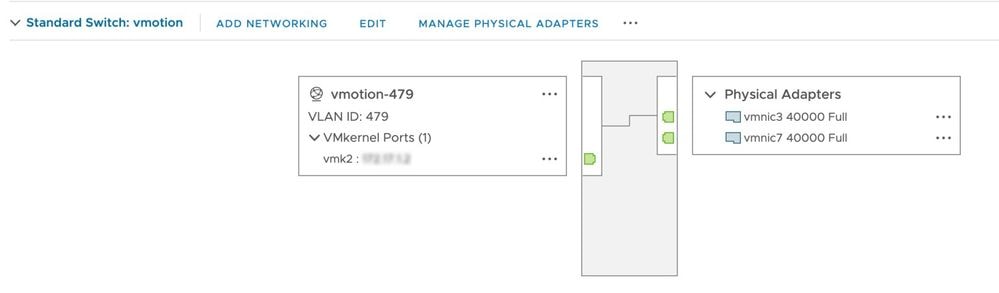

Mit dieser Prüfung wird sichergestellt, dass vMotion auf allen ESXi-Hosts im HX-Cluster aktiviert ist. In vCenter muss jeder ESXi-Host über einen virtuellen Switch (vSwitch) sowie eine vmkernel-Schnittstelle für vMotion verfügen.

Stellen Sie eine Verbindung mit Hyperflex Cluster Management IP (CMIP) her, indem Sie SSH als Administratorbenutzer verwenden, und führen Sie dann den folgenden Befehl aus:

hx_post_installWählen Sie Option 1 aus, um vMotion zu konfigurieren:

admin@SpringpathController:~$ hx_post_install

Select hx_post_install workflow-

1. New/Existing Cluster

2. Expanded Cluster (for non-edge clusters)

3. Generate Certificate

Note: Workflow No.3 is mandatory to have unique SSL certificate in the cluster. By Generating this certificate, it will replace your current certificate. If you're performing cluster expansion, then this option is not required.

Selection: 1

Logging in to controller HX-01-cmip.example.com

HX CVM admin password:

Getting ESX hosts from HX cluster...

vCenter URL: 192.168.202.35

Enter vCenter username (user@domain): administrator@vsphere.local

vCenter Password:

Found datacenter HX-Clusters

Found cluster HX-01

post_install to be run for the following hosts:

HX-01-esxi-01.example.com

HX-01-esxi-02.example.com

HX-01-esxi-03.example.com

Enter ESX root password:

Enter vSphere license key? (y/n) n

Enable HA/DRS on cluster? (y/n) y

Successfully completed configuring cluster HA.

Disable SSH warning? (y/n) y

Add vmotion interfaces? (y/n) y

Netmask for vMotion: 255.255.254.0

VLAN ID: (0-4096) 208

vMotion MTU is set to use jumbo frames (9000 bytes). Do you want to change to 1500 bytes? (y/n) y

vMotion IP for HX-01-esxi-01.example.com: 192.168.208.17

Adding vmotion-208 to HX-01-esxi-01.example.com

Adding vmkernel to HX-01-esxi-01.example.com

vMotion IP for HX-01-esxi-02.example.com: 192.168.208.18

Adding vmotion-208 to HX-01-esxi-02.example.com

Adding vmkernel to HX-01-esxi-02.example.com

vMotion IP for HX-01-esxi-03.example.com: 192.168.208.19

Adding vmotion-208 to HX-01-esxi-03.example.com

Adding vmkernel to HX-01-esxi-03.example.com

Hinweis: Für Edge-Cluster, die mit HX Installer bereitgestellt werden, muss das Skript hx_post_install über die HX Installer-CLI ausgeführt werden.

vCenter-Konnektivitätsprüfung reparieren "vCenter-Konnektivitätsprüfung fehlgeschlagen"

Stellen Sie eine Verbindung mit Hyperflex Cluster Management IP (CMIP) her, indem Sie SSH als Administratorbenutzer verwenden, und wechseln Sie zum Diag-Benutzer. Stellen Sie mit dem folgenden Befehl sicher, dass der HX-Cluster für vCenter registriert ist:

diag# hxcli vcenter info

Cluster Name : San_Jose

vCenter Datacenter Name : MX-HX

vCenter Datacenter ID : datacenter-3

vCenter Cluster Name : San_Jose

vCenter Cluster ID : domain-c8140

vCenter URL : 10.31.123.186Die vCenter-URL muss die IP-Adresse oder den vollqualifizierten Domänennamen (Fully Qualified Domain Name, FQDN) des vCenter-Servers anzeigen. Wenn nicht die richtigen Informationen angezeigt werden, registrieren Sie das HX-Cluster mit dem folgenden Befehl erneut bei vCenter:

diag# stcli cluster reregister --vcenter-datacenter MX-HX --vcenter-cluster San_Jose --vcenter-url 10.31.123.186 --vcenter-user administrator@vsphere.local

Reregister StorFS cluster with a new vCenter ...

Enter NEW vCenter Administrator password:

Cluster reregistration with new vCenter succeededStellen Sie mithilfe der folgenden Befehle sicher, dass eine Verbindung zwischen HX CMIP und vCenter besteht:

diag# nc -uvz 10.31.123.186 80

Connection to 10.31.123.186 80 port [udp/http] succeeded!

diag# nc -uvz 10.31.123.186 443

Connection to 10.31.123.186 443 port [udp/https] succeeded!Statusüberprüfung der Bereinigung "Bereinigung fehlgeschlagen" korrigieren

Stellen Sie mit SSH als Administrator eine Verbindung zu Hyperflex CMIP her, und wechseln Sie dann zum Diag-Benutzer. Führen Sie diesen Befehl aus, um den Knoten zu identifizieren, auf dem der Cleaner-Dienst nicht ausgeführt wird:

diag# stcli cleaner info

{ 'type': 'node', 'id': '7e83a6b2-a227-844b-87fb-f6e78e6a59be', 'name': '172.16.1.6' }: ONLINE

{ 'type': 'node', 'id': '8c83099e-b1e0-6549-a279-33da70d09343', 'name': '172.16.1.8' }: ONLINE

{ 'type': 'node', 'id': 'a697a21f-9311-3745-95b4-5d418bdc4ae0', 'name': '172.16.1.7' }: OFFLINEIn diesem Fall ist 172.16.1.7 die IP-Adresse der virtuellen Speichercontrollermaschine (SCVM), auf der der Cleaner nicht ausgeführt wird. Stellen Sie mithilfe von SSH eine Verbindung zur Management-IP-Adresse jedes SCVM im Cluster her, und suchen Sie dann mit dem folgenden Befehl nach der IP-Adresse eth1:

diag# ifconfig eth1

eth1 Link encap:Ethernet HWaddr 00:0c:29:38:2c:a7

inet addr:172.16.1.7 Bcast:172.16.255.255 Mask:255.255.0.0

UP BROADCAST RUNNING MULTICAST MTU:9000 Metric:1

RX packets:1036633674 errors:0 dropped:1881 overruns:0 frame:0

TX packets:983950879 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1000

RX bytes:723797691421 (723.7 GB) TX bytes:698522491473 (698.5 GB)Starten Sie den Cleaner-Dienst auf dem betroffenen Knoten mit dem folgenden Befehl:

diag# sysmtool --ns cleaner --cmd startNTP-Dienststatus korrigieren "NTPD-Dienststatus ist DOWN"

Stellen Sie mithilfe von SSH als Administrator eine Verbindung mit HX CMIP her, und wechseln Sie dann zum Diag-Benutzer. Führen Sie diesen Befehl aus, um zu bestätigen, dass der NTP-Dienst beendet wurde.

diag# service ntp status

* NTP server is not runningWenn der NTP-Dienst nicht ausgeführt wird, führen Sie diesen Befehl aus, um den NTP-Dienst zu starten.

diag# priv service ntp start

* Starting NTP server

...done.Beheben der Verfügbarkeit des NTP-Servers "Überprüfung der Erreichbarkeit der NTP-Server fehlgeschlagen"

Stellen Sie mithilfe von SSH als Administrator eine Verbindung mit HX CMIP her, und wechseln Sie dann zum Diag-Benutzer. Stellen Sie sicher, dass für den HX-Cluster erreichbare NTP-Server konfiguriert sind. Führen Sie diesen Befehl aus, um die NTP-Konfiguration im Cluster anzuzeigen.

diag# stcli services ntp show

10.31.123.226Stellen Sie sicher, dass zwischen jedem SCVM im HX-Cluster und dem NTP-Server an Port 123 eine Netzwerkverbindung besteht.

diag# nc -uvz 10.31.123.226 123

Connection to 10.31.123.226 123 port [udp/ntp] succeeded!Falls der im Cluster konfigurierte NTP-Server nicht mehr verwendet wird, können Sie einen anderen NTP-Server im Cluster konfigurieren.

stcli services ntp set NTP-IP-Address

Warnung: stcli services ntp set überschreibt die aktuelle NTP-Konfiguration im Cluster.

Beheben Sie die Erreichbarkeit des DNS-Servers. "DNS-Erreichbarkeitsprüfung fehlgeschlagen"

Stellen Sie mithilfe von SSH als Administrator eine Verbindung mit HX CMIP her, und wechseln Sie dann zum Diag-Benutzer. Stellen Sie sicher, dass für den HX-Cluster erreichbare DNS-Server konfiguriert sind. Führen Sie diesen Befehl aus, um die DNS-Konfiguration im Cluster anzuzeigen.

diag# stcli services dns show

10.31.123.226Stellen Sie sicher, dass zwischen jeder SCVM im HX-Cluster und dem DNS-Server an Port 53 eine Netzwerkverbindung besteht.

diag# nc -uvz 10.31.123.226 53

Connection to 10.31.123.226 53 port [udp/domain] succeeded!Falls der im Cluster konfigurierte DNS-Server nicht mehr verwendet wird, können Sie einen anderen DNS-Server im Cluster konfigurieren.

stcli services dns set DNS-IP-Adrress

Warnung: stcli services dns set überschreibt die aktuelle DNS-Konfiguration im Cluster.

Beheben Sie die VM-Version des Controllers "Der Wert der VM-Version des Controllers fehlt in der Einstellungsdatei auf dem ESXi-Host"

Mit dieser Prüfung wird sichergestellt, dass jede SCVM guestinfo.stctlvm.version = "3.0.6-3" in die Konfigurationsdatei enthält.

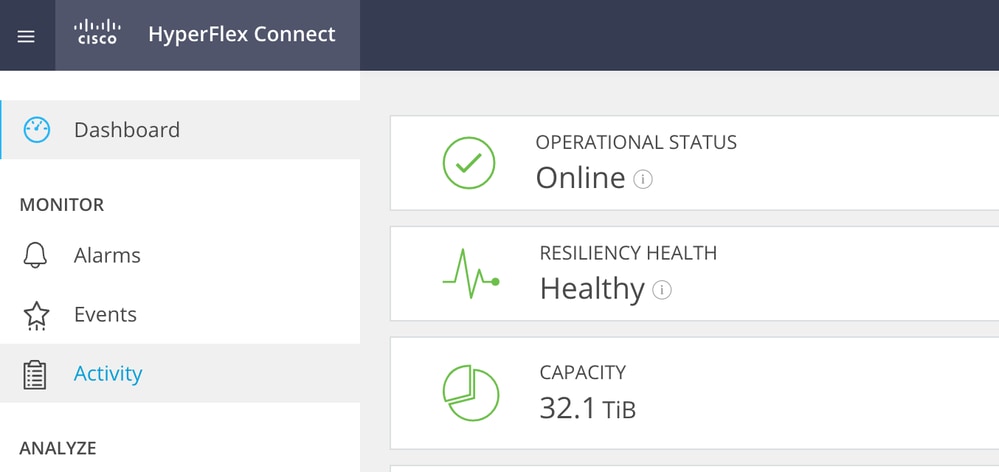

Melden Sie sich bei HX Connect an, und stellen Sie sicher, dass der Cluster fehlerfrei ist.

Stellen Sie über SSH mit dem Root-Konto eine Verbindung zu jedem ESXi-Host im Cluster her. Führen Sie dann diesen Befehl aus.

[root@San-Jose-Server-1:~] grep guestinfo /vmfs/volumes/SpringpathDS-FCH2119V1NH/stCtlVM-FCH2119V1NH/stCtlVM-FCH2119V1NH.vmx

guestinfo.stctlvm.version = "3.0.6-3"

guestinfo.stctlvm.configrdm = "False"

guestinfo.stctlvm.hardware.model = "HXAF240C-M4SX"

guestinfo.stctlvm.role = "storage"

Achtung: Der Name des Datenspeichers und der SCVM-Name können in Ihrem Cluster unterschiedlich sein. Sie können Spring eingeben und dann die Tabulatortaste drücken, um den Namen des Datenspeichers automatisch zu vervollständigen. Geben Sie als SCVM-Namen stCtl ein, und drücken Sie dann die Tabulatortaste, um den SCVM-Namen automatisch auszufüllen.

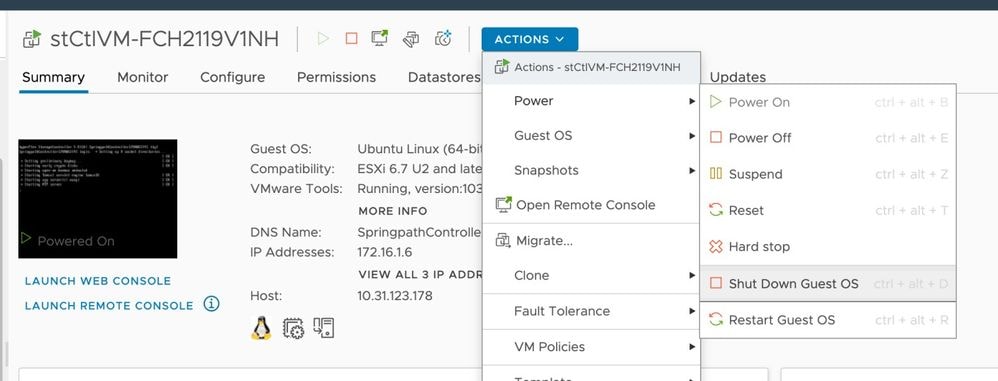

Wenn die Konfigurationsdatei der SCVM guestinfo.stctlvm.version = "3.0.6-3" nicht enthält, melden Sie sich bei vCenter an, und wählen Sie die SCVM aus. Klicken Sie auf Aktionen, navigieren Sie zu Einschalten, und wählen Sie Gastbetriebssystem herunterfahren aus, um das SCVM ordnungsgemäß auszuschalten.

Erstellen Sie über die ESXi-Befehlszeilenschnittstelle (CLI) eine Sicherung der SCVM-Konfigurationsdatei mit dem folgenden Befehl:

cp /vmfs/volumes/SpringpathDS-FCH2119V1NH/stCtlVM-FCH2119V1NH/stCtlVM-FCH2119V1NH.vmx /vmfs/volumes/SpringpathDS-FCH2119V1NH/stCtlVM-FCH2119V1NH/stCtlVM-FCH2119V1NH.vmx.bakFühren Sie dann diesen Befehl aus, um die Konfigurationsdatei des SCVM zu öffnen:

[root@San-Jose-Server-1:~] vi /vmfs/volumes/SpringpathDS-FCH2119V1NH/stCtlVM-FCH2119V1NH/stCtlVM-FCH2119V1NH.vmxDrücken Sie die Taste I, um die Datei zu bearbeiten, navigieren Sie dann zum Ende der Datei, und fügen Sie die folgende Zeile hinzu:

guestinfo.stctlvm.version = "3.0.6-3"Drücken Sie die ESC-Taste, und geben Sie :wq ein, um die Änderungen zu speichern.

Identifizieren Sie die Virtual Machine ID (VMID) der SCVM mit dem Befehl vim-cmd vmsvc/getallvms, und laden Sie die Konfigurationsdatei der SCVM neu:

[root@San-Jose-Server-1:~] vim-cmd vmsvc/getallvms

Vmid Name File Guest OS Version Annotation

1 stCtlVM-FCH2119V1NH [SpringpathDS-FCH2119V1NH] stCtlVM-FCH2119V1NH/stCtlVM-FCH2119V1NH.vmx ubuntu64Guest vmx-15

[root@San-Jose-Server-1:~] vim-cmd vmsvc/reload 1Laden Sie das SCVM mit den folgenden Befehlen neu, und schalten Sie es ein:

[root@San-Jose-Server-1:~] vim-cmd vmsvc/reload 1

[root@San-Jose-Server-1:~] vim-cmd vmsvc/power.on 1

Warnung: In diesem Beispiel ist die VMID 1.

Warten Sie, bis der HX-Cluster wieder fehlerfrei ist, bevor Sie zur nächsten SCVM wechseln.

Wiederholen Sie den gleichen Vorgang für die betroffenen SCVMs nacheinander.

Melden Sie sich anschließend mit SSH bei jedem SCVM an, und wechseln Sie zum Diag-Benutzerkonto. Starten Sie stMgr mit dem folgenden Befehl knotenweise neu:

diag# priv restart stMgr

stMgr start/running, process 22030Stellen Sie vor dem Wechsel zur nächsten SCVM sicher, dass stMgr mit dem folgenden Befehl voll betriebsbereit ist:

diag# stcli about

Waiting for stmgr management server on port 9333 to get ready . .

productVersion: 5.0.2d-42558

instanceUuid: EXAMPLE

serialNumber: EXAMPLE,EXAMPLE,EXAMPLE

locale: English (United States)

apiVersion: 0.1

name: HyperFlex StorageController

fullName: HyperFlex StorageController 5.0.2d

serviceType: stMgr

build: 5.0.2d-42558 (internal)

modelNumber: HXAF240C-M4SX

displayVersion: 5.0(2d)Zugehörige Informationen

Achtung: In diesem Beispiel ist die VMID 1.

Revisionsverlauf

| Überarbeitung | Veröffentlichungsdatum | Kommentare |

|---|---|---|

2.0 |

06-Nov-2023 |

Erstveröffentlichung |

1.0 |

11-Oct-2023 |

Erstveröffentlichung |

Beiträge von Cisco Ingenieuren

- Carlos RazoCisco TAC Engineer

Cisco kontaktieren

- Eine Supportanfrage öffnen

- (Erfordert einen Cisco Servicevertrag)

Feedback

Feedback