Konfigurieren der VXLAN-Funktion auf Cisco IOS XE-Geräten

Download-Optionen

-

ePub (318.7 KB)

In verschiedenen Apps auf iPhone, iPad, Android, Sony Reader oder Windows Phone anzeigen

Inklusive Sprache

In dem Dokumentationssatz für dieses Produkt wird die Verwendung inklusiver Sprache angestrebt. Für die Zwecke dieses Dokumentationssatzes wird Sprache als „inklusiv“ verstanden, wenn sie keine Diskriminierung aufgrund von Alter, körperlicher und/oder geistiger Behinderung, Geschlechtszugehörigkeit und -identität, ethnischer Identität, sexueller Orientierung, sozioökonomischem Status und Intersektionalität impliziert. Dennoch können in der Dokumentation stilistische Abweichungen von diesem Bemühen auftreten, wenn Text verwendet wird, der in Benutzeroberflächen der Produktsoftware fest codiert ist, auf RFP-Dokumentation basiert oder von einem genannten Drittanbieterprodukt verwendet wird. Hier erfahren Sie mehr darüber, wie Cisco inklusive Sprache verwendet.

Informationen zu dieser Übersetzung

Cisco hat dieses Dokument maschinell übersetzen und von einem menschlichen Übersetzer editieren und korrigieren lassen, um unseren Benutzern auf der ganzen Welt Support-Inhalte in ihrer eigenen Sprache zu bieten. Bitte beachten Sie, dass selbst die beste maschinelle Übersetzung nicht so genau ist wie eine von einem professionellen Übersetzer angefertigte. Cisco Systems, Inc. übernimmt keine Haftung für die Richtigkeit dieser Übersetzungen und empfiehlt, immer das englische Originaldokument (siehe bereitgestellter Link) heranzuziehen.

Inhalt

Einleitung

Dieses Dokument beschreibt die grundlegende Konfiguration und Fehlerbehebung für Cisco IOS® XE-Geräte.

Voraussetzungen

Anforderungen

Cisco empfiehlt, dass Sie über Kenntnisse in folgenden Bereichen verfügen:

- Grundlegendes Verständnis von DCI-Overlays und Multicast

Verwendete Komponenten

Die Informationen in diesem Dokument basierend auf folgenden Software- und Hardware-Versionen:

- ASR1004 mit Software 03.16.00.S

- CSR100v(VXE) mit Software 3.16.03.S

Die Informationen in diesem Dokument beziehen sich auf Geräte in einer speziell eingerichteten Testumgebung. Alle Geräte, die in diesem Dokument benutzt wurden, begannen mit einer gelöschten (Nichterfüllungs) Konfiguration. Wenn Ihr Netzwerk in Betrieb ist, stellen Sie sicher, dass Sie die möglichen Auswirkungen aller Befehle kennen.

Hintergrundinformationen

Virtual Extensible LAN (VXLAN) wird zunehmend als DCI-Lösung (Data Center Interconnect) verwendet. Die VXLAN-Funktion wird verwendet, um eine Layer-2-Erweiterung über die Layer-3/Public Routing-Domäne bereitzustellen. In diesem Dokument werden die grundlegende Konfiguration und Fehlerbehebung für Cisco IOS XE-Geräte erläutert.

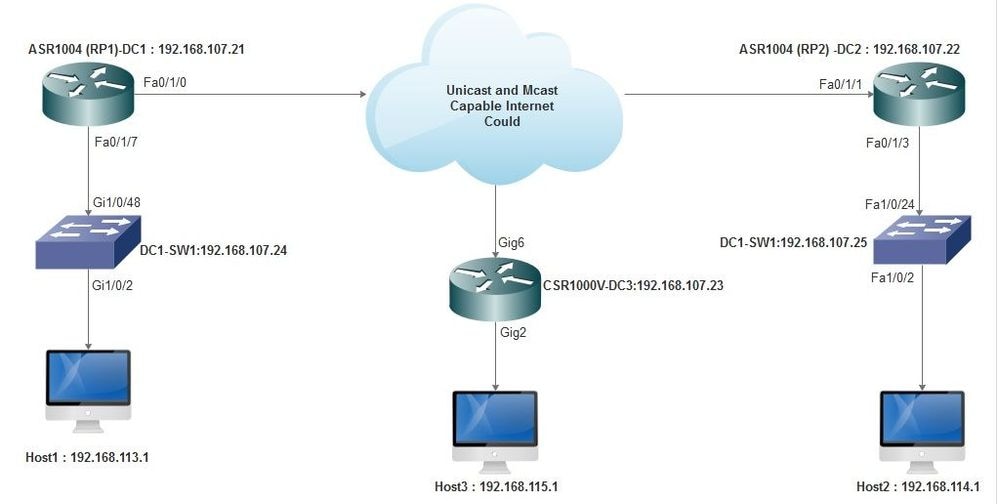

Die Abschnitte Konfigurieren und Überprüfen dieses Dokuments behandeln zwei Szenarien:

- Szenario A beschreibt eine VXLAN-Konfiguration zwischen drei Rechenzentren im Multicast-Modus.

- Szenario B beschreibt eine VXLAN-Konfiguration zwischen zwei Rechenzentren im Unicast-Modus.

Konfigurieren

Szenario A: Konfigurieren von VXLAN zwischen drei Rechenzentren im Multicast-Modus

Basiskonfiguration

Für den Multicast-Modus sind sowohl Unicast- als auch Multicast-Verbindungen zwischen den Standorten erforderlich. In diesem Konfigurationsleitfaden wird Open Shortest Path First (OSPF) für die Bereitstellung von Unicast-Verbindungen und Bidirectional Protocol Independent Multicast (PIM) für die Bereitstellung von Multicast-Verbindungen verwendet.

Nachfolgend finden Sie die Basiskonfiguration aller drei Rechenzentren für den Multicast-Betriebsmodus:

! DC1#show run | sec ospf router ospf 1 network 10.1.1.1 0.0.0.0 area 0 network 10.10.10.4 0.0.0.3 area 0

!

Bidirektionale PIM-Konfiguration:

!

DC1#show run | sec pim ip pim bidir-enable ip pim send-rp-discovery scope 10 ip pim bsr-candidate Loopback1 0 ip pim rp-candidate Loopback1 group-list 10 bidir ! access-list 10 permit 239.0.0.0 0.0.0.255

!

DC1#

!

Darüber hinaus ist der PIM Sparse Mode unter allen L3-Schnittstellen aktiviert, einschließlich des Loopbacks:

!

DC1#show run interface lo1 Building configuration... Current configuration : 83 bytes ! interface Loopback1 ip address 10.1.1.1 255.255.255.255 ip pim sparse-mode end

Stellen Sie außerdem sicher, dass Multicast-Routing auf Ihrem Gerät aktiviert ist und dass die Multicast-Routing-Tabelle ausgefüllt wird.

Netzwerkdiagramm

Unicast- und Multicast-fähiges Internet

Unicast- und Multicast-fähiges Internet

Konfiguration von DC1 (VTEP1)

! ! Vxlan udp port 1024 ! Interface Loopback1 ip address 10.1.1.1 255.255.255.255 ip pim sparse-mode !

Definieren Sie die VNI-Mitglieder und die Mitgliedsschnittstelle unter der Bridge-Domain-Konfiguration:

! bridge-domain 1 member vni 6001 member FastEthernet0/1/7 service-instance 1 !

Erstellen Sie die virtuelle Netzwerkschnittstelle (Network Virtual Interface, NVE), und definieren Sie die VNI-Mitglieder, die über das WAN auf andere Rechenzentren erweitert werden müssen:

! interface nve1 no ip address shut member vni 6001 mcast-group 10.0.0.10 ! source-interface Loopback1 !

Erstellen Sie Service-Instanzen über die LAN-Schnittstelle (d. h. die Schnittstelle, die das LAN-Netzwerk verbindet), um das jeweilige VLAN (802.1q markierter Datenverkehr) zu überlagern. In diesem Fall handelt es sich um VLAN 1:

! interface FastEthernet0/1/7 no ip address negotiation auto cdp enable no shut !

Entfernen Sie den VLAN-Tag, bevor Sie den Datenverkehr über das Overlay senden, und schieben Sie ihn nach dem Senden des zurückkehrenden Datenverkehrs in das VLAN:

! service instance 1 ethernet encapsulation unagged !

Konfiguration von DC2 (VTEP2)

! ! Vxlan udp port 1024 ! interface Loopback1 ip address 10.2.2.2 255.255.255.255 ip pim sparse-mode ! ! bridge-domain 1 member vni 6001 member FastEthernet0/1/3 service-instance 1 ! ! interface nve1 no ip address member vni 6001 mcast-group 10.0.0.10 ! source-interface Loopback1 shut ! ! interface FastEthernet0/1/3 no ip address negotiation auto cdp enable no shut ! service instance 1 ethernet encapsulation untagged !

DC3 (VTEP3)-Konfiguration

! ! Vxlan udp port 1024 ! interface Loopback1 ip address 10.3.3.3 255.255.255.255 ip pim sparse-mode ! ! bridge-domain 1 member vni 6001 member GigabitEthernet2 service-instance 1 ! interface nve1 no ip address shut member vni 6001 mcast-group 10.0.0.10 ! source-interface Loopback1 ! interface gig2 no ip address negotiation auto cdp enable no shut ! service instance 1 ethernet encapsulation untagged !

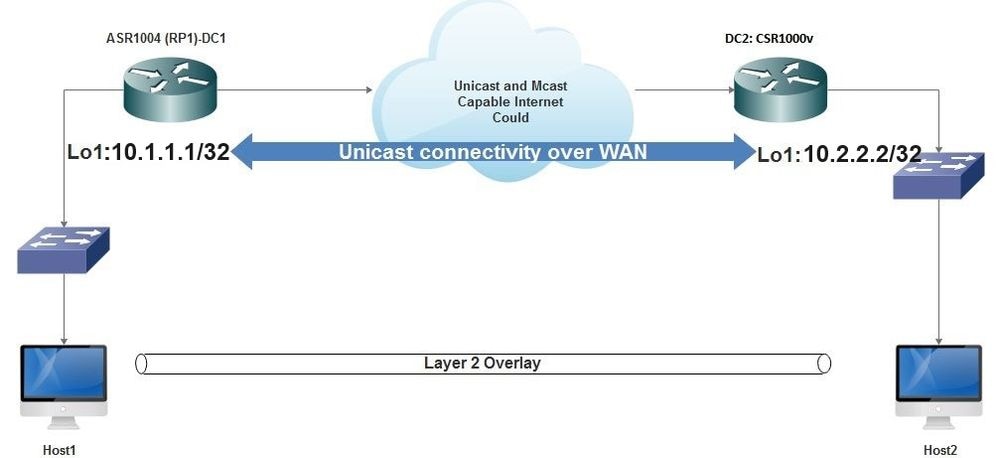

Szenario B: Konfigurieren von VXLAN zwischen zwei Rechenzentren im Unicast-Modus

Netzwerkdiagramm

Unicast-Verbindung über WAN

Unicast-Verbindung über WAN

Konfiguration von RZ1

! interface nve1 no ip address member vni 6001 ! ingress replication shold be configured as peer data centers loopback IP address. ! ingress-replication 10.2.2.2 ! source-interface Loopback1 ! ! interface gig0/2/1 no ip address negotiation auto cdp enable ! service instance 1 ethernet encapsulation untagged ! ! ! bridge-domain 1 member vni 6001 member gig0/2/1 service-instance 1

Konfiguration des RZ2

! interface nve1 no ip address member vni 6001 ingress-replication 10.1.1.1 ! source-interface Loopback1 ! ! interface gig5 no ip address negotiation auto cdp enable ! service instance 1 ethernet encapsulation untagged ! ! bridge-domain 1 member vni 6001 member gig5 service-instance 1

Überprüfung

Szenario A: Konfigurieren von VXLAN zwischen drei Rechenzentren im Multicast-Modus

Nachdem Sie die Konfiguration für Szenario A abgeschlossen haben, müssen die verbundenen Hosts in jedem Rechenzentrum in der Lage sein, sich innerhalb derselben Broadcast-Domäne zu erreichen.

Verwenden Sie diese Befehle, um die Konfigurationen zu überprüfen. Einige Beispiele finden Sie unter Szenario B.

Router#show nve vni Router#show nve vni interface nve1 Router#show nve interface nve1 Router#show nve interface nve1 detail Router#show nve peers

Szenario B: Konfigurieren von VXLAN zwischen zwei Rechenzentren im Unicast-Modus

Auf DC1:

DC1#show nve vni Interface VNI Multicast-group VNI state nve1 6001 N/A Up DC1#show nve interface nve1 detail Interface: nve1, State: Admin Up, Oper Up Encapsulation: Vxlan source-interface: Loopback1 (primary:10.1.1.1 vrf:0) Pkts In Bytes In Pkts Out Bytes Out 60129 6593586 55067 5303698 DC1#show nve peers Interface Peer-IP VNI Peer state nve1 10.2.2.2 6000 -

Auf DC2:

DC2#show nve vni

Interface VNI Multicast-group VNI state

nve1 6000 N/A Up

DC2#show nve interface nve1 detail

Interface: nve1, State: Admin Up, Oper Up Encapsulation: Vxlan

source-interface: Loopback1 (primary:10.2.2.2 vrf:0)

Pkts In Bytes In Pkts Out Bytes Out

70408 7921636 44840 3950835

DC2#show nve peers

Interface Peer-IP VNI Peer state

nve 10.1.1.1 6000 Up

DC2#show bridge-domain 1

Bridge-domain 1 (3 ports in all)

State: UP Mac learning: Enabled

Aging-Timer: 300 second(s)

BDI1 (up)

GigabitEthernet0/2/1 service instance 1

vni 6001

AED MAC address Policy Tag Age Pseudoport

0 7CAD.74FF.2F66 forward dynamic 281 nve1.VNI6001, VxLAN src: 10.1.1.1 dst: 10.2.2.2

0 B838.6130.DA80 forward dynamic 288 nve1.VNI6001, VxLAN src: 10.1.1.1 dst: 10.2.2.2

0 0050.56AD.1AD8 forward dynamic 157 nve1.VNI6001, VxLAN src: 10.1.1.1 dst: 10.2.2.2

Fehlerbehebung

Die Befehle im Abschnitt "Prüfen" enthalten grundlegende Schritte zur Fehlerbehebung. Diese zusätzliche Diagnose kann hilfreich sein, wenn das System nicht funktioniert.

Hinweis: Einige dieser Diagnosen können zu einer erhöhten Arbeitsspeicher- und CPU-Auslastung führen.

Fehlerdiagnose

#debug nve error

*Jan 4 20:00:54.993: NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes cast nodes

*Jan 4 20:00:54.993: NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes cast nodes

*Jan 4 20:00:54.995: NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes eer nodes

*Jan 4 20:00:54.995: NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes

#show nve log error

[01/01/70 00:04:34.130 UTC 1 3] NVE-MGR-STATE ERROR: vni 6001: error in create notification to Tunnel

[01/01/70 00:04:34.314 UTC 2 3] NVE-MGR-PEER ERROR: Intf state force up successful for mcast nodes

[01/01/70 00:04:34.326 UTC 3 3] NVE-MGR-PEER ERROR: Intf state force up successful for peer nodes

[01/01/70 01:50:59.650 UTC 4 3] NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes

[01/01/70 01:50:59.654 UTC 5 3] NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes

[01/01/70 01:50:59.701 UTC 6 3] NVE-MGR-PEER ERROR: Intf state force up successful for mcast nodes

[01/01/70 01:50:59.705 UTC 7 3] NVE-MGR-PEER ERROR: Intf state force up successful for peer nodes

[01/01/70 01:54:55.166 UTC 8 61] NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes

[01/01/70 01:54:55.168 UTC 9 61] NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes

[01/01/70 01:55:04.432 UTC A 3] NVE-MGR-PEER ERROR: Intf state force up successful for mcast nodes

[01/01/70 01:55:04.434 UTC B 3] NVE-MGR-PEER ERROR: Intf state force up successful for peer nodes

[01/01/70 01:55:37.670 UTC C 61] NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes

#show nve log event

[01/04/70 19:48:51.883 UTC 1DD16 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:48:51.884 UTC 1DD17 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:48:51.884 UTC 1DD18 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.884 UTC 1DD19 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.884 UTC 1DD1A 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.885 UTC 1DD1B 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.885 UTC 1DD1C 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.886 UTC 1DD1D 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.886 UTC 1DD1E 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.887 UTC 1DD1F 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.887 UTC 1DD20 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:21.884 UTC 1DD21 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

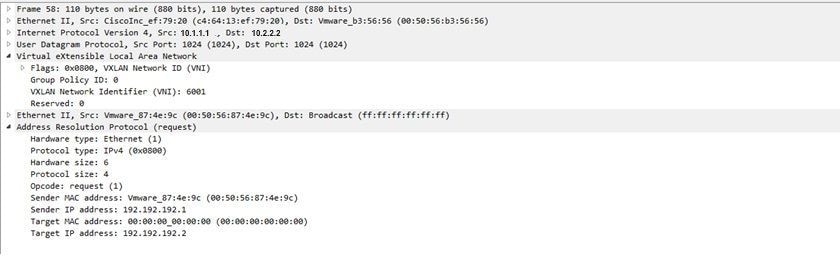

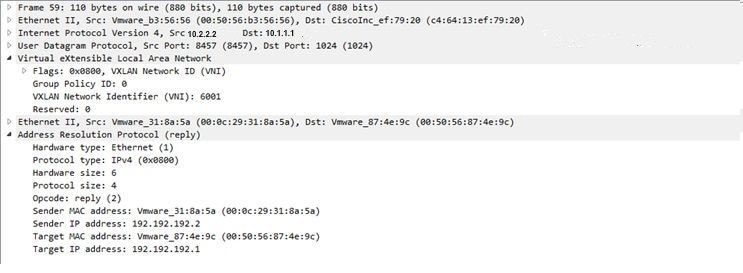

Integrierte Paketerfassung

Integrierte PaketerfassungDie in der Cisco IOS XE-Software verfügbare Embedded Packet Capture (EPC)-Funktion kann zusätzliche Informationen zur Fehlerbehebung bereitstellen.

In dieser Erfassung wird beispielsweise erklärt, welches Paket von VXLAN gekapselt wird:

EPC-Konfiguration (TEST_ACL ist die Zugriffsliste, die zum Filtern der Erfassungsdaten verwendet wird):

#monitor capture TEST access-list TEST_ACL interface gigabitEthernet0/2/0 both #monitor capture TEST buffer size 10 #monitor capture TEST start Die folgenden Paketspeicherabbilder werden generiert:

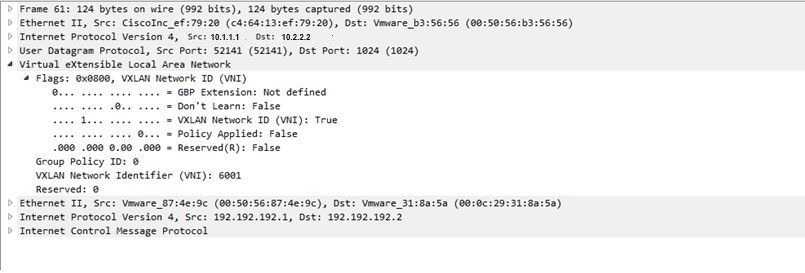

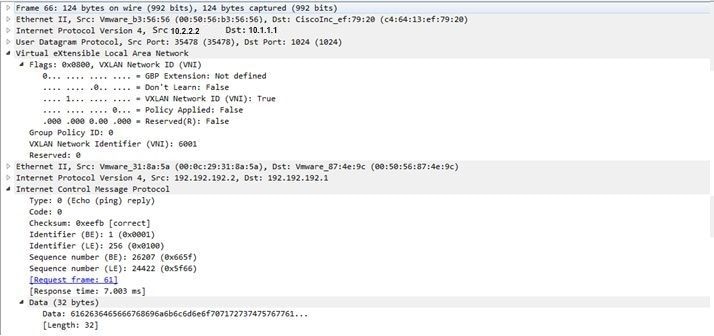

# show monitor capture TEST buffer dump # monitor capture TEST export bootflash:TEST.pcap // with this command you can export the capture in pcap format to the bootflash, which can be downloaded and opened in wireshark. Im folgenden Beispiel wird erläutert, wie das Internet Control Message Protocol (ICMP) über VXLAN funktioniert.

Address Resolution Protocol (ARP), gesendet über VXLAN-Overlay:

ARP-Antwort:

ICMP-Anforderung:

ICMP-Antwort:

Zusätzliche Befehle zum Debuggen und zur Fehlerbehebung

Zusätzliche Befehle zum Debuggen und zur FehlerbehebungIn diesem Abschnitt werden einige weitere Befehle zum Debuggen und zur Fehlerbehebung beschrieben.

In diesem Beispiel zeigen die hervorgehobenen Teile des Debugging, dass die NVE-Schnittstelle nicht der Multicast-Gruppe beitreten konnte. Daher wurde die VXLAN-Kapselung für VNI 6002 nicht aktiviert. Diese Debugergebnisse weisen auf Multicast-Probleme im Netzwerk hin.

#debug nve all

*Jan 5 06:13:55.844: NVE-MGR-DB: creating mcast node for 10.0.0.10

*Jan 5 06:13:55.846: NVE-MGR-MCAST: IGMP add for (0.0.0.0,10.0.0.10) was failure

*Jan 5 06:13:55.846: NVE-MGR-DB ERROR: Unable to join mcast core tree

*Jan 5 06:13:55.846: NVE-MGR-DB ERROR: Unable to join mcast core tree

*Jan 5 06:13:55.846: NVE-MGR-STATE ERROR: vni 6002: error in create notification to mcast

*Jan 5 06:13:55.846: NVE-MGR-STATE ERROR: vni 6002: error in create notification to mcast

*Jan 5 06:13:55.849: NVE-MGR-TUNNEL: Tunnel Endpoint 10.0.0.10 added

*Jan 5 06:13:55.849: NVE-MGR-TUNNEL: Endpoint 10.0.0.10 added

*Jan 5 06:13:55.851: NVE-MGR-EI: Notifying BD engine of VNI 6002 create

*Jan 5 06:13:55.857: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:13:55.857: NVE-MGR-EI: VNI 6002: BD state changed to up, vni state to Down

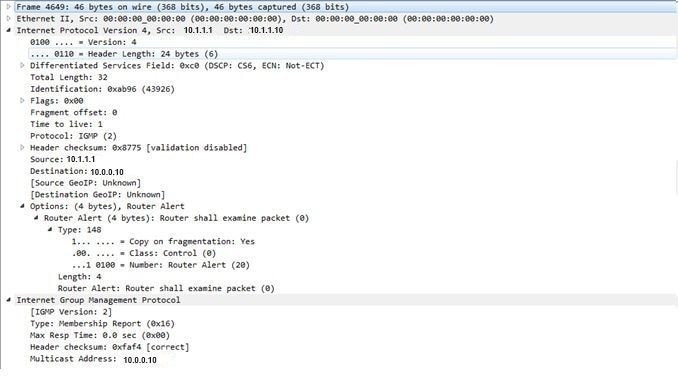

Nachfolgend finden Sie den IGMP-Mitgliedsbericht (Internet Group Management Protocol), der gesendet werden kann, sobald der VNI der Mcast-Gruppe beitritt:

In diesem Beispiel wird das erwartete Debug-Ergebnis nach der Konfiguration eines VNI unter NVE für den Multicast-Modus angezeigt, wenn Multicast wie erwartet funktioniert:

*Jan 5 06:19:20.335: NVE-MGR-DB: [IF 0x14]VNI node creation

*Jan 5 06:19:20.335: NVE-MGR-DB: VNI Node created [437C9B28]

*Jan 5 06:19:20.336: NVE-MGR-PD: VNI 6002 create notification to PD

*Jan 5 06:19:20.336: NVE-MGR-PD: VNI 6002 Create notif successful, map [pd 0x1020017] to [pi 0x437C9B28]

*Jan 5 06:19:20.336: NVE-MGR-DB: creating mcast node for 10.0.0.10

*Jan 5 06:19:20.342: NVE-MGR-MCAST: IGMP add for (0.0.0.0,10.0.0.10) was successful

*Jan 5 06:19:20.345: NVE-MGR-TUNNEL: Tunnel Endpoint 10.0.0.10 added

*Jan 5 06:19:20.345: NVE-MGR-TUNNEL: Endpoint 10.0.0.10 added

*Jan 5 06:19:20.347: NVE-MGR-EI: Notifying BD engine of VNI 6002 create

*Jan 5 06:19:20.347: NVE-MGR-DB: Return pd_hdl[0x1020017] for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.347: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.349: NVE-MGR-DB: Return vni state Create for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.349: NVE-MGR-DB: Return vni state Create for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.349: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.351: NVE-MGR-EI: L2FIB query for info 0x437C9B28

*Jan 5 06:19:20.351: NVE-MGR-EI: PP up notification for bd_id 3

*Jan 5 06:19:20.351: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.352: NVE-MGR-STATE: vni 6002: Notify clients of state change Create to Up

*Jan 5 06:19:20.352: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.353: NVE-MGR-PD: VNI 6002 Create to Up State update to PD successful

*Jan 5 06:19:20.353: NVE-MGR-EI: VNI 6002: BD state changed to up, vni state to Up

*Jan 5 06:19:20.353: NVE-MGR-STATE: vni 6002: No state change Up

*Jan 5 06:19:20.353: NVE-MGR-STATE: vni 6002: New State as a result of create Up

Zugehörige Informationen

Zugehörige Informationen Revisionsverlauf

| Überarbeitung | Veröffentlichungsdatum | Kommentare |

|---|---|---|

2.0 |

04-Dec-2023 |

Rezertifizierung |

1.0 |

03-Nov-2016 |

Erstveröffentlichung |

Beiträge von Cisco Ingenieuren

- Shambhu MishraCisco TAC Engineer

Cisco kontaktieren

- Eine Supportanfrage öffnen

- (Erfordert einen Cisco Servicevertrag)

Feedback

Feedback