Fehlerbehebung bei Punt Fabric Data Path Failure auf Tomahawk und Lightspeed Card

Download-Optionen

-

ePub (3.7 MB)

In verschiedenen Apps auf iPhone, iPad, Android, Sony Reader oder Windows Phone anzeigen

Inklusive Sprache

In dem Dokumentationssatz für dieses Produkt wird die Verwendung inklusiver Sprache angestrebt. Für die Zwecke dieses Dokumentationssatzes wird Sprache als „inklusiv“ verstanden, wenn sie keine Diskriminierung aufgrund von Alter, körperlicher und/oder geistiger Behinderung, Geschlechtszugehörigkeit und -identität, ethnischer Identität, sexueller Orientierung, sozioökonomischem Status und Intersektionalität impliziert. Dennoch können in der Dokumentation stilistische Abweichungen von diesem Bemühen auftreten, wenn Text verwendet wird, der in Benutzeroberflächen der Produktsoftware fest codiert ist, auf RFP-Dokumentation basiert oder von einem genannten Drittanbieterprodukt verwendet wird. Hier erfahren Sie mehr darüber, wie Cisco inklusive Sprache verwendet.

Informationen zu dieser Übersetzung

Cisco hat dieses Dokument maschinell übersetzen und von einem menschlichen Übersetzer editieren und korrigieren lassen, um unseren Benutzern auf der ganzen Welt Support-Inhalte in ihrer eigenen Sprache zu bieten. Bitte beachten Sie, dass selbst die beste maschinelle Übersetzung nicht so genau ist wie eine von einem professionellen Übersetzer angefertigte. Cisco Systems, Inc. übernimmt keine Haftung für die Richtigkeit dieser Übersetzungen und empfiehlt, immer das englische Originaldokument (siehe bereitgestellter Link) heranzuziehen.

Inhalt

Einleitung

In diesem Dokument werden Fehlermeldungen über Datenpfade in der einzelnen Fabric beschrieben, die beim Betrieb des Cisco Aggregation Services Routers (ASR) der Serie 9000 aufgetreten sind.

Hintergrundinformationen

Die Meldung wird in folgendem Format angezeigt:

- Alarme werden auf der Router-Konsole angezeigt, wie hier gezeigt.

- Das bedeutet, dass der Loopback-Pfad dieser Nachrichten an einer beliebigen Stelle unterbrochen wird.

RP/0/RP0/CPU0:Oct 28 12:46:58.459 IST: pfm_node_rp[349]: %PLATFORM-DIAGS-3-PUNT_FABRIC_DATA_PATH_FAILED :

Set|online_diag_rsp[24790]|System Punt/Fabric/data Path Test(0x2000004)|failure threshold is 3,

(slot, NP) failed: (0/9/CPU0, 1) (0/9/CPU0, 3)

Das Problem tritt bei NP1 und NP3 auf dem zuvor erwähnten 0/9/CPU0 auf.

Dieses Dokument richtet sich an alle, die die Fehlermeldung und die Aktionen verstehen möchten, die bei Auftreten des Problems durchgeführt werden müssen.

Die Tomahawk-basierte Line Card (LC) ist entweder als Service Edge Optimized (Enhanced QoS) oder Packet Transport Optimized (Basic QoS) LC erhältlich.

- SE = Services Edge Optimized

- TR = Packet Transport Optimized

Der 100-Gigabit-Ethernet-LC mit 4 und 8 Ports ist in zwei Varianten erhältlich, die entweder LAN/WAN/OTN Unified PHY CPAK-Ports oder LAN PHY-only CPAK-Ports unterstützen.

Diese LCs basieren auf Tomahawk:

- A9K-8X100G-LB-SE

- A9K-8X100G-LB-TR

- A9K-8X100GE-SE

- A9K-8X100GE-TR

- A9K-4X100GE-SE

- A9K-4X100GE-TR

- A9K-400G-DWDM-TR

- A9K-MOD400-SE

- A9K-MOD400-TR

- A9K-MOD200-SE

- A9K-MOD200-TR

- A9K-24X10GE-1G-SE

- A9K-24X10GE-1G-TR

- A9K-48X10GE-1G-SE

- A9K-48X10GE-1G-TR

- A99-12 X 100 GE

- A99-8X100GE-SE

- A99-8X100GE-TR

Anmerkung: Tomahawk-basierte LC-Teilenummern, die mit A99-X beginnen, sind mit den Chassis Cisco ASR 9904, ASR 9906, ASR 9910, ASR 9912 und ASR 9922 kompatibel. Sie sind nicht mit den Cisco Routern ASR 9006 und ASR 9010 kompatibel.

Lightspeed-basierte LCs können entweder als Service Edge Optimized (erweiterte QoS)- oder Packet Transport Optimized (grundlegende QoS)-LCs verfügbar sein. Im Gegensatz zu Tomahawk-basierten LCs ist nicht jedes LC-Modell sowohl in den Typen -SE als auch -TR verfügbar.

- SE = Services Edge Optimized

- TR = Packet Transport Optimized

Diese LCs basieren auf Lightspeed:

- A9K-16X100GE-TR

- A99-16X100GE-X-SE

- A99-32 X 100GE-TR

Lightspeed-Plus (LSP)-basierte LCs sind entweder als Service Edge Optimized (Enhanced QoS)- oder Packet Transport Optimized (Basic QoS)-LCs erhältlich.

Diese LCs sind LSP-basiert:

- A9K-4HG-FLEX-TR

- A9K-4HG-FLEX-SE

- A99-4HG-FLEX-TR

- A99-4HG-FLEX-SE

- A9K-8HG-FLEX-TR

- A9K-8HG-FLEX-SE

- A9K-20HG-FLEX-TR

- A9K-20HG-FLEX-SE

- A99-32 X 100GE-X-TR

- A99-32X100GE-X-SE

- A99-10X400GE-X-TR

- A99-10X400GE-X-SE

Punt-Fabric-Diagnosepaketpfad

- Die Diagnoseanwendung, die auf der CPU der Routingprozessorkarte ausgeführt wird, sendet regelmäßig Diagnosepakete ein, die für jeden Netzwerkprozessor (NP) bestimmt sind.

- Das Diagnosepaket befindet sich innerhalb des NP und wird wieder in die CPU der Routingprozessorkarte eingespeist, von der das Paket stammt.

- Diese regelmäßige Integritätsprüfung jedes NP mit einem eindeutigen Paket pro NP durch die Diagnoseanwendung auf der Routingprozessorkarte gibt eine Warnung für Funktionsfehler auf dem Datenpfad während des Routerbetriebs aus.

- Es muss unbedingt darauf hingewiesen werden, dass die Diagnoseanwendung sowohl auf dem aktiven Routingprozessor als auch auf dem Standby-Routingprozessor periodisch ein Paket pro NP einfügt und eine Erfolgs- oder Fehleranzahl pro NP aufrechterhält.

- Jede Minute wird ein Diagnosepaket an NP gesendet (an jede Virtual Queues Interface (VQI) viermal (insgesamt vier Minuten/VQI) und läuft über alle VQIs dieses NP). Um dies kurz zu machen, ist hier ein Beispiel:

Wenn man bedenkt, dass der LC über vier NPs verfügt, muss die Online-Diagnose für alle NPs durchgeführt werden (um sicherzustellen, dass sie fehlerfrei sind - Fabric-Pfade). Jetzt kann jeder NP über 20 VQIs verfügen (0-19, 20-39, 40-59, 60-79).

In der ersten Minute sendet die Online-Diagnose ein Paket an jeden NP.

1 min : against VQI 0, 20, 40, 60 (to all 4 NPs)

2 min:""""""""

3 min: """""""

4 min : """""

5th min : against VQI 1, 21, 41, 61..

6 min : """"""""

Dieser Vorgang wiederholt sich in einem Zyklus, sobald alle VQI abgeschlossen sind.

- Wenn ein Schwellenwert für verlorene Diagnosepakete erreicht wird, löst die Anwendung einen Alarm im Platform Fault Manager (PFM) aus.

RP/0/RP1/CPU0:AG2-2#show pfm location 0/RP1/CPU0

node: node0_RP0_CPU0

---------------------

CURRENT TIME: Apr 7 01:04:04 2022PFM TOTAL: 1 EMERGENCY/ALERT(E/A): 0 CRITICAL(CR): 0 ERROR(ER): 1

-------------------------------------------------------------------------------------------------

Raised Time |S#|Fault Name |Sev|Proc_ID|Dev/Path Name |Handle

--------------------+--+-----------------------------------+---+-------+--------------+----------

Apr 7 00:54:52 2022|0 |PUNT_FABRIC_DATA_PATH_FAILED |ER |10042 >>ID |System Punt/Fa|0x2000004

Um alle Informationen über PFM-Alarme zu erfassen, müssen Sie die folgende Befehlsausgabe erfassen:

show pfm location all

show pfm trace location all

Wenn Sie weitere Informationen über Alarme anzeigen möchten, die von einem bestimmten Prozess ausgelöst werden, können Sie den folgenden Befehl verwenden:

show pfm process name <process_name> location <location> >>> location where the PFM alarm is observed

High-Level-LC-Architektur

Tomahawk LC

8 x 100 G Architektur

Tomahawk - 8 x 100 G LC

Tomahawk - 8 x 100 G LC

12 x 100-G-Architektur

Tomahawk 12 x 100 G LC

Tomahawk 12 x 100 G LC

LC

A9K-20HG-FLEX-SE/TR

A9K-20HG-FLEX-SE/TR

A9K-20HG-FLEX-SE/TR

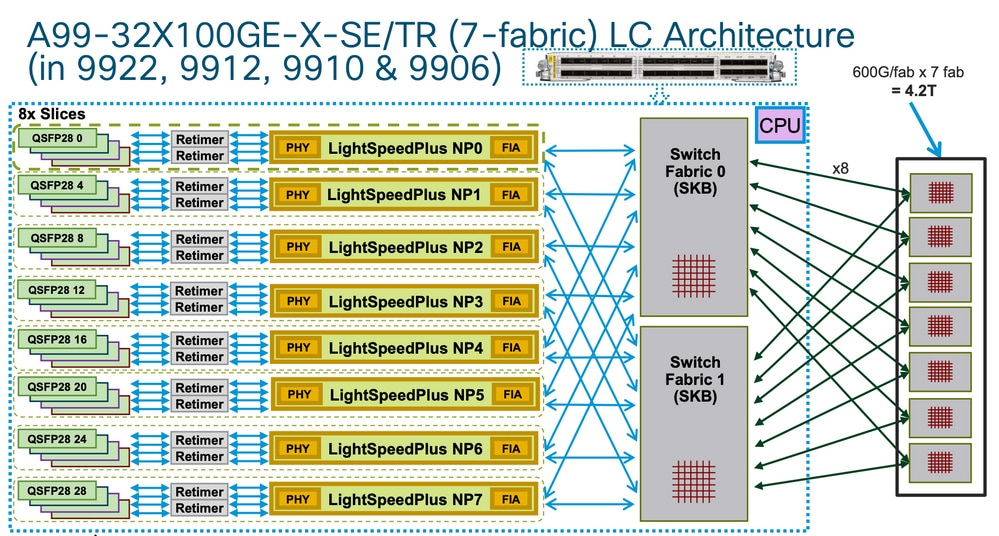

A99-32 x 100GE-X-SE/TR

A99-32 x 100GE-X-SE/TR

A99-32 x 100GE-X-SE/TR

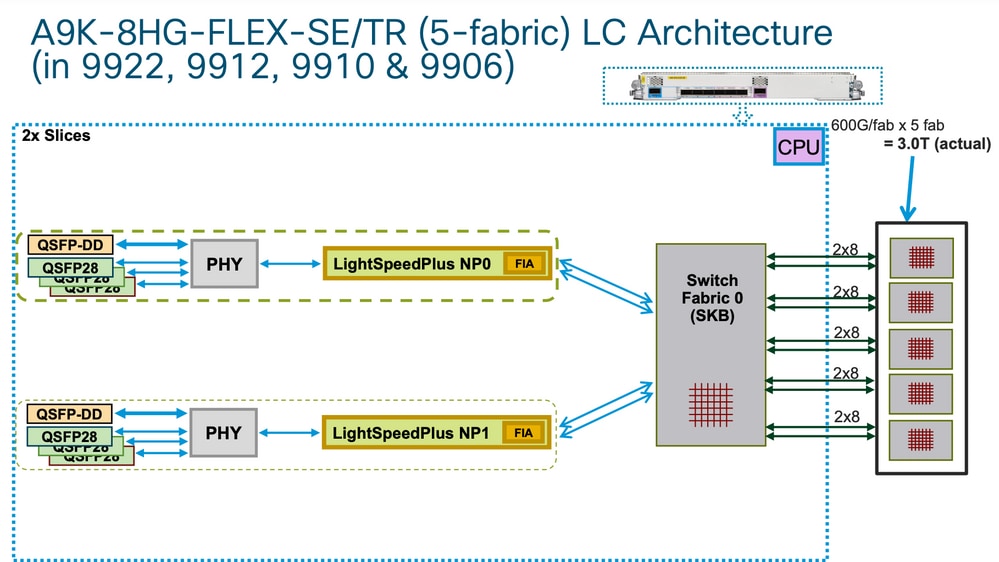

A9K-8HG-FLEX-SE/TR

LC-Architektur

LC-Architektur

LC-Architektur

LC-Architektur

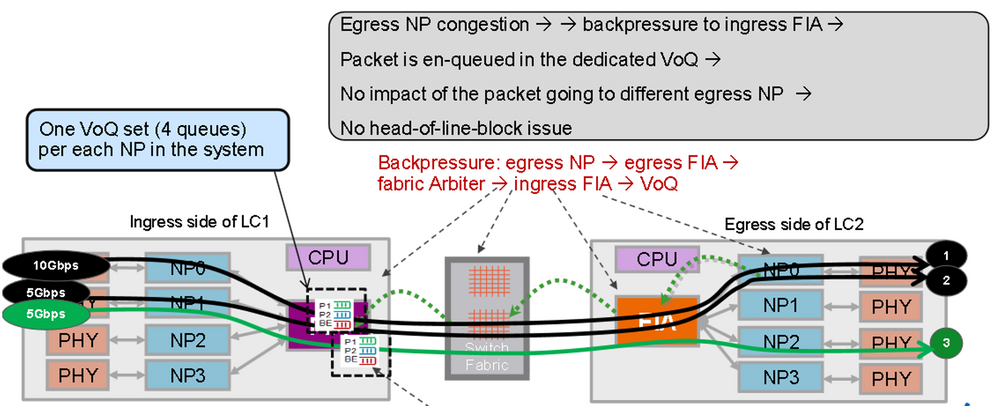

Virtuelle Ausgabewarteschlangen und der Arbiter

Jeder Route Switch Processor/Switch Processor (RSP/RP) verfügt über zwei Fabric-Chips, die beide von einem gemeinsamen Arbiter gesteuert werden (duale RSPs/RPs bedeuten ausfallsichere Arbiter pro Chassis). Nur der Arbiter auf dem aktiven RSP/RP steuert alle vier Fabric-Chips (unter Annahme von dualen RSPs). Beide Arbiter empfangen jedoch die Fabric-Zugriffsanforderungen, um jederzeit den Status des gesamten Systems zu kennen, sodass ein sofortiges Failover zwischen RSPs/RPs möglich ist. Es gibt keinen Keepalive zwischen den Arbitern, aber die RSPs/RPs haben einen Complex Programmable Logic Device (CPLD) ASIC (ähnlich einem FPGA) und eine seiner Funktionen besteht darin, den anderen RSP/RP-Zustand über Low-Level-Keepalives zu verfolgen und festzustellen, welcher der aktive Arbiter ist.

Jeder Fabric Interconnect ASIC verfügt über eine Reihe von VQIs, d. h. eine Reihe von Warteschlangen, die eine 100-G-Einheit im System (für Tomahawk) darstellen. Jede 100-G-Einheit (1 x 100-G-Ports auf einem einzelnen Ausgangs-NP werden mit einem einzelnen 100-G-VQI in einem Eingangs-NP dargestellt) verfügt über mehrere Prioritätsklassen.

Jeder VQI verfügt über vier Virtual Output Queues (VOQs) für unterschiedliche Paketprioritäten, von denen drei in der Weiterleitungsarchitektur des ASR 9000 verwendet werden. Diese entsprechen den Prioritätsstufen 1 und 2 und werden standardmäßig in die Eingangs-QoS-Richtlinie übernommen. Es gibt zwei Warteschlangen mit strikter Priorität und eine normale Warteschlange (die vierte Warteschlange ist für Multicast vorgesehen und wird nicht für die Unicast-Weiterleitung verwendet).

Im Allgemeinen beginnt die Standardwarteschlange, Pakete zuerst während des Gegendrucks von den Ausgangs-NP-VQIs zu verwerfen. Nur wenn die Ausgangs-Netzwerkverarbeitungseinheit (NPU) überlastet wird (mehr Bps oder PPS liefert, als die Schaltkreise verarbeiten können), übt sie Gegendruck auf den Eingangs-LC/NP aus. Dies wird durch eine Unterbrechung des VQI-Flusses auf dem Fabric Interface ASIC (FIA) an diesem Eingangs-LC dargestellt.

Beispiel:

RP/0/RP0/CPU0:AG3_1#show controllers np ports all location 0/0/CPU0 >>> LC0 is installed in slot 2

Node: 0/0/CPU0:

----------------------------------------------------------------

NP Bridge Fia Ports

-- ------ --- ---------------------------------------------------

0 -- 0 TenGigE0/0/0/0/0 - TenGigE0/0/0/0/9, TenGigE0/0/0/1/0 - TenGigE0/0/0/1/9

1 -- 1 TenGigE0/0/0/2/0 - TenGigE0/0/0/2/9, HundredGigE0/0/0/3

2 -- 2 HundredGigE0/0/0/4 - HundredGigE0/0/0/5 >>>Below is the VQI assignment

3 -- 3 HundredGigE0/0/0/6 - HundredGigE0/0/0/7

RP/0/RP0/CPU0:AG3_1#sh controller fabric vqi assignment slot 2

slot = 2

fia_inst = 2 >>>FIA 2

VQI = 40 SPEED_100G

VQI = 41 SPEED_100G

VQI = 42 SPEED_100G

VQI = 43 SPEED_100G

VQI = 44 SPEED_100G

VQI = 45 SPEED_100G

VQI = 46 SPEED_100G

VQI = 47 SPEED_100G

VQI = 56 SPEED_100G

VQI = 57 SPEED_100G

VQI = 58 SPEED_100G

VQI = 59 SPEED_100G

VQI = 60 SPEED_100G

VQI = 61 SPEED_100G

VQI = 62 SPEED_100G

VQI = 63 SPEED_100G

Wenn der Eingangs-LC beschließt, ein bestimmtes Paket an eine bestimmte Ausgangs-NPU zu senden, hat die MDF-Stufe (Modify) des Eingangs-LC ein Paket mit einem Fabric-Ziel-Header gekapselt. Wenn die FIA diese "Adresse" betrachtet, überprüft sie den VOQ für die jeweilige Ausgangs-NPU/das Ziel/den LC und erkennt, ob genügend Bandbreite verfügbar ist. Wenn sie bereit ist, die Warteschlange für diesen LC zu deaktivieren, fordert die Eingangs-FIA eine Freigabe für diesen Ziel-LC von der Fabric (dem Arbiter) an. Der Arbitrierungsalgorithmus ist QoS-fähig. Er stellt sicher, dass Pakete der P1-Klasse gegenüber der P2-Klasse bevorzugt werden usw. Der Schiedsrichter leitet die Zuschussanforderung von der Eingangs-FIA an die Ausgangs-FIA weiter.

Die Eingangs-FIA kann mehrere Pakete zu demselben Ausgangs-LC in einen so genannten Superframe gruppieren. Dies bedeutet, dass nicht native Frames/Pakete über die Switch-Fabric-Links geleitet werden, sondern Superframes. Dies ist wichtig zu beachten, da in einem Test mit konstanten 100pps die CLI anzeigen kann, dass die Fabric-Zähler nur 50pps melden. Dies bedeutet nicht, dass Pakete verloren gehen, sondern lediglich, dass in jedem Superframe zwei Pakete über die Switch-Fabric übertragen werden. Superframes enthalten Sequenzierungsinformationen, und FIAs unterstützen die Neuordnung (Pakete können über mehrere Fabric-Links verteilt werden). Nur Unicast-Pakete werden in Superframes platziert, keine Multicast-Pakete.

Sobald das Paket vom Egress-LC empfangen wurde, wird der Grant an den Arbiter zurückgegeben. Der Arbiter hat eine begrenzte Anzahl von Token pro VOQ. Wenn der Arbiter der Eingangs-FIA erlaubt, einen (Super-) Frame an einen bestimmten VOQ zu senden, wird dieser Token nur dann an den Pool zurückgegeben, wenn die Ausgangs-FIA die Frames an den Ausgangs-NP liefert. Hat der Ausgangs-NP ein Gegendrucksignal an den Ausgangs-FIA angehoben, bleibt der Token belegt. So gehen dem Arbiter schließlich die Token für diesen VOQ in der Eingangs-FIA aus. In diesem Fall verwirft die Eingangs-FIA die eingehenden Pakete. Der Auslöser für den Gegendruck ist der Auslastungsgrad der RFD-Puffer (Receive Frame Descriptor) in einem Ausgangs-NP. RFD-Puffer halten die Pakete, während sie vom NP-Mikrocode verarbeitet werden. Je mehr Funktionen das Paket verarbeitet, desto länger bleibt es in RFD-Puffern.

- Eingangs-FIA stellt Fabric-Anforderungen an alle Chassis-Arbiter.

- Der aktive Arbiter prüft auf Freezugriff-Berechtigungs-Token und verarbeitet seinen QoS-Algorithmus, wenn eine Überlastung vorliegt.

- Kreditmechanismus vom lokalen Arbiter zum aktiven Arbiter auf RSP.

- Aktiver Arbiter sendet Fabric-Grant-Token an eingehende FIA.

- Eingangs-FIA-Lastenausgleich (Super-)Frames über Fabric-Verbindungen

- Ausgangs-FIA gibt einen Fabric-Token an den zentralen Arbiter zurück.

Besser zu erwähnen, der Kreditmechanismus vom lokalen Arbiter zum aktiven Arbiter auf RSP. Fügen Sie auch einen anderen Abschnitt, um mögliche Fälle von Arbiter-Fehler (brauchen nicht zu erwähnen Fehlercodes, sondern einen Blick auf Arbiter ASIC-Fehler) zu betrachten, im Falle eines Arbiter-Problem und nicht erhalten Zuschüsse aufgrund der lokalen oder zentralen Arbiter und das verursacht Warteschlangen stapeln.

Überblick über virtuelle Ausgabewarteschlangen

Virtuelle Ausgabewarteschlange

Virtuelle Ausgabewarteschlange

Pakete, die an verschiedene Ausgangs-NPs geleitet werden, werden in unterschiedlichen VOQ-Sätzen abgelegt. Eine Überlastung auf einem NP blockiert nicht das Paket, das an verschiedene NPs weitergeleitet wird.

Fabric-Arbiter-Diagramm

Fabric-Arbiter

Fabric-Arbiter

Fabric Interconnects

ASR9006 und ASR9010 Switch Fabric Interconnects

ASR9006 und ASR9010 Switch Fabric Interconnects

ASR9006 und ASR9010 Switch Fabric Interconnects

ASR9922 Switch Fabric Interconnects

Der ASR9912 ist identisch mit der Unterstützung von nur 10 LCs und einem einzelnen Fabric Interconnect-Chip.

ASR9922 Switch Fabric Interconnects

ASR9922 Switch Fabric Interconnects

ASR9922 und ASR9912 Backplane

ASR9922 und ASR9912 Backplane

ASR9922 und ASR9912 Backplane

Überblick über die Online-Diagnose

- Das Online-Diagnose-Tool wird sowohl auf LC- als auch auf RP-CPU ausgeführt.

- Folgende Diagnosetests testen den Weiterleitungspfad:

- PuntFabricDataPath-Test wird auf aktiver und Standby-RP-CPU ausgeführt und sendet Diagnosepakete an jeden aktiven NP im System. Aktiver RP sendet.

- PuntFabricDataPath-Diagnosepakete als Unicast, Standby dagegen sendet sie als Multicast. Antwortpakete werden an die ursprüngliche RP-CPU zurückgesendet.

- Folgende Diagnosetests testen den Weiterleitungspfad:

- NP-Loopback-Test in LC.

- NPULoopback-Test wird auf jeder LC-CPU ausgeführt und sendet Diagnosepakete an jeden NP. Antwortpakete werden an die LC-CPU zurückgesendet.

Testen des Problems

Die hier beschriebenen Schritte enthalten einige Hinweise, wie Sie die Probleme im Zusammenhang mit dem Punt-Pfad-Fehler eingrenzen können. Sie müssen nicht in der exakt gleichen Reihenfolge ausgeführt werden.

Erforderliche Informationen zum Starten der Triage

- Betroffenen NP und LC ermitteln:

show logging | inc “PUNT_FABRIC_DATA_PATH”

RP/0/RP1/CPU0:Oct 28 12:46:58.459 IST: pfm_node_rp[349]: %PLATFORM-DIAGS-3-PUNT_FABRIC_DATA_PATH_FAILED :

Set|online_diag_rsp[24790]|System Punt/Fabric/data Path Test(0x2000004)|failure threshold is 3, (slot, NP)

failed: (0/9/CPU0, 1) (0/9/CPU0, 3)

Das Problem tritt bei NP1 und NP3 auf dem zuvor erwähnten 0/9/CPU0 auf.

- Um den Chassis-Steckplatz zu finden, geben Sie den

run nslot allBefehl ein. - PFM-Alarm

RP/0/RP1/CPU0:AG2-2#show pfm location 0/RP1/CPU0

node: node0_RP1_CPU0

---------------------

CURRENT TIME: Mar 25 12:11:29 2022

PFM TOTAL: 1 EMERGENCY/ALERT(E/A): 0 CRITICAL(CR): 0 ERROR(ER): 1

-------------------------------------------------------------------------------------------------

Raised Time |S#|Fault Name |Sev|Proc_ID|Dev/Path Name |Handle

--------------------+--+-----------------------------------+---+-------+--------------+----------

Mar 25 12:03:30 2022|1 |PUNT_FABRIC_DATA_PATH_FAILED |ER |8947 |System Punt/Fa|0x2000004

RP/0/RP1/CPU0:AG2-2#sh pfm process 8947 location 0/rp1/CPU0

node: node0_RP1_CPU0

---------------------

CURRENT TIME: Mar 25 12:12:36 2022

PFM TOTAL: 1 EMERGENCY/ALERT(E/A): 0 CRITICAL(CR): 0 ERROR(ER): 1

PER PROCESS TOTAL: 0 EM: 0 CR: 0 ER: 0

Device/Path[1 ]:Fabric loopbac [0x2000003 ] State:RDY Tot: 0

Device/Path[2 ]:System Punt/Fa [0x2000004 ] State:RDY Tot: 1

1 Fault Id: 432

Sev: ER

Fault Name: PUNT_FABRIC_DATA_PATH_FAILED

Raised Timestamp: Mar 25 12:03:30 2022

Clear Timestamp: Mar 25 12:07:32 2022

Changed Timestamp: Mar 25 12:07:32 2022

Resync Mismatch: FALSE

MSG: failure threshold is 3, (slot, NP) failed: (0/9/CPU0, 1) (0/9/CPU0, 3)

Diagnosepaket - Flussdiagramm

- DIAG-Nachrichten Paketpfad zwischen RP und LC (das Diagnose-Paketintervall beträgt eine Minute).

Paketpfad auf RP:

online_diags <===> SPP <===> Fabric <===> NP

Paketpfad auf LC:

online_diags <===> SPP <===> Punt-switch <====> NP

- NP-Loopback-Test in LC

Jede Minute wird ein DIAGS-Paket pro NP von der LC-CPU zum Punt-Switch eingespeist, und alle werden zu den NPs zurückgeschleift. Sie gehen überhaupt nicht in den Stoff. Der Wendepunkt oder die Halbwertsmarke ist der Mikrocode jedes NP.

- Diagnosesendepfad: LC: Online-Diagnose > Inject > LC-NP > (loop)

- Diagnoserückgabepfad: LC-NP > Punt > Online-Diagnose: LC

Diagnosetest

RP/0/RP0/CPU0:AG2-2(admin)#show diagnostic content location <> >>> (in cXR)

RP/0/RP0/CPU0:AG2-2#show diagnostic content location <> >>> (in eXR)

A9K-8X100GE-L-SE 0/0/CPU0:

Diagnostics test suite attributes:

M/C/* - Minimal bootup level test / Complete bootup level test / NA

B/O/* - Basic ondemand test / not Ondemand test / NA

P/V/* - Per port test / Per device test / NA

D/N/* - Disruptive test / Non-disruptive test / NA

S/* - Only applicable to standby unit / NA

X/* - Not a health monitoring test / NA

F/* - Fixed monitoring interval test / NA

E/* - Always enabled monitoring test / NA

A/I - Monitoring is active / Monitoring is inactive

n/a - Not applicable

Test Interval Thre- Timeout

ID Test Name Attributes (day hh:mm:ss.ms shold ms )

==== ================================== ============ ================= ===== =====

1) CPUCtrlScratchRegister ----------> *B*N****A 000 00:01:00.000 3 n/a

2) DBCtrlScratchRegister -----------> *B*N****A 000 00:01:00.000 3 n/a

3) PortCtrlScratchRegister ---------> *B*N****A 000 00:01:00.000 3 n/a

4) PHYScratchRegister --------------> *B*N****A 000 00:01:00.000 3 n/a

5) NPULoopback ---------------------> *B*N****A 000 00:01:00.000 3 n/a

RP/0/RP0/CPU0:AG2-2#show diagnostic result location 0/0/CPU0

A9K-8X100GE-L-SE 0/0/CPU0:

Overall diagnostic result: PASS

Diagnostic level at card bootup: bypass

Test results: (. = Pass, F = Fail, U = Untested)

1 ) CPUCtrlScratchRegister ----------> .

2 ) DBCtrlScratchRegister -----------> .

3 ) PortCtrlScratchRegister ---------> .

4 ) PHYScratchRegister --------------> .

5 ) NPULoopback ---------------------> .

- Sie können den Parameter "inject diags packages" wie in diesem Beispiel beschrieben manuell testen:

admin diag start location 0/x/cpu0 test NPULoopback (cXR)

RP/0/RP0/CPU0:AG3_1#diagnostic start location 0/0/CPU0 test NPULoopback >>> eXR

Fri May 13 06:53:00.902 EDT

RP/0/RP0/CPU0:AG3_1#show diagnostic res location 0/0/CPU0 test 5 detail >>> Here there are

multiple test 1-5 (check previous examples)

Test results: (. = Pass, F = Fail, U = Untested)

___________________________________________________________________________

5 ) NPULoopback ---------------------> .

Error code ------------------> 0 (DIAG_SUCCESS)

Total run count -------------> 67319

Last test execution time ----> Fri May 13 06:53:01 2022

First test failure time -----> n/a

Last test failure time ------> n/a

Last test pass time ---------> Fri May 13 06:53:01 2022

Total failure count ---------> 0

Consecutive failure count ---> 0

___________________________________________________________________________

- Überprüfen Sie, ob NP DIAG-Nachrichten empfängt/sendet:

RP/0/RSP1/CPU0:AG2-2#show controllers np counters location | inc DIAG| LC_CPU

108 PARSE_RSP_INJ_DIAGS_CNT 25195 0 >>> total DIAG packets injected by Active+Stdby RP

904 PUNT_DIAGS_RSP_ACT 12584 0 >>> Loopbacks to Active RP

906 PUNT_DIAGS_RSP_STBY 12611 0 >>> Loopbacks to Stdby R

122 PARSE_LC_INJ_DIAGS_CNT 2618 0 >>> total DIAG packets injected by LC

790 DIAGS 12618 0 >>> total DIAG packets replied back to LC

16 MDF_TX_LC_CPU 3998218312 937 >>> a packet punted to LC CPU PARSE_RSP_INJ_DIAGS_CNT should match (PUNT_DIAGS_RSP_ACT + PUNT_DIAGS_RSP_STDBY)

PARSE_LC_INJ_DIAGS_CNT should match DIAGS

PARSE_XX_INJ_DIAGS_CNT should increment periodically.

- Es wird geprüft, ob der Software Packet Path (SPP) DIAG-Meldungen sendet/empfängt:

show spp sid stats location | inc DIAG 2. DIAG 35430

2. DIAG 35430

Diese DIAG-Zähler werden empfangen und gesendet. Sie können auf dem LC immer zusammenpassen und inkrementieren.

- debug punt-inject l2-packages diag np 0 location 0/9/CPU0

Beispielprotokolle: SPP sendet und empfängt das Diagnosepaket mit der Sequenz "no 0x4e"-Pakete.

LC/0/1/CPU0:Jun 6 04:14:05.581 : spp[89]: Sent DIAG packet. NP:0 Slot:0 Seq:0x4e

LC/0/1/CPU0:Jun 6 04:14:05.584 : spp[89]: Rcvd DIAG packet. NP:0 Slot:0 Seq:0x4e

- Überprüfen Sie, ob der Paketpfad verworfen wird:

show drops all location

show drops all ongoing location

- Online-Diagnosedebugs prüfen (in cXR):

Online-Diagnosen sind oft hilfreich, um die Zeitstempel zu überprüfen, wenn Pakete gesendet/empfangen oder verpasst wurden. Diese Zeitstempel können mit SPP-Aufnahmen für die Paketkorrelation verglichen werden.

admin debug diagnostic engineer location

admin debug diagnostic error location

Anmerkung: Geben Sie den admin undebug all Befehl ein, um diese Debugs zu deaktivieren.

Beispielausgaben aus den Debugs:

RP/0/RSP0/CPU0:Mar 25 05:43:43.384 EST: online_diag_rsp[349]: Slot 1 has 4 NPs >>> Sending DIAG

messages to NPs on slot 1

RP/0/RSP0/CPU0:Mar 25 05:43:43.384 EST: online_diag_rsp[349]: PuntFabricDataPath: sending

a pak (seq 25), destination physical slot 1 (card type 0x3d02aa), NP 0, sfp=0xc6

RP/0/RSP0/CPU0:Mar 25 05:43:43.384 EST: online_diag_rsp[349]: PuntFabricDataPath: sending

a pak (seq 25), destination physical slot 1 (card type 0x3d02aa), NP 1, sfp=0xde

RP/0/RSP0/CPU0:Mar 25 05:43:43.384 EST: online_diag_rsp[349]: PuntFabricDataPath: sending

a pak (seq 25), destination physical slot 1 (card type 0x3d02aa), NP 2, sfp=0xf6

RP/0/RSP0/CPU0:Mar 25 05:43:43.384 EST: online_diag_rsp[349]: PuntFabricDataPath: sending

a pak (seq 25), destination physical slot 1 (card type 0x3d02aa), NP 3, sfp=0x10e

RP/0/RSP0/CPU0:Mar 25 05:43:43.888 EST: online_diag_rsp[349]: PuntFabricDataPath:

Time took to receive 22 pkts: 503922888 nsec, timeout value: 500000000 nsec

RP/0/RSP0/CPU0:Mar 25 05:43:43.888 EST: online_diag_rsp[349]: PuntFabricDataPath:

Received 22 packets, expected 24 => Some replies missed

RP/0/RSP0/CPU0:Mar 25 05:43:43.888 EST: online_diag_rsp[349]: PuntFabricDataPath:

Got a packet from physical slot 1, np 0

RP/0/RSP0/CPU0:Mar 25 05:43:43.888 EST: online_diag_rsp[349]: Successfully verified

a packet, seq. no.: 25

RP/0/RSP0/CPU0:Mar 25 05:43:43.888 EST: online_diag_rsp[349]: PuntFabricDataPath:

Got a packet from physical slot 1, np 2 <= Replies from NP1 and NP3 missing

RP/0/RSP0/CPU0:Mar 25 05:43:43.888 EST: online_diag_rsp[349]: Successfully verified

a packet, seq. no.: 25

RP/0/RSP0/CPU0:Mar 25 05:43:43.888 EST: online_diag_rsp[349]: PuntFabricDataPath:

Got a packet from physical slot 3, np 0

- Diagnoseüberwachung:

RP/0/RP1/CPU0:AG2-2#show diagnostic trace location 0/rp1/CPU0

Fri Mar 25 12:16:40.866 IST

1765 wrapping entries (3136 possible, 2048 allocated, 0 filtered, 3503120 total)

Mar 16 02:40:21.641 diags/online/gold_error 0/RP1/CPU0 t7356 Failed to get ack: got 0 responses,

expected 1

Mar 16 02:40:36.490 diags/online/message 0/RP1/CPU0 t8947 My nodeid 0x120, rack# is 0, slot# 1,

board type = 0x100327

Mar 16 02:40:36.948 diags/online/message 0/RP1/CPU0 t8947 dev cnt=25, path cnt=3, shm loc for

dev alarms@0x7fd4f0bec000, path alarms@0x7fd4f0bec01c, path alarm data@0x7fd4f0bec028

Mar 16 02:40:37.022 diags/online/message 0/RP1/CPU0 t8947 Last rpfo time: 1647378637

Mar 24 06:03:27.479 diags/online/error 0/RP1/CPU0 2105# t9057 PuntFabricDataPath test error:

physical slot 11(LC# 9): expected np mask: 0x0000000f, actual: 0x0000000b, failed: 0x00000004

Mar 24 06:03:27.479 diags/online/error 0/RP1/CPU0 634# t9057 PuntFabricDataPath test failure detected,

detail in the form of (0-based) (slot, NP: count): (LC9,2: 13)

Fabric-Auswahl

- Fabric-Zustand (dies bietet eine Zusammenfassung von Link-Status, Statistiken, Drops und Alarmen):

show controllers fabric health location <>

- Wirbelsäulengesundheit:

show controllers fabric health spine all

- Onboard Failure Logging (OBFL) (nach dem erneuten Laden wäre auch dies verfügbar):

admin

sysadmin-vm:0_RP0# show logging onboard fabric location 0/0

- Fabric-Zähler auf Eingangs-LC FIA überprüfen:

show controllers fabric fia errors ingress location <>

show controllers fabric fia stats location

- Eingangs-LC-Kreuzschiene (nicht anwendbar bei Trident und SIP-700):

show controllers fabric crossbar statistics instance [0-1] location <>

- Egress-LC-Querbalken (nicht anwendbar bei Trident und SIP-700):

show controllers fabric crossbar statistics instance [0-1] location <>

- Ausgangs-LC-FIA:

show controllers fabric fia errors egress location <>

show controllers fabric fia stats location

- Wirbelsäulenstatistik:

show controllers fabric crossbar statistics instance [0-1] spine [0-6]

- Fabric-Drops überprüfen:

- Eingangs-LC-FIA:

show controllers fabric fia drops ingress location <>

- Ausgangs-LC-FIA:

show controllers fabric fia drops egress location <>

- ASIC-Fehler:

- Sprachdienstleister:

show controllers fabric crossbar asic-errors instance 0 location<>

show asic-errors fia <> all location <>

-

- Tomahawk:

show asic-errors fia <> all location <>

RP/0/RP0/CPU0:AG3_1#show controllers np fabric-counters all np0 location 0/0/CPU0

Node: 0/0/CPU0:

----------------------------------------------------------------

Egress fabric-to-bridge interface 2 counters for NP 0

INTERLAKEN_CNT_TX_BYTES 0x000073fc 23b6d99b

INTERLAKEN_CNT_TX_FRM_GOOD 0x000000ae a79d6612

INTERLAKEN_CNT_TX_FRM_BAD 0x00000000 00000000 >>> this is 0 which is good,

need to check if it is incremented

-------------------------------------------------------------

Egress fabric-to-bridge interface 3 counters for NP 0

INTERLAKEN_CNT_TX_BYTES 0x0004abdd fe02068d

INTERLAKEN_CNT_TX_FRM_GOOD 0x000005b8 089aac95

INTERLAKEN_CNT_TX_FRM_BAD 0x00000000 00000000

-------------------------------------------------------------

Node: 0/0/CPU0:

----------------------------------------------------------------

Ingress fabric-to-bridge interface 2 counters for NP 0

INTERLAKEN_CNT_RX_BYTES 0x0004aeb5 a4b9dbbe

INTERLAKEN_CNT_RX_FRM_GOOD 0x0000058e b7b91c15

INTERLAKEN_CNT_RX_FRM_BAD 0x00000000 00000000

INTERLAKEN_CNT_RX_BURST_CRC32_ERROR 0x00000000 00000000

INTERLAKEN_CNT_RX_BURST_CRC24_ERROR 0x00000000 00000000

INTERLAKEN_CNT_RX_BURST_SIZE_ERROR 0x00000000 00000000

-------------------------------------------------------------

Ingress fabric-to-bridge interface 3 counters for NP 0

INTERLAKEN_CNT_RX_BYTES 0x000094ce b8783f95

INTERLAKEN_CNT_RX_FRM_GOOD 0x000000f5 33cf9ed7

INTERLAKEN_CNT_RX_FRM_BAD 0x00000000 00000000

INTERLAKEN_CNT_RX_BURST_CRC32_ERROR 0x00000000 00000000

INTERLAKEN_CNT_RX_BURST_CRC24_ERROR 0x00000000 00000000

INTERLAKEN_CNT_RX_BURST_SIZE_ERROR 0x00000000 00000000

- Überprüfung des Verbindungsstatus der FIA:

show controllers fabric fia link-status location

RP/0/RP0/CPU0:AG3_1#show controllers fabric fia link-status location 0/0/CPU0

********** FIA-0 **********

Category: link-0

spaui link-0 Up >>> FIA to NP link

spaui link-1 Up >>> FIA to NP link

arb link-0 Up >>> Arbitor link

xbar link-0 Up >>> FIA to XBAR link

xbar link-1 Up >>> FIA to XBAR link

xbar link-2 Up >>> FIA to XBAR link

- So überprüfen Sie den Verbindungsstatus von XBAR:

RP/0/RP0/CPU0:AG3_1#show controllers fabric crossbar link-status instance 0 lo 0/0/CPU0

Mon May 2 04:05:06.161 EDT

PORT Remote Slot Remote Inst Logical ID Status

======================================================

00 0/0/CPU0 01 2 Up

01 0/FC3 01 0 Up

02 0/FC3 00 0 Up

03 0/FC4 01 0 Up

04 0/FC2 01 0 Up

05 0/FC4 00 0 Up

06 0/FC2 00 0 Up

07 0/FC1 01 0 Up

10 0/FC1 00 0 Up

14 0/FC0 01 0 Up

15 0/FC0 00 0 Up

16 0/0/CPU0 02 0 Up

18 0/0/CPU0 02 2 Up

19 0/0/CPU0 02 1 Up

20 0/0/CPU0 03 2 Up

21 0/0/CPU0 03 1 Up

22 0/0/CPU0 03 0 Up

23 0/0/CPU0 00 2 Up

24 0/0/CPU0 00 1 Up

25 0/0/CPU0 00 0 Up

26 0/0/CPU0 01 0 Up

27 0/0/CPU0 01 1 Up

Wenn Sie diese Protokolle auf der LSP-Karte beobachten:

LC/0/3/CPU0:Jul 5 13:05:53.365 IST: fab_xbar[172]: %PLATFORM-CIH-5-ASIC_ERROR_THRESHOLD :

sfe[1]: An interface-err error has occurred causing packet drop transient.

ibbReg17.ibbExceptionHier.ibbReg17.ibbExceptionLeaf0.intIpcFnc0UcDataErr Threshold has been exceeded

17*2 hilft hier, den Port mit dem folgenden show controllers fabric crossbar link-status instance 1 lo 0/3/CPU0 Befehl zu identifizieren:

Protokollsammlung:

show platform

show inventory

show tech fabric

show tech np

show tech ethernet interface

show logging

show pfm location all

show pfm trace location <location id>

show controllers pm vqi location all

show hw-module fpd location all (cxr) / admin show hw-module fpd (exr)

show controllers fti trace <process-name> location <Card location>

admin show tech obfl

Cxr:

From Admin:

show logging onboard common location <>

show logging onboard error location <>

Exr:

From sysadmin/calvados:

show logging onboard fabric location <>

- ASIC-Fehler in FIA:

Für LS:

show controllers asic LS-FIA instance <instance> block <block_name> register-name <register_name> location <>

Für LSP:

show controllers asic LSP-FIA instance <instance> block <block_name> register-name <register_name> location <>

Wenn der gemeldete Fehler wie folgt aussieht:

LC/0/9/CPU0:Mar 1 05:12:25.474 IST: fialc[137]: %PLATFORM-CIH-5-ASIC_ERROR_THRESHOLD :

fia[3]: A link-err error has occurred causing performance loss persistent.

fnc2serdesReg1.fnc2serdesExceptionHier.fnc2serdesReg1.fnc2serdesExceptionLeaf0.

iNTprbsErrTxphyrdydropped6 Threshold has been exceeded

- Die Instanz ist die Instanznummer des FIA ASIC. Hier steht "3", "block_name" für "fnc2serdesReg1" und "register_name" für "fnc2serdesExceptionLeaf0".

- ASIC-Fehler auf LC/RSP XBAR:

show controllers asic SKB-XBAR instance <instance> block-name <block_name> register-name <register_name> location <>

Wenn der gemeldete Fehler wie folgt aussieht:

LC/0/7/CPU0:Mar 4 06:42:01.241 IST: fab_xbar[213]: %PLATFORM-CIH-5-ASIC_ERROR_THRESHOLD :

sfe[0]: An interface-err error has occurred causing packet drop transient.

ibbReg11.ibbExceptionHier.ibbReg11.ibbExceptionLeaf0.intIpcFnc1UcDataErr Threshold has been exceeded

- Die Instanz ist die Instanz einer Nummer des SFE/XBAR ASIC. Hier ist "0" block_name "ibbReg11" und register_name "ibbExceptionLeaf0".

- Wenn ASIC-Fehler in FC XBAR gemeldet werden:

show controllers asic FC2-SKB-XBAR instance <instance> block-name <block_name> register-name <register_name> location

Wenn der gemeldete Fehler wie folgt aussieht:

RP/0/RP0/CPU0:Mar 4 06:41:14.398 IST: fab_xbar_sp3[156]: %PLATFORM-CIH-3-ASIC_ERROR_SPECIAL_HANDLE_THRESH :

fc3xbar[1]: A link-err error has occurred causing packet drop transient.

cflReg17.cflExceptionHier.cflReg17.cflExceptionLeaf4.intCflPal1RxAlignErrPktRcvd Threshold has been exceeded

Dann ASIC ist "FC3-SKB-XBAR" Instanz ist die Instanz eine Nummer der SFE/XBAR ASIC. Hier ist es "1", beide kommen von "fc3xbar[1]" block_name ist "cflReg17" und register_name ist "cflExceptionLeaf4".

Beispiel:

RP/0/RSP0/CPU0: AG2-10#sh logging | i ASIC

RP/0/RSP0/CPU0:May 11 20:48:57.658 IST: fab_xbar[184]: %PLATFORM-CIH-5-ASIC_ERROR_THRESHOLD :

sfe[0]: An interface-err error has occurred causing packet drop transient.

ibbReg13.ibbExceptionHier.ibbReg13.ibbExceptionLeaf0.intIpcFnc0UcDataErr Threshold has been exceeded

RP/0/RSP0/CPU0: AG2-10#sh controllers fabric crossbar link-status instance 0 location 0/rsp0/CPU0

PORT Remote Slot Remote Inst Logical ID Status

======================================================

04 0/0/CPU0 00 1 Up

06 0/0/CPU0 00 0 Up

08 0/7/CPU0 00 1 Up

10 0/7/CPU0 00 0 Up

24 0/2/CPU0 00 0 Up

26 0/2/CPU0 00 1 Up

>>> ibbReg13 >> 13*2 = 26 SO IT IS POINTING TO LC2 – IN THIS CASE YOU CAN DO OIR TO RECOVER THE ASIC ERROR

40 0/RSP0/CPU0 00 0 Up

RP/0/RSP0/CPU0: AG2-10#show controllers asic SKB-XBAR instance 0 block-name ibbReg13 register-name ibbExceptionLeaf0 location 0/RSP0/CPU0

address name value

0x00050d080 SkyboltRegisters_ibbReg13_ibbExceptionLeaf0_int1Stat 0x00000000 (4 bytes)

address name value

0x00050d084 SkyboltRegisters_ibbReg13_ibbExceptionLeaf0_int1StatRw1s 0x00000000 (4 bytes)

address name value

0x00050d088 SkyboltRegisters_ibbReg13_ibbExceptionLeaf0_int1Enable 0xfffffffb (4 bytes)

address name value

0x00050d08c SkyboltRegisters_ibbReg13_ibbExceptionLeaf0_int1First 0x00000000 (4 bytes)

address name value

0x00050d090 SkyboltRegisters_ibbReg13_ibbExceptionLeaf0_int2Stat 0x00000c50 (4 bytes)

address name value

0x00050d094 SkyboltRegisters_ibbReg13_ibbExceptionLeaf0_int2StatRw1s 0x00000c50 (4 bytes)

address name value

0x00050d098 SkyboltRegisters_ibbReg13_ibbExceptionLeaf0_int2Enable 0x00000000 (4 bytes)

address name value

0x00050d09c SkyboltRegisters_ibbReg13_ibbExceptionLeaf0_int2First 0x00000000 (4 bytes)

address name value

0x00050d0a0 SkyboltRegisters_ibbReg13_ibbExceptionLeaf0_haltEnable 0x00000000 (4 bytes)

address name value

0x00050d0a4 SkyboltRegisters_ibbReg13_ibbExceptionLeaf0_fault 0x00000000 (4 bytes)

address name value

0x00050d0a8 SkyboltRegisters_ibbReg13_ibbExceptionLeaf0_intMulti 0x00000840 (4 bytes)

address name value

0x00050d0ac SkyboltRegisters_ibbReg13_ibbExceptionLeaf0_leaf 0x00000000 (4 bytes)

RP/0/RSP0/CPU0:AG2-10#

Arbiter-Fehleranalyse

So überprüfen Sie den Linkstatus:

RP/0/RSP0/CPU0:AG2-10#sho controllers fabric arbiter link-status location 0/1/$

Port Remote Slot Remote Elem Remote Inst Status

=======================================================

00 0/1/CPU0 FIA 0 Up

01 0/1/CPU0 FIA 1 Up

24 0/RSP0/CPU0 ARB 0 Up

25 0/RSP1/CPU0 ARB 0 Up

So überprüfen Sie die VQI-Verfügbarkeit:

RP/0/RP0/CPU0:AG3_1#sh controllers fabric vqi assignment all

Current mode: Highbandwidth mode - 2K VQIs

Node Number of VQIs

----------------------------

0/0/CPU0 80

0/1/CPU0 40

0/2/CPU0 48

0/3/CPU0 80

0/5/CPU0 80

0/7/CPU0 80

0/12/CPU0 64

RP*/RSP* 8

----------------------------

In Use = 480

Available = 1568

Überprüfen Sie die dem VQI zugewiesene Geschwindigkeit:

RP/0/RP0/CPU0:AG3_1#sh controller fabric vqi assignment slot 7

Thu May 12 07:58:59.897 EDT

slot = 7

fia_inst = 0

VQI = 400 SPEED_100G

VQI = 401 SPEED_100G

VQI = 402 SPEED_100G

VQI = 403 SPEED_100G

VQI = 404 SPEED_100G

VQI = 405 SPEED_100G

VQI = 406 SPEED_100G

slot = 7

fia_inst = 1

VQI = 416 SPEED_40G

VQI = 417 SPEED_40G

VQI = 418 SPEED_40G

VQI = 419 SPEED_40G

VQI = 420 SPEED_100G

Wenn Sie Schwanzabfälle auf FIA beobachten, überprüfen Sie diese Schritte:

Überprüfen Sie die Warteschlangentiefe in VQI:

RP/0/RP0/CPU0:AG3_1#show controllers fabric fia q-depth location 0/0/CPU0

Thu May 12 08:00:42.186 EDT

********** FIA-0 **********

Category: q_stats_a-0

Voq ddr pri Cellcnt Slot_FIA_NP

28 0 2 2 LC0_1_1

********** FIA-0 **********

Category: q_stats_b-0

Voq ddr pri Cellcnt Slot_FIA_NP

********** FIA-1 **********

Category: q_stats_a-1

Voq ddr pri Cellcnt Slot_FIA_NP

7 0 2 12342 LC0_0_0

>>> Here Packet count is high so we need to check for LC0 FIA0 NP0 (egress) is there any congestion

or any other issue in LC0 FIA0 or NP0

Here Pri = 2 is the default queue (BE) , Pri = 0 is P1 (Voice, real time) queue, Pri = 1 is P2

97 0 2 23 LC1_0_0

RP/0/RP0/CPU0:AG3_1#show controllers fabric vqi assignment slot 02

slot = 2

fia_inst = 0

VQI = 0 SPEED_10G

VQI = 1 SPEED_10G

VQI = 2 SPEED_10G

VQI = 3 SPEED_10G

VQI = 4 SPEED_10G

VQI = 5 SPEED_10G

VQI = 6 SPEED_10G

VQI = 7 SPEED_10G

Port-Zuordnungsdetails für den VQI:

RP/0/RP0/CPU0:AG3_1#show controllers pm vqi location 0/0/CPU0

Platform-manager VQI Assignment Information

Interface Name | ifh Value | VQI | NP#

--------------------------------------------------

TenGigE0_0_0_0_1 | 0x4000680 | 1 | 0

TenGigE0_0_0_0_2 | 0x40006c0 | 2 | 0

TenGigE0_0_0_0_3 | 0x4000700 | 3 | 0

TenGigE0_0_0_0_4 | 0x4000740 | 4 | 0

TenGigE0_0_0_0_5 | 0x4000780 | 5 | 0

TenGigE0_0_0_0_6 | 0x40007c0 | 6 | 0

TenGigE0_0_0_0_7 | 0x4000800 | 7 | 0

RP/0/RP0/CPU0:AG3_1#show controllers pm interface tenGigE 0/0/0/0/7

Ifname(1): TenGigE0_0_0_0_7, ifh: 0x4000800 :

iftype 0x1e

egress_uidb_index 0x12, 0x0, 0x0, 0x0

ingress_uidb_index 0x12, 0x0, 0x0, 0x0

port_num 0x0

subslot_num 0x0

ifsubinst 0x0

ifsubinst port 0x7

phy_port_num 0x7

channel_id 0x0

channel_map 0x0

lag_id 0x7e

virtual_port_id 0xa

switch_fabric_port 7 >>> VQI matching for the ports

in_tm_qid_fid0 0x38001e

in_tm_qid_fid1 0x0

in_qos_drop_base 0xa69400

out_tm_qid_fid0 0x1fe002

out_tm_qid_fid1 0xffffffff

np_port 0xd3

Protokollsammlung:

Show tech fabric

Show tech np

show controllers pm trace ?

async Platform manager async trace

creation Platform manager interface creation/deletion trace

error Platform manager error trace

information Platform manager information trace

init Platform manager init trace

other Platform manager common trace

stats Platform manager stats trace

NP-Fehlersuche

NP-Lastüberprüfung:

RP/0/RP0/CPU0:AG3_1#show controller np load all location 0/0/CPU0

Node: 0/0/CPU0:

----------------------------------------------------------------

Load Packet Rate

NP0: 2% utilization 3095766 pps

NP1: 3% utilization 5335675 pps

NP2: 0% utilization 498 pps

NP3: 0% utilization 1117 pps

Port-Zuordnung:

RP/0/RP0/CPU0:AG3_1#show controllers np ports all location 0/0/CPU0

Node: 0/0/CPU0:

----------------------------------------------------------------

NP Bridge Fia Ports

-- ------ --- ---------------------------------------------------

0 -- 0 TenGigE0/0/0/0/0 - TenGigE0/0/0/0/9, TenGigE0/0/0/1/0 - TenGigE0/0/0/1/9

1 -- 1 TenGigE0/0/0/2/0 - TenGigE0/0/0/2/9, HundredGigE0/0/0/3

2 -- 2 HundredGigE0/0/0/4 - HundredGigE0/0/0/5

3 -- 3 HundredGigE0/0/0/6 - HundredGigE0/0/0/7

Tomahawk

Beachten Sie, dass dies der Admin-Modus ist:

sysadmin-vm:0_RP0# show controller switch statistics location 0/LC0/LC-SW

Thu May 12 12:32:37.160 UTC+00:00

Rack Card Switch Rack Serial Number

--------------------------------------

0 LC0 LC-SW

Tx Rx

Phys State Drops/ Drops/

Port State Changes Tx Packets Rx Packets Errors Errors Connects To

----------------------------------------------------------------------------

0 Up 2 3950184361 3977756349 0 0 NP0

1 Up 2 0 0 0 0 NP0

8 Up 1 1319787462 209249871 0 0 LC CPU N0 P0

9 Up 1 3374323096 1819796660 0 0 LC CPU N0 P1

16 Up 2 2245174606 1089972811 0 0 NP1

17 Up 2 0 0 0 0 NP1

18 Up 2 65977 16543963 0 0 NP2

19 Up 2 0 0 0 0 NP2

32 Up 2 128588820 3904804720 0 0 NP3

33 Up 2 0 0 0 0 NP3

show asic-error np <> all loc <> >>> Ignore the macwrap errors as they are seen for every

interface flaps/ Execute 3-4 times to verify the drops increment

show controller np fast-drop <> loc <> >>> Execute 3-4 times to verify the drops increment

RP/0/RP0/CPU0:AG3_1#show controller np fast-drop np0 location 0/0/CPU0

Thu May 12 10:13:22.981 EDT

Node: 0/0/CPU0:

----------------------------------------------------------------

All fast drop counters for NP 0:

TenGigE0/0/0/1/0-TenGigE0/0/0/1/9:[Priority1] 0

TenGigE0/0/0/1/0-TenGigE0/0/0/1/9:[Priority2] 0

TenGigE0/0/0/1/0-TenGigE0/0/0/1/9:[Priority3] 0

TenGigE0/0/0/0/0-TenGigE0/0/0/0/9:[Priority1] 0

TenGigE0/0/0/0/0-TenGigE0/0/0/0/9:[Priority2] 0

TenGigE0/0/0/0/0-TenGigE0/0/0/0/9:[Priority3] 0

show controllers np punt-path-counters all HOST-IF-0 np<> location <>

[Check for IF_CNT_RX_FRM & IF_CNT_TX_FRM] >>> To check if diagnostic packets make it to the LC NP

Host CPU network port

Leichte Geschwindigkeit

show asic-error np <> all loc <> >>> Ignore the macwrap errors as they are seen for every interface flap

RP/0/RP0/CPU0:AG3_1#sho asic-errors np 0 all location 0/5/CPU0

************************************************************

* 0_5_CPU0 *

************************************************************

************************************************************

* Single Bit Errors *

************************************************************

************************************************************

* Multiple Bit Errors *

************************************************************

************************************************************

* Parity Errors *

************************************************************

************************************************************

* Generic Errors *

************************************************************

ASR, ASR9K Lightspeed 20*100GE SE LC, 0/5/CPU0, npu[0]

Name : mphmacwrapReg1.mphmacwrapExceptionLeaf4.mphWrapIrqUmacIpInt82

Leaf ID : 0x2023e082

Error count : 1

Last clearing : Thu Apr 7 11:41:47 2022

Last N errors : 1

--------------------------------------------------------------

First N errors.

@Time, Error-Data

------------------------------------------

show controller np fast-drop <> loc <> >>> Execute 3-4 times to verify the drops increment

RP/0/RP0/CPU0:AG3_1#show controller np fast-drop np0 location 0/5/CPU0

Thu May 12 10:13:28.321 EDT

Node: 0/5/CPU0:

----------------------------------------------------------------

All fast drop counters for NP 0:

HundredGigE0_5_0_0[Crit] 0

HundredGigE0_5_0_0[HP] 0

HundredGigE0_5_0_0[LP2] 0

HundredGigE0_5_0_0[LP1] 0

HundredGigE0_5_0_0[Crit+HP_OOR] 0

HundredGigE0_5_0_0[LP2+LP1_OOR] 0

HundredGigE0_5_0_1[Crit] 0

HundredGigE0_5_0_1[HP] 0

HundredGigE0_5_0_1[LP2] 0

HundredGigE0_5_0_1[LP1] 0

HundredGigE0_5_0_1[Crit+HP_OOR] 0

Beachten Sie, dass dies der Admin-Modus ist:

sysadmin-vm:0_RP0# show controller switch statistics location 0/LC5/LC-SW >>> Execute 3-4

times to verify the errors increment

Rack Card Switch Rack Serial Number

--------------------------------------

0 LC5 LC-SW

Tx Rx

Phys State Drops/ Drops/

Port State Changes Tx Packets Rx Packets Errors Errors Connects To

-----------------------------------------------------------------------------

0 Up 4 1456694749 329318054 0 4 CPU -- EOBC

1 Up 2 21 23 0 0 CPU -- flexE

2 Up 4 1063966999 87683758 0 0 CPU -- PUNT

3 Up 4 885103800 3021484524 0 0 CPU -- BFD

4 Up 3 329319167 1456700372 0 0 RP0

5 Up 3 0 0 0 0 RP1

6 Up 1 11887785 2256 0 0 IPU 0

7 Up 1 0 1086 0 0 IPU 1

9 Up 4 74028034 3025657779 0 0 NP0

10 Up 4 5 0 0 0 NP0

11 Down 1 0 0 0 0 PHY0 -- flexE

12 Up 4 264928 264929 0 0 NP1

13 Up 2 5 0 0 0 NP1

14 Down 1 0 0 0 0 PHY1 -- flexE

15 Up 4 1516538834 1159586563 0 0 NP2

Protokollsammlung:

show tech np

show tech fabric

show asic-errors fia trace all location <>

- Erfassen Sie in eXR den Befehl np_datalog:

RP/0/RP0/CPU0:AG3_1#run chvrf 0 ssh lc0_xr

LC : [one time capture]

show_np -e <> -d npdatalog [<> should be the affected NP]

Path where NP datalogs is saved : /misc/scratch/np/NPdatalog_0_0_CPU0_np0_prm__20220512-105332.txt.gz

LC : 5 to 10 times

show_np -e <> -d pipeline [<> should be the affected NP]

- Bei NP-Initialisierungsfehler auf LSP:

RP/0/RP0/CPU0:AG2-2#show controllers np ports all location 0/6/CPU0

Node: 0/6/CPU0:

----------------------------------------------------------------

NP Bridge Fia Ports

-- ------ --- ---------------------------------------------------

0 -- 0 HundredGigE0/6/0/0 - HundredGigE0/6/0/31 --

1 -- 1 HundredGigE0/6/0/4 - HundredGigE0/6/0/7

NP2 is down. >>>>>>>>>. NP Down/Init Failure

3 -- 3 HundredGigE0/6/0/12 - HundredGigE0/6/0/154 --

4 -- 4 HundredGigE0/6/0/16 - HundredGigE0/6/0/19

Diese Protokolle beachten:

LC/0/6/CPU0:Mar 23 02:53:56.175 IST: npu_server_lsp[138]: %PLATFORM-LDA-3-INIT_FAIL :

Failed to initialize lda_bb_np_reset_process 13795 inst 0x2 LC INIT: Failed in NP HAL

Reset np (0x00000001 - Operation not permitted) : npu_server_lsp : (PID=4597) :

-Traceback= 7fea2d5cd9f6 7fea2d7d5816 7fea21465efa 7fea21465fc2 7fea42ad0bed 55a9dbd66031

7fea45e1c855 7fea45e1cc2b 7fea2624d526 7fea3571b96a 7fea4d6e4831 55a9dbd691e9

LC/0/6/CPU0:Mar 23 02:53:56.185 IST: npu_server_lsp[138]: %PLATFORM-NP-4-INIT_DEBUG_MSG :

LDA NP2 Reset failed!! Check for a downlevel IPU version.

Protokollsammlung:

show tech-support ethernet interfaces

show tech-support ethernet controllers

show tech-support np

show tech-support fpd

admin show tech-support ctrace (in eXR)

show tech fabric

show asic-errors fia trace all location <>

show logging

gather (in eXR)

RP/0/RP0/CPU0:AG3_1#admin

sysadmin-vm:0_RP0#

[sysadmin-vm:0_RP0:~]$bash -l

[sysadmin-vm:0_RP0:~]$ gather

File will be generated and will get saved in rp0_xr:/misc/disk1

Allgemeine Protokollsammlung für Tomahawk, LSQ und LSP

show platform

show inventory

show tech fabric

show tech np

show tech ethernet interface

show logging

show pfm location all

show pfm trace location <location id>

sh pfm process <> location <>

show controllers pm vqi location all

show hw-module fpd location all (cxr) / admin show hw-module fpd (exr)

show controllers fti trace <process-name> location <card location>

Cxr:

From admin:

show logging onboard common location <>

show logging onboard error location <>

Exr:

From sysadmin/calvados:

show logging onboard fabric location <>"

Allgemeine Fehlersignatur und -empfehlung

| Kategorie |

Fehler |

Beobachtungen |

Empfehlung |

| NP-Initialisierungsfehler |

LC/0/0/CPU0:29. September 00:41:13.171 IST: pfm_node_lc[304]: %PLATTFORM-NP-1-NP_INIT_FAIL_NO_RESET: Set|prm_server_ty[168018]|0x1008006|Dauerhafter NP-Initialisierungsfehler, kein Neuladen der Linecard erforderlich. |

NP kann aufgrund eines HW-Paritäts-/TCAM-Fehlers in den persistenten NP-Init-Fehler wechseln, wodurch der NP deaktiviert wird. |

LC Zur Wiederherstellung über CLI neu laden. |

| Das Problem kann nach dem ersten Neuladen von LC behoben werden, wenn es vorübergehender Natur ist. |

Erteilen Sie eine Retourengenehmigung (Return Material Authorization, RMA), wenn Sie denselben Fehler wiederholt haben. |

||

| RMA bei Wiederholung von Instanzen (fotografieren Sie die fehlerhafte Platine, um sie auf beschädigte/verbogene Stifte in SR zu untersuchen). |

|||

| Die neue Karte kann aufgrund falscher Feldbehandlung mit demselben Problem konfrontiert sein. |

|||

| Schnittstelle, die dem NP zugeordnet ist, bleibt inaktiv/Keine Auswirkungen. |

|||

| ASIC FATAL FAULT-Double-Bit-ECC-Fehler |

LC/0/8/CPU0:29. Mai 18:29:09.836 IST: pfm_node_lc[301]: %FABRIC-FIA-0-ASIC_FATAL_FAULT: Set|fialc[159811]|0x108a000|Schwerwiegender Fehler in der ASIC0-Fabric-Schnittstelle 0x1 - DDR DOUBLE ECC ERROR |

Dies ist ein Doppelbit ECC-Fehler auf FIA ist ein Hard-Fehler. |

HW-Fehler auf FIA. |

| Der Fehler kann erneut auftreten, daher wird empfohlen, den LC-Server herunterzufahren. |

RMA der Karte. |

||

| Schnittstelle, die NP/FIA zugeordnet ist, bleibt inaktiv/Keine Auswirkungen. |

|||

| Das Problem tritt in einem der Fälle auf, in denen die FIA den Prozessblock fib_mgr erstellt hat. |

|||

| SERDES-Fehler |

・RP/0/RSP1/CPU0:Apr 17 12:22:10.690 IST: pfm_node_rp[378]: %PLATTFORM-CROSSBAR-1-SERDES_ERROR_LNK0: Set|fab_xbar[209006]|0x101702f|XBAR_1_Slot_1 |

Fabric-Fehler in LC Fabric oder RSP Fabric |

LC Über CLI neu laden, um den vorübergehenden/CRC-Fehler bei sich wiederholenden Fehlern wiederherzustellen. |

| DATA_NB_SERDES_1_FAIL_0 |

LC/0/3/CPU0:Apr 10 18:55:03.213 IST: pfm_node_lc[304]: %FABRIC-FIA-1-DATA_NB_SERDES_1_FAIL_0: Set|fialc[168004]|0x103d001|Daten-NB-Server-Fehler bei Link 1 auf FIA 1 RP/0/RSP0/CPU0:Apr 10 18:55:13.043 IST: FABMGR[227]: %PLATFORM-FABMGR-2-FABRIC_INTERNAL_FAULT: 0/3/CPU0 (Steckplatz 3) hat einen Fabric-Fehler festgestellt. Die Schnittstellen werden heruntergefahren. |

Schnittstellenüberarbeitungsmechanismus zur automatischen Wiederherstellung des SERDES-Fehlers in der Fabric Bei einem HW-Problem kann der Fehler auf dem LC oder RSP erneut auftreten. Die Schnittstelle bleibt in Betrieb/häufige Fehler auf SERDES beeinträchtigten den Datenverkehr. |

RMA für wiederholte Instanzen nach OIR. |

| ASIC-INIT-Fehler |

・LC/0/6/CPU0:Jul 17 00:01:40.738 2019:pfm_node_lc[301]: %FABRIC-FIA-1-ASIC_INIT_ERROR: Set|fialc[168003]|0x108a000|ASIC-INIT-Fehler in FIA-Instanz 0 erkannt |

FIA-Instanz-Ausfallereignis für FIA auf LC mit ASIC INIT ERROR in Syslog. |

LC Über CLI neu laden, um vorübergehende Probleme auszuschließen. |

| FATALER FIA-ASIC-Fehler (TS_NI_INTR_LCL_TIMER_EXPIRED) |

LC/0/19/CPU0:08.03 04:52:29.020 IST: pfm_node_lc[301]: %FABRIC-FIA-0-FATAL_INTERRUPT_ERROR: Set|fialc[172098]|0x108a003|FIA Fatal Error Interrupt auf FIA 3: TS_NI_INTR_LCL_TIMER_ABGELAUFEN |

Bei der neuen Karte wird deutlich, dass das Gerät zum Zeitpunkt der Lieferung/Installation falsch gehandhabt wurde, was zu physischen Schäden an der Platine führte. Einige Bretter zeigten keine physischen Schäden, jedoch wurde während der EFA ein Lötriss beobachtet. Dies deutet auf eine Überlastung der Verpackung und eine mögliche Fehlfunktion im Laufe der Zeit hin. Die Schnittstelle bleibt in Betrieb/häufige Fehler auf SERDES beeinträchtigten den Datenverkehr. |

Wenn das Problem weiterhin besteht, fahren Sie mit RMA/R&R fort. |

| NP Fast Reset (Tomahawk) |

LC/0/4/CPU0:Jul 6 04:06:49.259 IST: prm_server_ty[318]: %PLATFORM-NP-3-ECC: prm_ser_check: Das schnelle Zurücksetzen des NP wurde abgeschlossen, um eine Wiederherstellung nach einem weichen Fehler auf dem NP 1 zu erreichen. Es sind keine weiteren Korrekturmaßnahmen erforderlich. |

NP erkennt das Problem mit der weichen Parität und versucht, es zu beheben, indem es das schnelle Zurücksetzen des NP versucht. |

Keine RMA für den ersten Vorfall. |

| NP Parity LC-Neuladen |

LC/0/6/CPU0:Jan 27 20:38:08.011 IST: prm_server_to[315]: %PLATFORM-NP-0-LC_RELOAD: NP3 verfügte über 3 schnelle Resets innerhalb einer Stunde, die die NPdatalog-Erfassung und den automatischen LC-Neustart initiierten. |

In der Regel, nach drei Wiederherstellungsversuchen, die LC neu laden sich selbst für die Reparatur der Parität Problem auf NP in der Regel für die Tomahawk-Karte gesehen. LC ergreift Maßnahmen zur automatischen Wiederherstellung, indem der LC neu geladen wird und das Problem der weichen, nicht behebbaren Parität im gemeldeten NP behoben wird. Schnittstelle, die dem NP zugeordnet ist, fällt aus, wenn sie zurückgesetzt wird/keine Auswirkungen hat. |

RMA für wiederholte Instanzen desselben Fehlers. |

| LC_NP_LOOPBACK_FAILED |

LC/0/1/CPU0:26. Juli 17:29:06.146 IST: pfm_node_lc[304]: %PLATFORM-DIAGS-0-LC_NP_LOOPBACK_FAILED_TX_PATH: Set|online_diag_lc[168022]|Line Card NPU Loopback Test(0x2000006)|Verbindungsfehlermaske: 0x1. |

Fehler beim LC-NP-Loopback-Diagnosetest an einem der NP. |

LC Über CLI neu laden, um vorübergehende Probleme auszuschließen. |

| In PFM als Alarm "LC_NP_LOOPBACK_FAILED_XX_PATH" festgelegt. |

RMA für wiederholte Instanzen desselben Fehlers. |

||

| Schnittstelle, die dem NP zugeordnet ist, fällt aus, wenn sie zurückgesetzt wird/keine Auswirkungen hat. |

|||

| FABRIC-FIA-1-SUSTAINED_CRC_ERR |

LC/0/5/CPU0:06.03.05 05:47:34.748 IST: pfm_node_lc[303]: %FABRIC-FIA-1-SUSTAINED_CRC_ERR: Set|fialc[168004]|0x103d000|Fabric-Schnittstelle ASIC-0 weist anhaltende CRC-Fehler auf |

FIA aufgrund eines FABRIC FIA SUSTAINED CRC-Fehlers heruntergefahren. |

LC Über CLI neu laden, um vorübergehende Probleme auszuschließen. |

| Beim FIA-Shutdown-Ereignis fällt auch die Schnittstelle an der FIA aus. |

RMA für wiederholte Instanzen desselben Fehlers. |

||

| Die Schnittstelle bleibt aktiv/Keine Auswirkungen. |

|||

| FAB ARB XIF1 ERR |

・LC/0/6/CPU0:Jan 25 19:31:22.787 IST: pfm_node_lc[302]: %PLATFORM-FABARBITER-1-RX_LINK_ERR: Löschen|fab_arb[163918]|0x1001001|LIT_XIF1_K_CHAR_ERR LC/0/6/CPU0:Jan 25 19:31:22,787 IST: pfm_node_lc[302]: %PLATFORM-FABARBITER-1-SYNC_ERR : Löschen|fab_arb[163918]|0x1001001|LIT_XIF1_LOSS_SYNC LC/0/6/CPU0:Jan 25 19:33:23.010 IST: pfm_node_lc[302]: %PLATFORM-FABARBITER-1-RX_LINK_ERR: Set|fab_arb[163918]|0x1001001|LIT_XIF1_DISP_ERR |

PUNT-Fehler für LC- und Fabric-Arbiter-Synchronisierung und rx_link-Fehler. Die Schnittstelle bleibt aktiv/Keine Auswirkungen. |

OIR der Karte, um vorübergehende Probleme auszuschließen RMA für wiederholte Instanzen desselben Fehlers. |

| FPOE_Read_Write-Fehler |

xbar error trace (show tech fabric) |

Cisco Bug-ID CSCvv45788 |

Softwarefehler |

| FIA_XBAR-SERIEN |

#show Controller Fabric Fia Link-Status, Standort 0/9/CPU0 |

OIR der Karte, um vorübergehende Probleme auszuschließen RMA für wiederholte Instanzen desselben Fehlers. |

|

| NP DIAG ICFD Fast Reset |

NP-DIAG auf NP0, ICFD (STS-1), NP kann 0-4 sein NP3 verfügte über 3 schnelle Resets innerhalb einer Stunde, die die NPdatalog-Erfassung und den automatischen LC-Neustart initiierten. |

Löst ein FAST-Reset des NP aus Und LC wird neu geladen, wenn 3 NP schnell in einer Stunde zurückgesetzt werden. |

Wenn LC mehrere Male neu geladen wird, RMA. |

| PRM-Integritätsüberwachung konnte schnelle Zurücksetzungen des Paket-NP nicht abrufen. |

NP-DIAG-Fehler bei der Integritätsüberwachung NP3 verfügte über 3 schnelle Resets innerhalb einer Stunde, die die NPdatalog-Erfassung und den automatischen LC-Neustart initiierten. |

Löst ein FAST-Reset des NP aus Und LC wird neu geladen, wenn 3 NP schnell in einer Stunde zurückgesetzt werden. |

Wenn LC mehrere Male neu geladen wird, RMA. |

| PRM-Integritätsüberwachung wird beschädigt - schnelle Zurücksetzung des Paket-NP |

NP-DIAG Gesundheitsüberwachung Korruption auf NP3 verfügte über 3 schnelle Resets innerhalb einer Stunde, die die NPdatalog-Erfassung und den automatischen LC-Neustart initiierten. |

Löst ein FAST-Reset des NP aus Und LC wird neu geladen, wenn 3 NP schnell in einer Stunde zurückgesetzt werden. |

Wenn LC mehrere Male neu geladen wird, RMA. |

| Häufigster Inaktivitätsfehler |

NP-DIAG-Fehler auf NP Interrupt aus Ucode bei höchster Inaktivität - NP wird schnell zurückgesetzt |

Löst ein FAST-Reset des NP aus Und LC wird neu geladen, wenn 3 NP schnell in einer Stunde zurückgesetzt werden. |

Wenn LC mehrere Male neu geladen wird, RMA. |

| LSP NP-Initialisierungsfehler |

LC/0/6/CPU0:23. März 02:53:56.175 IST: npu_server_lsp[138]: %PLATFORM-LDA-3-INIT_FAIL: Fehler beim Initialisieren von lda_bb_np_reset_process 13795 inst 0x2 LC INIT: NP HAL Reset np fehlgeschlagen (0x00000001 - Vorgang nicht zulässig): npu_server_lsp: (PID=4597): -Traceback= 7fea2d5cd9f6 7fea2d7d5816 7fea21465efa 7fea21465fc2 7fea42ad0bed 55a9dbd66031 7fea45e1c855 7fea45e1cc2b 7fea 2624d526 7fea3571b96a 7fea4d6e4831 55a9dbd691e9 |

Diese Informationen müssen gesammelt werden:

Die Datei wird generiert und unter rp0_xr:/misc/disk1 gespeichert.

|

LC Über CLI neu laden, um vorübergehende Probleme auszuschließen. |

| Tomahawk NP Initialisierungsfehler (DDR-Schulung fehlgeschlagen) |

+++ show prm server trace error location 0/7/CPU0 [14:36:59.520 IST Sa 29.01.2022] ++++ 97 Wrapping-Einträge (2112 möglich, 320 zugewiesen, 0 gefiltert, 97 insgesamt) 29. Jan. 00:22:10.135 prm_server/error 0/7/CPU0 t10 prm_np_Channel_PowerUp : 0x80001d46 Fehler beim Einschalten des Kanals 3 Phase 4 29. Jan. 00:22:10.136 prm_server/error 0/7/CPU0 t10 np_thread_channel_bringup : 0xa57c0200 Stromversorgungsphase 4 fehlgeschlagen auf Kanal 3 29.01.00:22:10.136 prm_server/error 0/7/CPU0 t10 np_thread_channel_bringup NP3 konnte nicht gestartet werden, und es wurde erneut versucht. Wiederholungsnummer 1 29. Jan. 00:22:35.125 prm_server/error 0/7/CPU0 t10 prm_np_Channel_PowerUp : 0x80001d46 Fehler beim Einschalten des Kanals 3 Phase 4 29. Jan. 00:22:35.125 prm_server/error 0/7/CPU0 t10 np_thread_channel_bringup : 0xa57c0200 Stromversorgungsphase 4 fehlgeschlagen auf Kanal 3 Jan 29 00:22:35.125 prm_server/error 0/7/CPU0 t10 np_thread_channel_bringup NP3 konnte nicht gestartet werden, und es wurde erneut versucht. Wiederholungsnummer 2 29. Jan. 00:22:59.075 prm_server/error 0/7/CPU0 t10 prm_np_Channel_PowerUp : 0x80001d46 Fehler beim Einschalten des Kanals 3 Phase 4 Jan. 29 00:22:59.075 prm_server/error 0/7/CPU0 t10 np_thread_channel_bringup : 0xa57c0200 Stromversorgungsphase 4 fehlgeschlagen auf Kanal 3 29.01.00:22:59.075 prm_server/error 0/7/CPU0 t10 np_thread_channel_bringup Nach 3 Versuchen konnte NP3 nicht initialisiert werden. 29. Jan. 00:23:00.087 prm_server/error 0/7/CPU0 t10 prm_send_pfm_msg: Dauerhafter NP-Initialisierungsfehler, kein erneutes Laden der Linecard erforderlich. Einchecken von NP-Treiberprotokollen <NP#3>DDR-Schulung FEHLGESCHLAGEN (Status 0x1) <NP#3>ddr3TipRunAlg: Abstimmung fehlgeschlagen 0 <NP#3>drTipRunAlgo-Opcode: ddr3TipRunAlg fehlgeschlagen (Fehler 0x1) <NP#3>*** Fehler: Unbekannt 0x1 |

Knoten: node0_7_CPU0 29. Jan. 00:22:58|8 |NP_INIT_FAIL_NO_RESET |E/A|5356 |Netzwerkprozess|0x1008000 |

LC Über CLI neu laden, um vorübergehende Probleme auszuschließen. Wenn das Problem weiterhin die RMA des LC Cisco Bug-ID CSCwa85165 |

| LSP NP Init Failure (HbmReadParticleError-Fehler) |

LC/0/13/CPU0:Jan 10 13:34:59.106 IST: npu_server_lsp[278]: %PLATFORM-NP-4-SHUTDOWN_START: NP4: EMRHIMREG.ch1Psch0HbmReadParticleFehler erkannt, NP wird heruntergefahren LC/0/13/CPU0:Jan 10 13:34:59.106 IST: pfm_node_lc[330]: %PLATFORM-NP-0-UNRECOVERABLE_ERROR: Set|npu_server_lsp[4632]|0x10a5004|Auf NP4 wurde ein nicht behebbarer Fehler erkannt. |

+++ show controller np unterbricht alle Standorte 0/13/CPU0 [16:02:16.712 IST Mon Jan 10 2022] ++++ Knoten: 0/13/CPU0: ---------------------------------------------------------------- NPU-Interruptname-ID CNT - ------------------------------------------------------------------------------------------ -------------- ------- <Snip> 4 hbmdpReg0.hbmdpExceptionLeaf0.hbmdpIntNwlHbmdpRdDataUnCorrectableErrCh1Psch1 0x201dc013 1 4 hbmdpReg0.hbmdpExceptionLeaf0.hbmdpIntNwlHbmdpRdDataUnCorrectableErrCh1Psch0 0x201dc012 1 |

Überprüfen Sie, ob die Cisco Bug-ID CSCvt59803 installiert ist. LC-Neuladen über CLI hilft bei der Wiederherstellung. |

| Arbiter-Link nicht verfügbar mit Standby |

Fabric-Manager: |

OIR der Karte, um vorübergehende Probleme auszuschließen RMA für eine Wiederholung desselben Fehlers. |

|

| Serdes-Fehler |

show serdes trace location 0/X/CPU0 | i "HTL_ERR_DEVICE_NOT_CONNECTED") werden folgende Fehler angezeigt: |

Cisco Bug-ID CSCvz75552 |

Softwarefehler |

Bekannte Fehler

| Cisco Bug-ID | Komponente | Title |

| Cisco Bug-ID CSCvy00012 | asr9k-diags-online | Erschöpfung des Paketspeichers durch online_diag_rsp |

| Cisco Bug-ID CSCvw57721 | asr9k-Servicepack | Umbrella SMU mit aktualisierter Firmware für Lightspeed NP und Arbiter-Server |

| Cisco Bug-ID CSCvz75552 | asr9k-vic-ls | Phy-Firmware hängt und verursacht, dass optische Verbindungen auf A9K-20HG-FLEX nicht erkannt werden |

| Cisco Bug-ID CSCvz76691 | asr9k-Servicepack | Umbrella SMU mit verbessertem Link Status Interrupt Handling für Tomahawk Linecards |

| Cisco Bug-ID CSCvz84139 | asr9k-ls-Fabric | fab_si-Absturz bei Router-Upgrade auf 742 |

| Cisco Bug-ID CSCwa81006 | asr9k-pfm | ASR9K/eXR kann in einigen Szenarien kein Commit für das Herunterfahren des Fehler-Manager-Datenpfad-Ports ausführen |

| Cisco Bug-ID CSCvz16840 | asr9k-fia | BLB-Sitzungen schlagen fehl, wenn CLI LC neu lädt, da der Weiterleitungspfad aufgrund von in 6.5.2 hinzugefügten Änderungen vorzeitig geschlossen wird. |

| Cisco Bug-ID CSCwb64255 | asr9k-fab-xbar | neue SI-Einstellungen für SKB im Gehäuse von Starscream (9912) und Megatron (9922) |

| Cisco Bug-ID CSCwa09794 | asr9k-fab-xbar | neue SI nach Feinabstimmung für RO-Chassis für SKB-SM15 |

| Cisco Bug-ID CSCvv45788 | asr9k-fab-xbar | fab_xbar und mgid-programmer Prozesse, die gleichzeitig darauf zugreifen |

| Cisco Bug-ID CSCwd22196 | asr9k-prm | Ausschöpfung des RFD-Puffers zwischen ILKN-Verbindung auf Tomahawk LC |

| Cisco Bug-ID CSCwb66960 | asr9k-fab-infra | ASR9k Punt Fabric-Fehlerisolierung |

| Cisco Bug-ID CSCwa79758 | asr9k-fab-xbar | Multicast-Verlust am LSP LC nach Durchführung der OIR eines anderen LSP LC mit XBAR-Verbindungsfehler |

| Cisco Bug-ID CSCvw88284 | asr9k-lda-ls | RSP5 BW auf Standard 200G im 9910/9906-Chassis anstatt 600G. |

| Cisco Bug-ID CSCvm82379 | asr9k-fab-arb | fab-arb stürzte ab, während sie sh tech fabric |

| Cisco Bug-ID CSCvh00349 | asr9k-fia | Die ASR9k-Fabric kann im Standby-Modus gesendete Ucast-Pakete verarbeiten. |

| Cisco Bug-ID CSCvk44688 | asr9k-fia | FPGA hatte wiederholt Fehler und konnte nicht wiederhergestellt werden |

| Cisco Bug-ID CSCvy31670 | asr9k-ls-fia | Sprachdienstleister: Durch Entfernen von FC0 wird die Fabric-Ratenlimitierung aktiviert. FC4 bietet keine |

| Cisco Bug-ID CSCvt59803 | asr9k-ls-npdriver | Sprachdienstleister: PLATTFORM-NP-4-SHUTDOWN IMRHIMREG.ch1Psch1HbmReadParticleError |

Verhalten von fault-manager datapath port shutdown/toggle Command

- Mit diesem

fault-manager datapath port shutdownBefehl werden die Ports der jeweiligen FIA/NP, für die der Alarm "Punt Datapath Failure" (Punt-Datenpfad-Ausfall) gesetzt wurde, auf einem aktiven RP/RSP heruntergefahren. Die Schnittstelle wird erst automatisch aktiviert, wenn Sie den LC neu laden. Dieser CLI-Befehl funktioniert nicht wie in Version 7.x.x erwartet. (CLI-Befehlfault-manager datapath port shutdownfunktioniert nicht gemäß Entwurf von 7.x.x) - behoben in 7.7.2. - Der

fault-manager datapath port toggleCLI-Befehl funktioniert einwandfrei. Er öffnet den Port, sobald der Alarm "Punt Datapath Failure" gelöscht wird. - Auf diese Weise lässt sich ein Serviceausfall verhindern, wenn die erforderliche Redundanz auf Verbindungsebene und die Bandbreitenverfügbarkeit auf dem redundanten Pfad verfügbar sind.

Testen: Überprüfen der oben genannten Befehlsoperation

Einleitung der PUNT-Fehlergenerierung auf NP0 LC7:

RP/0/RP0/CPU0:ASR-9922-A#monitor np counter PUNT_DIAGS_RSP_ACT np0 count 20 location 0/7/CPU0

Wed Jul 7 14:15:17.489 UTC

Usage of NP monitor is recommended for cisco internal use only.

Please use instead 'show controllers np capture' for troubleshooting packet drops in NP

and 'monitor np interface' for per (sub)interface counter monitoring

Warning: Every packet captured will be dropped! If you use the 'count'

option to capture multiple protocol packets, this could disrupt

protocol sessions (eg, OSPF session flap). So if capturing protocol

packets, capture only 1 at a time.

Warning: A mandatory NP reset will be done after monitor to clean up.

This will cause ~150ms traffic outage. Links will stay Up.

Proceed y/n [y] > y

Monitor PUNT_DIAGS_RSP_ACT on NP0 ... (Ctrl-C to quit)

Wed Jul 7 14:17:08 2021 -- NP0 packet

From Fabric: 127 byte packet

0000: 00 09 00 00 b4 22 00 00 ff ff ff ff 00 00 ff ff ....4"..........

0010: 00 ff 00 ff f0 f0 f0 f0 cc cc cc cc aa aa aa aa ....ppppLLLL****

0020: 55 55 55 55 00 00 00 00 01 00 00 00 00 00 00 00 UUUU............

0030: 00 00 00 00 ff ff ff ff 00 00 ff ff 00 ff 00 ff ................

0040: f0 f0 f0 f0 cc cc cc cc aa aa aa aa 55 55 55 55 ppppLLLL****UUUU

0050: 00 00 00 00 01 00 00 00 00 00 00 00 00 00 00 00 ................

0060: ff ff ff ff 00 00 ff ff 00 ff 00 ff f0 f0 f0 f0 ............pppp

0070: cc cc cc cc aa aa aa aa 55 55 55 55 00 00 00 LLLL****UUUU...

(count 1 of 20)

Wed Jul 7 14:18:09 2021 -- NP0 packet

From Fabric: 256 byte packet

0000: 00 09 00 00 b5 22 00 00 ff ff ff ff 00 00 ff ff ....5"..........

0010: 00 ff 00 ff f0 f0 f0 f0 cc cc cc cc aa aa aa aa ....ppppLLLL****

0020: 55 55 55 55 00 00 00 00 01 00 00 00 00 00 00 00 UUUU............

0030: 00 00 00 00 ff ff ff ff 00 00 ff ff 00 ff 00 ff ................

0040: f0 f0 f0 f0 cc cc cc cc aa aa aa aa 55 55 55 55 ppppLLLL****UUUU

0050: 00 00 00 00 01 00 00 00 00 00 00 00 00 00 00 00 ................

0060: ff ff ff ff 00 00 ff ff 00 ff 00 ff f0 f0 f0 f0 ............pppp

0070: cc cc cc cc aa aa aa aa 55 55 55 55 00 00 00 00 LLLL****UUUU....

0080: 01 00 00 00 00 00 00 00 00 00 00 00 ff ff ff ff ................

0090: 00 00 ff ff 00 ff 00 ff f0 f0 f0 f0 cc cc cc cc ........ppppLLLL

00a0: aa aa aa aa 55 55 55 55 00 00 00 00 01 00 00 00 ****UUUU........

00b0: 00 00 00 00 00 00 00 00 ff ff ff ff 00 00 ff ff ................

00c0: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

00d0: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

00e0: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

00f0: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

(count 2 of 20)

Wed Jul 7 14:19:09 2021 -- NP0 packet

Actual packet size 515 bytes truncated size 384:

From Fabric: 384 byte packet

0000: 00 09 00 00 b6 22 00 00 ff ff ff ff 00 00 ff ff ....6"..........

0010: 00 ff 00 ff f0 f0 f0 f0 cc cc cc cc aa aa aa aa ....ppppLLLL****

0020: 55 55 55 55 00 00 00 00 01 00 00 00 00 00 00 00 UUUU............

0030: 00 00 00 00 ff ff ff ff 00 00 ff ff 00 ff 00 ff ................

0040: f0 f0 f0 f0 cc cc cc cc aa aa aa aa 55 55 55 55 ppppLLLL****UUUU

0050: 00 00 00 00 01 00 00 00 00 00 00 00 00 00 00 00 ................

0060: ff ff ff ff 00 00 ff ff 00 ff 00 ff f0 f0 f0 f0 ............pppp

0070: cc cc cc cc aa aa aa aa 55 55 55 55 00 00 00 00 LLLL****UUUU....

0080: 01 00 00 00 00 00 00 00 00 00 00 00 ff ff ff ff ................

0090: 00 00 ff ff 00 ff 00 ff f0 f0 f0 f0 cc cc cc cc ........ppppLLLL

00a0: aa aa aa aa 55 55 55 55 00 00 00 00 01 00 00 00 ****UUUU........

00b0: 00 00 00 00 00 00 00 00 ff ff ff ff 00 00 ff ff ................

00c0: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

00d0: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

00e0: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

00f0: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

0100: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

0110: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

0120: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

0130: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

0140: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

0150: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

0160: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

0170: 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 ................

RP/0/RP0/CPU0:ASR-9922-A#sh pfm location 0/RP0/CPU0

Wed Jul 7 14:19:17.174 UTC

node: node0_RP0_CPU0

---------------------

CURRENT TIME: Jul 7 14:19:17 2021

PFM TOTAL: 2 EMERGENCY/ALERT(E/A): 1 CRITICAL(CR): 0 ERROR(ER): 1

-------------------------------------------------------------------------------------------------

Raised Time |S#|Fault Name |Sev|Proc_ID|Dev/Path Name |Handle

--------------------+--+-----------------------------------+---+-------+--------------+----------

Jul 1 10:13:45 2021|0 |SPINE_UNAVAILABLE |E/A|5082 |Fabric Manager|0x1034000

Jul 7 14:19:09 2021|0 |PUNT_FABRIC_DATA_PATH_FAILED |ER |9429 |System Punt/Fa|0x2000004

RP/0/RP0/CPU0:ASR-9922-A#sh pfm process 9429 location 0/Rp0/CPU0

Wed Jul 7 14:19:37.128 UTC

node: node0_RP0_CPU0

---------------------

CURRENT TIME: Jul 7 14:19:37 2021

PFM TOTAL: 2 EMERGENCY/ALERT(E/A): 1 CRITICAL(CR): 0 ERROR(ER): 1

PER PROCESS TOTAL: 0 EM: 0 CR: 0 ER: 0

Device/Path[1 ]:Fabric loopbac [0x2000003 ] State:RDY Tot: 0

Device/Path[2 ]:System Punt/Fa [0x2000004 ] State:RDY Tot: 1

1 Fault Id: 432

Sev: ER

Fault Name: PUNT_FABRIC_DATA_PATH_FAILED

Raised Timestamp: Jul 7 14:19:09 2021

Clear Timestamp: N/A

Changed Timestamp: N/A

Resync Mismatch: FALSE

MSG: failure threshold is 3, (slot, NP) failed: (0/7/CPU0, 0)

Device/Path[3 ]:Crossbar Switc [0x108c000 ] State:RDY Tot: 0

Device/Path[4 ]:Crossbar Switc [0x108c001 ] State:RDY Tot: 0

Device/Path[5 ]:Crossbar Switc [0x108c002 ] State:RDY Tot: 0

Device/Path[6 ]:Crossbar Switc [0x108c003 ] State:RDY Tot: 0

Device/Path[7 ]:Crossbar Switc [0x108c004 ] State:RDY Tot: 0

Device/Path[8 ]:Crossbar Switc [0x108c005 ] State:RDY Tot: 0

Device/Path[9 ]:Crossbar Switc [0x108c006 ] State:RDY Tot: 0

Device/Path[10]:Crossbar Switc [0x108c007 ] State:RDY Tot: 0

Device/Path[11]:Crossbar Switc [0x108c008 ] State:RDY Tot: 0

Device/Path[12]:Crossbar Switc [0x108c009 ] State:RDY Tot: 0

Device/Path[13]:Crossbar Switc [0x108c00a ] State:RDY Tot: 0

Device/Path[14]:Crossbar Switc [0x108c00b ] State:RDY Tot: 0

Device/Path[15]:Crossbar Switc [0x108c00c ] State:RDY Tot: 0

Device/Path[16]:Crossbar Switc [0x108c00d ] State:RDY Tot: 0

Device/Path[17]:Crossbar Switc [0x108c00e ] State:RDY Tot: 0

Device/Path[18]:Fabric Interfa [0x108b000 ] State:RDY Tot: 0

Device/Path[19]:Fabric Arbiter [0x1086000 ] State:RDY Tot: 0

Device/Path[20]:CPU Controller [0x108d000 ] State:RDY Tot: 0

Device/Path[21]:Device Control [0x109a000 ] State:RDY Tot: 0

Device/Path[22]:ClkCtrl Contro [0x109b000 ] State:RDY Tot: 0

Device/Path[23]:NVRAM [0x10ba000 ] State:RDY Tot: 0

Device/Path[24]:Hooper switch [0x1097000 ] State:RDY Tot: 0

Device/Path[25]:Hooper switch [0x1097001 ] State:RDY Tot: 0

Device/Path[26]:Hooper switch [0x1097002 ] State:RDY Tot: 0

Device/Path[27]:Hooper switch [0x1097003 ] State:RDY Tot: 0

Der Port fiel in diesem Fall nicht aus:

RP/0/RP0/CPU0:ASR-9922-A#sh ipv4 int brief location 0/7/CPU0

Wed Jul 7 14:21:29.693 UTC

Interface IP-Address Status Protocol Vrf-Name

TenGigE0/7/0/0 unassigned Down Down default

TenGigE0/7/0/1 unassigned Down Down default

TenGigE0/7/0/2 unassigned Down Down default

TenGigE0/7/0/3 unassigned Down Down default

TenGigE0/7/0/4 unassigned Down Down default

TenGigE0/7/0/5 unassigned Down Down default

TenGigE0/7/0/6 unassigned Down Down default

TenGigE0/7/0/7 unassigned Shutdown Down default

TenGigE0/7/0/8 unassigned Shutdown Down default

TenGigE0/7/0/9 unassigned Shutdown Down default

TenGigE0/7/0/10 unassigned Down Down default

TenGigE0/7/0/11 unassigned Down Down default

TenGigE0/7/0/12 unassigned Down Down default

TenGigE0/7/0/13 unassigned Shutdown Down default

TenGigE0/7/0/14 unassigned Shutdown Down default

TenGigE0/7/0/15 unassigned Shutdown Down default

TenGigE0/7/0/16 unassigned Shutdown Down default

TenGigE0/7/0/17 unassigned Shutdown Down default

TenGigE0/7/0/18 unassigned Down Down default

TenGigE0/7/0/19 unassigned Up Up default >>>>>>> Port is UP

RP/0/RP0/CPU0:ASR-9922-A#sh logging last 200 | in 0/7/0

Wed Jul 7 14:22:35.715 UTC

RP/0/RP0/CPU0:ASR-9922-A#

Testfall 1.2:

Verhalten von NP/Ports mit dem fault-manager datapath port toggle Befehl:

RP/0/RP0/CPU0:ASR-9922-A#sh run formal | in data

Wed Jul 7 14:52:11.714 UTC

Building configuration...

fault-manager datapath port toggle

RP/0/RP0/CPU0:ASR-9922-A#

Kein Alarm in PFM:

RP/0/RP0/CPU0:ASR-9922-A#sh pfm location 0/Rp0/CPU0

Wed Jul 7 14:55:13.410 UTC

node: node0_RP0_CPU0

---------------------

CURRENT TIME: Jul 7 14:55:13 2021

PFM TOTAL: 1 EMERGENCY/ALERT(E/A): 1 CRITICAL(CR): 0 ERROR(ER): 0

-------------------------------------------------------------------------------------------------

Raised Time |S#|Fault Name |Sev|Proc_ID|Dev/Path Name |Handle

--------------------+--+-----------------------------------+---+-------+--------------+----------

Jul 1 10:13:45 2021|0 |SPINE_UNAVAILABLE |E/A|5082 |Fabric Manager|0x1034000

RP/0/RP0/CPU0:ASR-9922-A#

PUNT-Fehlergenerierung in NP0 LC7:

RP/0/RP0/CPU0:ASR-9922-A#monitor np counter PUNT_DIAGS_RSP_ACT np0 count 20 location 0/7/CPU0

Wed Jul 7 14:51:18.596 UTC

Usage of NP monitor is recommended for cisco internal use only.

Please use instead 'show controllers np capture' for troubleshooting packet drops in NP

and 'monitor np interface' for per (sub)interface counter monitoring

Warning: Every packet captured will be dropped! If you use the 'count'

option to capture multiple protocol packets, this could disrupt

protocol sessions (eg, OSPF session flap). So if capturing protocol

packets, capture only 1 at a time.

Warning: A mandatory NP reset will be done after monitor to clean up.

This will cause ~150ms traffic outage. Links will stay Up.

Proceed y/n [y] > y

Monitor PUNT_DIAGS_RSP_ACT on NP0 ... (Ctrl-C to quit)

Wed Jul 7 14:53:21 2021 -- NP0 packet

From Fabric: 127 byte packet

0000: 00 09 00 00 d8 22 00 00 ff ff ff ff 00 00 ff ff ....X"..........

0010: 00 ff 00 ff f0 f0 f0 f0 cc cc cc cc aa aa aa aa ....ppppLLLL****

0020: 55 55 55 55 00 00 00 00 01 00 00 00 00 00 00 00 UUUU............

0030: 00 00 00 00 ff ff ff ff 00 00 ff ff 00 ff 00 ff ................

0040: f0 f0 f0 f0 cc cc cc cc aa aa aa aa 55 55 55 55 ppppLLLL****UUUU

0050: 00 00 00 00 01 00 00 00 00 00 00 00 00 00 00 00 ................

0060: ff ff ff ff 00 00 ff ff 00 ff 00 ff f0 f0 f0 f0 ............pppp