Fehlerbehebung bei Firepower Threat Defense (FTD)-Clustern

Download-Optionen

-

ePub (4.1 MB)

In verschiedenen Apps auf iPhone, iPad, Android, Sony Reader oder Windows Phone anzeigen

Inklusive Sprache

In dem Dokumentationssatz für dieses Produkt wird die Verwendung inklusiver Sprache angestrebt. Für die Zwecke dieses Dokumentationssatzes wird Sprache als „inklusiv“ verstanden, wenn sie keine Diskriminierung aufgrund von Alter, körperlicher und/oder geistiger Behinderung, Geschlechtszugehörigkeit und -identität, ethnischer Identität, sexueller Orientierung, sozioökonomischem Status und Intersektionalität impliziert. Dennoch können in der Dokumentation stilistische Abweichungen von diesem Bemühen auftreten, wenn Text verwendet wird, der in Benutzeroberflächen der Produktsoftware fest codiert ist, auf RFP-Dokumentation basiert oder von einem genannten Drittanbieterprodukt verwendet wird. Hier erfahren Sie mehr darüber, wie Cisco inklusive Sprache verwendet.

Informationen zu dieser Übersetzung

Cisco hat dieses Dokument maschinell übersetzen und von einem menschlichen Übersetzer editieren und korrigieren lassen, um unseren Benutzern auf der ganzen Welt Support-Inhalte in ihrer eigenen Sprache zu bieten. Bitte beachten Sie, dass selbst die beste maschinelle Übersetzung nicht so genau ist wie eine von einem professionellen Übersetzer angefertigte. Cisco Systems, Inc. übernimmt keine Haftung für die Richtigkeit dieser Übersetzungen und empfiehlt, immer das englische Originaldokument (siehe bereitgestellter Link) heranzuziehen.

Inhalt

Einleitung

In diesem Dokument wird die Fehlerbehebung bei einer Cluster-Konfiguration auf der Firepower Next-Generation Firewall (NGFW) beschrieben.

Voraussetzungen

Anforderungen

Cisco empfiehlt, dass Sie über Kenntnisse in diesen Themen verfügen (Links finden Sie im Abschnitt "Verwandte Informationen"):

- FirePOWER Plattformarchitektur

- Konfiguration und Betrieb des FirePOWER Clusters

- Vertrautheit mit FTD und FirePOWER eXtensible Operating System (FXOS) CLI

- NGFW-/Datenebenenprotokolle

- NGFW/Datenebene - Paketverfolgung

- FXOS/Datenebenenerfassung

Verwendete Komponenten

- HW: FirePOWER 4125

- SW: 6.7.0 (Build 65) - Datenebene 9.15(1)

Die Informationen in diesem Dokument beziehen sich auf Geräte in einer speziell eingerichteten Testumgebung. Alle Geräte, die in diesem Dokument benutzt wurden, begannen mit einer gelöschten (Nichterfüllungs) Konfiguration. Wenn Ihr Netzwerk in Betrieb ist, stellen Sie sicher, dass Sie die möglichen Auswirkungen aller Befehle kennen.

Hintergrundinformationen

Die meisten der in diesem Dokument behandelten Aspekte gelten auch für die Fehlerbehebung in Clustern der Adaptive Security Appliance (ASA).

Konfigurieren

Der Konfigurationsteil einer Cluster-Bereitstellung wird in den FMC- und FXOS-Konfigurationsleitfäden behandelt:

- Clustering für die FirePOWER Threat Defense

- Bereitstellung eines Clusters für FirePOWER Threat Defense für Skalierbarkeit und hohe Verfügbarkeit

Cluster-Grundlagen

NGFW-Architektur

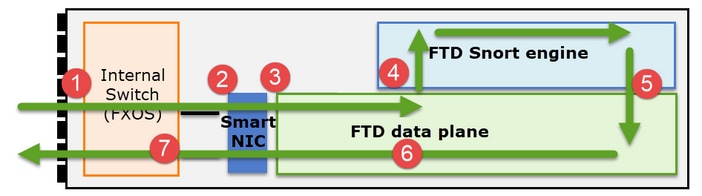

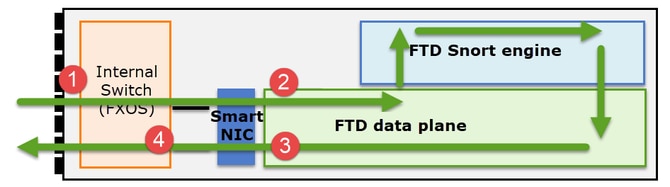

Es ist wichtig zu verstehen, wie eine FirePOWER 41xx- oder 93xx-Serie Transitpakete behandelt:

- Ein Paket gelangt an die Eingangsschnittstelle, und es wird vom internen Chassis-Switch verarbeitet.

- Das Paket durchläuft die Smart NIC. Wenn der Datenfluss ausgelagert wird (HW-Beschleunigung), wird das Paket nur von der Smart NIC verarbeitet und dann an das Netzwerk zurückgesendet.

- Wenn das Paket nicht ausgelagert wird, gelangt es auf die FTD-Datenebene, die hauptsächlich L3-/L4-Prüfungen durchführt.

- Wenn die Richtlinie dies erfordert, wird das Paket von der Snort-Engine geprüft (hauptsächlich L7-Inspektion).

- Die Snort-Engine gibt ein Urteil für das Paket zurück (z. B. Zulassen oder Blockieren).

- Die Datenebene verwirft oder leitet das Paket basierend auf dem Urteil von Snort weiter.

- Das Paket gelangt über den internen Chassis-Switch aus dem Chassis.

Cluster erfasst

FirePOWER-Appliances stellen mehrere Erfassungspunkte bereit, die einen Überblick über die Datenverkehrsflüsse geben. Wenn Sie die Fehlerbehebung durchführen und Cluster-Erfassungen aktivieren, bestehen die folgenden Hauptprobleme:

- Die Anzahl der Aufnahmen steigt mit der Anzahl der Einheiten im Cluster.

- Sie müssen wissen, wie der Cluster einen bestimmten Fluss behandelt, um das Paket durch den Cluster verfolgen zu können.

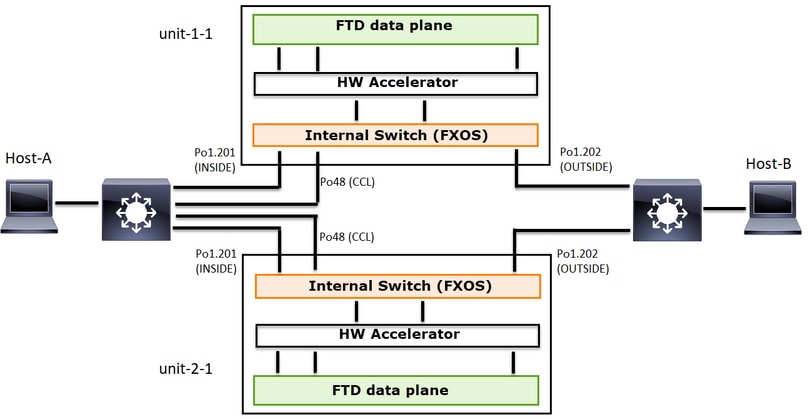

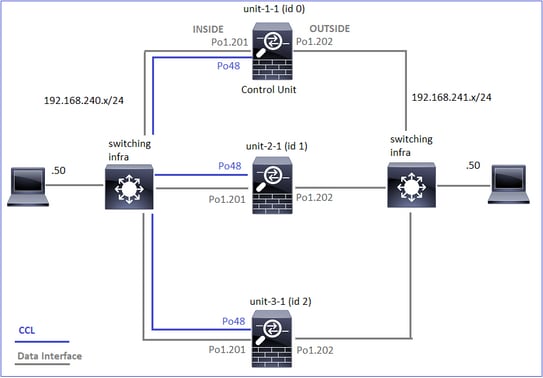

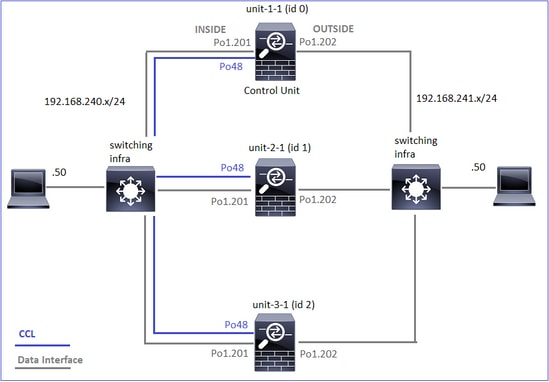

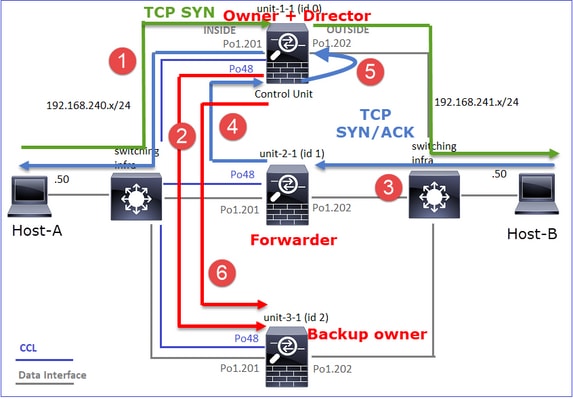

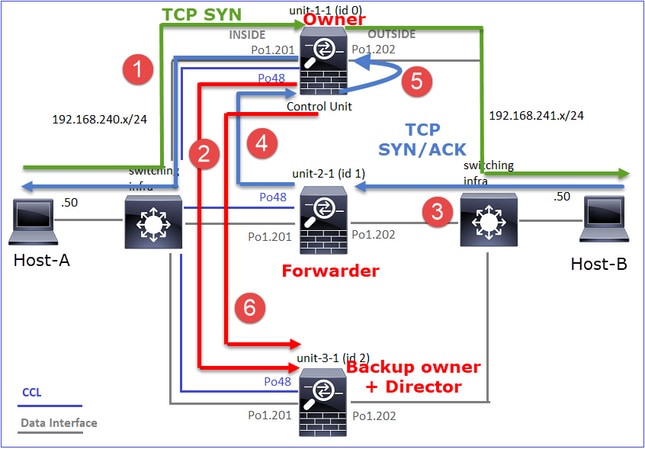

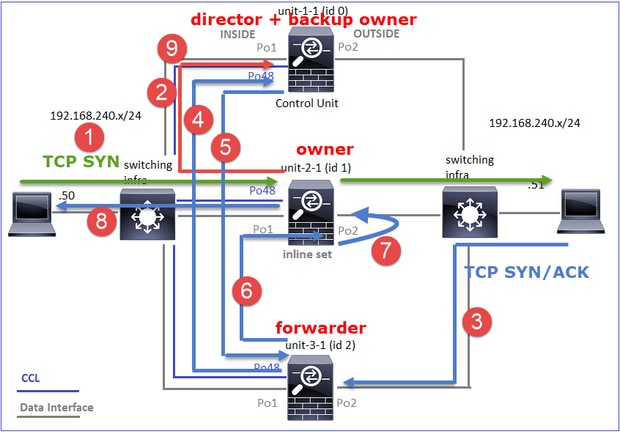

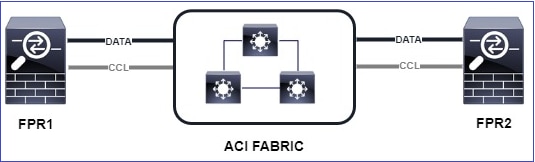

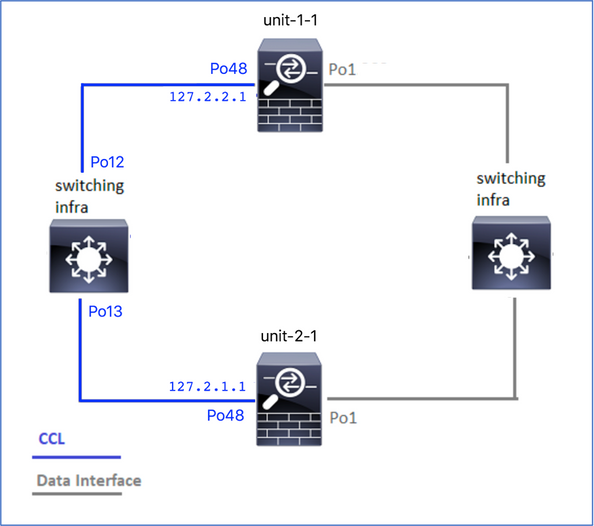

Dieses Diagramm zeigt ein Cluster mit 2 Einheiten (z. B. FP941xx/FP9300):

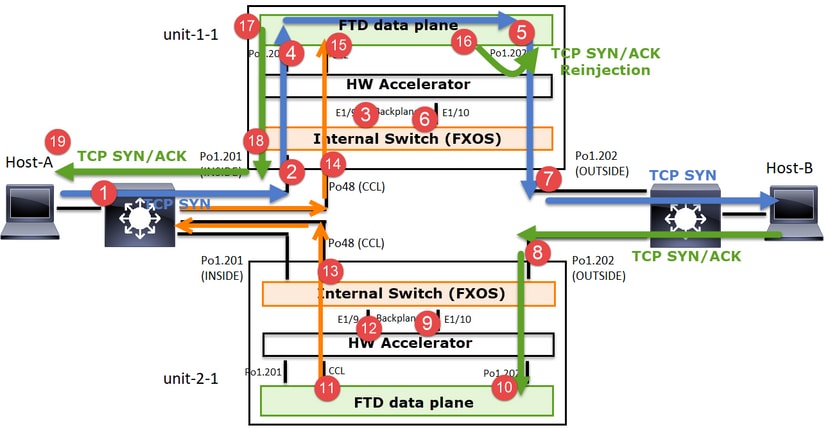

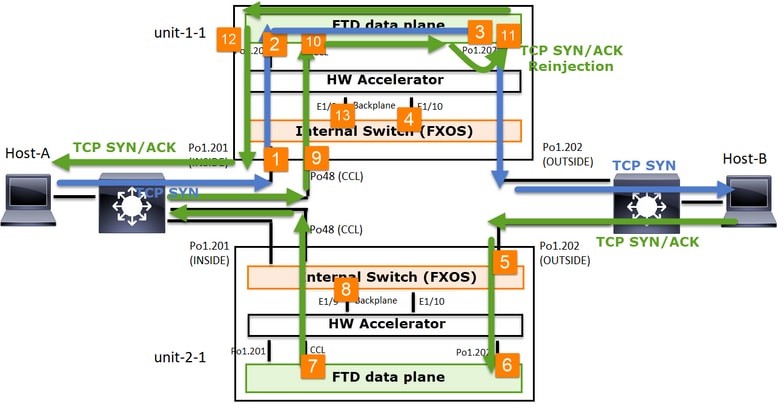

Im Fall einer asymmetrischen TCP-Verbindung sieht ein TCP SYN-, SYN/ACK-Austausch wie folgt aus:

Datenverkehr weiterleiten

- TCP-SYN wird von Host-A an Host-B gesendet.

- Das TCP-SYN erreicht das Chassis (eines der Elemente von Po1).

- TCP-SYN wird über eine der Backplane-Schnittstellen des Chassis (z. B. E1/9, E1/10 usw.) an die Datenebene gesendet.

- Das TCP-SYN kommt auf der Datenebene der Eingangsschnittstelle an (Po1.201/INSIDE). In diesem Beispiel übernimmt unit1-1 die Verantwortung für den Datenfluss, führt die Zufallszuweisung für die Initial Sequence Number (ISN) durch und codiert die Besitzinformationen (Cookies) in der Sequenznummer.

- TCP SYN wird von Po1.202/OUTSIDE (Datenebenen-Ausgangsschnittstelle) gesendet.

- Das TCP-SYN kommt an einer der Schnittstellen der Chassis-Backplane an (z. B. E1/9, E1/10 usw.).

- Das TCP-SYN wird von der physischen Schnittstelle des Chassis (eines der Elemente von Po1) an Host B gesendet.

Rückverkehr

- TCP SYN/ACK wird von Host B gesendet und kommt auf Einheit 2-1 an (einem der Elemente von Po1).

- TCP SYN/ACK wird über eine der Backplane-Schnittstellen des Chassis (z. B. E1/9, E1/10 usw.) an die Datenebene gesendet.

- TCP SYN/ACK kommt an der Datenebenen-Eingangsschnittstelle an (Po1.202/OUTSIDE).

- TCP-SYN/ACK wird von der Cluster Control Link (CCL) an Unit-1-1 gesendet. ISN ist standardmäßig aktiviert. So findet der Forwarder die Eigentümer-Info für TCP SYN+ACKs ohne die Beteiligung des Direktors. Bei anderen Paketen oder wenn ISN deaktiviert ist, wird der Director abgefragt.

- TCP SYN/ACK kommt an einer der Schnittstellen der Chassis-Backplane an (z. B. E1/9, E1/10 usw.).

- TCP-SYN/ACK wird von der physischen Schnittstelle des Chassis (eines der Elemente von Po48) an Einheit 1-1 gesendet.

- TCP SYN/ACK kommt an Einheit 1-1 an (einem der Mitglieder von Po48).

- TCP SYN/ACK wird über eine der Backplane-Schnittstellen des Chassis an die CCL-Port-Channel-Schnittstelle der Datenebene (Namensfeld-Cluster) weitergeleitet.

- Die Datenebene sendet das TCP SYN/ACK-Paket wieder an die Datenebenenschnittstelle Po1.202/OUTSIDE.

- TCP SYN/ACK wird von Po1.201/INSIDE (Datenebenen-Ausgangsschnittstelle) an HOST-A gesendet.

- Das TCP-SYN/ACK durchläuft eine der Backplane-Schnittstellen des Chassis (z. B. E1/9, E1/10 usw.) und geht aus einem der Elemente von Po1 aus.

- TCP SYN/ACK erreicht Host A.

Weitere Einzelheiten zu diesem Szenario finden Sie im entsprechenden Abschnitt in den Anwenderberichten zu Cluster Connection Establishment.

Basierend auf diesem Paketaustausch sind alle möglichen Cluster-Erfassungspunkte:

Für den Weiterleitungsverkehr (z. B. TCP SYN) erfassen Sie Folgendes:

- Die physische Schnittstelle des Chassis (z. B. Po1-Elemente). Diese Erfassung wird über die Benutzeroberfläche des Chassis Managers (CM) oder die CM-CLI konfiguriert.

- Datenebene-Eingangsschnittstelle (z. B. Po1.201 INSIDE).

- Ausgangsschnittstelle der Datenebene (z. B. Po1.202 OUTSIDE).

- Schnittstellen für Chassis-Backplane Der FP4100 verfügt über 2 Backplane-Schnittstellen. Beim FP9300 sind es insgesamt 6 (2 pro Modul). Da Sie nicht wissen, an welcher Schnittstelle das Paket ankommt, müssen Sie die Erfassung an allen Schnittstellen aktivieren.

Erfassung des zurückfließenden Datenverkehrs (z. B. TCP SYN/ACK) auf:

- Die physische Schnittstelle des Chassis (z. B. Po1-Elemente). Diese Erfassung wird über die Benutzeroberfläche des Chassis Managers (CM) oder die CM-CLI konfiguriert.

- Datenebene-Eingangsschnittstelle (z. B. Po1.202 OUTSIDE).

- Da das Paket umgeleitet wird, ist der nächste Erfassungspunkt die Datenebene CCL.

- Schnittstellen für Chassis-Backplane Auch hier müssen Sie die Erfassung auf beiden Schnittstellen aktivieren.

- Schnittstellen der CCL-Mitglieder im 1-HE-Chassis.

- CCL-Schnittstelle auf Datenebene (name-if-Cluster).

- Eingangsschnittstelle (Po1.202 OUTSIDE). Hierbei handelt es sich um das neu injizierte Paket von CCL zur Datenebene.

- Ausgangsschnittstelle der Datenebene (z. B. Po1.201 INSIDE).

- Schnittstellen für Chassis-Backplane

So aktivieren Sie die Clustererfassung

FXOS-Erfassungen

Der Vorgang wird in der FXOS-Konfigurationsanleitung beschrieben: Paketerfassung

Anmerkung: FXOS-Erfassungen können aus Sicht des internen Switches nur in Eingangsrichtung durchgeführt werden.

Erfassung der Datenebene

Die empfohlene Methode zum Aktivieren der Erfassung für alle Cluster-Mitglieder ist der Befehl cluster exec.

Stellen Sie sich einen Cluster mit drei Einheiten vor:

Verwenden Sie den folgenden Befehl, um zu überprüfen, ob in allen Cluster-Einheiten aktive Erfassungen vorhanden sind:

firepower# cluster exec show capture

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

So aktivieren Sie die Erfassung der Datenebene für alle Geräte an Po1.201 (INSIDE):

firepower# cluster exec capture CAPI interface INSIDE

Es wird dringend empfohlen, einen Erfassungsfilter anzugeben und den Erfassungspuffer zu erhöhen, falls ein hoher Datenverkehr erwartet wird:

firepower# cluster exec capture CAPI buffer 33554432 interface INSIDE match tcp host 192.168.240.50 host 192.168.241.50 eq 80

Verifizierung

firepower# cluster exec show capture

unit-1-1(LOCAL):******************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 5140 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 260 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

So zeigen Sie den Inhalt aller Aufnahmen an (diese Ausgabe kann sehr lang sein):

firepower# terminal pager 24

firepower# cluster exec show capture CAPI

unit-1-1(LOCAL):******************************************************

21 packets captured

1: 11:33:09.879226 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: S 2225395909:2225395909(0) win 29200 <mss 1460,sackOK,timestamp 1110209649 0,nop,wscale 7>

2: 11:33:09.880401 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.45456: S 719653963:719653963(0) ack 2225395910 win 28960 <mss 1380,sackOK,timestamp 1120565119 1110209649,nop,wscale 7>

3: 11:33:09.880691 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: . ack 719653964 win 229 <nop,nop,timestamp 1110209650 1120565119>

4: 11:33:09.880783 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: P 2225395910:2225396054(144) ack 719653964 win 229 <nop,nop,timestamp 1110209650 1120565119>

unit-2-1:*************************************************************

0 packet captured

0 packet shown

unit-3-1:*************************************************************

0 packet captured

0 packet shown

Traces erfassen

Wenn Sie sehen möchten, wie die eingehenden Pakete auf der Datenebene der einzelnen Einheiten behandelt werden, verwenden Sie das trace-Schlüsselwort. Dadurch werden die ersten 50 Eingangspakete nachverfolgt. Sie können bis zu 1000 eingehende Pakete verfolgen.

Anmerkung: Wenn auf eine Schnittstelle mehrere Erfassungen angewendet werden, können Sie ein einzelnes Paket nur einmal verfolgen.

So verfolgen Sie die ersten 1.000 Eingangspakete an der Schnittstelle OUTSIDE auf allen Cluster-Einheiten:

firepower# cluster exec cap CAPO int OUTSIDE buff 33554432 trace trace-count 1000 match tcp host 192.168.240.50 host 192.168.241.50 eq www

Sobald Sie den Fluss des Interesses erfassen, müssen Sie sicherstellen, dass Sie die Pakete des Interesses auf jeder Einheit verfolgen. Dabei ist zu beachten, dass ein bestimmtes Paket #1 in Einheit-1-1, #2 in einer anderen Einheit usw. sein kann.

In diesem Beispiel sehen Sie, dass SYN/ACK Paket #2 auf Einheit-2-1 ist, Paket #1 auf Einheit-3-1:

firepower# cluster exec show capture CAPO | include S.*ack

unit-1-1(LOCAL):******************************************************

1: 12:58:31.117700 802.1Q vlan#202 P0 192.168.240.50.45468 > 192.168.241.50.80: S 441626016:441626016(0) win 29200 <mss 1380,sackOK,timestamp 1115330849 0,nop,wscale 7>

2: 12:58:31.118341 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

1: 12:58:31.111429 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

So verfolgen Sie das Paket #2 (SYN/ACK) auf der lokalen Einheit:

firepower# cluster exec show cap CAPO packet-number 2 trace

unit-1-1(LOCAL):******************************************************

2: 12:58:31.118341 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Phase: 1

Type: CAPTURE

Subtype:

Result: ALLOW

Config:

Additional Information:

MAC Access list

...

So verfolgen Sie dasselbe Paket (SYN/ACK) auf der Remote-Einheit:

firepower# cluster exec unit unit-3-1 show cap CAPO packet-number 1 trace

1: 12:58:31.111429 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Phase: 1

Type: CAPTURE

Subtype:

Result: ALLOW

Config:

Additional Information:

MAC Access list

...

CCL-Erfassung

So aktivieren Sie die Erfassung für den CCL-Link (für alle Einheiten):

firepower# cluster exec capture CCL interface cluster

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Ausblenden erneut einwerfen

Eine auf einer Datenschnittstelle der Datenebene aktivierte Erfassung zeigt standardmäßig alle Pakete an:

- Diejenigen, die vom physischen Netzwerk eintreffen

- Diejenigen, die aus der CCL zurückgegeben werden

Wenn Sie die neu eingefügten Pakete nicht anzeigen möchten, verwenden Sie die Option reject-hide. Dies kann hilfreich sein, wenn Sie überprüfen möchten, ob ein Datenfluss asymmetrisch ist:

firepower# cluster exec capture CAPI_RH reinject-hide interface INSIDE match tcp host 192.168.240.50 host 192.168.241.50 eq 80

Diese Erfassung zeigt Ihnen nur, was die lokale Einheit auf der spezifischen Schnittstelle tatsächlich direkt vom physischen Netzwerk und nicht von den anderen Cluster-Einheiten erhält.

ASP-Drops

Wenn Sie für einen bestimmten Datenfluss nach Softwareverwerfen suchen möchten, können Sie die asp-drop-Erfassung aktivieren. Wenn Sie nicht wissen, auf welchen Grund Sie sich konzentrieren sollten, verwenden Sie das Schlüsselwort all. Wenn Sie sich nicht für die Paketnutzlast interessieren, können Sie außerdem das Schlüsselwort header-only angeben. So können Sie 20- bis 30-mal mehr Pakete erfassen:

firepower# cluster exec cap ASP type asp-drop all buffer 33554432 headers-only

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Darüber hinaus können Sie die für die ASP-Erfassung relevanten IPs angeben:

firepower# cluster exec cap ASP type asp-drop all buffer 33554432 headers-only match ip host 192.0.2.100 any

Erfassung löschen

Zum Löschen des Puffers von jeder Erfassung, die in allen Cluster-Einheiten ausgeführt wird. Dies stoppt die Aufnahmen nicht, sondern löscht nur die Puffer:

firepower# cluster exec clear capture /all

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Erfassen stoppen

Es gibt zwei Möglichkeiten, eine aktive Erfassung auf allen Cluster-Einheiten zu stoppen. Später können Sie fortfahren.

Weg 1

firepower# cluster exec cap CAPI stop

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Fortsetzen

firepower# cluster exec no capture CAPI stop

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Weg 2

firepower# cluster exec no capture CAPI interface INSIDE

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Fortsetzen

firepower# cluster exec capture CAPI interface INSIDE

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Erfassen

Es gibt mehrere Möglichkeiten, eine Erfassung zu exportieren.

Weg 1 - Zu einem Remote-Server

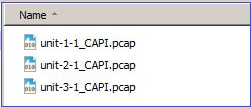

Auf diese Weise können Sie eine Aufzeichnung von der Datenebene auf einen Remote-Server (z. B. TFTP) hochladen. Die Erfassungsnamen werden automatisch entsprechend der Quelleinheit geändert:

firepower# cluster exec copy /pcap capture:CAPI tftp://192.168.240.55/CAPI.pcap

unit-1-1(LOCAL):******************************************************

Source capture name [CAPI]?

Address or name of remote host [192.168.240.55]?

Destination filename [CAPI.pcap]?

INFO: Destination filename is changed to unit-1-1_CAPI.pcap !!!!!!!

81 packets copied in 0.40 secs

unit-2-1:*************************************************************

INFO: Destination filename is changed to unit-2-1_CAPI.pcap !

unit-3-1:*************************************************************

INFO: Destination filename is changed to unit-3-1_CAPI.pcap !

Die hochgeladenen pcap-Dateien:

Weg 2 - Holen Sie die Aufnahmen vom FMC

Diese Methode gilt nur für FTD. Zuerst kopieren Sie die Aufnahme auf die FTD-Diskette:

firepower# cluster exec copy /pcap capture:CAPI disk0:CAPI.pcap

unit-1-1(LOCAL):******************************************************

Source capture name [CAPI]?

Destination filename [CAPI.pcap]?

!!!!!

62 packets copied in 0.0 secs

Kopieren Sie im Expertenmodus die Datei aus dem Verzeichnis /mnt/disk0/ in das Verzeichnis /ngfw/var/common/:

> expert

admin@firepower:~$ cd /mnt/disk0

admin@firepower:/mnt/disk0$ sudo cp CAPI.pcap /ngfw/var/common

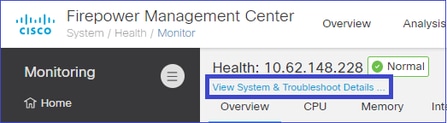

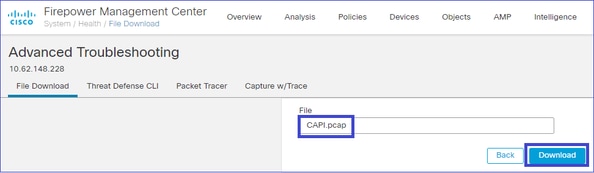

Navigieren Sie abschließend auf FMC zum Abschnitt System > Health > Monitor (System > Integrität > Monitor). Wählen Sie View System & Troubleshoot Details > Advanced Troubleshooting und holen Sie die Erfassungsdatei:

Erfassung löschen

Um eine Erfassung aus allen Cluster-Einheiten zu entfernen, verwenden Sie den folgenden Befehl:

firepower# cluster exec no capture CAPI

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Ausgelagerte Ströme

Auf FP41xx/FP9300 können Flows entweder statisch (z. B. Fastpath-Regeln) oder dynamisch an HW Accelerator ausgelagert werden. Weitere Informationen zum Flow-Offload finden Sie in diesem Dokument:

Wird ein Datenfluss ausgelagert, passieren nur wenige Pakete die FTD-Datenebene. Der Rest übernimmt der Hardware-Beschleuniger (Smart NIC).

Aus Sicht der Erfassung bedeutet dies, dass Sie nicht alle Pakete sehen, die das Gerät durchlaufen, wenn Sie nur Aufzeichnungen auf FTD-Datenebene aktivieren. In diesem Fall müssen Sie auch FXOS-Erfassungen auf Chassis-Ebene aktivieren.

Cluster Control Link (CCL)-Nachrichten

Wenn Sie eine Aufzeichnung auf der CCL durchführen, stellen Sie fest, dass die Cluster-Einheiten unterschiedliche Arten von Nachrichten austauschen. Interessant sind:

| Protokolle |

Beschreibung |

| UDP 49495 |

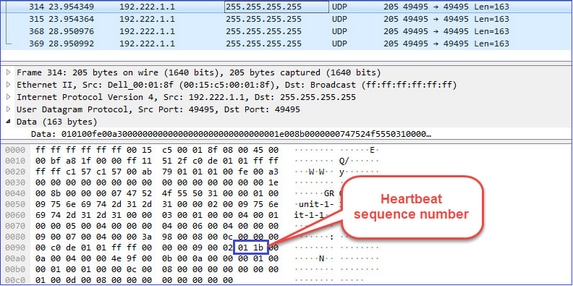

Cluster-Heartbeats (Keepalives) ・ L3-Broadcast (255.255.255.255) ・ Diese Pakete werden von jeder Cluster-Einheit mit einem Drittel des Werts für die Zeit der Statusprüfung gesendet. ・ Beachten Sie, dass nicht alle UDP 49495-Pakete, die in der Erfassung erkannt werden, Heartbeats sind. ・ Die Herzschläge enthalten eine Sequenznummer. |

| UDP 4193 |

Cluster Control Protocol - Datenpfadmeldungen ・ Unicast ・ Diese Pakete enthalten Informationen (Metadaten) über den Flow-Eigentümer, den Director, den Backup-Eigentümer usw. Beispiele: ・ Eine "Cluster-Add"-Nachricht wird vom Eigentümer an den Director gesendet, wenn ein neuer Fluss erstellt wird. ・ Eine "Cluster-Löschnachricht" wird vom Besitzer an den Director gesendet, wenn ein Fluss beendet wird. |

| Datenpakete |

Datenpakete, die zu den verschiedenen Datenverkehrsflüssen gehören, die den Cluster durchlaufen |

Cluster-Heartbeat

Cluster Control Point (CCP)-Nachrichten

Zusätzlich zu den Heartbeat-Nachrichten gibt es eine Reihe von Cluster-Steuernachrichten, die in bestimmten Szenarien über die CCL ausgetauscht werden. Einige davon sind Unicast-Nachrichten, während andere Broadcasts sind.

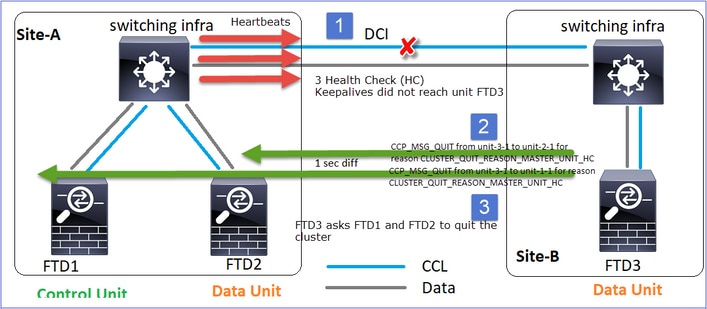

CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Wenn eine Einheit drei aufeinander folgende Heartbeat-Nachrichten vom Steuerungsknoten verliert, generiert sie eine CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC-Nachricht über die CCL. Diese Nachricht:

- Ist ein Unicast.

- Es wird in einem Intervall von 1 Sekunde an jede Einheit gesendet.

- Wenn ein Gerät diese Nachricht empfängt, beendet es den Cluster (DISABLED) und schließt sich erneut an.

Frage: Wozu dient CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC?

A. Aus der Sicht von Einheit-3-1 (Standort-B) wird die Verbindung zu Einheit-1-1 und Einheit-2-1 von Standort A getrennt, sodass sie so schnell wie möglich aus der Mitgliederliste entfernt werden muss. Andernfalls kann es zu Paketverlusten kommen, wenn Einheit-2-1 noch in der Mitgliederliste enthalten ist und Einheit-2-1 zufällig Direktor einer Verbindung ist. Die Datenflussabfrage zu Einheit-2-1 schlägt fehl.

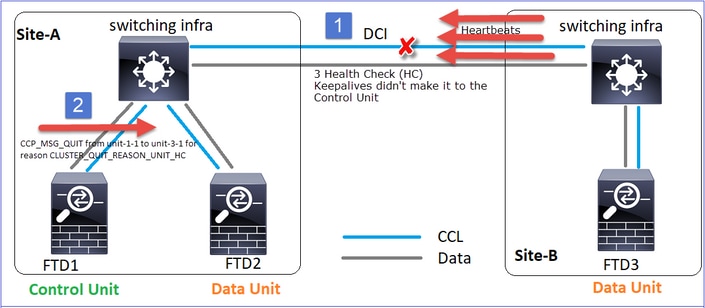

CLUSTER_QUIT_REASON_UNIT_HC

Wenn der Steuerungsknoten drei aufeinander folgende Heartbeat-Nachrichten von einem Datenknoten verliert, sendet er die CLUSTER_QUIT_REASON_UNIT_HC-Nachricht über die CCL. Diese Nachricht ist Unicast.

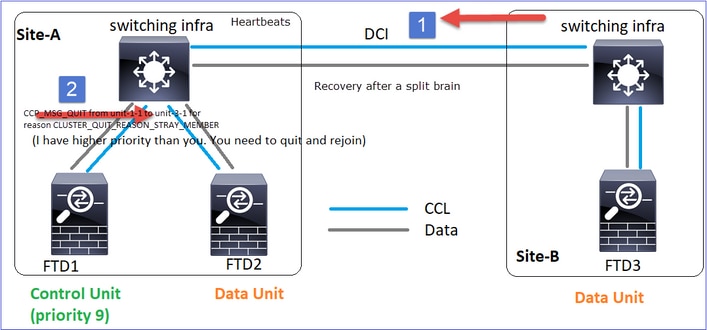

CLUSTER_QUIT_REASON_STRAY_MEMBER

Wenn eine Split-Partition wieder mit einer Peer-Partition verbunden wird, wird der neue Datenknoten von der dominanten Steuereinheit als Streuglied behandelt und erhält eine CCP-Abbruchmeldung mit dem Grund CLUSTER_QUIT_REASON_STRAY_MEMBER.

CLUSTER_QUIT_MEMBER_DROPOUT

Eine Broadcast-Nachricht, die von einem Datenknoten generiert und als Broadcast gesendet wird. Sobald ein Gerät diese Meldung erhält, wechselt es in den Status DISABLED (Deaktiviert). Darüber hinaus ist das automatische erneuten Beitreten kein Startpunkt:

firepower# show cluster info trace | include DROPOUT

Nov 04 00:22:54.699 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-1-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 04 00:22:53.699 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-2-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Der Cluster-Verlauf zeigt Folgendes an:

PRIMARY DISABLED Received control message DISABLE (member dropout announcement)

Cluster-Gesundheitscheck-Mechanismus

Wichtigste Punkte

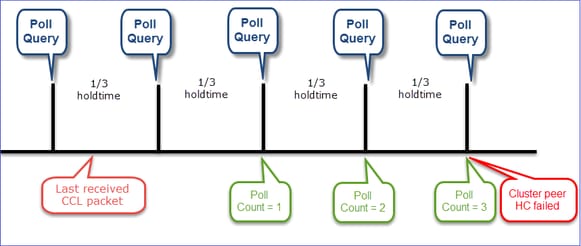

- Jede Cluster-Einheit sendet alle 1/3 des Werts für die Haltezeit der Integritätsprüfung einen Heartbeat an alle anderen Einheiten (Broadcast 255.255.255.255) und verwendet den UDP-Port 49495 als Transport über den CCL.

- Jede Cluster-Einheit verfolgt unabhängig jede andere Einheit mit einem Abfragezeitgeber und einem Abfragezählerwert.

- Wenn eine Cluster-Einheit innerhalb eines Heartbeat-Intervalls kein Paket (Heartbeat- oder Datenpaket) von einer Cluster-Peer-Einheit empfängt, erhöht sie den Wert für die Anzahl der Abfragen.

- Wenn der Wert für die Abfrageanzahl für eine Cluster-Peer-Einheit auf 3 gesetzt wird, gilt der Peer als ausgefallen.

- Bei jedem Empfang eines Herzschlages wird dessen Sequenznummer überprüft, und bei einem Unterschied zum zuvor empfangenen Herzschlag von 1 erhöht sich der Herzschlagfallzähler entsprechend.

- Wenn der Zähler für die Abrufanzahl für einen Cluster-Peer nicht 0 ist und ein Paket vom Peer empfangen wird, wird der Zähler auf den Wert 0 zurückgesetzt.

Verwenden Sie diesen Befehl, um die Cluster-Zustandszähler zu überprüfen:

firepower# show cluster info health details

----------------------------------------------------------------------------------

| Unit (ID)| Heartbeat| Heartbeat| Average| Maximum| Poll|

| | count| drops| gap (ms)| slip (ms)| count|

----------------------------------------------------------------------------------

| unit-2-1 ( 1)| 650| 0| 4999| 1| 0|

| unit-3-1 ( 2)| 650| 0| 4999| 1| 0|

----------------------------------------------------------------------------------

Beschreibung der Hauptspalten

| Spalte |

Beschreibung |

| Einheit (ID) |

Die ID des Remote-Cluster-Peers. |

| Herzschlag |

Die Anzahl der Heartbeats, die vom Remote-Peer über den CCL empfangen wurden |

| Herzschlag sinkt |

Die Anzahl der verpassten Heartbeats. Dieser Leistungsindikator wird auf der Grundlage der empfangenen Heartbeat-Sequenznummer berechnet. |

| durchschnittliche Lücke |

Das durchschnittliche Zeitintervall der empfangenen Heartbeats. |

| Umfrageanzahl |

Wenn dieser Zähler den Wert 3 annimmt, wird die Einheit aus dem Cluster entfernt. Das Intervall für die Abfrage der Abfrage entspricht dem Intervall für den Heartbeat, wird jedoch unabhängig ausgeführt. |

Verwenden Sie den folgenden Befehl, um die Zähler zurückzusetzen:

firepower# clear cluster info health details

Frage: Wie kann ich die Herzschlagfrequenz überprüfen?

A. Durchschnittliche Lücke prüfen:

firepower# show cluster info health details

----------------------------------------------------------------------------------

| Unit (ID)| Heartbeat| Heartbeat| Average| Maximum| Poll|

| | count| drops| gap (ms)| slip (ms)| count|

----------------------------------------------------------------------------------

| unit-2-1 ( 1)| 3036| 0| 999| 1| 0|

----------------------------------------------------------------------------------

Frage: Wie können Sie die Haltezeit des Clusters in FTD ändern?

A. FlexConfig verwenden

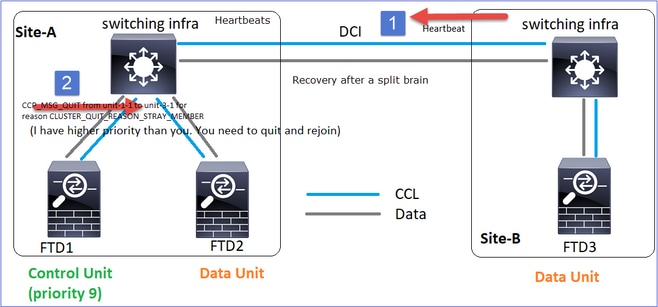

F. Wer wird der Kontrollknoten nach einem Split-Brain?

A. Die Einheit mit der höchsten Priorität (niedrigste Zahl):

firepower# show run cluster | include priority

priority 9

Weitere Informationen finden Sie unter Szenario 1 des HC-Ausfalls.

Die Visualisierung des Cluster-HC-Mechanismus

Indikative Timer: Die Min- und Max-Werte hängen von der zuletzt empfangenen CCL-Paketeingabe ab.

| Haltezeit |

Abfrageüberprüfung abfragen (Häufigkeit) |

Min. Erkennungszeit |

Max. Erkennungszeit |

| 3 Sek. (Standard) |

~ 1 Sekunde |

~3,01 Sek. |

~3,99 Sek. |

| 4 Sekunden |

~ 1,33 Sek. |

~4,01 Sek. |

~5,32 Sek. |

| 5 s |

~1,66 Sek. |

~5,01 s |

~6,65 s |

| 6 Sekunden |

~2 Sek. |

~6,01 s |

~7,99 Sek. |

| 7 s |

~2,33 Sek. |

~7,01 s |

~ 9,32 Sek. |

| 8 Sekunden |

~2,66 Sek. |

~8,01 s |

~10,65 Sek. |

Cluster-HC-Fehlerszenarien

In diesem Abschnitt werden folgende Ziele verfolgt:

- Verschiedene Cluster-HC-Ausfallszenarien.

- Wie die verschiedenen Protokolle und Befehlsausgaben korreliert werden können.

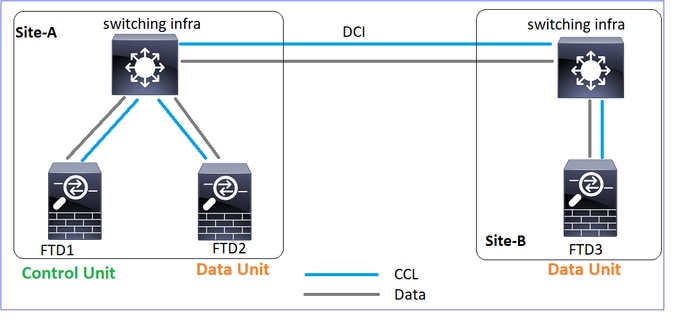

Topologie

Cluster-Konfiguration

| Einheit-1-1 |

Einheit-2-1 |

Einheit-3-1 |

cluster group GROUP1 |

cluster group GROUP1 |

cluster group GROUP1 |

Cluster-Status

| Einheit-1-1 |

Einheit-2-1 |

Einheit-3-1 |

firepower# show cluster info |

firepower# show cluster info |

firepower# show cluster info |

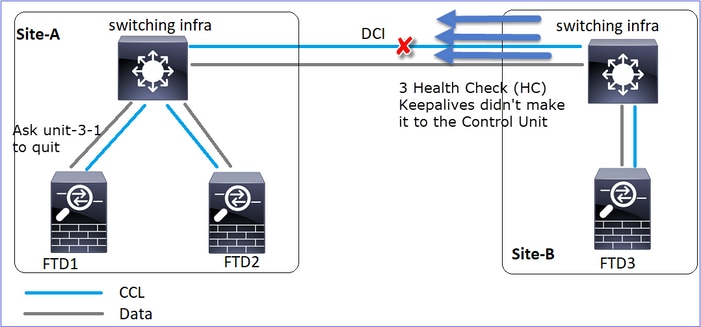

Szenario 1

CCL-Kommunikationsverlust in beide Richtungen über ca. 4 Sekunden.

Vor dem Ausfall

| FTD1 |

FTD2 |

FTD3 |

| Standort A |

Standort A |

Standort B |

| Kontrollknoten |

Datenknoten |

Datenknoten |

Nach der Wiederherstellung (keine Änderungen in den Rollen der Einheit)

| FTD1 |

FTD2 |

FTD3 |

| Standort A |

Standort A |

Standort B |

| Kontrollknoten |

Datenknoten |

Datenknoten |

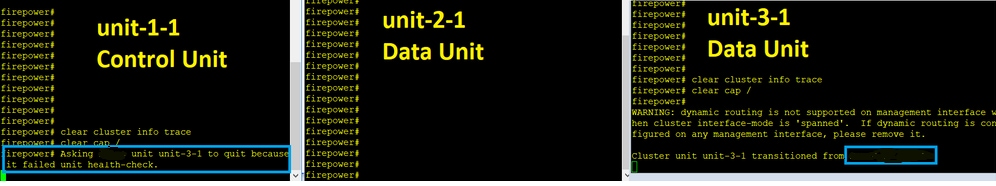

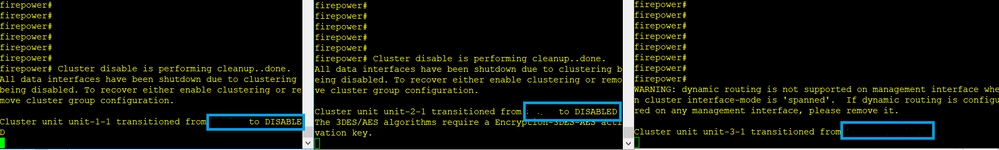

Analyse

Der Fehler (die CCL-Kommunikation ging verloren).

Konsolenmeldung auf Datenebene auf Einheit 3-1:

firepower#

WARNING: dynamic routing is not supported on management interface when cluster interface-mode is 'spanned'.

If dynamic routing is configured on any management interface, please remove it.

Cluster unit unit-3-1 transitioned from SECONDARY to PRIMARY

Cluster disable is performing cleanup..done.

All data interfaces have been shutdown due to clustering being disabled.

To recover either enable clustering or remove cluster group configuration.

Cluster-Ablaufverfolgungsprotokolle von Einheit 1-1:

firepower# show cluster info trace | include unit-3-1

Nov 02 09:38:14.239 [INFO]Notify chassis de-bundle port for blade unit-3-1, stack 0x000055a8918307fb 0x000055a8917fc6e8 0x000055a8917f79b5

Nov 02 09:38:14.239 [INFO]FTD - CD proxy received state notification (DISABLED) from unit unit-3-1

Nov 02 09:38:14.239 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 02 09:38:14.239 [INFO]Notify chassis de-bundle port for blade unit-3-1, stack 0x000055a8917eb596 0x000055a8917f4838 0x000055a891abef9d

Nov 02 09:38:14.239 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Nov 02 09:38:14.239 [CRIT]Received heartbeat event 'SECONDARY heartbeat failure' for member unit-3-1 (ID: 1).

Split Brain

| Einheit-1-1 |

Einheit-2-1 |

Einheit-3-1 |

firepower# show cluster info |

firepower# show cluster info |

firepower# show cluster info |

Cluster-Verlauf

| Einheit-1-1 |

Einheit-2-1 |

Einheit-3-1 |

| Keine Veranstaltungen |

Keine Veranstaltungen |

09:38:16 UTC Nov 2 2020 |

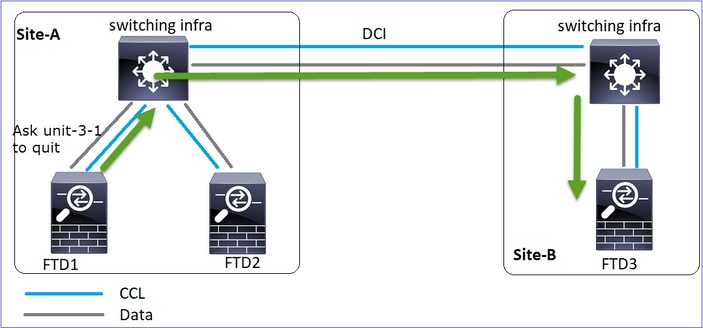

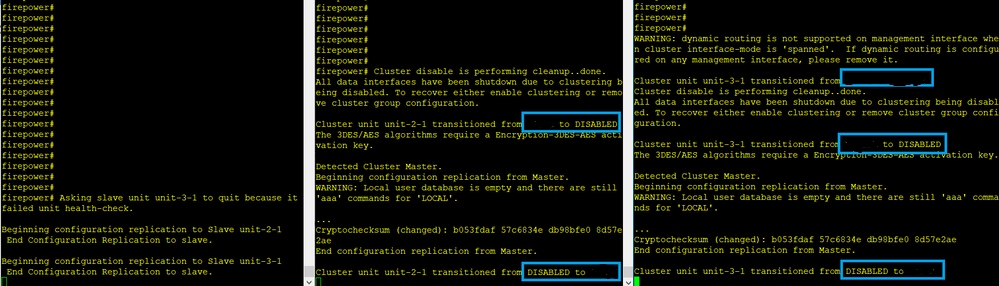

Wiederherstellung der CCL-Kommunikation

Unit-1-1 erkennt den aktuellen Steuerungsknoten und sendet, da Unit-1-1 eine höhere Priorität hat, eine CLUSTER_QUIT_REASON_STRAY_MEMBER-Nachricht an Unit-3-1, um einen neuen Wahlvorgang auszulösen. Am Ende wird Einheit-3-1 wieder als Datenknoten verbunden.

Wenn eine Split-Partition erneut mit einer Peer-Partition verbunden wird, wird der Datenknoten vom dominanten Kontrollknoten als streunendes Mitglied behandelt und erhält eine CCP-Abbruchmeldung mit dem Grund CLUSTER_QUIT_REASON_STRAY_MEMBER.

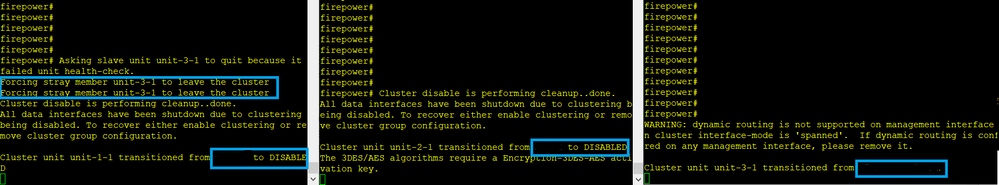

Unit-3-1 console logs show:

Cluster unit unit-3-1 transitioned from PRIMARY to DISABLED

The 3DES/AES algorithms require a Encryption-3DES-AES activation key.

Detected Cluster Primart.

Beginning configuration replication from Primary.

WARNING: Local user database is empty and there are still 'aaa' commands for 'LOCAL'.

..

Cryptochecksum (changed): a9ed686f 8e2e689c 2553a104 7a2bd33a

End configuration replication from Primary.

Cluster unit unit-3-1 transitioned from DISABLED to SECONDARY

Beide Einheiten (Einheit-1-1 und Einheit-3-1) zeigen in ihren Cluster-Protokollen:

firepower# show cluster info trace | include retain

Nov 03 21:20:23.019 [CRIT]Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Nov 03 21:20:23.019 [CRIT]Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Es werden auch Syslog-Meldungen für das Split-Brain generiert:

firepower# show log | include 747016

Nov 03 2020 21:20:23: %FTD-4-747016: Clustering: Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Nov 03 2020 21:20:23: %FTD-4-747016: Clustering: Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Cluster-Verlauf

| Einheit-1-1 |

Einheit-2-1 |

Einheit-3-1 |

| Keine Veranstaltungen |

Keine Veranstaltungen |

09:47:33 UTC Nov 2 2020 |

Szenario 2

CCL-Kommunikationsverlust für ca. 3-4 Sekunden in beide Richtungen.

Vor dem Ausfall

| FTD1 |

FTD2 |

FTD3 |

| Standort A |

Standort A |

Standort B |

| Kontrollknoten |

Datenknoten |

Datenknoten |

Nach der Wiederherstellung (keine Änderungen in den Rollen der Einheit)

| FTD1 |

FTD2 |

FTD3 |

| Standort A |

Standort A |

Standort B |

| Kontrollknoten |

Datenknoten |

Datenknoten |

Analyse

Veranstaltung 1: Der Steuerknoten verliert 3 HCs von der Einheit 3-1 und sendet eine Nachricht an die Einheit 3-1, um den Cluster zu verlassen.

Veranstaltung 2: Die CCL wurde sehr schnell wiederhergestellt, und die CLUSTER_QUIT_REASON_STRAY_MEMBER-Nachricht vom Steuerungsknoten gelangte zur Remote-Seite. Unit-3-1 wechselt direkt in den DISABLED-Modus, es gibt kein Split-Brain

Auf Gerät-1-1 (Steuerung) sehen Sie:

firepower#

Asking SECONDARY unit unit-3-1 to quit because it failed unit health-check.

Forcing stray member unit-3-1 to leave the cluster

Auf Einheit-3-1 (Datenknoten) wird Folgendes angezeigt:

firepower#

Cluster disable is performing cleanup..done.

All data interfaces have been shutdown due to clustering being disabled. To recover either enable clustering or remove cluster group configuration.

Cluster unit unit-3-1 transitioned from SECONDARY to DISABLED

Die Cluster-Einheit 3-1 wechselte in den Status DISABLED (Deaktiviert) und tritt nach der Wiederherstellung der CCL-Kommunikation wieder als Datenknoten bei:

firepower# show cluster history

20:58:40 UTC Nov 1 2020

SECONDARY DISABLED Received control message DISABLE (stray member)

20:58:45 UTC Nov 1 2020

DISABLED ELECTION Enabled from CLI

20:58:45 UTC Nov 1 2020

ELECTION SECONDARY_COLD Received cluster control message

20:58:45 UTC Nov 1 2020

SECONDARY_COLD SECONDARY_APP_SYNC Client progression done

20:59:33 UTC Nov 1 2020

SECONDARY_APP_SYNC SECONDARY_CONFIG SECONDARY application configuration sync done

20:59:44 UTC Nov 1 2020

SECONDARY_CONFIG SECONDARY_FILESYS Configuration replication finished

20:59:45 UTC Nov 1 2020

SECONDARY_FILESYS SECONDARY_BULK_SYNC Client progression done

21:00:09 UTC Nov 1 2020

SECONDARY_BULK_SYNC SECONDARY Client progression done

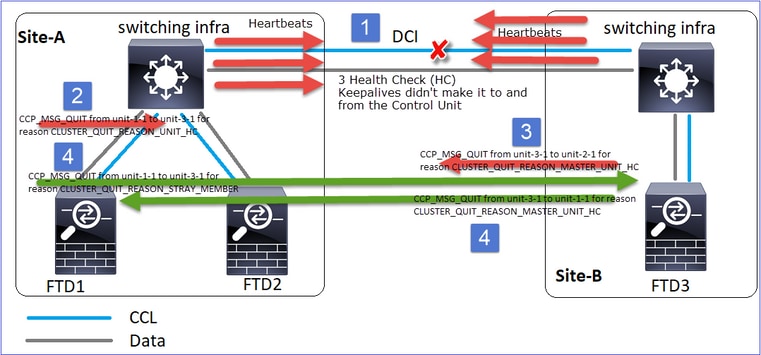

Szenario 3

CCL-Kommunikationsverlust für ca. 3-4 Sekunden in beide Richtungen.

Vor dem Scheitern.

| FTD1 |

FTD2 |

FTD3 |

| Standort A |

Standort A |

Standort B |

| Kontrollknoten |

Datenknoten |

Datenknoten |

Nach der Wiederherstellung (der Kontrollknoten wurde geändert).

| FTD1 |

FTD2 |

FTD3 |

| Standort A |

Standort A |

Standort B |

| Datenknoten |

Kontrollknoten |

Datenknoten |

Analyse

- CCL erlischt.

- Unit-1-1 erhält keine 3 HC-Nachrichten von Unit-3-1 und sendet eine QUIT-Nachricht an Unit-3-1. Diese Nachricht erreicht nie Unit-3-1.

- Einheit-3-1 sendet eine QUIT-Nachricht an Einheit-2-1. Diese Nachricht erreicht Einheit-2-1 nie.

Wiederherstellung mit CCL.

- Unit-1-1 erkennt, dass Unit-3-1 sich selbst als Kontrollknoten gemeldet hat und sendet die Nachricht QUIT_REASON_STRAY_MEMBER an Unit-3-1. Sobald Unit-3-1 die Nachricht erhält, wechselt sie in den Status DISABLED. Gleichzeitig sendet Unit-3-1 eine QUIT_REASON_PRIMARY_UNIT_HC-Nachricht an Unit-1-1 und fordert sie zum Beenden auf. Sobald Gerät 1-1 diese Nachricht erhält, wechselt sie in den Status DISABLED (Deaktiviert).

Cluster-Verlauf

| Einheit-1-1 |

Einheit-2-1 |

Einheit-3-1 |

19:53:09 UTC Nov 2 2020 |

19:53:06 UTC Nov 2 2020 |

19:53:06 UTC Nov 2 2020 |

Szenario 4

CCL-Kommunikationsverlust für ~3-4 Sekunden

Vor dem Ausfall

| FTD1 |

FTD2 |

FTD3 |

| Standort A |

Standort A |

Standort B |

| Kontrollknoten |

Datenknoten |

Datenknoten |

Nach der Wiederherstellung (der Kontrollknoten wechselte die Standorte)

| FTD1 |

FTD2 |

FTD3 |

| Standort A |

Standort A |

Standort B |

| Datenknoten |

Datenknoten |

Kontrollknoten |

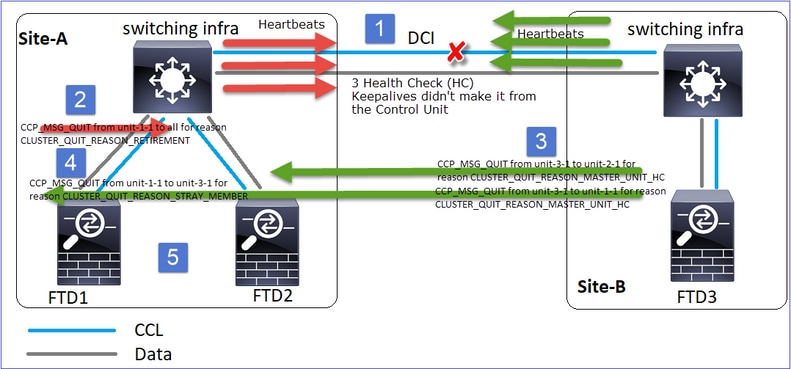

Analyse

Der Fehler

Ein anderer Geschmack desselben Versagens. In diesem Fall erhielt die Einheit-1-1 auch keine 3 HC-Nachrichten von der Einheit-3-1, und nachdem sie einen neuen Keepalive erhalten hatte, versuchte sie, die Einheit-3-1 mithilfe einer STRAY-Nachricht auszustoßen, aber die Nachricht schaffte es nie an die Einheit-3-1:

- Die CCL-Funktion bleibt einige Sekunden unidirektional. Unit-3-1 empfängt keine 3 HC-Nachrichten von Unit-1-1 und wird zu einem Kontrollknoten.

- Unit-2-1 sendet eine CLUSTER_QUIT_REASON_RETIREMENT-Nachricht (Broadcast).

- Unit-3-1 sendet eine QUIT_REASON_PRIMARY_UNIT_HC-Nachricht an Unit-2-1. Unit-2-1 empfängt sie und beendet den Cluster.

- Unit-3-1 sendet eine QUIT_REASON_PRIMARY_UNIT_HC-Nachricht an Unit-1-1. Unit-1-1 empfängt sie und beendet den Cluster. Wiederherstellung mit CCL.

- Die Einheiten 1-1 und 2-1 treten dem Cluster wieder als Datenknoten bei.

Anmerkung: Wenn sich die CCL in Schritt 5 nicht erholt, wird am Standort A der FTD1 zum neuen Kontrollknoten, und nach der CCL-Wiederherstellung gewinnt sie die neue Wahl.

Syslog-Meldungen auf Gerät 1-1:

firepower# show log | include 747

Nov 03 2020 23:13:08: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-3-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:09: %FTD-4-747015: Clustering: Forcing stray member unit-3-1 to leave the cluster

Nov 03 2020 23:13:09: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-2-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-4-747015: Clustering: Forcing stray member unit-3-1 to leave the cluster

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY to DISABLED

Nov 03 2020 23:13:12: %FTD-7-747006: Clustering: State machine is at state DISABLED

Nov 03 2020 23:13:12: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MY_STATE (state DISABLED,0x0000000000000000,0x0000000000000000)

Nov 03 2020 23:13:18: %FTD-6-747004: Clustering: State machine changed from state ELECTION to ONCALL

Cluster-Ablaufverfolgungsprotokolle auf Gerät 1-1:

firepower# show cluster info trace | include QUIT

Nov 03 23:13:10.789 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 03 23:13:10.769 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-1-1 for reason CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Nov 03 23:13:10.769 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_STRAY_MEMBER

Nov 03 23:13:09.789 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 03 23:13:09.769 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_STRAY_MEMBER

Nov 03 23:13:08.559 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 03 23:13:08.559 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Syslog-Meldungen auf Gerät-3-1:

firepower# show log | include 747

Nov 03 2020 23:13:09: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-2-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-1-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state SECONDARY to PRIMARY

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_FAST to PRIMARY_DRAIN

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_DRAIN to PRIMARY_CONFIG

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_CONFIG to PRIMARY_POST_CONFIG

Nov 03 2020 23:13:10: %FTD-7-747006: Clustering: State machine is at state PRIMARY_POST_CONFIG

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_POST_CONFIG to PRIMARY

Nov 03 2020 23:13:10: %FTD-7-747006: Clustering: State machine is at state PRIMARY

Cluster-Verlauf

| Einheit-1-1 |

Einheit-2-1 |

Einheit-3-1 |

23:13:13 UTC Nov 3 2020 |

23:13:12 UTC Nov 3 2020 |

23:13:10 UTC Nov 3 2020 |

Szenario 5

Vor dem Ausfall

| FTD1 |

FTD2 |

FTD3 |

| Standort A |

Standort A |

Standort B |

| Kontrollknoten |

Datenknoten |

Datenknoten |

Nach der Wiederherstellung (keine Änderungen)

| FTD1 |

FTD2 |

FTD3 |

| Standort A |

Standort A |

Standort B |

| Kontrollknoten |

Datenknoten |

Datenknoten |

Der Fehler

Einheit 3-1 sendete QUIT-Nachrichten an Einheit 1-1 und Einheit 2-1, aber aufgrund von Verbindungsproblemen erhielt nur Einheit 2-1 die QUIT-Nachricht.

Cluster-Ablaufverfolgungsprotokolle von Einheit 1-1:

firepower# show cluster info trace | include QUIT

Nov 04 00:52:10.429 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:47.059 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:45.429 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 04 00:51:45.429 [DBUG]Send CCP message to unit-3-1(1): CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Cluster-Ablaufverfolgungsprotokolle der Einheit 2-1:

firepower# show cluster info trace | include QUIT

Nov 04 00:52:10.389 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:47.019 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:46.999 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-2-1 for reason CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Nov 04 00:51:45.389 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Cluster-Verlauf

| Einheit-1-1 |

Einheit-2-1 |

Einheit-3-1 |

| Keine Veranstaltungen |

00:51:50 UTC Nov 4 2020 |

00:51:47 UTC Nov 4 2020 |

Verbindungsaufbau der Cluster-Datenebene

NGFW-Erfassungspunkte

Die NGFW bietet Erfassungsfunktionen in folgenden Punkten:

- Gehäuseinterner Switch (FXOS)

- FTD-Datenebenen-Engine

- FTD Snort-Engine

Bei der Fehlerbehebung von Datenpfad-Problemen in einem Cluster werden in den meisten Fällen die FXOS- und FTD-Datenebenen-Engine-Erfassungspunkte verwendet.

- FXOS-Eingangserfassung an der physischen Schnittstelle

- FTD-Eingangserfassung in Datenebenen-Engine

- FTD-Ausgangserfassung in Datenebenen-Engine

- FXOS-Eingangserfassung an Backplane-Schnittstelle

Weitere Informationen zu NGFW-Aufzeichnungen finden Sie in diesem Dokument:

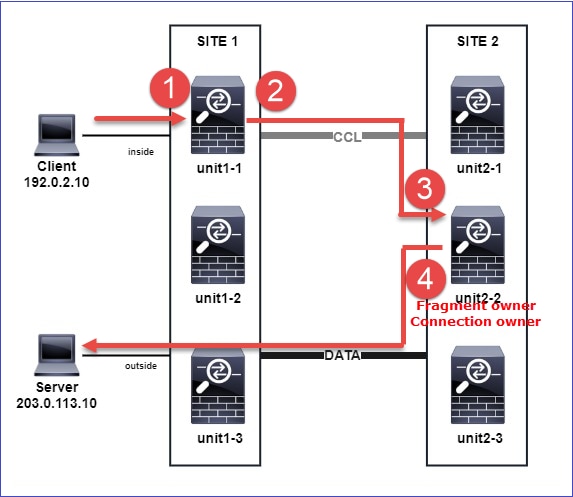

Grundlagen der Cluster Unit Flow-Rollen

Verbindungen können auf verschiedene Weise über einen Cluster hergestellt werden, wobei Faktoren wie die folgenden ausschlaggebend sind:

- Art des Datenverkehrs (TCP, UDP usw.)

- Auf dem benachbarten Switch konfigurierter Lastenausgleichsalgorithmus

- Auf der Firewall konfigurierte Funktionen

- Netzwerkbedingungen (z. B. IP-Fragmentierung, Netzwerkverzögerungen usw.)

| Flow-Rolle |

Beschreibung |

Flag(s) |

| Besitzer |

In der Regel wird das Gerät, das die Verbindung ursprünglich erhält, |

UIO |

| Direktor |

Die Einheit, die Ownerlookup-Anfragen von Weiterleitungen verarbeitet. |

Y |

| Sicherungseigentümer |

Solange der Director nicht dieselbe Einheit wie der Eigentümer ist, ist er auch der Backup-Eigentümer. Wenn sich der Besitzer selbst als Director entscheidet, wird ein separater Backup-Besitzer ausgewählt. |

Y (wenn der Director auch Sicherungseigentümer ist) y (wenn der Director nicht der Sicherungseigentümer ist) |

| Weiterleitung |

Eine Einheit, die Pakete an den Besitzer weiterleitet. |

z |

| Fragment-Besitzer |

Die Einheit, die den fragmentierten Datenverkehr verarbeitet |

- |

| Chassis-Backup |

Wenn in einem Interchassis-Cluster die Director/Backup- und Owner-Flows den Einheiten desselben Chassis gehören, wird eine Einheit in einem der anderen Chassis zu einem sekundären Backup/Director. Diese Rolle ist spezifisch für Interchassis-Cluster der FirePOWER Serie 9300 mit mehr als einem Blade. |

w |

- Weitere Informationen finden Sie im entsprechenden Abschnitt im Konfigurationshandbuch (siehe Links im Abschnitt "Weitere Informationen").

- In bestimmten Szenarien (siehe Abschnitt mit Fallstudien) werden einige Kennzeichen nicht immer angezeigt.

Erstellung von Cluster-Verbindungen - Anwenderberichte

Im nächsten Abschnitt werden verschiedene Fallstudien behandelt, die einige Möglichkeiten aufzeigen, wie eine Verbindung über einen Cluster hergestellt werden kann. Die Ziele sind:

- Machen Sie sich mit den verschiedenen Rollen der Einheiten vertraut.

- Demonstrieren Sie, wie die verschiedenen Befehlsausgaben korreliert werden können.

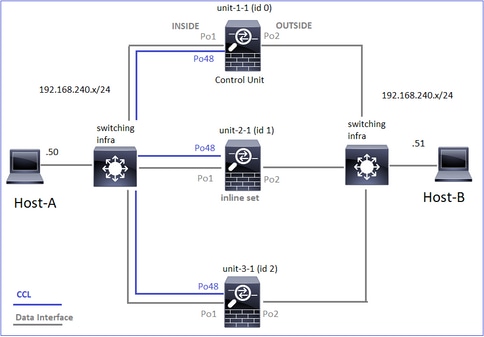

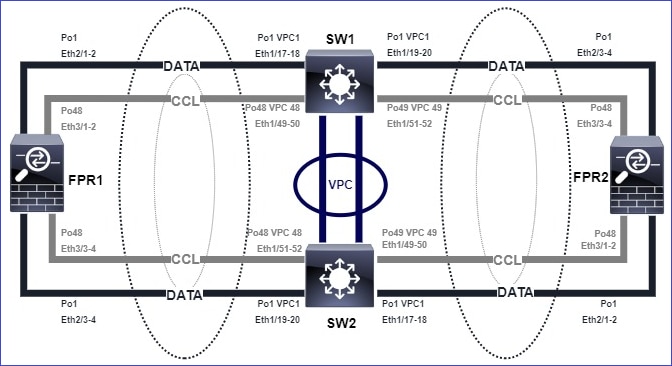

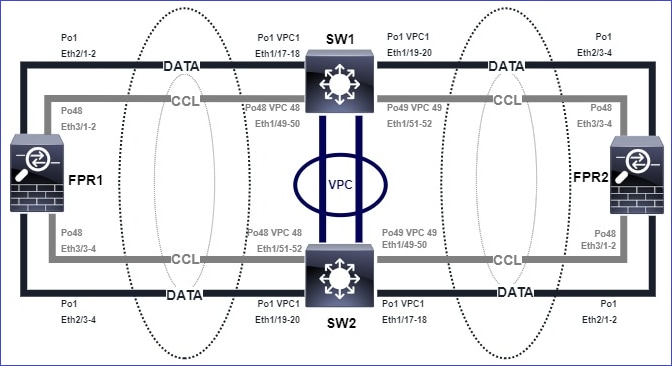

Topologie

Cluster-Einheiten und -IDs:

| Einheit-1-1 |

Einheit-2-1 |

Einheit-3-1 |

Cluster GROUP1: On |

Unit "unit-2-1" in state SECONDARY |

Unit "unit-3-1" in state SECONDARY |

Cluster-Erfassung aktiviert:

cluster exec cap CAPI int INSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPO int OUTSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPI_RH reinject-hide int INSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPO_RH reinject-hide int OUTSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CCL int cluster buffer 33554432

Anmerkung: Diese Tests wurden in einer Laborumgebung mit minimalem Datenverkehr durch den Cluster ausgeführt. Versuchen Sie, in der Produktion möglichst spezifische Erfassungsfilter (z. B. Zielport und wenn möglich Quellport) zu verwenden, um das "Rauschen" in den Erfassungen zu minimieren.

Fallstudie 1. Symmetrischer Datenverkehr (Eigentümer ist auch der Leiter)

Beobachtung 1. Die Erfassung von "reinject-hide" zeigt Pakete nur an Einheit 1-1. Das bedeutet, dass der Fluss in beide Richtungen durch Einheit 1-1 ging (symmetrischer Verkehr):

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data interface cluster [Capturing - 33513 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

unit-2-1:*************************************************************

capture CCL type raw-data interface cluster [Capturing - 23245 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

unit-3-1:*************************************************************

capture CCL type raw-data interface cluster [Capturing - 24815 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

Beobachtung 2. Analyse des Verbindungsflags für den Datenfluss mit Quellport 45954

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

22 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 2 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:45954, idle 0:00:00, bytes 487413076, flags UIO N1

unit-2-1:*************************************************************

22 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 249 most enabled, 0 most in effect

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 2 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:443 NP Identity Ifc 192.168.240.50:39698, idle 0:00:23, bytes 0, flags z

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:45954, idle 0:00:06, bytes 0, flags y

| Einheit |

Flag |

Hinweis |

| Einheit-1-1 |

UIO |

・ Flow Owner - Die Einheit übernimmt den Flow ・ Director - Da Unit-3-1 über "y" und nicht "Y" verfügt, impliziert dies, dass Unit-1-1 als Director für diesen Fluss ausgewählt wurde. Da es sich also auch um den Eigentümer handelt, wurde eine weitere Einheit (in diesem Fall Einheit-3-1) als Sicherungseigentümer ausgewählt |

| Einheit-2-1 |

- |

- |

| Einheit-3-1 |

y |

Das Gerät ist Sicherungseigentümer. |

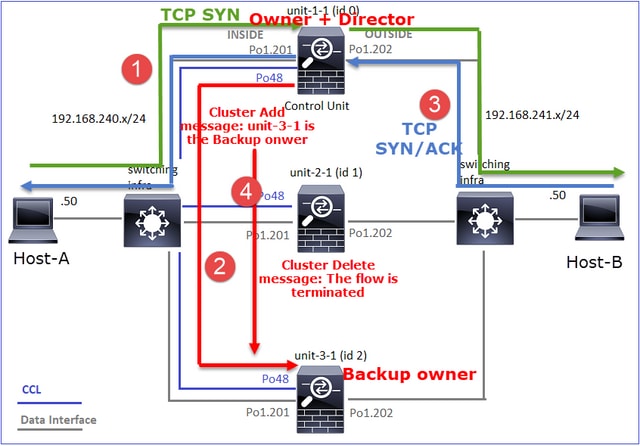

Dies kann wie folgt visualisiert werden:

- Das TCP-SYN-Paket kommt von Host-A an Einheit-1-1. Einheit-1-1 wird zum Eigentümer des Datenflusses.

- Unit-1-1 wird ebenfalls zum Flow Director gewählt. Daher wird auch Unit-3-1 als Backup-Eigentümer (Cluster-Add-Message) ausgewählt.

- Das TCP-SYN/ACK-Paket kommt von Host-B zu Einheit-3-1. Der Fluss ist symmetrisch.

- Sobald die Verbindung beendet ist, sendet der Besitzer eine Cluster-Löschmeldung, um die Flow-Informationen vom Backup-Besitzer zu entfernen.

Beobachtung 3. Erfassung mit Spur zeigt, dass beide Richtungen nur durch Einheit-1-1 gehen.

Schritt 1: Identifizieren Sie den Fluss und die Pakete, die für alle Cluster-Einheiten von Interesse sind, basierend auf dem Quell-Port:

firepower# cluster exec show capture CAPI | i 45954

unit-1-1(LOCAL):******************************************************

1: 08:42:09.362697 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: S 992089269:992089269(0) win 29200 <mss 1460,sackOK,timestamp 495153655 0,nop,wscale 7>

2: 08:42:09.363521 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.45954: S 4042762409:4042762409(0) ack 992089270 win 28960 <mss 1380,sackOK,timestamp 505509125 495153655,nop,wscale 7>

3: 08:42:09.363827 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: . ack 4042762410 win 229 <nop,nop,timestamp 495153657 505509125>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower# cluster exec show capture CAPO | i 45954

unit-1-1(LOCAL):******************************************************

1: 08:42:09.362987 802.1Q vlan#202 P0 192.168.240.50.45954 > 192.168.241.50.80: S 2732339016:2732339016(0) win 29200 <mss 1380,sackOK,timestamp 495153655 0,nop,wscale 7>

2: 08:42:09.363415 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45954: S 3603655982:3603655982(0) ack 2732339017 win 28960 <mss 1460,sackOK,timestamp 505509125 495153655,nop,wscale 7>

3: 08:42:09.363903 802.1Q vlan#202 P0 192.168.240.50.45954 > 192.168.241.50.80: . ack 3603655983 win 229 <nop,nop,timestamp 495153657 505509125>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Schritt 2: Da es sich um einen TCP-Flow handelt, werden die 3-Wege-Handshake-Pakete verfolgt. Wie in dieser Ausgabe zu sehen ist, ist "unit-1-1" der Eigentümer. Der Einfachheit halber werden die nicht relevanten Spurenphasen weggelassen:

firepower# show cap CAPI packet-number 1 trace

25985 packets captured

1: 08:42:09.362697 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: S 992089269:992089269(0) win 29200 <mss 1460,sackOK,timestamp 495153655 0,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

...

Rückverkehr (TCP SYN/ACK):

firepower# show capture CAPO packet-number 2 trace

25985 packets captured

2: 08:42:09.363415 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45954: S 3603655982:3603655982(0) ack 2732339017 win 28960 <mss 1460,sackOK,timestamp 505509125 495153655,nop,wscale 7>

...

Phase: 3

Type: FLOW-LOOKUP

Subtype:

Result: ALLOW

Config:

Additional Information:

Found flow with id 9364, using existing flow

Beobachtung 4. FTD-Datenebenen-Syslogs zeigen die Verbindungsherstellung und -terminierung auf allen Einheiten an:

firepower# cluster exec show log | include 45954

unit-1-1(LOCAL):******************************************************

Dec 01 2020 08:42:09: %FTD-6-302013: Built inbound TCP connection 9364 for INSIDE:192.168.240.50/45954 (192.168.240.50/45954) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 08:42:18: %FTD-6-302014: Teardown TCP connection 9364 for INSIDE:192.168.240.50/45954 to OUTSIDE:192.168.241.50/80 duration 0:00:08 bytes 1024000440 TCP FINs from INSIDE

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Dec 01 2020 08:42:09: %FTD-6-302022: Built backup stub TCP connection for INSIDE:192.168.240.50/45954 (192.168.240.50/45954) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 08:42:18: %FTD-6-302023: Teardown backup TCP connection for INSIDE:192.168.240.50/45954 to OUTSIDE:192.168.241.50/80 duration 0:00:08 forwarded bytes 0 Cluster flow with CLU closed on owner

Anwenderbericht 2. Symmetrischer Datenverkehr (anderer Eigentümer als der Director)

- Wie Fallstudie #1, aber in diesem Fall ist ein Flow Owner eine andere Einheit als der Director.

- Alle Ergebnisse sind ähnlich wie in der Fallstudie #1. Der Hauptunterschied zur Fallstudie #1 ist die "Y"-Markierung, die die "y"-Markierung von Szenario 1 ersetzt.

Beobachtung 1. Der Besitzer ist anders als der Direktor.

Analyse des Verbindungs-Flags für den Datenfluss mit Quellport 46278.

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 2 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46278, idle 0:00:00, bytes 508848268, flags UIO N1

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46276, idle 0:00:03, bytes 0, flags aA N1

unit-2-1:*************************************************************

21 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 5 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 NP Identity Ifc 192.168.240.50:46276, idle 0:00:02, bytes 0, flags z

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46278, idle 0:00:06, bytes 0, flags Y

| Einheit |

Flag |

Hinweis |

| Einheit-1-1 |

UIO |

・ Flow Owner - Die Einheit übernimmt den Flow |

| Einheit-2-1 |

- |

- |

| Einheit-3-1 |

Y |

・ Director und Backup Owner - Unit 3-1 hat die Markierung Y (Director). |

Dies kann wie folgt visualisiert werden:

- Das TCP-SYN-Paket kommt von Host-A an Einheit-1-1. Einheit-1-1 wird zum Eigentümer des Datenflusses.

- Unit-3-1 wird zum Flow Director gewählt. Unit-3-1 ist auch der Sicherungseigentümer (Cluster-Add-Meldung auf UDP 4193 über CCL).

- Das TCP-SYN/ACK-Paket kommt von Host-B zu Einheit-3-1. Der Fluss ist symmetrisch.

- Sobald die Verbindung beendet ist, sendet der Besitzer über den CCL eine "Cluster Delete"-Nachricht auf UDP 4193, um die Flow-Informationen vom Backup-Besitzer zu entfernen.

Beobachtung 2. Erfassung mit Spur zeigt, dass beide Richtungen nur durch Einheit-1-1 gehen

Schritt 1: Verwenden Sie den gleichen Ansatz wie in Fallstudie 1, um den Datenfluss und die relevanten Pakete in allen Cluster-Einheiten basierend auf dem Quell-Port zu identifizieren:

firepower# cluster exec show cap CAPI | include 46278

unit-1-1(LOCAL):******************************************************

3: 11:01:44.841631 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: S 1972783998:1972783998(0) win 29200 <mss 1460,sackOK,timestamp 503529072 0,nop,wscale 7>

4: 11:01:44.842317 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3524167695:3524167695(0) ack 1972783999 win 28960 <mss 1380,sackOK,timestamp 513884542 503529072,nop,wscale 7>

5: 11:01:44.842592 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: . ack 3524167696 win 229 <nop,nop,timestamp 503529073 513884542>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

Erfassung an der OUTSIDE-Schnittstelle:

firepower# cluster exec show cap CAPO | include 46278

unit-1-1(LOCAL):******************************************************

3: 11:01:44.841921 802.1Q vlan#202 P0 192.168.240.50.46278 > 192.168.241.50.80: S 2153055699:2153055699(0) win 29200 <mss 1380,sackOK,timestamp 503529072 0,nop,wscale 7>

4: 11:01:44.842226 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3382481337:3382481337(0) ack 2153055700 win 28960 <mss 1460,sackOK,timestamp 513884542 503529072,nop,wscale 7>

5: 11:01:44.842638 802.1Q vlan#202 P0 192.168.240.50.46278 > 192.168.241.50.80: . ack 3382481338 win 229 <nop,nop,timestamp 503529073 513884542>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

Schritt 2: Fokus auf Eingangspaketen (TCP SYN und TCP SYN/ACK):

firepower# cluster exec show cap CAPI packet-number 3 trace

unit-1-1(LOCAL):******************************************************

824 packets captured

3: 11:01:44.841631 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: S 1972783998:1972783998(0) win 29200 <mss 1460,sackOK,timestamp 503529072 0,nop,wscale 7>

…

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

Verfolgen Sie SYN/ACK auf Einheit 1-1:

firepower# cluster exec show cap CAPO packet-number 4 trace

unit-1-1(LOCAL):******************************************************

4: 11:01:44.842226 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3382481337:3382481337(0) ack 2153055700 win 28960 <mss 1460,sackOK,timestamp 513884542 503529072,nop,wscale 7>

Phase: 3

Type: FLOW-LOOKUP

Subtype:

Result: ALLOW

Config:

Additional Information:

Found flow with id 9583, using existing flow

Beobachtung 3. Die FTD-Syslogs auf Datenebene zeigen die Verbindungserstellung und -beendigung beim Eigentümer und Sicherungseigentümer:

firepower# cluster exec show log | include 46278

unit-1-1(LOCAL):******************************************************

Dec 01 2020 11:01:44: %FTD-6-302013: Built inbound TCP connection 9583 for INSIDE:192.168.240.50/46278 (192.168.240.50/46278) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 11:01:53: %FTD-6-302014: Teardown TCP connection 9583 for INSIDE:192.168.240.50/46278 to OUTSIDE:192.168.241.50/80 duration 0:00:08 bytes 1024001808 TCP FINs from INSIDE

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Dec 01 2020 11:01:44: %FTD-6-302022: Built director stub TCP connection for INSIDE:192.168.240.50/46278 (192.168.240.50/46278) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 11:01:53: %FTD-6-302023: Teardown director TCP connection for INSIDE:192.168.240.50/46278 to OUTSIDE:192.168.241.50/80 duration 0:00:08 forwarded bytes 0 Cluster flow with CLU closed on owner

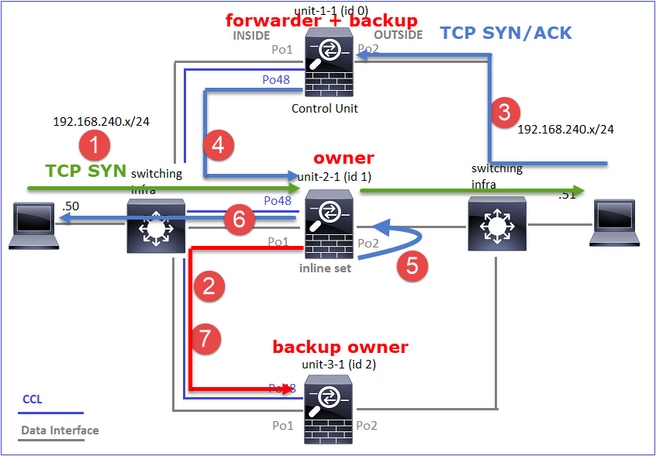

Fallstudie 3. Asymmetrischer Datenverkehr (Director leitet den Datenverkehr weiter).

Beobachtung 1. Die Erfassung zum Ausblenden der Wiedereinfuhr zeigt Pakete in Einheit 1-1 und Einheit 2-1 (asymmetrischer Fluss) an:

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33554320 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99932 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33553268 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Capturing - 53815 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Capturing - 658 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Capturing - 658 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

Beobachtung 2. Analyse des Verbindungsflags für den Datenfluss mit Quellport 46502.

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 2 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46502, idle 0:00:00, bytes 448760236, flags UIO N1

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46500, idle 0:00:06, bytes 0, flags aA N1

unit-2-1:*************************************************************

21 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 1 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46502, idle 0:00:00, bytes 0, flags Y

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 5 most used

dir connections: 0 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

| Einheit |

Flag |

Hinweis |

| Einheit-1-1 |

UIO |

・ Flow Owner - Die Einheit übernimmt den Flow. |

| Einheit-2-1 |

Y |

・ Director - Da Unit-2-1 die Markierung "Y" trägt, bedeutet dies, dass Unit-2-1 als Director für diesen Fluss ausgewählt wurde. ・ Backup Owner ・ Schließlich, obwohl es aus dieser Ausgabe nicht offensichtlich ist, aus der Ausgabe von show capture und show log, ist es offensichtlich, dass unit-2-1 diesen Fluss an den Eigentümer weiterleitet (obwohl es technisch in diesem Szenario nicht als Forwarder angesehen wird). Anmerkung: Eine Einheit kann nicht gleichzeitig Director (Y-Fluss) und Forwarder (z-Fluss) sein. Diese beiden Rollen schließen sich gegenseitig aus. Directors (Y-Fluss) können weiterhin Datenverkehr weiterleiten. Siehe die Ausgabe von show log weiter unten in diesem Anwenderbericht. |

| Einheit-3-1 |

- |

- |

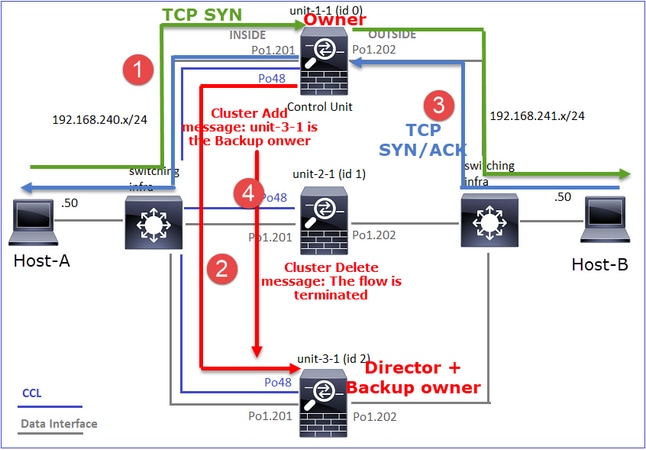

Dies kann wie folgt visualisiert werden:

- Das TCP-SYN-Paket kommt von Host-A an Einheit-1-1. Einheit-1-1 wird zum Eigentümer des Datenflusses.

- Unit-2-1 wird zum Flow Director und zum Backup-Eigentümer gewählt. Der Flow Owner sendet eine Unicast-Meldung zum Hinzufügen eines Clusters zum UDP 4193, um den Backup Owner über den Flow zu informieren.

- Das TCP-SYN/ACK-Paket kommt von Host-B an Einheit-2-1 an. Der Datenfluss ist asymmetrisch.

- Unit-2-1 leitet das Paket (aufgrund des TCP-SYN-Cookies) über die CCL an den Eigentümer weiter.

- Der Eigentümer sendet das Paket neu in die EXTERNE Schnittstelle und leitet es dann an Host A weiter.

- Sobald die Verbindung beendet ist, sendet der Besitzer eine Cluster-Löschmeldung, um die Flow-Informationen vom Backup-Besitzer zu entfernen.

Beobachtung 3: Die Erfassung mit Spur zeigt den asymmetrischen Datenverkehr und die Umleitung von Einheit-2-1 zu Einheit-1-1.

Schritt 1: Identifizieren Sie die Pakete, die zu dem gewünschten Fluss gehören (Port 46502):

firepower# cluster exec show capture CAPI | include 46502

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356121 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: S 4124514680:4124514680(0) win 29200 <mss 1460,sackOK,timestamp 510537534 0,nop,wscale 7>

4: 12:58:33.357037 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.46502: S 883000451:883000451(0) ack 4124514681 win 28960 <mss 1380,sackOK,timestamp 520893004 510537534,nop,wscale 7>

5: 12:58:33.357357 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: . ack 883000452 win 229 <nop,nop,timestamp 510537536 520893004>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Die Rückwärtsrichtung:

firepower# cluster exec show capture CAPO | include 46502

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356426 802.1Q vlan#202 P0 192.168.240.50.46502 > 192.168.241.50.80: S 1434968587:1434968587(0) win 29200 <mss 1380,sackOK,timestamp 510537534 0,nop,wscale 7>

4: 12:58:33.356915 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

5: 12:58:33.357403 802.1Q vlan#202 P0 192.168.240.50.46502 > 192.168.241.50.80: . ack 4257314723 win 229 <nop,nop,timestamp 510537536 520893004>

unit-2-1:*************************************************************

1: 12:58:33.359249 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

2: 12:58:33.360302 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: . ack 1434968736 win 235 <nop,nop,timestamp 520893005 510537536>

3: 12:58:33.361004 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: . 4257314723:4257316091(1368) ack 1434968736 win 235 <nop,nop,timestamp 520893006 510537536>

…

unit-3-1:*************************************************************

Schritt 2: Verfolgen Sie die Pakete. Standardmäßig werden nur die ersten 50 eingehenden Pakete verfolgt. Der Einfachheit halber werden die nicht relevanten Spurenphasen weggelassen.

Unit-1-1 (Eigentümer):

firepower# cluster exec show capture CAPI packet-number 3 trace

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356121 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: S 4124514680:4124514680(0) win 29200 <mss 1460,sackOK,timestamp 510537534 0,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

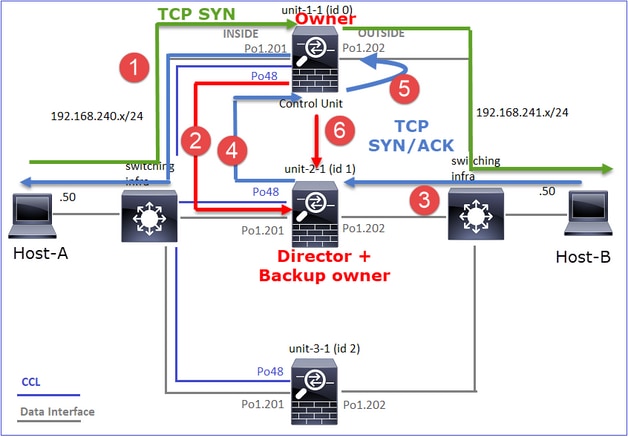

Einheit-2-1 (Weiterleitung)

Der zurückgegebene Datenverkehr (TCP SYN/ACK). Die interessierende Einheit ist Einheit 2-1, die dem Direktor/Sicherungseigentümer gehört und den Datenverkehr an den Eigentümer weiterleitet:

firepower# cluster exec unit unit-2-1 show capture CAPO packet-number 1 trace

1: 12:58:33.359249 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) am early redirecting to (0) due to matching action (-1).

Beobachtung 4. FTD-Datenebenen-Syslogs zeigen die Verbindungsherstellung und -terminierung auf allen Einheiten an:

firepower# cluster exec show log | i 46502

unit-1-1(LOCAL):******************************************************

Dec 01 2020 12:58:33: %FTD-6-302013: Built inbound TCP connection 9742 for INSIDE:192.168.240.50/46502 (192.168.240.50/46502) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 12:59:02: %FTD-6-302014: Teardown TCP connection 9742 for INSIDE:192.168.240.50/46502 to OUTSIDE:192.168.241.50/80 duration 0:00:28 bytes 2048000440 TCP FINs from INSIDE

unit-2-1:*************************************************************

Dec 01 2020 12:58:33: %FTD-6-302022: Built forwarder stub TCP connection for OUTSIDE:192.168.241.50/80 (192.168.241.50/80) to unknown:192.168.240.50/46502 (192.168.240.50/46502)