Einleitung

In diesem Dokument wird die End-to-End-Konfiguration von Jumbo Maximum Transition Unit (MTU) für alle Cisco Rechenzentrumsgeräte beschrieben.

Voraussetzungen

Anforderungen

Cisco empfiehlt, dass Sie über Kenntnisse in folgenden Bereichen verfügen:

- VMware ESXi

- Cisco UCS

- Cisco N5k

- Cisco Internet Small Computer Systems-Schnittstelle (iSCSI)

Verwendete Komponenten

In diesem Dokument wird die End-to-End-Konfiguration von Jumbo Maximum Transition Unit (MTU) für Cisco Rechenzentrumsgeräte in einem Netzwerk beschrieben, das aus einem auf dem Cisco Unified Computing System (UCS) installierten VMware ESXi-Host, Cisco Nexus Switches der Serie 1000V (N1kV), Cisco Nexus Switches der Serie 5000 (N5k) und den Cisco NetApp Controller.

Die Informationen in diesem Dokument basierend auf folgenden Software- und Hardware-Versionen:

- Cisco Nexus Switches der Serie 5020 Version 5.0(3)N2(2a)

- Cisco UCS Version 2.1(1d)

- Cisco UCS B200 M3 Blade-Server mit Cisco Virtual Interface Card (VIC) 1240

- vSphere 5.0 (ESXi und vCenter)

- Cisco N1kV Version 4.2(1)SV2(2.1a)

- NetApp FAS 3240

Die Informationen in diesem Dokument beziehen sich auf Geräte in einer speziell eingerichteten Testumgebung. Alle Geräte, die in diesem Dokument benutzt wurden, begannen mit einer gelöschten (Nichterfüllungs) Konfiguration. Wenn Ihr Netzwerk in Betrieb ist, stellen Sie sicher, dass Sie die möglichen Auswirkungen aller Befehle kennen.

Konfigurieren

Netzwerkdiagramm

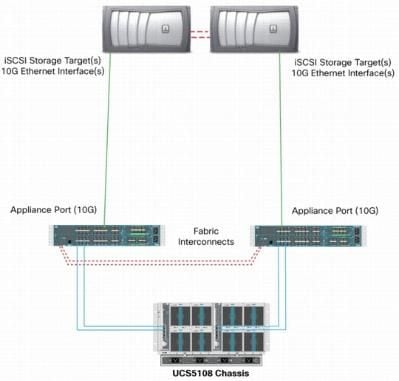

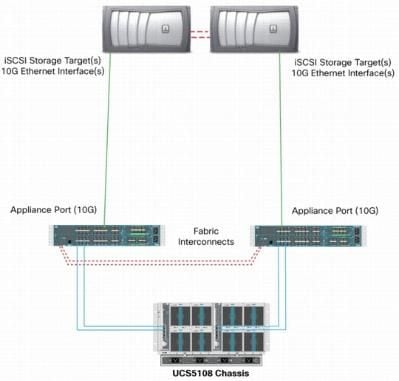

Bei der typischen iSCSI Storage Area Network (SAN)-Bereitstellung wird das Cisco UCS mit einem Fabric Interconnect im Ethernet-End-Host-Modus und das Speicherziel über einen Upstream-Switch oder ein Switched-Netzwerk verbunden.

Mithilfe der Appliance-Ports auf dem UCS kann der Speicher direkt mit den Fabric Interconnects verbunden werden.

Unabhängig davon, ob es sich beim Upstream-Netzwerk um 1 GbE oder 10 GbE handelt, wird durch die Verwendung von Jumbo Frames (z. B. einer MTU-Größe von 9.000) die Leistung verbessert, da die Anzahl der einzelnen Frames, die für eine bestimmte Datenmenge gesendet werden müssen, reduziert wird und iSCSI-Datenblöcke in mehrere Ethernet-Frames unterteilt werden müssen. Außerdem wird die CPU-Auslastung von Server und Speicher verringert.

Wenn Jumbo Frames verwendet werden, stellen Sie sicher, dass das UCS- und das Storage-Ziel sowie alle Netzwerkgeräte zwischen den Frames konfiguriert und konfiguriert werden können, um die größere Frame-Größe zu unterstützen.

Das bedeutet, dass die Jumbo-MTU Ende-zu-Ende (Initiator zu Ziel) konfiguriert werden muss, damit sie in der gesamten Domäne wirksam ist.

Es folgt eine Übersicht über das Verfahren zur End-to-End-Konfiguration der Jumbo-MTU:

- Erstellen Sie eine UCS-QoS-Systemklasse mit einer MTU von 9.000, und konfigurieren Sie dann die virtuelle NIC (vNIC) mit Jumbo-MTU.

- Aktivieren Sie Jumbo Frames (MTU 9000) auf allen Switches zwischen dem Initiator (UCS) und dem iSCSI-Ziel.

- Aktivieren Sie Jumbo Frames auf dem Betriebssystemadapter (VMkernel-Port des ESXi).

- Aktivieren Sie Jumbo Frames auf den NetApp-Schnittstellen.

Hinweis: Weitere Informationen finden Sie im Cisco Artikel Storage Connectivity Options and Best Practices with NetApp Storage.

Konfiguration des Cisco UCS

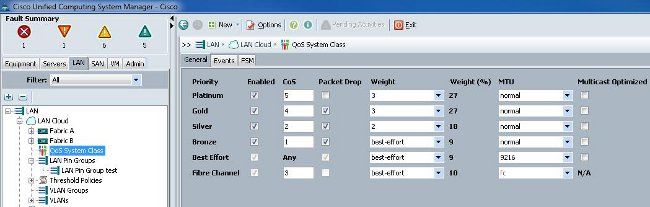

Die MTU wird im UCS pro Class of Service (CoS) festgelegt. Wenn für die vNIC keine QoS-Richtlinie definiert ist, die auf den vSwitch zusteuert, wird der Datenverkehr an die Klasse mit dem besten Aufwand weitergeleitet.

Führen Sie die folgenden Schritte aus, um Jumbo Frames zu aktivieren:

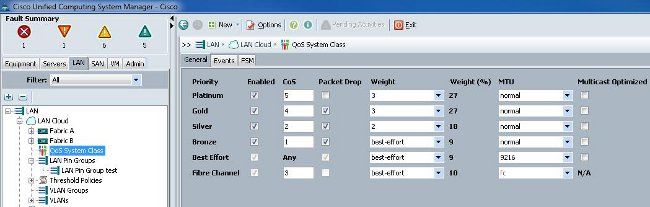

- Klicken Sie in der UCS-GUI auf die Registerkarte LAN.

- Navigieren Sie zu LAN > LAN Cloud > QoS System Class.

- Klicken Sie auf die QoS-Systemklasse, und ändern Sie die MTU-Größe für den Datenverkehr (der iSCSI-Datenverkehr überträgt) in 9216.

Hinweis: In diesem Beispiel wird die Klasse für den bestmöglichen Datenverkehr verwendet, um diese MTU-Aktualisierung zu veranschaulichen.

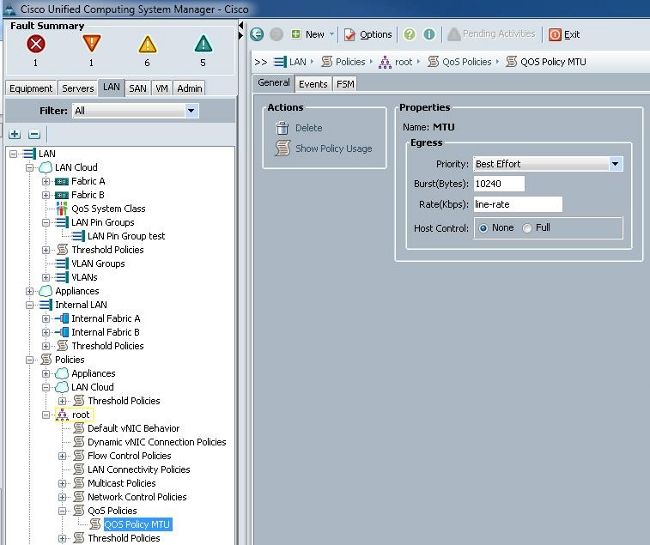

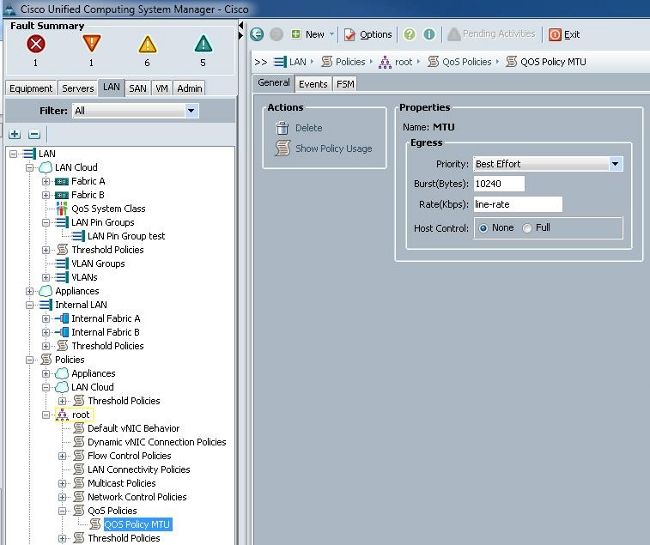

- Erstellen Sie auf der Registerkarte "LAN" eine QoS-Richtlinie, und wenden Sie sie auf die vNIC an, die den Speicherverkehr überträgt.

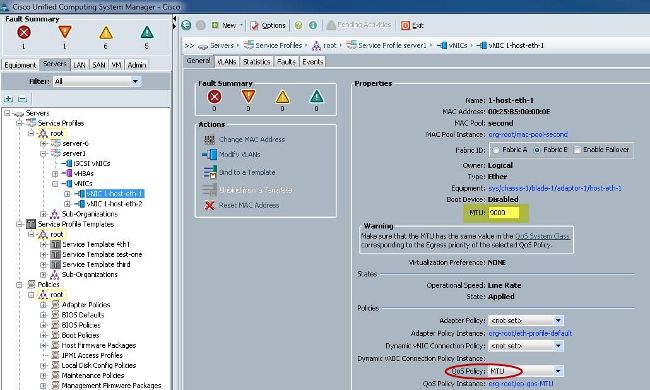

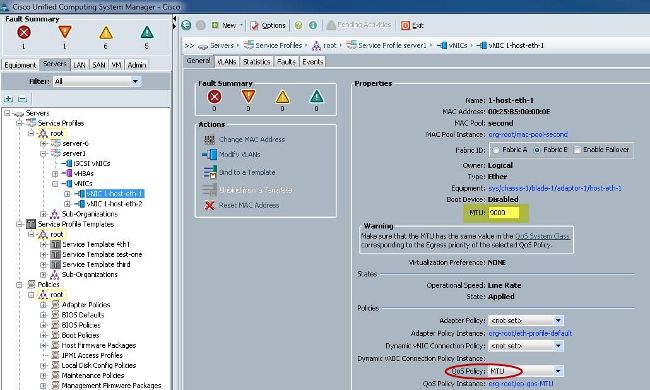

- Navigieren Sie unter den Serviceprofilen zur vNIC-Vorlage oder zur tatsächlichen vNIC, und legen Sie den MTU-Wert auf 9000 fest.

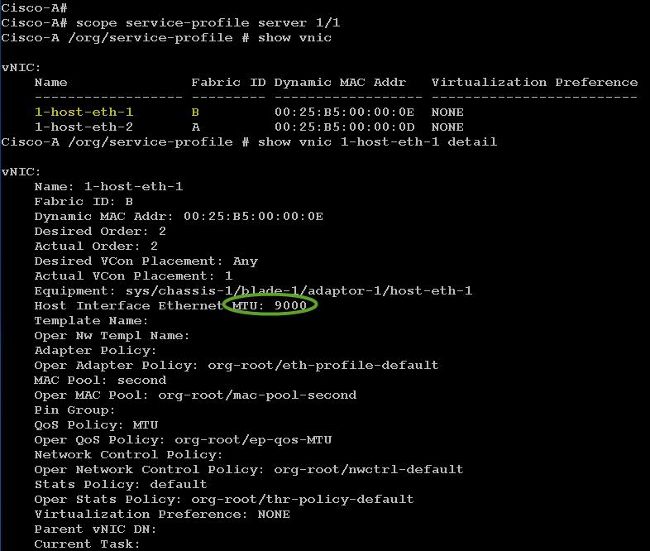

Überprüfung

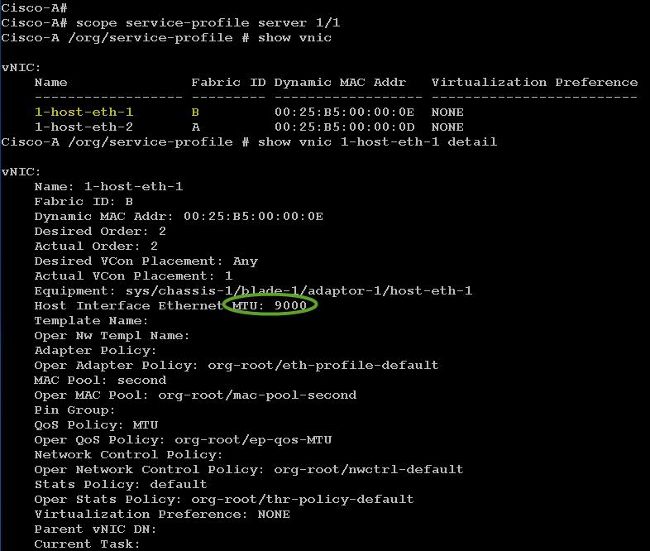

Überprüfen Sie, ob die MTU-Größe der vNIC wie zuvor beschrieben konfiguriert wurde.

Überprüfen Sie, ob die Jumbo-MTU-Größe der Uplink-Ports aktiviert ist.

N5k-Konfiguration

Mit dem Nexus 5000 wird Jumbo-MTU auf Systemebene aktiviert.

Öffnen Sie eine Eingabeaufforderung, und geben Sie die folgenden Befehle ein, um das System für Jumbo-MTU zu konfigurieren:

switch(config)#policy-map type network-qos jumbo

switch(config-pmap-nq)#class type network-qos class-default

switch(config-pmap-c-nq)#mtu 9216

switch(config-pmap-c-nq)#exit

switch(config-pmap-nq)#exit

switch(config)#system qos

switch(config-sys-qos)#service-policy type network-qos jumbo

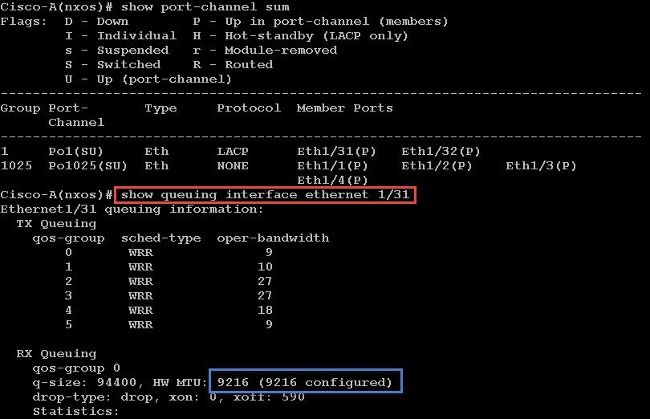

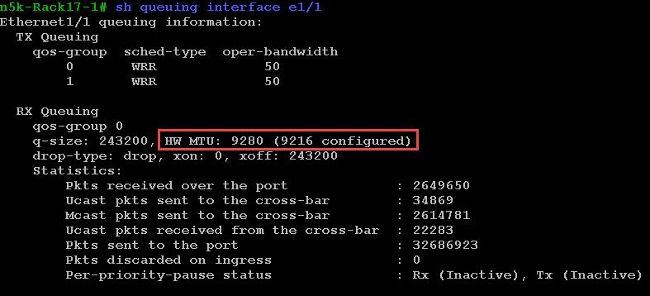

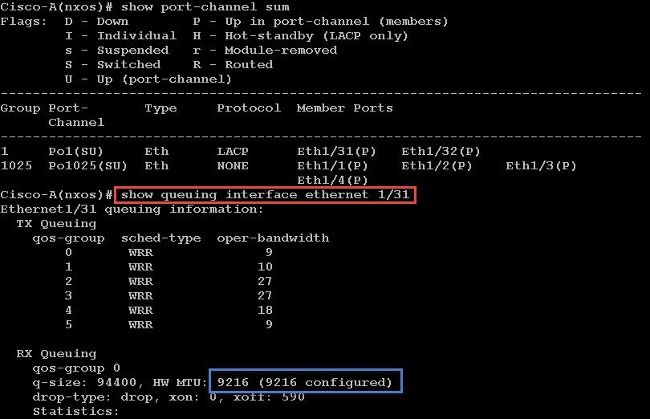

Überprüfung

Geben Sie den Befehl show queuing interface Ethernet x/y ein, um zu überprüfen, ob Jumbo-MTU aktiviert ist:

Hinweis: Der Befehl show interface Ethernet x/y zeigt eine MTU von 1500 an, was jedoch falsch ist.

VMware ESXi-Konfiguration

Sie können den MTU-Wert eines vSwitch so konfigurieren, dass alle Portgruppen und Ports Jumbo Frames verwenden.

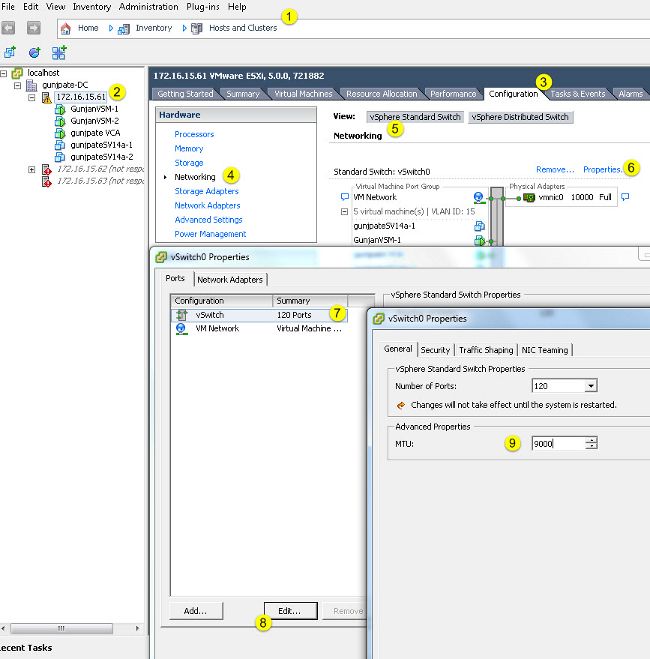

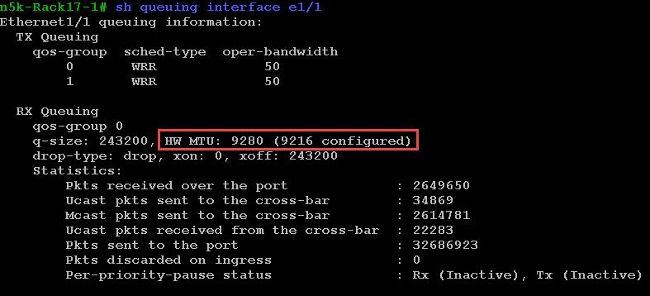

Führen Sie die folgenden Schritte aus, um Jumbo Frames auf einem Host-vSwitch zu aktivieren:

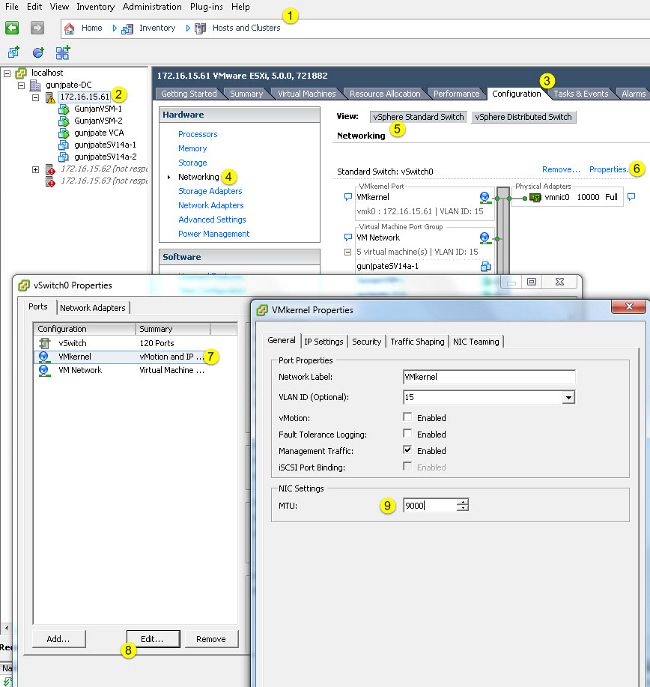

- Navigieren Sie vom vSphere-Client zu Home > Inventory > Hosts and Clusters (Startseite > Bestand > Hosts und Cluster).

- Wählen Sie den Host aus.

- Klicken Sie auf die Registerkarte Konfiguration.

- Wählen Sie im Menü Hardware die Option Networking.

- Wählen Sie im Feld Ansicht die Option vSphere Standard Switch aus.

- Klicken Sie auf Properties (Eigenschaften).

- Wählen Sie im Popup-Fenster "Eigenschaften" auf der Registerkarte "Ports" die Option vSwitch aus.

- Klicken Sie auf Bearbeiten.

- Ändern Sie auf der Registerkarte Allgemein des Popup-Fensters die MTU-Größe (unter Erweiterte Eigenschaften) von dem Standardwert (1500) in 9000. Dadurch werden Jumbo-Frames auf allen Portgruppen und Ports des vSwitch aktiviert.

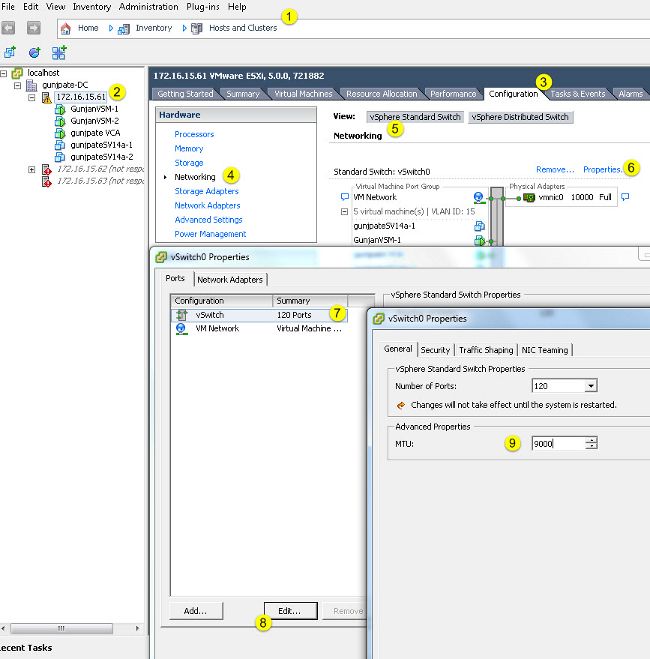

Führen Sie die folgenden Schritte aus, um Jumbo-Frames nur auf einem VMkernel-Port vom vCenter-Server aus zu aktivieren:

- Navigieren Sie vom vSphere-Client zu Home > Inventory > Hosts and Clusters.

- Wählen Sie den Host aus.

- Klicken Sie auf die Registerkarte Konfiguration.

- Wählen Sie im Menü Hardware die Option Networking.

- Wählen Sie im Feld Ansicht die Option vSphere Standard Switch aus.

- Klicken Sie auf Properties (Eigenschaften).

- Wählen Sie VMkernel auf der Registerkarte Ports des Popup-Fensters Eigenschaften aus.

- Klicken Sie auf Bearbeiten.

- Ändern Sie auf der Registerkarte General (Allgemein) des Popup-Fensters die MTU-Größe (unter NIC-Einstellungen) von dem Standardwert (1500) auf 9000. Dadurch werden Jumbo-Frames nur auf einem VMkernel-Port des vSwitch aktiviert.

Überprüfung

Geben Sie den Befehl vmkping -d -s 8972 <IP-Adresse der Speicher-Appliance> ein, um die Netzwerkkonnektivität zu testen und zu überprüfen, ob der VMkernel-Port mit Jumbo-MTU pingen kann.

Tipp: Weitere Informationen zu diesem Befehl finden Sie im VMware-Artikel Testing VMkernel network connectivity with the vmkping command.

Hinweis: Die größte echte Paketgröße ist 8972. Diese sendet ein 9000-Byte-Paket, wenn Sie die IP- und ICMP-Header-Bytes hinzufügen.

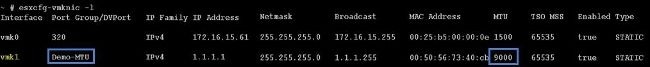

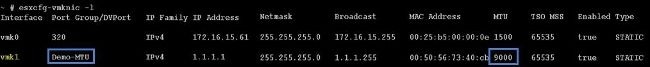

Überprüfen Sie auf ESXi-Hostebene, ob die MTU-Einstellungen richtig konfiguriert sind:

Cisco IOS-Konfiguration

Bei Cisco IOS® Switches besteht auf Switch-Ebene kein Konzept für eine globale MTU. Stattdessen wird die MTU auf Schnittstellen-/Etherchannel-Ebene konfiguriert.

Geben Sie die folgenden Befehle ein, um Jumbo-MTU zu konfigurieren:

7609(config)#int gigabitEthernet 1/1

7609(config-if)#mtu ?

<1500-9216> MTU size in bytes

7609(config-if)#mtu 9216

Überprüfung

Geben Sie den Befehl show interfaces gigabitEthernet 1/1 ein, um zu überprüfen, ob die Konfiguration korrekt ist:

7609#show interfaces gigabitEthernet 1/1

GigabitEthernet1/1 is up, line protocol is up (connected)

Hardware is C6k 1000Mb 802.3, address is 0007.0d0e.640a (bia 0007.0d0e.640a)

MTU 9216 bytes, BW 1000000 Kbit, DLY 10 usec,

reliability 255/255, txload 1/255, rxload 1/255

N1kV-Konfiguration

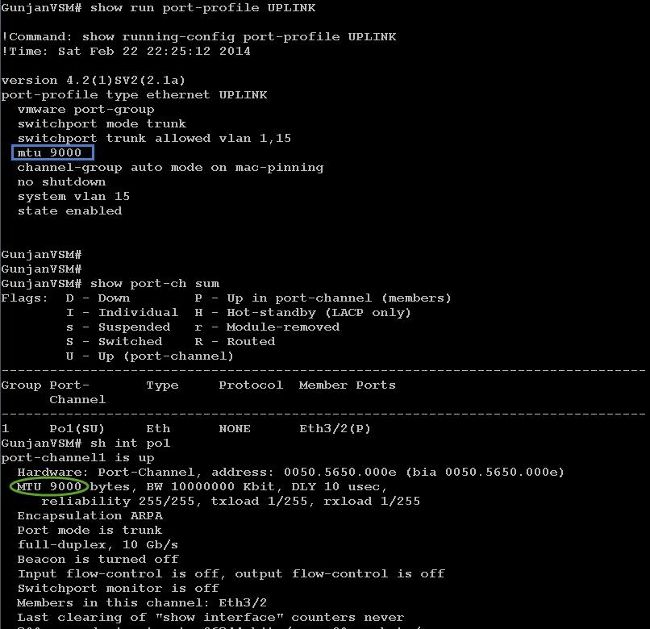

Beim N1kV kann die Jumbo-MTU nur auf den Ethernet-Portprofilen für den Uplink konfiguriert werden. Die MTU kann nicht auf der vEthernet-Schnittstelle konfiguriert werden.

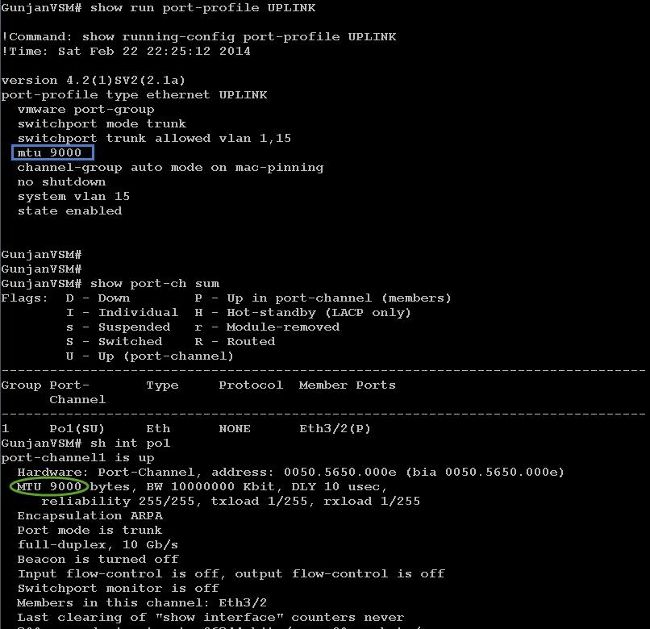

Überprüfung

Geben Sie den Befehl show run port-profile UPLINK ein, um zu überprüfen, ob die Konfiguration korrekt ist:

NetApp FAS 3240-Konfiguration

Auf dem Storage-Controller müssen für die Netzwerk-Ports, die mit dem Fabric Interconnect oder dem Layer-2-Switch (L2) verbunden sind, Jumbo-MTU konfiguriert sein. Nachfolgend finden Sie ein Beispiel für eine Konfiguration:

FAS3240-A> vlan create e1a 100

Ethernet e1a: Link being reconfigured.

vlan: e1a-100 has been created

Ethernet e1a: Link up.

FAS3240-A> vlan create e1b 100

Ethernet e1b: Link being reconfigured.

vlan: e1b-100 has been created

Ethernet e1b: Link up.

FAS3240-A> ifconfig e1a-100 192.168.101.105 netmask 255.255.255.0 mtusize 9000

partner e1a-100

FAS3240-A> ifconfig e1b-100 192.168.102.105 netmask 255.255.255.0 mtusize 9000

partner e1b-100

Überprüfung

In diesem Abschnitt können Sie überprüfen, ob die Konfiguration korrekt ist.

FAS3240-A> ifconfig –a

e1a: flags=0x80f0c867<BROADCAST,RUNNING,MULTICAST,TCPCKSUM,VLAN> mtu 9000

ether 00:c0:dd:11:40:2c (auto-10g_twinax-fd-up) flowcontrol full

e1b: flags=0x80f0c867<BROADCAST,RUNNING,MULTICAST,TCPCKSUM,VLAN> mtu 9000

ether 00:c0:dd:11:40:2e (auto-10g_twinax-fd-up) flowcontrol full

Feedback

Feedback