Konfigurieren von QoS auf einem UCS und Nexus 5000

Download-Optionen

-

ePub (118.4 KB)

In verschiedenen Apps auf iPhone, iPad, Android, Sony Reader oder Windows Phone anzeigen

Inklusive Sprache

In dem Dokumentationssatz für dieses Produkt wird die Verwendung inklusiver Sprache angestrebt. Für die Zwecke dieses Dokumentationssatzes wird Sprache als „inklusiv“ verstanden, wenn sie keine Diskriminierung aufgrund von Alter, körperlicher und/oder geistiger Behinderung, Geschlechtszugehörigkeit und -identität, ethnischer Identität, sexueller Orientierung, sozioökonomischem Status und Intersektionalität impliziert. Dennoch können in der Dokumentation stilistische Abweichungen von diesem Bemühen auftreten, wenn Text verwendet wird, der in Benutzeroberflächen der Produktsoftware fest codiert ist, auf RFP-Dokumentation basiert oder von einem genannten Drittanbieterprodukt verwendet wird. Hier erfahren Sie mehr darüber, wie Cisco inklusive Sprache verwendet.

Informationen zu dieser Übersetzung

Cisco hat dieses Dokument maschinell übersetzen und von einem menschlichen Übersetzer editieren und korrigieren lassen, um unseren Benutzern auf der ganzen Welt Support-Inhalte in ihrer eigenen Sprache zu bieten. Bitte beachten Sie, dass selbst die beste maschinelle Übersetzung nicht so genau ist wie eine von einem professionellen Übersetzer angefertigte. Cisco Systems, Inc. übernimmt keine Haftung für die Richtigkeit dieser Übersetzungen und empfiehlt, immer das englische Originaldokument (siehe bereitgestellter Link) heranzuziehen.

Inhalt

Einführung

Dieses Dokument beschreibt die Konfiguration von Quality of Service (QoS) auf Unified Computing System (UCS)- und Nexus-Geräten.

Voraussetzungen

Anforderungen

Für dieses Dokument bestehen keine speziellen Anforderungen.

Verwendete Komponenten

Die Informationen in diesem Dokument basieren auf den folgenden Software- und Hardwareversionen:

- UCS Fabric Interconnect (FI) 6100 und 6200

- Nexus 5000 und 5500

Die Informationen in diesem Dokument wurden von den Geräten in einer bestimmten Laborumgebung erstellt. Alle in diesem Dokument verwendeten Geräte haben mit einer leeren (Standard-)Konfiguration begonnen. Wenn Ihr Netzwerk in Betrieb ist, stellen Sie sicher, dass Sie die potenziellen Auswirkungen eines Befehls verstehen.

Hintergrundinformationen

Dieses Dokument behandelt UCS (6100 und 6200 Fabric Interconnects) und Nexus (5000 und 5500) QoS speziell für FlexPod und vBlock.

In dieser Dokumentation verwendete Terminologie, die sich auf QoS bezieht.

CoS = Class of Service = 802.1p = 3 Bit im .1q-Header für jedes Paket, um dem Switch die Klassifizierung mitzuteilen.

QoS = Quality of Service = Verarbeitung der einzelnen Serviceklassen durch den Switch.

MTU = Maximum Transmission Unit = Maximale Größe eines auf dem Switch zulässigen Frames/Pakets. Die gängigste und die Standardeinstellung (normal ist, was der folgende UCS-Screenshot zeigt) ist 1500.

Konfigurieren

UCS QoS sofort einsatzbereit

Die UCS-QoS-Einstellungen für Referenz (UCSM/LAN/QoS-Systemklasse):

Hinweis: Best Effort und Fibre Channel sind ausgegraut und können im UCS nicht deaktiviert werden.

Standard-QoS-Konfiguration

P10-UCS-A(nxos)# show running-config ipqos

logging level ipqosmgr 2

class-map type qos class-fcoe

class-map type queuing class-fcoe

match qos-group 1

class-map type queuing class-all-flood

match qos-group 2

class-map type queuing class-ip-multicast

match qos-group 2

policy-map type qos system_qos_policy

class class-fcoe

set qos-group 1

class class-default

policy-map type queuing system_q_in_policy

class type queuing class-fcoe

bandwidth percent 50

class type queuing class-default

bandwidth percent 50

policy-map type queuing system_q_out_policy

class type queuing class-fcoe

bandwidth percent 50

class type queuing class-default

bandwidth percent 50

class-map type network-qos class-fcoe

match qos-group 1

class-map type network-qos class-all-flood

match qos-group 2

class-map type network-qos class-ip-multicast

match qos-group 2

policy-map type network-qos system_nq_policy

class type network-qos class-fcoe

pause no-drop

mtu 2158

class type network-qos class-default

system qos

service-policy type qos input system_qos_policy

service-policy type queuing input system_q_in_policy

service-policy type queuing output system_q_out_policy

service-policy type network-qos system_nq_policy

Relevante Informationen:

- qos-group beschreibt, wie der Switch eine bestimmte CoS intern behandelt. Stellen Sie sich die qos-Gruppe als Eimer oder Spur vor, in die jedes Paket geht.

- Best Effort enthält keine explizite qos-Gruppe, daher wird standardmäßig qos-Gruppe 0 verwendet.

- Fibre Channel over Ethernet (FCoE) weist CoS 3 auf und wird in QoS-Gruppe 1 eingefügt

CoS <=> qos-group-Kurzreferenz

| CoS | QoS-Gruppe | |

| Platinum | 5 | 2 |

| Gold | 4 | 1 |

| Silber | 2 | 4 |

| Bronze | 1 | 5 |

| Bester Aufwand | Beliebig | 0 |

| Fibre Channel | 1 | 1 |

CoS kann auf dem UCS in CoS 6 geändert werden. CoS 7 ist für die interne UCS-Kommunikation reserviert.

show queuing interface-Befehl

P10-UCS-A(nxos)# show queuing interface

Ethernet1/1 queuing information:

TX Queuing

qos-group sched-type oper-bandwidth

0 WRR 50

1 WRR 50

RX Queuing

qos-group 0

q-size: 360640, HW MTU: 1500 (1500 configured)

drop-type: drop, xon: 0, xoff: 360640

Statistics:

Pkts received over the port : 27957

Ucast pkts sent to the cross-bar : 0

Mcast pkts sent to the cross-bar : 27957

Ucast pkts received from the cross-bar : 0

Pkts sent to the port : 347

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

qos-group 1

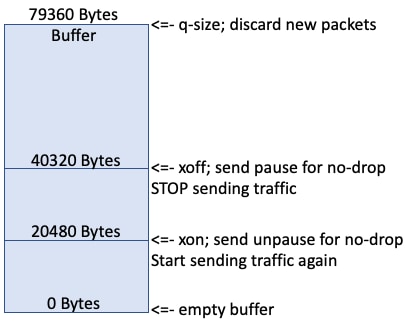

q-size: 79360, HW MTU: 2158 (2158 configured)

drop-type: no-drop, xon: 20480, xoff: 40320

Statistics:

Pkts received over the port : 0

Ucast pkts sent to the cross-bar : 0

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 0

Pkts sent to the port : 0

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

Total Multicast crossbar statistics:

Mcast pkts received from the cross-bar : 347

Diese Ausgabe zeigt, wie diese Schnittstelle die einzelnen Klassen in die Warteschlange stellt.

Informationen zu Switch-Port Ethernet 1/1:

- Best Effort erhält qos-Gruppe 0 und eine q-Größe von 360640 Byte Puffer und eine MTU von 1500.

- Dieser Port hat 27957 Pakete mit bestem Datenverkehr empfangen und 347 Pakete empfangen bzw. empfangen.

- "Beim Eingang verworfene Pakete" ist die Anzahl der empfangenen Pakete, aber zu diesem Zeitpunkt war der Puffer (q-size) voll, und der Switch entschied sich zu verwerfen. Dies wird auch als Tail Drop bezeichnet.

IOM-Port que

Show Queuing Interface for the Input and Output Modules (IOM) ports in the UCS chassis:

Ethernet1/1/1 queuing information: Input buffer allocation: Qos-group: 1 frh: 3 drop-type: no-drop cos: 3 xon xoff buffer-size ---------+---------+----------- 8960 14080 24320 Qos-group: 0 frh: 8 drop-type: drop cos: 0 1 2 4 5 6 xon xoff buffer-size ---------+---------+----------- 0 117760 126720 Queueing: queue qos-group cos priority bandwidth mtu --------+------------+--------------+---------+---------+---- 2 0 0 1 2 4 5 6 WRR 50 1600 3 1 3 WRR 50 2240 Queue limit: 66560 bytes Queue Statistics: queue rx tx ------+---------------+--------------- 2 18098 28051 3 0 0 Port Statistics: rx drop rx mcast drop rx error tx drop mux ovflow ---------------+---------------+---------------+---------------+-------------- 0 0 0 0 InActive Priority-flow-control enabled: yes Flow-control status: cos qos-group rx pause tx pause masked rx pause -------+-----------+---------+---------+--------------- 0 0 xon xon xon 1 0 xon xon xon 2 0 xon xon xon 3 1 xon xon xon 4 0 xon xon xon 5 0 xon xon xon 6 0 xon xon xon 7 n/a xon xon xon

Es gibt qos-Gruppe 0 und qos-Gruppe 1, qos-Gruppe 0 erhält Pakete, die mit cos 0 1 2 4 5 6 und qos-Gruppe 1 mit cos 3 gekennzeichnet sind. Die Puffergröße auf Fabric Extender (FEX)/IOMs ist etwas kleiner und beträgt nur 126720 Byte. FEX führt QoS etwas anders aus und übernimmt mehrere QoS-Gruppen und bündelt sie in einer Warteschlange. Die rx- und tx-Zähler für jede Warteschlange sind sichtbar.

show interface priority-flow control

Die letzte Ausgabe zum Auschecken lautet: show interface priority-flow control

P10-UCS-A(nxos)# show interface priority-flow-control ============================================================ Port Mode Oper(VL bmap) RxPPP TxPPP ============================================================ Ethernet1/1 Auto Off 0 0 Ethernet1/2 Auto Off 0 0 Ethernet1/3 Auto Off 0 0 Ethernet1/4 Auto Off 6 0 Ethernet1/5 Auto Off 0 0 Ethernet1/6 Auto Off 0 0 Ethernet1/7 Auto Off 0 0 Ethernet1/8 Auto Off 0 0 Ethernet1/9 Auto Off 0 0 Ethernet1/10 Auto Off 2 0 ..snip.. Vethernet733 Auto Off 0 0 Vethernet735 Auto Off 0 0 Vethernet737 Auto Off 0 0 Ethernet1/1/1 Auto On (8) 0 0 Ethernet1/1/2 Auto Off 0 0 Ethernet1/1/3 Auto On (8) 0 0 Ethernet1/1/4 Auto Off 0 0

Dies zeigt an, welche Schnittstellen Priority Flow Control (PFC) aushandelt (Auto On) und welche Schnittstellen PFC nicht aushandelt (Auto Off). PFC ist eine Möglichkeit für einen Switch, einen Nachbarswitch zu bitten, für kurze Zeit keine Pakete einer bestimmten CoS zu senden. PFC-Pausen (PPP,per Priority Pause) treten auf, wenn die Puffer voll/fast voll sind. Die Ausgabe von "show cdp neighbors" und "show fex details" zeigt, dass Ethernet 1/1-4 auf den FEX/IOM des Chassis 1 beschränkt ist, Ethernet 1/9-10 auf den Nexus 5000. In dieser Ausgabe wurden 6 Pausen auf Ethernet 1/4 an den FEX/IOM gesendet und 2 Pausen auf Ethernet1/10 an den Upstream-Nexus 5000 gesendet.

- PPPs selbst SIND KEINE SCHLECHTE SACHE!

Hinweis: Da FEX/IOM keine echten Switches sind, handelt PFC NICHT auf Ethernet1/1-4 zwischen ihnen aus, sondern kann mit dem Endpunkt Ethernet1/1/1 aushandeln. Die an einen FEX/IOM gesendeten PPPs werden über den Remote-Switch-Port Ethernet1/1/1 gesendet.

UCS QoS ist sofort einsatzbereit..

Was geschieht, wenn Silver aktiviert ist?

Dies führt zur Konfiguration:

class-map type qos class-fcoe

class-map type qos match-all class-silver match cos 2 class-map type queuing class-silver match qos-group 4

class-map type queuing class-all-flood

match qos-group 2

class-map type queuing class-ip-multicast

match qos-group 2

policy-map type qos system_qos_policy

class class-silver set qos-group 4

policy-map type queuing system_q_in_policy

class type queuing class-silver bandwidth percent 44

class type queuing class-fcoe

bandwidth percent 29

class type queuing class-default

bandwidth percent 27

policy-map type queuing system_q_out_policy

class type queuing class-silver bandwidth percent 44

class type queuing class-fcoe

bandwidth percent 29

class type queuing class-default

bandwidth percent 27

policy-map type queuing org-root/ep-qos-Default-Qos

class type queuing class-fcoe

class type queuing class-default

bandwidth percent 50

shape 40000000 kbps 10240

class-map type network-qos class-silver match qos-group 4class-map type network-qos class-all-flood

match qos-group 2

class-map type network-qos class-ip-multicast

match qos-group 2

policy-map type network-qos system_nq_policy

class type network-qos class-silver

class type network-qos class-fcoe

pause no-drop

mtu 2158

class type network-qos class-default

system qos

service-policy type qos input system_qos_policy

service-policy type queuing input system_q_in_policy

service-policy type queuing output system_q_out_policy

service-policy type network-qos system_nq_policy

Ethernet1/1 queuing information:

TX Queuing

qos-group sched-type oper-bandwidth

0 WRR 27

1 WRR 29

4 WRR 44

RX Queuing

qos-group 0

q-size: 308160, HW MTU: 9216 (9216 configured)

drop-type: drop, xon: 0, xoff: 301120

Statistics:

Pkts received over the port : 12

Ucast pkts sent to the cross-bar : 12

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 17

Pkts sent to the port : 17

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

qos-group 1

q-size: 79360, HW MTU: 2158 (2158 configured)

drop-type: no-drop, xon: 20480, xoff: 40320

Statistics:

Pkts received over the port : 7836003

Ucast pkts sent to the cross-bar : 7836003

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 4551954

Pkts sent to the port : 4551954

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

qos-group 4 q-size: 22720, HW MTU: 1500 (1500 configured)

drop-type: drop, xon: 0, xoff: 22720

Statistics:

Pkts received over the port : 0

Ucast pkts sent to the cross-bar : 0

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 0

Pkts sent to the port : 0

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

Beachten Sie, dass der Best Effort (QoS-Gruppe 0) q-Größe von 360640 auf 308160 gefallen ist, weil Silver (QoS-Gruppe 4) 22720 Pufferspeicher zugewiesen wurde.

Was ist, wenn Silver Jumbo gemacht wird?

Legen Sie MTU auf 9216 fest.

Ethernet1/1 queuing information:

TX Queuing

qos-group sched-type oper-bandwidth

0 WRR 27

1 WRR 29

4 WRR 44

RX Queuing

qos-group 0

q-size: 301120, HW MTU: 9216 (9216 configured)

drop-type: drop, xon: 0, xoff: 301120

Statistics:

Pkts received over the port : 3

Ucast pkts sent to the cross-bar : 3

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 0

Pkts sent to the port : 0

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

qos-group 1

q-size: 79360, HW MTU: 2158 (2158 configured)

drop-type: no-drop, xon: 20480, xoff: 40320

Statistics:

Pkts received over the port : 7842224

Ucast pkts sent to the cross-bar : 7842224

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 4555791

Pkts sent to the port : 4555791

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

qos-group 4

q-size: 29760, HW MTU: 9216 (9216 configured)

drop-type: drop, xon: 0, xoff: 29760

Statistics:

Pkts received over the port : 0

Ucast pkts sent to the cross-bar : 0

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 0

Pkts sent to the port : 0

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

Silver(qos-Gruppe 4) erhält jetzt 29760 q-Größe, gegenüber 22720.

Was geschieht, wenn Silver ohne Unterbrechungen angeboten wird?

Deaktivieren Sie die Einstellung für Packet Drop?

Ethernet1/1 queuing information:

TX Queuing

qos-group sched-type oper-bandwidth

0 WRR 27

1 WRR 29

4 WRR 44

RX Queuing

qos-group 0

q-size: 240640, HW MTU: 9216 (9216 configured)

drop-type: drop, xon: 0, xoff: 240640

Statistics:

Pkts received over the port : 20

Ucast pkts sent to the cross-bar : 20

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 1

Pkts sent to the port : 1

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

qos-group 1

q-size: 79360, HW MTU: 2158 (2158 configured)

drop-type: no-drop, xon: 20480, xoff: 40320

Statistics:

Pkts received over the port : 7837323

Ucast pkts sent to the cross-bar : 7837323

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 4552726

Pkts sent to the port : 4552726

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

qos-group 4 q-size: 90240, HW MTU: 9216 (9216 configured)

drop-type: no-drop, xon: 17280, xoff: 37120

Statistics:

Pkts received over the port : 0

Ucast pkts sent to the cross-bar : 0

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 0

Pkts sent to the port : 0

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

Beachten Sie, dass die Silver-Größe (QoS-Gruppe 4) auf 90240 erhöht wird, derFalltyp auf no-drop geändert wird und die Best Effort-QoS-Gruppe 0 auf 240640 reduziert wird.

Der Pufferbereich für die Best Effort qos-Gruppe 0 wird anderen QoS-Klassen neu zugewiesen.

Upstream-Nexus 5000

Die Nexus 5000-Standard-QoS-Konfigurationen sind ähnlich, aber nicht genau.

show running-config ipqos

P10-5k-a# show running-config ipqos

policy-map type network-qos jumbo

class type network-qos class-fcoe

pause no-drop

mtu 2158

class type network-qos class-default

mtu 9216

multicast-optimize

system qos

service-policy type network-qos jumbo

Der Nexus 5000 verbirgt Standardoptionen, sodass show running-config ipqos all erforderlich ist, um die gesamte Konfiguration anzuzeigen.

Show Queuing-Schnittstelle

P10-5k-a# show queuing interface

Ethernet1/1 queuing information:

TX Queuing

qos-group sched-type oper-bandwidth

0 WRR 100

1 WRR 0

RX Queuing

qos-group 0

q-size: 360640, HW MTU: 9216 (9216 configured)

drop-type: drop, xon: 0, xoff: 360640

Statistics:

Pkts received over the port : 16

Ucast pkts sent to the cross-bar : 16

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 0

Pkts sent to the port : 0

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

qos-group 1

q-size: 79360, HW MTU: 2158 (2158 configured)

drop-type: no-drop, xon: 20480, xoff: 40320

Statistics:

Pkts received over the port : 0

Ucast pkts sent to the cross-bar : 0

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 0

Pkts sent to the port : 0

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

show interface priority-flow control

An den Ports bis zum UCS (Ethernet1/1 - 2) ist PFC Off (Auto Off) aktiviert.

P10-5k-a(config-if-range)# show interface priority-flow-control ============================================================ Port Mode Oper(VL bmap) RxPPP TxPPP ============================================================ Ethernet1/1 Auto Off 0 0 Ethernet1/2 Auto Off 0 0 Ethernet1/3 Auto Off 0 0 Ethernet1/4 Auto Off 0 0 Ethernet1/5 Auto Off 0 0 Ethernet1/6 Auto Off 0 0 Ethernet1/7 Auto Off 0 0 Ethernet1/8 Auto Off 0 0 Ethernet1/9 Auto Off 0 0 Ethernet1/10 Auto On (0) 0 0 Ethernet1/11 Auto On (0) 0 0 Ethernet1/12 Auto On (0) 0 0 Ethernet1/13 Auto On (0) 0 0

..snip..

Hinzufügen von FCoE zur Konfiguration

Diese Richtlinien sind auf dem Nexus 5000 standardmäßig vorhanden, sind jedoch nicht aktiviert. Verwenden Sie sie daher nur.

system qos service-policy type queuing input fcoe-default-in-policy service-policy type queuing output fcoe-default-out-policy service-policy type qos input fcoe-default-in-policy

show interface priority-flow control

Die Ports bis zum UCS (Ethernet1/1 - 2) verfügen über PFC on (Auto On).

P10-5k-a(config-sys-qos)# sh int priority-flow-control ============================================================ Port Mode Oper(VL bmap) RxPPP TxPPP ============================================================ Ethernet1/1 Auto On (8) 0 0 Ethernet1/2 Auto On (8) 0 0 Ethernet1/3 Auto Off 0 0 Ethernet1/4 Auto Off 0 0

..snip..

PFC

PFC (802.1Qbb) zeigt, wie Nexus-/UCS-Geräte im Rahmen von Data Center Bridging (DCBX) eine verlustfreie Fabric erstellen. Für FCoE ist eine verlustfreie Fabric erforderlich. FCoE mit mehreren Hop ist besonders anfällig für dieses Konfigurationsproblem. Der Upstream-Switch, in der Regel ein Nexus 5000, muss mit den im UCS konfigurierten QoS-Einstellungen übereinstimmen.

Wie bereits erwähnt, können Switches mit PFC Nachbarswitches benachrichtigen, um anzuhalten, zusätzliche Frames zu senden. Betrachten Sie dies im Kontext einer Netzwerkumgebung mit mehreren Switches, in der der Datenverkehr in mehrere Richtungen gleichzeitig fließt. Beim Hinzufügen dieser Puffer von path1 (source1/destination1) werden Puffer multipliziert, da der Nachbarswitch wahrscheinlich Datenverkehr enthält, der mehrere Ports (mehrere Puffer) eingeht. Obwohl PFC bei der Verwendung von IP-Speicher nicht erforderlich ist, trägt es häufig zu einer drastischen Verbesserung der Leistung bei, da der Puffermultiplikationseffekt unnötige Paketverluste verhindert.

Ein ausgezeichneter Überblick über PFC/DCBX.

Warum wird PFC NICHT verhandelt?

QoS-No-Drop-Richtlinien müssen auf jeder Seite übereinstimmen.

Wenn eine QoS-Klasse auf einem Switch als no-drop und nicht als no-drop auf dem anderen definiert wird, handelt PFC nicht aus. Da das UCS Platinum als No-Drop, aber standardmäßig deaktiviert konfiguriert, tritt dies häufig auf, wenn Platinum aktiviert ist.

System QoS muss auf jeder Seite übereinstimmen.

Wenn die Eingabe in die Warteschlange und die Ausgabe in die Warteschlange und die QoS-Eingabe nicht übereinstimmen, handelt PFC nicht aus.

NetApp

Gold

NetApp-Filter senden standardmäßig ALLE IP-Speicherdatenverkehr, die von NetApp im CoS 4(Gold) mit VLAN markiert sind. Da sich die CoS-Bits im .1q-Header befinden, wenn die NetApp mit einem Access-Port verbunden ist, wird der NetApp-Datenverkehr in "Best Effort" übertragen.

Asymmetrische QoS

Ein häufiger Konfigurationsfehler besteht darin, eine andere CoS-Farbe (Silver) auszuwählen, um den NFS-Datenverkehr des Netzwerkdateisystems aus dem UCS einzufügen und den NFS-Datenverkehr von einer NetApp in Gold zurückzugeben. Der Datenverkehr ist also in etwa so:

| Server | UCS | Nexus 5000 | NetApp |

| Senden | Silver > | Silver > | Bester Aufwand |

| Empfangen | < Gold | < Gold | < Gold |

Wenn das UCS für Silver als Jumbo, aber NICHT als Gold konfiguriert wäre, würde dies Probleme verursachen.

Undefinierte QoS

Wenn eine QoS-Klasse (Platinum/Gold/Silver/Bronze) NICHT aktiviert ist, werden diese Pakete von UCS- und Nexus-Geräten als Best Effort behandelt und in die QoS-Gruppe 0 aufgenommen.

| Server | UCS | Nexus 5000 | NetApp |

| Senden | Silver > | Bester Aufwand > | Bester Aufwand |

| Empfangen | < Gold | < Bester Aufwand | < Gold |

Hinweis: Die CoS-Bits auf dem Paket werden NICHT geändert/gekennzeichnet, aber die Pakete werden unterschiedlich behandelt.

VCE-QoS (Virtual Computing Environment)

Das VCE QoS-Design ist alles andere als ideal.

| Nexus 1000 | UCS | Nexus 5000 | |

| BE/CoS 0 | 1500 | 1500 | 1600 |

| FC/CoS 1 | - | 2158 (kein Ablegen) | - |

| CoS 6 |

Mgmt | - | - |

| Platinum/CoS 5 |

- | 1500 (kein Tropfen) | 1500 |

| Gold/CoS 4 | VoMotion | 1500 | 1500 |

| Silver/CoS 2 | NFS | - | 9216 (kein Ablegen) |

Wenn CoS-Klassen auf einer Ebene definiert, aber auf einer anderen Ebene ignoriert werden, ist kompliziert und könnte dazu führen, dass Dinge nicht so funktionieren, wie sie ursprünglich vorgesehen waren. VCE verwendet z. B. Silver für NFS, aber wenn das UCS nicht über Silver verfügt, wird dieser Datenverkehr in Best Effort in Warteschlange gestellt. Dies ist kein Jumbo und kann dazu führen, dass NFS-Datenverkehr verworfen oder fragmentiert wird. PFC wird aufgrund von Diskrepanzen in Non-Drop-Richtlinien nicht ausgehandelt, aber dies ist offensichtlich in Ordnung, da PFC für Ethernet nicht erforderlich ist.

Tiefkühlpuffer

IP-basierte Storage-Protokolle sind äußerst bursty-Protokolle und werden oft mit einer MTU von 9.000 konfiguriert. Da Platinum/Gold/Silver/Bronze aufgrund der Größe 2960 q/9000 MTU nur drei Pakete in den Puffer eingehen können, bevor Tail-Drop verursacht wird, ist die Performance bei Platinum/Gold/Silver/Bronze schlecht.

Größere Puffer

Die UCS-Ethernet-Richtlinie ermöglicht die Erhöhung der vNIC-Puffer (Ringgröße). Der Standardwert ist 512 und der Höchstwert ist 4096. Wenn Sie diesen Wert auf das Maximum setzen, erhöht sich die Latenz des gesamten Puffers (##KB/10 Gbit/s) von 0,4 ms auf 3,2 ms. Änderungen in diesem Puffer ermöglichen also weniger Tropfen, aber auf Kosten einer erhöhten Latenz.

9216 MTU im Vergleich zu 9000 MTU

Der Zweck der Konfiguration von Jumbo Frames besteht darin, einem Endgerät die Kommunikation mit einem anderen Endgerät mit 9000 Byte Layer-3-Paketen zu ermöglichen. Bei Verwendung von Layer-2-Kapselungstechniken müssen die Switches und Router zwischen den Endgeräten in der Lage sein, etwas größere Layer-2-Frames als 9000 MTU-Layer-3-Pakete zu verarbeiten, um den Kapselungs-Overhead zu berücksichtigen. Im Zweifelsfall 9216 MTU auf Switches zulassen.

PFC und PPP

Wenn neue Pakete in die Warteschlange gestellt werden, wird der Puffer gefüllt.

Wenn der Puffer auf 20.000 steigt, füllt der Puffer weiter aus.

Wenn der Puffer auf 40.000 steigt, sendet der Switch eine PPP-Pause, wenn diese Warteschlange nicht unterbrochen ist. Dies bedeutet, dass der Remote-Switch den Datenverkehr nicht mehr senden soll.

Im Idealfall wird der Datenverkehr auf der Remote-Seite bald unterbrochen, und der verbleibende Puffer (79360-40320) hält eingehende Pakete im Flug.

Die Zähler für "bei Eingang verworfene Pkte" werden erhöht, wenn der Puffer voll ist.

FC und FCoE ist ein verlustfreies Protokoll in einer idealen Situation, in der der Remote-Switch aufhört, Datenverkehr und Puffer zu senden, die schließlich sinken und 20.000 erreichen. Der Switch sendet eine weitere PPP-Pause für diese Warteschlange ohne Dropdown, die den Remote-Switch anweist, den Datenverkehr erneut zu senden.

Fehlerbehebung

Für diese Konfiguration sind derzeit keine spezifischen Informationen zur Fehlerbehebung verfügbar.

Zugehörige Informationen

Beiträge von Cisco Ingenieuren

- Steven TardyCisco TAC-Techniker

- and Pom HamCisco TAC-Techniker

Cisco kontaktieren

- Eine Supportanfrage öffnen

- (Erfordert einen Cisco Servicevertrag)

Feedback

Feedback