Introducción

Este documento describe las opciones de ajuste para los adaptadores VNIC en el modo administrado de intersección (IMM) a través de los perfiles de servidor.

Prerequisites

Configuración recomendada del SO para adaptadores Ethernet:

Las políticas operativas de informática, almacenamiento y gestión deben configurarse previamente.

Requirements

Cisco recomienda que tenga conocimiento sobre estos temas:

- Modo gestionado de intercambio

- Conectividad de red física

- Parámetros del adaptador Ethernet recomendados por el SO

- Elementos de ajuste de VNIC

Componentes Utilizados

La información que contiene este documento se basa en las siguientes versiones de software y hardware.

- Firmware UCS-B200-M5 4.2(1a)

- Fabric Interconnect Cisco UCS 6454, firmware 4.2(1e)

- Software como servicio (SaaS) de Intersight

The information in this document was created from the devices in a specific lab environment. All of the devices used in this document started with a cleared (default) configuration. Si tiene una red en vivo, asegúrese de entender el posible impacto de cualquier comando.

Configurar

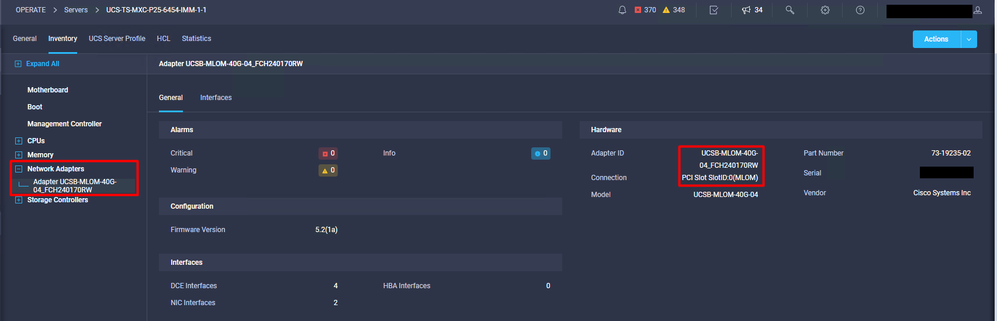

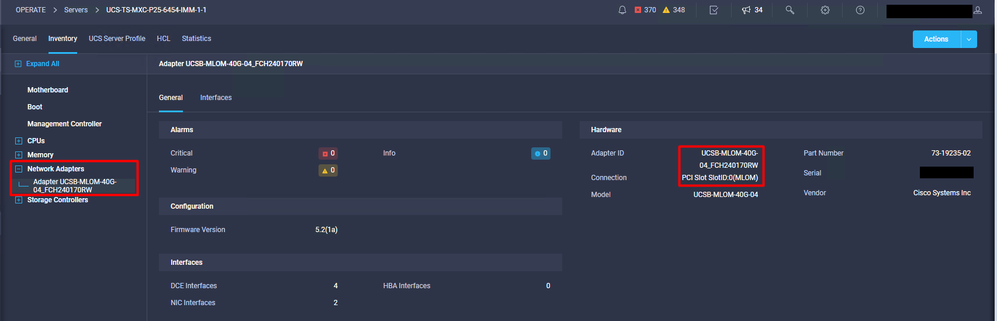

Paso 1. Identificación del adaptador VIC y la ID de ranura en el servidor

Vaya a la pestaña Servidores > Inventario > Seleccione la opción Adaptadores de red.

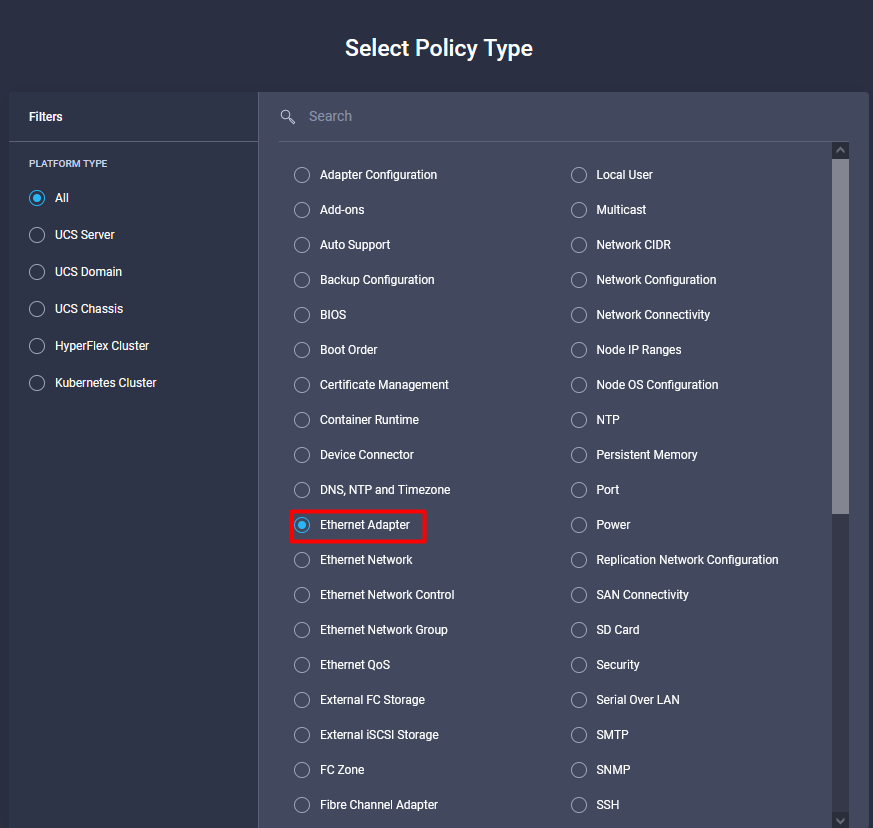

Paso 2. Crear política de adaptador Ethernet

Cree la política del adaptador Ethernet con los valores sugeridos por el proveedor del sistema operativo.

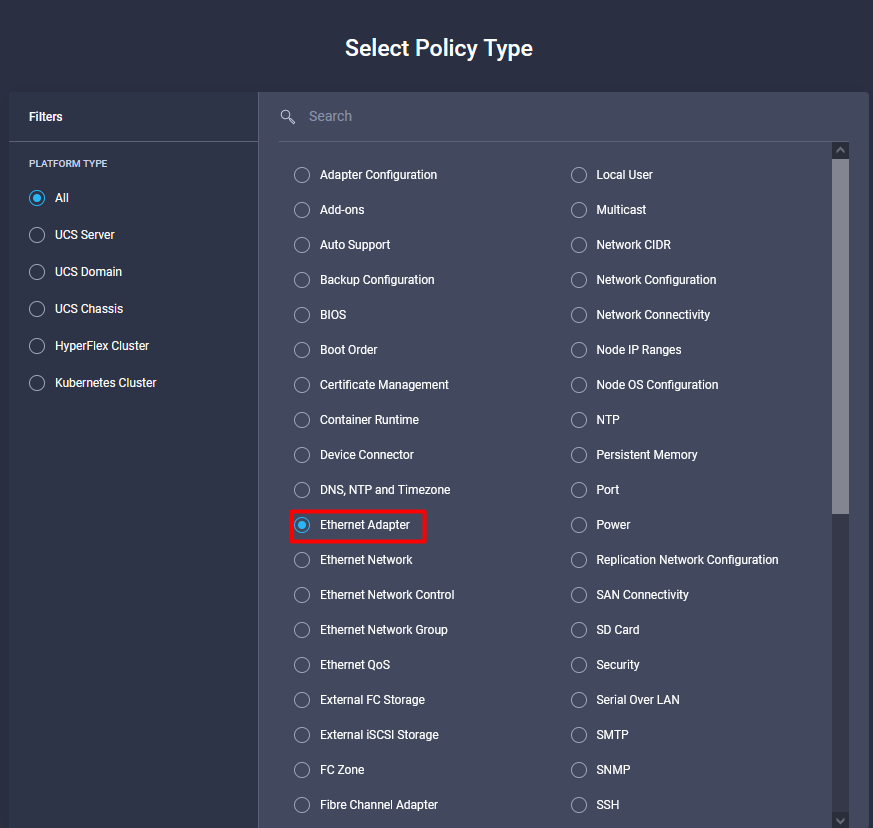

Vaya a la pestaña Políticas > Crear política > Seleccionar adaptador Ethernet.

Una vez dentro del menú Create Policy, seleccione la Organización y proporcione el Nombre de Política.

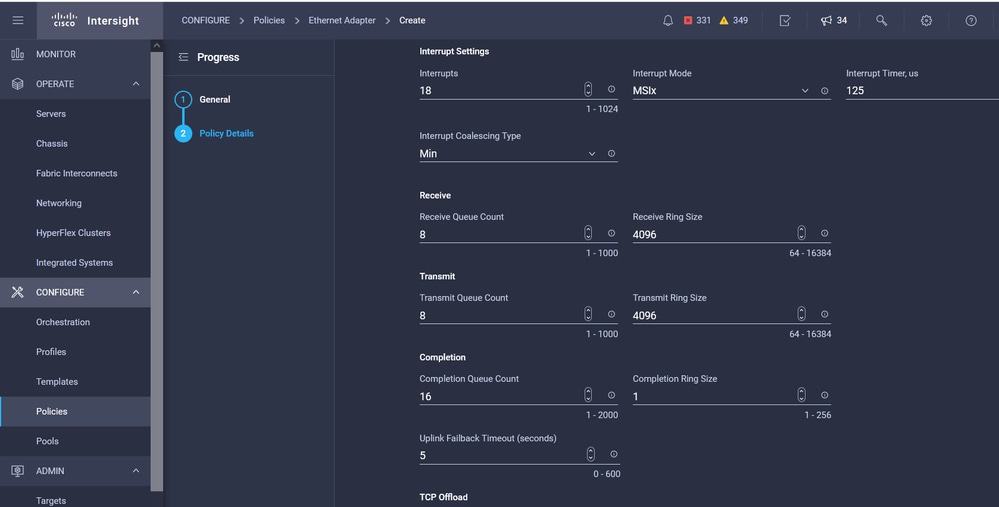

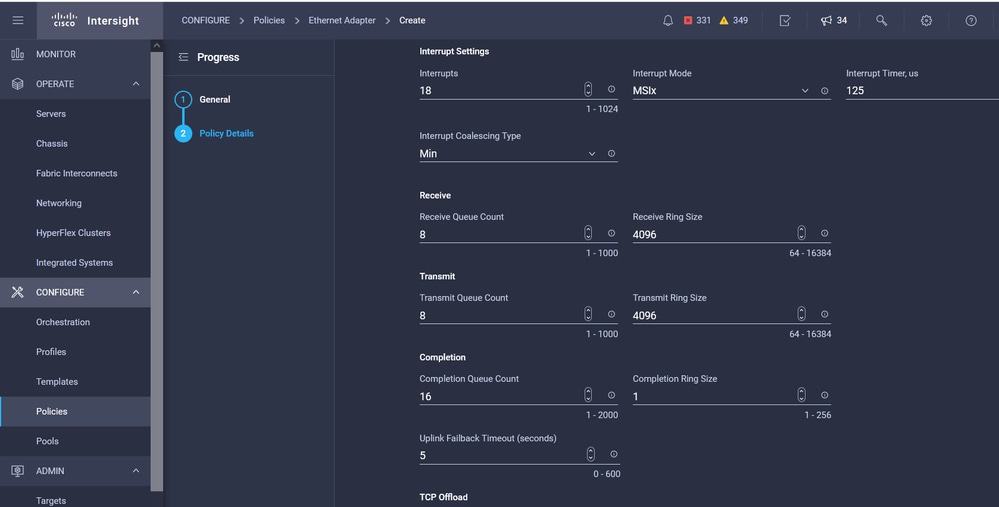

Paso 3. Configure los parámetros sugeridos por el proveedor del sistema operativo. Por lo general, las funciones enumeradas se configuran dentro de la política del adaptador Ethernet:

- Colas de recepción

- Transmitir colas

- Tamaño del timbre

- Colas de finalización

- Interrupciones

- Habilitación de la escalabilidad lateral de recepción (RSS) o la dirección de flujo de recepción acelerada (ARFS)

Nota: RSS y ARFS se excluyen mutuamente, así que configure sólo uno. No configure ambos.

Una vez creada, asigne la política de adaptador Ethernet a una política de conectividad LAN.

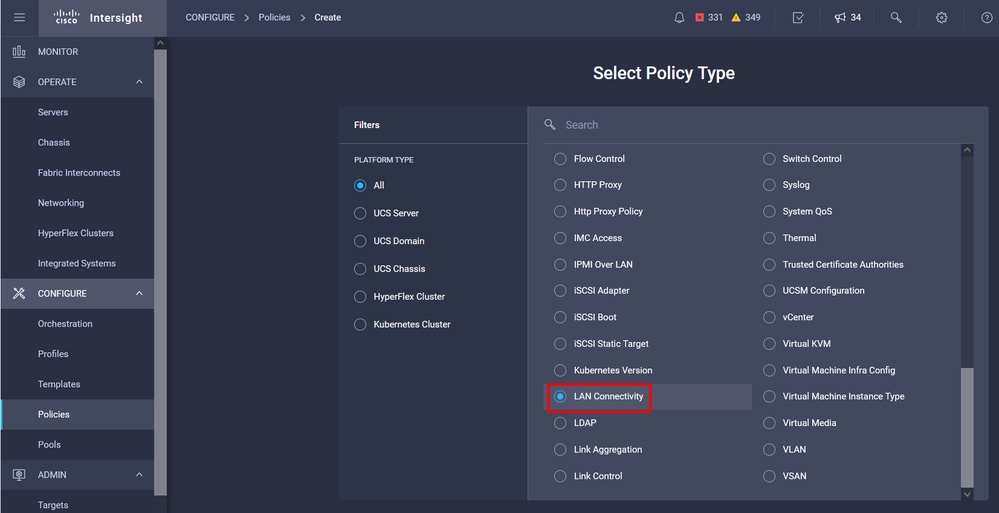

Paso 4. Crear una política de conectividad LAN

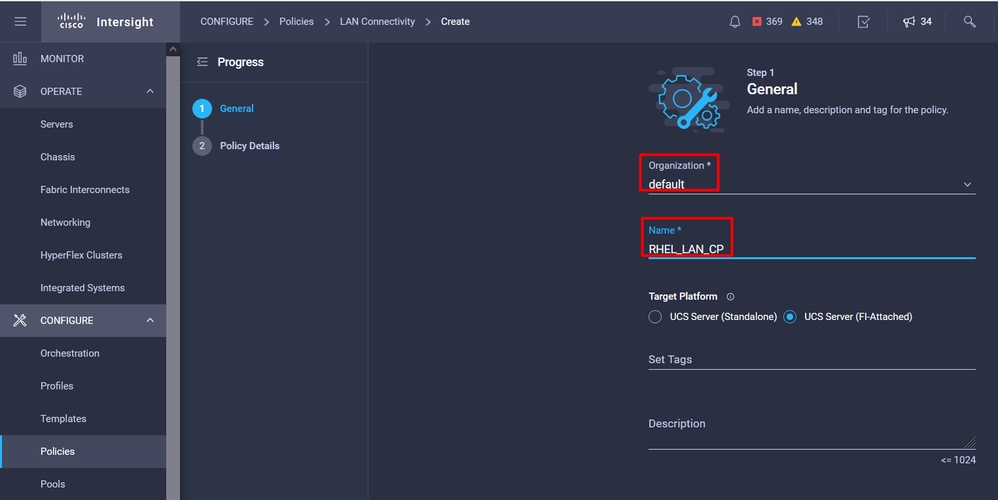

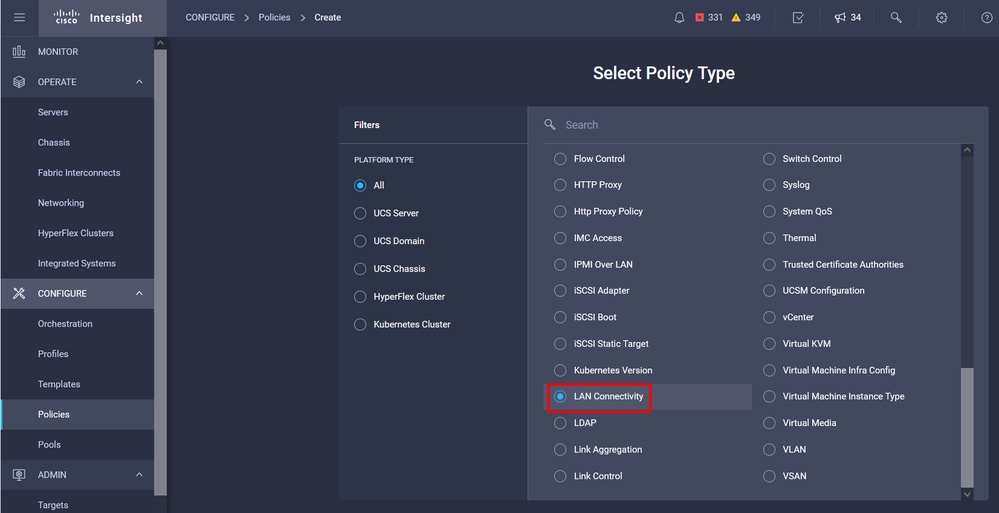

Vaya a la pestaña Políticas > Crear Política > Conectividad LAN

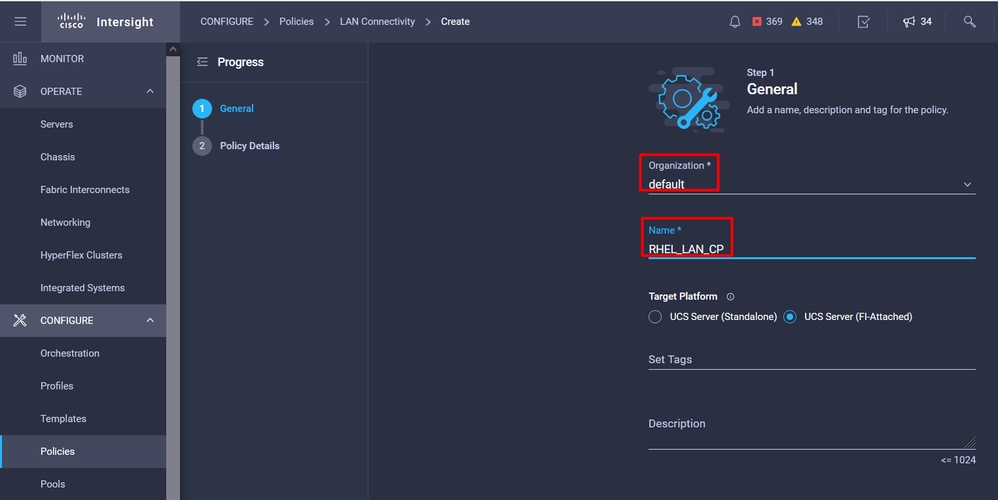

Seleccione la organización y proporcione el nombre de política.

En destino, la plataforma selecciona Servidor UCS (FI conectado).

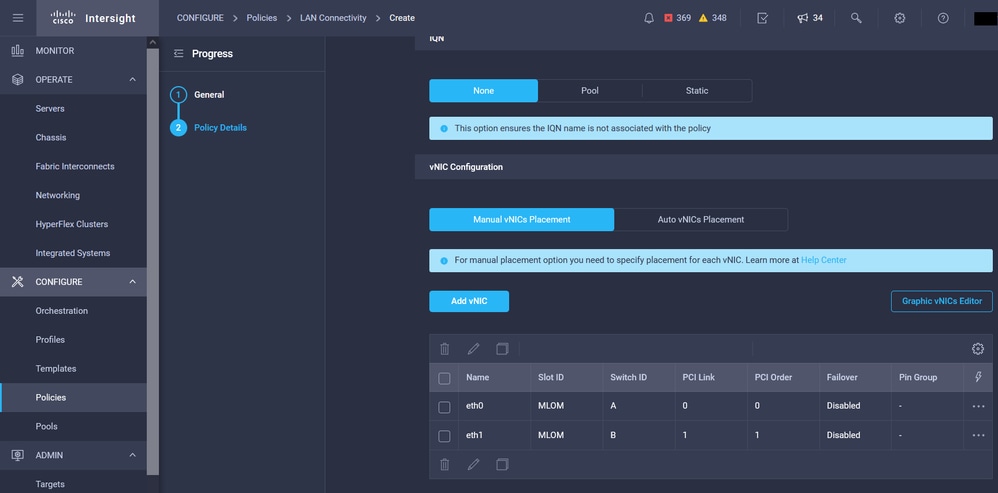

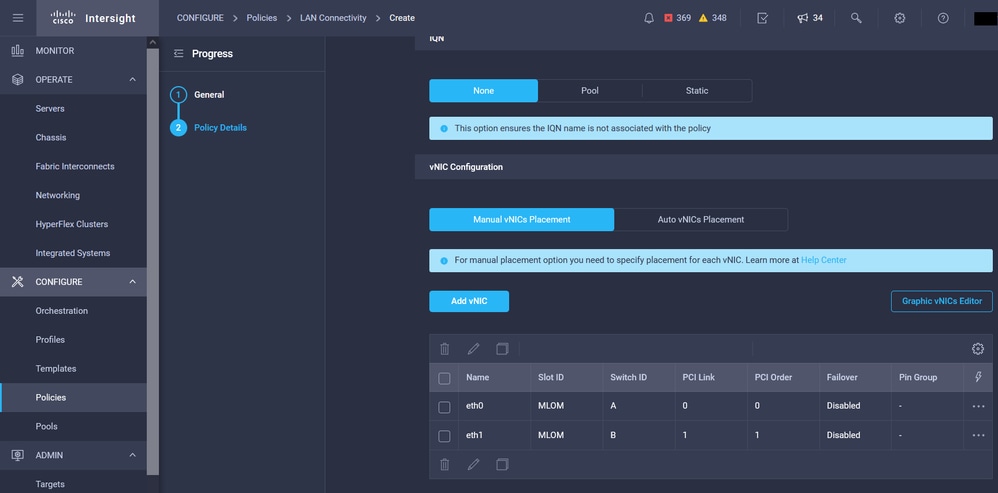

Dentro de la política de conectividad LAN, navegue hasta la sección Configuración de vNIC y configure al menos dos interfaces de red. En este ejemplo, se crean las interfaces eth0 y eth1.

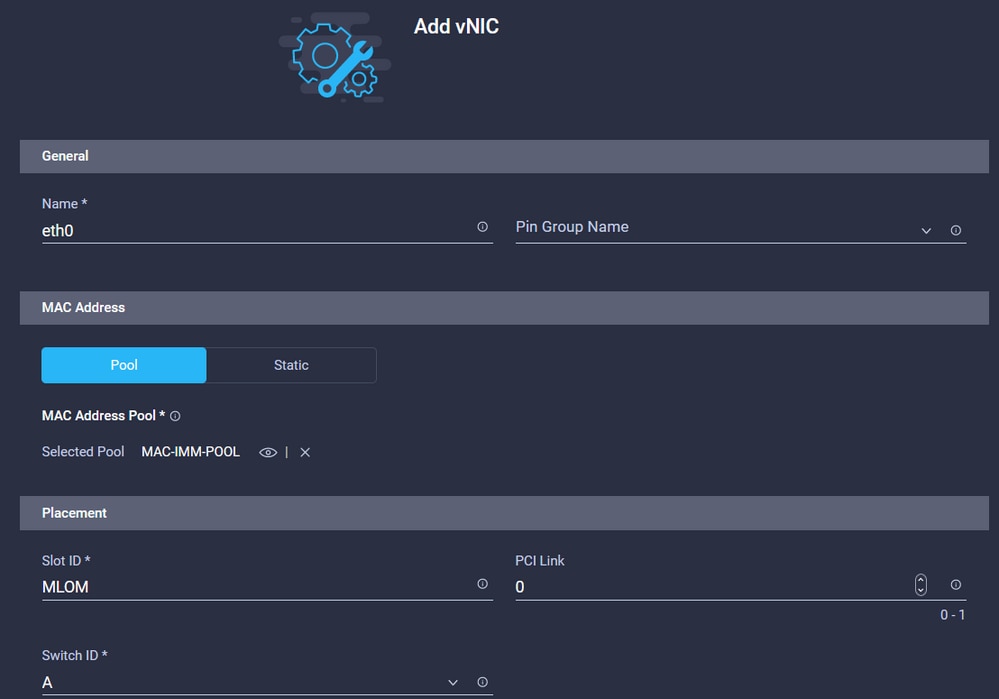

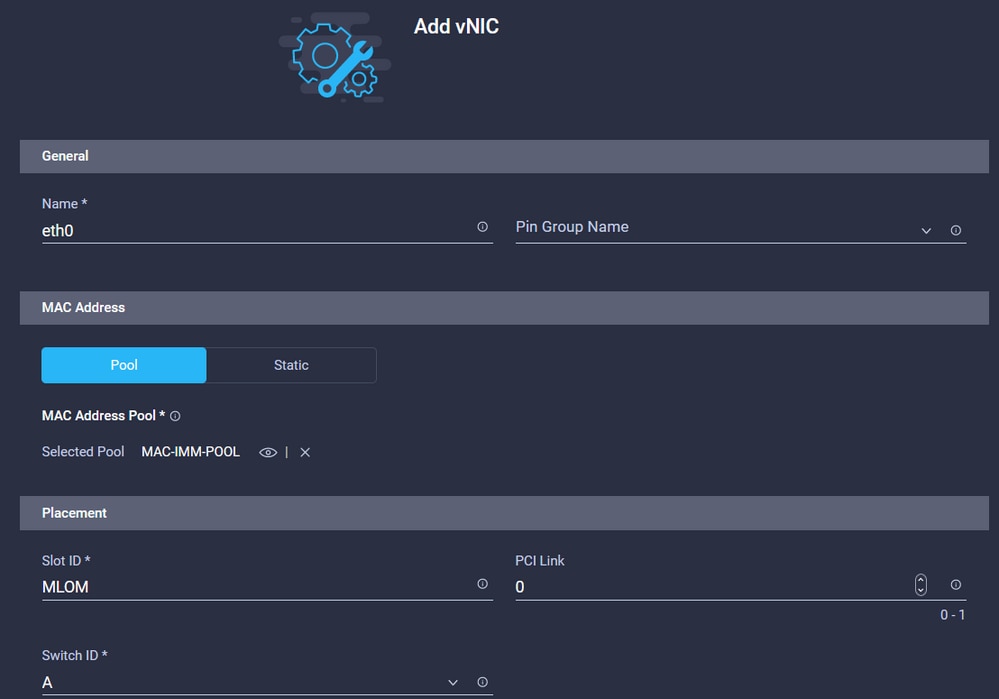

En la ficha Add vNIC configuration, en General, proporcione el nombre eth0.

En la sección MAC Address , seleccione el Pool de Direcciones MAC adecuado.

En la sección Ubicación, configure el ID de ranura como MLOM.

Deje las opciones PCI Link y PCI Order con valor 0 y Switch ID con opción A.

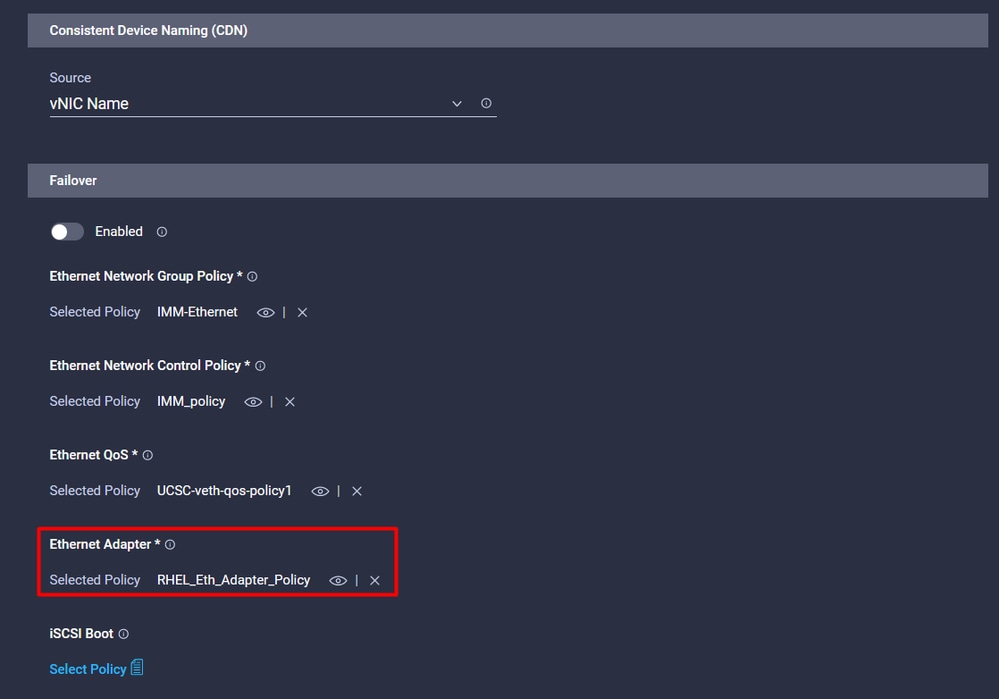

Vaya al menú Nomenclatura uniforme de dispositivos (CDN) y seleccione Nombre de VNIC.

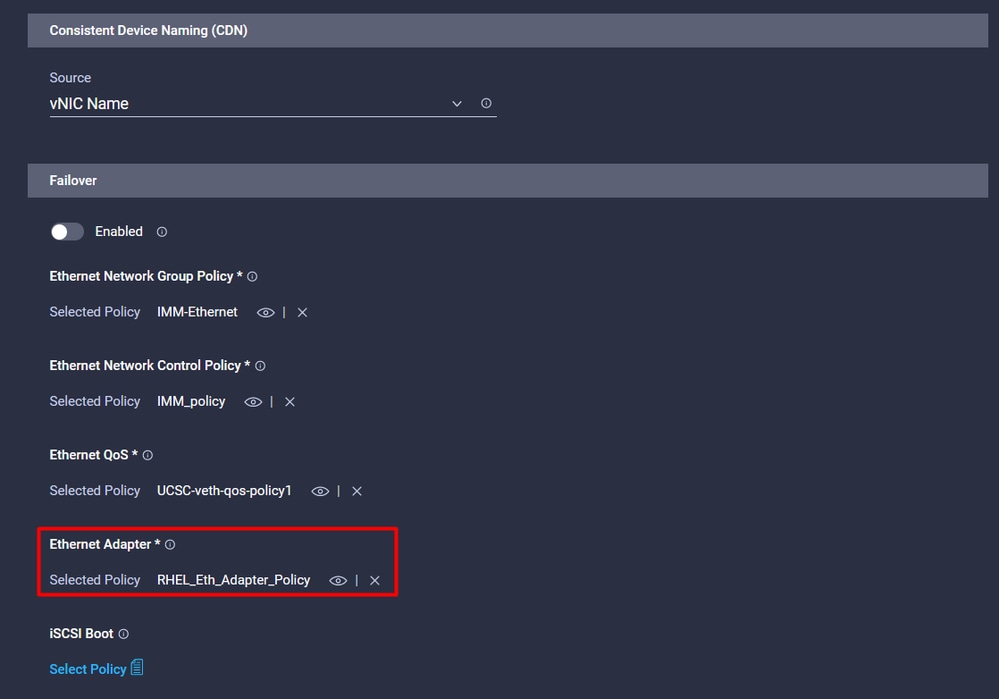

Agregue las políticas Ethernet Network Group Policy, Ethernet Network Control Policy, Ethernet QoS y Ethernet Adapter policies.

Repita los mismos pasos para crear la interfaz eth1, configure los valores PCI Link, PCI Order y Switch ID según corresponda.

Por último, cree la política de conectividad LAN. Una vez creado, asígnelo a un perfil de servidor UCS.

Paso 5. Crear un perfil de servidor.

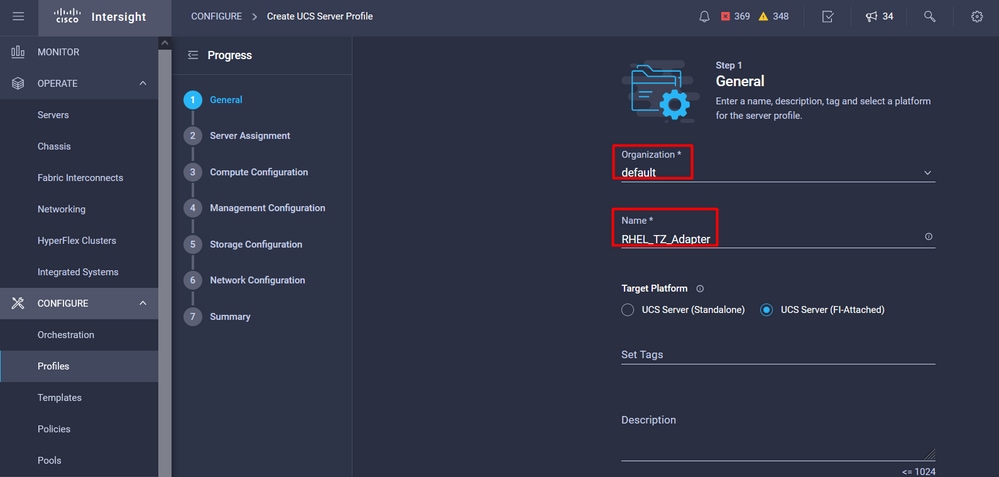

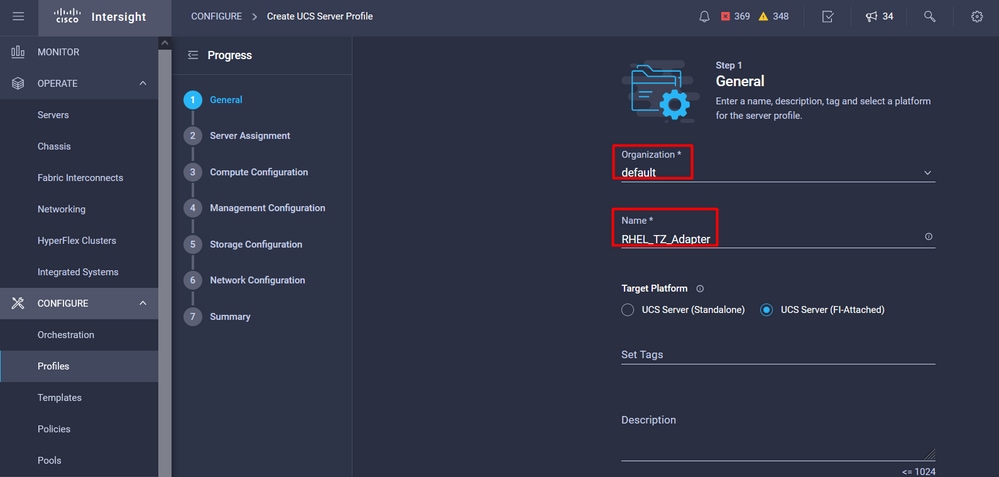

Vaya a la pestaña Profiles y seleccione Create UCS Server Profile.

Proporcione los detalles de Organización y Nombre.

Seleccione todas las configuraciones relacionadas como, por ejemplo, los parámetros de informática, gestión y almacenamiento.

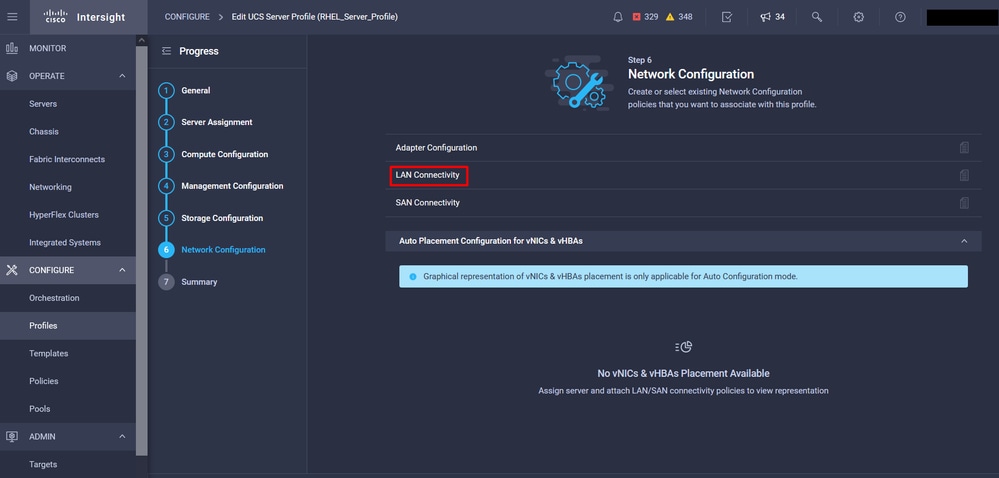

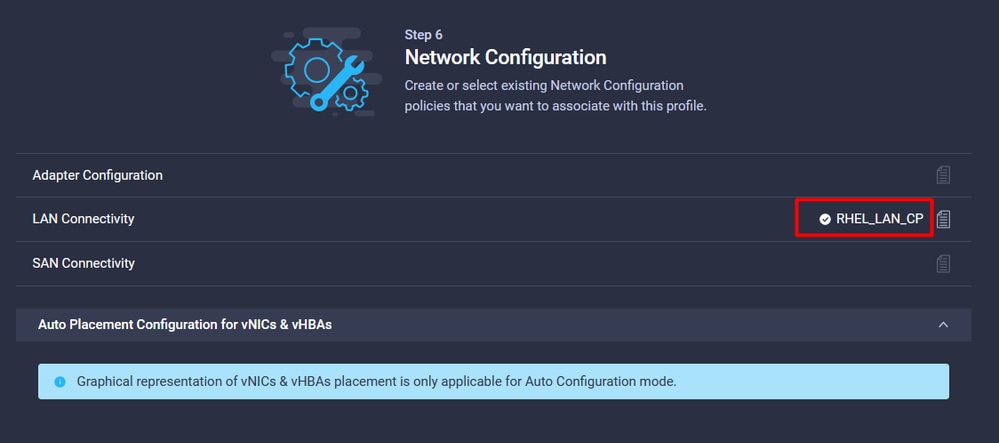

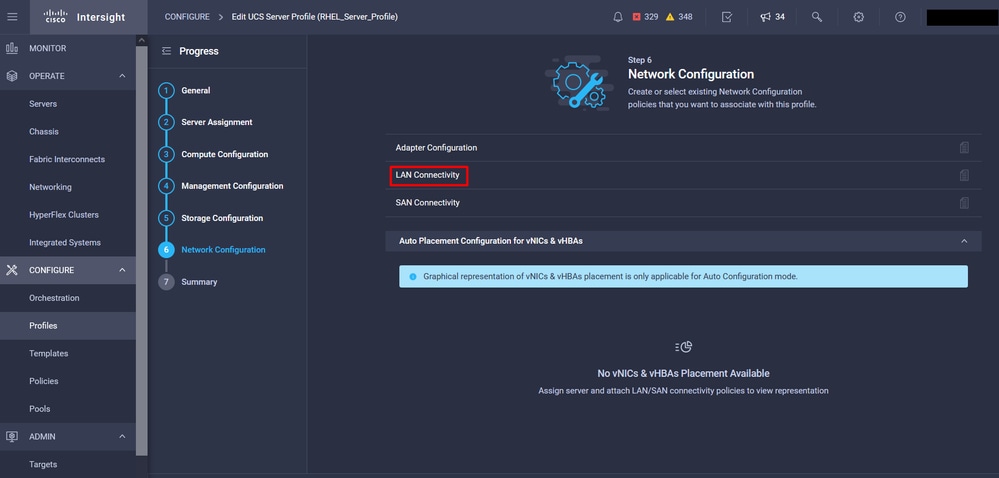

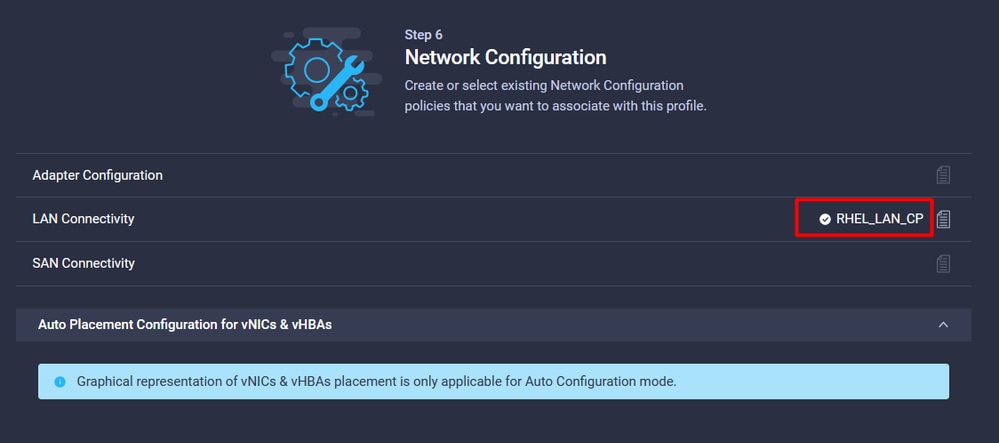

En Configuración de red, seleccione la política de conectividad LAN adecuada.

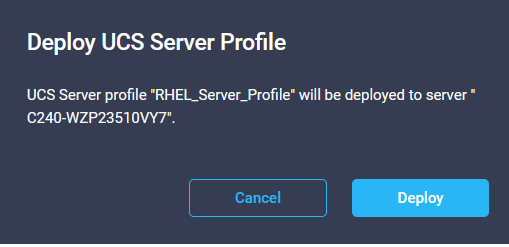

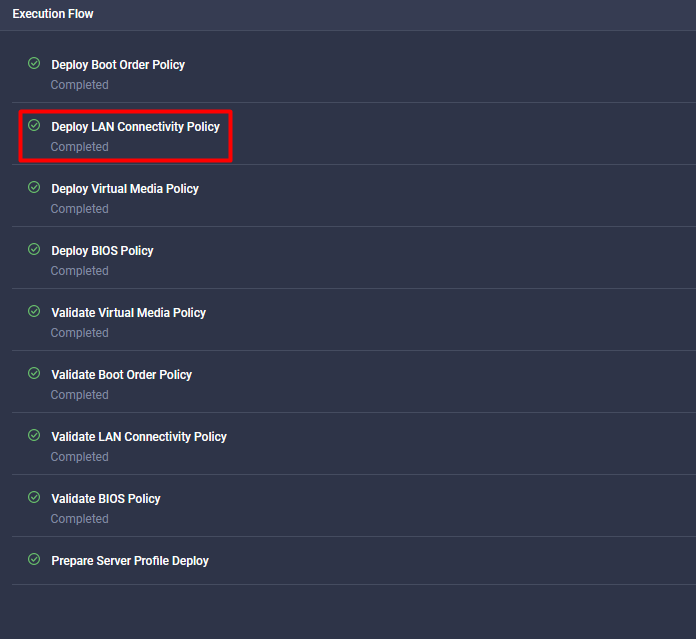

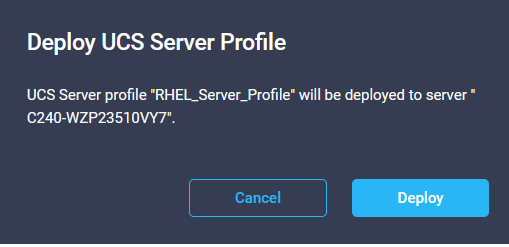

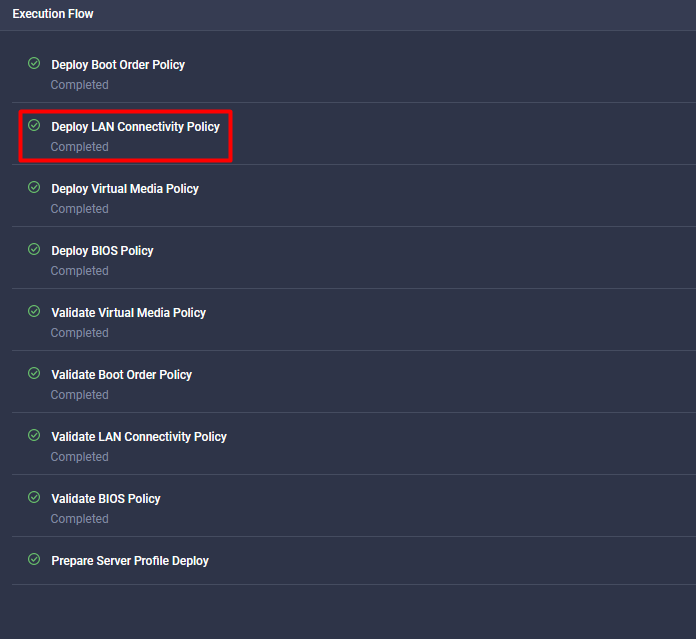

Seleccione Deploy para configurar el perfil de servidor y validar si todos los pasos se han completado correctamente.

Verificación

Use esta sección para confirmar que su configuración funciona correctamente.

Valide la configuración del adaptador en RHEL.

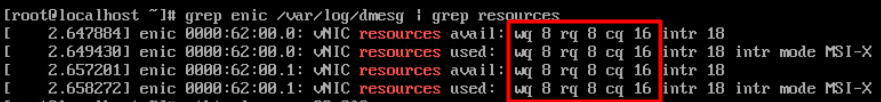

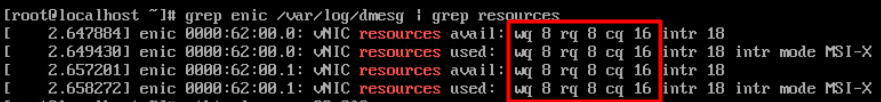

Para verificar los recursos actualmente disponibles proporcionados por el adaptador VIC, valide las colas de transmisión y recepción en el archivo dmesg:

$ grep enic /var/log/dmesg | grep resources

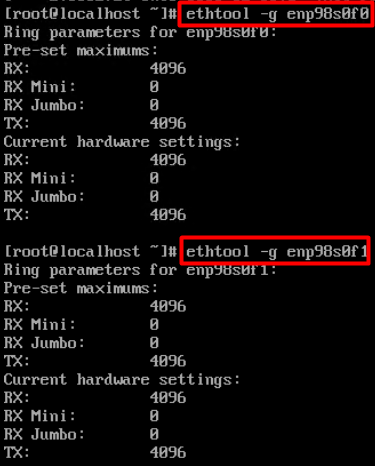

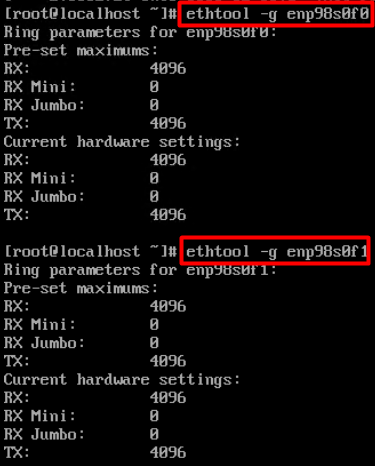

Valide el tamaño de timbre configurado.

ethtool -g interface_name

Valide la configuración del adaptador en VMware ESXi.

Para verificar los recursos disponibles actuales provistos por el adaptador VIC, valide las colas de transmisión y recepción con el siguiente comando, donde X es el número vmnic.

vsish -e get /net/pNics/vmnicX/txqueues/info

vsish -e get /net/pNics/vmnicX/rxqueues/info

Ejecute este comando para validar el tamaño del anillo:

esxcli network nic ring current get -n vmnicX

Valide la configuración del adaptador directamente en UCS.

Para validar los ajustes, conéctese a cualquiera de las Fabric Interconnects vía SSH.

Conecte al adaptador del servidor con el comando connect adapter x/y/z donde x es el número de chasis, y es el número de ranura y z es el número de adaptador.

Cuando esté conectado al adaptador, en el inicio de sesión adicional, introduzca dbgsh.

Ejecute el comando attach-mcp.

A continuación, ejecute el comando vnicl para enumerar los vnic disponibles.

Busque el nombre de vnic correspondiente eth0 y eth1 y valide la configuración.

UCS-IMM-A# connect adapter 1/1/1

Entering character mode

Escape character is '^]'.

(none) login: dbgsh

adapter (top):1#

adapter (top):4# attach-mcp

adapter (mcp):1# vnicl

adapter (mcp):19# vnicl

================================

vnicid : 18

name : eth0

type : enet

state : UP

adminst : UP

flags : OPEN, INIT, LINKUP, NOTIFY_INIT, ENABLE, USING_DEVCMD2

ucsm name : eth0

spec_flags : MULTIFUNC, TRUNK

mq_spec_flags :

slot : 0

h:bdf : 0:03:00.0

vs.mac : 00:25:b5:01:00:46

mac : 00:25:b5:01:00:46

vifid : 801

vifcookie : 801

uif : 0

portchannel_bypass : 0x0

cos : 0

vlan : 0

rate_limit : unlimited

cur_rate : unlimited

stby_vifid : 0

stby_vifcookie : 0

stby_recovery_delay : 0

channel : 0

stdby_channel : 0

profile :

stdby_profile :

init_errno : 0

cdn : eth0

devspec_flags : TSO, LRO, RXCSUM, TXCSUM, RSS, RSSHASH_IPV4, RSSHASH_TCPIPV4, RSSHASH_IPV6, RSSHASH_TCPIPV6

lif : 18

vmode : STATIC

encap mode : NONE

host wq : [11-18] (n=8)

host rq : [2010-2017] (n=8) (h=0x080107da)

host cq : [2002-2017] (n=16)

host intr : [3008-3025] (n=18)

notify : pa=0x10384de000/40 intr=17

devcmd2 wq : [19] (n=1)

================================

vnicid : 19

name : eth1

type : enet

state : UP

adminst : UP

flags : OPEN, INIT, LINKUP, NOTIFY_INIT, ENABLE, USING_DEVCMD2

ucsm name : eth1

spec_flags : MULTIFUNC, TRUNK

mq_spec_flags :

slot : 0

h:bdf : 0:03:00.1

vs.mac : 00:25:b5:01:00:45

mac : 00:25:b5:01:00:45

vifid : 800

vifcookie : 800

uif : 1

portchannel_bypass : 0x0

cos : 0

vlan : 0

rate_limit : unlimited

cur_rate : unlimited

stby_vifid : 0

stby_vifcookie : 0

stby_recovery_delay : 0

channel : 0

stdby_channel : 0

profile :

stdby_profile :

init_errno : 0

cdn : eth1

devspec_flags : TSO, LRO, RXCSUM, TXCSUM, RSS, RSSHASH_IPV4, RSSHASH_TCPIPV4, RSSHASH_IPV6, RSSHASH_TCPIPV6

lif : 19

vmode : STATIC

encap mode : NONE

host wq : [20-27] (n=8)

host rq : [2002-2009] (n=8) (h=0x080107d2)

host cq : [1986-2001] (n=16)

host intr : [2976-2993] (n=18)

notify : pa=0x1038e27000/40 intr=17

devcmd2 wq : [28] (n=1)

================================

Información Relacionada

Soporte Técnico y Documentación - Cisco Systems

Perfiles de servidor en Intersight

Pautas de ajuste de las tarjetas de interfaz virtual de Cisco UCS (informe técnico)

Guía de ajuste del rendimiento de red de Red Hat Enterprise Linux

Comentarios

Comentarios