Configuración de la Capa 2 Inconexa en Clusters Hyperflex

Opciones de descarga

-

ePub (1.3 MB)

Visualice en diferentes aplicaciones en iPhone, iPad, Android, Sony Reader o Windows Phone -

Mobi (Kindle) (1.0 MB)

Visualice en dispositivo Kindle o aplicación Kindle en múltiples dispositivos

Lenguaje no discriminatorio

El conjunto de documentos para este producto aspira al uso de un lenguaje no discriminatorio. A los fines de esta documentación, "no discriminatorio" se refiere al lenguaje que no implica discriminación por motivos de edad, discapacidad, género, identidad de raza, identidad étnica, orientación sexual, nivel socioeconómico e interseccionalidad. Puede haber excepciones en la documentación debido al lenguaje que se encuentra ya en las interfaces de usuario del software del producto, el lenguaje utilizado en función de la documentación de la RFP o el lenguaje utilizado por un producto de terceros al que se hace referencia. Obtenga más información sobre cómo Cisco utiliza el lenguaje inclusivo.

Acerca de esta traducción

Cisco ha traducido este documento combinando la traducción automática y los recursos humanos a fin de ofrecer a nuestros usuarios en todo el mundo contenido en su propio idioma. Tenga en cuenta que incluso la mejor traducción automática podría no ser tan precisa como la proporcionada por un traductor profesional. Cisco Systems, Inc. no asume ninguna responsabilidad por la precisión de estas traducciones y recomienda remitirse siempre al documento original escrito en inglés (insertar vínculo URL).

Contenido

Introducción

Este documento describe cómo implementar una configuración de capa 2 desconectada (DL2) en un clúster HX desde las perspectivas de UCS Manager (UCSM) y ESXi.

Prerequisites

Requirements

Cisco recomienda que tenga conocimiento sobre estos temas:

- Comprensión básica de la configuración DL2

- Conocimientos básicos sobre el clúster Hyperflex

- Conocimientos recomendados de UCSM sobre vNIC, perfiles de servicio y plantillas

Otros requisitos son:

- Al menos un enlace disponible en cada Fabric Interconnect y dos enlaces disponibles en el switch ascendente.

- Los links entre las Fabric Interconnects y el switch ascendente deben estar activos, deben configurarse como links ascendentes. Si no lo están, verifique esta Configuración del sistema - Configuración de puertos para configurarlos en UCSM.

- Las VLAN que se van a utilizar ya deben crearse en UCSM. Si no lo están, siga estos pasos: Network Configuration - Configuring Named VLAN.

- Las VLAN que se utilizarán deben crearse ya en el switch ascendente.

- Las VLAN que se van a utilizar no pueden existir en ninguna otra NIC virtual (vNIC) de los perfiles de servicio.

Componentes Utilizados

Este documento no tiene restricciones específicas en cuanto a versiones de software y de hardware.

- 2 UCS-FI-6248UP

- 2 N5K-C5548UP

- UCSM versión 4.2(1f)

La información que contiene este documento se creó a partir de los dispositivos en un ambiente de laboratorio específico. Todos los dispositivos que se utilizan en este documento se pusieron en funcionamiento con una configuración verificada (predeterminada). Si tiene una red en vivo, asegúrese de entender el posible impacto de cualquier comando.

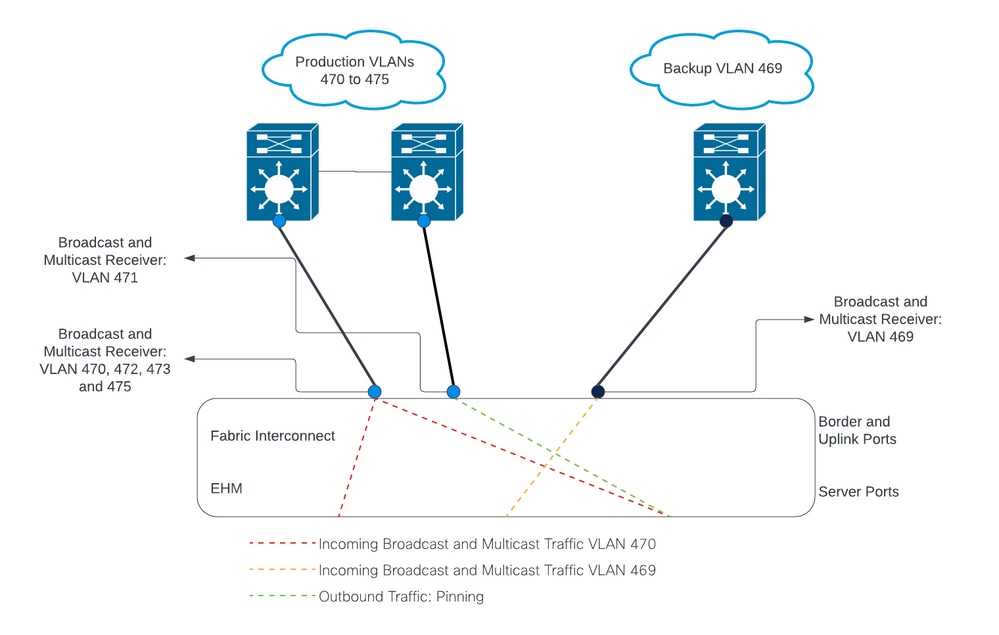

Diagrama de la red

Configuraciones

Las configuraciones DL2 se utilizan para segregar el tráfico en enlaces ascendentes específicos a los dispositivos ascendentes, de modo que el tráfico VLAN no se mezcla.

Configuración de las nuevas vNIC

Paso 1. Inicie sesión en UCSM y haga clic en la pestaña LAN en el panel izquierdo.

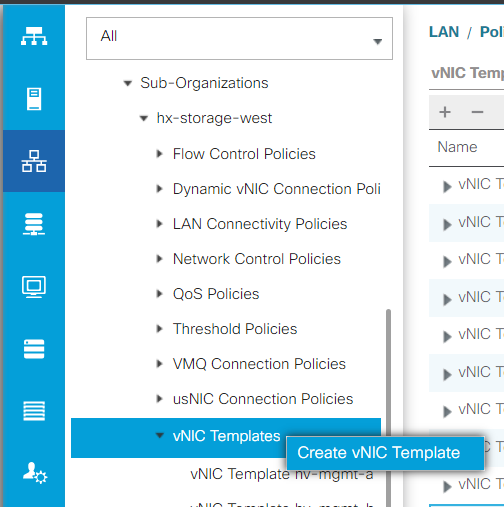

Vaya a Políticas > raíz > Suborganizaciones > Nombre de la suborganización > Plantillas vNIC. Haga clic con el botón secundario en él y haga clic en Crear plantilla de vNIC.

Paso 2. Asigne un nombre a la plantilla, deje seleccionado Fabric A, desplácese hacia abajo y seleccione las VLAN adecuadas para el nuevo enlace. El resto de los parámetros se pueden configurar como se desee.

A continuación, repita el mismo proceso, pero seleccione Fabric B esta vez.

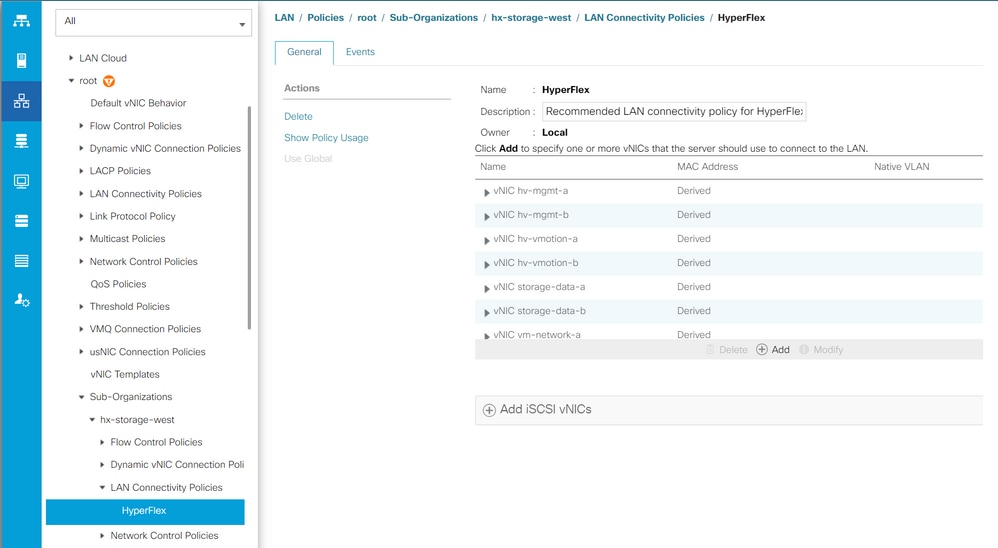

Paso 3. En la ficha LAN, vaya a Políticas > raíz > Suborganizaciones > Nombre de la suborganización > Políticas de conectividad LAN > Hiperflex.

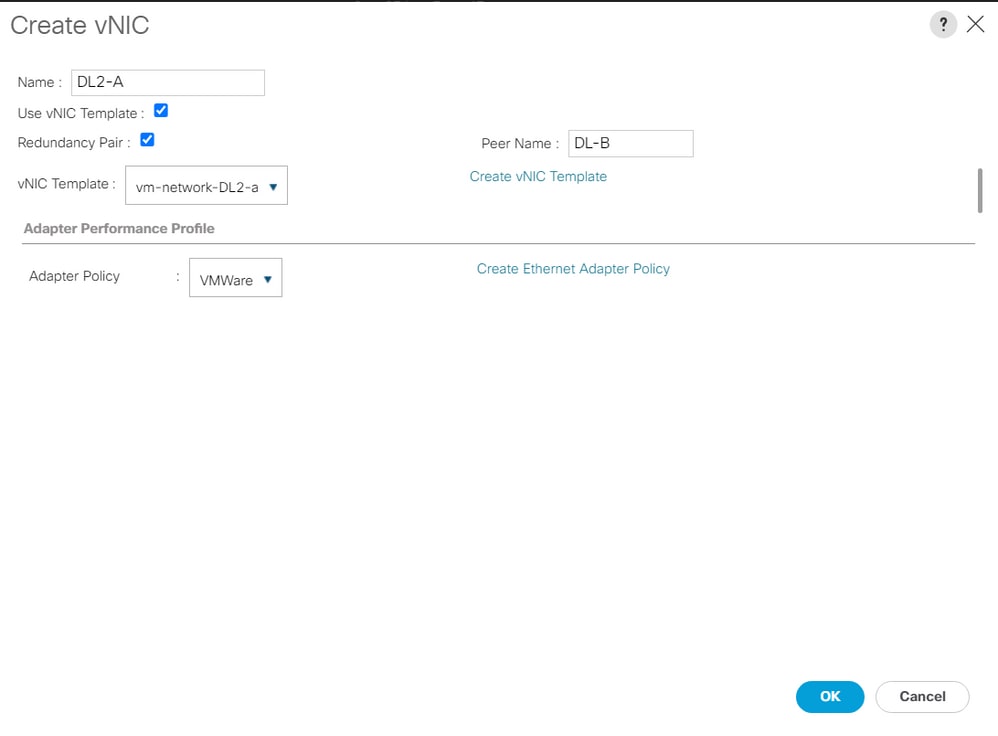

Paso 4. Haga clic en Add, asigne un nombre a la vNIC y seleccione un grupo de MAC en el menú desplegable.

Marque las casillas Use vNIC Template y Redundancy Pair. En el menú desplegable Plantilla de vNIC, seleccione la nueva plantilla y, junto a ella, introduzca el Nombre del mismo nivel.

Seleccione la política de adaptador que desee y haga clic en Aceptar.

Paso 5. En la lista vNIC, busque el par del que acaba de crear, selecciónelo y haga clic en Modificar.

Haga clic en el cuadro Use vNIC Template y seleccione la otra plantilla que se creó en el menú desplegable.

Haga clic en Save Changes en la parte inferior, esto activará Pending Activities para los servidores relacionados.

Confirmar actividades pendientes

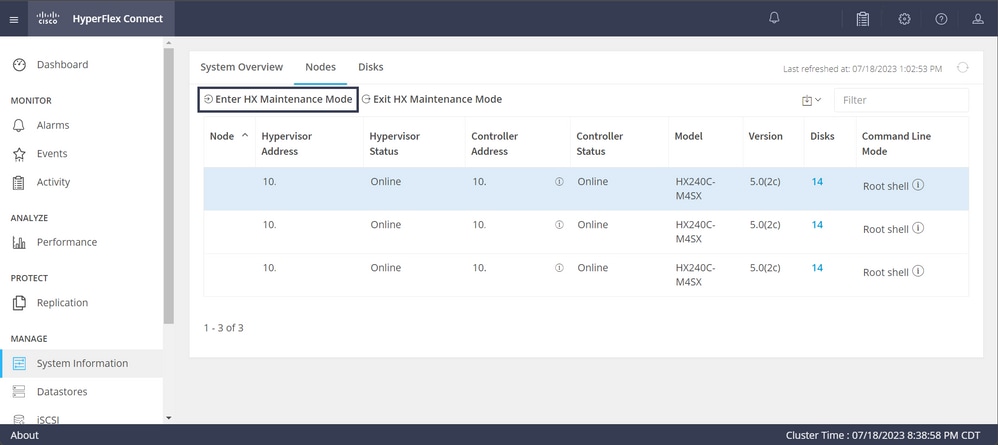

Paso 1. Inicie sesión en HX Connect, navegue hasta System Information > Nodes, haga clic en uno de los nodos y, a continuación, haga clic en Enter HX Maintenance Mode y espere a que finalice la tarea.

Paso 2. En vCenter, asegúrese de que el nodo está en mantenimiento.

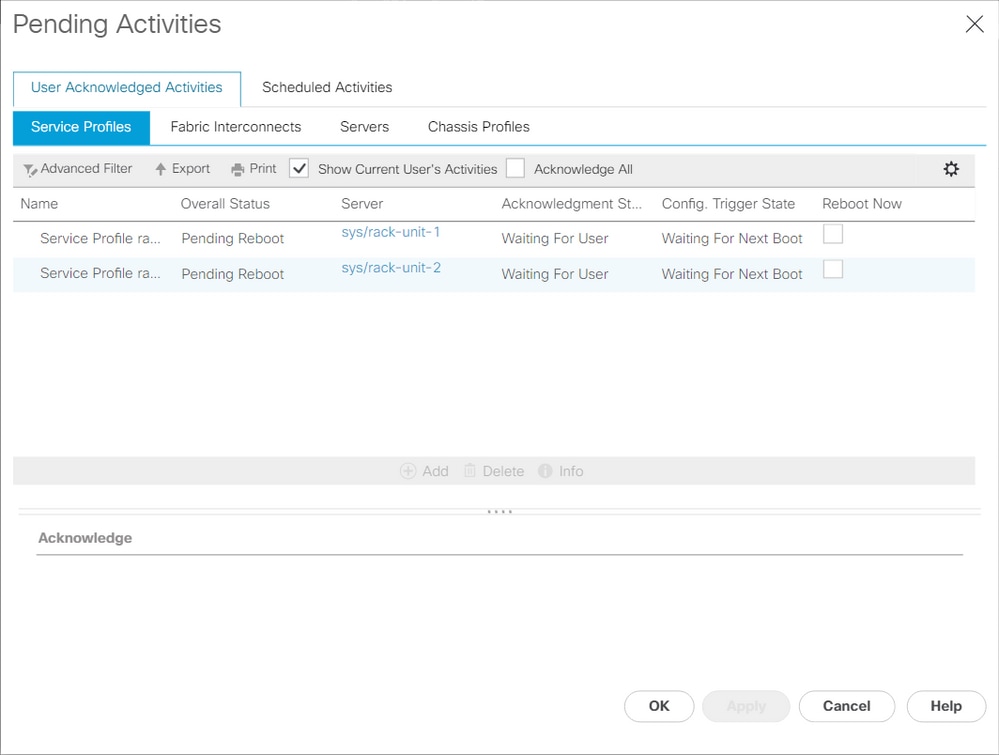

Paso 3. Una vez que el nodo esté en mantenimiento, vuelva a UCSM, haga clic en el icono de campana en la esquina superior derecha y en Reiniciar ahora.

Marque la casilla que coincida con el servidor que se encuentra actualmente en mantenimiento y, a continuación, haga clic en Aceptar.

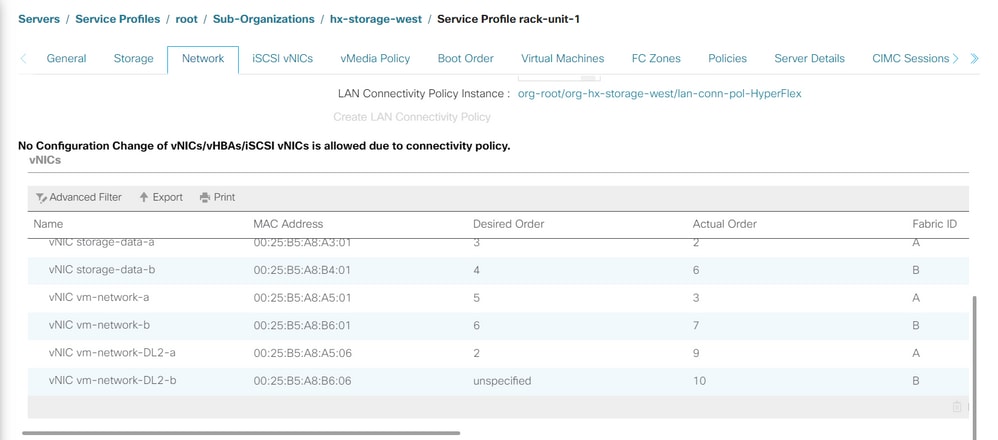

Paso 4. Una vez que se inicie el servidor, asegúrese de que las nuevas vNIC estén presentes. Para ello, vaya a Servidores > Perfiles de servicio > raíz > Suborganizaciones > Nombre de la suborganización > Nombre del perfil de servicio.

Haga clic en Network, desplácese hacia abajo y las nuevas vNIC deben estar allí.

Paso 5. Retire el servidor del modo de mantenimiento de la interfaz de usuario de HX Connect.

Haga clic en Salir del modo de mantenimiento HX.

Cuando el servidor deja de estar en mantenimiento, la máquina virtual del controlador de almacenamiento (SCVM) arranca y el clúster inicia el proceso de recuperación.

Para monitorear el proceso de curación, SSH ingresa a la IP del Administrador de Clústeres de Hyperflex (HX) y ejecuta el comando:

sysmtool --ns cluster --cmd healthdetailCluster Health Detail:

---------------------:

State: ONLINE

HealthState: HEALTHY

Policy Compliance: COMPLIANT

Creation Time: Tue May 30 04:48:45 2023

Uptime: 7 weeks, 1 days, 15 hours, 50 mins, 17 secs

Cluster Resiliency Detail:

-------------------------:

Health State Reason: Storage cluster is healthy.

# of nodes failure tolerable for cluster to be fully available: 1

# of node failures before cluster goes into readonly: NA

# of node failures before cluster goes to be crticial and partially available: 3

# of node failures before cluster goes to enospace warn trying to move the existing data: NA

# of persistent devices failures tolerable for cluster to be fully available: 2

# of persistent devices failures before cluster goes into readonly: NA

# of persistent devices failures before cluster goes to be critical and partially available: 3

# of caching devices failures tolerable for cluster to be fully available: 2

# of caching failures before cluster goes into readonly: NA

# of caching failures before cluster goes to be critical and partially available: 3

Current ensemble size: 3

Minimum data copies available for some user data: 3

Minimum cache copies remaining: 3

Minimum metadata copies available for cluster metadata: 3

Current healing status:

Time remaining before current healing operation finishes:

# of unavailable nodes: 0Paso 6. Una vez que el clúster esté en buen estado, repita los pasos 1-6. NO continúe con el siguiente paso hasta que todos los servidores tengan las nuevas vNIC presentes.

Configuración de las VLAN

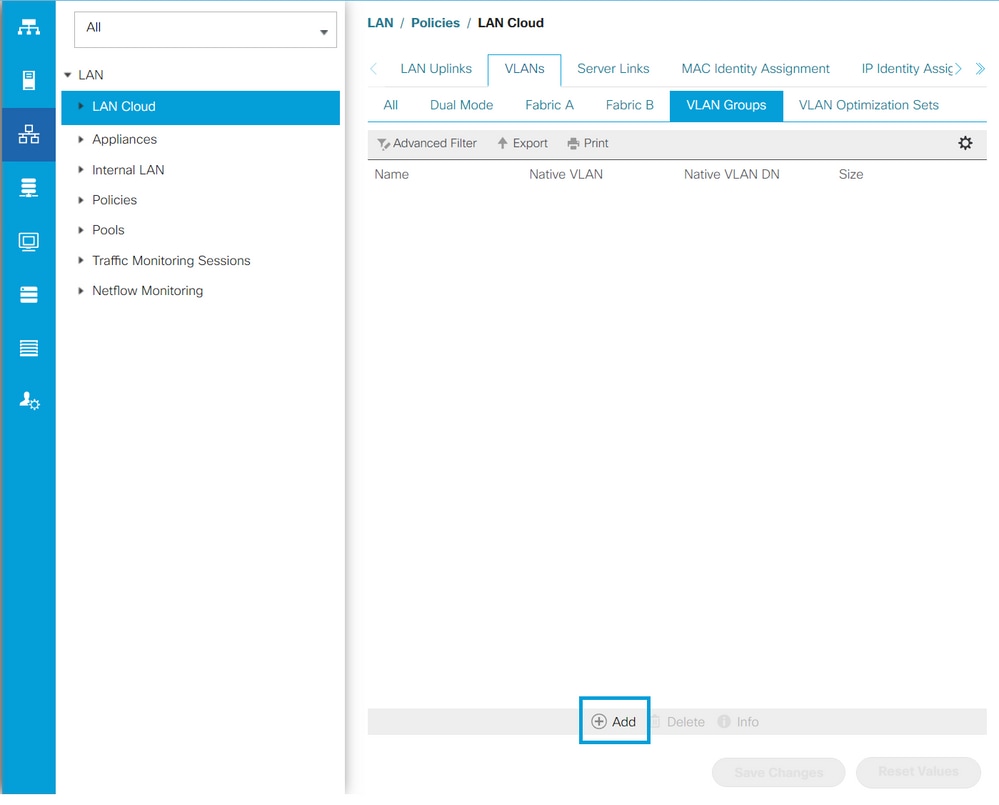

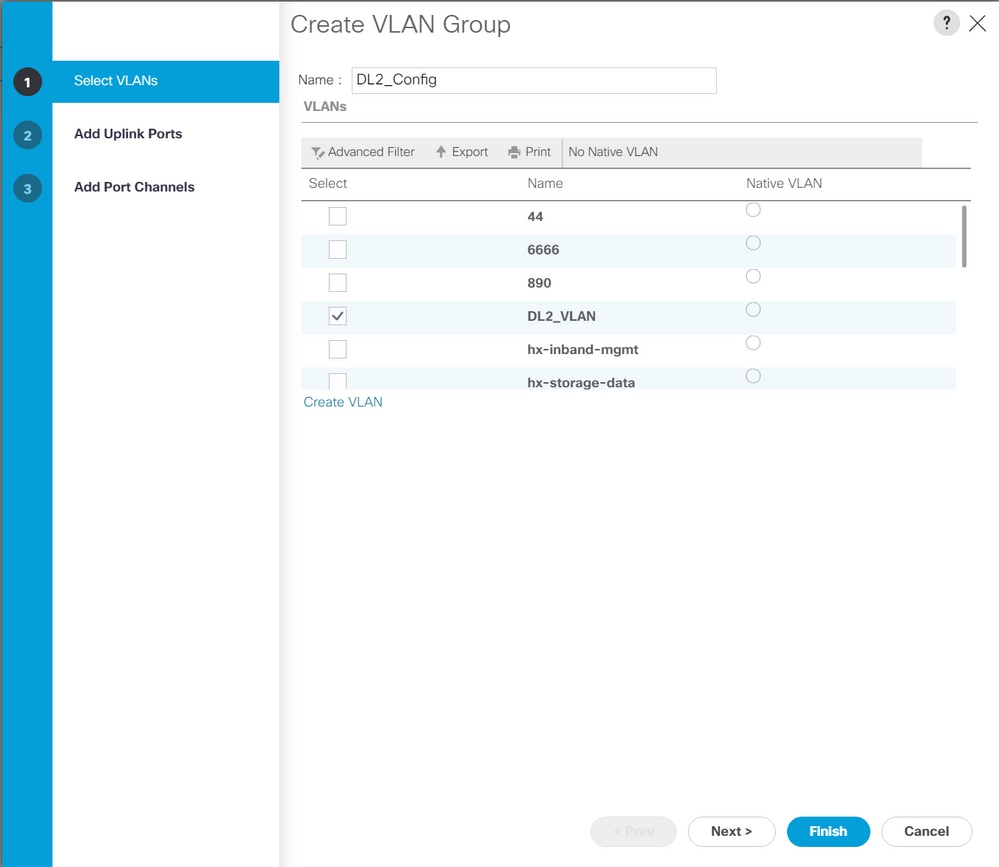

Paso 1. Desde UCSM, navegue hasta LAN > VLAN > Grupos de VLAN y haga clic en Agregar.

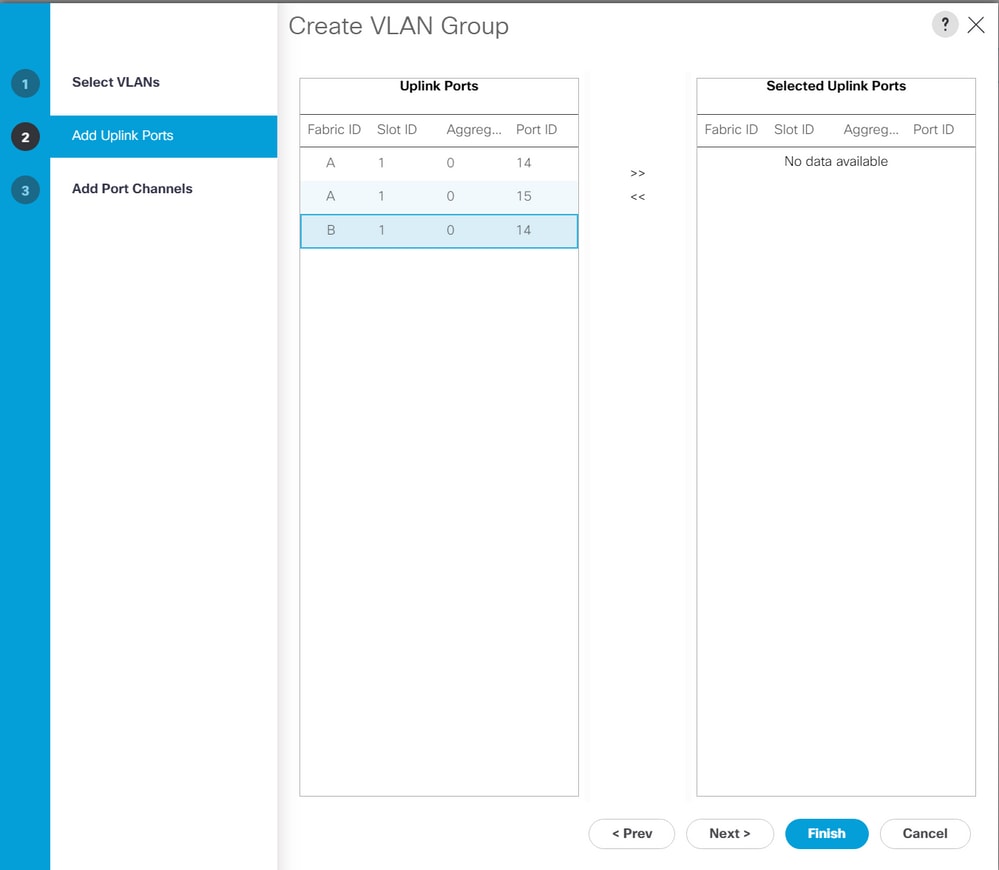

Paso 2. Asigne un nombre al grupo de VLAN y seleccione las VLAN adecuadas a continuación, haga clic en Next y vaya al paso 2 del asistente para agregar puertos de enlace ascendente individuales o al paso 3 para agregar canales de puerto.

Paso 3. Agregue el puerto de enlace ascendente o el canal de puerto haciendo clic en ellos y en el icono >>. Haga clic en Finish en la parte inferior.

configuración de ESXi

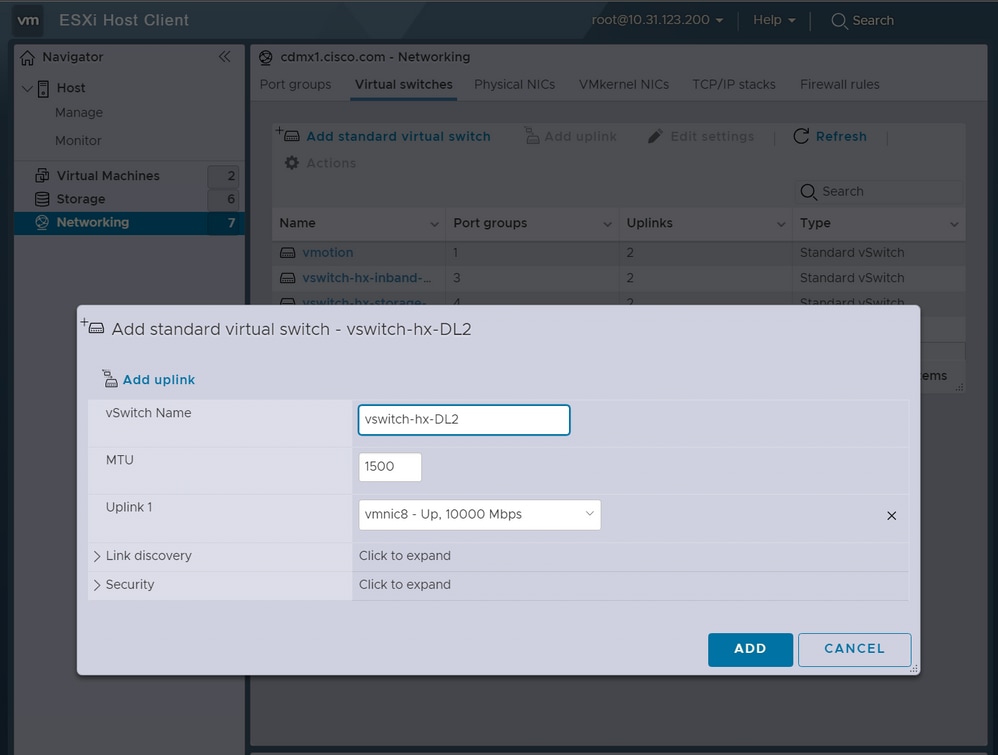

Paso 1. Inicie sesión en la vSphere del host de ESXi, vaya a Networking > Virtual Switches y haga clic en Agregue un switch virtual estándar.

Paso 2. Dé un nombre al vSwitch y una de las nuevas vmnics ya está allí. Haga clic en Agregar enlace ascendente para agregar la 2ª. Haga clic en Add (Agregar).

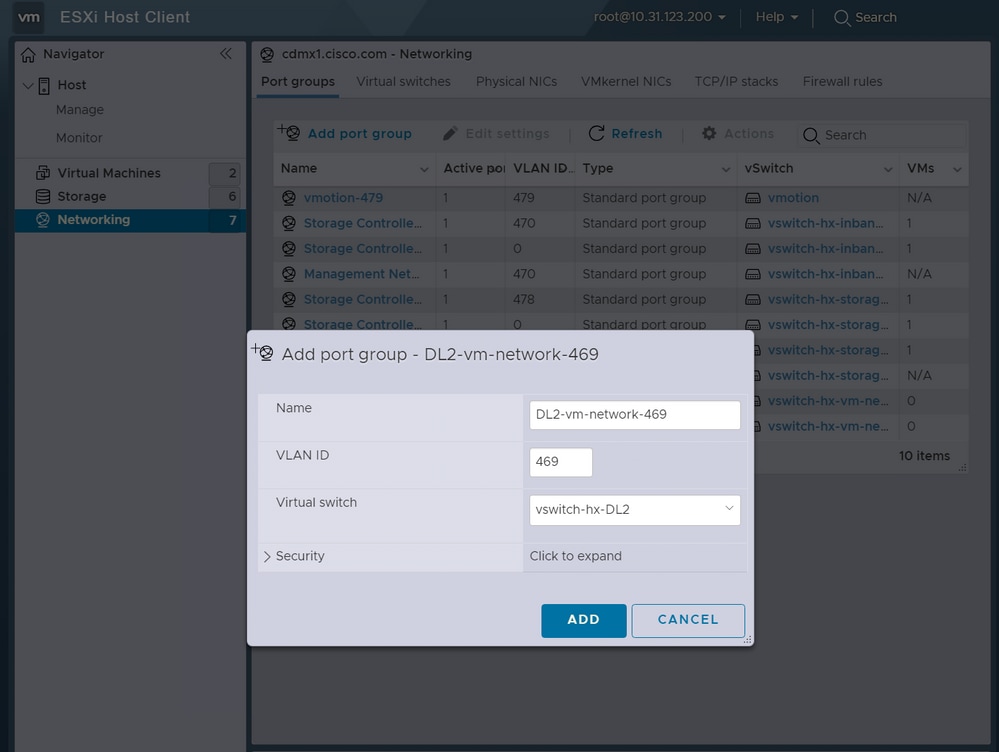

Paso 3. Navegue hasta Networking > Port groups y haga clic en Add port group

Paso 4. Asigne un nombre al grupo de puertos, introduzca la VLAN que desee y seleccione el nuevo switch virtual en el menú desplegable.

Paso 5. Repita el paso 4 para cada VLAN que fluya a través de los nuevos links.

Paso 6. Repita los pasos del 1 al 5 para cada servidor que forme parte del clúster.

Verificación

Verificación de UCSM

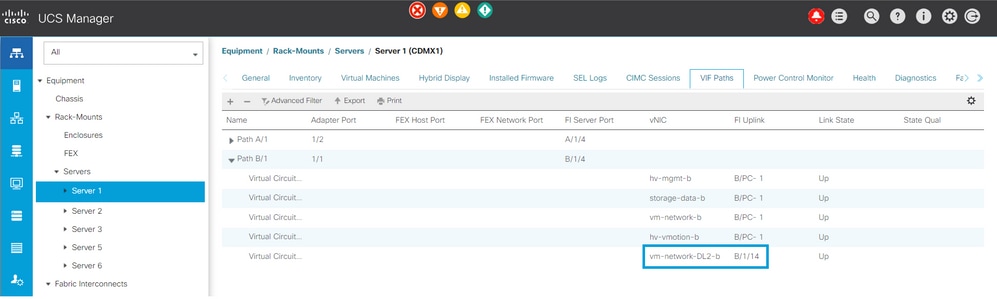

Navegue hasta Equipment > Rack-Mounts > Servers > Server # > VIF Paths y expanda Path A o B, bajo la columna vNIC, busque el que coincida con el vNIC DL2 y ese circuito virtual debe anclarse al enlace ascendente Fabric Interconnect (FI) o al canal de puerto configurado recientemente.

Verificación de CLI

Ruta de la interfaz virtual (VIF)

En una sesión SSH a las Fabric Interconnects, ejecute el comando:

show service-profile circuit server <server-number>

Este comando muestra las rutas VIF, sus vNIC correspondientes y la interfaz a la que están ancladas.

Fabric ID: A

Path ID: 1

VIF vNIC Link State Oper State Prot State Prot Role Admin Pin Oper Pin Transport

---------- --------------- ----------- ---------- ------------- ----------- ---------- ---------- ---------

966 hv-mgmt-a Up Active No Protection Unprotected 0/0/0 0/0/1 Ether

967 storage-data-a Up Active No Protection Unprotected 0/0/0 0/0/1 Ether

968 vm-network-a Up Active No Protection Unprotected 0/0/0 0/0/1 Ether

969 hv-vmotion-a Up Active No Protection Unprotected 0/0/0 0/0/1 Ether

990 network-DL2-a Up Active No Protection Unprotected 0/0/0 1/0/14 Ether

La columna Oper Pin debe mostrar el enlace ascendente FI o el canal de puerto recientemente configurados en la misma línea que la vNIC DL2.

En esta salida, el VIF 990, que corresponde a la vm-network-DL2-b vNIC, se fija a la interfaz 1/0/14.

Fijación de los enlaces ascendentes

Fabric-Interconnect-A# connect nx-os a

Fabric-Interconnect-A(nxos)# show pinning border-interfaces

--------------------+---------+----------------------------------------

Border Interface Status SIFs

--------------------+---------+----------------------------------------

Eth1/14 Active sup-eth2 Veth990 Veth992 Veth994En esta salida, el número Veth debe coincidir con el número VIF visto en la salida anterior y estar en la misma línea que la interfaz de enlace ascendente correcta.

Destinatario designado:

Fabric-Interconnect-A# connect nx-os a

Fabric-Interconnect-A(nxos)# show platform software enm internal info vlandb id <VLAN-ID>

vlan_id 469

-------------

Designated receiver: Eth1/14

Membership:

Eth1/14

En esta salida, debe mostrarse el enlace ascendente correcto.

Switches ascendentes

En una sesión SSH a los switches ascendentes, se puede verificar la tabla de direcciones MAC y se debe mostrar la dirección MAC de cualquier máquina virtual (VM) en esta VLAN.

Nexus-5K# show mac address-table vlan 469

Legend:

* - primary entry, G - Gateway MAC, (R) - Routed MAC, O - Overlay MAC

age - seconds since last seen,+ - primary entry using vPC Peer-Link

VLAN MAC Address Type age Secure NTFY Ports/SWID.SSID.LID

---------+-----------------+--------+---------+------+----+------------------

* 469 0000.0c07.ac45 static 0 F F Router

* 469 002a.6a58.e3bc static 0 F F Po1

* 469 0050.569b.048c dynamic 50 F F Eth1/14

* 469 547f.ee6a.8041 static 0 F F Router

En este ejemplo de configuración, la VLAN 469 es la VLAN independiente, la dirección MAC 0050:569B:048C pertenece a una VM de Linux asignada al vSwitch vswitch-hx-DL2 y al grupo de puertos DL2-vm-network-469, se muestra correctamente en la interfaz Ethernet 1/14, que es la interfaz del switch ascendente conectado a la Fabric Interconnect.

Desde la misma sesión hasta el switch ascendente, se puede verificar la configuración de VLAN.

Nexus-5K# show vlan brief

VLAN Name Status Ports

---- -------------------------------- --------- -------------------------------

1 default active Eth1/5, Eth1/8, Eth1/9, Eth1/10

Eth1/11, Eth1/12, Eth1/13

Eth1/15, Eth1/16, Eth1/17

Eth1/19, Eth1/20, Eth1/21

Eth1/22, Eth1/23, Eth1/24

Eth1/25, Eth1/26

469 DMZ active Po1, Eth1/14, Eth1/31, Eth1/32

En esta salida, la interfaz Ethernet 1/14 se asigna correctamente a la VLAN 469.

Troubleshoot

Errores de configuración de UCSM

Error: "No se ha podido encontrar ningún puerto de enlace ascendente operativo que transporte todas las VLAN de las vNIC. Las vNIC se cerrarán, lo que provocará la interrupción del tráfico en todas las VLAN existentes de las vNIC".

El error significa que no hay nuevos links ascendentes para transportar el nuevo tráfico, descartar cualquier problema de capa 1 y capa 2 en las interfaces y volver a intentarlo.

Error: "Error al fijar el origen ENM"

El error está relacionado con las VLAN asociadas de una vNIC que no se encuentra en un enlace ascendente.

Comportamientos posiblemente incorrectos

Los enlaces ascendentes anteriores detienen el flujo de datos porque las nuevas VLAN ya existen en una vNIC y se anclan a los nuevos enlaces ascendentes.

Elimine cualquier VLAN duplicada en la plantilla vNIC anterior. Navegue hasta Políticas > raíz > Suborganizaciones > Nombre de la suborganización > Plantillas vNIC y quite la VLAN de la plantilla vm-network vNIC.

Información Relacionada

Historial de revisiones

| Revisión | Fecha de publicación | Comentarios |

|---|---|---|

1.0 |

25-Jul-2023 |

Versión inicial |

Con la colaboración de ingenieros de Cisco

- Ignacio JimenezCisco TAC Engineer

- Sergio MoraCisco TAC Engineer

Contacte a Cisco

- Abrir un caso de soporte

- (Requiere un Cisco Service Contract)

Comentarios

Comentarios