Solución de problemas del clúster de Firepower Threat Defence (FTD)

Opciones de descarga

Lenguaje no discriminatorio

El conjunto de documentos para este producto aspira al uso de un lenguaje no discriminatorio. A los fines de esta documentación, "no discriminatorio" se refiere al lenguaje que no implica discriminación por motivos de edad, discapacidad, género, identidad de raza, identidad étnica, orientación sexual, nivel socioeconómico e interseccionalidad. Puede haber excepciones en la documentación debido al lenguaje que se encuentra ya en las interfaces de usuario del software del producto, el lenguaje utilizado en función de la documentación de la RFP o el lenguaje utilizado por un producto de terceros al que se hace referencia. Obtenga más información sobre cómo Cisco utiliza el lenguaje inclusivo.

Acerca de esta traducción

Cisco ha traducido este documento combinando la traducción automática y los recursos humanos a fin de ofrecer a nuestros usuarios en todo el mundo contenido en su propio idioma. Tenga en cuenta que incluso la mejor traducción automática podría no ser tan precisa como la proporcionada por un traductor profesional. Cisco Systems, Inc. no asume ninguna responsabilidad por la precisión de estas traducciones y recomienda remitirse siempre al documento original escrito en inglés (insertar vínculo URL).

Contenido

Introducción

Este documento describe la solución de problemas de una configuración de clúster en el firewall de última generación (NGFW) Firepower.

Prerequisites

Requirements

Cisco recomienda que conozca estos temas (consulte la sección Información Relacionada para ver los enlaces):

- Arquitectura de la plataforma Firepower

- Configuración y funcionamiento del clúster de Firepower

- Familiaridad con FTD y la CLI del sistema operativo extensible (FXOS) de Firepower

- Registros del plano de datos/NGFW

- Rastreador de paquetes de plano de datos/NGFW

- Capturas del plano de datos/FXOS

Componentes Utilizados

- HW: Firepower 4125

- SW: 6.7.0 (Compilación 65): plano de datos 9.15(1)

La información que contiene este documento se creó a partir de los dispositivos en un ambiente de laboratorio específico. Todos los dispositivos que se utilizan en este documento se pusieron en funcionamiento con una configuración verificada (predeterminada). Si tiene una red en vivo, asegúrese de entender el posible impacto de cualquier comando.

Antecedentes

La mayoría de los elementos que se tratan en este documento también son totalmente aplicables a la resolución de problemas del clúster de Adaptive Security Appliance (ASA).

Configurar

La parte de configuración de una implementación de clúster se trata en las guías de configuración de FMC y FXOS:

- Agrupación en clústeres para Firepower Threat Defence

- Implementación de un clúster para Firepower Threat Defense para ofrecer escalabilidad y alta disponibilidad

Fundamentos del clúster

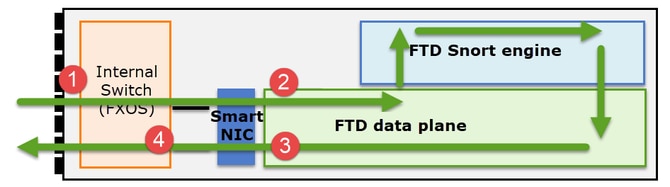

Arquitectura de NGFW

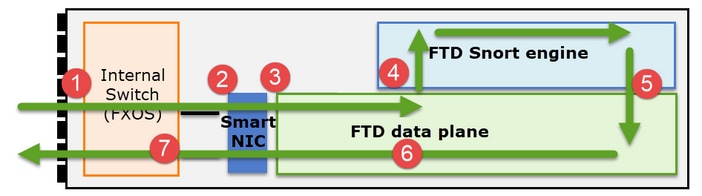

Es importante comprender cómo un Firepower serie 41xx o 93xx gestiona los paquetes de tránsito:

- Un paquete ingresa a la interfaz de ingreso y es manejado por el switch interno del chasis.

- El paquete pasa a través de la NIC inteligente. Si el flujo se descarga (aceleración de hardware), el paquete es manejado únicamente por la NIC inteligente y luego se envía de vuelta a la red.

- Si el paquete no se descarga, entra en el plano de datos FTD que realiza principalmente comprobaciones L3/L4.

- Si la política lo requiere, el motor Snort inspecciona el paquete (principalmente inspección L7).

- El motor Snort devuelve un veredicto (por ejemplo, permitir o bloquear) para el paquete.

- El plano de datos descarta o reenvía el paquete en función del veredicto de Snort.

- El paquete sale del chasis a través del switch de chasis interno.

Capturas de clúster

Los appliances Firepower proporcionan varios puntos de captura que proporcionan visibilidad de los flujos de tránsito. Al resolver problemas y habilitar las capturas de clúster, los principales desafíos son:

- El número de capturas aumenta a medida que aumenta el número de unidades del clúster.

- Debe ser consciente de la forma en que el clúster maneja un flujo específico para poder rastrear el paquete a través del clúster.

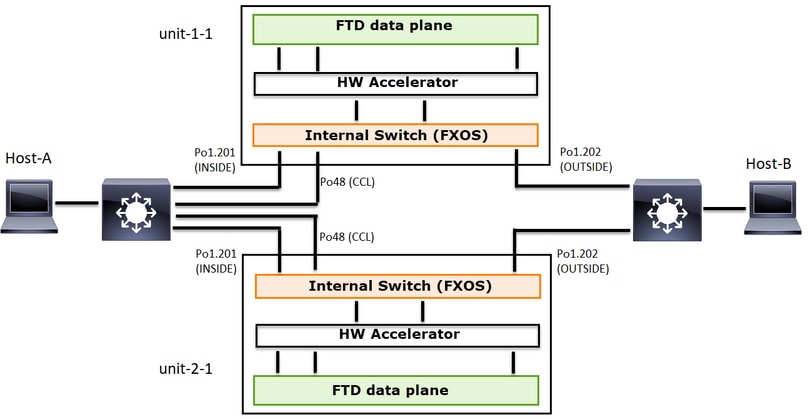

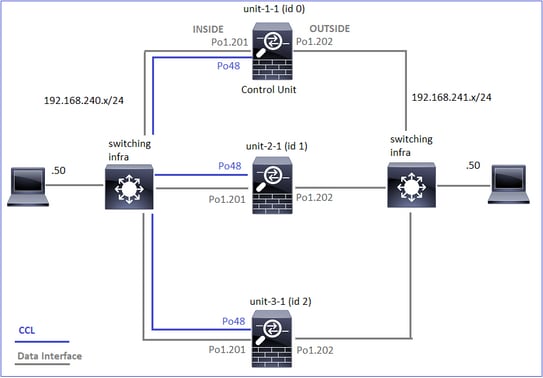

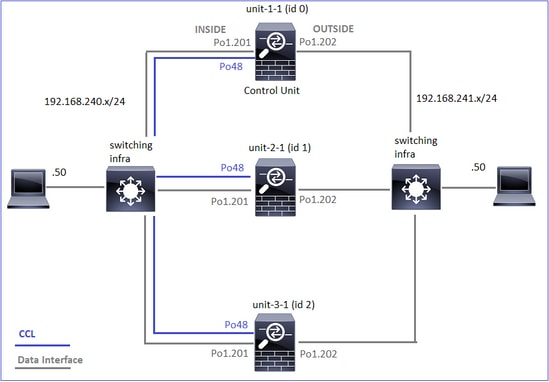

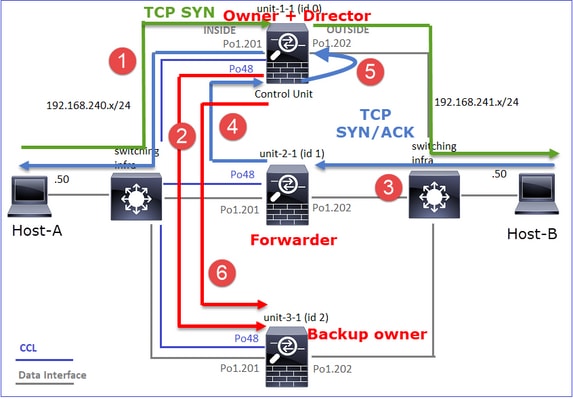

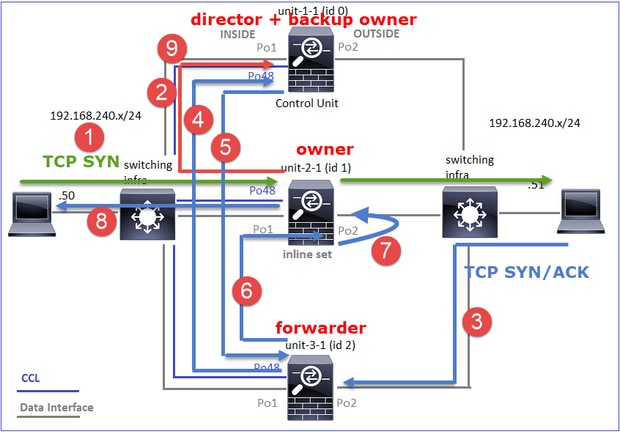

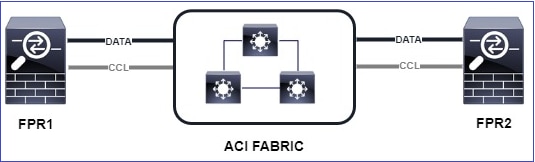

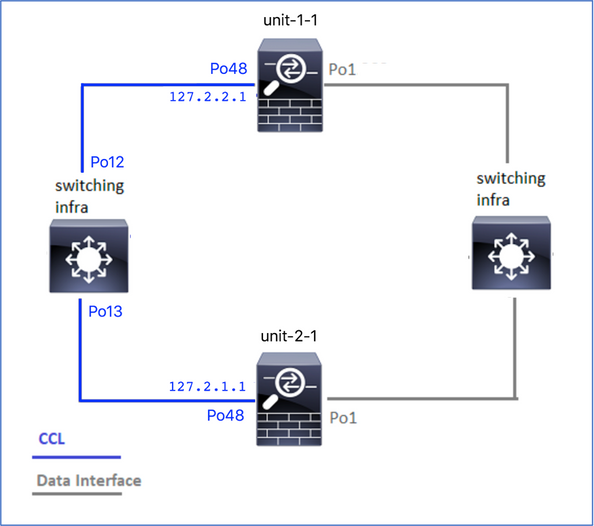

Este diagrama muestra un clúster de 2 unidades (por ejemplo, FP941xx/FP9300):

En el caso de un establecimiento de conexión TCP asimétrico, un intercambio SYN, SYN/ACK de TCP es similar a lo siguiente:

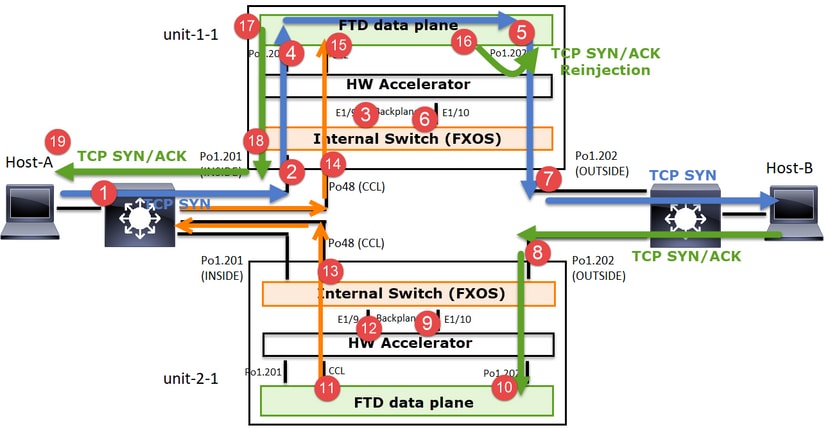

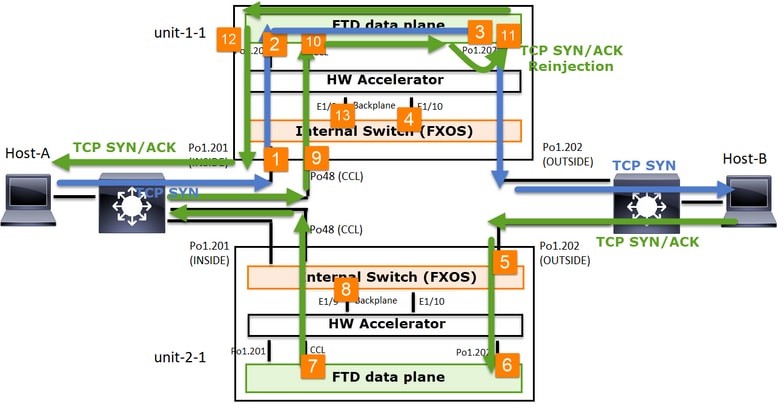

Tráfico directo

- TCP SYN se envía del Host A al Host B.

- TCP SYN llega al chasis (uno de los miembros de Po1).

- TCP SYN se envía a través de una de las interfaces de placa base del chasis (por ejemplo, E1/9, E1/10, etc.) al plano de datos.

- TCP SYN llega a la interfaz de entrada del plano de datos (Po1.201/INSIDE). En este ejemplo, unit1-1 toma posesión del flujo, realiza la aleatorización del número de secuencia inicial (ISN) y codifica la información de propiedad (cookie) en el número de secuencia.

- TCP SYN se envía desde Po1.202/OUTSIDE (interfaz de salida del plano de datos).

- TCP SYN llega a una de las interfaces de placa base del chasis (por ejemplo, E1/9, E1/10, etc.).

- TCP SYN se envía desde la interfaz física del chasis (uno de los miembros de Po1) hacia el Host B.

Tráfico de retorno

- TCP SYN/ACK se envía desde el Host B y llega a la unidad-2-1 (uno de los miembros de Po1).

- TCP SYN/ACK se envía a través de una de las interfaces de placa base del chasis (por ejemplo, E1/9, E1/10, etc.) al plano de datos.

- TCP SYN/ACK llega a la interfaz de ingreso del plano de datos (Po1.202/OUTSIDE).

- TCP SYN/ACK se envía desde el enlace de control de clúster (CCL) hacia la unidad 1-1. De forma predeterminada, ISN está habilitado. Por lo tanto, el reenviador encuentra la información del propietario para TCP SYN+ACKs sin la participación del director. Para otros paquetes o cuando se inhabilita el ISN, se consulta al director.

- TCP SYN/ACK llega a una de las interfaces de backplane del chasis (por ejemplo, E1/9, E1/10, etc.).

- TCP SYN/ACK se envía fuera de la interfaz física del chasis (uno de los miembros de Po48) hacia la unidad-1-1.

- TCP SYN/ACK llega a la unidad-1-1 (uno de los miembros de Po48).

- TCP SYN/ACK se reenvía a través de una de las interfaces de placa base del chasis a la interfaz de canal de puerto CCL del plano de datos (nameif cluster).

- El plano de datos reinyecta el paquete TCP SYN/ACK en la interfaz del plano de datos Po1.202/OUTSIDE.

- TCP SYN/ACK se envía desde Po1.201/INSIDE (interfaz de salida del plano de datos) hacia HOST-A.

- El TCP SYN/ACK atraviesa una de las interfaces de backplane del chasis (por ejemplo, E1/9, E1/10, etc.) y egresa uno de los miembros de Po1.

- TCP SYN/ACK llega al Host-A.

Para obtener más detalles sobre esta situación, lea la sección relacionada en los casos prácticos de establecimiento de conexión a clústeres.

Según este intercambio de paquetes, todos los puntos de captura de clúster posibles son:

Para la captura de tráfico de reenvío (por ejemplo, TCP SYN) en:

- La interfaz física del chasis (por ejemplo, miembros Po1). Esta captura se configura desde la interfaz de usuario del administrador de chasis (CM) o desde la CLI de CM.

- Interfaz de entrada de plano de datos (por ejemplo, Po1.201 INSIDE).

- Interfaz de salida del plano de datos (por ejemplo, Po1.202 OUTSIDE).

- Interfaces de placa base del chasis. En FP4100 hay 2 interfaces de backplane. En FP9300 hay un total de 6 (2 por módulo). Dado que no sabe en qué interfaz llega el paquete, debe habilitar la captura en todas las interfaces.

Para la captura del tráfico de retorno (por ejemplo, TCP SYN/ACK) en:

- La interfaz física del chasis (por ejemplo, miembros Po1). Esta captura se configura desde la interfaz de usuario del administrador de chasis (CM) o desde la CLI de CM.

- Interfaz de entrada de plano de datos (por ejemplo, Po1.202 OUTSIDE).

- Dado que el paquete se redirige, el siguiente punto de captura es el plano de datos CCL.

- Interfaces de placa base del chasis. De nuevo, debe habilitar la captura en ambas interfaces.

- Interfaces miembro CCL del chasis Unit-1-1.

- Interfaz CCL del plano de datos (name if cluster).

- Interfaz de entrada (Po1.202 OUTSIDE). Este es el paquete reinyectado desde CCL al plano de datos.

- Interfaz de salida del plano de datos (por ejemplo, Po1.201 INSIDE).

- Interfaces de placa base del chasis.

Cómo habilitar las capturas de clúster

Capturas de FXOS

El proceso se describe en la Guía de configuración de FXOS: Captura de paquete

Nota: Las capturas de FXOS solo se pueden realizar en la dirección de entrada desde el punto de vista del switch interno.

Capturas del plano de datos

La manera recomendada de habilitar la captura en todos los miembros del clúster es con el comando cluster exec.

Considere un clúster de 3 unidades:

Para verificar si hay capturas activas en todas las unidades del clúster, utilice este comando:

firepower# cluster exec show capture

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

Para habilitar una captura de plano de datos en todas las unidades en Po1.201 (INSIDE):

firepower# cluster exec capture CAPI interface INSIDE

Se recomienda especificar un filtro de captura y, en caso de que espere mucho tráfico, aumentar el búfer de captura:

firepower# cluster exec capture CAPI buffer 33554432 interface INSIDE match tcp host 192.168.240.50 host 192.168.241.50 eq 80

Verificación

firepower# cluster exec show capture

unit-1-1(LOCAL):******************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 5140 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 260 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

Para ver el contenido de todas las capturas (este resultado puede ser muy largo):

firepower# terminal pager 24

firepower# cluster exec show capture CAPI

unit-1-1(LOCAL):******************************************************

21 packets captured

1: 11:33:09.879226 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: S 2225395909:2225395909(0) win 29200 <mss 1460,sackOK,timestamp 1110209649 0,nop,wscale 7>

2: 11:33:09.880401 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.45456: S 719653963:719653963(0) ack 2225395910 win 28960 <mss 1380,sackOK,timestamp 1120565119 1110209649,nop,wscale 7>

3: 11:33:09.880691 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: . ack 719653964 win 229 <nop,nop,timestamp 1110209650 1120565119>

4: 11:33:09.880783 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: P 2225395910:2225396054(144) ack 719653964 win 229 <nop,nop,timestamp 1110209650 1120565119>

unit-2-1:*************************************************************

0 packet captured

0 packet shown

unit-3-1:*************************************************************

0 packet captured

0 packet shown

Capturar seguimientos

Si desea ver cómo el plano de datos de cada unidad maneja los paquetes de ingreso, utilice la palabra clave trace. Esto rastrea los primeros 50 paquetes de ingreso. Puede rastrear hasta 1000 paquetes de ingreso.

Nota: En caso de que tenga varias capturas aplicadas en una interfaz, puede rastrear un solo paquete una sola vez.

Para rastrear los primeros 1000 paquetes de ingreso en la interfaz OUTSIDE en todas las unidades del clúster:

firepower# cluster exec cap CAPO int OUTSIDE buff 33554432 trace trace-count 1000 match tcp host 192.168.240.50 host 192.168.241.50 eq www

Una vez que capture el flujo de interés, es necesario asegurarse de que rastrea los paquetes de interés en cada unidad. Lo importante a recordar es que un paquete específico puede ser #1 en la unidad-1-1, pero #2 en otra unidad, y así sucesivamente.

En este ejemplo, puede ver que el SYN/ACK es el paquete #2 en la unidad-2-1, pero el paquete #1 en la unidad-3-1:

firepower# cluster exec show capture CAPO | include S.*ack

unit-1-1(LOCAL):******************************************************

1: 12:58:31.117700 802.1Q vlan#202 P0 192.168.240.50.45468 > 192.168.241.50.80: S 441626016:441626016(0) win 29200 <mss 1380,sackOK,timestamp 1115330849 0,nop,wscale 7>

2: 12:58:31.118341 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

1: 12:58:31.111429 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Para rastrear el paquete #2 (SYN/ACK) en la unidad local:

firepower# cluster exec show cap CAPO packet-number 2 trace

unit-1-1(LOCAL):******************************************************

2: 12:58:31.118341 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Phase: 1

Type: CAPTURE

Subtype:

Result: ALLOW

Config:

Additional Information:

MAC Access list

...

Para rastrear el mismo paquete (SYN/ACK) en la unidad remota:

firepower# cluster exec unit unit-3-1 show cap CAPO packet-number 1 trace

1: 12:58:31.111429 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Phase: 1

Type: CAPTURE

Subtype:

Result: ALLOW

Config:

Additional Information:

MAC Access list

...

Captura de CCL

Para activar la captura en el enlace CCL (en todas las unidades):

firepower# cluster exec capture CCL interface cluster

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Rechazar ocultar

De forma predeterminada, una captura habilitada en una interfaz de datos del plano de datos muestra todos los paquetes:

- Los que llegan de la red física

- Los que se reinyectan desde la CCL

Si no desea ver los paquetes reinyectados, utilice la opción reinject-hide. Esto puede ser útil si desea verificar si un flujo es asimétrico:

firepower# cluster exec capture CAPI_RH reinject-hide interface INSIDE match tcp host 192.168.240.50 host 192.168.241.50 eq 80

Esta captura sólo muestra lo que la unidad local recibe realmente en la interfaz específica directamente de la red física, y no de las otras unidades del clúster.

caídas ASP

Si desea verificar si hay caídas de software para un flujo específico, puede habilitar la captura asp-drop. Si no sabe en qué motivo de caída debe centrarse, utilice la palabra clave all. Además, si no está interesado en la carga útil del paquete, puede especificar la palabra clave header-only. Esto le permite capturar de 20 a 30 veces más paquetes:

firepower# cluster exec cap ASP type asp-drop all buffer 33554432 headers-only

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Además, puede especificar las IP de interés en la captura ASP:

firepower# cluster exec cap ASP type asp-drop all buffer 33554432 headers-only match ip host 192.0.2.100 any

Borrar una captura

Para borrar el buffer de cualquier captura que se ejecute en todas las unidades del cluster. Esto no detiene las capturas, pero solo borra las memorias intermedias:

firepower# cluster exec clear capture /all

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Detener una captura

Hay 2 maneras de detener una captura activa en todas las unidades de clúster. Más adelante podrá continuar.

Vía 1

firepower# cluster exec cap CAPI stop

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Para reanudar

firepower# cluster exec no capture CAPI stop

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Vía 2

firepower# cluster exec no capture CAPI interface INSIDE

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Para reanudar

firepower# cluster exec capture CAPI interface INSIDE

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Recopilar una captura

Hay varias formas de exportar una captura.

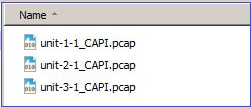

Modo 1: a un servidor remoto

Esto le permite cargar una captura desde el plano de datos a un servidor remoto (por ejemplo, TFTP). Los nombres de captura se cambian automáticamente para reflejar la unidad de origen:

firepower# cluster exec copy /pcap capture:CAPI tftp://192.168.240.55/CAPI.pcap

unit-1-1(LOCAL):******************************************************

Source capture name [CAPI]?

Address or name of remote host [192.168.240.55]?

Destination filename [CAPI.pcap]?

INFO: Destination filename is changed to unit-1-1_CAPI.pcap !!!!!!!

81 packets copied in 0.40 secs

unit-2-1:*************************************************************

INFO: Destination filename is changed to unit-2-1_CAPI.pcap !

unit-3-1:*************************************************************

INFO: Destination filename is changed to unit-3-1_CAPI.pcap !

Los archivos pcap cargados:

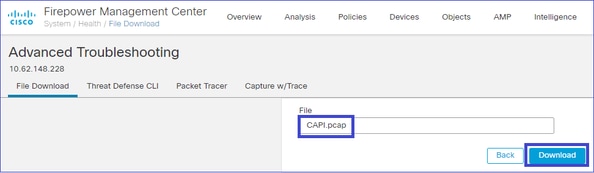

Camino 2 - Obtener las capturas de la FMC

Esta forma solo es aplicable al FTD. En primer lugar, copie la captura en el disco FTD:

firepower# cluster exec copy /pcap capture:CAPI disk0:CAPI.pcap

unit-1-1(LOCAL):******************************************************

Source capture name [CAPI]?

Destination filename [CAPI.pcap]?

!!!!!

62 packets copied in 0.0 secs

En el modo experto, copie el archivo de /mnt/disk0/ al directorio /ngfw/var/common/:

> expert

admin@firepower:~$ cd /mnt/disk0

admin@firepower:/mnt/disk0$ sudo cp CAPI.pcap /ngfw/var/common

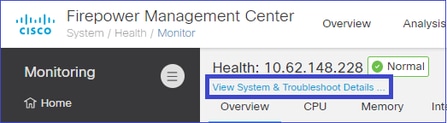

Por último, en FMC, vaya a la sección System > Health > Monitor. Elija View System & Troubleshoot Details > Advanced Troubleshooting y obtenga el archivo de captura:

Eliminar una captura

Para eliminar una captura de todas las unidades de clúster, utilice este comando:

firepower# cluster exec no capture CAPI

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Flujos descargados

En FP41xx/FP9300, los flujos se pueden descargar en el acelerador de hardware de forma estática (por ejemplo, reglas de ruta rápida) o dinámica. Para obtener más detalles sobre la descarga de flujo, consulte este documento:

Si se descarga un flujo, solo unos pocos paquetes pasan por el plano de datos FTD. El resto lo gestiona el acelerador de hardware (Smart NIC).

Desde el punto de vista de la captura, esto significa que si solo habilita las capturas de nivel de plano de datos FTD, no verá todos los paquetes que pasan a través del dispositivo. En este caso, también debe habilitar las capturas a nivel de chasis FXOS.

Mensajes del enlace de control de clústeres (CCL)

Si realiza una captura en CCL, observará que las unidades del clúster intercambian diferentes tipos de mensajes. Los de interés son:

| Protocolo |

Descripción |

| UDP 49495 |

Latidos del clúster (keepalives) · Transmisión de L3 (255.255.255.255) · Cada unidad de clúster envía estos paquetes a la mitad del valor de tiempo de espera de comprobación de estado. · Tenga en cuenta que no todos los paquetes UDP 49495 que se ven en la captura son latidos · Los latidos contienen un número de secuencia. |

| UDP 4193 |

Mensajes de ruta de datos de Cluster Control Protocol · Unidifusión · Estos paquetes contienen información (metadatos) sobre el propietario del flujo, el director, el propietario de la copia de seguridad, etc. Pueden citarse como ejemplo: · Se envía un mensaje de ‘cluster add’ del propietario al director cuando se crea un nuevo flujo · Se envía un mensaje de ‘eliminación de clúster’ del propietario al director cuando se termina un flujo |

| Paquetes de datos |

Paquetes de datos que pertenecen a los diversos flujos de tráfico que atraviesan el clúster |

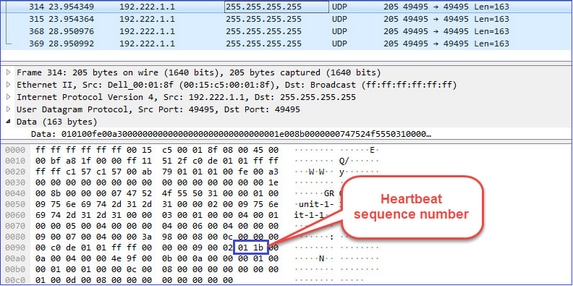

Latido del clúster

Mensajes del punto de control del clúster (CCP)

Además de los mensajes de latido, hay una serie de mensajes de control de clúster que se intercambian a través de CCL en escenarios específicos. Algunos de ellos son mensajes de unidifusión, mientras que otros son transmisiones.

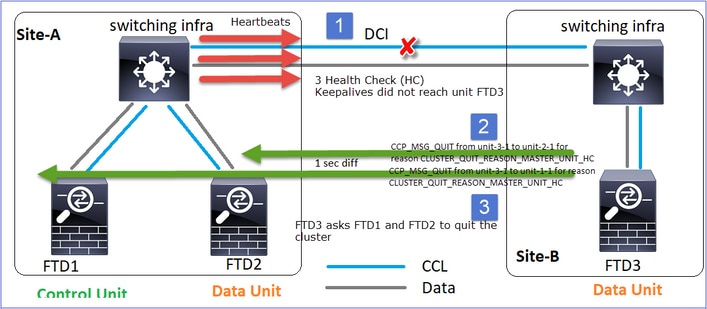

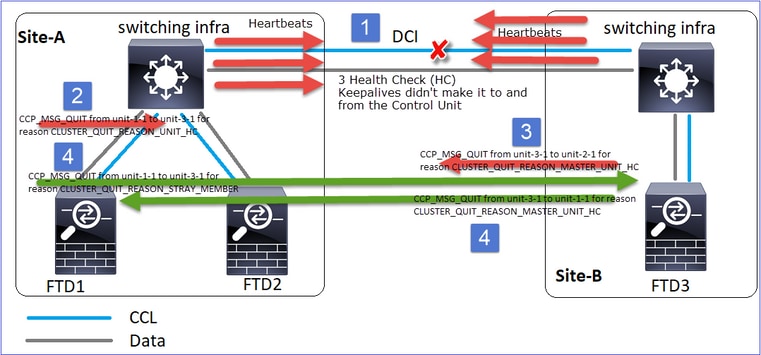

CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Siempre que una unidad pierde 3 mensajes de latido consecutivos del nodo de control, genera un mensaje CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC sobre la CCL. Este mensaje:

- Es una unidifusión.

- Se envía a cada una de las unidades con un intervalo de 1 segundo.

- Cuando una unidad recibe este mensaje, sale del clúster (DISABLED) y vuelve a unirse.

P. ¿Cuál es el propósito de CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC?

A. Desde el punto de vista de la unidad-3-1 (Sitio-B), pierde la conexión tanto con la unidad-1-1 como con la unidad-2-1 del sitio A, por lo que necesita eliminarlas de su lista de miembros tan pronto como sea posible; de lo contrario, puede perder paquetes si la unidad-2-1 sigue en su lista de miembros y la unidad-2-1 resulta ser un director de una conexión, y la consulta de flujo a la unidad-2-1 falla.

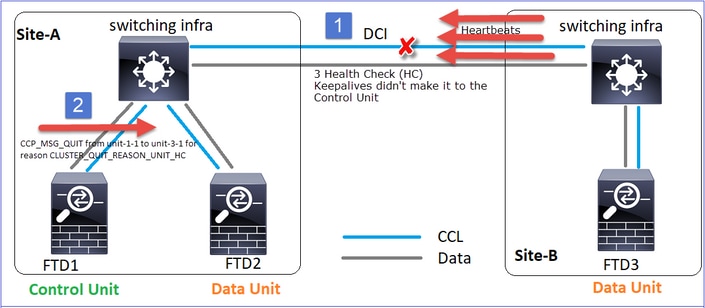

CLUSTER_QUIT_REASON_UNIT_HC

Siempre que el nodo de control pierde 3 mensajes de latido consecutivos de un nodo de datos, envía el mensaje CLUSTER_QUIT_REASON_UNIT_HC a través de la CCL. Este mensaje es unicast.

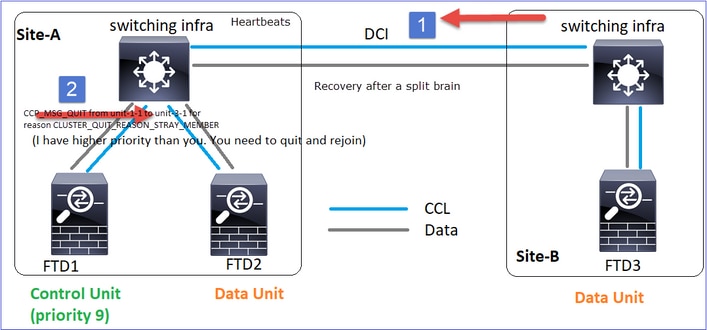

CLUSTER_QUIT_REASON_STRAY_MEMBER

Cuando una partición dividida se vuelve a conectar con una partición par, la unidad de control dominante trata el nuevo nodo de datos como un miembro perdido y recibe un mensaje de salida de CCP con la razón de CLUSTER_QUIT_REASON_STRAY_MEMBER.

CLUSTER_QUIT_MEMBER_DROPOUT

Mensaje de difusión generado por un nodo de datos y que se envía como difusión. Una vez que una unidad recibe este mensaje, pasa al estado DISABLED (DESACTIVADO). Además, la reincorporación automática no se inicia:

firepower# show cluster info trace | include DROPOUT

Nov 04 00:22:54.699 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-1-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 04 00:22:53.699 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-2-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

El historial del clúster muestra:

PRIMARY DISABLED Received control message DISABLE (member dropout announcement)

Mecanismo de comprobación del estado del clúster (HC)

Puntos principales

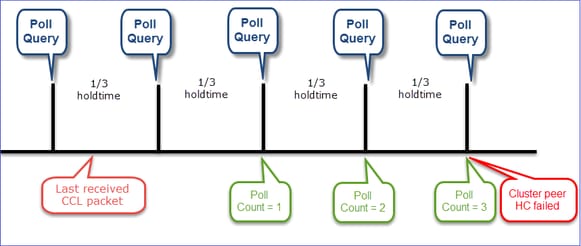

- Cada unidad de clúster envía un latido cada 1/3 del valor de tiempo de espera de comprobación de estado a todas las demás unidades (difusión 255.255.255.255) y utiliza el puerto UDP 49495 como transporte a través de CCL.

- Cada unidad de clúster realiza un seguimiento independiente de cada otra unidad con un temporizador de sondeo y un valor de recuento de sondeo.

- Si una unidad de clúster no recibe ningún paquete (latido o paquete de datos) de una unidad de clúster par dentro de un intervalo de latido, aumenta el valor de recuento de sondeo.

- Cuando el valor de conteo de sondeo para una unidad de peer de clúster se convierte en 3, el peer se considera inactivo.

- Siempre que se recibe un latido, se verifica su número de secuencia y, en caso de que la diferencia con el latido recibido anteriormente sea diferente a 1, el contador de caídas de latido aumenta en consecuencia.

- Si el contador de conteo de sondeos para un par de clúster es diferente de 0 y el par recibe un paquete, el contador se restablece a un valor 0.

Utilice este comando para verificar los contadores de estado del clúster:

firepower# show cluster info health details

----------------------------------------------------------------------------------

| Unit (ID)| Heartbeat| Heartbeat| Average| Maximum| Poll|

| | count| drops| gap (ms)| slip (ms)| count|

----------------------------------------------------------------------------------

| unit-2-1 ( 1)| 650| 0| 4999| 1| 0|

| unit-3-1 ( 2)| 650| 0| 4999| 1| 0|

----------------------------------------------------------------------------------

Descripción de las columnas principales

| Columna |

Descripción |

| Unidad (ID) |

El ID del peer del cluster remoto. |

| Conteo de latidos |

El número de latidos recibidos del peer remoto a través de CCL. |

| Heartbeat drops |

El número de latidos perdidos. Este contador se calcula en función del número de secuencia de latido recibido. |

| Brecha media |

El intervalo de tiempo promedio de los latidos recibidos. |

| Recuento de sondeos |

Cuando este contador se convierte en 3, la unidad se elimina del clúster. El intervalo de consulta de sondeo es el mismo que el intervalo de latido, pero se ejecuta de forma independiente. |

Para restablecer los contadores utilice este comando:

firepower# clear cluster info health details

P. ¿Cómo verificar la frecuencia de los latidos del corazón?

A. Compruebe el valor de la diferencia media:

firepower# show cluster info health details

----------------------------------------------------------------------------------

| Unit (ID)| Heartbeat| Heartbeat| Average| Maximum| Poll|

| | count| drops| gap (ms)| slip (ms)| count|

----------------------------------------------------------------------------------

| unit-2-1 ( 1)| 3036| 0| 999| 1| 0|

----------------------------------------------------------------------------------

P. ¿Cómo puede cambiar el tiempo de espera del clúster en FTD?

A. Uso de FlexConfig

P. ¿Quién se convierte en el nodo de control después de un cerebro partido?

A. La unidad con la prioridad más alta (el número más bajo):

firepower# show run cluster | include priority

priority 9

Verifique el escenario 1 de falla de HC para obtener más detalles.

Visualización del mecanismo de HC del clúster

Temporizadores indicativos: El mínimo y el máximo dependen de la última llegada de paquetes CCL recibida.

| Tiempo de espera |

Comprobación de consulta de sondeo (frecuencia) |

Tiempo mínimo de detección |

Tiempo máximo de detección |

| 3 s (predeterminado) |

~1 s |

~3,01 s |

~3,99 s |

| 4 seg. |

~1,33 s |

~4,01 s |

~5,32 s |

| 5 seg. |

~1,66 s |

~5,01 s |

~6,65 s |

| 6 seg. |

~2 s |

~6,01 s |

~7,99 s |

| 7 seg. |

~2,33 s |

~7,01 s |

~9,32 s |

| 8 seg. |

~2,66 s |

~8,01 s |

~10,65 s |

Escenarios de falla de clúster HC

Los objetivos de esta sección son demostrar:

- Diferentes escenarios de falla de HC de clúster.

- Cómo se pueden correlacionar los diferentes registros y salidas de comandos.

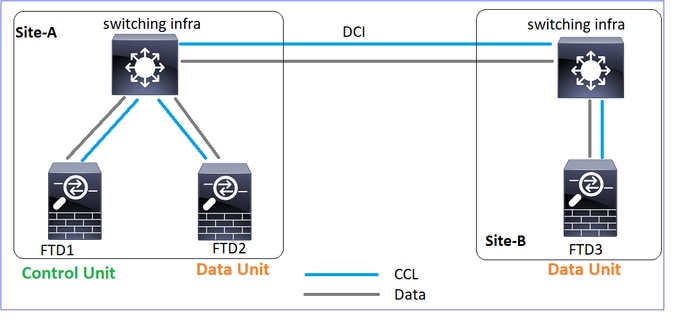

Topología

Configuración de agrupamiento

| Unidad-1-1 |

Unidad-2-1 |

Unidad-3-1 |

cluster group GROUP1 |

cluster group GROUP1 |

cluster group GROUP1 |

Estado del clúster

| Unidad-1-1 |

Unidad-2-1 |

Unidad-3-1 |

firepower# show cluster info |

firepower# show cluster info |

firepower# show cluster info |

Escenario 1

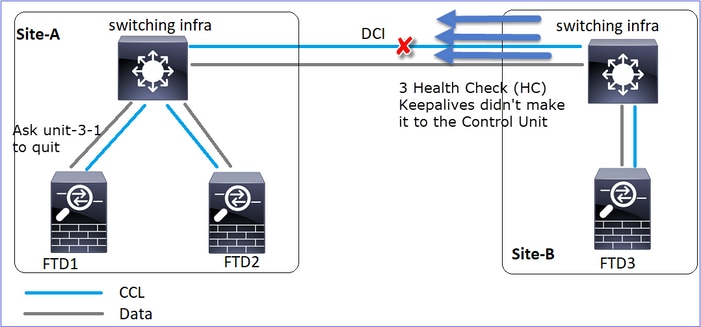

Pérdida de comunicación de CCL durante más de 4 segundos en ambas direcciones.

Antes del fracaso

| FTD1 |

FTD2 |

FTD3 |

| Sitio-A |

Sitio-A |

Sitio-B |

| Nodo de control |

Nodo de datos |

Nodo de datos |

Después de la recuperación (sin cambios en las funciones de unidad)

| FTD1 |

FTD2 |

FTD3 |

| Sitio-A |

Sitio-A |

Sitio-B |

| Nodo de control |

Nodo de datos |

Nodo de datos |

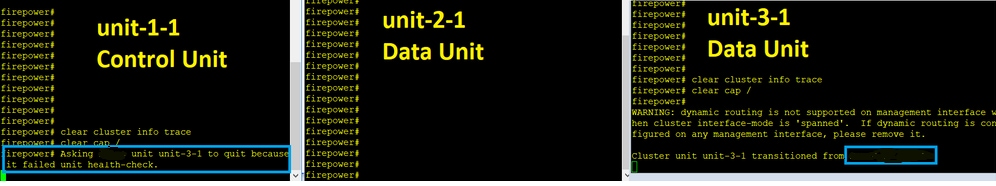

Análisis

Error (se perdió la comunicación de CCL).

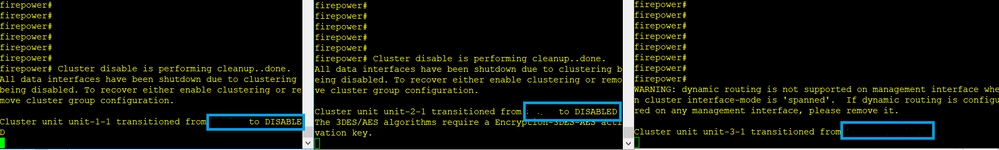

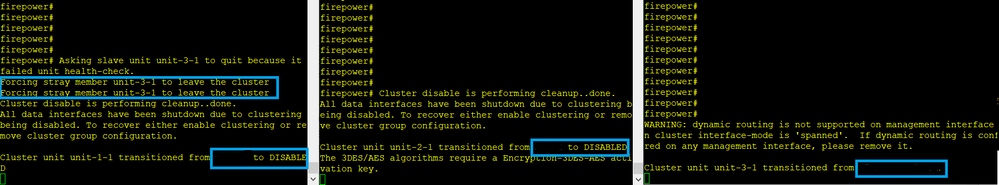

El mensaje de la consola del plano de datos en la unidad-3-1:

firepower#

WARNING: dynamic routing is not supported on management interface when cluster interface-mode is 'spanned'.

If dynamic routing is configured on any management interface, please remove it.

Cluster unit unit-3-1 transitioned from SECONDARY to PRIMARY

Cluster disable is performing cleanup..done.

All data interfaces have been shutdown due to clustering being disabled.

To recover either enable clustering or remove cluster group configuration.

Registros de seguimiento de clúster de Unit-1-1:

firepower# show cluster info trace | include unit-3-1

Nov 02 09:38:14.239 [INFO]Notify chassis de-bundle port for blade unit-3-1, stack 0x000055a8918307fb 0x000055a8917fc6e8 0x000055a8917f79b5

Nov 02 09:38:14.239 [INFO]FTD - CD proxy received state notification (DISABLED) from unit unit-3-1

Nov 02 09:38:14.239 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 02 09:38:14.239 [INFO]Notify chassis de-bundle port for blade unit-3-1, stack 0x000055a8917eb596 0x000055a8917f4838 0x000055a891abef9d

Nov 02 09:38:14.239 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Nov 02 09:38:14.239 [CRIT]Received heartbeat event 'SECONDARY heartbeat failure' for member unit-3-1 (ID: 1).

Cerebro partido

| Unidad-1-1 |

Unidad-2-1 |

Unidad-3-1 |

firepower# show cluster info |

firepower# show cluster info |

firepower# show cluster info |

Historial de clústeres

| Unidad-1-1 |

Unidad-2-1 |

Unidad-3-1 |

| No hay eventos |

No hay eventos |

09:38:16 UTC Nov 2 2020 |

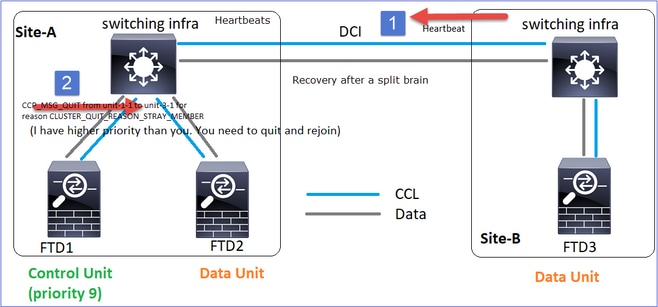

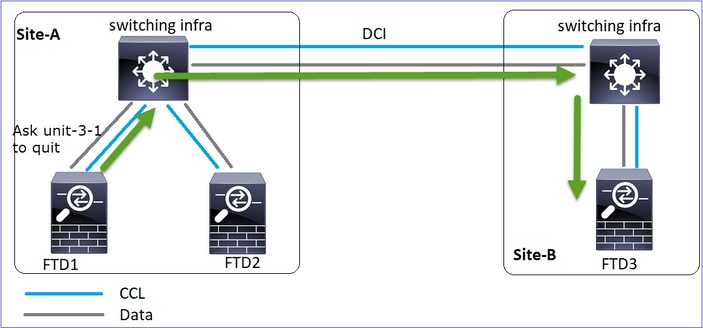

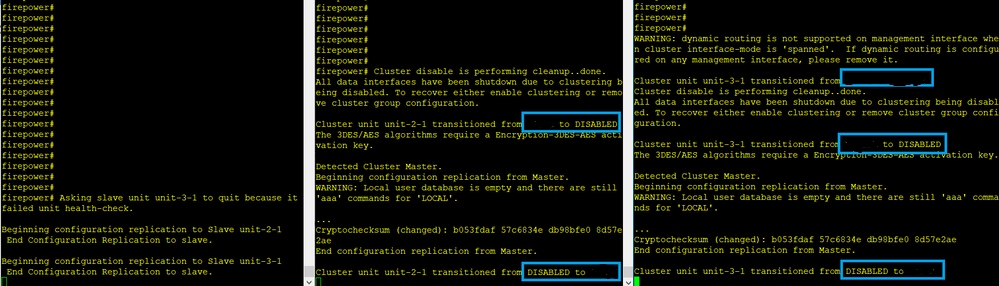

restauración de comunicación CCL

La unidad-1-1 detecta el nodo de control actual y, dado que la unidad-1-1 tiene mayor prioridad, envía a la unidad-3-1 un mensaje CLUSTER_QUIT_REASON_STRAY_MEMBER para activar un nuevo proceso de elección. Al final, la unidad-3-1 se vuelve a unir como un nodo de datos.

Cuando una partición dividida se vuelve a conectar con una partición par, el nodo de datos es tratado como un miembro perdido por el nodo de control dominante y recibe un mensaje de salida de CCP con una razón de CLUSTER_QUIT_REASON_STRAY_MEMBER.

Unit-3-1 console logs show:

Cluster unit unit-3-1 transitioned from PRIMARY to DISABLED

The 3DES/AES algorithms require a Encryption-3DES-AES activation key.

Detected Cluster Primart.

Beginning configuration replication from Primary.

WARNING: Local user database is empty and there are still 'aaa' commands for 'LOCAL'.

..

Cryptochecksum (changed): a9ed686f 8e2e689c 2553a104 7a2bd33a

End configuration replication from Primary.

Cluster unit unit-3-1 transitioned from DISABLED to SECONDARY

Ambas unidades (unit-1-1 y unit-3-1) muestran en sus registros de clúster:

firepower# show cluster info trace | include retain

Nov 03 21:20:23.019 [CRIT]Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Nov 03 21:20:23.019 [CRIT]Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

También hay mensajes syslog generados para el cerebro partido:

firepower# show log | include 747016

Nov 03 2020 21:20:23: %FTD-4-747016: Clustering: Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Nov 03 2020 21:20:23: %FTD-4-747016: Clustering: Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Historial de clústeres

| Unidad-1-1 |

Unidad-2-1 |

Unidad-3-1 |

| No hay eventos |

No hay eventos |

09:47:33 UTC Nov 2 2020 |

Escenario 2

Pérdida de comunicación de CCL durante aproximadamente 3-4 segundos en ambas direcciones.

Antes del fracaso

| FTD1 |

FTD2 |

FTD3 |

| Sitio-A |

Sitio-A |

Sitio-B |

| Nodo de control |

Nodo de datos |

Nodo de datos |

Después de la recuperación (sin cambios en las funciones de unidad)

| FTD1 |

FTD2 |

FTD3 |

| Sitio-A |

Sitio-A |

Sitio-B |

| Nodo de control |

Nodo de datos |

Nodo de datos |

Análisis

Evento 1: El nodo de control pierde 3 HCs de la unidad-3-1 y envía un mensaje a la unidad-3-1 para salir del clúster.

Evento 2: El CCL se recuperó muy rápido y el mensaje CLUSTER_QUIT_REASON_STRAY_MEMBER del nodo de control llegó al lado remoto. La Unidad-3-1 va directamente al modo DISABLED y no hay cerebro partido

En la unidad-1-1 (control) verá:

firepower#

Asking SECONDARY unit unit-3-1 to quit because it failed unit health-check.

Forcing stray member unit-3-1 to leave the cluster

En unit-3-1 (nodo de datos) verá:

firepower#

Cluster disable is performing cleanup..done.

All data interfaces have been shutdown due to clustering being disabled. To recover either enable clustering or remove cluster group configuration.

Cluster unit unit-3-1 transitioned from SECONDARY to DISABLED

La unidad de clúster 3-1 pasó a un estado DISABLED y, una vez restaurada la comunicación CCL, se vuelve a unir como un nodo de datos:

firepower# show cluster history

20:58:40 UTC Nov 1 2020

SECONDARY DISABLED Received control message DISABLE (stray member)

20:58:45 UTC Nov 1 2020

DISABLED ELECTION Enabled from CLI

20:58:45 UTC Nov 1 2020

ELECTION SECONDARY_COLD Received cluster control message

20:58:45 UTC Nov 1 2020

SECONDARY_COLD SECONDARY_APP_SYNC Client progression done

20:59:33 UTC Nov 1 2020

SECONDARY_APP_SYNC SECONDARY_CONFIG SECONDARY application configuration sync done

20:59:44 UTC Nov 1 2020

SECONDARY_CONFIG SECONDARY_FILESYS Configuration replication finished

20:59:45 UTC Nov 1 2020

SECONDARY_FILESYS SECONDARY_BULK_SYNC Client progression done

21:00:09 UTC Nov 1 2020

SECONDARY_BULK_SYNC SECONDARY Client progression done

Escenario 3

Pérdida de comunicación de CCL durante aproximadamente 3-4 segundos en ambas direcciones.

Antes del fracaso.

| FTD1 |

FTD2 |

FTD3 |

| Sitio-A |

Sitio-A |

Sitio-B |

| Nodo de control |

Nodo de datos |

Nodo de datos |

Después de la recuperación (se cambió el nodo de control).

| FTD1 |

FTD2 |

FTD3 |

| Sitio-A |

Sitio-A |

Sitio-B |

| Nodo de datos |

Nodo de control |

Nodo de datos |

Análisis

- CCL se desactiva.

- La Unidad-1-1 no obtiene 3 mensajes HC de la unidad-3-1 y envía un mensaje QUIT a la unidad-3-1. Este mensaje nunca llega a la unidad-3-1.

- La unidad-3-1 envía un mensaje QUIT a la unidad-2-1. Este mensaje nunca llega a la unidad-2-1.

CCL se recupera.

- La Unidad-1-1 ve que la unidad-3-1 se anuncia a sí misma como un nodo de control y envía el mensaje QUIT_REASON_STRAY_MEMBER a la unidad-3-1. Una vez que la unidad-3-1 obtiene este mensaje, pasa al estado DISABLED. Al mismo tiempo, la unidad-3-1 envía un mensaje QUIT_REASON_PRIMARY_UNIT_HC a la unidad-1-1 y le pide que salga. Una vez que la unidad-1-1 recibe este mensaje pasa al estado DISABLED.

Historial de clústeres

| Unidad-1-1 |

Unidad-2-1 |

Unidad-3-1 |

19:53:09 UTC Nov 2 2020 |

19:53:06 UTC Nov 2 2020 |

19:53:06 UTC Nov 2 2020 |

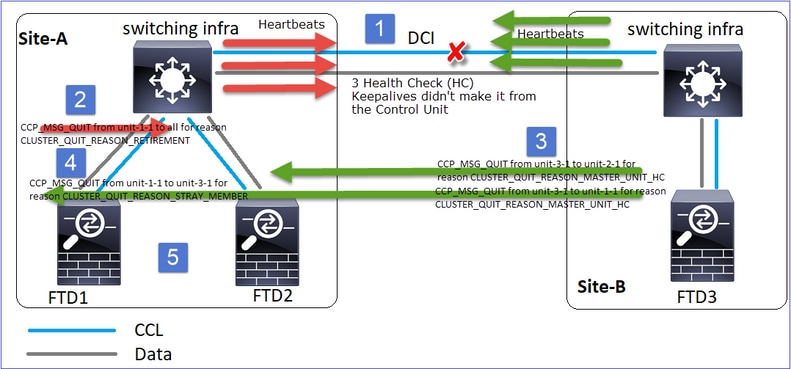

Situación 4

Pérdida de comunicación de CCL durante aproximadamente 3-4 s

Antes del fracaso

| FTD1 |

FTD2 |

FTD3 |

| Sitio-A |

Sitio-A |

Sitio-B |

| Nodo de control |

Nodo de datos |

Nodo de datos |

Después de la recuperación (el nodo de control cambió de sitio)

| FTD1 |

FTD2 |

FTD3 |

| Sitio-A |

Sitio-A |

Sitio-B |

| Nodo de datos |

Nodo de datos |

Nodo de control |

Análisis

El fracaso

Un sabor diferente de la misma falla. En este caso, la unidad-1-1 tampoco recibió 3 mensajes de HC de la unidad-3-1, y una vez que recibió un nuevo keepalive, trató de expulsar la unidad-3-1 con el uso de un mensaje STRAY, pero el mensaje nunca llegó a la unidad-3-1:

- CCL pasa a ser unidireccional durante unos segundos. La Unidad-3-1 no recibe 3 mensajes HC de la unidad-1-1 y se convierte en un nodo de control.

- La Unidad-2-1 envía un mensaje CLUSTER_QUIT_REASON_RETIREMENT (difusión).

- La Unidad-3-1 envía un mensaje QUIT_REASON_PRIMARY_UNIT_HC a la unidad-2-1. La Unidad-2-1 lo recibe y sale del agrupamiento.

- La Unidad-3-1 envía un mensaje QUIT_REASON_PRIMARY_UNIT_HC a la unidad-1-1. La Unidad-1-1 lo recibe y sale del agrupamiento. CCL se recupera.

- Las unidades 1-1 y 2-1 se vuelven a unir al clúster como nodos de datos.

Nota: Si en el paso 5 CCL no se recupera, en el sitio A el FTD1 se convierte en el nuevo nodo de control y, tras la recuperación de CCL, gana la nueva elección.

Mensajes de Syslog en la unidad-1-1:

firepower# show log | include 747

Nov 03 2020 23:13:08: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-3-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:09: %FTD-4-747015: Clustering: Forcing stray member unit-3-1 to leave the cluster

Nov 03 2020 23:13:09: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-2-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-4-747015: Clustering: Forcing stray member unit-3-1 to leave the cluster

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY to DISABLED

Nov 03 2020 23:13:12: %FTD-7-747006: Clustering: State machine is at state DISABLED

Nov 03 2020 23:13:12: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MY_STATE (state DISABLED,0x0000000000000000,0x0000000000000000)

Nov 03 2020 23:13:18: %FTD-6-747004: Clustering: State machine changed from state ELECTION to ONCALL

Registros de seguimiento de clúster en la unidad-1-1:

firepower# show cluster info trace | include QUIT

Nov 03 23:13:10.789 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 03 23:13:10.769 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-1-1 for reason CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Nov 03 23:13:10.769 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_STRAY_MEMBER

Nov 03 23:13:09.789 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 03 23:13:09.769 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_STRAY_MEMBER

Nov 03 23:13:08.559 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 03 23:13:08.559 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Mensajes de Syslog en la unidad-3-1:

firepower# show log | include 747

Nov 03 2020 23:13:09: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-2-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-1-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state SECONDARY to PRIMARY

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_FAST to PRIMARY_DRAIN

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_DRAIN to PRIMARY_CONFIG

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_CONFIG to PRIMARY_POST_CONFIG

Nov 03 2020 23:13:10: %FTD-7-747006: Clustering: State machine is at state PRIMARY_POST_CONFIG

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_POST_CONFIG to PRIMARY

Nov 03 2020 23:13:10: %FTD-7-747006: Clustering: State machine is at state PRIMARY

Historial de clústeres

| Unidad-1-1 |

Unidad-2-1 |

Unidad-3-1 |

23:13:13 UTC Nov 3 2020 |

23:13:12 UTC Nov 3 2020 |

23:13:10 UTC Nov 3 2020 |

Situación 5

Antes del fracaso

| FTD1 |

FTD2 |

FTD3 |

| Sitio-A |

Sitio-A |

Sitio-B |

| Nodo de control |

Nodo de datos |

Nodo de datos |

Después de la recuperación (sin cambios)

| FTD1 |

FTD2 |

FTD3 |

| Sitio-A |

Sitio-A |

Sitio-B |

| Nodo de control |

Nodo de datos |

Nodo de datos |

El fracaso

La Unidad-3-1 envió mensajes QUIT tanto a la unidad-1-1 como a la unidad-2-1, pero debido a problemas de conectividad sólo la unidad-2-1 recibió el mensaje QUIT.

Registros de seguimiento de clúster de Unit-1-1:

firepower# show cluster info trace | include QUIT

Nov 04 00:52:10.429 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:47.059 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:45.429 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 04 00:51:45.429 [DBUG]Send CCP message to unit-3-1(1): CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Registros de seguimiento de clúster de Unit-2-1:

firepower# show cluster info trace | include QUIT

Nov 04 00:52:10.389 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:47.019 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:46.999 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-2-1 for reason CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Nov 04 00:51:45.389 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Historial de clústeres

| Unidad-1-1 |

Unidad-2-1 |

Unidad-3-1 |

| No hay eventos |

00:51:50 UTC Nov 4 2020 |

00:51:47 UTC Nov 4 2020 |

Establecimiento de conexión de plano de datos de clúster

Puntos de captura de NGFW

El NGFW ofrece funciones de captura en los siguientes puntos:

- Switch interno del chasis (FXOS)

- motor de plano de datos FTD

- Motor FTD Snort

Cuando resuelve problemas de trayectoria de datos en un clúster, los puntos de captura utilizados en la mayoría de los casos son las capturas del motor de plano de datos FXOS y FTD.

- Captura de ingreso de FXOS en la interfaz física

- Captura de ingreso de FTD en el motor del plano de datos

- Captura de salida de FTD en el motor del plano de datos

- Captura de ingreso de FXOS en la interfaz de backplane

Para obtener más información sobre las capturas de NGFW, consulte este documento:

Fundamentos de roles de flujo de unidades de clúster

Las conexiones se pueden establecer a través de un clúster de varias maneras que dependen de factores como:

- Tipo de tráfico (TCP, UDP, etc.)

- Algoritmo de equilibrio de carga configurado en el switch adyacente

- Funciones configuradas en el firewall

- Condiciones de red (por ejemplo, fragmentación de IP, retrasos de red, etc.)

| Función de flujo |

Descripción |

Indicador(es) |

| OWNER |

Normalmente, la unidad que recibe inicialmente la conexión |

UIO |

| Director |

Unidad que gestiona las solicitudes de búsqueda de propietarios de los reenviadores. |

S |

| Propietario de backup |

Mientras el director no sea la misma unidad que el propietario, el director también será el propietario de la copia de seguridad. Si el propietario se elige a sí mismo como director, se elige un propietario de copia de seguridad independiente. |

Y (si el director es también el propietario de la copia de seguridad) y (si el director no es el propietario de la copia de seguridad) |

| Reenviador |

Unidad que reenvía paquetes al propietario |

z |

| Propietario del fragmento |

La unidad que maneja el tráfico fragmentado |

- |

| Respaldo del chasis |

En un clúster entre chasis, cuando los flujos director/respaldo y propietario son propiedad de las unidades del mismo chasis, una unidad en uno de los otros chasis se convierte en un respaldo/director secundario. Esta función es específica para los clústeres entre chasis de Firepower serie 9300 con más de un blade. |

w |

- Para obtener más información, consulte la sección relacionada de la Guía de configuración (consulte los enlaces de la Información relacionada)

- En escenarios específicos (consulte la sección de casos prácticos), algunos indicadores no siempre se muestran.

Casos prácticos de establecimiento de conexión a clústeres

En la siguiente sección se describen varios casos prácticos que muestran algunas de las formas en que se puede establecer una conexión a través de un clúster. Los objetivos son:

- Familiarícese con los distintos roles de las unidades.

- Demuestre cómo se pueden correlacionar los distintos resultados de comandos.

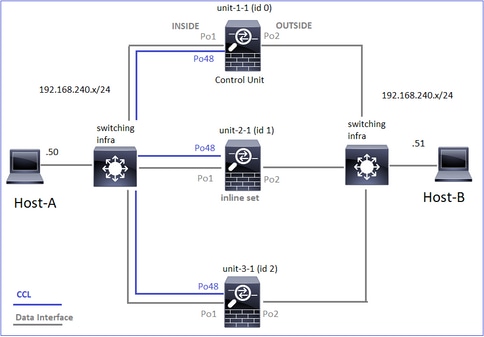

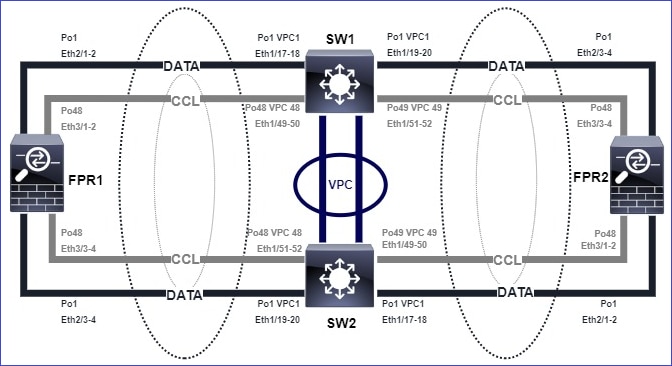

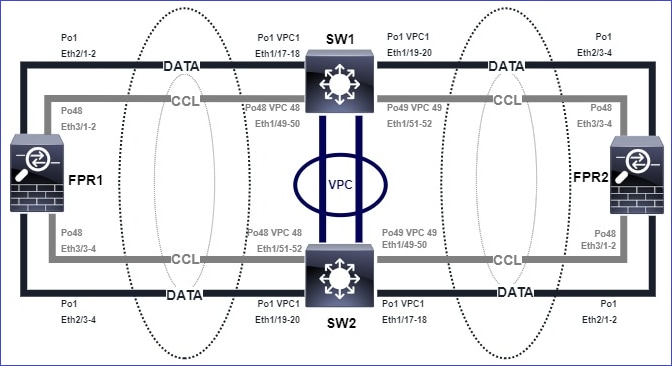

Topología

Unidades de clúster e ID:

| Unidad-1-1 |

Unidad-2-1 |

Unidad-3-1 |

Cluster GROUP1: On |

Unit "unit-2-1" in state SECONDARY |

Unit "unit-3-1" in state SECONDARY |

Capturas de clúster habilitadas:

cluster exec cap CAPI int INSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPO int OUTSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPI_RH reinject-hide int INSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPO_RH reinject-hide int OUTSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CCL int cluster buffer 33554432

Nota: Estas pruebas se ejecutaron en un entorno de laboratorio con un tráfico mínimo a través del clúster. En la producción, intente utilizar los filtros de captura más específicos posibles (por ejemplo, el puerto de destino y, siempre que sea posible, el puerto de origen) para minimizar el "ruido" en las capturas.

Caso práctico 1. Tráfico simétrico (el propietario es también el director)

Observación 1. Las capturas de reinyección-ocultación muestran paquetes solamente en la unidad-1-1. Esto significa que el flujo en ambas direcciones pasó por la unidad-1-1 (tráfico simétrico):

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data interface cluster [Capturing - 33513 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

unit-2-1:*************************************************************

capture CCL type raw-data interface cluster [Capturing - 23245 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

unit-3-1:*************************************************************

capture CCL type raw-data interface cluster [Capturing - 24815 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

Observación 2. Análisis del indicador de conexión para el flujo con el puerto de origen 45954

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

22 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 2 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:45954, idle 0:00:00, bytes 487413076, flags UIO N1

unit-2-1:*************************************************************

22 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 249 most enabled, 0 most in effect

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 2 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:443 NP Identity Ifc 192.168.240.50:39698, idle 0:00:23, bytes 0, flags z

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:45954, idle 0:00:06, bytes 0, flags y

| Unidad |

Indicador |

Nota |

| Unidad-1-1 |

UIO |

· Propietario de flujo: la unidad maneja el flujo · Director: dado que la unidad-3-1 tiene "y" y no "Y", esto implica que la unidad-1-1 fue elegida como el director para este flujo. Por lo tanto, dado que también es el propietario, se eligió otra unidad (unit-3-1 en este caso) como propietario de la copia de seguridad |

| Unidad-2-1 |

- |

- |

| Unidad-3-1 |

s |

La unidad es un propietario de respaldo |

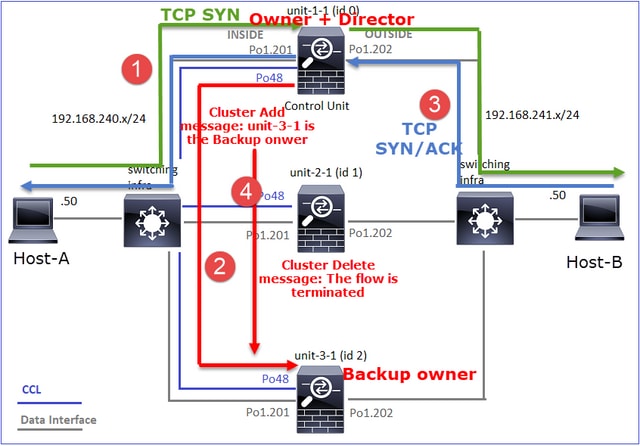

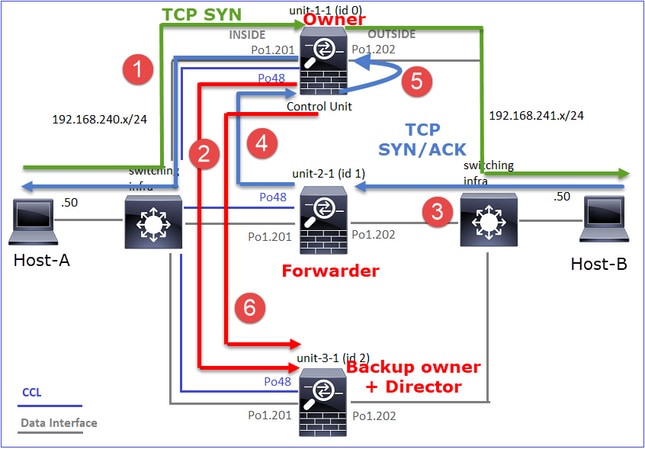

Esto se puede visualizar como:

- El paquete TCP SYN llega del Host-A a la unidad-1-1. La unidad-1-1 se convierte en el propietario del flujo.

- La Unidad-1-1 también es elegida directora de flujo. Por lo tanto, también elige la unidad-3-1 como el propietario de la copia de seguridad (mensaje de adición de clúster).

- El paquete TCP SYN/ACK llega del Host B a la unidad 3-1. El flujo es simétrico.

- Una vez finalizada la conexión, el propietario envía un mensaje de eliminación de clúster para quitar la información de flujo del propietario de la copia de seguridad.

Observación 3. Capturar con traza muestra que ambas direcciones van solo a través de la unidad-1-1.

Paso 1. Identifique el flujo y los paquetes de interés en todas las unidades de agrupamiento basadas en el puerto de origen:

firepower# cluster exec show capture CAPI | i 45954

unit-1-1(LOCAL):******************************************************

1: 08:42:09.362697 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: S 992089269:992089269(0) win 29200 <mss 1460,sackOK,timestamp 495153655 0,nop,wscale 7>

2: 08:42:09.363521 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.45954: S 4042762409:4042762409(0) ack 992089270 win 28960 <mss 1380,sackOK,timestamp 505509125 495153655,nop,wscale 7>

3: 08:42:09.363827 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: . ack 4042762410 win 229 <nop,nop,timestamp 495153657 505509125>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower# cluster exec show capture CAPO | i 45954

unit-1-1(LOCAL):******************************************************

1: 08:42:09.362987 802.1Q vlan#202 P0 192.168.240.50.45954 > 192.168.241.50.80: S 2732339016:2732339016(0) win 29200 <mss 1380,sackOK,timestamp 495153655 0,nop,wscale 7>

2: 08:42:09.363415 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45954: S 3603655982:3603655982(0) ack 2732339017 win 28960 <mss 1460,sackOK,timestamp 505509125 495153655,nop,wscale 7>

3: 08:42:09.363903 802.1Q vlan#202 P0 192.168.240.50.45954 > 192.168.241.50.80: . ack 3603655983 win 229 <nop,nop,timestamp 495153657 505509125>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Paso 2. Dado que se trata de un flujo TCP, realice un seguimiento de los paquetes de entrada en contacto de 3 vías. Como se puede ver en esta salida, la unidad-1-1 es el propietario. Para simplificar, se omiten las fases de seguimiento no relevantes:

firepower# show cap CAPI packet-number 1 trace

25985 packets captured

1: 08:42:09.362697 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: S 992089269:992089269(0) win 29200 <mss 1460,sackOK,timestamp 495153655 0,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

...

El tráfico de retorno (TCP SYN/ACK):

firepower# show capture CAPO packet-number 2 trace

25985 packets captured

2: 08:42:09.363415 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45954: S 3603655982:3603655982(0) ack 2732339017 win 28960 <mss 1460,sackOK,timestamp 505509125 495153655,nop,wscale 7>

...

Phase: 3

Type: FLOW-LOOKUP

Subtype:

Result: ALLOW

Config:

Additional Information:

Found flow with id 9364, using existing flow

Observación 4. Los syslogs del plano de datos FTD muestran la creación y terminación de la conexión en todas las unidades:

firepower# cluster exec show log | include 45954

unit-1-1(LOCAL):******************************************************

Dec 01 2020 08:42:09: %FTD-6-302013: Built inbound TCP connection 9364 for INSIDE:192.168.240.50/45954 (192.168.240.50/45954) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 08:42:18: %FTD-6-302014: Teardown TCP connection 9364 for INSIDE:192.168.240.50/45954 to OUTSIDE:192.168.241.50/80 duration 0:00:08 bytes 1024000440 TCP FINs from INSIDE

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Dec 01 2020 08:42:09: %FTD-6-302022: Built backup stub TCP connection for INSIDE:192.168.240.50/45954 (192.168.240.50/45954) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 08:42:18: %FTD-6-302023: Teardown backup TCP connection for INSIDE:192.168.240.50/45954 to OUTSIDE:192.168.241.50/80 duration 0:00:08 forwarded bytes 0 Cluster flow with CLU closed on owner

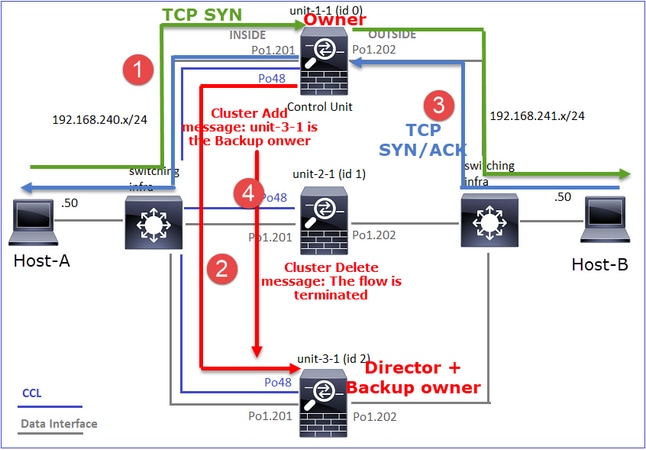

Caso práctico 2. Tráfico simétrico (el propietario es distinto del director)

- Igual que en el caso práctico #1, pero en este caso práctico, el propietario de un flujo es una unidad diferente a la del director.

- Todos los resultados son similares al caso práctico #1. La diferencia principal en comparación con el caso práctico #1 es el indicador "Y" que sustituye al indicador "y" del escenario 1.

Observación 1. El propietario es diferente del director.

Análisis del indicador de conexión para el flujo con el puerto de origen 46278.

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 2 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46278, idle 0:00:00, bytes 508848268, flags UIO N1

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46276, idle 0:00:03, bytes 0, flags aA N1

unit-2-1:*************************************************************

21 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 5 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 NP Identity Ifc 192.168.240.50:46276, idle 0:00:02, bytes 0, flags z

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46278, idle 0:00:06, bytes 0, flags Y

| Unidad |

Indicador |

Nota |

| Unidad-1-1 |

UIO |

· Propietario de flujo: la unidad maneja el flujo |

| Unidad-2-1 |

- |

- |

| Unidad-3-1 |

S |

· Director y Propietario de Respaldo - La Unidad 3-1 tiene el indicador Y (Director). |

Esto se puede visualizar como:

- El paquete TCP SYN llega del Host-A a la unidad-1-1. La unidad-1-1 se convierte en el propietario del flujo.

- La Unidad 3-1 es elegida como el director de flujo. Unit-3-1 también es el propietario de la copia de seguridad (mensaje 'cluster add' en UDP 4193 sobre CCL).

- El paquete TCP SYN/ACK llega del Host B a la unidad 3-1. El flujo es simétrico.

- Una vez que se termina la conexión, el propietario envía a través de CCL un mensaje de 'eliminación de clúster' en UDP 4193 para eliminar la información de flujo del propietario de la copia de seguridad.

Observación 2. La captura con traza muestra que ambas direcciones pasan solamente por la unidad-1-1

Paso 1. Utilice el mismo enfoque que en el caso práctico 1 para identificar el flujo y los paquetes de interés en todas las unidades de clúster basadas en el puerto de origen:

firepower# cluster exec show cap CAPI | include 46278

unit-1-1(LOCAL):******************************************************

3: 11:01:44.841631 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: S 1972783998:1972783998(0) win 29200 <mss 1460,sackOK,timestamp 503529072 0,nop,wscale 7>

4: 11:01:44.842317 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3524167695:3524167695(0) ack 1972783999 win 28960 <mss 1380,sackOK,timestamp 513884542 503529072,nop,wscale 7>

5: 11:01:44.842592 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: . ack 3524167696 win 229 <nop,nop,timestamp 503529073 513884542>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

Captura en la interfaz EXTERNA:

firepower# cluster exec show cap CAPO | include 46278

unit-1-1(LOCAL):******************************************************

3: 11:01:44.841921 802.1Q vlan#202 P0 192.168.240.50.46278 > 192.168.241.50.80: S 2153055699:2153055699(0) win 29200 <mss 1380,sackOK,timestamp 503529072 0,nop,wscale 7>

4: 11:01:44.842226 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3382481337:3382481337(0) ack 2153055700 win 28960 <mss 1460,sackOK,timestamp 513884542 503529072,nop,wscale 7>

5: 11:01:44.842638 802.1Q vlan#202 P0 192.168.240.50.46278 > 192.168.241.50.80: . ack 3382481338 win 229 <nop,nop,timestamp 503529073 513884542>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

Paso 2. Enfoque en los paquetes de ingreso (TCP SYN y TCP SYN/ACK):

firepower# cluster exec show cap CAPI packet-number 3 trace

unit-1-1(LOCAL):******************************************************

824 packets captured

3: 11:01:44.841631 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: S 1972783998:1972783998(0) win 29200 <mss 1460,sackOK,timestamp 503529072 0,nop,wscale 7>

…

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

Rastree el SYN/ACK en la unidad-1-1:

firepower# cluster exec show cap CAPO packet-number 4 trace

unit-1-1(LOCAL):******************************************************

4: 11:01:44.842226 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3382481337:3382481337(0) ack 2153055700 win 28960 <mss 1460,sackOK,timestamp 513884542 503529072,nop,wscale 7>

Phase: 3

Type: FLOW-LOOKUP

Subtype:

Result: ALLOW

Config:

Additional Information:

Found flow with id 9583, using existing flow

Observación 3. Los syslogs del plano de datos FTD muestran la creación y terminación de la conexión en propietario y propietario de respaldo:

firepower# cluster exec show log | include 46278

unit-1-1(LOCAL):******************************************************

Dec 01 2020 11:01:44: %FTD-6-302013: Built inbound TCP connection 9583 for INSIDE:192.168.240.50/46278 (192.168.240.50/46278) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 11:01:53: %FTD-6-302014: Teardown TCP connection 9583 for INSIDE:192.168.240.50/46278 to OUTSIDE:192.168.241.50/80 duration 0:00:08 bytes 1024001808 TCP FINs from INSIDE

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Dec 01 2020 11:01:44: %FTD-6-302022: Built director stub TCP connection for INSIDE:192.168.240.50/46278 (192.168.240.50/46278) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 11:01:53: %FTD-6-302023: Teardown director TCP connection for INSIDE:192.168.240.50/46278 to OUTSIDE:192.168.241.50/80 duration 0:00:08 forwarded bytes 0 Cluster flow with CLU closed on owner

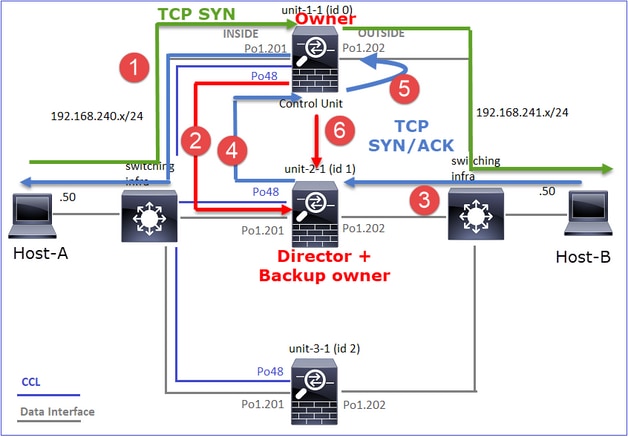

Caso práctico 3. Tráfico asimétrico (director reenvía el tráfico).

Observación 1. Las capturas de reinyección-ocultación muestran paquetes en la unidad-1-1 y la unidad-2-1 (flujo asimétrico):

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33554320 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99932 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33553268 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Capturing - 53815 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Capturing - 658 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Capturing - 658 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

Observación 2. Análisis del indicador de conexión para el flujo con el puerto de origen 46502.

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 2 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46502, idle 0:00:00, bytes 448760236, flags UIO N1

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46500, idle 0:00:06, bytes 0, flags aA N1

unit-2-1:*************************************************************

21 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 1 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46502, idle 0:00:00, bytes 0, flags Y

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 5 most used

dir connections: 0 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

| Unidad |

Indicador |

Nota |

| Unidad-1-1 |

UIO |

· Propietario de flujo: la unidad maneja el flujo. |

| Unidad-2-1 |

S |

· Director: dado que la unidad-2-1 tiene el indicador "Y", esto implica que la unidad-2-1 fue elegida como el director para este flujo. · Propietario de respaldo · Finalmente, aunque no es obvio a partir de esta salida, a partir de las salidas show capture y show log es evidente que la unidad-2-1 reenvía este flujo al propietario (aunque técnicamente no se considera un reenviador en este escenario). Nota: Una unidad no puede ser tanto director (flujo Y) como reenviador (flujo z), estas dos funciones se excluyen mutuamente. Los directores (flujo Y) aún pueden reenviar tráfico. Vea el resultado de show log más adelante en este caso práctico. |

| Unidad-3-1 |

- |

- |

Esto se puede visualizar como:

- El paquete TCP SYN llega del Host-A a la unidad-1-1. La unidad-1-1 se convierte en el propietario del flujo.

- La Unidad 2-1 se elige como director de flujo y propietario de la copia de seguridad. El propietario del flujo envía un mensaje de unidifusión 'cluster add' en UDP 4193 para informar al propietario de la copia de seguridad sobre el flujo.

- El paquete TCP SYN/ACK llega del Host B a la unidad 2-1. El flujo es asimétrico.

- Unit-2-1 reenvía el paquete a través de CCL al propietario (debido a TCP SYN Cookie).

- El propietario reinyecta el paquete en la interfaz OUTSIDE y luego reenvía el paquete hacia el Host-A.

- Una vez finalizada la conexión, el propietario envía un mensaje de eliminación de clúster para quitar la información de flujo del propietario de la copia de seguridad.

Observación 3. La captura con traza muestra el tráfico asimétrico y la redirección de la unidad-2-1 a la unidad-1-1.

Paso 1. Identifique los paquetes que pertenecen al flujo de interés (puerto 46502):

firepower# cluster exec show capture CAPI | include 46502

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356121 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: S 4124514680:4124514680(0) win 29200 <mss 1460,sackOK,timestamp 510537534 0,nop,wscale 7>

4: 12:58:33.357037 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.46502: S 883000451:883000451(0) ack 4124514681 win 28960 <mss 1380,sackOK,timestamp 520893004 510537534,nop,wscale 7>

5: 12:58:33.357357 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: . ack 883000452 win 229 <nop,nop,timestamp 510537536 520893004>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Dirección de retorno:

firepower# cluster exec show capture CAPO | include 46502

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356426 802.1Q vlan#202 P0 192.168.240.50.46502 > 192.168.241.50.80: S 1434968587:1434968587(0) win 29200 <mss 1380,sackOK,timestamp 510537534 0,nop,wscale 7>

4: 12:58:33.356915 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

5: 12:58:33.357403 802.1Q vlan#202 P0 192.168.240.50.46502 > 192.168.241.50.80: . ack 4257314723 win 229 <nop,nop,timestamp 510537536 520893004>

unit-2-1:*************************************************************

1: 12:58:33.359249 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

2: 12:58:33.360302 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: . ack 1434968736 win 235 <nop,nop,timestamp 520893005 510537536>

3: 12:58:33.361004 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: . 4257314723:4257316091(1368) ack 1434968736 win 235 <nop,nop,timestamp 520893006 510537536>

…

unit-3-1:*************************************************************

Paso 2. Seguimiento de los paquetes. De forma predeterminada, sólo se realiza un seguimiento de los primeros 50 paquetes de ingreso. Para simplificar, se omiten las fases de seguimiento no relevantes.

Unidad-1-1 (propietario):

firepower# cluster exec show capture CAPI packet-number 3 trace

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356121 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: S 4124514680:4124514680(0) win 29200 <mss 1460,sackOK,timestamp 510537534 0,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

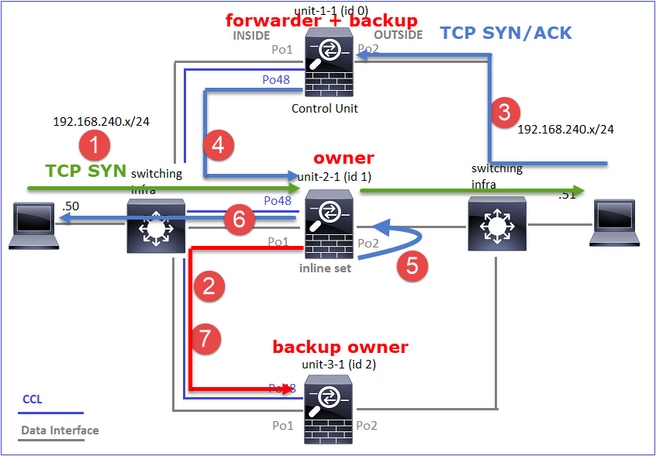

Unidad 2-1 (reenviador)

El tráfico de retorno (TCP SYN/ACK). La unidad de interés es la unidad-2-1, que es el director/propietario de la copia de seguridad y reenvía el tráfico al propietario:

firepower# cluster exec unit unit-2-1 show capture CAPO packet-number 1 trace

1: 12:58:33.359249 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) am early redirecting to (0) due to matching action (-1).

Observación 4. Los syslogs del plano de datos FTD muestran la creación y terminación de la conexión en todas las unidades:

firepower# cluster exec show log | i 46502

unit-1-1(LOCAL):******************************************************

Dec 01 2020 12:58:33: %FTD-6-302013: Built inbound TCP connection 9742 for INSIDE:192.168.240.50/46502 (192.168.240.50/46502) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 12:59:02: %FTD-6-302014: Teardown TCP connection 9742 for INSIDE:192.168.240.50/46502 to OUTSIDE:192.168.241.50/80 duration 0:00:28 bytes 2048000440 TCP FINs from INSIDE

unit-2-1:*************************************************************

Dec 01 2020 12:58:33: %FTD-6-302022: Built forwarder stub TCP connection for OUTSIDE:192.168.241.50/80 (192.168.241.50/80) to unknown:192.168.240.50/46502 (192.168.240.50/46502)

Dec 01 2020 12:58:33: %FTD-6-302023: Teardown forwarder TCP connection for OUTSIDE:192.168.241.50/80 to unknown:192.168.240.50/46502 duration 0:00:00 forwarded bytes 0 Forwarding or redirect flow removed to create director or backup flow

Dec 01 2020 12:58:33: %FTD-6-302022: Built director stub TCP connection for INSIDE:192.168.240.50/46502 (192.168.240.50/46502) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)