Configuración de L3out entre Sitios con Fabric de Varios Sitios ACI

Opciones de descarga

-

ePub (13.4 MB)

Visualice en diferentes aplicaciones en iPhone, iPad, Android, Sony Reader o Windows Phone -

Mobi (Kindle) (5.8 MB)

Visualice en dispositivo Kindle o aplicación Kindle en múltiples dispositivos

Lenguaje no discriminatorio

El conjunto de documentos para este producto aspira al uso de un lenguaje no discriminatorio. A los fines de esta documentación, "no discriminatorio" se refiere al lenguaje que no implica discriminación por motivos de edad, discapacidad, género, identidad de raza, identidad étnica, orientación sexual, nivel socioeconómico e interseccionalidad. Puede haber excepciones en la documentación debido al lenguaje que se encuentra ya en las interfaces de usuario del software del producto, el lenguaje utilizado en función de la documentación de la RFP o el lenguaje utilizado por un producto de terceros al que se hace referencia. Obtenga más información sobre cómo Cisco utiliza el lenguaje inclusivo.

Acerca de esta traducción

Cisco ha traducido este documento combinando la traducción automática y los recursos humanos a fin de ofrecer a nuestros usuarios en todo el mundo contenido en su propio idioma. Tenga en cuenta que incluso la mejor traducción automática podría no ser tan precisa como la proporcionada por un traductor profesional. Cisco Systems, Inc. no asume ninguna responsabilidad por la precisión de estas traducciones y recomienda remitirse siempre al documento original escrito en inglés (insertar vínculo URL).

Contenido

Introducción

Este documento describe los pasos para la configuración L3out entre sitios con el fabric multisitio de Cisco Application Centric Infrastructure (ACI).

Prerequisites

Requirements

Cisco recomienda que tenga conocimiento sobre estos temas:

- Configuración funcional del fabric de varios sitios de ACI

- Router externo/conectividad

Componentes Utilizados

La información de este documento se basa en:

-

Multi-Site Orchestrator (MSO) versión 2.2(1) o posterior

-

ACI versión 4.2(1) o posterior

- nodos MSO

- fabrics ACI

- Switch Nexus serie 9000 (N9K) (simulación de dispositivo externo de host final y L3out)

- Switch Nexus serie 9000 (N9K) (red entre sitios (ISN))

The information in this document was created from the devices in a specific lab environment. All of the devices used in this document started with a cleared (default) configuration. Si tiene una red en vivo, asegúrese de entender el posible impacto de cualquier comando.

Antecedentes

Esquemas Soportados para la Configuración Intersite L3out

Schema-config1

- Arrendatario que se extiende entre emplazamientos (A y B).

- Routing y reenvío virtuales (VRF) entre sitios (A y B).

- Grupo de terminales (EPG)/Dominio de puente (BD) local a un sitio (A).

- L3out local a otro sitio (B).

- EPG externo de L3out local a sitio (B).

- Creación y configuración de contratos realizada desde MSO.

Schema-config2

- Arrendatario que se extiende entre emplazamientos (A y B).

- VRF se extiende entre los sitios (A y B).

- EPG/BD se estira entre sitios (A y B).

- L3out local a un sitio (B).

- EPG externo de L3out local a sitio (B).

- La configuración del contrato se puede realizar desde MSO o cada sitio tiene una creación de contrato local desde Application Policy Infrastructure Controller (APIC) y se conecta localmente entre el EPG extendido y el EPG externo L3out. En este caso, Shadow External_EPG aparece en el sitio A porque es necesario para la relación de contratos local y las implementaciones de políticas.

Schema-config3

- Arrendatario que se extiende entre emplazamientos (A y B).

- VRF se extiende entre los sitios (A y B).

- EPG/BD se estira entre sitios (A y B).

- L3out local a un sitio (B).

- EPG externo de L3out entre sitios (A y B).

- La configuración del contrato se puede realizar desde MSO, o cada sitio tiene una creación de contrato local desde APIC y se conecta localmente entre el EPG extendido y el EPG externo extendido.

Schema-config4

- Arrendatario que se extiende entre emplazamientos (A y B).

- VRF se extiende entre los sitios (A y B).

- EPG/BD local a un sitio (A) o EPG/BD local a cada sitio (EPG-A en el sitio A y EPG-B en el sitio B).

- L3out local a un sitio (B), o para redundancia hacia conectividad externa puede tener L3out local a cada sitio (local al sitio A y local al sitio B).

- EPG externo de L3out entre sitios (A y B).

- La configuración del contrato se puede realizar desde MSO o cada sitio tiene una creación de contrato local desde APIC y se conecta localmente entre EPG estirado y EPG externo extendido.

Schema-config5 (routing de tránsito)

- Arrendatario que se extiende entre emplazamientos (A y B).

- VRF se extiende entre los sitios (A y B).

- L3out local a cada sitio (local al sitio A y local al sitio B).

- EPG externo de local a cada sitio (A y B).

- La configuración del contrato se puede realizar desde MSO o cada sitio tiene una creación de contrato local desde APIC y se conecta localmente entre el local EPG externo y el local EPG externo de sombra.

Schema-config5 (InterVRF Transit Routing)

- Arrendatario que se extiende entre emplazamientos (A y B).

- VRF local a cada sitio (A y B).

- L3out local a cada sitio (local al sitio A y local al sitio B).

- EPG externo de local a cada sitio (A y B).

- La configuración del contrato se puede realizar desde MSO o cada sitio tiene una creación de contrato local desde APIC y se conecta localmente entre el local EPG externo y el local EPG externo de sombra.

Nota: Este documento proporciona pasos básicos de configuración y verificación de L3out entre sitios. En este ejemplo, se utiliza Schema-config1.

Configurar

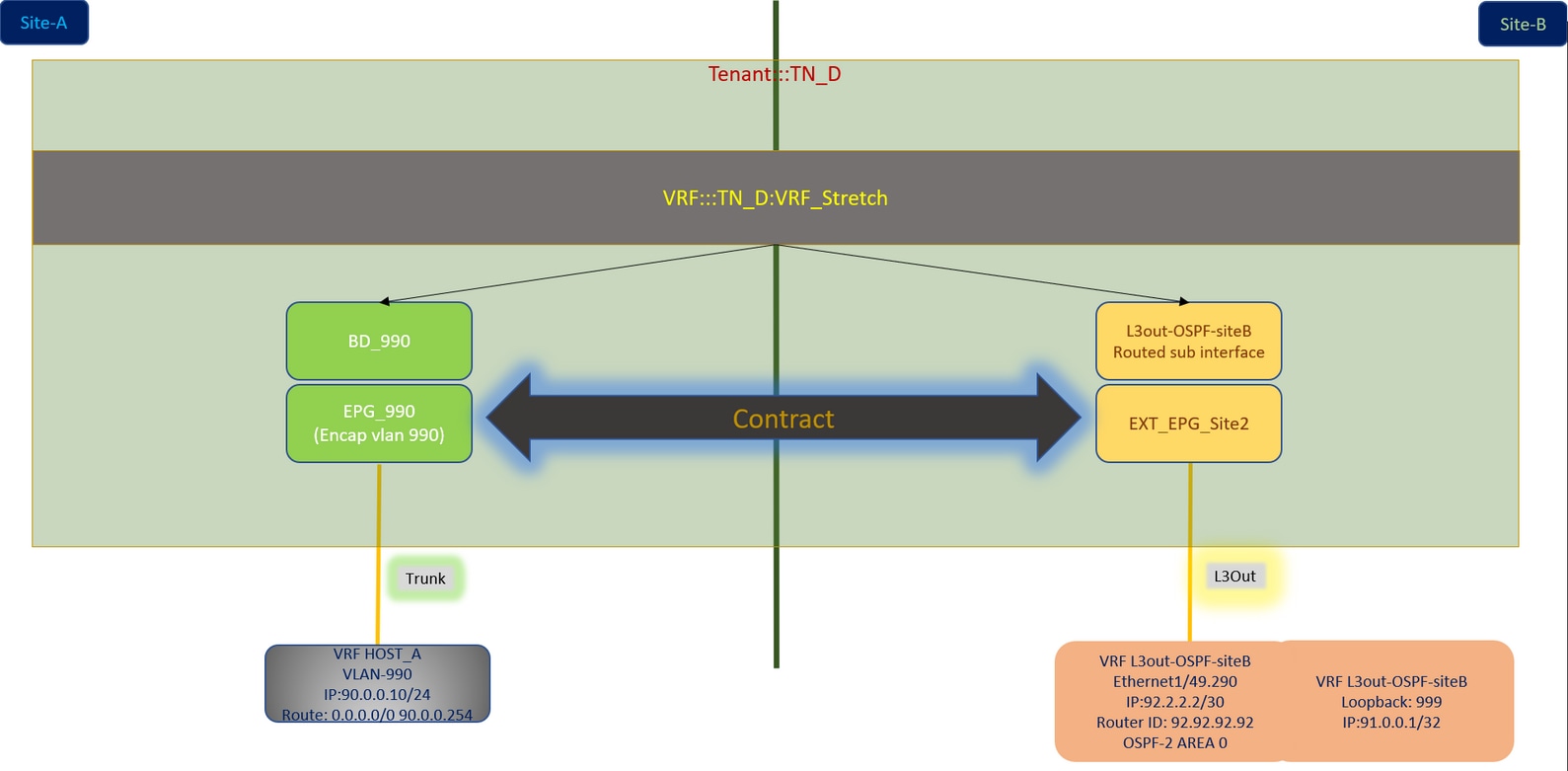

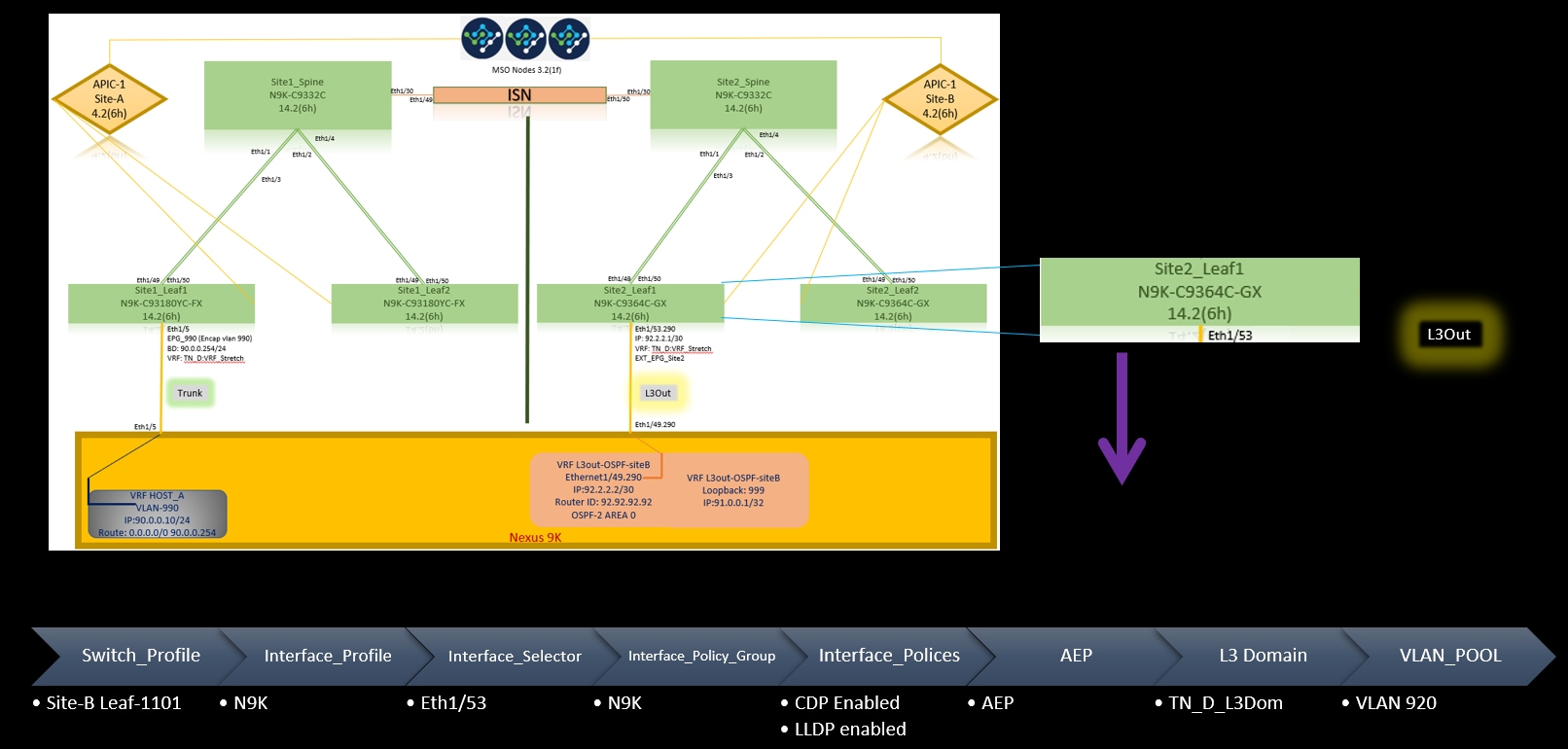

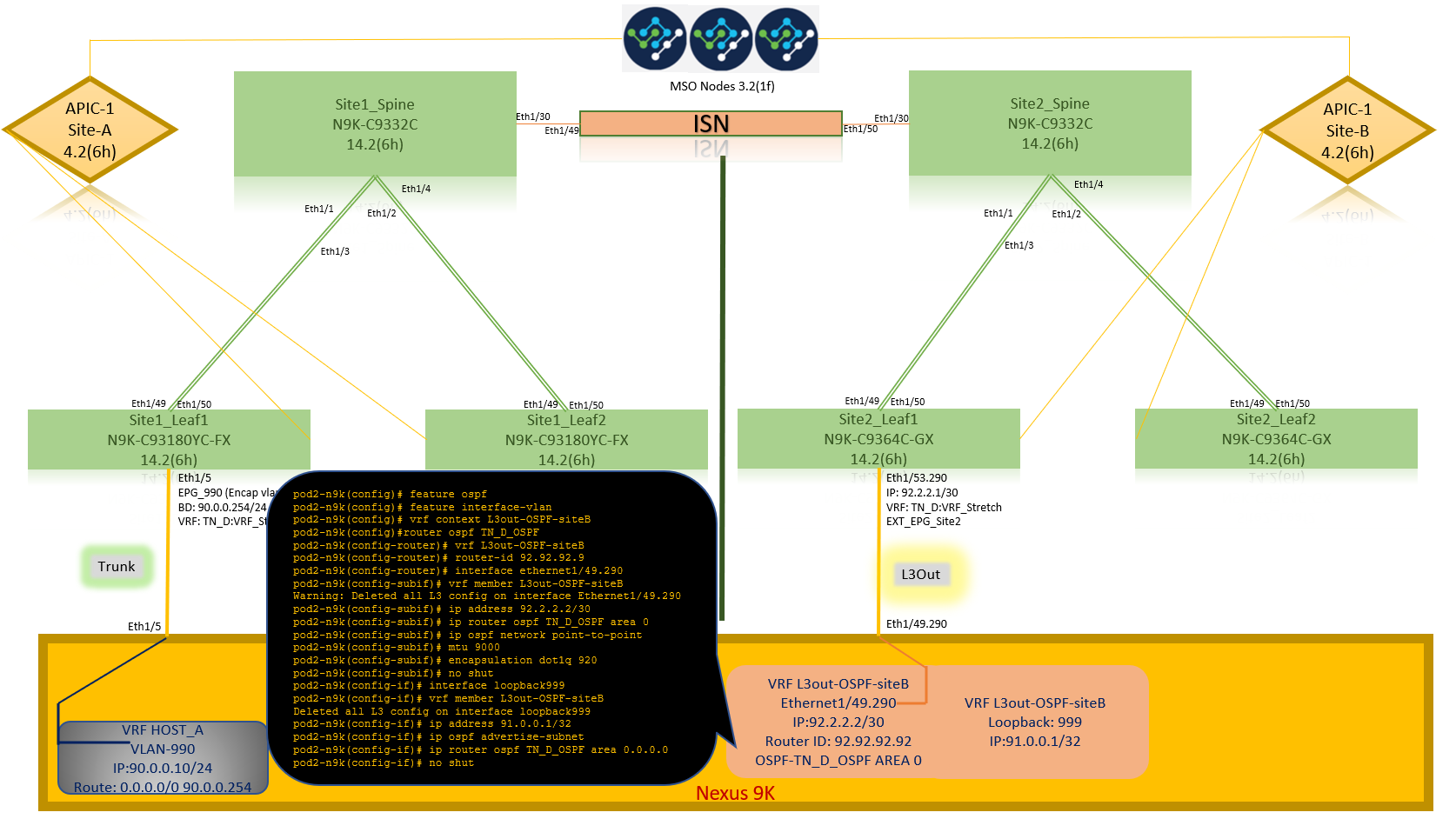

Diagramas de la Red

Topología física

Topología lógica

Configuraciones

En este ejemplo, utilizamos Schema-config1. Sin embargo, esta configuración se puede completar de forma similar (con cambios menores según la relación de contrato) para otras configuraciones de esquema admitidas, excepto que el objeto extendido debe estar en la plantilla extendida en lugar de en la plantilla de sitio específica.

Configurar Schema-config1

- Arrendatario que se extiende entre emplazamientos (A y B).

- VRF se extiende entre los sitios (A y B).

- EPG/BD local a un sitio (A).

- L3out local a otro sitio (B).

- EPG externo de L3out local a sitio (B).

- Creación de contratos y configuraciones realizadas desde MSO.

Revise las Pautas y Limitaciones de L3Out entre Sitios.

-

Configuración no admitida con L3out entre sitios:

-

Receptores de multidifusión en un sitio que recibe multidifusión de una fuente externa a través de otro sitio L3out. La multidifusión recibida en un sitio desde una fuente externa nunca se envía a otros sitios. Cuando un receptor en un sitio recibe multicast de una fuente externa, se debe recibir en una L3out local.

-

Un origen de multidifusión interno envía una multidifusión a un receptor externo con PIM-SM cualquier multidifusión de origen (ASM). Un origen de multidifusión interno debe poder alcanzar un punto de encuentro externo (RP) desde un L3out local.

-

Giant OverLay Fabric (GOLF).

-

Grupos preferidos para EPG externo.

-

Configuración de las políticas de fabric

Las políticas de fabric en cada sitio son una configuración esencial, porque esas configuraciones de políticas están vinculadas a conexiones físicas L3out o de arrendatario/EPG/enlace de puerto estático específicos. Cualquier error de configuración con políticas de fabric puede conducir a un error en la configuración lógica de APIC o MSO, de ahí la configuración de política de fabric proporcionada que se utilizó en una configuración de laboratorio. Ayuda a comprender qué objeto está vinculado a qué objeto en MSO o APIC.

Host_A Connection Fabric Policies at Site-A

Políticas de fabric de conexión L3out en el sitio B

Paso opcional

Una vez que haya implementado políticas de fabric para las conexiones respectivas, puede asegurarse de que todas las hojas/columnas se descubran y se puedan alcanzar desde el clúster APIC correspondiente. A continuación, puede validar que ambos sitios (clústeres APIC) están accesibles desde MSO y la configuración de varios sitios está operativa (y la conectividad IPN).

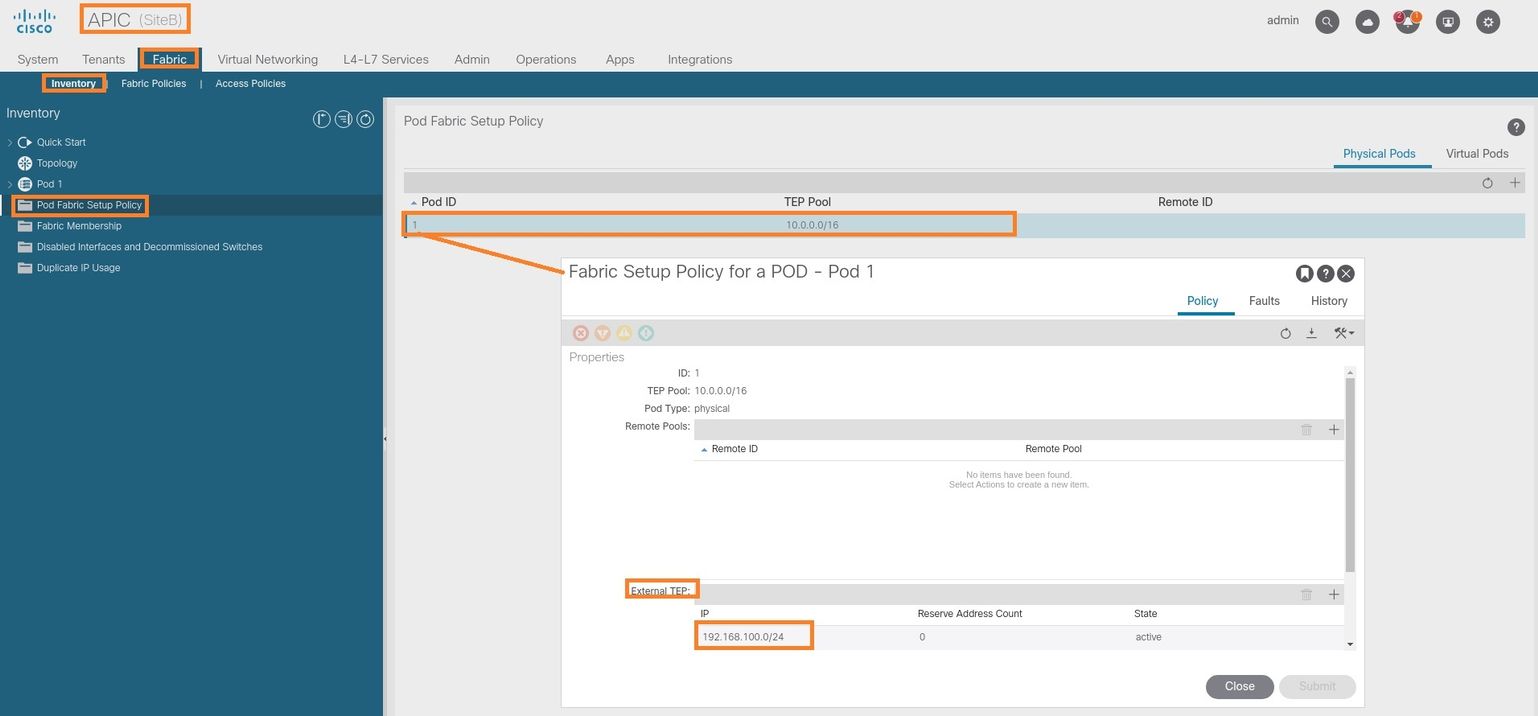

Configuración de RTEP/ETEP

El grupo de terminales de túnel enrutable (RTEP) o el grupo de terminales de túnel externo (ETEP) es la configuración necesaria para el L3out entre sitios. La versión anterior de MSO muestra "Grupos TEP enrutables" mientras que la versión más reciente de MSO muestra "Grupos TEP externos", pero ambos son sinónimos. Estos grupos TEP se utilizan para la VPN Ethernet (EVPN) de protocolo de gateway fronterizo (BGP) mediante VRF "Overlay-1".

Las rutas externas de L3out se anuncian a través de BGP EVPN hacia otro sitio. Este RTEP/ETEP también se utiliza para la configuración de hoja remota, por lo que si tiene una configuración ETEP/RTEP que ya existe en APIC, debe importarse en MSO.

Estos son los pasos para configurar ETEP desde la GUI de MSO. Dado que la versión es 3.X MSO, muestra ETEP. Los grupos ETEP deben ser únicos en cada sitio y no deben solaparse con ninguna subred EPG/BD interna de cada sitio.

Sitio A

Paso 1. En la página MSO GUI (abra el controlador multisitio en una página web), elija Infrastructure > Infra Configuration. Haga clic en Configurar Infra.

Paso 2. Dentro de Configure Infra, elija Site-A, Inside Site-A, elija pod-1. Luego, dentro del pod-1, configure Grupos TEP Externos con la dirección IP TEP externa para el Sitio-A. (En este ejemplo, es 192.168.200.0/24). Si tiene Multi-POD en el Sitio A, repita este paso para otros grupos de dispositivos.

Paso 3. Para verificar la configuración de los grupos ETEP en la GUI de APIC, elija Fabric > Inventory > Pod Fabric Setup Policy > Pod-ID (doble clic para abrir [Fabric Setup Policy a POD-Pod-x]) > External TEP.

También puede verificar la configuración con estos comandos:

moquery -c fabricExtRoutablePodSubnet

moquery -c fabricExtRoutablePodSubnet -f 'fabric.ExtRoutablePodSubnet.pool=="192.168.200.0/24"'

APIC1# moquery -c fabricExtRoutablePodSubnet Total Objects shown: 1 # fabric.ExtRoutablePodSubnet pool : 192.168.200.0/24 annotation : orchestrator:msc childAction : descr : dn : uni/controller/setuppol/setupp-1/extrtpodsubnet-[192.168.200.0/24] extMngdBy : lcOwn : local modTs : 2021-07-19T14:45:22.387+00:00 name : nameAlias : reserveAddressCount : 0 rn : extrtpodsubnet-[192.168.200.0/24] state : active status : uid : 0

Sitio B

Paso 1. Configure el grupo TEP externo para el sitio B (los mismos pasos que para el sitio A). En la página MSO GUI (abra el controlador multisitio en una página web), elija Infrastructure > Infra Configuration. Haga clic en Configurar Infra. Dentro de Configure Infra, elija Site-B. Dentro del Sitio B, elija pod-1. Luego, dentro del pod-1, configure Grupos TEP Externos con la dirección IP TEP externa para el Sitio-B. (En este ejemplo, es 192.168.100.0/24). Si tiene Multi-POD en el Sitio-B, repita este paso para otros grupos de dispositivos.

Paso 2. Para verificar la configuración de los grupos ETEP en la GUI de APIC, elija Fabric > Inventory > Pod Fabric Setup Policy > Pod-ID (doble clic para abrir [Fabric Setup Policy a POD-Pod-x]) > External TEP.

Para el APIC del Sitio B, ingrese este comando para verificar el conjunto de direcciones ETEP.

apic1# moquery -c fabricExtRoutablePodSubnet -f 'fabric.ExtRoutablePodSubnet.pool=="192.168.100.0/24"' Total Objects shown: 1 # fabric.ExtRoutablePodSubnet pool : 192.168.100.0/24 annotation : orchestrator:msc <<< This means, configuration pushed from MSO. childAction : descr : dn : uni/controller/setuppol/setupp-1/extrtpodsubnet-[192.168.100.0/24] extMngdBy : lcOwn : local modTs : 2021-07-19T14:34:18.838+00:00 name : nameAlias : reserveAddressCount : 0 rn : extrtpodsubnet-[192.168.100.0/24] state : active status : uid : 0

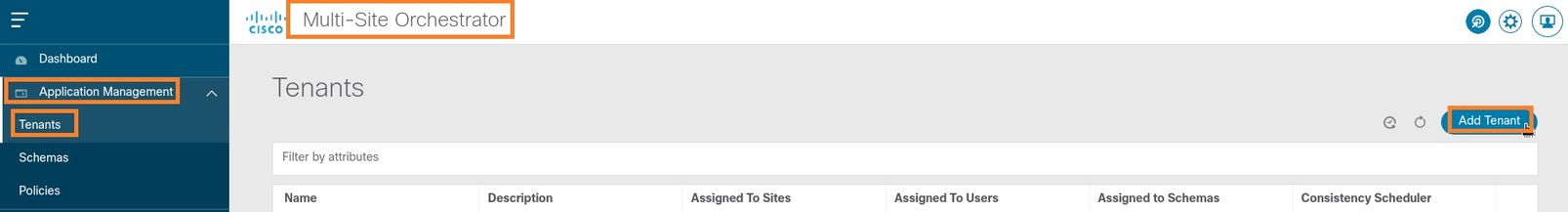

Configuración del arrendatario de extensión

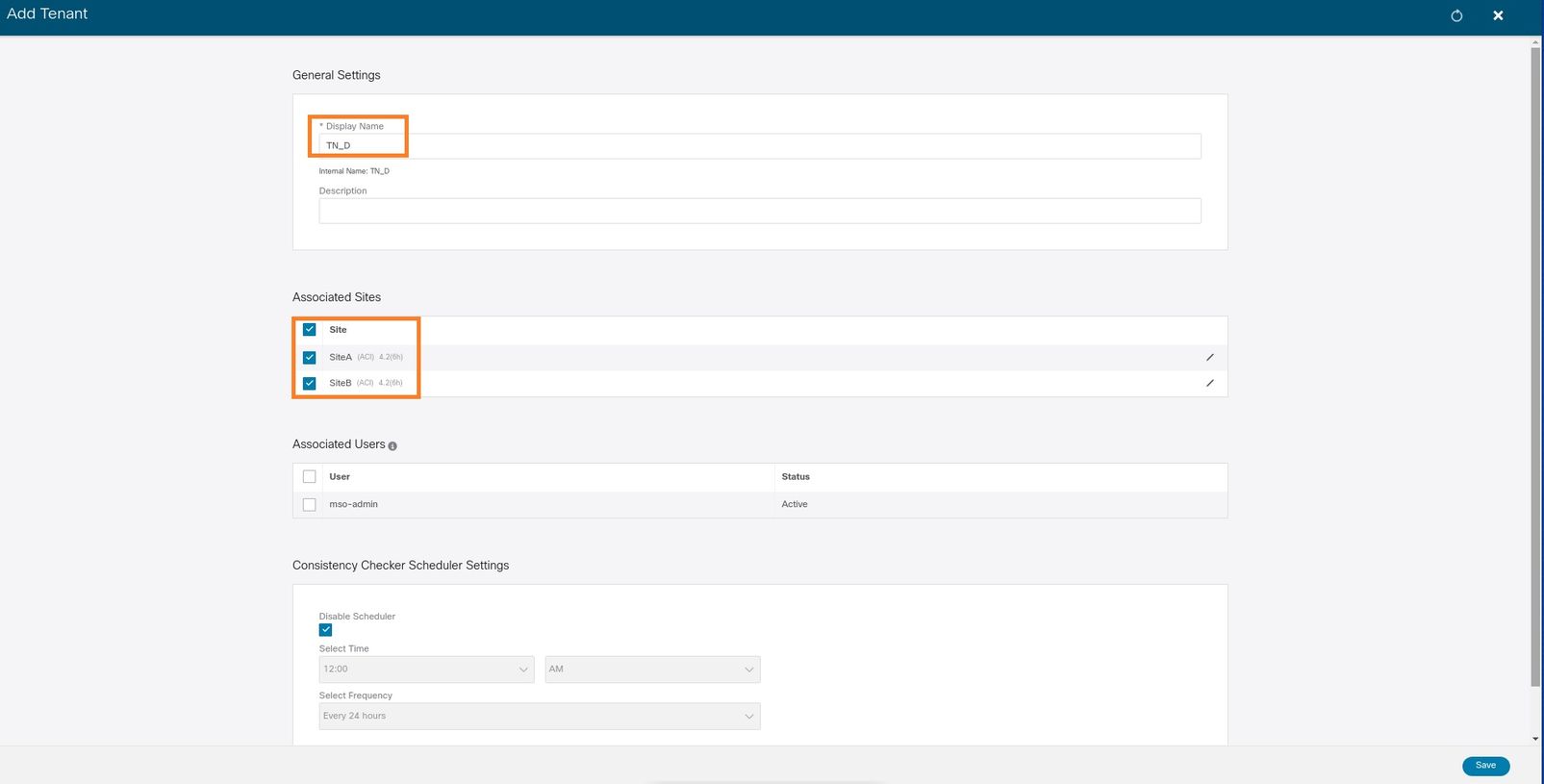

Paso 1. En la GUI de MSO, elija Administración de aplicaciones > Arrendatarios. Haga clic en Agregar arrendatario. En este ejemplo, el nombre del arrendatario es "TN_D".

Paso 2. En el campo Display Name, introduzca el nombre del arrendatario. En la sección Sitios asociados, active las casillas de verificación Sitio A y Sitio B.

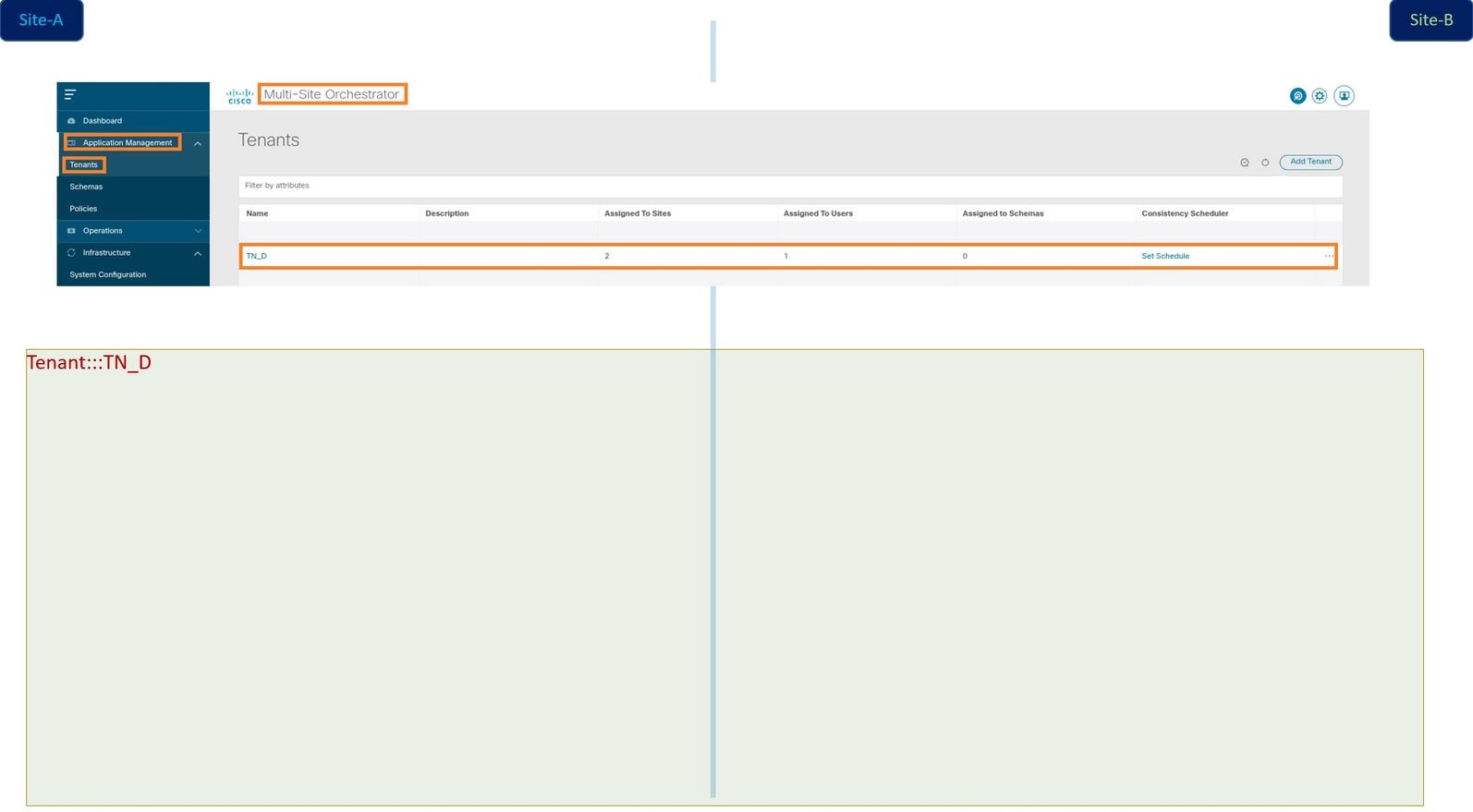

Paso 3. Verifique que se haya creado el nuevo arrendatario "Tn_D".

Vista lógica

Cuando creamos un arrendatario de MSO, básicamente crea un arrendatario en el Sitio A y el Sitio B. Se trata de un arrendatario de larga distancia. En este ejemplo se muestra una vista lógica de este arrendatario. Esta vista lógica ayuda a comprender que el arrendatario TN_D se extiende entre el Sitio A y el Sitio B.

Puede verificar la vista lógica en el APIC de cada sitio. Puede ver que el Sitio A y el Sitio B muestran el arrendatario "TN_D" creado.

El mismo arrendatario extendido "TN_D" también se crea en el Sitio-B.

Este comando muestra el arrendatario enviado desde MSO y puede utilizarlo con fines de verificación. Puede ejecutar este comando en el APIC de ambos sitios.

APIC1# moquery -c fvTenant -f 'fv.Tenant.name=="TN_D"' Total Objects shown: 1 # fv.Tenant name : TN_D annotation : orchestrator:msc childAction : descr : dn : uni/tn-TN_D extMngdBy : msc lcOwn : local modTs : 2021-09-17T21:42:52.218+00:00 monPolDn : uni/tn-common/monepg-default nameAlias : ownerKey : ownerTag : rn : tn-TN_D status : uid : 0

apic1# moquery -c fvTenant -f 'fv.Tenant.name=="TN_D"' Total Objects shown: 1 # fv.Tenant name : TN_D annotation : orchestrator:msc childAction : descr : dn : uni/tn-TN_D extMngdBy : msc lcOwn : local modTs : 2021-09-17T21:43:04.195+00:00 monPolDn : uni/tn-common/monepg-default nameAlias : ownerKey : ownerTag : rn : tn-TN_D status : uid : 0

Configuración del esquema

A continuación, cree un esquema con un total de tres plantillas:

- Plantilla para el Sitio A: La plantilla para el Sitio A sólo se asocia al Sitio A, por lo que cualquier configuración de objeto lógico de esa plantilla sólo puede enviar al APIC del Sitio A.

- Plantilla para el sitio B: La plantilla para el Sitio-B sólo se asocia al Sitio-B, por lo que cualquier configuración de objeto lógico en esa plantilla sólo puede empujar al APIC del Sitio-B.

- Plantilla extendida: La plantilla extendida se asocia a ambos sitios y cualquier configuración lógica de la plantilla extendida puede trasladarse a ambos sitios de APIC.

Crear el esquema

El esquema es localmente significativo en MSO, no crea ningún objeto en APIC. La configuración de esquema es la separación lógica de cada configuración. Puede tener varios esquemas para los mismos arrendatarios y también puede tener varias plantillas dentro de cada esquema.

Por ejemplo, puede tener un esquema para el servidor de base de datos para el arrendatario X y el servidor de aplicaciones utiliza un esquema diferente para el mismo arrendatario-X. Esto puede ayudar a separar cada configuración específica relacionada con la aplicación y es fácil cuando necesita depurar un problema. También es fácil encontrar información.

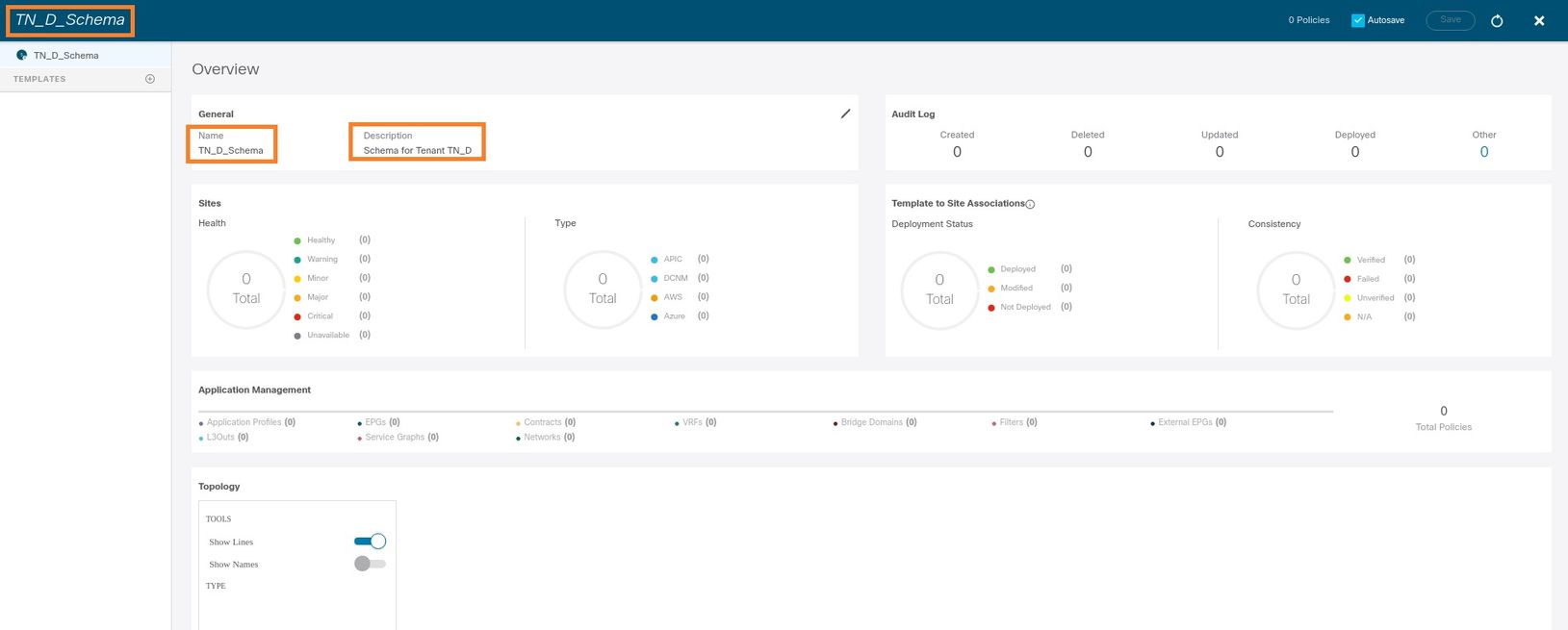

Cree un esquema con el nombre del arrendatario (por ejemplo, TN_D_Schema). Sin embargo, no es necesario que el nombre del esquema comience con el nombre del arrendatario, puede crear un esquema con cualquier nombre.

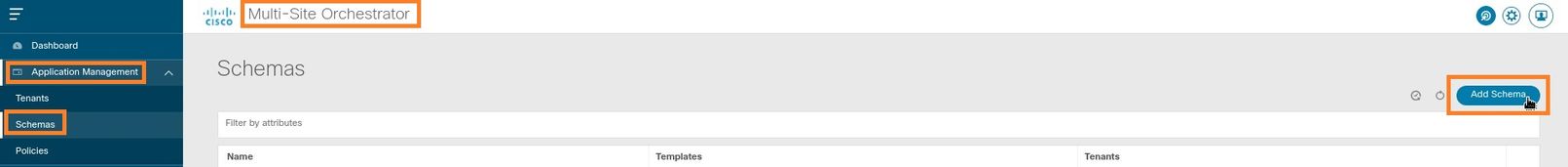

Paso 1. Elija Administración de aplicaciones > Esquemas. Haga clic en Agregar esquema.

Paso 2. En el campo Name, ingrese el nombre del esquema. En este ejemplo es "TN_D_Schema", sin embargo, puede mantener cualquier nombre que sea apropiado para su entorno. Haga clic en Add (Agregar).

Paso 3. Verifique que se haya creado el esquema "TN_D_Schema".

Creación de la plantilla Site-A

Paso 1. Agregue una plantilla dentro del esquema.

- Para crear una plantilla, haga clic en Plantillas bajo el esquema que ha creado. Se muestra el cuadro de diálogo Seleccionar un tipo de plantilla.

- Elija ACI Multi-cloud.

- Haga clic en Add (Agregar).

Paso 2. Introduzca un nombre para la plantilla. Esta plantilla es específica del Sitio A, de ahí el nombre de la plantilla "Plantilla del Sitio A". Una vez creada la plantilla, puede asociar un arrendatario específico a la plantilla. En este ejemplo, se adjunta el arrendatario "TN_D".

Configurar la plantilla

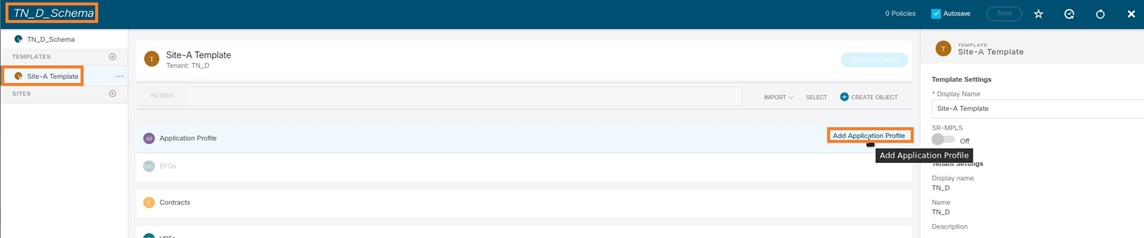

Configuración del perfil de aplicación

Paso 1. Del esquema que creó, elija Plantilla de Sitio A. Haga clic en Agregar perfil de aplicación.

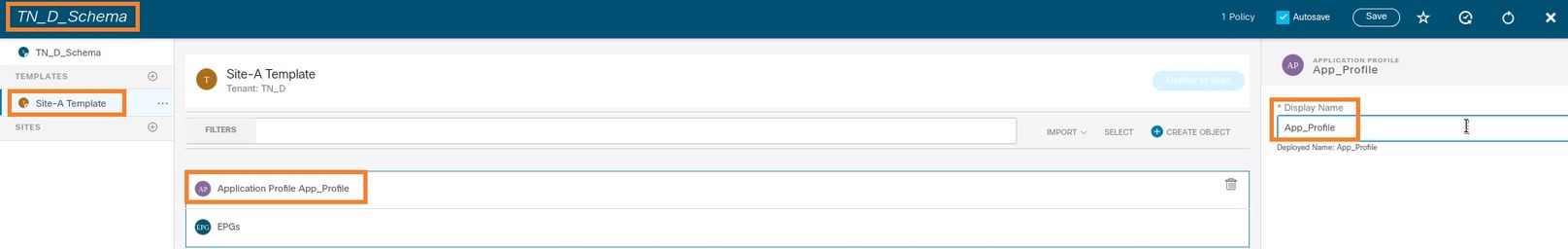

Paso 2. En el campo Display Name, ingrese el nombre del perfil de aplicación App_Profile.

Paso 3. El siguiente paso es crear EPG. Para agregar EPG en el perfil de aplicación, haga clic en Agregar EPG en la plantilla Sitio-A. Puede ver que se crea un nuevo EPG dentro de la configuración de EPG.

Paso 4. Para conectar EPG con BD y VRF, debe agregar BD y VRF en EPG. Elija Plantilla de Sitio A. En el campo Display Name, ingrese el nombre del EPG y adjunte un nuevo BD (puede crear un nuevo BD o adjuntar un BD existente).

Tenga en cuenta que debe asociar el VRF a un BD, pero el VRF se estira en este caso. Puede crear la plantilla extendida con VRF estirado y, a continuación, adjuntar ese VRF a BD en una plantilla específica del sitio (en nuestro caso, es plantilla del sitio A).

Crear la plantilla de extensión

Paso 1. Para crear la plantilla de extensión, en TN_D_Schema haga clic en Plantillas. Se muestra el cuadro de diálogo Seleccionar un tipo de plantilla. Elija ACI Multi-cloud. Haga clic en Add (Agregar). Ingrese el nombre Plantilla extendida para la plantilla. (Puede introducir cualquier nombre para la plantilla extendida.)

Paso 2. Elija Plantilla extendida y cree un VRF con el nombre VRF_Stretch. (Puede introducir cualquier nombre para VRF.)

El BD se creó con la creación de EPG en Plantilla de Sitio A, pero no había ningún VRF adjunto, por lo que debe adjuntar el VRF que ahora está creado en la Plantilla de Trama.

Paso 3. Elija Site-A Template > BD_990. En la lista desplegable Virtual Routing & Forwarding, elija VRF_Stretch. (El que creó en el paso 2 de esta sección.)

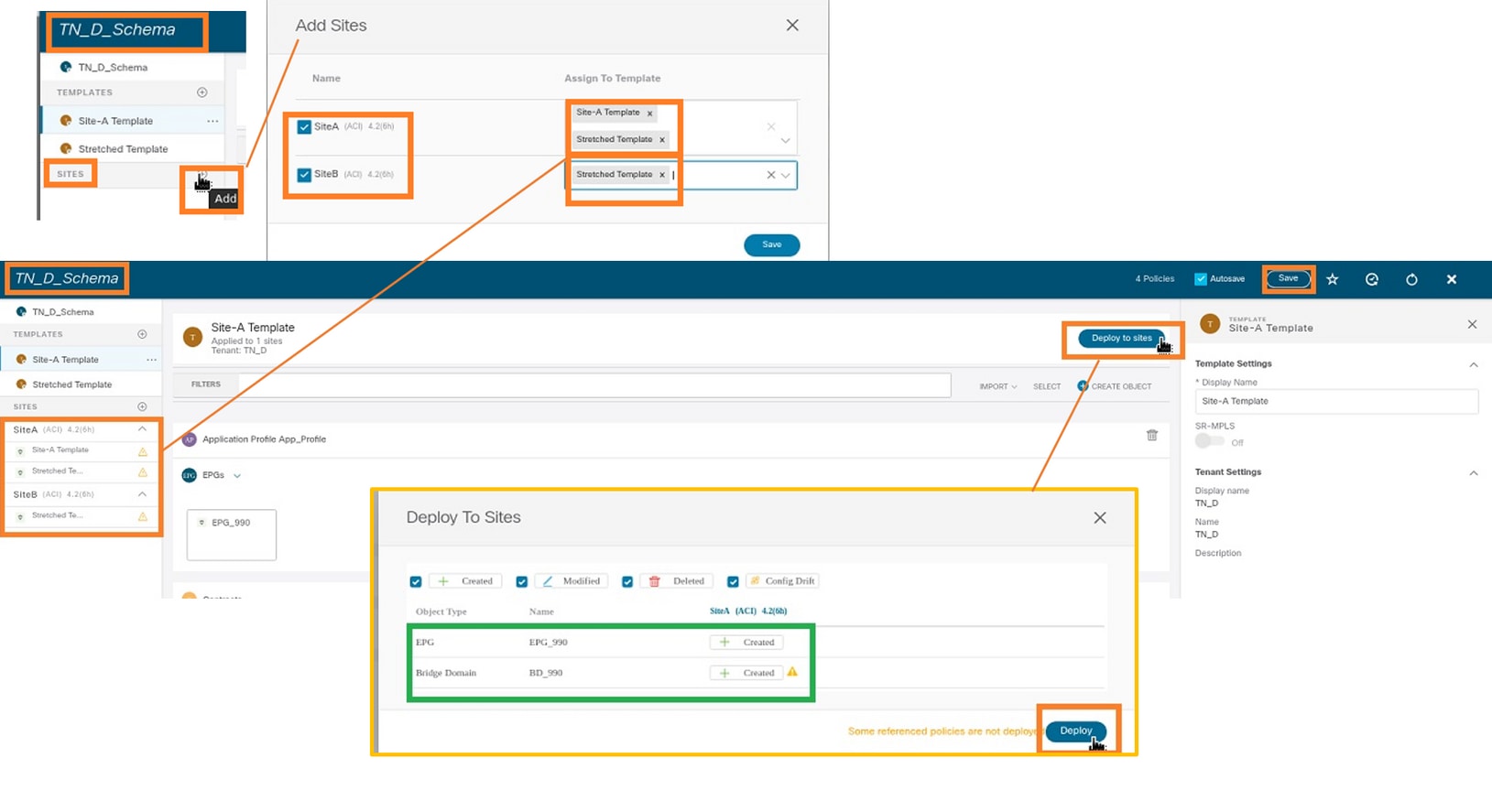

Asociar la plantilla

El siguiente paso es adjuntar la plantilla Site-A sólo con Site-A, y la plantilla extendida debe adjuntarse a ambos sitios. Haga clic en Implementar en el sitio dentro del esquema para implementar plantillas en los sitios respectivos.

Paso 1. Haga clic en el signo +bajo TN_D_Schema > SITES para agregar sitios a la plantilla. En la lista desplegable Asignar a plantilla, elija la plantilla correspondiente para los sitios apropiados.

Paso 2. Puede ver que el Sitio A tiene EPG y BD ahora creados, pero el Sitio B no tiene el mismo EPG/BD creado porque esa configuración sólo se aplica al Sitio A de MSO. Sin embargo, puede ver que el VRF se crea en la plantilla extendida por lo tanto se crea en ambos sitios.

Paso 3. Verifique la configuración con estos comandos.

APIC1# moquery -c fvAEPg -f 'fv.AEPg.name=="EPG_990"' Total Objects shown: 1 # fv.AEPg name : EPG_990 annotation : orchestrator:msc childAction : configIssues : configSt : applied descr : dn : uni/tn-TN_D/ap-App_Profile/epg-EPG_990 exceptionTag : extMngdBy : floodOnEncap : disabled fwdCtrl : hasMcastSource : no isAttrBasedEPg : no isSharedSrvMsiteEPg : no lcOwn : local matchT : AtleastOne modTs : 2021-09-18T08:26:49.906+00:00 monPolDn : uni/tn-common/monepg-default nameAlias : pcEnfPref : unenforced pcTag : 32770 prefGrMemb : exclude prio : unspecified rn : epg-EPG_990 scope : 2850817 shutdown : no status : triggerSt : triggerable txId : 1152921504609182523 uid : 0

APIC1# moquery -c fvBD -f 'fv.BD.name=="BD_990"'

Total Objects shown: 1

# fv.BD

name : BD_990

OptimizeWanBandwidth : yes

annotation : orchestrator:msc

arpFlood : yes

bcastP : 225.0.56.224

childAction :

configIssues :

descr :

dn : uni/tn-TN_D/BD-BD_990

epClear : no

epMoveDetectMode :

extMngdBy :

hostBasedRouting : no

intersiteBumTrafficAllow : yes

intersiteL2Stretch : yes

ipLearning : yes

ipv6McastAllow : no

lcOwn : local

limitIpLearnToSubnets : yes

llAddr : ::

mac : 00:22:BD:F8:19:FF

mcastAllow : no

modTs : 2021-09-18T08:26:49.906+00:00

monPolDn : uni/tn-common/monepg-default

mtu : inherit

multiDstPktAct : bd-flood

nameAlias :

ownerKey :

ownerTag :

pcTag : 16387

rn : BD-BD_990

scope : 2850817

seg : 16580488

status :

type : regular

uid : 0

unicastRoute : yes

unkMacUcastAct : proxy

unkMcastAct : flood

v6unkMcastAct : flood

vmac : not-applicable

: 0

APIC1# moquery -c fvCtx -f 'fv.Ctx.name=="VRF_Stretch"' Total Objects shown: 1 # fv.Ctx name : VRF_Stretch annotation : orchestrator:msc bdEnforcedEnable : no childAction : descr : dn : uni/tn-TN_D/ctx-VRF_Stretch extMngdBy : ipDataPlaneLearning : enabled knwMcastAct : permit lcOwn : local modTs : 2021-09-18T08:26:58.185+00:00 monPolDn : uni/tn-common/monepg-default nameAlias : ownerKey : ownerTag : pcEnfDir : ingress pcEnfDirUpdated : yes pcEnfPref : enforced pcTag : 16386 rn : ctx-VRF_Stretch scope : 2850817 seg : 2850817 status : uid : 0

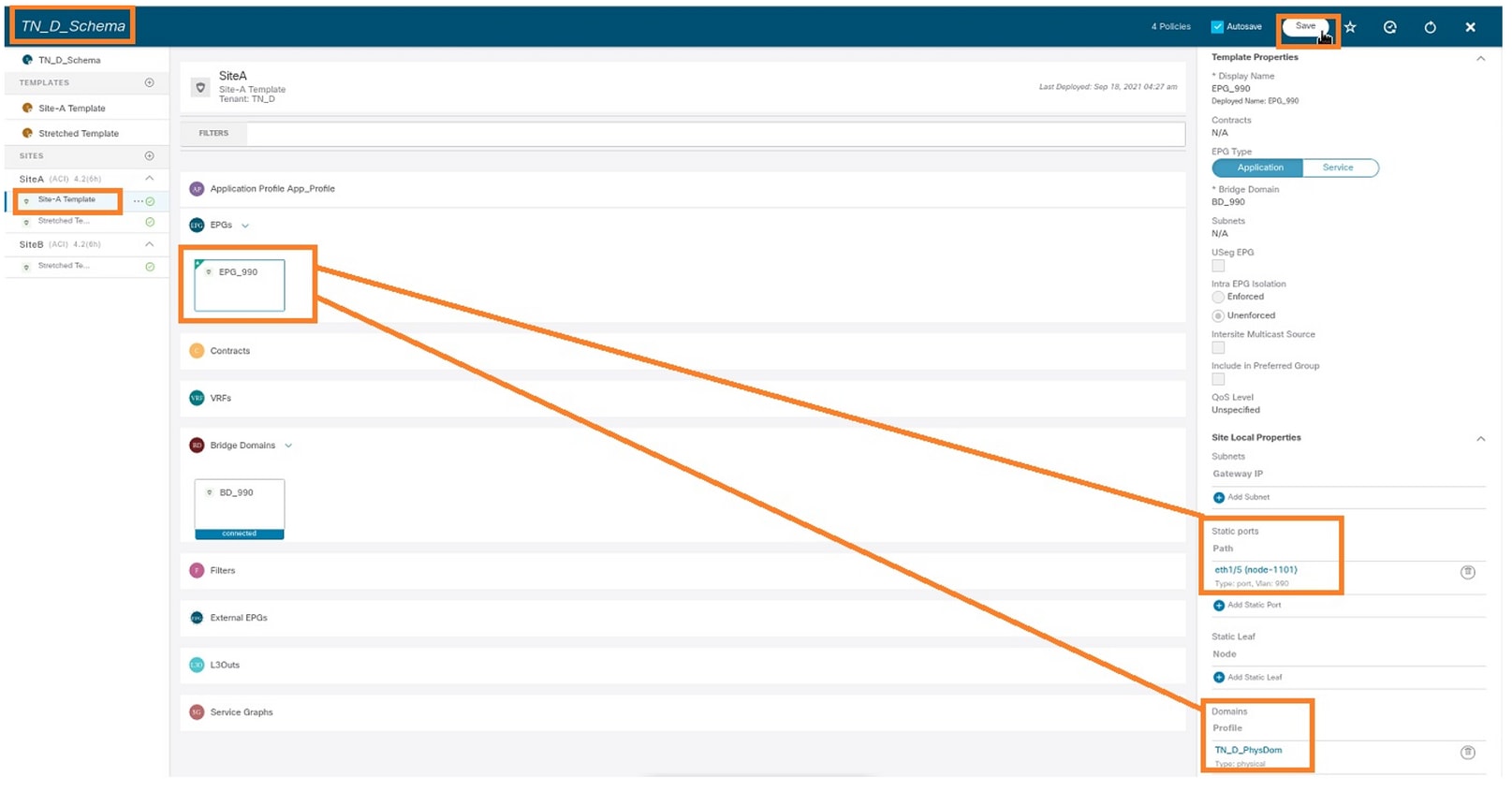

Configurar enlace de puerto estático

Ahora puede configurar el enlace de puerto estático bajo EPG "EPG_990" y también configurar el N9K con VRF HOST_A (básicamente simula HOST_A). La configuración de enlace de puerto estático del lado ACI se completará primero.

Paso 1. Agregue el dominio físico en EPG_990.

- Del esquema que creó, elija Plantilla de Sitio A > EPG_990.

- En el cuadro Propiedades de plantilla, haga clic en Agregar dominio.

- En el cuadro de diálogo Agregar dominio, elija estas opciones en las listas desplegables:

- Tipo de asociación de dominio - Físico

- Perfil de Dominio - TN_D_PhysDom

- Implementación inmediata: inmediata

- Resolución Inmediata - Inmediato

- Click Save.

Paso 2. Agregue el puerto estático (Site1_Leaf1 eth1/5).

- Del esquema que creó, elija Plantilla de Sitio A > EPG_990.

- En el cuadro Template Properties, haga clic en Add Static Port.

- En el cuadro de diálogo Agregar EPG estático en PC, VPC o interfaz, elija Node-101 eth1/5 y asigne VLAN 990.

Paso 3. Asegúrese de que los puertos estáticos y el dominio físico se agregan en EPG_990.

Verifique el enlace de trayectoria estática con este comando:

APIC1# moquery -c fvStPathAtt -f 'fv.StPathAtt.pathName=="eth1/5"' | grep EPG_990 -A 10 -B 5 # fv.StPathAtt pathName : eth1/5 childAction : descr : dn : uni/epp/fv-[uni/tn-TN_D/ap-App_Profile/epg-EPG_990]/node-1101/stpathatt-[eth1/5] lcOwn : local modTs : 2021-09-19T06:16:46.226+00:00 monPolDn : uni/tn-common/monepg-default name : nameAlias : ownerKey : ownerTag : rn : stpathatt-[eth1/5] status :

Configurar BD

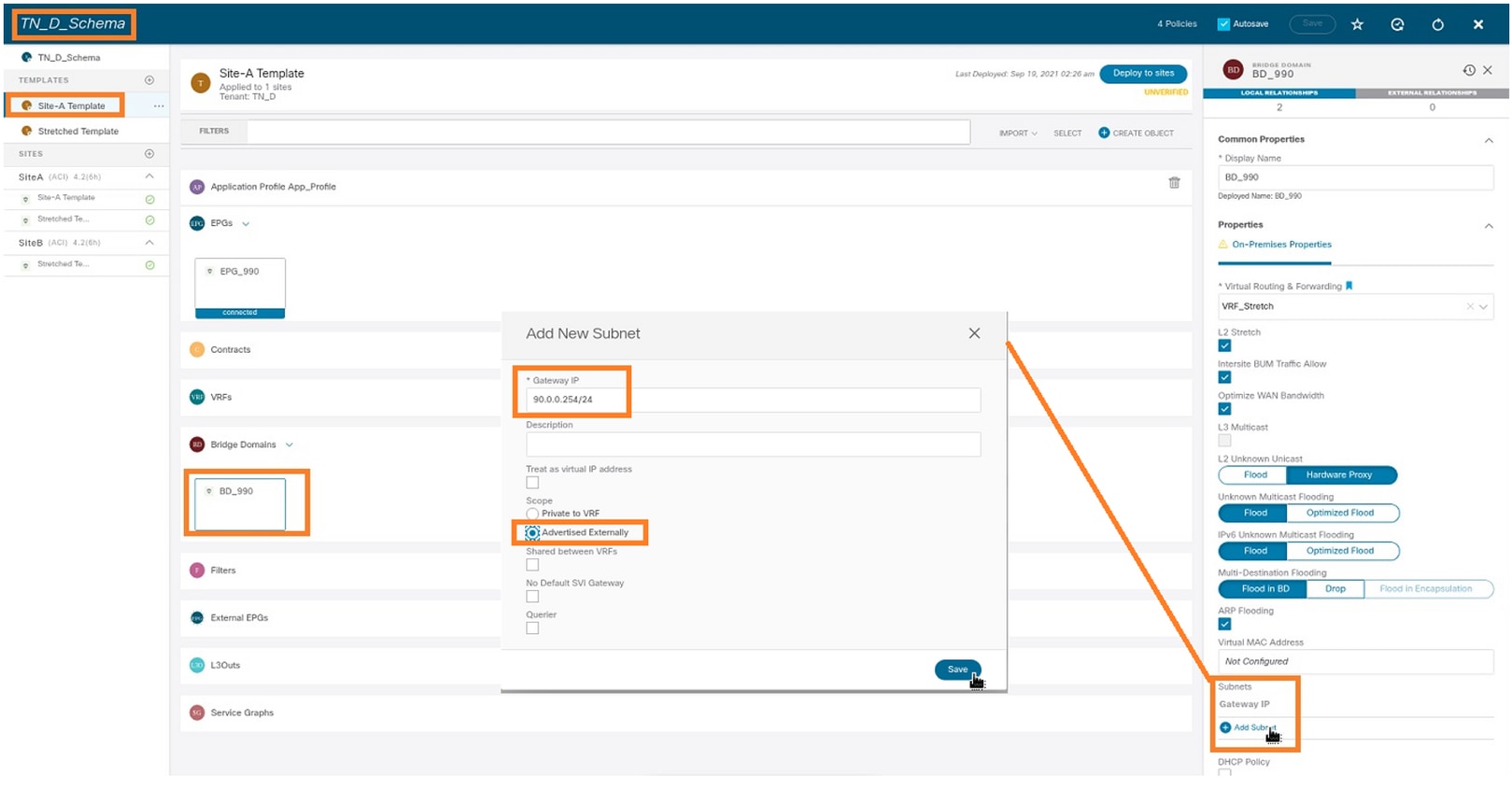

Paso 1. Agregue la subred/IP bajo BD (HOST_A utiliza BD IP como gateway).

- Del esquema que creó, elija Plantilla de Sitio A > BD_990.

- Haga clic en Agregar subred.

- En el cuadro de diálogo Agregar nueva subred, ingrese la dirección IP de gateway y haga clic en el botón de opción Anuncio externo.

Paso 2. Verifique que la subred se agregue en el Sitio A APIC1 con este comando.

APIC1# moquery -c fvSubnet -f 'fv.Subnet.ip=="90.0.0.254/24"' Total Objects shown: 1 # fv.Subnet ip : 90.0.0.254/24 annotation : orchestrator:msc childAction : ctrl : nd descr : dn : uni/tn-TN_D/BD-BD_990/subnet-[90.0.0.254/24] extMngdBy : lcOwn : local modTs : 2021-09-19T06:33:19.943+00:00 monPolDn : uni/tn-common/monepg-default name : nameAlias : preferred : no rn : subnet-[90.0.0.254/24] scope : public status : uid : 0 virtual : no

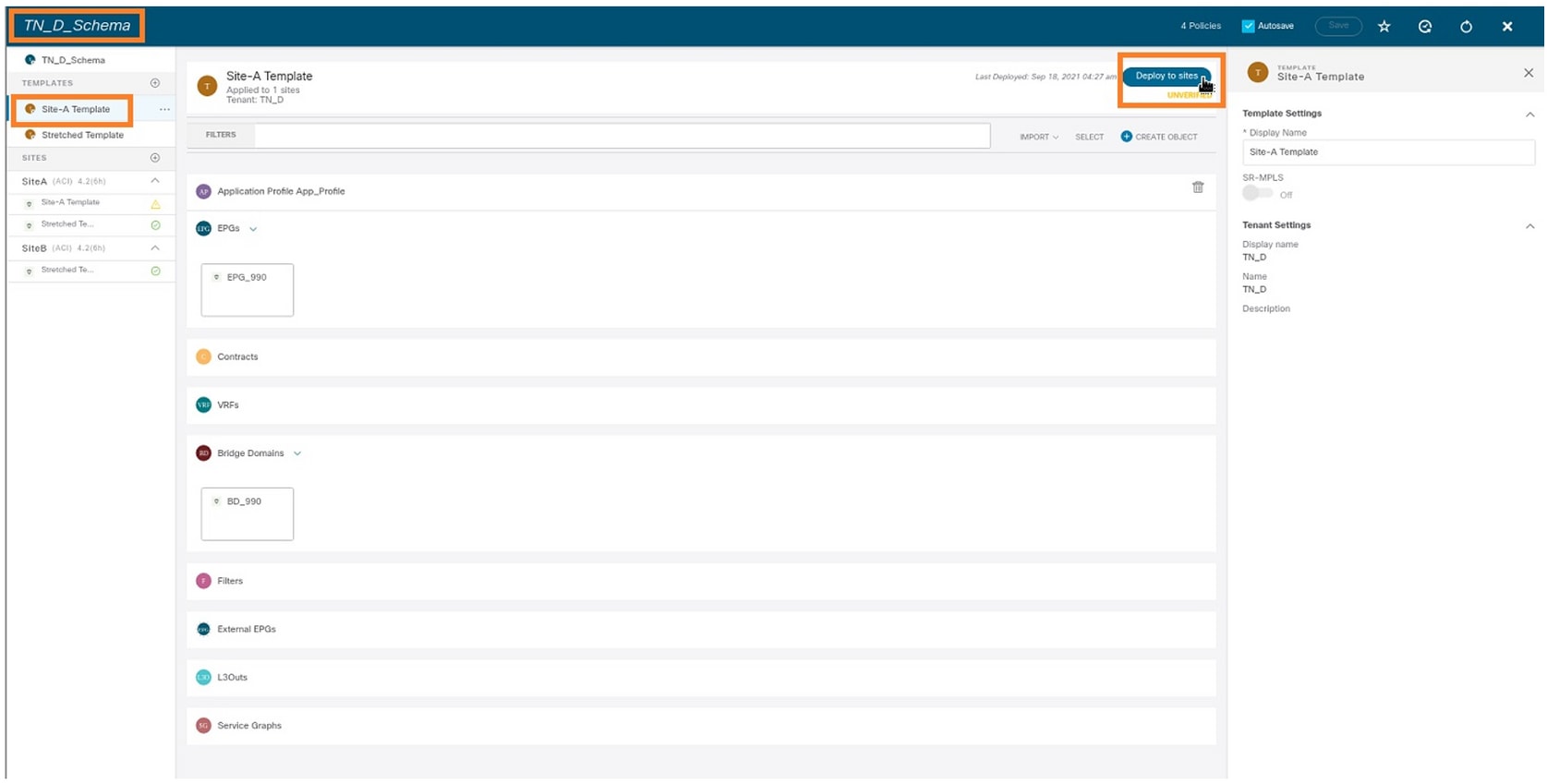

Paso 3. Implemente la plantilla Site-A.

- Del esquema que creó, elija Plantilla de Sitio A.

- Haga clic en Implementar en sitios.

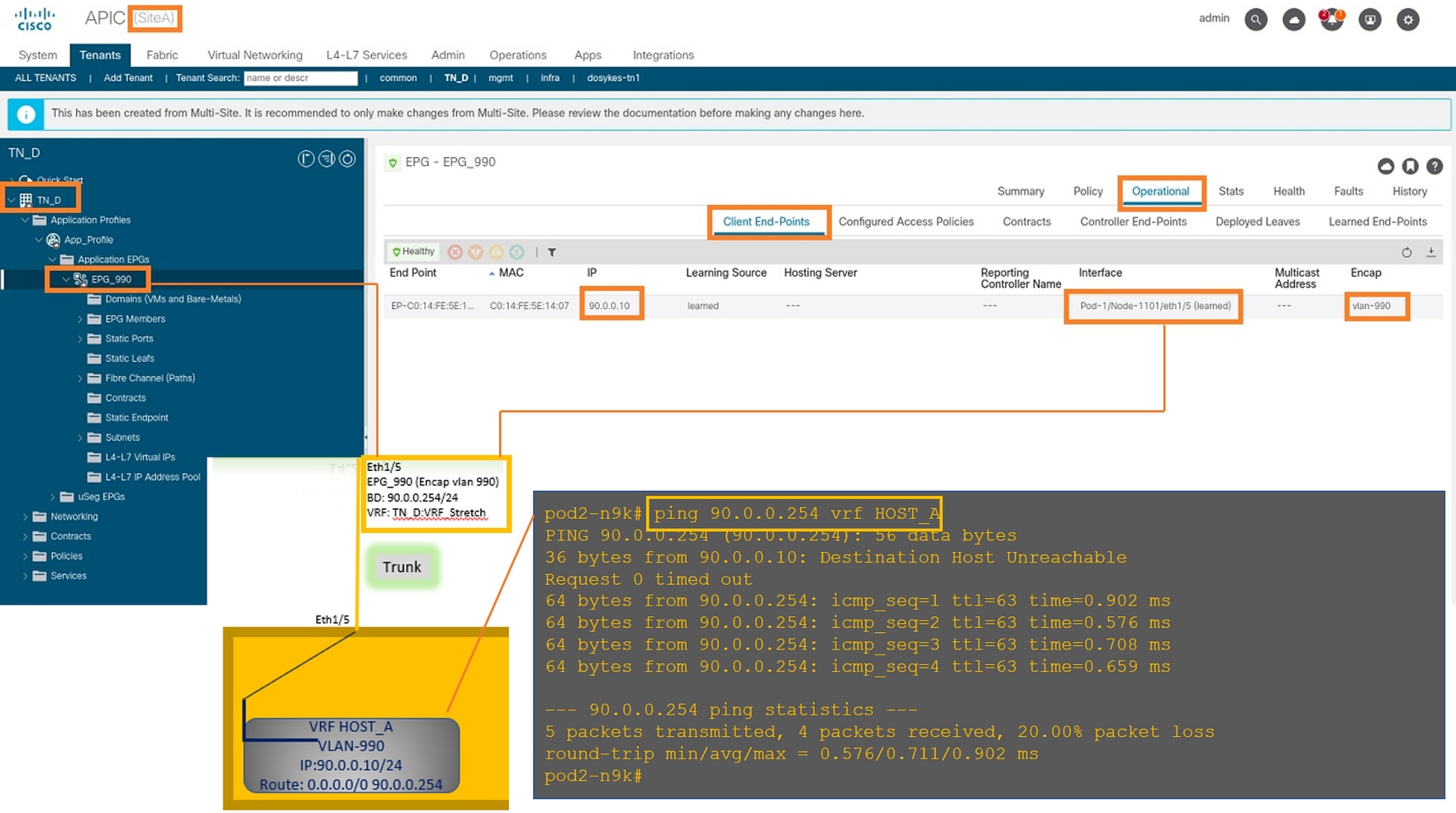

Configuración del host A (N9K)

Configure el dispositivo N9K con VRF HOST_A. Una vez finalizada la configuración N9K, puede ver ACI Leaf BD anycast address (gateway de HOST_A) que se puede alcanzar ahora a través de ICMP(ping).

En la ficha operativa de ACI, puede ver que se ha aprendido 90.0.0.10 (dirección IP de HOST_A).

Creación de la plantilla Site-B

Paso 1. Del esquema que creó, elija PLANTILLAS. Haga clic en el signo + y cree una plantilla con el nombre Site-B Template.

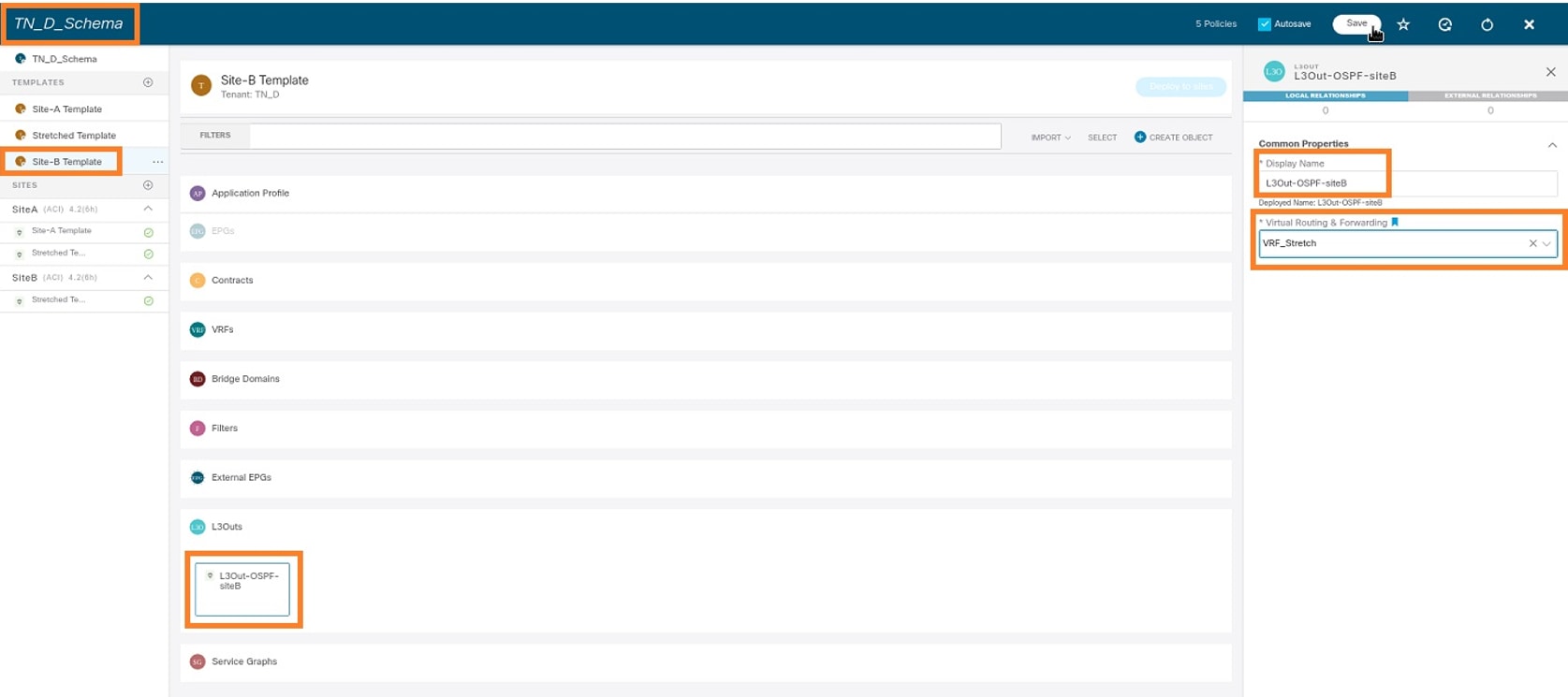

Configuración de Site-B L3out

Cree L3out y adjunte VRF_Stretch. Debe crear un objeto L3out desde MSO y el resto de la configuración L3out debe realizarse desde APIC (ya que los parámetros L3out no están disponibles en MSO). Además, cree un EPG externo desde MSO (sólo en la plantilla Sitio-B, ya que no se estira el EPG externo).

Paso 1. Del esquema que creó, elija Plantilla de Sitio-B. En el campo Display Name, ingrese L3out_OSPF_siteB. En la lista desplegable Virtual Routing & Forwarding, elija VRF_Stretch.

Crear el EPG externo

Paso 1. Del esquema que creó, elija Plantilla de Sitio-B. Haga clic en Agregar EPG externo.

Paso 2. Conecte L3out con EPG externo.

- Del esquema que creó, elija Plantilla de Sitio-B.

- En el campo Display Name, ingrese EXT_EPG_Site2.

- En el campo Subredes de clasificación, ingrese 0.0.0.0/0 para la subred externa para EPG externo.

El resto de la configuración de L3out se completa desde APIC (Site-B).

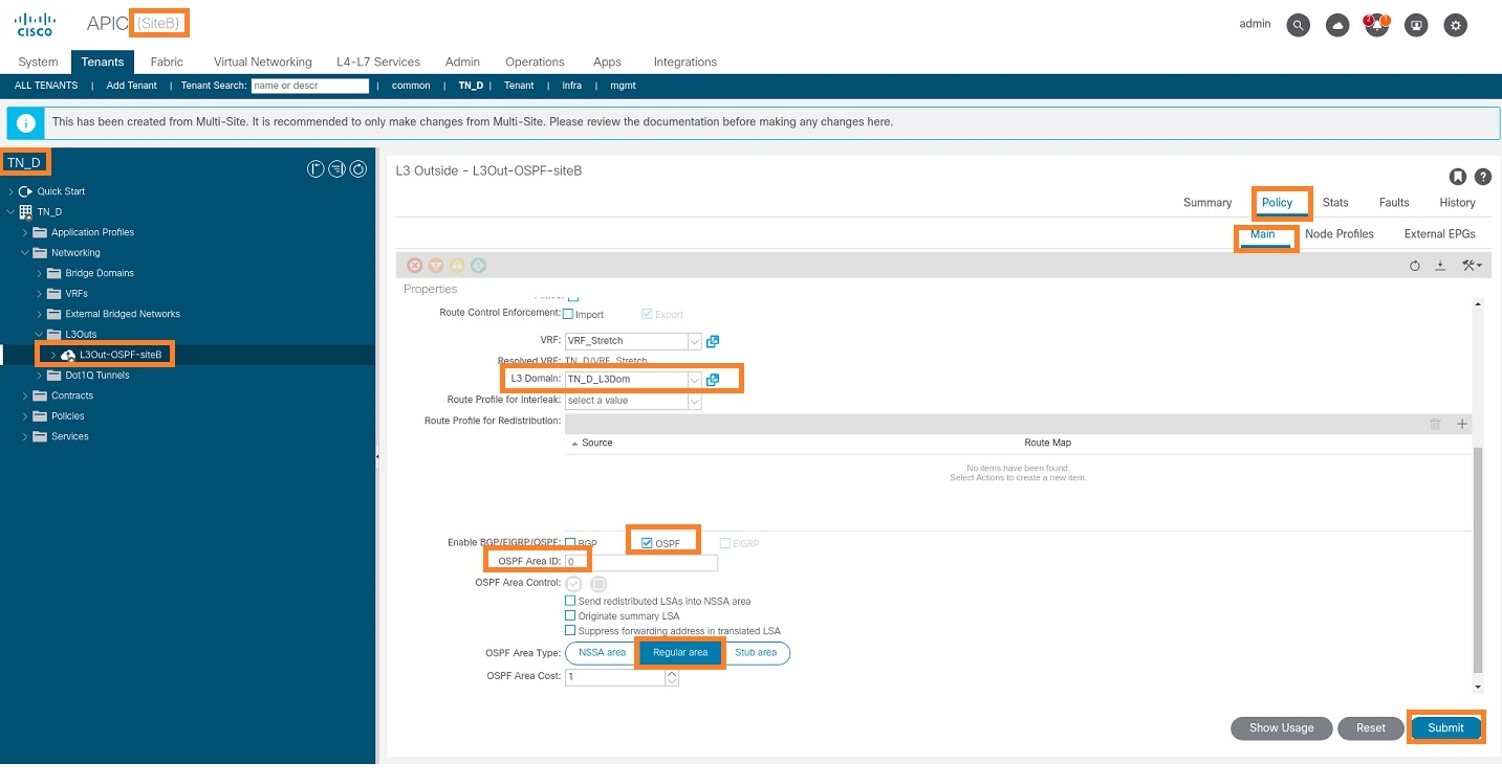

Paso 3. Agregue el dominio L3, habilite el protocolo OSPF y configure OSPF con el área normal 0.

- Desde APIC-1 en el Sitio-B, elija TN_D > Networking > L3out-OSPF-siteB > Policy > Main.

- En la lista desplegable Dominio L3, elija TN_D_L3Dom.

- Marque la casilla de verificación OSPF para Habilitar BGP/EIGRP/OSPF.

- En el campo OSPF Area ID, ingrese 0.

- En el tipo de área OSPF, elija área regular.

- Haga clic en Submit (Enviar).

Paso 4. Cree el perfil del nodo.

- Desde APIC-1 en el Sitio-B, elija TN_D > Networking > L3Outs > L3Out-OSPF-siteB > Perfiles de Nodo Lógico.

- Haga clic en Crear perfil de nodo.

Paso 5. Elija el switch Site2_Leaf1 como nodo en el sitio B.

- Desde APIC-1 en el Sitio-B, elija TN_D > Networking > L3Outs > L3Out-OSPF-siteB > Logical Node Profiles > Create Node Profile.

- En el campo Name, ingrese Site2_Leaf1.

- Haga clic en el signo + para agregar un nodo.

- Agregue el pod-2 node-101 con la dirección IP de ID del router.

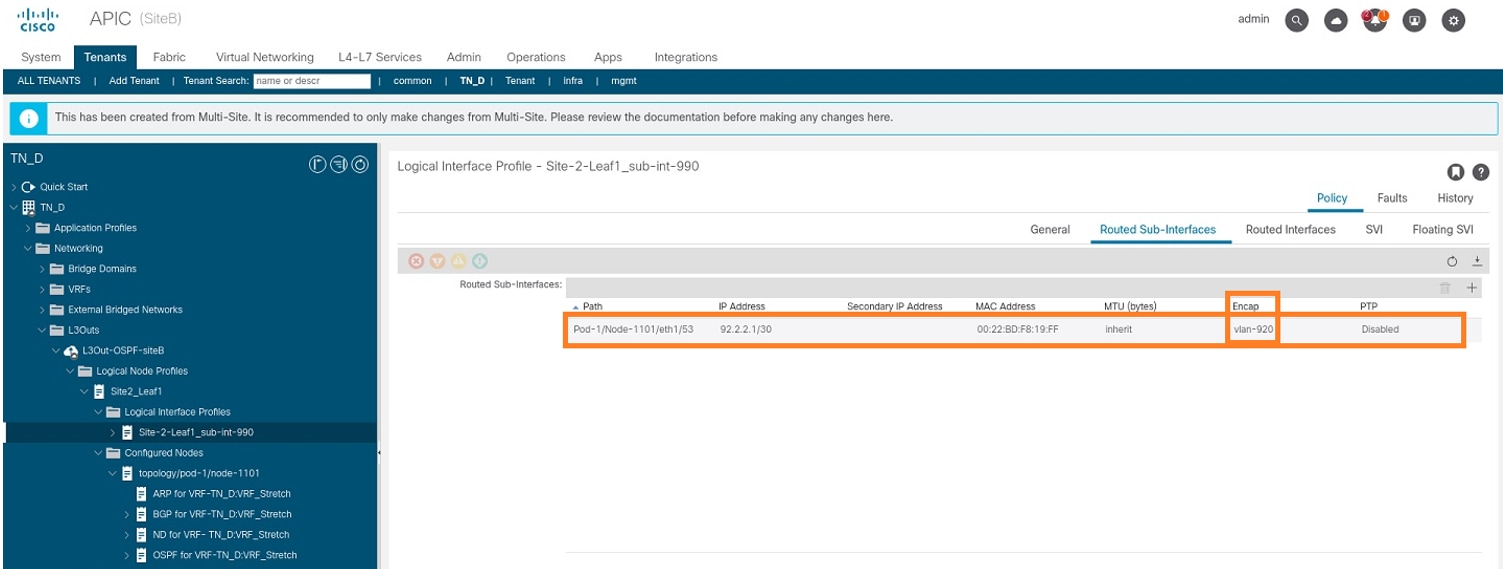

Paso 6. Agregue el perfil de interfaz (la VLAN externa es 920 (creación de SVI)).

- Desde APIC-1 en el Sitio-B, elija TN_D > Networking > L3Outs > L3out-OSPF-SiteB > Perfiles de Interfaz Lógica.

- Haga clic con el botón derecho del ratón y agregue el perfil de la interfaz.

- Elija Subinterfaces enrutadas.

- Configure la dirección IP, la MTU y la VLAN-920.

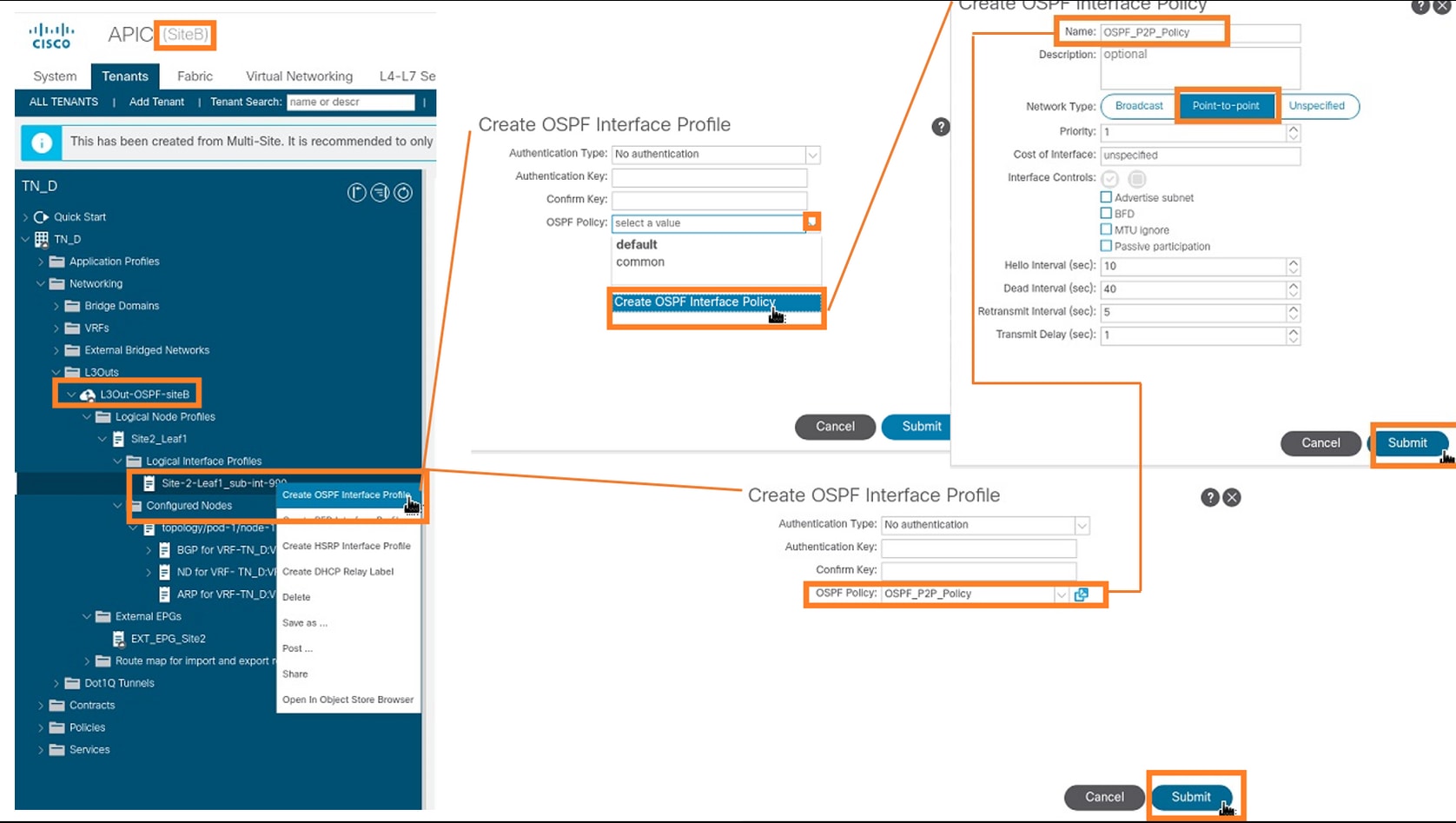

Paso 7. Cree la política OSPF (Point to Point Network).

- Desde APIC-1 en el Sitio-B, elija TN_D > Networking > L3Outs > L3Out-OSPF-siteB > Perfiles de Interfaz Lógica.

- Haga clic con el botón derecho y elija Crear perfil de interfaz OSPF.

- Elija las opciones como se muestra en la captura de pantalla y haga clic en Enviar.

Paso 8. Verifique la política de perfil de interfaz OSPF conectada bajo TN_D > Networking > L3Outs > L3Out-OSPF-siteB > Perfiles de interfaz lógica > (perfil de interfaz) > Perfil de interfaz OSPF.

Paso 9. Verifique que MSO haya creado el EPG externo "EXT_EPG_Site2". Desde APIC-1 en el Sitio-B, elija TN_D > L3Outs > L3Out-OSPF-siteB > EPGs externos > EXT_EPG_Site2.

Configuración del N9K externo (Sitio-B)

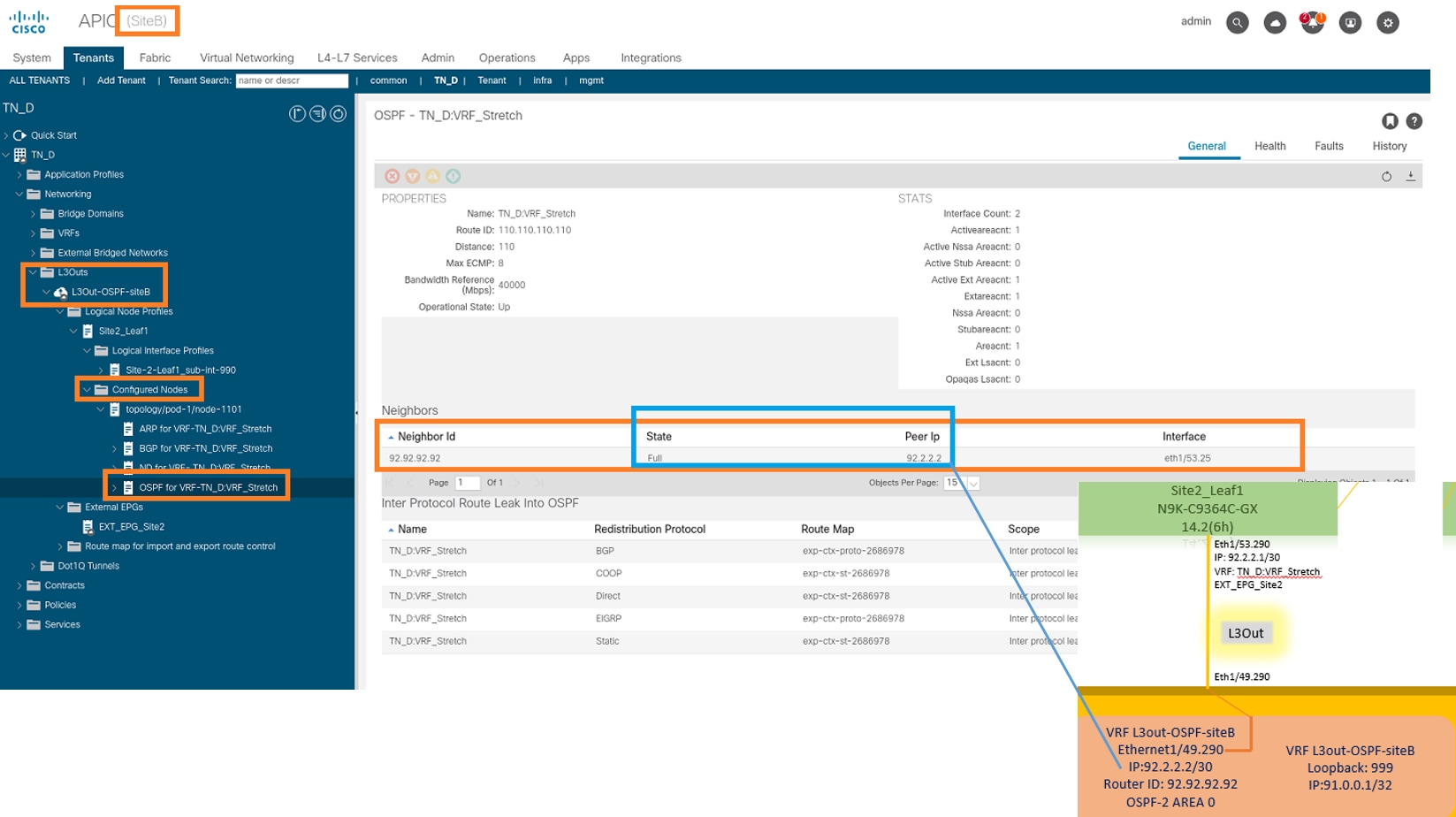

Después de la configuración N9K (VRF L3out-OSPF-siteB), podemos ver que la vecindad OSPF se establece entre el N9K y la hoja ACI (en el Sitio-B).

Verifique que se establezca la vecindad OSPF y UP (estado completo).

Desde APIC-1 en el Sitio-B, elija TN_D > Networking > L3Outs > L3Out-OSPF-siteB > Perfiles de Nodo Lógico > Perfiles de Interfaz Lógica > Nodos Configurados > topología/pod01/node-1101 > OSPF para VRF-TN_DVRF_Switch > Estado de ID de Vecino > Completo.

También puede verificar la vecindad OSPF en N9K. Además, puede hacer ping a la IP de hoja de ACI (Sitio B).

En este punto, la configuración de Host_A en el sitio A y L3out en el sitio B está completa.

Adjuntar el sitio B L3out al sitio A EPG(BD)

A continuación, puede adjuntar Site-B L3out al Sitio A BD-990 desde MSO. Tenga en cuenta que la columna del lado izquierdo tiene dos secciones: 1) Plantilla y 2) Sitios.

Paso 1. En la segunda sección Sitios, puede ver la plantilla adjunta a cada sitio. Cuando se adjunta L3out a "Site-A Template" (Plantilla del sitio A), se adjunta básicamente de la plantilla ya adjunta dentro de la sección Sitios.

Sin embargo, cuando implemente la plantilla, implemente desde la sección Plantillas > Plantilla de Sitio A y elija guardar/implementar en los sitios.

Paso 2. Implemente desde la plantilla principal "Site-A Template" en la primera sección "Templates" (Plantillas).

Configuración del contrato

Se requiere un contrato entre EPG externo en el sitio B y EPG_990 interno en el sitio A. Por lo tanto, primero puede crear un contrato desde MSO y adjuntarlo a ambos EPG.

Cisco Application Centric Infrastructure - Cisco ACI Contract Guide puede ayudar a entender el contrato. Por lo general, el EPG interno se configura como proveedor y el EPG externo se configura como consumidor.

Crear el contrato

Paso 1. En TN_D_Schema, elija Plantilla Stretched > Contratos. Haga clic Agregar contrato.

Paso 2. Agregue un filtro para permitir todo el tráfico.

- En TN_D_Schema, elija Plantilla Stretched > Contratos.

- Agregar un contrato con:

- Nombre de visualización: Intersite-L3out-Contract

- Alcance: VRF

Paso 3.

- En TN_D_Schema, elija Plantilla Stretched > Filtros.

- En el campo Display Name, ingrese Allow-all-traffic.

- Haga clic en Agregar entrada. Se muestra el cuadro de diálogo Agregar entrada.

- En el campo Name, ingrese Any_Traffic.

- En la lista desplegable Ether Type, elija no especificado para permitir todo el tráfico.

- Click Save.

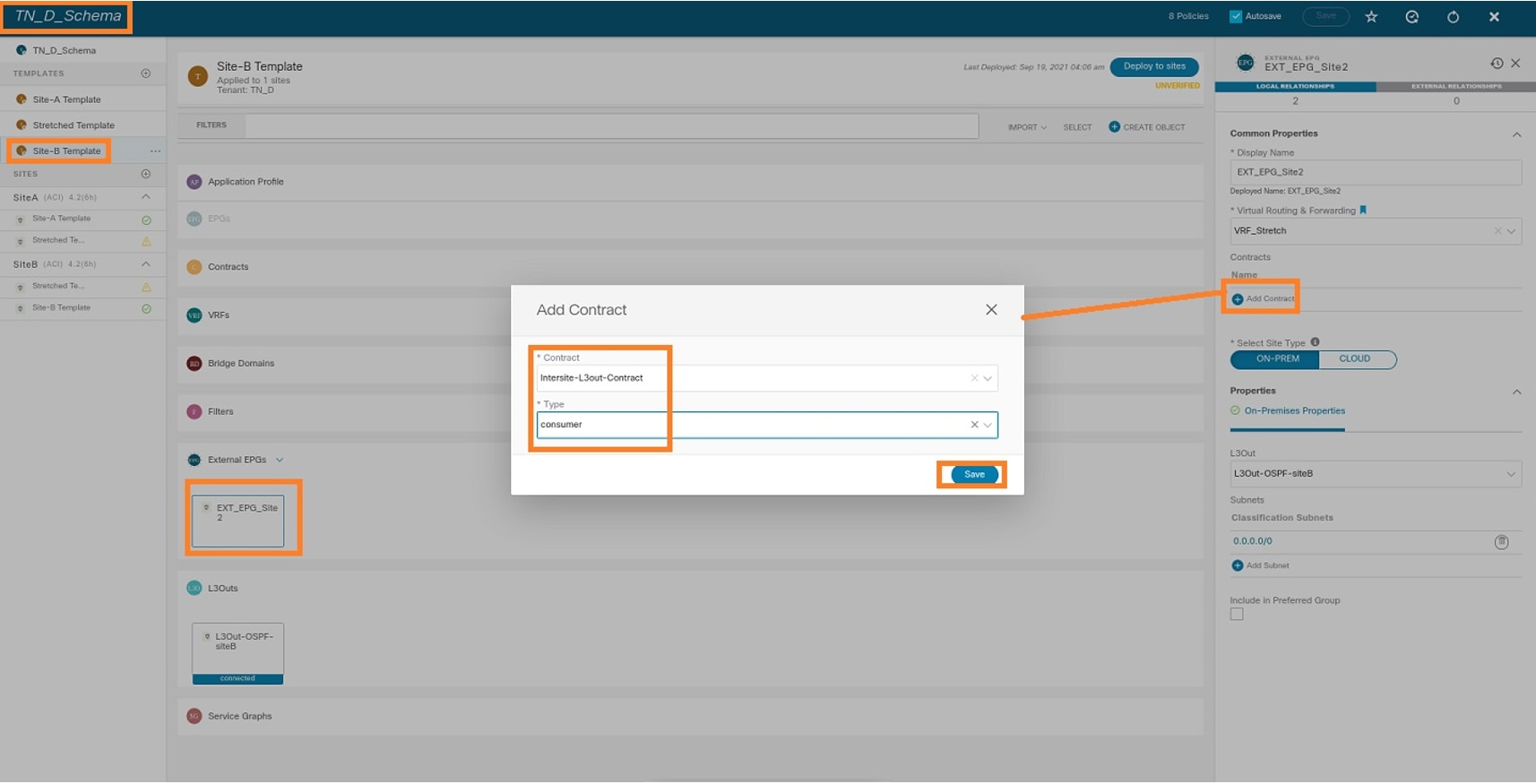

Paso 4. Agregue un contrato a EPG externo como "Consumidor" (plantilla en el sitio B) (implemente en el sitio).

- En TN_D_Schema, elija Site-B Template > EXT_EPG_Site2.

- Haga clic en Agregar contrato. Se muestra el cuadro de diálogo Agregar contrato.

- En el campo Contrato, ingrese Intersite-L3out-Contract.

- En la lista desplegable Tipo, elija consumidor.

Paso 5. Agregue el contrato a EPG interno "EPG_990" como "Proveedor" (plantilla en el sitio A) (Implementación en el sitio).

- En TN_D_Schema, elija Plantilla de Sitio A > EPG_990.

- Haga clic en Agregar contrato. Se muestra el cuadro de diálogo Agregar contrato.

- En el campo Contrato, ingrese Intersite-L3out-Contract.

- En la lista desplegable Tipo, elija proveedor.

En cuanto se agrega el contrato, puede ver "Shadow L3out / External EPG" creado en el Sitio A.

También puede ver que "Shadow EPG_990 y BD_990" también fueron creados en el Sitio-B.

Paso 6. Ingrese estos comandos para verificar el APIC del Sitio B.

apic1# moquery -c fvAEPg -f 'fv.AEPg.name=="EPG_990"' Total Objects shown: 1 # fv.AEPg name : EPG_990 annotation : orchestrator:msc childAction : configIssues : configSt : applied descr : dn : uni/tn-TN_D/ap-App_Profile/epg-EPG_990 exceptionTag : extMngdBy : floodOnEncap : disabled fwdCtrl : hasMcastSource : no isAttrBasedEPg : no isSharedSrvMsiteEPg : no lcOwn : local matchT : AtleastOne modTs : 2021-09-19T18:47:53.374+00:00 monPolDn : uni/tn-common/monepg-default nameAlias : pcEnfPref : unenforced pcTag : 49153 <<< Note that pcTag is different for shadow EPG. prefGrMemb : exclude prio : unspecified rn : epg-EPG_990 scope : 2686978 shutdown : no status : triggerSt : triggerable txId : 1152921504609244629 uid : 0

apic1# moquery -c fvBD -f 'fv.BD.name==\"BD_990\"' Total Objects shown: 1 # fv.BD name : BD_990 OptimizeWanBandwidth : yes annotation : orchestrator:msc arpFlood : yes bcastP : 225.0.181.192 childAction : configIssues : descr : dn : uni/tn-TN_D/BD-BD_990 epClear : no epMoveDetectMode : extMngdBy : hostBasedRouting : no intersiteBumTrafficAllow : yes intersiteL2Stretch : yes ipLearning : yes ipv6McastAllow : no lcOwn : local limitIpLearnToSubnets : yes llAddr : :: mac : 00:22:BD:F8:19:FF mcastAllow : no modTs : 2021-09-19T18:47:53.374+00:00 monPolDn : uni/tn-common/monepg-default mtu : inherit multiDstPktAct : bd-flood nameAlias : ownerKey : ownerTag : pcTag : 32771 rn : BD-BD_990 scope : 2686978 seg : 15957972 status : type : regular uid : 0 unicastRoute : yes unkMacUcastAct : proxy unkMcastAct : flood v6unkMcastAct : flood vmac : not-applicable

Paso 7. Revise y verifique la configuración del dispositivo externo N9K.

Verificación

Use esta sección para confirmar que su configuración funciona correctamente.

Endpoint Learn

Verifique que el punto final del Sitio-A se aprendió como un punto final en Site1_Leaf1.

Site1_Leaf1# show endpoint interface ethernet 1/5

Legend:

s - arp H - vtep V - vpc-attached p - peer-aged

R - peer-attached-rl B - bounce S - static M - span

D - bounce-to-proxy O - peer-attached a - local-aged m - svc-mgr

L - local E - shared-service

+-----------------------------------+---------------+-----------------+--------------+-------------+

VLAN/ Encap MAC Address MAC Info/ Interface

Domain VLAN IP Address IP Info

+-----------------------------------+---------------+-----------------+--------------+-------------+

18 vlan-990 c014.fe5e.1407 L eth1/5

TN_D:VRF_Stretch vlan-990 90.0.0.10 L eth1/5

Verificación ETEP/RTEP

Hojas de Site_A.

Site1_Leaf1# show ip interface brief vrf overlay-1

IP Interface Status for VRF "overlay-1"(4)

Interface Address Interface Status

eth1/49 unassigned protocol-up/link-up/admin-up

eth1/49.7 unnumbered protocol-up/link-up/admin-up

(lo0)

eth1/50 unassigned protocol-up/link-up/admin-up

eth1/50.8 unnumbered protocol-up/link-up/admin-up

(lo0)

eth1/51 unassigned protocol-down/link-down/admin-up

eth1/52 unassigned protocol-down/link-down/admin-up

eth1/53 unassigned protocol-down/link-down/admin-up

eth1/54 unassigned protocol-down/link-down/admin-up

vlan9 10.0.0.30/27 protocol-up/link-up/admin-up

lo0 10.0.80.64/32 protocol-up/link-up/admin-up

lo1 10.0.8.67/32 protocol-up/link-up/admin-up

lo8 192.168.200.225/32 protocol-up/link-up/admin-up <<<<< IP from ETEP site-A

lo1023 10.0.0.32/32 protocol-up/link-up/admin-up

Site2_Leaf1# show ip interface brief vrf overlay-1

IP Interface Status for VRF "overlay-1"(4)

Interface Address Interface Status

eth1/49 unassigned protocol-up/link-up/admin-up

eth1/49.16 unnumbered protocol-up/link-up/admin-up

(lo0)

eth1/50 unassigned protocol-up/link-up/admin-up

eth1/50.17 unnumbered protocol-up/link-up/admin-up

(lo0)

eth1/51 unassigned protocol-down/link-down/admin-up

eth1/52 unassigned protocol-down/link-down/admin-up

eth1/54 unassigned protocol-down/link-down/admin-up

eth1/55 unassigned protocol-down/link-down/admin-up

eth1/56 unassigned protocol-down/link-down/admin-up

eth1/57 unassigned protocol-down/link-down/admin-up

eth1/58 unassigned protocol-down/link-down/admin-up

eth1/59 unassigned protocol-down/link-down/admin-up

eth1/60 unassigned protocol-down/link-down/admin-up

eth1/61 unassigned protocol-down/link-down/admin-up

eth1/62 unassigned protocol-down/link-down/admin-up

eth1/63 unassigned protocol-down/link-down/admin-up

eth1/64 unassigned protocol-down/link-down/admin-up

vlan18 10.0.0.30/27 protocol-up/link-up/admin-up

lo0 10.0.72.64/32 protocol-up/link-up/admin-up

lo1 10.0.80.67/32 protocol-up/link-up/admin-up

lo6 192.168.100.225/32 protocol-up/link-up/admin-up <<<<< IP from ETEP site-B

lo1023 10.0.0.32/32 protocol-up/link-up/admin-up

Alcance ICMP

Haga ping en la dirección IP WAN del dispositivo externo desde HOST_A.

Haga ping en la dirección de loopback del dispositivo externo.

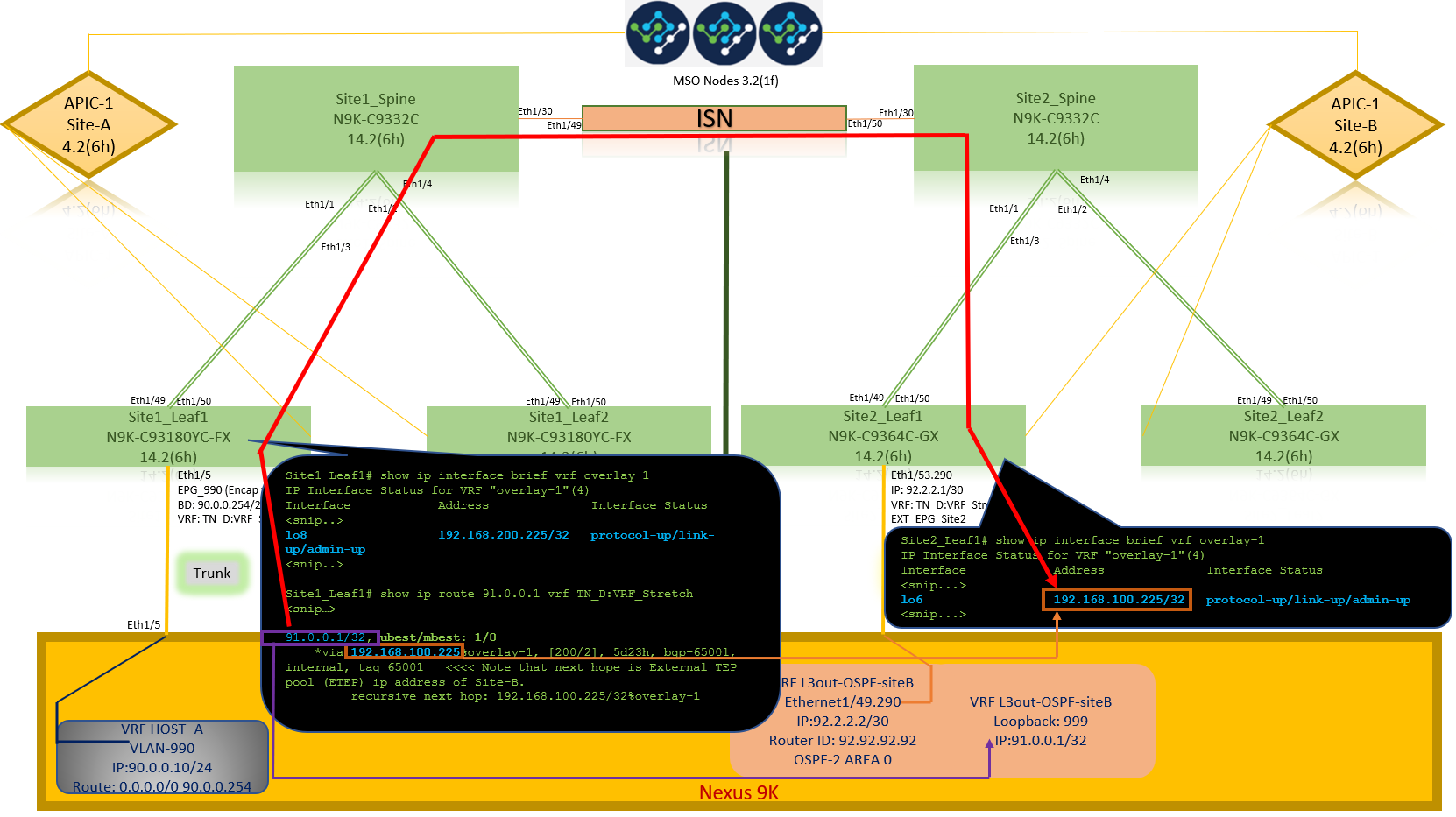

Verificación de ruta

Verifique la dirección IP WAN del dispositivo externo O la ruta de subred de loopback está presente en la tabla de ruteo. Cuando verifica el salto siguiente para la subred del dispositivo externo en "Site1_Leaf1", es la IP TEP externa de la hoja "Site2-Leaf1".

Site1_Leaf1# show ip route 92.2.2.2 vrf TN_D:VRF_Stretch

IP Route Table for VRF "TN_D:VRF_Stretch"

'*' denotes best ucast next-hop

'**' denotes best mcast next-hop

'[x/y]' denotes [preference/metric]

'%' in via output denotes VRF

92.2.2.0/30, ubest/mbest: 1/0

*via 192.168.100.225%overlay-1, [200/0], 5d23h, bgp-65001, internal, tag 65001 <<<< Note that next hope is External TEP pool (ETEP) ip address of Site-B.

recursive next hop: 192.168.100.225/32%overlay-1

Site1_Leaf1# show ip route 91.0.0.1 vrf TN_D:VRF_Stretch

IP Route Table for VRF "TN_D:VRF_Stretch"

'*' denotes best ucast next-hop

'**' denotes best mcast next-hop

'[x/y]' denotes [preference/metric]

'%' in via output denotes VRF

91.0.0.1/32, ubest/mbest: 1/0

*via 192.168.100.225%overlay-1, [200/2], 5d23h, bgp-65001, internal, tag 65001 <<<< Note that next hope is External TEP pool (ETEP) ip address of Site-B.

recursive next hop: 192.168.100.225/32%overlay-1

Troubleshoot

En esta sección encontrará información que puede utilizar para solucionar problemas de configuración.

Site2_Leaf1

Importación/exportación de ruta de familia de direcciones BGP entre TN_D:VRF_stretch y Overlay-1.

Site2_Leaf1# show system internal epm vrf TN_D:VRF_Stretch

+--------------------------------+--------+----------+----------+------+--------

VRF Type VRF vnid Context ID Status Endpoint

Count

+--------------------------------+--------+----------+----------+------+--------

TN_D:VRF_Stretch Tenant 2686978 46 Up 1

Site2_Leaf1# show vrf TN_D:VRF_Stretch detail

VRF-Name: TN_D:VRF_Stretch, VRF-ID: 46, State: Up

VPNID: unknown

RD: 1101:2686978

Max Routes: 0 Mid-Threshold: 0

Table-ID: 0x8000002e, AF: IPv6, Fwd-ID: 0x8000002e, State: Up

Table-ID: 0x0000002e, AF: IPv4, Fwd-ID: 0x0000002e, State: Up

Site2_Leaf1# vsh

Site2_Leaf1# show bgp vpnv4 unicast 91.0.0.1 vrf TN_D:VRF_Stretch BGP routing table information for VRF overlay-1, address family VPNv4 Unicast Route Distinguisher: 1101:2686978 (VRF TN_D:VRF_Stretch) BGP routing table entry for 91.0.0.1/32, version 12 dest ptr 0xae6da350 Paths: (1 available, best #1) Flags: (0x80c0002 00000000) on xmit-list, is not in urib, exported vpn: version 346, (0x100002) on xmit-list Multipath: eBGP iBGP Advertised path-id 1, VPN AF advertised path-id 1 Path type: redist 0x408 0x1 ref 0 adv path ref 2, path is valid, is best path AS-Path: NONE, path locally originated 0.0.0.0 (metric 0) from 0.0.0.0 (10.0.72.64) Origin incomplete, MED 2, localpref 100, weight 32768 Extcommunity: RT:65001:2686978 VNID:2686978 COST:pre-bestpath:162:110 VRF advertise information: Path-id 1 not advertised to any peer VPN AF advertise information: Path-id 1 advertised to peers: 10.0.72.65 <<

Site-B

apic1# acidiag fnvread ID Pod ID Name Serial Number IP Address Role State LastUpdMsgId -------------------------------------------------------------------------------------------------------------- 101 1 Site2_Spine FDO243207JH 10.0.72.65/32 spine active 0 102 1 Site2_Leaf2 FDO24260FCH 10.0.72.66/32 leaf active 0 1101 1 Site2_Leaf1 FDO24260ECW 10.0.72.64/32 leaf active 0

Site2_Spine

Site2_Spine# vsh

Site2_Spine# show bgp vpnv4 unicast 91.0.0.1 vrf overlay-1 BGP routing table information for VRF overlay-1, address family VPNv4 Unicast <---------26bits---------> Route Distinguisher: 1101:2686978 <<<<<2686978 <--Binary--> 00001010010000000000000010 BGP routing table entry for 91.0.0.1/32, version 717 dest ptr 0xae643d0c Paths: (1 available, best #1) Flags: (0x000002 00000000) on xmit-list, is not in urib, is not in HW Multipath: eBGP iBGP Advertised path-id 1 Path type: internal 0x40000018 0x800040 ref 0 adv path ref 1, path is valid, is best path AS-Path: NONE, path sourced internal to AS 10.0.72.64 (metric 2) from 10.0.72.64 (10.0.72.64) <<< Site2_leaf1 IP Origin incomplete, MED 2, localpref 100, weight 0 Received label 0 Received path-id 1 Extcommunity: RT:65001:2686978 COST:pre-bestpath:168:3221225472 VNID:2686978 COST:pre-bestpath:162:110 Path-id 1 advertised to peers: 192.168.10.13 <<<< Site1_Spine mscp-etep IP.

Site1_Spine# show ip interface vrf overlay-1 <snip...>

lo12, Interface status: protocol-up/link-up/admin-up, iod: 89, mode: mscp-etep IP address: 192.168.10.13, IP subnet: 192.168.10.13/32 <<IP broadcast address: 255.255.255.255 IP primary address route-preference: 0, tag: 0

<snip...>

Site1_Spine

Site1_Spine# vsh

Site1_Spine# show bgp vpnv4 unicast 91.0.0.1 vrf overlay-1

BGP routing table information for VRF overlay-1, address family VPNv4 Unicast <---------26Bits-------->

Route Distinguisher: 1101:36241410 <<<<<36241410<--binary-->10001010010000000000000010

BGP routing table entry for 91.0.0.1/32, version 533 dest ptr 0xae643dd4

Paths: (1 available, best #1)

Flags: (0x000002 00000000) on xmit-list, is not in urib, is not in HW

Multipath: eBGP iBGP

Advertised path-id 1

Path type: internal 0x40000018 0x880000 ref 0 adv path ref 1, path is valid, is best path, remote site path

AS-Path: NONE, path sourced internal to AS

192.168.100.225 (metric 20) from 192.168.11.13 (192.168.11.13) <<< Site2_Leaf1 ETEP IP learn via Site2_Spine mcsp-etep address.

Origin incomplete, MED 2, localpref 100, weight 0

Received label 0

Extcommunity:

RT:65001:36241410

SOO:65001:50331631

COST:pre-bestpath:166:2684354560

COST:pre-bestpath:168:3221225472

VNID:2686978

COST:pre-bestpath:162:110

Originator: 10.0.72.64 Cluster list: 192.168.11.13 <<< Originator Site2_Leaf1 and Site2_Spine ips are listed here...

Path-id 1 advertised to peers:

10.0.80.64 <<<< Site1_Leaf1 ip

Site2_Spine# show ip interface vrf overlay-1

<snip..>

lo13, Interface status: protocol-up/link-up/admin-up, iod: 92, mode: mscp-etep

IP address: 192.168.11.13, IP subnet: 192.168.11.13/32

IP broadcast address: 255.255.255.255

IP primary address route-preference: 0, tag: 0

<snip..>

Site-B

apic1# acidiag fnvread

ID Pod ID Name Serial Number IP Address Role State LastUpdMsgId

--------------------------------------------------------------------------------------------------------------

101 1 Site2_Spine FDO243207JH 10.0.72.65/32 spine active 0

102 1 Site2_Leaf2 FDO24260FCH 10.0.72.66/32 leaf active 0

1101 1 Site2_Leaf1 FDO24260ECW 10.0.72.64/32 leaf active 0

Verifique el indicador entre sitios.

Site1_Spine# moquery -c bgpPeer -f 'bgp.Peer.addr*"192.168.11.13"'

Total Objects shown: 1

# bgp.Peer

addr : 192.168.11.13/32

activePfxPeers : 0

adminSt : enabled

asn : 65001

bgpCfgFailedBmp :

bgpCfgFailedTs : 00:00:00:00.000

bgpCfgState : 0

childAction :

ctrl :

curPfxPeers : 0

dn : sys/bgp/inst/dom-overlay-1/peer-[192.168.11.13/32]

lcOwn : local

maxCurPeers : 0

maxPfxPeers : 0

modTs : 2021-09-13T11:58:26.395+00:00

monPolDn :

name :

passwdSet : disabled

password :

peerRole : msite-speaker

privateASctrl :

rn : peer-[192.168.11.13/32] <<

srcIf : lo12 status : totalPfxPeers : 0 ttl : 16 type : inter-site

<<

Introducción a la Entrada del Distinguidor de Ruta

Cuando se configura el indicador entre sitios, el spine de sitio local puede establecer el id de sitio local en el route-target a partir del bit 25. Cuando Site1 obtiene la trayectoria BGP con este bit configurado en el RT, sabe que ésta es una trayectoria de sitio remoto.

Site2_Leaf1# vsh

Site2_Leaf1# show bgp vpnv4 unicast 91.0.0.1 vrf TN_D:VRF_Stretch

BGP routing table information for VRF overlay-1, address family VPNv4 Unicast <---------26Bits-------->

Route Distinguisher: 1101:2686978 (VRF TN_D:VRF_Stretch) <<<<<2686978 <--Binary--> 00001010010000000000000010

BGP routing table entry for 91.0.0.1/32, version 12 dest ptr 0xae6da350

Site1_Spine# vsh

Site1_Spine# show bgp vpnv4 unicast 91.0.0.1 vrf overlay-1

<---------26Bits-------->

Route Distinguisher: 1101:36241410 <<<<<36241410<--binary-->10001010010000000000000010

^^---26th bit set to 1 and with 25th bit value it become 10.

Observe que el valor binario RT es exactamente el mismo para Site1 excepto para el bit 26th configurado en 1. Tiene un valor decimal (marcado como azul). 1101:36241410 es lo que puede esperar ver en Site1 y lo que la hoja interna en Site1 debe importarse.

Site1_Leaf1

Site1_Leaf1# show vrf TN_D:VRF_Stretch detail

VRF-Name: TN_D:VRF_Stretch, VRF-ID: 46, State: Up

VPNID: unknown

RD: 1101:2850817

Max Routes: 0 Mid-Threshold: 0

Table-ID: 0x8000002e, AF: IPv6, Fwd-ID: 0x8000002e, State: Up

Table-ID: 0x0000002e, AF: IPv4, Fwd-ID: 0x0000002e, State: Up

Site1_Leaf1# show bgp vpnv4 unicast 91.0.0.1 vrf overlay-1 BGP routing table information for VRF overlay-1, address family VPNv4 Unicast Route Distinguisher: 1101:2850817 (VRF TN_D:VRF_Stretch) BGP routing table entry for 91.0.0.1/32, version 17 dest ptr 0xadeda550 Paths: (1 available, best #1) Flags: (0x08001a 00000000) on xmit-list, is in urib, is best urib route, is in HW vpn: version 357, (0x100002) on xmit-list Multipath: eBGP iBGP Advertised path-id 1, VPN AF advertised path-id 1 Path type: internal 0xc0000018 0x80040 ref 56506 adv path ref 2, path is valid, is best path, remote site path Imported from 1101:36241410:91.0.0.1/32 AS-Path: NONE, path sourced internal to AS 192.168.100.225 (metric 64) from 10.0.80.65 (192.168.10.13) Origin incomplete, MED 2, localpref 100, weight 0 Received label 0 Received path-id 1 Extcommunity: RT:65001:36241410 SOO:65001:50331631 COST:pre-bestpath:166:2684354560 COST:pre-bestpath:168:3221225472 VNID:2686978 COST:pre-bestpath:162:110 Originator: 10.0.72.64 Cluster list: 192.168.10.13192.168.11.13 <<<< '10.0.72.64'='Site2_Leaf1' , '192.168.10.13'='Site1_Spine' , '192.168.11.13'='Site2_Spine' VRF advertise information: Path-id 1 not advertised to any peer VPN AF advertise information: Path-id 1 not advertised to any peer <snip..>

Site1_Leaf1# show bgp vpnv4 unicast 91.0.0.1 vrf TN_D:VRF_Stretch BGP routing table information for VRF overlay-1, address family VPNv4 Unicast Route Distinguisher: 1101:2850817 (VRF TN_D:VRF_Stretch) BGP routing table entry for 91.0.0.1/32, version 17 dest ptr 0xadeda550 Paths: (1 available, best #1) Flags: (0x08001a 00000000) on xmit-list, is in urib, is best urib route, is in HW vpn: version 357, (0x100002) on xmit-listMultipath: eBGP iBGP Advertised path-id 1, VPN AF advertised path-id 1 Path type: internal 0xc0000018 0x80040 ref 56506 adv path ref 2, path is valid, is best path, remote site path Imported from 1101:36241410:91.0.0.1/32 AS-Path: NONE, path sourced internal to AS 192.168.100.225 (metric 64) from 10.0.80.65 (192.168.10.13) Origin incomplete, MED 2, localpref 100, weight 0 Received label 0 Received path-id 1 Extcommunity: RT:65001:36241410 SOO:65001:50331631 COST:pre-bestpath:166:2684354560 COST:pre-bestpath:168:3221225472 VNID:2686978 COST:pre-bestpath:162:110 Originator: 10.0.72.64 Cluster list: 192.168.10.13 192.168.11.13 VRF advertise information: Path-id 1 not advertised to any peer VPN AF advertise information: Path-id 1 not advertised to any peer

Por lo tanto, "Site1_Leaf1" tiene una entrada de ruta para la subred 91.0.0.1/32 con la dirección ETEP 192.168.100.225 del siguiente salto "Site2_Leaf1".

Site1_Leaf1# show ip route 91.0.0.1 vrf TN_D:VRF_Stretch

IP Route Table for VRF "TN_D:VRF_Stretch"

'*' denotes best ucast next-hop

'**' denotes best mcast next-hop

'[x/y]' denotes [preference/metric]

'%' in via output denotes VRF

91.0.0.1/32, ubest/mbest: 1/0

*via 192.168.100.225%overlay-1, [200/2], 5d23h, bgp-65001, internal, tag 65001 <<<< Note that next hope is External TEP pool (ETEP) ip address of Site-B.

recursive next hop: 192.168.100.225/32%overlay-1

Site-A Spine agrega route-map hacia la dirección IP de vecino BGP de "Site2_Spine" mcsp-ETEP.

Por lo tanto, si piensa en los flujos de tráfico, cuando el punto final del Sitio A habla con la dirección IP externa, el paquete puede encapsularse con el origen como dirección TEP "Site1_Leaf1" y el destino es la dirección ETEP de la dirección IP 192.168.100.225 "Site2_Leaf".

Verificar ELAM (Site1_Spine)

Site1_Spine# vsh_lc module-1# debug platform internal roc elam asic 0 module-1(DBG-elam)# trigger reset module-1(DBG-elam)# trigger init in-select 14 out-select 1 module-1(DBG-elam-insel14)# set inner ipv4 src_ip 90.0.0.10 dst_ip 91.0.0.1 next-protocol 1 module-1(DBG-elam-insel14)# start module-1(DBG-elam-insel14)# status ELAM STATUS =========== Asic 0 Slice 0 Status Armed Asic 0 Slice 1 Status Armed Asic 0 Slice 2 Status Armed Asic 0 Slice 3 Status Armed

pod2-n9k# ping 91.0.0.1 vrf HOST_A source 90.0.0.10 PING 91.0.0.1 (91.0.0.1) from 90.0.0.10: 56 data bytes 64 bytes from 91.0.0.1: icmp_seq=0 ttl=252 time=1.015 ms 64 bytes from 91.0.0.1: icmp_seq=1 ttl=252 time=0.852 ms 64 bytes from 91.0.0.1: icmp_seq=2 ttl=252 time=0.859 ms 64 bytes from 91.0.0.1: icmp_seq=3 ttl=252 time=0.818 ms 64 bytes from 91.0.0.1: icmp_seq=4 ttl=252 time=0.778 ms --- 91.0.0.1 ping statistics --- 5 packets transmitted, 5 packets received, 0.00% packet loss round-trip min/avg/max = 0.778/0.864/1.015 ms

Site1_Spine ELAM se activa. Ereport confirma que el paquete se encapsula con una dirección TEP de la dirección IP y el destino del TEP de la hoja del sitio A hacia la dirección ETEP Site2_Leaf1.

module-1(DBG-elam-insel14)# status ELAM STATUS =========== Asic 0 Slice 0 Status Armed Asic 0 Slice 1 Status Armed Asic 0 Slice 2 Status Triggered Asic 0 Slice 3 Status Armed module-1(DBG-elam-insel14)# ereport Python available. Continue ELAM decode with LC Pkg ELAM REPORT ------------------------------------------------------------------------------------------------------------------------------------------------------ Outer L3 Header ------------------------------------------------------------------------------------------------------------------------------------------------------ L3 Type : IPv4 DSCP : 0 Don't Fragment Bit : 0x0 TTL : 32 IP Protocol Number : UDP Destination IP : 192.168.100.225 <<<'Site2_Leaf1' ETEP address Source IP : 10.0.80.64 <<<'Site1_Leaf1' TEP address ------------------------------------------------------------------------------------------------------------------------------------------------------ Inner L3 Header ------------------------------------------------------------------------------------------------------------------------------------------------------ L3 Type : IPv4 DSCP : 0 Don't Fragment Bit : 0x0 TTL : 254 IP Protocol Number : ICMP Destination IP : 91.0.0.1 Source IP : 90.0.0.10

Site1_Spine Verificar Route-Map

Cuando la columna Sitio-A recibe un paquete, puede redirigir a la dirección ETEP "Sitio2_Hoja1" en lugar de buscar la entrada de la cooperativa o de la ruta. (Cuando tiene intersite-L3out en el Sitio-B, entonces la columna Sitio-A crea un route-map llamado "infra-intersite-l3out" para redirigir el tráfico hacia ETEP del Sitio2_Leaf1 y salir de L3out.)

Site1_Spine# show bgp vpnv4 unicast neighbors 192.168.11.13 vrf overlay-1

BGP neighbor is 192.168.11.13, remote AS 65001, ibgp link, Peer index 4

BGP version 4, remote router ID 192.168.11.13

BGP state = Established, up for 10w4d

Using loopback12 as update source for this peer

Last read 00:00:03, hold time = 180, keepalive interval is 60 seconds

Last written 00:00:03, keepalive timer expiry due 00:00:56

Received 109631 messages, 0 notifications, 0 bytes in queue

Sent 109278 messages, 0 notifications, 0 bytes in queue

Connections established 1, dropped 0

Last reset by us never, due to No error

Last reset by peer never, due to No error

Neighbor capabilities:

Dynamic capability: advertised (mp, refresh, gr) received (mp, refresh, gr)

Dynamic capability (old): advertised received

Route refresh capability (new): advertised received

Route refresh capability (old): advertised received

4-Byte AS capability: advertised received

Address family VPNv4 Unicast: advertised received

Address family VPNv6 Unicast: advertised received

Address family L2VPN EVPN: advertised received

Graceful Restart capability: advertised (GR helper) received (GR helper)

Graceful Restart Parameters:

Address families advertised to peer:

Address families received from peer:

Forwarding state preserved by peer for:

Restart time advertised by peer: 0 seconds

Additional Paths capability: advertised received

Additional Paths Capability Parameters:

Send capability advertised to Peer for AF:

L2VPN EVPN

Receive capability advertised to Peer for AF:

L2VPN EVPN

Send capability received from Peer for AF:

L2VPN EVPN

Receive capability received from Peer for AF:

L2VPN EVPN

Additional Paths Capability Parameters for next session:

[E] - Enable [D] - Disable

Send Capability state for AF:

VPNv4 Unicast[E] VPNv6 Unicast[E]

Receive Capability state for AF:

VPNv4 Unicast[E] VPNv6 Unicast[E]

Extended Next Hop Encoding Capability: advertised received

Receive IPv6 next hop encoding Capability for AF:

IPv4 Unicast

Message statistics:

Sent Rcvd

Opens: 1 1

Notifications: 0 0

Updates: 1960 2317

Keepalives: 107108 107088

Route Refresh: 105 123

Capability: 104 102

Total: 109278 109631

Total bytes: 2230365 2260031

Bytes in queue: 0 0

For address family: VPNv4 Unicast

BGP table version 533, neighbor version 533

3 accepted paths consume 360 bytes of memory

3 sent paths

0 denied paths

Community attribute sent to this neighbor

Extended community attribute sent to this neighbor

Third-party Nexthop will not be computed.

Outbound route-map configured is infra-intersite-l3out, handle obtained <<<< route-map to redirect traffic from Site-A to Site-B 'Site2_Leaf1' L3out

For address family: VPNv6 Unicast

BGP table version 241, neighbor version 241

0 accepted paths consume 0 bytes of memory

0 sent paths

0 denied paths

Community attribute sent to this neighbor

Extended community attribute sent to this neighbor

Third-party Nexthop will not be computed.

Outbound route-map configured is infra-intersite-l3out, handle obtained

<snip...>

Site1_Spine# show route-map infra-intersite-l3out

route-map infra-intersite-l3out, permit, sequence 1

Match clauses:

ip next-hop prefix-lists: IPv4-Node-entry-102

ipv6 next-hop prefix-lists: IPv6-Node-entry-102

Set clauses:

ip next-hop 192.168.200.226

route-map infra-intersite-l3out, permit, sequence 2 <<<< This route-map match if destination IP of packet 'Site1_Spine' TEP address then send to 'Site2_Leaf1' ETEP address.

Match clauses:

ip next-hop prefix-lists: IPv4-Node-entry-1101

ipv6 next-hop prefix-lists: IPv6-Node-entry-1101

Set clauses:

ip next-hop 192.168.200.225

route-map infra-intersite-l3out, deny, sequence 999

Match clauses:

ip next-hop prefix-lists: infra_prefix_local_pteps_inexact

Set clauses:

route-map infra-intersite-l3out, permit, sequence 1000

Match clauses:

Set clauses:

ip next-hop unchanged

Site1_Spine# show ip prefix-list IPv4-Node-entry-1101

ip prefix-list IPv4-Node-entry-1101: 1 entries

seq 1 permit 10.0.80.64/32 <<

Site1_Spine# show ip prefix-list IPv4-Node-entry-102 ip prefix-list IPv4-Node-entry-102: 1 entries seq 1 permit 10.0.80.66/32 Site1_Spine# show ip prefix-list infra_prefix_local_pteps_inexact ip prefix-list infra_prefix_local_pteps_inexact: 1 entries seq 1 permit 10.0.0.0/16 le 32

Historial de revisiones

| Revisión | Fecha de publicación | Comentarios |

|---|---|---|

1.0 |

09-Dec-2021 |

Versión inicial |

Con la colaboración de ingenieros de Cisco

- Darshankumar MistryCisco TAC Engineer

Contacte a Cisco

- Abrir un caso de soporte

- (Requiere un Cisco Service Contract)

Comentarios

Comentarios