Ejemplo de Configuración de Nexus 5500 VM-FEX

Contenido

Introducción

Este documento describe cómo configurar, utilizar y resolver problemas de la función Virtual Machine Fabric Extender (VM-FEX) en switches Cisco Nexus 5500.

Prerequisites

Requirements

Cisco recomienda que tenga conocimientos básicos sobre estos temas.

- Canal de puerto virtual (VPC) Nexus

- VMware vSphere

Componentes Utilizados

La información que contiene este documento se basa en estas versiones de software y hardware.

- Nexus 5548UP que ejecuta la versión 5.2(1)N1(4)

- Servidor en rack Unified Computing System (UCS)-C C210 M2 con tarjeta de interfaz virtual UCS P81E que ejecuta la versión de firmware 1.4(2)

- vSphere versión 5.0 (ESXi y vCenter)

The information in this document was created from the devices in a specific lab environment. All of the devices used in this document started with a cleared (default) configuration. Si su red está activa, asegúrese de comprender el impacto potencial de cualquier comando o configuración de captura de paquetes.

Descripción general de VM-FEX

VM-FEX combina redes virtuales y físicas en una única infraestructura. Permite aprovisionar, configurar y administrar el tráfico de red de máquinas virtuales y el tráfico de red sin software específico dentro de una infraestructura unificada.

El software VM-FEX amplía la tecnología Cisco Fabric Extender a la máquina virtual con estas funciones:

- Cada máquina virtual incluye una interfaz dedicada en el switch principal.

- Todo el tráfico de la máquina virtual se envía directamente a la interfaz dedicada del switch.

- Se elimina el vSwitch estándar del hipervisor.

VM-FEX es un tipo de switch virtual distribuido (DVS o VDS). El DVS presenta una abstracción de un único switch en varios servidores ESX que forman parte del mismo contenedor del Data Center en vCenter. La configuración de Virtual Machine (VM) Virtual Network Interface Controller (VNIC) se mantiene desde una ubicación centralizada (Nexus 5000 o UCS en VM-FEX, este documento ilustra el VM-FEX basado en Nexus 5000).

VM-FEX puede funcionar en dos modos:

- Transferencia: Este es el modo predeterminado, en el que el VEM está involucrado en la trayectoria de datos para el tráfico de VM.

- Alto rendimiento: El VEM no gestiona el tráfico de VM, pero se pasa directamente al adaptador de virtualización de E/S de red (NIV).

Para utilizar el modo de alto rendimiento, debe solicitarlo la configuración del perfil de puerto y debe ser compatible con el sistema operativo VM y con su adaptador virtual. Más adelante en este documento se proporciona más información al respecto.

Definiciones

- Módulo Ethernet virtual (VEM). Módulo de software de Cisco que se ejecuta dentro del hipervisor ESX y proporciona la implementación de VNLink en un único paquete

- Network IO Virtualization (NIV) utiliza VNtagging para implementar varios enlaces de red virtual (VN-Link) en el mismo canal Ethernet físico

- Intercambio de capacidad de conexión en puente del Data Center (DCBX)

- Control de interfaz VNIC (VIC)

- NIC virtual (VNIC), que indica un punto final de host. Se puede asociar con una VIF activa o una VIF en espera

- Puerto virtual distribuido (DVPort). VNIC está conectado al DVPort en el VEM

- Interfaz virtual NIV (VIF), que se indica en un terminal de red

- La interfaz Ethernet virtual (vEth) representa la VIF en el switch

- Switch de paso (PTS). módulo VEM instalado en el hipervisor

Configurar

La topología es un servidor UCS-C con VIC P81E de doble conexión con dos switches VPC Nexus 5548.

Diagrama de la red

Estos componentes necesarios ya deben estar instalados:

- El VPC se configura e inicializa correctamente entre los dos switches Nexus 5000.

- VMWare vCenter está instalado y conectado a través de un cliente vSphere.

- ESXi se instala en el servidor UCS-C y se agrega a vCenter.

Los pasos de configuración se resumen a continuación:

- Activar el modo NIV en el adaptador del servidor:

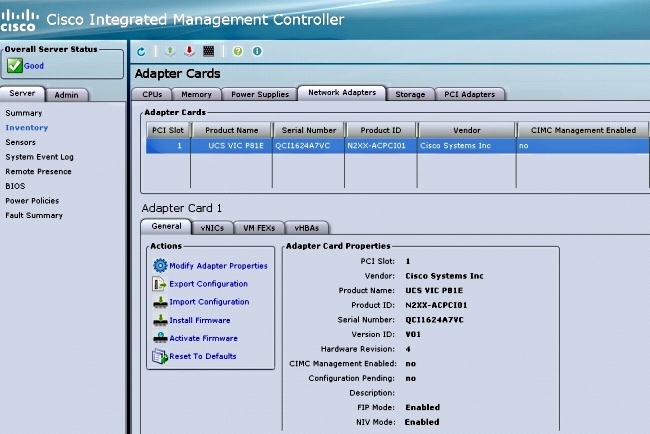

- Conéctese a la interfaz de Cisco Integrated Management Controller (CIMC) mediante HTTP e inicie sesión con las credenciales de administrador.

- Elija Inventory > Network Adapters > Modify Adapter Properties.

- Active el modo NIV, establezca el número de interfaces de VM FEX y guarde los cambios.

- Apague y, a continuación, encienda el servidor.

Después de que el servidor vuelva a estar en línea, verifique que NIV esté habilitado: - Conéctese a la interfaz de Cisco Integrated Management Controller (CIMC) mediante HTTP e inicie sesión con las credenciales de administrador.

- Cree dos vEths estáticos en el servidor.

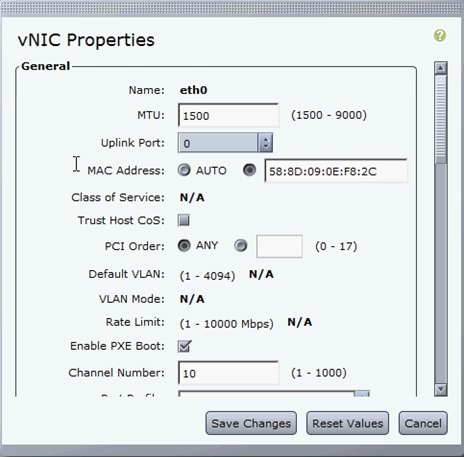

Para crear dos VNIC, elija Inventory > Network Adapters > VNICs > Add.

Estos son los campos más importantes que se deben definir:

- Puerto de enlace ascendente VIC que se utilizará (P81E tiene dos puertos de enlace ascendente a los que se hace referencia como 0 y 1).

- Número de canal: Este es un ID de canal único del VNIC en el adaptador. Esto se hace referencia en el comando bind bajo la interfaz vEth en el Nexus 5000. El alcance del número de canal se limita al link físico VNTag. El canal se puede considerar como un "link virtual" en el link físico entre el switch y el adaptador del servidor.

- Perfil de puerto: Se puede seleccionar la lista de perfiles de puerto definida en el Nexus 5000 ascendente. Se crea automáticamente una interfaz vEth en el Nexus 5000 si el Nexus 5000 se configura con el comando vEthernet auto-create. Tenga en cuenta que sólo se pasan al servidor los nombres de perfil de puerto vEthernet (la configuración de perfil de puerto no lo es). Esto ocurre después de que se establece la conectividad del link VNTag y se realizan los pasos iniciales de entrada en contacto y negociación entre el switch y el adaptador del servidor.

- Activar conmutación por fallo de enlace ascendente: Los VNIC conmutan por error al otro puerto de enlace ascendente P81E si el puerto de enlace ascendente configurado se desconecta.

- Puerto de enlace ascendente VIC que se utilizará (P81E tiene dos puertos de enlace ascendente a los que se hace referencia como 0 y 1).

- Reinicie el servidor

- Instale el VEM en el host ESXi.

Para ver un ejemplo de instalación del VEM en el host ESXi, refiérase a Instalación o Actualización del Cisco VEM Software Bundle en un Host ESX o ESXi en la Guía de Configuración de la GUI de Cisco UCS Manager VM-FEX para VMware, versión 2.1. - Habilite el conjunto de funciones de virtualización y las funciones VM-FEX y HTTP:

(config)# install feature-set virtualization

(config)# feature-set virtualization

(config)# feature vmfex

(config)# feature http-server

(Optional) Allow the Nexus 5000 to auto-create its Vethernet interfaces when the

corresponding vNICs are defined on the server:

(config)# vethernet auto-create - Habilite VNTag en las interfaces de host.

Configure the N5k interface that connects to the servers in VNTAG mode:

(config)# interface Eth 1/1

(config-if)# switchport mode vntag

(config-if)# no shutdown - Traiga vEths estáticos.

En ambos switches Nexus 5500, habilite las interfaces virtuales vEth estáticas que deben conectarse a las dos VNIC estáticas habilitadas en la VIC del servidor.

En el Nexus 5548-A, introduzca:interface vethernet 1

bind interface eth 1/1 channel 10

no shutdown

En el Nexus 5548-B, introduzca:interface vethernet 2

bind interface eth 1/1 channel 11

no shutdown

Alternativamente, estas interfaces vEth se pueden crear automáticamente con el comando vethernet auto-create.

Aquí está un ejemplo.

En cada uno de los dos Nexus 5000, configure:interface Vethernet1

description server_uplink1

bind interface Ethernet101/1/1 channel 11

bind interface Ethernet102/1/1 channel 11

interface Vethernet2

description server_uplink2

bind interface Ethernet101/1/1 channel 12

bind interface Ethernet102/1/1 channel 12 - Configure la conexión SVS a vCenter y conéctese.

En ambos switches Nexus 5500, configure:svs connection <name>

protocol vmware-vim

remote ip address <vCenter-IP> vrf <vrf>

dvs-name <custom>

vmware dvs datacenter-name <VC_DC_name>

En el switch principal VPC solamente, conéctese a vCenter:svs connection <name>

connect

Sample configuration on VPC primary:

svs connection MyCon

protocol vmware-vim

remote ip address 10.2.8.131 port 80 vrf management

dvs-name MyVMFEX

vmware dvs datacenter-name MyVC

connect

A continuación se muestra una configuración de ejemplo en VPC secundario:svs connection MyCon

protocol vmware-vim

remote ip address 10.2.8.131 port 80 vrf management

dvs-name MyVMFEX

vmware dvs datacenter-name MyVC - Cree perfiles de puerto en el Nexus 5000.

En ambos switches Nexus 5500, configure los perfiles de puerto para las VNIC VM-FEX. Estos perfiles de puerto aparecen como grupos de puertos del switch DVS en vCenter.

Aquí tiene un ejemplo:vlan 10,20

port-profile type vethernet VM1

dvs-name all

switchport mode access

switchport access vlan 10

no shutdown

state enabled

port-profile type vethernet VM2

dvs-name all

switchport mode access

switchport access vlan 20

no shutdown

state enabled

Modo de alto rendimiento de VM

Para implementar el modo de alto rendimiento (DirectPath IO) y eludir el hipervisor para el tráfico de VM, configure el perfil de puerto vEthernet con el comando high-performance host-netio. En el caso de las topologías VPC, el perfil de puerto siempre debe editarse en ambos switches de par VPC. Por ejemplo:port-profile type vethernet VM2

high-performance host-netio

Para que el modo de alto rendimiento esté operativo, su VM debe tener estos requisitos previos adicionales:

- El adaptador virtual de VM debe ser de tipo vmxnet3 (proteger vCenter: Haga clic con el botón derecho en VM > Edit settings > Network adapter > Adapter type en el menú derecho).

- La VM debe tener una reserva de memoria completa (en vCenter: Haga clic con el botón derecho del ratón en VM > Edit settings > Resources tab > Memory > Slide reservation slider to the right-most).

- El sistema operativo que se ejecuta en la máquina virtual debe admitir esta función.

A continuación se muestra cómo se verifica el modo de alto rendimiento (DirectPath IO) cuando se utiliza.

En VM Hardware Settings (Parámetros de hardware de VM), el campo DirectPath I/O del menú derecho se muestra como activo cuando el modo de alto rendimiento de VM está en uso y como inactivo cuando el modo de paso de VM predeterminado está en uso. - El adaptador virtual de VM debe ser de tipo vmxnet3 (proteger vCenter: Haga clic con el botón derecho en VM > Edit settings > Network adapter > Adapter type en el menú derecho).

- Registre el VPC primario Nexus 5548 en vCenter:

Conéctese mediante HTTP al VPC principal Nexus 5548 y descargue el archivo XML de extensión:

A continuación, registre ese complemento de extensión en vCenter: elija Plug-ins > Manage Plug-ins > Right click > New Plug-in. - Conéctese a vCenter. (Consulte el paso 8.)

- Verifique que Nexus 5000 se registre en vSphere como vDS:

Verifique la creación de un nuevo DVS en vCenter con el nombre definido en dvs-name bajo conexión svs en el Nexus 5000: elija Inicio > Inventario > Redes.

En el switch principal VPC Nexus 5000, verifique que la conexión SVS esté en línea con este comando:n5k1# show svs connections

Local Info:

-----------

connection MyCon:

ip address: 10.2.8.131

remote port: 80

vrf: management

protocol: vmware-vim https

certificate: default

datacenter name: MyVC

extension key: Cisco_Nexus_1000V_126705946

dvs name: MyVMFEX

DVS uuid: 89 dd 2c 50 b4 81 57 e4-d1 24 f5 28 df e3 d2 70

config status: Enabled

operational status: Connected

sync status: in progress

version: VMware vCenter Server 5.0.0 build-455964

Peer Info:

----------

connection MyCon:

ip address: 10.2.8.131

remote port: 80

vrf: management

protocol: vmware-vim https

extension key: Cisco_Nexus_1000V_126705946

certificate: default

certificate match: TRUE

datacenter name: MyVC

dvs name: MyVMFEX

DVS uuid: -

config status: Disabled

operational status: Disconnected

n5k1# - Asegúrese de que los grupos de puertos VM estén disponibles en vCenter.

Los perfiles de puerto vEthernet definidos en el Nexus 5000 deben aparecer en vCenter como grupos de puertos en el DVS en la vista de red: - Migre los hosts ESXi al DVS.

Desde VSphere, elija Home > Inventory > Networking, haga clic con el botón derecho en el nombre de DVS y luego Add Host para agregar los hosts ESXi al DVS.

Las interfaces virtuales Adapter-FEX son los enlaces ascendentes de los hosts ESXi. Elija el grupo de puertos de enlace ascendente predeterminado (used_or_quarantine_uplink) para esos puertos de enlace ascendente. - Aprovisione la VM.

Elija un grupo de puertos VM-FEX para el adaptador de red de una VM (haga clic con el botón derecho en VM > Edit Settings > Network Adapter > Network Label en el menú derecho). - VM VNIC aprovisionadas.

- El adaptador inicia la interfaz VIC creada para el switch.

Cuando se asigna un adaptador de red VM a un grupo de puertos VM-FEX, se crea dinámicamente una interfaz vEthernet en el Nexus 5000. El rango de interfaces vEth creadas dinámicamente comienza en 32769.

Estas interfaces se pueden verificar a través de estos comandos:# show interface virtual status

# show interface virtual summary

Verificación y resolución de problemas

Utilice esta sección para verificar que su configuración funciona correctamente y para resolver cualquier problema que encuentre.

- Para verificar que las dos VNIC estáticas del servidor UCS-C estén conectadas con el VN-Link a las interfaces estáticas de vEth fijas en el Nexus 5500, ingrese este comando:

n5k1# show system internal dcbx info interface e1/1

Interface info for if_index: 0x1a001000(Eth1/1)

tx_enabled: TRUE

rx_enabled: TRUE

dcbx_enabled: TRUE

DCX Protocol: CEE

DCX CEE NIV extension: enabled

<output omitted> - En caso de topologías activo/en espera a dos FEX de doble conexión, asegúrese de que la interfaz vEth se muestre como modo activo o en espera en los dos switches VPC Nexus 5000.

Aquí el modo se muestra como desconocido:

n5k1# show int virtual status

Interface VIF-index Bound If Chan Vlan Status Mode Vntag

-------------------------------------------------------------------------

Veth1 VIF-16 Eth101/1/1 11 1 Up Active 2

Veth1 None Eth102/1/1 11 0 Init Unknown 0

Veth2 None Eth101/1/1 12 0 Init Unknown 0

Veth2 None Eth102/1/1 12 0 Init Unknown 0

Veth3 VIF-18 Eth101/1/2 11 1 Up Active 2

Veth3 None Eth102/1/2 11 0 Init Unknown 0

Veth4 None Eth101/1/2 12 0 Init Unknown 0

Veth4 VIF-19 Eth102/1/2 12 1 Up Active 3

Si encuentra el modo desconocido, asegúrese de habilitar el modo de conmutación por fallas de link ascendente en el VNIC. Asegúrese también de que el número de canal especificado en el CIMC coincida con el número de canal especificado en la configuración de vEthernet.

El resultado correcto debe parecerse a lo siguiente:n5k1# show int virtual status

Interface VIF-index Bound If Chan Vlan Status Mode Vntag

-------------------------------------------------------------------------

Veth1 VIF-27 Eth101/1/1 11 1 Up Active 2

Veth1 VIF-35 Eth102/1/1 11 1 Up Standby 2

Veth2 VIF-36 Eth101/1/1 12 1 Up Standby 3

Veth2 VIF-33 Eth102/1/1 12 1 Up Active 3

Veth3 VIF-30 Eth101/1/2 11 1 Up Active 2

Veth3 VIF-21 Eth102/1/2 11 1 Up Standby 2

Veth4 VIF-24 Eth101/1/2 12 1 Up Standby 3

Veth4 VIF-31 Eth102/1/2 12 1 Up Active 3 - Las interfaces vEth no aparecen en el switch.

En el menú HTTP de CIMC del servidor UCS-C, verifique que:

- NIV está activado en el adaptador.

- En el adaptador se configura un número distinto de cero de interfaces VM-FEX.

- La conmutación por fallas del adaptador está habilitada en la VNIC.

- El servidor UCS-C se reinició después de realizar la configuración anterior.

- NIV está activado en el adaptador.

- Las interfaces vEth no se conectan.

Compruebe si VIF_CREATE aparece en este comando:# show system internal vim info logs interface veth 1

03/28/2014 16:31:47.770137: RCVD VIF CREATE request on If Eth1/32 <<<<<<<

03/28/2014 16:31:53.405004: On Eth1/32 - VIC CREATE sending rsp for msg_id 23889

to completion code SUCCESS

03/28/2014 16:32:35.739252: On Eth1/32 - RCVD VIF ENABLE. VIF-index 698 msg id 23953

VIF_ID: 0, state_valid: n, active

03/28/2014 16:32:35.802019: On Eth1/32 - VIC ENABLE sending rsp for msg_id 23953 to

completion code SUCCESS

03/28/2014 16:32:36.375495: On Eth1/32 - Sent VIC SET, INDEX: 698, msg_id 23051, up,

enabled, active, cos 0VIF_ID: 50 vlan:

1 rate 0xf4240, burst_size 0xf

03/28/2014 16:32:36.379441: On Eth1/32 - RCVD VIC SET resp, INDEX: 698, msg_id 23051,

up, enabled,active, cos 0, completion

code: 100

Si VIF_CREATE no aparece o el switch no responde correctamente, siga estos pasos:

- En vCenter, verifique que el switch DVS se haya configurado correctamente con dos enlaces ascendentes físicos para el host ESX (haga clic con el botón derecho en el switch DVS > Manage Hosts > Select Physical Adapters).

- En vCenter, verifique que VMNIC haya seleccionado la etiqueta de red/perfil de puerto correcta (haga clic con el botón derecho en VM > Edit Settings > Click en Network adapter > check Network label).

- En vCenter, verifique que el switch DVS se haya configurado correctamente con dos enlaces ascendentes físicos para el host ESX (haga clic con el botón derecho en el switch DVS > Manage Hosts > Select Physical Adapters).

- La conexión SVS a vCenter no se conecta.

Como se muestra en el paso 12 de la sección anterior, utilice este proceso para verificar que el Nexus 5000 se conectó a vCenter:

- En vCenter, verifique que el DVS aparezca en la vista de red.

- En el VPC primario Nexus 5000, verifique que el SVS esté conectado (utilice el comando show svs connection).

En caso de que no se establezca la conexión, verifique que:

- La configuración SVS es idéntica en ambos pares VPC.

- VPC se inicializa y las funciones se establecen correctamente.

- El certificado XML del switch principal de VPC se instala en vCenter.

- El switch principal VPC tiene "conexión" configurada en el modo de configuración "conexión svs".

- El nombre del Data Center coincide con el nombre utilizado en vCenter.

- El routing y reenvío virtual (VRF) correcto se configura en el comando remoto SVS y el switch tiene conectividad IP con la dirección IP del vCenter.

Si se cumplen todas estas condiciones pero la conexión SVS aún no se realiza correctamente, recopile este resultado y póngase en contacto con el centro de asistencia técnica Cisco Technical Assistance Center (TAC):show msp port-profile vc sync-status

show msp internal errors

show msp internal event-history msgs

show vms internal errors

show vms internal event-history msgs - En vCenter, verifique que el DVS aparezca en la vista de red.

- El switch Nexus 5500 no se puede alcanzar a través de HTTP.

Verifique que la función http-server esté habilitada:n5k1# show feature | i http

http-server 1 disabled

n5k1# conf t

Enter configuration commands, one per line. End with CNTL/Z.

n5k1(config)# feature http-server

n5k1(config)#

Historial de revisiones

| Revisión | Fecha de publicación | Comentarios |

|---|---|---|

1.0 |

15-May-2014 |

Versión inicial |

Contacte a Cisco

- Abrir un caso de soporte

- (Requiere un Cisco Service Contract)

Comentarios

Comentarios