Configuración de QoS en un UCS y Nexus 5000

Opciones de descarga

-

ePub (117.4 KB)

Visualice en diferentes aplicaciones en iPhone, iPad, Android, Sony Reader o Windows Phone -

Mobi (Kindle) (145.5 KB)

Visualice en dispositivo Kindle o aplicación Kindle en múltiples dispositivos

Lenguaje no discriminatorio

El conjunto de documentos para este producto aspira al uso de un lenguaje no discriminatorio. A los fines de esta documentación, "no discriminatorio" se refiere al lenguaje que no implica discriminación por motivos de edad, discapacidad, género, identidad de raza, identidad étnica, orientación sexual, nivel socioeconómico e interseccionalidad. Puede haber excepciones en la documentación debido al lenguaje que se encuentra ya en las interfaces de usuario del software del producto, el lenguaje utilizado en función de la documentación de la RFP o el lenguaje utilizado por un producto de terceros al que se hace referencia. Obtenga más información sobre cómo Cisco utiliza el lenguaje inclusivo.

Acerca de esta traducción

Cisco ha traducido este documento combinando la traducción automática y los recursos humanos a fin de ofrecer a nuestros usuarios en todo el mundo contenido en su propio idioma. Tenga en cuenta que incluso la mejor traducción automática podría no ser tan precisa como la proporcionada por un traductor profesional. Cisco Systems, Inc. no asume ninguna responsabilidad por la precisión de estas traducciones y recomienda remitirse siempre al documento original escrito en inglés (insertar vínculo URL).

Contenido

Introducción

Este documento describe la configuración de calidad de servicio (QoS) en los dispositivos Unified Computing System (UCS) y Nexus.

Prerequisites

Requirements

No hay requisitos específicos para este documento.

Componentes Utilizados

La información que contiene este documento se basa en las siguientes versiones de software y hardware.

- Fabric Interconnect (FI) 6100 y 6200 de UCS

- Nexus 5000 y 5500

The information in this document was created from the devices in a specific lab environment. All of the devices used in this document started with a cleared (default) configuration. Si tiene una red en vivo, asegúrese de entender el posible impacto de cualquier comando.

Antecedentes

Este documento trata sobre UCS(Fabric Interconnects 6100 y 6200) y QoS Nexus(5000 y 5500) específicamente relacionados con FlexPod y vBlock.

Terminología utilizada en esta documentación relacionada con QoS.

CoS = Clase de servicio = 802.1p = 3 bits en el encabezado .1q en cada paquete para decirle al switch cómo clasificar.

QoS = Calidad de servicio = Cómo maneja el switch cada clase de servicio.

MTU = Unidad máxima de transmisión = Tamaño máximo de una trama/paquete permitido en el switch. El valor más común y predeterminado (normal es lo que muestra la captura de pantalla de UCS) es 1500.

Configurar

QoS de UCS lista para usar

La configuración de QoS de UCS para referencia (UCSM/LAN/QoS System Class):

Nota: El mejor esfuerzo y el canal de fibra están atenuados y no se pueden deshabilitar en UCS.

Configuración de QoS predeterminada

P10-UCS-A(nxos)# show running-config ipqos

logging level ipqosmgr 2

class-map type qos class-fcoe

class-map type queuing class-fcoe

match qos-group 1

class-map type queuing class-all-flood

match qos-group 2

class-map type queuing class-ip-multicast

match qos-group 2

policy-map type qos system_qos_policy

class class-fcoe

set qos-group 1

class class-default

policy-map type queuing system_q_in_policy

class type queuing class-fcoe

bandwidth percent 50

class type queuing class-default

bandwidth percent 50

policy-map type queuing system_q_out_policy

class type queuing class-fcoe

bandwidth percent 50

class type queuing class-default

bandwidth percent 50

class-map type network-qos class-fcoe

match qos-group 1

class-map type network-qos class-all-flood

match qos-group 2

class-map type network-qos class-ip-multicast

match qos-group 2

policy-map type network-qos system_nq_policy

class type network-qos class-fcoe

pause no-drop

mtu 2158

class type network-qos class-default

system qos

service-policy type qos input system_qos_policy

service-policy type queuing input system_q_in_policy

service-policy type queuing output system_q_out_policy

service-policy type network-qos system_nq_policy

Información relevante:

- qos-group es la forma en que el switch trata internamente un CoS determinado. Piense en qos-group como una cubeta o lane en la que entra cada paquete.

- Best Effort no obtiene un qos-group explícito, por lo que es el valor predeterminado para qos-group 0

- Fibre Channel over Ethernet (FCoE) tiene CoS 3 y se coloca en el grupo de QoS 1

CoS <=> hoja de referencia de qos-group

| CoS | qos-group | |

| Platino | 5 | 2 |

| Gold | 4 | 3 |

| Plata | 2 | 4 |

| Bronce | 1 | 5 |

| Mejor esfuerzo | cualquiera | 0 |

| Fibre Channel | 3 | 1 |

La CoS se puede cambiar a CoS 6 en UCS. CoS 7 está reservado para las comunicaciones internas de UCS.

comando show queuing interface

P10-UCS-A(nxos)# show queuing interface

Ethernet1/1 queuing information:

TX Queuing

qos-group sched-type oper-bandwidth

0 WRR 50

1 WRR 50

RX Queuing

qos-group 0

q-size: 360640, HW MTU: 1500 (1500 configured)

drop-type: drop, xon: 0, xoff: 360640

Statistics:

Pkts received over the port : 27957

Ucast pkts sent to the cross-bar : 0

Mcast pkts sent to the cross-bar : 27957

Ucast pkts received from the cross-bar : 0

Pkts sent to the port : 347

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

qos-group 1

q-size: 79360, HW MTU: 2158 (2158 configured)

drop-type: no-drop, xon: 20480, xoff: 40320

Statistics:

Pkts received over the port : 0

Ucast pkts sent to the cross-bar : 0

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 0

Pkts sent to the port : 0

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

Total Multicast crossbar statistics:

Mcast pkts received from the cross-bar : 347

Este resultado muestra cómo esta interfaz pone en cola cada clase.

Información sobre el switchport Ethernet 1/1:

- El mejor esfuerzo obtiene qos-group 0 y un tamaño Q de 360640 bytes de búferes y una MTU de 1500.

- Este puerto ingresó/recibió 27957 paquetes de mejor esfuerzo y egresó/envió 347 paquetes.

- "Los paquetes descartados en el ingreso" es el número de paquetes que se han recibido pero durante ese instante el buffer(q-size) estaba lleno y el switch decidió descartar, esto también se conoce como descarte de cola.

puerto IOM que

Mostrar interfaz de cola para los puertos de los módulos de entrada y salida (IOM) en el chasis UCS:

Ethernet1/1/1 queuing information: Input buffer allocation: Qos-group: 1 frh: 3 drop-type: no-drop cos: 3 xon xoff buffer-size ---------+---------+----------- 8960 14080 24320 Qos-group: 0 frh: 8 drop-type: drop cos: 0 1 2 4 5 6 xon xoff buffer-size ---------+---------+----------- 0 117760 126720 Queueing: queue qos-group cos priority bandwidth mtu --------+------------+--------------+---------+---------+---- 2 0 0 1 2 4 5 6 WRR 50 1600 3 1 3 WRR 50 2240 Queue limit: 66560 bytes Queue Statistics: queue rx tx ------+---------------+--------------- 2 18098 28051 3 0 0 Port Statistics: rx drop rx mcast drop rx error tx drop mux ovflow ---------------+---------------+---------------+---------------+-------------- 0 0 0 0 InActive Priority-flow-control enabled: yes Flow-control status: cos qos-group rx pause tx pause masked rx pause -------+-----------+---------+---------+--------------- 0 0 xon xon xon 1 0 xon xon xon 2 0 xon xon xon 3 1 xon xon xon 4 0 xon xon xon 5 0 xon xon xon 6 0 xon xon xon 7 n/a xon xon xon

Hay qos-group 0 y qos-group 1, qos-group 0 obtiene paquetes marcados con cos 0 1 2 4 5 6 y qos-group 1 get cos 3. El tamaño del búfer en Fabric Extender (FEX)/IOM es un poco más pequeño y solo 126720 bytes. El FEX realiza QoS de manera ligeramente diferente y toma varios grupos de QoS y los agrupa en una cola. Se pueden ver los contadores rx y tx para cada cola.

show interface priority-flow-control

El último resultado que se desprotegerá es: show interface priority-flow-control

P10-UCS-A(nxos)# show interface priority-flow-control ============================================================ Port Mode Oper(VL bmap) RxPPP TxPPP ============================================================ Ethernet1/1 Auto Off 0 0 Ethernet1/2 Auto Off 0 0 Ethernet1/3 Auto Off 0 0 Ethernet1/4 Auto Off 6 0 Ethernet1/5 Auto Off 0 0 Ethernet1/6 Auto Off 0 0 Ethernet1/7 Auto Off 0 0 Ethernet1/8 Auto Off 0 0 Ethernet1/9 Auto Off 0 0 Ethernet1/10 Auto Off 2 0 ..snip.. Vethernet733 Auto Off 0 0 Vethernet735 Auto Off 0 0 Vethernet737 Auto Off 0 0 Ethernet1/1/1 Auto On (8) 0 0 Ethernet1/1/2 Auto Off 0 0 Ethernet1/1/3 Auto On (8) 0 0 Ethernet1/1/4 Auto Off 0 0

Esto muestra qué interfaces negocia el control de flujo de prioridad (PFC) (Auto On) y qué interfaces PFC no negocia (Auto Off). La PFC es una manera para que un switch pida a un switch vecino que no envíe paquetes de una CoS específica durante un breve período de tiempo. Las pausas PFC (PPP,por pausa de prioridad) se producen cuando las memorias intermedias están llenas/casi llenas. La salida de "show cdp neighbors" y "show fex details" nos indica que Ethernet 1/1-4 se ha reducido a FEX/IOM del chasis 1 y Ethernet 1/9-10 a Nexus 5000. En este resultado, se enviaron 6 pausas hacia abajo a FEX/IOM en Ethernet 1/4 y se han enviado 2 pausas Ethernet1/10 al Nexus 5000 ascendente.

- ¡LOS PROPIOS PPP NO SON ALGO MALO!

Nota: Debido a que FEX/IOM no son realmente switches, PFC NO negocia entre ellos en Ethernet1/1-4, sino que puede negociar con el terminal Ethernet1/1/1. Los PPPs enviados a un FEX/IOM se envían a través del switchport remoto Ethernet1/1/1.

Así es como UCS QoS está listo para usar....

¿Qué sucede si Silver está activado?

Esto da como resultado la configuración:

class-map type qos class-fcoe

class-map type qos match-all class-silver match cos 2 class-map type queuing class-silver match qos-group 4

class-map type queuing class-all-flood

match qos-group 2

class-map type queuing class-ip-multicast

match qos-group 2

policy-map type qos system_qos_policy

class class-silver set qos-group 4

policy-map type queuing system_q_in_policy

class type queuing class-silver bandwidth percent 44

class type queuing class-fcoe

bandwidth percent 29

class type queuing class-default

bandwidth percent 27

policy-map type queuing system_q_out_policy

class type queuing class-silver bandwidth percent 44

class type queuing class-fcoe

bandwidth percent 29

class type queuing class-default

bandwidth percent 27

policy-map type queuing org-root/ep-qos-Default-Qos

class type queuing class-fcoe

class type queuing class-default

bandwidth percent 50

shape 40000000 kbps 10240

class-map type network-qos class-silver match qos-group 4class-map type network-qos class-all-flood

match qos-group 2

class-map type network-qos class-ip-multicast

match qos-group 2

policy-map type network-qos system_nq_policy

class type network-qos class-silver

class type network-qos class-fcoe

pause no-drop

mtu 2158

class type network-qos class-default

system qos

service-policy type qos input system_qos_policy

service-policy type queuing input system_q_in_policy

service-policy type queuing output system_q_out_policy

service-policy type network-qos system_nq_policy

Ethernet1/1 queuing information:

TX Queuing

qos-group sched-type oper-bandwidth

0 WRR 27

1 WRR 29

4 WRR 44

RX Queuing

qos-group 0

q-size: 308160, HW MTU: 9216 (9216 configured)

drop-type: drop, xon: 0, xoff: 301120

Statistics:

Pkts received over the port : 12

Ucast pkts sent to the cross-bar : 12

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 17

Pkts sent to the port : 17

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

qos-group 1

q-size: 79360, HW MTU: 2158 (2158 configured)

drop-type: no-drop, xon: 20480, xoff: 40320

Statistics:

Pkts received over the port : 7836003

Ucast pkts sent to the cross-bar : 7836003

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 4551954

Pkts sent to the port : 4551954

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

qos-group 4 q-size: 22720, HW MTU: 1500 (1500 configured)

drop-type: drop, xon: 0, xoff: 22720

Statistics:

Pkts received over the port : 0

Ucast pkts sent to the cross-bar : 0

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 0

Pkts sent to the port : 0

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

Observe que el mejor esfuerzo (qos-group 0) q-size pasó de 360640 a 308160 porque Silver (qos-group 4) estaba asignado a 2720 espacio de búfers.

¿Y si Silver se hace Jumbo?

Establezca MTU en 9216.

Ethernet1/1 queuing information:

TX Queuing

qos-group sched-type oper-bandwidth

0 WRR 27

1 WRR 29

4 WRR 44

RX Queuing

qos-group 0

q-size: 301120, HW MTU: 9216 (9216 configured)

drop-type: drop, xon: 0, xoff: 301120

Statistics:

Pkts received over the port : 3

Ucast pkts sent to the cross-bar : 3

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 0

Pkts sent to the port : 0

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

qos-group 1

q-size: 79360, HW MTU: 2158 (2158 configured)

drop-type: no-drop, xon: 20480, xoff: 40320

Statistics:

Pkts received over the port : 7842224

Ucast pkts sent to the cross-bar : 7842224

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 4555791

Pkts sent to the port : 4555791

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

qos-group 4

q-size: 29760, HW MTU: 9216 (9216 configured)

drop-type: drop, xon: 0, xoff: 29760

Statistics:

Pkts received over the port : 0

Ucast pkts sent to the cross-bar : 0

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 0

Pkts sent to the port : 0

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

Silver(qos-group 4) ahora obtiene 29760 de tamaño Q, en comparación con 22720.

¿Qué sucede si Silver no se realiza una gota?

¿Desmarca el parámetro Packet Drop?

Ethernet1/1 queuing information:

TX Queuing

qos-group sched-type oper-bandwidth

0 WRR 27

1 WRR 29

4 WRR 44

RX Queuing

qos-group 0

q-size: 240640, HW MTU: 9216 (9216 configured)

drop-type: drop, xon: 0, xoff: 240640

Statistics:

Pkts received over the port : 20

Ucast pkts sent to the cross-bar : 20

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 1

Pkts sent to the port : 1

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

qos-group 1

q-size: 79360, HW MTU: 2158 (2158 configured)

drop-type: no-drop, xon: 20480, xoff: 40320

Statistics:

Pkts received over the port : 7837323

Ucast pkts sent to the cross-bar : 7837323

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 4552726

Pkts sent to the port : 4552726

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

qos-group 4 q-size: 90240, HW MTU: 9216 (9216 configured)

drop-type: no-drop, xon: 17280, xoff: 37120

Statistics:

Pkts received over the port : 0

Ucast pkts sent to the cross-bar : 0

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 0

Pkts sent to the port : 0

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

Observe que el tamaño cuadrado Silver (qos-group 4) aumenta a 90240, drop-type cambia a no-drop y Best Effort qos-group 0 se reduce a 240640.

El espacio de búfer de grupo 0 de QoS Best Effort se reasigna a otras clases de QoS.

Upstream Nexus 5000

Las configuraciones de QoS predeterminadas de Nexus 5000 son similares pero no exactas.

show running-config ipqos

P10-5k-a# show running-config ipqos

policy-map type network-qos jumbo

class type network-qos class-fcoe

pause no-drop

mtu 2158

class type network-qos class-default

mtu 9216

multicast-optimize

system qos

service-policy type network-qos jumbo

El Nexus 5000 oculta las opciones predeterminadas, por lo que show running-config ipqos all es necesario para ver toda la configuración.

show queuing interface

P10-5k-a# show queuing interface

Ethernet1/1 queuing information:

TX Queuing

qos-group sched-type oper-bandwidth

0 WRR 100

1 WRR 0

RX Queuing

qos-group 0

q-size: 360640, HW MTU: 9216 (9216 configured)

drop-type: drop, xon: 0, xoff: 360640

Statistics:

Pkts received over the port : 16

Ucast pkts sent to the cross-bar : 16

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 0

Pkts sent to the port : 0

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

qos-group 1

q-size: 79360, HW MTU: 2158 (2158 configured)

drop-type: no-drop, xon: 20480, xoff: 40320

Statistics:

Pkts received over the port : 0

Ucast pkts sent to the cross-bar : 0

Mcast pkts sent to the cross-bar : 0

Ucast pkts received from the cross-bar : 0

Pkts sent to the port : 0

Pkts discarded on ingress : 0

Per-priority-pause status : Rx (Inactive), Tx (Inactive)

show interface priority-flow-control

Los puertos que se dirigen a UCS (Ethernet1/1 - 2) tienen PFC desactivado(Auto Off).

P10-5k-a(config-if-range)# show interface priority-flow-control ============================================================ Port Mode Oper(VL bmap) RxPPP TxPPP ============================================================ Ethernet1/1 Auto Off 0 0 Ethernet1/2 Auto Off 0 0 Ethernet1/3 Auto Off 0 0 Ethernet1/4 Auto Off 0 0 Ethernet1/5 Auto Off 0 0 Ethernet1/6 Auto Off 0 0 Ethernet1/7 Auto Off 0 0 Ethernet1/8 Auto Off 0 0 Ethernet1/9 Auto Off 0 0 Ethernet1/10 Auto On (0) 0 0 Ethernet1/11 Auto On (0) 0 0 Ethernet1/12 Auto On (0) 0 0 Ethernet1/13 Auto On (0) 0 0

..snip..

Agregar FCoE a la configuración

Estas políticas se encuentran en el Nexus 5000 de forma predeterminada, pero no están habilitadas, por lo que solo es necesario usarlas.

system qos service-policy type queuing input fcoe-default-in-policy service-policy type queuing output fcoe-default-out-policy service-policy type qos input fcoe-default-in-policy

show interface priority-flow-control

Los puertos hasta UCS (Ethernet1/1 - 2) tienen PFC activado (encendido automático).

P10-5k-a(config-sys-qos)# sh int priority-flow-control ============================================================ Port Mode Oper(VL bmap) RxPPP TxPPP ============================================================ Ethernet1/1 Auto On (8) 0 0 Ethernet1/2 Auto On (8) 0 0 Ethernet1/3 Auto Off 0 0 Ethernet1/4 Auto Off 0 0

..snip..

PFC

PFC(802.1Qbb) es la forma en que los dispositivos Nexus/UCS crean un fabric sin pérdidas como parte del puente de Data Center (DCBX). FCoE requiere un fabric sin pérdidas, y FCoE multisalto es especialmente propenso a este problema de configuración. El switch ascendente, normalmente un Nexus 5000, debe coincidir con la configuración de QoS configurada en UCS.

Como se ha indicado anteriormente, PFC es una manera de que los switches notifiquen a los switches vecinos que se detengan para enviar tramas adicionales. Piense en esto en el contexto de un entorno de red de switch múltiple con tráfico que va en muchas direcciones a la vez, no sólo agrega búfers de path1(source1/destination1) esto está multiplicando los búferes porque el switch vecino probablemente tenga tráfico que ingresa varios puertos(buffers múltiples). Aunque no se requiere PFC cuando se utiliza almacenamiento IP, a menudo ayuda a mejorar drásticamente el rendimiento debido a este efecto de multiplicación del búfer que evita la pérdida innecesaria de paquetes.

Una excelente descripción general de PFC/DCBX.

¿Por qué PFC NO negocia?

La política de QoS sin descarte debe coincidir en cada lado.

Si una clase de QoS se define en un switch como no drop y no como no drop en el otro, PFC no negocia. Dado que UCS configura Platinum como no drop pero está desactivada, esto ocurre a menudo cuando Platinum está habilitado.

La QoS del sistema debe coincidir en cada lado

Si la entrada de cola y la salida de cola y la entrada de QoS no coinciden, PFC no negocia.

NetApp

Gold

De forma predeterminada, los filtros de NetApp envían TODO el tráfico de almacenamiento IP etiquetado por la red NetApp en CoS 4 (Gold). Como los bits de CoS están en el encabezado .1q cuando NetApp está conectado a un puerto de acceso, el tráfico de NetApp se pone en el mejor esfuerzo.

QoS asimétrica

Un error común de configuración es elegir otro color CoS (Silver) para poner el tráfico NFS de sistema de archivos de red de UCS en y devolver el tráfico NFS de una NetApp en Gold. Así que el tráfico es algo así:

| Servidor | UCS | Nexus 5K | NetApp |

| Enviar | Silver > | Silver > | Mejor esfuerzo |

| ‘Recibir’ | < Gold | < Gold | < Gold |

Si UCS estuviera configurado para que Silver fuera Jumbo pero NO Gold, esto causaría problemas.

QoS no definida

Cuando NO se habilita una clase de QoS (Platinum/Gold/Silver/Bronze), los dispositivos UCS y Nexus tratan esos paquetes como Best Effort (Mayor esfuerzo) y los colocan en qos-group 0.

| Servidor | UCS | Nexus 5K | NetApp |

| Enviar | Silver > | Mejor esfuerzo > | Mejor esfuerzo |

| ‘Recibir’ | < Gold | < Mejor esfuerzo | < Gold |

Nota: los bits de CoS en el paquete NO se modifican/remarcan, pero los paquetes se tratan de manera diferente.

QoS de entorno de informática virtual (VCE)

El diseño de QoS de VCE es menos que ideal.

| Nexus 1000 | UCS | Nexus 5K | |

| BE / CoS 0 | 1500 | 1500 | 1600 |

| FC/CoS 1 | - | 2158 (sin caída) | - |

| CoS 6 |

mgmt | - | - |

| Platino/CoS 5 |

- | 1500 (sin caída) | 1500 |

| Gold/CoS 4 | vmotion | 1500 | 1500 |

| Silver/CoS 2 | NFS | - | 9216 (sin caída) |

Si tiene clases de CoS definidas en un nivel, pero ignoradas en otro nivel es complicado y podría hacer que las cosas no funcionen como se pretendía. Por ejemplo, VCE utiliza Silver para NFS, pero si UCS no tiene Silver definido, este tráfico se coloca en cola en Best Effort (Mayor esfuerzo), que no es Jumbo y puede provocar que el tráfico NFS se descarte o se fragmente. La PFC no se negocia debido a las discordancias en las políticas de no descartar, pero evidentemente esto está bien porque la PFC no es necesaria para la Ethernet.

Búferes poco profundos

Los protocolos de almacenamiento basados en el protocolo de Internet (IP) son protocolos muy ráfagas y a menudo se configuran con 9000 MTU. Como tales, el rendimiento en Platinum/Gold/Silver/Bronze debido a la MTU de tamaño q/9000 de 29760 sólo permite 3 paquetes en el buffer antes de que se produzca la caída de cola.

Búfers más grandes

La política Ethernet de UCS permite aumentar los búferes vNIC (tamaño del anillo). El valor predeterminado es 512 y el máximo es 4096. si cambia este valor al máximo, la latencia completa del búfer (##KB / 10Gbps) aumenta de 0,4 ms a 3,2 ms. Por lo tanto, los cambios en este búfer permiten menos caídas, pero a expensas de una mayor latencia.

9216 MTU frente a 9000 MTU

El punto de la configuración de tramas gigantes es permitir que un dispositivo terminal hable con otro dispositivo terminal con paquetes de capa 3 de 9000 bytes. Cuando se utilizan técnicas de encapsulación de capa 2, los switches y routers entre los dispositivos de terminal deben poder manejar tramas de capa 2 ligeramente más grandes que los paquetes de capa 3 de MTU de 9000 para tener en cuenta la sobrecarga de encapsulación. En caso de duda, permita 9216 MTU en los switches.

PFC y PPP

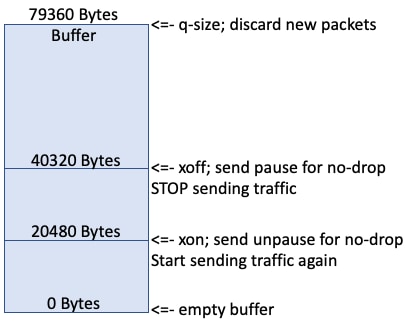

A medida que se ponen en cola nuevos paquetes, el búfer se llena.

Cuando el búfer alcanza los 20k, el búfer continúa llenándose.

Cuando el búfer llega a 40k, el switch envía una pausa PPP si esta cola no es de descarte, lo que indica que el switch remoto se detiene para enviar tráfico.

Idealmente, el lado remoto se detiene pronto para enviar tráfico y el resto del búfer (79360-40320) contiene paquetes entrantes en vuelo.

Los contadores de "paquetes descartados en el ingreso" aumentan cuando el búfer está lleno.

FC y FCoE es un protocolo sin pérdidas en una situación ideal en la que el switch remoto se detiene para enviar tráfico y niveles de búfer que eventualmente caen y alcanzan los 20k. El switch envía otra pausa PPP para esta cola sin descarte que indica al switch remoto que comience a enviar tráfico de nuevo.

Troubleshoot

Actualmente no hay información de troubleshooting específica disponible para esta configuración.

Información Relacionada

Con la colaboración de ingenieros de Cisco

- Steven TardyCisco TAC Engineers

- and Pom HamCisco TAC Engineers

Contacte a Cisco

- Abrir un caso de soporte

- (Requiere un Cisco Service Contract)

Comentarios

Comentarios