Introduction

Ce document décrit l'analyse de la connectivité réseau ou de la durée de vie du paquet pour un domaine UCS (Unified Computing System) en mode géré Intersight et identifie la connexion interne des serveurs avec l'Explorateur d'API et les commandes NXOS.

Contribution de Luis Uribe, ingénieur TAC Cisco.

Conditions préalables

Conditions requises

Cisco vous recommande de prendre connaissance des rubriques suivantes :

- Intersight

- Connectivité réseau physique

- API (Application Programming Interface)

Composants utilisés

Les informations contenues dans ce document sont basées sur les versions de matériel et de logiciel suivantes :

- Interconnexion de fabric Cisco UCS 6454, microprogramme 4.2(1e)

- Serveur lame UCSB-B200-M5, microprogramme 4.2(1a)

- Logiciel Intersight as a Service (SaaS)

The information in this document was created from the devices in a specific lab environment. All of the devices used in this document started with a cleared (default) configuration. Si votre réseau est en ligne, assurez-vous de bien comprendre l’incidence possible des commandes.

Informations générales

La connexion entre les interconnexions de fabric et les vNIC (Virtual Network Interface) est établie via des circuits virtuels, appelés VIF (Virtual Interface). Ces VIF sont épinglés vers des liaisons ascendantes et permettent la communication avec le réseau en amont

En mode géré Intersight, aucune commande ne mappe les interfaces virtuelles avec chaque serveur, par exemple show service-profile circuit. Les commandes API Explorer/NXOS peuvent être utilisées afin de déterminer la relation des circuits internes créés dans le domaine UCS.

Explorateur d'API

L'explorateur d'API est disponible à partir de l'interface graphique utilisateur de l'une ou l'autre des interconnexions de fabric (principale ou subordonnée). Une fois connecté à la console, accédez à Inventaire, sélectionnez le serveur, puis cliquez sur Lancer l'Explorateur d'API.

L'Explorateur d'API contient une référence d'API, qui répertorie les appels disponibles. Il inclut également une interface client de transfert d'état de représentation (REST) pour tester les appels API.

Identification du VIF par les appels API

Vous pouvez utiliser un ensemble d'appels API pour déterminer quelle VIF correspond à chaque vNIC virtuelle. Cela vous permet de dépanner NXOS plus efficacement.

Pour les besoins de ce document, la navigation avec les appels API se fait par l'intermédiaire des éléments suivants : Châssis, serveur, adaptateur réseau, vNIC/vHBA.

| Appel API |

Syntaxe |

| ID du châssis GET |

/redfish/v1/Chassis |

| GET ID adaptateur |

/redfish/v1/Châssis/{ChassisId}/NetworkAdapters |

| GET Network details (liste de vnics/vhbas) |

/redfish/v1/Châssis/{ChassisId}/NetworkAdapters/{NetworkAdapterId} |

| GET Fonctions des périphériques réseau (configuration vNIC) |

/redfish/v1/Châssis/{ChassisId}/NetworkAdapters/{NetworkAdapterId}/NetworkDeviceFunctions |

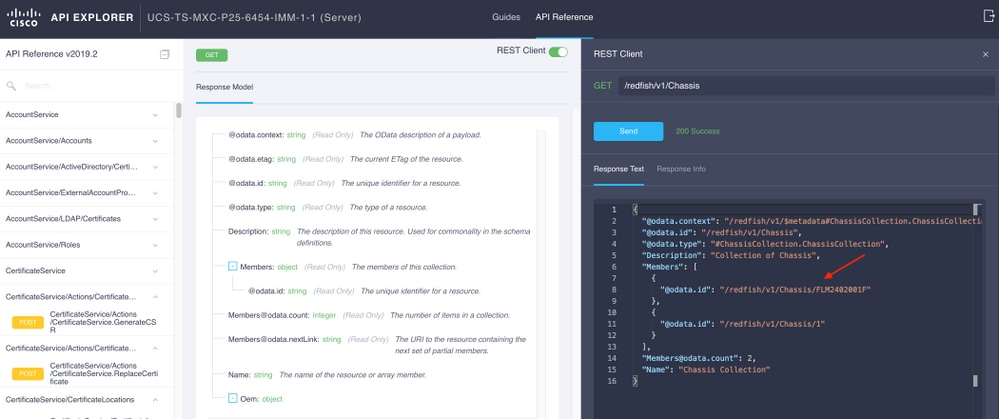

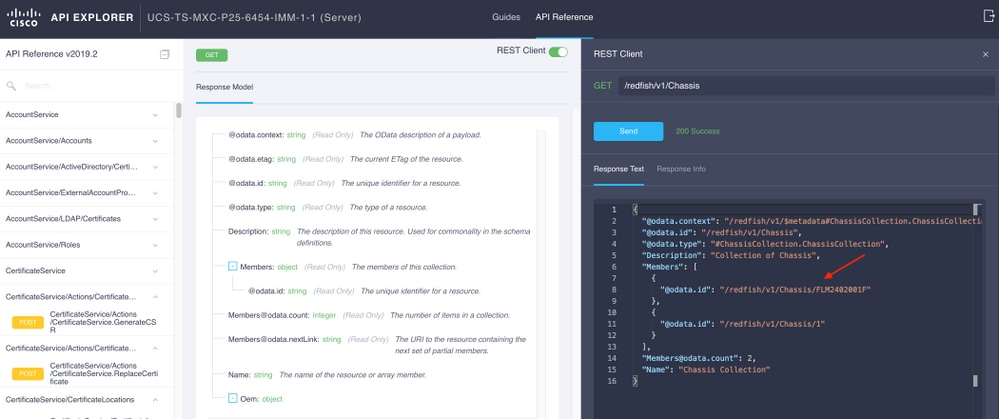

Récupérer l'ID du châssis

Copiez l'ID de châssis pour l'appel API.

/redfish/v1/Chassis/FLM2402001F

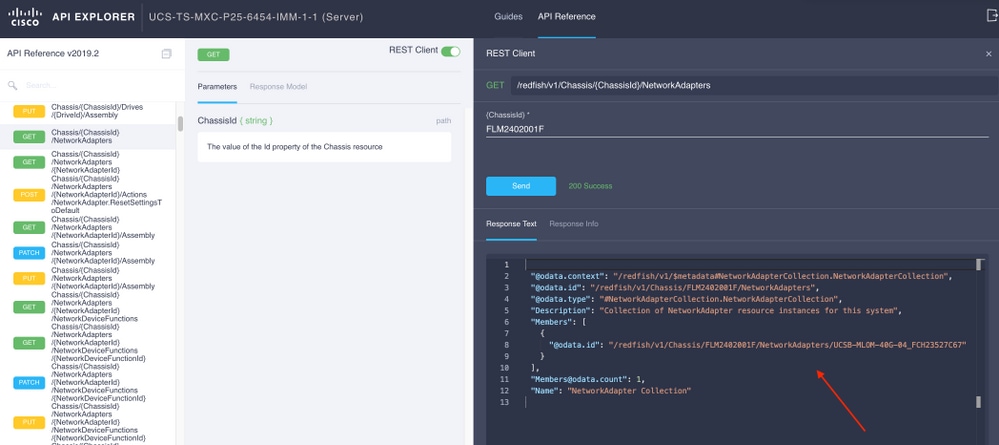

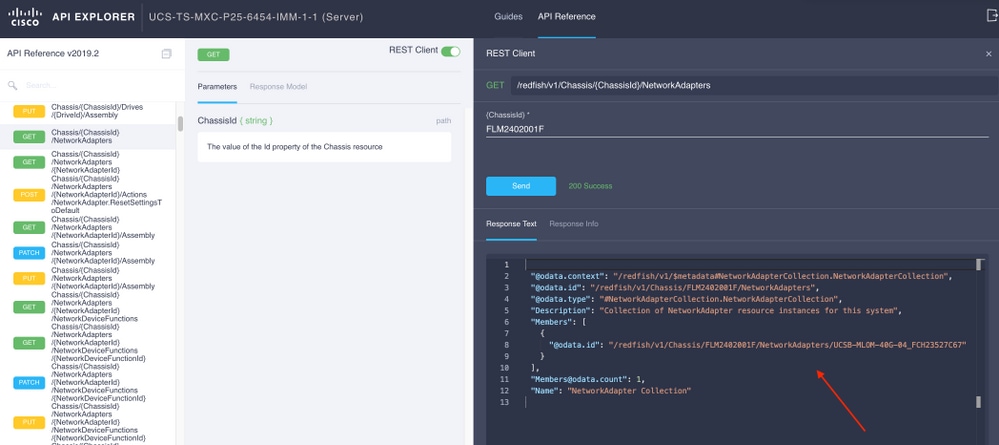

Récupérer l'ID de la carte réseau

Copiez l'ID réseau pour l'appel API suivant.

/redfish/v1/Chassis/FLM2402001F/NetworkAdapters/UCSB-MLOM-40G-04_FCH23527C67

Récupérer l'ID vNIC

Copiez l'ID des cartes réseau.

/redfish/v1/Chassis/FLM2402001F/NetworkAdapters/UCSB-MLOM-40G-04_FCH23527C67/NetworkDeviceFunctions/Vnic-A

/redfish/v1/Chassis/FLM2402001F/NetworkAdapters/UCSB-MLOM-40G-04_FCH23527C67/NetworkDeviceFunctions/Vnic-B

Récupérer l'ID VIF de la vNIC correspondante

Dans ce cas, vNIC-A est mappé à VIF 800. À partir de là, les commandes NXOS contiennent cette interface virtuelle.

Identification de VIF avec les filtres NXOS et Grep

Si l'Explorateur d'API n'est pas disponible ou si vous n'avez pas accès à l'interface utilisateur graphique, les commandes CLI peuvent être utilisées pour récupérer les informations VIF.

Note: Vous devez connaître le profil de serveur pour pouvoir utiliser ces commandes.

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show run interface | grep prev 1 IMM-Server-1

switchport trunk allowed vsan 1

switchport description SP IMM-Server-1, vHBA vhba-a, Blade:FLM2402001F

--

interface Vethernet800

description SP IMM-Server-1, vNIC Vnic-A, Blade:FLM2402001F

--

interface Vethernet803

description SP IMM-Server-1, vNIC Vnic-b, Blade:FLM2402001F

--

interface Vethernet804

description SP IMM-Server-1, vHBA vhba-a, Blade:FLM2402001F

| Syntaxe de commande |

Utilisation |

| show run interface | grep prev 1 <nom du profil de serveur> |

Répertorie les VLAN associés à chaque vNIC/vHBA |

| show run interface | grep prev 1 10 <nom du profil de serveur> |

Répertorie la configuration Vethernet détaillée |

Dépannage de NXOS

Une fois que la vNIC a été mappée à la correspondante Vethernet, l'analyse peut être effectuée sur NXOS avec les mêmes commandes utilisées pour dépanner les interfaces physiques.

La note pour les vNIC est veth - Vethernet.

show interface brief affiche le Veth800 en état de panne avec l'erreur ENM Source Pin Failure comme motif.

UCS-TS-MXC-P25-6454-IMM-A# connect nxos

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show interface brief | grep -i Veth800

Veth800 1 virt trunk down ENM Source Pin Fail auto

show interface montre que Vethernet 800 est en état d'initialisation.

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show interface Vethernet 800

Vethernet800 is down (initializing)

Port description is SP IMM-Server-1, vNIC Vnic-A, Blade:FLM2402001F

Hardware is Virtual, address is 0000.abcd.dcba

Port mode is trunk

Speed is auto-speed

Duplex mode is auto

300 seconds input rate 0 bits/sec, 0 packets/sec

300 seconds output rate 0 bits/sec, 0 packets/sec

Rx

0 unicast packets 0 multicast packets 0 broadcast packets

0 input packets 0 bytes

0 input packet drops

Tx

0 unicast packets 0 multicast packets 0 broadcast packets

0 output packets 0 bytes

0 flood packets

0 output packet drops

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show running-config interface Vethernet 800

!Command: show running-config interface Vethernet800

!Running configuration last done at: Mon Sep 27 16:03:46 2021

!Time: Tue Sep 28 14:35:22 2021

version 9.3(5)I42(1e) Bios:version 05.42

interface Vethernet800

description SP IMM-Server-1, vNIC Vnic-A, Blade:FLM2402001F

no lldp transmit

no lldp receive

no pinning server sticky

pinning server pinning-failure link-down

no cdp enable

switchport mode trunk

switchport trunk allowed vlan 1,470

hardware vethernet mac filtering per-vlan

bind interface port-channel1280 channel 800

service-policy type qos input default-IMM-QOS

no shutdown

Un VIF doit être épinglé vers une interface de liaison ascendante, dans ce scénario, show pinning border interface n'affiche pas le Vethernet épinglé vers une liaison ascendante.

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show pinning border-interfaces

--------------------+---------+----------------------------------------

Border Interface Status SIFs

--------------------+---------+----------------------------------------

Eth1/45 Active sup-eth1

Eth1/46 Active Eth1/1/33

Cela indique que les liaisons ascendantes nécessitent une configuration supplémentaire. Ce résultat correspond à la configuration show running de la liaison ascendante Ethernet 1/46.

UCS-TS-MXC-P25-6454-IMM-B(nx-os)# show running-config interface ethernet 1/45

!Command: show running-config interface Ethernet1/45

!No configuration change since last restart

!Time: Wed Sep 29 05:15:21 2021

version 9.3(5)I42(1e) Bios:version 05.42

interface Ethernet1/45

description Uplink

pinning border

switchport mode trunk

switchport trunk allowed vlan 69,470

no shutdown

show mac address-table details que Veth800 utilise VLAN 1 qui n'est pas présent sur les liaisons ascendantes.

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show mac address-table

Legend:

* - primary entry, G - Gateway MAC, (R) - Routed MAC, O - Overlay MAC

age - seconds since last seen,+ - primary entry using vPC Peer-Link,

(T) - True, (F) - False, C - ControlPlane MAC, ~ - vsan

VLAN MAC Address Type age Secure NTFY Ports

---------+-----------------+--------+---------+------+----+------------------

* 1 0025.b501.0036 static - F F Veth800

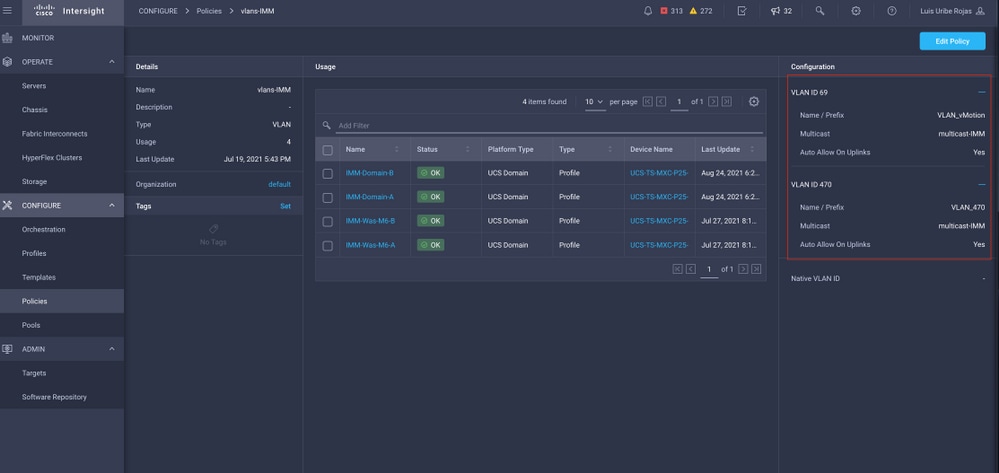

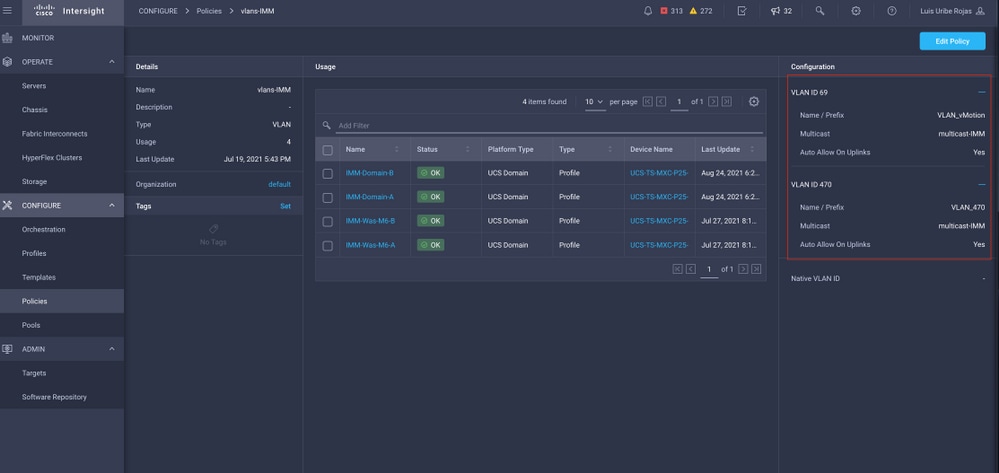

Sur un domaine UCS, le VLAN utilisé doit également être inclus sur la vNIC et les liaisons ascendantes. La politique VLAN configure les VLAN sur les interconnexions de fabric. L'image montre la configuration de ce domaine UCS.

Le VLAN 1 n'étant pas présent sur la stratégie, il doit être ajouté.

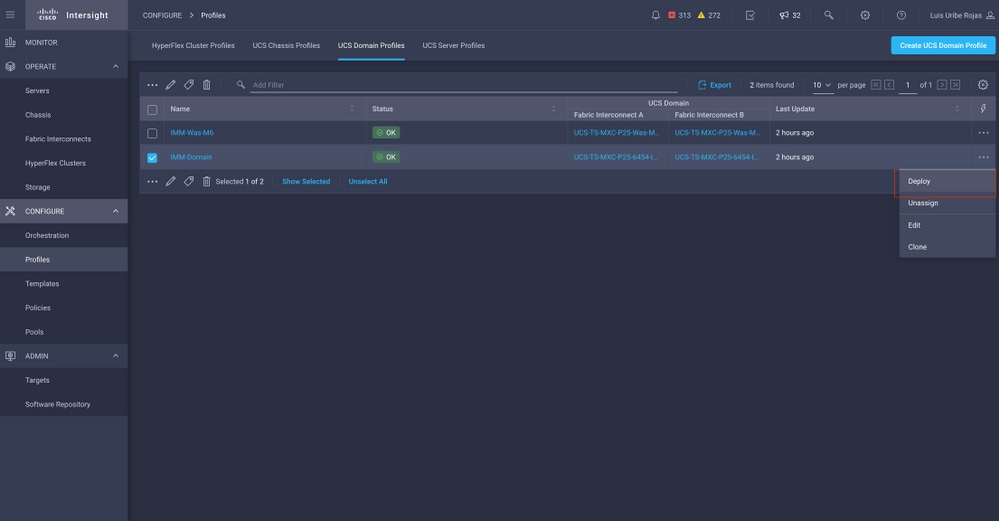

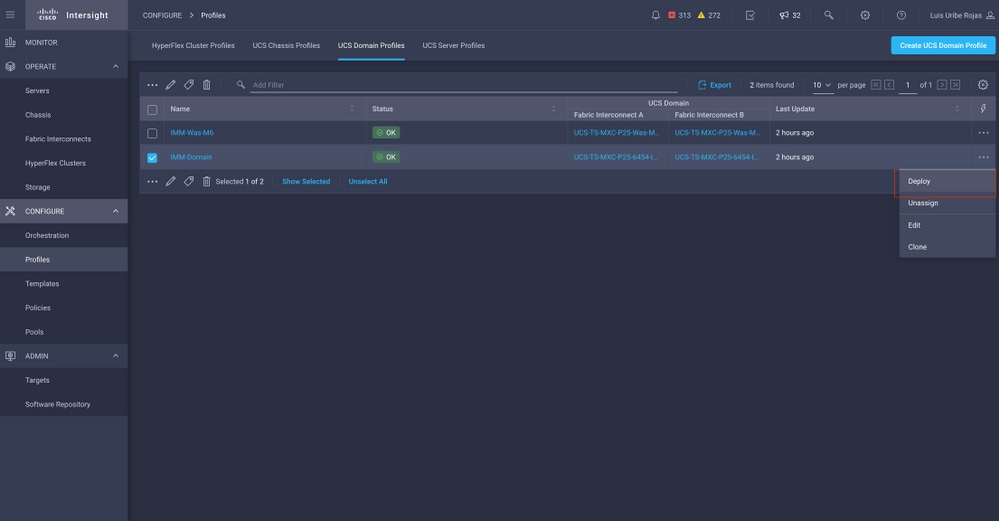

Sélectionnez Modifier la stratégie afin d'autoriser la connectivité. Cette modification nécessite le déploiement du profil de domaine UCS.

L'affectation de VLAN peut être vérifiée par l'interface de ligne de commande :

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show running-config interface ethernet 1/45

!Command: show running-config interface Ethernet1/45

!Running configuration last done at: Wed Sep 29 07:50:43 2021

!Time: Wed Sep 29 07:59:31 2021

version 9.3(5)I42(1e) Bios:version 05.42

interface Ethernet1/45

description Uplink

pinning border

switchport mode trunk

switchport trunk allowed vlan 1,69,470

udld disable

no shutdown

UCS-TS-MXC-P25-6454-IMM-A(nx-os)#

Maintenant que les VLAN nécessaires sont ajoutés, le même ensemble de commandes peut être utilisé afin de vérifier la connectivité sur Vethernet800 :

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show interface brief | grep -i Veth800

Veth800 1 virt trunk up none auto

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show interface Vethernet 800

Vethernet800 is up

Port description is SP IMM-Server-1, vNIC Vnic-A, Blade:FLM2402001F

Hardware is Virtual, address is 0000.abcd.dcba

Port mode is trunk

Speed is auto-speed

Duplex mode is auto

300 seconds input rate 0 bits/sec, 0 packets/sec

300 seconds output rate 0 bits/sec, 0 packets/sec

Rx

0 unicast packets 1 multicast packets 6 broadcast packets

7 input packets 438 bytes

0 input packet drops

Tx

0 unicast packets 25123 multicast packets 137089 broadcast packets

162212 output packets 11013203 bytes

0 flood packets

0 output packet drops

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show running-config interface Vethernet 800

!Command: show running-config interface Vethernet800

!Running configuration last done at: Wed Sep 29 07:50:43 2021

!Time: Wed Sep 29 07:55:51 2021

version 9.3(5)I42(1e) Bios:version 05.42

interface Vethernet800

description SP IMM-Server-1, vNIC Vnic-A, Blade:FLM2402001F

no lldp transmit

no lldp receive

no pinning server sticky

pinning server pinning-failure link-down

switchport mode trunk

switchport trunk allowed vlan 1,69,470

hardware vethernet mac filtering per-vlan

bind interface port-channel1280 channel 800

service-policy type qos input default-IMM-QOS

no shutdown

Le Veth800 figure sur les interfaces épinglées aux interfaces Ethernet de liaison ascendante :

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show pinning border-interfaces

--------------------+---------+----------------------------------------

Border Interface Status SIFs

--------------------+---------+----------------------------------------

Eth1/45 Active sup-eth1 Veth800 Veth803

Eth1/46 Active Eth1/1/33

Total Interfaces : 2

UCS-TS-MXC-P25-6454-IMM-A(nx-os)#

Les VIF sont désormais prêts à transmettre le trafic au réseau en amont.

Informations connexes

Commentaires

Commentaires