Introduction

Ce document décrit les options de réglage fin des cartes VNIC en mode IMM (Intersight Managed Mode) via les profils de serveur.

Conditions préalables

Paramètres recommandés par le système d'exploitation pour les cartes Ethernet :

Les politiques de calcul, de stockage et de gestion opérationnelles doivent être configurées au préalable.

Conditions requises

Cisco vous recommande de prendre connaissance des rubriques suivantes :

- Mode géré Intersight

- Connectivité réseau physique

- Paramètres de carte Ethernet recommandés par le SE

- Eléments de réglage fin de VNIC

Composants utilisés

Les informations contenues dans ce document sont basées sur les versions de matériel et de logiciel suivantes :

- Microprogramme UCS-B200-M5 4.2(1a)

- Interconnexion de fabric Cisco UCS 6454, microprogramme 4.2(1e)

- Logiciel Intersight en tant que service (SaaS)

The information in this document was created from the devices in a specific lab environment. All of the devices used in this document started with a cleared (default) configuration. Si votre réseau est en ligne, assurez-vous de bien comprendre l’incidence possible des commandes.

Configuration

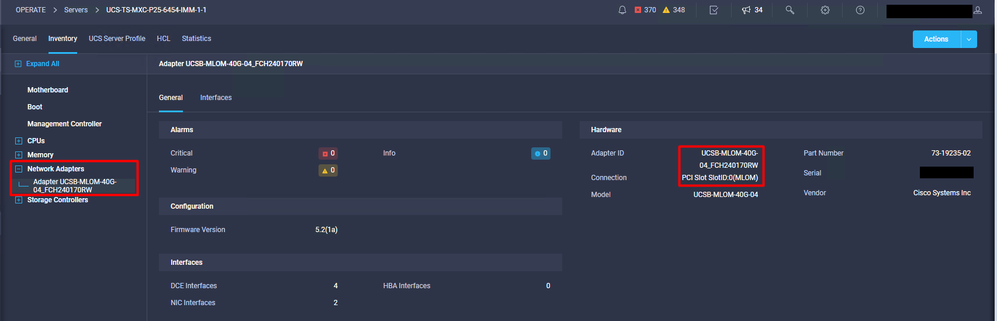

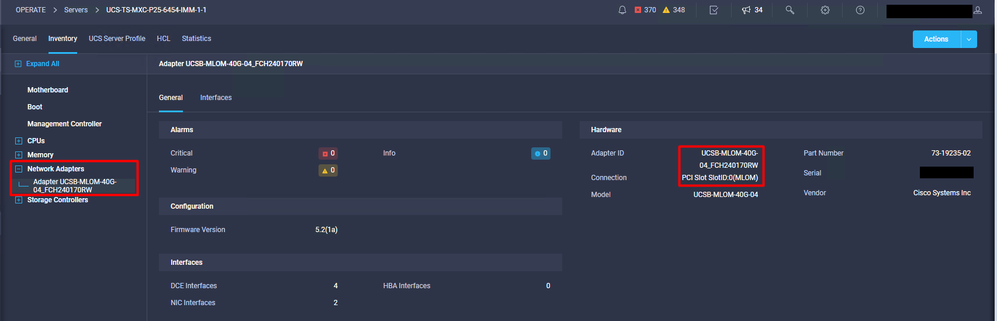

Étape 1. Identifier l'adaptateur VIC et l'ID de logement sur le serveur

Accédez à l'onglet Servers > Inventory > Sélectionnez l'option Network Adapters.

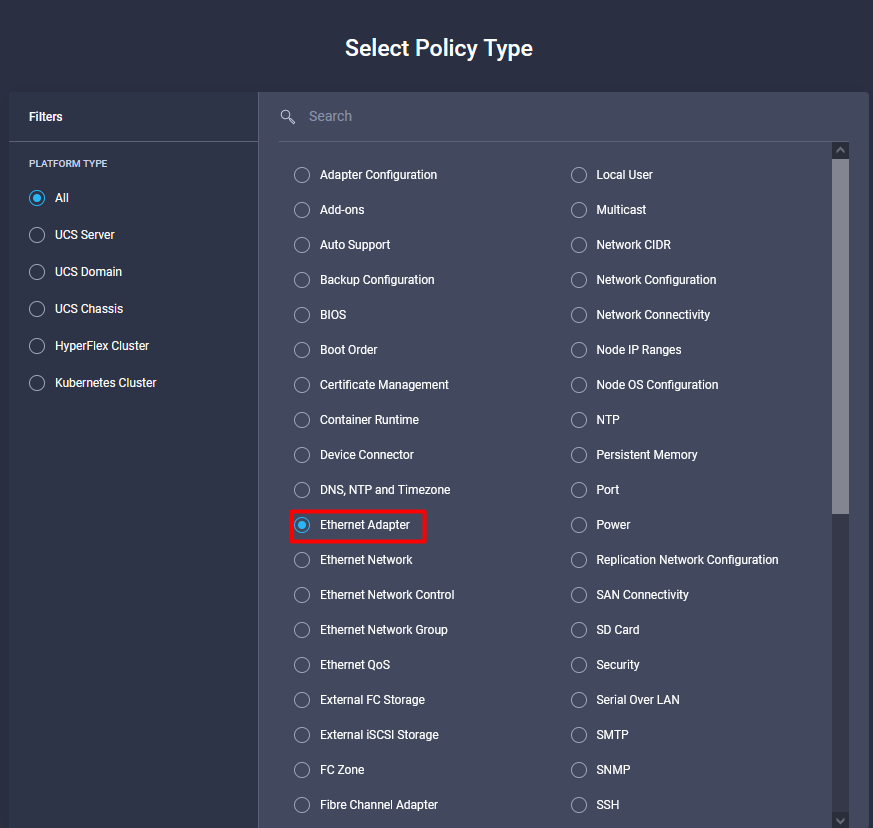

Étape 2 : création d’une stratégie de carte Ethernet

Créez la politique de carte Ethernet avec les valeurs suggérées par le fournisseur du système d'exploitation.

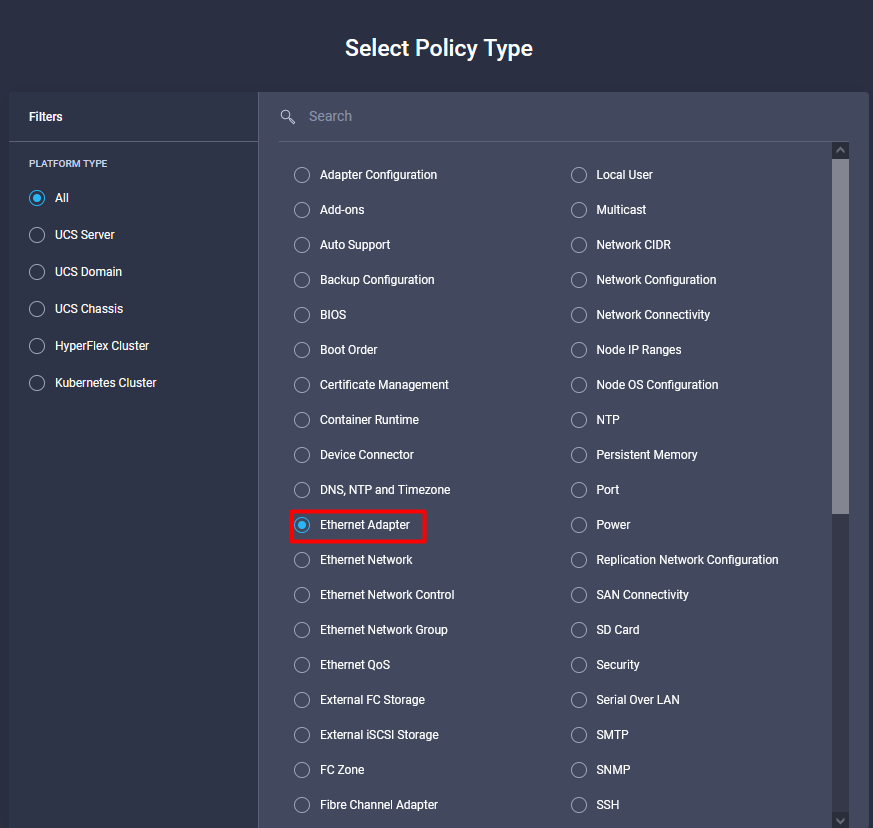

Accédez à l'onglet Policies > Create Policy > Select Ethernet Adapter.

Dans le menu Créer une stratégie, sélectionnez l'organisation et indiquez le nom de la stratégie.

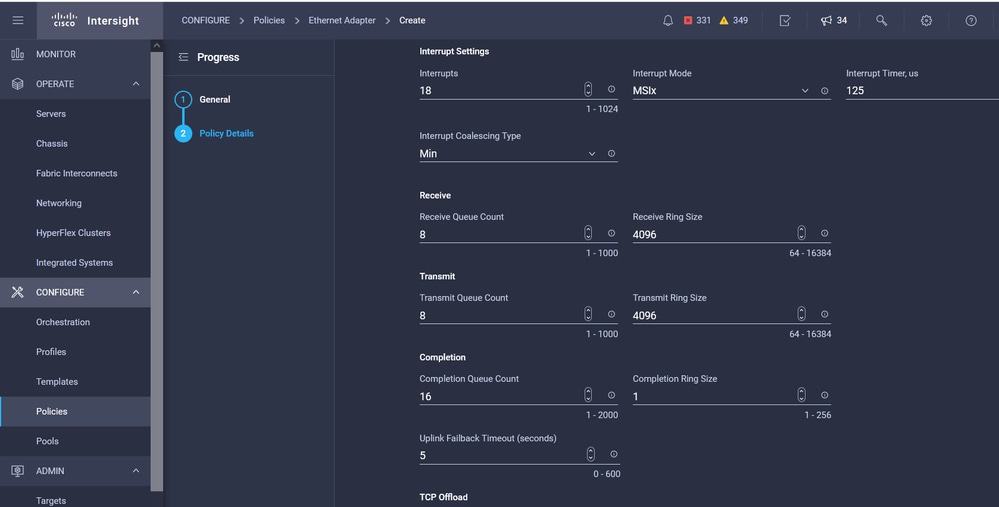

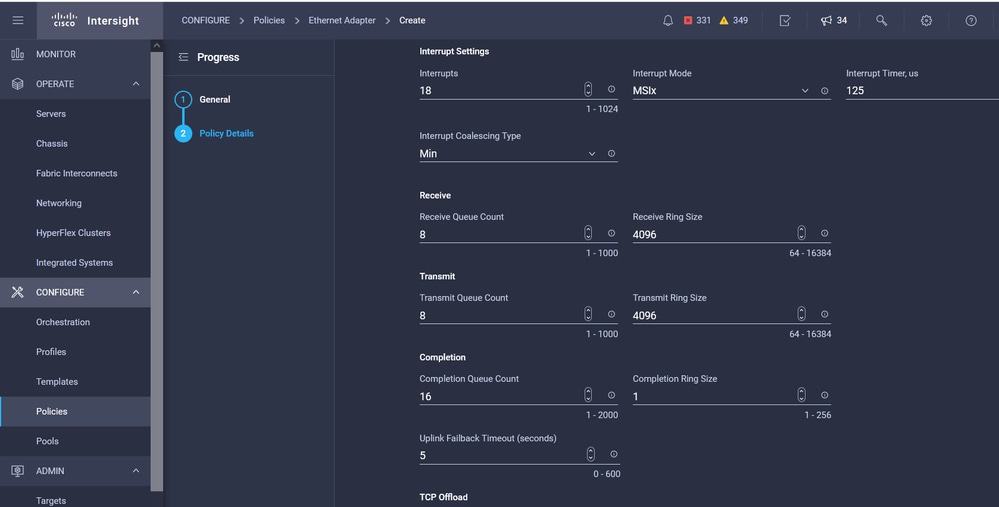

Étape 3. Configuration des paramètres suggérés par le fournisseur du système d’exploitation En général, les fonctionnalités répertoriées sont configurées dans la politique de carte Ethernet :

- Files de réception

- Files d'attente

- Taille de sonnerie

- Files d'attente

- Interruptions

- Activer RSS (Receive Side Scaling) ou ARFS (Accelerated Receive Flow Steering)

Note: RSS et ARFS s'excluant mutuellement, configurez-en un seul. Ne configurez pas les deux.

Une fois créée, affectez la politique de carte Ethernet à une politique de connectivité LAN.

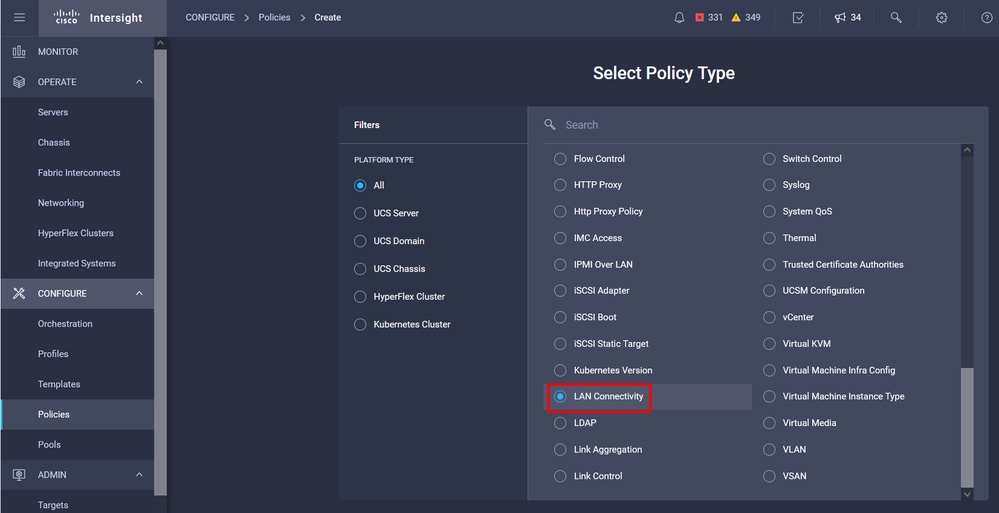

Étape 4 : création d’une politique de connectivité LAN

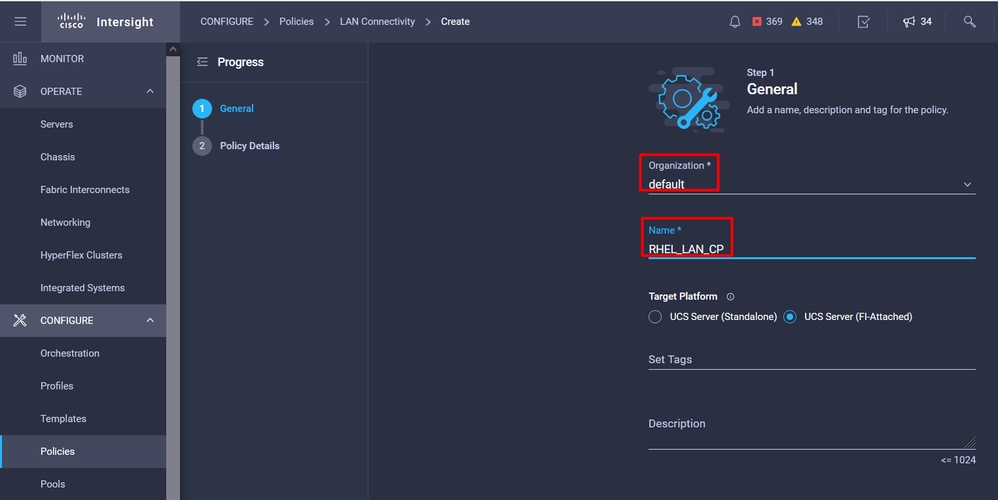

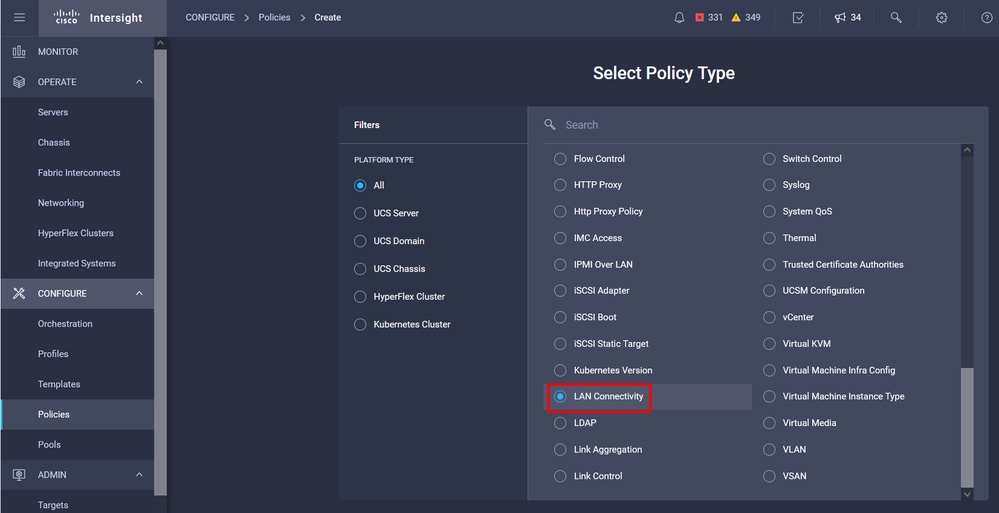

Accédez à l'onglet Policies > Create Policy > LAN Connectivity

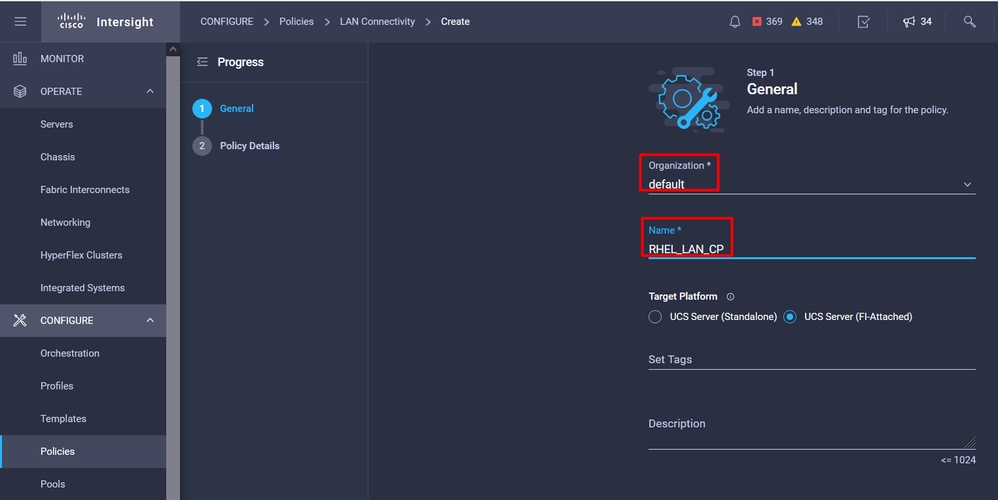

Sélectionnez l'organisation et indiquez le nom de la stratégie.

Sous Cible, la plate-forme sélectionne Serveur UCS (FI-Attached).

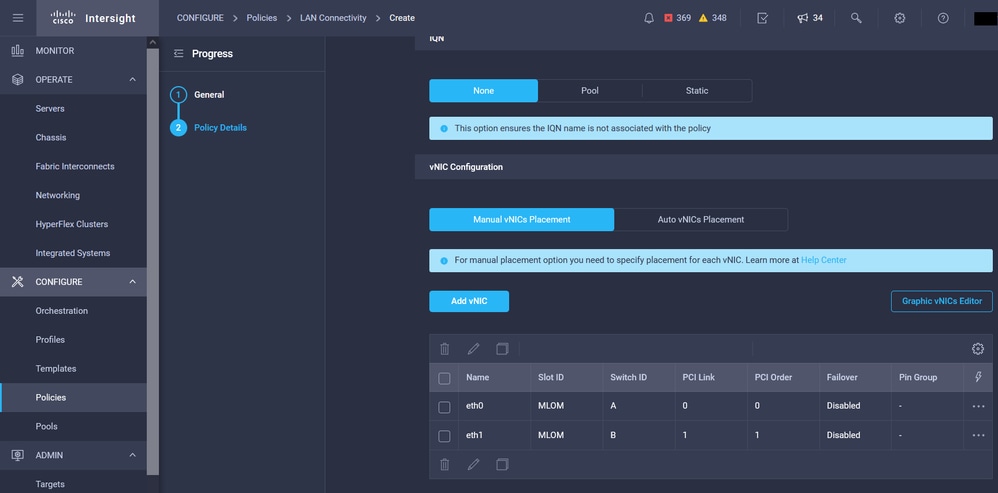

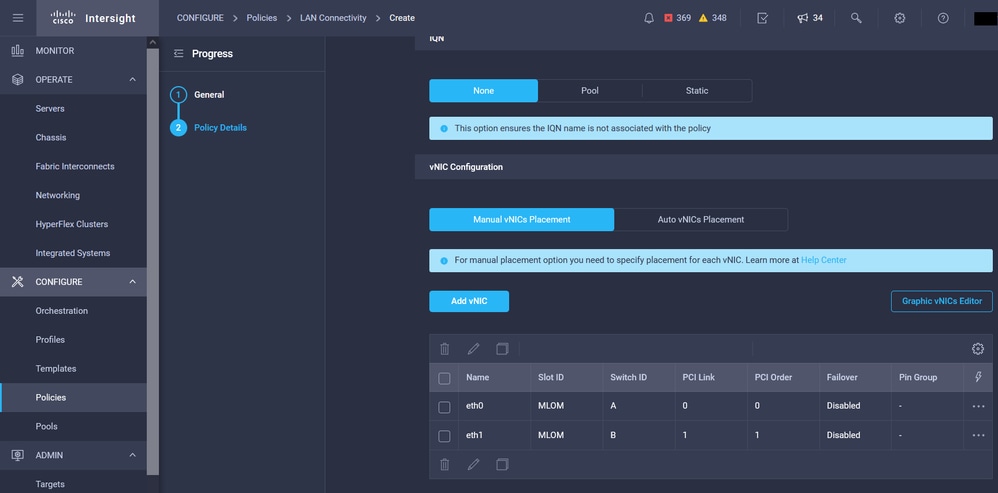

Dans la politique de connectivité LAN, accédez à la section vNIC Configuration et configurez au moins deux interfaces réseau. Dans cet exemple, les interfaces eth0 et eth1 sont créées.

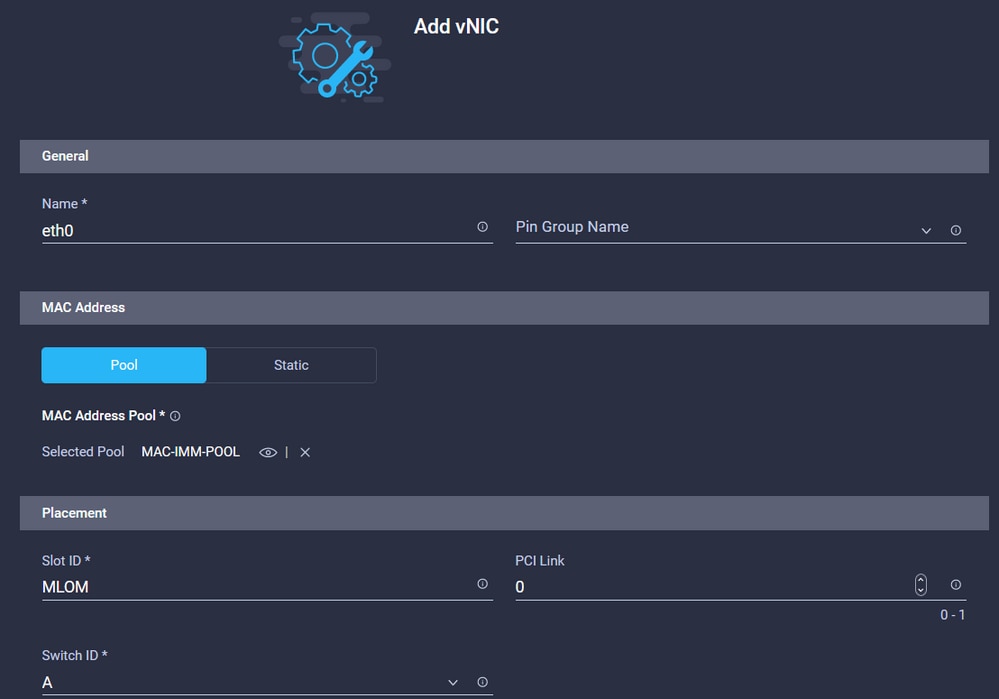

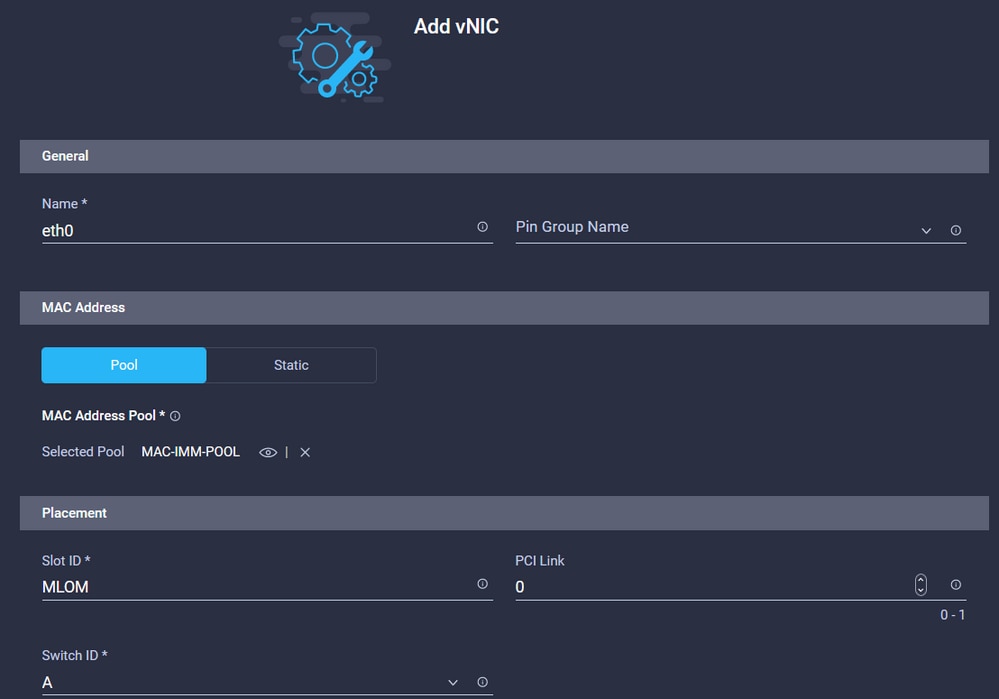

Dans l'onglet de configuration Add vNIC, sous General, indiquez le nom eth0.

Dans la section MAC Address, sélectionnez le pool d'adresses MAC approprié.

Dans la section Placement, configurez l'ID de logement comme MLOM.

Conservez les options PCI Link et PCI Order avec la valeur 0 et l'option Switch ID avec l'option A.

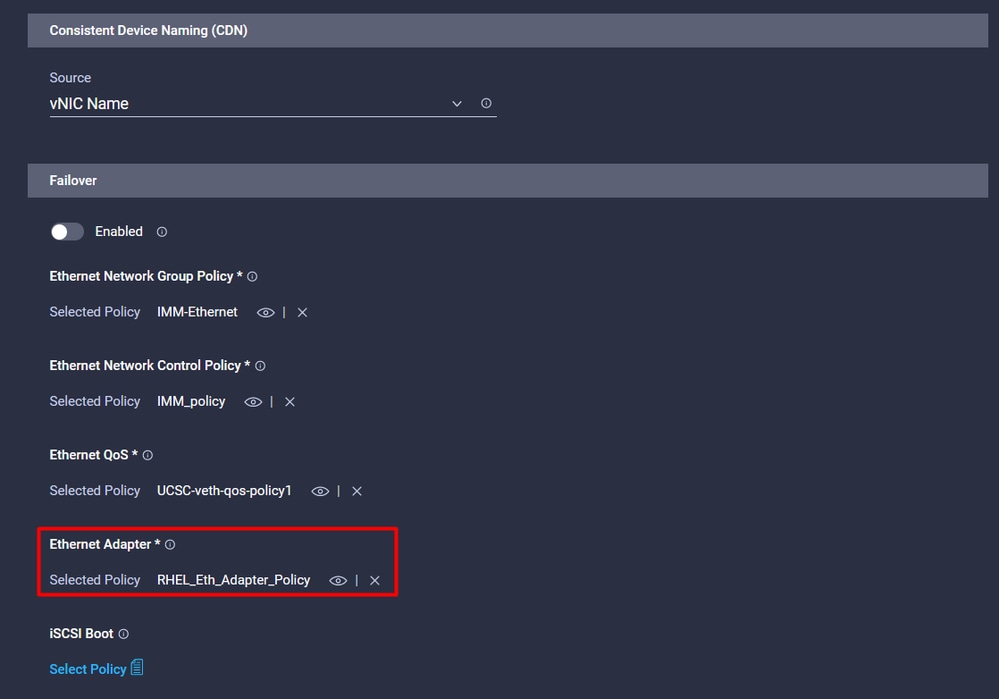

Accédez au menu Consistent Device Naming (CDN) et sélectionnez VNIC Name.

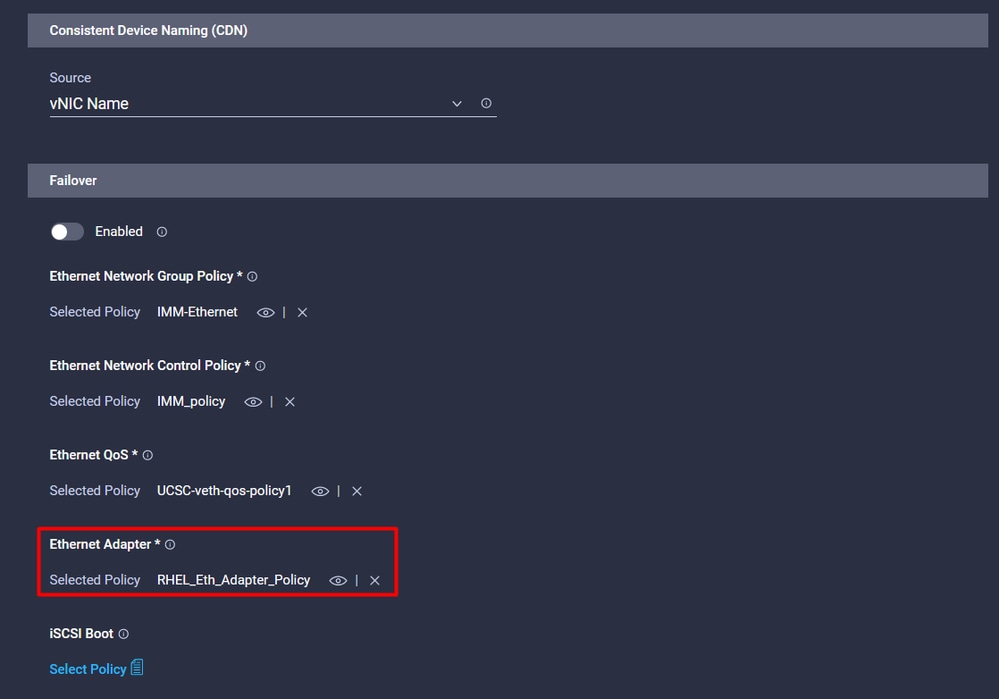

Ajoutez les stratégies Ethernet Network Group Policy, Ethernet Network Control Policy, Ethernet QoS et Ethernet Adapter Policy.

Répétez les mêmes étapes pour créer l'interface eth1, configurer les valeurs PCI Link, PCI Order et Switch ID en conséquence.

Enfin, créez la politique de connectivité LAN. Une fois créé, affectez-le à un profil de serveur UCS.

Étape 5. Créez un profil de serveur.

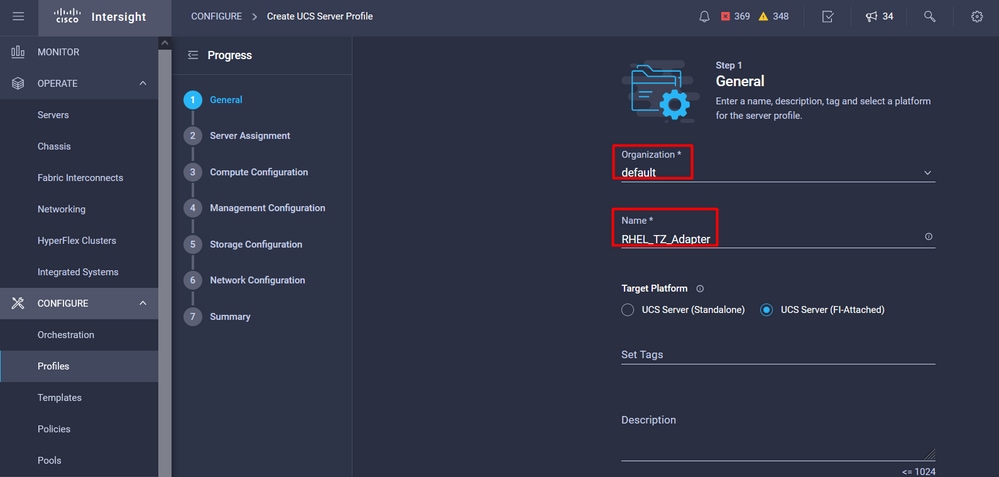

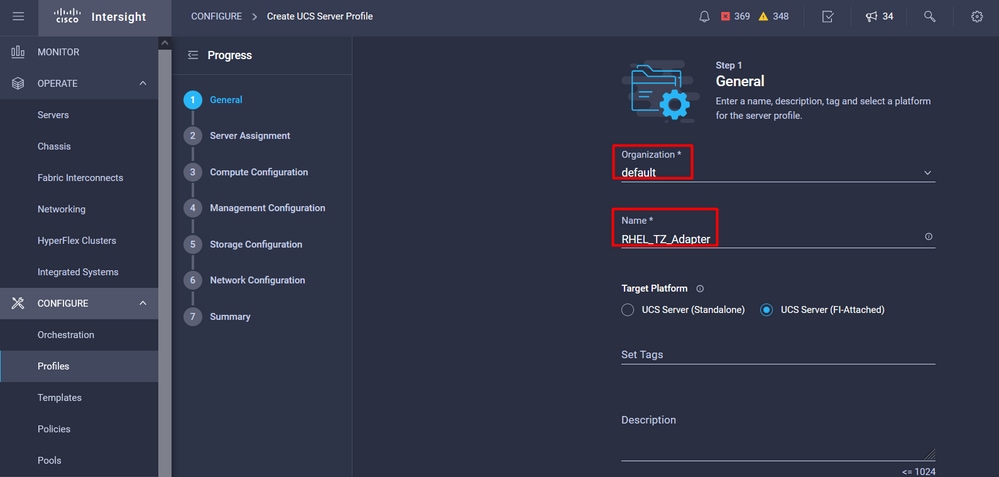

Accédez à l'onglet Profiles, puis sélectionnez Create UCS Server Profile.

Fournissez les détails Organisation et Nom.

Sélectionnez toutes les configurations associées, telles que les paramètres de calcul, de gestion et de stockage.

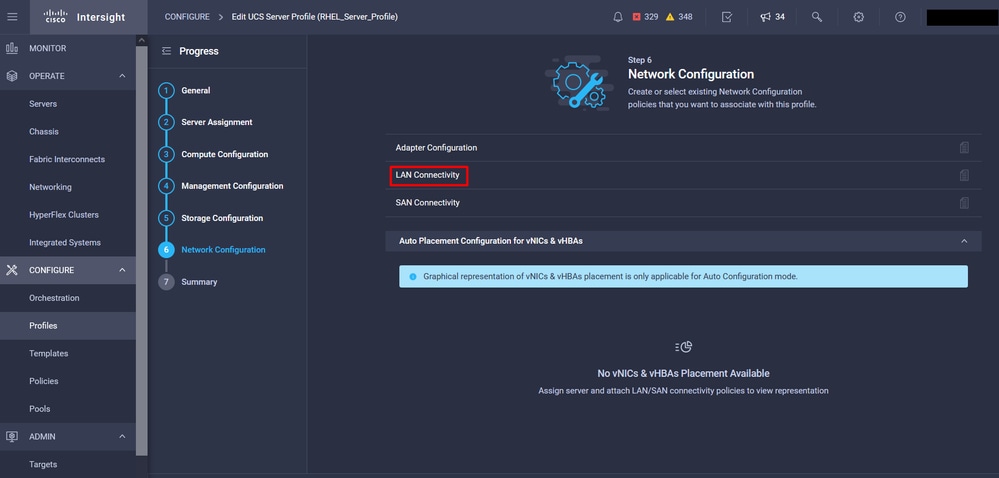

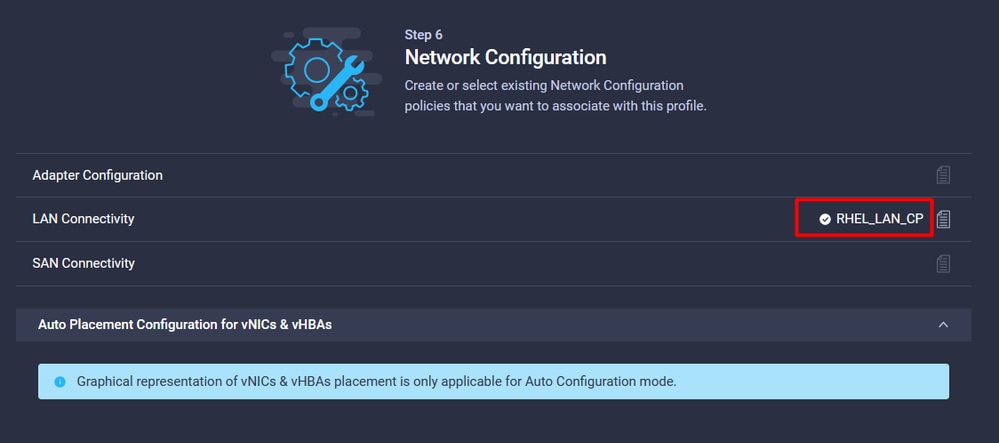

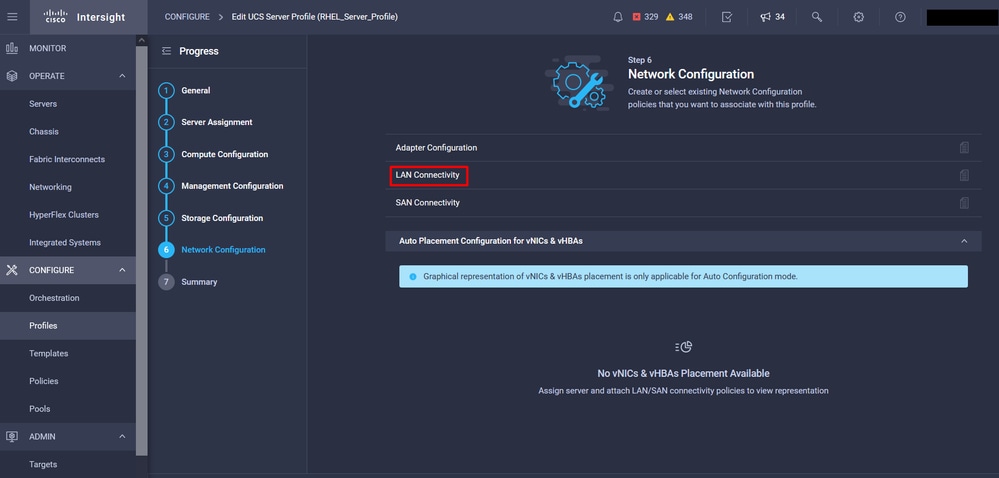

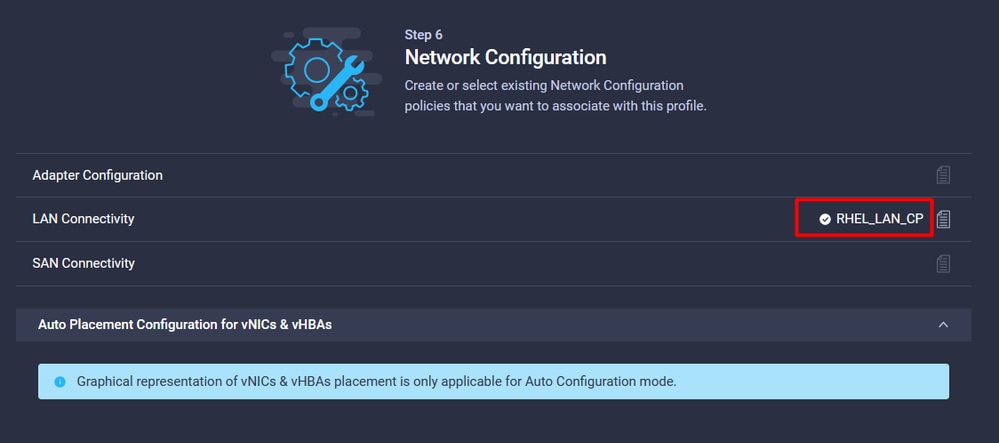

Sous Network configuration, sélectionnez la politique de connectivité LAN appropriée.

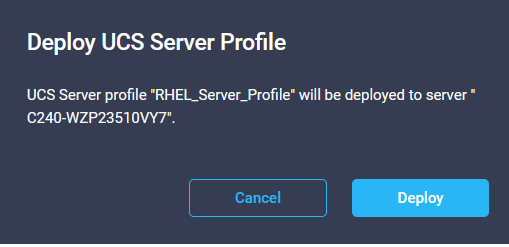

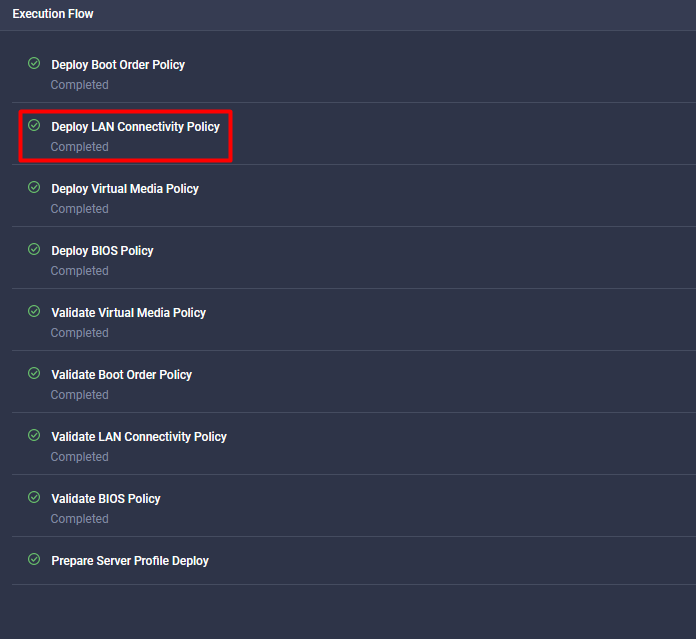

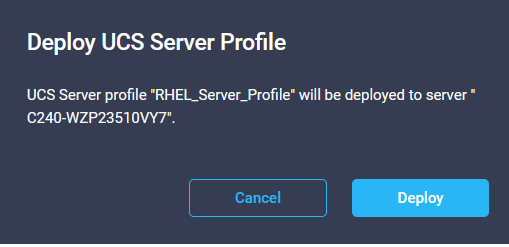

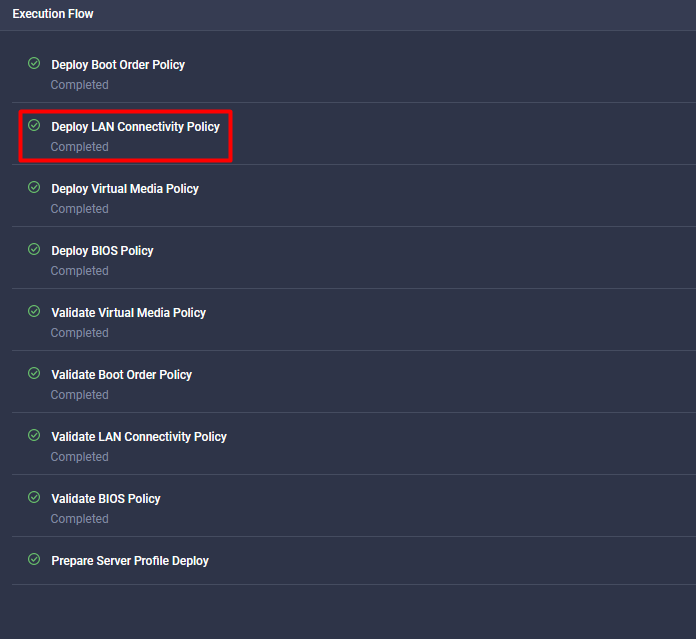

Sélectionnez Déployer pour configurer le profil de serveur et valider que toutes les étapes ont été effectuées avec succès.

Vérification

Référez-vous à cette section pour vous assurer du bon fonctionnement de votre configuration.

Validez les paramètres de la carte sur RHEL.

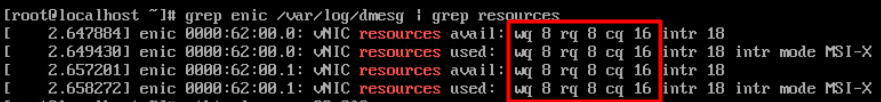

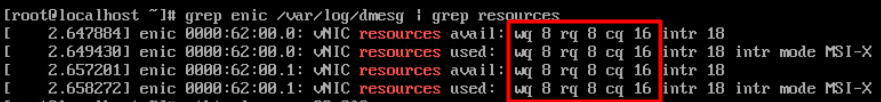

Pour vérifier les ressources actuellement disponibles fournies par l'adaptateur VIC, validez les files d'attente de transmission et de réception sur le fichier dmesg :

$ grep enic /var/log/dmesg | grep resources

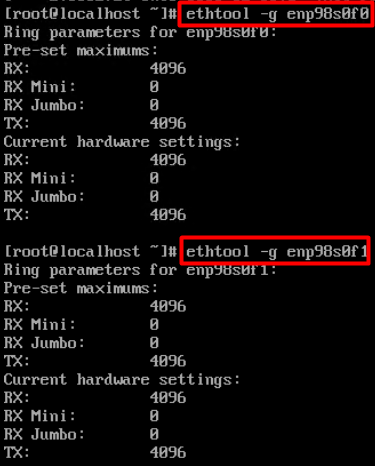

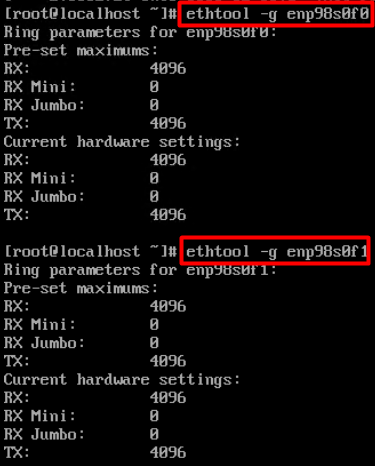

Validez la taille de sonnerie configurée.

ethtool -g interface_name

Validez les paramètres de la carte sur VMware ESXi.

Afin de vérifier les ressources actuellement disponibles fournies par la carte VIC, validez les files d'attente de transmission et de réception avec la commande ci-dessous, où X est le numéro vmnic.

vsish -e get /net/pNics/vmnicX/txqueues/info

vsish -e get /net/pNics/vmnicX/rxqueues/info

Exécutez cette commande pour valider la taille de la sonnerie :

esxcli network nic ring current get -n vmnicX

Validez les paramètres de la carte directement sur UCS.

Afin de valider les paramètres, connectez-vous à l'une des interconnexions de fabric via SSH.

Connectez-vous à l'adaptateur serveur à l'aide de la commande connect adapter x/y/z, où x est le numéro de châssis, y est le numéro de logement et z est le numéro d'adaptateur.

Une fois connecté à l'adaptateur, sur la connexion supplémentaire, entrez dbgsh.

Exécutez la commande attach-mcp.

Exécutez ensuite la commande vnicl , pour répertorier les vnic disponibles.

Recherchez le nom de vnic correspondant eth0 et eth1 et validez les paramètres.

UCS-IMM-A# connect adapter 1/1/1

Entering character mode

Escape character is '^]'.

(none) login: dbgsh

adapter (top):1#

adapter (top):4# attach-mcp

adapter (mcp):1# vnicl

adapter (mcp):19# vnicl

================================

vnicid : 18

name : eth0

type : enet

state : UP

adminst : UP

flags : OPEN, INIT, LINKUP, NOTIFY_INIT, ENABLE, USING_DEVCMD2

ucsm name : eth0

spec_flags : MULTIFUNC, TRUNK

mq_spec_flags :

slot : 0

h:bdf : 0:03:00.0

vs.mac : 00:25:b5:01:00:46

mac : 00:25:b5:01:00:46

vifid : 801

vifcookie : 801

uif : 0

portchannel_bypass : 0x0

cos : 0

vlan : 0

rate_limit : unlimited

cur_rate : unlimited

stby_vifid : 0

stby_vifcookie : 0

stby_recovery_delay : 0

channel : 0

stdby_channel : 0

profile :

stdby_profile :

init_errno : 0

cdn : eth0

devspec_flags : TSO, LRO, RXCSUM, TXCSUM, RSS, RSSHASH_IPV4, RSSHASH_TCPIPV4, RSSHASH_IPV6, RSSHASH_TCPIPV6

lif : 18

vmode : STATIC

encap mode : NONE

host wq : [11-18] (n=8)

host rq : [2010-2017] (n=8) (h=0x080107da)

host cq : [2002-2017] (n=16)

host intr : [3008-3025] (n=18)

notify : pa=0x10384de000/40 intr=17

devcmd2 wq : [19] (n=1)

================================

vnicid : 19

name : eth1

type : enet

state : UP

adminst : UP

flags : OPEN, INIT, LINKUP, NOTIFY_INIT, ENABLE, USING_DEVCMD2

ucsm name : eth1

spec_flags : MULTIFUNC, TRUNK

mq_spec_flags :

slot : 0

h:bdf : 0:03:00.1

vs.mac : 00:25:b5:01:00:45

mac : 00:25:b5:01:00:45

vifid : 800

vifcookie : 800

uif : 1

portchannel_bypass : 0x0

cos : 0

vlan : 0

rate_limit : unlimited

cur_rate : unlimited

stby_vifid : 0

stby_vifcookie : 0

stby_recovery_delay : 0

channel : 0

stdby_channel : 0

profile :

stdby_profile :

init_errno : 0

cdn : eth1

devspec_flags : TSO, LRO, RXCSUM, TXCSUM, RSS, RSSHASH_IPV4, RSSHASH_TCPIPV4, RSSHASH_IPV6, RSSHASH_TCPIPV6

lif : 19

vmode : STATIC

encap mode : NONE

host wq : [20-27] (n=8)

host rq : [2002-2009] (n=8) (h=0x080107d2)

host cq : [1986-2001] (n=16)

host intr : [2976-2993] (n=18)

notify : pa=0x1038e27000/40 intr=17

devcmd2 wq : [28] (n=1)

================================

Informations connexes

Support et documentation techniques - Cisco Systems

Profils de serveur dans Intersight

Directives de réglage des cartes d'interface virtuelle Cisco UCS (livre blanc)

Guide de réglage des performances du réseau Red Hat Enterprise Linux

Commentaires

Commentaires