Dépannage du cluster FTD (Firepower Threat Defense)

Langage exempt de préjugés

Dans le cadre de la documentation associée à ce produit, nous nous efforçons d’utiliser un langage exempt de préjugés. Dans cet ensemble de documents, le langage exempt de discrimination renvoie à une langue qui exclut la discrimination en fonction de l’âge, des handicaps, du genre, de l’appartenance raciale de l’identité ethnique, de l’orientation sexuelle, de la situation socio-économique et de l’intersectionnalité. Des exceptions peuvent s’appliquer dans les documents si le langage est codé en dur dans les interfaces utilisateurs du produit logiciel, si le langage utilisé est basé sur la documentation RFP ou si le langage utilisé provient d’un produit tiers référencé. Découvrez comment Cisco utilise le langage inclusif.

À propos de cette traduction

Cisco a traduit ce document en traduction automatisée vérifiée par une personne dans le cadre d’un service mondial permettant à nos utilisateurs d’obtenir le contenu d’assistance dans leur propre langue. Il convient cependant de noter que même la meilleure traduction automatisée ne sera pas aussi précise que celle fournie par un traducteur professionnel.

Table des matières

Introduction

Ce document décrit le dépannage d'une configuration de cluster sur le pare-feu de nouvelle génération Firepower (NGFW).

Conditions préalables

Exigences

Cisco recommande que vous ayez connaissance de ces sujets (voir la section Informations connexes pour les liens) :

- Architecture de plate-forme Firepower

- Configuration et fonctionnement du cluster Firepower

- Familiarité avec l'interface de ligne de commande FTD et Firepower eXtensible Operating System (FXOS)

- Logiciels NGFW/journaux du plan de données

- NGFW/traceur de paquets de plan de données

- Captures FXOS/plan de données

Composants utilisés

- Matériel : Firepower 4125

- Logiciel : 6.7.0 (Build 65) - plan de données 9.15(1)

The information in this document was created from the devices in a specific lab environment. All of the devices used in this document started with a cleared (default) configuration. Si votre réseau est en ligne, assurez-vous de bien comprendre l’incidence possible des commandes.

Informations générales

La plupart des éléments abordés dans ce document s'appliquent également au dépannage de cluster ASA (Adaptive Security Appliance).

Configurer

La partie configuration d'un déploiement de cluster est traitée dans les guides de configuration FMC et FXOS :

- Mise en grappe pour Firepower Threat Defense

- Déploiement d'un cluster pour Firepower Threat Defense pour une évolutivité et une haute disponibilité

Notions de base des clusters

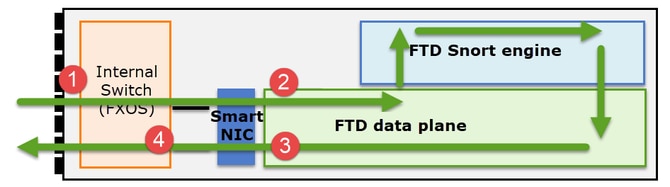

Architecture NGFW

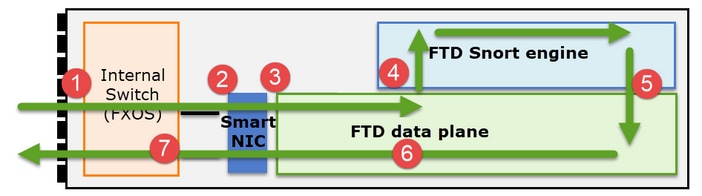

Il est important de comprendre comment une gamme Firepower 41xx ou 93xx gère les paquets de transit :

- Un paquet entre dans l'interface d'entrée et est géré par le commutateur interne du châssis.

- Le paquet passe par la carte réseau intelligente. Si le flux est déchargé (accélération matérielle), le paquet est traité uniquement par la carte réseau intelligente, puis renvoyé au réseau.

- Si le paquet n'est pas déchargé, il entre dans le plan de données FTD qui effectue principalement des vérifications L3/L4.

- Si la politique l'exige, le paquet est inspecté par le moteur Snort (principalement inspection L7).

- Le moteur Snort renvoie un verdict (par exemple, autoriser ou bloquer) pour le paquet.

- Le plan de données abandonne ou transfère le paquet en fonction du verdict de Snort.

- Le paquet sort du châssis par le commutateur interne du châssis.

Captures de cluster

Les appliances Firepower fournissent plusieurs points de capture qui offrent une visibilité sur les flux de transit. Lorsque vous dépannez et activez les captures de cluster, les principaux défis sont les suivants :

- Le nombre de captures augmente en même temps que le nombre d'unités du cluster.

- Vous devez connaître la façon dont le cluster gère un flux spécifique pour pouvoir suivre le paquet à travers le cluster.

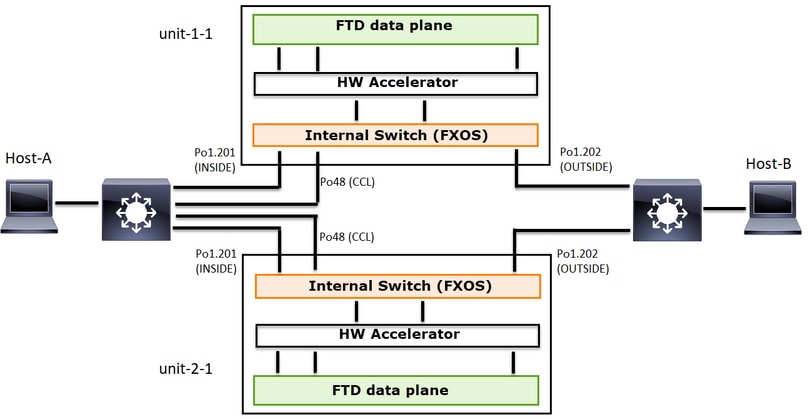

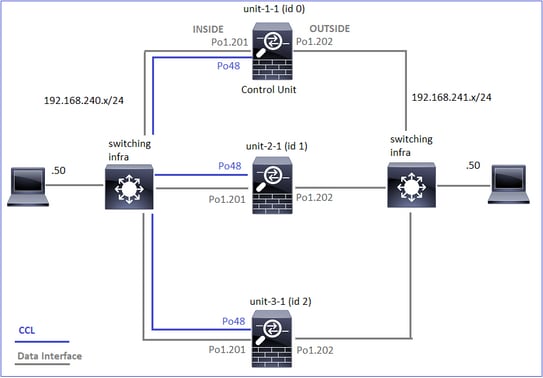

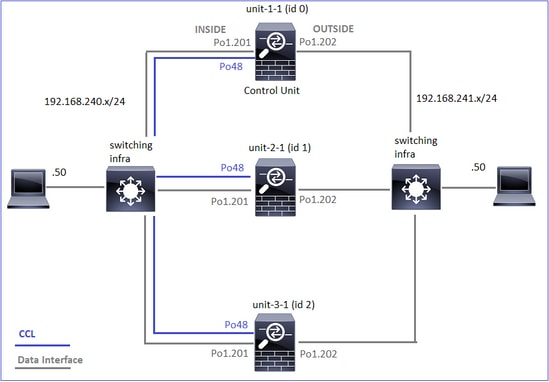

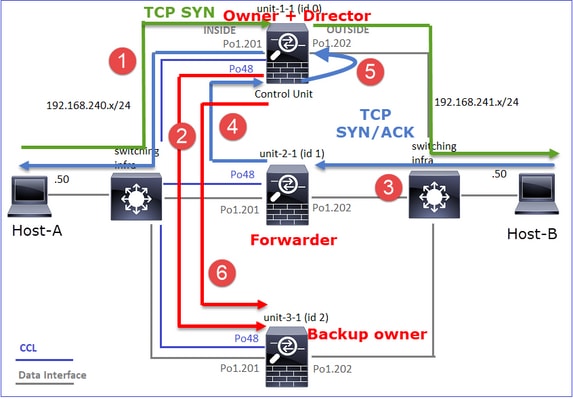

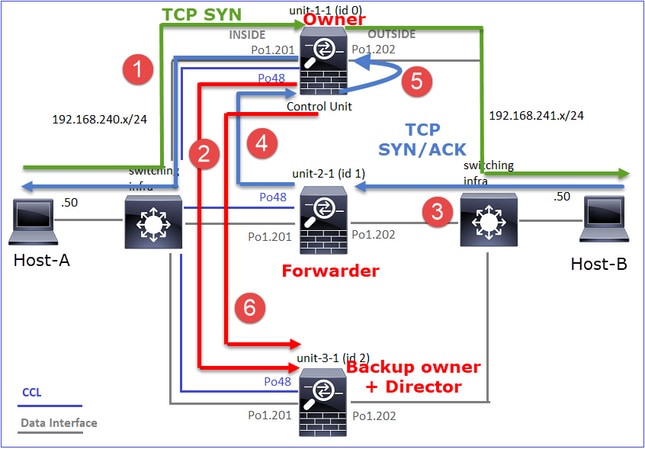

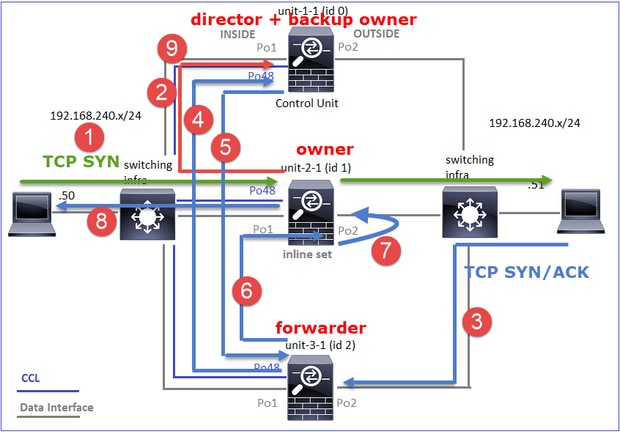

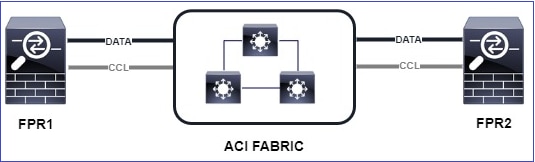

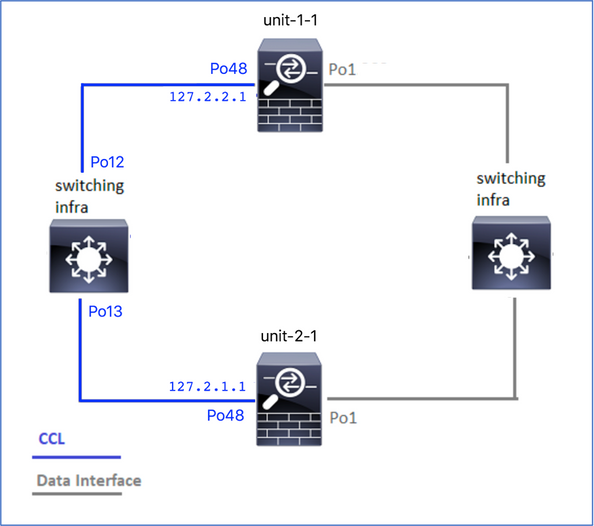

Ce schéma illustre un cluster de 2 unités (par exemple, FP941xx/FP9300) :

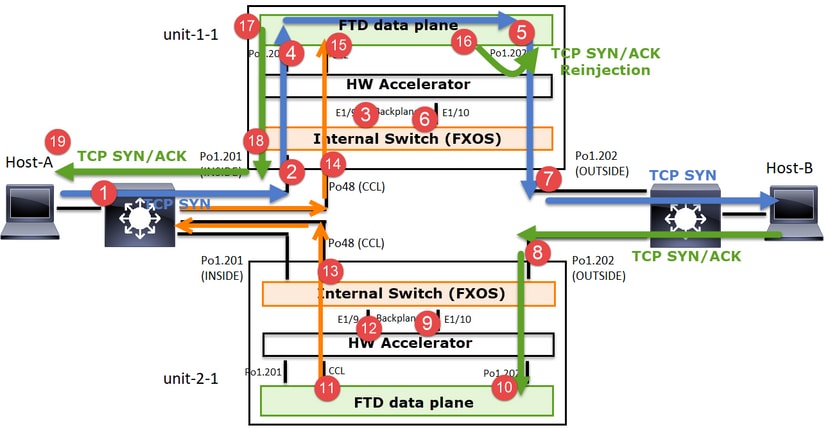

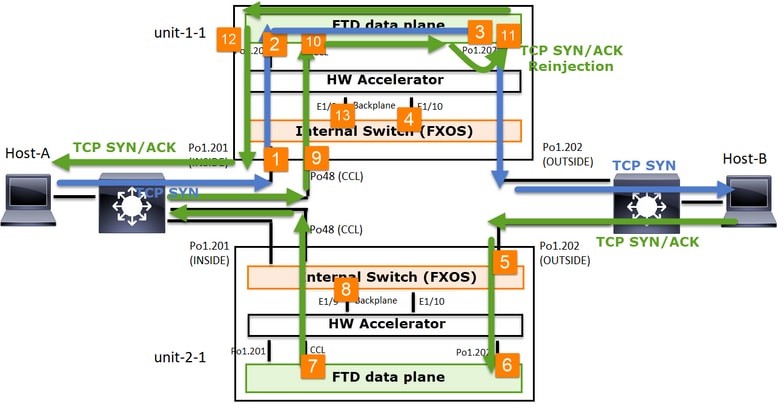

Dans le cas d'un établissement de connexion TCP asymétrique, un échange SYN, SYN/ACK TCP ressemble à ceci :

Transférer le trafic

- TCP SYN est envoyé de l’hôte A à l’hôte B.

- TCP SYN arrive sur le châssis (un des membres de Po1).

- TCP SYN est envoyé au plan de données via l'une des interfaces de fond de panier du châssis (par exemple, E1/9, E1/10, etc.).

- TCP SYN arrive sur l'interface d'entrée du plan de données (Po1.201/INSIDE). Dans cet exemple, unit1-1 prend possession du flux, effectue la randomisation ISN (Initial Sequence Number) et code les informations de propriété (cookie) dans le numéro de séquence.

- TCP SYN est envoyé depuis Po1.202/OUTSIDE (interface de sortie du plan de données).

- TCP SYN arrive sur l'une des interfaces de fond de panier du châssis (par exemple, E1/9, E1/10, etc.).

- TCP SYN est envoyé de l’interface physique du châssis (l’un des membres de Po1) vers l’hôte B.

Trafic de retour

- TCP SYN/ACK est envoyé depuis l’hôte B et arrive sur l’unité 2-1 (l’un des membres de Po1).

- TCP SYN/ACK est envoyé au plan de données via l'une des interfaces de fond de panier du châssis (par exemple, E1/9, E1/10, etc.).

- TCP SYN/ACK arrive sur l'interface d'entrée du plan de données (Po1.202/OUTSIDE).

- TCP SYN/ACK est envoyé de la liaison de contrôle de cluster (CCL) vers l'unité 1-1. Par défaut, ISN est activé. Ainsi, le redirecteur trouve les informations de propriétaire pour les SYN+ACK TCP sans l'implication du directeur. Pour les autres paquets ou lorsque le RNIS est désactivé, le directeur est interrogé.

- TCP SYN/ACK arrive sur l'une des interfaces de fond de panier du châssis (par exemple, E1/9, E1/10, etc.).

- TCP SYN/ACK est envoyé de l'interface physique du châssis (l'un des membres de Po48) vers l'unité 1-1.

- TCP SYN/ACK arrive sur l'unité 1-1 (l'un des membres de Po48).

- TCP SYN/ACK est transmis via l'une des interfaces de fond de panier du châssis à l'interface port-channel CCL du plan de données (cluster de noms).

- Le plan de données réinjecte le paquet TCP SYN/ACK dans l'interface de plan de données Po1.202/OUTSIDE.

- TCP SYN/ACK est envoyé de Po1.201/INSIDE (interface de sortie du plan de données) vers l'hôte A.

- Le protocole TCP SYN/ACK traverse l'une des interfaces de fond de panier du châssis (par exemple, E1/9, E1/10, etc.) et sort de l'un des membres de Po1.

- TCP SYN/ACK arrive sur l’hôte A.

Pour plus d'informations sur ce scénario, consultez la section correspondante des Études de cas d'établissement d'une connexion de cluster.

Sur la base de cet échange de paquets, tous les points de capture de cluster possibles sont les suivants :

Pour la capture du trafic de transfert (par exemple, TCP SYN) sur :

- Interface physique du châssis (par exemple, membres Po1). Cette capture est configurée à partir de l'interface utilisateur de Chassis Manager (CM) ou de l'interface de ligne de commande de CM.

- Interface d'entrée du plan de données (par exemple, Po1.201 INSIDE).

- Interface de sortie du plan de données (par exemple, Po1.202 OUTSIDE).

- Interfaces de fond de panier du châssis. Le FP4100 comporte 2 interfaces de fond de panier. Sur le FP9300, il y en a un total de 6 (2 par module). Puisque vous ne savez pas dans quelle interface le paquet arrive, vous devez activer la capture sur toutes les interfaces.

Pour la capture du trafic de retour (par exemple, TCP SYN/ACK) sur :

- Interface physique du châssis (par exemple, membres Po1). Cette capture est configurée à partir de l'interface utilisateur de Chassis Manager (CM) ou de l'interface de ligne de commande de CM.

- Interface d'entrée du plan de données (par exemple, Po1.202 OUTSIDE).

- Comme le paquet est redirigé, le point de capture suivant est le plan de données CCL.

- Interfaces de fond de panier du châssis. Là encore, vous devez activer la capture sur les deux interfaces.

- Interfaces membres CCL du châssis Unit-1-1.

- Interface CCL du plan de données (cluster de nom).

- Interface d'entrée (Po1.202 OUTSIDE). Il s’agit du paquet réinjecté de CCL vers le plan de données.

- Interface de sortie du plan de données (par exemple, Po1.201 INSIDE).

- Interfaces de fond de panier du châssis.

Activation des captures de cluster

Captures FXOS

Le processus est décrit dans le Guide de configuration de FXOS : Capture de paquets

Remarque : les captures FXOS ne peuvent être prises que dans la direction d'entrée du point de vue du commutateur interne.

Captures du plan de données

La méthode recommandée pour activer la capture sur tous les membres du cluster est avec la commande cluster exec.

Prenons l'exemple d'un cluster à 3 unités :

Pour vérifier s'il existe des captures actives dans toutes les unités de cluster, utilisez cette commande :

firepower# cluster exec show capture

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

Pour activer une capture de plan de données sur toutes les unités sur Po1.201 (INSIDE) :

firepower# cluster exec capture CAPI interface INSIDE

Il est fortement recommandé de spécifier un filtre de capture et, si vous prévoyez un trafic important, d'augmenter la mémoire tampon de capture :

firepower# cluster exec capture CAPI buffer 33554432 interface INSIDE match tcp host 192.168.240.50 host 192.168.241.50 eq 80

Vérification

firepower# cluster exec show capture

unit-1-1(LOCAL):******************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 5140 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 260 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

Pour afficher le contenu de toutes les captures (ce résultat peut être très long) :

firepower# terminal pager 24

firepower# cluster exec show capture CAPI

unit-1-1(LOCAL):******************************************************

21 packets captured

1: 11:33:09.879226 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: S 2225395909:2225395909(0) win 29200 <mss 1460,sackOK,timestamp 1110209649 0,nop,wscale 7>

2: 11:33:09.880401 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.45456: S 719653963:719653963(0) ack 2225395910 win 28960 <mss 1380,sackOK,timestamp 1120565119 1110209649,nop,wscale 7>

3: 11:33:09.880691 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: . ack 719653964 win 229 <nop,nop,timestamp 1110209650 1120565119>

4: 11:33:09.880783 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: P 2225395910:2225396054(144) ack 719653964 win 229 <nop,nop,timestamp 1110209650 1120565119>

unit-2-1:*************************************************************

0 packet captured

0 packet shown

unit-3-1:*************************************************************

0 packet captured

0 packet shown

Capturer les traces

Si vous voulez voir comment les paquets entrants sont traités par le plan de données sur chaque unité, utilisez le mot clé trace. Il suit les 50 premiers paquets entrants. Vous pouvez tracer jusqu'à 1 000 paquets entrants.

Remarque : si plusieurs captures sont appliquées à une interface, vous ne pouvez tracer un seul paquet qu'une seule fois.

Pour suivre les 1 000 premiers paquets entrants sur l'interface OUTSIDE sur toutes les unités de cluster :

firepower# cluster exec cap CAPO int OUTSIDE buff 33554432 trace trace-count 1000 match tcp host 192.168.240.50 host 192.168.241.50 eq www

Une fois que vous avez capturé le flux d'intérêt, vous devez vous assurer que vous suivez les paquets d'intérêt sur chaque unité. Il est important de se rappeler qu’un paquet spécifique peut être #1 sur l’unité 1-1, mais #2 sur une autre unité, etc.

Dans cet exemple, vous pouvez voir que le paquet SYN/ACK est le paquet #2 sur l'unité-2-1, mais le paquet #1 sur l'unité-3-1 :

firepower# cluster exec show capture CAPO | include S.*ack

unit-1-1(LOCAL):******************************************************

1: 12:58:31.117700 802.1Q vlan#202 P0 192.168.240.50.45468 > 192.168.241.50.80: S 441626016:441626016(0) win 29200 <mss 1380,sackOK,timestamp 1115330849 0,nop,wscale 7>

2: 12:58:31.118341 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

1: 12:58:31.111429 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Pour suivre le paquet #2 (SYN/ACK) sur l’unité locale :

firepower# cluster exec show cap CAPO packet-number 2 trace

unit-1-1(LOCAL):******************************************************

2: 12:58:31.118341 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Phase: 1

Type: CAPTURE

Subtype:

Result: ALLOW

Config:

Additional Information:

MAC Access list

...

Pour suivre le même paquet (SYN/ACK) sur l'unité distante :

firepower# cluster exec unit unit-3-1 show cap CAPO packet-number 1 trace

1: 12:58:31.111429 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Phase: 1

Type: CAPTURE

Subtype:

Result: ALLOW

Config:

Additional Information:

MAC Access list

...

Capture CCL

Pour activer la capture sur la liaison CCL (sur toutes les unités) :

firepower# cluster exec capture CCL interface cluster

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Réinjecter Masquer

Par défaut, une capture activée sur une interface de données de plan de données affiche tous les paquets :

- Ceux qui arrivent du réseau physique

- Ceux qui sont réinjectés à partir de la CCL

Si vous ne voulez pas voir les paquets réinjectés, utilisez l'option reinject-hide. Cela peut être utile si vous voulez vérifier si un flux est asymétrique :

firepower# cluster exec capture CAPI_RH reinject-hide interface INSIDE match tcp host 192.168.240.50 host 192.168.241.50 eq 80

Cette capture vous montre uniquement ce que l'unité locale reçoit réellement sur l'interface spécifique directement du réseau physique, et non des autres unités de cluster.

Gouttes ASP

Si vous voulez vérifier les pertes logicielles pour un flux spécifique, vous pouvez activer la capture asp-drop. Si vous ne savez pas sur quelle raison vous concentrer, utilisez le mot clé all. En outre, si vous n'êtes pas intéressé par la charge utile du paquet, vous pouvez spécifier le mot clé headers-only. Cela vous permet de capturer 20 à 30 fois plus de paquets :

firepower# cluster exec cap ASP type asp-drop all buffer 33554432 headers-only

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

En outre, vous pouvez spécifier les IP qui vous intéressent dans la capture ASP :

firepower# cluster exec cap ASP type asp-drop all buffer 33554432 headers-only match ip host 192.0.2.100 any

Effacer une capture

Pour effacer la mémoire tampon de toute capture exécutée dans toutes les unités de cluster. Cela n'arrête pas les captures, mais efface uniquement les tampons :

firepower# cluster exec clear capture /all

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Arrêter une capture

Il existe deux façons d'arrêter une capture active sur toutes les unités de cluster. Plus tard, vous pourrez reprendre.

Voie 1

firepower# cluster exec cap CAPI stop

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Pour reprendre

firepower# cluster exec no capture CAPI stop

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Voie 2

firepower# cluster exec no capture CAPI interface INSIDE

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Pour reprendre

firepower# cluster exec capture CAPI interface INSIDE

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Collecter une capture

Il existe plusieurs façons d'exporter une capture.

Méthode 1 - Vers un serveur distant

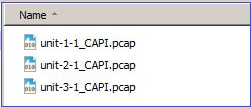

Cela vous permet de télécharger une capture depuis le plan de données vers un serveur distant (par exemple, TFTP). Les noms de capture sont automatiquement modifiés pour refléter l'unité source :

firepower# cluster exec copy /pcap capture:CAPI tftp://192.168.240.55/CAPI.pcap

unit-1-1(LOCAL):******************************************************

Source capture name [CAPI]?

Address or name of remote host [192.168.240.55]?

Destination filename [CAPI.pcap]?

INFO: Destination filename is changed to unit-1-1_CAPI.pcap !!!!!!!

81 packets copied in 0.40 secs

unit-2-1:*************************************************************

INFO: Destination filename is changed to unit-2-1_CAPI.pcap !

unit-3-1:*************************************************************

INFO: Destination filename is changed to unit-3-1_CAPI.pcap !

Les fichiers pcap téléchargés :

Méthode 2 - Récupérer les captures à partir du FMC

Cette méthode s'applique uniquement au FTD. Tout d'abord, copiez la capture sur le disque FTD :

firepower# cluster exec copy /pcap capture:CAPI disk0:CAPI.pcap

unit-1-1(LOCAL):******************************************************

Source capture name [CAPI]?

Destination filename [CAPI.pcap]?

!!!!!

62 packets copied in 0.0 secs

À partir du mode expert, copiez le fichier du répertoire /mnt/disk0/ vers le répertoire /ngfw/var/common/ :

> expert

admin@firepower:~$ cd /mnt/disk0

admin@firepower:/mnt/disk0$ sudo cp CAPI.pcap /ngfw/var/common

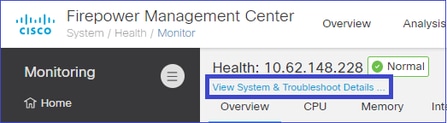

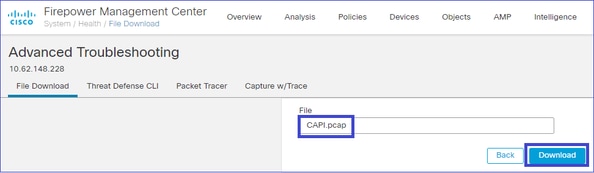

Enfin, sur FMC, accédez à System > Health > Monitor section. Choisissez View System & Troubleshoot Details > Advanced Troubleshooting et récupérez le fichier de capture :

Supprimer une capture

Pour supprimer une capture de toutes les unités de cluster, utilisez cette commande :

firepower# cluster exec no capture CAPI

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Flux déchargés

Sur les modèles FP41xx/FP9300, les flux peuvent être transférés vers HW Accelerator de manière statique (par exemple, les règles Fastpath) ou dynamique. Pour plus d'informations sur le déchargement de flux, consultez ce document :

Si un flux est déchargé, seuls quelques paquets passent par le plan de données FTD. Le reste est géré par l'accélérateur matériel (carte réseau intelligente).

Du point de vue de la capture, cela signifie que si vous activez uniquement les captures au niveau du plan de données FTD, vous ne voyez pas tous les paquets qui passent par le périphérique. Dans ce cas, vous devez également activer les captures au niveau du châssis FXOS.

Messages CCL (Cluster Control Link)

Si vous effectuez une capture sur la CCL, vous remarquerez que les unités de cluster échangent différents types de messages. Ceux qui vous intéressent sont :

| Protocol |

Description |

| UDP 49495 |

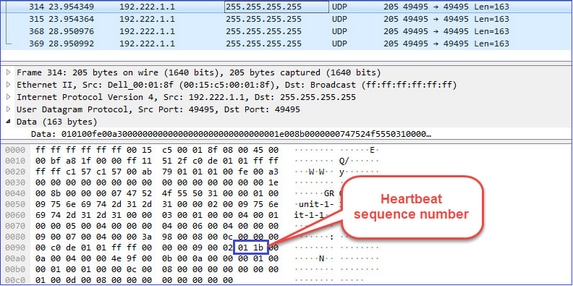

Pulsations de cluster (keepalives) · Diffusion L3 (255.255.255.255) · Ces paquets sont envoyés par chaque unité de cluster à 1/3 de la valeur de temps d'attente du contrôle d'intégrité. · Notez que tous les paquets UDP 49495 vus dans la capture ne sont pas des pulsations · Les battements de coeur contiennent un numéro d'ordre. |

| UDP 4193 |

Messages de chemin de données du protocole de contrôle de cluster · Monodiffusion · Ces paquets contiennent des informations (métadonnées) sur le propriétaire du flux, le directeur, le propriétaire de la sauvegarde, etc. Exemples : · Un message « cluster add » est envoyé par le propriétaire au directeur lorsqu'un nouveau flux est créé · Un message de « suppression de cluster » est envoyé par le propriétaire au directeur lorsqu'un flux est interrompu |

| paquets de données |

Paquets de données qui appartiennent aux différents flux de trafic qui traversent le cluster |

Pulsation du cluster

Messages CCP (Cluster Control Point)

Outre les messages de pulsation, un certain nombre de messages de contrôle de cluster sont échangés via la CCL dans des scénarios spécifiques. Certains d'entre eux sont des messages de monodiffusion tandis que d'autres sont des diffusions.

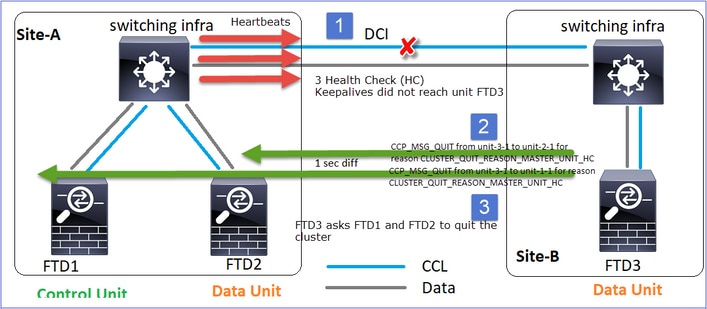

CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Chaque fois qu'une unité perd 3 messages de pulsation consécutifs en provenance du noeud de contrôle, elle génère un message CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC sur la CCL. Ce message:

- Est une monodiffusion.

- Il est envoyé à chacune des unités avec un intervalle d'une seconde.

- Lorsqu'une unité reçoit ce message, quitte le cluster (DISABLED) et se reconnecte.

Q. Quelle est la fonction de CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC ?

A. Du point de vue de l'unité-3-1 (Site-B), il perd la connexion à l'unité-1-1 et à l'unité-2-1 du site A, donc il doit les retirer de sa liste de membres dès que possible, sinon, il peut avoir un paquet perdu si l'unité-2-1 est toujours dans sa liste de membres et que l'unité-2-1 se trouve être un directeur d'une connexion, et la requête de flux vers l'unité-2-1 échoue.

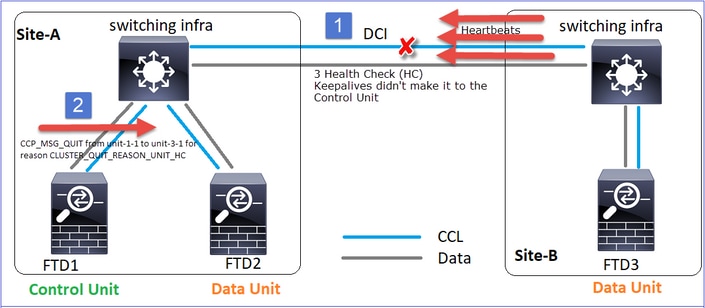

CLUSTER_QUIT_REASON_UNIT_HC

Chaque fois que le noeud de contrôle perd 3 messages de pulsation consécutifs à partir d'un noeud de données, il envoie un message CLUSTER_QUIT_REASON_UNIT_HC sur la CCL. Ce message est en monodiffusion.

MEMBRE_PARCOURS_RAISON_ARRÊT_GRAPPE

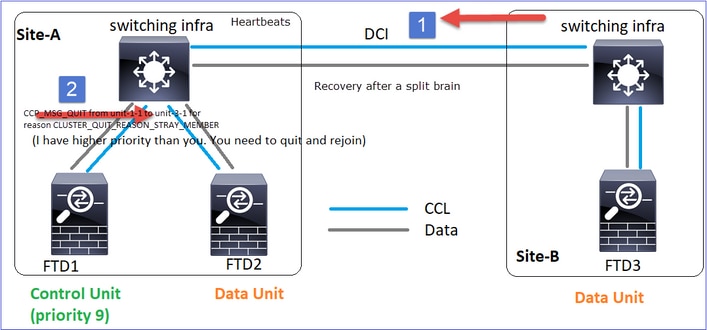

Lorsqu'une partition partagée se reconnecte à une partition homologue, le nouveau noeud de données est traité comme un membre parasite par l'unité de contrôle dominante et reçoit un message CCP quit avec la raison CLUSTER_QUIT_REASON_STRAY_MEMBER.

ABANDON_MEMBRE_QUIT_CLUSTER

Message de diffusion généré par un noeud de données et envoyé sous forme de diffusion. Une fois qu'une unité reçoit ce message, passe à l'état DISABLED. En outre, la réjointure automatique ne démarre pas :

firepower# show cluster info trace | include DROPOUT

Nov 04 00:22:54.699 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-1-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 04 00:22:53.699 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-2-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

L'historique du cluster indique :

PRIMARY DISABLED Received control message DISABLE (member dropout announcement)

Mécanisme de vérification de l'état de santé des clusters (HC)

Points principaux

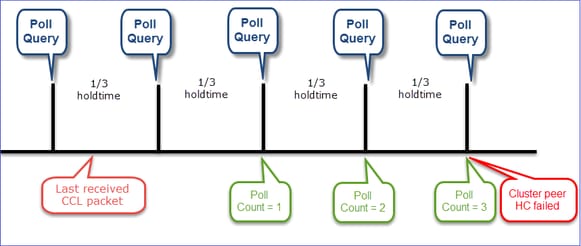

- Chaque unité de cluster envoie une pulsation toutes les 1/3 de la valeur de temps d'attente du contrôle d'intégrité à toutes les autres unités (diffusion 255.255.255.255) et utilise le port UDP 49495 comme transport sur la CCL.

- Chaque unité de grappe suit indépendamment une unité sur deux avec un compteur d'interrogation et une valeur de comptage d'interrogation.

- Si une unité de cluster ne reçoit aucun paquet (pulsation ou paquet de données) d'une unité homologue de cluster au cours d'un intervalle de pulsation, elle augmente la valeur du nombre d'interrogations.

- Lorsque la valeur du nombre d'interrogations pour une unité homologue de cluster devient 3, l'homologue est considéré comme inactif.

- Chaque fois qu'un battement de coeur est reçu, son numéro de séquence est vérifié et dans le cas où la différence avec le battement de coeur précédemment reçu est différente de 1, le compteur d'abandon de battement de coeur augmente en conséquence.

- Si le compteur du nombre d'interrogations d'un homologue de cluster est différent de 0 et qu'un paquet est reçu par l'homologue, le compteur est réinitialisé à une valeur 0.

Utilisez cette commande pour vérifier les compteurs d'intégrité du cluster :

firepower# show cluster info health details

----------------------------------------------------------------------------------

| Unit (ID)| Heartbeat| Heartbeat| Average| Maximum| Poll|

| | count| drops| gap (ms)| slip (ms)| count|

----------------------------------------------------------------------------------

| unit-2-1 ( 1)| 650| 0| 4999| 1| 0|

| unit-3-1 ( 2)| 650| 0| 4999| 1| 0|

----------------------------------------------------------------------------------

Description des colonnes principales

| Colonne |

Description |

| Unité (ID) |

ID de l'homologue de cluster distant. |

| Nombre de pulsations |

Nombre de pulsations reçues de l'homologue distant sur la CCL. |

| Les pulsations chutent |

Nombre de pulsations manquées. Ce compteur est calculé en fonction du numéro de séquence de pulsation reçu. |

| Écart moyen |

Intervalle de temps moyen des pulsations reçues. |

| Nombre de sondages |

Lorsque ce compteur passe à 3, l'unité est retirée de la grappe. L'intervalle de requête d'interrogation est identique à l'intervalle de pulsation, mais s'exécute indépendamment. |

Pour réinitialiser les compteurs, utilisez cette commande :

firepower# clear cluster info health details

Q. Comment vérifier la fréquence des battements de coeur ?

A. Vérifiez la valeur moyenne de l'écart :

firepower# show cluster info health details

----------------------------------------------------------------------------------

| Unit (ID)| Heartbeat| Heartbeat| Average| Maximum| Poll|

| | count| drops| gap (ms)| slip (ms)| count|

----------------------------------------------------------------------------------

| unit-2-1 ( 1)| 3036| 0| 999| 1| 0|

----------------------------------------------------------------------------------

Q. Comment pouvez-vous modifier le temps d'attente du cluster sur le FTD ?

A. Utiliser FlexConfig

Q. Qui devient le noeud de contrôle après une scission du cerveau ?

A. L'unité ayant la priorité la plus élevée (numéro le plus bas) :

firepower# show run cluster | include priority

priority 9

Consultez le scénario de défaillance HC 1 pour plus de détails.

Visualisation du mécanisme HC du cluster

Temporisateurs indicatifs : les valeurs min et max dépendent de la dernière arrivée du paquet CCL reçu.

| Temps d'attente |

Vérification de requête de sondage (fréquence) |

Temps de détection minimal |

Temps de détection max. |

| 3 s (par défaut) |

~1 s |

~3,01 s |

~3,99 s |

| 4 sec |

~1,33 s |

~4,01 s |

~5,32 s |

| 5 sec |

~1,66 s |

~5,01 s |

~6,65 s |

| 6 sec |

~2 s |

~6,01 s |

~7,99 s |

| 7 sec |

~2,33 s |

~7,01 s |

~9,32 s |

| 8 sec |

~2,66 s |

~8,01 s |

~10,65 s |

Scénarios de défaillance HC de cluster

Les objectifs de cette section sont de démontrer :

- Différents scénarios de défaillance HC de cluster.

- Comment corréler les différents journaux et les résultats des commandes.

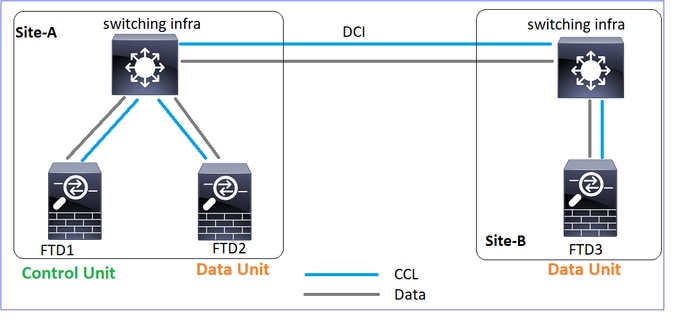

Topologie

Configuration de cluster

| Unité-1-1 |

Unité-2-1 |

Unité-3-1 |

cluster group GROUP1 |

cluster group GROUP1 |

cluster group GROUP1 |

État du cluster

| Unité-1-1 |

Unité-2-1 |

Unité-3-1 |

firepower# show cluster info |

firepower# show cluster info |

firepower# show cluster info |

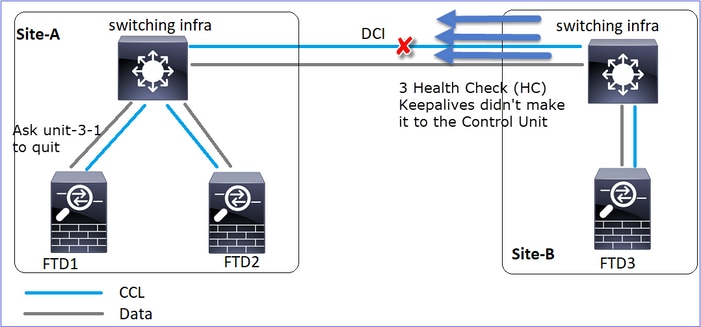

Scénario 1

Perte de communication CCL pour ~4+ sec dans les deux directions.

Avant la défaillance

| FTD1 |

FTD2 |

FTD3 |

| Site-A |

Site-A |

Site-B |

| Noeud de contrôle |

Noeud Données |

Noeud Données |

Après la restauration (aucune modification des rôles d'unité)

| FTD1 |

FTD2 |

FTD3 |

| Site-A |

Site-A |

Site-B |

| Noeud de contrôle |

Noeud Données |

Noeud Données |

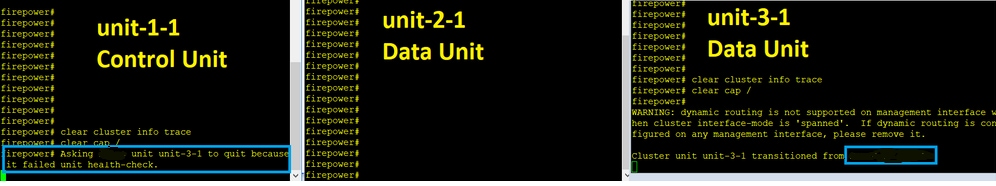

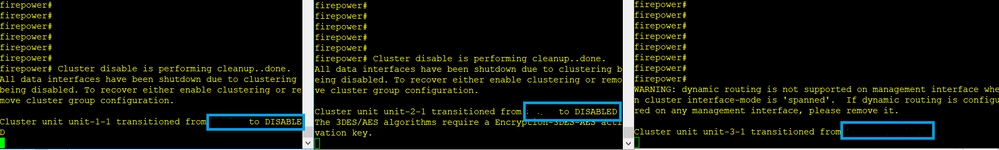

Analyse

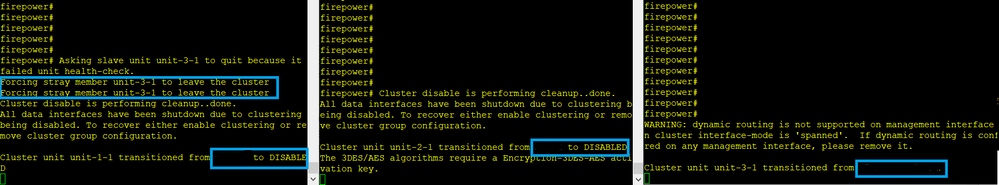

Échec (communication CCL perdue).

Le message de console du plan de données sur l'unité 3-1 :

firepower#

WARNING: dynamic routing is not supported on management interface when cluster interface-mode is 'spanned'.

If dynamic routing is configured on any management interface, please remove it.

Cluster unit unit-3-1 transitioned from SECONDARY to PRIMARY

Cluster disable is performing cleanup..done.

All data interfaces have been shutdown due to clustering being disabled.

To recover either enable clustering or remove cluster group configuration.

Journaux de suivi de cluster Unit-1-1 :

firepower# show cluster info trace | include unit-3-1

Nov 02 09:38:14.239 [INFO]Notify chassis de-bundle port for blade unit-3-1, stack 0x000055a8918307fb 0x000055a8917fc6e8 0x000055a8917f79b5

Nov 02 09:38:14.239 [INFO]FTD - CD proxy received state notification (DISABLED) from unit unit-3-1

Nov 02 09:38:14.239 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 02 09:38:14.239 [INFO]Notify chassis de-bundle port for blade unit-3-1, stack 0x000055a8917eb596 0x000055a8917f4838 0x000055a891abef9d

Nov 02 09:38:14.239 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Nov 02 09:38:14.239 [CRIT]Received heartbeat event 'SECONDARY heartbeat failure' for member unit-3-1 (ID: 1).

Split-brain

| Unité-1-1 |

Unité-2-1 |

Unité-3-1 |

firepower# show cluster info |

firepower# show cluster info |

firepower# show cluster info |

Historique du cluster

| Unité-1-1 |

Unité-2-1 |

Unité-3-1 |

| Aucun événement |

Aucun événement |

09:38:16 UTC Nov 2 2020 |

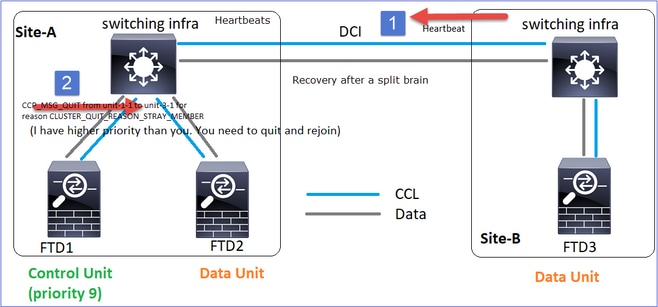

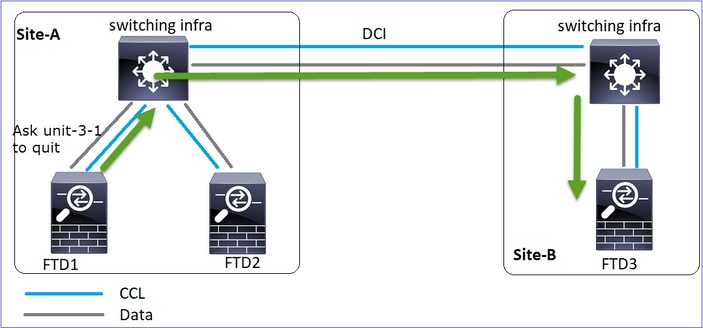

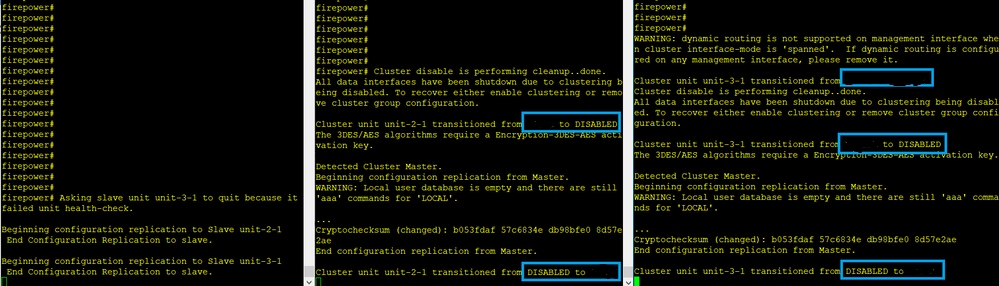

Restauration des communications CCL

Unit-1-1 détecte le noeud de contrôle actuel et, comme unit-1-1 a une priorité plus élevée, envoie à unit-3-1 un message CLUSTER_QUIT_REASON_STRAY_MEMBER pour déclencher un nouveau processus de sélection. En fin de compte, l'unité 3-1 se joint à nouveau en tant que noeud de données.

Lorsqu'une partition partagée se reconnecte à une partition homologue, le noeud de données est traité comme un membre parasite par le noeud de contrôle dominant et reçoit un message CCP quit avec une raison de CLUSTER_QUIT_REASON_STRAY_MEMBER.

Unit-3-1 console logs show:

Cluster unit unit-3-1 transitioned from PRIMARY to DISABLED

The 3DES/AES algorithms require a Encryption-3DES-AES activation key.

Detected Cluster Primart.

Beginning configuration replication from Primary.

WARNING: Local user database is empty and there are still 'aaa' commands for 'LOCAL'.

..

Cryptochecksum (changed): a9ed686f 8e2e689c 2553a104 7a2bd33a

End configuration replication from Primary.

Cluster unit unit-3-1 transitioned from DISABLED to SECONDARY

Les deux unités (unit-1-1 et unit-3-1) affichent dans leurs journaux de cluster :

firepower# show cluster info trace | include retain

Nov 03 21:20:23.019 [CRIT]Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Nov 03 21:20:23.019 [CRIT]Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Il y a aussi des messages syslog générés pour le split-brain :

firepower# show log | include 747016

Nov 03 2020 21:20:23: %FTD-4-747016: Clustering: Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Nov 03 2020 21:20:23: %FTD-4-747016: Clustering: Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Historique du cluster

| Unité-1-1 |

Unité-2-1 |

Unité-3-1 |

| Aucun événement |

Aucun événement |

09:47:33 UTC Nov 2 2020 |

Scénario 2

Perte de communication CCL d'environ 3 à 4 secondes dans les deux directions.

Avant la défaillance

| FTD1 |

FTD2 |

FTD3 |

| Site-A |

Site-A |

Site-B |

| Noeud de contrôle |

Noeud Données |

Noeud Données |

Après la restauration (aucune modification des rôles d'unité)

| FTD1 |

FTD2 |

FTD3 |

| Site-A |

Site-A |

Site-B |

| Noeud de contrôle |

Noeud Données |

Noeud Données |

Analyse

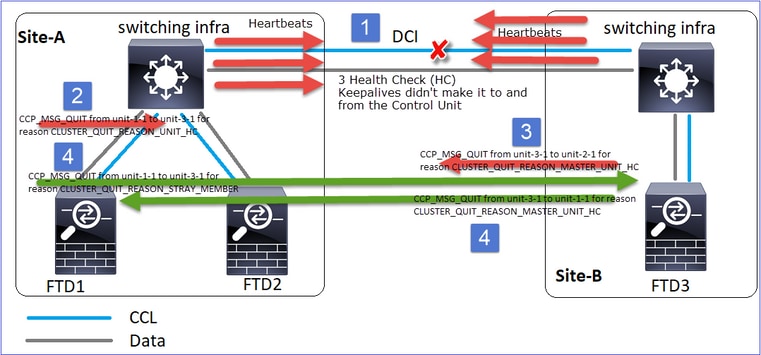

Événement 1 : Le noeud de contrôle perd 3 HC de l'unité 3-1 et envoie un message à l'unité 3-1 pour quitter la grappe.

Événement 2 : La CCL s'est rétablie très rapidement et le message CLUSTER_QUIT_REASON_STRAY_MEMBER du noeud de contrôle est arrivé sur le côté distant. Unit-3-1 passe directement en mode DISABLED et il n'y a pas de split-brain

Sur l'unité 1-1 (contrôle), vous voyez :

firepower#

Asking SECONDARY unit unit-3-1 to quit because it failed unit health-check.

Forcing stray member unit-3-1 to leave the cluster

Sur l'unité 3-1 (noeud de données), vous voyez :

firepower#

Cluster disable is performing cleanup..done.

All data interfaces have been shutdown due to clustering being disabled. To recover either enable clustering or remove cluster group configuration.

Cluster unit unit-3-1 transitioned from SECONDARY to DISABLED

L'unité de cluster 3-1 est passée à l'état DISABLED et, une fois la communication CCL restaurée, elle rejoint à nouveau le réseau en tant que noeud de données :

firepower# show cluster history

20:58:40 UTC Nov 1 2020

SECONDARY DISABLED Received control message DISABLE (stray member)

20:58:45 UTC Nov 1 2020

DISABLED ELECTION Enabled from CLI

20:58:45 UTC Nov 1 2020

ELECTION SECONDARY_COLD Received cluster control message

20:58:45 UTC Nov 1 2020

SECONDARY_COLD SECONDARY_APP_SYNC Client progression done

20:59:33 UTC Nov 1 2020

SECONDARY_APP_SYNC SECONDARY_CONFIG SECONDARY application configuration sync done

20:59:44 UTC Nov 1 2020

SECONDARY_CONFIG SECONDARY_FILESYS Configuration replication finished

20:59:45 UTC Nov 1 2020

SECONDARY_FILESYS SECONDARY_BULK_SYNC Client progression done

21:00:09 UTC Nov 1 2020

SECONDARY_BULK_SYNC SECONDARY Client progression done

Scénario 3

Perte de communication CCL d'environ 3 à 4 secondes dans les deux directions.

Avant l'échec.

| FTD1 |

FTD2 |

FTD3 |

| Site-A |

Site-A |

Site-B |

| Noeud de contrôle |

Noeud Données |

Noeud Données |

Après la restauration (le noeud de contrôle a été modifié).

| FTD1 |

FTD2 |

FTD3 |

| Site-A |

Site-A |

Site-B |

| Noeud Données |

Noeud de contrôle |

Noeud Données |

Analyse

- CCL tombe en panne.

- Unit-1-1 n'obtient pas 3 messages HC de unit-3-1 et envoie un message QUIT à unit-3-1. Ce message n'atteint jamais unit-3-1.

- Unit-3-1 envoie un message QUIT à Unit-2-1. Ce message n'atteint jamais l'unité 2-1.

CCL récupère.

- L'unité 1-1 voit que l'unité 3-1 s'est annoncée comme noeud de contrôle et envoie le message QUIT_REASON_STRAY_MEMBER à l'unité 3-1. Une fois que l'unité 3-1 reçoit ce message, il passe à l'état DISABLED. En même temps, l'unité-3-1 envoie un message QUIT_REASON_PRIMARY_UNIT_HC à l'unité-1-1 et lui demande de quitter. Une fois que l'unité 1-1 reçoit ce message, il passe à l'état DISABLED.

Historique du cluster

| Unité-1-1 |

Unité-2-1 |

Unité-3-1 |

19:53:09 UTC Nov 2 2020 |

19:53:06 UTC Nov 2 2020 |

19:53:06 UTC Nov 2 2020 |

Scénario 4

Perte de communication CCL d'environ 3 à 4 secondes

Avant la défaillance

| FTD1 |

FTD2 |

FTD3 |

| Site-A |

Site-A |

Site-B |

| Noeud de contrôle |

Noeud Données |

Noeud Données |

Après la restauration (le noeud de contrôle a changé de site)

| FTD1 |

FTD2 |

FTD3 |

| Site-A |

Site-A |

Site-B |

| Noeud Données |

Noeud Données |

Noeud de contrôle |

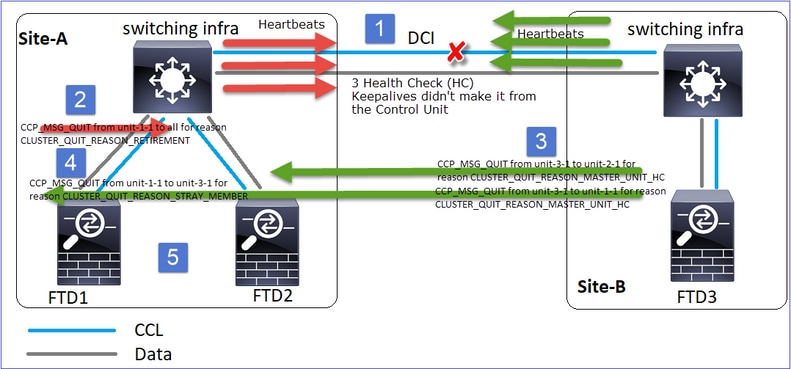

Analyse

L'échec

Un autre aspect de la même panne. Dans ce cas, l’unité-1-1 n’a pas non plus reçu 3 messages HC de l’unité-3-1, et une fois qu’elle a reçu un nouveau keepalive, elle a essayé de mettre l’unité-3-1 à la porte en utilisant un message STRAY, mais le message n’est jamais arrivé à l’unité-3-1 :

- CCL devient unidirectionnelle pendant quelques secondes. L'unité 3-1 ne reçoit pas de messages 3 HC de l'unité 1-1 et devient un noeud de contrôle.

- Unit-2-1 envoie un message CLUSTER_QUIT_REASON_RETIREMENT (diffusion).

- Unit-3-1 envoie un message QUIT_REASON_PRIMARY_UNIT_HC à unit-2-1. L'unité 2-1 la reçoit et quitte la grappe.

- Unit-3-1 envoie un message QUIT_REASON_PRIMARY_UNIT_HC à unit-1-1. L'unité 1-1 la reçoit et quitte la grappe. CCL récupère.

- Les unités 1-1 et 2-1 rejoignent le cluster en tant que noeuds de données.

Remarque : si à l'étape 5 la CCL ne récupère pas, dans le site A, le FTD1 devient le nouveau noeud de contrôle et, après la récupération de la CCL, il gagne la nouvelle sélection.

Messages Syslog sur unit-1-1 :

firepower# show log | include 747

Nov 03 2020 23:13:08: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-3-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:09: %FTD-4-747015: Clustering: Forcing stray member unit-3-1 to leave the cluster

Nov 03 2020 23:13:09: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-2-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-4-747015: Clustering: Forcing stray member unit-3-1 to leave the cluster

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY to DISABLED

Nov 03 2020 23:13:12: %FTD-7-747006: Clustering: State machine is at state DISABLED

Nov 03 2020 23:13:12: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MY_STATE (state DISABLED,0x0000000000000000,0x0000000000000000)

Nov 03 2020 23:13:18: %FTD-6-747004: Clustering: State machine changed from state ELECTION to ONCALL

Journaux de suivi de cluster sur l'unité 1-1 :

firepower# show cluster info trace | include QUIT

Nov 03 23:13:10.789 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 03 23:13:10.769 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-1-1 for reason CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Nov 03 23:13:10.769 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_STRAY_MEMBER

Nov 03 23:13:09.789 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 03 23:13:09.769 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_STRAY_MEMBER

Nov 03 23:13:08.559 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 03 23:13:08.559 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Messages Syslog sur unit-3-1 :

firepower# show log | include 747

Nov 03 2020 23:13:09: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-2-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-1-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state SECONDARY to PRIMARY

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_FAST to PRIMARY_DRAIN

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_DRAIN to PRIMARY_CONFIG

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_CONFIG to PRIMARY_POST_CONFIG

Nov 03 2020 23:13:10: %FTD-7-747006: Clustering: State machine is at state PRIMARY_POST_CONFIG

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_POST_CONFIG to PRIMARY

Nov 03 2020 23:13:10: %FTD-7-747006: Clustering: State machine is at state PRIMARY

Historique du cluster

| Unité-1-1 |

Unité-2-1 |

Unité-3-1 |

23:13:13 UTC Nov 3 2020 |

23:13:12 UTC Nov 3 2020 |

23:13:10 UTC Nov 3 2020 |

Scénario 5

Avant la défaillance

| FTD1 |

FTD2 |

FTD3 |

| Site-A |

Site-A |

Site-B |

| Noeud de contrôle |

Noeud Données |

Noeud Données |

Après la restauration (aucune modification)

| FTD1 |

FTD2 |

FTD3 |

| Site-A |

Site-A |

Site-B |

| Noeud de contrôle |

Noeud Données |

Noeud Données |

L'échec

Unit-3-1 a envoyé des messages QUIT à unit-1-1 et unit-2-1, mais en raison de problèmes de connectivité, seule l'unit-2-1 a reçu le message QUIT.

Journaux de suivi de cluster Unit-1-1 :

firepower# show cluster info trace | include QUIT

Nov 04 00:52:10.429 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:47.059 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:45.429 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 04 00:51:45.429 [DBUG]Send CCP message to unit-3-1(1): CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Journaux de suivi de cluster Unit-2-1 :

firepower# show cluster info trace | include QUIT

Nov 04 00:52:10.389 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:47.019 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:46.999 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-2-1 for reason CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Nov 04 00:51:45.389 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Historique du cluster

| Unité-1-1 |

Unité-2-1 |

Unité-3-1 |

| Aucun événement |

00:51:50 UTC Nov 4 2020 |

00:51:47 UTC Nov 4 2020 |

Établissement de la connexion du plan de données du cluster

Points de capture NGFW

Le pare-feu de nouvelle génération offre des fonctionnalités de capture sur les points suivants :

- Commutateur interne du châssis (FXOS)

- moteur de plan de données FTD

- Moteur FTD Snort

Lorsque vous dépannez des problèmes de chemin de données sur un cluster, les points de capture utilisés dans la plupart des cas sont les captures de moteur de plan de données FXOS et FTD.

- Capture d'entrée FXOS sur l'interface physique

- Capture d'entrée FTD dans un moteur de plan de données

- Capture de sortie FTD dans un moteur de plan de données

- Capture d'entrée FXOS sur interface de fond de panier

Pour plus d'informations sur les captures NGFW, consultez ce document :

Notions de base sur les rôles de flux des unités

Les connexions peuvent être établies par le biais d'un cluster de plusieurs manières qui dépendent de facteurs tels que :

- Type de trafic (TCP, UDP, etc.)

- Algorithme d’équilibrage de charge configuré sur le commutateur adjacent

- Fonctionnalités configurées sur le pare-feu

- Conditions réseau (par exemple, fragmentation IP, retards réseau, etc.)

| Rôle de flux |

Description |

Indicateur(s) |

| Propriétaire |

Généralement, l'unité qui reçoit initialement la connexion |

UIO |

| directeur |

Unité qui gère les demandes de recherche de propriétaire provenant des redirecteurs. |

O |

| Propriétaire de sauvegarde |

Tant que le directeur n'est pas la même unité que le propriétaire, le directeur est également le propriétaire de secours. Si le propriétaire se choisit lui-même comme directeur, un propriétaire de sauvegarde distinct est choisi. |

Y (si le directeur est également le propriétaire de la sauvegarde) y (si le directeur n'est pas le propriétaire de la sauvegarde) |

| Transporteur |

Unité qui transmet des paquets au propriétaire |

z |

| Propriétaire du fragment |

Unité qui gère le trafic fragmenté |

- |

| Sauvegarde du châssis |

Dans un cluster inter-châssis, lorsque les flux directeur/sauvegarde et propriétaire appartiennent aux unités du même châssis, une unité de l'un des autres châssis devient un directeur/sauvegarde secondaire. Ce rôle est spécifique aux clusters inter-châssis de la gamme Firepower 9300 avec plus d'1 lame. |

w |

- Pour plus d'informations, consultez la section correspondante du Guide de configuration (voir les liens dans Informations connexes)

- Dans des scénarios spécifiques (voir la section des études de cas), certains indicateurs ne sont pas toujours affichés.

Études de cas sur Cluster Connection Establishment

La section suivante couvre diverses études de cas qui illustrent certaines des manières dont une connexion peut être établie par le biais d'un cluster. Les objectifs sont les suivants :

- Familiarisez-vous avec les différents rôles d'unité.

- Montrez comment les différentes sorties de commande peuvent être corrélées.

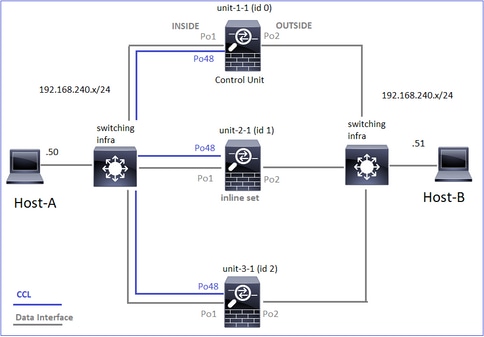

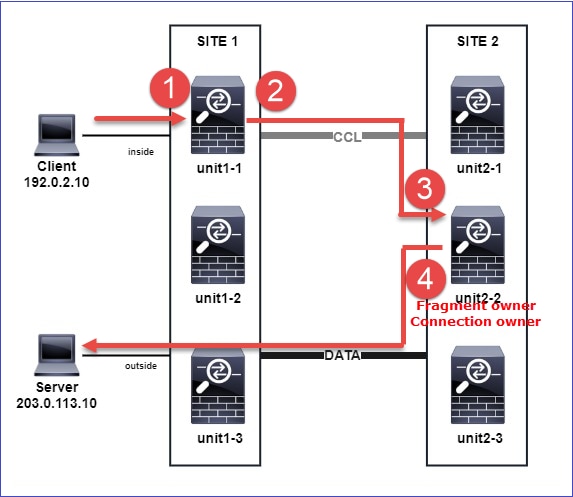

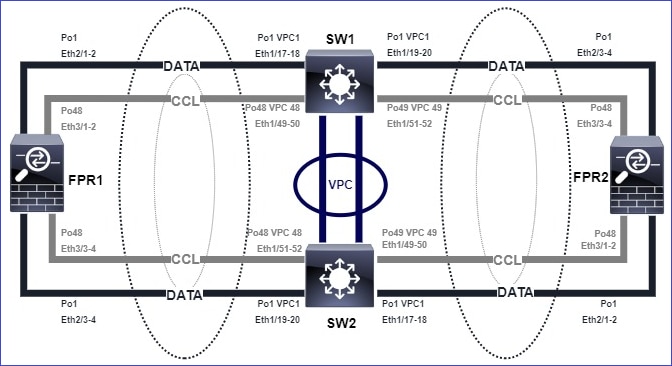

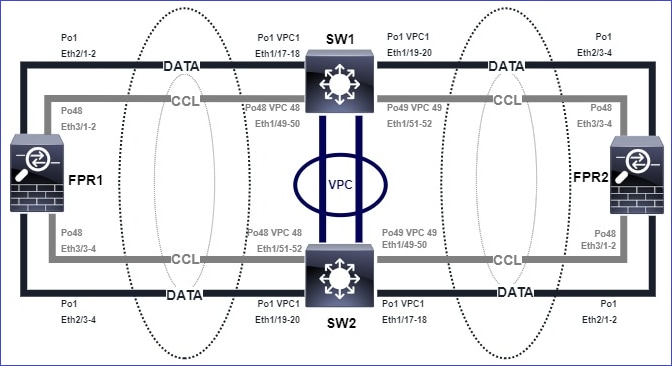

Topologie

Unités et ID de cluster :

| Unité-1-1 |

Unité-2-1 |

Unité-3-1 |

Cluster GROUP1: On |

Unit "unit-2-1" in state SECONDARY |

Unit "unit-3-1" in state SECONDARY |

Captures de cluster activées :

cluster exec cap CAPI int INSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPO int OUTSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPI_RH reinject-hide int INSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPO_RH reinject-hide int OUTSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CCL int cluster buffer 33554432

Remarque : ces tests ont été exécutés dans un environnement de travaux pratiques avec un trafic minimal dans le cluster. En production, essayez d'utiliser des filtres de capture aussi spécifiques que possible (par exemple, le port de destination et, dans la mesure du possible, le port source) pour minimiser le « bruit » dans les captures.

Étude de cas 1. Trafic symétrique (le propriétaire est également le directeur)

Observation 1. Les captures réinjecter-masquer affichent les paquets uniquement sur l'unité 1-1. Cela signifie que le flux dans les deux directions a traversé l'unité 1-1 (trafic symétrique) :

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data interface cluster [Capturing - 33513 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

unit-2-1:*************************************************************

capture CCL type raw-data interface cluster [Capturing - 23245 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

unit-3-1:*************************************************************

capture CCL type raw-data interface cluster [Capturing - 24815 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

Observation 2. Analyse des indicateurs de connexion pour le flux avec le port source 45954

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

22 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 2 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:45954, idle 0:00:00, bytes 487413076, flags UIO N1

unit-2-1:*************************************************************

22 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 249 most enabled, 0 most in effect

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 2 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:443 NP Identity Ifc 192.168.240.50:39698, idle 0:00:23, bytes 0, flags z

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:45954, idle 0:00:06, bytes 0, flags y

| Unité |

Drapeau |

Remarque |

| Unité-1-1 |

UIO |

· Flow Owner - L'unité gère le flux · Directeur - Puisque l'unité-3-1 a « y » et non « Y », cela signifie que l'unité-1-1 a été choisie comme directeur pour ce flux. Ainsi, puisqu'il est également propriétaire, une autre unité (unit-3-1 dans ce cas) a été élue comme propriétaire de secours |

| Unité-2-1 |

- |

- |

| Unité-3-1 |

o |

L'unité est propriétaire d'une sauvegarde |

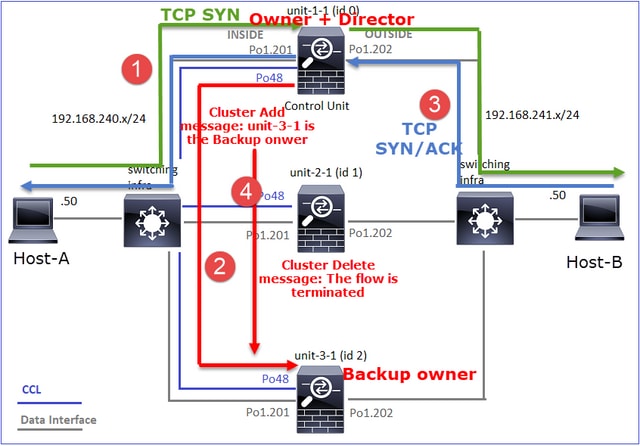

Cela peut être visualisé comme suit :

- Le paquet TCP SYN arrive de l’hôte A à l’unité 1-1. Unit-1-1 devient le propriétaire du flux.

- Unit-1-1 est également élu directeur de flux. Ainsi, il choisit également unit-3-1 comme propriétaire de sauvegarde (message d'ajout de cluster).

- Le paquet TCP SYN/ACK arrive de l’hôte B à l’unité 3-1. Le flux est symétrique.

- Une fois la connexion terminée, le propriétaire envoie un message de suppression de cluster pour supprimer les informations de flux du propriétaire de sauvegarde.

Observation 3. La capture avec trace montre que les deux directions passent uniquement par l'unité 1-1.

Étape 1. Identifiez le flux et les paquets intéressants dans toutes les unités de cluster en fonction du port source :

firepower# cluster exec show capture CAPI | i 45954

unit-1-1(LOCAL):******************************************************

1: 08:42:09.362697 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: S 992089269:992089269(0) win 29200 <mss 1460,sackOK,timestamp 495153655 0,nop,wscale 7>

2: 08:42:09.363521 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.45954: S 4042762409:4042762409(0) ack 992089270 win 28960 <mss 1380,sackOK,timestamp 505509125 495153655,nop,wscale 7>

3: 08:42:09.363827 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: . ack 4042762410 win 229 <nop,nop,timestamp 495153657 505509125>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower# cluster exec show capture CAPO | i 45954

unit-1-1(LOCAL):******************************************************

1: 08:42:09.362987 802.1Q vlan#202 P0 192.168.240.50.45954 > 192.168.241.50.80: S 2732339016:2732339016(0) win 29200 <mss 1380,sackOK,timestamp 495153655 0,nop,wscale 7>

2: 08:42:09.363415 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45954: S 3603655982:3603655982(0) ack 2732339017 win 28960 <mss 1460,sackOK,timestamp 505509125 495153655,nop,wscale 7>

3: 08:42:09.363903 802.1Q vlan#202 P0 192.168.240.50.45954 > 192.168.241.50.80: . ack 3603655983 win 229 <nop,nop,timestamp 495153657 505509125>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Étape 2. Puisqu'il s'agit d'un flux TCP, tracez les paquets d'échange en trois étapes. Comme on peut le voir dans cette sortie, unit-1-1 est le propriétaire. Pour des raisons de simplicité, les phases de trace non pertinentes sont omises :

firepower# show cap CAPI packet-number 1 trace

25985 packets captured

1: 08:42:09.362697 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: S 992089269:992089269(0) win 29200 <mss 1460,sackOK,timestamp 495153655 0,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

...

Le trafic de retour (TCP SYN/ACK) :

firepower# show capture CAPO packet-number 2 trace

25985 packets captured

2: 08:42:09.363415 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45954: S 3603655982:3603655982(0) ack 2732339017 win 28960 <mss 1460,sackOK,timestamp 505509125 495153655,nop,wscale 7>

...

Phase: 3

Type: FLOW-LOOKUP

Subtype:

Result: ALLOW

Config:

Additional Information:

Found flow with id 9364, using existing flow

Observation 4. Les syslogs du plan de données FTD affichent la création et la terminaison de la connexion sur toutes les unités :

firepower# cluster exec show log | include 45954

unit-1-1(LOCAL):******************************************************

Dec 01 2020 08:42:09: %FTD-6-302013: Built inbound TCP connection 9364 for INSIDE:192.168.240.50/45954 (192.168.240.50/45954) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 08:42:18: %FTD-6-302014: Teardown TCP connection 9364 for INSIDE:192.168.240.50/45954 to OUTSIDE:192.168.241.50/80 duration 0:00:08 bytes 1024000440 TCP FINs from INSIDE

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Dec 01 2020 08:42:09: %FTD-6-302022: Built backup stub TCP connection for INSIDE:192.168.240.50/45954 (192.168.240.50/45954) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 08:42:18: %FTD-6-302023: Teardown backup TCP connection for INSIDE:192.168.240.50/45954 to OUTSIDE:192.168.241.50/80 duration 0:00:08 forwarded bytes 0 Cluster flow with CLU closed on owner

Étude de cas 2. Trafic symétrique (propriétaire différent du directeur)

- Identique à l'étude de cas #1, mais dans cette étude de cas, le propriétaire d'un flux est une unité différente du directeur.

- Tous les résultats sont similaires à l'étude de cas #1. La principale différence par rapport à l'étude de cas #1 est l'indicateur « Y » qui remplace l'indicateur « y » du scénario 1.

Observation 1. Le propriétaire est différent du directeur.

Analyse des indicateurs de connexion pour le flux avec le port source 46278.

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 2 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46278, idle 0:00:00, bytes 508848268, flags UIO N1

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46276, idle 0:00:03, bytes 0, flags aA N1

unit-2-1:*************************************************************

21 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 5 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 NP Identity Ifc 192.168.240.50:46276, idle 0:00:02, bytes 0, flags z

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46278, idle 0:00:06, bytes 0, flags Y

| Unité |

Drapeau |

Remarque |

| Unité-1-1 |

UIO |

· Flow Owner - L'unité gère le flux |

| Unité-2-1 |

- |

- |

| Unité-3-1 |

O |

· Directeur et propriétaire de la sauvegarde - L'unité 3-1 porte le drapeau Y (Directeur). |

Cela peut être visualisé comme suit :

- Le paquet TCP SYN arrive de l’hôte A à l’unité 1-1. Unit-1-1 devient le propriétaire du flux.

- Unit-3-1 est élu directeur de flux. Unit-3-1 est également le propriétaire de la sauvegarde (message « cluster add » sur UDP 4193 sur la CCL).

- Le paquet TCP SYN/ACK arrive de l’hôte B à l’unité 3-1. Le flux est symétrique.

- Une fois la connexion terminée, le propriétaire envoie sur la CCL un message « cluster delete » sur UDP 4193 pour supprimer les informations de flux du propriétaire de sauvegarde.

Observation 2. La capture avec trace montre que les deux directions passent uniquement par l'unité 1-1

Étape 1. Utilisez la même approche que dans l'étude de cas 1 pour identifier le flux et les paquets d'intérêt dans toutes les unités de cluster en fonction du port source :

firepower# cluster exec show cap CAPI | include 46278

unit-1-1(LOCAL):******************************************************

3: 11:01:44.841631 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: S 1972783998:1972783998(0) win 29200 <mss 1460,sackOK,timestamp 503529072 0,nop,wscale 7>

4: 11:01:44.842317 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3524167695:3524167695(0) ack 1972783999 win 28960 <mss 1380,sackOK,timestamp 513884542 503529072,nop,wscale 7>

5: 11:01:44.842592 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: . ack 3524167696 win 229 <nop,nop,timestamp 503529073 513884542>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

Capture sur l'interface OUTSIDE :

firepower# cluster exec show cap CAPO | include 46278

unit-1-1(LOCAL):******************************************************

3: 11:01:44.841921 802.1Q vlan#202 P0 192.168.240.50.46278 > 192.168.241.50.80: S 2153055699:2153055699(0) win 29200 <mss 1380,sackOK,timestamp 503529072 0,nop,wscale 7>

4: 11:01:44.842226 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3382481337:3382481337(0) ack 2153055700 win 28960 <mss 1460,sackOK,timestamp 513884542 503529072,nop,wscale 7>

5: 11:01:44.842638 802.1Q vlan#202 P0 192.168.240.50.46278 > 192.168.241.50.80: . ack 3382481338 win 229 <nop,nop,timestamp 503529073 513884542>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

Étape 2. Concentrez-vous sur les paquets entrants (TCP SYN et TCP SYN/ACK) :

firepower# cluster exec show cap CAPI packet-number 3 trace

unit-1-1(LOCAL):******************************************************

824 packets captured

3: 11:01:44.841631 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: S 1972783998:1972783998(0) win 29200 <mss 1460,sackOK,timestamp 503529072 0,nop,wscale 7>

…

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

Suivez le SYN/ACK sur l'unité 1-1 :

firepower# cluster exec show cap CAPO packet-number 4 trace

unit-1-1(LOCAL):******************************************************

4: 11:01:44.842226 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3382481337:3382481337(0) ack 2153055700 win 28960 <mss 1460,sackOK,timestamp 513884542 503529072,nop,wscale 7>

Phase: 3

Type: FLOW-LOOKUP

Subtype:

Result: ALLOW

Config:

Additional Information:

Found flow with id 9583, using existing flow

Observation 3. Les syslogs du plan de données FTD affichent la création et la fin de la connexion sur le propriétaire et le propriétaire de sauvegarde :

firepower# cluster exec show log | include 46278

unit-1-1(LOCAL):******************************************************

Dec 01 2020 11:01:44: %FTD-6-302013: Built inbound TCP connection 9583 for INSIDE:192.168.240.50/46278 (192.168.240.50/46278) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 11:01:53: %FTD-6-302014: Teardown TCP connection 9583 for INSIDE:192.168.240.50/46278 to OUTSIDE:192.168.241.50/80 duration 0:00:08 bytes 1024001808 TCP FINs from INSIDE

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Dec 01 2020 11:01:44: %FTD-6-302022: Built director stub TCP connection for INSIDE:192.168.240.50/46278 (192.168.240.50/46278) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 11:01:53: %FTD-6-302023: Teardown director TCP connection for INSIDE:192.168.240.50/46278 to OUTSIDE:192.168.241.50/80 duration 0:00:08 forwarded bytes 0 Cluster flow with CLU closed on owner

Étude de cas 3. Trafic asymétrique (le directeur transfère le trafic).

Observation 1. Les captures réinjecter-masquer affichent les paquets sur l'unité 1-1 et l'unité 2-1 (flux asymétrique) :

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33554320 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99932 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33553268 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Capturing - 53815 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Capturing - 658 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Capturing - 658 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

Observation 2. Analyse des indicateurs de connexion pour le flux avec le port source 46502.

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 2 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46502, idle 0:00:00, bytes 448760236, flags UIO N1

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46500, idle 0:00:06, bytes 0, flags aA N1

unit-2-1:*************************************************************

21 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 1 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46502, idle 0:00:00, bytes 0, flags Y

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 5 most used

dir connections: 0 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

| Unité |

Drapeau |

Remarque |

| Unité-1-1 |

UIO |

· Flow Owner : l'unité gère le flux. |

| Unité-2-1 |

O |

· Directeur - Comme l'unité 2-1 a la mention « Y », cela signifie que l'unité 2-1 a été choisie comme directeur pour ce flux. · Propriétaire de sauvegarde · Enfin, bien que cela ne soit pas évident à partir de ce résultat, les résultats des commandes show capture et show log indiquent clairement que l'unité 2-1 transmet ce flux au propriétaire (bien que techniquement, il ne soit pas considéré comme un transmetteur dans ce scénario). Remarque : une unité ne peut pas être à la fois directeur (flux Y) et redirecteur (flux z). Ces 2 rôles s'excluent mutuellement. Les directeurs (flux Y) peuvent toujours transférer le trafic. Reportez-vous au résultat de la commande show log plus loin dans cette étude de cas. |

| Unité-3-1 |

- |

- |

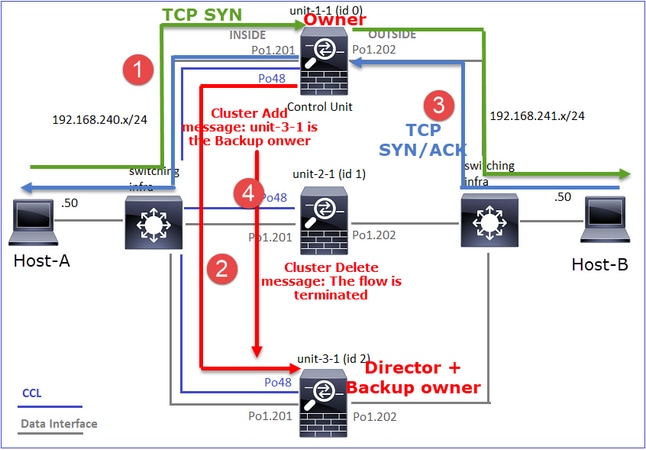

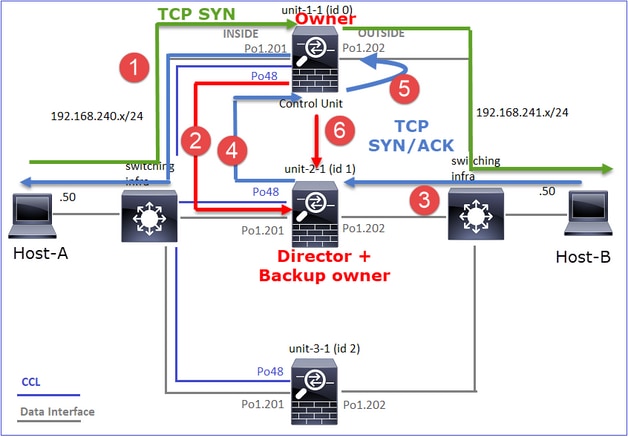

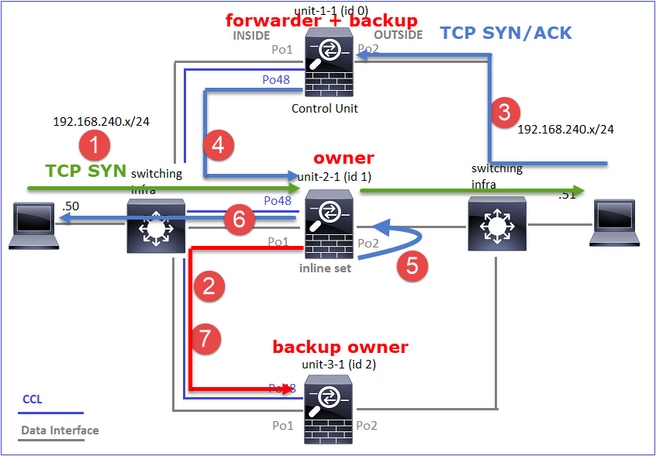

Cela peut être visualisé comme suit :

- Le paquet TCP SYN arrive de l’hôte A à l’unité 1-1. Unit-1-1 devient le propriétaire du flux.

- Unit-2-1 est élu directeur de flux et propriétaire de sauvegarde. Le propriétaire du flux envoie un message de monodiffusion « cluster add » sur UDP 4193 pour informer le propriétaire de sauvegarde du flux.

- Le paquet TCP SYN/ACK arrive de l’hôte B à l’unité 2-1. Le flux est asymétrique.

- Unit-2-1 transfère le paquet via la CCL au propriétaire (en raison du cookie TCP SYN).

- Le propriétaire réinjecte le paquet sur l’interface OUTSIDE, puis le transfère vers l’hôte A.

- Une fois la connexion terminée, le propriétaire envoie un message de suppression de cluster pour supprimer les informations de flux du propriétaire de sauvegarde.

Observation 3. La capture avec trace indique le trafic asymétrique et la redirection de l'unité 2-1 vers l'unité 1-1.

Étape 1. Identifiez les paquets qui appartiennent au flux d’intérêt (port 46502) :

firepower# cluster exec show capture CAPI | include 46502

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356121 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: S 4124514680:4124514680(0) win 29200 <mss 1460,sackOK,timestamp 510537534 0,nop,wscale 7>

4: 12:58:33.357037 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.46502: S 883000451:883000451(0) ack 4124514681 win 28960 <mss 1380,sackOK,timestamp 520893004 510537534,nop,wscale 7>

5: 12:58:33.357357 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: . ack 883000452 win 229 <nop,nop,timestamp 510537536 520893004>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

La direction de retour :

firepower# cluster exec show capture CAPO | include 46502

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356426 802.1Q vlan#202 P0 192.168.240.50.46502 > 192.168.241.50.80: S 1434968587:1434968587(0) win 29200 <mss 1380,sackOK,timestamp 510537534 0,nop,wscale 7>

4: 12:58:33.356915 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

5: 12:58:33.357403 802.1Q vlan#202 P0 192.168.240.50.46502 > 192.168.241.50.80: . ack 4257314723 win 229 <nop,nop,timestamp 510537536 520893004>

unit-2-1:*************************************************************

1: 12:58:33.359249 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

2: 12:58:33.360302 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: . ack 1434968736 win 235 <nop,nop,timestamp 520893005 510537536>

3: 12:58:33.361004 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: . 4257314723:4257316091(1368) ack 1434968736 win 235 <nop,nop,timestamp 520893006 510537536>

…

unit-3-1:*************************************************************

Étape 2. Suivez les paquets. Par défaut, seuls les 50 premiers paquets entrants sont suivis. Pour des raisons de simplicité, les phases de trace non pertinentes sont omises.

Unit-1-1 (propriétaire) :

firepower# cluster exec show capture CAPI packet-number 3 trace

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356121 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: S 4124514680:4124514680(0) win 29200 <mss 1460,sackOK,timestamp 510537534 0,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

Unité-2-1 (redirecteur)

Trafic de retour (TCP SYN/ACK). L'unité d'intérêt est l'unité 2-1 qui est le directeur/propriétaire de sauvegarde et transmet le trafic au propriétaire :

firepower# cluster exec unit unit-2-1 show capture CAPO packet-number 1 trace

1: 12:58:33.359249 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) am early redirecting to (0) due to matching action (-1).

Observation 4. Les syslogs du plan de données FTD affichent la création et la terminaison de la connexion sur toutes les unités :

firepower# cluster exec show log | i 46502

unit-1-1(LOCAL):******************************************************

Dec 01 2020 12:58:33: %FTD-6-302013: Built inbound TCP connection 9742 for INSIDE:192.168.240.50/46502 (192.168.240.50/46502) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 12:59:02: %FTD-6-302014: Teardown TCP connection 9742 for INSIDE:192.168.240.50/46502 to OUTSIDE:192.168.241.50/80 duration 0:00:28 bytes 2048000440 TCP FINs from INSIDE

unit-2-1:*************************************************************

Dec 01 2020 12:58:33: %FTD-6-302022: Built forwarder stub TCP connection for OUTSIDE:192.168.241.50/80 (192.168.241.50/80) to unknown:192.168.240.50/46502 (192.168.240.50/46502)

Dec 01 2020 12:58:33: %FTD-6-302023: Teardown forwarder TCP connection for OUTSIDE:192.168.241.50/80 to unknown:192.168.240.50/46502 duration 0:00:00 forwarded bytes 0 Forwarding or redirect flow removed to create director or backup flow

Dec 01 2020 12:58:33: %FTD-6-302022: Built director stub TCP connection for INSIDE:192.168.240.50/46502 (192.168.240.50/46502) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)