Remplacement du serveur UCS 240M4 OSPD - vEPC

Options de téléchargement

-

ePub (947.8 KB)

Consulter à l’aide de différentes applications sur iPhone, iPad, Android ou Windows Phone -

Mobi (Kindle) (555.6 KB)

Consulter sur un appareil Kindle ou à l’aide d’une application Kindle sur plusieurs appareils

Langage exempt de préjugés

Dans le cadre de la documentation associée à ce produit, nous nous efforçons d’utiliser un langage exempt de préjugés. Dans cet ensemble de documents, le langage exempt de discrimination renvoie à une langue qui exclut la discrimination en fonction de l’âge, des handicaps, du genre, de l’appartenance raciale de l’identité ethnique, de l’orientation sexuelle, de la situation socio-économique et de l’intersectionnalité. Des exceptions peuvent s’appliquer dans les documents si le langage est codé en dur dans les interfaces utilisateurs du produit logiciel, si le langage utilisé est basé sur la documentation RFP ou si le langage utilisé provient d’un produit tiers référencé. Découvrez comment Cisco utilise le langage inclusif.

À propos de cette traduction

Cisco a traduit ce document en traduction automatisée vérifiée par une personne dans le cadre d’un service mondial permettant à nos utilisateurs d’obtenir le contenu d’assistance dans leur propre langue. Il convient cependant de noter que même la meilleure traduction automatisée ne sera pas aussi précise que celle fournie par un traducteur professionnel.

Contenu

Introduction

Ce document décrit l'étape nécessaire afin de remplacer un serveur défectueux qui héberge le directeur de plate-forme d'OpenStack (OSPD) dans une installation d'Ultra-M.

Informations générales

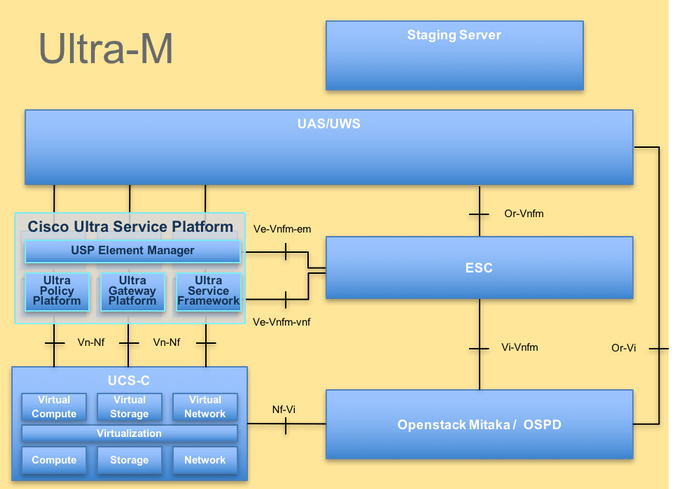

Ultra-M est une solution mobile virtualisée préemballée et validée de noyau de paquet qui est conçue afin de simplifier le déploiement de VNFs. OpenStack est le gestionnaire virtualisé d'infrastructure (SCORE) pour Ultra-M et se compose de ces types de noeud :

- Calcul

- Disque de mémoire d'objet - Calcul (OSD - Calcul)

- Contrôleur

- OSPD

L'architecture de haut niveau d'Ultra-M et les composants impliqués sont dépeints dans cette image :

Architecture d'UltraM

Architecture d'UltraM

Ce document est destiné pour le personnel de Cisco qui sont au courant de la plate-forme de Cisco Ultra-M et elle détaille les étapes qui sont exigées afin de pour être effectuées au niveau d'OpenStack au moment du remplacement de serveur OSPD.

Remarque: Ultra la release M 5.1.x est considérée comme afin de définire les procédures dans ce document.

Abréviations

| VNF | Fonction réseau virtuelle |

| CF | Fonction de contrôle |

| SF | Fonction de service |

| ESC | Contrôleur élastique de service |

| BALAI | Méthode de procédure |

| OSD | Disques de mémoire d'objet |

| HDD | Lecteur de disque dur |

| Disque transistorisé | Lecteur semi-conducteur |

| SCORE | Gestionnaire virtuel d'infrastructure |

| VM | Virtual machine |

| EM | Gestionnaire d'éléments |

| UAS | Services d’automatisation ultra |

| UUID | Universellement identifiant unique |

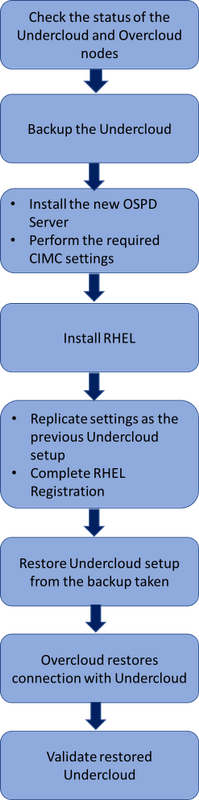

Processus du balai

Processus de haut niveau de la procédure de remplacement

Processus de haut niveau de la procédure de remplacement

Conditions préalables

Contrôle d'état

Avant que vous remplaciez un serveur OSPD, il est important de vérifier l'état actuel de l'environnement de plate-forme d'OpenStack de Red Hat et de s'assurer qu'il est sain afin d'éviter des complications quand le processus de remplacement est allumé.

Vérifiez le statut de pile d'OpenStack et de la liste de noeud :

[stack@director ~]$ source stackrc

[stack@director ~]$ openstack stack list --nested

[stack@director ~]$ ironic node-list

[stack@director ~]$ nova list

Assurez-vous si tous les services d'undercloud sont dans chargé, état actif et courant du noeud OSP-D :

[stack@director ~]$ systemctl list-units "openstack*" "neutron*" "openvswitch*"

UNIT LOAD ACTIVE SUB DESCRIPTION

neutron-dhcp-agent.service loaded active running OpenStack Neutron DHCP Agent

neutron-openvswitch-agent.service loaded active running OpenStack Neutron Open vSwitch Agent

neutron-ovs-cleanup.service loaded active exited OpenStack Neutron Open vSwitch Cleanup Utility

neutron-server.service loaded active running OpenStack Neutron Server

openstack-aodh-evaluator.service loaded active running OpenStack Alarm evaluator service

openstack-aodh-listener.service loaded active running OpenStack Alarm listener service

openstack-aodh-notifier.service loaded active running OpenStack Alarm notifier service

openstack-ceilometer-central.service loaded active running OpenStack ceilometer central agent

openstack-ceilometer-collector.service loaded active running OpenStack ceilometer collection service

openstack-ceilometer-notification.service loaded active running OpenStack ceilometer notification agent

openstack-glance-api.service loaded active running OpenStack Image Service (code-named Glance) API server

openstack-glance-registry.service loaded active running OpenStack Image Service (code-named Glance) Registry server

openstack-heat-api-cfn.service loaded active running Openstack Heat CFN-compatible API Service

openstack-heat-api.service loaded active running OpenStack Heat API Service

openstack-heat-engine.service loaded active running Openstack Heat Engine Service

openstack-ironic-api.service loaded active running OpenStack Ironic API service

openstack-ironic-conductor.service loaded active running OpenStack Ironic Conductor service

openstack-ironic-inspector-dnsmasq.service loaded active running PXE boot dnsmasq service for Ironic Inspector

openstack-ironic-inspector.service loaded active running Hardware introspection service for OpenStack Ironic

openstack-mistral-api.service loaded active running Mistral API Server

openstack-mistral-engine.service loaded active running Mistral Engine Server

openstack-mistral-executor.service loaded active running Mistral Executor Server

openstack-nova-api.service loaded active running OpenStack Nova API Server

openstack-nova-cert.service loaded active running OpenStack Nova Cert Server

openstack-nova-compute.service loaded active running OpenStack Nova Compute Server

openstack-nova-conductor.service loaded active running OpenStack Nova Conductor Server

openstack-nova-scheduler.service loaded active running OpenStack Nova Scheduler Server

openstack-swift-account-reaper.service loaded active running OpenStack Object Storage (swift) - Account Reaper

openstack-swift-account.service loaded active running OpenStack Object Storage (swift) - Account Server

openstack-swift-container-updater.service loaded active running OpenStack Object Storage (swift) - Container Updater

openstack-swift-container.service loaded active running OpenStack Object Storage (swift) - Container Server

openstack-swift-object-updater.service loaded active running OpenStack Object Storage (swift) - Object Updater

openstack-swift-object.service loaded active running OpenStack Object Storage (swift) - Object Server

openstack-swift-proxy.service loaded active running OpenStack Object Storage (swift) - Proxy Server

openstack-zaqar.service loaded active running OpenStack Message Queuing Service (code-named Zaqar) Server

openstack-zaqar@1.service loaded active running OpenStack Message Queuing Service (code-named Zaqar) Server Instance 1

openvswitch.service loaded active exited Open vSwitch

LOAD = Reflects whether the unit definition was properly loaded.

ACTIVE = The high-level unit activation state, i.e. generalization of SUB.

SUB = The low-level unit activation state, values depend on unit type.

37 loaded units listed. Pass --all to see loaded but inactive units, too.

To show all installed unit files use 'systemctl list-unit-files'.

Sauvegarde

Assurez-vous que vous avez le suffisamment d'espace disque disponible avant que vous exécutiez l'opération de sauvegarde. On s'attend à ce que ce tarball soit au moins 3.5 Go.

[stack@director ~]$df -h

Exécutez cette commande comme sauvegarde d'utilisateur de base les données du noeud d'undercloud à un fichier nommé undercloud-sauvegarde [horodateur] .tar.gz.

[root@director ~]# mysqldump --opt --all-databases > /root/undercloud-all-databases.sql

[root@director ~]# tar --xattrs -czf undercloud-backup-`date +%F`.tar.gz /root/undercloud-all-databases.sql

/etc/my.cnf.d/server.cnf /var/lib/glance/images /srv/node /home/stack

tar: Removing leading `/' from member names

Installez le nouveau noeud OSPD

Installation de serveur UCS

Les étapes afin d'installer un nouveau serveur UCS C240 M4 aussi bien que les étapes de première installation peuvent être référées de l'installation de serveur du Cisco UCS C240 M4 et du guide de service.

Ouvrez une session au serveur avec l'utilisation de l'IP CIMC.

Exécutez la mise à jour du BIOS si le micrologiciel n'est pas selon la version recommandée utilisée précédemment. Des étapes pour la mise à jour du BIOS sont indiquées ici : Guide de mise à jour du BIOS de Serveur rack Cisco UCS série C.

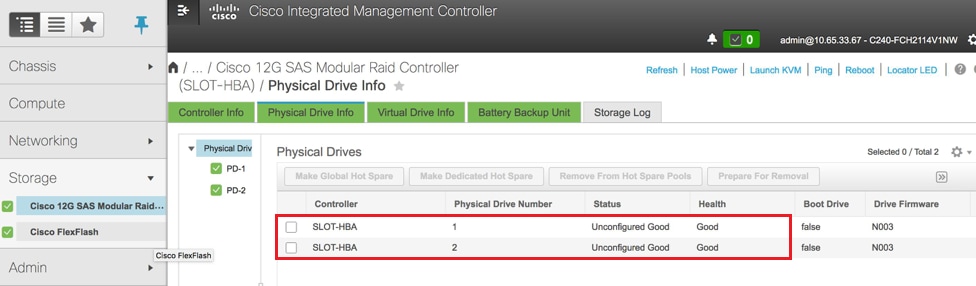

Vérifiez le statut de lecteurs physiques. Ce doit être bon Unconfigured :

Naviguez vers la mémoire > le contrôleur modulaire d'incursion de Cisco 12G SAS (SLOT-HBA) > les informations physiques d'entraînement comme affiché ici dans l'image.

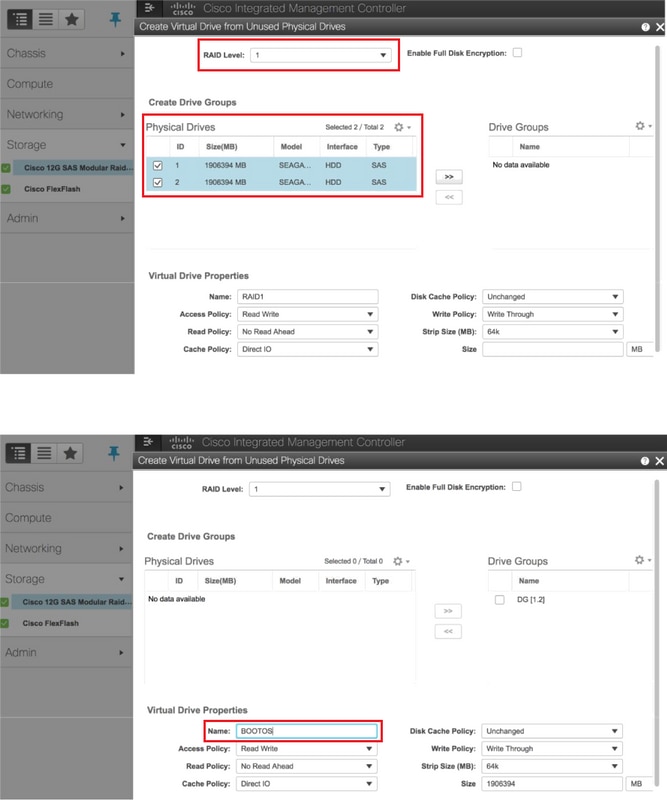

Créez une unité de disques virtuelle des lecteurs physiques avec le niveau 1 RAID :

Naviguez vers la mémoire > le contrôleur modulaire d'incursion de Cisco 12G SAS (SLOT-HBA) > les informations de contrôleur > créent l'unité de disques virtuelle des lecteurs physiques inutilisés suivant les indications de l'image.

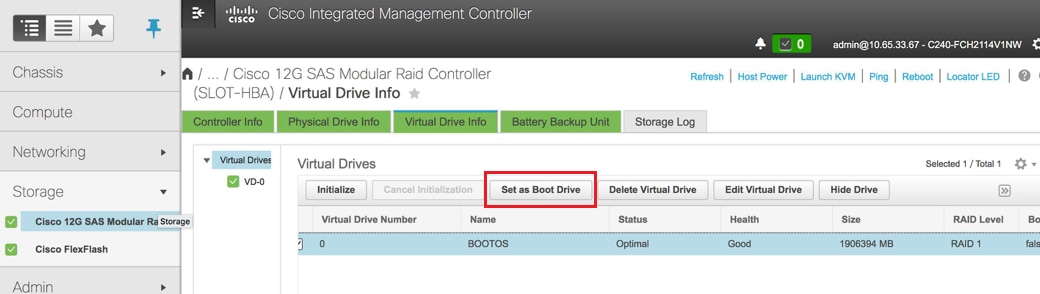

Sélectionnez le VD et configurez le positionnement comme lecteur de démarrage suivant les indications de l'image.

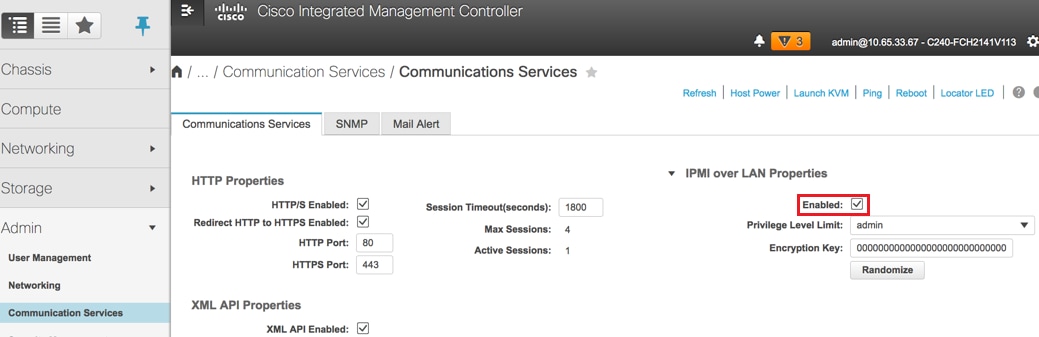

Enable IPMI au-dessus de RÉSEAU LOCAL :

Naviguez vers l'admin > les services de communication > les services de communication suivant les indications de l'image.

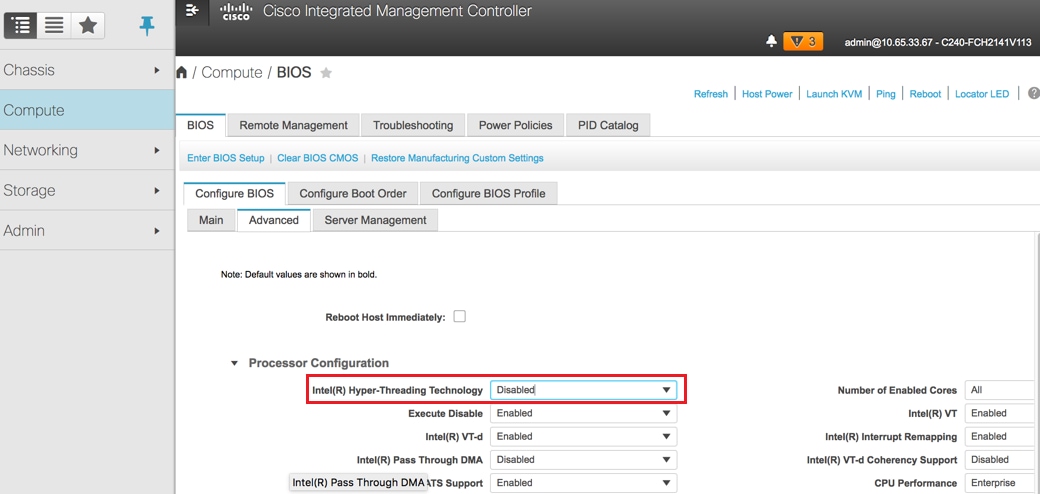

Débronchement hyperthreading :

Naviguez pour calculer > BIOS > configurent BIOS > a avancé > configuration de processeur suivant les indications de l'image.

Remarque: L'image affichée ici et les étapes de configuration mentionnées dans cette section sont concernant la version 3.0(3e) de micrologiciels et il pourrait y avoir de légères variations si vous travaillez sur d'autres versions.

Installation de Red Hat

Montez l'image ISO de Red Hat

1. Procédure de connexion au serveur OSP-D.

2. Console du lancement KVM.

3. Naviguez vers des medias virtuels > lancent des périphériques virtuels. Recevez la session et l'enable se souvenant votre configuration pour de futures connexions.

4. Sélectionnez la carte virtuelle de medias > de carte CD/DVDand l'image ISO de Red Hat.

5. Sélectionnez l'alimentation > système remis à l'état initial (démarrage chaud) pour redémarrer le système.

6. Lors de la reprise, la presse F6and Cisco que choisi vDVD1.22and vKVM-tracé appuient sur entrent.

Installez Red Hat Enterprise Linux

Remarque: La procédure dans cette section représente une version simplifiée du processus d'installation qui identifie le nombre minimal de paramètres qui doivent être configurés.

1. Sélectionnez l'option d'installer Red Hat Enterprise Linux (RHEL) afin de commencer l'installation.

2. La sélection > le minimum de logiciel choisi installent seulement.

3. Interfaces de configure network (eno1 et eno2).

4. Cliquez sur en fonction le réseau et l'adresse Internet.

- Sélectionnez l'interface qui serait utilisée pour la transmission externe (eno1 ou eno2)

- Cliquez sur Configure

- Sélectionnez l'ipv4 Settingstab, sélectionnez la méthode manuelle et cliquez sur en fonction Add

- Placez ces paramètres comme utilisé précédemment : Adresse, netmask, passerelle, serveur DNS

5. La date et l'heure choisies et spécifient votre région et ville.

6. Activez le temps de réseau et configurez les serveurs de NTP.

7. Destination d'installation et choisis de système de fichiers de l'utilisation ext4.

Remarque: Supprimez /home/ et réappropriez la capacité sous la racine/.

8. Débronchement Kdump.

9. Placez le mot de passe root seulement.

10. Commencez le

d'installation.

Restaurez l'Undercloud

Préparez l'installation d'undercloud basée sur la sauvegarde

Une fois l'ordinateur installé avec RHEL 7.3 et est dans un état propre, réactive tous les abonnements/référentiel requis pour installer et exécuter le directeur.

Configuration d'adresse Internet :

[root@director ~]$sudo hostnamectl set-hostname <FQDN_hostname>

[root@director ~]$sudo hostnamectl set-hostname --transient <FQDN_hostname>

Éditez le fichier de /etc/hosts :

[root@director ~]$ vi /etc/hosts

<ospd_external_address> <server_hostname> <FQDN_hostname>

10.225.247.142 pod1-ospd pod1-ospd.cisco.com

Validez l'adresse Internet :

[root@director ~]$ cat /etc/hostname

pod1-ospd.cisco.com

Validez la configuration DNS :

[root@director ~]$ cat /etc/resolv.conf

#Generated by NetworkManager

nameserver <DNS_IP>

Modifiez l'interface NIC de ravitaillement :

[root@director ~]$ cat /etc/sysconfig/network-scripts/ifcfg-eno1

DEVICE=eno1

ONBOOT=yes

HOTPLUG=no

NM_CONTROLLED=no

PEERDNS=no

DEVICETYPE=ovs

TYPE=OVSPort

OVS_BRIDGE=br-ctlplane

BOOTPROTO=none

MTU=1500

Terminez-vous l'enregistrement de Red Hat

Téléchargez ce module afin de configurer l'abonnement-gestionnaire afin d'utiliser le Rhésus-satellite :

[root@director ~]$ rpm -Uvh http://<satellite-server>/pub/katello-ca-consumer-latest.noarch.rpm

[root@director ~]$ subscription-manager config

Inscrivez-vous au Rhésus-satellite avec l'utilisation de cet activationkey pour RHEL 7.3.

[root@director ~]$subscription-manager register --org="<ORG>" --activationkey="<KEY>"

Afin de voir l'abonnement :

[root@director ~]$ subscription-manager list –consumed

Activez les référentiel semblables au vieux repos OSPD :

[root@director ~]$ sudo subscription-manager repos --disable=*

[root@director ~]$ subscription-manager repos --enable=rhel-7-server-rpms --enable=rhel-7-server-extras-rpms --enable=rh

el-7-server-openstack-10-rpms --enable=rhel-7-server-rh-common-rpms --enable=rhel-ha-for-rhel-7-server-rpm

Exécutez une mise à jour sur votre système afin de s'assurer que vous avez les derniers systèmes matériel/logiciel de base et redémarrer le système :

[root@director ~]$sudo yum update -y

[root@director ~]$sudo reboot

Restauration d'Undercloud

Après que vous activiez l'abonnement, importez le `sauvegardé .tar.gz de l'undercloud-sauvegarde-date +%F de fichier tar d'undercloud au nouveau répertoire racine du serveur /root OSP-D.

Installez le serveur de mariadb :

[root@director ~]$ yum install -y mariadb-server

Extrayez le fichier de configuration de MariaDB et la sauvegarde de base de données (DB). Exécutez cette exécution comme utilisateur de base.

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz etc/my.cnf.d/server.cnf

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz root/undercloud-all-databases.sql

Éditez /etc/my.cnf.d/server.cnf et commentez l'entrée de grippage-adresse si présent :

[root@tb3-ospd ~]# vi /etc/my.cnf.d/server.cnf

Commencez le service de MariaDB et mettez à jour temporairement la configuration de max_allowed_packet :

[root@director ~]$ systemctl start mariadb

[root@director ~]$ mysql -uroot -e"set global max_allowed_packet = 16777216;"

Nettoyez certaines autorisations (être recréé plus tard) :

[root@director ~]$ for i in ceilometer glance heat ironic keystone neutron nova;do mysql -e "drop user $i";done

[root@director ~]$ mysql -e 'flush privileges'

Remarque: Si le service de télémètre de plafond a été précédemment désactivé dans l'installation, exécutez cette commande et retirez le télémètre de plafond.

Créez le compte de stackuser :

[root@director ~]$ sudo useradd stack

[root@director ~]$ sudo passwd stack << specify a password

[root@director ~]$ echo "stack ALL=(root) NOPASSWD:ALL" | sudo tee -a /etc/sudoers.d/stack

[root@director ~]$ sudo chmod 0440 /etc/sudoers.d/stack

Restaurez le répertoire home d'utilisateur de pile :

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz home/stack

Installez les modules de base rapides et de regard, et puis restaurez leurs données :

[root@director ~]$ yum install -y openstack-glance openstack-swift

[root@director ~]$ tar --xattrs -xzC / -f undercloud-backup-$DATE.tar.gz srv/node var/lib/glance/images

Confirmez que les données sont possédées par l'utilisateur correct :

[root@director ~]$ chown -R swift: /srv/node

[root@director ~]$ chown -R glance: /var/lib/glance/images

Restaurez les Certificats SSL d'undercloud (facultatifs - être fait seulement si l'installation utilise des Certificats SSL).

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz etc/pki/instack-certs/undercloud.pem

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz etc/pki/ca-trust/source/anchors/ca.crt.pem

Réexécutez l'installation d'undercloud comme stackuser et l'assurez pour l'exécuter dans le répertoire home d'utilisateur de pile :

[root@director ~]$ su - stack

[stack@director ~]$ sudo yum install -y python-tripleoclient

Confirmez que l'adresse Internet est correctement placée dans /etc/hosts.

Réinstallez l'undercloud :

[stack@director ~]$ openstack undercloud install

<snip>

#############################################################################

Undercloud install complete.

The file containing this installation's passwords is at

/home/stack/undercloud-passwords.conf.

There is also a stackrc file at /home/stack/stackrc.

These files are needed to interact with the OpenStack services, and must be

secured.

#############################################################################

Rebranchez l'Undercloud restauré au couvrir

Après que vous vous terminiez ces étapes, l'undercloud peut être prévu pour restaurer automatiquement sa connexion au couvrir. Les Noeuds continueront à voter l'orchestration (la chaleur) pour des tâches en suspens, avec l'utilisation d'une demande de HTTP simple qui est émise toutes les quelques secondes.

Validez la restauration terminée

Employez ces commandes afin d'exécuter une vérification de l'intégrité de l'environnement nouvellement restauré :

[root@director ~]$ su - stack

Last Log in: Tue Nov 28 21:27:50 EST 2017 from 10.86.255.201 on pts/0

[stack@director ~]$ source stackrc

[stack@director ~]$ nova list

+--------------------------------------+--------------------+--------+------------+-------------+------------------------+

| ID | Name | Status | Task State | Power State | Networks |

+--------------------------------------+--------------------+--------+------------+-------------+------------------------+

| b1f5294a-629e-454c-b8a7-d15e21805496 | pod1-compute-0 | ACTIVE | - | Running | ctlplane=192.200.0.119 |

| 9106672e-ac68-423e-89c5-e42f91fefda1 | pod1-compute-1 | ACTIVE | - | Running | ctlplane=192.200.0.120 |

| b3ed4a8f-72d2-4474-91a1-b6b70dd99428 | pod1-compute-2 | ACTIVE | - | Running | ctlplane=192.200.0.124 |

| 677524e4-7211-4571-ac35-004dc5655789 | pod1-compute-3 | ACTIVE | - | Running | ctlplane=192.200.0.107 |

| 55ea7fe5-d797-473c-83b1-d897b76a7520 | pod1-compute-4 | ACTIVE | - | Running | ctlplane=192.200.0.122 |

| c34c1088-d79b-42b6-9306-793a89ae4160 | pod1-compute-5 | ACTIVE | - | Running | ctlplane=192.200.0.108 |

| 4ba28d8c-fb0e-4d7f-8124-77d56199c9b2 | pod1-compute-6 | ACTIVE | - | Running | ctlplane=192.200.0.105 |

| d32f7361-7e73-49b1-a440-fa4db2ac21b1 | pod1-compute-7 | ACTIVE | - | Running | ctlplane=192.200.0.106 |

| 47c6a101-0900-4009-8126-01aaed784ed1 | pod1-compute-8 | ACTIVE | - | Running | ctlplane=192.200.0.121 |

| 1a638081-d407-4240-b9e5-16b47e2ff6a2 | pod1-compute-9 | ACTIVE | - | Running | ctlplane=192.200.0.112 |

<snip>

[stack@director ~]$ ssh heat-admin@192.200.0.107

[heat-admin@pod1-controller-0 ~]$ sudo pcs status

Cluster name: tripleo_cluster

Stack: corosync

Current DC: pod1-controller-0 (version 1.1.15-11.el7_3.4-e174ec8) - partition with quorum

3 nodes and 22 resources configured

Online: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

Full list of resources:

ip-10.1.10.10 (ocf::heartbeat:IPaddr2): Started pod1-controller-0

ip-11.120.0.97 (ocf::heartbeat:IPaddr2): Started pod1-controller-1

Clone Set: haproxy-clone [haproxy]

Started: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

Master/Slave Set: galera-master [galera]

Masters: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

ip-192.200.0.106 (ocf::heartbeat:IPaddr2): Started pod1-controller-0

ip-11.120.0.95 (ocf::heartbeat:IPaddr2): Started pod1-controller-1

ip-11.119.0.98 (ocf::heartbeat:IPaddr2): Started pod1-controller-0

ip-11.118.0.92 (ocf::heartbeat:IPaddr2): Started pod1-controller-1

Clone Set: rabbitmq-clone [rabbitmq]

Started: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

Master/Slave Set: redis-master [redis]

Masters: [ pod1-controller-0 ]

Slaves: [ pod1-controller-1 pod1-controller-2 ]

openstack-cinder-volume (systemd:openstack-cinder-volume): Started pod1-controller-0

my-ipmilan-for-controller-0 (stonith:fence_ipmilan): Stopped

my-ipmilan-for-controller-1 (stonith:fence_ipmilan): Stopped

my-ipmilan-for-controller-2 (stonith:fence_ipmilan): Stopped

Failed Actions:

* my-ipmilan-for-controller-0_start_0 on pod1-controller-1 'unknown error' (1): call=190, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:45 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-1_start_0 on pod1-controller-1 'unknown error' (1): call=192, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:53:08 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-2_start_0 on pod1-controller-1 'unknown error' (1): call=188, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:23 2017', queued=0ms, exec=20004ms

* my-ipmilan-for-controller-0_start_0 on pod1-controller-0 'unknown error' (1): call=210, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:53:08 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-1_start_0 on pod1-controller-0 'unknown error' (1): call=207, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:45 2017', queued=0ms, exec=20004ms

* my-ipmilan-for-controller-2_start_0 on pod1-controller-0 'unknown error' (1): call=206, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:45 2017', queued=0ms, exec=20006ms

* ip-192.200.0.106_monitor_10000 on pod1-controller-0 'not running' (7): call=197, status=complete, exitreason='none',

last-rc-change='Wed Nov 22 13:51:31 2017', queued=0ms, exec=0ms

* my-ipmilan-for-controller-0_start_0 on pod1-controller-2 'unknown error' (1): call=183, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:23 2017', queued=1ms, exec=20006ms

* my-ipmilan-for-controller-1_start_0 on pod1-controller-2 'unknown error' (1): call=184, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:23 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-2_start_0 on pod1-controller-2 'unknown error' (1): call=177, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:02 2017', queued=0ms, exec=20005ms

Daemon Status:

corosync: active/enabled

pacemaker: active/enabled

pcsd: active/enabled

[heat-admin@pod1-controller-0 ~]$ sudo ceph status

cluster eb2bb192-b1c9-11e6-9205-525400330666

health HEALTH_OK

monmap e1: 3 mons at {pod1-controller-0=11.118.0.40:6789/0,pod1-controller-1=11.118.0.41:6789/0,pod1-controller-2=11.118.0.42:6789/0}

election epoch 58, quorum 0,1,2 pod1-controller-0,pod1-controller-1,pod1-controller-2

osdmap e1398: 12 osds: 12 up, 12 in

flags sortbitwise,require_jewel_osds

pgmap v1245812: 704 pgs, 6 pools, 542 GB data, 352 kobjects

1625 GB used, 11767 GB / 13393 GB avail

704 active+clean

client io 21549 kB/s wr, 0 op/s rd, 120 op/s wr

Exécution de gestion d'identité de contrôle (clef de voûte)

Cette étape valide des exécutions de gestion d'identité par la question pour une liste d'utilisateurs.

[stack@director ~]$ source stackrc

[stack@director ~]$ openstack user list

+----------------------------------+------------------+

| ID | Name |

+----------------------------------+------------------+

| 69ac2b9d89414314b1366590c7336f7d | admin |

| f5c30774fe8f49d0a0d89d5808a4b2cc | glance |

| 3958d852f85749f98cca75f26f43d588 | heat |

| cce8f2b7f1a843a08d0bb295a739bd34 | ironic |

| ce7c642f5b5741b48a84f54d3676b7ee | ironic-inspector |

| a69cd42a5b004ec5bee7b7a0c0612616 | mistral |

| 5355eb161d75464d8476fa0a4198916d | neutron |

| 7cee211da9b947ef9648e8fe979b4396 | nova |

| f73d36563a4a4db482acf7afc7303a32 | swift |

| d15c12621cbc41a8a4b6b67fa4245d03 | zaqar |

| 3f0ed37f95544134a15536b5ca50a3df | zaqar-websocket |

+----------------------------------+------------------+

[stack@director ~]$

[stack@director ~]$ source <overcloudrc>

[stack@director ~]$ openstack user list

+----------------------------------+------------+

| ID | Name |

+----------------------------------+------------+

| b4e7954942184e2199cd067dccdd0943 | admin |

| 181878efb6044116a1768df350d95886 | neutron |

| 6e443967ee3f4943895c809dc998b482 | heat |

| c1407de17f5446de821168789ab57449 | nova |

| c9f64c5a2b6e4d4a9ff6b82adef43992 | glance |

| 800e6b1163b74cc2a5fab4afb382f37d | cinder |

| 4cfa5a2a44c44c678025842f080e5f53 | heat-cfn |

| 9b222eeb8a58459bb3bfc76b8fff0f9f | swift |

| 815f3f25bcda49c290e1b56cd7981d1b | core |

| 07c40ade64f34a64932129175150fa4a | gnocchi |

| 0ceeda0bc32c4d46890e53adef9a193d | aodh |

| f3caab060171468592eab376a94967b8 | ceilometer |

+----------------------------------+------------+

[stack@director ~]$

Images de téléchargement pour la future introspection de noeud

Validez /httpboot et tous ces fichiers inspector.ipxe, agent.kernel, agent.ramdisk, sinon poursuivez à ces étapes.

[stack@director ~]$ ls /httpboot

inspector.ipxe

[stack@director ~]$ source stackrc

[stack@director ~]$ cd images/

[stack@director images]$ openstack overcloud image upload --image-path /home/stack/images

Image "overcloud-full-vmlinuz" is up-to-date, skipping.

Image "overcloud-full-initrd" is up-to-date, skipping.

Image "overcloud-full" is up-to-date, skipping.

Image "bm-deploy-kernel" is up-to-date, skipping.

Image "bm-deploy-ramdisk" is up-to-date, skipping.

[stack@director images]$ ls /httpboot

agent.kernel agent.ramdisk inspector.ipxe

[stack@director images]$

Clôture de reprise

La clôture sera dans l'état arrêté après reprise OSPD. Cette procédure activera la clôture.

[heat-admin@pod1-controller-0 ~]$ sudo pcs property set stonith-enabled=true

[heat-admin@pod1-controller-0 ~]$ sudo pcs status

[heat-admin@pod1-controller-0 ~]$sudo pcs stonith show

Informations connexes

Contribution d’experts de Cisco

- Padmaraj RamanoudjamServices avancés de Cisco

- Partheeban RajagopalServices avancés de Cisco

Contacter Cisco

- Ouvrir un dossier d’assistance

- (Un contrat de service de Cisco est requis)

Commentaires

Commentaires