Esempio di configurazione di Nexus 5500 VM-FEX

Sommario

Introduzione

In questo documento viene descritto come configurare, utilizzare e risolvere i problemi relativi alla funzionalità Virtual Machine Fabric Extender (VM-FEX) sugli switch Cisco Nexus 5500.

Prerequisiti

Requisiti

Cisco raccomanda la conoscenza di base di questi argomenti.

- VPC (Virtual Port Channel) Nexus

- VMware vSphere

Componenti usati

Le informazioni di questo documento si basano sulle seguenti versioni hardware e software:

- Nexus 5548UP con versione 5.2(1)N1(4)

- Server rack UCS C210 M2 con UCS P81E Virtual Interface Card con firmware versione 1.4(2)

- vSphere versione 5.0 (ESXi e vCenter)

Le informazioni discusse in questo documento fanno riferimento a dispositivi usati in uno specifico ambiente di emulazione. Su tutti i dispositivi menzionati nel documento la configurazione è stata ripristinata ai valori predefiniti. Se la rete è operativa, valutare attentamente eventuali conseguenze derivanti dall'uso dei comandi o dalla configurazione dell'acquisizione dei pacchetti.

VM-FEX

VM-FEX combina reti virtuali e fisiche in un'unica infrastruttura. Consente di effettuare il provisioning, configurare e gestire il traffico di rete delle macchine virtuali e il traffico di rete bare metal all'interno di un'infrastruttura unificata.

Il software VM-FEX estende la tecnologia Cisco Fabric Extender al sistema virtuale con le seguenti funzionalità:

- Ogni macchina virtuale include un'interfaccia dedicata sullo switch padre.

- Tutto il traffico della macchina virtuale viene inviato direttamente all'interfaccia dedicata sullo switch.

- Lo switch vSwitch standard nell'hypervisor viene eliminato.

VM-FEX è un tipo di switch virtuale distribuito (DVS o VDS). Il DVS presenta un'astrazione di un singolo switch su più server ESX che fanno parte dello stesso contenitore del centro dati in vCenter. La configurazione del Virtual Machine (VM) Virtual Network Interface Controller (VNIC) viene gestita da una postazione centralizzata (Nexus 5000 o UCS in VM-FEX; in questo documento viene illustrata la VM-FEX basata su Nexus 5000).

VM-FEX può funzionare in due modalità:

- Pass-through: Si tratta della modalità predefinita, in cui VEM è coinvolto nel percorso dati per il traffico VM.

- Prestazioni elevate: Il traffico della VM non viene gestito da VEM ma viene passato direttamente alla scheda di virtualizzazione IO di rete (NIV).

Per utilizzare la modalità ad alte prestazioni, è necessario che sia richiesta dalla configurazione del profilo della porta e che sia supportata dal sistema operativo VM e dalla relativa scheda virtuale. Ulteriori informazioni al riguardo sono disponibili più avanti in questo documento.

Definizioni

- Virtual Ethernet Module (VEM). Modulo software Cisco che viene eseguito all'interno dell'hypervisor ESX e fornisce l'implementazione VNLink in un unico pacchetto

- Network IO Virtualization (NIV) utilizza VNtagging per installare diversi collegamenti di rete virtuali (VN-Link) sullo stesso canale Ethernet fisico

- DCBX (Datacenter Bridging Capability Exchange)

- Controllo interfaccia VNIC (VIC)

- VNIC (Virtual NIC), che indica un endpoint host. Può essere associato a un VIF attivo o a un VIF in standby

- Porta virtuale distribuita (DVPort). VNIC è collegato alla porta DVP in VEM

- Interfaccia virtuale NIV (VIF), indicata in un endpoint di rete

- L'interfaccia Ethernet virtuale (Eth) rappresenta il file VIF sullo switch

- PTS (Pass-Through Switch). Modulo VEM installato nell'hypervisor

Configurazione

La topologia è un server UCS-C con P81E VIC dual-homed per due switch Nexus 5548 VPC.

Esempio di rete

I componenti necessari devono essere già installati:

- Il VPC è configurato e inizializzato correttamente tra i due switch Nexus 5000.

- VMWare vCenter è installato e connesso tramite un client vSphere.

- ESXi viene installato sul server UCS-C e aggiunto a vCenter.

I passaggi della configurazione sono riepilogati di seguito:

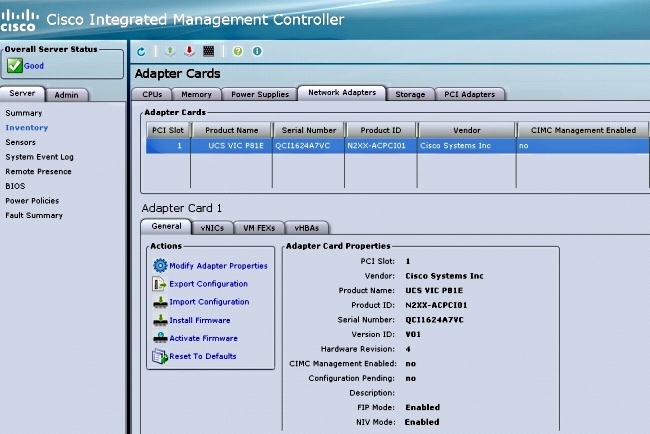

- Attivare la modalità NIV nella scheda di rete del server:

- Connettersi all'interfaccia di Cisco Integrated Management Controller (CIMC) tramite HTTP e accedere con le credenziali di amministratore.

- Scegliere Inventario > Schede di rete > Modifica proprietà scheda.

- Attivare la modalità INV, impostare il numero di interfacce VM FEX e salvare le modifiche.

- Spegnere e accendere il server.

Dopo il riavvio del server, verificare che il VCI sia attivato:

- Connettersi all'interfaccia di Cisco Integrated Management Controller (CIMC) tramite HTTP e accedere con le credenziali di amministratore.

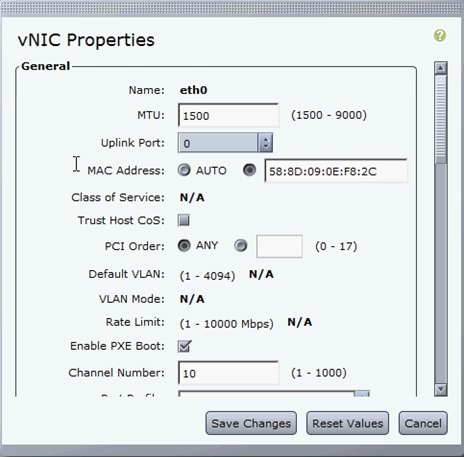

- Creare due vertici statici sul server.

Per creare due VNIC, scegliere Inventario > Schede di rete > VNIC > Aggiungi.

Questi sono i campi più importanti da definire:

- Porta uplink VIC da utilizzare (P81E ha due porte uplink indicate come 0 e 1).

- Numero canale: Questo è un ID di canale univoco della VNIC sulla scheda di rete. A tale scopo, è possibile utilizzare il comando bind dell'interfaccia vEth di Nexus 5000. L'ambito del numero di canale è limitato al collegamento fisico VNTag. Il canale può essere considerato come un "collegamento virtuale" sul collegamento fisico tra lo switch e la scheda di rete del server.

- Profilo porta: È possibile selezionare l'elenco dei profili di porta definiti sul Nexus 5000 a monte. Se Nexus 5000 è configurato con il comando vEthernet auto-create, su Nexus 5000 viene creata automaticamente un'interfaccia Ethernet. Si noti che al server vengono passati solo i nomi dei profili delle porte vEthernet (la configurazione dei profili delle porte non è supportata). Questo si verifica dopo che è stata stabilita la connettività del collegamento VNTag e sono stati eseguiti l'handshake iniziale e i passaggi di negoziazione tra lo switch e l'adattatore server.

- Abilita failover uplink: Le VNIC eseguono il failover sull'altra porta di uplink P81E se la porta di uplink configurata non è in linea.

- Porta uplink VIC da utilizzare (P81E ha due porte uplink indicate come 0 e 1).

- Riavviare il server.

- Installare VEM sull'host ESXi.

Per un esempio di installazione di VEM sull'host ESXi, vedere Installazione o aggiornamento del bundle software VEM Cisco su un host ESX o ESXi in Cisco UCS Manager VM-FEX for VMware GUI Configuration Guide, versione 2.1. - Abilitare le funzionalità di virtualizzazione e VM-FEX e HTTP:

(config)# install feature-set virtualization

(config)# feature-set virtualization

(config)# feature vmfex

(config)# feature http-server

(Optional) Allow the Nexus 5000 to auto-create its Vethernet interfaces when the

corresponding vNICs are defined on the server:

(config)# vethernet auto-create - Abilitare VNTag sulle interfacce host.

Configure the N5k interface that connects to the servers in VNTAG mode:

(config)# interface Eth 1/1

(config-if)# switchport mode vntag

(config-if)# no shutdown - Alzate i vetri statici.

Su entrambi gli switch Nexus 5500, abilitare le interfacce virtuali vEth statiche che devono connettersi alle due VNIC statiche abilitate sul VIC del server.

Sul Nexus 5548-A, immettere:interface vethernet 1

bind interface eth 1/1 channel 10

no shutdown

Sul Nexus 5548-B, immettere:interface vethernet 2

bind interface eth 1/1 channel 11

no shutdown

In alternativa, le interfacce Ethernet possono essere create automaticamente con il comando vethernet auto-create.

Ecco un esempio.

Su ognuno dei due Nexus 5000, configurare:interface Vethernet1

description server_uplink1

bind interface Ethernet101/1/1 channel 11

bind interface Ethernet102/1/1 channel 11

interface Vethernet2

description server_uplink2

bind interface Ethernet101/1/1 channel 12

bind interface Ethernet102/1/1 channel 12 - Configurare la connessione SVS a vCenter e connettersi.

Su entrambi gli switch Nexus 5500, configurare:svs connection <name>

protocol vmware-vim

remote ip address <vCenter-IP> vrf <vrf>

dvs-name <custom>

vmware dvs datacenter-name <VC_DC_name>

Solo sullo switch primario VPC, collegarsi a vCenter:svs connection <name>

connect

Sample configuration on VPC primary:

svs connection MyCon

protocol vmware-vim

remote ip address 10.2.8.131 port 80 vrf management

dvs-name MyVMFEX

vmware dvs datacenter-name MyVC

connect

Di seguito è riportato un esempio di configurazione nel database VPC secondario:svs connection MyCon

protocol vmware-vim

remote ip address 10.2.8.131 port 80 vrf management

dvs-name MyVMFEX

vmware dvs datacenter-name MyVC - Creare profili di porta su Nexus 5000.

Su entrambi gli switch Nexus 5500, configurare i profili delle porte per le VNIC VM-FEX. Questi profili delle porte vengono visualizzati come gruppi di porte dello switch DVS in vCenter.

Di seguito è riportato un esempio:vlan 10,20

port-profile type vethernet VM1

dvs-name all

switchport mode access

switchport access vlan 10

no shutdown

state enabled

port-profile type vethernet VM2

dvs-name all

switchport mode access

switchport access vlan 20

no shutdown

state enabled

Modalità VM ad alte prestazioni

Per implementare la modalità ad alte prestazioni (IO DirectPath) e ignorare l'hypervisor per il traffico VM, configurare il profilo della porta vEthernet con il comando host-net ad alte prestazioni. Nel caso di topologie VPC, il profilo della porta deve essere sempre modificato su entrambi gli switch peer VPC. Ad esempio:port-profile type vethernet VM2

high-performance host-netio

Per rendere operativa la modalità ad alte prestazioni, la VM deve soddisfare i seguenti prerequisiti aggiuntivi:

- La scheda virtuale della macchina virtuale deve essere di tipo vmxnet3 (archiviare vCenter: Fare clic con il pulsante destro del mouse su VM > Modifica impostazioni > Scheda di rete > Tipo scheda nel menu a destra.

- La VM deve disporre di una riserva di memoria completa (in vCenter: Fare clic con il pulsante destro del mouse su VM > Modifica impostazioni > scheda Risorse > Memoria > Spostare il dispositivo di scorrimento all'estrema destra.

- Il sistema operativo in esecuzione sulla macchina virtuale deve supportare questa funzionalità.

Di seguito viene riportata la procedura per verificare la modalità High-Performance (DirectPath IO) quando viene utilizzata.

In Impostazioni hardware VM, il campo I/O di DirectPath nel menu a destra viene visualizzato come attivo quando la modalità VM High-Performance è in uso e come inattivo quando la modalità pass-through VM predefinita è in uso.

- La scheda virtuale della macchina virtuale deve essere di tipo vmxnet3 (archiviare vCenter: Fare clic con il pulsante destro del mouse su VM > Modifica impostazioni > Scheda di rete > Tipo scheda nel menu a destra.

- Registrare il Nexus 5548 primario VPC in vCenter:

Connettersi tramite HTTP al Nexus 5548 primario del VPC e scaricare il file XML di estensione:

Registrare quindi il plug-in di estensione in vCenter: scegliete Plug-in > Gestisci plug-in > Clic destro > Nuovo plug-in. - Connettersi a vCenter. Vedere il punto 8.

- Verificare che Nexus 5000 sia registrato in vSphere come vDS:

Verificare la creazione di un nuovo DVS in vCenter con il nome definito in dvs-name in svs connection sul Nexus 5000: scegliere Home > Inventario > Reti.

Sullo switch primario Nexus 5000 VPC, verificare che la connessione SVS sia online con questo comando:n5k1# show svs connections

Local Info:

-----------

connection MyCon:

ip address: 10.2.8.131

remote port: 80

vrf: management

protocol: vmware-vim https

certificate: default

datacenter name: MyVC

extension key: Cisco_Nexus_1000V_126705946

dvs name: MyVMFEX

DVS uuid: 89 dd 2c 50 b4 81 57 e4-d1 24 f5 28 df e3 d2 70

config status: Enabled

operational status: Connected

sync status: in progress

version: VMware vCenter Server 5.0.0 build-455964

Peer Info:

----------

connection MyCon:

ip address: 10.2.8.131

remote port: 80

vrf: management

protocol: vmware-vim https

extension key: Cisco_Nexus_1000V_126705946

certificate: default

certificate match: TRUE

datacenter name: MyVC

dvs name: MyVMFEX

DVS uuid: -

config status: Disabled

operational status: Disconnected

n5k1# - Verificare che i gruppi di porte VM siano disponibili in vCenter.

I profili delle porte vEthernet definiti in Nexus 5000 devono essere visualizzati in vCenter come gruppi di porte in DVS nella visualizzazione di rete:

- Migrazione degli host ESXi su DVS.

Da VMphere, scegliere Home > Inventario > Reti, fare clic con il pulsante destro del mouse sul nome del DVS, quindi Aggiungi host per aggiungere gli host ESXi al DVS.

Le interfacce virtuali Adapter-FEX sono gli uplink degli host ESXi. Scegliere il gruppo di porte uplink predefinito (unused_or_quarantine_uplink) per tali porte uplink. - Eseguire il provisioning della macchina virtuale.

Scegliere un gruppo di porte VM-FEX per la scheda di rete di una VM (fare clic con il pulsante destro del mouse su VM > Modifica impostazioni > Scheda di rete > Etichetta di rete nel menu destro). - Provisioning delle VNIC delle VM eseguito.

- La scheda avvia la creazione dell'interfaccia VIC sullo switch.

Quando una scheda di rete VM viene mappata a un gruppo di porte VM-FEX, viene creata dinamicamente un'interfaccia vEthernet su Nexus 5000. L'intervallo di interfacce vEth create dinamicamente inizia a 32769.

Queste interfacce possono essere controllate con i seguenti comandi:# show interface virtual status

# show interface virtual summary

Verifica e risoluzione dei problemi

Per verificare che la configurazione funzioni correttamente e per risolvere eventuali problemi, consultare questa sezione.

- Per verificare che le due VNIC statiche del server UCS-C siano connesse con il collegamento VPN alle interfacce statiche vEth fisse su Nexus 5500, immettere questo comando:

n5k1# show system internal dcbx info interface e1/1

Interface info for if_index: 0x1a001000(Eth1/1)

tx_enabled: TRUE

rx_enabled: TRUE

dcbx_enabled: TRUE

DCX Protocol: CEE

DCX CEE NIV extension: enabled

<output omitted> - In caso di topologie attive/standby su due FEX dual-homed, verificare che l'interfaccia Eth visualizzi la modalità attiva o standby sui due switch Nexus 5000 VPC.

Qui la modalità viene mostrata come sconosciuta:

n5k1# show int virtual status

Interface VIF-index Bound If Chan Vlan Status Mode Vntag

-------------------------------------------------------------------------

Veth1 VIF-16 Eth101/1/1 11 1 Up Active 2

Veth1 None Eth102/1/1 11 0 Init Unknown 0

Veth2 None Eth101/1/1 12 0 Init Unknown 0

Veth2 None Eth102/1/1 12 0 Init Unknown 0

Veth3 VIF-18 Eth101/1/2 11 1 Up Active 2

Veth3 None Eth102/1/2 11 0 Init Unknown 0

Veth4 None Eth101/1/2 12 0 Init Unknown 0

Veth4 VIF-19 Eth102/1/2 12 1 Up Active 3

In caso di modalità sconosciuta, verificare di abilitare la modalità di failover uplink sulla VNIC. Verificare inoltre che il numero di canale specificato in CIMC corrisponda al numero di canale specificato nella configurazione vEthernet.

L'output corretto dovrebbe essere simile al seguente:n5k1# show int virtual status

Interface VIF-index Bound If Chan Vlan Status Mode Vntag

-------------------------------------------------------------------------

Veth1 VIF-27 Eth101/1/1 11 1 Up Active 2

Veth1 VIF-35 Eth102/1/1 11 1 Up Standby 2

Veth2 VIF-36 Eth101/1/1 12 1 Up Standby 3

Veth2 VIF-33 Eth102/1/1 12 1 Up Active 3

Veth3 VIF-30 Eth101/1/2 11 1 Up Active 2

Veth3 VIF-21 Eth102/1/2 11 1 Up Standby 2

Veth4 VIF-24 Eth101/1/2 12 1 Up Standby 3

Veth4 VIF-31 Eth102/1/2 12 1 Up Active 3 - Le due interfacce non vengono visualizzate sullo switch.

Nel menu HTTP CIMC del server UCS-C verificare che:

- Il VCI è attivato sulla scheda di rete.

- Sulla scheda è configurato un numero di interfacce VM-FEX diverso da zero.

- Failover della scheda abilitato sulla VNIC.

- Il server UCS-C è stato riavviato dopo aver eseguito la configurazione precedente.

- Il VCI è attivato sulla scheda di rete.

- Entrambe le interfacce non sono in linea.

Verificare se VIF_CREATE viene visualizzato in questo comando:# show system internal vim info logs interface veth 1

03/28/2014 16:31:47.770137: RCVD VIF CREATE request on If Eth1/32 <<<<<<<

03/28/2014 16:31:53.405004: On Eth1/32 - VIC CREATE sending rsp for msg_id 23889

to completion code SUCCESS

03/28/2014 16:32:35.739252: On Eth1/32 - RCVD VIF ENABLE. VIF-index 698 msg id 23953

VIF_ID: 0, state_valid: n, active

03/28/2014 16:32:35.802019: On Eth1/32 - VIC ENABLE sending rsp for msg_id 23953 to

completion code SUCCESS

03/28/2014 16:32:36.375495: On Eth1/32 - Sent VIC SET, INDEX: 698, msg_id 23051, up,

enabled, active, cos 0VIF_ID: 50 vlan:

1 rate 0xf4240, burst_size 0xf

03/28/2014 16:32:36.379441: On Eth1/32 - RCVD VIC SET resp, INDEX: 698, msg_id 23051,

up, enabled,active, cos 0, completion

code: 100

Se VIF_CREATE non viene visualizzato o lo switch non risponde correttamente, attenersi alla seguente procedura:

- In vCenter, verificare che lo switch DVS sia stato configurato correttamente con due uplink fisici per l'host ESX (fare clic con il pulsante destro del mouse su Switch DVS > Gestisci host > Seleziona adattatori fisici).

- In vCenter, verificare che VMNIC abbia selezionato l'etichetta di rete/il profilo della porta corretto (fare clic con il pulsante destro del mouse su VM > Modifica impostazioni > fare clic su Scheda di rete > Controlla etichetta di rete).

- In vCenter, verificare che lo switch DVS sia stato configurato correttamente con due uplink fisici per l'host ESX (fare clic con il pulsante destro del mouse su Switch DVS > Gestisci host > Seleziona adattatori fisici).

- La connessione SVS a vCenter non è in linea.

Come illustrato al passaggio 12 della sezione precedente, utilizzare questo processo per verificare che Nexus 5000 sia stato collegato a vCenter:

- In vCenter verificare che il DVD sia visualizzato nella visualizzazione di rete.

- Sul Nexus 5000 VPC primario, verificare che l'SVS sia collegato (usare il comando show svs connection).

Se la connessione non viene stabilita, verificare che:

- La configurazione SVS è identica su entrambi i peer VPC.

- VPC viene inizializzato e i ruoli vengono stabiliti correttamente.

- Il certificato XML dello switch primario VPC è installato in vCenter.

- Sullo switch primario VPC la modalità di configurazione "connect" è configurata come "svs connection" (connessione sv).

- Il nome del centro dati corrisponde al nome utilizzato in vCenter.

- Il VRF (Virtual Routing and Forwarding) corretto è configurato nel comando remoto SVS e lo switch ha una connettività IP all'indirizzo IP vCenter.

Se tutte queste condizioni sono soddisfatte ma la connessione SVS non riesce, raccogliere questo output e contattare il Cisco Technical Assistance Center (TAC):show msp port-profile vc sync-status

show msp internal errors

show msp internal event-history msgs

show vms internal errors

show vms internal event-history msgs - In vCenter verificare che il DVD sia visualizzato nella visualizzazione di rete.

- Lo switch Nexus 5500 non è raggiungibile tramite HTTP.

Verificare che la funzionalità http-server sia abilitata:n5k1# show feature | i http

http-server 1 disabled

n5k1# conf t

Enter configuration commands, one per line. End with CNTL/Z.

n5k1(config)# feature http-server

n5k1(config)#

Cronologia delle revisioni

| Revisione | Data di pubblicazione | Commenti |

|---|---|---|

1.0 |

15-May-2014 |

Versione iniziale |

Feedback

Feedback