はじめに

このドキュメントでは、Hyperflexクラスタの一般的なIntersightヘルスチェック障害をトラブルシューティングする方法について説明します。

前提条件

要件

次の項目に関する知識があることが推奨されます。

- ネットワークタイムプロトコル(NTP)とドメインネームシステム(DNS)の基本的な知識。

- Linuxコマンドラインの基本的な知識。

- VMware ESXiの基本的な知識。

- VIテキストエディタの基本的な知識。

- Hyperflexクラスタの運用

使用するコンポーネント

このドキュメントの情報は、次のハードウェアに基づくものです。

Hyperflex Data Platform(HXDP)5.0.(2a)以降

このドキュメントの情報は、特定のラボ環境にあるデバイスに基づいて作成されました。このドキュメントで使用するすべてのデバイスは、クリアな(デフォルト)設定で作業を開始しています。本稼働中のネットワークでは、各コマンドによって起こる可能性がある影響を十分確認してください。

背景説明

Cisco Intersightは、Hyperflexクラスタ上で一連のテストを実行し、クラスタの健全性が日々の運用およびメンテナンスタスクに最適な状態であることを確認する機能を提供します。

HX 5.0(2a)以降、HyperflexはHyperflexコマンドラインでのトラブルシューティング用にエスカレーションされた権限を持つdiagユーザアカウントを導入しました。 SSHを管理ユーザとして使用してHyperflex Cluster Management IP(CMIP)に接続し、diagユーザに切り替えます。

HyperFlex StorageController 5.0(2d)

admin@192.168.202.30's password:

This is a Restricted shell.

Type '?' or 'help' to get the list of allowed commands.

hxshell:~$ su diag

Password:

____ __ _____ _ _ _ _____

| ___| / /_ _ | ____(_) __ _| |__ | |_ |_ _|_ _____

|___ \ _____ | '_ \ _| |_ | _| | |/ _` | '_ \| __| _____ | | \ \ /\ / / _ \

___) | |_____| | (_) | |_ _| | |___| | (_| | | | | |_ |_____| | | \ V V / (_) |

|____/ \___/ |_| |_____|_|\__, |_| |_|\__| |_| \_/\_/ \___/

|___/

Enter the output of above expression: 5

Valid captcha

diag#

トラブルシュート

ESXi VIBの修正「インストールされているVIBの一部で、非推奨のvmkAPIが使用されている」を確認

ESXi 7.0以降にアップグレードする場合、IntersightはHyperflexクラスタ内のESXiホストが古いvmkapiバージョンに依存して構築されたドライバを持っていないことを確認します。VMwareは、影響を受けるvSphereインストールバンドル(VIB)のリストを提供し、この問題について次の記事で説明します。KB 78389

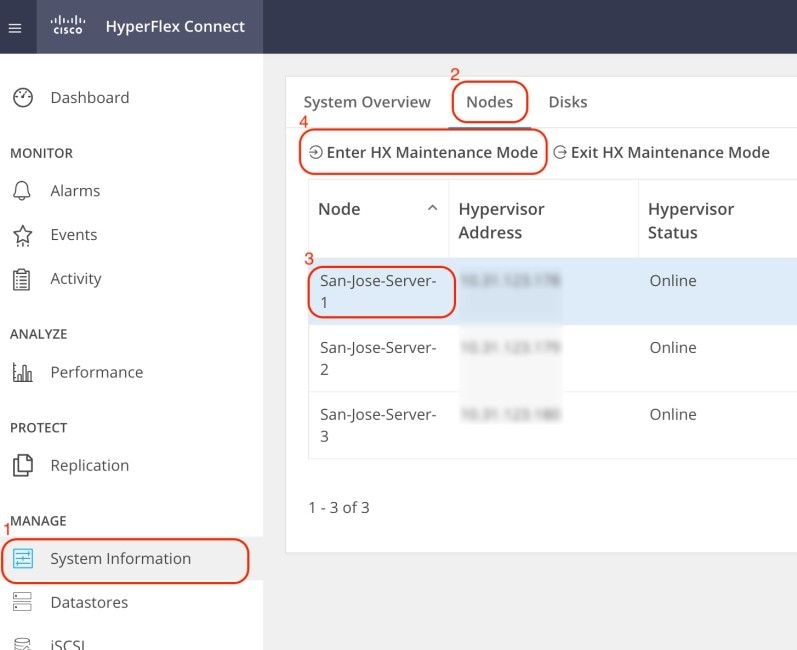

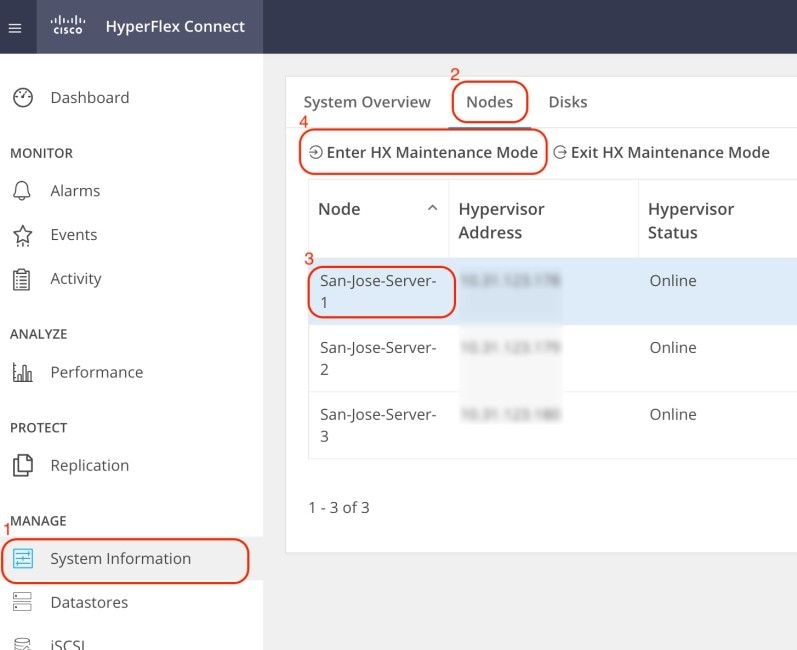

Hyperflex Connect Webユーザインターフェイス(UI)にログインし、システム情報に移動します。Nodesをクリックし、Hyperflex (HX)ノードを選択します。次に、Enter HX Maintenance Modeをクリックします。

SSHクライアントを使用して、ESXiホストの管理IPアドレスに接続します。次に、次のコマンドを使用してESXiホストのVIBを確認します。

esxcli software vib list

次のコマンドを使用してVIBを削除します。

esxcli software vib remove -n driver_VIB_name

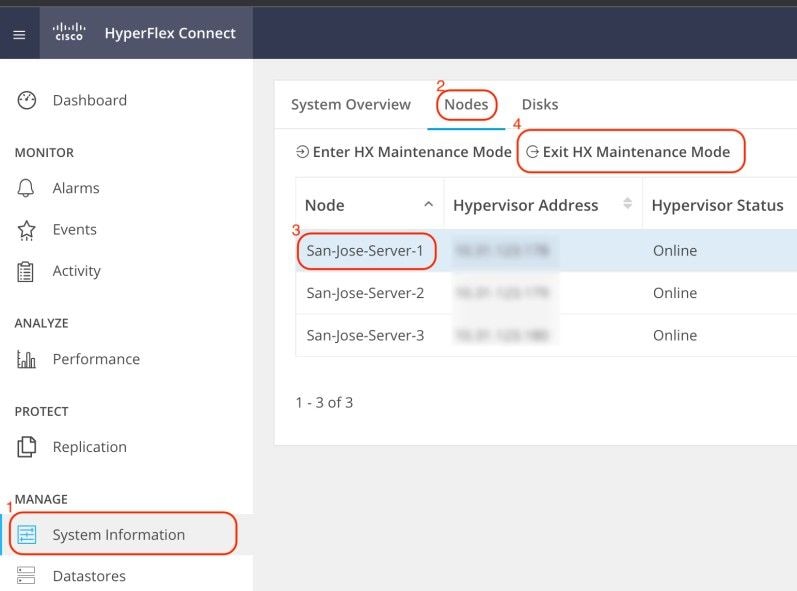

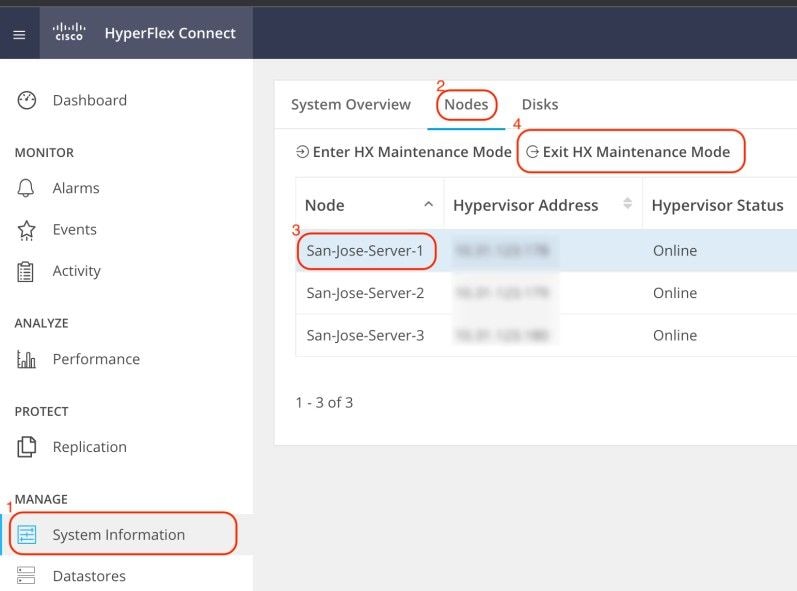

ESXiホストをリブートします。オンラインに戻ったら、HX ConnectからHXノードを選択し、Exit HX Maintenance Modeをクリックします。

HXクラスタが正常になるまで待ちます。次に、クラスタ内の他のノードに対して同じ手順を実行します。

vMotionが有効になっている「VMotionがESXiホストで無効になっている」問題の修正

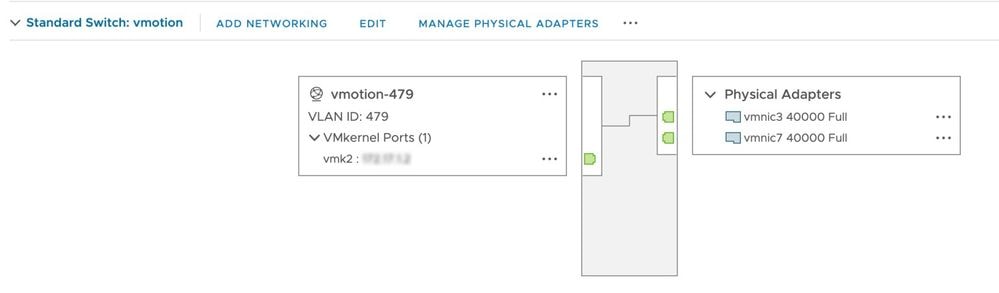

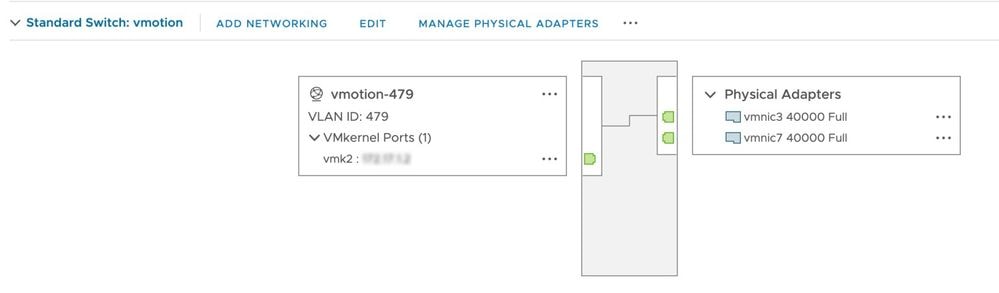

このチェックでは、HXクラスタ内のすべてのESXiホストでvMotionが有効になっていることを確認します。vCenterからは、各ESXiホストに仮想スイッチ(vSwitch)とvMotion用のvmkernelインターフェイスが必要です。

SSHを管理ユーザとして使用してHyperflex Cluster Management IP(CMIP)に接続し、次のコマンドを実行します。

hx_post_install

vMotionを設定するには、オプション1を選択します。

admin@SpringpathController:~$ hx_post_install

Select hx_post_install workflow-

1. New/Existing Cluster

2. Expanded Cluster (for non-edge clusters)

3. Generate Certificate

Note: Workflow No.3 is mandatory to have unique SSL certificate in the cluster. By Generating this certificate, it will replace your current certificate. If you're performing cluster expansion, then this option is not required.

Selection: 1

Logging in to controller HX-01-cmip.example.com

HX CVM admin password:

Getting ESX hosts from HX cluster...

vCenter URL: 192.168.202.35

Enter vCenter username (user@domain): administrator@vsphere.local

vCenter Password:

Found datacenter HX-Clusters

Found cluster HX-01

post_install to be run for the following hosts:

HX-01-esxi-01.example.com

HX-01-esxi-02.example.com

HX-01-esxi-03.example.com

Enter ESX root password:

Enter vSphere license key? (y/n) n

Enable HA/DRS on cluster? (y/n) y

Successfully completed configuring cluster HA.

Disable SSH warning? (y/n) y

Add vmotion interfaces? (y/n) y

Netmask for vMotion: 255.255.254.0

VLAN ID: (0-4096) 208

vMotion MTU is set to use jumbo frames (9000 bytes). Do you want to change to 1500 bytes? (y/n) y

vMotion IP for HX-01-esxi-01.example.com: 192.168.208.17

Adding vmotion-208 to HX-01-esxi-01.example.com

Adding vmkernel to HX-01-esxi-01.example.com

vMotion IP for HX-01-esxi-02.example.com: 192.168.208.18

Adding vmotion-208 to HX-01-esxi-02.example.com

Adding vmkernel to HX-01-esxi-02.example.com

vMotion IP for HX-01-esxi-03.example.com: 192.168.208.19

Adding vmotion-208 to HX-01-esxi-03.example.com

Adding vmkernel to HX-01-esxi-03.example.com

注:HXインストーラを使用して導入されたエッジクラスタの場合、hx_post_installスクリプトをHXインストーラCLIから実行する必要があります。

vCenter接続チェックの修正「vCenter接続チェック失敗」

SSHを管理ユーザとして使用してHyperflex Cluster Management IP(CMIP)に接続し、diagユーザに切り替えます。次のコマンドを使用して、HXクラスタがvCenterに登録されていることを確認します。

diag# hxcli vcenter info

Cluster Name : San_Jose

vCenter Datacenter Name : MX-HX

vCenter Datacenter ID : datacenter-3

vCenter Cluster Name : San_Jose

vCenter Cluster ID : domain-c8140

vCenter URL : 10.31.123.186

vCenter URLには、vCenterサーバのIPアドレスまたは完全修飾ドメイン名(FQDN)が表示されている必要があります。正しい情報が表示されない場合は、次のコマンドを使用してHXクラスタをvCenterに再登録します。

diag# stcli cluster reregister --vcenter-datacenter MX-HX --vcenter-cluster San_Jose --vcenter-url 10.31.123.186 --vcenter-user administrator@vsphere.local

Reregister StorFS cluster with a new vCenter ...

Enter NEW vCenter Administrator password:

Cluster reregistration with new vCenter succeeded

次のコマンドを使用して、HX CMIPとvCenterの間に接続があることを確認します。

diag# nc -uvz 10.31.123.186 80

Connection to 10.31.123.186 80 port [udp/http] succeeded!

diag# nc -uvz 10.31.123.186 443

Connection to 10.31.123.186 443 port [udp/https] succeeded!

クリーナのステータスチェックを修正「クリーナのチェックに失敗」

SSHを管理ユーザとして使用してHyperflex CMIPに接続し、diagユーザに切り替えます。次のコマンドを実行して、クリーナサービスが実行されていないノードを特定します。

diag# stcli cleaner info

{ 'type': 'node', 'id': '7e83a6b2-a227-844b-87fb-f6e78e6a59be', 'name': '172.16.1.6' }: ONLINE

{ 'type': 'node', 'id': '8c83099e-b1e0-6549-a279-33da70d09343', 'name': '172.16.1.8' }: ONLINE

{ 'type': 'node', 'id': 'a697a21f-9311-3745-95b4-5d418bdc4ae0', 'name': '172.16.1.7' }: OFFLINE

この場合、172.16.1.7は、クリーナが実行されていないストレージコントローラ仮想マシン(SCVM)のIPアドレスです。 SSHを使用してクラスタ内の各SCVMの管理IPアドレスに接続し、次のコマンドを使用してeth1のIPアドレスを検索します。

diag# ifconfig eth1

eth1 Link encap:Ethernet HWaddr 00:0c:29:38:2c:a7

inet addr:172.16.1.7 Bcast:172.16.255.255 Mask:255.255.0.0

UP BROADCAST RUNNING MULTICAST MTU:9000 Metric:1

RX packets:1036633674 errors:0 dropped:1881 overruns:0 frame:0

TX packets:983950879 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1000

RX bytes:723797691421 (723.7 GB) TX bytes:698522491473 (698.5 GB)

次のコマンドを使用して、影響を受けるノードでクリーナサービスを開始します。

diag# sysmtool --ns cleaner --cmd start

NTPサービスステータス「NTPD Service Status is DOWN」を修正します。

SSHを管理ユーザとして使用してHX CMIPに接続し、diagユーザに切り替えます。このコマンドを実行して、NTPサービスが停止していることを確認します。

diag# service ntp status

* NTP server is not running

NTPサービスが実行されていない場合は、次のコマンドを実行してNTPサービスを開始します。

diag# priv service ntp start

* Starting NTP server

...done.

NTPサーバの到達可能性の修正「NTPサーバの到達可能性チェックが失敗しました」

SSHを管理ユーザとして使用してHX CMIPに接続し、diagユーザに切り替えます。HXクラスタに到達可能なNTPサーバが設定されていることを確認します。このコマンドを実行して、クラスタ内のNTP設定を表示します。

diag# stcli services ntp show

10.31.123.226

HXクラスタ内の各SCVMとポート123のNTPサーバの間にネットワーク接続があることを確認します。

diag# nc -uvz 10.31.123.226 123

Connection to 10.31.123.226 123 port [udp/ntp] succeeded!

クラスタに設定されているNTPサーバが使用されなくなったら、クラスタ内で別のNTPサーバを設定できます。

stcli services ntp set NTP-IP-Address

警告:stcli services ntp setは、クラスタ内の現在のNTP設定を上書きします。

DNSサーバの到達可能性「DNS到達可能性チェック失敗」を修正する

SSHを管理ユーザとして使用してHX CMIPに接続し、diagユーザに切り替えます。HXクラスタに到達可能なDNSサーバが設定されていることを確認します。このコマンドを実行して、クラスタ内のDNS設定を表示します。

diag# stcli services dns show

10.31.123.226

HXクラスタ内の各SCVMとポート53のDNSサーバの間にネットワーク接続があることを確認します。

diag# nc -uvz 10.31.123.226 53

Connection to 10.31.123.226 53 port [udp/domain] succeeded!

クラスタに設定されているDNSサーバが使用されていない場合は、クラスタ内に別のDNSサーバを設定できます。

stcli services dns set DNS-IP-Adrress

警告:stcli services dns setはクラスタ内の現在のDNS設定を上書きします。

コントローラVMのバージョン「ESXiホストの設定ファイルにコントローラVMのバージョン値がない」を修正します。

このチェックにより、各SCVMのコンフィギュレーションファイルにguestinfo.stctlvm.version = "3.0.6-3"が含まれるようになります。

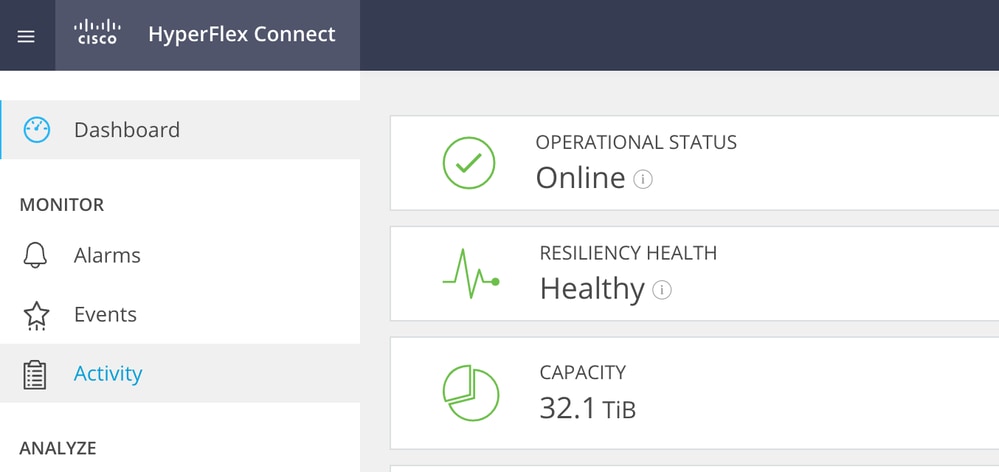

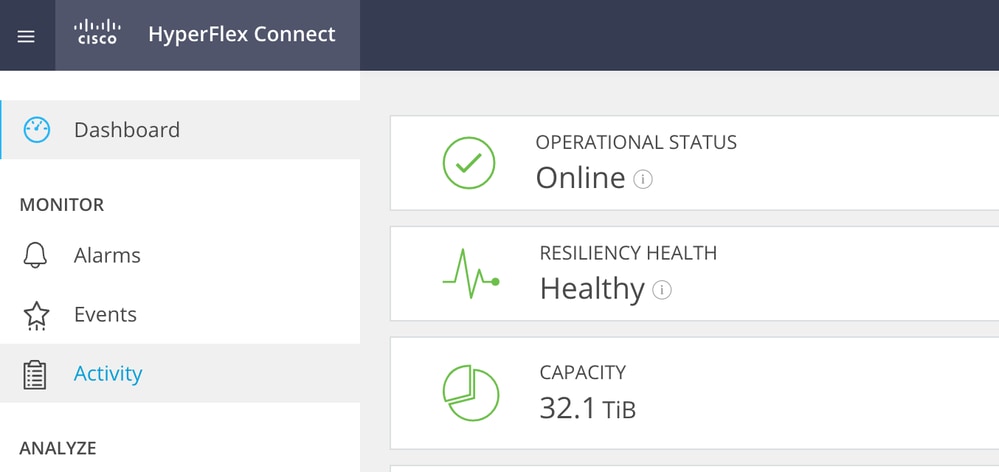

HX Connectにログインし、クラスタが正常であることを確認します。

rootアカウントでSSHを使用して、クラスタ内の各ESXiホストに接続します。次に、このコマンドを実行します

[root@San-Jose-Server-1:~] grep guestinfo /vmfs/volumes/SpringpathDS-FCH2119V1NH/stCtlVM-FCH2119V1NH/stCtlVM-FCH2119V1NH.vmx

guestinfo.stctlvm.version = "3.0.6-3"

guestinfo.stctlvm.configrdm = "False"

guestinfo.stctlvm.hardware.model = "HXAF240C-M4SX"

guestinfo.stctlvm.role = "storage"

注意:データストア名とSCVM名は、クラスタで異なる場合があります。Springと入力してからTabキーを押すと、データストア名をオートコンプリートできます。SCVM名には、stCtlと入力してからTabキーを押すと、SCVM名をオートコンプリートできます。

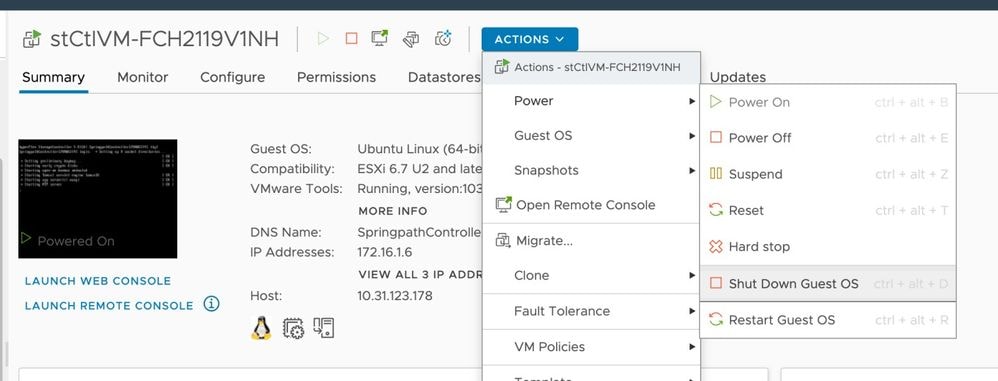

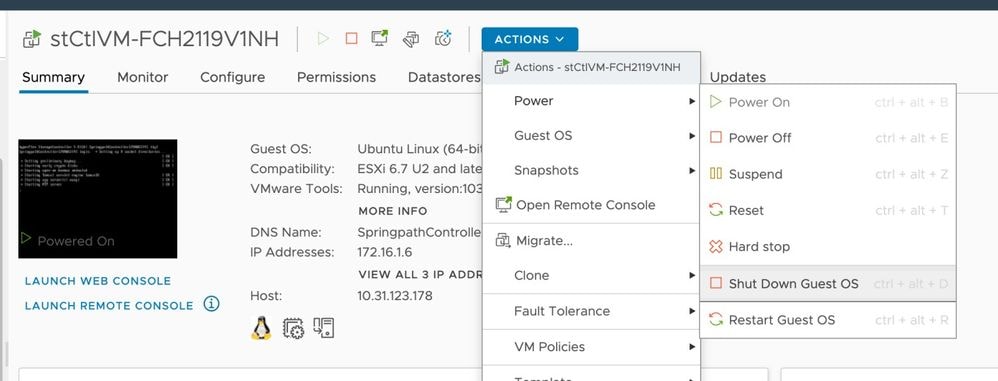

SCVMのコンフィギュレーションファイルにguestinfo.stctlvm.version = "3.0.6-3"が含まれていない場合は、vCenterにログインしてSCVMを選択します。Actionsをクリックし、Powerに移動して、Shut Down Guest OSを選択し、SCVMの電源を正常にオフにします。

ESXiコマンドラインインターフェイス(CLI)から、次のコマンドを使用してSCVMコンフィギュレーションファイルのバックアップを作成します。

cp /vmfs/volumes/SpringpathDS-FCH2119V1NH/stCtlVM-FCH2119V1NH/stCtlVM-FCH2119V1NH.vmx /vmfs/volumes/SpringpathDS-FCH2119V1NH/stCtlVM-FCH2119V1NH/stCtlVM-FCH2119V1NH.vmx.bak

次に、次のコマンドを実行して、SCVMのコンフィギュレーションファイルを開きます。

[root@San-Jose-Server-1:~] vi /vmfs/volumes/SpringpathDS-FCH2119V1NH/stCtlVM-FCH2119V1NH/stCtlVM-FCH2119V1NH.vmx

Iキーを押してファイルを編集し、ファイルの末尾に移動して次の行を追加します。

guestinfo.stctlvm.version = "3.0.6-3"

ESCキーを押し、:wqと入力して変更を保存します。

コマンドvim-cmd vmsvc/getallvmsを使用してSCVMの仮想マシンID(VMID)を特定し、SCVMのコンフィギュレーションファイルをリロードします。

[root@San-Jose-Server-1:~] vim-cmd vmsvc/getallvms

Vmid Name File Guest OS Version Annotation

1 stCtlVM-FCH2119V1NH [SpringpathDS-FCH2119V1NH] stCtlVM-FCH2119V1NH/stCtlVM-FCH2119V1NH.vmx ubuntu64Guest vmx-15

[root@San-Jose-Server-1:~] vim-cmd vmsvc/reload 1

次のコマンドを使用して、SCVMをリロードし、電源をオンにします。

[root@San-Jose-Server-1:~] vim-cmd vmsvc/reload 1

[root@San-Jose-Server-1:~] vim-cmd vmsvc/power.on 1

次のSCVMに移動する前に、HXクラスタが正常に戻るまで待つ必要があります。

影響を受けるSCVMで同じ手順を1つずつ繰り返します。

最後に、SSHを使用して各SCVMにログインし、diagユーザアカウントに切り替えます。次のコマンドを使用して、stMgrを1ノードずつ再起動します。

diag# priv restart stMgr

stMgr start/running, process 22030

次のSCVMに移行する前に、次のコマンドを使用してstMgrが完全に動作していることを確認します。

diag# stcli about

Waiting for stmgr management server on port 9333 to get ready . .

productVersion: 5.0.2d-42558

instanceUuid: EXAMPLE

serialNumber: EXAMPLE,EXAMPLE,EXAMPLE

locale: English (United States)

apiVersion: 0.1

name: HyperFlex StorageController

fullName: HyperFlex StorageController 5.0.2d

serviceType: stMgr

build: 5.0.2d-42558 (internal)

modelNumber: HXAF240C-M4SX

displayVersion: 5.0(2d)

関連情報

フィードバック

フィードバック