OSPD サーバ UCS 240M4 の置換- vEPC

ダウンロード オプション

偏向のない言語

この製品のマニュアルセットは、偏向のない言語を使用するように配慮されています。このマニュアルセットでの偏向のない言語とは、年齢、障害、性別、人種的アイデンティティ、民族的アイデンティティ、性的指向、社会経済的地位、およびインターセクショナリティに基づく差別を意味しない言語として定義されています。製品ソフトウェアのユーザーインターフェイスにハードコードされている言語、RFP のドキュメントに基づいて使用されている言語、または参照されているサードパーティ製品で使用されている言語によりドキュメントに例外が存在する場合があります。シスコのインクルーシブランゲージに対する取り組みの詳細は、こちらをご覧ください。

翻訳について

シスコは世界中のユーザにそれぞれの言語でサポート コンテンツを提供するために、機械と人による翻訳を組み合わせて、本ドキュメントを翻訳しています。ただし、最高度の機械翻訳であっても、専門家による翻訳のような正確性は確保されません。シスコは、これら翻訳の正確性について法的責任を負いません。原典である英語版(リンクからアクセス可能)もあわせて参照することを推奨します。

目次

概要

この資料が不良なサーバを取り替えるために必要なステップを記述したものです Ultra-M セットアップの OpenStack プラットフォーム ディレクター(OSPD)をホストする。

背景説明

Ultra-M は事前包装され、検証された仮想化されたモービル パケット コア ソリューションです VNFs の配備を簡素化するために設計されている。 OpenStack は Ultra-M のための Virtualized Infrastructure Manager (VIM)で、これらのノードタイプで構成されています:

- 計算

- オブジェクト ストレージ ディスク-計算(OSD -計算)

- コントローラ

- OSPD

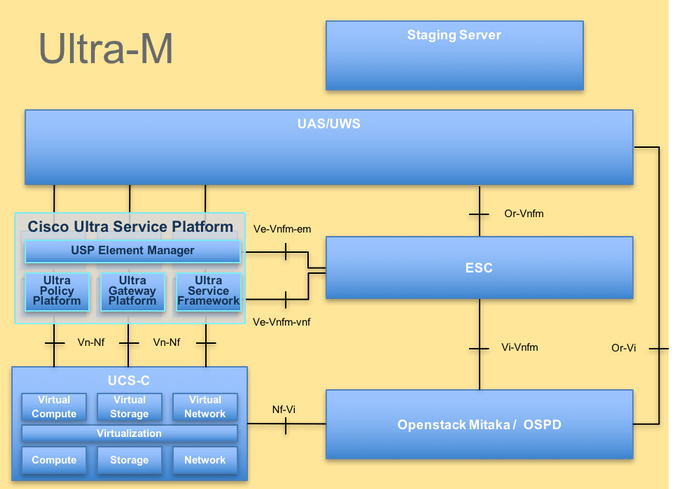

Ultra-M の高レベル アーキテクチャおよび含まれるコンポーネントはこのイメージで描写されます:

UltraM アーキテクチャ

UltraM アーキテクチャ

この資料は Cisco Ultra-M プラットフォームについて詳しく知っている OSPD サーバ 置換の時に水平な OpenStack で遂行されるために必要となるステップを詳述します Cisco社員のために意図され。

注: 超 M 5.1.x リリースはこの資料の手順を定義するために考慮されます。

省略形

| VNF | バーチャルネットワーク 機能 |

| CF | 制御機能 |

| SF | サービス 機能 |

| ESC | 伸縮性があるサービス コントローラ |

| MOP | プロシージャの方式 |

| OSD | オブジェクト ストレージ ディスク |

| HDD | ハードディスク ドライブ |

| SSD | ソリッド ステート ドライブ |

| VIM | 仮想 な インフラストラクチャ マネージャ |

| VM | 仮想マシン |

| EM | Element Manager |

| UAS | Ultra Automation Services |

| UUID | ユニバーサル固有の識別番号 |

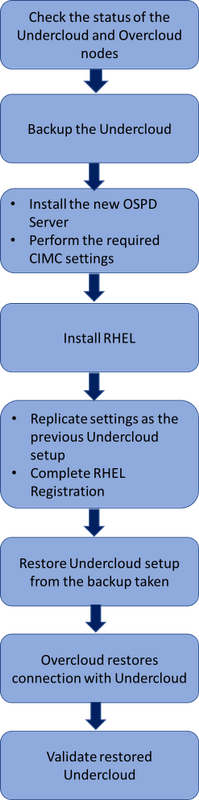

Mop の作業の流れ

交換手順の高レベル作業の流れ

交換手順の高レベル作業の流れ

前提条件

ステータス チェック

OSPD サーバを取り替える前に、Red Hat OpenStack プラットフォーム 環境の現在のステートをチェックし、交換の手順がオンになっているとき複雑な状況を避けるため健全であることを確認することは重要です。

OpenStack スタックおよびノード リストのステータスをチェックして下さい:

[stack@director ~]$ source stackrc

[stack@director ~]$ openstack stack list --nested

[stack@director ~]$ ironic node-list

[stack@director ~]$ nova list

OSP-D ノードからのアクティブおよび走行状態かどうかすべての undercloud サービス ロードされることをにある確認して下さい:

[stack@director ~]$ systemctl list-units "openstack*" "neutron*" "openvswitch*"

UNIT LOAD ACTIVE SUB DESCRIPTION

neutron-dhcp-agent.service loaded active running OpenStack Neutron DHCP Agent

neutron-openvswitch-agent.service loaded active running OpenStack Neutron Open vSwitch Agent

neutron-ovs-cleanup.service loaded active exited OpenStack Neutron Open vSwitch Cleanup Utility

neutron-server.service loaded active running OpenStack Neutron Server

openstack-aodh-evaluator.service loaded active running OpenStack Alarm evaluator service

openstack-aodh-listener.service loaded active running OpenStack Alarm listener service

openstack-aodh-notifier.service loaded active running OpenStack Alarm notifier service

openstack-ceilometer-central.service loaded active running OpenStack ceilometer central agent

openstack-ceilometer-collector.service loaded active running OpenStack ceilometer collection service

openstack-ceilometer-notification.service loaded active running OpenStack ceilometer notification agent

openstack-glance-api.service loaded active running OpenStack Image Service (code-named Glance) API server

openstack-glance-registry.service loaded active running OpenStack Image Service (code-named Glance) Registry server

openstack-heat-api-cfn.service loaded active running Openstack Heat CFN-compatible API Service

openstack-heat-api.service loaded active running OpenStack Heat API Service

openstack-heat-engine.service loaded active running Openstack Heat Engine Service

openstack-ironic-api.service loaded active running OpenStack Ironic API service

openstack-ironic-conductor.service loaded active running OpenStack Ironic Conductor service

openstack-ironic-inspector-dnsmasq.service loaded active running PXE boot dnsmasq service for Ironic Inspector

openstack-ironic-inspector.service loaded active running Hardware introspection service for OpenStack Ironic

openstack-mistral-api.service loaded active running Mistral API Server

openstack-mistral-engine.service loaded active running Mistral Engine Server

openstack-mistral-executor.service loaded active running Mistral Executor Server

openstack-nova-api.service loaded active running OpenStack Nova API Server

openstack-nova-cert.service loaded active running OpenStack Nova Cert Server

openstack-nova-compute.service loaded active running OpenStack Nova Compute Server

openstack-nova-conductor.service loaded active running OpenStack Nova Conductor Server

openstack-nova-scheduler.service loaded active running OpenStack Nova Scheduler Server

openstack-swift-account-reaper.service loaded active running OpenStack Object Storage (swift) - Account Reaper

openstack-swift-account.service loaded active running OpenStack Object Storage (swift) - Account Server

openstack-swift-container-updater.service loaded active running OpenStack Object Storage (swift) - Container Updater

openstack-swift-container.service loaded active running OpenStack Object Storage (swift) - Container Server

openstack-swift-object-updater.service loaded active running OpenStack Object Storage (swift) - Object Updater

openstack-swift-object.service loaded active running OpenStack Object Storage (swift) - Object Server

openstack-swift-proxy.service loaded active running OpenStack Object Storage (swift) - Proxy Server

openstack-zaqar.service loaded active running OpenStack Message Queuing Service (code-named Zaqar) Server

openstack-zaqar@1.service loaded active running OpenStack Message Queuing Service (code-named Zaqar) Server Instance 1

openvswitch.service loaded active exited Open vSwitch

LOAD = Reflects whether the unit definition was properly loaded.

ACTIVE = The high-level unit activation state, i.e. generalization of SUB.

SUB = The low-level unit activation state, values depend on unit type.

37 loaded units listed. Pass --all to see loaded but inactive units, too.

To show all installed unit files use 'systemctl list-unit-files'.

バックアップ

バックアップ プロセスを行う前に利用可能 な 十分なディスクスペースがあることを確認して下さい。 この tarball は少なくとも 3.5 GB であると期待されます。

[stack@director ~]$df -h

undercloud ノードから undercloud バックアップ[タイムスタンプ] .tar.gz と名付けられるファイルにデータをバックアップするためにルート ユーザとしてこのコマンドを実行して下さい。

[root@director ~]# mysqldump --opt --all-databases > /root/undercloud-all-databases.sql

[root@director ~]# tar --xattrs -czf undercloud-backup-`date +%F`.tar.gz /root/undercloud-all-databases.sql

/etc/my.cnf.d/server.cnf /var/lib/glance/images /srv/node /home/stack

tar: Removing leading `/' from member names

新しい OSPD ノードをインストールして下さい

UCS サーバインストール

ステップ新しい UCS C240 M4 サーバをインストールするために、また初期セットアップ ステップは Cisco UCS C240 M4 サーバインストールおよびサービス ガイドから参照することができます。

CIMC IP の使用のサーバへのログイン。

ファームウェアが以前に使用される推奨されるバージョンによってない場合 BIOS アップグレードを行って下さい。 BIOS アップグレードのためのステップはここに与えられます: Cisco UCS Cシリーズ RAC マウント サーバ BIOS アップグレード ガイド。

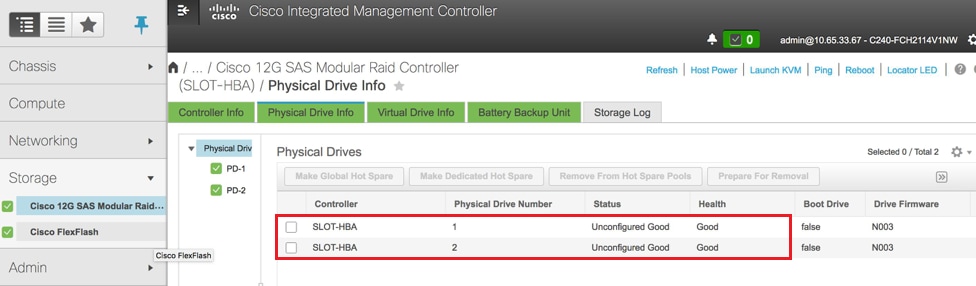

物理ドライブのステータスを確認して下さい。 それは未設定よい必要があります:

> 物理ドライブ情報はストレージ > Cisco 12G SAS モジュラ侵略コントローラ(SLOT-HBA)にここにイメージで示されているようにナビゲート します。

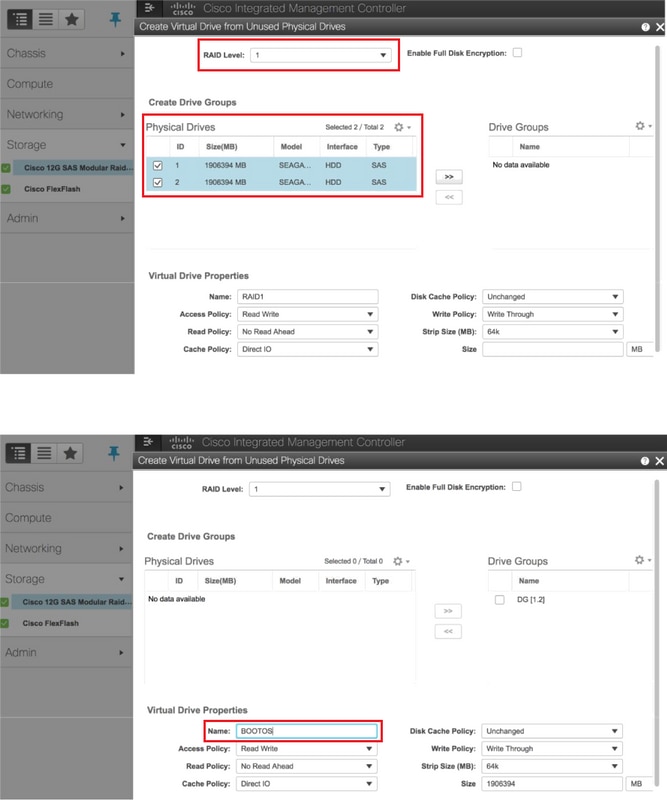

RAID レベル 1 で物理ドライブからの仮想ドライブを作成して下さい:

ストレージ > Cisco 12G SAS モジュラ侵略コントローラ(SLOT-HBA)へのナビゲートはイメージに示すように > コントローラ 情報 > 未使用物理ドライブからの仮想ドライブを作成します。

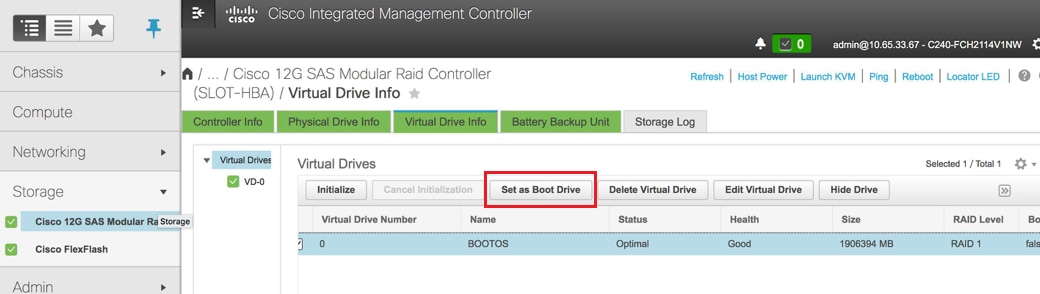

VD を選択し、ブート ドライブでイメージに示すようにセットを設定して下さい。

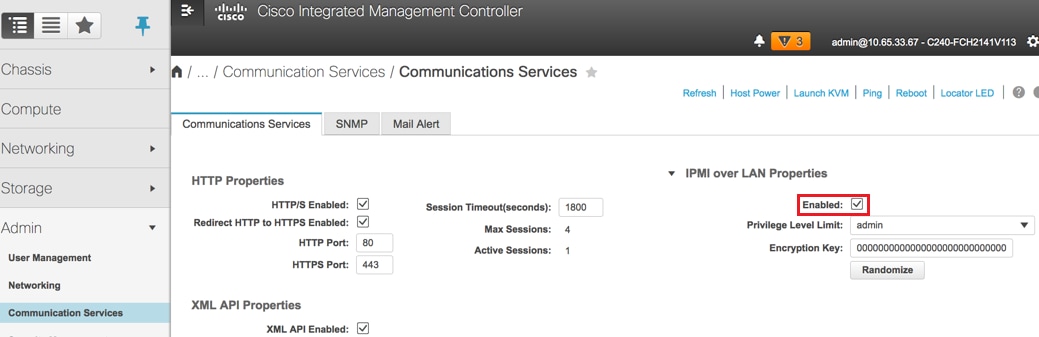

LAN 上の IPMI を有効に して下さい:

イメージに示すように Admin > コミュニケーションサービス > コミュニケーションサービスにナビゲート して下さい。

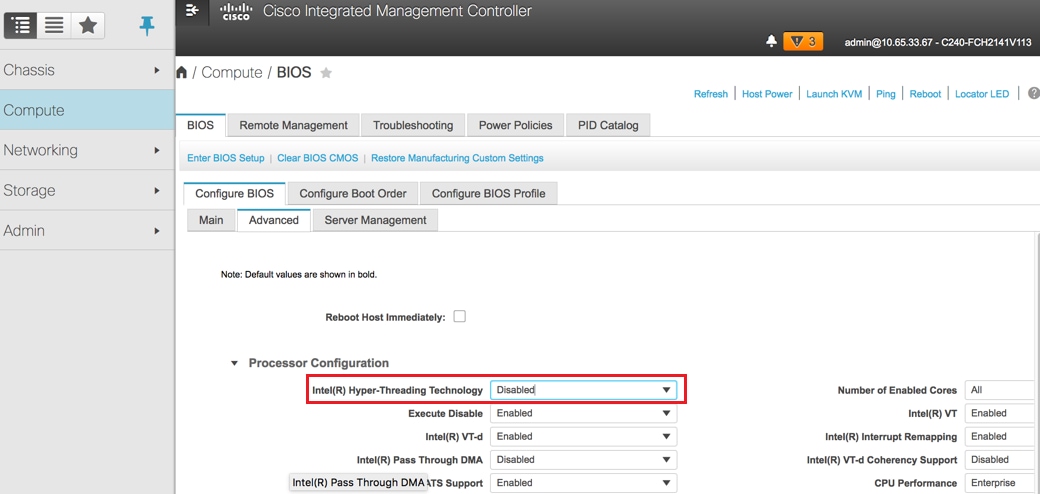

hyperthreading ディセーブル:

計算するべきナビゲートはイメージに示すように > BIOS > 設定 BIOS > > プロセッサ 設定進みました。

注: このセクションでおよび述べられるコンフィギュレーションのステップはファームウェアのバージョン 3.0(3e) についてここに示されているイメージあり、他のバージョンに取り組む場合わずかな変化があるかもしれません。

Red Hat インストール

Red Hat ISO イメージをマウントして下さい

1. OSP-D サーバへのログイン。

2. 起動 KVM コンソール。

3. 仮想 なメディア > アクティブ化仮想デバイスへのナビゲート。 セッションを受け入れ、未来の接続の設定を覚えていることを有効に して下さい。

4. 仮想 なメディア > マップ CD/DVDand マップを Red Hat ISO イメージ選択して下さい。

5. 電源を > システム(ウォームブート)をシステムをリブートするためにリセットするために選択して下さい。

6. 再始動に、F6and を『Cisco』 を選択 します vKVM マッピング された vDVD1.22and を『Enter』 を押します押して下さい。

Red Hat Enterprise Linux をインストールして下さい

注: このセクションのプロシージャは設定する必要があるパラメータの最小番号を確認するインストールプロセスの簡単バージョンを表します。

1. Red Hat Enterprise Linux (RHEL)をインストールを始めるためにインストールするオプションを選択して下さい。

2. 選択を > 最小インストールだけ『Software』 を選択 して下さい。

3. ネットワーク インターフェイスを設定して下さい(eno1 および eno2)。

4. ネットワークおよびホスト名をクリックして下さい。

- 外部コミュニケーションのために使用するインターフェイスを選択して下さい(eno1 か eno2)

- 『Configure』 をクリック して下さい

- IPv4 Settingstab を選択し、手動法を選択し、『Add』 をクリック して下さい

- 以前に使用されるようにこれらのパラメータを設定 して下さい: アドレス、ネットマスク、ゲートウェイ、DNSサーバ

5. 日時を選択し、領域および都市を規定 して下さい。

6. ネットワーク タイムを有効に し、NTP サーバを設定して下さい。

7. インストール宛先を選択し、ext4 ファイル システム を使用して下さい。

注: /home/ を削除し、ルート/の下でキャパシティを再割当てして下さい。

8. Kdump を無効に して下さい。

9. ルートパスワードだけを設定 して下さい。

10. インストール

を始めて下さい。

Undercloud を復元する

バックアップに基づいて undercloud インストールを準備して下さい

RHEL 7.3 とインストールされるマシンはきれいな状態にありましたり、ディレクターをインストールし、実行するのに必要とされるすべてのサブスクリプション/リポジトリを再び有効にし。

ホスト名設定:

[root@director ~]$sudo hostnamectl set-hostname <FQDN_hostname>

[root@director ~]$sudo hostnamectl set-hostname --transient <FQDN_hostname>

/etc/hosts ファイルを編集して下さい:

[root@director ~]$ vi /etc/hosts

<ospd_external_address> <server_hostname> <FQDN_hostname>

10.225.247.142 pod1-ospd pod1-ospd.cisco.com

ホスト名を検証して下さい:

[root@director ~]$ cat /etc/hostname

pod1-ospd.cisco.com

DNS 設定を検証して下さい:

[root@director ~]$ cat /etc/resolv.conf

#Generated by NetworkManager

nameserver <DNS_IP>

提供 NIC インターフェイスを修正して下さい:

[root@director ~]$ cat /etc/sysconfig/network-scripts/ifcfg-eno1

DEVICE=eno1

ONBOOT=yes

HOTPLUG=no

NM_CONTROLLED=no

PEERDNS=no

DEVICETYPE=ovs

TYPE=OVSPort

OVS_BRIDGE=br-ctlplane

BOOTPROTO=none

MTU=1500

Red Hat 登録を完了して下さい

サブスクリプション マネージャを RH サテライトを使用するために設定するためにこのパッケージをダウンロードして下さい:

[root@director ~]$ rpm -Uvh http://<satellite-server>/pub/katello-ca-consumer-latest.noarch.rpm

[root@director ~]$ subscription-manager config

RHEL 7.3 のためのこの activationkey の使用の RH サテライトによって登録して下さい。

[root@director ~]$subscription-manager register --org="<ORG>" --activationkey="<KEY>"

サブスクリプションを見るため:

[root@director ~]$ subscription-manager list –consumed

古い OSPD レポと同じようなリポジトリを有効に して下さい:

[root@director ~]$ sudo subscription-manager repos --disable=*

[root@director ~]$ subscription-manager repos --enable=rhel-7-server-rpms --enable=rhel-7-server-extras-rpms --enable=rh

el-7-server-openstack-10-rpms --enable=rhel-7-server-rh-common-rpms --enable=rhel-ha-for-rhel-7-server-rpm

持っています最新の基礎システム・パッケージを確認し、システムをリブートするためにシステムのアップデートを行って下さい:

[root@director ~]$sudo yum update -y

[root@director ~]$sudo reboot

Undercloud リストア

サブスクリプションを有効に した後、新しい OSP-D サーバルートディレクトリ /root にバックアップされた undercloud tarファイル undercloud バックアップ日付 +%F `.tar.gz をインポートして下さい。

mariadb サーバをインストールして下さい:

[root@director ~]$ yum install -y mariadb-server

MariaDB コンフィギュレーション ファイルおよびデータベース(DB)バックアップを得て下さい。 ルート ユーザとしてこのオペレーションを行って下さい。

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz etc/my.cnf.d/server.cnf

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz root/undercloud-all-databases.sql

/etc/my.cnf.d/server.cnf を編集し、バインド アドレス エントリもしあればコメントにして下さい:

[root@tb3-ospd ~]# vi /etc/my.cnf.d/server.cnf

MariaDB サービスを開始し、一時的に max_allowed_packet 設定をアップデートして下さい:

[root@director ~]$ systemctl start mariadb

[root@director ~]$ mysql -uroot -e"set global max_allowed_packet = 16777216;"

ある特定の権限をクリーンアップして下さい(作り直された以降であるため):

[root@director ~]$ for i in ceilometer glance heat ironic keystone neutron nova;do mysql -e "drop user $i";done

[root@director ~]$ mysql -e 'flush privileges'

注: 雲高計サービスがセットアップで以前に 無効に なる場合、このコマンドを実行し、雲高計を取除いて下さい。

stackuser アカウントを作成して下さい:

[root@director ~]$ sudo useradd stack

[root@director ~]$ sudo passwd stack << specify a password

[root@director ~]$ echo "stack ALL=(root) NOPASSWD:ALL" | sudo tee -a /etc/sudoers.d/stack

[root@director ~]$ sudo chmod 0440 /etc/sudoers.d/stack

スタック ユーザ ホーム ディレクトリを復元する:

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz home/stack

速い一見基礎パッケージをインストールし、次にデータを復元する:

[root@director ~]$ yum install -y openstack-glance openstack-swift

[root@director ~]$ tar --xattrs -xzC / -f undercloud-backup-$DATE.tar.gz srv/node var/lib/glance/images

データが正しいユーザによって所有されることを確認して下さい:

[root@director ~]$ chown -R swift: /srv/node

[root@director ~]$ chown -R glance: /var/lib/glance/images

undercloud SSL 証明書(オプションのを-セットアップが SSL 証明書を使用するときだけ)されるため復元する。

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz etc/pki/instack-certs/undercloud.pem

[root@director ~]$ tar -xzC / -f undercloud-backup-$DATE.tar.gz etc/pki/ca-trust/source/anchors/ca.crt.pem

undercloud インストールを stackuser として再実行し、スタック ユーザ ホーム ディレクトリでそれを実行するために確認して下さい:

[root@director ~]$ su - stack

[stack@director ~]$ sudo yum install -y python-tripleoclient

ホスト名が /etc/hosts で正しく設定 されることを確認して下さい。

undercloud を再インストールして下さい:

[stack@director ~]$ openstack undercloud install

<snip>

#############################################################################

Undercloud install complete.

The file containing this installation's passwords is at

/home/stack/undercloud-passwords.conf.

There is also a stackrc file at /home/stack/stackrc.

These files are needed to interact with the OpenStack services, and must be

secured.

#############################################################################

曇に復元する Undercloud を再接続して下さい

これらのステップを完了した後、undercloud は自動的に曇への接続を回復すると期待することができます。 ノードは数秒ごとに発行される簡単な HTTP 要求の使用の保留中のタスクのためのオーケストレーション(熱)を、ポーリングし続けます。

完了された復元を検証して下さい

最近復元する 環境の健康診断を行うためにこれらのコマンドを使用して下さい:

[root@director ~]$ su - stack

Last Log in: Tue Nov 28 21:27:50 EST 2017 from 10.86.255.201 on pts/0

[stack@director ~]$ source stackrc

[stack@director ~]$ nova list

+--------------------------------------+--------------------+--------+------------+-------------+------------------------+

| ID | Name | Status | Task State | Power State | Networks |

+--------------------------------------+--------------------+--------+------------+-------------+------------------------+

| b1f5294a-629e-454c-b8a7-d15e21805496 | pod1-compute-0 | ACTIVE | - | Running | ctlplane=192.200.0.119 |

| 9106672e-ac68-423e-89c5-e42f91fefda1 | pod1-compute-1 | ACTIVE | - | Running | ctlplane=192.200.0.120 |

| b3ed4a8f-72d2-4474-91a1-b6b70dd99428 | pod1-compute-2 | ACTIVE | - | Running | ctlplane=192.200.0.124 |

| 677524e4-7211-4571-ac35-004dc5655789 | pod1-compute-3 | ACTIVE | - | Running | ctlplane=192.200.0.107 |

| 55ea7fe5-d797-473c-83b1-d897b76a7520 | pod1-compute-4 | ACTIVE | - | Running | ctlplane=192.200.0.122 |

| c34c1088-d79b-42b6-9306-793a89ae4160 | pod1-compute-5 | ACTIVE | - | Running | ctlplane=192.200.0.108 |

| 4ba28d8c-fb0e-4d7f-8124-77d56199c9b2 | pod1-compute-6 | ACTIVE | - | Running | ctlplane=192.200.0.105 |

| d32f7361-7e73-49b1-a440-fa4db2ac21b1 | pod1-compute-7 | ACTIVE | - | Running | ctlplane=192.200.0.106 |

| 47c6a101-0900-4009-8126-01aaed784ed1 | pod1-compute-8 | ACTIVE | - | Running | ctlplane=192.200.0.121 |

| 1a638081-d407-4240-b9e5-16b47e2ff6a2 | pod1-compute-9 | ACTIVE | - | Running | ctlplane=192.200.0.112 |

<snip>

[stack@director ~]$ ssh heat-admin@192.200.0.107

[heat-admin@pod1-controller-0 ~]$ sudo pcs status

Cluster name: tripleo_cluster

Stack: corosync

Current DC: pod1-controller-0 (version 1.1.15-11.el7_3.4-e174ec8) - partition with quorum

3 nodes and 22 resources configured

Online: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

Full list of resources:

ip-10.1.10.10 (ocf::heartbeat:IPaddr2): Started pod1-controller-0

ip-11.120.0.97 (ocf::heartbeat:IPaddr2): Started pod1-controller-1

Clone Set: haproxy-clone [haproxy]

Started: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

Master/Slave Set: galera-master [galera]

Masters: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

ip-192.200.0.106 (ocf::heartbeat:IPaddr2): Started pod1-controller-0

ip-11.120.0.95 (ocf::heartbeat:IPaddr2): Started pod1-controller-1

ip-11.119.0.98 (ocf::heartbeat:IPaddr2): Started pod1-controller-0

ip-11.118.0.92 (ocf::heartbeat:IPaddr2): Started pod1-controller-1

Clone Set: rabbitmq-clone [rabbitmq]

Started: [ pod1-controller-0 pod1-controller-1 pod1-controller-2 ]

Master/Slave Set: redis-master [redis]

Masters: [ pod1-controller-0 ]

Slaves: [ pod1-controller-1 pod1-controller-2 ]

openstack-cinder-volume (systemd:openstack-cinder-volume): Started pod1-controller-0

my-ipmilan-for-controller-0 (stonith:fence_ipmilan): Stopped

my-ipmilan-for-controller-1 (stonith:fence_ipmilan): Stopped

my-ipmilan-for-controller-2 (stonith:fence_ipmilan): Stopped

Failed Actions:

* my-ipmilan-for-controller-0_start_0 on pod1-controller-1 'unknown error' (1): call=190, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:45 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-1_start_0 on pod1-controller-1 'unknown error' (1): call=192, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:53:08 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-2_start_0 on pod1-controller-1 'unknown error' (1): call=188, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:23 2017', queued=0ms, exec=20004ms

* my-ipmilan-for-controller-0_start_0 on pod1-controller-0 'unknown error' (1): call=210, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:53:08 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-1_start_0 on pod1-controller-0 'unknown error' (1): call=207, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:45 2017', queued=0ms, exec=20004ms

* my-ipmilan-for-controller-2_start_0 on pod1-controller-0 'unknown error' (1): call=206, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:45 2017', queued=0ms, exec=20006ms

* ip-192.200.0.106_monitor_10000 on pod1-controller-0 'not running' (7): call=197, status=complete, exitreason='none',

last-rc-change='Wed Nov 22 13:51:31 2017', queued=0ms, exec=0ms

* my-ipmilan-for-controller-0_start_0 on pod1-controller-2 'unknown error' (1): call=183, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:23 2017', queued=1ms, exec=20006ms

* my-ipmilan-for-controller-1_start_0 on pod1-controller-2 'unknown error' (1): call=184, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:23 2017', queued=0ms, exec=20005ms

* my-ipmilan-for-controller-2_start_0 on pod1-controller-2 'unknown error' (1): call=177, status=Timed Out, exitreason='none',

last-rc-change='Wed Nov 22 13:52:02 2017', queued=0ms, exec=20005ms

Daemon Status:

corosync: active/enabled

pacemaker: active/enabled

pcsd: active/enabled

[heat-admin@pod1-controller-0 ~]$ sudo ceph status

cluster eb2bb192-b1c9-11e6-9205-525400330666

health HEALTH_OK

monmap e1: 3 mons at {pod1-controller-0=11.118.0.40:6789/0,pod1-controller-1=11.118.0.41:6789/0,pod1-controller-2=11.118.0.42:6789/0}

election epoch 58, quorum 0,1,2 pod1-controller-0,pod1-controller-1,pod1-controller-2

osdmap e1398: 12 osds: 12 up, 12 in

flags sortbitwise,require_jewel_osds

pgmap v1245812: 704 pgs, 6 pools, 542 GB data, 352 kobjects

1625 GB used, 11767 GB / 13393 GB avail

704 active+clean

client io 21549 kB/s wr, 0 op/s rd, 120 op/s wr

識別 サービス(台形)オペレーションをチェックして下さい

このステップはユーザのリストのための問い合わせによって識別 サービス オペレーションを検証します。

[stack@director ~]$ source stackrc

[stack@director ~]$ openstack user list

+----------------------------------+------------------+

| ID | Name |

+----------------------------------+------------------+

| 69ac2b9d89414314b1366590c7336f7d | admin |

| f5c30774fe8f49d0a0d89d5808a4b2cc | glance |

| 3958d852f85749f98cca75f26f43d588 | heat |

| cce8f2b7f1a843a08d0bb295a739bd34 | ironic |

| ce7c642f5b5741b48a84f54d3676b7ee | ironic-inspector |

| a69cd42a5b004ec5bee7b7a0c0612616 | mistral |

| 5355eb161d75464d8476fa0a4198916d | neutron |

| 7cee211da9b947ef9648e8fe979b4396 | nova |

| f73d36563a4a4db482acf7afc7303a32 | swift |

| d15c12621cbc41a8a4b6b67fa4245d03 | zaqar |

| 3f0ed37f95544134a15536b5ca50a3df | zaqar-websocket |

+----------------------------------+------------------+

[stack@director ~]$

[stack@director ~]$ source <overcloudrc>

[stack@director ~]$ openstack user list

+----------------------------------+------------+

| ID | Name |

+----------------------------------+------------+

| b4e7954942184e2199cd067dccdd0943 | admin |

| 181878efb6044116a1768df350d95886 | neutron |

| 6e443967ee3f4943895c809dc998b482 | heat |

| c1407de17f5446de821168789ab57449 | nova |

| c9f64c5a2b6e4d4a9ff6b82adef43992 | glance |

| 800e6b1163b74cc2a5fab4afb382f37d | cinder |

| 4cfa5a2a44c44c678025842f080e5f53 | heat-cfn |

| 9b222eeb8a58459bb3bfc76b8fff0f9f | swift |

| 815f3f25bcda49c290e1b56cd7981d1b | core |

| 07c40ade64f34a64932129175150fa4a | gnocchi |

| 0ceeda0bc32c4d46890e53adef9a193d | aodh |

| f3caab060171468592eab376a94967b8 | ceilometer |

+----------------------------------+------------+

[stack@director ~]$

未来のノード内省のためのアップロード イメージ

これらのステップに進まないために /httpboot およびこれらのファイルすべて inspector.ipxe を、agent.kernel、agent.ramdisk、検証して下さい。

[stack@director ~]$ ls /httpboot

inspector.ipxe

[stack@director ~]$ source stackrc

[stack@director ~]$ cd images/

[stack@director images]$ openstack overcloud image upload --image-path /home/stack/images

Image "overcloud-full-vmlinuz" is up-to-date, skipping.

Image "overcloud-full-initrd" is up-to-date, skipping.

Image "overcloud-full" is up-to-date, skipping.

Image "bm-deploy-kernel" is up-to-date, skipping.

Image "bm-deploy-ramdisk" is up-to-date, skipping.

[stack@director images]$ ls /httpboot

agent.kernel agent.ramdisk inspector.ipxe

[stack@director images]$

囲うことを再起動して下さい

囲うことは OSPD リカバリの後に停止状態にあります。 このプロシージャは囲うことを有効に します。

[heat-admin@pod1-controller-0 ~]$ sudo pcs property set stonith-enabled=true

[heat-admin@pod1-controller-0 ~]$ sudo pcs status

[heat-admin@pod1-controller-0 ~]$sudo pcs stonith show

関連情報

シスコ エンジニア提供

- Padmaraj RamanoudjamCisco アドバンスド サービス

- Partheeban RajagopalCisco アドバンスド サービス

シスコに問い合わせ

- サポート ケースをオープン

- (シスコ サービス契約が必要です。)

フィードバック

フィードバック