Catalyst 3550 스위치의 QoS 스케줄링 및 대기열 처리

목차

소개

출력 스케줄링은 인터페이스 이그레스(egress)에서 과도한 초과 서브스크립션이 발생할 경우 중요한 트래픽이 삭제되지 않도록 합니다.이 문서에서는 Cisco Catalyst 3550 스위치의 출력 스케줄링과 관련된 모든 기술과 알고리즘에 대해 설명합니다.이 문서에서는 Catalyst 3550 스위치에서 출력 스케줄링을 구성하고 확인하는 방법에 대해서도 중점적으로 설명합니다.

사전 요구 사항

요구 사항

이 문서에 대한 특정 요건이 없습니다.

사용되는 구성 요소

이 문서의 정보는 Cisco IOS® Software 릴리스 12.1(12c)EA1을 실행하는 Catalyst 3550을 기반으로 합니다.

이 문서의 정보는 특정 랩 환경의 디바이스를 토대로 작성되었습니다.이 문서에 사용된 모든 디바이스는 초기화된(기본) 컨피그레이션으로 시작되었습니다.현재 네트워크가 작동 중인 경우, 모든 명령어의 잠재적인 영향을 미리 숙지하시기 바랍니다.

표기 규칙

문서 규칙에 대한 자세한 내용은 Cisco 기술 팁 표기 규칙을 참고하십시오.

Catalyst 3550 스위치의 포트 출력 대기열 기능

3550 스위치에는 두 가지 유형의 포트가 있습니다.

-

기가비트 포트

-

비기가비트 포트(10/100Mbps 포트)

이 두 포트의 기능은 서로 다릅니다.이 섹션의 나머지 부분에는 이러한 기능이 요약되어 있습니다.이 문서의 다른 섹션에서는 기능에 대해 자세히 설명합니다.

기가비트 및 비 기가비트 포트 모두 지원하는 기능

3550의 각 포트에는 4개의 서로 다른 출력 대기열이 있습니다.이러한 큐 중 하나를 엄격한 우선 순위 큐로 구성할 수 있습니다.나머지 각 대기열은 엄격한 우선 순위가 아닌 대기열로 구성되며 WRR(Weighted Round Robin)을 사용하여 서비스됩니다. 모든 포트에서 패킷은 CoS(Class of Service)를 기준으로 가능한 4개의 대기열 중 하나에 할당됩니다.

기가비트 포트만 지원하는 기능

또한 기가비트 포트는 각 대기열 내에서 대기열 관리 메커니즘을 지원합니다.각 큐에서 WRED(Weighted Random Early Detection) 또는 tail drop(2개의 임계값)을 사용하도록 구성할 수 있습니다.또한 각 대기열의 크기(각 대기열에 할당된 버퍼)를 조정할 수 있습니다.

비 기가비트 포트만 지원하는 기능

비기가비트 포트에는 WRED 또는 tail drop과 같은 대기열 메커니즘이 2개의 임계값으로 없습니다.10/100Mbps 포트의 FIFO 대기열만 지원됩니다.이러한 포트에서 4개의 대기열 각각을 변경할 수 없습니다.그러나 대기열당 최소 예약 크기를 할당할 수 있습니다.

CoS-to-Queue 매핑

이 섹션에서는 3550에서 각 패킷을 대기열에 배치하기로 결정하는 방법에 대해 설명합니다.패킷은 CoS를 기준으로 대기열에 배치됩니다.가능한 8개의 CoS 값 각각은 4개의 가능한 대기열 중 하나에 매핑되며 이 예에서는 CoS-to-queue 맵 인터페이스 명령을 사용합니다.

(config-if)#wrr-queue cos-map queue-id cos1... cos8

예를 들면 다음과 같습니다.

3550(config-if)#wrr-queue cos-map 1 0 1 3550(config-if)#wrr-queue cos-map 2 2 3 3550(config-if)#wrr-queue cos-map 3 4 5 3550(config-if)#wrr-queue cos-map 4 6 7

이 예에서는 다음을 수행합니다.

-

큐 1의 CoS 0 및 1(Q1)

-

Q2의 CoS 2 및 3

-

3분기에 CoS 4 및 5개

-

CoS 6 및 7 in Q4

포트의 CoS-to-queue 매핑을 확인하려면 다음 명령을 실행할 수 있습니다.

cat3550#show mls qos interface gigabitethernet0/1 queueing GigabitEthernet0/1 ...Cos-queue map: cos-qid 0 - 1 1 - 1 2 - 2 3 - 2 4 - 3 5 - 3 6 - 4 7 - 4...

엄격한 우선 순위 대기열

엄격한 우선 순위 큐는 항상 먼저 비워집니다.따라서 엄격한 우선순위 대기열에 패킷이 있는 즉시 패킷이 전달됩니다.각 패킷이 WRR 대기열 중 하나에서 포워딩되면 엄격한 우선 순위 큐가 확인되고 필요한 경우 비워집니다.

엄격한 우선 순위 큐는 음성 등의 지연/지터에 민감한 트래픽을 위해 특별히 설계되었습니다.엄격한 우선 순위 대기열은 결국 다른 대기열의 기아 문제를 야기할 수 있습니다.패킷이 엄격한 우선순위 큐에서 대기하는 경우 다른 3개의 WRR 대기열에 배치된 패킷은 전달되지 않습니다.

팁

다른 대기열의 굶주림을 방지하려면 우선 순위 대기열에 있는 트래픽에 특히 유의하십시오.이 대기열은 일반적으로 음성 트래픽에 사용되며, 일반적으로 볼륨이 그리 높지 않습니다.그러나 누군가 CoS 우선 순위의 대용량 트래픽을 엄격한 우선 순위 큐(예: 대용량 파일 전송 또는 백업)로 보낼 수 있는 경우 다른 트래픽이 부족해질 수 있습니다.이 문제를 방지하려면 네트워크에서 트래픽의 분류/수락 및 표시에 특수 트래픽을 배치해야 합니다.예를 들어 다음과 같은 예방 조치를 취할 수 있습니다.

-

신뢰할 수 없는 모든 소스 포트에 대해 신뢰할 수 없는 포트 QoS 상태를 사용합니다.

-

Cisco IP Phone 포트에 대해 신뢰할 수 있는 경계 기능을 사용하여 다른 애플리케이션에 대해 IP 전화에 대해 구성된 신뢰 상태에서 사용하지 않도록 합니다.

-

엄격한 우선 순위 대기열로 이동하는 트래픽을 폴리싱합니다.기가비트 포트에서 CoS 5(DSCP[differentiated services code point] 46)에서 100MB로 폴리싱 트래픽에 대한 제한을 설정합니다.

이러한 항목에 대한 자세한 내용은 다음 문서를 참조하십시오.

-

QoS 구성(Catalyst 3500)의 포트 보안 섹션을 보장하기 위해 신뢰할 수 있는 경계 구성

3550에서는 하나의 대기열을 항상 Q4(우선순위 큐)로 구성할 수 있습니다. 인터페이스 모드에서 이 명령을 사용합니다.

3550(config-if)#priority-queue out

우선 순위 큐가 인터페이스에 구성되지 않은 경우 Q4는 표준 WRR 큐로 간주됩니다.이 문서의 Catalyst 3550의 Weighted Round-Robin 섹션에서는 자세한 내용을 제공합니다.동일한 Cisco IOS 명령을 실행하는 경우 인터페이스에 strict priority queue가 구성되어 있는지 확인할 수 있습니다.

NifNif#show mls qos interface gigabitethernet0/1 queueing GigabitEthernet0/1 Egress expedite queue: ena

Catalyst 3550의 Weighted Round-Robin

WRR은 3550의 출력 스케줄링에 사용되는 메커니즘입니다.WRR은 세 개 또는 네 개의 큐 사이에서 작동합니다(엄격한 우선 순위 큐가 없는 경우). WRR에서 사용되는 대기열은 라운드 로빈 방식으로 비우고 각 대기열의 가중치를 구성할 수 있습니다.

예를 들어, 다음 목록에 나와 있는 것처럼 큐가 다르게 제공되도록 가중치를 구성할 수 있습니다.

-

서비스 WRR Q1:시간의 10%

-

서비스 WRR Q2:시간의 20%

-

3사분기 WRR 서비스:시간의 60%

-

서비스 WRR Q4:시간의 10%

각 대기열에 대해 다음 명령을 인터페이스 모드에서 실행하여 4개의 가중치(각 대기열에 연결된 가중치 포함)를 구성할 수 있습니다.

(config-f)#wrr-queue bandwidth weight1 weight2 weight3 weight4

예를 들면 다음과 같습니다.

3550(config)#interface gigabitethernet 0/1

3550(config-if)#wrr-queue bandwidth 1 2 3 4

참고: 가중치는 상대적입니다.다음 값이 사용됩니다.

-

Q1 = 무게 1 / (무게1 + 무게2 + 무게3 + 무게4) = 1 / (1+2+3+4) = 1/10

-

Q2 = 2/10

-

Q3 = 3/10

-

Q4 = 4/10

WRR은 다음 두 가지 방법으로 구현할 수 있습니다.

-

대역폭당 WRR:각 가중치는 전송 가능한 특정 대역폭을 나타냅니다.가중치 Q1은 대역폭의 약 10%, Q2는 대역폭의 20% 등 거의 10%가 허용됩니다.이 계획은 현재 Catalyst 6500/6000 시리즈에서만 구현됩니다.

-

패킷당 WRR:3550 스위치에 구현된 알고리즘입니다.각 가중치는 크기와 상관없이 전송될 패킷의 특정 수를 나타냅니다.

3550은 패킷당 WRR을 구현하므로 이 동작은 다음 섹션의 컨피그레이션에 적용됩니다.

-

Q1은 10개 중 1개의 패킷을 전송합니다.

-

Q2는 10개 중 2개의 패킷을 전송합니다.

-

Q3는 10개 중 3개의 패킷을 전송합니다.

-

Q4는 10개 중 4개의 패킷을 전송합니다.

전송할 패킷의 크기는 모두 같을 수 있습니다.4개의 대기열 간에 대역폭을 공유할 수 있습니다.그러나 평균 패킷 크기가 대기열 간에 다른 경우 혼잡 시 전송 및 삭제되는 항목에 큰 영향을 미칩니다.

예를 들어, 스위치에 두 개의 플로우만 있다고 가정합니다.가정적으로 다음과 같은 조건이 있다고 가정합니다.

-

CoS가 3인 1Gbps의 작은 대화형 애플리케이션 트래픽(80바이트[B] 프레임)이 Q2에 배치됩니다.

-

CoS가 0인 1Gbps의 대용량 파일 전송 트래픽(1518-B 프레임)이 Q1에 배치됩니다.

스위치에서 2개의 대기열이 1Gbps의 데이터와 함께 전송됩니다.

두 스트림 모두 동일한 출력 Gigabit 포트를 공유해야 합니다.Q1과 Q2 간에 동일한 가중치가 구성된다고 가정합니다. WRR은 패킷당 적용되며 각 대기열에서 전송되는 데이터의 양은 두 대기열 간에 다릅니다.각 큐에서 동일한 수의 패킷이 전달되지만 스위치는 실제로 다음과 같은 양의 데이터를 전송합니다.

-

Q2 중 7700 pps(초당 패킷) = (77700 x 8 x 64) bits per second(bps)(약 52Mbps)

-

Q1 중 7,700pps = (7700 x 8 x 1500) bps(약 948Mbps)

팁

-

네트워크에 대한 각 큐에 대해 공정한 액세스를 허용하려면 각 패킷의 평균 크기를 고려하십시오.각 패킷은 하나의 대기열에 배치되고 그에 따라 가중치가 수정됩니다.예를 들어, 모든 대기열이 대역폭의 1/4를 가지도록 4개의 대기열 각각에 동일한 액세스 권한을 부여하려면 트래픽은 다음과 같습니다.

-

1분기:최선의 인터넷 트래픽.트래픽의 평균 패킷 크기는 256B라고 가정합니다.

-

2분기:주로 1500B의 패킷과 함께 파일 전송으로 구성된 백업

-

3분기:192 B 패킷에서 수행되는 비디오 스트림

-

4분기:주로 64B 패킷으로 구성된 대화형 애플리케이션입니다.

이렇게 하면 다음과 같은 조건이 생성됩니다.

-

Q1은 Q4의 대역폭의 4배를 소비합니다.

-

Q2는 Q4의 24배에 달하는 대역폭을 사용합니다.

-

Q3는 Q4의 대역폭의 3배에 달합니다.

-

-

네트워크에 대한 동일한 대역폭 액세스를 가지려면 다음을 구성합니다.

-

Q1(가중치가 6)

-

가중치가 1인 Q2

-

Q3 가중치 8

-

Q4 가중치 24

-

-

이러한 가중치를 할당하면 혼잡 시 4개의 대기열 간에 동일한 대역폭 공유를 얻을 수 있습니다.

-

엄격한 우선 순위 큐가 활성화된 경우 WRR 가중치는 나머지 세 개의 큐 간에 재배포됩니다.엄격한 우선순위 큐가 활성화되어 있고 Q4가 구성되지 않은 경우 가중치가 1, 2, 3 및 4인 첫 번째 예는 다음과 같습니다.

-

Q1 = 1 / (1+2+3) = 6개 중 1개 패킷

-

Q2 = 6개 중 2개 패킷

-

Q3 = 6개 중 3개 패킷

대기열 가중치를 확인하기 위해 이 Cisco IOS Software show 명령을 실행할 수 있습니다.

NifNif#show mls qos interface gigabitethernet0/1 queueing GigabitEthernet0/1 QoS is disabled. Only one queue is used When QoS is enabled, following settings will be applied Egress expedite queue: dis wrr bandwidth weights: qid-weights 1 - 25 2 - 25 3 - 25 4 - 25

신속 처리 우선순위 대기열이 활성화된 경우 신속 처리 대기열이 비활성화된 경우에만 Q4 가중치가 사용됩니다.예를 들면 다음과 같습니다.

NifNif#show mls qos interface gigabitethernet0/1 queueing GigabitEthernet0/1 Egress expedite queue: ena wrr bandwidth weights: qid-weights 1 - 25 2 - 25 3 - 25 4 - 25 !--- The expedite queue is disabled.

-

Catalyst 3550 스위치의 WRED

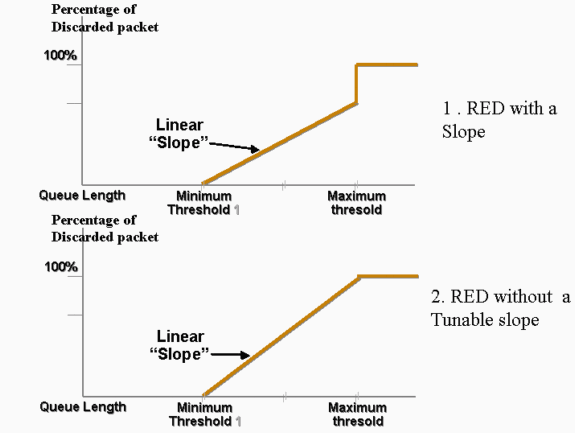

WRED는 3550 시리즈 스위치의 기가비트 포트에서만 사용할 수 있습니다.WRED는 RED(Random Early Detection)의 수정으로, 혼잡 방지에 사용됩니다.RED에는 다음 매개변수가 정의되어 있습니다.

-

최소 임계값:큐 내의 임계값을 나타냅니다.이 임계값 아래로 삭제된 패킷이 없습니다.

-

최대(최대) 임계값:큐 내의 다른 임계값을 나타냅니다.모든 패킷은 최대 임계값 이상으로 삭제됩니다.

-

기울기:최소 및 최대 사이의 패킷을 삭제할 확률드롭 확률을 대기열 크기와 함께 선형으로 증가(특정 경사 사용)

이 그래프는 RED 대기열에 있는 패킷의 삭제 가능성을 보여줍니다.

참고: RED를 구현하는 모든 Catalyst 스위치를 사용하여 슬로프를 조정할 수 있습니다.

WRED에서는 여러 서비스에 가중치가 적용됩니다.표준 서비스와 프리미엄 서비스를 정의할 수 있습니다.각 서비스는 서로 다른 임계값 집합을 수신합니다.최소 임계값 1에 도달하면 표준 서비스에 할당된 패킷만 삭제됩니다.최소 임계값 2에 도달하면 프리미엄 서비스의 패킷만 삭제되기 시작합니다.최소 임계값 2가 최소 임계값 1보다 높으면 표준 서비스의 패킷이 프리미엄 서비스의 패킷보다 더 많이 삭제됩니다.다음 그래프는 WRED가 있는 각 서비스에 대한 삭제 확률의 예를 보여줍니다.

참고: 3550 스위치에서는 최소 임계값을 조정할 수 없지만 최대 임계값만 조정할 수 있습니다.최소 임계값은 항상 0으로 설정됩니다. 3550에서 현재 구현된 것을 나타내는 삭제 가능성을 제공합니다.

3550에서 WRED에 대해 활성화된 모든 대기열은 항상 0이 아닌 삭제 가능성이 있으며 항상 패킷을 삭제합니다.이는 최소 임계값이 항상 0이기 때문입니다. 패킷이 최대 속도로 삭제되는 것을 방지하려면 가중치 tail drop을 사용합니다. 이 drop은 Catalyst 3550 스위치의 Tail Drop 섹션에서 설명합니다.

팁: Cisco 버그 ID CSCdz73556 ![]() (등록된 고객만 해당)은 최소 임계값 컨피그레이션에 대한 개선 요청을 문서화합니다.

(등록된 고객만 해당)은 최소 임계값 컨피그레이션에 대한 개선 요청을 문서화합니다.

RED 및 WRED에 대한 자세한 내용은 혼잡 회피 개요를 참조하십시오.

3550에서는 두 개의 다른 서비스를 제공하기 위해 서로 다른 두 개의 최대 임계값으로 WRED를 구성할 수 있습니다.두 임계값 중 하나에 서로 다른 유형의 트래픽이 할당되며, 이는 내부 DSCP에만 따라 달라집니다.이는 패킷의 CoS에만 의존하는 대기열 할당과 다릅니다.DSCP-to-threshold 테이블 매핑은 64개의 DSCP의 각 임계값을 결정합니다.이 테이블을 보고 수정하려면 다음 명령을 실행할 수 있습니다.

(config-if)#wrr-queue dscp-map threshold_number DSCP_1 DSCP_2 DSCP_8

예를 들어 이 명령은 DSCP 26을 임계값 2에 할당합니다.

NifNif(config-if)#wrr-queue dscp-map 2 26

NifNif#show mls qos interface gigabitethernet0/1 queueing

GigabitEthernet0/1

Dscp-threshold map:

d1 : d2 0 1 2 3 4 5 6 7 8 9

---------------------------------------

0 : 01 01 01 01 01 01 01 01 01 01

1 : 01 01 01 01 01 01 02 01 01 01

2 : 01 01 01 01 02 01 02 01 01 01

3 : 01 01 01 01 01 01 01 01 01 01

4 : 02 01 01 01 01 01 02 01 01 01

5 : 01 01 01 01 01 01 01 01 01 01

6 : 01 01 01 01

DSCP-to-threshold 맵의 정의 후 선택한 대기열에서 WRED가 활성화됩니다.다음 명령을 실행합니다.

(config-if)#wrr-queue random-detect max-threshold queue_id threshold_1 threshold_2

이 예에서는 다음을 구성합니다.

-

임계값 1 = 50% 및 임계값 2 = 100%인 Q1

-

임계값 1 = 70% 및 임계값 2 = 100%인 Q2

3550(config)#interface gigabitethernet 0/1 3550(config-if)#wrr-queue random-detect max-threshold 1 50 100 3550(config-if)#wrr-queue random-detect max-threshold 2 70 100 3550(config-if)#wrr-queue random-detect max-threshold 3 50 100 3550(config-if)#wrr-queue random-detect max-threshold 4 70 100

각 대기열에서 대기 유형(WRED 또는 not)을 확인하기 위해 이 명령을 실행할 수 있습니다.

nifnif#show mls qos interface gigabitethernet0/1 buffers GigabitEthernet0/1 .. qid WRED thresh1 thresh2 1 dis 10 100 2 dis 10 100 3 ena 10 100 4 dis 100 100

ena는 enable을 의미하며 대기열은 WRED를 사용합니다.disable을 의미하며 대기열에서 tail drop을 사용합니다.

각 임계값에 대해 삭제된 패킷 수를 모니터링할 수도 있습니다.다음 명령을 실행합니다.

show mls qos interface gigabitethernetx/x statistics

WRED drop counts:

qid thresh1 thresh2 FreeQ

1 : 327186552 8 1024

2 : 0 0 1024

3 : 37896030 0 1024

4 : 0 0 1024

Catalyst 3550 스위치의 tail Drop

기가비트 포트의 3550에서 tail drop은 기본 메커니즘입니다.각 기가비트 포트에는 두 개의 tail drop 임계값이 있을 수 있습니다.DSCP 집합은 이 문서의 Catalyst 3550 스위치 섹션에서 정의하는 동일한 DSCP 임계값 맵을 사용하여 각 tail 삭제 임계값에 할당됩니다.임계값에 도달하면 해당 임계값에 할당된 DSCP가 있는 모든 패킷이 삭제됩니다.tail drop 임계값을 구성하려면 다음 명령을 실행할 수 있습니다.

(config-if)#wrr-queue threshold queue-id threshold-percentage1 threshold-percentage2

이 예에서는 다음을 구성합니다.

-

tail drop threshold 1 = 50% 및 threshold 2 = 100%의 Q1

-

임계값 1 = 70% 및 임계값 2 = 100%인 Q2

Switch(config-if)#wrr-queue threshold 1 50 100 Switch(config-if)#wrr-queue threshold 2 70 100 Switch(config-if)#wrr-queue threshold 3 60 100 Switch(config-if)#wrr-queue threshold 4 80 100

기가비트 포트의 대기열 크기 구성

3550 스위치는 중앙 버퍼링을 사용합니다.즉 포트당 고정 버퍼 크기가 없습니다.그러나 Gigabit 포트에는 대기열에 추가할 수 있는 고정 패킷 수가 있습니다.이 고정 번호는 4096입니다.기본적으로 기가비트 포트의 각 대기열은 패킷 크기에 관계없이 최대 1024개의 패킷을 가질 수 있습니다.그러나 이러한 4096 패킷이 4개의 큐 사이에서 분할되는 방식을 수정할 수 있습니다.다음 명령을 실행합니다.

wrr-queue queue-limit Q_size1 Q_size2 Q_size3 Q_size4

예를 들면 다음과 같습니다.

3550(config)#interface gigabitethernet 0/1 3550(config-if)#wrr-queue queue-limit 4 3 2 1

이러한 대기열 크기 매개변수는 상대적입니다.이 예에서는 다음을 보여 줍니다.

-

Q1은 Q4보다 4배 큽니다.

-

Q2는 Q4보다 3배 큽니다.

-

Q3는 Q4보다 2배 큽니다.

4096 패킷은 다음과 같은 방법으로 재배포됩니다.

-

Q1 = [4 / (1+2+3+4)] * 4096 = 1639 패킷

-

Q2 = 0.3 * 4096 = 1229 패킷

-

Q3 = 0.2 * 4096 = 819 패킷

-

Q4 = 0.1 * 4096 = 409개 패킷

이 명령을 사용하면 4개의 대기열 중에서 분할 버퍼의 상대적 가중치를 볼 수 있습니다.

cat3550#show mls qos interface buffers GigabitEthernet0/1 Notify Q depth: qid-size 1 - 4 2 - 3 3 - 2 4 - 1 ...

또한 각 큐에서 유지할 수 있는 여유 패킷 수를 확인하기 위해 이 명령을 실행할 수 있습니다.

(config-if)#show mls qos interface gigabitethernetx/x statistics

WRED drop counts:

qid thresh1 thresh2 FreeQ

1 : 0 0 1639

2 : 0 0 1229

3 : 0 0 819

4 : 0 0 409

FreeQ count 매개 변수가 동적입니다.FreeQ 카운터는 최대 큐 크기를 빼고 현재 대기열에 있는 패킷 수를 제공합니다.예를 들어, Q1에 현재 39개의 패킷이 있는 경우 FreeQ 카운트에서 1,600개의 패킷이 무료입니다.예를 들면 다음과 같습니다.

(config-if)#show mls qos interface gigabitethernetx/x statistics

WRED drop counts:

qid thresh1 thresh2 FreeQ

1 : 0 0 1600

2 : 0 0 1229

3 : 0 0 819

4 : 0 0 409

비기가비트 포트의 대기열 관리 및 대기열 크기

10/100Mbps 포트에서 사용할 수 있는 대기열 관리 체계가 없습니다(2개의 임계값이 있는 WRED 또는 tail 드롭 없음). 4개의 대기열 모두 FIFO 대기열입니다.또한 각 기가비트 포트에 대해 4096개의 패킷을 예약하는 최대 큐 크기는 없습니다.10/100Mbps 포트는 리소스가 부족하여 패킷이 가득 찰 때까지 각 큐에 패킷을 저장합니다.대기열당 최소 패킷 수를 예약할 수 있습니다.이 최소값은 기본적으로 대기열당 100개의 패킷으로 설정됩니다.서로 다른 최소 예약 값을 정의하고 각 대기열에 값 중 하나를 지정하는 경우 각 대기열에 대해 이 최소 예약 값을 수정할 수 있습니다.

이 수정을 위해 다음 단계를 완료합니다.

-

각 전역 최소 예약 값에 대해 버퍼 크기를 할당합니다.

최대 8개의 최소 예약 값을 구성할 수 있습니다.다음 명령을 실행합니다.

(Config)# mls qos min-reserve min-reserve-level min-reserve-buffersize이러한 최소 예약 값은 스위치에 전역적으로 적용됩니다.기본적으로 모든 최소 예약 값은 100개의 패킷으로 설정됩니다.

예를 들어, 최소 예약 레벨 1/150 패킷과 최소 예약 레벨 2/50 패킷을 구성하려면 다음 명령을 실행합니다.

nifnif(config)#mls qos min-reserve ? <1-8> Configure min-reserve level nifnif(config)#mls qos min-reserve 1 ? <10-170> Configure min-reserve buffers nifnif(config)#mls qos min-reserve 1 150 nifnif(config)#mls qos min-reserve 2 50

-

각 대기열에 최소 예약 값 중 하나를 할당합니다.

이 대기열에 대해 보장된 버퍼 수를 확인하려면 각 대기열을 최소 예약 값 중 하나에 할당해야 합니다.기본적으로 다음 조건이 적용됩니다.

-

Q1은 최소 예약 레벨 1에 할당됩니다.

-

Q2는 최소 예약 레벨 2에 할당됩니다.

-

3분기는 최소 예약 레벨 3에 할당됩니다.

-

Q4는 최소 예약 레벨 4에 할당됩니다.

기본적으로 모든 최소 예약 값은 100입니다.

대기열당 다른 최소 예약 값을 할당하려면 이 interface 명령을 실행할 수 있습니다.

(config-if)#wrr-queue min-reserve queue-id min-reserve-level예를 들어 Q1에 최소 예약 2를 지정하고 Q2에 최소 예약 1을 할당하려면 다음 명령을 실행합니다.

nifnif(config)#interface fastethernet 0/1 nifnif(config-if)#wrr-queue min-reserve ? <1-4> queue id nifnif(config-if)#wrr-queue min-reserve 1 ? <1-8> min-reserve level nifnif(config-if)#wrr-queue min-reserve 1 2 nifnif(config-if)#wrr-queue min-reserve 2 1

다음과 같은 최소 예약 할당을 확인하려면 이 명령을 실행할 수 있습니다.

nifnif#show mls qos interface fastethernet0/1 buffers FastEthernet0/1 Minimum reserve buffer size: 150 50 100 100 100 100 100 100 !--- This shows the value of all eight min reserve levels. Minimum reserve buffer level select: 2 1 3 4 !--- This shows the min reserve level that is assigned to !--- each queue (from Q1 to Q4).

-

결론

3550의 포트에서 대기 및 스케줄링에는 다음 단계가 포함됩니다.

-

큐 중 하나에 각 CoS를 할당합니다.

-

필요한 경우 엄격한 우선 순위 큐를 활성화합니다.

-

WRR 가중치를 할당하고 대기열 내의 예상 패킷 크기를 고려합니다.

-

큐 크기를 수정합니다(기가비트 포트만 해당).

-

대기열 관리 메커니즘(기가비트 포트에서만 tail drop 또는 WRED)을 활성화합니다.

적절한 대기 및 스케줄링은 음성/비디오 트래픽의 지연/잡음을 줄이고 미션 크리티컬 트래픽의 손실을 방지할 수 있습니다.스케줄링 성능을 극대화하려면 다음 지침을 준수해야 합니다.

-

신뢰 또는 특정 표시를 사용하여 네트워크에 있는 트래픽을 서로 다른 클래스에 분류합니다.

-

경찰의 교통량이 너무 많다.

피드백

피드백