12000 시리즈 라우터의 "QM_SANITY_WARNING" 메시지 문제 해결

다운로드 옵션

편견 없는 언어

본 제품에 대한 문서 세트는 편견 없는 언어를 사용하기 위해 노력합니다. 본 설명서 세트의 목적상, 편견 없는 언어는 나이, 장애, 성별, 인종 정체성, 민족 정체성, 성적 지향성, 사회 경제적 지위 및 교차성에 기초한 차별을 의미하지 않는 언어로 정의됩니다. 제품 소프트웨어의 사용자 인터페이스에서 하드코딩된 언어, RFP 설명서에 기초한 언어 또는 참조된 서드파티 제품에서 사용하는 언어로 인해 설명서에 예외가 있을 수 있습니다. 시스코에서 어떤 방식으로 포용적인 언어를 사용하고 있는지 자세히 알아보세요.

이 번역에 관하여

Cisco는 전 세계 사용자에게 다양한 언어로 지원 콘텐츠를 제공하기 위해 기계 번역 기술과 수작업 번역을 병행하여 이 문서를 번역했습니다. 아무리 품질이 높은 기계 번역이라도 전문 번역가의 번역 결과물만큼 정확하지는 않습니다. Cisco Systems, Inc.는 이 같은 번역에 대해 어떠한 책임도 지지 않으며 항상 원본 영문 문서(링크 제공됨)를 참조할 것을 권장합니다.

소개

이 문서에서는 IOS를 실행하는 12000 시리즈 cisco 라우터의 여러 라인 카드에서 발생할 수 있는 패킷 버퍼 고갈 메시지를 디버깅하는 절차에 대해 설명합니다. GSR 버퍼 관리에 대한 지식이 부족하여 실제로 제대로 작동하는 하드웨어를 교체하는 데 귀중한 시간과 리소스가 낭비되는 것을 보는 것은 너무 흔합니다.

사전 요구 사항

요구 사항

Cisco 12000 Series Router 아키텍처에 대한 개요가 있어야 합니다.

사용되는 구성 요소

이 문서의 정보는 다음 소프트웨어 및 하드웨어 버전을 기반으로 합니다.

- Cisco 12000 Series 인터넷 라우터

- 기가비트 스위치 라우터를 지원하는 Cisco IOS® 소프트웨어 릴리스

이 문서의 정보는 특정 랩 환경의 디바이스를 토대로 작성되었습니다. 이 문서에 사용된 모든 디바이스는 지워진(기본) 컨피그레이션으로 시작됩니다. 현재 네트워크가 작동 중인 경우, 모든 명령어의 잠재적인 영향을 미리 숙지하시기 바랍니다.

표기 규칙

문서 규칙에 대한 자세한 내용은 Cisco 기술 팁 표기 규칙을 참고하십시오.

문제

GSR 또는 12000 시리즈 cisco 라우터는 진정으로 분산된 아키텍처를 가지고 있습니다. 즉, 각 LC는 Cisco IOS 소프트웨어 이미지의 자체 사본을 실행하며 패킷 전달 결정을 자체적으로 완료할 수 있는 인텔리전스를 보유하고 있습니다. 각 라인 카드는 자체적으로 작동합니다

- 전달 조회

- 패킷 버퍼 관리

- QOS

- 플로우 제어

GSR에서 패킷 스위칭 중 가장 중요한 작업 중 하나는 라인 카드에 있는 다양한 BMA(Buffer Management ASIC)에 의해 수행되는 버퍼 관리입니다. 다음은 프로덕션 중에 라우터 로그에 표시될 수 있는 GSR 버퍼 관리와 관련된 몇 가지 메시지입니다. 다음 섹션에서는 이러한 메시지가 라우터 로그에 표시되도록 할 수 있는 다양한 트리거와 문제를 완화하기 위해 수행해야 할 해결 조치에 대해 설명합니다. 일부 상황에서는 프로토콜 플랩으로 나타날 수 있는 패킷 손실도 발생할 수 있으며, 이는 네트워크에 영향을 미칠 수 있습니다.

%EE48-3-QM_SANITY_WARNING: ToFab FreeQ buffers depleted

SLOT 1:Sep 16 19:06:40.003 UTC: %EE48-3-QM_SANITY_WARNING: Few free buffers(1) are available in ToFab FreeQ pool# 2

SLOT 8:Sep 16 19:06:45.943 UTC: %EE48-3-QM_SANITY_WARNING: Few free buffers(0) are available in ToFab FreeQ pool# 1

SLOT 0:Sep 16 19:06:46.267 UTC: %EE48-3-QM_SANITY_WARNING: Few free buffers(2) are available in ToFab FreeQ pool# 2

SLOT 8:Sep 16 19:06:47.455 UTC: %EE48-3-QM_SANITY_WARNING: ToFab FreeQ buffers depleted. Recarving the ToFab buffers

SLOT 8:Sep 16 19:06:47.471 UTC: %EE192-3-BM_QUIESCE:

솔루션

배경

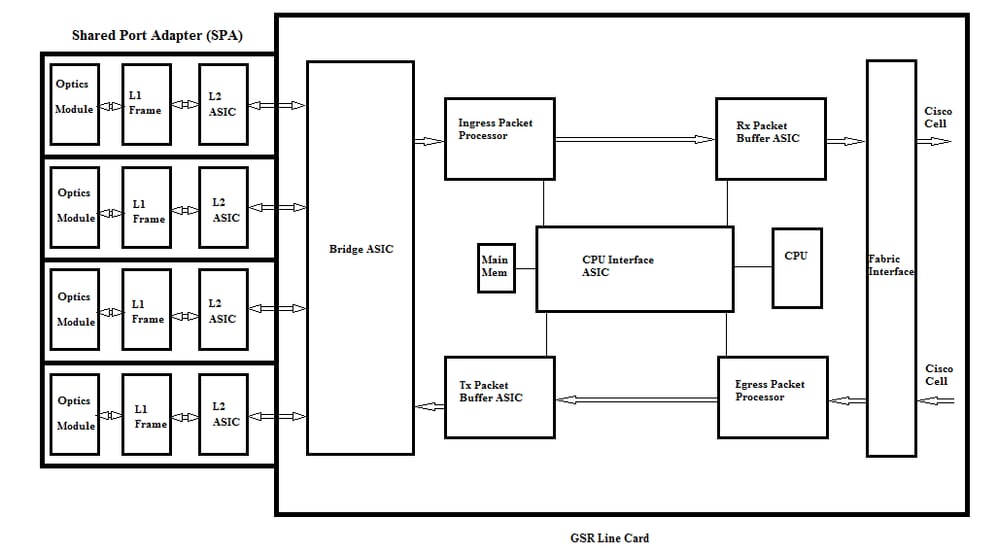

QM-SANITY 경고 오류를 해결하려면 GSR 라인 카드의 패킷 흐름을 이해해야 합니다. 아래 그림에서는 C12k 라인 카드의 기본 블록 및 패킷 흐름 경로에 대해 설명합니다.

Cisco 12000 Series Internet Router의 LC(Line Card)에는 두 가지 유형의 메모리가 있습니다.

- 라우트 또는 프로세서 메모리(동적 RAM - DRAM): 주로 온보드 프로세서에서 Cisco IOS 소프트웨어를 실행하고 네트워크 라우팅 테이블(Forwarding Information Base - FIB, adjacency)을 저장할 수 있는 메모리입니다.

- 패킷 메모리(동기식 동적 RAM - SDRAM): 라인 카드 패킷 메모리는 라인 카드 프로세서에 의한 스위칭 결정을 기다리는 데이터 패킷을 임시로 저장합니다.

위 이미지에서 볼 수 있듯이, GSR 라인 카드에는 패킷 메모리에 대한 액세스를 제공하는 트래픽 흐름의 각 방향에 하나씩 특수 패킷 버퍼 ASIC(Application Specific Integrated Circuit)가 있습니다. BMA(Buffer Management ASIC)라고도 하는 이러한 ASIC는 라인 카드에서 패킷 버퍼링 및 버퍼 대기열 관리 기능을 수행합니다. 높은 처리량/포워딩 속도를 지원하기 위해 어느 방향의 패킷 메모리는 다양한 MTU 크기의 패킷을 전달하도록 설계된 다양한 크기의 메모리 풀에 조각됩니다.

PLIM(Physical Layer Interface Module) 카드에서 수신한 프레임은 레이어 2로 처리되고 PLIM 카드의 로컬 메모리로 DMAed됩니다. 수신된 데이터 유닛이 완료되면 PLIM의 ASIC가 인그레스 BMA에 연결하여 적절한 크기의 버퍼를 요청합니다. 버퍼가 부여된 경우 패킷은 라인 카드 인그레스 패킷 메모리로 이동합니다. 사용 가능한 버퍼가 없는 경우 패킷이 삭제되고 무시된 인터페이스 카운터가 올라갑니다. 인그레스 패킷 프로세서는 패킷에 대해 처리 기능을 수행하고, 전달 결정을 내리고, 패킷을 이그레스 라인 카드에 해당하는 toFab 대기열로 이동합니다. FIA(Fabric Interface ASIC)는 패킷을 시스코 셀로 분할하고, 해당 셀은 스위치 패브릭으로 전송됩니다. 그런 다음 패킷은 이그레스 라인 카드의 FIA에 의해 스위치 패브릭에서 수신되며 Frfab 큐로 이동하여 리어셈블된 다음 이그레스 PLIM으로 이동한 다음 최종적으로 유선으로 전송됩니다.

특정 버퍼 풀에서 버퍼를 선택하는 FrFab BMA의 결정은 인그레스 라인 카드 스위칭 엔진에 의한 결정에 기초합니다. 전체 상자의 모든 대기열이 같은 크기 및 순서로 되어 있으므로 스위칭 엔진은 전송 LC에 패킷을 라우터에 들어온 동일한 번호의 대기열에 넣으라고 지시합니다.

패킷이 전환되는 동안 패킷을 이동하는 데 사용된 인그레스 라인 카드의 특정 버퍼 풀의 큐 크기는 이그레스 라인 카드의 BMA가 버퍼를 반환할 때까지 1씩 감소합니다. 또한 전체 버퍼 관리는 버퍼 관리 ASIC가 하드웨어에서 수행하며, 결함이 적은 운영을 위해서는 BMA가 원래 풀에서 소싱한 원래 풀로 버퍼를 반환해야 합니다.

GSR 패킷 버퍼 관리가 패킷 손실로 이어지는 스트레스 또는 장애를 경험할 수 있는 세 가지 시나리오가 있습니다. 다음은 세 가지 시나리오입니다.

시나리오 1:

하드웨어 대기열 관리가 실패합니다. 이그레스 BMA가 패킷 버퍼를 반환하지 못하거나 패킷 버퍼를 잘못된 버퍼 풀로 반환할 때 이 문제가 발생합니다. 버퍼가 잘못된 풀로 반환되면 일부 버퍼 풀이 증가하고 일부 버퍼 풀이 일정 기간 동안 감소하여 결국 버퍼 풀 크기가 감소한 패킷이 영향을 받는 것을 볼 수 있습니다. 패킷 버퍼가 고갈되고 경고 임계값을 초과하면 QM-Sanity 경고가 표시됩니다.

QM sanity debugs and show controllers to fab queues 명령을 사용하여 이 조건의 영향을 받았는지 확인합니다. QM 온전성 임계값을 활성화하는 방법을 알아보려면 문제 해결 섹션을 참조하십시오.

이 상태는 일반적으로 하드웨어 결함으로 인해 발생합니다. 라우터의 아래 출력을 확인하고 패리티 오류 또는 라인 카드 충돌을 확인합니다. 라인 카드를 교체하는 것이 해결책입니다.

show controllers fia

show context all

show log

예:

QM 무결성 디버깅 및 show controller tofab 대기열에서 풀 2의 크기는 커지지만 풀 4는 낮게 실행되고 있음을 확인할 수 있습니다. 이는 풀 4에서 버퍼를 손실하고 있으며 풀 2로 반환되고 있음을 나타냅니다.

QM 무결성 디버깅:

SLOT 5:Oct 25 04:41:03.286 UTC: Pool 1: Carve Size 102001: Current Size 73078

SLOT 5:Oct 25 04:41:03.286 UTC: Pool 2: Carve Size 78462: Current Size 181569

SLOT 5:Oct 25 04:41:03.286 UTC: Pool 3: Carve Size 57539: Current Size 6160

SLOT 5:Oct 25 04:41:03.286 UTC: Pool 4: Carve Size 22870: Current Size 67

SLOT 5:Oct 25 04:41:03.286 UTC: IPC FreeQ: Carve Size 600: Current Size 600

fab 큐에 컨트롤러 표시:

Qnum Head Tail #Qelem LenThresh

---- ---- ---- ------ ---------

4 non-IPC free queues:

102001/102001 (buffers specified/carved), 39.1%, 80 byte data size

1 13542 13448 73078 262143

78462/78462 (buffers specified/carved), 30.0%, 608 byte data size

2 131784 131833 181569 262143

57539/57539 (buffers specified/carved), 22.0%, 1616 byte data size

3 184620 182591 6160 262143

23538/22870 (buffers specified/carved), 8.74%, 4592 byte data size

4 239113 238805 67 262143

시나리오 2:

다음 홉 디바이스 또는 전달 경로의 트래픽 혼잡. 이 시나리오에서 GSR이 트래픽을 피딩하는 디바이스는 GSR 속도로 처리할 수 없으므로 다음 홉 디바이스는 GSR로 일시 중지 프레임을 전송하여 속도를 낮춰달라고 요청합니다. GSR PLIM 카드에서 흐름 제어가 활성화된 경우 라우터는 일시 중지 프레임을 적용하고 패킷 버퍼링을 시작합니다. 결국 라우터에 버퍼가 부족하여 QM 온전성 오류 메시지 및 패킷이 삭제됩니다. 패킷 버퍼가 고갈되고 경고 임계값을 초과하면 QM-Sanity 경고가 표시됩니다. QM 온전성 임계값을 찾는 방법은 문제 해결 섹션을 참조하십시오.

라우터가 이 시나리오의 영향을 받는지 확인하려면 이그레스 인터페이스의 show interface 출력을 사용합니다. 아래 캡처에서는 일시 중지 프레임을 수신하는 인터페이스의 예를 보여줍니다. 실행 계획은 다음 홉 디바이스에서 혼잡의 원인을 살펴보는 것입니다.

GigabitEthernet6/2 is up, line protocol is up

Small Factor Pluggable Optics okay

Hardware is GigMac 4 Port GigabitEthernet, address is 000b.455d.ee02 (bia 000b.455d.ee02)

Description: Cisco Sydney Lab

Internet address is 219.158.33.86/30

MTU 1500 bytes, BW 500000 Kbit, DLY 10 usec, rely 255/255, load 154/255

Encapsulation ARPA, loopback not set

Keepalive set (10 sec)

Full Duplex, 1000Mbps, link type is force-up, media type is LX

output flow-control is on, input flow-control is on

ARP type: ARPA, ARP Timeout 04:00:00

Last input 00:00:02, output 00:00:02, output hang never

Last clearing of "show interface" counters 7w1d

Queueing strategy: random early detection (WRED)

Output queue 0/40, 22713601 drops; input queue 0/75, 736369 drops

Available Bandwidth 224992 kilobits/sec

30 second input rate 309068000 bits/sec, 49414 packets/sec

30 second output rate 303400000 bits/sec, 73826 packets/sec

143009959974 packets input, 88976134206186 bytes, 0 no buffer

Received 7352 broadcasts, 0 runts, 0 giants, 0 throttles

0 input errors, 0 CRC, 0 frame, 0 overrun, 0 ignored

0 watchdog, 7352 multicast, 45 pause input

234821393504 packets output, 119276570730993 bytes, 0 underruns

Transmitted 73201 broadcasts

0 output errors, 0 collisions, 0 interface resets

0 babbles, 0 late collision, 0 deferred

0 lost carrier, 0 no carrier, 0 pause output

0 output buffer failures, 0 output buffers swapped out

시나리오 3:

열악한 네트워크 설계/트래픽 버스트/DOS 공격으로 인해 초과 유입 시 라인 카드가 처리할 수 있는 것보다 더 많은 트래픽이 라우터로 전달되는 높은 트래픽 상태가 지속되는 경우 QM Sanity 경고가 발생할 수 있습니다.

이를 해결하려면 라우터의 모든 인터페이스에서 트래픽 속도를 확인합니다. 그러면 고속 링크 중 하나가 저속 링크를 혼잡하게 만들고 있는지 여부가 표시됩니다.

show interface output 명령을 사용합니다.

명령 문제 해결

LC에 대한 현재 QM 무결성 수준 확인하기

-

LC에 연결

-

활성화 모드로 이동

-

Run test fab 명령

-

"qm_sanity_info"의 출력을 수집합니다.

-

옵션 q - 테스트 fab 명령줄 종료

-

LC에서 끝내기

QM 무결성 매개변수를 구성하려면

- 컨피그레이션 모드로 변경

- hw-module slot <slot#> qm-sanity tofab warning freq <> 실행

QM 무결성 디버그를 활성화/비활성화하려면

- LC에 연결

-

활성화 모드로 이동

-

Run test fab 명령

-

"qm_sanity_debug"를 실행합니다. 다시 실행하면 디버그가 중지됩니다.

-

옵션 q - 테스트 fab 명령줄 종료

-

LC에서 끝내기

GSR 패브릭 인터페이스 asic 통계를 확인하려면

- 컨트롤러 fia 표시

Tofab 대기열을 확인하려면

- fab 큐에 컨트롤러 표시

Frfab 쿼리를 확인하려면

- 컨트롤러 frafab 큐 표시

예:

아래 출력은 작업 중인 Lab 라우터에서 가져와 명령 출력을 데모합니다.

GSR-1-PE-5#show controller fia

Fabric configuration: 10Gbps bandwidth (2.4Gbps available), redundant fabric

Master Scheduler: Slot 17 Backup Scheduler: Slot 16

Fab epoch no 0 Halt count 0

From Fabric FIA Errors

-----------------------

redund overflow 0 cell drops 0

cell parity 0

Switch cards present 0x001F Slots 16 17 18 19 20

Switch cards monitored 0x001F Slots 16 17 18 19 20

Slot: 16 17 18 19 20

Name: csc0 csc1 sfc0 sfc1 sfc2

-------- -------- -------- -------- --------

los 0 0 0 0 0

state Off Off Off Off Off

crc16 0 0 0 0 0

To Fabric FIA Errors

-----------------------

sca not pres 0 req error 0 uni fifo overflow 0

grant parity 0 multi req 0 uni fifo undrflow 0

cntrl parity 0 uni req 0

multi fifo 0 empty dst req 0 handshake error 0

cell parity 0

GSR-1-PE-5#attach 1

Entering Console for Modular SPA Interface Card in Slot: 1

Type "exit" to end this session

Press RETURN to get started!

LC-Slot1>en

LC-Slot1#test fab

BFLC diagnostic console program

BFLC (? for help) [?]: qm_sanity_debug

QM Sanity Debug enabled

BFLC (? for help) [qm_sanity_debug]:

SLOT 1:02:54:33: ToFAB BMA information

SLOT 1:02:54:33: Number of FreeQs carved 4

SLOT 1:02:54:33: Pool 1: Carve Size 102001: Current Size 102001

SLOT 1:02:54:33: Pool 2: Carve Size 78462: Current Size 78462

SLOT 1:02:54:33: Pool 3: Carve Size 57539: Current Size 57539

SLOT 1:02:54:33: Pool 4: Carve Size 22870: Current Size 22870

SLOT 1:02:54:33: IPC FreeQ: Carve Size 600: Current Size 600

SLOT 1:02:54:33: Number of LOQs enabled 768

SLOT 1:02:54:33: Number of LOQs disabled 1280

SLOT 1:02:54:33: ToFAB BMA information

SLOT 1:02:54:33: Number of FreeQs carved 4

SLOT 1:02:54:33: Pool 1: Carve Size 102001: Current Size 102001

SLOT 1:02:54:33: Pool 2: Carve Size 78462: Current Size 78462

SLOT 1:02:54:33: Pool 3: Carve Size 57539: Current Size 57539

SLOT 1:02:54:33: Pool 4: Carve Size 22870: Current Size 22870

SLOT 1:02:54:33: IPC FreeQ: Carve Size 600: Current Size 600

SLOT 1:02:54:33: Number of LOQs enabled 768

SLOT 1:02:54:33: Number of LOQs disabled 1280

QM Sanity Debug disabled

BFLC (? for help) [qm_sanity_debug]: qm_sanity_info

ToFab QM Sanity level Warning

FrFab QM Sanity level None

Sanity Check is triggered every 20 seconds

Min. buffers threshold in percentage 5

BFLC (? for help) [qm_sanity_info]: q

LC-Slot1#exi

Disconnecting from slot 1.

Connection Duration: 00:01:09

GSR-1-PE-5#config t

Enter configuration commands, one per line. End with CNTL/Z.

GSR-1-PE-5(config)#hw-module slot 1 qm-sanity tofab warning freq 10

GSR-1-PE-5(config)#end

GSR-1-PE-5#attach 1

02:57:25: %SYS-5-CONFIG_I: Configured from console by console

GSR-1-PE-5#attach 1

Entering Console for Modular SPA Interface Card in Slot: 1

Type "exit" to end this session

Press RETURN to get started!

LC-Slot1>en

LC-Slot1#test fab

BFLC diagnostic console program

BFLC (? for help) [?]: qm_sanity_info

ToFab QM Sanity level Warning

FrFab QM Sanity level None

Sanity Check is triggered every 10 seconds

Min. buffers threshold in percentage 5

BFLC (? for help) [qm_sanity_info]: q

LC-Slot1#exit

Disconnecting from slot 1.

Connection Duration: 00:00:27

GSR-1-PE-5#execute-on all show controllers tofab queues

========= Line Card (Slot 0) =========

Carve information for ToFab buffers

SDRAM size: 268435456 bytes, address: E0000000, carve base: E0018000

268337152 bytes carve size, 4 SDRAM bank(s), 16384 bytes SDRAM pagesize, 2 carve(s)

max buffer data size 4592 bytes, min buffer data size 80 bytes

262141/262141 buffers specified/carved

265028848/265028848 bytes sum buffer sizes specified/carved

Qnum Head Tail #Qelem LenThresh

---- ---- ---- ------ ---------

4 non-IPC free queues:

107232/107232 (buffers specified/carved), 40.90%, 80 byte data size

601 107832 107232 262143

73232/73232 (buffers specified/carved), 27.93%, 608 byte data size

107833 181064 73232 262143

57539/57539 (buffers specified/carved), 21.94%, 1616 byte data size

181065 238603 57539 262143

23538/23538 (buffers specified/carved), 8.97%, 4592 byte data size

238604 262141 23538 262143

IPC Queue:

600/600 (buffers specified/carved), 0.22%, 4112 byte data size

155 154 600 262143

Raw Queue (high priority):

0 0 0 65535

Raw Queue (medium priority):

0 0 0 32767

Raw Queue (low priority):

0 0 0 16383

ToFab Queues:

Dest Slot Queue# Head Tail Length Threshold

pkts pkts

==============================================================

0 0 0 0 0 262143

15 2191(hpr) 0 0 0 0

Multicast 2048 0 0 0 262143

2049 0 0 0 262143

========= Line Card (Slot 1) =========

Carve information for ToFab buffers

SDRAM size: 268435456 bytes, address: 26000000, carve base: 26010000

268369920 bytes carve size, 4 SDRAM bank(s), 32768 bytes SDRAM pagesize, 2 carve(s)

max buffer data size 4592 bytes, min buffer data size 80 bytes

262140/261472 buffers specified/carved

267790176/264701344 bytes sum buffer sizes specified/carved

Qnum Head Tail #Qelem LenThresh

---- ---- ---- ------ ---------

4 non-IPC free queues:

102001/102001 (buffers specified/carved), 39.1%, 80 byte data size

1 601 102601 102001 262143

78462/78462 (buffers specified/carved), 30.0%, 608 byte data size

2 102602 181063 78462 262143

57539/57539 (buffers specified/carved), 22.0%, 1616 byte data size

3 181064 238602 57539 262143

23538/22870 (buffers specified/carved), 8.74%, 4592 byte data size

4 238603 261472 22870 262143

IPC Queue:

600/600 (buffers specified/carved), 0.22%, 4112 byte data size

30 85 84 600 262143

Raw Queue (high priority):

27 0 0 0 65368

Raw Queue (medium priority):

28 0 0 0 32684

Raw Queue (low priority):

31 0 0 0 16342

ToFab Queues:

Dest Slot Queue# Head Tail Length Threshold

pkts pkts

=============================================================

::::::::::::::::::::

Hi Priority

0 2176(hpr) 0 0 0

1 2177(hpr) 0 0 0

2 2178(hpr) 0 0 0

3 2179(hpr) 0 0 0

4 2180(hpr) 553 552 0

5 2181(hpr) 0 0 0

6 2182(hpr) 0 0 0

7 2183(hpr) 0 0 0

8 2184(hpr) 0 0 0

9 2185(hpr) 0 0 0

10 2186(hpr) 0 0 0

11 2187(hpr) 0 0 0

12 2188(hpr) 0 0 0

13 2189(hpr) 0 0 0

14 2190(hpr) 0 0 0

15 2191(hpr) 0 0 0

Multicast

2048 0 0 0

2049 0 0 0

2050 0 0 0

2051 0 0 0

2052 0 0 0

2053 0 0 0

2054 0 0 0

2055 0 0 0

========= Line Card (Slot 3) =========

Carve information for ToFab buffers

SDRAM size: 268435456 bytes, address: E0000000, carve base: E0018000

268337152 bytes carve size, 4 SDRAM bank(s), 16384 bytes SDRAM pagesize, 2 carve(s)

max buffer data size 4112 bytes, min buffer data size 80 bytes

262142/262142 buffers specified/carved

230886224/230886224 bytes sum buffer sizes specified/carved

Qnum Head Tail #Qelem LenThresh

---- ---- ---- ------ ---------

3 non-IPC free queues:

94155/94155 (buffers specified/carved), 35.91%, 80 byte data size

601 94755 94155 262143

57539/57539 (buffers specified/carved), 21.94%, 608 byte data size

94756 152294 57539 262143

109848/109848 (buffers specified/carved), 41.90%, 1616 byte data size

152295 262142 109848 262143

IPC Queue:

600/600 (buffers specified/carved), 0.22%, 4112 byte data size

207 206 600 262143

Raw Queue (high priority):

0 0 0 65535

Raw Queue (medium priority):

0 0 0 32767

Raw Queue (low priority):

0 0 0 16383

ToFab Queues:

Dest Slot Queue# Head Tail Length Threshold

pkts pkts

==============================================================

0 0 0 0 0 262143

1 0 0 0 262143

2 0 0 0 262143

3 0 0 0 262143

:::::::::::::::::::::::::::

2049 0 0 0 262143

2050 0 0 0 262143

2051 0 0 0 262143

2052 0 0 0 262143

2053 0 0 0 262143

2054 0 0 0 262143

2055 0 0 0 262143

GSR-1-PE-5#execute-on slot 2 show controller frfab queues

========= Line Card (Slot 2) =========

Carve information for FrFab buffers

SDRAM size: 268435456 bytes, address: D0000000, carve base: D241D100

230567680 bytes carve size, 4 SDRAM bank(s), 16384 bytes SDRAM pagesize, 2 carve(s)

max buffer data size 4592 bytes, min buffer data size 80 bytes

235926/235926 buffers specified/carved

226853664/226853664 bytes sum buffer sizes specified/carved

Qnum Head Tail #Qelem LenThresh

---- ---- ---- ------ ---------

4 non-IPC free queues:

96484/96484 (buffers specified/carved), 40.89%, 80 byte data size

11598 11597 96484 262143

77658/77658 (buffers specified/carved), 32.91%, 608 byte data size

103116 103115 77658 262143

40005/40005 (buffers specified/carved), 16.95%, 1616 byte data size

178588 178587 40005 262143

21179/21179 (buffers specified/carved), 8.97%, 4592 byte data size

214748 235926 21179 262143

IPC Queue:

600/600 (buffers specified/carved), 0.25%, 4112 byte data size

66 65 600 262143

Multicast Raw Queue:

0 0 0 58981

Multicast Replication Free Queue:

235930 262143 26214 262143

Raw Queue (high priority):

78 77 0 235927

Raw Queue (medium priority):

11596 11595 0 58981

Raw Queue (low priority):

0 0 0 23592

Interface Queues:

Interface Queue# Head Tail Length Threshold

pkts pkts

======================================================

0 0 103107 103106 0 32768

3 178588 178587 0 32768

1 4 103110 103109 0 32768

7 11586 11585 0 32768

2 8 0 0 0 32768

11 0 0 0 32768

3 12 0 0 0 32768

15 0 0 0 32768

GSR-1-PE-5#

개정 이력

| 개정 | 게시 날짜 | 의견 |

|---|---|---|

1.0 |

30-Jul-2017 |

최초 릴리스 |

피드백

피드백