ASAv in GoTo (L3) Mode met het gebruik van AVS-ACI 1.2(x) release

Downloadopties

Inclusief taalgebruik

De documentatie van dit product is waar mogelijk geschreven met inclusief taalgebruik. Inclusief taalgebruik wordt in deze documentatie gedefinieerd als taal die geen discriminatie op basis van leeftijd, handicap, gender, etniciteit, seksuele oriëntatie, sociaaleconomische status of combinaties hiervan weerspiegelt. In deze documentatie kunnen uitzonderingen voorkomen vanwege bewoordingen die in de gebruikersinterfaces van de productsoftware zijn gecodeerd, die op het taalgebruik in de RFP-documentatie zijn gebaseerd of die worden gebruikt in een product van een externe partij waarnaar wordt verwezen. Lees meer over hoe Cisco gebruikmaakt van inclusief taalgebruik.

Over deze vertaling

Cisco heeft dit document vertaald via een combinatie van machine- en menselijke technologie om onze gebruikers wereldwijd ondersteuningscontent te bieden in hun eigen taal. Houd er rekening mee dat zelfs de beste machinevertaling niet net zo nauwkeurig is als die van een professionele vertaler. Cisco Systems, Inc. is niet aansprakelijk voor de nauwkeurigheid van deze vertalingen en raadt aan altijd het oorspronkelijke Engelstalige document (link) te raadplegen.

Inhoud

Inleiding

Dit document beschrijft hoe een AVS-switch (Application Virtual Switch) kan worden ingezet met één firewall voor adaptieve security virtuele applicatie (ASAv) in Routed/GOTO-modus als L4-L7 Service Graph tussen twee End Point-Groepen (EPG's) om client-naar-server communicatie op te zetten met ACI 1.2(x) release.

Voorwaarden

Vereisten

Cisco raadt u aan om kennis te hebben over deze onderwerpen:

- Toegangsbeleid ingesteld en interfaces ingesteld en in bedrijf

- reeds geconfigureerd EPG, Bridge Domain (BD) en Virtual Routing and Forwarding (VRF)

Gebruikte componenten

De informatie in dit document is gebaseerd op de volgende software- en hardware-versies:

Hardware en software:

- UCS C220 - 2.0(6d)

- ESXi/vCenter - 5.5

- ASAv - asa-toestel-pkg-1.2.4.8

- AVS - 5.2.1.SV3.1.10

- APIC - 1.2(1i)

- Leaf/Spines - 11.2(1i)

- Apparaatpakketten *.zip al gedownload

Functies:

- AVS

- ASAv

- EPG's, BD, VRF

- Toegangscontrolelijst (ACL)

- L4-L7 servicesdiagram

- vCenter

De informatie in dit document is gebaseerd op de apparaten in een specifieke laboratoriumomgeving. Alle apparaten die in dit document worden beschreven, hadden een opgeschoonde (standaard)configuratie. Als uw netwerk live is, moet u de potentiële impact van elke opdracht begrijpen.

Configureren

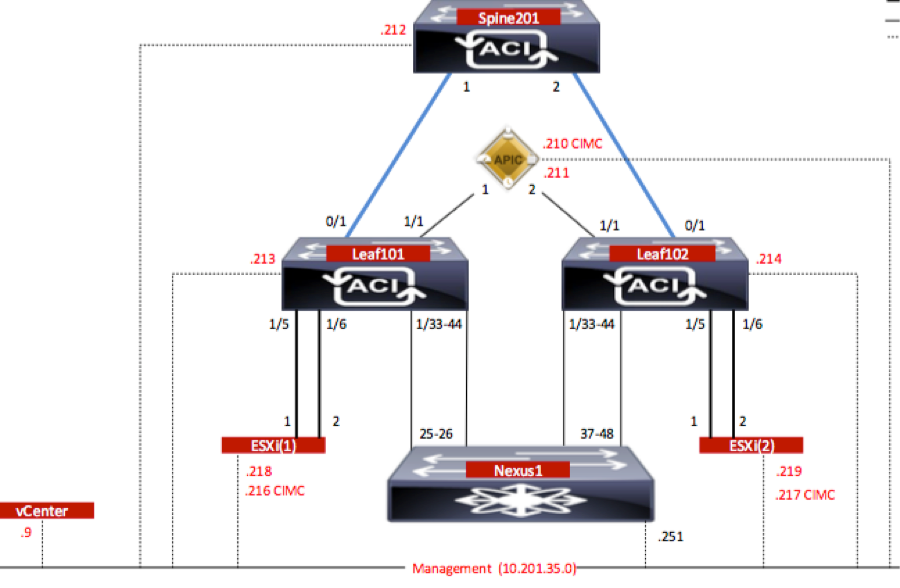

Netwerkdiagram

Zoals in de afbeelding wordt weergegeven,

Configuraties

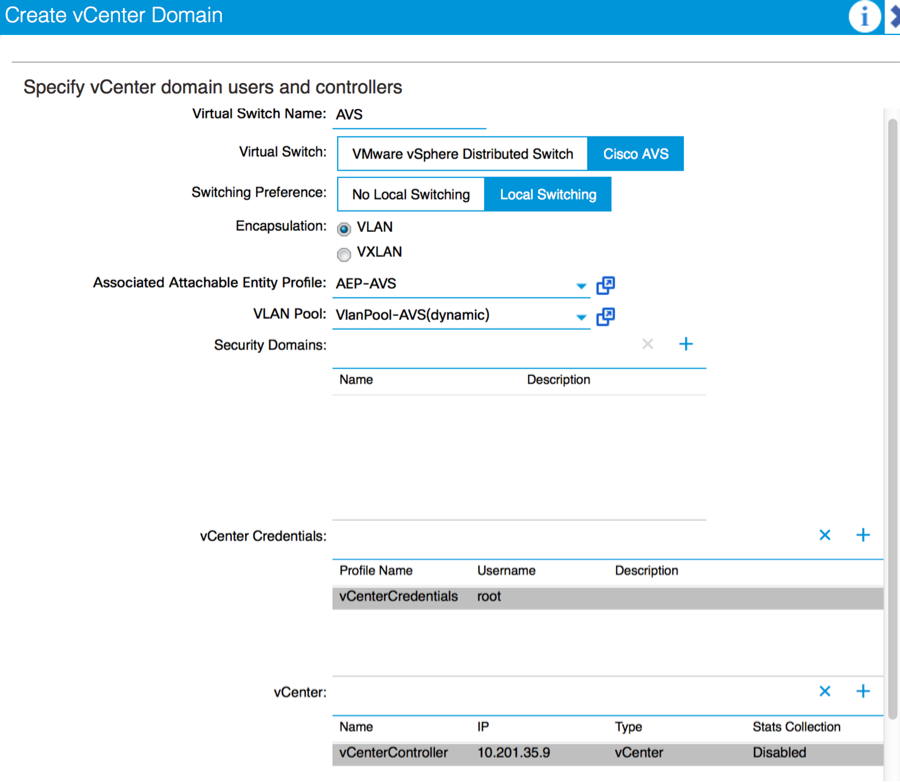

AVS Initiële Setup maakt een VMware vCenter Domain (VMware-integratie) 2

Opmerking:

- U kunt meerdere datacenters en DVS-items (Distributed Virtual Switch) maken onder één domein. U kunt echter maar één Cisco AVS-account voor elk datacenter hebben.

- De plaatsing van het servicesdiagram met Cisco AVS wordt ondersteund van Cisco ACI release 1.2(1i) met Cisco AVS release 5.2(1)SV3(1.10). De volledige configuratie van de servicesgrafiek wordt uitgevoerd op de Cisco Application Policy Infrastructuur Controller (Cisco APIC).

- De implementatie van Service Virtual Machine (VM) met Cisco AVS wordt alleen ondersteund op Virtual Machine Manager (VM)-domeinen met Virtual Local Area Networks (VLAN’s) insluitingsmodus. De berekende VM's (de leverancier en de verbruiker VM's) kunnen echter deel uitmaken van VM-domeinen met Virtual Extensible LAN (VXLAN) of VLAN-insluiting.

- Let er ook op dat als een lokale switching wordt gebruikt, het Multicastadres en de pool niet nodig zijn. Als er geen lokale switching is geselecteerd, moet Multicast pool worden geconfigureerd en het multicast adres van AVS moet geen deel uitmaken van de multicast pool. Al het verkeer dat van de AVS afkomstig is, wordt VLAN of VXLAN ingekapseld.

Navigeren in naar VM Network > VMWare > vCenter Domain, zoals in de afbeelding wordt getoond:

Als u Port-Channel of VPC (Virtual Port-Channel) gebruikt, wordt aanbevolen om het vSwitch-beleid in te stellen voor het gebruik van Mac-centrifugeren.

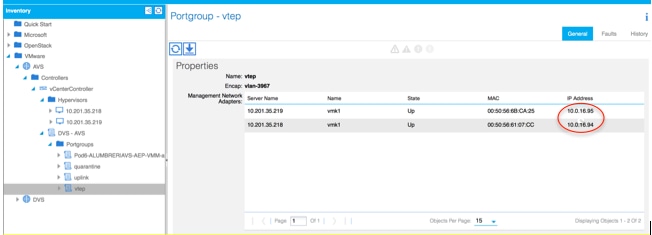

Daarna moet APIC de AVS switch configuratie naar vCenter duwen, zoals in de afbeelding wordt getoond:

Op APIC kunt u opmerken dat een VXLAN Tunnel Endpoint (VTEP) adres is toegewezen aan de VTEP poortgroep voor AVS. Dit adres wordt toegewezen ongeacht welke Connectivity-modus wordt gebruikt (VLAN of VXLAN)

Installeer de Cisco AVS-software in vCenter.

- Download vSphere Installatie Bundle (VIB) vanuit CCO door deze link te gebruiken

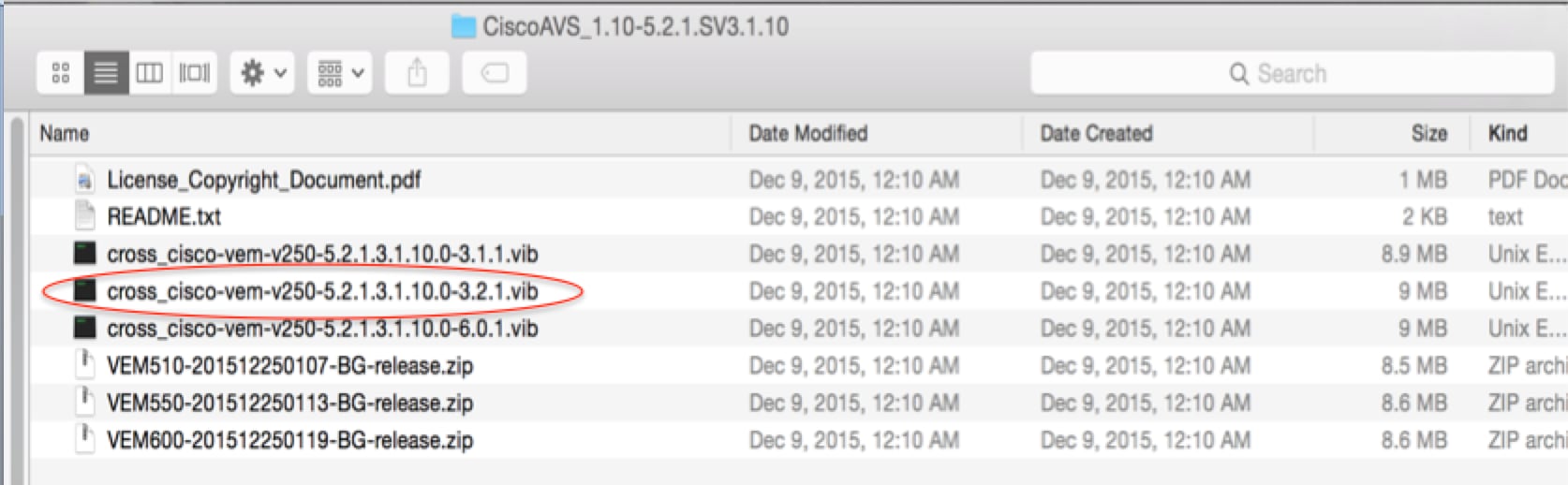

Opmerking: in dit geval gebruiken we ESX 5.5, tabel 1, geeft de compatibiliteitsmatrix voor ESXi 6.0, 5.5, 5.1 en 5.0 weer

Tabel 1 - host-softwareversie en compatibiliteit voor ESXi 6.0, 5.5, 5.1 en 5.0

In het ZIP-bestand zijn er 3 VIB-bestanden, één voor elk van de ESXi-hostversies, selecteer de bestanden die geschikt zijn voor ESX 5.5, zoals in de afbeelding:

- Kopieer het VIB-bestand naar ESX Datastore - dit kan via CLI of rechtstreeks vanaf vCenter worden gedaan

Opmerking: Als er een VIB-bestand op de host bestaat, verwijdert u het bestand door de opdracht esxcli-software te gebruiken.

esxcli software vib verwijder -n cross_cisco-vem-v197-5.2.1.3.1.5.0-3.2.1.vib

of door rechtstreeks door te bladeren in de Datastore.

- Installeer de AVS-software met de volgende opdracht op de ESXi-host:

esxcli-software vib install -v /vmfs/Volume/datastore1/cross_cisco-vem-v250-5.2.1.3.1.10.0-3.2.1.vib —onderhoudsmodus —no-sig-check

- Nadat de Virtual Ethernet-module (VEM) is geïnstalleerd, kunt u hosts aan uw AVS toevoegen:

In het dialoogvenster Add Host to vSphere Distributed Switch kiest u de virtuele NIC-poorten die worden aangesloten op de bladswitch (In dit voorbeeld verplaatst u alleen vmnic6), zoals in de afbeelding:

- Klik op Volgende

- Klik in het dialoogvenster Network Connectivity op Volgende

- Klik in het dialoogvenster Virtual Machine Network op Volgende

- Klik in het dialoogvenster Klaar om te voltooien op Voltooien

Opmerking: Als er meerdere ESXi-hosts gebruikt worden, moeten al deze hosts gebruik worden gemaakt van de AVS/VEM zodat zij kunnen worden bestuurd van de standaard switch tot DVS of AVS.

Hierdoor is de integratie van AVS voltooid en zijn we klaar om door te gaan met de inzet van L4-L7 ASAv:

ASAv eerste instelling

- Cisco ASAv-apparaatpakket downloaden en in APIC importeren:

Navigeren in op L4-L7 Services > Packages > het apparaatpakket importeren, zoals in de afbeelding wordt getoond:

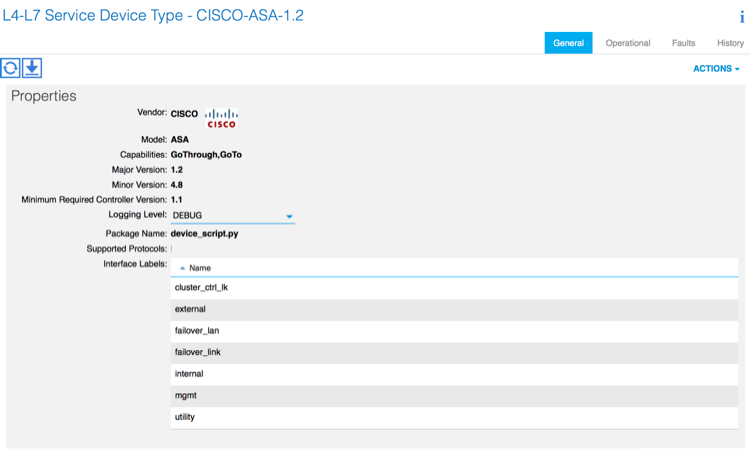

- Als alles goed werkt, kunt u het geïmporteerde apparaatpakket zien, waarmee de map L4-L7-servicetypen wordt uitgebreid, zoals in de afbeelding:

Voordat u verdergaat, zijn er weinig aspecten van de installatie die moeten worden bepaald voordat de echte L4-L7 integratie wordt uitgevoerd:

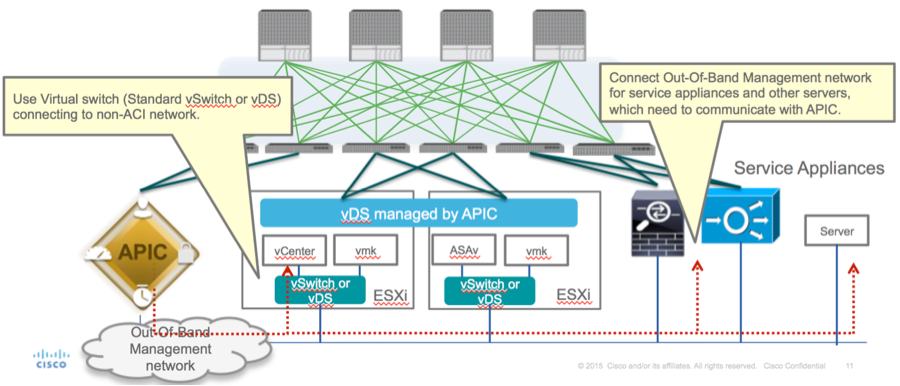

Er zijn twee soorten beheernetwerken: In-Band Management en Out-Band (OB); deze kunnen worden gebruikt voor het beheer van apparaten die geen deel uitmaken van de basis-Application Centric Infrastructure (ACI) (blad, stekels of apic controller) die ASAv, Loadbalances, enz. zouden omvatten.

In dit geval wordt OB voor ASAv ingezet met behulp van de standaard vSwitch. Voor niet-metalen ASA of andere serviceapparatuur en/of servers sluit u de OB Management-poort aan op de OB-switch of het OB-netwerk, zoals in de afbeelding wordt getoond.

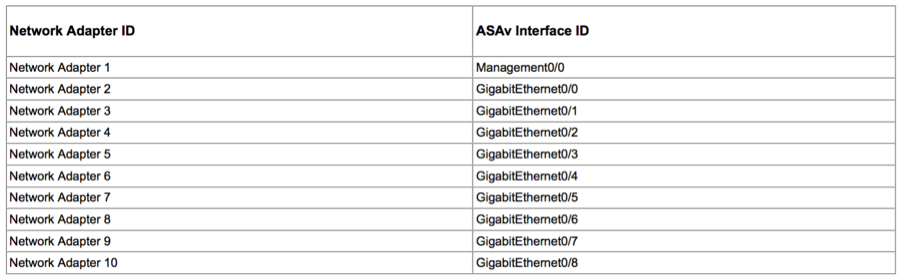

ASAv OB MGMT-poortverbinding moet ESXi-uplinks gebruiken om te communiceren met APIC via OOB. Wanneer u vNIC-interfaces in kaart brengt, komt netwerkadapter1 altijd overeen met de Management0/0-interface in de ASAv en de rest van de datacommunicatie wordt gestart vanaf Network adapter2.

Tabel 2 toont de overeenstemming van netwerkadapter-ID’s en ASAv-interface-ID’s:

Tabel 2

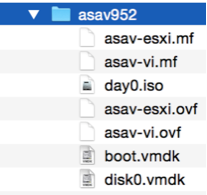

- De ASAv VM implementeren via de wizard van File>OVF (Open Virtualization Format)-sjabloon implementeren

- Selecteer asav-esxi als u standalone ESX Server of asav-vi voor vCenter wilt gebruiken. In dit geval wordt vCenter gebruikt.

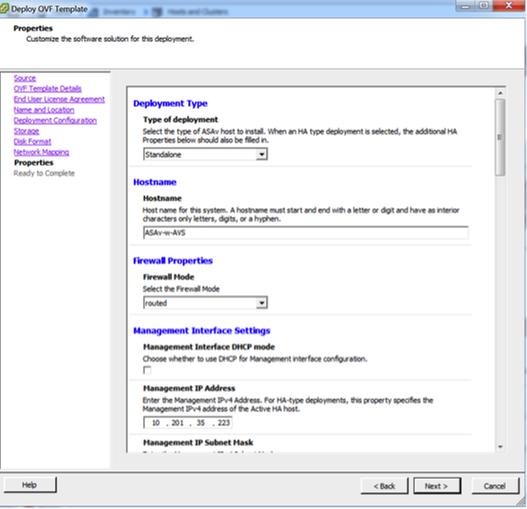

- Ga door de installatiewizard, accepteer bepalingen en voorwaarden. Midden in de wizard kunt verschillende opties bepalen, zoals hostname, beheer, ip-adres, firewallmodus en andere specifieke informatie over ASAv. Denk eraan om OB-beheer voor ASAv te gebruiken, zoals in dit geval u interfacebeheer0/0 moet bewaren terwijl u het VM Network (Standard Switch) gebruikt en de interface Gigabit Ethernet0-8 de standaardnetwerkpoorten is.

- Klik op Voltooien en wacht tot de ASAv-implementatie is voltooid

- Power On uw ASA VM en log in via console om eerste configuratie te verifiëren

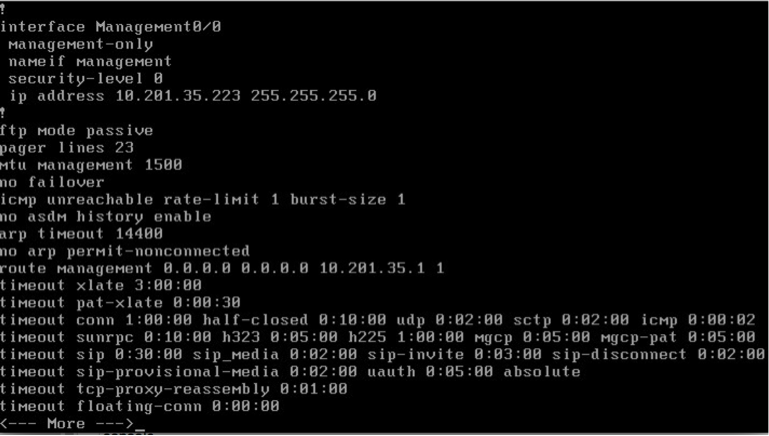

- Zoals in de afbeelding wordt getoond, wordt sommige beheerconfiguratie al naar de ASAv firewall geduwd. Configureer de gebruikersnaam en het wachtwoord voor de beheerder. Deze gebruikersnaam en het wachtwoord worden door APIC gebruikt om in te loggen en de ASA te configureren. De ASA zou connectiviteit moeten hebben aan het OB netwerk en APIC moeten kunnen bereiken.

wachtwoord voor gebruikersnaam <device_password> gecodeerd recht 15

Daarnaast schakelt u http server in vanaf de Global Configuration-modus:

http-server

http 0.0.0.0.0.0.0.0

L4-L7 voor ASAv-integratie in APIC:

- Meld u aan bij de ACI GUI, klik op de aanbesteding waar het servicesdiagram wordt ingezet. L4-L7-services uitvouwen onder in het navigatiedeelvenster en met de rechtermuisknop op L4-L7-apparaten en op L4-L7-apparaten maken om de wizard te openen

-

Voor deze implementatie worden de volgende instellingen toegepast:

Beheerde modus

Firewallservice

-virtueel apparaat

-Verbonden met een AVS-domein met één knooppunt

ASA 5500-V model

Routed Mode (GoTo)

-Management Address (moet het eerder toegewezen adres aan de MGMT0/0 interface aanpassen)

- Gebruik HTTPS als APIC standaard het best beveiligde protocol om met ASAv te communiceren

- De juiste definitie van de apparaatinterfaces en de clusterinterfaces is van cruciaal belang voor een succesvolle implementatie

Voor het eerste deel, gebruik tabel 2 in de vorige sectie om de IDs van de Netwerkadapter goed aan te passen aan de ASAv interface-IDs die u wilt gebruiken. Het pad verwijst naar de fysieke poort of poortkanaal of VPC die de weg in en uit de firewallinterfaces mogelijk maakt. In dit geval, is ASA gevestigd in een ESX host, waar in en uit hetzelfde zijn voor beide interfaces. In een fysiek apparaat zouden binnen en buiten de firewall (FW) verschillende fysieke poorten zijn.

Voor het tweede deel moeten de Cluster interfaces altijd worden gedefinieerd zonder uitzonderingen (zelfs als Cluster HA niet wordt gebruikt), dit is omdat het Objectmodel een associatie heeft tussen de mAs-interface (meta-interface op het Apparaatpakket), de LIf-interface (bladinterface zoals bijvoorbeeld, extern, intern, binnen, enz.) en de CIf (beton) . De L4-L7 betonapparaten moeten worden geconfigureerd in een apparaatclusterconfiguratie en deze abstractie wordt een logisch apparaat genoemd. Het logische apparaat heeft logische interfaces die in kaart worden gebracht aan concrete interfaces op het betonnen apparaat.

Voor dit voorbeeld zal de volgende vereniging worden gebruikt:

Gi0/0 = Vmnic2 = serverInt/provider/server > EPG1

Gi0/1 = Vmnic3 = clientInt/consument/cliënt > EPG2

Opmerking: Voor failover/HA-implementaties wordt Gigabit Ethernet 0/8 vooraf geconfigureerd als de failover-interface.

De status van het apparaat moet stabiel zijn en u dient bereid te zijn om het sjabloon van het functieprofiel en de servicesdiagram in te voeren

Servicecamera

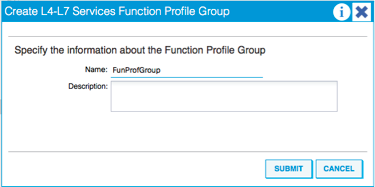

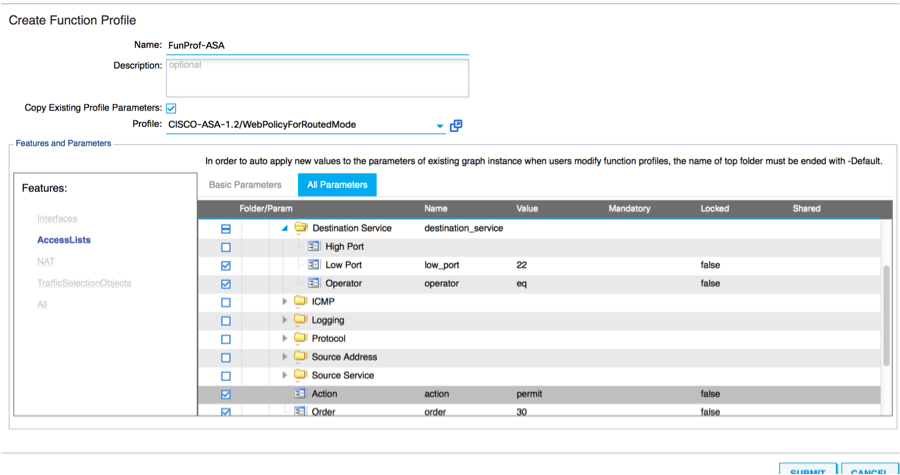

Om te beginnen, om een Functieprofiel voor ASAv te maken maar daarvoor moet u Functie Profile Group en dan L4-L7 Services Functie Profile onder deze map maken, zoals in de afbeelding te zien is:

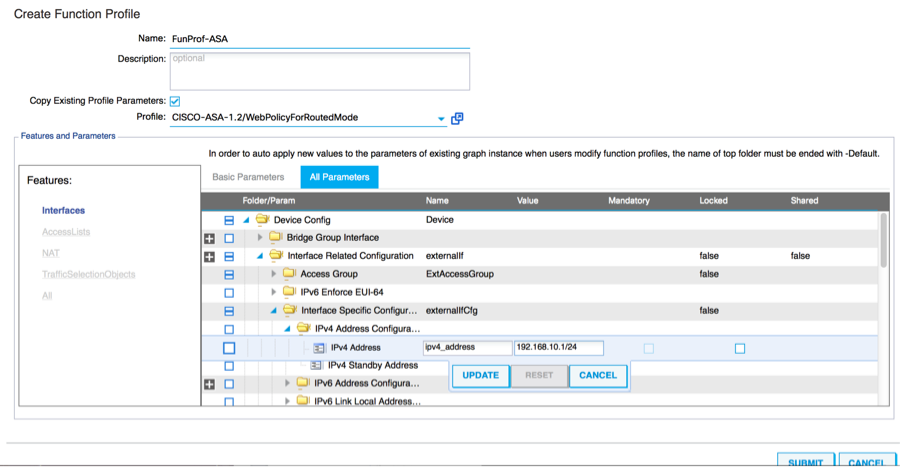

- Selecteer het Webex ProfileForRoutedMode van het uitrolmenu en ga verder om de interfaces op de firewall te configureren. Vanaf hier zijn de stappen optioneel en kunnen deze later worden geïmplementeerd of aangepast. Deze stappen kunnen in een paar verschillende fasen in de implementatie worden genomen afhankelijk van hoe herbruikbaar of aangepast de Grafiek van de Dienst zou kunnen zijn.

Voor deze oefening vereist een routed Firewall(GoTo Mode) dat elke interface een uniek IP-adres heeft. De standaard ASA-configuratie heeft ook een interface-beveiligingsniveau (externe interface is minder veilig, interne interface is veiliger). U kunt de naam van de interface ook wijzigen volgens uw vereisten. In dit voorbeeld worden de standaardinstellingen gebruikt.

- Uitbreidt de interface-specifieke configuratie, voegt IP-adres en beveiligingsniveau voor ServerInt toe met de volgende indeling voor het IP-adres x.x.x.x/y.y.y of x.x.x.x/yy. Herhaal het proces voor de ClientInt-interface.

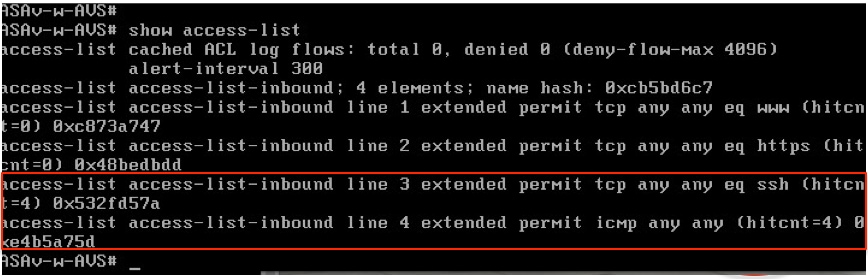

Opmerking: U kunt ook de standaardinstellingen voor toegangslijsten wijzigen en uw eigen basissjabloon maken. Standaard zal de RoutedMode-sjabloon regels voor HTTP en HTTPS bevatten. Voor deze oefening zullen SSH en ICMP aan de toegestane buitentoegangslijst worden toegevoegd.

- Klik vervolgens op Inzenden

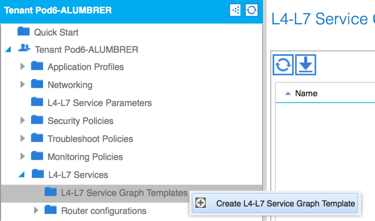

- Creëer nu de opdracht Grafiek Service

- Sleep de Cluster in het recht om de relatie tussen consument en leverancier te vormen, selecteer Routed Mode en het eerder gemaakte functieprofiel.

- Controleer het sjabloon op fouten. De sjablonen worden gecreëerd om opnieuw te kunnen worden gebruikt, ze moeten dan worden toegepast op specifieke EPG's etc.

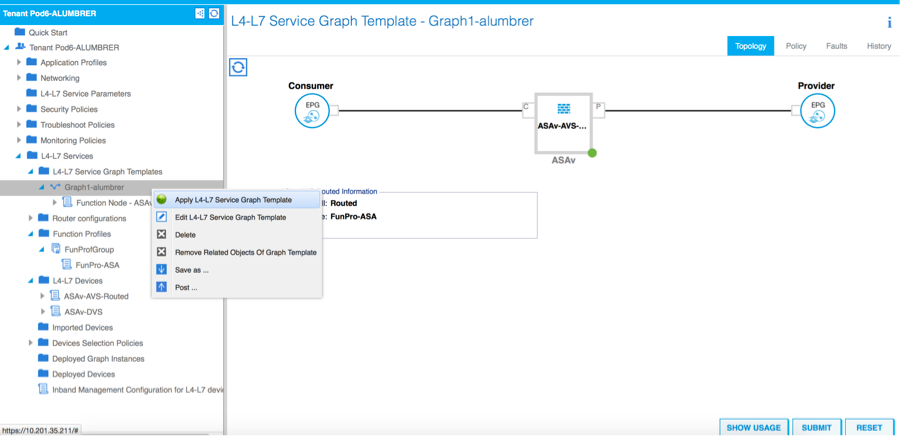

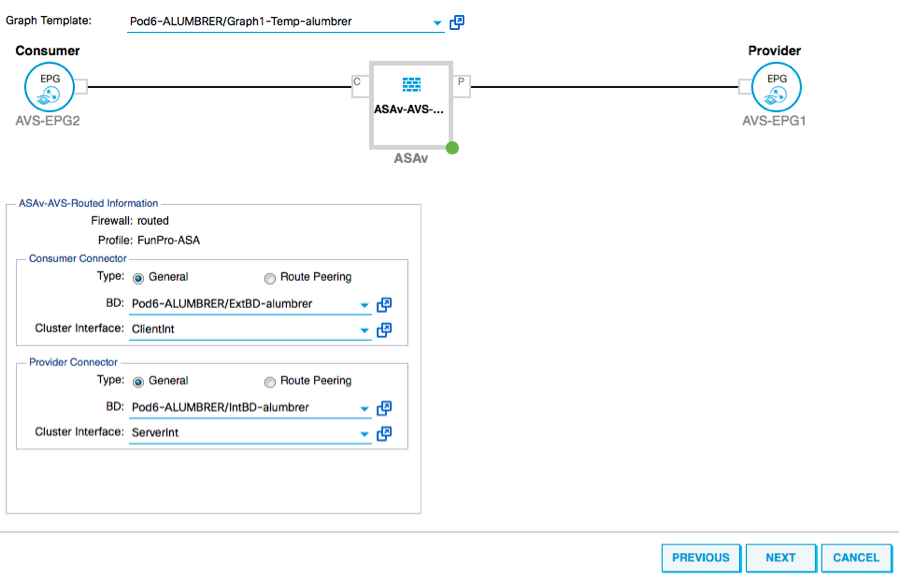

- Als u een sjabloon wilt toepassen, klikt u met de rechtermuisknop en vervolgens selecteert u L4-L7 Service Graphsjabloon toepassen

- Stel vast welke EPG aan de zijde van de consument en aan de zijde van de leverancier zal staan. In deze oefening is AVS-EPG2 de Consumentenklant (client) en AVS-EPG1 is de Provider (server). Onthoud dat er geen filter wordt toegepast, zodat de firewall alle filtering kan uitvoeren op basis van de toegangslijst die is gedefinieerd in de laatste sectie van deze wizard.

- Klik op Volgende

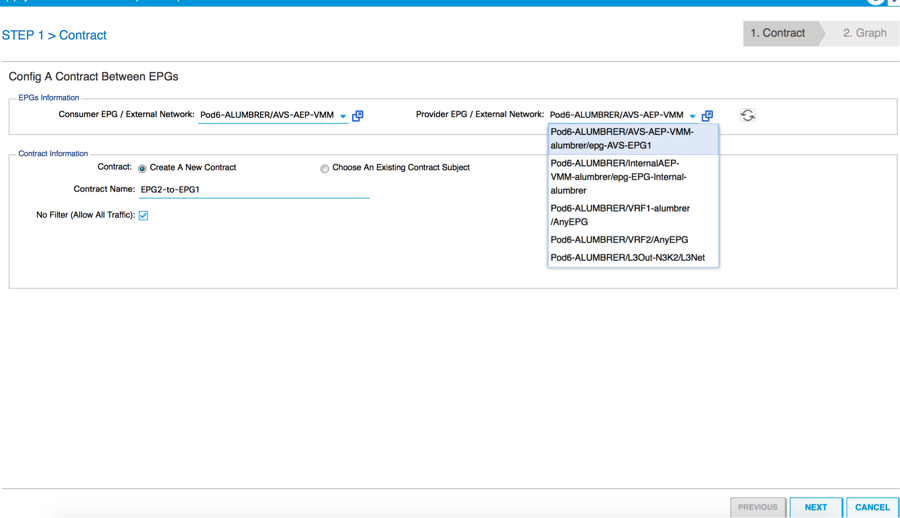

- Controleer de BD - informatie voor elk van de EPG's. In dit geval is EPG1 de leverancier op de IntBD-DB en EPG2 de consument op BD ExtBD. EPG1 sluit een verbinding op een firewallinterface ServerInt en EPG2 wordt aangesloten op een interface-clientInt. Beide interfaces worden het DG voor elk van de EPG's, zodat het verkeer te allen tijde de firewall moet oversteken.

- Klik op Volgende

- Klik in het gedeelte Config op Alle parameters en controleer of er RODE indicatoren zijn die moeten worden bijgewerkt/geconfigureerd. In de uitvoer zoals weergegeven in de afbeelding, kan worden opgemerkt dat de volgorde op de toegangslijst is gemist. Dit is gelijk aan de lijnvolgorde die u in een toonip access-list X zult zien.

- U kunt ook de IP-adressering controleren die is toegewezen op basis van het functieprofiel dat eerder is gedefinieerd. Hier is een goede kans om informatie indien nodig te wijzigen. Nadat alle parameters zijn ingesteld, klikt u op Voltooien, zoals in de afbeelding:

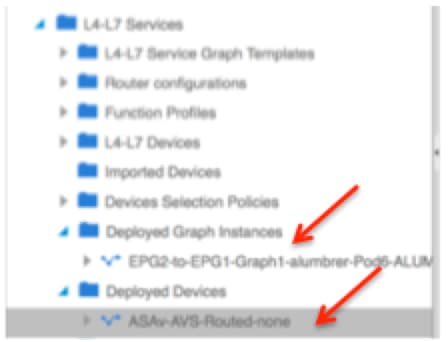

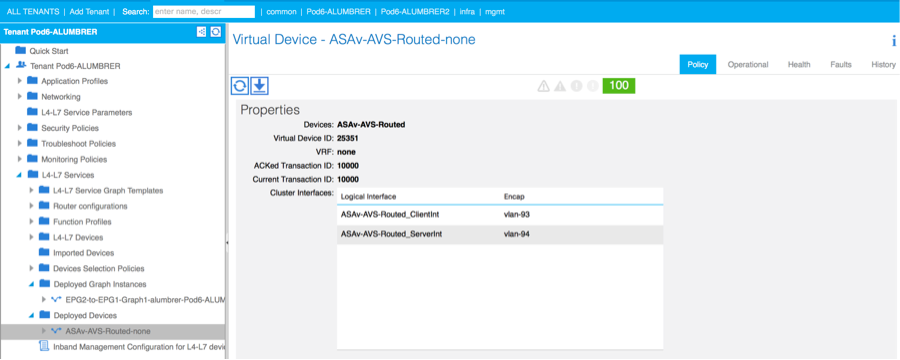

- Als alles goed gaat, moet er een nieuw gebruikt apparaat en een Graph Instance verschijnen.

Verifiëren

- Een belangrijk ding om te verifiëren na het creëren van de Servicegrafiek is dat de relatie tussen consument en leverancier met de juiste Meta-connector is gecreëerd. Controleer dit onder de eigenschappen van de functieknop.

Opmerking: Elke interface van de Firewall wordt toegewezen met een encap-VLAN uit de AVS Dynamic Pool. Controleer of er geen fouten zijn.

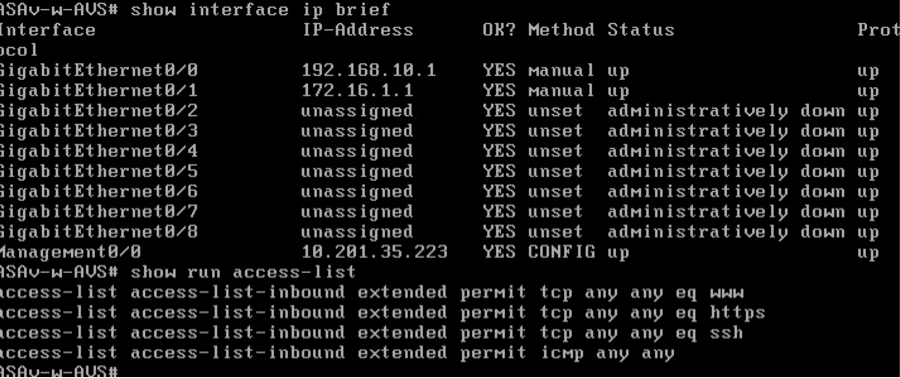

- Nu kan je ook de informatie verifiëren die naar de ASAv is gestuurd

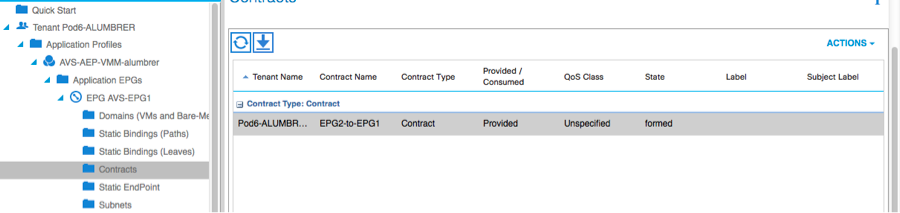

- Een nieuw contract wordt toegewezen onder de EPG's. Als u van nu af aan iets in de toegangslijst wilt wijzigen, moet de wijziging worden doorgevoerd vanuit de L4-L7 Service parameters van de Provider EPG.

- Op vCenter kunt u ook controleren of de schaduwEPG's zijn toegewezen aan elk van de FW-interfaces:

Voor deze test lieten ik de 2 EPG's communiceren met standaardcontracten, deze 2 EPG's zijn in verschillende domeinen en verschillende VRF's, dus was het lekken van de route tussen deze twee eerder geconfigureerd. Dit vereenvoudigt een beetje nadat u de Service Graph hebt ingevoegd aangezien de FW de routing en het filteren tussen de 2 EPG's instelt. Het DG dat voorheen in het kader van de EPG en de BD was ingesteld, kan nu worden afgeschaft, net als de contracten. Alleen het door de L4-L7 aangegane contract dient onder de EPG's te blijven.

Aangezien het standaardcontract wordt verwijderd, kunt u bevestigen dat het verkeer nu door de ASAv stroomt, zou de opdracht toegang-lijst moeten tonen de hit tellen voor de regel die elke keer dat de client een verzoek naar de server verstuurt.

Op het blad moeten endpoints worden geleerd voor VM's van klanten en servers en de ASAv-interfaces

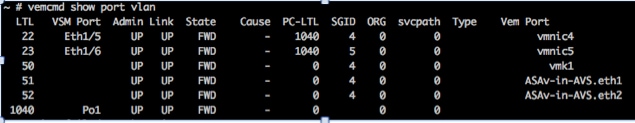

Zie beide firewallinterfaces op de VEM.

ESX-1

ESX-2

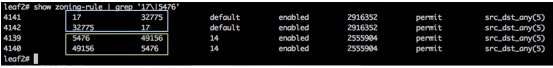

Ten slotte kunnen de firewallregels ook op bladniveau worden geverifieerd als we de pc-tags voor bron- en doelgroepen kennen:

Filter ID's kunnen worden aangepast met de PC-tags op het blad om de FW-regels te controleren.

Opmerking: De EPG PCTags/klasse communiceren nooit rechtstreeks. De communicatie wordt onderbroken of samengebonden via de schaduwEPG's die worden gecreëerd door de invoeging van de L4-L7 servicesgrafiek.

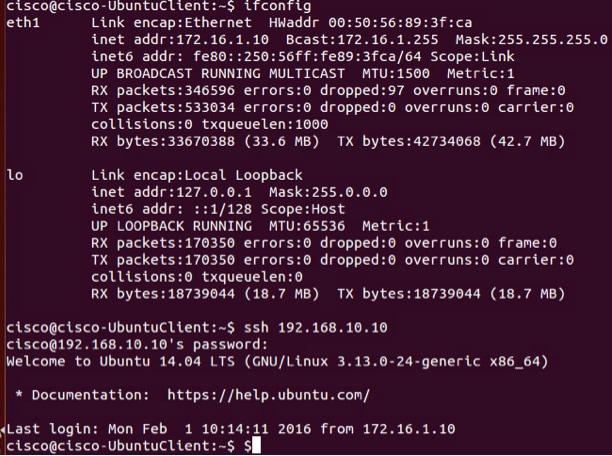

En communicatielijn naar server werkt.

Problemen oplossen

VTEP-adres is niet toegewezen

Controleer of het Infrastructuur VLAN is ingeschakeld onder het AEP:

Niet ondersteunde versie

Controleer of de VEM-versie correct is en ondersteuning biedt voor een geschikt ESXi VMWare-systeem.

~ # vem version Running esx version -1746974 x86_64 VEM Version: 5.2.1.3.1.10.0-3.2.1 OpFlex SDK Version: 1.2(1i) System Version: VMware ESXi 5.5.0 Releasebuild-1746974 ESX Version Update Level: 0[an error occurred while processing this directive]

VEM- en fabriccommunicatie niet werkend

- Check VEM status vem status - Try reloading or restating the VEM at the host: vem reload vem restart - Check if there’s connectivity towards the Fabric. You can try pinging 10.0.0.30 which is (infra:default) with 10.0.0.30 (shared address, for both Leafs) ~ # vmkping -I vmk1 10.0.0.30 PING 10.0.0.30 (10.0.0.30): 56 data bytes --- 10.0.0.30 ping statistics --- 3 packets transmitted, 0 packets received, 100% packet loss If ping fails, check: - Check OpFlex status - The DPA (DataPathAgent) handles all the control traffic between AVS and APIC (talks to the immediate Leaf switch that is connecting to) using OpFlex (opflex client/agent).[an error occurred while processing this directive]

All EPG communication will go thru this opflex connection. ~ # vemcmd show opflex Status: 0 (Discovering) Channel0: 0 (Discovering), Channel1: 0 (Discovering) Dvs name: comp/prov-VMware/ctrlr-[AVS]-vCenterController/sw-dvs-129 Remote IP: 10.0.0.30 Port: 8000 Infra vlan: 3967 FTEP IP: 10.0.0.32 Switching Mode: unknown Encap Type: unknown NS GIPO: 0.0.0.0 you can also check the status of the vmnics at the host level: ~ # esxcfg-vmknic -l Interface Port Group/DVPort IP Family IP Address Netmask Broadcast MAC Address MTU TSO MSS Enabled Type vmk0 Management Network IPv4 10.201.35.219 255.255.255.0 10.201.35.255 e4:aa:5d:ad:06:3e 1500 65535 true STATIC vmk0 Management Network IPv6 fe80::e6aa:5dff:fead:63e 64 e4:aa:5d:ad:06:3e 1500 65535 true STATIC, PREFERRED vmk1 160 IPv4 10.0.32.65 255.255.0.0 10.0.255.255 00:50:56:6b:ca:25 1500 65535 true STATIC vmk1 160 IPv6 fe80::250:56ff:fe6b:ca25 64 00:50:56:6b:ca:25 1500 65535 true STATIC, PREFERRED ~ # - Also on the host, verify if DHCP requests are sent back and forth: ~ # tcpdump-uw -i vmk1 tcpdump-uw: verbose output suppressed, use -v or -vv for full protocol decode listening on vmk1, link-type EN10MB (Ethernet), capture size 96 bytes 12:46:08.818776 IP truncated-ip - 246 bytes missing! 0.0.0.0.bootpc > 255.255.255.255.bootps: BOOTP/DHCP, Request from 00:50:56:6b:ca:25 (oui Unknown), length 300 12:46:13.002342 IP truncated-ip - 246 bytes missing! 0.0.0.0.bootpc > 255.255.255.255.bootps: BOOTP/DHCP, Request from 00:50:56:6b:ca:25 (oui Unknown), length 300 12:46:21.002532 IP truncated-ip - 246 bytes missing! 0.0.0.0.bootpc > 255.255.255.255.bootps: BOOTP/DHCP, Request from 00:50:56:6b:ca:25 (oui Unknown), length 300 12:46:30.002753 IP truncated-ip - 246 bytes missing! 0.0.0.0.bootpc > 255.255.255.255.bootps: BOOTP/DHCP, Request from 00:50:56:6b:ca:25 (oui Unknown), length 300

Op dit punt kan worden vastgesteld dat de communicatie van de fabric tussen de ESXi-host en de Leaf niet goed werkt. Sommige verificatieopdrachten kunnen aan de linkerkant worden gecontroleerd om de oorzaak van de wortel te bepalen.

leaf2# show cdp ne

Capability Codes: R - Router, T - Trans-Bridge, B - Source-Route-Bridge

S - Switch, H - Host, I - IGMP, r - Repeater,

V - VoIP-Phone, D - Remotely-Managed-Device,

s - Supports-STP-Dispute

Device-ID Local Intrfce Hldtme Capability Platform Port ID

AVS:localhost.localdomainmain

Eth1/5 169 S I s VMware ESXi vmnic4

AVS:localhost.localdomainmain

Eth1/6 169 S I s VMware ESXi vmnic5

N3K-2(FOC1938R02L)

Eth1/13 166 R S I s N3K-C3172PQ-1 Eth1/13

leaf2# show port-c sum

Flags: D - Down P - Up in port-channel (members)

I - Individual H - Hot-standby (LACP only)

s - Suspended r - Module-removed

S - Switched R - Routed

U - Up (port-channel)

M - Not in use. Min-links not met

F - Configuration failed

-------------------------------------------------------------------------------

Group Port- Type Protocol Member Ports

Channel

-------------------------------------------------------------------------------

5 Po5(SU) Eth LACP Eth1/5(P) Eth1/6(P)

[an error occurred while processing this directive]

Er zijn 2 poorten die gebruikt worden in de ESXi en die aangesloten zijn via een Po5

leaf2# show vlan extended VLAN Name Status Ports ---- -------------------------------- --------- ------------------------------- 13 infra:default active Eth1/1, Eth1/20 19 -- active Eth1/13 22 mgmt:inb active Eth1/1 26 -- active Eth1/5, Eth1/6, Po5 27 -- active Eth1/1 28 :: active Eth1/5, Eth1/6, Po5 36 common:pod6_BD active Eth1/5, Eth1/6, Po5 VLAN Type Vlan-mode Encap ---- ----- ---------- ------------------------------- 13 enet CE vxlan-16777209, vlan-3967 19 enet CE vxlan-14680064, vlan-150 22 enet CE vxlan-16383902 26 enet CE vxlan-15531929, vlan-200 27 enet CE vlan-11 28 enet CE vlan-14 36 enet CE vxlan-15662984[an error occurred while processing this directive] Op basis van de bovenstaande output kan worden waargenomen dat het Inra VLAN niet is toegestaan of door de Uplinks poorten loopt die naar de ESXi host gaan (1/5-6). Dit duidt op een verkeerde configuratie met het interfacebeleid of het Switch-beleid dat op APIC is ingesteld.

Controleer beide:

Toegangsbeleid > Interfacebeleid > Bewerkingen > Toegangsbeleid > Switch > profielen

In dit geval zijn de interfaceprofielen gekoppeld aan de verkeerde AEP (oude AEP gebruikt voor DVS), zoals in de afbeelding:

Nadat we de juiste AEP voor AVS hebben ingesteld, kunnen we nu zien dat de Inra Vlan is gezien door de juiste Unlinks op het Leaf:

leaf2# show vlan extended

VLAN Name Status Ports

---- -------------------------------- --------- -------------------------------

13 infra:default active Eth1/1, Eth1/5, Eth1/6,

Eth1/20, Po5

19 -- active Eth1/13

22 mgmt:inb active Eth1/1

26 -- active Eth1/5, Eth1/6, Po5

27 -- active Eth1/1

28 :: active Eth1/5, Eth1/6, Po5

36 common:pod6_BD active Eth1/5, Eth1/6, Po5

VLAN Type Vlan-mode Encap

---- ----- ---------- -------------------------------

13 enet CE vxlan-16777209, vlan-3967

19 enet CE vxlan-14680064, vlan-150

22 enet CE vxlan-16383902

26 enet CE vxlan-15531929, vlan-200

27 enet CE vlan-11

28 enet CE vlan-14

36 enet CE vxlan-15662984

and Opflex connection is restablised after restarting the VEM module:

~ # vem restart

stopDpa

VEM SwISCSI PID is

Warn: DPA running host/vim/vimuser/cisco/vem/vemdpa.213997

Warn: DPA running host/vim/vimuser/cisco/vem/vemdpa.213997

watchdog-vemdpa: Terminating watchdog process with PID 213974

~ # vemcmd show opflex

Status: 0 (Discovering)

Channel0: 14 (Connection attempt), Channel1: 0 (Discovering)

Dvs name: comp/prov-VMware/ctrlr-[AVS]-vCenterController/sw-dvs-129

Remote IP: 10.0.0.30 Port: 8000

Infra vlan: 3967

FTEP IP: 10.0.0.32

Switching Mode: unknown

Encap Type: unknown

NS GIPO: 0.0.0.0

~ # vemcmd show opflex

Status: 12 (Active)

Channel0: 12 (Active), Channel1: 0 (Discovering)

Dvs name: comp/prov-VMware/ctrlr-[AVS]-vCenterController/sw-dvs-129

Remote IP: 10.0.0.30 Port: 8000

Infra vlan: 3967

FTEP IP: 10.0.0.32

Switching Mode: LS

Encap Type: unknown

NS GIPO: 0.0.0.0

[an error occurred while processing this directive]

Gerelateerde informatie

Installatie van virtuele Switch voor toepassingen

Cisco Systems, Inc. Cisco Application Virtual Switch Installatie-gids, release 5.2(1)SV3(1.2)De ASAv implementeren met VMware

Cisco Systems, Inc. Cisco adaptieve security virtuele applicatie (ASAv) Quick Start-gids, 9.4

Cisco ACI en Cisco AVS

Cisco Systems, Inc. Cisco ACI-virtualisatiegids, release 1.2(1i)

Service Graph Design met Cisco Application Centraal Infrastructuur Witboek

Service Graph Design met Cisco Application Centraal Infrastructuur Witboek

Bijgedragen door Cisco-engineers

- Aida LumbrerasCisco geavanceerde services engineer

Contact Cisco

- Een ondersteuningscase openen

- (Vereist een Cisco-servicecontract)

Feedback

Feedback