Plaatsing van moederbord in een Ultra-M UCS 240 M4-server - CPAR

Downloadopties

Inclusief taalgebruik

De documentatie van dit product is waar mogelijk geschreven met inclusief taalgebruik. Inclusief taalgebruik wordt in deze documentatie gedefinieerd als taal die geen discriminatie op basis van leeftijd, handicap, gender, etniciteit, seksuele oriëntatie, sociaaleconomische status of combinaties hiervan weerspiegelt. In deze documentatie kunnen uitzonderingen voorkomen vanwege bewoordingen die in de gebruikersinterfaces van de productsoftware zijn gecodeerd, die op het taalgebruik in de RFP-documentatie zijn gebaseerd of die worden gebruikt in een product van een externe partij waarnaar wordt verwezen. Lees meer over hoe Cisco gebruikmaakt van inclusief taalgebruik.

Over deze vertaling

Cisco heeft dit document vertaald via een combinatie van machine- en menselijke technologie om onze gebruikers wereldwijd ondersteuningscontent te bieden in hun eigen taal. Houd er rekening mee dat zelfs de beste machinevertaling niet net zo nauwkeurig is als die van een professionele vertaler. Cisco Systems, Inc. is niet aansprakelijk voor de nauwkeurigheid van deze vertalingen en raadt aan altijd het oorspronkelijke Engelstalige document (link) te raadplegen.

Inhoud

Inleiding

In dit document worden de stappen beschreven die vereist zijn om het foutieve moederbord van een server in een Ultra-M instelling te vervangen.

Deze procedure is van toepassing op een OpenStack-omgeving met behulp van NEWTON-versie waarbij ESC geen CPAR beheert en CPAR rechtstreeks op de VM wordt geïnstalleerd die op OpenStack wordt ingezet.

Achtergrondinformatie

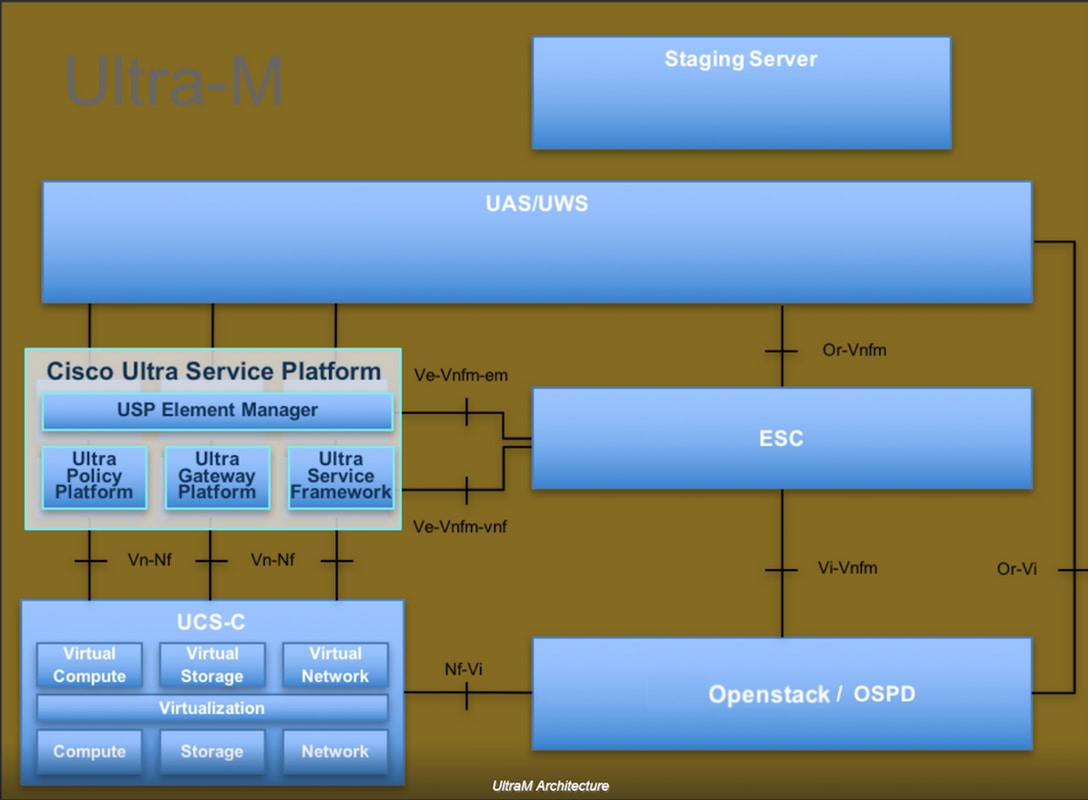

Ultra-M is een vooraf verpakte en gevalideerde gevirtualiseerde mobiele pakketoplossing die is ontworpen om de plaatsing van VNFs te vereenvoudigen. OpenStack is de Gevirtualiseerde Infrastructuur Manager (VIM) voor Ultra-M en bestaat uit deze knooptypen:

- berekenen

- Object Storage Disk - computing (OSD)

- Controller

- OpenStack Platform - Director (OSPF)

De hoge architectuur van Ultra-M en de betrokken onderdelen zijn in deze afbeelding weergegeven:

Dit document is bedoeld voor Cisco-personeel dat bekend is met het Cisco Ultra-M-platform en bevat details over de stappen die moeten worden uitgevoerd bij OpenStack en Redhat OS.

Opmerking: De Ultra M 5.1.x release wordt overwogen om de procedures in dit document te definiëren.

Afkortingen

| MOP | Procedure |

| OSD | Objectopslaglocaties |

| OSPF | OpenStack platform Director |

| HDD | Station vaste schijf |

| SSD | Solid State Drive |

| VIM | Virtual-infrastructuurbeheer |

| VM | Virtuele machine |

| EM | Element Manager |

| UAS | Ultra Automation Services |

| UUID | Universele unieke ID-versterker |

Werkstroom van de MoP

Moederbordvervanging in Ultra-M setup

In een Ultra-M opstelling kunnen er scenario's zijn waar een vervanging van het moederbord in de volgende servertypes vereist is: Computeren, OSD-computing en controller.

Opmerking: De laarsschijven met de installatie van de opening worden vervangen na de vervanging van het moederbord. Daarom is het niet vereist het knooppunt weer aan de overcloud toe te voegen. Nadat de server is ingeschakeld na de vervangingsactiviteit, kan deze zich terugschrijven naar de overcloud-stapel.

Voorwaarden

Voordat u een computing-knooppunt vervangt, is het belangrijk om de huidige status van uw Red Hat OpenStack Platform-omgeving te controleren. Aanbevolen wordt om de huidige status te controleren om complicaties te voorkomen wanneer het computing-vervangingsproces is ingeschakeld. Deze stroom van vervanging kan worden bereikt.

In geval van herstel, adviseert Cisco om een steun van de spatie- gegevensbank te nemen met het gebruik van deze stappen:

[root@director ~]# mysqldump --opt --all-databases > /root/undercloud-all-databases.sql [root@director ~]# tar --xattrs -czf undercloud-backup-`date +%F`.tar.gz /root/undercloud-all-databases.sql /etc/my.cnf.d/server.cnf /var/lib/glance/images /srv/node /home/stack tar: Removing leading `/' from member names

Dit proces zorgt ervoor dat een knooppunt kan worden vervangen zonder dat de beschikbaarheid van een van de gevallen wordt beïnvloed.

Opmerking: Zorg ervoor dat u de snapshot van de case hebt zodat u de VM indien nodig kunt herstellen. Volg deze procedure over hoe u de VM kunt benutten.

Vervanging moederbord in computingsknooppunt

Voor de activiteit worden de VM's die in het computing-knooppunt worden gehost, scherp uitgeschakeld. Nadat het moederbord is vervangen, worden de VM's weer teruggezet.

Identificeer de VM's die worden Hosted in het computing-knooppunt

[stack@al03-pod2-ospd ~]$ nova list --field name,host +--------------------------------------+---------------------------+----------------------------------+ | ID | Name | Host | +--------------------------------------+---------------------------+----------------------------------+ | 46b4b9eb-a1a6-425d-b886-a0ba760e6114 | AAA-CPAR-testing-instance | pod2-stack-compute-4.localdomain | | 3bc14173-876b-4d56-88e7-b890d67a4122 | aaa2-21 | pod2-stack-compute-3.localdomain | | f404f6ad-34c8-4a5f-a757-14c8ed7fa30e | aaa21june | pod2-stack-compute-3.localdomain | +--------------------------------------+---------------------------+----------------------------------+

Opmerking: In de hier weergegeven output komt de eerste kolom overeen met de universeel-unieke IDentifier (UUID), de tweede kolom is de VM naam en de derde kolom is de hostname waar de VM aanwezig is. De parameters uit deze uitvoer worden in de volgende secties gebruikt.

Back-up: Snapshot-proces

Stap 1. CPAR-toepassingssluiting.

Stap 1. Open elke SSH-client die is aangesloten op het netwerk en sluit een verbinding aan op de CPAR-instantie.

Het is belangrijk niet alle 4 AAA-gevallen tegelijkertijd binnen één site te sluiten, maar het één voor één te doen.

Stap 2.Sluit de CPAR-toepassing met deze opdracht af:

/opt/CSCOar/bin/arserver stop A Message stating “Cisco Prime Access Registrar Server Agent shutdown complete.” Should show up

Als een gebruiker een CLI-sessie open heeft gelaten, werkt de opdracht Landserver stop niet en wordt dit bericht weergegeven:

ERROR: You can not shut down Cisco Prime Access Registrar while the CLI is being used. Current list of running CLI with process id is: 2903 /opt/CSCOar/bin/aregcmd –s

In dit voorbeeld moet het gemarkeerde proces id 2903 worden beëindigd voordat CPAR kan worden gestopt. Als dit zich voordoet, dient u dit proces met deze opdracht te beëindigen:

kill -9 *process_id*

Herhaal dan de stap 1.

Stap 3.Controleer dat de CPAR-toepassing inderdaad werd afgesloten door de opdracht uit te geven:

/opt/CSCOar/bin/arstatus

Deze berichten moeten verschijnen:

Cisco Prime Access Registrar Server Agent not running Cisco Prime Access Registrar GUI not running

VM Snapshot-taak

Stap 1.Voer de website Horizon GUI in die overeenkomt met de site (City) waaraan momenteel wordt gewerkt.

Bij het inschakelen van Horizon wordt dit scherm waargenomen:

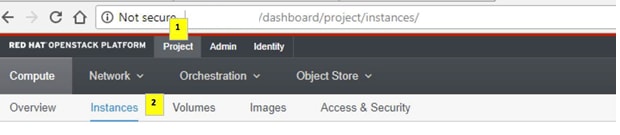

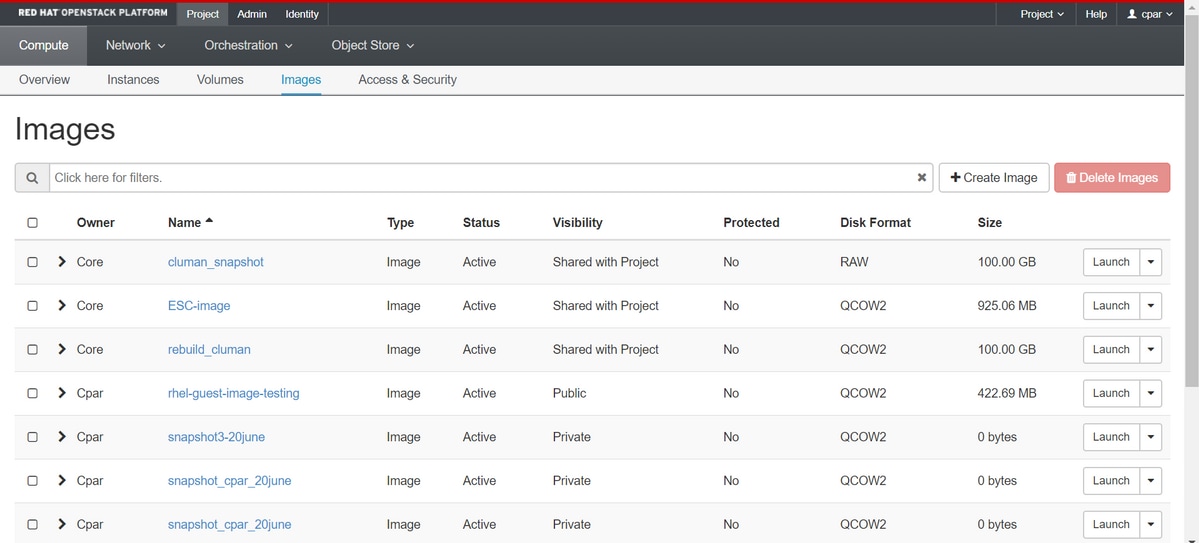

Stap 2.Navigeer naar Project > Afbeeldingen, zoals in de afbeelding.

Als de gebruikte gebruiker CPAR was, verschijnen alleen de 4 AAA-instellingen in dit menu.

Stap 3.Sluit slechts één exemplaar tegelijk en herhaal het gehele proces in dit document.

Om de VM te sluiten, navigeer naar Handelingen > Instantie uitschakelen en bevestig uw selectie.

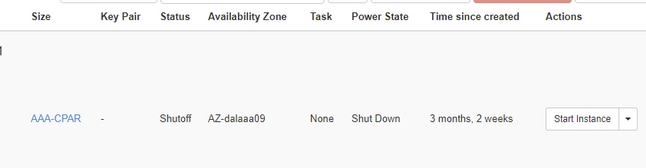

Stap 4.Bevestig dat de instantie inderdaad werd afgesloten door de Status = Shutoff en Power State = Down te controleren.

Deze stap beëindigt het CPAR sluitingsproces.

VM Snapshot

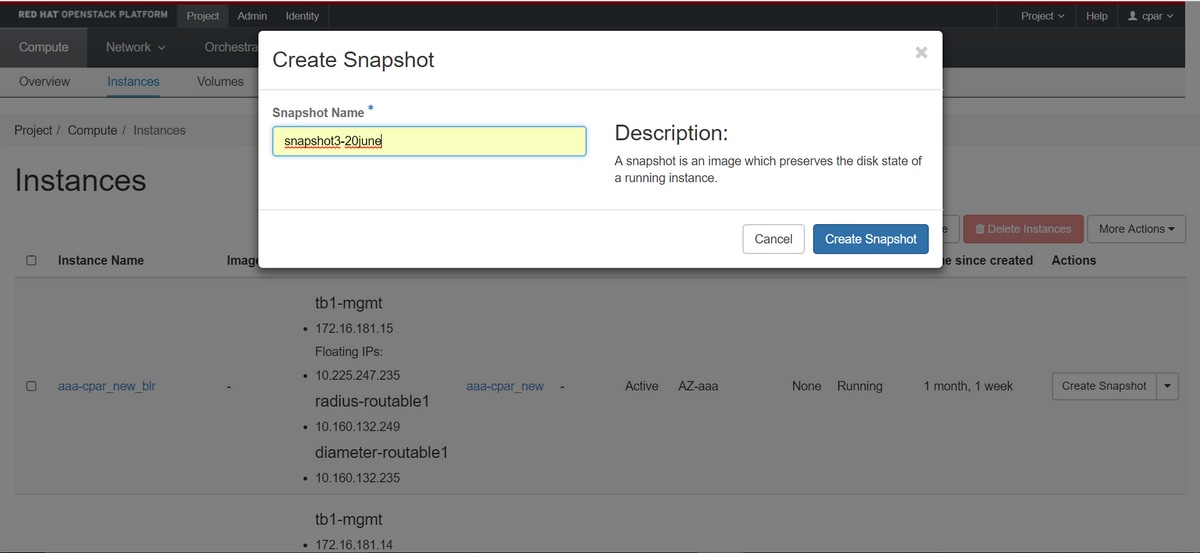

Zodra de CPAR-VM's zijn gezakt, kunnen de momentopnamen parallel worden genomen, aangezien ze tot onafhankelijke computers behoren.

De vier QCOW2-bestanden worden parallel aangemaakt.

Een momentopname nemen van elk AAA-exemplaar (25 minuten - 1 uur) (25 minuten voor instanties die een qkoe-afbeelding als bron hebben gebruikt en 1 uur voor gevallen waarin een rauwe afbeelding als bron wordt gebruikt)

Stap 1. Meld u aan bij de Horizon van de OpenStack van PODGUI.

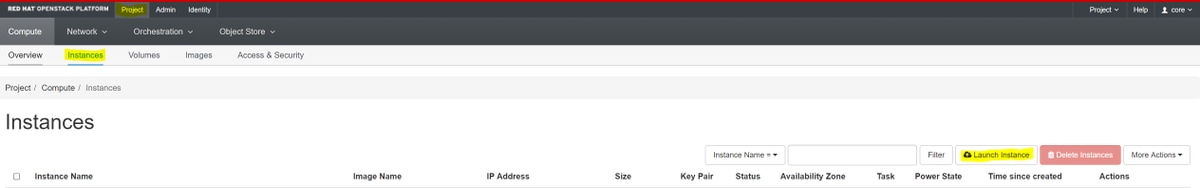

Stap 2. Na het inloggen, gaat u naar het gedeelte Project > Samenstellen > Instanties in het bovenste menu en zoekt u de AAA-instanties.

Stap 3. Klik op de knop Snapshot maken om door te gaan met het maken van een snapshot (dit moet worden uitgevoerd op de betreffende AAA-instantie).

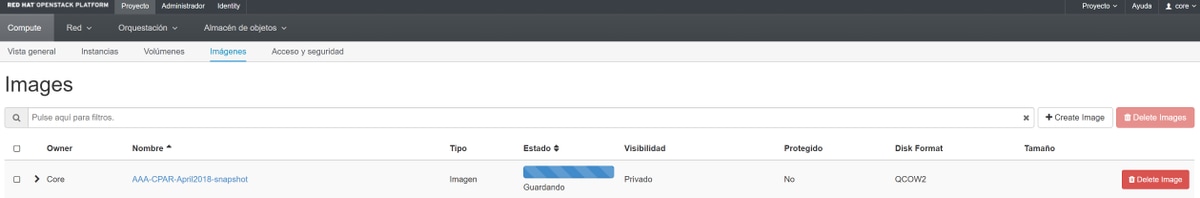

Stap 4. Zodra de snapshot draait, navigeer naar het menu AFBEELDINGEN en controleer of alle klaar is en rapporteer geen problemen.

Stap 5. De volgende stap is het downloaden van de snapshot op een QCOW2-formaat en het overdragen aan een externe entiteit voor het geval dat de OspD tijdens dit proces verloren gaat. Om dit te bereiken, moet u de snapshot met deze gezagslijst identificeren op het niveau van de OspD.

[root@elospd01 stack]# glance image-list +--------------------------------------+---------------------------+ | ID | Name | +--------------------------------------+---------------------------+ | 80f083cb-66f9-4fcf-8b8a-7d8965e47b1d | AAA-Temporary | | 22f8536b-3f3c-4bcc-ae1a-8f2ab0d8b950 | ELP1 cluman 10_09_2017 | | 70ef5911-208e-4cac-93e2-6fe9033db560 | ELP2 cluman 10_09_2017 | | e0b57fc9-e5c3-4b51-8b94-56cbccdf5401 | ESC-image | | 92dfe18c-df35-4aa9-8c52-9c663d3f839b | lgnaaa01-sept102017 | | 1461226b-4362-428b-bc90-0a98cbf33500 | tmobile-pcrf-13.1.1.iso | | 98275e15-37cf-4681-9bcc-d6ba18947d7b | tmobile-pcrf-13.1.1.qcow2 | +--------------------------------------+---------------------------+

Stap 6. Nadat u de te downloaden momentopname hebt geïdentificeerd (in dit geval is deze de snapshot die hierboven in groen is aangegeven), kunt u deze op een QCOW2-indeling downloaden met behulp van de hier weergegeven opdrachtafbeelding-download.

[root@elospd01 stack]# glance image-download 92dfe18c-df35-4aa9-8c52-9c663d3f839b --file /tmp/AAA-CPAR-LGNoct192017.qcow2 &

- Het "&"-proces wordt naar de achtergrond verzonden. Het zal enige tijd duren om deze actie te voltooien, zodra het wordt gedaan, kan het beeld in /tmp folder vinden.

- Bij het verzenden van het proces naar de achtergrond, als de connectiviteit is verloren, wordt het proces ook stopgezet.

- Voer de opdracht "afstand -h" uit zodat in het geval van een SSH-verbinding het proces nog loopt en eindigt op de OSPD.

Stap 7. Zodra het downloadproces is voltooid, moet een compressieverhouding worden uitgevoerd omdat deze snapshot met ZEROES kan worden ingevuld vanwege processen, taken en tijdelijke bestanden die door het besturingssysteem worden verwerkt. De opdracht die gebruikt moet worden voor het comprimeren van bestanden is ondoorzichtig.

[root@elospd01 stack]# virt-sparsify AAA-CPAR-LGNoct192017.qcow2 AAA-CPAR-LGNoct192017_compressed.qcow2

Dit proces duurt enige tijd (ongeveer 10 tot 15 minuten). Als dit eenmaal is voltooid, is het resulterende bestand het bestand dat naar een externe entiteit moet worden overgedragen zoals in de volgende stap is gespecificeerd.

Om dit te bereiken, moet de volgende opdracht worden uitgevoerd en moet u de eigenschap "corrupt" aan het einde van de uitvoer opzoeken.

[root@wsospd01 tmp]# qemu-img info AAA-CPAR-LGNoct192017_compressed.qcow2 image: AAA-CPAR-LGNoct192017_compressed.qcow2 file format: qcow2 virtual size: 150G (161061273600 bytes) disk size: 18G cluster_size: 65536 Format specific information: compat: 1.1 lazy refcounts: false refcount bits: 16 corrupt: false

Om een probleem te vermijden waarbij het OspD verloren gaat, moet de recent gecreëerde momentopname op het QCOW2-formaat worden overgedragen aan een externe entiteit. Voordat u de bestandsoverdracht wilt starten, moeten we controleren of de bestemming voldoende beschikbare schijfruimte heeft, gebruikt u de opdracht "df -kh" om de geheugenruimte te controleren. Ons advies is om het tijdelijk over te brengen naar de OspD van een andere site door gebruik te maken van SFTP "sftproot@x.x.x.x", waarbij x.x.x.x het IP van een externe OspD is. Om de overdracht te versnellen, kan de bestemming naar meerdere OSPF's worden gestuurd. Op dezelfde manier kunnen we de volgende opdracht SCP *name_of_the_file*.qkoe2 root@ x.x.x.x:/tmp (waarbij x.x.x.x de IP van een externe OspD is) gebruiken om het bestand naar een andere OspD over te brengen.

GainMaker-voeding

Uitgeschakeld knooppunt

- Zo schakelt u het exemplaar uit: nova stop <INSTANCE_NAME>

- U ziet nu de naam van het exemplaar met de statusschuifschakelaar.

[stack@director ~]$ nova stop aaa2-21 Request to stop server aaa2-21 has been accepted. [stack@director ~]$ nova list +--------------------------------------+---------------------------+---------+------------+-------------+------------------------------------------------------------------------------------------------------------+ | ID | Name | Status | Task State | Power State | Networks | +--------------------------------------+---------------------------+---------+------------+-------------+------------------------------------------------------------------------------------------------------------+ | 46b4b9eb-a1a6-425d-b886-a0ba760e6114 | AAA-CPAR-testing-instance | ACTIVE | - | Running | tb1-mgmt=172.16.181.14, 10.225.247.233; radius-routable1=10.160.132.245; diameter-routable1=10.160.132.231 | | 3bc14173-876b-4d56-88e7-b890d67a4122 | aaa2-21 | SHUTOFF | - | Shutdown | diameter-routable1=10.160.132.230; radius-routable1=10.160.132.248; tb1-mgmt=172.16.181.7, 10.225.247.234 | | f404f6ad-34c8-4a5f-a757-14c8ed7fa30e | aaa21june | ACTIVE | - | Running | diameter-routable1=10.160.132.233; radius-routable1=10.160.132.244; tb1-mgmt=172.16.181.10 | +--------------------------------------+---------------------------+---------+------------+-------------+------------------------------------------------------------------------------------------------------------+

Moederbord vervangen

De stappen om het moederbord in een UCS C240 M4-server te vervangen kunnen worden doorverwezen vanaf Cisco UCS C240 M4-serverinstallatie en -servicegids

- Meld u aan bij de server met gebruik van de CIMC IP.

- Start een upgrade als de firmware niet voldoet aan de eerder gebruikte aanbevolen versie. Hier vindt u stappen voor een upgrade op basis van het besturingssysteem Cisco UCS C-Series-upgrade op rackserver

De VM's herstellen

Een instantie herstellen door een Snapshot

herstelproces

Het is mogelijk de vorige instantie opnieuw in te zetten met de momentopname die in eerdere stappen is genomen.

Stap 1 [OPTIONEEL].Als er geen vorige VMsnapshot beschikbaar is, sluit u de OSPD-knooppunt aan, waar de back-up is verzonden en zet u de back-up terug naar het oorspronkelijke OSP-knooppunt. Gebruik van "sftproot@x.x.x.x" waarbij x.x.x.x het IP van het oorspronkelijke OSPD-overleg is. Sla het snapshot-bestand in /tmp-map op.

Stap 2.Sluit aan op het OSPD-knooppunt waar de instantie opnieuw wordt ingezet.

Bron de omgevingsvariabelen met deze opdracht:

Bron de omgevingsvariabelen met deze opdracht:

# source /home/stack/pod1-stackrc-Core-CPAR

Stap 3.Om de momentopname als een afbeelding te gebruiken, moet deze als zodanig naar de horizon worden geüpload. Gebruik de volgende opdracht om dit te doen.

#glance image-create -- AAA-CPAR-Date-snapshot.qcow2 --container-format bare --disk-format qcow2 --name AAA-CPAR-Date-snapshot

Het proces is aan de horizon zichtbaar.

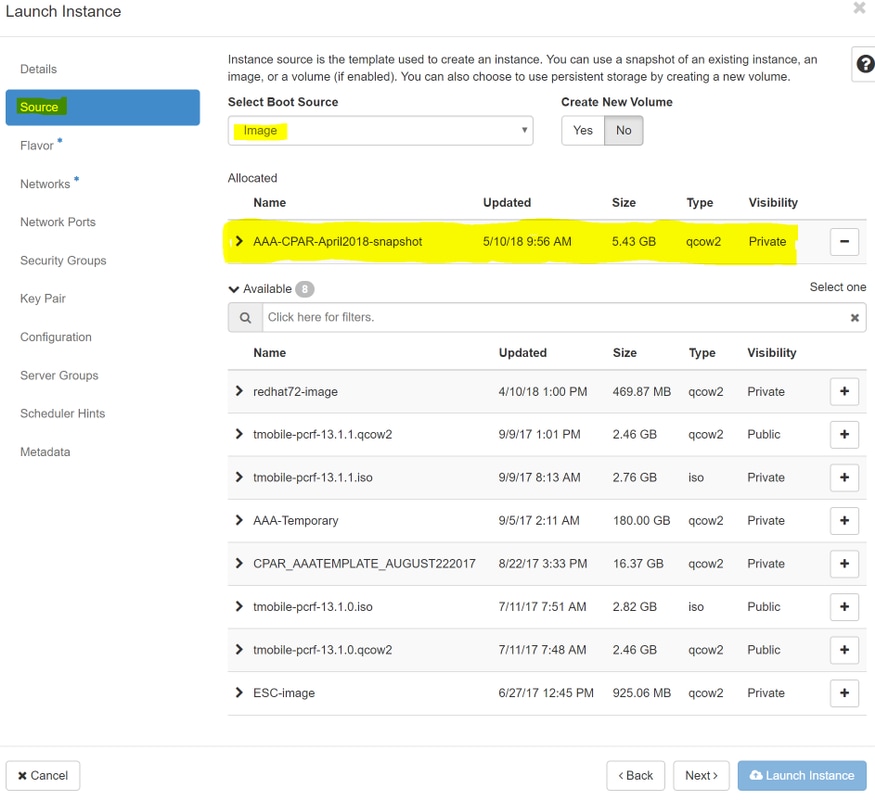

Stap 4.Ga in Horizon naar Project > Afbeeldingen en klik op Instantie starten.

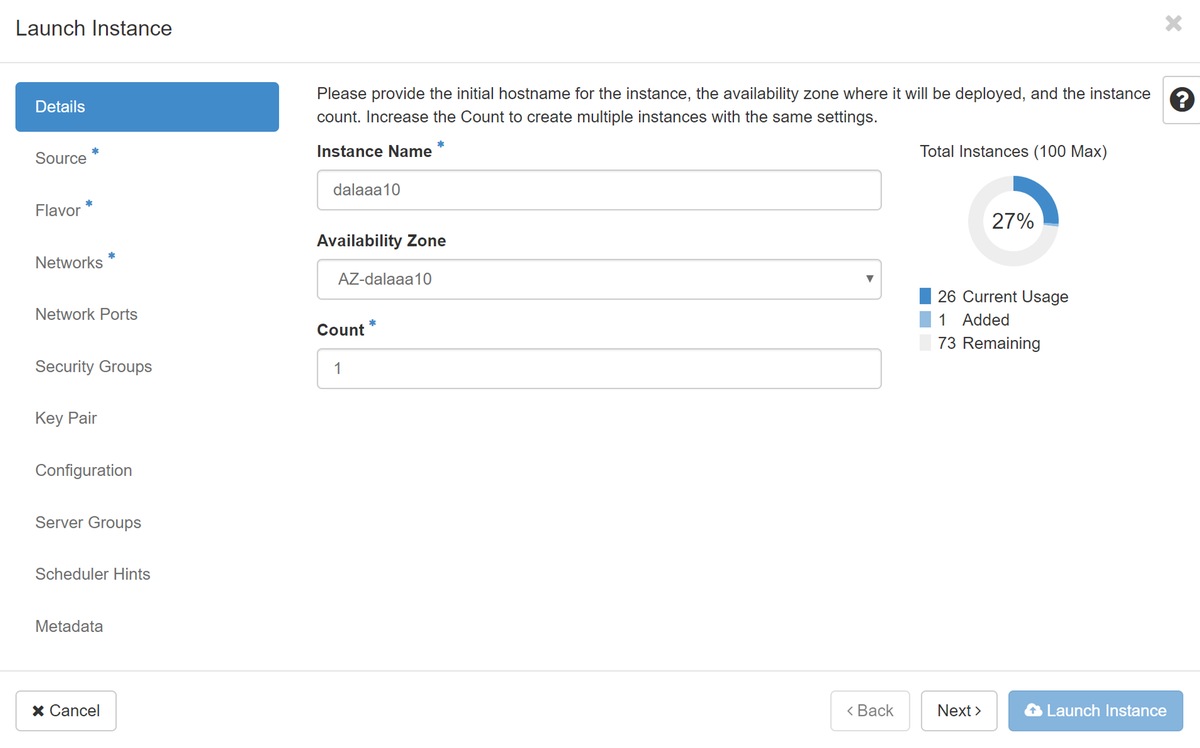

Stap 5.Vul de naam van de instantie in en kies de beschikbare zone.

Stap 6.Kies in het tabblad Bron de afbeelding om de instantie te maken. In het menu Opstartbron selecteren wordt er een lijst met afbeeldingen hier weergegeven. Selecteer de afbeeldingen die eerder zijn geüpload terwijl u op + teken klikt.

Stap 7.Kies in het tabblad Smaak de AAA-afbeelding terwijl u op +teken klikt.

Stap 8.Ten slotte navigeer u naar het tabblad Netwerk en kies de netwerken die de instantie nodig heeft terwijl u op + teken klikt. Selecteer in dit geval diameter-soutable1, straal-routable1 en tb1-gmmt.

Stap 9. Klik tot slot op de instantie Start om het te maken. De voortgang kan in Horizon worden gevolgd:

Na een paar minuten wordt de instantie volledig geïnstalleerd en klaar voor gebruik.

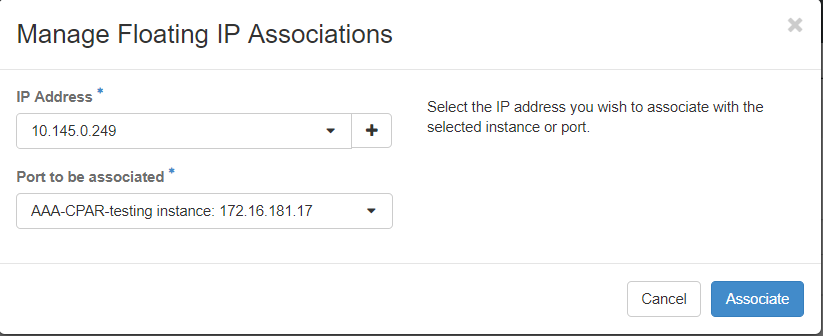

Een drijvend IP-adres maken en toewijzen

Een drijvend IP-adres is een routeerbaar adres, wat betekent dat het bereikbaar is vanaf de buitenkant van de Ultra M/OpenStack-architectuur en het kan communiceren met andere knooppunten van het netwerk.

Stap 1.Klik in het bovenste menu Horizon op Admin > Zwevende IP’s.

Stap 2. Klik op de knop ToewijzenIP aan Project.

Stap 3. Selecteer in het venster Allocation Floating IP de Pools waarvan het nieuwe zwevende IP deel uitmaakt, de Projectie waar deze zal worden toegewezen, en het nieuwe IP-adres.

Bijvoorbeeld:

Stap 4.Klik op de knop AllocationFloating IP.

Stap 5. In het bovenste menu Horizon navigeer naarProject > Afstanden.

Stap 6.In de kolom Actie klikt u op het pijltje dat in de knop Snapshot maken wijst, verschijnt er een menu. Selecteer de optie Zwevende IP-communicatie associëren.

Stap 7. Selecteer het corresponderende zwevende IP-adres dat bedoeld is om in het IP-adresveld te worden gebruikt, en kies de corresponderende beheerinterface (eth0) van de nieuwe instantie waar deze zwevende IP in de aan te sluiten poort zal worden toegewezen. Raadpleeg de volgende afbeelding als voorbeeld van deze procedure.

Stap 8. Klik tot slot op knop Associeren.

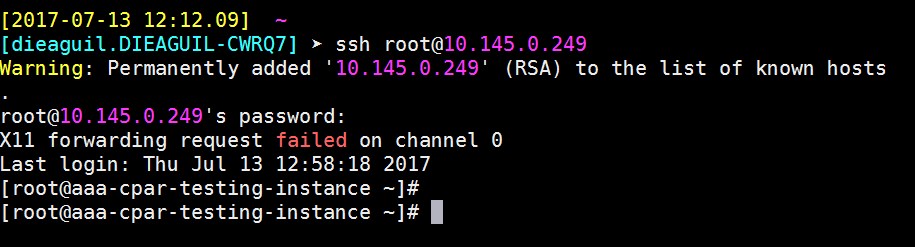

SSH’s inschakelen

Stap 1.In het bovenste menu Horizon navigeer naar Project > Samenstellingen.

Stap 2.Klik op de naam van de instantie/VM die in sectieLunch een nieuw exemplaar is gemaakt.

Stap 3. Klik op Consoletabon. Dit geeft de opdrachtregel-interface van de VM weer.

Stap 4.Voer de juiste inlogreferenties in zodra de CLI is weergegeven:

Gebruikersnaam:root

Wachtwoord:cisco123

Stap 5.Voer in de CLI de commandvi/etc/ssh/sshd_configuratie in om de configuratie van de stuurgroep te bewerken.

Stap 6. Zodra het configuratie-bestand van de SSH is geopend, drukt u opIom het bestand te bewerken. Raadpleeg het gedeelte hieronder en wijzig de eerste regel van Wachtwoordverificatie en vervolgens de wachtwoordverificatie en de wachtwoordverificatie ja.

Stap 7.Druk op ESC en voer:wq! in om sshd_fig bestandswijzigingen op te slaan.

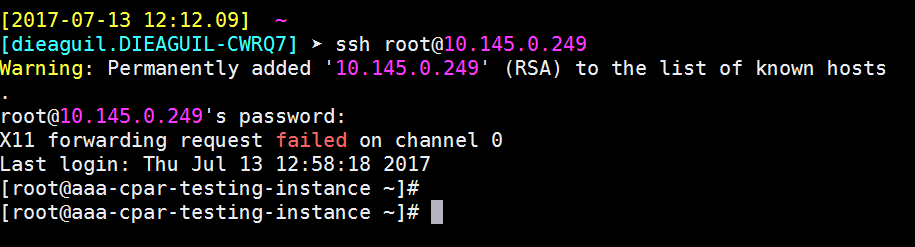

Stap 8. Voer de basisservice opnieuw uit.

Stap 9.Om de wijzigingen in de SSH-configuratie op de juiste wijze te kunnen testen, opent u een SSH-client en probeert u een beveiligde verbinding op afstand op te zetten met behulp van de aan de instantie toegewezen zwevende IP (d.w.z. 10.145.0.249) en de gebruikersnaam.

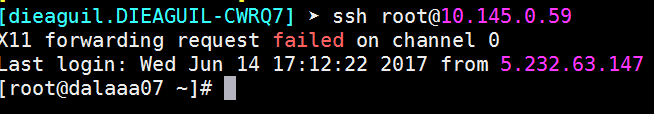

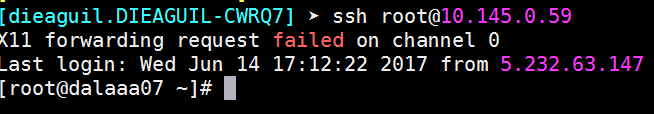

Een SSH-sessie opzetten

Open een SSH-sessie met behulp van het IP-adres van de betreffende VM/server waar de toepassing is geïnstalleerd.

CPAR-instel

Volg de onderstaande stappen, zodra de activiteit is voltooid en de CPAR-diensten kunnen worden hersteld in de gesloten site.

- Om terug te loggen naar Horizon, navigeer naar Project > Instance > Start Instance.

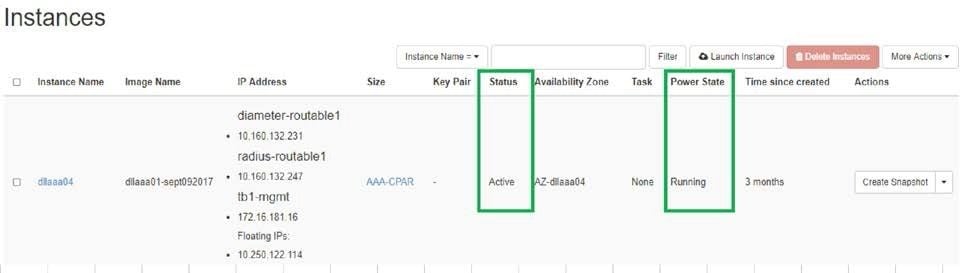

- Controleer of de status van de instantie actief is en de energietoestand actief is:

Controle van de gezondheid na de activiteit

Stap 1.Voer de opdracht /optie/CSCOar/bin/arstatus uit op OS-niveau.

[root@aaa04 ~]# /opt/CSCOar/bin/arstatus Cisco Prime AR RADIUS server running (pid: 24834) Cisco Prime AR Server Agent running (pid: 24821) Cisco Prime AR MCD lock manager running (pid: 24824) Cisco Prime AR MCD server running (pid: 24833) Cisco Prime AR GUI running (pid: 24836) SNMP Master Agent running (pid: 24835) [root@wscaaa04 ~]#

Stap 2.Voer de opdracht /opt/CSCOar/bin/aregcmd uit op OS-niveau en voer de admin-referenties in. Controleer dat CPAR Health 10 van de 10 is en de exit CPAR CLI.

[root@aaa02 logs]# /opt/CSCOar/bin/aregcmd Cisco Prime Access Registrar 7.3.0.1 Configuration Utility Copyright (C) 1995-2017 by Cisco Systems, Inc. All rights reserved. Cluster: User: admin Passphrase: Logging in to localhost [ //localhost ] LicenseInfo = PAR-NG-TPS 7.2(100TPS:) PAR-ADD-TPS 7.2(2000TPS:) PAR-RDDR-TRX 7.2() PAR-HSS 7.2() Radius/ Administrators/ Server 'Radius' is Running, its health is 10 out of 10 --> exit

Stap 3.Start het opdrachtnetstat | de diameter van de massa en controleer of alle DRA-verbindingen zijn aangelegd.

De hieronder genoemde uitvoer is bestemd voor een omgeving waarin Diameter-koppelingen worden verwacht. Als er minder links worden weergegeven, betekent dit dat de DRA wordt losgekoppeld van het geluid dat moet worden geanalyseerd.

[root@aa02 logs]# netstat | grep diameter tcp 0 0 aaa02.aaa.epc.:77 mp1.dra01.d:diameter ESTABLISHED tcp 0 0 aaa02.aaa.epc.:36 tsa6.dra01:diameter ESTABLISHED tcp 0 0 aaa02.aaa.epc.:47 mp2.dra01.d:diameter ESTABLISHED tcp 0 0 aaa02.aaa.epc.:07 tsa5.dra01:diameter ESTABLISHED tcp 0 0 aaa02.aaa.epc.:08 np2.dra01.d:diameter ESTABLISHED

Stap 4.Controleer dat het TPS-logbestand toont dat verzoeken worden verwerkt door CPAR. De uitgezette waarden vertegenwoordigen de TPS en dat zijn de waarden waaraan we aandacht moeten besteden.

De waarde van TPS mag niet hoger zijn dan 1500.

[root@wscaaa04 ~]# tail -f /opt/CSCOar/logs/tps-11-21-2017.csv 11-21-2017,23:57:35,263,0 11-21-2017,23:57:50,237,0 11-21-2017,23:58:05,237,0 11-21-2017,23:58:20,257,0 11-21-2017,23:58:35,254,0 11-21-2017,23:58:50,248,0 11-21-2017,23:59:05,272,0 11-21-2017,23:59:20,243,0 11-21-2017,23:59:35,244,0 11-21-2017,23:59:50,233,0

Stap 5.Zoek alle "error" of "alarm" berichten in name_Straal_1_log

[root@aaa02 logs]# grep -E "error|alarm" name_radius_1_log

Stap 6.Controleer de hoeveelheid geheugen die het CPAR-proces gebruikt door de volgende opdracht uit te geven:

bovenkant | straal

[root@sfraaa02 ~]# top | grep radius 27008 root 20 0 20.228g 2.413g 11408 S 128.3 7.7 1165:41 radius

Deze gemarkeerde waarde moet lager zijn dan: 7 GB, het maximum dat op toepassingsniveau is toegestaan.

Moederbordvervanging in OSD computing-knooppunt

Voor de activiteit worden de VM's die in de Computeknoop worden geserveerd, op een slinkse manier afgekoppeld en wordt de CEPH in de onderhoudsmodus geplaatst. Zodra het moederbord is vervangen, worden de VM's weer teruggezet en wordt de CEPH uit de onderhoudsmodus verwijderd.

Identificeer de VM's die worden Hosted in het OSD-computing knooppunt

Identificeer de VM's die op de OSD-computerserver worden gehost.

[stack@director ~]$ nova list --field name,host | grep osd-compute-0 | 46b4b9eb-a1a6-425d-b886-a0ba760e6114 | AAA-CPAR-testing-instance | pod2-stack-compute-4.localdomain |

Back-up: Snapshot-proces

CPAR-toepassingssluiting

Stap 1. Open elke SSH-client die is aangesloten op het netwerk en sluit een verbinding aan op de CPAR-instantie.

Het is belangrijk niet alle 4 AAA-gevallen tegelijkertijd binnen één site te sluiten, maar het één voor één te doen.

Stap 2.Sluit de CPAR-toepassing met deze opdracht af:

/opt/CSCOar/bin/arserver stop A Message stating “Cisco Prime Access Registrar Server Agent shutdown complete.” Should show up

Opmerking: Als een gebruiker een CLI-sessie open heeft gelaten, werkt de opdracht Landserver stop niet en wordt het volgende bericht weergegeven:

ERROR: You can not shut down Cisco Prime Access Registrar while the CLI is being used. Current list of running CLI with process id is: 2903 /opt/CSCOar/bin/aregcmd –s

In dit voorbeeld moet het gemarkeerde proces id 2903 worden beëindigd voordat CPAR kan worden gestopt. Als dit zich voordoet, dient u dit proces met deze opdracht te beëindigen:

kill -9 *process_id*

Herhaal dan de stap 1.

Stap 3.Controleer dat de CPAR-toepassing inderdaad werd afgesloten met deze opdracht:

/opt/CSCOar/bin/arstatus

Deze berichten verschijnen :

Cisco Prime Access Registrar Server Agent not running Cisco Prime Access Registrar GUI not running

VM Snapshot-taak

Stap 1.Voer de website Horizon GUI in die overeenkomt met de site (City) waaraan momenteel wordt gewerkt.

Bij het bereiken van de Horizon wordt het beeld dat wordt getoond waargenomen:

Stap 2. Navigeer naar Project > Instellingen, zoals in de afbeelding.

Als de gebruikte gebruiker CPAR was, verschijnen alleen de 4 AAA-instellingen in dit menu.

Stap 3.Sluit slechts één exemplaar tegelijk en herhaal het gehele proces in dit document.

Om de VM te sluiten, navigeer naar Handelingen > Instantie afsluiten en bevestig uw selectie.

Stap 4.Bevestig dat de instantie inderdaad werd afgesloten door de Status = Shutoff en Power State = Down te controleren.

Deze stap beëindigt het CPAR sluitingsproces.

VM Snapshot

Zodra de CPAR-VM's zijn gezakt, kunnen de momentopnamen parallel worden genomen, aangezien ze tot onafhankelijke computers behoren.

De vier QCOW2-bestanden worden parallel aangemaakt.

Neem een momentopname van elk AAA-exemplaar (25 minuten - 1 uur) (25 minuten voor instanties die een qkoe-afbeelding als bron hebben gebruikt en 1 uur voor gevallen waarin een rauwe afbeelding als bron wordt gebruikt)

Stap 1. Meld u aan bij de HorizonGUI van POD.

Stap 2. Na het inloggen, gaat u naar het gedeelte Project > Samenstellen > Instanties in het bovenste menu en zoekt u de AAA-instanties.

Stap 3. Klik op de knop Snapshot maken om door te gaan met het maken van een snapshot (dit moet worden uitgevoerd op de betreffende AAA-instantie).

Stap 4. Zodra de snapshot draait, navigeer naar het menu AFBEELDINGEN en controleer of alle klaar is en rapporteer geen problemen.

Stap 5. De volgende stap is het downloaden van de snapshot op een QCOW2-formaat en het overdragen aan een externe entiteit voor het geval dat de OspD tijdens dit proces verloren gaat. Om dit te bereiken, moet u de snapshot met deze gezagslijst identificeren op het niveau van de OspD.

[root@elospd01 stack]# glance image-list +--------------------------------------+---------------------------+ | ID | Name | +--------------------------------------+---------------------------+ | 80f083cb-66f9-4fcf-8b8a-7d8965e47b1d | AAA-Temporary | | 22f8536b-3f3c-4bcc-ae1a-8f2ab0d8b950 | ELP1 cluman 10_09_2017 | | 70ef5911-208e-4cac-93e2-6fe9033db560 | ELP2 cluman 10_09_2017 | | e0b57fc9-e5c3-4b51-8b94-56cbccdf5401 | ESC-image | | 92dfe18c-df35-4aa9-8c52-9c663d3f839b | lgnaaa01-sept102017 | | 1461226b-4362-428b-bc90-0a98cbf33500 | tmobile-pcrf-13.1.1.iso | | 98275e15-37cf-4681-9bcc-d6ba18947d7b | tmobile-pcrf-13.1.1.qcow2 | +--------------------------------------+---------------------------+

Stap 6. Nadat u de snapshot hebt geïdentificeerd, moet u deze downloaden (in dit geval is dit het geval dat hierboven groen is gemarkeerd), kunt u het nu downloaden op een QCOW2-indeling met deze opdrachtbalk, afbeelding-download zoals hieronder wordt getoond.

[root@elospd01 stack]# glance image-download 92dfe18c-df35-4aa9-8c52-9c663d3f839b --file /tmp/AAA-CPAR-LGNoct192017.qcow2 &

- Het "&"-proces wordt naar de achtergrond verzonden. Het zal enige tijd duren om deze actie te voltooien, zodra het wordt gedaan, kan het beeld in /tmp folder vinden.

- Bij het verzenden van het proces naar de achtergrond, als de connectiviteit is verloren, wordt het proces ook stopgezet.

- Voer de opdracht "afstand -h" uit zodat in het geval van een SSH-verbinding het proces nog loopt en eindigt op de OSPD.

7. Zodra het downloadproces is voltooid, moet een compressieverhouding worden uitgevoerd, aangezien deze snapshot met ZEROES kan worden ingevuld vanwege processen, taken en tijdelijke bestanden die door het besturingssysteem worden verwerkt. De opdracht die gebruikt moet worden voor het comprimeren van bestanden is ondoorzichtig.

[root@elospd01 stack]# virt-sparsify AAA-CPAR-LGNoct192017.qcow2 AAA-CPAR-LGNoct192017_compressed.qcow2

Dit proces duurt enige tijd (ongeveer 10 tot 15 minuten). Als dit eenmaal is voltooid, is het resulterende bestand het bestand dat naar een externe entiteit moet worden overgedragen zoals in de volgende stap is gespecificeerd.

Om dit te bereiken, moet u de volgende opdracht uitvoeren en naar de eigenschap "corrupt" zoeken aan het einde van de uitvoer.

[root@wsospd01 tmp]# qemu-img info AAA-CPAR-LGNoct192017_compressed.qcow2 image: AAA-CPAR-LGNoct192017_compressed.qcow2 file format: qcow2 virtual size: 150G (161061273600 bytes) disk size: 18G cluster_size: 65536 Format specific information: compat: 1.1 lazy refcounts: false refcount bits: 16 corrupt: false

Om een probleem te vermijden waarbij het OspD verloren gaat, moet de recent gecreëerde momentopname op het QCOW2-formaat worden overgedragen aan een externe entiteit. Voordat u de bestandsoverdracht wilt starten, moeten we controleren of de bestemming voldoende beschikbare schijfruimte heeft, gebruikt u de opdracht "df -kh" om de geheugenruimte te controleren. Ons advies is om het tijdelijk over te brengen naar de OspD van een andere site door gebruik te maken van SFTP "sftproot@x.x.x.x", waarbij x.x.x.x het IP van een externe OspD is. Om de overdracht te versnellen, kan de bestemming naar meerdere OSPF's worden gestuurd. Op dezelfde manier kunnen we de volgende opdracht SCP *name_of_the_file*.qkoe2 root@ x.x.x.x:/tmp (waarbij x.x.x.x de IP van een externe OspD is) gebruiken om het bestand naar een andere OspD over te brengen.

CEPH in onderhoudsmodus plaatsen

Stap 1. Controleer of de status van de ceptboom in de server aanwezig is

[heat-admin@pod2-stack-osd-compute-0 ~]$ sudo ceph osd tree

ID WEIGHT TYPE NAME UP/DOWN REWEIGHT PRIMARY-AFFINITY

-1 13.07996 root default

-2 4.35999 host pod2-stack-osd-compute-0

0 1.09000 osd.0 up 1.00000 1.00000

3 1.09000 osd.3 up 1.00000 1.00000

6 1.09000 osd.6 up 1.00000 1.00000

9 1.09000 osd.9 up 1.00000 1.00000

-3 4.35999 host pod2-stack-osd-compute-1

1 1.09000 osd.1 up 1.00000 1.00000

4 1.09000 osd.4 up 1.00000 1.00000

7 1.09000 osd.7 up 1.00000 1.00000

10 1.09000 osd.10 up 1.00000 1.00000

-4 4.35999 host pod2-stack-osd-compute-2

2 1.09000 osd.2 up 1.00000 1.00000

5 1.09000 osd.5 up 1.00000 1.00000

8 1.09000 osd.8 up 1.00000 1.00000

11 1.09000 osd.11 up 1.00000 1.00000

Stap 2. Meld u aan bij het OSD computing-knooppunt en zet de CEPH in de onderhoudsmodus.

[root@pod2-stack-osd-compute-0 ~]# sudo ceph osd set norebalance

[root@pod2-stack-osd-compute-0 ~]# sudo ceph osd set noout

[root@pod2-stack-osd-compute-0 ~]# sudo ceph status

cluster eb2bb192-b1c9-11e6-9205-525400330666

health HEALTH_WARN

noout,norebalance,sortbitwise,require_jewel_osds flag(s) set

monmap e1: 3 mons at {pod2-stack-controller-0=11.118.0.10:6789/0,pod2-stack-controller-1=11.118.0.11:6789/0,pod2-stack-controller-2=11.118.0.12:6789/0}

election epoch 10, quorum 0,1,2 pod2-stack-controller-0,pod2-stack-controller-1,pod2-stack-controller-2

osdmap e79: 12 osds: 12 up, 12 in

flags noout,norebalance,sortbitwise,require_jewel_osds

pgmap v22844323: 704 pgs, 6 pools, 804 GB data, 423 kobjects

2404 GB used, 10989 GB / 13393 GB avail

704 active+clean

client io 3858 kB/s wr, 0 op/s rd, 546 op/s wr

Opmerking: Wanneer de CEPH wordt verwijderd, komt de VNF-HD-VAL in de gedegradeerde staat terecht, maar de hd-schijf moet nog toegankelijk zijn

GainMaker-voeding

Uitgeschakeld knooppunt

- Zo schakelt u het exemplaar uit: nova stop <INSTANCE_NAME>

- U ziet de naam van het exemplaar met de statusschuifschakelaar.

[stack@director ~]$ nova stop aaa2-21 Request to stop server aaa2-21 has been accepted. [stack@director ~]$ nova list +--------------------------------------+---------------------------+---------+------------+-------------+------------------------------------------------------------------------------------------------------------+ | ID | Name | Status | Task State | Power State | Networks | +--------------------------------------+---------------------------+---------+------------+-------------+------------------------------------------------------------------------------------------------------------+ | 46b4b9eb-a1a6-425d-b886-a0ba760e6114 | AAA-CPAR-testing-instance | ACTIVE | - | Running | tb1-mgmt=172.16.181.14, 10.225.247.233; radius-routable1=10.160.132.245; diameter-routable1=10.160.132.231 | | 3bc14173-876b-4d56-88e7-b890d67a4122 | aaa2-21 | SHUTOFF | - | Shutdown | diameter-routable1=10.160.132.230; radius-routable1=10.160.132.248; tb1-mgmt=172.16.181.7, 10.225.247.234 | | f404f6ad-34c8-4a5f-a757-14c8ed7fa30e | aaa21june | ACTIVE | - | Running | diameter-routable1=10.160.132.233; radius-routable1=10.160.132.244; tb1-mgmt=172.16.181.10 | +--------------------------------------+---------------------------+---------+------------+-------------+------------------------------------------------------------------------------------------------------------+

Moederbord vervangen

De stappen om het moederbord in een UCS C240 M4-server te vervangen kunnen worden doorverwezen vanaf Cisco UCS C240 M4-serverinstallatie en -servicegids

- Meld u aan bij de server met gebruik van de CIMC IP.

- Start een upgrade als de firmware niet voldoet aan de eerder gebruikte aanbevolen versie. Hier vindt u stappen voor een upgrade op basis van het besturingssysteem Cisco UCS C-Series-upgrade op rackserver

Verplaats CEPH uit de onderhoudsmodus

Aanmelden bij het OSD computing-knooppunt en CEPH uit de onderhoudsmodus verplaatsen.

[root@pod2-stack-osd-compute-0 ~]# sudo ceph osd unset norebalance

[root@pod2-stack-osd-compute-0 ~]# sudo ceph osd unset noout

[root@pod2-stack-osd-compute-0 ~]# sudo ceph status

cluster eb2bb192-b1c9-11e6-9205-525400330666

health HEALTH_OK

monmap e1: 3 mons at {pod2-stack-controller-0=11.118.0.10:6789/0,pod2-stack-controller-1=11.118.0.11:6789/0,pod2-stack-controller-2=11.118.0.12:6789/0}

election epoch 10, quorum 0,1,2 pod2-stack-controller-0,pod2-stack-controller-1,pod2-stack-controller-2

osdmap e81: 12 osds: 12 up, 12 in

flags sortbitwise,require_jewel_osds

pgmap v22844355: 704 pgs, 6 pools, 804 GB data, 423 kobjects

2404 GB used, 10989 GB / 13393 GB avail

704 active+clean

client io 3658 kB/s wr, 0 op/s rd, 502 op/s wr

De VM's herstellen

Een instantie herstellen door een Snapshot

Herstelproces:

Het is mogelijk de vorige instantie opnieuw in te zetten met de momentopname die in eerdere stappen is genomen.

Stap 1 [OPTIONEEL].Als er geen vorige VMsnapshot beschikbaar is, sluit u de OSPD-knooppunt aan, waar de back-up is verzonden en zet u de back-up terug naar het oorspronkelijke OSP-knooppunt. Gebruik van "sftproot@x.x.x.x" waarbij x.x.x.x het IP van het oorspronkelijke OSPD-overleg is. Sla het snapshot-bestand in /tmp-map op.

Stap 2.Sluit aan op het OSPD-knooppunt waar de instantie opnieuw wordt ingezet.

Bron de omgevingsvariabelen met deze opdracht:

# source /home/stack/pod1-stackrc-Core-CPAR

Stap 3.Om de momentopname als een afbeelding te gebruiken, moet deze als zodanig naar de horizon worden geüpload. Gebruik de volgende opdracht om dit te doen.

#glance image-create -- AAA-CPAR-Date-snapshot.qcow2 --container-format bare --disk-format qcow2 --name AAA-CPAR-Date-snapshot

Het proces is aan de horizon zichtbaar.

Stap 4.Ga in Horizon naar Project > Afbeeldingen en klik op Instantie starten.

Stap 5.Vul de naam van de instantie in en kies de beschikbare zone.

Stap 6.Kies in het tabblad Bron het beeld om de instantie te maken. In het menu Opstartbron selecteren wordt er een lijst met afbeeldingen hier weergegeven. Selecteer de afbeeldingen die eerder zijn geüpload terwijl u op + teken klikt.

Stap 7.Kies in het tabblad Smaak de AAA-afbeelding terwijl u op het +-teken klikt.

Stap 8.Ten slotte navigeer u naar het tabblad Network en kies de netwerken die de instantie nodig heeft, terwijl u op het +-teken klikt. Selecteer in dit geval diameter-soutable1, straal-routable1 en tb1-gmmt.

Stap 9. Klik tot slot op de instantie Start om het te maken. De voortgang kan in Horizon worden gevolgd:

Na een paar minuten wordt de instantie volledig geïnstalleerd en klaar voor gebruik.

Een drijvend IP-adres maken en toewijzen

Een drijvend IP-adres is een routeerbaar adres, wat betekent dat het bereikbaar is vanaf de buitenkant van de Ultra M/OpenStack-architectuur en het kan communiceren met andere knooppunten van het netwerk.

Stap 1.Klik in het bovenste menu Horizon op Admin > Zwevende IP’s.

Stap 2.Klik op de knop ToewijzenIP aan Project.

Stap 3. Selecteer in het venster Allocation Floating IP de Pools waarvan het nieuwe zwevende IP deel uitmaakt, de Projectie waar deze zal worden toegewezen, en het nieuwe IP-adres.

Bijvoorbeeld:

Stap 4.Klik op de knop AllocationFloating IP.

Stap 5. In het bovenste menu Horizon navigeer naarProject > Afstanden.

Stap 6. Klik in de kolom Action op het pijltje dat in de knop Snapshot maken wijst, u dient een menu te selecteren. Selecteer de optie Zwevende IP-communicatie associëren.

Stap 7. Selecteer het corresponderende zwevende IP-adres dat bedoeld is om in het IP-adresveld te worden gebruikt, en kies de corresponderende beheerinterface (eth0) van de nieuwe instantie waar deze zwevende IP in de aan te sluiten poort zal worden toegewezen. Raadpleeg de volgende afbeelding als voorbeeld van deze procedure.

Stap 8.Klik tot slot op de knop Koppelen.

SSH’s inschakelen

Stap 1.In het bovenste menu Horizon navigeer naar Project > Samenstellingen.

Stap 2.Klik op de naam van de instantie/VM die in sectieLunch een nieuw exemplaar is gemaakt.

Stap 3.Klik op Consoletab. Dit geeft de CLI van de VM weer.

Stap 4. Zodra de CLI is weergegeven, voert u de juiste inlogaanmeldingsgegevens in:

Gebruikersnaam:root

Wachtwoord:cisco123

Stap 5.Voer in de CLI de commandvi/etc/ssh/sshd_configuratie in om de configuratie van de stuurgroep te bewerken.

Stap 6. Zodra het configuratie-bestand van de SSH is geopend, drukt u opIom het bestand te bewerken. Kijk vervolgens naar de sectie die hier wordt weergegeven en verander de eerste regel van Wachtwoordverificatie zonder Wachtwoord verificatie.

Stap 7.Druk op ESC en voer:wq! in om sshd_fig bestandswijzigingen op te slaan.

Stap 8. Start de standaardservice opnieuw.

Stap 9.Om de wijzigingen in de SSH-configuratie op de juiste wijze te kunnen testen, opent u een SSH-client en probeert u een beveiligde verbinding op afstand op te zetten met behulp van de aan de instantie toegewezen zwevende IP (d.w.z. 10.145.0.249) en de gebruikersnaam.

Een SSH-sessie instellen

Open een SSH-sessie met behulp van het IP-adres van de betreffende VM/server waar de toepassing is geïnstalleerd.

CPAR-instel

Volg deze stappen, zodra de activiteit is voltooid en de CPAR-diensten kunnen worden hersteld in de gesloten site.

- Login terug naar Horizon, navigeer naar Project > Instantie > Instantie starten.

- Controleer of de status van de instantie actief is en de energietoestand actief is:

Controle van de gezondheid na de activiteit

Stap 1. Start de opdracht /optioneel/CSCOar/bin/arstatus op OS-niveau.

[root@aaa04 ~]# /opt/CSCOar/bin/arstatus Cisco Prime AR RADIUS server running (pid: 24834) Cisco Prime AR Server Agent running (pid: 24821) Cisco Prime AR MCD lock manager running (pid: 24824) Cisco Prime AR MCD server running (pid: 24833) Cisco Prime AR GUI running (pid: 24836) SNMP Master Agent running (pid: 24835) [root@wscaaa04 ~]#

Stap 2. Start de opdracht /opt/CSCOar/bin/aregcmd op OS-niveau en voer de admin-referenties in. Controleer dat CPAR Health 10 van de 10 is en de exit CPAR CLI.

[root@aaa02 logs]# /opt/CSCOar/bin/aregcmd Cisco Prime Access Registrar 7.3.0.1 Configuration Utility Copyright (C) 1995-2017 by Cisco Systems, Inc. All rights reserved. Cluster: User: admin Passphrase: Logging in to localhost [ //localhost ] LicenseInfo = PAR-NG-TPS 7.2(100TPS:) PAR-ADD-TPS 7.2(2000TPS:) PAR-RDDR-TRX 7.2() PAR-HSS 7.2() Radius/ Administrators/ Server 'Radius' is Running, its health is 10 out of 10 --> exit

Stap 3.Start het opdrachtnetstat | de diameter van de massa en controleer of alle DRA-verbindingen zijn aangelegd.

De hier genoemde uitvoer is bestemd voor een omgeving waarin Diameter-koppelingen worden verwacht. Als er minder links worden weergegeven, betekent dit dat de DRA wordt losgekoppeld van het geluid dat moet worden geanalyseerd.

[root@aa02 logs]# netstat | grep diameter tcp 0 0 aaa02.aaa.epc.:77 mp1.dra01.d:diameter ESTABLISHED tcp 0 0 aaa02.aaa.epc.:36 tsa6.dra01:diameter ESTABLISHED tcp 0 0 aaa02.aaa.epc.:47 mp2.dra01.d:diameter ESTABLISHED tcp 0 0 aaa02.aaa.epc.:07 tsa5.dra01:diameter ESTABLISHED tcp 0 0 aaa02.aaa.epc.:08 np2.dra01.d:diameter ESTABLISHED

Stap 4.Controleer dat het TPS-logbestand toont dat verzoeken worden verwerkt door CPAR. De uitgezette waarden vertegenwoordigen de TPS en dat zijn de waarden waaraan we aandacht moeten besteden.

De waarde van TPS mag niet hoger zijn dan 1500.

[root@wscaaa04 ~]# tail -f /opt/CSCOar/logs/tps-11-21-2017.csv 11-21-2017,23:57:35,263,0 11-21-2017,23:57:50,237,0 11-21-2017,23:58:05,237,0 11-21-2017,23:58:20,257,0 11-21-2017,23:58:35,254,0 11-21-2017,23:58:50,248,0 11-21-2017,23:59:05,272,0 11-21-2017,23:59:20,243,0 11-21-2017,23:59:35,244,0 11-21-2017,23:59:50,233,0

Stap 5.Zoek alle "error" of "alarm" berichten in name_Straal_1_log

[root@aaa02 logs]# grep -E "error|alarm" name_radius_1_log

Stap 6.Controleer de hoeveelheid geheugen die in het CPAR-proces met deze opdracht wordt gebruikt:

bovenkant | straal

[root@sfraaa02 ~]# top | grep radius 27008 root 20 0 20.228g 2.413g 11408 S 128.3 7.7 1165:41 radius

Deze gemarkeerde waarde moet lager zijn dan: 7 GB, het maximum dat op toepassingsniveau is toegestaan.

Moederboard vervanging in controllerknooppunt

Controleer de controllerstatus en gebruik Cluster in onderhoudsmodus

Vanaf OSPF is inloggen op de controller en controleren of pc's in goede staat zijn - alle drie controllers online en galera tonen alle drie controllers als Master.

[heat-admin@pod2-stack-controller-0 ~]$ sudo pcs status

Cluster name: tripleo_cluster

Stack: corosync

Current DC: pod2-stack-controller-2 (version 1.1.15-11.el7_3.4-e174ec8) - partition with quorum

Last updated: Fri Jul 6 09:02:52 2018Last change: Mon Jul 2 12:49:52 2018 by root via crm_attribute on pod2-stack-controller-0

3 nodes and 19 resources configured

Online: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

Full list of resources:

ip-11.120.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

Clone Set: haproxy-clone [haproxy]

Started: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

Master/Slave Set: galera-master [galera]

Masters: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

ip-192.200.0.110(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

ip-11.120.0.44(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

ip-11.118.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

Clone Set: rabbitmq-clone [rabbitmq]

Started: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

ip-10.225.247.214(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

Master/Slave Set: redis-master [redis]

Masters: [ pod2-stack-controller-2 ]

Slaves: [ pod2-stack-controller-0 pod2-stack-controller-1 ]

ip-11.119.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

openstack-cinder-volume(systemd:openstack-cinder-volume):Started pod2-stack-controller-1

Daemon Status:

corosync: active/enabled

pacemaker: active/enabled

pcsd: active/enabled

Plaats het cluster in de onderhoudsmodus

[heat-admin@pod2-stack-controller-0 ~]$ sudo pcs cluster standby

[heat-admin@pod2-stack-controller-0 ~]$ sudo pcs status

Cluster name: tripleo_cluster

Stack: corosync

Current DC: pod2-stack-controller-2 (version 1.1.15-11.el7_3.4-e174ec8) - partition with quorum

Last updated: Fri Jul 6 09:03:10 2018Last change: Fri Jul 6 09:03:06 2018 by root via crm_attribute on pod2-stack-controller-0

3 nodes and 19 resources configured

Node pod2-stack-controller-0: standby

Online: [ pod2-stack-controller-1 pod2-stack-controller-2 ]

Full list of resources:

ip-11.120.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

Clone Set: haproxy-clone [haproxy]

Started: [ pod2-stack-controller-1 pod2-stack-controller-2 ]

Stopped: [ pod2-stack-controller-0 ]

Master/Slave Set: galera-master [galera]

Masters: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

ip-192.200.0.110(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

ip-11.120.0.44(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

ip-11.118.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

Clone Set: rabbitmq-clone [rabbitmq]

Started: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

ip-10.225.247.214(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

Master/Slave Set: redis-master [redis]

Masters: [ pod2-stack-controller-2 ]

Slaves: [ pod2-stack-controller-1 ]

Stopped: [ pod2-stack-controller-0 ]

ip-11.119.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

openstack-cinder-volume(systemd:openstack-cinder-volume):Started pod2-stack-controller-1

Daemon Status:

corosync: active/enabled

pacemaker: active/enabled

pcsd: active/enabled

Moederbord vervangen

De procedure voor het vervangen van het moederbord in een UCS C240 M4-server kan worden geraadpleegd via Cisco UCS C240 M4-serverinstallatie en -servicegids

- Meld u aan bij de server met gebruik van de CIMC IP.

- Start een upgrade als de firmware niet voldoet aan de eerder gebruikte aanbevolen versie. Hier worden stappen voor een upgrade gegeven:

Cisco UCS C-Series upgrade-handleiding voor rackservers

Cluster status terugzetten

Aanmelden bij de getroffen controller, de stand-by modus verwijderen door stand-by in te stellen. Controleer dat controller online komt met cluster en galera alle drie controllers als Master. Dit kan een paar minuten duren.

[heat-admin@pod2-stack-controller-0 ~]$ sudo pcs cluster unstandby

[heat-admin@pod2-stack-controller-0 ~]$ sudo pcs status

Cluster name: tripleo_cluster

Stack: corosync

Current DC: pod2-stack-controller-2 (version 1.1.15-11.el7_3.4-e174ec8) - partition with quorum

Last updated: Fri Jul 6 09:03:37 2018Last change: Fri Jul 6 09:03:35 2018 by root via crm_attribute on pod2-stack-controller-0

3 nodes and 19 resources configured

Online: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

Full list of resources:

ip-11.120.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

Clone Set: haproxy-clone [haproxy]

Started: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

Master/Slave Set: galera-master [galera]

Masters: [ pod2-stack-controller-1 pod2-stack-controller-2 ]

Slaves: [ pod2-stack-controller-0 ]

ip-192.200.0.110(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

ip-11.120.0.44(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

ip-11.118.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

Clone Set: rabbitmq-clone [rabbitmq]

Started: [ pod2-stack-controller-1 pod2-stack-controller-2 ]

Stopped: [ pod2-stack-controller-0 ]

ip-10.225.247.214(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

Master/Slave Set: redis-master [redis]

Masters: [ pod2-stack-controller-2 ]

Slaves: [ pod2-stack-controller-0 pod2-stack-controller-1 ]

ip-11.119.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

openstack-cinder-volume(systemd:openstack-cinder-volume):Started pod2-stack-controller-1

Daemon Status:

corosync: active/enabled

pacemaker: active/enabled

pcsd: active/enabled

Bijgedragen door Cisco-engineers

- Karthikeyan DachanamoorthyCisco geavanceerde services

- Harshita BhardwajCisco geavanceerde services

Contact Cisco

- Een ondersteuningscase openen

- (Vereist een Cisco-servicecontract)

Feedback

Feedback