Probleemoplossing "QM_SANITY_WARNING" bericht op router van 12000 serie

Downloadopties

Inclusief taalgebruik

De documentatie van dit product is waar mogelijk geschreven met inclusief taalgebruik. Inclusief taalgebruik wordt in deze documentatie gedefinieerd als taal die geen discriminatie op basis van leeftijd, handicap, gender, etniciteit, seksuele oriëntatie, sociaaleconomische status of combinaties hiervan weerspiegelt. In deze documentatie kunnen uitzonderingen voorkomen vanwege bewoordingen die in de gebruikersinterfaces van de productsoftware zijn gecodeerd, die op het taalgebruik in de RFP-documentatie zijn gebaseerd of die worden gebruikt in een product van een externe partij waarnaar wordt verwezen. Lees meer over hoe Cisco gebruikmaakt van inclusief taalgebruik.

Over deze vertaling

Cisco heeft dit document vertaald via een combinatie van machine- en menselijke technologie om onze gebruikers wereldwijd ondersteuningscontent te bieden in hun eigen taal. Houd er rekening mee dat zelfs de beste machinevertaling niet net zo nauwkeurig is als die van een professionele vertaler. Cisco Systems, Inc. is niet aansprakelijk voor de nauwkeurigheid van deze vertalingen en raadt aan altijd het oorspronkelijke Engelstalige document (link) te raadplegen.

Inleiding

Dit document beschrijft de procedure om de berichten van de pakketbuffer depletion te zuiveren die op verschillende lijnkaarten in een router van 12000 Series cisco kunnen gebeuren die IOS in werking stelt. Het is veel te gebruikelijk om kostbare tijd en middelen te zien verspillen aan het vervangen van de hardware die eigenlijk goed functioneert door gebrek aan kennis over GSR bufferbeheer.

Voorwaarden

Vereisten

De lezer moet een overzicht hebben van de Cisco 12000 Series routerarchitectuur.

Gebruikte componenten

De informatie in dit document is gebaseerd op de volgende software- en hardware-versies:

- Cisco 12000 Series internetrouter

- Cisco IOS®-softwarerelease die de Gigabit Switch-router ondersteunt

De informatie in dit document is gebaseerd op de apparaten in een specifieke laboratoriumomgeving. Alle apparaten die in dit document worden gebruikt, worden gestart met een uitgeschakelde (standaard) configuratie. Als uw netwerk live is, moet u de potentiële impact van elke opdracht begrijpen.

Conventies

Probleem

GSR of 12000 Series cisco-routers hebben een werkelijk gedistribueerde architectuur. Dit betekent dat elke LC zijn eigen exemplaar van Cisco IOS-softwareafbeelding uitvoert en over de intelligentie beschikt om het pakketdoorstuurbesluit op eigen kracht te voltooien. Elke lijnkaart doet zijn eigen

- Doorsturen van zoekopdracht

- Packet-bufferbeheer

- QOS

- Flow Control

Een van de belangrijkste bediening tijdens pakketswitching in GSR is het bufferbeheer dat wordt uitgevoerd door verschillende Buffer Management ASIC’s (BMA’s) in de lijnkaarten. Hieronder staan enkele berichten met betrekking tot GSR bufferbeheer die in de routerlogboeken kunnen verschijnen terwijl in productie. In de volgende sectie zullen wij de verschillende trekkers bespreken die deze berichten konden veroorzaken om op de routerlogboeken te verschijnen en wat zijn de correctieve actie die moet worden gedaan om het probleem te verlichten. In een bepaalde situatie kan dit ook leiden tot pakketverlies dat zich kan manifesteren als protocolflappen en netwerkgevolgen kan veroorzaken.

%EE48-3-QM_SANITY_WARNING: ToFab FreeQ buffers depleted

SLOT 1:Sep 16 19:06:40.003 UTC: %EE48-3-QM_SANITY_WARNING: Few free buffers(1) are available in ToFab FreeQ pool# 2

SLOT 8:Sep 16 19:06:45.943 UTC: %EE48-3-QM_SANITY_WARNING: Few free buffers(0) are available in ToFab FreeQ pool# 1

SLOT 0:Sep 16 19:06:46.267 UTC: %EE48-3-QM_SANITY_WARNING: Few free buffers(2) are available in ToFab FreeQ pool# 2

SLOT 8:Sep 16 19:06:47.455 UTC: %EE48-3-QM_SANITY_WARNING: ToFab FreeQ buffers depleted. Recarving the ToFab buffers

SLOT 8:Sep 16 19:06:47.471 UTC: %EE192-3-BM_QUIESCE:

Oplossing

Achtergrond

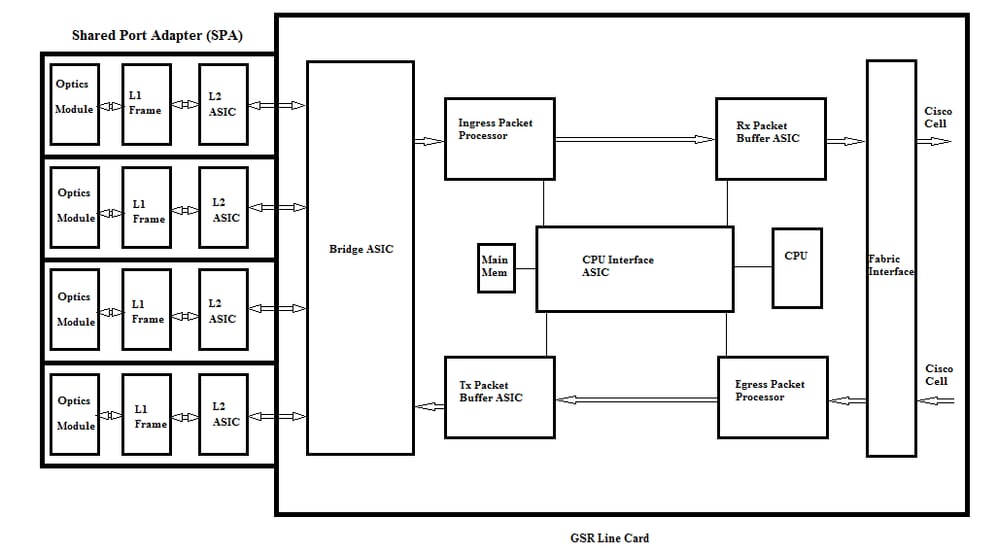

Om de QM-SANITY-waarschuwingsfouten op te lossen, moeten we de pakketstroom op een GSR-lijnkaart begrijpen. In de onderstaande afbeelding worden de belangrijkste blokken van een C12k-lijnkaart en het pakketstroompad uitgelegd.

De lijnkaart (LC) op een Cisco 12000 Series internetrouter heeft twee typen geheugen:

- Route of processorgeheugen (Dynamic RAM - DRAM): Met dit geheugen kan de on-board processor voornamelijk Cisco IOS-software gebruiken en netwerkroutingtabellen opslaan (Forwarding Information Base - FIB, nabijheid)

- Packet memory (synchroon dynamisch RAM - SDRAM): het pakketgeheugen van de lijnkaart slaat tijdelijk gegevenspakketten op in afwachting van switchingbeslissingen van de lijnkaartprocessor.

Zoals uit het bovenstaande beeld blijkt, heeft GSR lijnkaart gespecialiseerde pakketbuffer ASIC ( Application Specific Integrated Circuit), een in elke richting van verkeersstroom die toegang biedt tot het pakketgeheugen.Deze ASIC's ook bekend als Buffer Management ASIC (BMA) doet de pakketbuffering en bufferwachtrijbeheer functie op de lijnkaart. Om hoge doorvoersnelheid/doorstuursnelheden te ondersteunen, wordt het pakketgeheugen in beide richtingen in geheugenpools van verschillende grootte gesneden, die zijn ontworpen om pakketten van verschillende MTU-formaten door te sturen.

De frames die ontvangen worden door de Physical Layer Interface Module (PLIM)-kaarten zijn Layer 2 verwerkt en DMA's opgeslagen in een lokaal geheugen in de PLIM-kaart. Zodra de ontvangen data-unit is voltooid, neemt een ASIC in de PLIM contact op met de BMA en vraagt om een buffer van de juiste grootte. Als de buffer wordt verleend, beweegt het pakket zich aan het het pakketgeheugen van de lijnkaarttoegang. Als er geen beschikbare buffers zijn wordt het pakket gelaten vallen en de genegeerde interfaceteller zal stijgen. De toegangspakketprocessor doet de functieverwerking op het pakket, neemt het doorsturen besluit en verplaatst het pakket naar de wachtrij voor de wachtrij voor de uitgangslijn. De Fabric Interface ASIC( FIA) segmenteert het pakket naar Cisco-cellen en de cella wordt naar de switch verzonden. Vervolgens worden de pakketten van de switch door de FIA ontvangen op de uitgangslijn kaart en gaat verder naar de Frfab-wachtrijen waar ze weer in elkaar gezet worden, dan naar de uitgang PLIM, en uiteindelijk op de draad verzonden.

De beslissing van de FrFab BMA om de buffer uit een bepaalde bufferpool te selecteren is gebaseerd op de beslissing van de ingress line card switchingmotor. Aangezien alle wachtrijen in het gehele vak van dezelfde grootte zijn en in dezelfde volgorde staan, vertelt de switchingengine de verzendende LC om het pakket in dezelfde nummerwachtrij te plaatsen waar het de router heeft ingevoerd.

Terwijl het pakket wordt geschakeld, zal de rijgrootte van een bepaalde bufferpool bij de ingangslijnkaart die werd gebruikt om het pakket te bewegen door één worden verminderd tot BMA in de uitgangslijnkaart de buffer terugkeert. In dit verband moet ook worden opgemerkt dat het volledige bufferbeheer in hardware wordt uitgevoerd door de bufferbeheersvereniging en dat voor een foutloze werking het noodzakelijk is dat de BMA de buffers terugbrengt naar de oorspronkelijke pool van waaruit zij afkomstig is.

Er zijn drie scenario's waar het GSR pakketbufferbeheer stress of mislukking kan ervaren die tot pakketverlies leiden. Hieronder staan de drie scenario's.

Scenario 1:

Het beheer van de hardwarerij mislukt. Dit gebeurt wanneer de uitgaande BMA er niet in slaagt de pakketbuffer terug te geven of de pakketbuffer teruggeeft aan de onjuiste bufferpool. Als de buffers worden teruggebracht naar het onjuiste zwembad, zullen we zien sommige bufferpools groeien en sommige bufferpools uitputten over een periode van tijd en uiteindelijk het uitvoeren van pakketten met de uitputtende bufferpool grootte. We beginnen de QM-Sanity waarschuwingen te zien als de pakketbuffer uitpoot en de waarschuwingsdrempel overschrijdt.

Gebruik de QM sanity debugs en toon controllers om te fab wachtrijen te controleren of u door deze voorwaarde wordt beïnvloed. Raadpleeg de sectie Problemen oplossen om te weten te komen hoe u QM-drempelwaarden voor de hygiëne inschakelt.

Deze aandoening wordt over het algemeen veroorzaakt door defecte hardware. Controleer de onderstaande uitgangen op de router en zoekt naar pariteitsfouten of lijnkaartcrashes. De oplossing zou de lijnkaart vervangen.

show controllers fia

show context all

show log

Voorbeeld:

Van de QM sanity debugs en toon controller tofab wachtrij kunnen we zien dat Pool 2 groeit in grootte terwijl Pool 4 laag loopt. Dit geeft aan dat Pool 4 buffers verliest en wordt teruggestuurd naar Pool 2.

QM-hygiëne debugt:

SLOT 5:Oct 25 04:41:03.286 UTC: Pool 1: Carve Size 102001: Current Size 73078

SLOT 5:Oct 25 04:41:03.286 UTC: Pool 2: Carve Size 78462: Current Size 181569

SLOT 5:Oct 25 04:41:03.286 UTC: Pool 3: Carve Size 57539: Current Size 6160

SLOT 5:Oct 25 04:41:03.286 UTC: Pool 4: Carve Size 22870: Current Size 67

SLOT 5:Oct 25 04:41:03.286 UTC: IPC FreeQ: Carve Size 600: Current Size 600

toon controllers om wachtrijen te fab:

Qnum Head Tail #Qelem LenThresh

---- ---- ---- ------ ---------

4 non-IPC free queues:

102001/102001 (buffers specified/carved), 39.1%, 80 byte data size

1 13542 13448 73078 262143

78462/78462 (buffers specified/carved), 30.0%, 608 byte data size

2 131784 131833 181569 262143

57539/57539 (buffers specified/carved), 22.0%, 1616 byte data size

3 184620 182591 6160 262143

23538/22870 (buffers specified/carved), 8.74%, 4592 byte data size

4 239113 238805 67 262143

Scenario 2:

Traffic congestie op het volgende hopapparaat of het volgende pad. In dit scenario kan het toestel waaraan de GSR het verkeer voedt, niet met GSR’s snelheid verwerken, waardoor de volgende hop-toestel pauzestanden naar GSR stuurt en haar vraagt om te vertragen. Als flow control is ingeschakeld op GSR PLIM-kaarten, zal de router de pauzeframes herkennen en de pakketten gaan bufferen. Uiteindelijk zal de router door buffers lopen waardoor de QM Sanity foutmeldingen en pakketdruppels. We beginnen de QM-Sanity waarschuwingen te zien als de pakketbuffer uitpoot en de waarschuwingsdrempel overschrijdt. Raadpleeg het gedeelte Problemen oplossen over het vinden van de QM-drempels.

Gebruik de output van de showinterface op de uitgangsinterface om te controleren als de router door dit Scenario wordt beïnvloed. De onderstaande opname geeft een voorbeeld van een interface die pauzeframes ontvangt. Het actieplan zal de oorzaak van de congestie in het volgende hopapparaat onderzoeken.

GigabitEthernet6/2 is up, line protocol is up

Small Factor Pluggable Optics okay

Hardware is GigMac 4 Port GigabitEthernet, address is 000b.455d.ee02 (bia 000b.455d.ee02)

Description: Cisco Sydney Lab

Internet address is 219.158.33.86/30

MTU 1500 bytes, BW 500000 Kbit, DLY 10 usec, rely 255/255, load 154/255

Encapsulation ARPA, loopback not set

Keepalive set (10 sec)

Full Duplex, 1000Mbps, link type is force-up, media type is LX

output flow-control is on, input flow-control is on

ARP type: ARPA, ARP Timeout 04:00:00

Last input 00:00:02, output 00:00:02, output hang never

Last clearing of "show interface" counters 7w1d

Queueing strategy: random early detection (WRED)

Output queue 0/40, 22713601 drops; input queue 0/75, 736369 drops

Available Bandwidth 224992 kilobits/sec

30 second input rate 309068000 bits/sec, 49414 packets/sec

30 second output rate 303400000 bits/sec, 73826 packets/sec

143009959974 packets input, 88976134206186 bytes, 0 no buffer

Received 7352 broadcasts, 0 runts, 0 giants, 0 throttles

0 input errors, 0 CRC, 0 frame, 0 overrun, 0 ignored

0 watchdog, 7352 multicast, 45 pause input

234821393504 packets output, 119276570730993 bytes, 0 underruns

Transmitted 73201 broadcasts

0 output errors, 0 collisions, 0 interface resets

0 babbles, 0 late collision, 0 deferred

0 lost carrier, 0 no carrier, 0 pause output

0 output buffer failures, 0 output buffers swapped out

Scenario 3:

In tijden van overtekening als gevolg van een slecht netwerkontwerp/verkeersbursts/DOS-aanval. QM Sanity waarschuwing kan optreden als er aanhoudende hoge verkeersconditie is waar meer verkeer wordt gericht op de router dan wat de lijnkaarten kunnen verwerken.

Om deze controle te roteren controleer de verkeerstarieven op alle interfaces in de router. Dat zal duidelijk maken of een van de hogesnelheidsverbindingen langzame verbindingen verstopt.

Gebruik het bevel van de showinterface.

Opdrachten voor probleemoplossing

Om het huidige QM saniteitsniveau te controleren voor een LC

-

Bevestigen aan LC

-

Ga naar modus inschakelen

-

Opdracht Test Fab uitvoeren

-

Verzamel de output van "qm_sanity_info"

-

Optie q om test fab opdrachtregel te verlaten

-

Sluiten uit LC

QM-prioriteitsparameters configureren

- overschakelen naar de configuratiemodus

- Voer hw-module sleuf <slot#> qm-sanity uit om veelvuldig te waarschuwen <>

Debugs van QM-beveiliging inschakelen/uitschakelen

- Bevestigen aan LC

-

Ga naar modus inschakelen

-

Opdracht Test Fab uitvoeren

-

Start "qm_sanity_debug". Draai opnieuw en het zal stoppen met de debugs

-

Optie q om test fab opdrachtregel te verlaten

-

Sluiten uit LC

Statistieken van de basisinterface van de GSR-fabric controleren

- show controller fia

De Tofab-wachtrijen controleren

- toon controllers om wachtrijen te fab

Om frabvragen te controleren

- voorbeeldwachtrijen voor controller weergeven

Voorbeeld:

De onderstaande output wordt van een werkende router van het Laboratorium getrokken om de beveloutput aan te tonen.

GSR-1-PE-5#show controller fia

Fabric configuration: 10Gbps bandwidth (2.4Gbps available), redundant fabric

Master Scheduler: Slot 17 Backup Scheduler: Slot 16

Fab epoch no 0 Halt count 0

From Fabric FIA Errors

-----------------------

redund overflow 0 cell drops 0

cell parity 0

Switch cards present 0x001F Slots 16 17 18 19 20

Switch cards monitored 0x001F Slots 16 17 18 19 20

Slot: 16 17 18 19 20

Name: csc0 csc1 sfc0 sfc1 sfc2

-------- -------- -------- -------- --------

los 0 0 0 0 0

state Off Off Off Off Off

crc16 0 0 0 0 0

To Fabric FIA Errors

-----------------------

sca not pres 0 req error 0 uni fifo overflow 0

grant parity 0 multi req 0 uni fifo undrflow 0

cntrl parity 0 uni req 0

multi fifo 0 empty dst req 0 handshake error 0

cell parity 0

GSR-1-PE-5#attach 1

Entering Console for Modular SPA Interface Card in Slot: 1

Type "exit" to end this session

Press RETURN to get started!

LC-Slot1>en

LC-Slot1#test fab

BFLC diagnostic console program

BFLC (? for help) [?]: qm_sanity_debug

QM Sanity Debug enabled

BFLC (? for help) [qm_sanity_debug]:

SLOT 1:02:54:33: ToFAB BMA information

SLOT 1:02:54:33: Number of FreeQs carved 4

SLOT 1:02:54:33: Pool 1: Carve Size 102001: Current Size 102001

SLOT 1:02:54:33: Pool 2: Carve Size 78462: Current Size 78462

SLOT 1:02:54:33: Pool 3: Carve Size 57539: Current Size 57539

SLOT 1:02:54:33: Pool 4: Carve Size 22870: Current Size 22870

SLOT 1:02:54:33: IPC FreeQ: Carve Size 600: Current Size 600

SLOT 1:02:54:33: Number of LOQs enabled 768

SLOT 1:02:54:33: Number of LOQs disabled 1280

SLOT 1:02:54:33: ToFAB BMA information

SLOT 1:02:54:33: Number of FreeQs carved 4

SLOT 1:02:54:33: Pool 1: Carve Size 102001: Current Size 102001

SLOT 1:02:54:33: Pool 2: Carve Size 78462: Current Size 78462

SLOT 1:02:54:33: Pool 3: Carve Size 57539: Current Size 57539

SLOT 1:02:54:33: Pool 4: Carve Size 22870: Current Size 22870

SLOT 1:02:54:33: IPC FreeQ: Carve Size 600: Current Size 600

SLOT 1:02:54:33: Number of LOQs enabled 768

SLOT 1:02:54:33: Number of LOQs disabled 1280

QM Sanity Debug disabled

BFLC (? for help) [qm_sanity_debug]: qm_sanity_info

ToFab QM Sanity level Warning

FrFab QM Sanity level None

Sanity Check is triggered every 20 seconds

Min. buffers threshold in percentage 5

BFLC (? for help) [qm_sanity_info]: q

LC-Slot1#exi

Disconnecting from slot 1.

Connection Duration: 00:01:09

GSR-1-PE-5#config t

Enter configuration commands, one per line. End with CNTL/Z.

GSR-1-PE-5(config)#hw-module slot 1 qm-sanity tofab warning freq 10

GSR-1-PE-5(config)#end

GSR-1-PE-5#attach 1

02:57:25: %SYS-5-CONFIG_I: Configured from console by console

GSR-1-PE-5#attach 1

Entering Console for Modular SPA Interface Card in Slot: 1

Type "exit" to end this session

Press RETURN to get started!

LC-Slot1>en

LC-Slot1#test fab

BFLC diagnostic console program

BFLC (? for help) [?]: qm_sanity_info

ToFab QM Sanity level Warning

FrFab QM Sanity level None

Sanity Check is triggered every 10 seconds

Min. buffers threshold in percentage 5

BFLC (? for help) [qm_sanity_info]: q

LC-Slot1#exit

Disconnecting from slot 1.

Connection Duration: 00:00:27

GSR-1-PE-5#execute-on all show controllers tofab queues

========= Line Card (Slot 0) =========

Carve information for ToFab buffers

SDRAM size: 268435456 bytes, address: E0000000, carve base: E0018000

268337152 bytes carve size, 4 SDRAM bank(s), 16384 bytes SDRAM pagesize, 2 carve(s)

max buffer data size 4592 bytes, min buffer data size 80 bytes

262141/262141 buffers specified/carved

265028848/265028848 bytes sum buffer sizes specified/carved

Qnum Head Tail #Qelem LenThresh

---- ---- ---- ------ ---------

4 non-IPC free queues:

107232/107232 (buffers specified/carved), 40.90%, 80 byte data size

601 107832 107232 262143

73232/73232 (buffers specified/carved), 27.93%, 608 byte data size

107833 181064 73232 262143

57539/57539 (buffers specified/carved), 21.94%, 1616 byte data size

181065 238603 57539 262143

23538/23538 (buffers specified/carved), 8.97%, 4592 byte data size

238604 262141 23538 262143

IPC Queue:

600/600 (buffers specified/carved), 0.22%, 4112 byte data size

155 154 600 262143

Raw Queue (high priority):

0 0 0 65535

Raw Queue (medium priority):

0 0 0 32767

Raw Queue (low priority):

0 0 0 16383

ToFab Queues:

Dest Slot Queue# Head Tail Length Threshold

pkts pkts

==============================================================

0 0 0 0 0 262143

15 2191(hpr) 0 0 0 0

Multicast 2048 0 0 0 262143

2049 0 0 0 262143

========= Line Card (Slot 1) =========

Carve information for ToFab buffers

SDRAM size: 268435456 bytes, address: 26000000, carve base: 26010000

268369920 bytes carve size, 4 SDRAM bank(s), 32768 bytes SDRAM pagesize, 2 carve(s)

max buffer data size 4592 bytes, min buffer data size 80 bytes

262140/261472 buffers specified/carved

267790176/264701344 bytes sum buffer sizes specified/carved

Qnum Head Tail #Qelem LenThresh

---- ---- ---- ------ ---------

4 non-IPC free queues:

102001/102001 (buffers specified/carved), 39.1%, 80 byte data size

1 601 102601 102001 262143

78462/78462 (buffers specified/carved), 30.0%, 608 byte data size

2 102602 181063 78462 262143

57539/57539 (buffers specified/carved), 22.0%, 1616 byte data size

3 181064 238602 57539 262143

23538/22870 (buffers specified/carved), 8.74%, 4592 byte data size

4 238603 261472 22870 262143

IPC Queue:

600/600 (buffers specified/carved), 0.22%, 4112 byte data size

30 85 84 600 262143

Raw Queue (high priority):

27 0 0 0 65368

Raw Queue (medium priority):

28 0 0 0 32684

Raw Queue (low priority):

31 0 0 0 16342

ToFab Queues:

Dest Slot Queue# Head Tail Length Threshold

pkts pkts

=============================================================

::::::::::::::::::::

Hi Priority

0 2176(hpr) 0 0 0

1 2177(hpr) 0 0 0

2 2178(hpr) 0 0 0

3 2179(hpr) 0 0 0

4 2180(hpr) 553 552 0

5 2181(hpr) 0 0 0

6 2182(hpr) 0 0 0

7 2183(hpr) 0 0 0

8 2184(hpr) 0 0 0

9 2185(hpr) 0 0 0

10 2186(hpr) 0 0 0

11 2187(hpr) 0 0 0

12 2188(hpr) 0 0 0

13 2189(hpr) 0 0 0

14 2190(hpr) 0 0 0

15 2191(hpr) 0 0 0

Multicast

2048 0 0 0

2049 0 0 0

2050 0 0 0

2051 0 0 0

2052 0 0 0

2053 0 0 0

2054 0 0 0

2055 0 0 0

========= Line Card (Slot 3) =========

Carve information for ToFab buffers

SDRAM size: 268435456 bytes, address: E0000000, carve base: E0018000

268337152 bytes carve size, 4 SDRAM bank(s), 16384 bytes SDRAM pagesize, 2 carve(s)

max buffer data size 4112 bytes, min buffer data size 80 bytes

262142/262142 buffers specified/carved

230886224/230886224 bytes sum buffer sizes specified/carved

Qnum Head Tail #Qelem LenThresh

---- ---- ---- ------ ---------

3 non-IPC free queues:

94155/94155 (buffers specified/carved), 35.91%, 80 byte data size

601 94755 94155 262143

57539/57539 (buffers specified/carved), 21.94%, 608 byte data size

94756 152294 57539 262143

109848/109848 (buffers specified/carved), 41.90%, 1616 byte data size

152295 262142 109848 262143

IPC Queue:

600/600 (buffers specified/carved), 0.22%, 4112 byte data size

207 206 600 262143

Raw Queue (high priority):

0 0 0 65535

Raw Queue (medium priority):

0 0 0 32767

Raw Queue (low priority):

0 0 0 16383

ToFab Queues:

Dest Slot Queue# Head Tail Length Threshold

pkts pkts

==============================================================

0 0 0 0 0 262143

1 0 0 0 262143

2 0 0 0 262143

3 0 0 0 262143

:::::::::::::::::::::::::::

2049 0 0 0 262143

2050 0 0 0 262143

2051 0 0 0 262143

2052 0 0 0 262143

2053 0 0 0 262143

2054 0 0 0 262143

2055 0 0 0 262143

GSR-1-PE-5#execute-on slot 2 show controller frfab queues

========= Line Card (Slot 2) =========

Carve information for FrFab buffers

SDRAM size: 268435456 bytes, address: D0000000, carve base: D241D100

230567680 bytes carve size, 4 SDRAM bank(s), 16384 bytes SDRAM pagesize, 2 carve(s)

max buffer data size 4592 bytes, min buffer data size 80 bytes

235926/235926 buffers specified/carved

226853664/226853664 bytes sum buffer sizes specified/carved

Qnum Head Tail #Qelem LenThresh

---- ---- ---- ------ ---------

4 non-IPC free queues:

96484/96484 (buffers specified/carved), 40.89%, 80 byte data size

11598 11597 96484 262143

77658/77658 (buffers specified/carved), 32.91%, 608 byte data size

103116 103115 77658 262143

40005/40005 (buffers specified/carved), 16.95%, 1616 byte data size

178588 178587 40005 262143

21179/21179 (buffers specified/carved), 8.97%, 4592 byte data size

214748 235926 21179 262143

IPC Queue:

600/600 (buffers specified/carved), 0.25%, 4112 byte data size

66 65 600 262143

Multicast Raw Queue:

0 0 0 58981

Multicast Replication Free Queue:

235930 262143 26214 262143

Raw Queue (high priority):

78 77 0 235927

Raw Queue (medium priority):

11596 11595 0 58981

Raw Queue (low priority):

0 0 0 23592

Interface Queues:

Interface Queue# Head Tail Length Threshold

pkts pkts

======================================================

0 0 103107 103106 0 32768

3 178588 178587 0 32768

1 4 103110 103109 0 32768

7 11586 11585 0 32768

2 8 0 0 0 32768

11 0 0 0 32768

3 12 0 0 0 32768

15 0 0 0 32768

GSR-1-PE-5#

Revisiegeschiedenis

| Revisie | Publicatiedatum | Opmerkingen |

|---|---|---|

1.0 |

30-Jul-2017 |

Eerste vrijgave |

Bijgedragen door Cisco-engineers

- Shabeer MansoorCisco TAC

Contact Cisco

- Een ondersteuningscase openen

- (Vereist een Cisco-servicecontract)

Feedback

Feedback