Back-up- en herstelprocedures voor verschillende Ultra-M-componenten - CPS

Downloadopties

Inclusief taalgebruik

De documentatie van dit product is waar mogelijk geschreven met inclusief taalgebruik. Inclusief taalgebruik wordt in deze documentatie gedefinieerd als taal die geen discriminatie op basis van leeftijd, handicap, gender, etniciteit, seksuele oriëntatie, sociaaleconomische status of combinaties hiervan weerspiegelt. In deze documentatie kunnen uitzonderingen voorkomen vanwege bewoordingen die in de gebruikersinterfaces van de productsoftware zijn gecodeerd, die op het taalgebruik in de RFP-documentatie zijn gebaseerd of die worden gebruikt in een product van een externe partij waarnaar wordt verwezen. Lees meer over hoe Cisco gebruikmaakt van inclusief taalgebruik.

Over deze vertaling

Cisco heeft dit document vertaald via een combinatie van machine- en menselijke technologie om onze gebruikers wereldwijd ondersteuningscontent te bieden in hun eigen taal. Houd er rekening mee dat zelfs de beste machinevertaling niet net zo nauwkeurig is als die van een professionele vertaler. Cisco Systems, Inc. is niet aansprakelijk voor de nauwkeurigheid van deze vertalingen en raadt aan altijd het oorspronkelijke Engelstalige document (link) te raadplegen.

Inleiding

Dit document beschrijft de stappen die nodig zijn om een back-up te maken van een virtuele machine en deze te herstellen in een Ultra-M-configuratie waarin de host CPS virtuele netwerkfuncties roept.

Achtergrondinformatie

Ultra-M is een voorverpakte en gevalideerde, gevirtualiseerde mobiele packet-core-oplossing die ontworpen is om de implementatie van Virtual Network Functions (VNF’s) te vereenvoudigen. Ultra-M oplossing bestaat uit deze Virtual Machine (VM) types:

- Elastische servicescontroller (ESC)

- Cisco Policy Suite (CPS)

De high-level architectuur van Ultra-M en de betrokken componenten zijn zoals getoond in dit beeld.

Opmerking: Ultra M 5.1.x release wordt overwogen om de procedures in dit document te definiëren. Dit document is bedoeld voor het Cisco-personeel dat bekend is met Cisco Ultra-M platform.

Afkortingen

| VNF | Virtuele netwerkfunctie |

| ESC | Elastic-servicecontroller |

| MOP | Werkwijze |

| OSD | Schijven voor objectopslag |

| HDD | Harde schijf |

| SSD | Solid state drive |

| VIM | Virtual Infrastructure Manager |

| VM | Virtuele machine |

| UUID | Universele unieke IDentifier |

Reserve-procedure

OSPF-back-up

1. Controleer de status van OpenStack stack en de lijst met knooppunten.

[stack@director ~]$ source stackrc

[stack@director ~]$ openstack stack list --nested

[stack@director ~]$ ironic node-list

[stack@director ~]$ nova list

2. Controleer of alle undercloud-services geladen, actief en actief zijn vanuit het OSP-D knooppunt.

[stack@director ~]$ systemctl list-units "openstack*" "neutron*" "openvswitch*"

UNIT LOAD ACTIVE SUB DESCRIPTION

neutron-dhcp-agent.service loaded active running OpenStack Neutron DHCP Agent

neutron-openvswitch-agent.service loaded active running OpenStack Neutron Open vSwitch Agent

neutron-ovs-cleanup.service loaded active exited OpenStack Neutron Open vSwitch Cleanup Utility

neutron-server.service loaded active running OpenStack Neutron Server

openstack-aodh-evaluator.service loaded active running OpenStack Alarm evaluator service

openstack-aodh-listener.service loaded active running OpenStack Alarm listener service

openstack-aodh-notifier.service loaded active running OpenStack Alarm notifier service

openstack-ceilometer-central.service loaded active running OpenStack ceilometer central agent

openstack-ceilometer-collector.service loaded active running OpenStack ceilometer collection service

openstack-ceilometer-notification.service loaded active running OpenStack ceilometer notification agent

openstack-glance-api.service loaded active running OpenStack Image Service (code-named Glance) API server

openstack-glance-registry.service loaded active running OpenStack Image Service (code-named Glance) Registry server

openstack-heat-api-cfn.service loaded active running Openstack Heat CFN-compatible API Service

openstack-heat-api.service loaded active running OpenStack Heat API Service

openstack-heat-engine.service loaded active running Openstack Heat Engine Service

openstack-ironic-api.service loaded active running OpenStack Ironic API service

openstack-ironic-conductor.service loaded active running OpenStack Ironic Conductor service

openstack-ironic-inspector-dnsmasq.service loaded active running PXE boot dnsmasq service for Ironic Inspector

openstack-ironic-inspector.service loaded active running Hardware introspection service for OpenStack Ironic

openstack-mistral-api.service loaded active running Mistral API Server

openstack-mistral-engine.service loaded active running Mistral Engine Server

openstack-mistral-executor.service loaded active running Mistral Executor Server

openstack-nova-api.service loaded active running OpenStack Nova API Server

openstack-nova-cert.service loaded active running OpenStack Nova Cert Server

openstack-nova-compute.service loaded active running OpenStack Nova Compute Server

openstack-nova-conductor.service loaded active running OpenStack Nova Conductor Server

openstack-nova-scheduler.service loaded active running OpenStack Nova Scheduler Server

openstack-swift-account-reaper.service loaded active running OpenStack Object Storage (swift) - Account Reaper

openstack-swift-account.service loaded active running OpenStack Object Storage (swift) - Account Server

openstack-swift-container-updater.service loaded active running OpenStack Object Storage (swift) - Container Updater

openstack-swift-container.service loaded active running OpenStack Object Storage (swift) - Container Server

openstack-swift-object-updater.service loaded active running OpenStack Object Storage (swift) - Object Updater

openstack-swift-object.service loaded active running OpenStack Object Storage (swift) - Object Server

openstack-swift-proxy.service loaded active running OpenStack Object Storage (swift) - Proxy Server

openstack-zaqar.service loaded active running OpenStack Message Queuing Service (code-named Zaqar) Server

openstack-zaqar@1.service loaded active running OpenStack Message Queuing Service (code-named Zaqar) Server Instance 1

openvswitch.service loaded active exited Open vSwitch

LOAD = Reflects whether the unit definition was properly loaded.

ACTIVE = The high-level unit activation state, for example, generalization of SUB.

SUB = The low-level unit activation state, values depend on unit type.

37 loaded units listed. Pass --all to see loaded but inactive units, too.

To show all installed unit files use 'systemctl list-unit-files'.

3. Bevestig dat u voldoende schijfruimte beschikbaar hebt voordat u het back-upproces uitvoert. Verwacht wordt dat deze tarball minimaal 3,5 GB zal zijn.

[stack@director ~]$df -h

4. Voer deze opdrachten uit als de hoofdgebruiker om een back-up te maken van de gegevens van de undercloud-knooppunt naar een bestand met de naam undercloud-back-up-[timestamp].tar.gz en breng het over naar de back-upserver.

[root@director ~]# mysqldump --opt --all-databases > /root/undercloud-all-databases.sql

[root@director ~]# tar --xattrs -czf undercloud-backup-`date +%F`.tar.gz /root/undercloud-all-databases.sql

/etc/my.cnf.d/server.cnf /var/lib/glance/images /srv/node /home/stack

tar: Removing leading `/' from member names

ESC-back-up

1. ESC stelt op zijn beurt de Virtual Network Function (VNF) in via interactie met VIM.

2. ESC heeft een 1:1-redundantie in Ultra-M oplossing. Er zijn 2 ESC-VM's geïmplementeerd en ondersteunen een enkele storing in Ultra-M. Herstel bijvoorbeeld het systeem als er één storing in het systeem is.

Opmerking: als er meer dan één storing is, wordt deze niet ondersteund en kan een herimplementatie van het systeem nodig zijn.

ESC-back-upgegevens:

- Configuratie uitvoeren

- ConfD CDB-database

- ESC-logs

- Syslog-configuratie

3. De frequentie van ESC DB-back-up is lastig en moet zorgvuldig worden behandeld als ESC monitort en onderhoudt de verschillende toestandmachines voor verschillende geïmplementeerde VNF VM's. Aanbevolen wordt dat deze back-ups worden uitgevoerd na deze activiteiten in de gegeven VNF/POD/Site.

4. Controleer of ESC goed werkt met health.sh script.

[root@auto-test-vnfm1-esc-0 admin]# escadm status

0 ESC status=0 ESC Primary Healthy

[root@auto-test-vnfm1-esc-0 admin]# health.sh

esc ui is disabled -- skipping status check

esc_monitor start/running, process 836

esc_mona is up and running ...

vimmanager start/running, process 2741

vimmanager start/running, process 2741

esc_confd is started

tomcat6 (pid 2907) is running... [ OK ]

postgresql-9.4 (pid 2660) is running...

ESC service is running...

Active VIM = OPENSTACK

ESC Operation Mode=OPERATION

/opt/cisco/esc/esc_database is a mountpoint

============== ESC HA (Primary) with DRBD =================

DRBD_ROLE_CHECK=0

MNT_ESC_DATABSE_CHECK=0

VIMMANAGER_RET=0

ESC_CHECK=0

STORAGE_CHECK=0

ESC_SERVICE_RET=0

MONA_RET=0

ESC_MONITOR_RET=0

=======================================

ESC HEALTH PASSED

5. Maak een back-up van de actieve configuratie en verstuur het bestand naar de back-upserver.

[root@auto-test-vnfm1-esc-0 admin]# /opt/cisco/esc/confd/bin/confd_cli -u admin -C

admin connected from 127.0.0.1 using console on auto-test-vnfm1-esc-0.novalocal

auto-test-vnfm1-esc-0# show running-config | save /tmp/running-esc-12202017.cfg

auto-test-vnfm1-esc-0#exit

[root@auto-test-vnfm1-esc-0 admin]# ll /tmp/running-esc-12202017.cfg

-rw-------. 1 tomcat tomcat 25569 Dec 20 21:37 /tmp/running-esc-12202017.cfg

Reserve ESC-database

1. Log in op ESC VM en voer deze opdracht uit voordat u de back-up maakt.

[admin@esc ~]# sudo bash

[root@esc ~]# cp /opt/cisco/esc/esc-scripts/esc_dbtool.py /opt/cisco/esc/esc-scripts/esc_dbtool.py.bkup

[root@esc esc-scripts]# sudo sed -i "s,'pg_dump,'/usr/pgsql-9.4/bin/pg_dump," /opt/cisco/esc/esc-scripts/esc_dbtool.py

#Set ESC to mainenance mode

[root@esc esc-scripts]# escadm op_mode set --mode=maintenance

2. Controleer de ESC-modus en controleer of deze in de onderhoudsmodus staat.

[root@esc esc-scripts]# escadm op_mode show

3. Back-up database met behulp van database back-up terugzetten tool beschikbaar in ESC.

[root@esc scripts]# sudo /opt/cisco/esc/esc-scripts/esc_dbtool.py backup --file scp://<username>:<password>@<backup_vm_ip>:<filename>

4. Stel de ESC-functie terug in op de werkmodus en bevestig de modus.

[root@esc scripts]# escadm op_mode set --mode=operation

[root@esc scripts]# escadm op_mode show

5. Navigeer naar de scriptmap en verzamel de logbestanden.

[root@esc scripts]# /opt/cisco/esc/esc-scripts

sudo ./collect_esc_log.sh

6. Om een momentopname van het ESC te maken, moet het ESC eerst worden uitgeschakeld.

shutdown -r now

7. Maak een snapshot van de afbeelding vanuit OSPD.

nova image-create --poll esc1 esc_snapshot_27aug2018

8. Controleer of de snapshot is gemaakt.

openstack image list | grep esc_snapshot_27aug2018

9. Start het ESC vanaf het OSPD.

nova start esc1

10. Herhaal dezelfde procedure op de standby ESC VM en verplaats de logbestanden naar de back-upserver.

11. Verzamel back-up van de syslogconfiguratie op zowel de ESC-VMS als breng ze over naar de back-upserver.

[admin@auto-test-vnfm2-esc-1 ~]$ cd /etc/rsyslog.d

[admin@auto-test-vnfm2-esc-1 rsyslog.d]$ls /etc/rsyslog.d/00-escmanager.conf

00-escmanager.conf

[admin@auto-test-vnfm2-esc-1 rsyslog.d]$ls /etc/rsyslog.d/01-messages.conf

01-messages.conf

[admin@auto-test-vnfm2-esc-1 rsyslog.d]$ls /etc/rsyslog.d/02-mona.conf

02-mona.conf

[admin@auto-test-vnfm2-esc-1 rsyslog.d]$ls /etc/rsyslog.conf

rsyslog.conf

CPS-back-up

Stap 1. Maak een backup van CPS Cluster-Manager.

Gebruik deze opdracht om de nova-instanties te bekijken en noteer de naam van de VM-instantie van de clustermanager:

nova list

Stop de cluman van ESC.

/opt/cisco/esc/esc-confd/esc-cli/esc_nc_cli vm-action STOP <vm-name>

Stap 2. Controleer of Cluster Manager zich in de SHUTOFF-staat bevindt.

admin@esc1 ~]$ /opt/cisco/esc/confd/bin/confd_cli admin@esc1> show esc_datamodel opdata tenants tenant Core deployments * state_machine

Stap 3. Maak een nieuwe snapshot-afbeelding zoals in deze opdracht:

nova image-create --poll <cluman-vm-name> <snapshot-name>

Opmerking: zorg ervoor dat u voldoende schijfruimte hebt voor de snapshot.

.Belangrijk - Als VM onbereikbaar wordt na het maken van een snapshot, controleert u de status van VM met de opdracht nova list. Als het in SHUTOFF-staat is, moet u de VM handmatig starten.

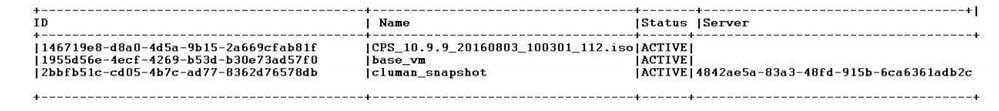

Stap 4. Bekijk de beeldlijst met deze opdracht: nova image-list

Afbeelding 1: Voorbeelduitvoer

Stap 5. Wanneer een snapshot wordt gemaakt, wordt de snapshot-afbeelding opgeslagen in OpenStack Glance. Als u de snapshot wilt opslaan in een externe gegevensopslag, downloadt u de snapshot en draagt u het bestand in OSPD over naar (/home/stack/CPS_BACKUP).

Gebruik deze opdracht in OpenStack om de afbeelding te downloaden:

glance image-download –-file For example: glance image-download –-file snapshot.raw 2bbfb51c-cd05-4b7c-ad77-8362d76578db

Stap 6. Maak een lijst van de gedownloade beelden zoals in deze opdracht:

ls —ltr *snapshot*

Example output: -rw-r--r--. 1 root root 10429595648 Aug 16 02:39 snapshot.raw

Stap 7. Bewaar de snapshot van de Cluster Manager VM om in de toekomst te herstellen.

2. Maak een back-up van de configuratie en database.

1. config_br.py -a export --all /var/tmp/backup/ATP1_backup_all_$(date +\%Y-\%m-\%d).tar.gz OR 2. config_br.py -a export --mongo-all /var/tmp/backup/ATP1_backup_mongoall$(date +\%Y-\%m-\%d).tar.gz 3. config_br.py -a export --svn --etc --grafanadb --auth-htpasswd --haproxy /var/tmp/backup/ATP1_backup_svn_etc_grafanadb_haproxy_$(date +\%Y-\%m-\%d).tar.gz 4. mongodump - /var/qps/bin/support/env/env_export.sh --mongo /var/tmp/env_export_$date.tgz 5. patches - cat /etc/broadhop/repositories, check which patches are installed and copy those patches to the backup directory /home/stack/CPS_BACKUP on OSPD 6. backup the cronjobs by taking backup of the cron directory: /var/spool/cron/ from the Pcrfclient01/Cluman. Then move the file to CPS_BACKUP on the OSPD.

Controleer vanuit de crontab-l of er een andere back-up nodig is.

Alle back-ups overbrengen naar de OSPD /home/stack/CPS_BACK.

3. Back-up van archiefbestand uit ESC Primary.

/opt/cisco/esc/confd/bin/netconf-console --host 127.0.0.1 --port 830 -u <admin-user> -p <admin-password> --get-config > /home/admin/ESC_config.xml

Overdracht het bestand in OSPD /home/stack/CPS_BACKUP.

4. Back-uplijn -l-gegevens.

Maak een tekstbestand met crontab -l en zet het op een externe locatie (in OSPD /home/stack/CPS_BACK).

5. Maak een back-up van de routebestanden van de LB- en PCRF-client.

Collect and scp the configurations from both LBs and Pcrfclients route -n /etc/sysconfig/network-script/route-*

Procedure terugzetten

OSPF-herstel

Op basis van deze aannames wordt een OSPD-herstelprocedure uitgevoerd.

1. OSPD-back-up is beschikbaar vanaf oude OSPD-server.

2. OSPD-herstel kan worden uitgevoerd op de nieuwe server die de vervanging is van de oude OSPD-server in het systeem. .

ESC-herstel

1. ESC-VM kan worden hersteld als de VM een fout vertoont of als de afsluitstatus een harde herstart uitvoert om de getroffen VM op te starten. Voer deze stappen uit om ESC te herstellen.

2. Identificeer de VM die zich in FOUT- of Uitschakelingsstatus bevindt, zodra de geïdentificeerde harde reboot van de ESC-VM is vastgesteld. In dit voorbeeld start u de automatische test-vnfm1-ESC-0 opnieuw op.

[root@tb1-baremetal scripts]# nova list | grep auto-test-vnfm1-ESC-

| f03e3cac-a78a-439f-952b-045aea5b0d2c | auto-test-vnfm1-ESC-0 | ACTIVE | - | running | auto-testautovnf1-uas-orchestration=172.31.12.11; auto-testautovnf1-uas-management=172.31.11.3 |

| 79498e0d-0569-4854-a902-012276740bce | auto-test-vnfm1-ESC-1 | ACTIVE | - | running | auto-testautovnf1-uas-orchestration=172.31.12.15; auto-testautovnf1-uas-management=172.31.11.15 |

[root@tb1-baremetal scripts]# [root@tb1-baremetal scripts]# nova reboot --hard f03e3cac-a78a-439f-952b-045aea5b0d2c\

Request to reboot server <Server: auto-test-vnfm1-ESC-0> has been accepted.

[root@tb1-baremetal scripts]#

3. Indien ESC-VM wordt verwijderd en opnieuw moet worden geüpload. Gebruik deze reeks stappen.

[stack@pod1-ospd scripts]$ nova list |grep ESC-1

| c566efbf-1274-4588-a2d8-0682e17b0d41 | vnf1-ESC-ESC-1 | ACTIVE | - | running | vnf1-UAS-uas-orchestration=172.16.11.14; vnf1-UAS-uas-management=172.16.10.4 |

[stack@pod1-ospd scripts]$ nova delete vnf1-ESC-ESC-1

Request to delete server vnf1-ESC-ESC-1 has been accepted.

4. Als ESC VM niet kan worden hersteld en de database moet worden hersteld, moet de database worden hersteld van de eerder gebruikte back-up.

5. Voor het terugzetten van ESC-databases moet u ervoor zorgen dat de ESC-service wordt gestopt voordat de database wordt hersteld; voor ESC HA moet u eerst de secundaire VM en vervolgens de primaire VM uitvoeren.

# service keepalived stop

6. Controleer de ESC-servicestatus en controleer of alles bij primaire en secundaire VM's voor HA wordt gestopt.

# escadm status

7. Voer het script uit om de database te herstellen. Als onderdeel van de restauratie van de DB naar de nieuwe ESC-instantie, kan de tool ook een van de instanties promoten om een primaire ESC te zijn, zijn DB-map aan het DBD-apparaat toe te voegen en de PostgreSQL-database te starten.

# /opt/cisco/esc/esc-scripts/esc_dbtool.py restore --file scp://<username>:<password>@<backup_vm_ip>:<filename>

8. Start de ESC-service opnieuw om het terugzetten van de database te voltooien. Start de keepalived-service opnieuw op als u HA in beide VM's wilt uitvoeren.

# service keepalived start

9. Zodra de VM met succes is hersteld en actief is; zorg ervoor dat alle syslogspecifieke configuratie is hersteld van de vorige succesvolle bekende back-up. zorg ervoor dat deze is hersteld in alle ESC-VM's.

[admin@auto-test-vnfm2-esc-1 ~]$

[admin@auto-test-vnfm2-esc-1 ~]$ cd /etc/rsyslog.d

[admin@auto-test-vnfm2-esc-1 rsyslog.d]$ls /etc/rsyslog.d/00-escmanager.conf

00-escmanager.conf

[admin@auto-test-vnfm2-esc-1 rsyslog.d]$ls /etc/rsyslog.d/01-messages.conf

01-messages.conf

[admin@auto-test-vnfm2-esc-1 rsyslog.d]$ls /etc/rsyslog.d/02-mona.conf

02-mona.conf

[admin@auto-test-vnfm2-esc-1 rsyslog.d]$ls /etc/rsyslog.conf

rsyslog.conf

10. Als de ESC vanaf een OSPD-snapshot moet worden herbouwd, gebruikt u deze opdracht met behulp van een snapshot die tijdens de back-up wordt gemaakt.

nova rebuild --poll --name esc_snapshot_27aug2018 esc1

11. Controleer de status van het ESC nadat de verbouwing is voltooid.

nova list --fileds name,host,status,networks | grep esc

12. Controleer ESC-gezondheid met deze opdracht.

health.sh

Copy Datamodel to a backup file

/opt/cisco/esc/esc-confd/esc-cli/esc_nc_cli get esc_datamodel/opdata > /tmp/esc_opdata_`date +%Y%m%d%H%M%S`.txt

Wanneer ESC VM niet start

- In sommige gevallen kan ESC de VM niet starten vanwege een onverwachte status. Een tijdelijke oplossing is om een ESC-overschakeling uit te voeren door de primaire ESC te rebooten. De overschakeling naar het ESC kan ongeveer een minuut duren. Voer health.sh uit op de nieuwe primaire ESC om te controleren of deze omhoog is. Wanneer de ESC primair wordt, kan ESC de VM-status herstellen en de VM starten. Aangezien deze bewerking is gepland, moet u 5 tot 7 minuten wachten voordat deze kan worden voltooid.

- U kunt /var/log/esc/yangesc.log en /var/log/esc/escmanager.log controleren. Als u niet ziet dat VM na 5-7 minuten wordt hersteld, moet de gebruiker handmatig de getroffen VM(s) herstellen.

- Zodra de VM is hersteld en actief is; zorg ervoor dat alle syslogspecifieke configuratie is hersteld van de vorige succesvolle bekende back-up. Zorg ervoor dat deze in alle ESC-VM's is hersteld

root@abautotestvnfm1em-0:/etc/rsyslog.d# pwd

/etc/rsyslog.d

root@abautotestvnfm1em-0:/etc/rsyslog.d# ll

total 28

drwxr-xr-x 2 root root 4096 Jun 7 18:38 ./

drwxr-xr-x 86 root root 4096 Jun 6 20:33 ../]

-rw-r--r-- 1 root root 319 Jun 7 18:36 00-vnmf-proxy.conf

-rw-r--r-- 1 root root 317 Jun 7 18:38 01-ncs-java.conf

-rw-r--r-- 1 root root 311 Mar 17 2012 20-ufw.conf

-rw-r--r-- 1 root root 252 Nov 23 2015 21-cloudinit.conf

-rw-r--r-- 1 root root 1655 Apr 18 2013 50-default.conf

root@abautotestvnfm1em-0:/etc/rsyslog.d# ls /etc/rsyslog.conf

rsyslog.conf

CPS-herstel

Herstel Cluster Manager VM in OpenStack.

Stap 1. Kopieer de VM-snapshot van de clusterbeheerder naar de controllerblade zoals in deze opdracht wordt getoond:

ls —ltr *snapshot*

Example output: -rw-r--r--. 1 root root 10429595648 Aug 16 02:39 snapshot.raw

Stap 2. Upload de snapshot-afbeelding naar OpenStack vanuit Datastore:

glance image-create --name --file --disk-format qcow2 --container-format bare

Stap 3. Controleer of de snapshot is geüpload met een Nova-opdracht zoals in dit voorbeeld:

nova image-list

Afbeelding 2: Voorbeelduitvoer

Stap 4. Afhankelijk van of de clustermanager VM bestaat of niet, kunt u ervoor kiezen de cluman te maken of de cluman opnieuw op te bouwen:

· Als de Cluster Manager VM-instantie niet bestaat, maakt u de Cluman VM met een opdracht Heat or Nova zoals in dit voorbeeld:

Maak de cluman VM met ESC.

/opt/cisco/esc/esc-confd/esc-cli/esc_nc_cli edit-config /opt/cisco/esc/cisco-cps/config/gr/tmo/gen/<original_xml_filename>

De PCRF-cluster kan paaien met behulp van de vorige opdracht en vervolgens de configuraties van de clustermanager herstellen van de back-ups die zijn gemaakt met config_br.py herstel, mongorestore van dump genomen in back-up.

delete - nova boot --config-drive true --image "" --flavor "" --nic net-id=",v4-fixed-ip=" --nic net-id="network_id,v4-fixed-ip=ip_address" --block-device-mapping "/dev/vdb=2edbac5e-55de-4d4c-a427-ab24ebe66181:::0" --availability-zone "az-2:megh-os2-compute2.cisco.com" --security-groups cps_secgrp "cluman"

· Als de Cluster Manager VM-instantie bestaat, gebruik dan een nova rebuild-opdracht om de Cluman VM-instantie opnieuw op te bouwen met de geüploade momentopname zoals getoond:

nova rebuild <instance_name> <snapshot_image_name>

Voorbeeld:

nova rebuild cps-cluman-5f3tujqvbi67 cluman_snapshot

Stap 5. Maak een lijst van alle instanties zoals getoond, en controleer dat de nieuwe instantie van de clustermanager wordt tot stand gebracht en lopend:

nova list

Afbeelding 3. Voorbeeldoutput

Herstel de nieuwste patches op het systeem.

1. Copy the patch files to cluster manager which were backed up in OSPD /home/stack/CPS_BACKUP 2. Login to the Cluster Manager as a root user. 3. Untar the patch by executing this command: tar -xvzf [patch name].tar.gz 4. Edit /etc/broadhop/repositories and add this entry: file:///$path_to_the plugin/[component name] 5. Run build_all.sh script to create updated QPS packages: /var/qps/install/current/scripts/build_all.sh 6. Shutdown all software components on the target VMs: runonall.sh sudo monit stop all 7. Make sure all software components are shutdown on target VMs: statusall.sh

Opmerking: de softwarecomponenten moeten allemaal worden weergegeven met de huidige status Niet gecontroleerd.

8. Update the qns VMs with the new software using reinit.sh script: /var/qps/install/current/scripts/upgrade/reinit.sh 9. Restart all software components on the target VMs: runonall.sh sudo monit start all 10. Verify that the component is updated, run: about.sh

Herstel de kronenbanen.

1. Verplaats het back-upbestand van OSPD naar Cluman/Pcrfclient01.

2. Start de opdracht om de taak vanuit de back-up te activeren.

#crontab Cron-backup

3. Controleer of de cronjobs door deze opdracht zijn geactiveerd.

#crontab -l

Herstel individuele VM's in het cluster.

Zo implementeert u de pcrfclient01 VM:

Stap 1. Log in bij de Cluster Manager VM als basisgebruiker.

Stap 2. Onthoud de UUID van SVN-repository met deze opdracht:

svn info http://pcrfclient02/repos | grep UUID

De opdracht kan de UUID van de repository uitvoeren.

Bijvoorbeeld: Repository UUID: ea50bbd2-5726-46b8-b807-10f4a7424f0e

Stap 3. Importeer de back-up Policy Builder-configuratiegegevens op de Cluster Manager, zoals in dit voorbeeld:

config_br.py -a import --etc-oam --svn --stats --grafanadb --auth-htpasswd --users /mnt/backup/oam_backup_27102016.tar.gz

Opmerking: veel implementaties voeren een foute taak uit waarbij regelmatig een back-up wordt gemaakt van configuratiegegevens. Zie Subversion Repository back-up voor meer informatie.

Stap 4. Voer deze opdracht uit om de VM-archiefbestanden op de Cluster Manager te genereren met behulp van de nieuwste configuraties:

/var/qps/install/current/scripts/build/build_svn.sh

Stap 5. Voer een van de volgende handelingen uit om de pcrfclient01 VM te implementeren:

Gebruik in OpenStack de HEAT-sjabloon of de opdracht Nova om de VM opnieuw te maken. Zie CPS-installatiehandleiding voor OpenStack voor meer informatie.

Stap 6. Installeer de primaire/secundaire synchronisatie van SVN tussen de pcrfclient01 en pcrfclient02 opnieuw met pcrfclient01 als primair door deze serie opdrachten uit te voeren.

Als SVN al gesynchroniseerd is, geef deze opdrachten dan niet uit.

Om te controleren of SVN synchroon is, voert u deze opdracht uit vanaf pcrfclient02.

Als een waarde wordt teruggegeven, dan is SVN al in sync:

/usr/bin/svn propget svn:sync-from-url --revprop -r0 http://pcrfclient01/repos

Voer deze opdrachten uit vanuit pcrfclient01:

/bin/rm -fr /var/www/svn/repos /usr/bin/svnadmin create /var/www/svn/repos /usr/bin/svn propset --revprop -r0 svn:sync-last-merged-rev 0 http://pcrfclient02/repos-proxy-sync /usr/bin/svnadmin setuuid /var/www/svn/repos/ "Enter the UUID captured in step 2" /etc/init.d/vm-init-client / var/qps/bin/support/recover_svn_sync.sh

Stap 7. Als pcrfclient01 ook de arbiter-VM is, voert u de volgende stappen uit:

a) Maak de monostream start/stop scripts op basis van de systeemconfiguratie. Niet alle implementaties hebben al deze databases geconfigureerd.

Opmerking: raadpleeg /etc/broadhop/mongoConfig.cfg om te bepalen welke databases moeten worden geïnstalleerd.

cd /var/qps/bin/support/mongo build_set.sh --session --create-scripts build_set.sh --admin --create-scripts build_set.sh --spr --create-scripts build_set.sh --balance --create-scripts build_set.sh --audit --create-scripts build_set.sh --report --create-scripts

b) Start het mongoproces:

/usr/bin/systemctl start sessionmgr-XXXXX

c) Wacht tot de arbiter start en voer vervolgens diagnostics.sh —get_replica_status uit om de gezondheid van de replica set te controleren.

Zo implementeert u de pcrfclient02 VM:

Stap 1. Log in bij de Cluster Manager VM als basisgebruiker.

Stap 2. Voer deze opdracht uit om de VM-archiefbestanden op de Cluster Manager te genereren met behulp van de nieuwste configuraties:

/var/qps/install/current/scripts/build/build_svn.sh

Stap 3. Voer een van de volgende handelingen uit om de pcrfclient02 VM te implementeren:

Gebruik in OpenStack de HEAT-sjabloon of de opdracht Nova om de VM opnieuw te maken. Zie CPS-installatiehandleiding voor OpenStack voor meer informatie.

Stap 4. Secure-shell naar de pcrfclient01:

ssh pcrfclient01

Stap 5. Draai dit script om de SVN repo’s van pcrfclient01 te herstellen:

/var/qps/bin/support/recover_svn_sync.sh

Een sessionmgr VM opnieuw implementeren:

Stap 1. Log in bij de Cluster Manager VM als basisgebruiker.

Stap 2. Voer een van de volgende handelingen uit om de sessionmgr VM te implementeren en de mislukte of beschadigde VM te vervangen:

Gebruik in OpenStack de HEAT-sjabloon of de opdracht Nova om de VM opnieuw te maken. Zie CPS-installatiehandleiding voor OpenStack voor meer informatie.

Stap 3. Maak de monostream start/stop scripts op basis van de systeemconfiguratie.

Niet alle implementaties hebben al deze databases geconfigureerd. Raadpleeg /etc/broadhop/mongoConfig.cfg om te bepalen welke databases moeten worden geïnstalleerd.

cd /var/qps/bin/support/mongo build_set.sh --session --create-scripts build_set.sh --admin --create-scripts build_set.sh --spr --create-scripts build_set.sh --balance --create-scripts build_set.sh --audit --create-scripts build_set.sh --report --create-scripts

Stap 4. Bevestig shell aan de sessionmgr VM en start het mongoproces:

ssh sessionmgrXX /usr/bin/systemctl start sessionmgr-XXXXX

Stap 5. Wacht tot de leden starten en de secundaire leden gesynchroniseerd zijn en voer vervolgens diagnostics.sh —get_replica_status uit om de status van de database te controleren.

Stap 6. Als u Session Manager-database wilt herstellen, gebruikt u een van deze voorbeeldopdrachten, afhankelijk van de vraag of de back-up is uitgevoerd met de optie —mongo-all of —mongo:

• config_br.py -a import --mongo-all --users /mnt/backup/Name of backup or • config_br.py -a import --mongo --users /mnt/backup/Name of backup

Zo herimplementeert u de Policy Director (taakverdeling) VM:

Stap 1. Log in bij de Cluster Manager VM als basisgebruiker.

Stap 2. Voer deze opdracht uit om de back-up Policy Builder-configuratiegegevens in Cluster Manager te importeren:

config_br.py -a import --network --haproxy --users /mnt/backup/lb_backup_27102016.tar.gz

Stap 3. Voer deze opdracht uit om de VM-archiefbestanden op de Cluster Manager te genereren met behulp van de nieuwste configuraties:

/var/qps/install/current/scripts/build/build_svn.sh

Stap 4. Voer een van de volgende handelingen uit om de lb01 VM te implementeren:

Gebruik in OpenStack de HEAT-sjabloon of de opdracht Nova om de VM opnieuw te maken. Zie CPS-installatiehandleiding voor OpenStack voor meer informatie.

Zo implementeert u de Policy Server (QNS) VM:

Stap 1. Log in bij de Cluster Manager VM als basisgebruiker.

Stap 2. Importeer de back-up Policy Builder-configuratiegegevens op de Cluster Manager, zoals in dit voorbeeld:

config_br.py -a import --users /mnt/backup/qns_backup_27102016.tar.gz

Stap 3. Voer deze opdracht uit om de VM-archiefbestanden op de Cluster Manager te genereren met behulp van de nieuwste configuraties:

/var/qps/install/current/scripts/build/build_svn.sh

Stap 4. Voer een van de volgende handelingen uit om de qns VM te implementeren:

Gebruik in OpenStack de HEAT-sjabloon of de opdracht Nova om de VM opnieuw te maken. Zie CPS-installatiehandleiding voor OpenStack voor meer informatie.

Algemene procedure voor het terugzetten van databases.

Stap 1. Voer deze opdracht uit om de database te herstellen:

config_br.py –a import --mongo-all /mnt/backup/backup_$date.tar.gz where $date is the timestamp when the export was made.

Voorbeeld,

config_br.py –a import --mongo-all /mnt/backup/backup_27092016.tgz

Stap 2. Log in op de database en controleer of deze actief is en toegankelijk is:

1. Meld u aan bij Session Manager:

mongo --host sessionmgr01 --port $port

waarbij $port het poortnummer is van de database die moet worden gecontroleerd. 27718 is bijvoorbeeld de standaard balanspost.

2. Geef de database weer door deze opdracht uit te voeren:

show dbs

3. Switch de mongo shell naar de database door deze opdracht uit te voeren:

use $db

waarbij $db een databasenaam is die in de vorige opdracht wordt weergegeven.

Het gebruikscommando switch de mongo shell naar die database.

Voorbeeld,

use balance_mgmt

4. Voer deze opdracht uit om de collecties weer te geven:

show collections

5. Voer deze opdracht uit om het aantal records in de verzameling weer te geven:

db.$collection.count() For example, db.account.count()

Het vorige voorbeeld kan het aantal verslagen in de inzamelingsrekening in het gegevensbestand van het Saldo (balance_mgmt) tonen.

Terugzetten van opslaglocatie voor subversie.

Voer deze opdracht uit om de configuratiegegevens van de Policy Builder van een back-up te herstellen:

config_br.py –a import --svn /mnt/backup/backup_$date.tgz where, $date is the date when the cron created the backup file.

Zet Grafana Dashboard terug.

U kunt het Grafana-dashboard herstellen met deze opdracht:

config_br.py -a import --grafanadb /mnt/backup/

De terugzetprocedure valideren.

Na het herstellen van de gegevens, verifieert het werkende systeem door dit bevel uit te voeren:

/var/qps/bin/diag/diagnostics.sh

Revisiegeschiedenis

| Revisie | Publicatiedatum | Opmerkingen |

|---|---|---|

2.0 |

20-Mar-2024 |

Bijgewerkt Titel, Inleiding, Alt-tekst, machinevertaling, Stijlvereisten en Opmaak. |

1.0 |

21-Sep-2018 |

Eerste vrijgave |

Bijgedragen door Cisco-engineers

- Aaditya DeodharCisco geavanceerde services

Contact Cisco

- Een ondersteuningscase openen

- (Vereist een Cisco-servicecontract)

Feedback

Feedback