Introdução

Este documento descreve como configurar a Unidade Máxima de Transição (MTU - Maximum Transition Unit) jumbo de ponta a ponta em dispositivos de data center da Cisco.

Pré-requisitos

Requisitos

A Cisco recomenda que você tenha conhecimento destes tópicos:

- VMware ESXi

- Cisco UCS

- Cisco N5k

- Interface de Sistemas de Computadores Pequenos da Internet (iSCSI) da Cisco

Componentes Utilizados

Este documento descreve como configurar uma Jumbo Maximum Transition Unit (MTU) de ponta a ponta em dispositivos de data center da Cisco em uma rede que consiste em um host VMware ESXi instalado no Cisco Unified Computing System (UCS), switches Cisco Nexus 1000V Series (N1kV), switches Cisco Nexus 5000 Series (N5k) e o controlador Cisco NetApp.

As informações neste documento são baseadas nestas versões de software e hardware:

- Switches Cisco Nexus 5020 Series versão 5.0(3)N2(2a)

- Cisco UCS versão 2.1(1d)

- Servidor blade Cisco UCS B200 M3 com Cisco Virtual Interface Card (VIC) 1240

- vSphere 5.0 (ESXi e vCenter)

- Cisco N1kV versão 4.2(1)SV2(2.1a)

- FAS 3240 da NetApp

As informações neste documento foram criadas a partir de dispositivos em um ambiente de laboratório específico. Todos os dispositivos utilizados neste documento foram iniciados com uma configuração (padrão) inicial. Se a rede estiver ativa, certifique-se de que você entenda o impacto potencial de qualquer comando.

Configurar

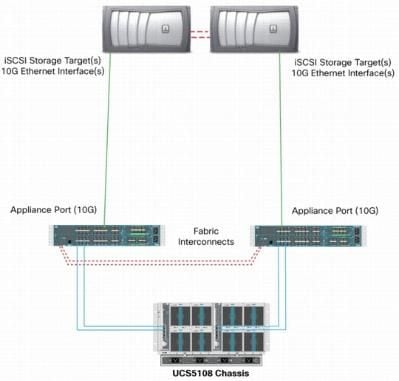

Diagrama de Rede

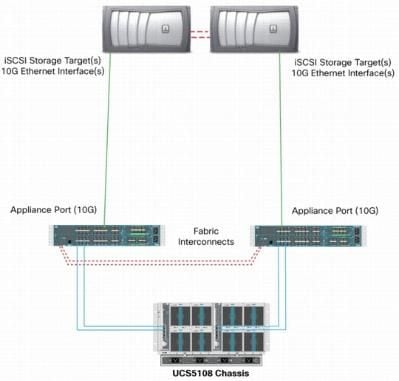

A implantação típica da rede de área de armazenamento (SAN) iSCSI usa o Cisco UCS com uma interconexão em malha no modo de host final Ethernet e o destino de armazenamento conectado por um switch upstream ou rede comutada.

Com o uso das portas do dispositivo no UCS, o armazenamento pode ser conectado diretamente às interconexões em malha.

Quer a rede upstream seja de 1 GbE ou 10 GbE, o uso de quadros jumbo (um tamanho de MTU de 9000, por exemplo) melhora o desempenho porque reduz o número de quadros individuais que devem ser enviados para uma determinada quantidade de dados e reduz a necessidade de separar blocos de dados iSCSI em vários quadros Ethernet. Eles também reduzem a utilização da CPU do host e do armazenamento.

Se forem usados quadros jumbo, certifique-se de que o UCS e o destino de armazenamento, bem como todos os equipamentos de rede entre eles, sejam capazes e configurados para suportar o tamanho de quadro maior.

Isso significa que a MTU jumbo deve ser configurada fim-a-fim (iniciador a destino) para que seja efetiva no domínio.

Esta é uma visão geral do procedimento usado para configurar a MTU jumbo fim-a-fim:

- Crie uma Classe de Sistema de Qualidade de Serviço (QoS - Quality of Service) do UCS com um MTU de 9000 e depois configure a NIC Virtual (vNIC) com MTU jumbo.

- Ative jumbo frames (MTU 9000) em todos os switches entre o iniciador (UCS) e o destino iSCSI.

- Ative os jumbo frames no adaptador do sistema operacional (porta VMkernel do ESXi).

- Habilite quadros jumbo nas interfaces NetApp.

Observação: consulte o artigo Cisco Unified Computing System (UCS) Storage Connectivity Options and Best Practices with NetApp Storage Cisco para obter informações adicionais.

Configuração do Cisco UCS

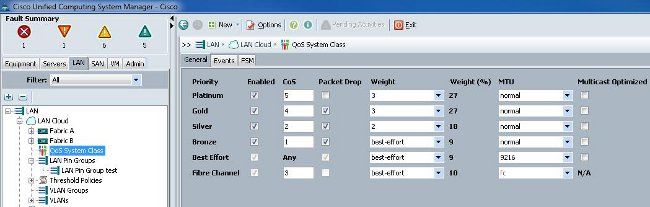

A MTU é definida em uma base por Classe de Serviço (CoS - Class of Service) no UCS. Se você não tiver uma política de QoS definida para o vNIC que se dirige para o vSwitch, o tráfego se move para a classe de melhor esforço.

Conclua estes passos para ativar quadros jumbo:

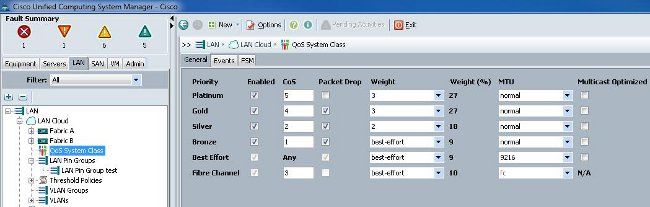

- Na GUI do UCS, clique na guia LAN.

- Navegue até LAN > LAN Cloud > QoS System Class.

- Clique em QoS System Class e altere a classe de tráfego (que transporta o tráfego iSCSI) MTU para 9216.

Observação: este exemplo usa a classe de tráfego Best Effort para ilustrar essa atualização de MTU.

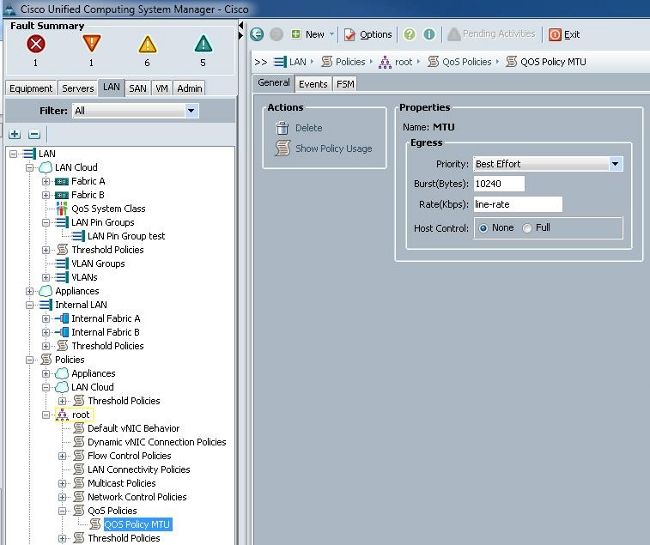

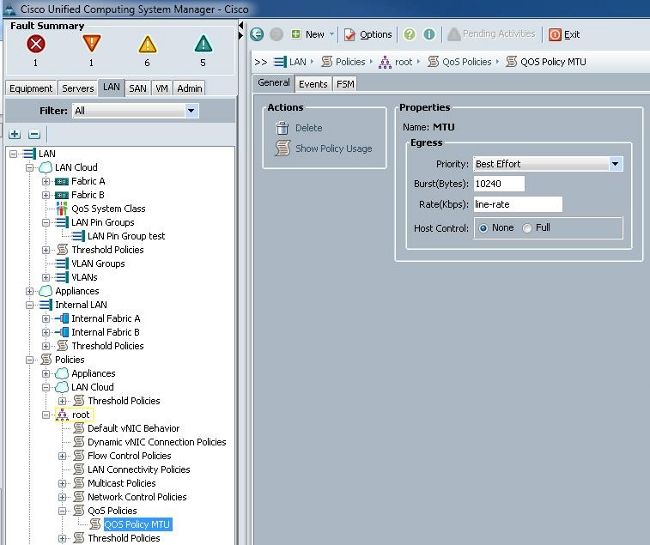

- Crie uma política de QoS na guia LAN e aplique-a à vNIC que transporta o tráfego de armazenamento.

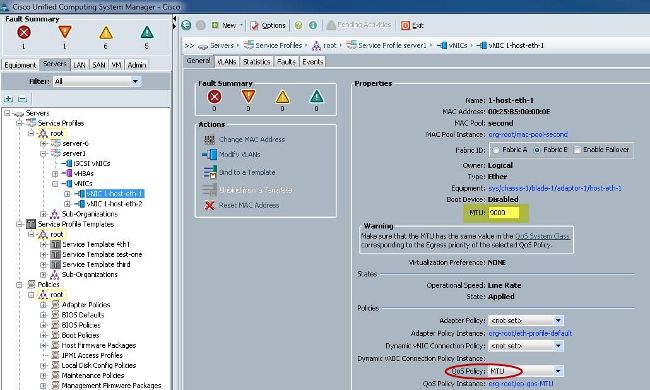

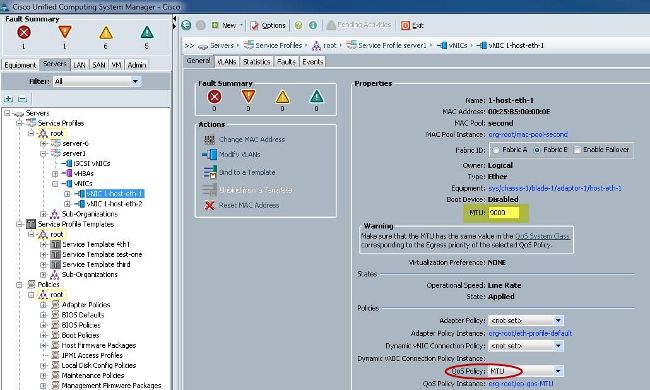

- Navegue até o modelo vNIC ou o vNIC real em Perfis de serviço e defina o valor de MTU como 9000.

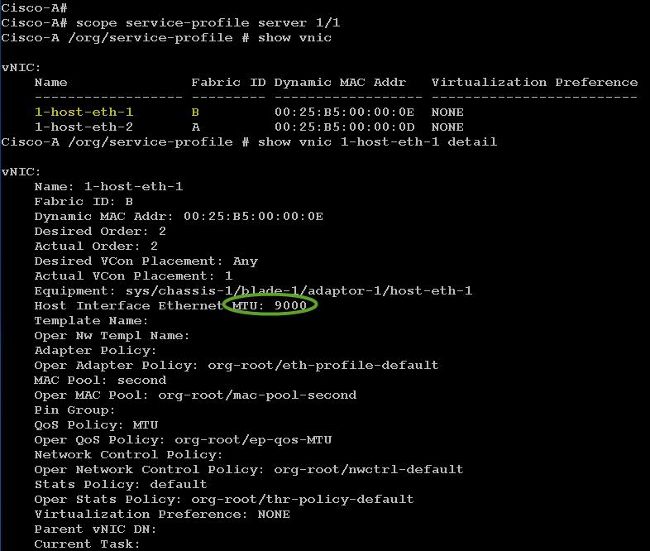

Verificar

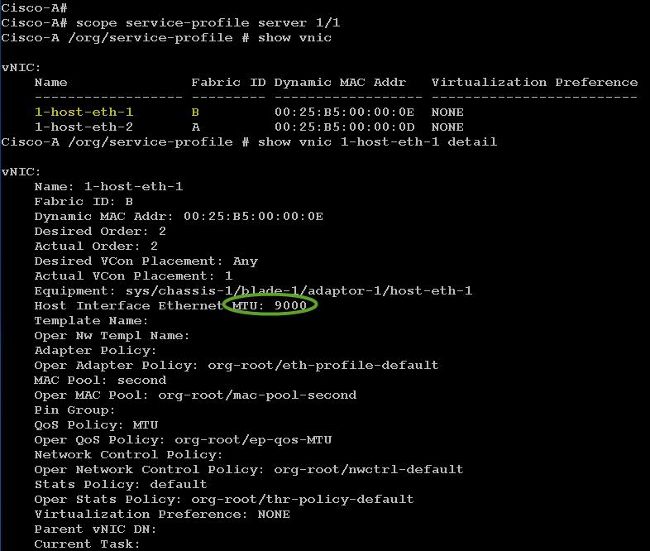

Verifique se o vNIC tem o MTU configurado conforme descrito anteriormente.

Verifique se as portas de uplink têm MTU jumbo habilitada.

Configuração do N5k

Com o N5k, o jumbo MTU é habilitado no nível do sistema.

Abra um prompt de comando e insira estes comandos para configurar o sistema para MTU jumbo:

switch(config)#policy-map type network-qos jumbo

switch(config-pmap-nq)#class type network-qos class-default

switch(config-pmap-c-nq)#mtu 9216

switch(config-pmap-c-nq)#exit

switch(config-pmap-nq)#exit

switch(config)#system qos

switch(config-sys-qos)#service-policy type network-qos jumbo

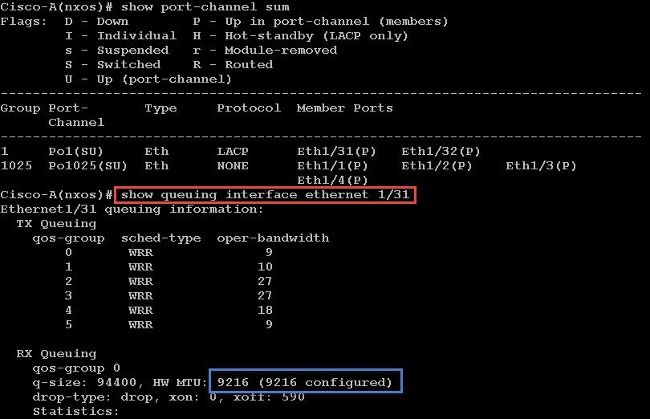

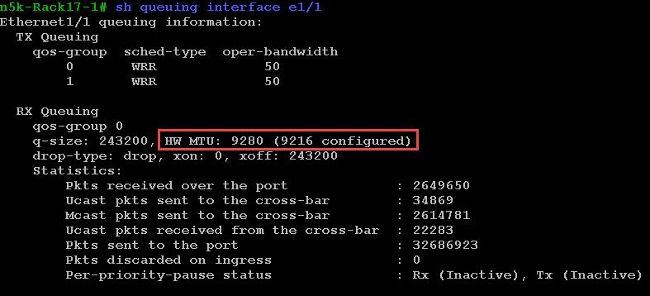

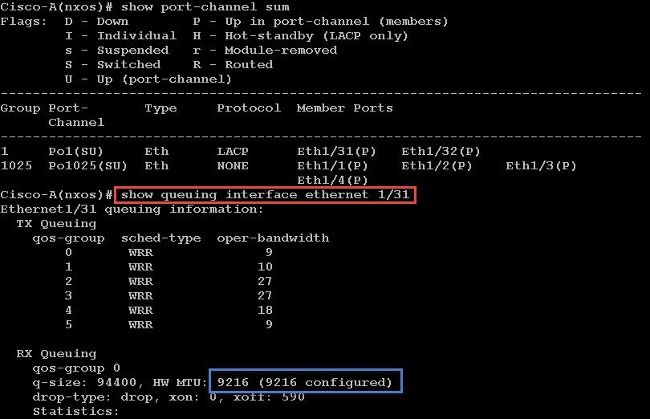

Verificar

Insira o comando show queuing interface Ethernet x/y para verificar se a MTU jumbo está habilitada:

Observação: o comando show interface Ethernet x/y mostra um MTU de 1500, mas isso está incorreto.

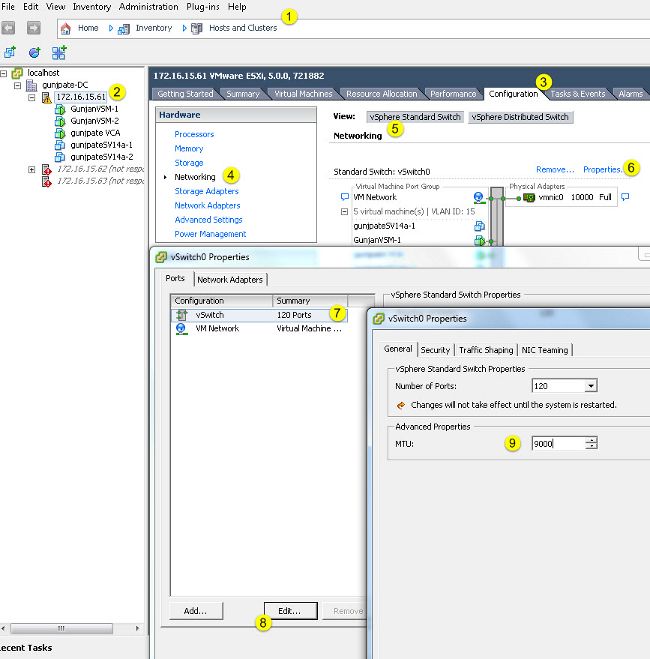

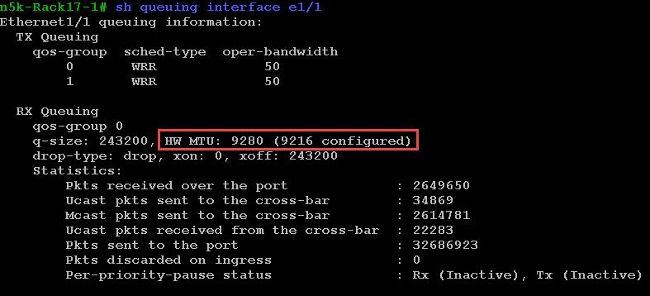

Configuração do VMware ESXi

Você pode configurar o valor de MTU de um vSwitch para que todos os grupos de portas e portas usem quadros jumbo.

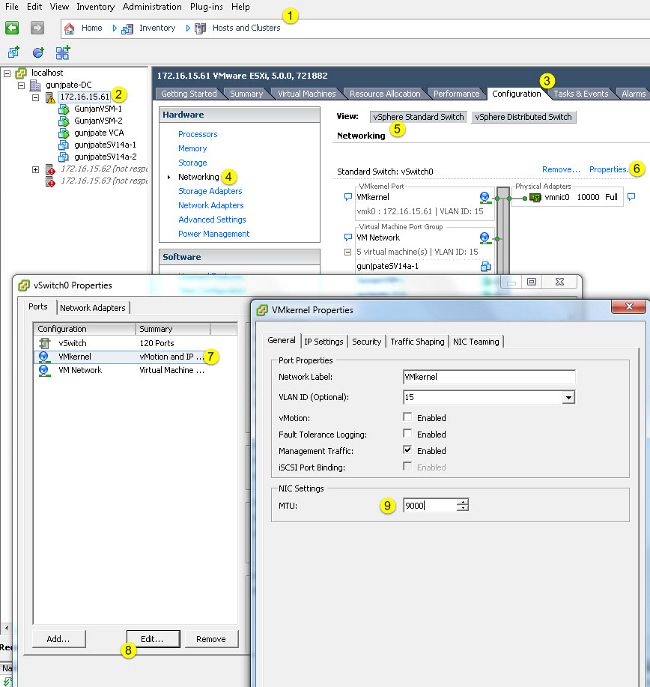

Conclua estes passos para habilitar quadros jumbo em um vSwitch de host:

- Navegue até Home > Inventory > Hosts and Clusters no cliente vSphere.

- Selecione o host.

- Clique na guia Configuração.

- Selecione Networking no menu Hardware.

- Escolha vSphere Standard Switch no campo View.

- Clique em Propriedades.

- Selecione vSwitch na guia Portas da janela pop-up Propriedades.

- Clique em Editar.

- Na guia Geral da janela pop-up, altere a MTU (em Propriedades avançadas) do valor padrão (1500) para 9000. Isso ativa quadros jumbo em todos os grupos de portas e portas do vSwitch.

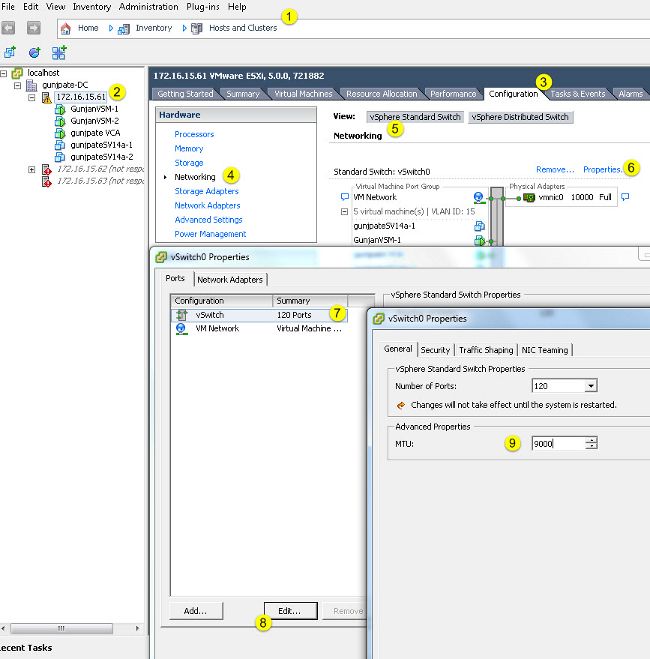

Conclua estes passos para habilitar quadros jumbo somente em uma porta VMkernel do servidor vCenter:

- No cliente vSphere, navegue até Home > Inventory > Hosts and Clusters.

- Selecione o host.

- Clique na guia Configuração.

- Selecione Networking no menu Hardware.

- Escolha vSphere Standard Switch no campo View.

- Clique em Propriedades.

- Selecione VMkernel na guia Ports da janela pop-up Properties.

- Clique em Editar.

- Na guia Geral da janela pop-up, altere a MTU (em Configurações da placa de rede) do valor padrão (1500) para 9000. Isso permite quadros jumbo em apenas uma porta VMkernel do vSwitch.

Verificar

Insira o comando vmkping -d -s 8972 <storage appliance ip address> para testar a conectividade de rede e verificar se a porta do VMkernel pode fazer ping com MTU jumbo.

Dica: consulte o artigo Testando a conectividade de rede do VMkernel com o comando vmkping da VMware para obter mais informações sobre esse comando.

Observação: o maior tamanho de pacote verdadeiro é 8972, que envia um pacote de 9.000 bytes quando você adiciona os bytes de cabeçalho IP e ICMP.

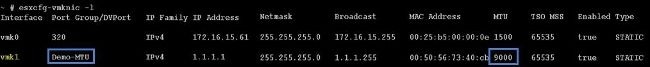

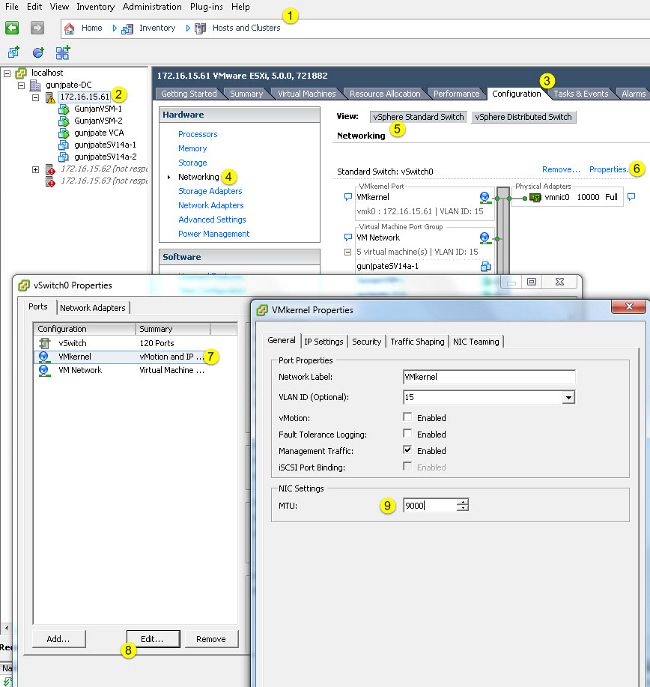

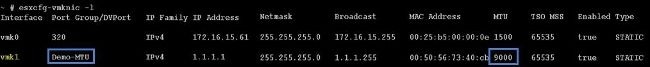

No nível do host ESXi, verifique se as configurações de MTU estão definidas corretamente:

Configuração do Cisco IOS

Com os switches Cisco IOS®, não há conceito de MTU global no nível do switch. Em vez disso, o MTU é configurado no nível da interface/canal de ether.

Insira estes comandos para configurar a MTU jumbo:

7609(config)#int gigabitEthernet 1/1

7609(config-if)#mtu ?

<1500-9216> MTU size in bytes

7609(config-if)#mtu 9216

Verificar

Insira o comando show interfaces gigabitEthernet 1/1 para verificar se a configuração está correta:

7609#show interfaces gigabitEthernet 1/1

GigabitEthernet1/1 is up, line protocol is up (connected)

Hardware is C6k 1000Mb 802.3, address is 0007.0d0e.640a (bia 0007.0d0e.640a)

MTU 9216 bytes, BW 1000000 Kbit, DLY 10 usec,

reliability 255/255, txload 1/255, rxload 1/255

Configuração de N1kV

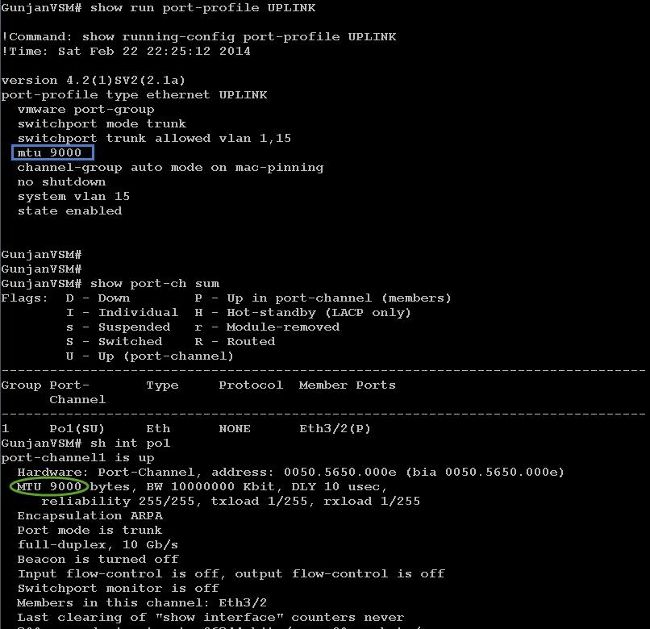

Com o N1kV, a MTU jumbo pode ser configurada apenas nos perfis de porta Ethernet para uplink; a MTU não pode ser configurada na interface vEthernet.

Verificar

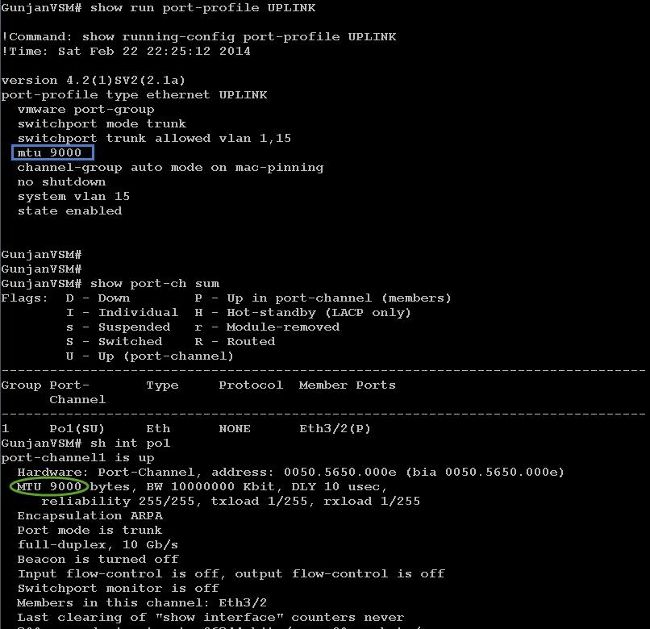

Insira o comando show run port-profile UPLINK para verificar se a configuração está correta:

Configuração do NetApp FAS 3240

No controlador de armazenamento, as portas de rede conectadas ao Interconector de estrutura ou ao switch de Camada 2 (L2) devem ter o jumbo MTU configurado. Aqui está um exemplo de configuração:

FAS3240-A> vlan create e1a 100

Ethernet e1a: Link being reconfigured.

vlan: e1a-100 has been created

Ethernet e1a: Link up.

FAS3240-A> vlan create e1b 100

Ethernet e1b: Link being reconfigured.

vlan: e1b-100 has been created

Ethernet e1b: Link up.

FAS3240-A> ifconfig e1a-100 192.168.101.105 netmask 255.255.255.0 mtusize 9000

partner e1a-100

FAS3240-A> ifconfig e1b-100 192.168.102.105 netmask 255.255.255.0 mtusize 9000

partner e1b-100

Verificar

Use esta seção para verificar se a configuração está correta.

FAS3240-A> ifconfig –a

e1a: flags=0x80f0c867<BROADCAST,RUNNING,MULTICAST,TCPCKSUM,VLAN> mtu 9000

ether 00:c0:dd:11:40:2c (auto-10g_twinax-fd-up) flowcontrol full

e1b: flags=0x80f0c867<BROADCAST,RUNNING,MULTICAST,TCPCKSUM,VLAN> mtu 9000

ether 00:c0:dd:11:40:2e (auto-10g_twinax-fd-up) flowcontrol full

Feedback

Feedback