Configurar o L3out entre sites com estruturas de vários locais da ACI

Opções de download

Linguagem imparcial

O conjunto de documentação deste produto faz o possível para usar uma linguagem imparcial. Para os fins deste conjunto de documentação, a imparcialidade é definida como uma linguagem que não implica em discriminação baseada em idade, deficiência, gênero, identidade racial, identidade étnica, orientação sexual, status socioeconômico e interseccionalidade. Pode haver exceções na documentação devido à linguagem codificada nas interfaces de usuário do software do produto, linguagem usada com base na documentação de RFP ou linguagem usada por um produto de terceiros referenciado. Saiba mais sobre como a Cisco está usando a linguagem inclusiva.

Sobre esta tradução

A Cisco traduziu este documento com a ajuda de tecnologias de tradução automática e humana para oferecer conteúdo de suporte aos seus usuários no seu próprio idioma, independentemente da localização. Observe que mesmo a melhor tradução automática não será tão precisa quanto as realizadas por um tradutor profissional. A Cisco Systems, Inc. não se responsabiliza pela precisão destas traduções e recomenda que o documento original em inglês (link fornecido) seja sempre consultado.

Contents

Introduction

Este documento descreve as etapas para a configuração L3out entre locais com a estrutura de vários locais da Cisco Application Centric Infrastructure (ACI).

Prerequisites

Requirements

A Cisco recomenda que você tenha conhecimento destes tópicos:

- Configuração funcional da estrutura em vários locais da ACI

- Roteador/conectividade externa

Componentes Utilizados

As informações neste documento são baseadas em:

-

Multi-Site Orchestrator (MSO) versão 2.2(1) ou posterior

-

ACI versão 4.2(1) ou posterior

- nós MSO

- Malhas da ACI

- Switch Nexus 9000 Series (N9K) (host final e simulação de dispositivo externo L3out)

- Switch Nexus 9000 Series (N9K) (rede entre locais (ISN))

The information in this document was created from the devices in a specific lab environment. All of the devices used in this document started with a cleared (default) configuration. Se a rede estiver ativa, certifique-se de que você entenda o impacto potencial de qualquer comando.

Informações de Apoio

Esquemas suportados para configuração de L3out entre sites

Esquema-config1

- Espaço estendido entre os locais (A e B).

- Virtual Routing and Forwarding (VRF) estendido entre os sites (A e B).

- Grupo de endpoints (EPG)/Domínio da bridge (BD) local para um local (A).

- L3out local para outro site (B).

- EPG externo de L3out local para local (B).

- Criação e configuração de contrato feitas do MSO.

Esquema-config2

- Espaço estendido entre os locais (A e B).

- VRF estendido entre os locais (A e B).

- EPG/BD estendido entre os sites (A e B).

- L3out local para um local (B).

- EPG externo de L3out local para local (B).

- A configuração do contrato pode ser feita no MSO, ou cada site tem a criação de contrato local do Application Policy Infrastructure Controller (APIC) e anexado localmente entre o EPG estendido e o EPG externo L3out. Nesse caso, Shadow External_EPG aparece no site A porque é necessário para a relação de contrato local e implementações de política.

Esquema-config3

- Espaço estendido entre os locais (A e B).

- VRF estendido entre os locais (A e B).

- EPG/BD estendido entre os sites (A e B).

- L3out local para um local (B).

- EPG externo de L3out estendido entre os sites (A e B).

- A configuração do contrato pode ser feita no MSO, ou cada site tem criação de contrato local no APIC e anexado localmente entre o EPG estendido e o EPG externo estendido.

Esquema-config4

- Espaço estendido entre os locais (A e B).

- VRF estendido entre os locais (A e B).

- EPG/BD local para um local (A) ou EPG/BD local para cada local (EPG-A no local A e EPG-B no local B).

- L3out local para um local (B) ou, para redundância em relação à conectividade externa, você pode ter L3out local para cada local (local para o local A e local para o local B).

- EPG externo de L3out estendido entre os sites (A e B).

- A configuração do contrato pode ser feita no MSO ou cada site tem criação de contrato local no APIC e anexado localmente entre EPG estendido e EPG externo estendido.

Schema-config5 (Roteamento de trânsito)

- Espaço estendido entre os locais (A e B).

- VRF estendido entre os locais (A e B).

- L3out local para cada site (local para o site A e local para o site B).

- EPG externo de local para cada local (A e B).

- A configuração do contrato pode ser feita no MSO ou cada site tem criação de contrato local no APIC e anexado localmente entre o EPG local externo e o EPG externo invisível local.

Schema-config5 (Roteamento de Trânsito InterVRF)

- Espaço estendido entre os locais (A e B).

- VRF local para cada local (A e B).

- L3out local para cada site (local para o site A e local para o site B).

- EPG externo de local para cada local (A e B).

- A configuração do contrato pode ser feita no MSO ou cada site tem criação de contrato local no APIC e anexado localmente entre o EPG local externo e o EPG externo invisível local.

Observação: este documento fornece etapas básicas de configuração e verificação de L3out entre locais. Neste exemplo, Schema-config1 é usado.

Configurar

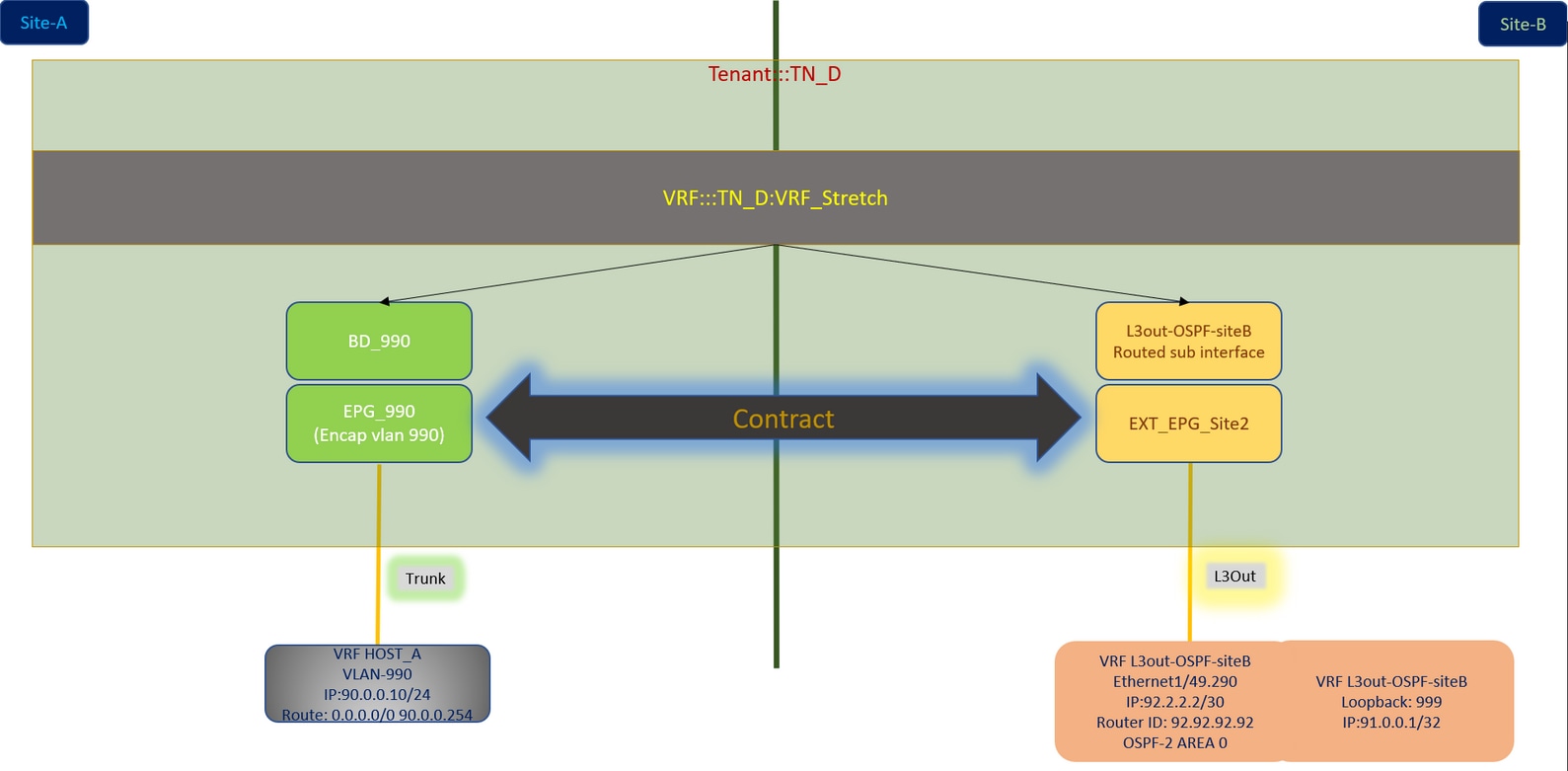

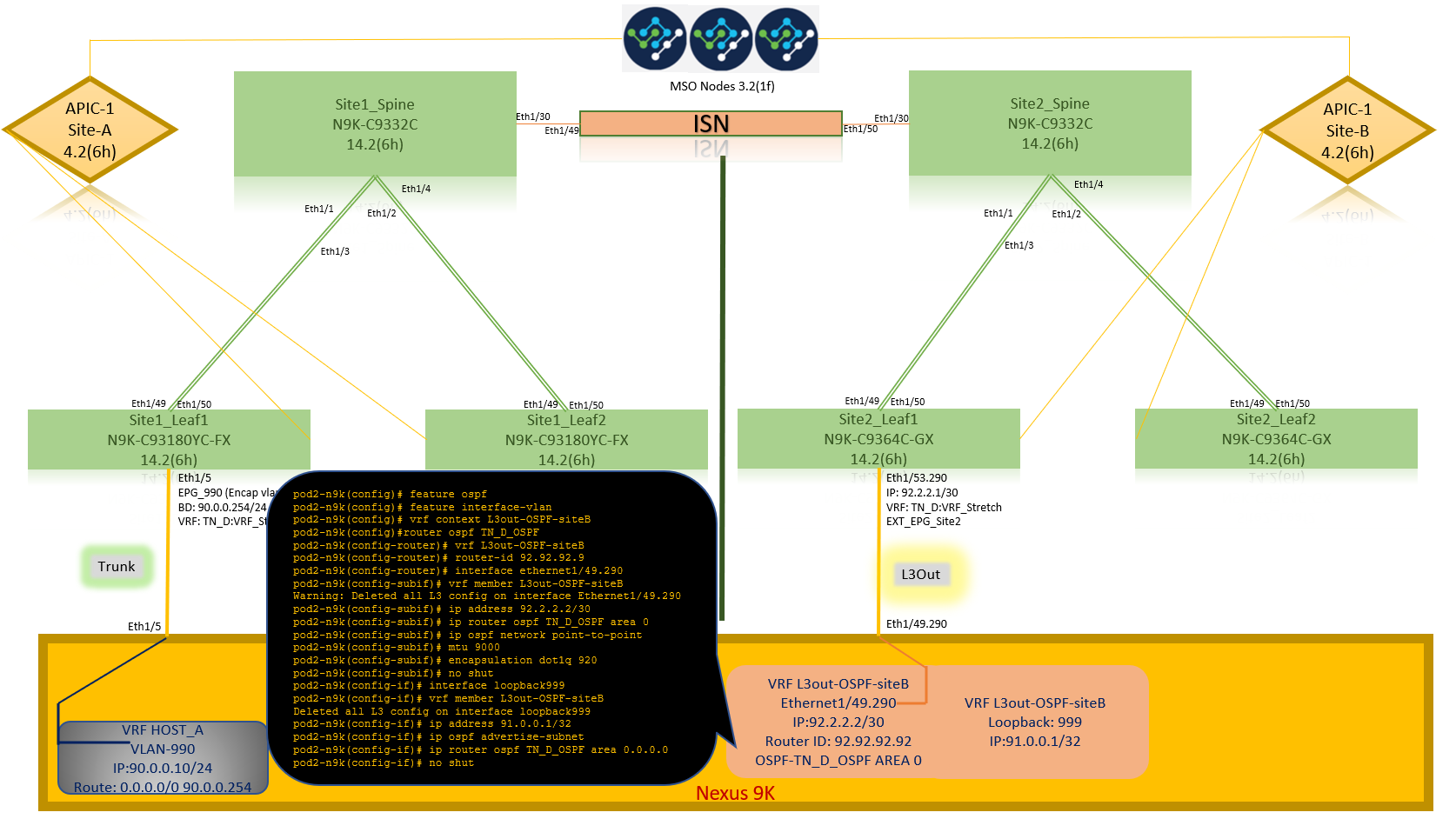

Diagramas de rede

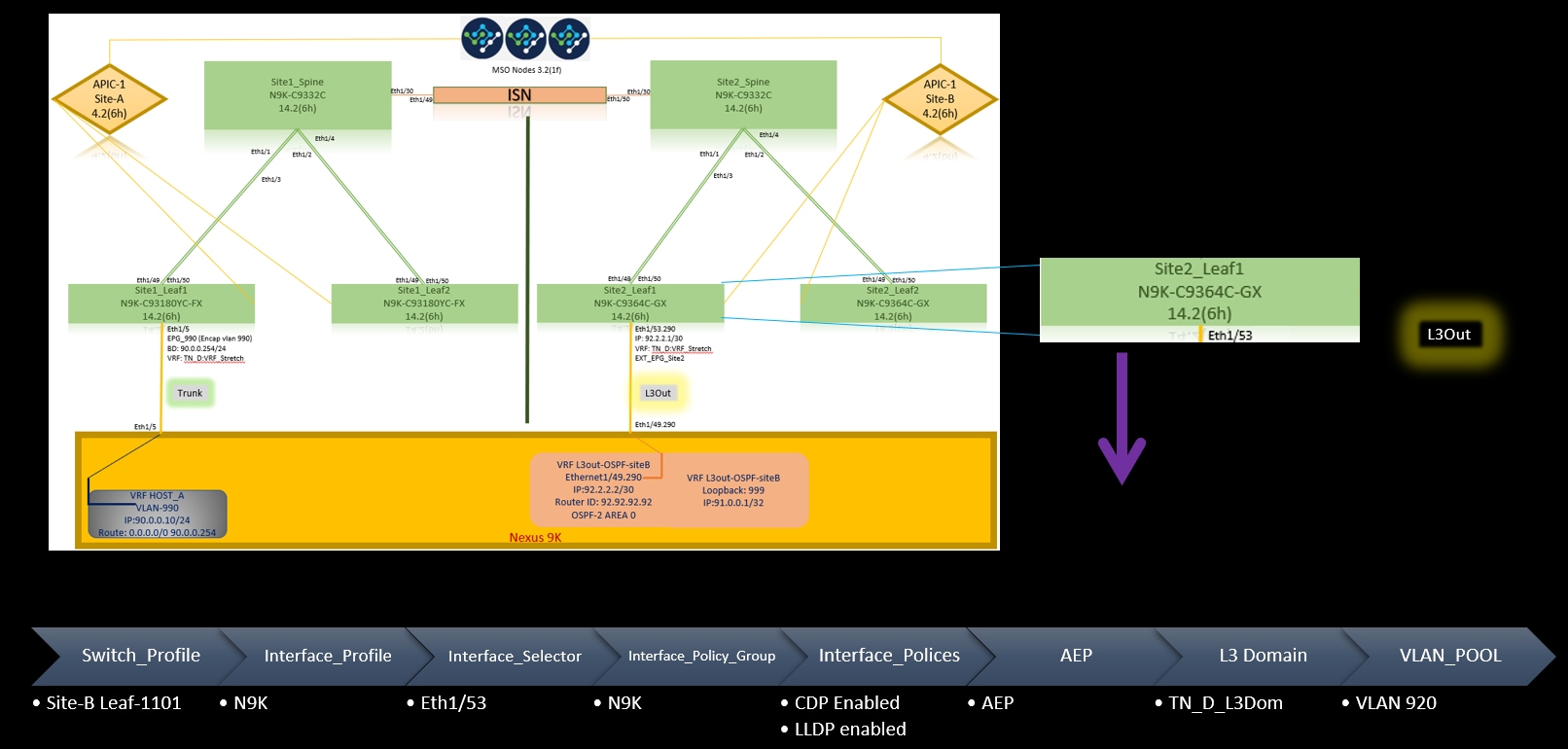

Topologia física

Topologia lógica

Configurações

Neste exemplo, usamos Schema-config1. No entanto, essa configuração pode ser concluída de forma semelhante (com pequenas alterações conforme a relação de contrato) para outras configurações de esquema suportadas, exceto que o objeto estendido precisa estar no modelo estendido em vez do modelo de site específico.

Configurar Schema-config1

- Espaço estendido entre os locais (A e B).

- VRF estendido entre os locais (A e B).

- EPG/BD local para um local (A).

- L3out local para outro site (B).

- EPG externo de L3out local para local (B).

- Criação de contrato e configurações feitas do MSO.

Analise as Diretrizes e Limitações de L3Out Intersite.

-

Configuração não suportada com L3out entre locais:

-

Receptores multicast em um site que recebe multicast de uma fonte externa via outra L3out de site. O multicast recebido em um site de uma fonte externa nunca é enviado para outros sites. Quando um receptor em um site recebe multicast de uma fonte externa, ele deve ser recebido em um L3out local.

-

Uma origem multicast interna envia um multicast a um receptor externo com PIM-SM any source multicast (ASM). Uma origem de multicast interno deve ser capaz de acessar um ponto de encontro externo (RP) de um L3out local.

-

Malha OverLay Giant (GOLF).

-

Grupos preferidos para EPG externo.

-

Configurar as políticas de estrutura

As políticas de estrutura em cada local são uma configuração essencial, pois essas configurações de política estão vinculadas a conexões físicas específicas de espaço/EPG/porta estática ou L3out. Qualquer erro de configuração com políticas de estrutura pode levar à falha da configuração lógica do APIC ou MSO, portanto, a configuração de política de estrutura fornecida que foi usada em uma configuração de laboratório. Ele ajuda a entender qual objeto está vinculado a qual objeto no MSO ou no APIC.

Políticas de estrutura de conexão Host_A no site A

Políticas de estrutura de conexão L3out no site B

Etapa opcional

Depois de ter as políticas de estrutura em vigor para as respectivas conexões, você pode garantir que todas as folhas/espinhos sejam descobertas e acessíveis a partir do respectivo cluster APIC. Em seguida, você pode validar se os dois locais (clusters APIC) estão acessíveis do MSO e se a configuração de vários locais está operacional (e conectividade IPN).

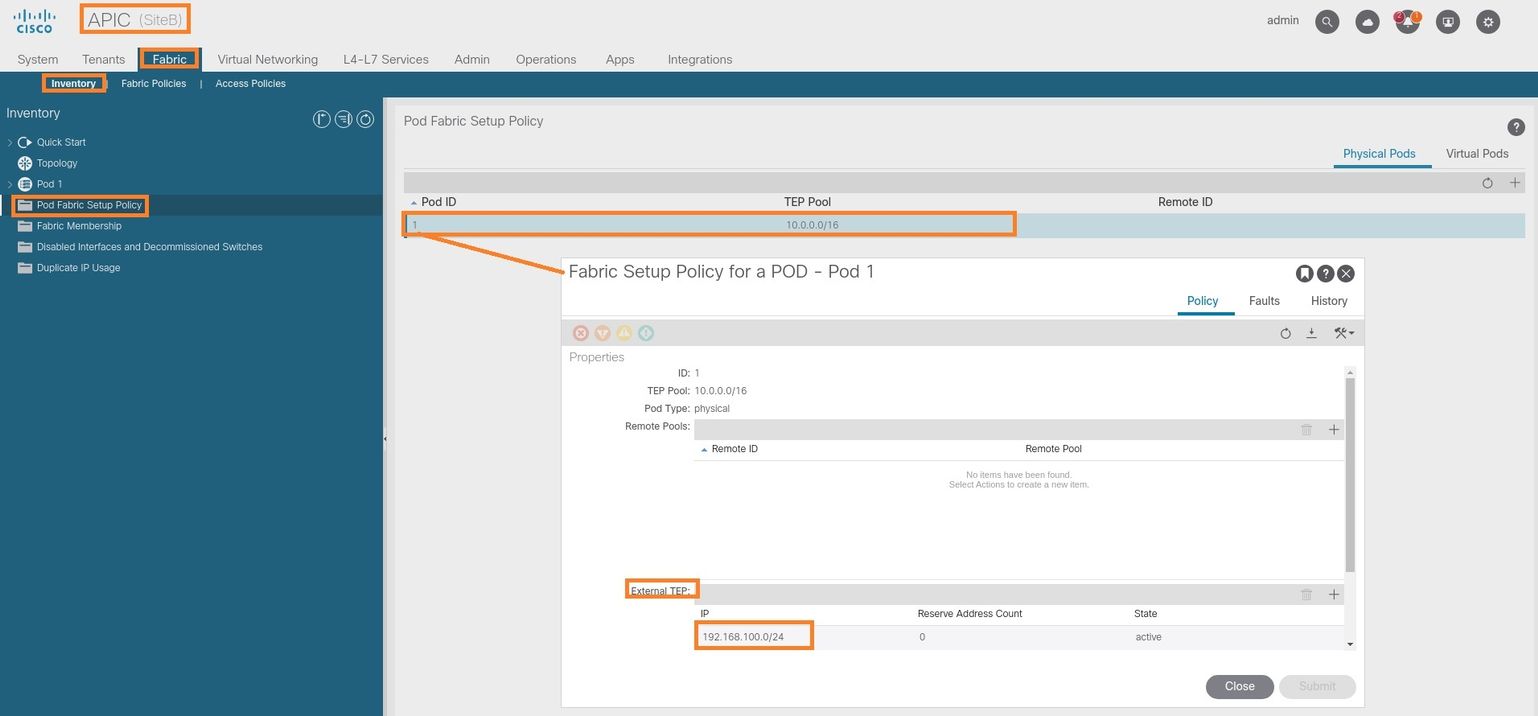

Configurar RTEP/ETEP

O RTEP (Routable Tunnel Endpoint Pool) ou ETEP (External Tunnel Endpoint Pool) é a configuração necessária para L3out entre locais. A versão mais antiga do MSO exibe "Pools de TEP Roteáveis", enquanto a versão mais recente do MSO exibe "Pools de TEP Externos", mas ambos são sinônimos. Esses pools de TEP são usados para o Border Gateway Protocol (BGP) Ethernet VPN (EVPN) via VRF "Overlay-1".

As rotas externas de L3out são anunciadas via BGP EVPN para outro site. Esse RTEP/ETEP também é usado para configuração de folha remota, portanto, se você tiver uma configuração ETEP/RTEP que já exista no APIC, ele deverá ser importado no MSO.

Aqui estão as etapas para configurar ETEP a partir da GUI do MSO. Como a versão é 3.X MSO, ela exibe ETEP. Os pools ETEP devem ser exclusivos em cada site e não devem se sobrepor a nenhuma sub-rede EPG/BD interna de cada site.

Site A

Etapa 1. Na página da GUI do MSO (abra o controlador de vários sites em uma página da Web), escolha Infrastructure > Infra Configuration. Clique em Configurar Infra.

Etapa 2. Dentro de Configure Infra, escolha Site-A, Inside Site-A, escolha pod-1. Em seguida, no pod-1 interno, configure grupos TEP externos com o endereço IP TEP externo para o Site A. (Neste exemplo, 192.168.200.0/24). Se você tiver Multi-POD no Site A, repita esta etapa para outros pods.

Etapa 3. Para verificar a configuração dos pools ETEP na GUI do APIC, escolha Fabric > Inventory > Pod Fabric Setup Policy > Pod-ID (clique duas vezes para abrir [Fabric Setup Policy a POD-Pod-x]) > External TEP.

Você também pode verificar a configuração com estes comandos:

moquery -c fabricExtRoutablePodSubnet

moquery -c fabricExtRoutablePodSubnet -f 'fabric.ExtRoutablePodSubnet.pool=="192.168.200.0/24"'

APIC1# moquery -c fabricExtRoutablePodSubnet Total Objects shown: 1 # fabric.ExtRoutablePodSubnet pool : 192.168.200.0/24 annotation : orchestrator:msc childAction : descr : dn : uni/controller/setuppol/setupp-1/extrtpodsubnet-[192.168.200.0/24] extMngdBy : lcOwn : local modTs : 2021-07-19T14:45:22.387+00:00 name : nameAlias : reserveAddressCount : 0 rn : extrtpodsubnet-[192.168.200.0/24] state : active status : uid : 0

Local B

Etapa 1. Configure o pool de TEP externo para o site B (As mesmas etapas do site A). Na página da GUI do MSO (abra o controlador de vários sites em uma página da Web), escolha Infrastructure > Infra Configuration. Clique em Configurar Infra. Dentro de Configure Infra, escolha Site-B. Dentro do Site-B, escolha pod-1. Em seguida, no pod-1 interno, configure grupos TEP externos com o endereço IP TEP externo para o Site-B. (Neste exemplo, 192.168.100.0/24). Se você tiver Multi-POD no Site-B, repita esta etapa para outros pods.

Etapa 2. Para verificar a configuração dos pools ETEP na GUI do APIC, escolha Fabric > Inventory > Pod Fabric Setup Policy > Pod-ID (clique duas vezes para abrir [Fabric Setup Policy a POD-Pod-x]) > External TEP.

Para o APIC Site-B, insira este comando para verificar o pool de endereços ETEP.

apic1# moquery -c fabricExtRoutablePodSubnet -f 'fabric.ExtRoutablePodSubnet.pool=="192.168.100.0/24"' Total Objects shown: 1 # fabric.ExtRoutablePodSubnet pool : 192.168.100.0/24 annotation : orchestrator:msc <<< This means, configuration pushed from MSO. childAction : descr : dn : uni/controller/setuppol/setupp-1/extrtpodsubnet-[192.168.100.0/24] extMngdBy : lcOwn : local modTs : 2021-07-19T14:34:18.838+00:00 name : nameAlias : reserveAddressCount : 0 rn : extrtpodsubnet-[192.168.100.0/24] state : active status : uid : 0

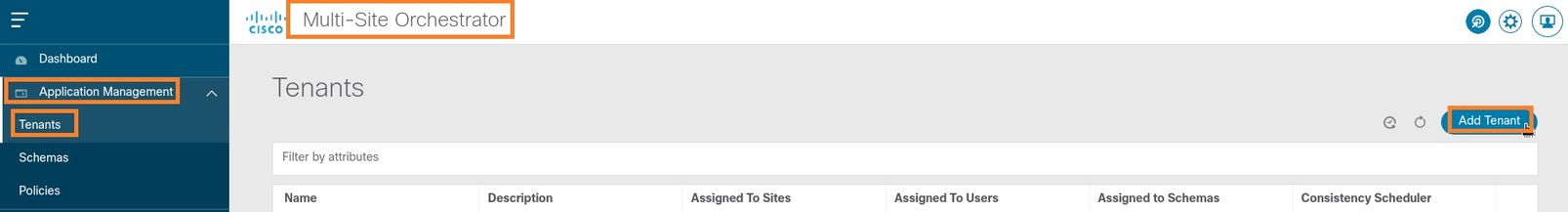

Configurar o Espaço Estendido

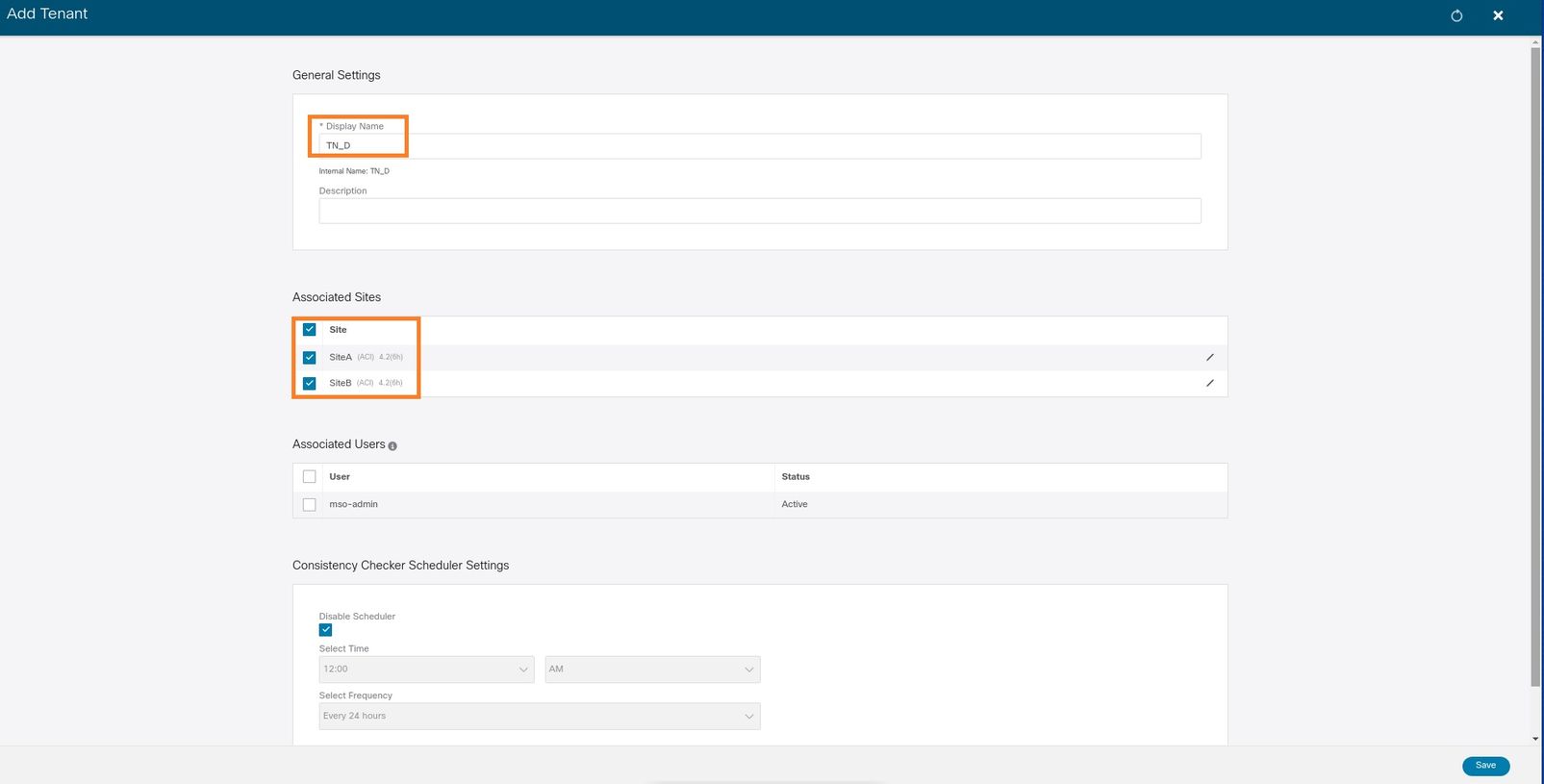

Etapa 1. Na GUI do MSO, escolha Gerenciamento de aplicativos > Locatários. Clique em Adicionar Espaço. Neste exemplo, o nome do Espaço é "TN_D".

Etapa 2. No campo Display Name, insira o nome do espaço. Na seção Sites associados, marque as caixas de seleção Site A e Site B.

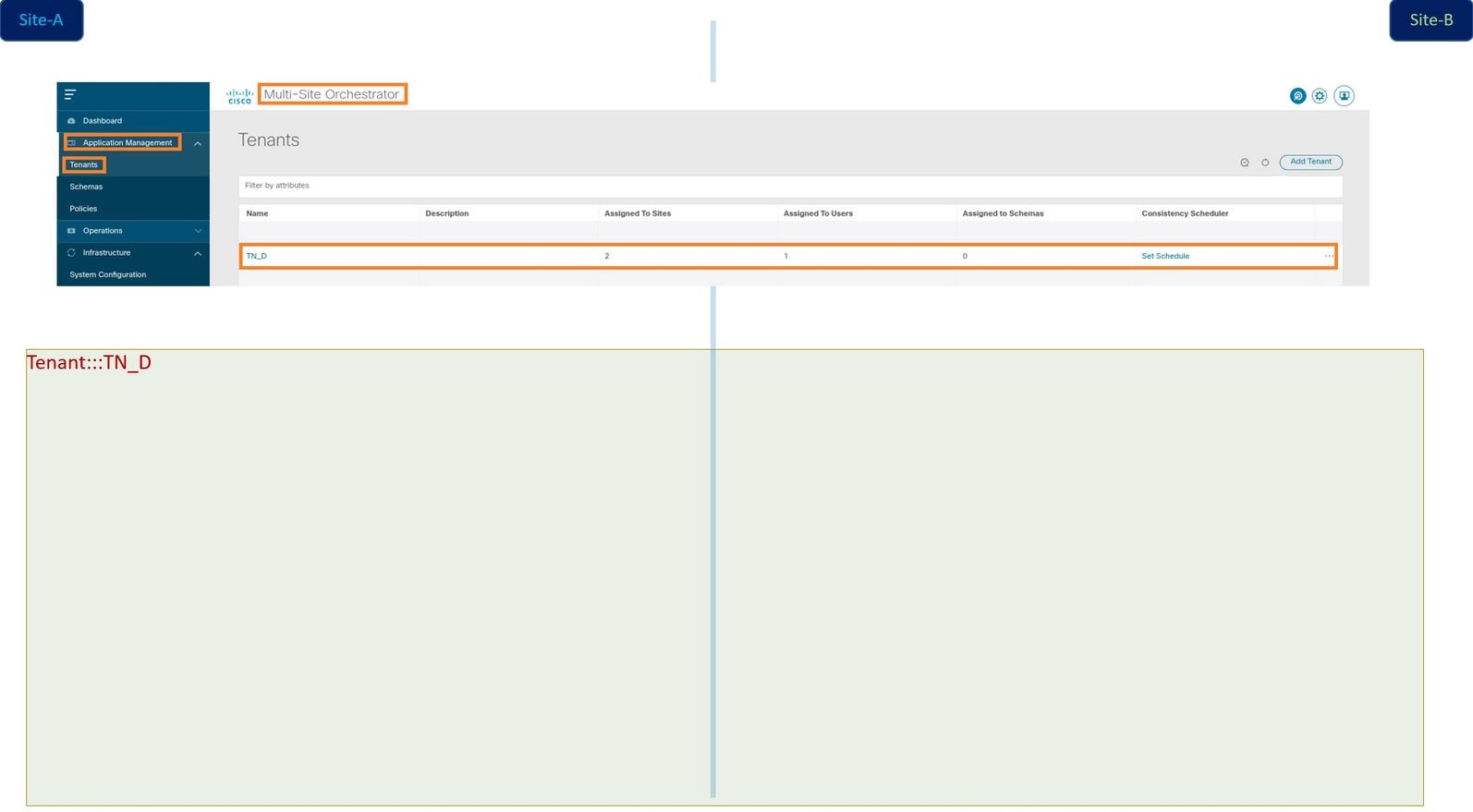

Etapa 3. Verifique se o novo espaço "Tn_D" foi criado.

Visão Lógica

Quando criamos um espaço do MSO, ele basicamente cria um espaço no Site A e no Site B. É um inquilino. Uma exibição lógica deste espaço é mostrada neste exemplo. Essa exibição lógica ajuda a entender que o TN_D do espaço é um espaço estendido entre o Site A e o Site B.

Você pode verificar a exibição lógica no APIC de cada site. Você pode ver que o Site A e o Site B mostram o espaço "TN_D" criado.

O mesmo espaço estendido "TN_D" também é criado no Site-B.

Esse comando mostra o espaço enviado do MSO e você pode usá-lo para fins de verificação. Você pode executar esse comando no APIC de ambos os sites.

APIC1# moquery -c fvTenant -f 'fv.Tenant.name=="TN_D"' Total Objects shown: 1 # fv.Tenant name : TN_D annotation : orchestrator:msc childAction : descr : dn : uni/tn-TN_D extMngdBy : msc lcOwn : local modTs : 2021-09-17T21:42:52.218+00:00 monPolDn : uni/tn-common/monepg-default nameAlias : ownerKey : ownerTag : rn : tn-TN_D status : uid : 0

apic1# moquery -c fvTenant -f 'fv.Tenant.name=="TN_D"' Total Objects shown: 1 # fv.Tenant name : TN_D annotation : orchestrator:msc childAction : descr : dn : uni/tn-TN_D extMngdBy : msc lcOwn : local modTs : 2021-09-17T21:43:04.195+00:00 monPolDn : uni/tn-common/monepg-default nameAlias : ownerKey : ownerTag : rn : tn-TN_D status : uid : 0

Configurar o esquema

Em seguida, crie um esquema que tenha um total de três modelos:

- Modelo para o Site-A: O modelo para o Site-A apenas se associa ao Site-A, portanto, qualquer configuração de objeto lógico nesse modelo pode ser enviada apenas para o APIC do Site-A.

- Modelo para o Site-B: O modelo para o Site-B apenas se associa ao Site-B, portanto, qualquer configuração de objeto lógico nesse modelo só pode ser enviada para o APIC do Site-B.

- Modelo ampliado: O modelo estendido associa-se a ambos os sites e qualquer configuração lógica no modelo estendido pode ser enviada para ambos os sites de APICs.

Criar o Esquema

O esquema é localmente significativo no MSO, não cria nenhum objeto no APIC. A configuração do esquema é a separação lógica de cada configuração. Você pode ter vários esquemas para os mesmos espaços e também pode ter vários modelos dentro de cada esquema.

Por exemplo, você pode ter um esquema para o servidor de banco de dados para o espaço X e o servidor de aplicativos usa um esquema diferente para o mesmo espaço-X. Isso pode ajudar a separar cada configuração específica relacionada ao aplicativo e é fácil quando você precisa depurar um problema. Também é fácil encontrar informações.

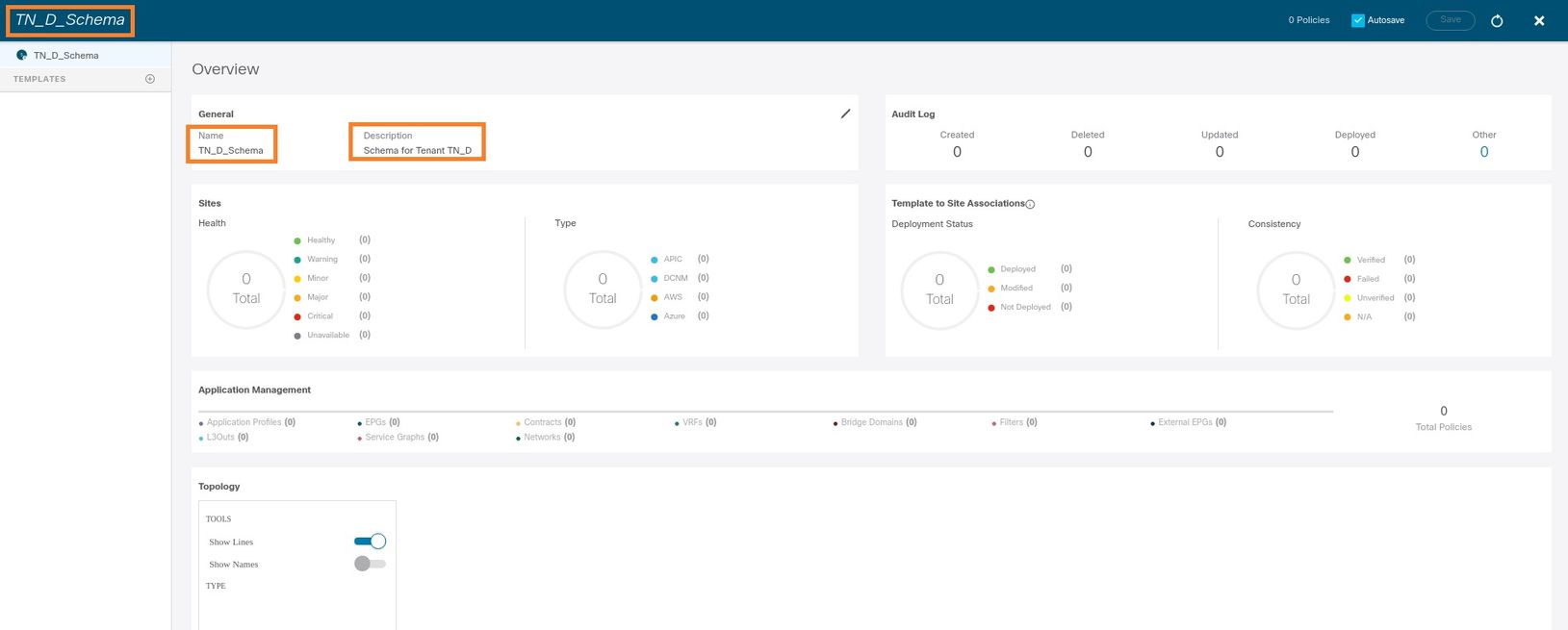

Crie um esquema com o nome do espaço (por exemplo, TN_D_Schema). No entanto, não é necessário ter o nome do esquema iniciado com o nome do espaço, você pode criar um esquema com qualquer nome.

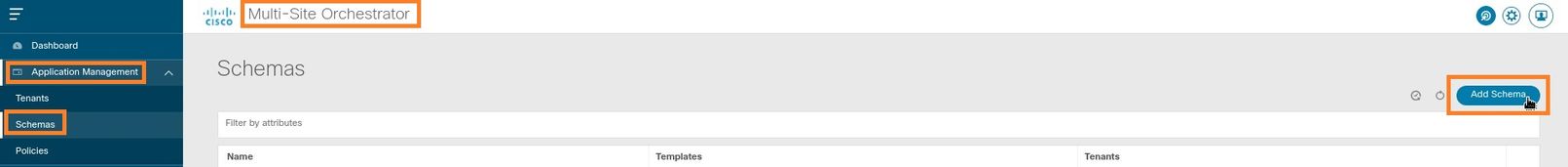

Etapa 1. Escolha Gerenciamento de aplicativos > Esquemas. Clique em Adicionar esquema.

Etapa 2. No campo Nome, insira o nome do esquema. Neste exemplo, é "TN_D_Schema", no entanto, você pode manter qualquer nome apropriado para o seu ambiente. Clique em Add.

Etapa 3. Verifique se o esquema "TN_D_Schema" foi criado.

Criar o Modelo do Site A

Etapa 1. Adicione um modelo dentro do esquema.

- Para criar um modelo, clique em Modelos no esquema que você criou. A caixa de diálogo Selecionar um tipo de modelo é exibida.

- Escolha ACI Multi-cloud.

- Clique em Add.

Etapa 2. Insira um nome para o modelo. Este modelo é específico do Site-A, portanto o nome do modelo "Modelo do Site-A". Quando o modelo for criado, você poderá anexar um espaço específico ao modelo. Neste exemplo, o espaço "TN_D" está anexado.

Configurar o modelo

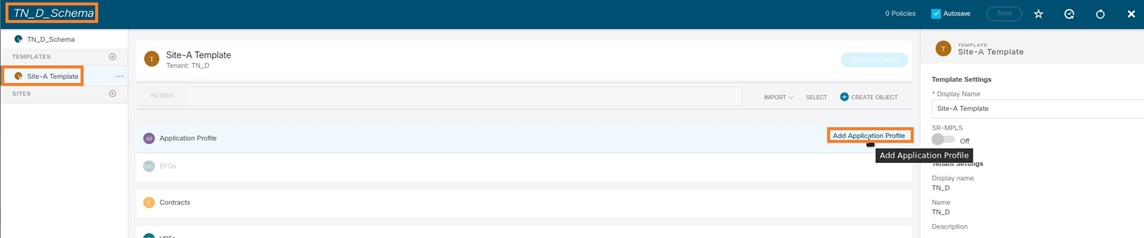

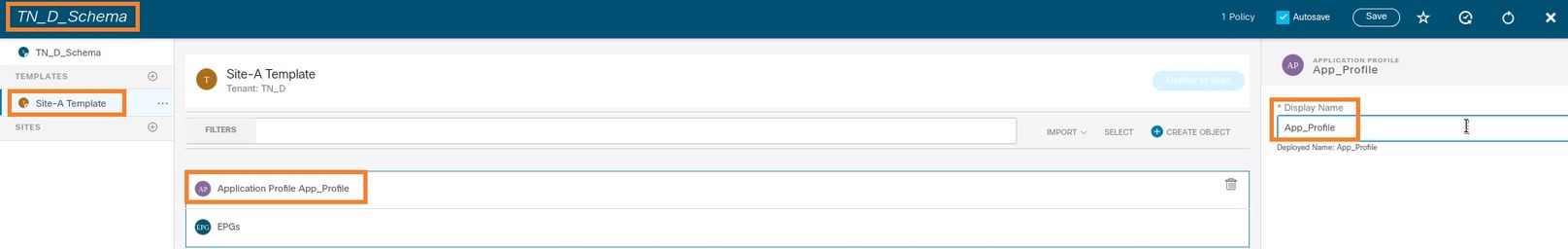

Configuração do perfil do aplicativo

Etapa 1. No esquema que você criou, escolha Modelo Site-A. Clique em Add Application Profile.

Etapa 2. No campo Display Name, insira o nome do perfil do aplicativo App_Profile.

Etapa 3. A próxima etapa é criar o EPG. Para adicionar o EPG no perfil do aplicativo, clique em Adicionar EPG no modelo Site-A. Você pode ver que um novo EPG é criado na configuração do EPG.

Etapa 4. Para anexar o EPG com BD e VRF, você precisa adicionar BD e VRF em EPG. Escolha Modelo Site-A. No campo Display Name, insira o nome do EPG e anexe um novo BD (você pode criar um novo BD ou anexar um BD existente).

Observe que você precisa conectar o VRF a um BD, mas o VRF é ampliado nesse caso. Você pode criar o modelo estendido com VRF estendido e, em seguida, anexar esse VRF ao BD sob o modelo específico do site (no nosso caso, é o Modelo do site A).

Crie o modelo Stretch

Etapa 1. Para criar o modelo de trecho, em TN_D_Schema, clique em Modelos. A caixa de diálogo Selecionar um tipo de modelo é exibida. Escolha ACI Multi-cloud. Clique em Add. Digite o nome Modelo estendido para o modelo. (Você pode digitar qualquer nome para o modelo ampliado.)

Etapa 2. Escolha Modelo estendido e crie um VRF com o nome VRF_Stretch. (Você pode digitar qualquer nome para VRF.)

O BD foi criado com a criação do EPG em Modelo do site A, mas não havia VRF anexado, portanto você precisa anexar o VRF que agora está criado no Modelo estendido.

Etapa 3. Escolha Modelo Site-A > BD_990. Na lista suspensa Virtual Routing & Forwarding, escolha VRF_Stretch. (O que você criou na Etapa 2 desta seção.)

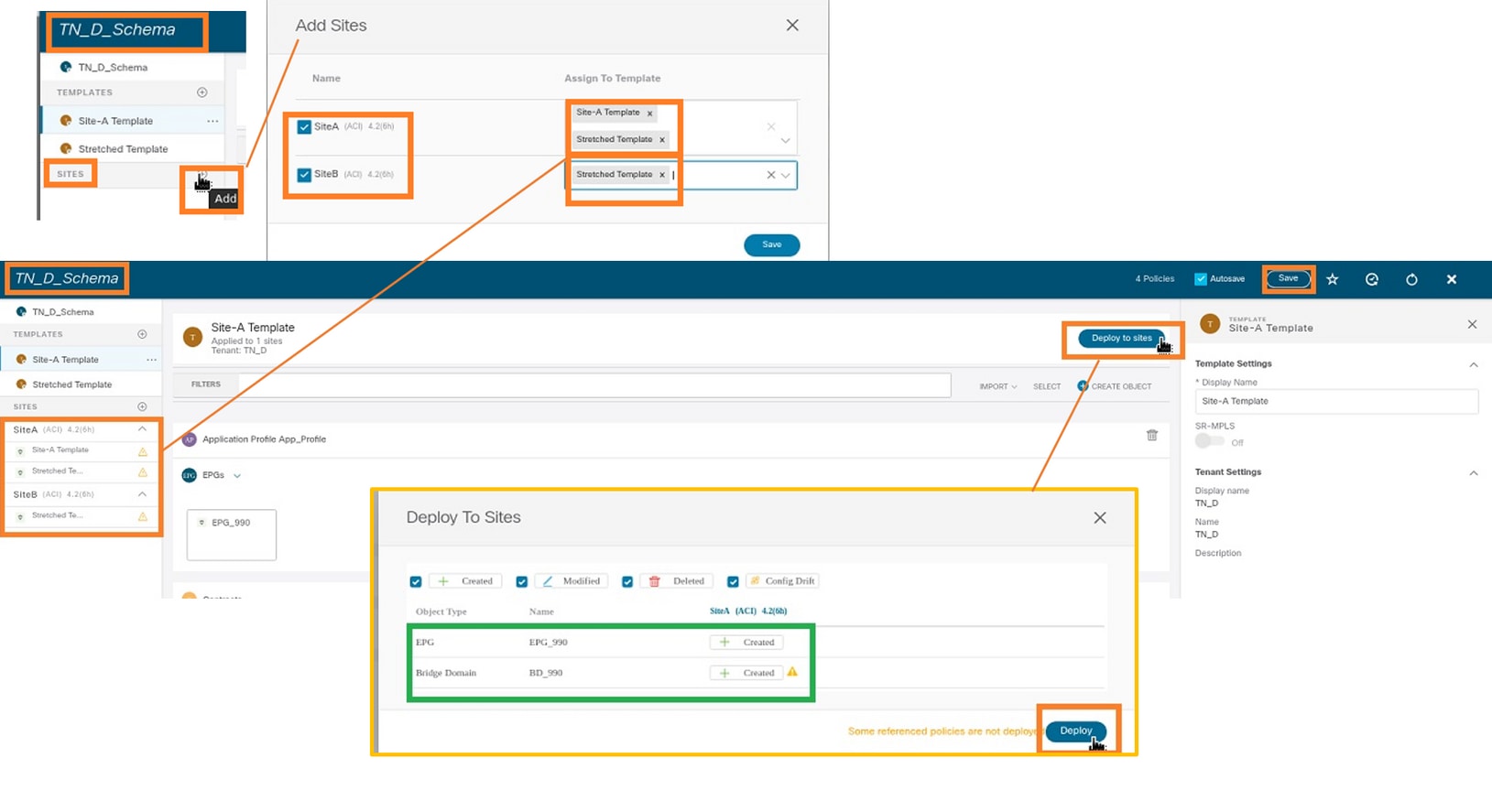

Anexar o modelo

A próxima etapa é anexar o Modelo do Site-A com Site-A apenas, e o modelo ampliado precisa ser anexado a ambos os sites. Clique em Implantar para site dentro do esquema para implantar modelos nos respectivos sites.

Etapa 1. Clique no + sinal em TN_D_Schema > SITES para adicionar sites ao modelo. Na lista suspensa Atribuir ao modelo, escolha o modelo respectivo para os sites apropriados.

Etapa 2. Você pode ver que o Site-A tem EPG e BD agora criados, mas o Site-B não tem o mesmo EPG/BD criado porque essa configuração se aplica somente ao Site-A do MSO. No entanto, você pode ver que o VRF é criado no modelo estendido, portanto, ele é criado em ambos os sites.

Etapa 3. Verifique a configuração com esses comandos.

APIC1# moquery -c fvAEPg -f 'fv.AEPg.name=="EPG_990"' Total Objects shown: 1 # fv.AEPg name : EPG_990 annotation : orchestrator:msc childAction : configIssues : configSt : applied descr : dn : uni/tn-TN_D/ap-App_Profile/epg-EPG_990 exceptionTag : extMngdBy : floodOnEncap : disabled fwdCtrl : hasMcastSource : no isAttrBasedEPg : no isSharedSrvMsiteEPg : no lcOwn : local matchT : AtleastOne modTs : 2021-09-18T08:26:49.906+00:00 monPolDn : uni/tn-common/monepg-default nameAlias : pcEnfPref : unenforced pcTag : 32770 prefGrMemb : exclude prio : unspecified rn : epg-EPG_990 scope : 2850817 shutdown : no status : triggerSt : triggerable txId : 1152921504609182523 uid : 0

APIC1# moquery -c fvBD -f 'fv.BD.name=="BD_990"'

Total Objects shown: 1

# fv.BD

name : BD_990

OptimizeWanBandwidth : yes

annotation : orchestrator:msc

arpFlood : yes

bcastP : 225.0.56.224

childAction :

configIssues :

descr :

dn : uni/tn-TN_D/BD-BD_990

epClear : no

epMoveDetectMode :

extMngdBy :

hostBasedRouting : no

intersiteBumTrafficAllow : yes

intersiteL2Stretch : yes

ipLearning : yes

ipv6McastAllow : no

lcOwn : local

limitIpLearnToSubnets : yes

llAddr : ::

mac : 00:22:BD:F8:19:FF

mcastAllow : no

modTs : 2021-09-18T08:26:49.906+00:00

monPolDn : uni/tn-common/monepg-default

mtu : inherit

multiDstPktAct : bd-flood

nameAlias :

ownerKey :

ownerTag :

pcTag : 16387

rn : BD-BD_990

scope : 2850817

seg : 16580488

status :

type : regular

uid : 0

unicastRoute : yes

unkMacUcastAct : proxy

unkMcastAct : flood

v6unkMcastAct : flood

vmac : not-applicable

: 0

APIC1# moquery -c fvCtx -f 'fv.Ctx.name=="VRF_Stretch"' Total Objects shown: 1 # fv.Ctx name : VRF_Stretch annotation : orchestrator:msc bdEnforcedEnable : no childAction : descr : dn : uni/tn-TN_D/ctx-VRF_Stretch extMngdBy : ipDataPlaneLearning : enabled knwMcastAct : permit lcOwn : local modTs : 2021-09-18T08:26:58.185+00:00 monPolDn : uni/tn-common/monepg-default nameAlias : ownerKey : ownerTag : pcEnfDir : ingress pcEnfDirUpdated : yes pcEnfPref : enforced pcTag : 16386 rn : ctx-VRF_Stretch scope : 2850817 seg : 2850817 status : uid : 0

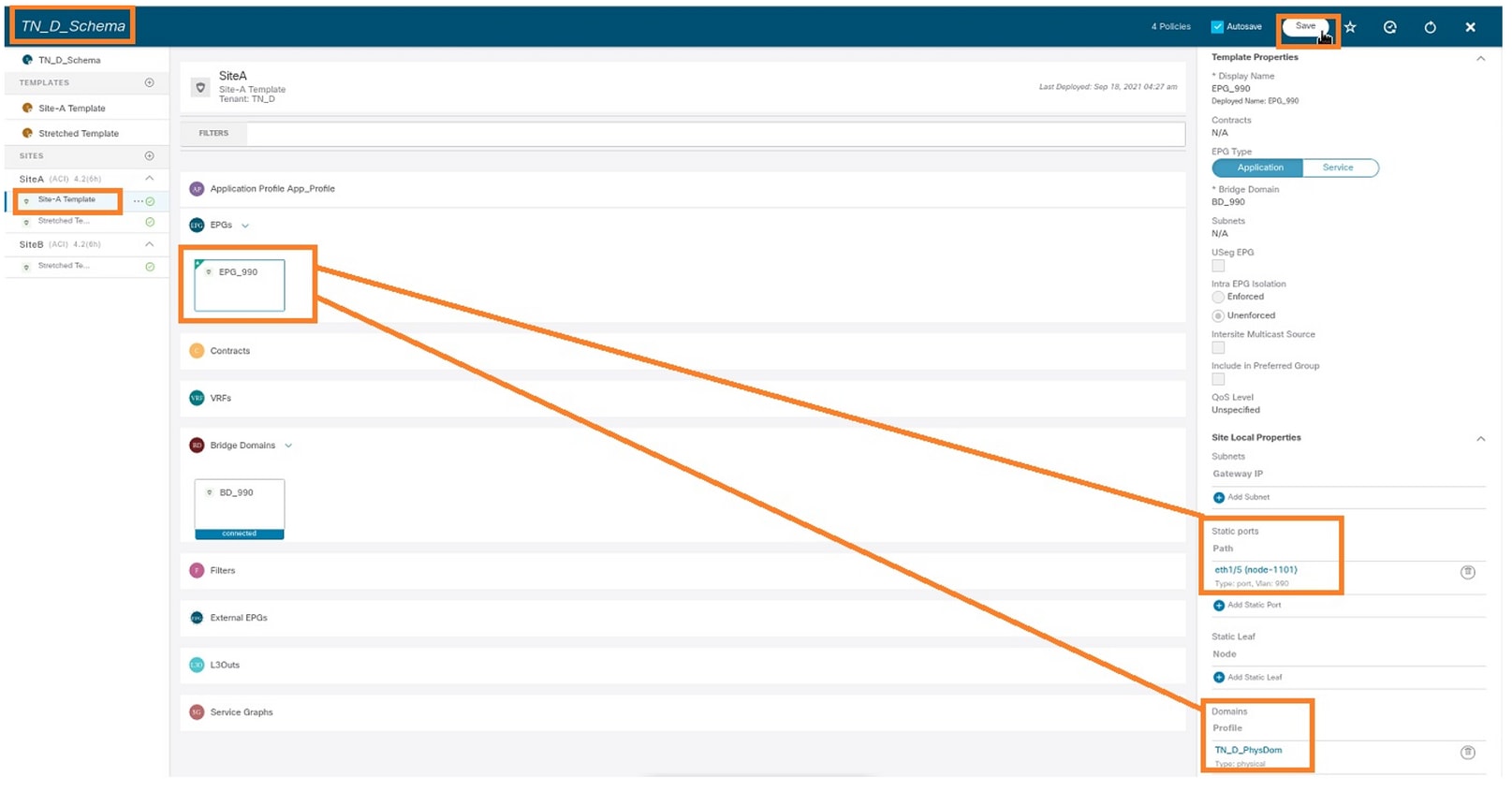

Configurar ligação de porta estática

Agora você pode configurar a associação de porta estática em EPG "EPG_990" e também configurar o N9K com VRF HOST_A (basicamente ele simula HOST_A). A configuração de vinculação de porta estática do lado da ACI será concluída primeiro.

Etapa 1. Adicione o domínio físico em EPG_990.

- No esquema que você criou, escolha Modelo de Site-A > EPG_990.

- Na caixa Propriedades do modelo, clique em Adicionar domínio.

- Na caixa de diálogo Adicionar domínio, escolha estas opções nas listas suspensas:

- Tipo de associação de domínio - físico

- Perfil de domínio - TN_D_PhysDom

- Implantação imediata - imediata

- Resolução imediata - imediata

- Click Save.

Etapa 2. Adicione a porta estática (Site1_Leaf1 eth1/5).

- No esquema que você criou, escolha Modelo de Site-A > EPG_990.

- Na caixa Propriedades do modelo, clique em Adicionar porta estática.

- Na caixa de diálogo Add Static EPG on PC, VPC or Interface, escolha Node-101 eth1/5 e atribua a VLAN 990.

Etapa 3. Verifique se as portas estáticas e o domínio físico foram adicionados em EPG_990.

Verifique a ligação do caminho estático com este comando:

APIC1# moquery -c fvStPathAtt -f 'fv.StPathAtt.pathName=="eth1/5"' | grep EPG_990 -A 10 -B 5 # fv.StPathAtt pathName : eth1/5 childAction : descr : dn : uni/epp/fv-[uni/tn-TN_D/ap-App_Profile/epg-EPG_990]/node-1101/stpathatt-[eth1/5] lcOwn : local modTs : 2021-09-19T06:16:46.226+00:00 monPolDn : uni/tn-common/monepg-default name : nameAlias : ownerKey : ownerTag : rn : stpathatt-[eth1/5] status :

Configurar BD

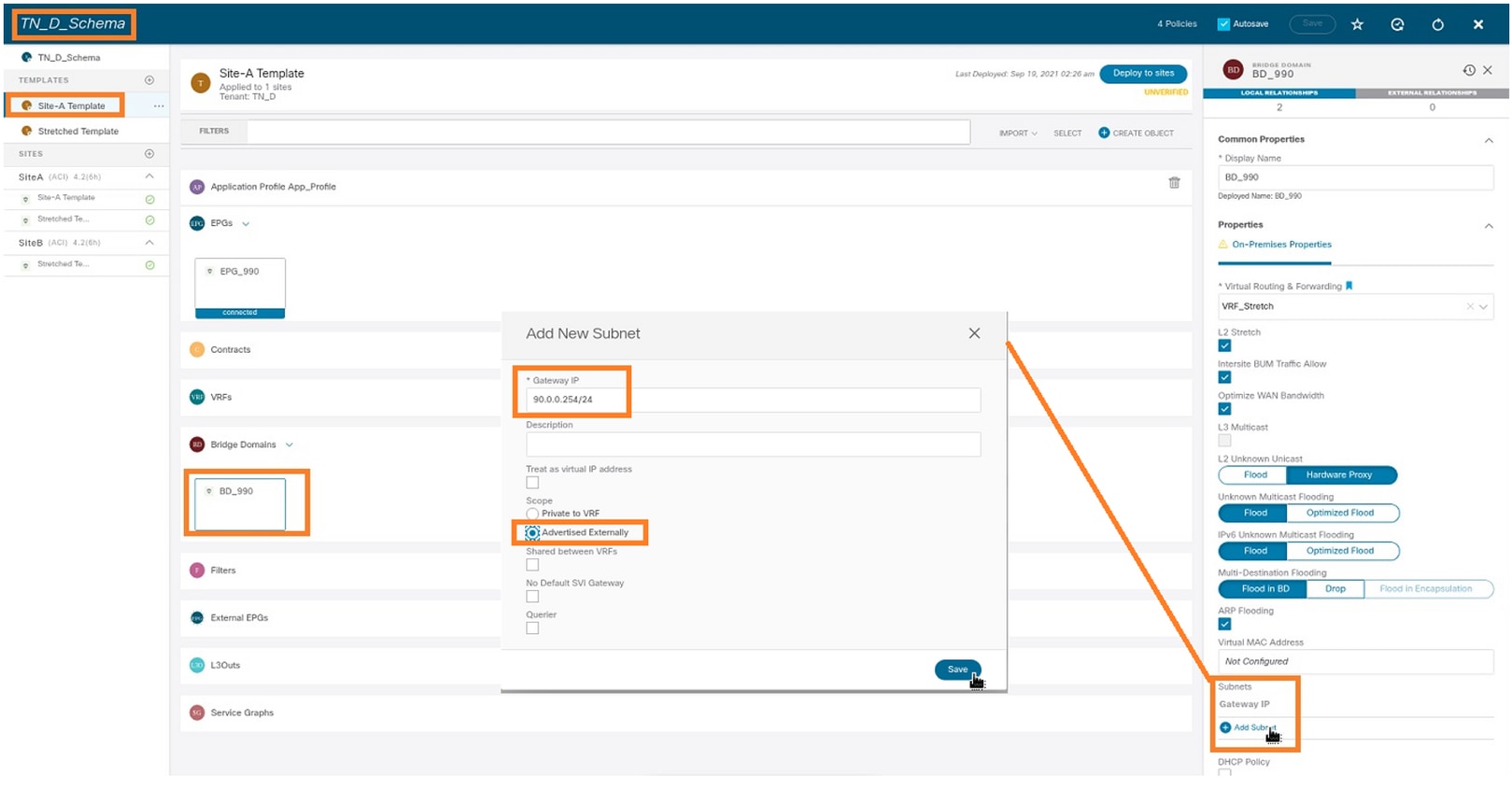

Etapa 1. Adicione a sub-rede/IP em BD (HOST_A usa BD IP como gateway).

- No esquema que você criou, escolha Modelo de Site-A > BD_990.

- Clique em Adicionar sub-rede.

- Na caixa de diálogo Adicionar nova sub-rede, digite o endereço IP do gateway e clique no botão de opção Anunciado externamente.

Etapa 2. Verifique se a sub-rede foi adicionada ao site A do APIC1 com este comando.

APIC1# moquery -c fvSubnet -f 'fv.Subnet.ip=="90.0.0.254/24"' Total Objects shown: 1 # fv.Subnet ip : 90.0.0.254/24 annotation : orchestrator:msc childAction : ctrl : nd descr : dn : uni/tn-TN_D/BD-BD_990/subnet-[90.0.0.254/24] extMngdBy : lcOwn : local modTs : 2021-09-19T06:33:19.943+00:00 monPolDn : uni/tn-common/monepg-default name : nameAlias : preferred : no rn : subnet-[90.0.0.254/24] scope : public status : uid : 0 virtual : no

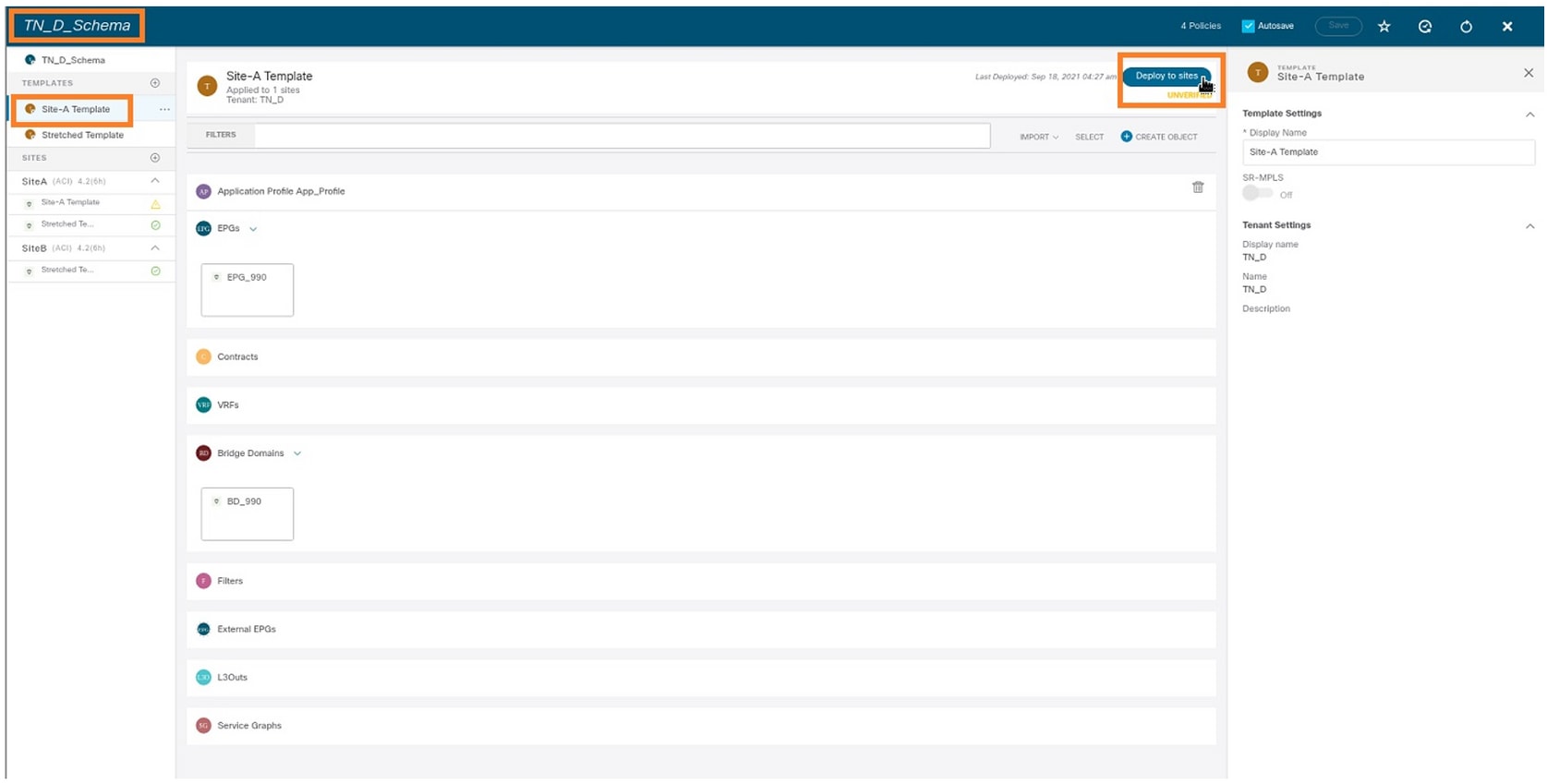

Etapa 3. Implante o modelo Site-A.

- No esquema que você criou, escolha Modelo Site-A.

- Clique em Implantar em sites.

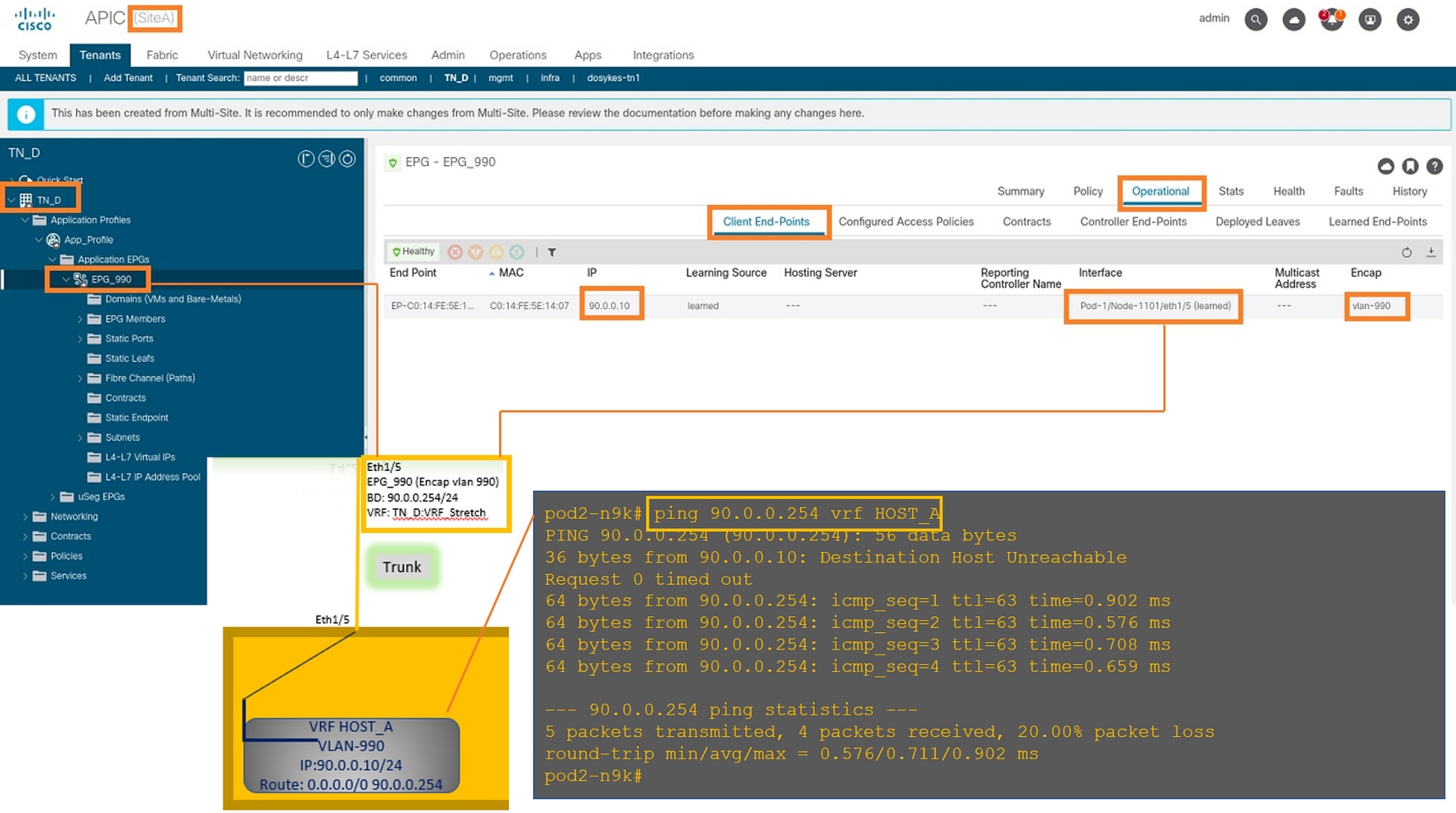

Configurar o Host-A (N9K)

Configure o dispositivo N9K com VRF HOST_A. Quando a configuração N9K for concluída, você poderá ver que o endereço anycast BD folha ACI (gateway de HOST_A) está acessível agora via ICMP(ping).

Na guia operacional da ACI, você pode ver que 90.0.0.10 (endereço IP do HOST_A) foi aprendido.

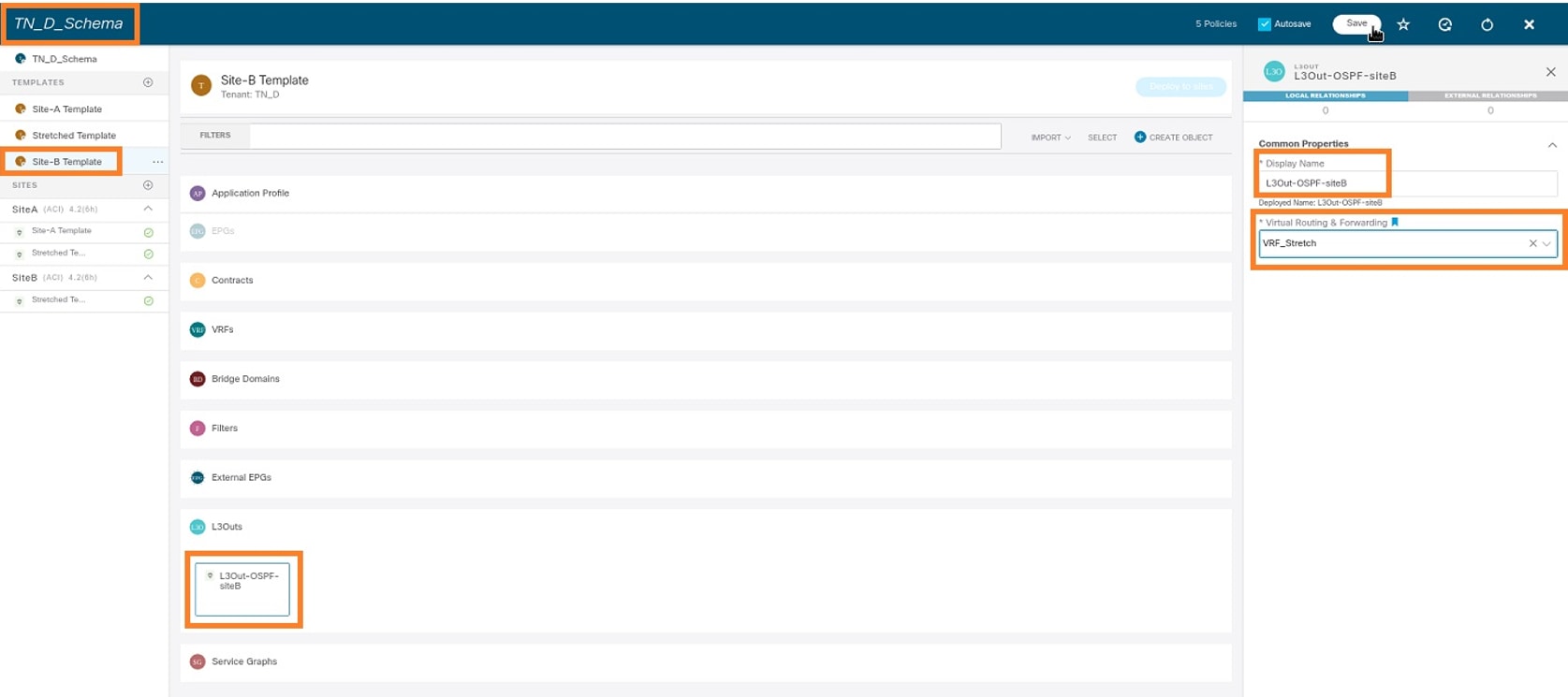

Criar o Modelo Site-B

Etapa 1. No esquema que você criou, escolha MODELOS. Clique no + sinal e crie um modelo com o nome Modelo Site-B.

Configurar L3out do Site-B

Crie L3out e anexe VRF_Stretch. Você precisa criar um objeto L3out do MSO e o resto da configuração L3out precisa ser feito do APIC (já que os parâmetros L3out não estão disponíveis no MSO). Além disso, crie um EPG externo do MSO (somente no modelo Site-B, pois o EPG externo não é ampliado).

Etapa 1. No esquema que você criou, escolha Modelo Site-B. No campo Display Name, digite L3out_OSPF_siteB. Na lista suspensa Virtual Routing & Forwarding, escolha VRF_Stretch.

Crie o EPG externo

Etapa 1. No esquema que você criou, escolha Modelo Site-B. Clique em Adicionar EPG externo.

Etapa 2. Conecte L3out com EPG externo.

- No esquema que você criou, escolha Modelo Site-B.

- No campo Display Name, digite EXT_EPG_Site2.

- No campo Classificação de sub-redes, insira 0.0.0.0/0 para a sub-rede externa do EPG externo.

O restante da configuração L3out é concluído do APIC (Site-B).

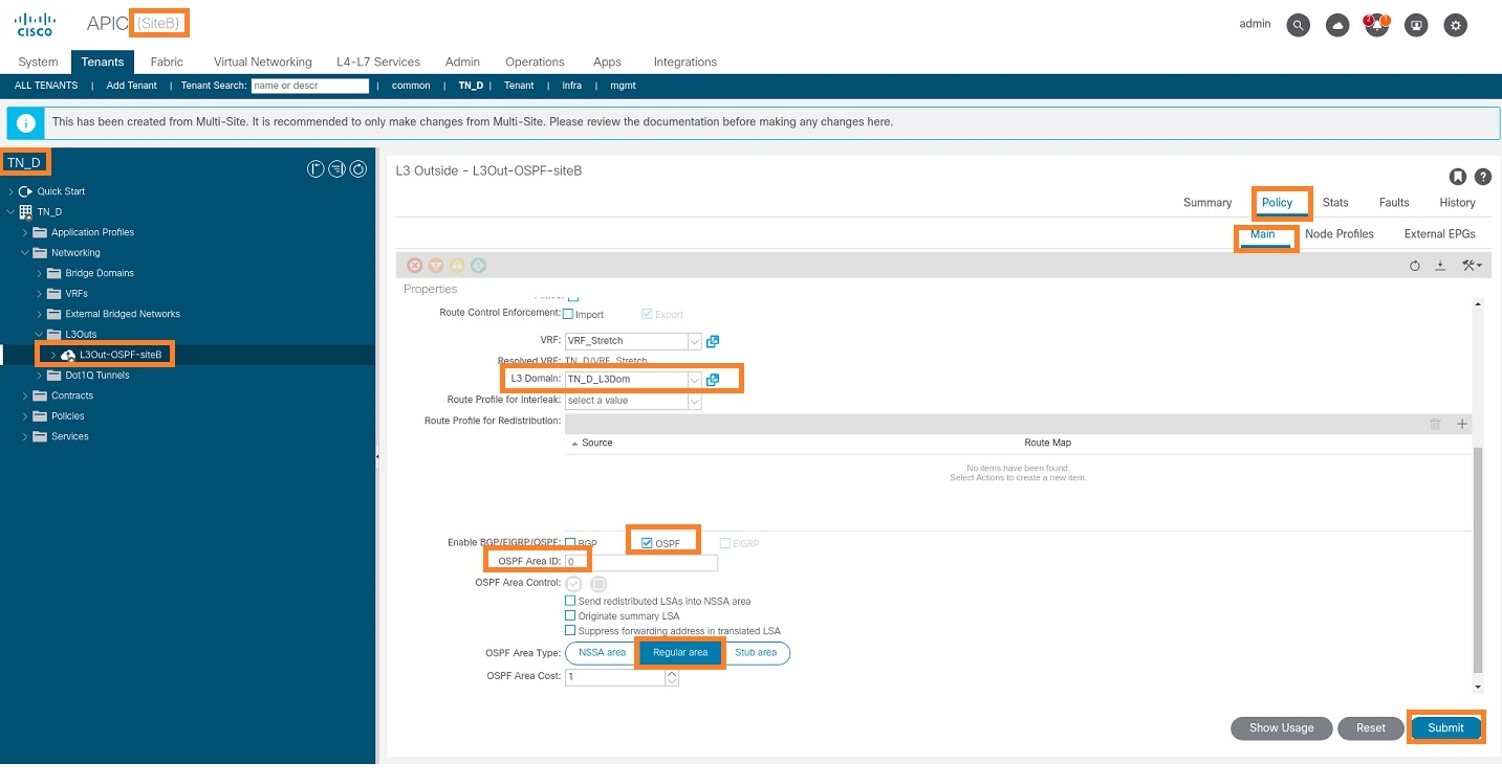

Etapa 3. Adicione o domínio L3, ative o protocolo OSPF e configure o OSPF com a área regular 0.

- No APIC-1 no Site-B, escolha TN_D > Rede > L3out-OSPF-siteB > Política > Principal.

- Na lista suspensa Domínio L3, escolha TN_D_L3Dom.

- Marque a caixa de seleção OSPF para Ativar BGP/EIGRP/OSPF.

- No campo ID da área OSPF, digite 0.

- No Tipo de área OSPF, escolha Área regular.

- Clique em Submit.

Etapa 4. Crie o perfil do nó.

- No APIC-1 no Site-B, escolha TN_D > Rede > L3Outs > L3Out-OSPF-siteB > Perfis de Nó Lógico.

- Clique em Criar perfil de nó.

Etapa 5. Escolha o switch Site2_Leaf1 como um nó no site B.

- No APIC-1 no Site-B, escolha TN_D > Rede > L3Outs > L3Out-OSPF-siteB > Perfis de Nó Lógico > Criar Perfil de Nó.

- No campo Nome, digite Site2_Leaf1.

- Clique no + sinal para adicionar um nó.

- Adicione o pod-2 node-101 com o endereço IP do ID do roteador.

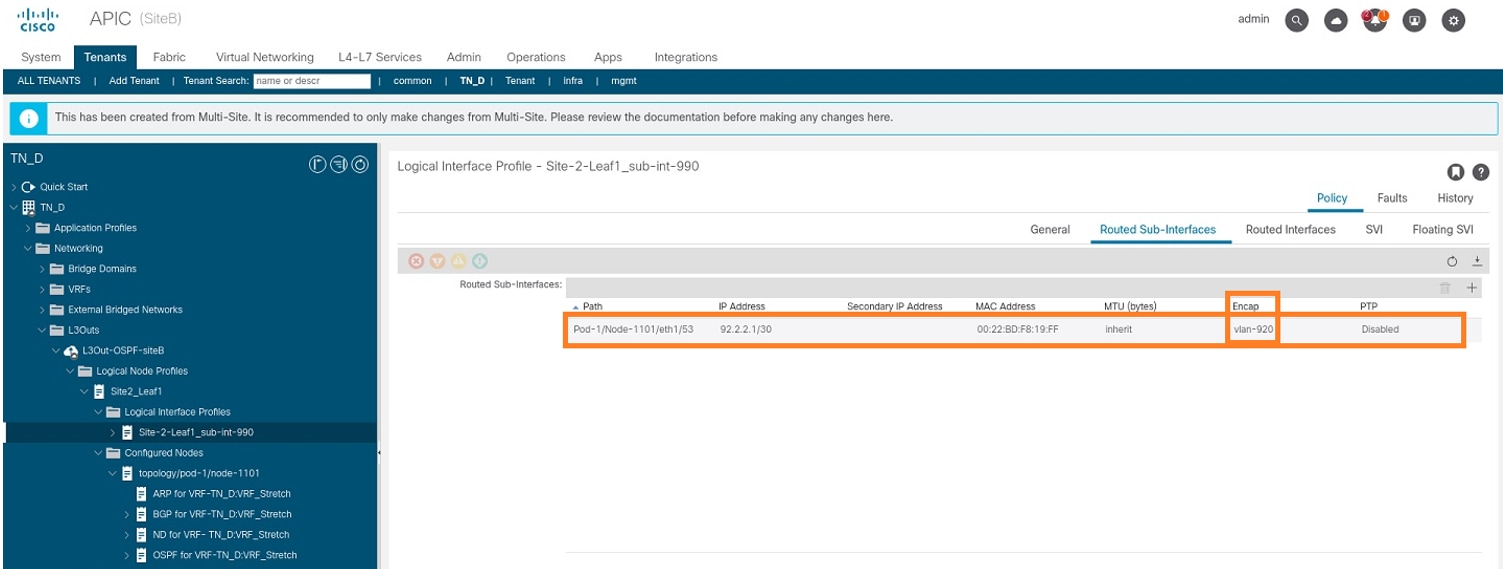

Etapa 6. Adicione o perfil da interface (a VLAN externa é 920 (criação de SVI)).

- No APIC-1 no Site-B, escolha TN_D > Rede > L3Outs > L3out-OSPF-SiteB > Perfis de Interface Lógica.

- Clique com o botão direito do mouse e adicione o perfil da interface.

- Escolha Subinterfaces roteadas.

- Configure o endereço IP, MTU e VLAN-920.

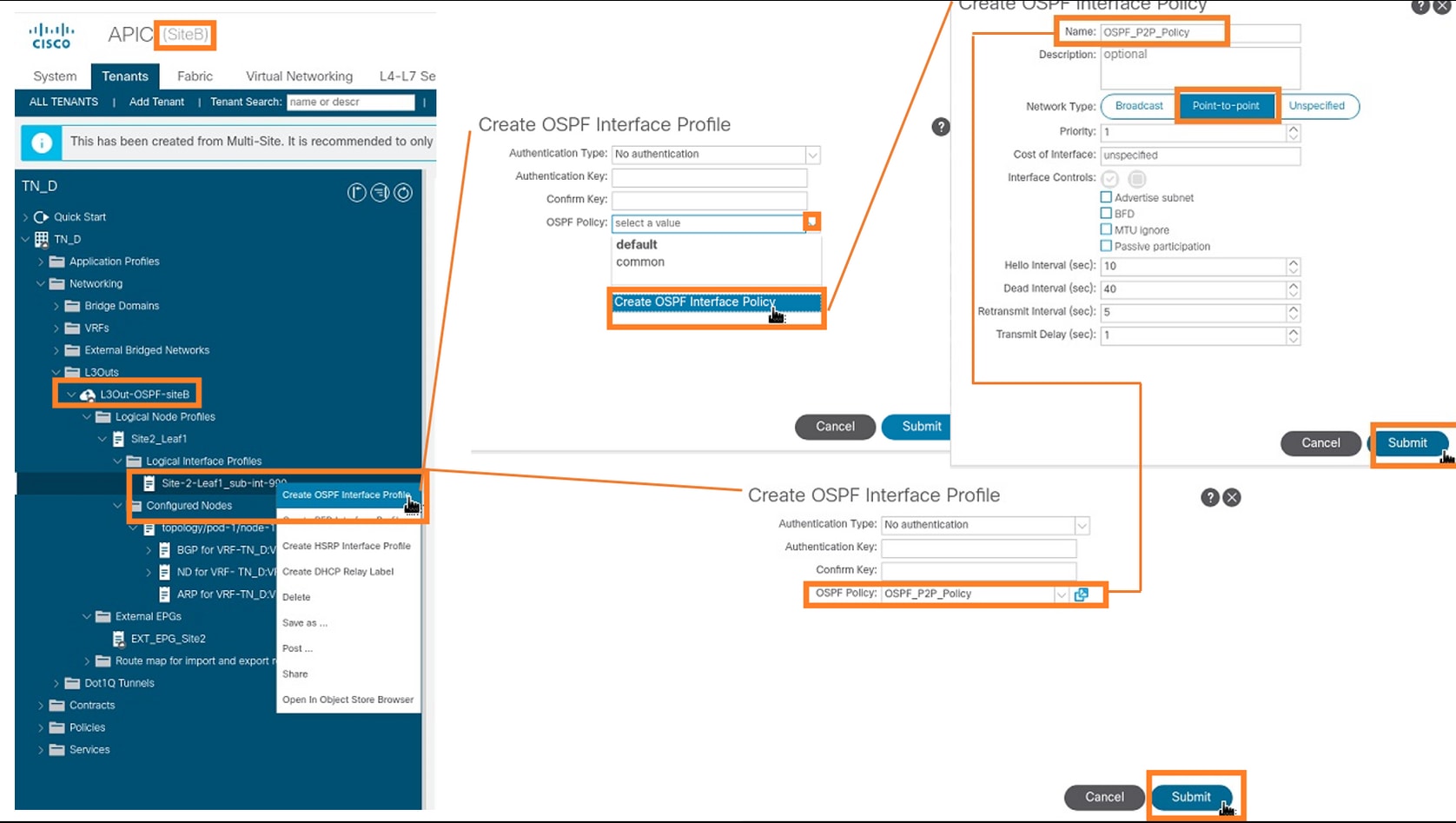

Passo 7. Crie a política OSPF (Rede Ponto a Ponto).

- No APIC-1 no Site-B, escolha TN_D > Rede > L3Outs > L3Out-OSPF-siteB > Perfis de Interface Lógica.

- Clique com o botão direito do mouse e escolha Create OSPF Interface Profile.

- Escolha as opções conforme mostrado na captura de tela e clique em Enviar.

Etapa 8. Verifique a política de perfil da interface OSPF conectada em TN_D > Rede > L3Outs > L3Out-OSPF-siteB > Perfis de Interface Lógica > (perfil de interface) > Perfil de Interface OSPF.

Etapa 9. Verifique se EPG externo "EXT_EPG_Site2" foi criado pelo MSO. No APIC-1 no Site-B, escolha TN_D > L3Outs > L3Out-OSPF-siteB > EPGs externas > EXT_EPG_Site2.

Configurar o N9K externo (Site-B)

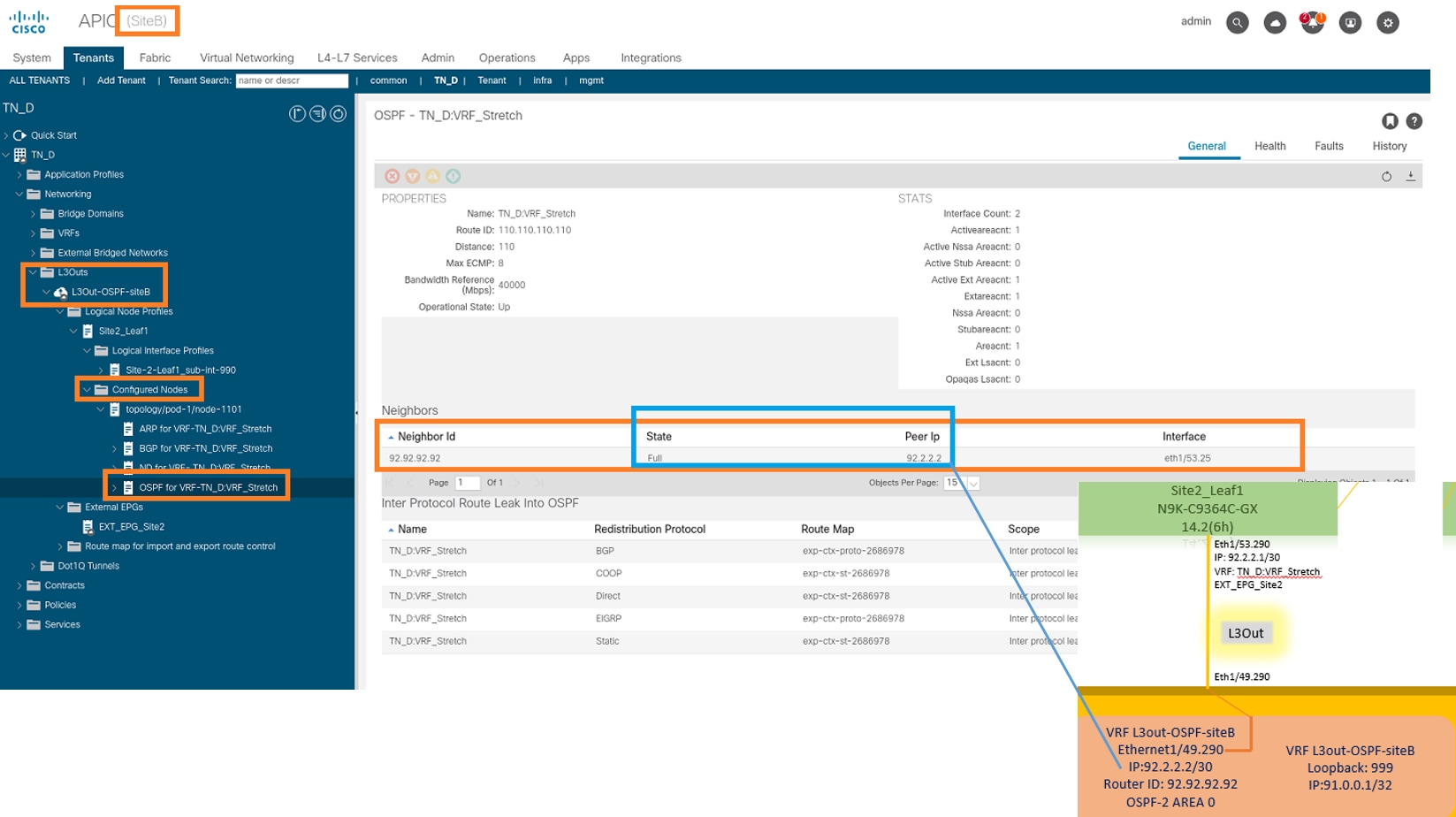

Após a configuração N9K (VRF L3out-OSPF-siteB), podemos ver que a vizinhança do OSPF é estabelecida entre o N9K e o ACI Leaf (no Site-B).

Verifique se a vizinhança do OSPF está estabelecida e UP (Full State).

No APIC-1 no Site-B, escolha TN_D > Rede > L3Outs > L3Out-OSPF-siteB > Perfis de Nó Lógico > Perfis de Interface Lógica > Nós Configurados > topologia/pod01/node-1101 > OSPF para VRF-TN_DVRF_Switch > Estado de Vizinho > Completo.

Você também pode verificar a vizinhança do OSPF em N9K. Além disso, você pode fazer ping no IP leaf da ACI (Site-B).

Neste ponto, a configuração do Host_A no site A e na configuração L3out no site B está completa.

Anexar L3out do Site-B ao Site-A EPG(BD)

Em seguida, você pode anexar o L3out do Site-B ao Site-A BD-990 do MSO. Observe que a coluna do lado esquerdo tem duas seções: 1) Modelo e 2) Sites.

Etapa 1. Na segunda seção Sites, você pode ver o modelo anexado a cada site. Ao anexar L3out a "Modelo do site A", você é basicamente anexado ao modelo já anexado na seção Sites.

No entanto, ao implantar o modelo, implante a partir da seção Modelos > Modelo do site A e escolha salvar/implantar em sites.

Etapa 2. Implante a partir do modelo principal "Modelo do site A" na primeira seção "Modelos".

Configurar o contrato

Você precisa de um contrato entre o EPG externo no site B e o EPG_990 interno no site A. Então, você pode primeiro criar um contrato do MSO e anexá-lo aos dois EPGs.

Cisco Application Centric Infrastructure - O Guia de Contrato da Cisco ACI pode ajudar a entender o contrato. Geralmente, o EPG interno é configurado como um provedor e o EPG externo é configurado como um consumidor.

Crie o contrato

Etapa 1. Em TN_D_Schema, escolha Stretched Template > Contracts. Clique em Adicionar contrato.

Etapa 2. Adicione um filtro para permitir todo o tráfego.

- Em TN_D_Schema, escolha Stretched Template > Contracts.

- Adicionar um contrato com:

- Nome de exibição: Contrato de L3out no local

- Escopo: VRF

Etapa 3.

- Em TN_D_Schema, escolha Stretched Template > Filters.

- No campo Display Name, digite Allow-all-traffic.

- Clique em Adicionar entrada. A caixa de diálogo Adicionar entrada é exibida.

- No campo Nome, digite Any_Traffic.

- Na lista suspensa Tipo de Ether, escolha não especificado para permitir todo o tráfego.

- Click Save.

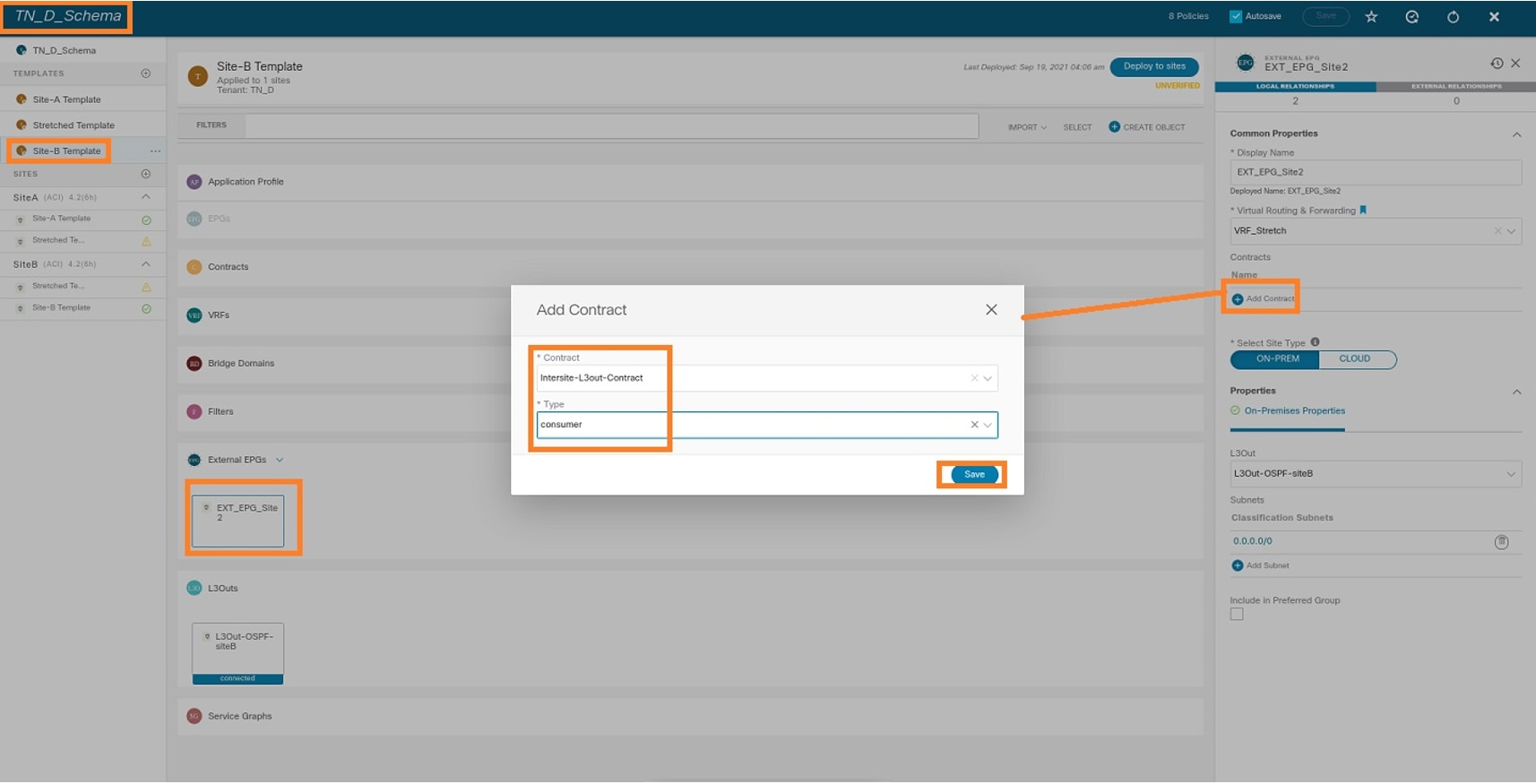

Etapa 4. Adicione o contrato ao EPG externo como "Consumidor" (no Modelo Site-B) (Implante no site).

- Em TN_D_Schema, escolha Site-B Template > EXT_EPG_Site2.

- Clique em Adicionar contrato. A caixa de diálogo Adicionar contrato é exibida.

- No campo Contrato, insira Intersite-L3out-Contract.

- Na lista suspensa Tipo, escolha consumidor.

Etapa 5. Adicione o contrato ao EPG interno "EPG_990" como "Provedor" (no Modelo Site-A) (Implantar no site).

- Em TN_D_Schema, escolha Site-A Template > EPG_990.

- Clique em Adicionar contrato. A caixa de diálogo Adicionar contrato é exibida.

- No campo Contrato, insira Intersite-L3out-Contract.

- Na lista suspensa Tipo, escolha provedor.

Assim que o contrato for adicionado, você poderá ver "Shadow L3out / External EPG" criado no Site A.

Você também pode ver que "Shadow EPG_990 e BD_990" também foram criados no Site-B.

Etapa 6. Insira estes comandos para verificar o APIC do site B.

apic1# moquery -c fvAEPg -f 'fv.AEPg.name=="EPG_990"' Total Objects shown: 1 # fv.AEPg name : EPG_990 annotation : orchestrator:msc childAction : configIssues : configSt : applied descr : dn : uni/tn-TN_D/ap-App_Profile/epg-EPG_990 exceptionTag : extMngdBy : floodOnEncap : disabled fwdCtrl : hasMcastSource : no isAttrBasedEPg : no isSharedSrvMsiteEPg : no lcOwn : local matchT : AtleastOne modTs : 2021-09-19T18:47:53.374+00:00 monPolDn : uni/tn-common/monepg-default nameAlias : pcEnfPref : unenforced pcTag : 49153 <<< Note that pcTag is different for shadow EPG. prefGrMemb : exclude prio : unspecified rn : epg-EPG_990 scope : 2686978 shutdown : no status : triggerSt : triggerable txId : 1152921504609244629 uid : 0

apic1# moquery -c fvBD -f 'fv.BD.name==\"BD_990\"' Total Objects shown: 1 # fv.BD name : BD_990 OptimizeWanBandwidth : yes annotation : orchestrator:msc arpFlood : yes bcastP : 225.0.181.192 childAction : configIssues : descr : dn : uni/tn-TN_D/BD-BD_990 epClear : no epMoveDetectMode : extMngdBy : hostBasedRouting : no intersiteBumTrafficAllow : yes intersiteL2Stretch : yes ipLearning : yes ipv6McastAllow : no lcOwn : local limitIpLearnToSubnets : yes llAddr : :: mac : 00:22:BD:F8:19:FF mcastAllow : no modTs : 2021-09-19T18:47:53.374+00:00 monPolDn : uni/tn-common/monepg-default mtu : inherit multiDstPktAct : bd-flood nameAlias : ownerKey : ownerTag : pcTag : 32771 rn : BD-BD_990 scope : 2686978 seg : 15957972 status : type : regular uid : 0 unicastRoute : yes unkMacUcastAct : proxy unkMcastAct : flood v6unkMcastAct : flood vmac : not-applicable

Passo 7. Revise e verifique a configuração N9K do dispositivo externo.

Verificar

Use esta seção para confirmar se a sua configuração funciona corretamente.

Aprendizado de endpoint

Verifique se o endpoint Site-A foi aprendido como um endpoint no Site1_Leaf1.

Site1_Leaf1# show endpoint interface ethernet 1/5

Legend:

s - arp H - vtep V - vpc-attached p - peer-aged

R - peer-attached-rl B - bounce S - static M - span

D - bounce-to-proxy O - peer-attached a - local-aged m - svc-mgr

L - local E - shared-service

+-----------------------------------+---------------+-----------------+--------------+-------------+

VLAN/ Encap MAC Address MAC Info/ Interface

Domain VLAN IP Address IP Info

+-----------------------------------+---------------+-----------------+--------------+-------------+

18 vlan-990 c014.fe5e.1407 L eth1/5

TN_D:VRF_Stretch vlan-990 90.0.0.10 L eth1/5

Verificação ETEP/RTEP

Leafs Site_A.

Site1_Leaf1# show ip interface brief vrf overlay-1

IP Interface Status for VRF "overlay-1"(4)

Interface Address Interface Status

eth1/49 unassigned protocol-up/link-up/admin-up

eth1/49.7 unnumbered protocol-up/link-up/admin-up

(lo0)

eth1/50 unassigned protocol-up/link-up/admin-up

eth1/50.8 unnumbered protocol-up/link-up/admin-up

(lo0)

eth1/51 unassigned protocol-down/link-down/admin-up

eth1/52 unassigned protocol-down/link-down/admin-up

eth1/53 unassigned protocol-down/link-down/admin-up

eth1/54 unassigned protocol-down/link-down/admin-up

vlan9 10.0.0.30/27 protocol-up/link-up/admin-up

lo0 10.0.80.64/32 protocol-up/link-up/admin-up

lo1 10.0.8.67/32 protocol-up/link-up/admin-up

lo8 192.168.200.225/32 protocol-up/link-up/admin-up <<<<< IP from ETEP site-A

lo1023 10.0.0.32/32 protocol-up/link-up/admin-up

Site2_Leaf1# show ip interface brief vrf overlay-1

IP Interface Status for VRF "overlay-1"(4)

Interface Address Interface Status

eth1/49 unassigned protocol-up/link-up/admin-up

eth1/49.16 unnumbered protocol-up/link-up/admin-up

(lo0)

eth1/50 unassigned protocol-up/link-up/admin-up

eth1/50.17 unnumbered protocol-up/link-up/admin-up

(lo0)

eth1/51 unassigned protocol-down/link-down/admin-up

eth1/52 unassigned protocol-down/link-down/admin-up

eth1/54 unassigned protocol-down/link-down/admin-up

eth1/55 unassigned protocol-down/link-down/admin-up

eth1/56 unassigned protocol-down/link-down/admin-up

eth1/57 unassigned protocol-down/link-down/admin-up

eth1/58 unassigned protocol-down/link-down/admin-up

eth1/59 unassigned protocol-down/link-down/admin-up

eth1/60 unassigned protocol-down/link-down/admin-up

eth1/61 unassigned protocol-down/link-down/admin-up

eth1/62 unassigned protocol-down/link-down/admin-up

eth1/63 unassigned protocol-down/link-down/admin-up

eth1/64 unassigned protocol-down/link-down/admin-up

vlan18 10.0.0.30/27 protocol-up/link-up/admin-up

lo0 10.0.72.64/32 protocol-up/link-up/admin-up

lo1 10.0.80.67/32 protocol-up/link-up/admin-up

lo6 192.168.100.225/32 protocol-up/link-up/admin-up <<<<< IP from ETEP site-B

lo1023 10.0.0.32/32 protocol-up/link-up/admin-up

Alcançabilidade de ICMP

Faça ping no endereço IP da WAN do dispositivo externo do HOST_A.

Faça ping no endereço de loopback do dispositivo externo.

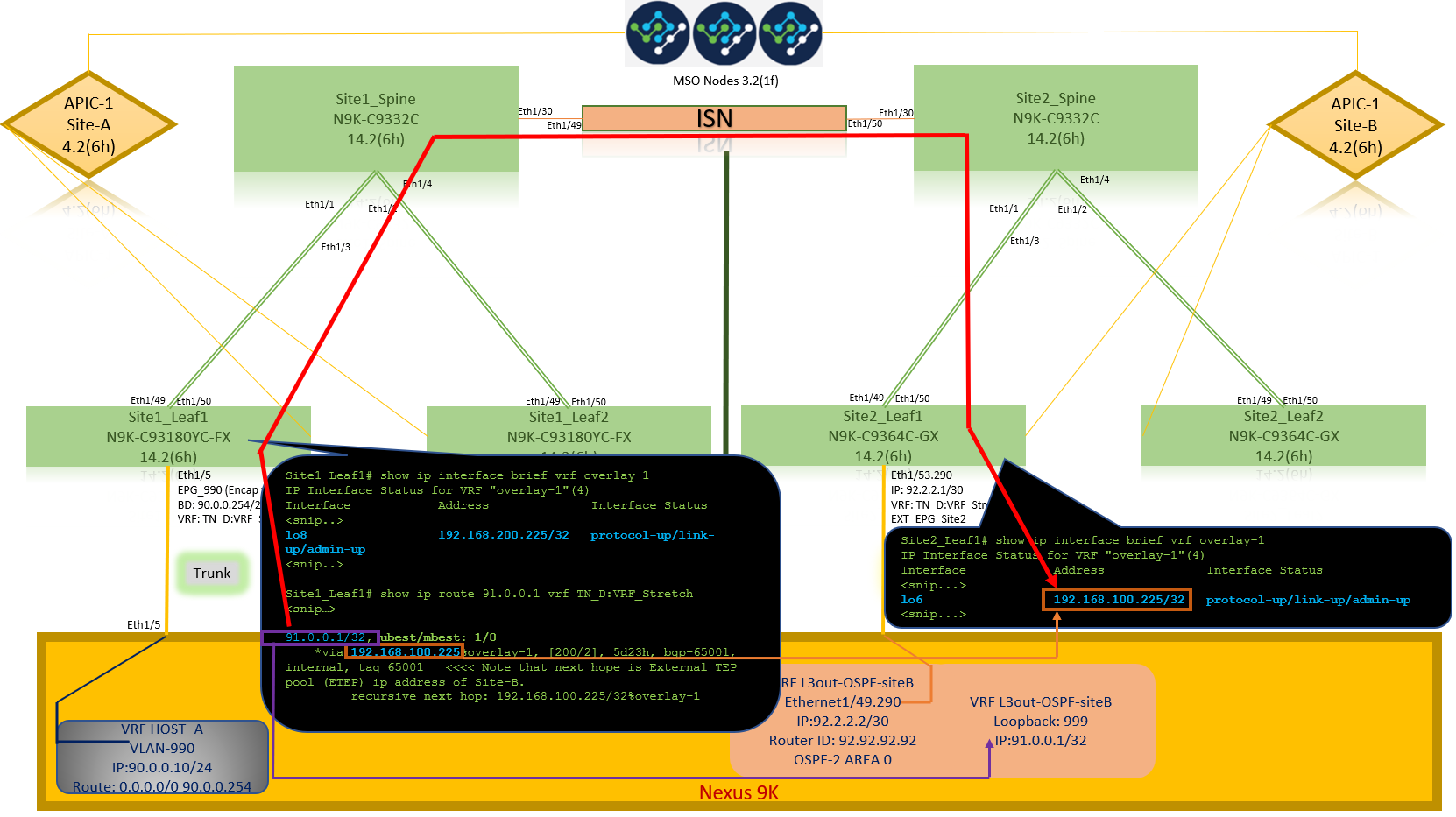

Verificação de rota

Verifique se o endereço IP da WAN do dispositivo externo OU a rota de sub-rede de loopback está presente na tabela de roteamento. Quando você verifica o próximo salto para a sub-rede do dispositivo externo em "Site1_Leaf1", é o IP TEP Externo da Folha "Site2-Leaf1".

Site1_Leaf1# show ip route 92.2.2.2 vrf TN_D:VRF_Stretch

IP Route Table for VRF "TN_D:VRF_Stretch"

'*' denotes best ucast next-hop

'**' denotes best mcast next-hop

'[x/y]' denotes [preference/metric]

'%' in via output denotes VRF

92.2.2.0/30, ubest/mbest: 1/0

*via 192.168.100.225%overlay-1, [200/0], 5d23h, bgp-65001, internal, tag 65001 <<<< Note that next hope is External TEP pool (ETEP) ip address of Site-B.

recursive next hop: 192.168.100.225/32%overlay-1

Site1_Leaf1# show ip route 91.0.0.1 vrf TN_D:VRF_Stretch

IP Route Table for VRF "TN_D:VRF_Stretch"

'*' denotes best ucast next-hop

'**' denotes best mcast next-hop

'[x/y]' denotes [preference/metric]

'%' in via output denotes VRF

91.0.0.1/32, ubest/mbest: 1/0

*via 192.168.100.225%overlay-1, [200/2], 5d23h, bgp-65001, internal, tag 65001 <<<< Note that next hope is External TEP pool (ETEP) ip address of Site-B.

recursive next hop: 192.168.100.225/32%overlay-1

Troubleshoot

Esta seção fornece informações que podem ser usadas para o troubleshooting da sua configuração.

Site2_Folha1

Importação/exportação de rota da família de endereços BGP entre TN_D:VRF_estich e Overlay-1.

Site2_Leaf1# show system internal epm vrf TN_D:VRF_Stretch

+--------------------------------+--------+----------+----------+------+--------

VRF Type VRF vnid Context ID Status Endpoint

Count

+--------------------------------+--------+----------+----------+------+--------

TN_D:VRF_Stretch Tenant 2686978 46 Up 1

Site2_Leaf1# show vrf TN_D:VRF_Stretch detail

VRF-Name: TN_D:VRF_Stretch, VRF-ID: 46, State: Up

VPNID: unknown

RD: 1101:2686978

Max Routes: 0 Mid-Threshold: 0

Table-ID: 0x8000002e, AF: IPv6, Fwd-ID: 0x8000002e, State: Up

Table-ID: 0x0000002e, AF: IPv4, Fwd-ID: 0x0000002e, State: Up

Site2_Leaf1# vsh

Site2_Leaf1# show bgp vpnv4 unicast 91.0.0.1 vrf TN_D:VRF_Stretch BGP routing table information for VRF overlay-1, address family VPNv4 Unicast Route Distinguisher: 1101:2686978 (VRF TN_D:VRF_Stretch) BGP routing table entry for 91.0.0.1/32, version 12 dest ptr 0xae6da350 Paths: (1 available, best #1) Flags: (0x80c0002 00000000) on xmit-list, is not in urib, exported vpn: version 346, (0x100002) on xmit-list Multipath: eBGP iBGP Advertised path-id 1, VPN AF advertised path-id 1 Path type: redist 0x408 0x1 ref 0 adv path ref 2, path is valid, is best path AS-Path: NONE, path locally originated 0.0.0.0 (metric 0) from 0.0.0.0 (10.0.72.64) Origin incomplete, MED 2, localpref 100, weight 32768 Extcommunity: RT:65001:2686978 VNID:2686978 COST:pre-bestpath:162:110 VRF advertise information: Path-id 1 not advertised to any peer VPN AF advertise information: Path-id 1 advertised to peers: 10.0.72.65 <<

Site-B

apic1# acidiag fnvread ID Pod ID Name Serial Number IP Address Role State LastUpdMsgId -------------------------------------------------------------------------------------------------------------- 101 1 Site2_Spine FDO243207JH 10.0.72.65/32 spine active 0 102 1 Site2_Leaf2 FDO24260FCH 10.0.72.66/32 leaf active 0 1101 1 Site2_Leaf1 FDO24260ECW 10.0.72.64/32 leaf active 0

Site2_Spine

Site2_Spine# vsh

Site2_Spine# show bgp vpnv4 unicast 91.0.0.1 vrf overlay-1 BGP routing table information for VRF overlay-1, address family VPNv4 Unicast <---------26bits---------> Route Distinguisher: 1101:2686978 <<<<<2686978 <--Binary--> 00001010010000000000000010 BGP routing table entry for 91.0.0.1/32, version 717 dest ptr 0xae643d0c Paths: (1 available, best #1) Flags: (0x000002 00000000) on xmit-list, is not in urib, is not in HW Multipath: eBGP iBGP Advertised path-id 1 Path type: internal 0x40000018 0x800040 ref 0 adv path ref 1, path is valid, is best path AS-Path: NONE, path sourced internal to AS 10.0.72.64 (metric 2) from 10.0.72.64 (10.0.72.64) <<< Site2_leaf1 IP Origin incomplete, MED 2, localpref 100, weight 0 Received label 0 Received path-id 1 Extcommunity: RT:65001:2686978 COST:pre-bestpath:168:3221225472 VNID:2686978 COST:pre-bestpath:162:110 Path-id 1 advertised to peers: 192.168.10.13 <<<< Site1_Spine mscp-etep IP.

Site1_Spine# show ip interface vrf overlay-1 <snip...>

lo12, Interface status: protocol-up/link-up/admin-up, iod: 89, mode: mscp-etep IP address: 192.168.10.13, IP subnet: 192.168.10.13/32 <<IP broadcast address: 255.255.255.255 IP primary address route-preference: 0, tag: 0

<snip...>

Site1_Spine

Site1_Spine# vsh

Site1_Spine# show bgp vpnv4 unicast 91.0.0.1 vrf overlay-1

BGP routing table information for VRF overlay-1, address family VPNv4 Unicast <---------26Bits-------->

Route Distinguisher: 1101:36241410 <<<<<36241410<--binary-->10001010010000000000000010

BGP routing table entry for 91.0.0.1/32, version 533 dest ptr 0xae643dd4

Paths: (1 available, best #1)

Flags: (0x000002 00000000) on xmit-list, is not in urib, is not in HW

Multipath: eBGP iBGP

Advertised path-id 1

Path type: internal 0x40000018 0x880000 ref 0 adv path ref 1, path is valid, is best path, remote site path

AS-Path: NONE, path sourced internal to AS

192.168.100.225 (metric 20) from 192.168.11.13 (192.168.11.13) <<< Site2_Leaf1 ETEP IP learn via Site2_Spine mcsp-etep address.

Origin incomplete, MED 2, localpref 100, weight 0

Received label 0

Extcommunity:

RT:65001:36241410

SOO:65001:50331631

COST:pre-bestpath:166:2684354560

COST:pre-bestpath:168:3221225472

VNID:2686978

COST:pre-bestpath:162:110

Originator: 10.0.72.64 Cluster list: 192.168.11.13 <<< Originator Site2_Leaf1 and Site2_Spine ips are listed here...

Path-id 1 advertised to peers:

10.0.80.64 <<<< Site1_Leaf1 ip

Site2_Spine# show ip interface vrf overlay-1

<snip..>

lo13, Interface status: protocol-up/link-up/admin-up, iod: 92, mode: mscp-etep

IP address: 192.168.11.13, IP subnet: 192.168.11.13/32

IP broadcast address: 255.255.255.255

IP primary address route-preference: 0, tag: 0

<snip..>

Site-B

apic1# acidiag fnvread

ID Pod ID Name Serial Number IP Address Role State LastUpdMsgId

--------------------------------------------------------------------------------------------------------------

101 1 Site2_Spine FDO243207JH 10.0.72.65/32 spine active 0

102 1 Site2_Leaf2 FDO24260FCH 10.0.72.66/32 leaf active 0

1101 1 Site2_Leaf1 FDO24260ECW 10.0.72.64/32 leaf active 0

Verifique o sinalizador entre sites.

Site1_Spine# moquery -c bgpPeer -f 'bgp.Peer.addr*"192.168.11.13"'

Total Objects shown: 1

# bgp.Peer

addr : 192.168.11.13/32

activePfxPeers : 0

adminSt : enabled

asn : 65001

bgpCfgFailedBmp :

bgpCfgFailedTs : 00:00:00:00.000

bgpCfgState : 0

childAction :

ctrl :

curPfxPeers : 0

dn : sys/bgp/inst/dom-overlay-1/peer-[192.168.11.13/32]

lcOwn : local

maxCurPeers : 0

maxPfxPeers : 0

modTs : 2021-09-13T11:58:26.395+00:00

monPolDn :

name :

passwdSet : disabled

password :

peerRole : msite-speaker

privateASctrl :

rn : peer-[192.168.11.13/32] <<

srcIf : lo12 status : totalPfxPeers : 0 ttl : 16 type : inter-site

<<

Entender a entrada do Distinguisher de Rota

Quando o flag entre sites é definido, o spine do site local pode definir o id do site local no destino da rota iniciando no 25º bit. Quando o Site1 obtém o caminho BGP com esse bit definido no RT, ele sabe que esse é um caminho de local remoto.

Site2_Leaf1# vsh

Site2_Leaf1# show bgp vpnv4 unicast 91.0.0.1 vrf TN_D:VRF_Stretch

BGP routing table information for VRF overlay-1, address family VPNv4 Unicast <---------26Bits-------->

Route Distinguisher: 1101:2686978 (VRF TN_D:VRF_Stretch) <<<<<2686978 <--Binary--> 00001010010000000000000010

BGP routing table entry for 91.0.0.1/32, version 12 dest ptr 0xae6da350

Site1_Spine# vsh

Site1_Spine# show bgp vpnv4 unicast 91.0.0.1 vrf overlay-1

<---------26Bits-------->

Route Distinguisher: 1101:36241410 <<<<<36241410<--binary-->10001010010000000000000010

^^---26th bit set to 1 and with 25th bit value it become 10.

Observe que o valor binário de RT é exatamente o mesmo para Site1, exceto pelo 26º bit definido como 1. Tem um valor decimal (marcado como azul). 1101:36241410 é o que você pode esperar ver no Site1 e o que a folha interna no Site1 deve ser importada.

Site1_Folha1

Site1_Leaf1# show vrf TN_D:VRF_Stretch detail

VRF-Name: TN_D:VRF_Stretch, VRF-ID: 46, State: Up

VPNID: unknown

RD: 1101:2850817

Max Routes: 0 Mid-Threshold: 0

Table-ID: 0x8000002e, AF: IPv6, Fwd-ID: 0x8000002e, State: Up

Table-ID: 0x0000002e, AF: IPv4, Fwd-ID: 0x0000002e, State: Up

Site1_Leaf1# show bgp vpnv4 unicast 91.0.0.1 vrf overlay-1 BGP routing table information for VRF overlay-1, address family VPNv4 Unicast Route Distinguisher: 1101:2850817 (VRF TN_D:VRF_Stretch) BGP routing table entry for 91.0.0.1/32, version 17 dest ptr 0xadeda550 Paths: (1 available, best #1) Flags: (0x08001a 00000000) on xmit-list, is in urib, is best urib route, is in HW vpn: version 357, (0x100002) on xmit-list Multipath: eBGP iBGP Advertised path-id 1, VPN AF advertised path-id 1 Path type: internal 0xc0000018 0x80040 ref 56506 adv path ref 2, path is valid, is best path, remote site path Imported from 1101:36241410:91.0.0.1/32 AS-Path: NONE, path sourced internal to AS 192.168.100.225 (metric 64) from 10.0.80.65 (192.168.10.13) Origin incomplete, MED 2, localpref 100, weight 0 Received label 0 Received path-id 1 Extcommunity: RT:65001:36241410 SOO:65001:50331631 COST:pre-bestpath:166:2684354560 COST:pre-bestpath:168:3221225472 VNID:2686978 COST:pre-bestpath:162:110 Originator: 10.0.72.64 Cluster list: 192.168.10.13192.168.11.13 <<<< '10.0.72.64'='Site2_Leaf1' , '192.168.10.13'='Site1_Spine' , '192.168.11.13'='Site2_Spine' VRF advertise information: Path-id 1 not advertised to any peer VPN AF advertise information: Path-id 1 not advertised to any peer <snip..>

Site1_Leaf1# show bgp vpnv4 unicast 91.0.0.1 vrf TN_D:VRF_Stretch BGP routing table information for VRF overlay-1, address family VPNv4 Unicast Route Distinguisher: 1101:2850817 (VRF TN_D:VRF_Stretch) BGP routing table entry for 91.0.0.1/32, version 17 dest ptr 0xadeda550 Paths: (1 available, best #1) Flags: (0x08001a 00000000) on xmit-list, is in urib, is best urib route, is in HW vpn: version 357, (0x100002) on xmit-listMultipath: eBGP iBGP Advertised path-id 1, VPN AF advertised path-id 1 Path type: internal 0xc0000018 0x80040 ref 56506 adv path ref 2, path is valid, is best path, remote site path Imported from 1101:36241410:91.0.0.1/32 AS-Path: NONE, path sourced internal to AS 192.168.100.225 (metric 64) from 10.0.80.65 (192.168.10.13) Origin incomplete, MED 2, localpref 100, weight 0 Received label 0 Received path-id 1 Extcommunity: RT:65001:36241410 SOO:65001:50331631 COST:pre-bestpath:166:2684354560 COST:pre-bestpath:168:3221225472 VNID:2686978 COST:pre-bestpath:162:110 Originator: 10.0.72.64 Cluster list: 192.168.10.13 192.168.11.13 VRF advertise information: Path-id 1 not advertised to any peer VPN AF advertise information: Path-id 1 not advertised to any peer

Portanto, "Site1_Leaf1" tem uma entrada de rota para a sub-rede 91.0.0.1/32 com o endereço ETEP do próximo salto "Site2_Leaf1" 192.168.100.225.

Site1_Leaf1# show ip route 91.0.0.1 vrf TN_D:VRF_Stretch

IP Route Table for VRF "TN_D:VRF_Stretch"

'*' denotes best ucast next-hop

'**' denotes best mcast next-hop

'[x/y]' denotes [preference/metric]

'%' in via output denotes VRF

91.0.0.1/32, ubest/mbest: 1/0

*via 192.168.100.225%overlay-1, [200/2], 5d23h, bgp-65001, internal, tag 65001 <<<< Note that next hope is External TEP pool (ETEP) ip address of Site-B.

recursive next hop: 192.168.100.225/32%overlay-1

Site-A Spine não adiciona o mapa de rota ao endereço IP do vizinho BGP de "Site2_Spine" mcsp-ETEP.

Se você pensar nos fluxos de tráfego, quando o endpoint Site-A se comunica com o endereço IP externo, o pacote pode ser encapsulado com a origem como endereço TEP "Site1_Leaf1" e o destino é o endereço ETEP do endereço IP "Site2_Leaf" 192.168.100.225.

Verificar ELAM (Site1_Spine)

Site1_Spine# vsh_lc module-1# debug platform internal roc elam asic 0 module-1(DBG-elam)# trigger reset module-1(DBG-elam)# trigger init in-select 14 out-select 1 module-1(DBG-elam-insel14)# set inner ipv4 src_ip 90.0.0.10 dst_ip 91.0.0.1 next-protocol 1 module-1(DBG-elam-insel14)# start module-1(DBG-elam-insel14)# status ELAM STATUS =========== Asic 0 Slice 0 Status Armed Asic 0 Slice 1 Status Armed Asic 0 Slice 2 Status Armed Asic 0 Slice 3 Status Armed

pod2-n9k# ping 91.0.0.1 vrf HOST_A source 90.0.0.10 PING 91.0.0.1 (91.0.0.1) from 90.0.0.10: 56 data bytes 64 bytes from 91.0.0.1: icmp_seq=0 ttl=252 time=1.015 ms 64 bytes from 91.0.0.1: icmp_seq=1 ttl=252 time=0.852 ms 64 bytes from 91.0.0.1: icmp_seq=2 ttl=252 time=0.859 ms 64 bytes from 91.0.0.1: icmp_seq=3 ttl=252 time=0.818 ms 64 bytes from 91.0.0.1: icmp_seq=4 ttl=252 time=0.778 ms --- 91.0.0.1 ping statistics --- 5 packets transmitted, 5 packets received, 0.00% packet loss round-trip min/avg/max = 0.778/0.864/1.015 ms

Site1_Spine ELAM é acionado. O relatório confirma que o pacote é encapsulado com um endereço TEP do endereço IP e destino do TEP Folha do Site A em direção ao endereço ETEP do Site2_Leaf1.

module-1(DBG-elam-insel14)# status ELAM STATUS =========== Asic 0 Slice 0 Status Armed Asic 0 Slice 1 Status Armed Asic 0 Slice 2 Status Triggered Asic 0 Slice 3 Status Armed module-1(DBG-elam-insel14)# ereport Python available. Continue ELAM decode with LC Pkg ELAM REPORT ------------------------------------------------------------------------------------------------------------------------------------------------------ Outer L3 Header ------------------------------------------------------------------------------------------------------------------------------------------------------ L3 Type : IPv4 DSCP : 0 Don't Fragment Bit : 0x0 TTL : 32 IP Protocol Number : UDP Destination IP : 192.168.100.225 <<<'Site2_Leaf1' ETEP address Source IP : 10.0.80.64 <<<'Site1_Leaf1' TEP address ------------------------------------------------------------------------------------------------------------------------------------------------------ Inner L3 Header ------------------------------------------------------------------------------------------------------------------------------------------------------ L3 Type : IPv4 DSCP : 0 Don't Fragment Bit : 0x0 TTL : 254 IP Protocol Number : ICMP Destination IP : 91.0.0.1 Source IP : 90.0.0.10

Site1_Spine Verificar mapa de rota

Quando a coluna do site A recebe um pacote, ela pode redirecionar para o endereço ETEP "Site2_Leaf1" em vez de procurar a entrada de coop ou rota. (Quando você tem L3out entre locais no Site-B, a coluna Site-A cria um mapa de rota chamado "infra-inter-site-l3out" para redirecionar o tráfego para ETEP de Site2_Leaf1 e sair de L3out.)

Site1_Spine# show bgp vpnv4 unicast neighbors 192.168.11.13 vrf overlay-1

BGP neighbor is 192.168.11.13, remote AS 65001, ibgp link, Peer index 4

BGP version 4, remote router ID 192.168.11.13

BGP state = Established, up for 10w4d

Using loopback12 as update source for this peer

Last read 00:00:03, hold time = 180, keepalive interval is 60 seconds

Last written 00:00:03, keepalive timer expiry due 00:00:56

Received 109631 messages, 0 notifications, 0 bytes in queue

Sent 109278 messages, 0 notifications, 0 bytes in queue

Connections established 1, dropped 0

Last reset by us never, due to No error

Last reset by peer never, due to No error

Neighbor capabilities:

Dynamic capability: advertised (mp, refresh, gr) received (mp, refresh, gr)

Dynamic capability (old): advertised received

Route refresh capability (new): advertised received

Route refresh capability (old): advertised received

4-Byte AS capability: advertised received

Address family VPNv4 Unicast: advertised received

Address family VPNv6 Unicast: advertised received

Address family L2VPN EVPN: advertised received

Graceful Restart capability: advertised (GR helper) received (GR helper)

Graceful Restart Parameters:

Address families advertised to peer:

Address families received from peer:

Forwarding state preserved by peer for:

Restart time advertised by peer: 0 seconds

Additional Paths capability: advertised received

Additional Paths Capability Parameters:

Send capability advertised to Peer for AF:

L2VPN EVPN

Receive capability advertised to Peer for AF:

L2VPN EVPN

Send capability received from Peer for AF:

L2VPN EVPN

Receive capability received from Peer for AF:

L2VPN EVPN

Additional Paths Capability Parameters for next session:

[E] - Enable [D] - Disable

Send Capability state for AF:

VPNv4 Unicast[E] VPNv6 Unicast[E]

Receive Capability state for AF:

VPNv4 Unicast[E] VPNv6 Unicast[E]

Extended Next Hop Encoding Capability: advertised received

Receive IPv6 next hop encoding Capability for AF:

IPv4 Unicast

Message statistics:

Sent Rcvd

Opens: 1 1

Notifications: 0 0

Updates: 1960 2317

Keepalives: 107108 107088

Route Refresh: 105 123

Capability: 104 102

Total: 109278 109631

Total bytes: 2230365 2260031

Bytes in queue: 0 0

For address family: VPNv4 Unicast

BGP table version 533, neighbor version 533

3 accepted paths consume 360 bytes of memory

3 sent paths

0 denied paths

Community attribute sent to this neighbor

Extended community attribute sent to this neighbor

Third-party Nexthop will not be computed.

Outbound route-map configured is infra-intersite-l3out, handle obtained <<<< route-map to redirect traffic from Site-A to Site-B 'Site2_Leaf1' L3out

For address family: VPNv6 Unicast

BGP table version 241, neighbor version 241

0 accepted paths consume 0 bytes of memory

0 sent paths

0 denied paths

Community attribute sent to this neighbor

Extended community attribute sent to this neighbor

Third-party Nexthop will not be computed.

Outbound route-map configured is infra-intersite-l3out, handle obtained

<snip...>

Site1_Spine# show route-map infra-intersite-l3out

route-map infra-intersite-l3out, permit, sequence 1

Match clauses:

ip next-hop prefix-lists: IPv4-Node-entry-102

ipv6 next-hop prefix-lists: IPv6-Node-entry-102

Set clauses:

ip next-hop 192.168.200.226

route-map infra-intersite-l3out, permit, sequence 2 <<<< This route-map match if destination IP of packet 'Site1_Spine' TEP address then send to 'Site2_Leaf1' ETEP address.

Match clauses:

ip next-hop prefix-lists: IPv4-Node-entry-1101

ipv6 next-hop prefix-lists: IPv6-Node-entry-1101

Set clauses:

ip next-hop 192.168.200.225

route-map infra-intersite-l3out, deny, sequence 999

Match clauses:

ip next-hop prefix-lists: infra_prefix_local_pteps_inexact

Set clauses:

route-map infra-intersite-l3out, permit, sequence 1000

Match clauses:

Set clauses:

ip next-hop unchanged

Site1_Spine# show ip prefix-list IPv4-Node-entry-1101

ip prefix-list IPv4-Node-entry-1101: 1 entries

seq 1 permit 10.0.80.64/32 <<

Site1_Spine# show ip prefix-list IPv4-Node-entry-102 ip prefix-list IPv4-Node-entry-102: 1 entries seq 1 permit 10.0.80.66/32 Site1_Spine# show ip prefix-list infra_prefix_local_pteps_inexact ip prefix-list infra_prefix_local_pteps_inexact: 1 entries seq 1 permit 10.0.0.0/16 le 32

Histórico de revisões

| Revisão | Data de publicação | Comentários |

|---|---|---|

1.0 |

09-Dec-2021 |

Versão inicial |

Colaborado por engenheiros da Cisco

- Darshankumar MistryCisco TAC Engineer

Contate a Cisco

- Abrir um caso de suporte

- (É necessário um Contrato de Serviço da Cisco)

Feedback

Feedback