新機能および変更された機能に関する情報

次の表は、この最新リリースまでの主な変更点の概要を示したものです。ただし、今リリースまでの変更点や新機能の一部は表に記載されていません。

|

Cisco APIC のリリース バージョン |

特長 |

|---|---|

|

6.0(2) |

VMware vCenter を使用した仮想 APIC の展開のサポート。 |

|

6.1(1) |

ESXi ホストをホストするさまざまな仮想マシン仕様にサポートが拡張されました。 |

概要

Cisco APIC リリース 6.0(2)以降では、クラスタ内のすべての APIC が仮想 APIC であるクラスタを展開できます。CloudFormation テンプレートを使用して AWS に仮想 APIC を展開するか、VMware Center の OVF テンプレートを使用して ESXi ホストに仮想 APIC を展開できます。仮想 APIC は、お客様のオンプレミスの既存のサーバーに展開できます。

このドキュメントでは、ESXi を使用した仮想 APIC の展開について詳しく説明します。 AWS を使用した仮想 APIC の展開の詳細については、AWS を使用した Cisco 仮想 APIC の展開ドキュメントを参照してください。

展開モード

2 つの展開モードがサポートされています。

-

レイヤ 2:仮想 APIC が展開されている ESXi ホストが、ACI ファブリックのリーフ スイッチに直接接続されます。APIC をホストする ESXi ホストは、LACP ポート チャネルを使用して、アクティブ/スタンバイ アップリンクまたはアクティブ/アクティブ アップリンクを使用して ACI リーフ スイッチに接続できます。

-

レイヤ 3:仮想 APIC が展開されている ESXi ホストは、外部ネットワークを介して ACI ファブリックにリモート接続されます。

ESXi ホストが ACI ファブリックに直接接続されている

このモードは、レイヤ 2 接続と呼ばれ、ESXi ホストが ACI ファブリックのリーフ スイッチに直接接続されます。レイヤ 2 モードで APIC をホストしている ESXi ホストは、アクティブ/アクティブ モードまたはアクティブ/スタンバイ モードで接続できます。ただし、APIC 1 をホストしている ESXi ホストは、アクティブ/スタンバイ モードのみを使用する必要があります。

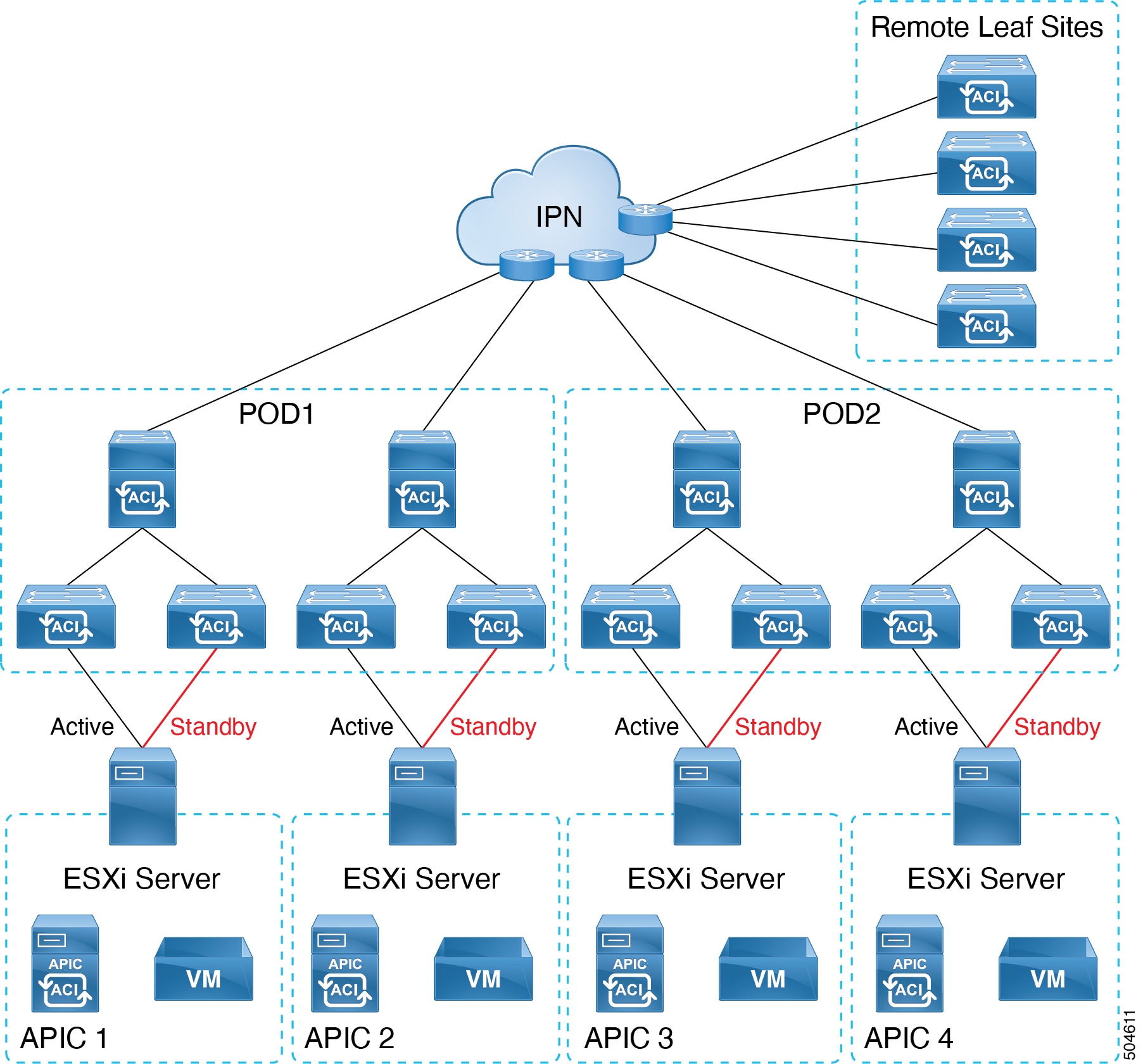

アクティブ/スタンバイ ESXi アップリンクを備えた仮想 APIC

次の図に示すように、APIC VM は、ACI ファブリックのリーフ スイッチに直接接続されている ESXi ホストでホストされます。リーフ スイッチに接続されている ESXi ホスト アップリンクの 1 つがアクティブ モードで、もう 1 つがスタンバイ モードです。

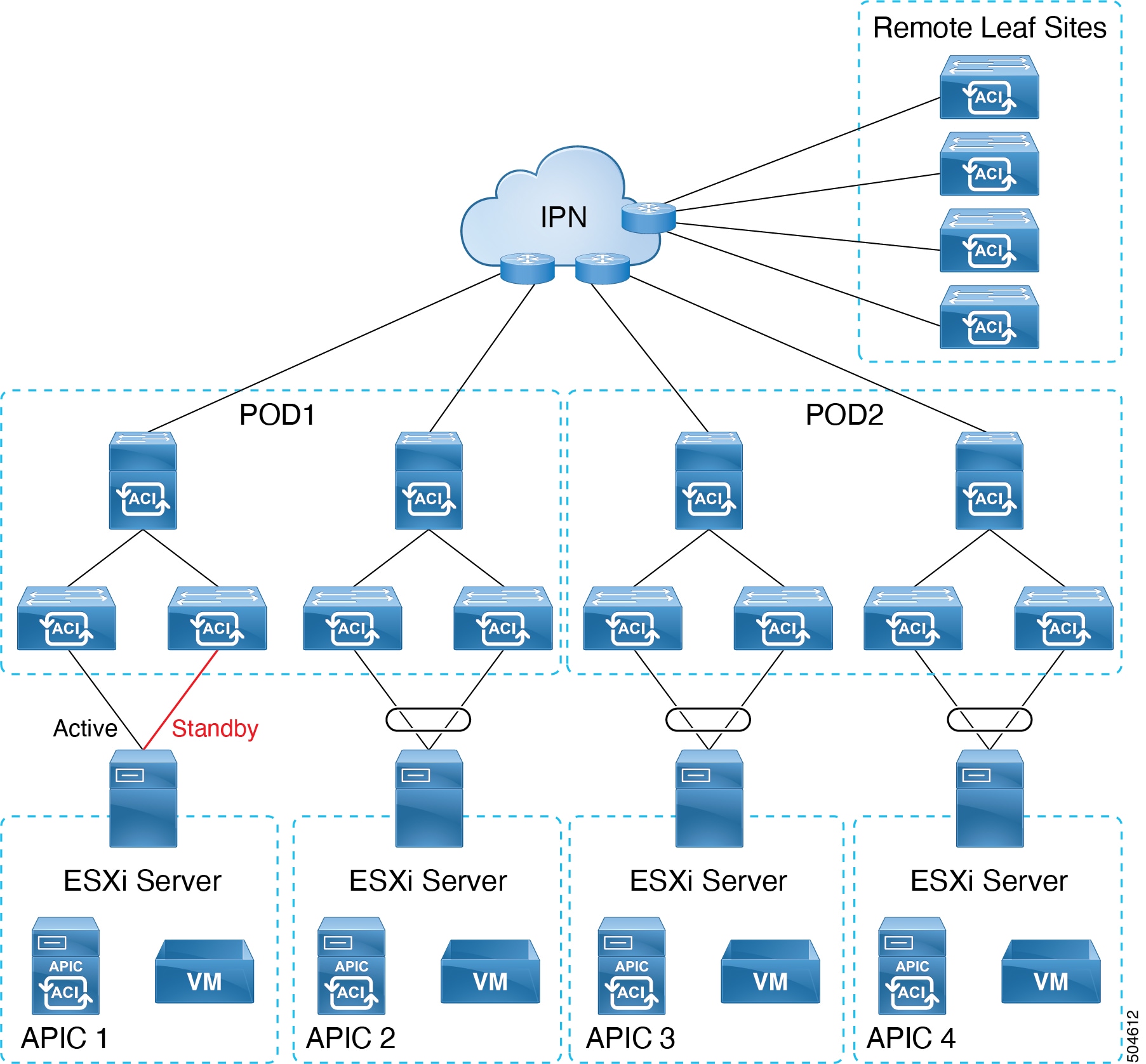

アクティブ/アクティブ ESXi アップリンクを備えた仮想 APIC

次の図に示すように、APIC VM は、ACI ファブリックのリーフ スイッチに直接接続されている ESXi ホストでホストされます。ESXi ホストの両方のアップリンクは、LACP ポート チャネルとしてリーフ スイッチに接続されます。

(注) |

LACP は vSphere 分散仮想スイッチ(DVS)を必要とします。LACP は vSphere 標準スイッチではサポートされていません。 |

クラスタの APIC 1 は、アクティブ/スタンバイ ESXi アップリンクに接続する必要があります。クラスタの他の APIC、APIC 2 ~ N(N はクラスタ サイズ)は、アクティブ/アクティブ ESXi アップリンクに接続できます。

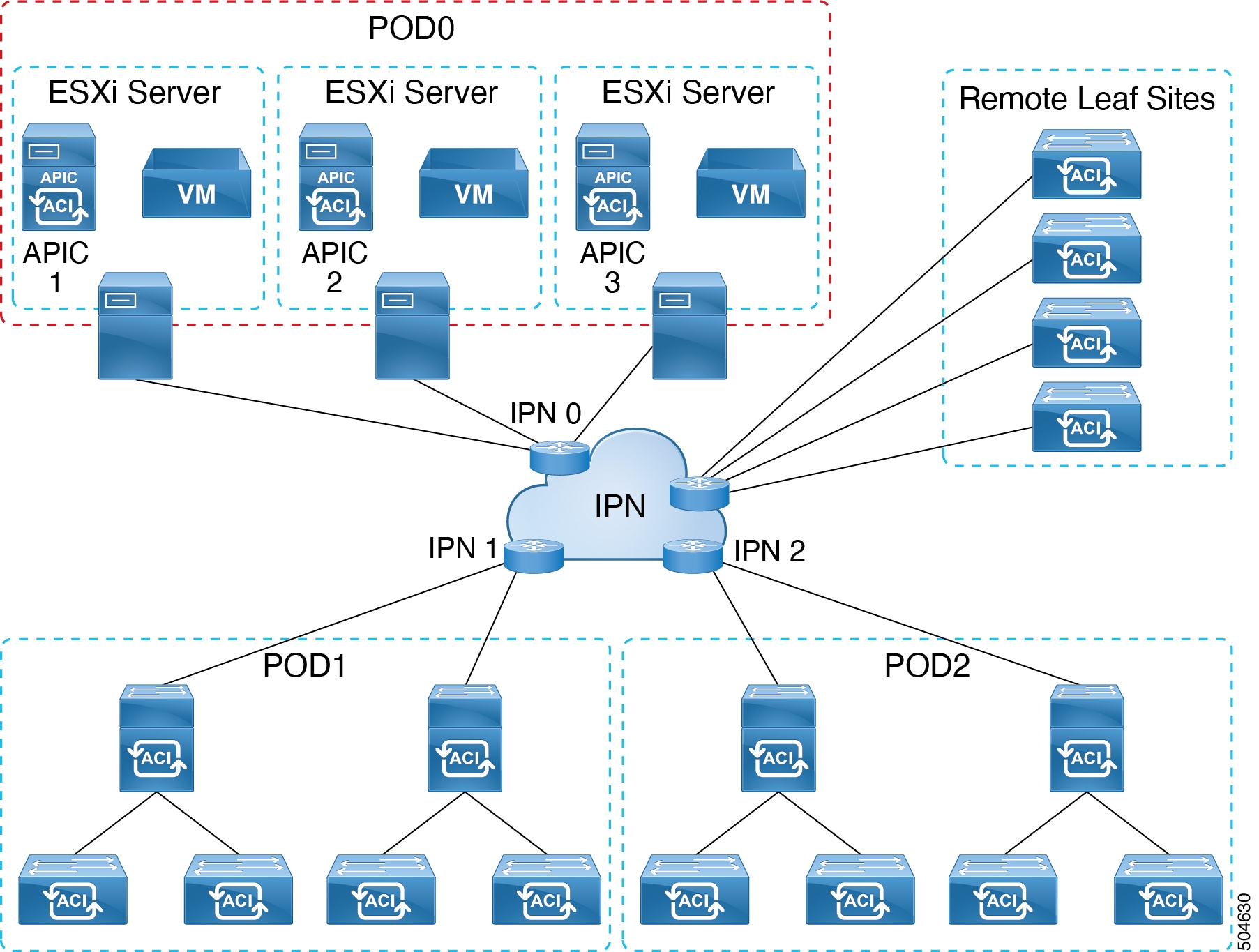

ESXi ホストが ACI ファブリックにリモート接続されている

次の図に示すように、APIC VM は、外部ネットワークに接続され、IPN を介して ACI ファブリックにリモート接続されている ESXi ホストでホストされます。

ESXi 上に仮想 APIC を展開する際の注意事項と制限事項

ESXi 上に仮想 APIC を展開する際には、次の注意事項と制限事項があります。

-

ESXi ホストごとに複数の仮想 APICがサポートされます。高可用性を実現するには、ESXi ホストごとに 1 つの仮想 APIC を使用することをお勧めします。

-

ファブリック スイッチは、Cisco Application Centric Infrastructure(ACI)リリース 6.0(2)以降を実行している必要があります。リリース 6.0(2)より前のリリースを実行しているファブリック スイッチがある場合でも、自動ファームウェア アップデートを使用したファブリック検出中に、6.0(2)リリースへ自動的にアップグレーすることができます。

-

混合モードはサポートされていません。つまり、各クラスタ内のすべての APIC は同じタイプ(レイヤ 2 またはレイヤ 3)である必要があります。レイヤ3 ESXi 上の仮想 APIC は、レイヤ 3 AWS の仮想 APIC またはレイヤ3の物理 APIC とクラスタを形成することはできません。

-

ESXi に仮想 APIC を展開する前に、すべての ESXi ホストのクロックが NTP を使用して同期されていることを確認します。

-

ESXi を使用して展開された仮想 APIC は AWS に移行できません。その逆 (AWS 上に展開してから ESXi に移行すること)も同様です。サポートされている移行シナリオについては、物理 APIC から仮想 APIC への移行セクションを参照してください。

-

ESXi を使用して仮想 APIC(リリース 6.0(2))を展開した後は、Cisco APIC リリース 6.0(2) より前のリリースにダウングレードすることはできません。

-

スタンバイ APIC はサポートされていません。

物理 APIC クラスタの場合、スタンバイ APIC は、現用系クラスタと一緒のファームウェア バージョンであることを保証するため、ファームウェア アップデートと一緒に自動的にアップデートされます。これにより、障害発生時の APIC の置き換えが可能になります。ただし、仮想 APIC クラスタの場合、ユーザーは必要に応じて同じバージョンの APIC のインスタンスを作成できます。『Cisco APIC Getting Started Guide』のAPIC コントローラの置き換えセクションを参照してください。

-

クラスタとファブリックのセキュリティは、自己署名証明書を使用して提供されます。

-

仮想 APIC のホストに使用されるのと同じ DVS で VMM を展開する場合は、 Cisco APIC GUI で CDP を有効にし、LLDP を無効にします。 に移動します。

-

仮想 APIC VM をホストする ESXi ホストは、 Cisco ACI モードのリーフ スイッチに直接接続する必要があります。ファブリックに直接接続されている仮想 APIC の場合、リーフとの間の LLDP トラフィックを消費することが必要になります。したがって、インターセプトを回避するために、LLDP は vDS で無効にされます。VMM の vDS を操作するには、CDP を有効にします。詳細については、VMware vCenter を使用した仮想 APIC の展開の手順のネットワーキングの前提条件セクションを参照してください。

中間スイッチを介して接続される ESXi ホストはサポートされません。これには UCS ファブリック インターコネクトも含まれます。

-

クラスタ内のノードは同じ PID である必要があります。たとえば、クラスタ内の 1 つのノードが APIC-SERVER-VMWARE-S1 である場合、他のすべてのノードも APIC-SERVER-VMWARE-S1 である必要があります。

VM の詳細な仕様については、VMware vCenter を使用した仮想 APIC の展開の手順を参照してください。

-

小規模な ACI クラスタのセットアップでは、サポートされる組み合わせは、1 つの物理 APIC と 2 つの仮想 APICです(APIC-SERVER-VMWARE-M1 のみ)。

VM の詳細な仕様については、VMware vCenter を使用した仮想 APIC の展開の手順を参照してください。

-

事前にパッケージ化されたアプリケーションのみをサポートします。サポートされる、事前にパッケージ化されたアプリとしては、以下のものがあります。

-

Network Insights Cloud Connector

-

アップグレード前の検証ツール

-

-

仮想 APIC クラスタは、すべての Cisco ACI マルチポッド、リモート リーフ スイッチ、および Cisco ACI マルチサイト トポロジでサポートされます。拡張性の制限については、Verified Scalability Guide for Cisco APICを参照してください。

-

仮想 APIC は VMware vMotion をサポートしています。

-

仮想 APIC は、VMware vSphere High Availability(HA)または VMware vSphere Fault Tolerance(FT)をサポートしていません。

VMware vCenter を使用した仮想 APIC の展開

VMware vCenter GUI を使用して ESXi ホストに仮想 APIC を展開するには、次の手順に従います。

初期展開は、 .ova イメージ(Cisco.com の [ソフトウェア ダウンロード(Software Downloads)] から入手可能)を使用して行います。クラスタを(GUI または API を使用して)起動し、 完全に適合した後、.iso イメージを使用して APIC を将来のバージョンにアップグレードすることもできます。

始める前に

ネットワークの前提条件

ESXi に仮想 APIC を展開する前に、次のネットワーク関連の前提条件が満たされていることを確認します。

-

VMware vCenter GUI にログインし、次のように分散仮想スイッチ(DVS)設定を編集します。

-

次のシナリオに基づいて、LLDP を無効にするか、CDP を有効にします。

-

VMM 統合なしで DVS を使用する場合は、検出プロトコル タイプを CDP または(無効)に設定します。この設定により、LLDP パケットが分散仮想スイッチを介して APIC VM に渡されます。

-

VMM 統合で DVS を使用する場合は、検出プロトコル タイプを CDP として設定します。

(注)

LLDP は標準仮想スイッチではサポートされていません。標準仮想スイッチは CDP をサポートします。

-

-

VLAN の設定。

仮想 APIC の新しい分散ポート グループを設定します。VLAN トランキングを有効にし、VLAN 範囲を設定します。次の VLAN を VLAN トランク範囲に追加します。

-

Infra VLAN

-

インバンド管理 VLAN(インバンド管理が設定されている場合)

-

VLAN 0(VLAN 0 は LLDP 転送 LLDP パケットに必要です。リーフ スイッチから送信された LLDP パケットにはタグは付けられません)。

-

-

DVS に ESXi ホストを追加します。

ファブリック リーフに接続する物理アダプタ vmnic を DVS アップリンク(アップリンク 1 やアップリンク 2 など)に割り当てます。

-

-

上記の前提条件に加えて、仮想 APIC がアクティブ/アクティブ ESXi アップリンクに接続されている場合は、次の前提条件が適用されます(APIC 1 は常にアクティブ/スタンバイ ESXi アップリンクに接続されます)。

-

APIC 2 〜 N(N はクラスタサイズ)をホストする ESXi ホストにアクティブ/アクティブが使用されている場合は、リーフ スイッチに接続された vmnic を LAG メンバーとして割り当てる DVS で LAG を作成します。アクティブ/アクティブ ポート グループに LAG を追加します。

(注)

アクティブ/アクティブおよびアクティブ/スタンバイ アップリンクを同じ DVS ポート グループに設定することはできません。アクティブ/アクティブ構成とアクティブ/スタンバイ構成の両方を使用するには、2 つのポート グループが必要です。

-

ESXi アップリンクを ACI リーフに接続します。

-

-

(リモート接続された仮想 APIC の場合)トランキングを有効にし、ルーテッド IP ネットワーク(IPN)への接続に使用されるレイヤ 3 APIC インフラ VLAN とインバンド管理 VLAN を含むように VLAN 範囲を設定します。

仮想マシンの前提条件

ESXi ホストが次の表に記載されている VM 仕様をサポートできることを確認します。

Cisco APIC リリース 6.1(1) 以降、APIC-SERVER-VMWARE-S1 と APIC-SERVER-VMWARE-L1 の 2 つの新しい仮想 APIC PID が導入されました。このセクションでは、これらの PID でサポートされる仮想マシンの仕様について説明します。

(注) |

(VMWare vCenter を使用せずに)ESXi ホストに直接展開された VM の場合、APIC-SERVER-VMWARE-S1 および APIC-SERVER-VMWARE-L1 はサポートされません。ただし、APIC-SERVER-VMWARE-M1 は引き続き、ESXi ホストに直接展開された VM によりサポートされます。 |

|

CPU |

3 GHz 以上の 16 個の vCPU |

|

メモリ |

96 GB の RAM |

|

ストレージ |

|

|

Network |

2 つのインターフェイス。

仮想 APIC 間で許容される遅延は、最大 50 ミリ秒です。 |

|

CPU |

3 GHz 以上の CPU 8 基 |

|

メモリ |

32 GB RAM |

|

ストレージ |

|

|

Network |

2 つのインターフェイス。

仮想 APIC 間で許容される遅延は、最大 50 ミリ秒です。 |

|

CPU |

3 GHz 以上の vCPU 32 基 |

|

メモリ |

192 GB の RAM |

|

ストレージ |

|

|

Network |

2 つのインターフェイス。

仮想 APIC 間で許容される遅延は、最大 50 ミリ秒です。 |

(注) |

仮想 APIC クラスタは、中規模の CPU、ハード ドライブ、およびメモリ構成(最大 1,200 個のエッジ ポート)をサポートします。 |

手順

|

ステップ 1 |

[OVF テンプレートの展開(Deploy OVF Template)] を選択します。完了する必要がある 6 つのステップ(画面)があります。以下の画面で次の詳細を入力します。 |

|

ステップ 2 |

クラスタに必要なノードの数に応じて、上記の手順を繰り返します。たとえば、3 ノード クラスタを構築する場合は、上記の手順を 3 回実行します。ブートストラップとクラスタの起動手順に進む前に、すべての VM がオンになっていることを確認します。詳細については、Cisco APIC 開始ガイドのGUI を使用した Cisco APIC クラスタの起動手順を参照してください。APIC 1 の IP アドレスを使用して、APIC クラスタ起動 GUI にアクセスします。 |

次のタスク

アクティブ/スタンバイ ESXi アップリンクに接続されている APIC をアクティブ/アクティブ ESXi アップリンク(APIC 1 を除く)に変更する場合は、以下の手順に従います。

-

APIC1 が完全に適合したら、Cisco APIC GUI のノード登録ポリシーを使用して、すべてのファブリックノードを APIC1 に登録します。

ノード登録のため、[ファブリック(Fabric)] > [インベントリ(Inventory)] > [ファブリック メンバーシップ(Fabric Membership)] に移動します。

-

VMware vCenter GUI を使用して、DVS の APIC 2 ~ N のアクティブ/アクティブ ESXi アップリンク(LAG)でポートグループに接続します。

-

LACP ポリシーを使用して、残りの仮想 APIC 接続インターフェイスの VPC ポリシー グループを設定します。

Cisco APIC GUI の [ポート チャネル ポリシー(Port Channel Policy)] ページで、[制御(Control)] フィールドの [個別ポートの一時停止(Suspend Individual Port)] オプションを削除し、モードを LACP アクティブとして選択します。

[ファブリック(Fabric )] > [アクセスポリシー(Access Policies)] > [ ポリシー(Policies)] > [インターフェイス(Interface)] > [ポート チャネル(Port Channel)] を選択します。

-

すべての APIC が 完全に適合 していることを確認します(Cisco APIC GUI)。

[システム(System)] > [ダッシュボード(Dashboard)] に移動します。[コントローラ ステータス(Controller Status)] ペイン(右下)の [正常性(Health State)] 列に [完全(Fully)] と表示されます。

レイヤ 3 接続された APIC クラスタと一緒に ACI ネットワークを作成

このセクションの手順では、作成された仮想 APIC クラスタとリモート ACI ファブリック間の接続を確立します。

レイヤ 3 で接続された APIC クラスタは、DHCP リレーと、IPN によって提供される OSPF または BGP アンダーレイを使用して、ファブリック ノードを検出できます。

次のリストは、レイヤ 3 で接続された仮想 APIC クラスタを使用して ACI ネットワークを展開する手順の概要を示しています。

手順

|

ステップ 1 |

ファブリックに接続された IPN デバイスをプロビジョニングとAPIC クラスタに接続された IPN デバイスをプロビジョニング — これらの手順の説明に従って IPN を構成します。 |

|

ステップ 2 |

APIC クラスタの起動方法については、Cisco APIC Getting Started GuideのCisco APIC クラスタの起動の手順を参照してください。 |

|

ステップ 3 |

APIC クラスタのレイヤー 3 接続を構成して、IPN を介してファブリック ポッドと通信します。ファブリック ポッドへの接続を準備を参照してください。 |

|

ステップ 4 |

ファブリック ポッドを持ち上げます。ファブリックは、ファブリック検出と登録の概要で説明されているように、レイヤ 3 接続を介して APIC クラスタによって検出されます。 |

次のタスク

同様の方法で、追加のファブリック ポッドとリモート リーフ サイトを、レイヤ 3 で接続された APIC クラスタに接続できます。

APIC クラスタ接続をレイヤ 3 ネットワークへ展開するときのガイドラインと制限。

仮想レイヤ 3 接続の APIC クラスタを展開するときは、次のガイドラインと制限に従ってください。

-

APIC 接続ポート グループが APIC インフラ レイヤ 3 ネットワーク VLAN 用に設定されていることを確認します。インバンド管理を使用する場合、ポートグループは、インフラ レイヤ 3 ネットワーク VLAN とインバンド管理 VLAN の両方を許可するトランクとして設定する必要があります。

-

すべての APIC クラスタ サイズは、レイヤ 3 で接続された APIC ポッドでサポートされます。

-

レイヤ 3 で接続された APIC ポッド内の APIC は、ファブリック ポッド内の APIC でクラスタを形成できません。このトポロジでは、ファブリック ポッドに APIC がないようにする必要があります。

-

レイヤ 3 で接続された APIC は、同じサブネットまたは異なるサブネットに配置できます。同じサブネットの場合は、APIC 接続 IPN インターフェイスで「no ip redirects」を設定します。

-

APIC 間の遅延とファブリック ポッドとの遅延が 50 ミリ秒の往復時間(RTT)を超えないことを条件として、レイヤー 3 で接続された APIC を地理的に分散させることができます。これは、およそ最大 2,500 マイルの地理的距離に相当します。

-

IPN ネットワーク要件を満たすことができるデバイスはすべて IPN デバイスとして使用できますが、可能であれば、Cisco Nexus 9300 クラウド スケール ファミリのスイッチを展開することをお勧めします。これらは、実稼働環境で最も一般的に見られるデバイスであり、シスコの内部テストでより生産に検証されるデバイスでもあります。IPN デバイス要件の詳細については、[ACI マルチポッド ホワイト ペーパー(ACI Multi-Pod White Paper)]の「ポッド間接続の展開に関する考慮事項」を参照してください。

-

APIC サブネットは、OSPF または BGP ルートとしてスパインにアドバタイズする必要があります。OSPF と BGP の両方が、APIC ノードと IPN デバイス間のアンダーレイ プロトコルとしてサポートされます。

-

APIC クラスタとファブリック ポッド間のすべてのコントロール プレーン トラフィックは IPN を通過するため、このトラフィックに QoS を構成することをお勧めします。このガイドの QoS の構成 セクションを参照してください。

-

レイヤ 3 ネットワークを介したファブリックへの APIC クラスタ接続は、次をサポートしません:

-

Kubernetes の ACI CNI(Redhat Openshift、SUSE/Rancher RKE、Ubuntu 上のアップストリーム Kubernetes)

-

Openstack 用の ACI ML2(Redhat Openstack、Canonical Openstack)

-

-

レイヤ3ネットワークを介したファブリックへの APIC クラスタ接続は、ストリクト モードをサポートします。ストリクト モードの場合は、コントローラを明示的に承認する必要があります。

APIC クラスタに接続された IPN デバイスをプロビジョニング

このセクションでは、APIC クラスタ ポッドであるポッド 0 に接続された IPN デバイスの構成について説明します。このESXi ホストが ACI ファブリックにリモート接続されているセクションのレイヤ 3 のトポロジを参照すると、クラスタに面した IPN デバイスは IPN0 として示されています。推奨されるプラクティスとして、IPN0 は冗長性のために 2 つのデバイスで構成されます。各 APIC のファブリック インターフェイスは、2 つのデバイスにデュアルホーム接続されています。次の構成例では、2 つの Cisco Nexus 9000 シリーズ スイッチ(IPN0a および IPN0b)が次の選択肢で構成されています:

-

VLAN 1500 は、APIC のインターフェイス VLAN として使用されます。

-

スイッチ インターフェイスは、レイヤ 2 トランク ポートとして構成されます。代わりに、APIC ファブリック インターフェイスが APIC セットアップ中に VLAN 0 を使用するように構成されている場合、インターフェイスはアクセス ポートである可能性があります。

-

どちらのスイッチも、APIC サブネットのデフォルト ゲートウェイ アドレスとして機能する単一の IP アドレスを共有するように HSRP を使用して設定されています。

-

APIC サブネットは、アンダーレイ プロトコルとして OSPF を使用してスパインにアドバタイズされます。代わりに、BGP アンダーレイを展開できます。

# Example configuration of IPN0a:

interface Vlan1500

no shutdown

vrf member IPN

no ip redirects

ip address 172.16.0.252/24

ip ospf passive-interface

ip router ospf 1 area 0.0.0.0

hsrp version 2

hsrp 1500

ip 172.16.0.1

interface Ethernet1/1

switchport mode trunk

switchport tru allowed vlan 1500

spanning-tree port type edge trunk

# Example configuration of IPN0b:

interface Vlan1500

no shutdown

vrf member IPN

no ip redirects

ip address 172.16.0.253/24

ip ospf passive-interface

ip router ospf 1 area 0.0.0.0

hsrp version 2

hsrp 1500

ip 172.16.0.1

interface Ethernet1/1

switchport mode trunk

switchport tru allowed vlan 1500

spanning-tree port type edge trunk

ファブリックに接続された IPN デバイスをプロビジョニング

このセクションでは、ファブリック ポッドに接続された IPN デバイスである MPod IPN の構成について説明します。IPN は APIC では管理されません。これは、次の情報が事前する必要があります。

-

ファブリック ポッドの背表紙に接続されているインターフェイスを設定します。VLAN-4 でトラフィックをタグ付けするレイヤ 3 サブインターフェイスを使用し、MTU をサイト間コントロール プレーンおよびデータ プレーン トラフィックに必要な最大 MTU より 50 バイト以上増やします。

-

OSPF プロセスとエリア識別子を指定して、サブインターフェイスで OSPF(または BGP)を有効にします。

-

スパインに接続されている IPN インターフェイスで DHCP リレーを有効にします。

-

PIM をイネーブルにします。

-

PIM 双方向としてブリッジ ドメイン GIPo 範囲の追加(bidir)の範囲をグループ化(デフォルトでは 225.0.0.0/15)。

グループを bidir モードが機能の転送を共有ツリーのみ。

-

PIM として 239.255.255.240/28 を追加 bidir 範囲をグループ化します。

-

すべての背表紙に接続されたインターフェイスで PIM を有効にします。

(注) |

マルチキャストは、レイヤ 3 で接続された APIC クラスタを持つ単一のポッド ファブリックには必要ありませんが、マルチポッド ファブリックのポッド間で必要です。 |

(注) |

PIM bidir を展開する際には、どの時点であっても、特定のマルチキャスト グループ範囲に対して、1 つのアクティブな RP(ランデブー ポイント)を設定することだけが可能です。RP の冗長性が活用することで実現そのため、 ファントム RP 設定します。希薄モードの冗長性を提供するために使用するエニー キャストまたは MSDP メカニズムはのオプションではありませんマルチキャスト ソースの情報は、Bidir で利用可能なは不要であるため bidir 。 |

次のスイッチ構成の例は、MPod IPN として展開されたスイッチ用です。DHCP リレー設定により、APIC クラスタによるファブリックの検出が可能になります。ポッド間接続用の IPN での専用 VRF の展開はオプションですが、ベスト プラクティスとして推奨されます。代わりにグローバル ルーティング ドメインを使用することもできます。

Example: OSPF as the underlay protocol

feature dhcp

feature pim

service dhcp

ip dhcp relay

# Create a new VRF.

vrf context overlay-1

ip pim rp-address 12.1.1.1 group-list 225.0.0.0/15 bidir

ip pim rp-address 12.1.1.1 group-list 239.255.255.240/28 bidir

interface Ethernet1/54.4 #spine connected interface

mtu 9150

encapsulation dot1q 4

vrf member overlay-1

ip address 192.168.0.1/30

ip ospf network point-to-point

ip router ospf infra area 0.0.0.0

ip dhcp relay address 172.16.0.2 #infra address of APIC 1

ip dhcp relay address 172.16.0.3 #infra address of APIC 2

ip dhcp relay address 172.16.0.4 #infra address of APIC 3

no shutdown

interface loopback29

vrf member overlay-1

ip address 12.1.1.2/30

router ospf infra

vrf overlay-1

router-id 29.29.29.29

Example: BGP as the underlay protocol

router bgp 65010

vrf IPN

neighbor 192.168.0.2 remote-as 65001

address-family ipv4 unicast

disable-peer-as-check

BGP 構成では、各ポッドが同じ ASN を使用するため、マルチポッドに disable-peer-as-check コマンドが必要です。

ファブリック ポッドへの接続を準備

ファブリック ポッド(ポッド 1)を起動する前に、IPN を介してファブリック ポッド内のスパインに接続できるように、レイヤ 3 で接続された APIC クラスタ(ポッド 0)を事前に構成する必要があります。これは、自動ファブリック検出に必要です。

始める前に

-

レイヤ 3 接続された仮想 APIC クラスタがファブリックとは別のセキュリティ ゾーンに展開されている場合は、必要なプロトコルとポートを許可するようにファイアウォールを構成します。

-

ファブリック ポッド スパインに接続されているポッド間ネットワーク(IPN)デバイスを構成します。

-

ファブリックの外部ルーティング プロファイルを構成します。

-

アンダーレイ プロトコルとして OSPF を使用している場合は、OSPF インターフェイス ポリシーを構成します。

手順

|

ステップ 1 |

レイヤ 3 接続クラスタ内の APIC の 1 つにログインします。 |

|

ステップ 2 |

を選択します。 |

|

ステップ 3 |

作業ウィンドウで、[ポッド ファブリック セットアップ ポリシー(Pod Fabric Setup Policy)] ページの [ + ] 記号をクリックします。 [ポッド TEP プールの設定(Set Up Pod TEP Pool)] ダイアログ ボックスが開きます。 |

|

ステップ 4 |

[ポッド TEP プールの作成(Set Up Pod TEP Pool)]ダイアログボックスで、次の手順を行います。

|

|

ステップ 5 |

ナビゲーション ペインで、[クイック スタート(Quick Start) を展開し、[ポッドの追加(Add Pod)] をクリックします。 |

|

ステップ 6 |

作業ペインで、[Add Pod] をクリックします。 |

|

ステップ 7 |

[Configure Interpod Connectivity STEP 1 > Overview] パネルで、ポッド間ネットワーク(IPN)接続の設定に必要なタスクを確認し、[Get Started] をクリックします。 |

|

ステップ 8 |

[Configure Interpod Connectivity STEP 2 > IP Connectivity] ダイアログボックスで、次の手順を実行します。 |

|

ステップ 9 |

[ポッド間接続構成 ステップ 3(Configure Interpod Connectivity STEP 3)] > [ルーティング プロトコル(Routing Protocols)] ダイアログボックスの [OSPF] エリアで、スパインを IPN インターフェイスへ OSPF を構成するために次の手順を実行します: |

|

ステップ 10 |

[ポッド間接続構成 ステップ 3(Configure Interpod Connectivity STEP 3)] > [ルーティング プロトコル(Routing Protocols)] ダイアログボックスの [BGP] エリアで、[デフォルトを使用(Use Defaults)] をチェックしたままにするか、チェックを外します。 デフォルトでは、[デフォルトを使用(Use Defaults)] チェックボックスはオフになっています。チェックボックスをオンにすると、Border Gateway Protocol(BGP)を構成するための GUI のフィールドが非表示になります。オフにした場合は、すべてのフィールドが表示されます。チェックボックスをオフにした場合は、次の手順を構成します。 |

|

ステップ 11 |

[次へ] をクリックします。 |

|

ステップ 12 |

[Configure Interpod Connectivity STEP 4 > External TEP] ダイアログボックスで、次の手順を実行します。 |

|

ステップ 13 |

[次へ(Next)] をクリックします。 [概要(Summary)] パネルが表示され、このウィザードで作成されたポリシーのリストが表示されます。ここでこれらのポリシーの名前を変更できます。

|

|

ステップ 14 |

[Finish] をクリックします。 |

次のタスク

次のセクションで要約されているように、APIC によるファブリック ノードの検出と登録をモニタします。

ファブリック検出と登録の概要

以下は、スイッチの登録および検出プロセスの概要です。

-

DHCP リレー エージェントとして機能する IPN は、DHCP 要求をスパインから APIC に転送します。

-

スパイン スイッチが APIC に表示されるようになり、[ファブリック メンバーシップ(Nodes Pending Registration)] 画面の [ノード保留中の登録(Nodes Pending Registration)] の下に表示されます。[ファブリック(Fabric)] > [インベントリ(Invertory)] > [ファブリック メンバーシップ(Fabric Membership)]に移動します。

-

APIC にスパイン スイッチを登録します。

-

APIC は、スパイン インターフェイスの IP アドレスを IPN に割り当て、スパインを含むファブリック ポッド用に構成された TEP プールから TEP IP を割り当てます。この時点で、スパインは ACI ファブリックに参加します。

-

スパインは、IPN がこのサブネットを学習できるように、OSPF または BGP を介して IPN に TEP サブネットをアドバタイズします。

-

スパインは、接続されたリーフ スイッチの DHCP リレー エージェントとして機能し、要求を APIC に転送します。

-

リーフ スイッチは APIC に表示され、[ファブリック(Fabric)] > [インベントリ(Inventory)] > [ファブリック メンバーシップ(Fabric Membership)] の [登録保留中のノード] のセクションに表示されます。

-

APIC でこれらのリーフ スイッチを手動で登録する必要があります。

-

リーフ スイッチが登録されると、APIC は TEP IP アドレスと DHCP 設定情報をリーフに転送し、リーフは ACI ファブリックに参加します。この検出プロセスを通じて、レイヤ 3 に接続された APIC クラスタは、ファブリック ポッド内のすべてのスイッチを検出します。

レイヤ 3 で接続された APIC クラスタの QoS の設定

APIC クラスタとファブリック間のすべてのトラフィックは IPN を通過するため、このトラフィックに QoS を構成することをお勧めします。具体的な推奨事項は次のとおりです。

(注) |

このセクションの設定例は、IPN デバイスとして使用できる Cisco Nexus 9000 シリーズ スイッチ用です。別のプラットフォームを使用する場合、設定はいくらか異なります。 |

-

DSCP クラス CoS 変換ポリシーを有効化します。

-

すべての IPN トラフィックのエンドツーエンド DCSP 値を保持します。DSCP クラスの CoS 変換ポリシーが有効になっている場合、スパイン スイッチは、このポリシーに従って IPN に送信されるパケットの DSCP 値を設定します。APIC 宛てのトラフィックは、ポリシー プレーン クラスを使用します。ポッド間コントロール プレーン トラフィック(つまり、OSPF および MP-BGP パケット)は、コントロール プレーン クラスを使用します。ポリシー プレーン クラスが緊急転送(EF)用に設定され、コントロール プレーン クラスが CS4 用に設定されていることを確認します。IPN ネットワークでは、これら 2 つのクラスに優先順位を付けるように構成して、輻輳時でもポリシー プレーンとコントロール プレーンが安定した状態を維持できるようにすることが可能です。

次の例は、IPN デバイスとして使用される Cisco Nexus 9000 シリーズ スイッチでポリシー プレーン トラフィックの QoS を設定するための構成を示しています。

interface Vlan1500 no shutdown vrf member overlay-1 ip address 172.16.0.2/24 ip ospf passive-interface ip router ospf 1 area 0.0.0.0 hsrp version 2 hsrp 100 ip 172.16.0.1 ip access-list APIC_Cluster 10 permit ip 172.16.0.0/24 any class-map type qos match-all APIC-Class match access-group name APIC_Cluster policy-map type qos APIC_Policy class APIC-Class set dscp 46 interface Ethernet1/1 switchport mode trunk switchport access vlan 1500 service-policy type qos input APIC_Policy interface Ethernet1/2 switchport mode trunk switchport access vlan 1500 service-policy type qos input APIC_Policy interface Ethernet1/3 switchport mode trunk switchport access vlan 1500 service-policy type qos input APIC_Policy -

また、ポリシー プレーン トラフィックのドロップを防ぐために、APIC への非ポリシー プレーン トラフィックのレートを制限することを推奨します。クラスタに面した IPN にポリサーを展開して、46(EF)以外の DSCP 値を持つトラフィックを、60 Mbps のバーストで 4 Gbps に制限します。次に、IPN デバイスとして使用される Cisco Nexus 9000 シリーズ スイッチのレート制限構成の例を示します。

class-map type qos match-all no_rate_limit match dscp 46 policy-map type qos APIC_Rate_Limit class no_rate_limit class class-default police cir 4 gbps bc 7500 kbytes conform transmit violate drop interface Ethernet1/1-3 switchport mode trunk switchport access vlan 1500 service-policy type qos input APIC_Policy service-policy type qos output APIC_Rate_Limit

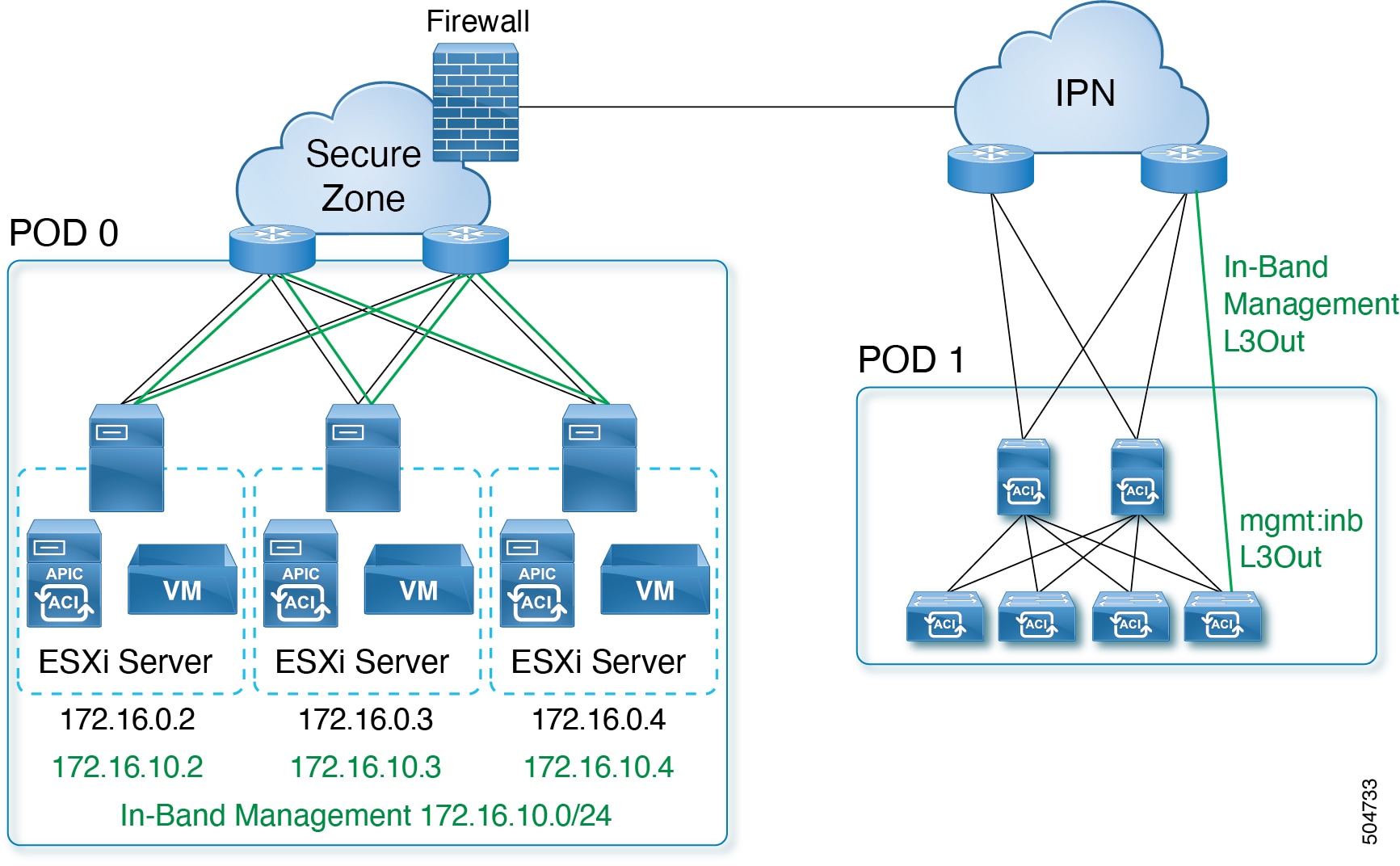

インバンド管理の構成

レイヤ 3 接続された APIC クラスタを使用してインバンド管理を展開すると、インバンド管理 VRF(mgmt:inb)はスパインを介して IPN にルーティングされません。APIC のインバンド管理インターフェイスへの接続は、ボーダー リーフ スイッチのいずれかにおいて構成された L3Out からルーティングする必要があります。この L3Out は、インバンド管理 VRF の mgmt テナントで構成する必要があります。

この手順を使用して、レイヤ 3 で接続された APIC クラスタのインバンド管理を構成します。

始める前に

DVS(VMware VCenter)の APIC 接続ポートグループでインバンド VLAN を構成します。

手順

|

ステップ 1 |

APIC 上流に位置するスイッチを構成します。 例: IPN VRF を使用してインバンド管理ネットワークをルーティングすることも、別の VRF を選択することもできます。 |

||

|

ステップ 2 |

通常のインバンド管理構成手順を使用して、インバンド管理用の APIC を構成します。

インバンド管理の設定の詳細については、[Cisco APIC と静的管理アクセス(Cisco APIC and Static Management Access )] テクニカル ノートの「Static In-band Management」の章を参照してください。 |

||

|

ステップ 3 |

上流に位置するスイッチ内で APIC インターフェイスを構成する。 APIC 接続インターフェイスはトランク インターフェイスである必要があります。APIC が 0 以外のインフラ VLAN で初期化された場合、次の例のようにインターフェイスを設定できます。

|

物理 APIC から仮想 APIC への移行

注目 |

物理 APIC から仮想 APIC に移行するには、すべてのファブリック ノードから設定を消去し、バックアップから設定を復元する必要があります。すべてのファブリック ノードが再初期化されます。これは中断を伴う手順です。 この手順については、Cisco TAC にお問い合わせください。 |

物理 APIC(レイヤ 2、APIC が ACI ファブリックに直接接続されている)を仮想 APIC(レイヤ 2、ESXi ホストが ACI ファブリックに直接接続されている)に移行するには、次の手順に従います。次の手順には、物理 APIC(レイヤ 3、APIC が ACI ファブリックにリモート接続されている)を仮想 APIC(レイヤ 3、ESXi ホストが ACI ファブリックにリモート接続されている)に移行するための詳細も含まれています。

始める前に

前提条件

-

物理 APIC とすべてのノード(スパインおよびリーフ スイッチ)を 6.0.2 にアップグレードします。

-

既存のすべての構成のバックアップを作成します。

-

物理 APIC ノードをシャットダウンします。

-

すべてのファブリック ノードをクリーン リロードします。ファブリック ノードをクリーン リブートするには、各ファブリック ノードにログインし、次を実行します。

setup-clean-config.sh reload

ガイドラインと制約事項

-

クラスタ サイズが一致していることを確認します(たとえば 5 ノードの物理クラスタから 3 ノードの仮想クラスタへの移行はサポートされていません)。

-

両方のクラスタが正常であり、新しいクラスタが必要な数の APIC をサポートできることを確認します。

-

新しいクラスタの APIC で設定されたインフラ VLAN は、インポートされる設定と同じである必要があります。不一致がある場合、インフラ EPG はインポートされません。

手順

|

ステップ 1 |

VMware vCenter GUI で、ネットワーク フォルダの下に DVS を作成します(ESXi バージョンと互換性のある DVS スイッチ バージョンを使用します)。[データセンターの選択(Select DataCenter)] > [アクション(Actions)] > [新しいフォルダ(New Folder)] > [新しいネットワークフォルダ(New Network Folder)] を選択します。 使用される検出プロトコルが CDP(LLDP ではない)の場合、VMM ドメイン統合用に作成された既存の DVS を使用できます。 |

|

ステップ 2 |

(レイヤ 2 のみ)DVS アップリンク(VMware vCenter)で LLDP を無効にします。 |

|

ステップ 3 |

ESXi ホストを追加します。以下でレイヤ 2 とレイヤ 3 それぞれの詳細について確認してください。

|

|

ステップ 4 |

DVS で InfraPortGroup を作成します。以下でレイヤ 2 とレイヤ 3 それぞれの詳細について確認してください。

|

|

ステップ 5 |

ESXi ホストに仮想 APIC VM を展開します。物理 APIC ノードと同じ IP アドレスを使用し、それに応じて OOB およびインフラ ポート グループを選択します。 |

|

ステップ 6 |

APIC VM をオンにします。VM が起動したら、APIC クラスタの起動 GUI に進みます。詳細については、Cisco APIC 開始ガイドのGUI を使用した Cisco APIC クラスタの起動手順を参照してください。 |

|

ステップ 7 |

設定を APIC 1 にインポートし、すべてのファブリックノードが [アクティブ(Active)] ステータスで検出されていることを確認します。 [ファブリック(Fabric)] > [インベントリ(Inventory)] > [ファブリック メンバーシップ(Fabric Membership)] に移動します。[登録済みノード(Registered Nodes)] タブで、すべてのファブリックノードがアクティブ状態になっているかどうかを確認します。 |

|

ステップ 8 |

APIC 2(から N、N はクラスタ サイズ)がクラスタに参加し、クラスタが正常であることを確認します。 [システム(System)] > [ダッシュボード(Dashboard)] に移動します。[コントローラ ステータス(Controller Status)] ペイン(右下)の [正常性状態(Health State)] 列に [完全に適合(Fully match ] と表示されます。 |

次のタスク

トラフィックの検証:

-

Cisco APIC GUI で [操作ダッシュボード(Operations Dashboard)] を確認し、プログラムされたポリシーを確認します。

-

何らかの障害がないか確認します。[システム(System)] > [障害(Faults)] の順に選択します。

フィードバック

フィードバック