Hyper-V 2016 および Citrix XenDesktop を使用した Cisco HyperFlex M5 オールフラッシュ ハイパーコンバージド システム

Hyper-V 2016 および Citrix XenDesktop を使用した Cisco HyperFlex M5 オールフラッシュ ハイパーコンバージド システム

Citrix XenDesktop 7.16 を使用した仮想デスクトップ インフラストラクチャとしての Cisco HyperFlex の設計と導入

最終更新日:2018 年 8 月 21 日

Cisco Validated Design プログラムについて

Cisco Validated Design (CVD) プログラムは、お客様による信頼性の高い、確実かつ速やかな展開を容易にするために、デザイン、テスト、および文書化されたシステムおよびソリューションで構成されています。詳細に

ついては、以下を参照してください。

http://www.cisco.com/go/designzone

このマニュアルに記載されているデザイン、仕様、表現、情報、および推奨事項(総称して「デザイン」)は、

本マニュアル作成時点における、障害も含めた「現状のまま」として提供されます。シスコ及びそのサプライヤ

は、商品性の保証、特定目的への準拠の保証、及び権利を侵害しないことに関する保証、あるいは取引過程、

使用、取引慣行によって発生する保証をはじめとする、一切の保証責任を負わないものとします。いかなる場合においても、シスコ及びそのサプライヤは、このデザインを使用すること、または使用できないことによって発生する利益の損失やデータの損傷をはじめとする、間接的、派生的、偶発的、あるいは特殊な損害について、あらゆる可能性がシスコまたはそのサプライヤに知らされていたとしても、それらに対する責任を一切負わないものとします。

デザインは予告なしに変更されることがあります。このマニュアルに記載されているデザインの使用は、すべてユーザ側の責任になります。これらのデザインは、シスコ、シスコのサプライヤ、またはシスコのパートナーからの技術的な助言や他の専門的な助言に相当するものではありません。ユーザは、デザインを実装する前に技術

アドバイザに相談してください。シスコによるテストの対象外となった要因によって、結果が異なることがあります。

CCDE、CCENT、Cisco Eos、Cisco Lumin、Cisco Nexus、Cisco StadiumVision、Cisco TelePresence、Cisco WebEx、Cisco ロゴ、DCE、Welcome to the Human Network は商標です。Changing the Way We Work, Live, Play, and Learn、および Cisco Store はサービス マークです。Access Registrar、Aironet、AsyncOS、Bringing the Meeting To You、Catalyst、CCDA、CCDP、CCIE、CCIP、CCNA、CCNP、CCSP、CCVP、Cisco、Cisco Certified Internetwork Expert ロゴ、Cisco IOS、Cisco Press、Cisco Systems、Cisco Systems Capital、Cisco Systems ロゴ、Cisco Unified Computing System (Cisco UCS)、Cisco UCS B-Series Blade Servers、Cisco UCS C-Series Rack Servers、Cisco UCS S-Series Storage Servers、Cisco UCS Manager、Cisco UCS Management Software、Cisco Unified Fabric、Cisco Application Centric Infrastructure、Cisco Nexus 9000 Series、Cisco Nexus 7000 Series。Cisco Prime Data Center Network Manager、Cisco NX-OS Software、Cisco MDS Series、Cisco Unity、Collaboration Without Limitation、EtherFast、EtherSwitch、Event Center、Fast Step、Follow Me Browsing、FormShare、GigaDrive、HomeLink、Internet Quotient、IOS、iPhone、iQuick Study、LightStream、Linksys、MediaTone、MeetingPlace、MeetingPlace Chime Sound、MGX、Networkers、Networking Academy、Network Registrar、PCNow、PIX、PowerPanels、ProConnect、ScriptShare、SenderBase、SMARTnet、Spectrum Expert、StackWise、The Fastest Way to Increase Your Internet Quotient、TransPath、WebEx、および WebEx ロゴは Cisco Systems, Inc. またはその関連会社の米国および一部の国における登録商標です。

本書または Web サイトにおけるその他の商標は、第三者の知的財産です。パートナーという言葉が使用されて

いても、シスコとその他の会社とのパートナーシップを示すものではありません (0809R)。

© 2018 Cisco Systems, Inc. All rights reserved.

目次

Cisco Unified Computing System

Cisco Unified Computing System のコンポーネント

Cisco VIC1340 コンバージド ネットワーク アダプタ

Cisco UCS 2304XP ファブリック エクステンダ

Cisco HyperFlex コンバージド データ プラットフォーム ソフトウェア

Cisco HyperFlex Connect HTML5 対応の管理 Web ページ

Citrix XenApp™ と XenDesktop™ 7.16

マシンの更新または再起動のスケジュールの前に、複数の通知を送信

ハイパーバイザのテンプレートからの VM のプロビジョニング用 API のサポート

Cisco Unified Computing System の Citrix XenDesktop のアーキテクチャと設計、および Cisco HyperFlex のストレージ設計の基本

プロジェクト計画とソリューション サイジングに関する確認事項の例

Deployment Hardware and Software

Cisco Unified Computing System Configuration

Deploy and Configure HyperFlex Data Platform

Deploying HX Data Platform Installer on Hyper-V Infrastructure

Deploy the HX Data Platform Installer OVA with a Static IP Address

Cisco UCS Manager Configuration using HX Data Platform Installer

Microsoft Windows OS and Hyper-V Installation

Configure vMedia and Boot Policies through Cisco UCS Manager

Deploying HX Data Platform Installer and Cluster Configuration

Post HyperFlex Cluster Installation for Hyper-V 2016

Build the Virtual Machines and Environment for Workload Testing

Software Infrastructure Configuration

Install and Configure XenDesktop Delivery Controller, Citrix Licensing, and StoreFront

Configure the XenDesktop Site Administrators

Configure Additional XenDesktop Controller

Add the Second Delivery Controller to the XenDesktop Site

Install and Configure StoreFront

Additional StoreFront Configuration

Install XenDesktop Virtual Desktop Agents

Persistent Static Provisioned with MCS

Citrix XenDesktop Policies and Profile Management

Configure Citrix XenDesktop Policies

Configuring User Profile Management

Testing Methodology and Success Criteria

Recommended Maximum Workload and Configuration Guidelines

Four Node Cisco HXAF220c-M5S Rack Server and HyperFlex All-Flash Cluster

Appendix A – Cisco Nexus 93108YC Switch Configuration

日本語は部分翻訳のみ、全文は英語版を参照下さい。

https://www.cisco.com/c/en/us/td/docs/unified_computing/ucs/UCS_CVDs/hx301a_vdi_hyperv_xd716.html

エグゼクティブ サマリー

市場の変化に即応するためには、瞬時に対応できる開発プロセスを支えるシステムが欠かせません。Cisco HypFerlex™ システムでは、ハイパーコンバージェンスの持てる力を最大限に引き出し、IT をワークロード

ニーズに適応させることができます。ソフトウェア デファインド インフラストラクチャ アプローチを採用したこのシステムでは、Cisco HyperFlex HX シリーズ ノードによるソフトウェア デファインド コンピューティング、強力な Cisco HyperFlex HX Data Platform を利用したソフトウェア デファインド ストレージ、そして Cisco® Application Centric Infrastructure (Cisco ACI™) と統合できる Cisco UCS ファブリックによるソフトウェア

デファインド ネットワークが 1 つのシステムに統合されています。

この一元化された技術により、サーバ、ストレージ、ネットワークが統合された適応性の高いクラスタとして実現します。この中では、リソースの迅速な導入、適合、拡大・縮小、管理が可能で、アプリケーションとビジネスを効率化できます。

このドキュメントは、4 ノード(Cisco HyperFlex HXAF220C-M5SX サーバ 4 台)の Cisco HyperFlex

システムで、最大 450 ユーザの混合ワークロードを扱う場合のアーキテクチャ リファレンスと設計ガイドです。Citrix XenDesktop 7.16 仮想デスクトップで、Office 2016 マシンの作成サービスが動作する Microsoft Windows 10 を実行する場合の導入ガイダンスとパフォーマンス データを提供します。このソリューションでは、あらかじめ統合され、ベスト プラクティスに則ったデータセンター アーキテクチャが採用されており、Cisco Unified Computing System (UCS)、Cisco Nexus® 9000 ファミリ スイッチ、Cisco HyperFlex Data Platform

ソフトウェア バージョン 3.0.1a での構築が対象となっています。

ソリューションのコアとなる部分は、Cisco HyperFlex HXAF220C-M5SX ハイパーコンバージド ノード上で 100 % 仮想化しており、オンボード M.2 SATA SSD ドライブを介して起動される Microsoft Hyper-V 2016

ハイパーバイザおよび Cisco HyperFlex Data Platform ストレージ コントローラ VM を実行します。仮想

デスクトップは XenDesktop 7.16 で構成されており、従来の永続/非永続仮想デスクトップ (Windows 7/8/10)、ホスト アプリケーションおよびリモート デスクトップ サービス (RDS) (Microsoft Server 2008 R2)、Windows Server 2012 R2 または Windows Server 2016 ベースのデスクトップが含まれています。これまでにない拡張性とシンプルな管理が実現されており、4 ノードの Cisco HyperFlex クラスタで、Citrix XenDesktop Provisioning Services または Machine Creation Services による Windows 10 デスクトップ (450)、完全クローン

デスクトップ (450)、XenApp サーバ ベース型デスクトップ (600) をプロビジョニングできます。

本ドキュメントを利用することで、このソリューションを導入するお客様に対して、推奨されるベスト

プラクティスとサイジングに関するガイドラインも提供します。

このソリューションでは、450 の仮想デスクトップ マシンを 5 分以内で起動させ、ユーザが就業開始するような、HyperFlex 上の仮想ワークスペースを利用開始するケースでも、大きな遅延が発生しないようにします。

これまでの HyperFlex に関する Cisco Validated Design (CVD) での分析の結果、Cisco UCS B200 M5、Cisco UCS C220 M5、Cisco UCS C240 M5 を使用した HyperFlex ハイパーコンバージド ハイブリッド構成ノード 8 台のクラスタ サイズの制限を上回るリニア スケーラビリティが確認されています。Cisco HXAF220 M5 または Cisco HXAF240 M5 ノードで HX Data Platform 3.0.1 を実行する新しい HyperFlex オール フラッシュ

システムでは、N+1 のサーバ耐障害性を備えた上で、クラスタあたりのナレッジ ワーカー ユーザ数を最大 1,000 に拡張できます。

このソリューションでは、ハードウェア アクセラレーション グラフィックのワークロードもサポートしています。Cisco HyperFlex HXAF240c M5 ノード、および Cisco UCS C240 M5 コンピューティング サーバでは、

それぞれ最大 2 枚の NVIDIA M10 カードまたは P40 カードをサポートできます。Cisco UCS B200 M5 サーバでは、高密度、高パフォーマンスのグラフィック ワークロード用に、最大 2 枚の NVIDIA P6 カードをサポートします。この機能と Citrix XenDesktop との統合方法の詳細については、NVIDIA GPU およびソフトウェアを使用した第 5 世代サーバに関する『Cisco Graphics White Paper』[英語] を参照してください。

本ソリューションにより、仮想デスクトップを使用するエンド ユーザに対して非常に優れた操作性が提供されます。Login VSI 4.1.25 を使用して Knowledge Worker ワークロードをベンチマーク モードで評価したところ、テストしたすべての提供方法で、エンドユーザの反応時間を示す平均指数が 1 秒を下回りました。これは業界でも最も高い性能にあることを示しています。

はじめに

データセンター設計の分野における最近の傾向としては、ハイパーコンバージド インフラストラクチャを小規模ながら初めて、細かく拡張できることが求められつつあります。事前検証済みの IT プラットフォームに合わせて仮想化をもちいることで、あらゆる規模のお客様がこの新しい技術を使用した「ジャストインタイムのインフラ

提供」を模索しています。Cisco HyperFlex ハイパー コンバージド ソリューションでは、導入時間を短縮できるため、俊敏性の向上とコストの削減が可能です。最高品質のストレージ、サーバ、ネットワーク コンポーネントを使用して、デスクトップ仮想化のワークロード処理基盤として動作し、迅速かつ着実な導入とスケール アウトを可能とする効率的なアーキテクチャ設計が実現します。

対象読者

対象読者としては、セールス エンジニア、フィールド コンサルタント、プロフェッショナル サービス、IT

マネージャ、パートナー エンジニアリング、およびインフラストラクチャにより IT の効率向上と革新を

実現したいお客様が挙げられますが、それらに限定されるわけではありません。

このドキュメントの使用目的

このドキュメントは、Cisco HyperFlex オールフラッシュ システムの Cisco Validated Design (CVD) として、段階的な設計、構成、実装について説明します。この Cisco HyperFlex オールフラッシュ システムでは、Cisco UCS 6300 シリーズ ファブリック インターコネクトおよび Cisco Nexus 9300 シリーズ スイッチを使用した Citrix XenDesktop/XenApp のワークロードが 4 つ別個に実行されます。

最新情報

Cisco HyperFlex オールフラッシュ システムの Cisco Validated Design で、第 5 世代 UCS をベースにした HyperFlex システムに搭載可能なインテル Xeon スケーラブル ファミリー プロセッサーをベースとした仮想

デスクトップ インフラストラクチャの検証結果をご案内するのは、今回が初めてとなります。次の内容が

含まれます。

· Cisco Nexus 9000 と Cisco HyperFlex を使用する場合の Cisco UCS 3.2(3)および Cisco HyperFlex Data Platform 3.0.1a サポートの検証。

· Microsoft Hyper-V 2016

Citrix XenDesktop 7.16 Persistent デスクトップと Citrix Machine Creation Services

Cisco HX Data Platform を正常にインストールするには、特定のソフトウェアおよびハードウェアの

バージョン、ネットワーク設定が必要です。すべての要件については、Cisco HyperFlex Systems Getting Started Guide [英語] を参照してください。

ハードウェアとソフトウェアのすべての依存関係の一覧については、Cisco UCS Manager の Web ページを参照してください。Hardware and Software Interoperability for Cisco HyperFlex HX-Series [英語]

データセンターの市場分野は、業界標準のシステム上で動作する仮想化の進んだプライベート、パブリック、

ハイブリッド クラウド コンピューティング モデルに移行しつつあります。こうした環境では、管理が容易で

拡張性に優れ、繰り返し使用可能な統一的な設計ポイントが必要になります。

このような要因から、事前設計されたコンピューティング、ネットワーキング、ストレージの構成要素に対する

ニーズが生じ、初期設計のコスト削減、管理のシンプル化、水平スケーラビリティ、高い使用率の実現への最適化が求められています。

使用例として以下が挙げられます。

· 大企業のデータセンター(障害発生時の対象範囲は小さい)

· サービス プロバイダーのデータセンター(障害発生時の対象範囲は小さい)

· 一般企業・期間の汎用的データセンター

· 地方オフィス/分散環境

· 小中規模における独立、個別展開

この Cisco Validated Design では、Microsoft Server 2016 をベースとした Citrix XenDesktop Microsoft Windows 10 仮想デスクトップと Citrix XenApp サーバ デスクトップ セッション両方の統合基盤として機能

するハードウェアとソフトウェアの定義・設定情報を含んでいます。単一システムとして、Cisco HyperFlex

ハードウェアおよびデータ プラットフォーム ソフトウェア、Cisco Nexus® スイッチ、Cisco Unified Computing System (Cisco UCS®)、Citrix XenDesktop、Microsoft Hyper-V を対象とした複合ワークロード ソリューションが含まれます。設置面積は、業界で標準的な 42U ラックシステムの 8 ラック ユニット分に相当し、

ネットワーキング コンポーネント、コンピューティング コンポーネント、ストレージ コンポーネントなどに適した設計となっています。Cisco Nexus スイッチおよび Cisco UCS ファブリック インターコネクトには充分なポート密度があり、ネットワーク コンポーネントに複数の HyperFlex クラスタを搭載し、単一の Cisco UCS ドメインとすることが可能です。

Cisco Validated Design アーキテクチャの主な利点は、お客様の要件に合わせて環境をカスタマイズできることです。要件や要求の変化に合わせて簡単に拡張でき、スケール アップ(Cisco Validated Design ユニットに

リソースを追加)とスケール アウト(Cisco Validated Design ユニット自体を追加)の両方が可能です。

このドキュメントで詳しく説明するリファレンス アーキテクチャでは、ハイパーコンバージド デスクトップ

仮想化ソリューションの特長として復元力、費用面でのメリット、導入の容易さが強調されています。単一の

インターフェイスで複数のプロトコルを利用することができ、まさに一度接続すれば事足りるアーキテクチャ

であることから、顧客の選択と投資保護が実現します。

シスコと Microsoft 社のテクノロジーを結集することにより、効率性と堅牢性が高く、手頃なデスクトップ

仮想化ソリューションが生まれました。このソリューションは、仮想デスクトップとホステッド共有デスクトップが混在する導入をサポートし、さまざまな使用例に対応できます。ソリューションの主要コンポーネントには、

次のようなものがあります。

· 同じサイズで、より強力に。Cisco HX シリーズ ノードは、768 GB の 2666 Mhz メモリを備えた

デュアル 18 コア 2.3 GHz Intel Xeon (Gold 6140) スケーラブル ファミリー プロセッサーと Citrix XenDesktop を搭載しており、同一ハードウェアの過去にリリースされた世代の製品に比べ、より多くの

仮想デスクトップをサポートします。さらに、この調査で使用された Intel Xeon Gold 6140 18 コア

スケーラブル ファミリー プロセッサーを利用したケースでは、サーバごとの容量の増加とコストのバランスが実現されました。

· デザインに組み込まれたハイ アベイラビリティによる耐障害性。仮想デスクトップおよび

インフラストラクチャ ワークロード用に、複数の Cisco HX シリーズ ノード、Cisco UCS ラック サーバ、Cisco UCS ブレード サーバをベースとして、さまざまな設計が行われており、テストされたあらゆる

ペイロードに対して、N+1 のサーバ耐障害性が考慮されています。

· 厳しいブート シナリオで限界に対するストレス テストを実施。450 ユーザのホステッド仮想

デスクトップと 600 ユーザのホステッド共有デスクトップが混在する環境をブートし、5 分以内に XenDesktop Studio への登録が完了しました。コールド スタートが非常に高速で安定したデスクトップ仮想化システムをお客様に提供できます。

· シミュレーションされたログイン ストームで限界に対するストレス テストを実施。450 人のユーザ全員がログインして、プロセッサが過負荷になったり、メモリまたはストレージ リソースを使い果たしたり

することなく、ワークロードは 48 分の間、定常状態で実行されました。非常に要求の厳しいログイン

および起動ストームを簡単に処理できるデスクトップ仮想化システムをお客様に提供できます。

· データセンター向けの非常にコンパクトなコンピューティング。Cisco Nexus スイッチと Cisco

ファブリック インターコネクトを含んだ初期段階のシステム構成は、8 ラック ユニットで 450 ユーザを

サポートできるようになっています。1 つまたは複数のノードを追加することで、Citrix XenDesktop の

ユーザを、クラスタスケール上の上限(現在はハイパーコンバージド ノード 16、コンピューティング専用ノード 16)に達するまで Cisco HyperFlex クラスタに段階的に追加できます。

· 100 % の仮想化:この CVD のデザインでは、Microsoft Hyper-V 2016 での 100 % の仮想化が検証済み

です。仮想デスクトップ、ユーザ データ、プロファイル、サポートするすべてのインフラストラクチャ

コンポーネント(Active Directory、SQL サーバ、Citrix XenDesktop コンポーネント、XenDesktop VDI

デスクトップ、XENAPP サーバを含む)が仮想マシンとしてホストされました。これにより、システム全体が Cisco HyperFlex ハイパーコンバージド インフラストラクチャとステートレスな Cisco UCS HX

シリーズ サーバで実行されることになり、お客様にメンテナンス性と容量追加における高い柔軟性を

提供します(ソリューションのキャパシティを最大に高め、最適な経済性を追求するため、VM の

インフラストラクチャは HX クラスタの外側の Cisco UCS C220 M4 ラック サーバ 2 台でホストされています)。

· シスコのデータセンターの管理:シスコは、シンプルな拡張性、一貫性の保証、容易なメンテナンスを

実現する新しい Cisco UCS Manager 3.2(2) ソフトウェアによって、業界におけるリーダーシップを維持しています。また、Cisco UCS Manager、Cisco UCS Central、Cisco UCS Director の継続的な開発に取り組んでおり、ローカル側、Cisco UCS ドメイン間、全世界における顧客環境の一貫性を確実なものとしています。Cisco UCS ソフトウェア スイートを提供することで、導入/運用管理をさらにシンプルにし、顧客組織におけるコンピューティング、ストレージ、ネットワーキングの各分野の専門家が、制御できる範囲を引き続き広げられるようにします。

· Cisco 40G ファブリック:40G ユニファイド ファブリックには、6300 シリーズ ファブリック

インターコネクトに関する追加検証が加えられ、より厳しいワークロード テストを実施しながら、

優れたユーザ応答時間が維持されました。

· Cisco HyperFlex Connect (HX Connect):HyperFlex v2.5 では、HTML 5 をベースとした新しい Web UI が導入され、Cisco HyperFlex の主要管理ツールとして利用可能となっています。これはクラスタ上で

一元化された制御ポイントとして機能します。管理者はボリュームの作成、データ プラットフォームの状態を監視、リソース使用率を管理できます。またこのデータを使用して、クラスタをいつ拡張する必要があるかを予測することもできます。

· Cisco HyperFlex ストレージのパフォーマンス:Cisco HyperFlex では、業界トップクラスの

ハイパーコンバージド ストレージ性能が実現されており、相当に負荷の高い I/O バースト(ログイン ストームなど)でも効率的に処理できます。低遅延で書き込みスループットが高く、シンプルで柔軟なビジネス継続性を実現し、デスクトップ単位のストレージ コストの削減を支援します。

· Cisco HyperFlex の俊敏性:Cisco HyperFlex システムにより、ユーザがインフラストラクチャに対してシームレスにストレージを追加、アップグレード、削除でき、仮想デスクトップの要件を満たせるように

なります。

· パフォーマンスと拡張性の最適化。ホステッド共有デスクトップ セッションの場合、仮想マシンに割り

当てられた vCPU の数が、サーバ上で使用可能なハイパースレッド(論理)コアの数を超えない場合に最高のパフォーマンスが得られました。つまり、最高のパフォーマンスは、仮想化 RDS システムを実行して

いる仮想マシンに対して、限度を超えた CPU リソースをコミットしない場合に得られます。

シスコ デスクトップ仮想化ソリューション:データセンター

進化する職場環境

今日の IT 部門は、急速に進化する職場環境に直面しています。海外の請負業者、分散したコールセンターの運営、ナレッジワーカーとタスク ワーカー、パートナー、コンサルタント、世界各地から時間を問わず接続してくる

パートナー、コンサルタント、幹部など、ユーザの多様化と地理的分散はますます進んでいます。

こうしたユーザのモバイル化も進み、従来のようにオフィスだけでなく、社内の会議室やホーム オフィス、

移動中やホテル、さらにはコーヒー ショップなどで仕事する従業員が増えています。また、従業員は、

増え続ける多様なクライアント コンピューティング デバイスやモバイル デバイスから、自分の好みのデバイス

を選べることも望んでいます。こうした傾向から IT 部門にますます求められるのは、企業データの保護と、

ユーザ、エンドポイント デバイス、デスクトップ アクセスの複合的なシナリオによるデータの漏洩や損失の防止です(図 1)。

これらの課題は、古くなった PC や制限のあるローカル ストレージに対応するためのデスクトップ更新サイクルや、新しいオペレーティング システム(特に Microsoft Windows 10 や生産性ツール、Microsoft Office 2016)への移行によって複雑化しています。

図 1 シスコ データセンター パートナー コラボレーション

デスクトップ仮想化を推進する主な要素として、制御の向上と管理コストの削減によるデータ セキュリティの

向上、キャパシティの拡大・縮小、TCO の削減が挙げられます。

シスコ デスクトップ仮想化における重点項目

シスコは、優れたデスクトップ仮想化データセンター インフラストラクチャを提供するため、シンプル化、

セキュリティ、拡張性という 3 つの主要要素を重視しています。プラットフォームのモジュール化され、連係するソフトウェアが、シンプルで、セキュアで、スケーラブルなデスクトップ仮想化プラットフォームを実現します。

シンプル化

Cisco UCS と Cisco HyperFlex により、業界標準のコンピューティングに対して、先進的な新しいアプローチを提供し、デスクトップ仮想化におけるデータセンター インフラストラクチャの中核を担います。Cisco UCS の

数多くの機能および利点の代表的な例として、必要なサーバ数やサーバあたりで使用されるケーブル数が大幅に

削減されること、および Cisco UCS サービス プロファイルを通してサーバを迅速に導入または

再プロビジョニングできることが挙げられます。管理が必要なサーバやケーブル数が削減され、サーバおよび仮想デスクトップ プロビジョニングが合理化されることによって、操作が大幅にシンプル化されます。

Cisco UCS Manager サービス プロファイルとシスコ エコパートナー ソリューションのクローニングを利用すると、数千ものデスクトップを数分でプロビジョニングできます。このアプローチにより、エンド ユーザの生産性が高まり、ビジネスの俊敏性が向上するため、IT リソースを他のタスクに割り当てることができます。

Cisco UCS Manager は、データセンターで日常的に生じるサーバ、ネットワーク、ストレージ アクセス

インフラストラクチャの構成やプロビジョニングなどのエラーが発生しやすい操作を自動化します。さらに、1 RU あたりのメモリ・CPU 密度の高い Cisco UCS B シリーズ ブレード サーバ、C シリーズ、HX シリーズ ラック

サーバにより、高いデスクトップ密度が実現し、サーバ インフラストラクチャに求められる要件を軽減することができます。

シンプル化は、デスクトップ仮想化を実装する際の問題を減らす上でも役立ちます。シスコと Microsoft 社などをはじめとするテクノロジー パートナーが、HyperFlex などの事前定義済みハイパーコンバージド

アーキテクチャ インフラストラクチャ パッケージを含む検証済み統合アーキテクチャを開発しました。シスコ デスクトップ仮想化ソリューションは、Microsoft Hyper-V を使用してテストされています。

安全性

仮想デスクトップは本質的に従来の物理的なものよりもセキュアですが、セキュリティに関する新たな課題も伴います。ミッションクリティカルな Web サーバやアプリケーション サーバと、仮想デスクトップなどが共通

インフラストラクチャを使用している場合、セキュリティの脅威の上で高いリスクを負うようになりました。

仮想マシン間でのトラフィックが、セキュリティ面での重要な検討課題となっています。特に、Microsoft Live Migration のようにサーバ インフラストラクチャ内を仮想マシンが移動する場合など、動的な環境において、IT マネージャがリスクに対処する必要が生じています。

つまり、拡大されたコンピューティング インフラストラクチャにおける仮想マシンのモビリティの動的かつ流動的な性質を考慮すると、デスクトップ仮想化により、ポリシーやセキュリティを仮想マシン レベルで認識する

必要性が大きく高まります。新しい仮想デスクトップを容易に増加させることが可能になったことが、仮想化対応のネットワークおよびセキュリティ インフラストラクチャの重要性を高めています。デスクトップ仮想化のためのシスコのデータセンター インフラストラクチャ(Cisco UCS および Cisco Nexus ファミリ ソリューション)では、デスクトップからハイパーバイザまで包括的に対応したセキュリティを通して、データセンター、

ネットワーク、およびデスクトップのセキュリティを強化します。セキュリティは、仮想デスクトップの

セグメンテーション、仮想マシン対応のポリシーや管理、および LAN や WAN のインフラ全体のネットワーク

セキュリティによって強化されます。

拡張性

デスクトップ仮想化ソリューションは拡大を続けています。したがって、そのような拡大に応じて、

ソリューションの規模の拡張や推定が可能でなければなりません。シスコ デスクトップ仮想化ソリューションは、デスクトップ密度(サーバごとのデスクトップ数)が高く、サーバを追加することでほぼリニアに性能が増加します。シスコのデータセンター インフラストラクチャが提供する柔軟なプラットフォームを利用すると、このような拡大にも対応でき、ビジネスの俊敏性が向上します。Cisco UCS Manager のサービス プロファイルにより、

オンデマンドでのデスクトップのプロビジョニングが可能となり、数千単位のデスクトップの展開が、数十単位

での展開と同じように容易になります。

Cisco HyperFlex サーバは、ほぼリニアに性能を向上させ、規模を拡大することができます。Cisco UCS には、特許取得済みの Cisco 拡張メモリ テクノロジーが実装されており、より少ないソケットで大きなメモリ面積を

実現しています(2 および 4 ソケットのサーバで最大 1.5 テラバイト (TB) の拡張性を実現)。構成要素として

ユニファイド ファブリック テクノロジーを使用しており、Cisco UCS サーバでの集約帯域幅は、サーバごとに

最大 80 Gbps にまで拡張できます。また、ノースバウンド Cisco UCS ファブリック インターコネクトでは、

ラインレートでの 2 テラビット/秒 (Tbps) での送信が可能です。これにより、デスクトップ仮想化の I/O と

メモリにおけるボトルネックの発生を防ぎます。Cisco UCS は高性能と低遅延を実現したユニファイド

ファブリックベース ネットワーキング アーキテクチャであり、高精細ビデオやコミュニケーション トラフィックなどの非常に通信量の多い仮想デスクトップ トラフィックをサポートします。さらに、Cisco HyperFlex は、シスコ

デスクトップ仮想化ソリューションの一部として、起動時やログイン ストーム時のデータの可用性と最適な

パフォーマンスを維持します。Citrix XenDesktop や Cisco HyperFlex ソリューションをベースとした最近の Cisco Validated Design では、拡張性とパフォーマンスが重視されており、450 以上のホステッド仮想デスクトップとホステッド共有デスクトップが 5 分以内に起動されます。

Cisco UCS および Cisco Nexus データセンター インフラストラクチャでは、デスクトップ仮想化、

データセンター アプリケーション、クラウド コンピューティングをサポートする、サーバ、ネットワーク、

およびストレージ リソースの透過的拡張機能を備えた、成長のための理想的なプラットフォームが提供されます。

節約と成功

簡素化された、安全性と拡張性の高いデスクトップ仮想化向けシスコ データセンター インフラストラクチャでは、他のアプローチと比べて時間とコストを節約できます。Cisco UCS により、サーバあたり仮想デスクトップ密度が業界トップレベルの水準で提供されます。そして、導入コスト (CapEx) と運用コスト (OpEx) の両方が

削減され、早期の投資回収および継続的なコスト削減(投資効果 (ROI) の向上と総所有コストの削減)が実現します。また、Cisco UCS アーキテクチャとシスコ ユニファイド ファブリックにより、サーバごとの必要な

ケーブル数やポート数が減ることで、より低コストのネットワーク インフラストラクチャを構築できます。

また、ストレージの階層化と重複排除テクノロジーによって、ストレージ コストを下げ、デスクトップ ストレージのニーズを最大 50 % にまで削減します。

デスクトップ仮想化対応の Cisco HyperFlex を利用することで、導入が簡素化され、生産性発揮までの時間が

短縮され、ビジネスの俊敏性が向上します。IT スタッフおよびエンド ユーザは迅速に生産性を向上させることができ、企業が、仮想デスクトップを必要に応じて時間や場所を問わず導入できるため、新規のビジネス チャンスに迅速に対応できます。シスコの高性能なシステムとネットワークは物理 PC デスクトップ環境に近いユーザ

エクスペリエンスを実現し、ユーザは時と場所を問わず生産性を発揮できます。

組織のデスクトップ仮想化の効果を測定するには、通常、直近および長期での効率性や有効性を確認します。

シスコ デスクトップ仮想化ソリューションは非常に効率性が高く、迅速な導入が可能な上、必要なデバイスやケーブルの数が少ないため、コストを削減できます。また、エンド ユーザの選択したデバイスに必要なサービスが提供され、同時に IT の運用、管理、データ セキュリティも向上するため、大変高い効果が見込めます。このような効果は、仮想化分野を主導するパートナーとシスコとの業界内でも最高のパートナーシップと設計のテストや検証を元に実現されており、ソリューション ライフサイクルを通じて顧客を支援します。また、デスクトップ仮想化向けプラットフォームとして、安全かつ柔軟で拡張可能なシスコのプラットフォームを使用することで、長期的な効果を担保します。

最終的には、デスクトップ仮想化製品のそれぞれのエンド ユーザが、優れたエクスペリエンスを享受できるかが評価の基準になります。Cisco HyperFlex ではクラス最高の性能が提供されており、1 秒を切るベースライン応答時間とフル ロード時の 1 秒足らずの平均指数応答時間が実現されています。

使用例

· 医療:デスクトップと端末間のモビリティ、コンプライアンス、コスト

· 官公庁:テレワーキング導入、ビジネス継続性、業務の連続性 (COOP) トレーニング センター

· 金融:リテール バンクの IT コスト削減、保険代理店、コンプライアンス、プライバシー

· 教育:幼稚園から高校までの生徒のアクセス、高等教育、リモート学習

· 地方自治体:機関間の IT およびサービスの統合、セキュリティ

· 小売:ブランチオフィス IT コストの削減およびリモート ベンダー

· 製造:タスク ワーカーおよびナレッジ ワーカーと海外請負業者

· Microsoft Windows 10 への移行

· グラフィック要件の厳しいアプリケーション

· セキュリティおよびコンプライアンスの取り組み

· リモート オフィスおよびブランチ オフィス、またはオフショア施設の開設

· 合併と買収などによるクライアント基盤の統合

図 2 では、Cisco Validated Design コンポーネント上に構築された Hyper-V 2016 における Citrix XenDesktop とネットワーク接続について示しています。この参照アーキテクチャは、ワイヤワンス (wire-once) 戦略を強化するものです。新たなストレージがアーキテクチャに追加され、ホストから Cisco UCS ファブリック

インターコネクトまでの配線をやり直す必要がありません。

図 2フルスケール、単一 UCS ドメイン、シスコのシングル ラック アーキテクチャ

物理トポロジ

Cisco HyperFlex System は、1 組の Cisco UCS 6200/6300 シリーズ ファブリック インターコネクトから

構成されており、クラスタあたり最大 16 の HXAF シリーズ ラック マウント サーバを備えています。さらに、クラスタごとに最大 16 のコンピューティング専用サーバを追加できます。Cisco UCS 5108 ブレード シャーシを追加することで、ハイブリッド クラスタ設計において追加のコンピューティング リソースに Cisco UCS B200 M5 ブレード サーバを使用できます。また、Cisco UCS C240 と C220 ラックサーバを、追加の

コンピューティング リソースに使用することもできます。1 組のファブリック インターコネクトに、最大 8 つの HX クラスタを個別に構築・共存させることが可能です。ファブリック インターコネクトは、すべての HX

シリーズ ラック マウント サーバとすべての Cisco UCS 5108 ブレード シャーシの両方に接続されます。

インストール時には、ファブリック インターコネクトから顧客のデータセンター ネットワークに、

ノースバウンド ネットワーク接続とも呼ばれるアップストリーム ネットワーク接続が行われます。

![]() この調査では、Cisco 6332-16UP ファブリック インターコネクトを Cisco Nexus 93108YCPX スイッチにアップリンクしました。

この調査では、Cisco 6332-16UP ファブリック インターコネクトを Cisco Nexus 93108YCPX スイッチにアップリンクしました。

図 3 および図 4 では、ハイパーコンバージド トポロジ、ハイブリッド ハイパーコンバージド トポロジ、

コンピューティング専用トポロジについて示しています。

図 3 Cisco HyperFlex の標準トポロジ

図 4Cisco HyperFlex ハイパーコンバージドおよびコンピューティング専用ノード トポロジ

ファブリック インターコネクト

ファブリック インターコネクト (FI) は、管理クラスタとして動作する 2 つのユニットのペアとして展開され、

A サイド ファブリックおよび B サイド ファブリックからなる 2 つの別個のネットワーク ファブリックを

構成します。そのため、設計上の要素表記として、FI A や FI B またはファブリック A、ファブリック B という

呼称がもちいられます。これらのファブリック インターコネクトは両方とも常にアクティブで、冗長構成や

高可用性構成のためのネットワーク ファブリック上でデータを通過させます。Cisco UCS Manager などの

管理サービスにおいても、2 つの FI がクラスタ形式で提供されます。つまり、一方の FI がプライマリでもう一方の FI がセカンダリとなり、クラスタ化されたローミング IP アドレスが付与されます。このプライマリ/

セカンダリの関係は管理クラスタに関してのみであり、データ伝送には影響を与えません。

ファブリック インターコネクトには以下のポートがあり、Cisco UCS ドメインの適切な管理のためには、それらのポートに接続する必要があります。

· Mgmt:GUI または CLI ツールを通じて、ファブリック インターコネクトや Cisco UCS ドメインを管理する際に使用するポート (10/100/1000 Mbps) です。また、ドメイン内の管理対象サーバへのリモート KVM、IPMI、SoL セッションにも使用されます。これは通常、管理ネットワークに接続されます。

· L1:Cisco UCS 管理クラスタを構成する際のクロス接続ポートです。これは、RJ45 プラグを備えた標準の CAT5/CAT6 イーサネット ケーブルを使用して、ファブリック インターコネクトのペアの L1 ポートに直接接続されます。スイッチやハブに接続する必要はありません。

· L2:Cisco UCS 管理クラスタを構成する際のクロス接続ポートです。これは、RJ45 プラグを備えた標準の CAT5/CAT6 イーサネット ケーブルを使用して、ファブリック インターコネクトのペアの L2 ポートに直接接続されます。スイッチやハブに接続する必要はありません。

· Console:ファブリック インターコネクトに直接コンソール アクセスを行うための RJ45 シリアル

ポートです。通常、RJ45 アダプタを備えたシリアル ケーブルを使用して、FI の初期設定プロセスを実施

する際に使用されます。また、ターミナル アグリゲータ、またはリモート コンソール サーバ デバイス

にも接続できます。

HX シリーズ ラック マウント サーバ

HX シリーズ コンバージド サーバは、Cisco UCS ファブリック インターコネクトに、直接接続モードで

接続されます。このオプションを使用すると、Cisco UCS Manager は、管理通信とデータ通信の両方にシングル ケーブルを使用して HX シリーズ ラックマウント サーバを管理できます。HXAF220C-M5SX と HXAF240C-M5SX サーバの両方で、Cisco VIC 1387 ネットワーク インターフェイス カード (NIC) を、デュアル 40 ギガビット

イーサネット (GbE) ポートを備えたモジュール型 LAN on Motherboard (MLOM) スロットに取り付けて構成

することができます。標準接続、および情報接続を行うには、VIC 1387 のポート 1 を FI A のポートにつなぎ、VIC 1387 のポート 2 を FI B のポートにつなぎます(図 5)。

![]() このケーブル配線に誤りがあると、エラー、検出の失敗、冗長接続の失敗につながる可能性があります。

このケーブル配線に誤りがあると、エラー、検出の失敗、冗長接続の失敗につながる可能性があります。

図 5 HX シリーズ サーバの接続

Cisco UCS B シリーズ ブレード サーバ

ハイブリッド HyperFlex クラスタには、コンピューティング容量の強化策として、Cisco UCS B200 M5

ブレード サーバも 1 ~ 8 台組み合わせることができます。他の Cisco UCS B シリーズ ブレード サーバと同様に、Cisco UCS B200 M5 は、Cisco UCS 5108 ブレード シャーシ内に取り付ける必要があります。ブレード

シャーシには、1 ~ 4 基の電源装置と 8 台のモジュール型冷却ファンを装着できるようになっています。シャーシの背面には、シスコ ファブリック エクステンダを取り付けるためのベイが 2 つあります。ファブリック

エクステンダ(一般的に IO モジュール、または IOM とも呼ばれます)は、シャーシをファブリック インターコネクトに接続します。内部的には、シャーシのバック プレーンにある各ブレード サーバに取り付けられた Cisco VIC 1340 カードに、ファブリック エクステンダが接続されます。標準的な方法で接続するには、左側の IOM または IOM 1 から 10 GbE リンク(1 ~ 4)か 40 GbE リンク(ネイティブ X 2)を FI A に接続し、右側の IOM または IOM 2 から同じ数の 10 GbE リンクを FI B に接続します(図 6)。ケーブルの設定が不正な場合は、エラー、検出の失敗、冗長接続の失敗につながる可能性があります。

図 6Cisco UCS 5108 シャーシの接続

論理ネットワークの設計

Cisco HyperFlex システムでは、通信パスが 4 つの定義ゾーンに分類されています(図 6)。

· 管理ゾーン:このゾーンは、物理ハードウェア、ハイパーバイザ ホスト、ストレージ プラットフォーム

コントローラ仮想マシン (SCVM) を管理する際に必要な接続で構成されます。これらのインターフェイスと IP アドレスは、LAN や WAN の全体で、HX システムを管理する担当者全員で利用できる必要があります。このゾーンでは、ドメイン ネーム システム (DNS)、Network Time Protocol (NTP) サービスへのアクセス権限があり、セキュア シェル (SSH) 通信が許可されている必要があります。このゾーンは、複数の物理

コンポーネントと仮想コンポーネントからできています。

- ファブリック インターコネクト管理ポート。

- Cisco UCS 外部管理インターフェイス。サーバやブレードによって使用され、FI 管理ポートを通じて応答します。

- Hyper-V ホスト管理インターフェイス。

- ストレージ コントローラ VM 管理インターフェイス。

- ローミング HX クラスタ管理インターフェイス。

· VM ゾーン:このゾーンは、HyperFlex ハイパーコンバージド システム内で実行されるゲスト VM へのサービス ネットワーク IO に必要な接続で構成されます。通常、このゾーンには、ネットワークのアップリンクを介して Cisco UCS ファブリック インターコネクトにトランクされる複数の VLAN が含まれており、802.1Q VLAN ID のタグが付けられます。これらのインターフェイスと IP アドレスは、LAN や WAN の全体を通じて、HX システムのゲスト VM と通信する必要があるスタッフやコンピュータ

エンドポイントのすべてで利用できるようになっている必要があります。

· ストレージ ゾーン:このゾーンは、Cisco HX Data Platform ソフトウェア、Hyper-V ホスト、および

ストレージ コントローラ VM が HX 分散データ ファイルシステムにサービス提供するために使用する接続で構成されます。適切に運用するためには、これらのインターフェイスと IP アドレスが相互に通信できる必要があります。通常の運用では、このトラフィックはすべて Cisco UCS ドメイン内で発生しますが、

ハードウェア障害が生じた場合には、Cisco UCS ドメインのネットワーク ノースバウンドを通過する必要があります。そのため、HX ストレージ トラフィックに使用される VLAN は、Cisco UCS ドメインからの

ネットワーク アップリンクを通過し、FI B から FI A に到達するか、その逆が可能である必要があります。このゾーンは、基本的にはジャンボ フレームでのトラフィックになるため、Cisco UCS のアップリンク

でジャンボ フレームを有効にする必要があります。このゾーンには、複数のコンポーネントがあります。

- HX クラスタ内の各 HYPER-V ホストのストレージ トラフィックに使用する vmnic

インターフェイス。

- ストレージ コントローラ VM ストレージ インターフェイス。

- ローミング HX クラスタ ストレージ インターフェイス。

· ライブ マイグレーション ゾーン:このゾーンは、ホストからホストへのゲスト VM のライブ

マイグレーションを有効にするために、Hyper-V ホストによって使用される接続から構成されます。通常の運用では、このトラフィックはすべて Cisco UCS ドメイン内で発生しますが、ハードウェア障害が生じた場合には、Cisco UCS ドメインのネットワーク ノースバウンドを通過する必要があります。そのため、HX ストレージ トラフィックに使用される VLAN は、Cisco UCS ドメインからのネットワーク アップリンクを通過し、FI B から FI A に到達するか、その逆が可能である必要があります。

参照ハードウェア構成は次のとおりです。

· Cisco Nexus 93108YCPX スイッチ X 2

· Cisco UCS 6332-16UP ファブリック インターコネクト X 2

· HyperFlex Data Platform バージョン 3.0.1a を実行する Cisco HX シリーズ ラック サーバ X 4

デスクトップ仮想化の場合、導入には Microsoft Hyper-V を実行する Citrix XenDesktop が含まれます。設計に

おいては、永続デスクトップ/非永続デスクトップ用に大規模な構成要素が意図され、4 ノード構成ごとに次の

密度で提供されます。

· MCS を使用した Citrix XenDesktop Windows 10 非永続仮想デスクトップ X 450

![]() 今回の調査においては、すべての Windows 10 仮想デスクトップが 4 GB のメモリでプロビジョニングされました。通常、永続デスクトップのユーザは、より多くのメモリを必要とします。4 GB 以上のメモリが必要な場合、Cisco HXAF220c-M5SX HX シリーズ ラック サーバ上のセカンド メモリ チャネルが利用される

今回の調査においては、すべての Windows 10 仮想デスクトップが 4 GB のメモリでプロビジョニングされました。通常、永続デスクトップのユーザは、より多くのメモリを必要とします。4 GB 以上のメモリが必要な場合、Cisco HXAF220c-M5SX HX シリーズ ラック サーバ上のセカンド メモリ チャネルが利用される

必要があります。

ここで提供されるデータにより、顧客環境に合わせて VDI デスクトップを実行できるようになります。たとえば、

既存のサーバにドライブを追加することで、I/O キャパシティやスループットを改善することができます。もしくは、新しい機能を導入するために、特別なハードウェアやソフトウェア機能を追加することができます。このドキュメントでは、図 2 で示したベース アーキテクチャ導入の詳細な手順について案内しますこれらの手順には、物理的な

ネットワークのケーブリングやコンピューティング デバイス、ストレージ デバイスの設定などがすべて含まれます。

設定のガイドライン

このドキュメントでは、Cisco HyperFlex の仮想デスクトップにおけるさまざまな種類のワークロードに対して、Cisco Validated Design (CVD) での冗長構成や高可用性設定を行う際の詳細について説明します。どの冗長

コンポーネントが各手順で設定されるかを示す設定のガイドラインが提示されます。たとえば、Cisco Nexus A

および Cisco Nexus B は、設定される Cisco Nexus スイッチのペア メンバーを識別します。同様に、Cisco UCS 6332 ファブリック インターコネクトも識別されます。さらに、このドキュメントでは、複数の Cisco UCS

および HyperFlex ホスト(VM-Host-Infra-01、VM-Host-Infra-02、VM-Host-VDI-01 などのように連番で識別されます)をプロビジョニングするための詳細な手順について説明します。最後に、環境に関連する情報を、所定の手順で指定する必要がある点についてふれます。<text> がコマンド構造の一部として表示されます。

この項では、この調査で概要を示すソリューションで使用されているインフラストラクチャ コンポーネントに

ついて説明します。

Cisco Unified Computing System

Cisco UCS Manager (UCSM) は、Cisco Unified Computing System™ (Cisco UCS) と Cisco HyperFlex の

すべてのソフトウェアとハードウェアのコンポーネントを、直感的な GUI、コマンドライン インターフェイス (CLI)、XML API によって統合管理できる機能を備えています。一元管理機能を備えた単一の管理ドメインがあり、複数のシャーシや数千台もの仮想マシンを制御できます。

Cisco UCS は、コンピューティング、ネットワーキング、およびストレージ アクセスを統合した次世代のデータセンター プラットフォームです。仮想環境向けに最適化されており、業界標準のオープン テクノロジーを利用して設計されたもので、総所有コスト (TCO) の削減とビジネスの俊敏性強化を目的としています。このシステムは、低遅延のロスレス 40 ギガビット イーサネット ユニファイド ネットワーク ファブリックと、エンタープライズクラスの x86 アーキテクチャ サーバを統合します。これはすべてのリソースが単一の管理ドメインに集約された、統合型の拡張性に優れたマルチシャーシ対応のプラットフォームです。

Cisco Unified Computing System のコンポーネント

Cisco UCS の主なコンポーネントは、次のとおりです。

· コンピューティング:インテル® Xeon® スケーラブル ファミリー プロセッサーをベースとしたブレード サーバ、ラック サーバ、ハイパーコンバージド サーバをシステムに組み込んだ、まったく新しいクラスのコンピューティング システムをベースとする設計です。

· ネットワーク:このシステムは低遅延でロスレスの 40 Gbps ユニファイド ネットワーク ファブリック上で統合されています。このネットワーク基盤は、現状では LAN、SAN、高性能コンピューティング (HPC) ネットワークとして扱われている異なるネットワークを統合します。ユニファイド ファブリックにより、ネットワーク アダプタ、スイッチ、およびケーブルの数が減少し、電力と冷却の要件が緩和されるため、コスト削減につながります。

· 仮想化:仮想環境のスケーラビリティ、パフォーマンス、および運用制御を強化することで、仮想化の

可能性を最大限に活用します。シスコのセキュリティ、ポリシー適用、および診断機能は仮想化環境にまで拡張されており、変化するビジネス要件や IT 要件により適切に対応できます。

· ストレージ:Cisco HyperFlex ラック サーバにより、強力な HX データ プラットフォーム ソフトウェア

を使用した高性能で復元力の高いストレージを提供します。顧客は、耐障害性要件に応じて、少なくとも

3 つのノード(レプリケーション ファクタ 2/3)を展開できます。これらのノードは、HyperFlex

ストレージとコンピューティング クラスタを構成します。各ノードのオンボード ストレージはクラスタ レベルで集約され、すべてのノードで自動的に共有されます。

· 管理:Cisco UCS の特色は、あらゆるシステム コンポーネントを統合し、ソリューション全体を 1 つの大きなサーバ・ネットワーク・ストレージ リソースとして、Cisco UCS Manager ソフトウェアから管理できることです。すべてのシステムの構成プロセスや動作を管理できる直感的な GUI、CLI、堅牢な API を備えています。直近の開発結果として、Cisco Intersight というクラウド ベースの管理システムも用意されています。

Cisco UCS と Cisco HyperFlex は、次の機能を提供するように設計されています。

· TCO の削減と、ビジネスの俊敏性の向上。

· ジャストインタイムのプロビジョニングとモビリティのサポートによる、IT スタッフの生産性の向上。

· 単一の統合されたシステムにより、データセンターのテクノロジーを統合し、全体として管理、サービスを提供。

· 数百台の個別サーバと数千台の仮想マシンに対応する設計と要件に合わせて I/O 帯域幅を拡張できる拡張性。

· 業界のリーダー企業とのパートナー エコシステムによって支えられている業界標準を提供。

Cisco UCS Manager は、複数のブレード シャーシ、ブレード/ラック サーバ、および数千単位の仮想マシンに

わたる Cisco Unified Computing System のすべてのソフトウェア コンポーネントとハードウェア

コンポーネントを管理する、統合された組み込みソフトとしての管理機能を提供します。Cisco UCS Manager は、すべての機能にわたって管理情報にアクセスできる直感的な GUI、コマンドライン インターフェイス (CLI)、および XML API を介して Cisco UCS 全体を 1 つのエンティティとして管理します。

Cisco HyperFlex システムは、サーバおよびメモリ リソース、統合されたネットワーク接続、VM ストレージ用の高性能の分散ログ構造ファイル システム、仮想化サーバ用のハイパーバイザ ソフトウェア、これらが単一の Cisco UCS 管理ドメインに統合された、完結型の仮想サーバ プラットフォームです。

図 8Cisco HyperFlex システムの概要

バージョン 3.0.1 の拡張機能

新しいソフトウェア機能

このリリースでは、クラウド ネイティブのワークロードの中でもミッション クリティカルなもののサポートに

関して、大きな進展がありました。

· 複数のハイパーバイザ:VMware vSphere、Microsoft Hyper-V Server 2016 をサポートしています。

インストール要件と手順の詳細については、VMware 用 Cisco HyperFlex システム インストレーション

ガイド、および『Cisco HyperFlex Systems Installation Guide on Microsoft Hyper-V(Microsoft Hyper-V での Cisco HyperFlex System インストール ガイド)』を参照してください。

· ストレッチ クラスタ:単一の HyperFlex クラスタで 2 つのデータセンターをカバーすることで、高い

水準の可用性を可能とする機能です。詳細については、『Cisco HyperFlex Systems Stretched Cluster Guide(Cisco HyperFlex System ストレッチ クラスタ ガイド)』を参照してください。

· Kubernetes FlexVolume ドライバ:永続型ボリュームの Kubernetes ポッドへの自動プロビジョニングを有効にします。

· 復元力の向上:論理可用性ゾーン (LAZ) を有効にすることで、自動的にクラスタを分割し、ノードの

復元力を高め、ディスク障害に対処します。この機能は、HyperFlex クラスタに 8 つ以上のコンバージド ノードがある場合にのみ有効になります。クラスタが LAZ に対応している場合は、1 つのノードで同時に展開が行われます。詳細については、リリース 3.0(1a) の公開済みの問題を参照してください。

· ディザスタ リカバリ ワークフロー:Cisco HX Connect を使用したディザスタ リカバリ ワークフローの強化(計画/未計画の VM 移行)詳細については、『Cisco HyperFlex Systems Administration Guide, Release 3.0(Cisco HyperFlex System 管理ガイド)』を参照してください。

· REST API:HyperFlex REST API 開発者向けの追加ガイダンスとして、クイックスタート ガイドを Cisco DevNet に用意しています。詳細については、『Cisco HyperFlex Systems REST API Getting Started Guide(Cisco HyperFlex System REST API スタートアップ ガイド』を参照してください。

· リンク モード:vCenter の強化されたリンク モード機能を使用して、複数の環境用の HyperFlex

プラグインをサポートします。

新しいハードウェア機能

· HX 容量スケーリング オプションの拡張

- 大型フォーム ファクタ (LFF) HX M5 240 シャーシで、最大 12 台の 6 TB/8 TB ドライブをサポート

します。注:現在は、HX M5 240 ノードでのみサポートしています。詳細については、Cisco HyperFlex HX シリーズ スペック シートを参照してください。

- 18.06TiB の最大クラスタ キャパシティを備えた 1.8 TB SFF HDD を、ハイブリッド M5 エッジ

ノードでのみサポートします。詳細については、Cisco HyperFlex HX シリーズ スペック シートを参照してください。

- 強化されたノード拡張オプション:32 のコンピューティング ノードで、最大 32 のコンバージェンス(クラスタあたり)をサポートします。詳細については、Cisco HyperFlex HX シリーズ スペック

シートを参照してください。

· Intel Optane SSD のサポートにより、ドライブ レベルでの高いパフォーマンスと耐久性をサポートします。HyperFlex で最新のフラッシュ メモリ技術である 3D Xpoint の要件を満たしています。新しい

キャッシング ドライブ オプションとして、Intel Optane NVMe SSD HX-NVMEXP-I375 を追加しました。

![]() M5 オール フラッシュ構成でのみサポートされます。詳細については、次を参照してください。Cisco HyperFlex HX シリーズ スペック シート、『Cisco HX220c M5 HyperFlex Node Installation Guide(Cisco HX220c M5 HyperFlex ノード インストール ガイド)』、『Cisco HX240c M5 HyperFlex Node Installation Guide(Cisco HX240c M5 HyperFlex ノード インストール ガイド)』

M5 オール フラッシュ構成でのみサポートされます。詳細については、次を参照してください。Cisco HyperFlex HX シリーズ スペック シート、『Cisco HX220c M5 HyperFlex Node Installation Guide(Cisco HX220c M5 HyperFlex ノード インストール ガイド)』、『Cisco HX240c M5 HyperFlex Node Installation Guide(Cisco HX240c M5 HyperFlex ノード インストール ガイド)』

· HX240c M5 ノードは、従来の NVIDIA カードに加えて、AMD マルチユーザ GPU (MxGPU)

ハードウェア ベースのグラフィック仮想化をサポートします。AMD FirePro S7150 シリーズ GPU が HX240c M5 ノードで使用できるようになりました。これらのグラフィック アクセラレータにより、安全性とパフォーマンスに優れた、コスト効率の高い VDI 環境が有効になります。詳細については、次を参照してください。Cisco HyperFlex HX シリーズ スペック シート、『Cisco HX240c M5 HyperFlex Node Installation Guide(Cisco HX240c M5 HyperFlex Node インストール ガイド)』導入手順については、AMD GPU の導入を参照してください。

· HyperFlex Edge の構成を拡張:HyperFlex Edge の発注時の PID が新しくなり、より柔軟でシンプルな構成が可能になり、コストが削減できます。詳細については、Cisco HyperFlex HX シリーズ スペック シートを参照してください。

サポート対象バージョンおよびシステム要件

Cisco HX Data Platform を正常にインストールするには、特定のソフトウェアおよびハードウェアのバージョン、ネットワーク設定が必要です。

要件の一覧については、『Cisco HyperFlex Systems Installation Guide on Microsoft Hyper-V(Microsoft Hyper-V での Cisco HyperFlex System インストール ガイド)』を参照してください。

ハードウェアおよびソフトウェアの相互運用性

ハードウェアとソフトウェアの相互依存関係の一覧については、それぞれの Cisco UCS Manager リリース

バージョンの Cisco HyperFlex HX シリーズにおけるハードウェアおよびソフトウェアの相互運用性 [英語] を参照してください。

Microsoft Hyper-V のソフトウェア要件

ソフトウェア要件には、互換性のあるバージョンの Cisco HyperFlex システム (HX) コンポーネントと Microsoft サーバ コンポーネントを使用していることの確認が含まれます。

HyperFlex ソフトウェアのバージョン

HX コンポーネント(Cisco HX データ プラットフォーム インストーラ、Cisco HX データ プラットフォーム、Cisco UCS ファームウェア)が別々のサーバにインストールされています。HX ストレージ クラスタで使用される各サーバの各コンポーネントと、その中で使用される各サーバの各コンポーネントに互換性があることを確認します。

· 事前に設定された HX サーバに同じバージョンの Cisco UCS サーバ ファームウェアがインストールされていることを確認します。Cisco UCS ファブリック インターコネクト (FI) のファームウェア バージョンが異なっている場合は、『Cisco HyperFlex System アップグレード ガイド』を参照して、ファームウェア バージョンの調整手順について確認してください。

· M5:新しくハイブリッドまたはオール フラッシュ(Cisco HyperFlex HX240c M5 または HX220c M5)導入する場合、Cisco UCS Manager 3.2(3b) 以降がインストールされていることを確認します。

· SED ベースの HyperFlex システムの場合、M4 SED システムであれば、A バンドル

(インフラストラクチャ)と C バンドル(ラック サーバ)が、Cisco UCS Manager バージョン 3.1(3h) 以上であることを確認します。M5 SED システムであれば、すべてのバンドルが Cisco UCS Manager

バージョン 3.2(3b) 以上であることを確認します。

Cisco UCS ファブリック インターコネクト

Cisco UCS 6300 シリーズ ファブリック インターコネクトは、Cisco UCS の中核であり、システムの

ネットワーク接続と管理の機能を提供します。Cisco UCS 6300 シリーズは、ライン レート、低遅延、ロスレスの 40 ギガビット イーサネット、FCoE、ファイバ チャネル機能を提供します。

ファブリック インターコネクトは、Cisco UCS B シリーズ ブレード サーバ、Cisco UCS C-シリーズおよび HX

シリーズ ラックサーバ、Cisco UCS 5100 シリーズ ブレード サーバ シャーシの管理および通信の基盤となります。ファブリック インターコネクトに接続されているすべてのサーバは、可用性の高い単一の管理ドメインの

一部として管理されます。さらに、Cisco UCS 6300 シリーズは、ユニファイド ファブリックをサポートしているため、ドメイン内のすべてのブレードが LAN と SAN の両方に接続できます。

ネットワーキングでは、Cisco UCS 6300 シリーズはカットスルー アーキテクチャを使用し、パケット サイズや対応サービスに依存せず、すべてのポートで低遅延のラインレート 40 ギガビット イーサネット、2.56

テラビット (Tb) のスイッチング容量、シャーシあたり 320 Gbps の帯域幅をサポートします。この製品シリーズでは、シスコの低遅延でロスレスの 40 ギガビット イーサネット ユニファイド ネットワーク ファブリック機能をサポートし、これによりイーサネット ネットワークの信頼性、効率性、拡張性が向上します。ファブリック インターコネクトでは、ロスレス イーサネット ファブリックに対する複数のトラフィック クラスがブレード サーバからインターコネクトにかけてサポートされます。ネットワーク インターフェイス カード (NIC)、ホスト バス

アダプタ (HBA)、ケーブル、スイッチを統合可能な FCoE が最適化されたサーバ設計によって、TCO を大幅に削減できます。

図 9Cisco UCS 6332 ファブリック インターコネクト

図 10 Cisco UCS 6332-16UP ファブリック インターコネクト

Cisco HyperFlex HX シリーズ ノード

ソフトウェア デファインド インフラをベースとする Cisco HyperFlex システムでは、Cisco Unified Computing System (Cisco UCS) サーバによるソフトウェア デファインドのコンピューティング、強力な Cisco HX Data Platform を利用したソフトウェア デファインド ストレージ、そして Cisco Application Centric Infrastructure (Cisco ACI™) とも連携・統合可能な Cisco UCS ファブリックによるソフトウェア デファインド

ネットワーキングが一元化されています。こうしたテクノロジーにより接続とハードウェア管理を一元化することで、統合されたリソース プールをビジネス ニーズに合わせて提供できる、適応性の高い統合クラスタが実現します。

Cisco HyperFlex クラスタには(ディスク ストレージと共に)最低 3 つの HX シリーズ ノードが必要です。

データはこれらのうち最低 2 つのノードで複製され、3 番目のノードは単一ノードの障害時に運用を継続する上で必要になります。各ノードのディスク ストレージには 1 台の高性能 SSD ドライブが搭載されており、データ キャッシュと書き込み要求への迅速な応答 (ACK) を可能にしています。また、各ノードの最大データ容量には、プラットフォームの回転ディスクかエンタープライズ レベルの SSD の物理的な容量が備えられています。

Cisco UCS HXAF220c-M5S ラック サーバ

HXAF220c M5 サーバは、インテル® Xeon® プロセッサー スケーラブル ファミリ、24 個の 2666MHz DIMM 用 DIMM スロット、最大 128 GB の個別 DIMM 容量、および最大 3.0 TB の総 DRAM 容量を搭載した 1U

フォーム ファクタで Cisco HyperFlex ポートフォリオの機能を拡張します。

この構成の Cisco HyperFlex オール フラッシュ ノードは設置面積が小さく、ストレージ キャパシティ用として、起動ドライブとして動作する M.2 SATA SSD ドライブを 1 台、240 GB のソリッド ステート ドライブ (SSD) データ ロギング ドライブを 1 台、400 GB の SSD ログ書き込みドライブを 1 台、3.8 テラバイト (TB) もしくは 960 GB の SATA SSD ドライブを最大 8 台含んでいます。1 つの HX クラスタには、最小で 3 個、最大で 16 個のノードを構成できます。詳細については、Cisco HyperFlex HXAF220c-M5S スペックシートを参照してくだ

さい。

図 11 Cisco UCS HXAF220c M5SX ラック サーバの正面図

図 12 Cisco UCS HXAF220c-M5SX ラック サーバの背面図

Cisco UCS HXAF220c-M5S は、データセンターおよびリモート サイト向での高いパフォーマンスと柔軟性を

提供し、最適化を可能とします。このエンタープライズクラスのサーバは、Web インフラストラクチャから分散型データベースの処理サービスに関して妥協することなく、市場で最高レベルの性能、汎用性、密度を実現します。Cisco UCS HXAF220c-M5SX は、プログラム制御機能を備えた使いやすい Cisco UCS Manager ソフトウェアと、Cisco® Single Connect テクノロジーによる簡素化されたサーバ アクセスにより、ステートレスで実際の

処理サービスおよび仮想化での処理状況に合わせて迅速に実行することが可能です。インテル Xeon スケーラブル ファミリー プロセッサー製品ファミリを基盤とし、64 GB の DIMM を使用した場合、最大 1.5 TB のメモリ、最大 10 台のディスク ドライブを搭載でき、最大 40 Gbps の I/O スループットを実現します。Cisco UCS HXAF220c-M5S は、要求の厳しいアプリケーション処理の実行に必要とされる優れたパフォーマンス、柔軟性、I/O スループットを提供します。

Cisco UCS HXAF220c-M5S では、次の内容が提供されます。

· 最大 2 つのマルチコア インテル Xeon スケーラブル ファミリー プロセッサー。最大 56 プロセス コア

· 業界標準の DDR4 メモリ用 DIMM スロット 24 個、2666 MHz のメモリアクセス速度をサポート、合計で最大 1.5 TB のメモリ容量(64 GB DIMM 使用時)

· 10 台のホットプラグ対応 SAS および SATA HDD または SSD

· Cisco UCS VIC 1387、2 ポート、80 ギガビット イーサネットおよび FCoE:モジュラ型 (mLOM) 対応メザニン アダプタ

· Cisco FlexStorage ローカル ドライブ ストレージ サブシステム。柔軟なブートおよびローカル

ストレージ機能により、ハイパーバイザのインストールおよび起動が可能

· エンタープライズ クラスのパススルー RAID コントローラ

· Cisco FlexStorage モジュールの追加、変更、削除が容易

Cisco HyperFlex HXAF240c-M5SX ノード

この最適化されたキャパシティ構成には、最低限 3 つのノードが含まれています。クラスタ ストレージを補強

する SED SATA または SAS SSD ドライブが最大 23 台、240 GB SATA SSD ハウスキーピング ドライブが

1 台、400 GB SAS SSD キャッシング ドライブが 1 台、起動ドライブとして動作する M.2 SATA SSD

ドライブが 1 台構成可能です。詳細については、Cisco HyperFlex HXAF240c M5 ノード スペック シートを参照してください。

図 13 HXAF240c-M4SX ノード

HyperFlex HX220C-M4S ハイブリッド ノード

この設置面積の少ない構成には、最低限 3 つのノードが含まれており、クラスタ ストレージの容量を補強する 1.2 テラバイト (TB) SAS ドライブが 6 台、240 GB SSD ハウスキーピング ドライブが 1 台、480 GB SAS SSD キャッシング ドライブが 1 台、起動ドライブとして動作する 240 Gb SATA M.2 SSD 1 台構成可能です。詳細については、Cisco HyperFlex HX220c M5 ノード スペック シートを参照してください。

図 14 HX220C-M4S ノード

HyperFlex HX240C-M4SX ハイブリッド ノード

この最適化されたキャパシティ構成には、最低限 3 つのノードが含まれています。クラスタ ストレージを補強

する 1.2 TB SAS ドライブが最大 23 台、240 GB SSD ハウスキーピング ドライブが 1 台、1.6 TB SSD

キャッシング ドライブが 1 台、起動ドライブとして動作する 240 Gb SATA M.2 SSD が 1 台構成可能です。詳細については、Cisco HyperFlex HX240c M5 ノードのスペック シートを参照してください。

図 15 HX240C-M5SX ノード

Cisco VIC 1387 MLOM インターフェイス カード

Cisco UCS 仮想インターフェイス カード (VIC) 1387 は、Cisco UCS HX シリーズ ラック サーバに搭載可能なカードで、拡張された着脱可能小型フォームファクタ (QSFP+) の 40 Gbps イーサネットおよび Fibre Channel over Ethernet (FCoE) を 2 ポート搭載したモジュール型 LAN On Motherboard (mLOM) アダプタです (図 11)。mLOM スロットを使用すれば PCIe スロットを使用せずに Cisco VIC を構成できるため、I/O の拡張性が向上します。シスコの次世代統合型ネットワーク アダプタ (CNA) テクノロジーを取り入れることで、将来の機能リリースにおける投資を保護します。このカードにより、ポリシーベースでステートレス、かつ俊敏性に優れたサーバ インフラストラクチャが実現します。PCIe 標準準拠のインターフェイスを最大 256 個までホストに提供可能で、ネットワーク インターフェイス カード (NIC) またはホスト バス アダプタ (HBA) として動的に構成することができます。カードの特性は、ブート時にサーバに関連付けられたサービス プロファイルを使用して動的に設定されます。PCIe インターフェイスの番号、タイプ(NIC または HBA)、ID(MAC アドレスおよび World Wide Name (WWN))、フェールオーバー ポリシー、帯域幅、Quality of Service (QoS) ポリシーは、すべてサービス プロファイルから決定されます。

図 16 Cisco VIC 1387 mLOM カード

Cisco HyperFlex コンピューティング ノード

Cisco UCS B200 M5 ブレード

ワークロードに対して、コンピューティング リソースやメモリ リソースを追加する必要が生じたが、追加できるストレージ容量がない場合には、コンピューティング専用のハイブリッド クラスタ構成を使用することができます。この構成を使用する場合には、HyperFlex コンバージド ノードが最小で 3 台(最大で 16 台)と、追加の

コンピューティング容量として Cisco UCS B200-M5 ブレード サーバが 1 ~ 16 台必要になります。HX

シリーズ ノードは前述のように設定し、Cisco UCS B200 M5 サーバにはブート ドライブが搭載されています。Cisco UCS B200 M5 コンピューティング ノードを使用するは、Cisco UCS 5108 ブレード サーバ シャーシ、および Cisco UCS 2300/2200 シリーズ ファブリック エクステンダのペアも必要です。詳細については、Cisco UCS B200 M5 ブレード サーバ スペック シートを参照してください。

Cisco VIC1340 コンバージド ネットワーク アダプタ

Cisco UCS 仮想インターフェイス カード (VIC) 1340(図 18)は、Cisco UCS B シリーズ ブレード サーバの M4 世代に特化して設計された、2 ポート 40 Gbps イーサネットまたはデュアル 10 Gbps イーサネット X 4、Fibre Channel over Ethernet (FCoE) 対応のモジュール型 LAN on Motherboard (mLOM) です。オプションのポート エクスパンダと組み合わせて使用すると、40 Gbps イーサネットの 2 つのポートに対して Cisco UCS VIC 1340 の機能を有効にできます。

Cisco UCS VIC 1340 では、ポリシーベースでステートレス、かつ俊敏性の高いサーバ インフラストラクチャを構築できます。このインフラストラクチャは、ネットワーク インターフェイス カード (NIC) またはホスト バス アダプタ (HBA) として動的に設定可能な、最大 256 の PCIe 規格準拠インターフェイスをホストに提供します。さらに、Cisco UCS VIC 1340 は Cisco UCS ファブリック インターコネクト ポートを仮想マシンに拡張し、サーバ仮想化の展開および管理を簡素化する Cisco® Data Center Virtual Machine Fabric Extender (VM-FEX) をサポートします。

図 19 では、Cisco UCS B シリーズ B200 M4 ブレード サーバに搭載された Cisco UCS VIC 1340 仮想インターフェイス カードを示しています。

図 19 Cisco UCS B200 M5 に搭載された Cisco UCS VIC 1340

Cisco UCS 5108 ブレード シャーシ

Cisco UCS 5100 シリーズ ブレード サーバ シャーシは、Cisco Unified Computing System の重要な構成要素

であり、スケーラブルで柔軟なブレード サーバ シャーシを提供します。Cisco UCS 5108 ブレード サーバ

シャーシは、高さが 6 ラック ユニット (6 RU) で、業界標準の 19 インチ ラックシステムに搭載可能です。1 台

のシャーシに最大で 8 個のハーフ幅の Cisco UCS B シリーズ ブレード サーバを格納できます。また、

ハーフ幅とフル幅の両方のブレードのフォーム ファクタに対応できます。

ホットスワップ可能な 4 基の単相電源装置にシャーシの前面からアクセスできます。これらの電源装置の効率は 92 % で、非冗長、N + 1 冗長、およびグリッド冗長の各構成をサポートするように設定できます。シャーシの

背面には、8 基のホットスワップ可能なファン、4 つの電源コネクタ(各電源装置に 1 つ)、Cisco UCS

ファブリック エクステンダ用の 2 つの I/O ベイがあります。パッシブ ミッド プレーンでは、各ファブリック

エクステンダのサーバ スロットあたりで最大 40 Gbps の I/O 帯域幅が提供されます。このシャーシは、

40 ギガビット イーサネット標準もサポート可能です。

図 20 Cisco UCS 5108 ブレード シャーシ(前面と背面)

Cisco UCS 2304XP ファブリック エクステンダ

Cisco UCS 2304 ファブリック エクステンダは、ファブリック インターコネクトとブレード シャーシに格納

されている各ブレードサーバの間でユニファイド ファブリック接続するモジュールとして組み込みます。

40 ギガビット イーサネット接続を提供し、接続配線、診断、サーバ ネットワーク管理を簡素化します。本製品は第 3 世代の I/O モジュール (IOM) となり、第 2 世代の Cisco UCS 2200 シリーズ ファブリック エクステンダと

共通のモジュールサイズで、現在提供中の Cisco UCS 5108 ブレード サーバ シャーシと互換性を持ちます。

Cisco UCS 2304 によって、Cisco UCS 6300 シリーズ ファブリック インターコネクトと Cisco UCS 5100

シリーズ ブレード サーバ シャーシとの間で I/O ファブリック接続され、すべてのブレードサーバとシャーシが

ロスレスで、ユーザ定義可能な Fibre Channel over Ethernet (FCoE) ファブリックによって1 つに結ばれます。ファブリック エクステンダは分散型ラインカードと同様の製品であるため、スイッチング処理は行わず、

ファブリック インターコネクトの拡張部分として管理されます。このようなアプローチを取ることで、ブレード シャーシから各種スイッチが取り払われ、システム全体構造の複雑さが低減します。また、Cisco UCS の規模を拡大してシャーシの数を増やしても、必要なスイッチの数が増えることはないので、TCO が削減され、すべてのシャーシを可用性の高い 1 つの管理ドメインとして扱うことが可能になります。

Cisco UCS 2304 ではファブリック インターコネクトと併せてシャーシ環境(電源、ファン、ブレード)も管理できます。したがって、シャーシごとに管理のためのモジュールを構成する必要もありません。

Cisco UCS 2304 ファブリック エクステンダは Cisco UCS 5100 シリーズ ブレードシャーシの背面に取り付けられます。Cisco UCS 5100 シリーズ ブレードシャーシ 1 台あたり最大 22 台のファブリック エクステンダを搭載でき、接続帯域の拡大と冗長性を実現します(図 22)。

Cisco UCS 2304 ファブリック エクステンダには 40 ギガビット イーサネット、FCoE 対応の Quad Small Form-Factor Pluggable (QSFP+) ポートが 4 個あり、これらのポートでブレード シャーシとファブリック

インターコネクトに接続します。それぞれの Cisco UCS 2304 では、40 ギガビット イーサネット ポートが 1 基あり、ミッド プレーンを経由してシャーシのハーフ幅スロットにそれぞれ接続されます。その結果、合計で 40G X 8 のコンピューティング用インターフェイスが提供されます。通常は冗長性を得るためファブリック

エクステンダをペアで構成し、その 2 台により、最大 320 Gbps の I/O をシャーシに提供することが可能です。

図 21 Cisco UCS 2304XP ファブリック エクステンダ

Cisco UCS C220 M5 ラック サーバ

Cisco UCS C220 M5 ラック サーバは、1 RU フォーム ファクタのエンタープライズクラスの

インフラストラクチャ サーバです。インテル Xeon スケーラブル ファミリー プロセッサー製品ファミリと

次世代の DDR4 メモリが組み込まれており、12 Gbps の SAS スループットにより、非常に高いパフォーマンスと効率性を実現します。ワークロードに対して追加のコンピューティング リソースやメモリ リソースが必要になる一方でストレージ容量を追加できない場合にも、HX シリーズ コンバージド ノードの数に応じて、Cisco UCS C220 M5 ラック サーバをコンピューティング専用ハイブリッド HX クラスタの構築に使用することができます。この構成には、HX シリーズ コンバージド ノードが最小で 3 台(最大で 16 台)と、追加のコンピューティング容量として Cisco UCS C220-M4 ラック サーバが 1 ~ 16 台が含まれています。

図 22 Cisco UCS C220 M5 ラック サーバ

Cisco UCS C240 M5 ラック サーバ

Cisco UCS C240 M5 ラック サーバは、2 ソケット、2 ラック ユニット (2RU) フォーム ファクタの

エンタープライズクラスのサーバです。インテル Xeon スケーラブル ファミリー プロセッサー製品ファミリと次世代の DDR4 メモリが組み込まれており、12 Gbps の SAS スループットにより、非常に高いパフォーマンスと、多岐にわたるストレージと I/O の集中するインフラストラクチャ ワークロードに対する優れた拡張性を提供します。Cisco UCS C240 M5 ラック サーバは、HX シリーズ コンバージド ノードの数に応じて、コンピューティング リソースとメモリ リソースを追加することで、コンピューティング専用ハイブリッド HX クラスタの拡張に使用することができます。この構成には、HX シリーズ コンバージド ノードが最小で 3 台(最大で 16 台)と、

追加のコンピューティング容量として Cisco UCS C240-M4 ラック サーバが 1 ~ 16 台が含まれています。

図 23 Cisco UCS C240 M5 ラック サーバ

Cisco HyperFlex コンバージド データ プラットフォーム ソフトウェア

HX データ プラットフォームは専用の高性能な分散ファイルシステムで、多岐にわたるエンタープライズクラス データ管理サービスを提供します。データ プラットフォームの技術革新により、分散ストレージ技術が再定義され、従来のハイパーコンバージド インフラストラクチャを凌ぐ性能を発揮します。このデータ プラットフォームにはエンタープライズ共有ストレージ システムに期待されるすべての機能があるため、複雑なファイバ チャネル ストレージ ネットワークとデバイスの設定や管理をする必要がなくなります。このプラットフォームは操作を

簡素化し、データの可用性を保証します。エンタープライズクラスのストレージ機能には、次のものがあります。

· レプリケーションがクラスタ全体のデータを複製するため、単一または複数のコンポーネントに障害が発生した場合にも、データの可用性は影響を受けません(設定されたレプリケーション ファクタの設定により

ます)。

· 重複排除は常にオンになっているので、仮想クラスタ内のストレージ要件を削減できます。仮想クラスタ内では、クライアント仮想マシンにおける複数のオペレーティング システムのインスタンスが複製された

大量のデータ アクセスを提供します。

· 圧縮:データ ストレージ使用量を削減し、コストを削減します。ログ構造のファイル システムは、

さまざまなサイズのブロックを保存し、内部のフラグメンテーションを減らすよう設計されています。

· シン プロビジョニング:実際に利用する必要性が生じるまでストレージ スペースを消費しないため、

データ ボリュームの増加を抑制し、ストレージに「成長に合わせて投資」できます。

· 高速でスペース効率の高いクローン機能により、ストレージ ボリュームを迅速に複製可能です。そのため、仮想マシンをメタデータの操作だけで複製でき、実際のデータ コピーは書き込み操作に対してのみ実行されます。

· スナップショットはバックアップとリモートレプリケーション操作を促進し、常時「オン」状態となって

いるため、データ可用性のニーズに対応します。

Cisco HyperFlex Connect HTML5 対応の管理 Web ページ

Cisco HyperFlex の主要な管理ツールとして、新しい HTML 5 ベースの Web UI を使用できます。これは

クラスタ上で一元化された制御ポイントとして機能します。管理者はボリュームを作成し、データ

プラットフォームの状態をモニタリングし、リソースの使用率を管理できます。またこのデータを使用して、クラスタをいつ拡張する必要があるかを予測することもできます。HyperFlex Connect UI を使用するには、Web ブラウザから HyperFlex クラスタの IP アドレス http://<hx controller cluster ip> にアクセスします。

Cisco Intersight 管理 Web ページ

Cisco Intersight は、IT 運用管理 (ITOM) を単純化および自動化し、日常的な業務作業をより容易により効率的

にします。Cisco Intersight クラウド ベース プラットフォームを通じて、Cisco UCS および HyperFlex

システムの適応型管理という考え方をさらに拡張します。データセンターからエッジまでの IT インフラストラクチャの自動操作、簡素化と効率性を提供します。

図 24 HyperFlex Connect GUI

レプリケーション ファクタ

各ストレージ ブロックで重複する複製の数に関するポリシーは、クラスタのセットアップ時に選択され、

「レプリケーション ファクタ」 (RF) と呼ばれます。

· レプリケーション ファクタ RF3:ストレージ層に対して I/O 書き込みがあるたびに、書き込まれた

ブロックからさらに 2 つの複製が追加され、別の場所に保存されます。つまりブロックの複製が合計 3 つ作成されます。ブロックの各複製が同じディスク上、またはクラスタ上の同じノードに複数保存されない

ようにブロックが分散されます。この仕組みにより、2 つのノード全体で同時に障害が発生してもデータ

損失が発生せず、バックアップなどのリカバリ プロセスによる復元が可能になります。

· レプリケーション ファクタ RF2:ストレージ層に対して I/O 書き込みがあるたびに、書き込まれた

ブロックからさらに 1 つの複製が追加され、別の場所に保存されます。つまりブロックの複製が合計 2 つ作成されます。ブロックの各複製が同じディスク上、またはクラスタ上の同じノードに複数保存されない

ようにブロックが分散されます。この仕組みにより、1 つのノード全体で障害が発生してもデータ損失が

発生せず、バックアップなどのリカバリ プロセスによる復元が可能になります。

データ分散化

キャッシング レイヤを使用してパフォーマンスが最適化されるように、着信データがクラスタ内のすべての

ノードに分散されます。すべてのノードに均等に保存されているストライプ ユニットに対して、新しいデータをマッピングすることで、効果的なデータ分散化を実現します。データ レプリカの数は、設定したポリシーによって決まります。アプリケーションがデータを書き込むと、そのデータは関連する情報ブロックが含まれている

ストライプ ユニットに基づいて適切なノードに送信されます。このデータ分散化アプローチを、同時に複数のストリームを書き込める機能と組み合わせることで、ネットワークとストレージのホット スポットを回避できます。また、仮想マシンの場所にかかわらず同じ I/O パフォーマンスを実現でき、ワークロード配置の柔軟性も向上します。これは、データをローカルで使用するアプローチを取り、利用可能なネットワーキング リソースと I/O リソースを完全に使用せず、ホット スポットに対して脆弱な他のアーキテクチャとは逆のアプローチになります。

Hyper-V Cluster Optimization などのツールを使用して仮想マシンを新しい場所に移動する場合に、Cisco HyperFlex HX データ プラットフォームではデータを移動する必要がありません。このアプローチにより、

システム間での仮想マシンの移動に伴う影響やコストを大幅に削減できます。

データ操作

データ プラットフォームに分散型のログ構造ファイル システムを採用することで、ノードの構成に応じて

キャッシング容量やストレージ容量の処理方法が変化します。

オールフラッシュメモリ構成の場合、データ プラットフォームでは SSD にキャッシング レイヤが使用され、

書き込み時の処理速度を向上させます。そして、SSD でキャパシティ レイヤが構成され、読み込み要求が SSD で取得されたデータに対して、直接実行されます。読み込み処理の速度を向上させるために、専用の読み込み

キャッシュを用意する必要はありません。

新しいデータは、可用性要件に対応できるように複数のノードにわたってストライプされます(通常は 2 台または 3 台のノードです)。設定したポリシーに基づき、新しい書き込み操作は、クラスタ内の別のノードにある SSD ドライブに複製されます。その後で、永続的な書き込み操作として認識されます。このアプローチにより、SSD やノードで障害が発生した場合のデータ損失の可能性を低減できます。なお、データを長期間格納する場合には、

書き込み操作がオールフラッシュ メモリ構成にあるキャパシティ レイヤの SSD に移行されます。

ログ構造ファイル システムでは、2 つのうち 1 つの書き込みログ(RF=3 の場合は 3 つのうち 1 つ)に、

容量が満たされるまで順に書き込みが行われます。そして、最初のレイヤからキャパシティ レイヤにデータが

移行される際に、他の書き込みログに切り替えられます。既存のデータが(論理的に)上書きされる場合、ログ

構造のアプローチではシンプルに新しいブロックを付加し、メタデータを更新します。このレイアウトの利点は、シーク操作に大きく時間を費やすことがないように SSD を構成できることです。これにより、データへの書き込み操作と上書き操作がランダムに実行されることによるフラッシュ メディア上のトータルの書き込み処理数を削減し、SSD における書き込み操作の増幅レベルを低減させます。

各ノードのキャパシティ レイヤに移行されたデータは、重複排除されて圧縮されます。このプロセスは書き込み操作が認識された後に行われるため、これらの操作でパフォーマンスに悪影響が及ぶことはありません。小さな

重複排除ブロック サイズにより、重複排除率が向上します。さらに圧縮によりデータ スペースを削減します。

その後、データはキャパシティ レイヤに移動され、書き込みキャッシュ セグメントは解放されて再利用可能に

なります(図 25)。

図 25 Cisco HyperFlex HX Data Platform 書き込みオペレーション フロー

キャパシティ レイヤから頻繁に読み取られる直近のデータであるホット データ セットは、メモリにキャッシュ

されます。しかしながら、オールフラッシュ構成では、高性能の SSD にすでに永続型のデータ コピーがある

ことから、そのようなキャッシュにはパフォーマンス上の利点がなく、キャッシュの読み込みに SSD は使用されません。これらの構成では、SSD で読み込みキャッシュを使用するとボトルネックとなり、SSD 全体で集約された帯域幅を使用する際の妨げとなる可能性があります。

データ最適化

Cisco HyperFlex HX Data Platform には、精密なインライン重複排除や可変ブロック インライン圧縮が搭載されており、キャッシュ(SSD、メモリ)レイヤおよびキャパシティ(SSD または HDD)レイヤのオブジェクトに

対して常に有効になっています。他社のソリューションでは、パフォーマンス維持のためにこれらの機能を無効にする必要があります。一方、シスコのデータ プラットフォームの重複排除と圧縮機能は、パフォーマンスを維持、強化し、物理ストレージのキャパシティ要件を大幅に削減できるように設計されています。

データ重複排除

データ重複排除は、クラスタ内のすべてのストレージ(メモリ、SSD ドライブを含む)で使用されます。この

プラットフォームは、特許出願中の Top-K Majority アルゴリズムを基盤とし、実証的研究の成果を活用しています。実証的研究では、小さなデータ ブロックに分割し、少数のデータ ブロックに基づけば、ほとんどのデータは大幅に重複排除できる可能性があることが示されています。頻繁に使用されるブロックのみに対して

フィンガープリントとインデックスを作成することにより、少量のメモリで高い重複排除率を実現でき、クラスタ ノード内の価値の高いリソースであるメモリ使用量を節約できます(図 26)。

図 26 Cisco HyperFlex HX Data Platform はパフォーマンスに影響を与えずにデータ ストレージを最適化

インライン圧縮

Cisco HyperFlex HX Data Platform は、データ セットに対して高性能なインライン圧縮を使用し、ストレージ

容量を節約します。他の製品も圧縮機能を提供していますが、パフォーマンスに悪影響を及ぼす場合が少なくありません。一方、シスコのデータ プラットフォームは CPU オフロード指示を使用して、圧縮操作による

パフォーマンスへの影響を軽減します。さらに、ログ構造の分散オブジェクト レイヤは、以前に圧縮されたデータの変更(書き込み操作)に影響を及ぼしません。新規の変更は圧縮されて新しい場所に書き込まれ、既存の(古い)データは削除用にマークされます(そのデータをスナップショット内で保持する必要がある場合を除きます)。

書き込み操作の前に、変更対象のデータを読み取る必要はありません。一般的には読み取り、変更、書き込み

という手順が必要ですが、この機能はその手順に伴う悪影響を回避し、書き込みパフォーマンスを大幅に向上させます。

ログ構造の分散オブジェクト

Cisco HyperFlex HX Data Platform では、ログ構造の分散オブジェクト ストア レイヤにより、データを

グループ化して圧縮します。データは、重複排除エンジンでフィルタされ、自己アドレス可能なオブジェクトになります。これらのオブジェクトは、ログ構造でディスクに順次書き込まれます。すべての新しい I/O(ランダム I/O を含む)は、キャッシング層(SSD、メモリ)および永続層(SSD または HDD)の両方に順次書き込まれます。オブジェクトはクラスタ内のすべてのノードにわたって分散されるため、ストレージ容量を均等に使用できます。

シーケンシャル レイアウトを使用することで、プラットフォームのフラッシュ メモリの耐久性を向上させることができます。読み取り、変更、書き込みという手順ではないため、圧縮、スナップショット、複製操作の

パフォーマンスには影響がほとんどないか、まったくありません。また、全体的なパフォーマンスに対しても同様です。

データ ブロックはオブジェクトに圧縮され、固定サイズのセグメント内に順次配置されます。次に、それらの

セグメントはログ構造で順次配置されます(図 27)。ログ構造セグメント内の圧縮された各オブジェクトは、キーを使用して一意にアドレス可能です。各キーはフィンガープリントされ、チェックサムと保存されており、高度なデータ整合性を実現します。また、オブジェクトが時系列で書き込まれるため、このプラットフォームはメディアやノードの障害から迅速に回復できます。障害が発生してデータが削除された場合、その時点より後にシステムが受信したデータのみを再度書き込めば回復できるからです。

図 27 Cisco HyperFlex HX Data Platform はパフォーマンスに影響を与えずにデータ ストレージを最適化

暗号化

セキュアな状態で暗号化されたストレージにより、データ プラットフォームのキャッシング レイヤと永続型

レイヤの両方を随時暗号化します。エンタープライズ キー管理ソフトウェアによる統合、またはパスフレーズで保護されたキーによる統合を通じて、保管中のデータを暗号化することで、HIPAA、PCI DSS、FISMA、SOX 規制に準拠できます。プラットフォーム自体が連邦情報処理標準 (FIPS) 140-1 に沿うように強化され、暗号化ドライブにキー管理の仕組みを備えることで FIPS 140-2 標準にも準拠します。

データ サービス

Cisco HyperFlex HX Data Platform では、スペース効率の高いデータ サービスがスケーラブルに実装されています。これらのサービスには、シン プロビジョニング、スペース再利用、ポインタベースのスナップショット、

クローンが含まれ、パフォーマンスには影響が及びません。

シン プロビジョニング

このプラットフォームでは、予測に基づいてディスク容量を購入してインストールする必要がないため、長期間使用されないままになるリスクを避けられ、ストレージを効率的に使用できます。仮想データ コンテナは、任意の量の論理スペースをアプリケーションに示せます。一方、必要な物理記憶域の量は、書き込まれるデータによって決定されます。ビジネス要件に応じて、既存ノードのストレージを拡張したり、ストレージ集約型ノードを追加してクラスタを拡張したりできます。必要になる前の段階で容量確保のためにストレージを購入しておく必要性はなくなります。

スナップショット

Cisco HyperFlex HX Data Platform はメタデータベースのゼロコピー スナップショットを使用して、

バックアップ操作やリモート複製を容易にします。これらの機能は、データを常時利用できる必要がある企業にとって極めて重要です。スペース効率の高いスナップショットにより、物理ストレージ容量の消費を心配せずに、データのオンライン バックアップを頻繁に実行できます。データはオフライン移動や、これらのスナップショットからの迅速な復元が可能です。

· 高速なスナップショットの更新:スナップショットに変更されたデータが含まれている場合、新しい場所に書き込まれ、メタデータが更新されます。読み取り、変更、書き込みという手順を実行する必要はありません。

· 高速なスナップショットの削除:スナップショットは迅速に削除できます。このプラットフォームでは、SSD 上の少量のメタデータを削除するだけで済みます。デルタディスク技術を使用するソリューションで必要となる、長時間の統合プロセスは不要です。

· 柔軟なスナップショット:Cisco HyperFlex HX Data Platform を使用すると、個別のファイル ベースで

スナップショットを作成できます。仮想環境内で、これらのファイルは仮想マシンのドライブにマッピングされます。柔軟に異なる仮想マシンに異なるスナップショット ポリシーを適用できます。

多くの基本的なバックアップ アプリケーションでは、データ セット全体、または前回のバックアップ以降に変更されたブロックが、ストレージあるいはオペレーティング システムが処理可能な速度で読み取られます。この

場合、HyperFlex が Cisco UCS 上に 10GbE で構築されていることから、複数のバックアップ スループットが

数ギガビット/秒単位となり、パフォーマンスに影響が生じる可能性があります。Windows Server Backup などの基本的なバックアップ アプリケーション、特に初回のバックアップで変更ブロック トラッキングなどが行われ

ない場合には、ピーク時以外の時間にスケジュールする必要があります。

Veeam Backup and Replication v9.5 などのフル機能のバックアップ アプリケーションでは、バックアップ

アプリケーションが利用できるスループットを制限して、遅延の影響を受けやすいアプリケーションを稼働時間中に保護する機能があります。v9.5 Update 2 のリリースによって、Veeam は HX のネイティブ スナップショットを統合した製品になりました。HX のネイティブ スナップショットでは、デルタ ディスク スナップショットに

よるパフォーマンスの低下が起こらず、スナップショットを削除する際の統合作用に影響を与えるサイズの

大きなディスク IO が発生しません。

SQL の管理者にとって特に重要となるのは、Veeam Explorer for SQL です。Microsoft VSS フレームワーク内

でのトランザクション レベルを回復させることができます。Veeam Explorer for SQL Server では SQL Server データベースの復元が可能で、バックアップ復元ポイントから、特定の時点までのログ再生から、特定の

トランザクションまでのログ再生から、という 3 つの方法があります。その際に、VM または SQL Server を

オフラインにする必要はありません。

高速でスペース効率の高いクローン

Cisco HyperFlex HX Data Platform では、クローンは書き込み可能なスナップショットです。クローンを使用

すると、テストや開発環境用に、仮想デスクトップやアプリケーションなどの項目を迅速にプロビジョニングできます。これらの高速でスペース効率の高いクローンにより、ストレージ ボリュームを迅速に複製可能です。そのため、仮想マシンをメタデータの操作だけで複製でき、実際のデータ コピーは書き込み操作に対してのみ実行されます。このアプローチでは、何百個ものクローンの作成や削除を数分で行えます。フルコピー方式と比較すると、このアプローチは時間を大幅に節約し、IT の俊敏性や生産性を高められます。

クローンは作成時に重複排除されます。それぞれのクローンに差が生じ始めた場合は、共通するデータは共有され、固有のデータのみが新たな記憶域に保存されます。差が生じたクローン内にあるデータ重複は、重複排除エンジンが排除し、クローンのストレージ フットプリントをさらに削減します。

データ レプリケーションと可用性

Cisco HyperFlex HX Data Platform では、ログ構造の分散オブジェクト レイヤが新しいデータを複製し、データの可用性を高めます。設定したポリシーに基づき、書き込みキャッシュに書き込まれたデータは、異なるノードにある 1 台または 2 台の SSD ドライブに同時に複製されます。その後で、書き込み操作がアプリケーションに認識されます。このアプローチにより、新しい書き込みが迅速に認識されるとともに、SSD やノードの障害から

データを保護できます。SSD またはノードで障害が発生した場合、データの利用可能なコピーを使用して、別の SSD ドライブまたはノード上でレプリカが迅速に再作成されます。

ログ構造の分散オブジェクト レイヤは、書き込みキャッシュからキャパシティ レイヤに移動されたデータも複製します。この複製されたデータは、先ほどと同様に、SSD やノードの障害から保護されています。2 つの

レプリカ(合計 3 つのデータ コピー)があるため、クラスタは 2 台の SSD ドライブ、または 2 台のノードで、関連性のない障害が発生しても対応でき、データ損失のリスクがありません。関連性のない障害とは、複数の物理ノードで発生する障害のことです。同じノード上で発生した障害は、同じデータのコピーに影響することから、単一の障害として扱われます。たとえば、ノードのあるディスクで障害が起き、続いて同じノードの別のディスクで障害が発生した場合、これらの関連する障害は、そのシステムでは 1 件の障害とみなされます。この場合、クラスタは、別のノードで関連性のない障害が発生しても耐えられる場合があります。フォールトトレラントな構成および設定の一覧については、Cisco HyperFlex HX Data Platform のシステム管理者ガイドを参照してください。

Cisco HyperFlex HX コントローラ ソフトウェアで問題が発生した場合、そのノード内にあるアプリケーション

からのデータ要求は、クラスタ内の別のコントローラに自動で転送されます。この機能を使用すると、クラスタやデータの可用性に影響を与えずに、コントローラ ソフトウェアのアップグレードやメンテナンスをローリング

方式で実施できます。この自己修復機能は、Cisco HyperFlex HX Data Platform が実稼働アプリケーションに

最適な理由の 1 つです。

さらに、ネイティブ レプリケーションにより、ローカルまたはリモート クラスタに整合性のとれたクラスタ

データが転送されます。ネイティブ レプリケーションを使用することで、ローカルまたはリモート環境の

スナップショットを取得したり、特定の時点のコピーを格納したりすることができ、バックアップやディザスタ

リカバリにもちいることができます。

データ リバランシング

分散ファイル システムには、堅牢なデータ リバランシング機能が必要です。Cisco HyperFlex HX Data Platform では、メタデータ アクセスでオーバーヘッドが生じず、リバランシングが極めて効率的です。リバランシングは、中断を伴わないオンライン プロセスであり、キャッシング レイヤと永続レイヤの両方で実行されます。データを詳細に特定して移動することで、ストレージ容量の使用を改善します。このプラットフォームでは、ノードや

ドライブが追加または削除された場合や、それらで障害が発生した場合に、既存データが自動でリバランスされます。新しいノードがクラスタに追加されると、その容量とパフォーマンスを新しいデータと既存データで利用可能になります。リバランシング エンジンは、既存データを新しいノードに分配し、クラスタ内にあるすべてのノードの容量とパフォーマンスが均等に使用されるようにします。ノードで障害が発生した場合や、ノードがクラスタから削除された場合は、リバランシング エンジンがデータのコピーを再構築し、それらのノードからクラスタ内にある利用可能なノードに分配します。

オンライン アップグレード

Cisco HyperFlex HX シリーズ システムと HX データ プラットフォームではオンライン アップグレードがサ

ポートされており、業務を中断することなく、環境の更新や拡張を行えます。プロセッサ性能の追加、BIOS、

ドライバ、ハイパーバイザ、ファームウェアのダウンロードおよびインストール、Cisco UCS Manager の

アップデート、強化、バグ修正などの物理リソースの拡張を容易に行うことができます。

Cisco Nexus 93108YCPX スイッチ

Cisco Nexus 93180YC-EX スイッチは、48 個の 1/10/25 Gbps Small Form Pluggable Plus (SFP+) ポートと 6 個の 40/100 Gbps Quad SFP+ (QSFP+) アップリンク ポートを備えています。すべてのポートはライン

レートであり、1 ラックユニット (1RU) のフォーム ファクタで 3.6 Tbps のスループットを提供します。

柔軟なアーキテクチャ

· 従来型とリーフ/スパイン型の両方のアーキテクチャに対応した、トップオブラック、ファブリック

エクステンド アグリゲーション、ミドルオブロー ファイバベースのサーバ アクセス接続を含む

· Cisco ACI アーキテクチャのリーフ ノード サポートを含む

· Cisco Nexus 2000 ファブリック エクステンダのサポートにより、拡張性の向上と管理のシンプル化を実現

多機能

· パフォーマンス、復元力、拡張性、管理性、およびプログラマビリティを確保するように設計された Cisco NX-OS ソフトウェアの改良バージョン

· ACI 対応インフラストラクチャにより、ユーザが自動化されたポリシーベースでのシステム管理を活用可能

· ネットワーク サービスを提供する仮想拡張 LAN (VXLAN) ルーティング

· ライン レートでのデータ収集による充実したトラフィック フローのテレメトリ

· ポート単位およびキュー単位でリアルタイムにバッファ利用状態を把握し、トラフィックのマイクロ

バーストやアプリケーションのトラフィック パターンをモニタリング可能

リアルタイムの可視化とテレメトリ

· Cisco Tetration Analytics プラットフォームと組み込みのハードウェア センサーによる、豊富な

トラフィック フロー テレメトリとライン レートでのデータ収集

· Cisco Nexus Data Broker によるネットワーク トラフィックのモニタリングと分析

· ポート単位およびキュー単位でリアルタイムにバッファの利用状態を把握し、トラフィックのマイクロ

バーストやアプリケーションのトラフィック パターンをモニタリング

高可用性と効率に優れた設計

· 高性能な非ブロック アーキテクチャ

· ホットアイル/コールドアイル型の構成への容易な導入

· ホットスワップ可能な冗長構成の電源モジュールおよびファン トレイ

運用のシンプル化

· Pre-boot Execution Environment (PXE) と Power-On Auto Provisioning (POAP) のサポートにより、

ソフトウェアのアップグレードと設定ファイルのインストールをシンプル化

· Puppet、Chef、Ansible などの DevOps ツールとスイッチの設定と自動化

· インテリジェントな API により、HTTP/HTTPS インフラストラクチャ上で実行する

リモート プロシージャ コール(RPC、JSON または XML)を介したスイッチ管理が可能

· Python スクリプトにより、スイッチのコマンドライン インターフェイス (CLI) へのプログラム的な

アクセスを提供

· ホット/コールド パッチとオンライン診断を含む

投資保護

· シスコの 40 GB 双方向トランシーバを使用し、40 ギガビット イーサネット用に既存の 10 ギガビット イーサネット ケーブル設備の再利用が可能

· 10 Gb/25 Gb でのアクセス接続および 40 Gb/100 Gb でのアップリンクをサポートすることで、より速い速度でのデータセンターのインフラストラクチャの移行と切り替えを促進

· 1 RU フォーム ファクタで 1.44 Tbps の帯域幅

· 1/10 Gbps SFP+ 固定ポート X 48

· アップリンク接続用の 40 Gbps QSFP+ 固定ポート X 6(QSFP to SFP または SFP+ アダプタ (QSA) を介して 10 Gb ポートに変換可能)

· 1 ~ 2 マイクロ秒の遅延

· 前面から背面、背面から前面への切り替えが可能なエアーフロー設定

· 80 PLUS プラチナ規格に準拠した、ホットスワップ可能な冗長構成の 1+1 電源モジュール

· ホットスワップ可能な冗長構成の 2+1 ファン トレイ

図 28 Cisco Nexus 93108YC スイッチ

Microsoft Hyper-V 2016

Microsoft Hyper-V Server 2016 は、Windows ハイパーバイザ、Windows Server ドライバ モデル、

仮想化コンポーネントのみを含んだスタンドアロンの製品です。シンプルで信頼性の高い仮想化ソリューションを提供し、サーバ使用率の向上とコストの削減を支援します。

Microsoft Hyper-V Server 2016 の Windows ハイパーバイザ テクノロジーは、Windows Server 2016 の Hyper-V ロールと同じものです。したがって、Windows Server 2016 の Hyper-V ロールで利用できる

コンテンツの大半は、Microsoft Hyper-V Server 2016 にも当てはまります。

Microsoft System Center 2016

このドキュメントでは、Microsoft System Center Operations Manager (SCOM)、および Virtual Machine Manager (SCVMM) のインストール手順については説明しません。SCOM および SCVMM 2016 を

インストールするには、Microsoft のガイドラインに従ってください。

· SCOM:https://docs.microsoft.com/en-us/system-center/scom/deploy-overview [英語]

· SCVMM:https://docs.microsoft.com/en-us/system-center/vmm/install-console [英語]

Citrix XenApp™ と XenDesktop™ 7.16

企業の IT 部門には、コストの管理、制御の一元化、企業のセキュリティ ポリシーの適用を行いつつ、Microsoft Windows アプリケーションやデスクトップのプロビジョニングを行うという課題が課せられています。デバイスの種類や使用可能なネットワーク帯域幅にかかわらず、あらゆる場所でユーザに Windows アプリケーションを

導入し、モバイル ワーカーの生産性を向上させます。Citrix XenDesktop 7.16 を使用することで、IT 部門は

データ資産を保護し、設備投資や運用コスト削減しながら、アプリケーションやデスクトップのプロビジョニングを効果的に制御できます。

XenDesktop 7.16 リリースでは、次のような利点を提供しています。

· あらゆる使用例をカバーした包括的な仮想デスクトップを配信。XenDesktop 7.16 リリースには、

XenApp のすべての機能が含まれ、ユーザに対してアプリケーションのみを提供したり、デスクトップ全体を提供したりすることができます。管理者は、同じ管理コンソールから、XenApp の公開済み

アプリケーションやデスクトップを展開(低コストで IT 制御を最大化)できますし、パーソナライズされた VDI デスクトップ(イメージの管理をシンプル化)を展開することもできます。Citrix XenDesktop 7.16 では、共通のポリシーと統合されたツールが利用して、インフラストラクチャ リソースとユーザ アクセスの両方を管理することができます。

· BYO (Bring Your Own) デバイスのサポートと選択のシンプル化。XenDesktop 7.16 では、企業の

何千もの Microsoft Windows ベース アプリケーションやモバイル デバイスに対して、最適化された

パフォーマンスと、ネイティブ感覚の操作感をもたらします。HDX テクノロジーにより、グラフィック

集約型の設計やエンジニアリング アプリケーションに対しても、「高解像度」のユーザ

エクスペリエンスを生み出します。

· アプリケーションおよびデスクトップ管理のコストと複雑さを低減。XenDesktop 7.16 により、IT 部門

が俊敏性に優れ、コスト効率の高いクラウド サービスを活用でき、季節的な需要の変動や突発的な

キャパシティの変化に対応できるようになります。IT 部門は、プライベートまたはパブリック クラウドに XenDesktop アプリケーションやデスクトップのワークロードを導入できます。

· 一元化による機密情報の保護。XenDesktop では、情報資産がデータセンターに存在することから、

アプリケーションの一元化や知的財産の保護と、データの利用を同時に行うことができ、企業データの損失リスクを軽減します。

· Virtual Delivery Agent の改善。XenDesktop 7.16 では、主要な改善項目として、ユニバーサル プリント サーバとドライバの強化、Windows 10 での HDX 3D Pro グラフィック アクセラレーションのサポートが行われています。

· ユーザの高解像度エクスペリエンスの改善。XenDesktop 7.16 では、画期的なディスプレイ プロトコル

の開発において、引き続き先駆的な取り組みが行われており、Thinwire ディスプレイ リモート処理

プロトコルの強化や HDX 3D Pro 用の Framehawk のサポートが実施されています。

Citrix XenApp と XenDesktop は、統合型アーキテクチャ上に構築されたアプリケーションおよびデスクトップ仮想化ソリューションです。管理が容易で、あらゆる組織のユーザのニーズを満たすのに十分な柔軟性を備えています。XenApp と XenDesktop には、IT タスクを簡素化して自動化する、共通の管理ツール セットがあります。オンプレミス導入と同じアーキテクチャと管理ツールを使用して、パブリック クラウド、プライベート クラウド、およびハイブリッド クラウドの導入を管理できます。

Citrix XenApp の機能を以下に示します。

· サーバ ベースのホスト型アプリケーションとも呼ばれる XenApp 公開アプリ:これは、Microsoft Windows サーバから任意のタイプのデバイス(Windows PC、Mac、スマートフォン、タブレットなど)にホストされるアプリケーションです。一部の XenApp エディションには、モバイル デバイス上での Windows アプリケーションのユーザ エクスペリエンスをさらに最適化するテクノロジーが組み込まれています。たとえば、ネイティブ モバイル デバイスのディスプレイ、ナビゲーション、コントロールを自動的に Windows アプリケーションに変換し、モバイル ネットワーク上のパフォーマンスを向上させ、開発者があらゆるモバイル環境にカスタム Windows アプリケーションを最適化できるようになっています。

· サーバ ホスト型デスクトップとも呼ばれる XenApp 公開デスクトップ:これは、Windows サーバ

オペレーティング システムからホストされる、低コストのロックダウン型 Windows 仮想デスクトップです。このデスクトップは、コール センターの従業員など、標準の一連作業を行うユーザに最適です。

· 仮想マシン ホスト型アプリケーション:これは、サーバ環境でホストできないアプリケーションのために Windows デスクトップ オペレーティング システムを実行しているマシンからホストされる

アプリケーションです。

· Microsoft App-V で提供される Windows アプリケーション:このアプリケーションは、他の XenApp

導入に使用される管理ツールと同じものを使用します。

· Citrix XenDesktop:重要な機能強化が行われ、お客様は Windows アプリケーションおよびデスクトップをモバイル サービスとして容易に配信でき、同時に管理の複雑さと関連コストの問題にも対応できます。このリリースの機能強化は、次のとおりです。

· XenApp と XenDesktop での製品アーキテクチャの統一:FlexCast Management Architecture (FMA)。

このリリースでは、ホステッド共有アプリケーション (RDS) と包括的な仮想デスクトップ (VDI) の両方を

提供する単一の管理インターフェイス セットが用意されています。Citrix XenApp ファームと XenDesktop ファームが別々にプロビジョニングされていた以前のリリースとは異なり、XenDesktop 7.16 リリースでは、管理者は単一のインフラストラクチャを導入し、一貫性のあるツール セットを使用して、混在する

アプリケーションとデスクトップのワークロードを管理することができます。

· クラウドへの導入の拡張をサポート。このリリースでは、Microsoft Azure、Amazon Web Services (AWS)、もしくは任意のクラウド プラットフォームを利用したパブリック クラウドまたはプライベート クラウド

から、ハイブリッド クラウドのプロビジョニングを行うことができます。クラウド導入は、従来の

オンプレミス インフラストラクチャ上の導入と同じ管理コンソールを通して、設定、管理、監視されます。

Citrix XenDesktop の機能を以下に示します。

· VDI デスクトップ:これらの仮想デスクトップは、1 つの共有サーバ ベースの環境で動作するのではなく、それぞれが Microsoft Windows デスクトップ オペレーティング システムを実行します。また、ユーザが自由にパーソナライズできる各ユーザ用のデスクトップを提供できます。

· ホスト型物理デスクトップ:このソリューションは、データセンター内から、ブレード サーバのような

強力な物理マシンへのセキュアなアクセスを提供するのに最適です。

· リモート PC アクセス:このソリューションを使用すれば、ユーザは、セキュアな XenDesktop 接続を

介してどこからでも物理 Windows PC にログインすることができます。

· サーバ VDI:これは、マルチテナント クラウド環境にホスト型デスクトップを提供するために設計されたソリューションです。

· ユーザが仮想デスクトップを使用し続けるための機能:これらの機能により、ユーザはネットワークに接続していなくても作業を続けることができます。

この製品リリースには、次の新機能や拡張機能が含まれています。

![]() XenDesktop の一部のエディションには、XenApp で利用できる機能が含まれます。

XenDesktop の一部のエディションには、XenApp で利用できる機能が含まれます。

ゾーン

複数の地点が広範囲に分散して WAN で接続されている配置の場合、ネットワークの遅延と信頼性が問題となり

ます。ゾーンを設定することで、リモート ロケーションのユーザがローカルのリソースに接続でき、WAN に

おける大きなセグメントを通過させることなく通信が行えます。また、ゾーンを使用することで、単一の Citrix Studio コンソール、Citrix Director、サイト データベースから効率的にサイトを管理することができます。これにより、導入、スタッフ配置、ライセンシング、リモート ロケーションの別のデータベースに含まれる追加のサイトのメンテナンスにかかるコストを削減できます。

ゾーンは、あらゆる規模の導入に役立ちます。ゾーンを使って、アプリケーションやデスクトップをエンド

ユーザの近くに配置することで、パフォーマンスが向上します。

詳細については、ゾーンに関する解説 [英語] を参照してください。

改善されたデータベース フローと設定

サイトの作成中にデータベースを設定する場合、サイト、ロギング、データベースのモニタリングで、別の場所を指定できるようになりました。設定後に、3 つのすべてのデータベースで、複数の場所が指定できます。以前の

リリースでは、3 つのデータベースがすべて同じアドレスで作成され、設定後に、サイト データベースに異なる

アドレスを指定することができませんでした。

サイトの作成時には、複数のデリバリ コントローラを設定後に同様に追加できるようになっています。以前の

リリースでは、サイトを作成した後にしかコントローラを追加できませんでした。

詳細については、データベースおよびコントローラの解説 [英語] を参照してください。

アプリケーションの制限

アプリケーションの制限を設定して、アプリケーションの使用を管理することができます。たとえば、

アプリケーションの制限を使用することで、アプリケーションを同時に利用できるユーザの数を管理できます。

同様に、リソース集約型アプリケーションの同時インスタンスの数を管理することもできます、これにより、

サーバ パフォーマンスを維持し、サービスの低下を防ぐことができます。

詳細については、アプリケーションの管理に関する解説 [英語] を参照してください。

マシンの更新または再起動のスケジュールの前に、複数の通知を送信

次のようなアクションが開始される前に、該当のマシンに通知メッセージを繰り返し送信するか、選択できるようになりました。

· 新しいマスター イメージを使用して、マシン カタログ内のマシンを更新

· 設定されたスケジュールに沿って、デリバリ グループ内のマシンを再起動

該当するマシンに、最初のメッセージを更新や再起動の始まる 15 分前に送信するよう指定した場合、それらが

開始されるまでに 5 分間隔で繰り返し送信されるメッセージも指定できます。

詳細については、マシン カタログの管理とデリバリ グループ内にあるマシンの管理の解説 [英語] を参照してください。

セッションのローミング管理用の API のサポート

デフォルトでは、セッションがユーザとクライアント デバイス間でローミングされます。ユーザがセッションを開始し、別のデバイスに移動すると、同じセッションが使用され、両方のデバイスでアプリケーションが利用可能となります。アプリケーションは、デバイスの種類や現在のセッションの場所にかかわらず、動作します。

アプリケーションに割り当てられたプリンタやその他のリソースについても同様です。

![]() セッションのローミングの調整を行う際に、PowerShell SDK を使用できるようになりました。これは、以前のリリースでは試験的な機能でした。

セッションのローミングの調整を行う際に、PowerShell SDK を使用できるようになりました。これは、以前のリリースでは試験的な機能でした。

詳細については、セッションに関する解説 [英語] を参照してください。

ハイパーバイザのテンプレートからの VM のプロビジョニング用 API のサポート

マシン カタログの作成または更新に PowerShell SDK を使用する場合、他のハイパーバイザ接続から

テンプレートを選択できるようになりました。これにより、現在利用できる VM イメージとスナップショットに

加えて、選択できるようになります。

新規およびその他のプラットフォームのサポート

すべてのサポート情報については、システム要件の解説 [英語] を参照してください。サード パーティ製品

バージョンのサポートについては、定期的に更新されます。

デフォルトでは、デリバリ コントローラをインストールする際に、SQL Server 2012 Express SP2 がインストールされます。SP1 はインストールされません。

コンポーネント インストーラにより、Microsoft Visual C++ ランタイムのより新しいバージョン(32 ビット/ 64 ビット Microsoft Visual C++ 2013、2010 SP1、2008 SP1)が自動的に導入されます。Visual C++ 2005 は導入されません。

Windows 10 で実行されているマシンには、Windows デスクトップ OS 用の Studio もしくは VDA をインストールできます。

Microsoft Azure の仮想化リソースへの接続も作成できます。

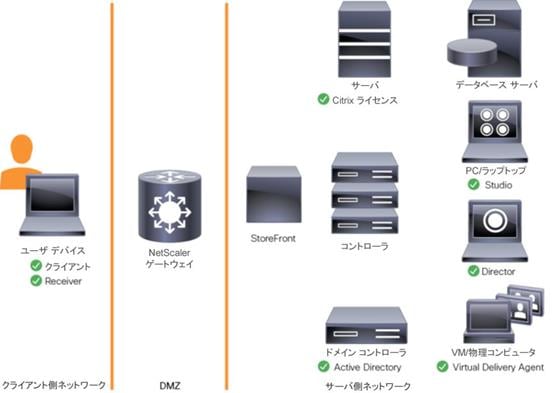

図 29 Citrix XenDesktop の論理アーキテクチャ

Cisco Unified Computing System の Citrix XenDesktop のアーキテクチャと設計、および Cisco HyperFlex のストレージ設計の基本

ユーザ デバイスのますます増加する多様な基盤、従来のデスクトップの管理における複雑さ、セキュリティ、

さらにはプログラムを機能させるための私物コンピュータの持ち込み (BYOC) など、仮想デスクトップ

ソリューションを検討するには多くの理由があります。仮想デスクトップ ソリューションを設計する際の最初の手順は、ユーザ コミュニティと、役割を正常に実行するために必要なタスクの種類を理解することです。次の

ユーザの分類があります。

· ナレッジ ワーカーは現在、ただオフィスで一日中作業するだけではありません。会議に出席し、支店を

訪れ、自宅やコーヒー ショップでさえも作業を行います。あらゆる場所で仕事するこのようなワーカーは、同じすべてのアプリケーションとデータに任意の場所からアクセスできることを求めています。

· 外部の請負業者は、ますます日常業務の一部となってきています。アプリケーションとデータの特定部分にアクセスする必要がありますが、管理者は、業者が使用するデバイスと作業する場所を依然としてほとんど制御できていません。このため、これらのユーザにデバイスを提供するコストと、これらのユーザに各自のデバイスからのアクセスを許可するセキュリティ リスクとが妥協点を見つける上での妨げになっています。

· タスク ワーカーは、明確に定義された一連のタスクを実行します。これらのワーカーは、少数の

アプリケーション セットにアクセスし、PC からの要件は限定されています。ただし、これらのワーカーは、顧客、パートナー、および従業員と対話するため、最も機密性の高いデータにアクセスします。

· モバイル ワーカーは、ネットワークに接続できるかどうかに関係なく、任意の場所から仮想デスクトップ

にアクセスできる必要があります。さらに、これらのワーカーは、自分の PC に独自のアプリケーションをインストールし、写真や音楽などの自身のデータを格納することによって、このようなデバイスを

パーソナライズできることを求めています。

· 共用ワークステーション ユーザは、多くの場合最先端の大学やビジネス コンピュータ ラボ、会議室や

トレーニング センターにいます。共用ワークステーション環境には、組織のニーズが変わった場合に、

上位に合わせて最新のオペレーティング システムとアプリケーションでデスクトップを再プロビジョニングするための一定の要件があります。

ユーザの分類を識別して、ユーザの分類ごとにビジネス要件を定義した後は、ユーザの要件に基づいて必要な仮想デスクトップのタイプを評価することが不可欠になります。ユーザごとに本質的には次の 5 つのデスクトップ

環境が考えられます。

· 従来の PC:従来の PC は、一般的にデスクトップ環境を構成していたもの(ローカルにオペレーティング

システムがインストールされた物理デバイス)です。

· ホステッド共有デスクトップ:ホステッド サーバベース デスクトップは、ユーザがデリバリ プロトコル

を介して対話するデスクトップです。ホステッド サーバベース デスクトップの場合、インストールされた単一のサーバ オペレーティング システム インスタンス(Microsoft Windows Server 2012 など)が複数

のユーザによって同時に共有されます。各ユーザは、デスクトップ「セッション」を受信し、隔離された

メモリ スペースで作業します。1 人のユーザによって行われた変更は他のユーザに影響を与える可能性があります。

· ホステッド仮想デスクトップ:ホステッド仮想デスクトップは、仮想化レイヤ (ESX) またはベアメタル ハードウェアのいずれかで実行される仮想デスクトップです。ユーザはデスクトップを使用して作業したり、デスクトップの前に座ったりするのではなく、デリバリ プロトコルを介して対話します。

· 発行済みアプリケーション:発行済みアプリケーションは Microsoft Session Host のみで実行され、

ユーザはデリバリ プロトコルを介して対話します。発行済みアプリケーションの場合、インストールされた単一のアプリケーション インスタンス(Microsoft など)が複数のユーザによって同時に共有されます。

各ユーザは、アプリケーション「セッション」を受信し、隔離されたメモリ スペースで作業します。

· ストリーミングされるアプリケーション:ストリーミングされるデスクトップやアプリケーションはユーザのローカル クライアント デバイスのみで実行され、要求に応じてサーバから送信されます。ユーザは

アプリケーションやデスクトップと直接対話しますが、リソースはネットワークに接続している場合にのみ使用できます。

· ローカル仮想デスクトップ:ローカル仮想デスクトップは、ユーザのローカル デバイスのみで実行される

デスクトップで、ネットワークから切断されているときも作動し続けます。この場合、ユーザのローカル

デバイスはタイプ 1 のハイパーバイザとして使用され、デバイスをネットワークに接続したときにデータ

センターと同期されます。

このドキュメントにおける検証の目的は、XenDesktop 仮想デスクトップと XenApp ホステッド共有

デスクトップ サーバの両方のセッションが検証することです。各項では、この環境の基本的な設計決定について説明します。

アプリケーションおよびデータの把握

デスクトップ ユーザ グループおよびサブグループの識別が終了したら、次のタスクとして、グループ

アプリケーションおよびデータ要件をカタログに登録する必要があります。この作業は、VDI 計画の中で最も時間のかかるプロセスの 1 つですが、VDI プロジェクトを成功させるには不可欠です。アプリケーションおよび

データを識別して同一の場所に配置しないと、パフォーマンスが低下します。

組織のさまざまなアプリケーションおよびデータのペアを分析するプロセスは、SalesForce.com などの包括的なクラウド アプリケーションが関連することによって複雑になる場合があります。このようなアプリケーション

およびデータの分析はこの Cisco Validated Design の処理対象ではありませんが、計画プロセスには含める必要があります。この重要な作業について組織を支援するサードパーティ ツールが各種提供されています。

プロジェクト計画とソリューション サイジングに関する確認事項の例

ユーザ グループ、アプリケーションおよびデータ要件を把握したら、プロジェクトとソリューション サイジングに関するいくつかの主要な確認事項を検討します。

プロジェクトに関する一般的な確認事項には、初期段階で対処しなければならないものもあります。次に例を挙げます。

· VDI のパイロット計画は、デスクトップ グループ、アプリケーション、データのビジネス分析に基づいて作成されているか。

· パイロット プログラムを実行するインフラストラクチャと予算は用意されているか。

· VDI プロジェクトの実行に必要なスキルを持つ人材はいるか。そのような人材を雇用したり、契約を結んだりすることができるか。

· デスクトップ サブグループごとにエンド ユーザ エクスペリエンスのパフォーマンス測定指標はあるか。

· 成功と失敗の評価基準をどうするか。

· 成功した場合、または失敗した場合、今後どのような影響が出るか。

次のリストは、ユーザ サブグループごとに対処する必要があるサイジングに関する確認事項の一部です。

· 導入予定のデスクトップ OS は何かWindows 7、Windows 8、Windows 10 のどれか。

· 32 ビット デスクトップ OS か、64 ビット デスクトップ OS か。

· パイロットでは何台の仮想デスクトップを導入するか。実稼働環境ではどうか。すべて Windows 10/7/8 か。

· 該当のデスクトップ グループのデスクトップには、メモリ容量はどれぐらい必要か。

· リッチ メディア、Flash、またはグラフィックを多用するワークロードはあるか。

· エンド ポイントのグラフィック処理能力はどのくらいか。

· リモート デスクトップ サーバ用の Citrix XenApp がホストするセッションは使用されるか。

· ソリューションのハイパーバイザは何か。

· 既存環境のストレージ構成はどのようなものか。

· 書き込み集中型 VDI ワークロードに十分な IOPS を確保できるか。

· VDI サービス専用に調整されたストレージはあるか。

· デスクトップに対する音声コンポーネントはあるか。

· ウイルス対策はイメージに含まれているか。

· ユーザ プロファイル管理(非ローミング プロファイルベースなど)はソリューションに含まれているか。

· 耐障害性、フェールオーバー、ディザスタ リカバリ計画はどのようなものか。

· 他にデスクトップ サブグループ固有の確認事項はないか。

Citrix XenDesktop の設計の基本

ますます増加し多様化するユーザ デバイス基盤、従来のデスクトップの管理における複雑さ、セキュリティ、

さらにはプログラムを機能させるための Bring Your Own (BYO) デバイスなどが、仮想デスクトップ

ソリューションに移行する主な理由となります。

Citrix XenDesktop 7.16 では、ホステッド共有および VDI デスクトップ仮想化テクノロジーがユニファイド

アーキテクチャに統合され、拡張性および効率性に優れたシンプルで扱いやすいソリューションによって Windows アプリケーションおよびデスクトップをサービスとして配信することができます。

ユーザは、タブレット、スマートフォン、PC、Mac、およびシン クライアントからアクセス可能な使いやすい

「ストア」からアプリケーションを選択できます。XenDesktop は、HDX 高解像度パフォーマンスを備え、

タッチ操作用に最適化されたネイティブ エクスペリエンスを提供します。このことはモバイル ネットワーク上でも同様です。

マシン カタログ

同一の仮想マシン (VM) の集まりは、マシン カタログと呼ばれる単一エンティティとして管理されます。この

CVD では、カタログ内のマシンが一貫していることを確認するために、VM プロビジョニングで Citrix Provisioning Services を利用しています。この CVD では、マシン カタログ内のマシンは、Windows Server OS(RDS ホステッド共有デスクトップの場合)または Windows デスクトップ OS(ホステッド プール VDI

デスクトップの場合)のいずれかを実行するように設定されています。

デリバリ グループ

デスクトップやアプリケーションをユーザに配信するには、マシン カタログを作成してから、デリバリ グループを作成してカタログ内のマシンをユーザに割り当てます。デリバリ グループを通して、デスクトップ、

アプリケーション、またはその組み合わせをユーザに提供します。デリバリ グループを作成することで、マシンやアプリケーションをユーザに柔軟に割り当てることができます。デリバリ グループでは、次のことが可能です。

· 複数のカタログ内のマシンを使用する

· 複数のマシンにユーザを割り当てる

· 1 つのマシンに複数のユーザを割り当てる

作成プロセスの一環として、次のデリバリ グループ プロパティを指定します。

· デリバリ グループに割り当てるユーザ、グループ、およびアプリケーション

· ユーザのニーズに合ったデスクトップ設定

· デスクトップ電源管理オプション

図 30 に、ユーザがマシン カタログおよびデリバリ グループを通じてデスクトップやアプリケーションに

アクセスする仕組みを示します

図 30 マシン カタログおよびデリバリ グループを通じたデスクトップやアプリケーションへのアクセス

XenDesktop 導入例

一般的な XenDesktop の導入例は、次の 2 つです。

· 分散コンポーネント構成

· マルチサイト構成

XenApp および XenDesktop 7.16 は統合アーキテクチャに基づいているため、ホステッド共有デスクトップ(HSD、サーバ OS マシンを使用)とホステッド仮想デスクトップ(HVD、デスクトップ OS を使用)を

組み合わせて導入することができます。

分散コンポーネント構成

導入対象コンポーネントを多数のサーバに分散させたり、サイト内のコントローラの数を増やして拡張性強化やフェールオーバーを実現したりすることができます。別のコンピュータに管理コンソールをインストールして、

導入をリモートから管理できます。NetScaler ゲートウェイ(旧称アクセス ゲートウェイ)を経由したリモート

アクセスに基づくインフラストラクチャには、分散導入が必要となります。

図 31 に、分散コンポーネント構成の例を示します。初期の概念検証 (POC) 導入では、この構成の簡易

バージョンがよく導入されます。このドキュメントで説明されている CVD では、示された分散コンポーネント

構成に似た構成で Citrix XenDesktop が導入されています。2 つの Cisco C220 ラック サーバでは、

インフラストラクチャ サービス(AD、DNS、DHCP、プロファイル、SQL、Citrix XenDesktop 管理、

および StoreFront サーバ)をホストしています。

マルチサイト構成

複数の地域にサイトがある場合、Citrix NetScaler を使用してユーザの接続を最も適切なサイトに誘導し、StoreFront を使用してデスクトップやアプリケーションをユーザに配信できます。

図 32 では複数のサイトが表現されており、2 つのデータセンターでサイトが作成されています。サイトを 1 つだけでなく 2 つグローバルに持つことで、不要な WAN トラフィックの量を最小限に抑えています。

StoreFront を使用することで、複数のサイトのリソースを集約し、ユーザに NetScaler による単一ポイントでのアクセスを提供します。各サイトを管理するのに個別の Studio コンソールが必要になります。サイトを単一

エンティティとして管理することはできません。ディレクタを使用すると、複数のサイトをまたいでユーザを

サポートできます。

Citrix NetScaler によって、アプリケーション パフォーマンスの向上、サーバのロード バランシング、

セキュリティ強化、ユーザ エクスペリエンスの最適化が促進されます。この例では、2 つの NetScaler を使用してハイ アベイラビリティ構成を実現しています。NetScaler をグローバル サーバ ロード バランシング用に構成し、DMZ に配置してマルチサイト フォールトトレラント ソリューションを提供しています。

Citrix のクラウド サービス

Citrix 製品のポートフォリオを、サービスとして簡単に提供します。Citrix Cloud サービスでは、Citrix の

テクノロジーの配信と管理がシンプルになり、既存のオンプレミス ソフトウェア導入への拡張を通じて、

ハイブリッド ワークスペース サービスを構築します。

· 高速:アプリケーションやデスクトップの導入、または安全なデジタル ワークスペースの構築を、週単位ではなく時間単位で行います。

· 適応性:クラウド、仮想インフラストラクチャ、もしくはそれらのハイブリッドでの導入を選択できます。

· セキュア:制御対象のアプリケーション、デスクトップ、データにおけるすべての機密情報の安全を維持します。

· シンプル:単一の管理プレーンを通じて完全に統合された Citrix ポートフォリオを用意することで、管理をシンプルにします。

混合ワークロードに対する XenDesktop 環境の設計

Citrix XenDesktop 7.16 では、アプリケーションまたはデスクトップをユーザに提供するために使用する方法は、ホストするアプリケーションやデスクトップのタイプ、使用可能なシステム リソース、ユーザのタイプ、および提供するユーザ エクスペリエンスによって異なります。

| サーバ OS マシン | 要件:安価なサーバベース配信によって、最小限のコストで数多くのユーザに ユーザ:明確に定義されたタスクを実行し、パーソナライゼーションや アプリケーション タイプ:アプリケーションのタイプは問いません。 |

| デスクトップ OS マシン | 要件:クライアントベースのセキュアなアプリケーション提供ソリューションによって集中管理を実現し、ホスト サーバ(またはハイパーバイザ)1 台あたりで ユーザ:社員、外部請負業者、サードパーティの協力者、および臨時のチーム アプリケーション タイプ:他のアプリケーションと一緒では適切に動作しない 旧オペレーティング システム(Windows XP や Windows Vista など)および旧アーキテクチャ(32 ビットや 16 ビットなど)で実行されるアプリケーションも同様です。各アプリケーションをそれぞれ個別の仮想マシンに分離することで、1 台のマシンで障害が発生しても、他のユーザに影響しなくなります。 |

| リモート PC アクセス | 要件:従業員が VPN を使用しなくても物理コンピュータにセキュアにリモート ユーザ:自宅から作業するという選択肢はあっても、企業のデスクトップにある ホスト:デスクトップ OS マシンと同じです。 アプリケーション タイプ:オフライン コンピュータから配信し、リモート |

Products Deployed

The architecture deployed is highly modular. While each customer’s environment might vary in its exact configuration, the reference architecture contained in this document once built, can easily be scaled as requirements and demands change. This includes scaling both up (adding additional resources within existing Cisco HyperFlex system) and out (adding additional Cisco UCS HX-series nodes, or Cisco UCS B/C-series as compute nodes).

The solution includes Cisco networking, Cisco UCS, and Cisco HyperFlex hyper-converged storage, which efficiently fits into a single data center rack, including the access layer network switches.

This validated design document details the deployment of the multiple configurations extending to 450 users for virtual desktop and hosted shared desktop workload featuring the following deployment methods:

· Citrix XenDesktop 7.16 persistent HVDs provisioned with Citrix Machine Creation Services (MCS) and using full copy on Cisco HyperFlex

· Microsoft Windows Server 2016 for User Profile Manager

· Microsoft Windows 2016 Server for Login VSI Management and data servers to simulate real world VDI workload

· Microsoft Hyper-V 2016

· Microsoft System Center Virtual Machine Manager 2016

· Windows 10 64-bit Operating Systems for VDI virtual machines

· Microsoft SQL Server 2016

· Cisco HyperFlex data platform v3.0.1a

図 33 Detailed Reference Architecture with Physical Hardware Cabling Configured to Enable the Solution

Hardware Deployed

The solution contains the following hardware as shown in 図 34:

· Two Cisco Nexus 93108YC Layer 2 Access Switches

· Two Cisco UCS C220 M4 Rack Servers with dual socket Intel Xeon E5-2620v4 2.1-GHz 8-core processors, 128GB RAM 2133-MHz and VIC1227 mLOM card for the hosted infrastructure with N+1 server fault tolerance. (Not show in the diagram).

· Four Cisco UCS HXAF220c-M5S Rack Servers with Intel Xeon Gold 6140 scalable family 2.3-GHz 18-core processors, 768GB RAM 2666-MHz and VIC1387 mLOM cards running Cisco HyperFlex data platform v3.0.1a for the virtual desktop workloads with N+1 server fault tolerance.

Software Deployed

Table 1 lists the software and firmware version used in the study.

Table 1 Software and Firmware Versions

| Vendor | Product | Version |

| Cisco | UCS Component Firmware | 3.2(3d) bundle release |

| Cisco | UCS Manager | 3.2(3d) bundle release |

| Cisco | UCS HXAF220c-M5S rack server | 3.2(3d) bundle release |

| Cisco | VIC 1387 | 4.2(2d) |

| Cisco | HyperFlex Data Platform | 3.0.1a-26588 |

|

|

|

|

|

|

|

|

| Network | Cisco Nexus 9000 NX-OS | 7.0(3)I2(2d) |

| Citrix | XenDesktop | 7.16 |

| Citrix | Provisioning Services | 7.16 |

| Citrix | User Profile Manager |

|

| Citrix | Receiver | 4.11 |

| Microsoft | SCVMM | 2016 |

| Microsoft | Hyper-V Server | 2016 |

|

|

|

|

Logical Architecture

The logical architecture of this solution is designed to support up to 450 Hosted Virtual Microsoft Windows 10 Desktops users within a four node Cisco UCS HXAF220c- HyperFlex cluster, which provides physical redundancy for each workload type.

図 35 Logical Architecture Design

Table 1 lists the software revisions for this solution.

![]() This document is intended to allow you to fully configure your environment. In this process, various steps require you to insert customer-specific naming conventions, IP addresses, and VLAN schemes, as well as to record appropriate MAC addresses. Table 2 through Table 6 lists the information you need to configure your environment.

This document is intended to allow you to fully configure your environment. In this process, various steps require you to insert customer-specific naming conventions, IP addresses, and VLAN schemes, as well as to record appropriate MAC addresses. Table 2 through Table 6 lists the information you need to configure your environment.

VLANs

The VLAN configuration recommended for the environment includes a total of seven VLANs as outlined in Table 2.

Table 2 Table 2 VLANs Configured in this Study

| VLAN Name | VLAN ID | VLAN Purpose |

| Default | 1 | Native VLAN |

| Hx-in-Band-Mgmt | 30 | VLAN for in-band management interfaces |

| Infra-Mgmt | 32 | VLAN for Virtual Infrastructure |

| Hx-storage-data | 101 | VLAN for HyperFlex Storage |

| Hx-livemigration | 33 | VLAN for Hyper-V Live Migration |

| Vm-network | 34 | VLAN for VDI Traffic |

| OOB-Mgmt | 132 | VLAN for out-of-band management interfaces |

![]() A dedicated network or subnet for physical device management is often used in datacenters. In this scenario, the mgmt0 interfaces of the two Fabric Interconnects would be connected to that dedicated network or subnet. This is a valid configuration for HyperFlex installations with the following caveat; wherever the HyperFlex installer is deployed it must have IP connectivity to the subnet of the mgmt0 interfaces of the Fabric Interconnects, and also have IP connectivity to the subnets used by the hx-inband-mgmt VLANs listed above.

A dedicated network or subnet for physical device management is often used in datacenters. In this scenario, the mgmt0 interfaces of the two Fabric Interconnects would be connected to that dedicated network or subnet. This is a valid configuration for HyperFlex installations with the following caveat; wherever the HyperFlex installer is deployed it must have IP connectivity to the subnet of the mgmt0 interfaces of the Fabric Interconnects, and also have IP connectivity to the subnets used by the hx-inband-mgmt VLANs listed above.

Jumbo Frames