ESXi 上で RoCE v2 を使用するファブリック(NVMeoF)を介して NVMe を使用する際のガイドライン

一般的なガイドラインと制限事項

-

Cisco では、UCS ハードウェアとソフトウェアの互換性をチェックして、NVMeoF のサポートを判断することを推奨します。NVMeoF は、Cisco UCS B シリーズ、C シリーズ、および X シリーズのサーバでサポートされています。

-

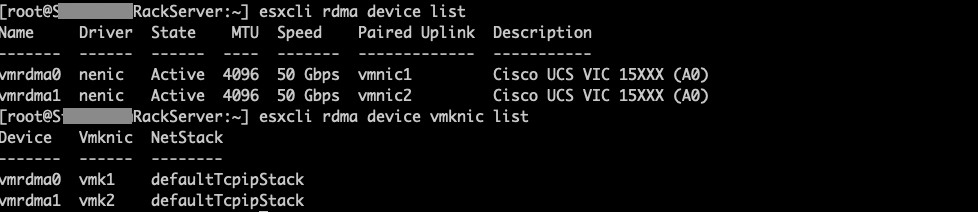

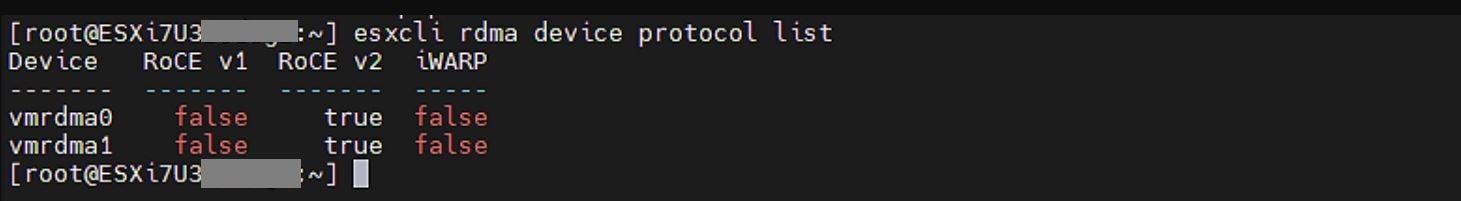

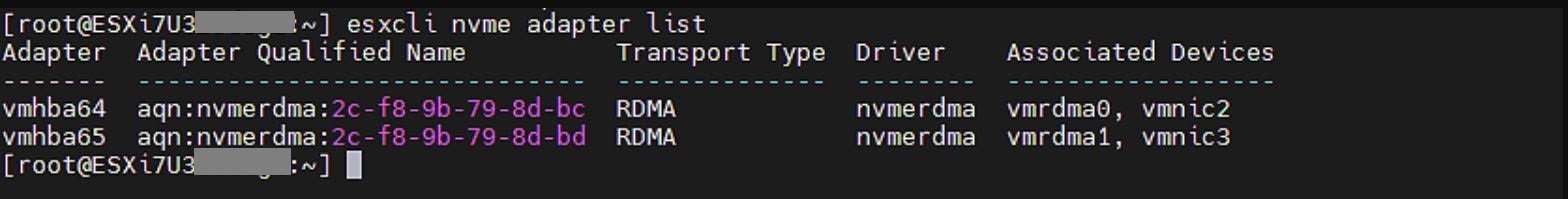

RoCE v2 を使用した Nonvolatile Memory Express(NVMe)over RDMA は、現在、Cisco VIC 15000 シリーズ アダプタでのみサポートされています。

-

RoCE v2 インターフェイスを作成する場合は、シスコが推奨するキュー ペア、メモリ リージョン、リソースグループ、およびサービス クラスの設定を使用してください。キュー ペア、メモリ領域、リソース グループ、およびサービス クラスの設定が異なると、NVMeoF の機能が保証されない可能性があります。

-

RoCE v2 は、アダプタごとに最大 2 つの RoCE v2 対応インターフェイスをサポートします。

-

NVMeoF ネームスペースからのブートはサポートされていません。

-

レイヤ 3 ルーティングはサポートされていません。

-

システム クラッシュ時に crashdump を NVMeoF ネームスペースに保存することはサポートされていません。

-

NVMeoF は、usNIC、VxLAN、VMQ、VMMQ、NVGRE、GENEVE オフロード、ENS、および DPDK 機能とともに使用することはできません。

-

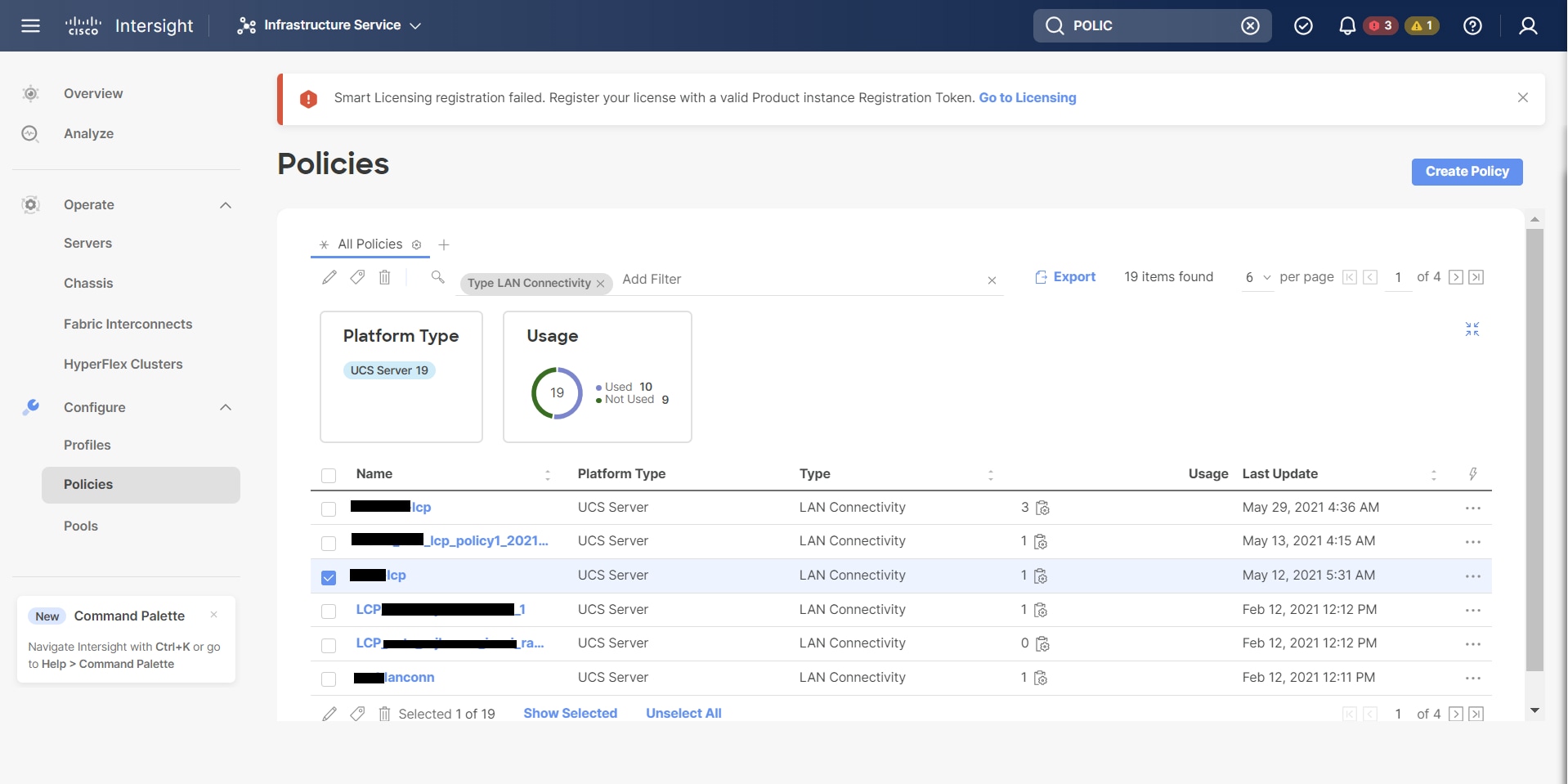

Cisco Intersight は、RoCE v2 対応の vNIC に対してファブリック フェールオーバーをサポートしません。

-

Quality of Service(QoS)no drop クラス構成は、Cisco Nexus 9000 シリーズ スイッチなどのアップストリーム スイッチで適切に構成する必要があります。QoS の設定は、異なるアップストリーム スイッチ間で異なります。

-

スパニング ツリー プロトコル(STP)を使用している場合、フェールオーバまたはフェールバック イベントが発生したときに、ネットワーク接続が一時的に失われる可能性があります。この接続性の問題が発生しないようにするには、アップリンク スイッチで STP を無効にします。

ダウングレードのガイドライン: 最初に RoCEv2 構成を削除してから、Cisco UCS Manager リリース 4.2(3b) バージョンよりも前のリリースバージョンにダウングレードします。

フィードバック

フィードバック