Linux 上で RoCE v2 を使用するファブリック(NVMeoF)を介して NVMe を使用する際のガイドライン

一般的なガイドラインと制限事項

-

Cisco では、UCS ハードウェアとソフトウェアの互換性をチェックして、NVMeoF のサポートを判断することを推奨します。NVMeoF は、Cisco UCS B シリーズ、C シリーズ、および X シリーズのサーバでサポートされています。

-

RoCE v2 を使用した RDMA 上の NVMe は、Cisco UCS VIC 1400、VIC 14000、および VIC 15000 シリーズのアダプタでサポートされています。

-

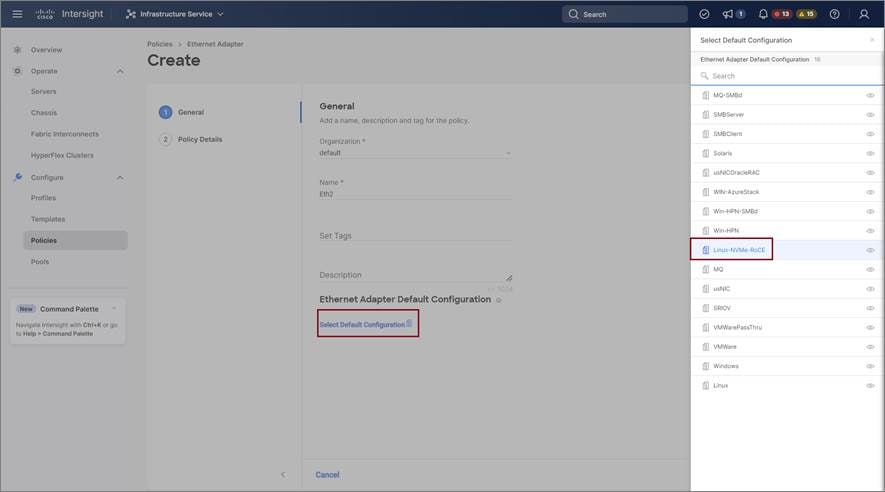

RoCE v2 インターフェイスを作成する際には、Cisco Intersight が提供する Linux-NVMe-RoCE アダプタ ポリシーを使用します。

-

Ethernet Adapter ポリシーでは、キュー ペア、メモリ領域、リソース グループ、および優先度の設定値を、Cisco が提供するデフォルト値以外に変更しないでください。キュー ペア、メモリ領域、リソース グループ、および優先度の設定が異なると、NVMeoF の機能が保証されない可能性があります。

-

RoCE v2 インターフェイスを構成する場合は、Cisco.com からダウンロードした enic と enic_rdma の両方のバイナリドライバを使用して、一致する enic と enic_rdma ドライバのセットをインストールします。inbox enic ドライバを使用して Cisco.com からダウンロードしたバイナリ enic_rdma ドライバを使用しようとしても、機能しません。

-

RoCE v2 は、アダプタごとに最大 2 つの RoCE v2 対応インターフェイスをサポートします。

-

NVMeoF ネームスペースからのブートはサポートされていません。

-

レイヤ 3 ルーティングはサポートされていません。

-

RoCE v2 はボンディングをサポートしていません。

-

システム クラッシュ時に crashdump を NVMeoF ネームスペースに保存することはサポートされていません。

-

NVMeoF は、usNIC、VxLAN、VMQ、VMMQ、NVGRE、GENEVE オフロード、および DPDK 機能とともに使用することはできません。

-

Cisco Intersight は、RoCE v2 対応の vNIC に対してファブリック フェールオーバーをサポートしません。

-

Quality of Service(QoS)no drop クラス構成は、Cisco Nexus 9000 シリーズ スイッチなどのアップストリーム スイッチで適切に構成する必要があります。QoS の設定は、異なるアップストリーム スイッチ間で異なります。

-

スパニング ツリー プロトコル (STP) によって、フェールオーバまたはフェールバック イベントが発生したときに、ネットワーク接続が一時的に失われる可能性があります。この問題が発生しないようにするには、アップリンクスイッチで STP を無効にします。

フィードバック

フィードバック