前提条件とガイドライン

VMware ESX で Nexus ダッシュボード クラスタを展開する前に、次の手順を実行する必要があります。

-

ファクターから ESX が拡張性とサービス要件をサポートしていることを確認します。

スケールとサービスのサポートと共同ホスティングは、クラスタのフォーム ファクターと、展開する予定の特定のサービスによって異なります。Nexus ダッシュボード キャパシティ プラン二ング ツールを使用して、仮想フォーム ファクタが展開要件を満たすことを確認できます。

(注)

一部のサービス (Nexus Dashboard Fabric Controller など) は、1 つ以上の特定のユース ケースに対して単一の ESX 仮想ノードのみを必要とする場合があります。その場合、キャパシティ プランニング ツールで要件が示されるので、次のセクションの追加のノード展開手順をスキップできます。

-

前提条件:Nexus Dashboard に記載されている一般的な前提条件を確認して完了します。

この文書は、ベースとなる Nexus ダッシュボードクラスタを最初に展開する方法について説明するものである点に留意してください。追加ノード(

セカンダリまたはスタンバイなど)で既存のクラスタを拡張する場合は、代わりにCisco Nexus ダッシュボード ユーザー ガイドの「インフラストラクチャの管理」の章を参照してください。これは、Nexus ダッシュボード UI またはオンラインでCisco Nexus ダッシュボード ユーザー ガイドから利用できます。 -

展開予定のサービスのリリース ノートに説明されている追加の前提条件を確認し、条件を満たすようにしてください。

-

Nexus ダッシュボード VM に使用される CPU ファミリが AVX 命令セットをサポートしていることを確認します。

-

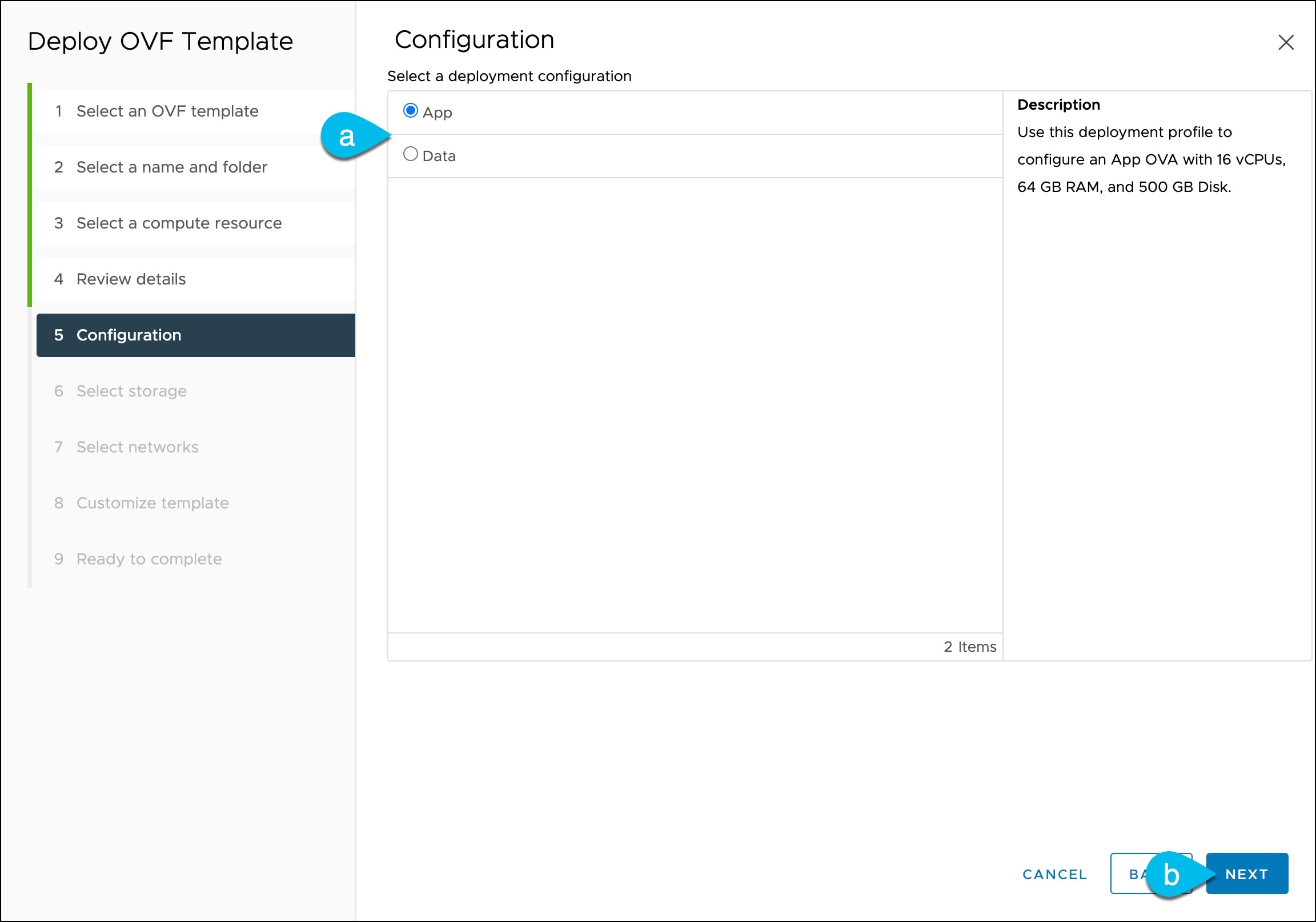

VMware ESXで展開する場合、2種類のノードを展開できます。

-

データノード:追加のリソースを必要とする特定のサービス向けに設計された、より高いシステム要件を持つノード プロファイル。

-

アプリケーション ノード:ほとんどのサービスに使用できる、リソース フットプリントが小さいノード プロファイル。

(注)

一部の大規模な Nexus Dashboard ファブリックコントローラの展開では、追加のセカンダリ ノードが必要になる場合があります。NDFC クラスタにセカンダリノードを追加する予定の場合には、OVA-App プロファイルを使用してすべてのノード(最初の 3 ノードのクラスタと追加のセカンダリ ノード)を展開できます。詳細なスケール情報は、使用しているリリースの Cisco Nexus Dashboard ファブリック コントローラの検証済みスケーラビリティ ガイドで入手できます。

十分なシステム リソースをもつことを確認します。

表 1. 導入要件 データノードの要件

アプリケーションノードの要件

-

VMware ESXi 7.0、7.0.1、7.0.2、7.0.3、8.0.2

-

vCenter を使用して展開する場合、VMware vCenter 7.0.1、7.0.2、7.0.3、8.0.2

-

各 VM には次のものが必要です。

-

少なくとも 2.2 GHz の物理予約された 32 個の vCPU

-

物理予約された 128GB の RAM

-

データ ボリューム用の 3TB SSD ストレージとシステム ボリューム用の追加の 50GB

データノードは、次の最小パフォーマンス要件を満たすストレージに展開する必要があります。-

SSD は、データストアに直接接続するか、RAID ホストバスアダプタ(HBA)を使用している場合は JBOD モードで接続する必要があります。

-

SSD は、

混合使用/アプリケーション用に最適化する必要があります(読み取り最適化ではありません)。 -

4K ランダム読み取り IOPS:

93000 -

4K ランダム書き込み IOPS:

31000

-

-

-

各Nexus Dashboardノードは、異なるESXiサーバーに展開することを推奨します。

-

VMware ESXi 7.0、7.0.1、7.0.2、7.0.3、8.0.2

-

vCenter を使用して展開する場合、VMware vCenter 7.0.1、7.0.2、7.0.3、8.0.2

-

各 VM には次のものが必要です。

-

少なくとも 2.2 GHz の物理予約された 16 個の vCPU

-

物理予約された 64GB の RAM

-

データ ボリューム用に 500GB HDD または SSD ストレージ、システム ボリューム用に追加の 50GB

一部のサービスでは、

アプリノードをより高速な SSD ストレージに展開する必要がありますが、他のサービスでは HDD をサポートしています。Nexus ダッシュボード キャパシティ プランニング ツールをチェックして、正しいタイプのストレージを使用していることを確認してください。(注)

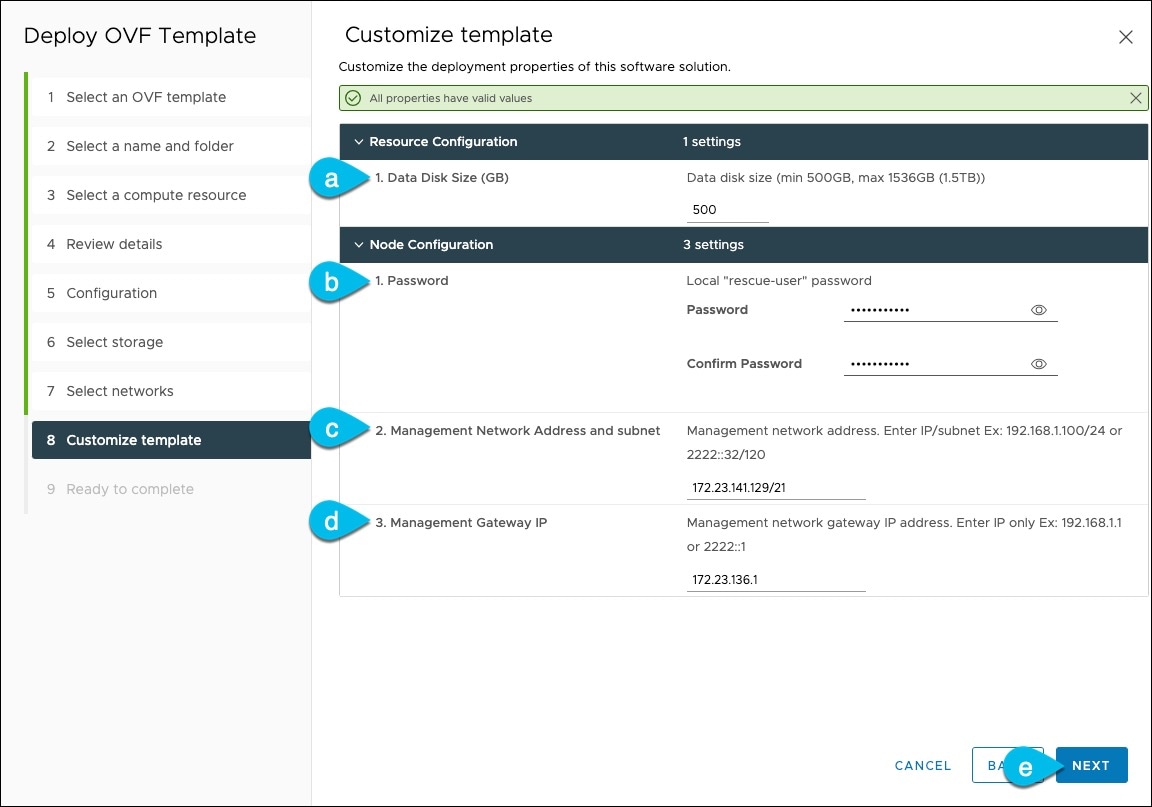

Nexus Dashboard リリース3.0(1i) および Nexus Dashboard Insightsリリース6.3(1)以降では、Insights サービスにOVA-Appノード プロファイルを使用できます。ただし、Insights のホスティングに使用されるノード VM を展開する場合は、デフォルトの 500 GB のディスク要件から 1536 GB に変更する必要があります。

-

-

各 Nexus ダッシュボードノードは、異なる ESXi サーバに展開することを推奨します。

-

-

クラスタ ノードのデータ インターフェイスの VLAN ID を設定する場合は、仮想ゲスト VLAN タギング(VGT)モードの vCenter のデータ インターフェイス ポート グループで VLAN 4095 を有効にする必要があります。

Nexus Dashboard データ インターフェイスの VLAN ID を指定する場合、パケットはその VLAN ID を持つ Dot1q タグを伝送する必要があります。vSwitch のポート グループに明示的な VLAN タグを設定し、Nexus Dashboard VM の VNIC にアタッチすると、vSwitch は、パケットをその VNIC に送信する前に、アップリンクからのパケットから Dot1q タグを削除します。vND ノードは Dot1q タグを想定しているため、すべての VLAN を許可するには、データ インターフェイス ポート グループで VLAN 4095 を有効にする必要があります。

-

各ノードの VM を展開したら、次のセクションの展開手順で説明されているように、VMware ツールの定期的な時刻同期が無効になっていることを確認します。

-

VMware vMotion は Nexus ダッシュボード クラスタ ノードではサポートされていません。

-

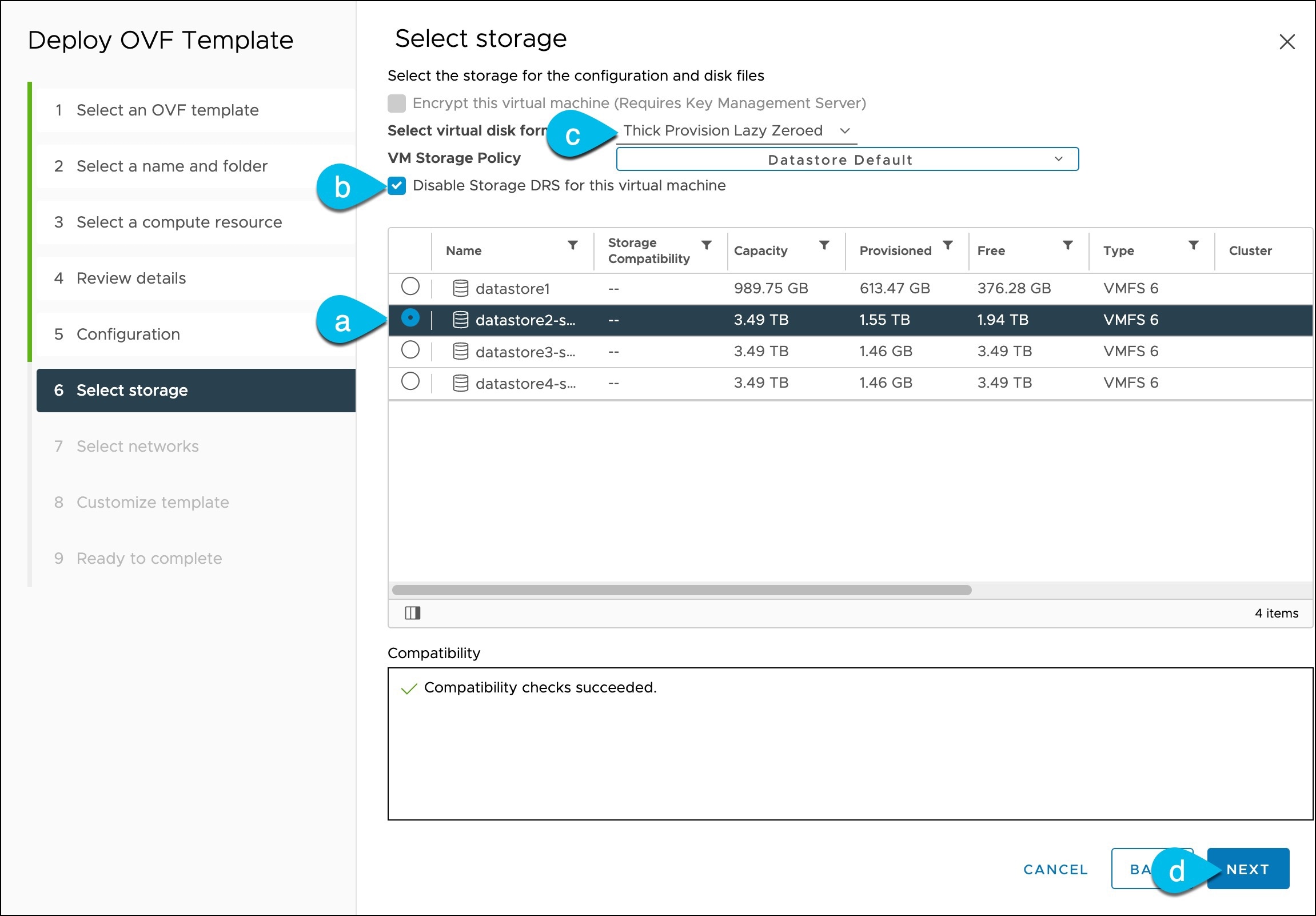

VMware 分散リソース スケジューラ (DRS) は、Nexus ダッシュボード クラスタ ノードではサポートされていません。

ESXi クラスタ レベルで DRS を有効にしている場合は、次のセクションで説明するように、展開時に Nexus ダッシュボード VM に対して明示的に無効にする必要があります。

-

コンテンツ ライブラリによる展開はサポートされていません。

-

Nexus ダッシュボードはプラットフォーム インフラストラクチャであるため、すべてのサービスを停止することはできません。

つまり、デバッグ目的などで、仮想マシンのスナップショットを作成する場合、スナップショットではすべての Nexus ダッシュボード サービスが実行されている必要があります。

-

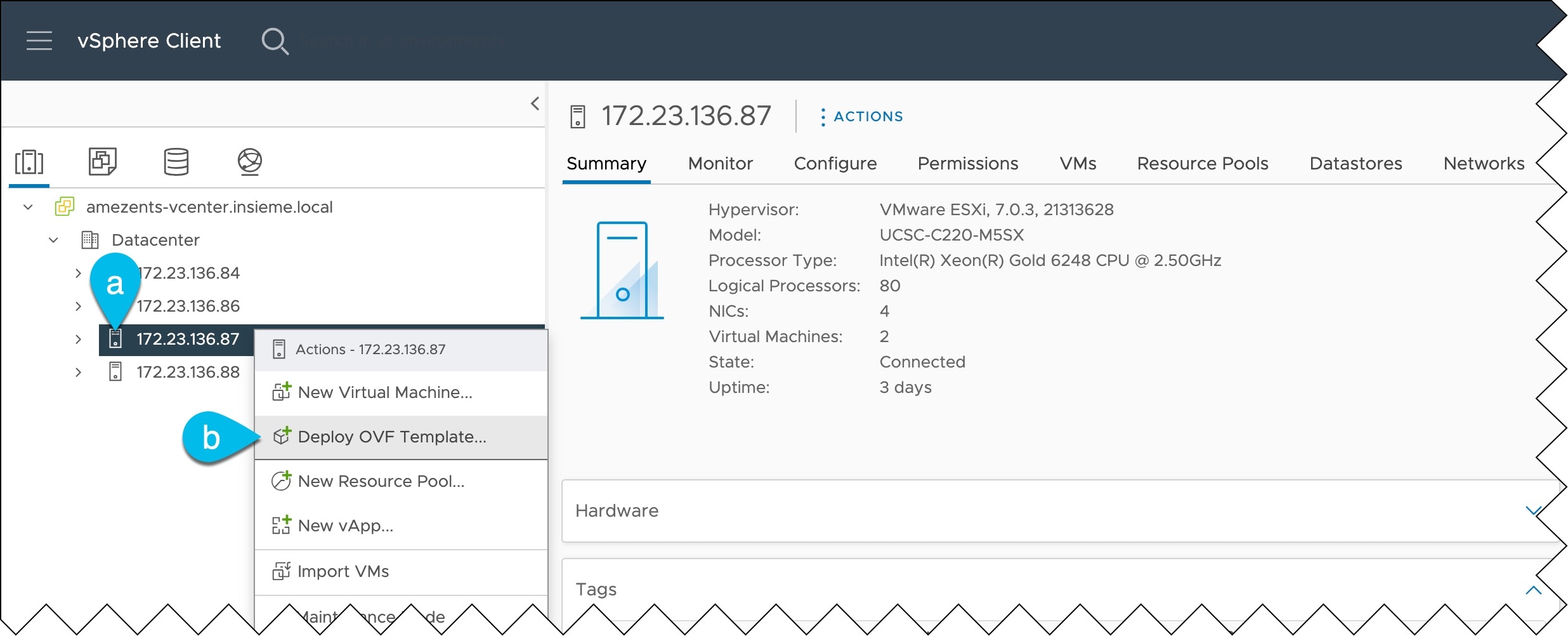

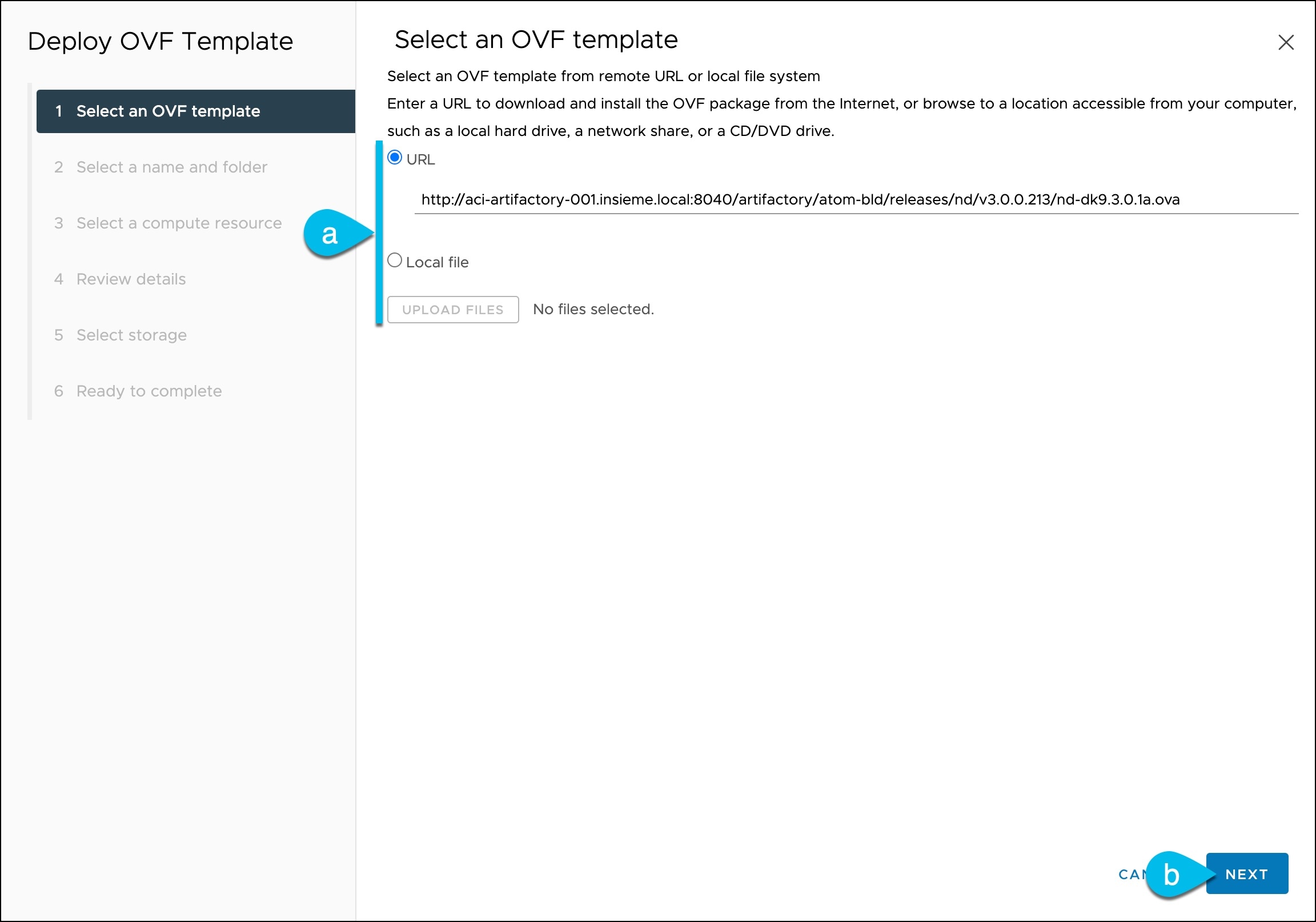

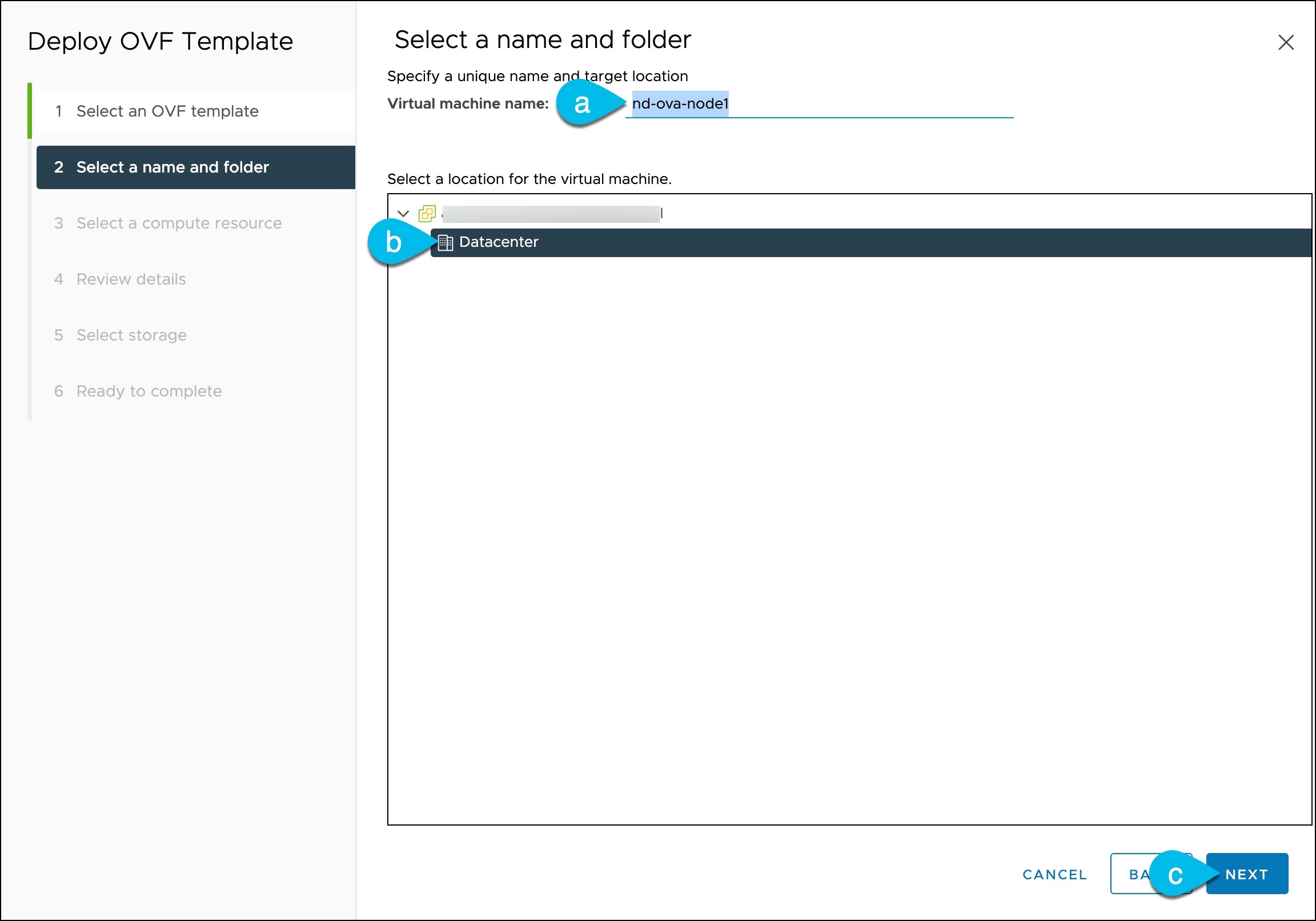

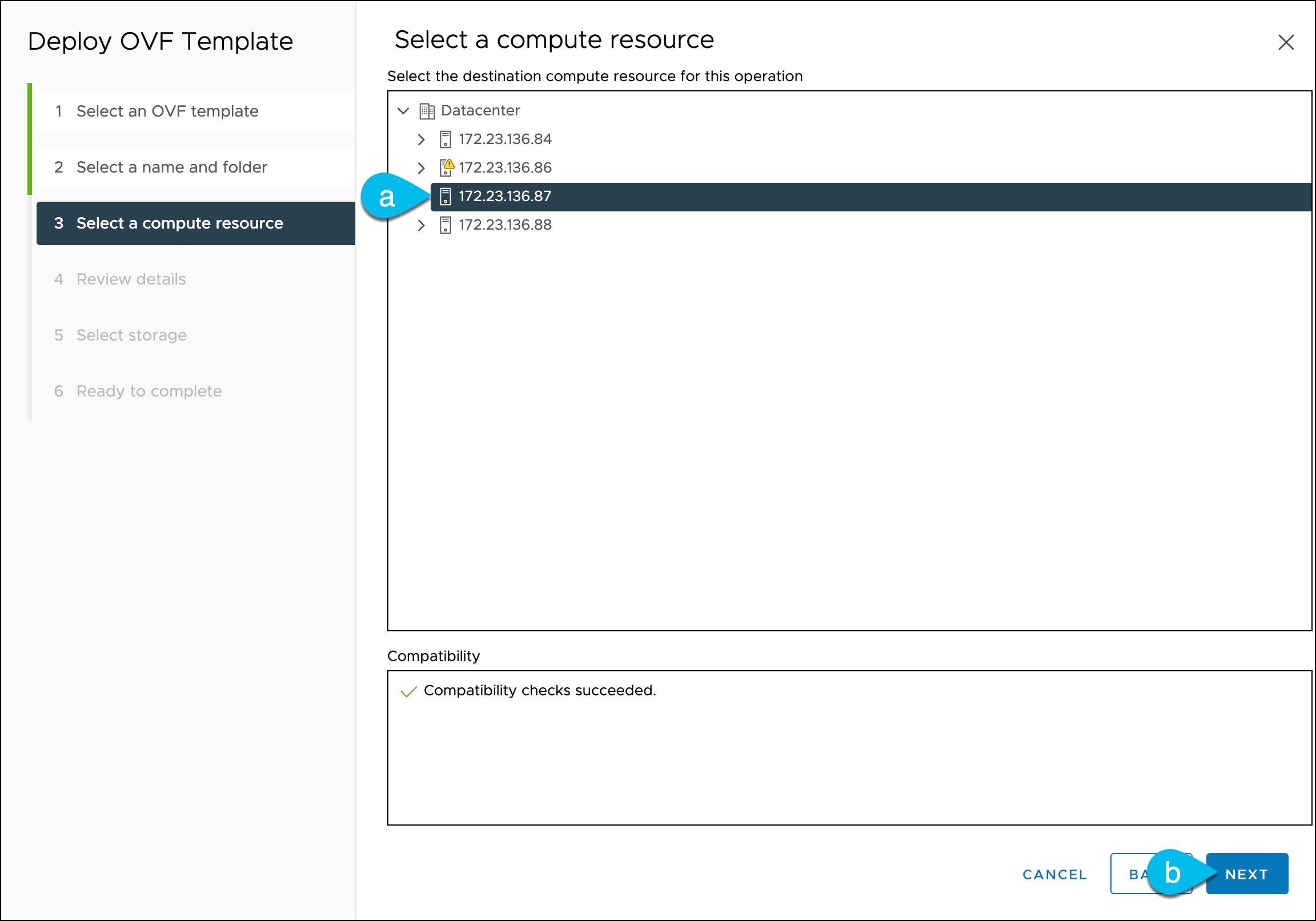

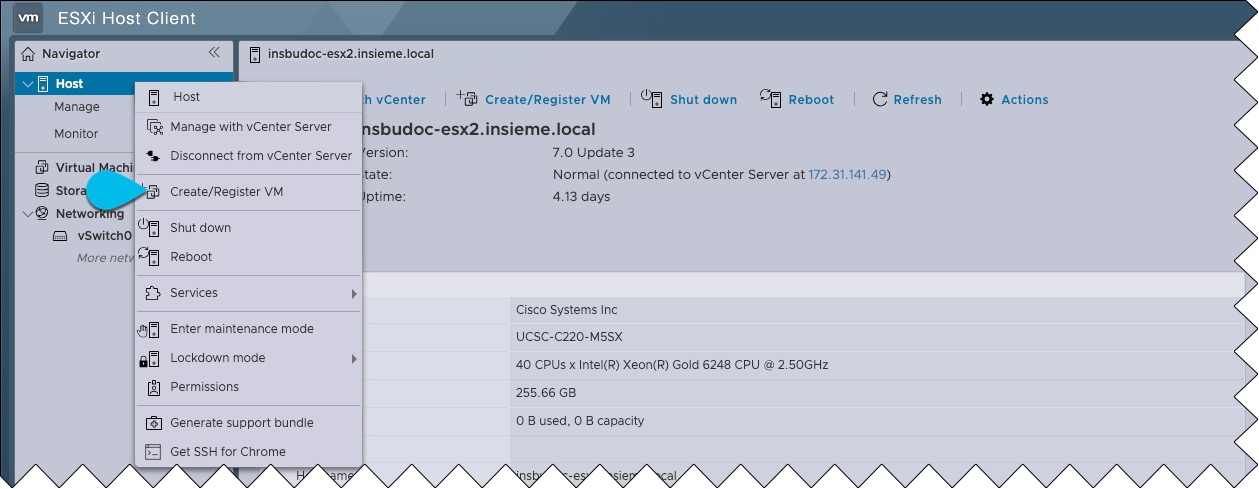

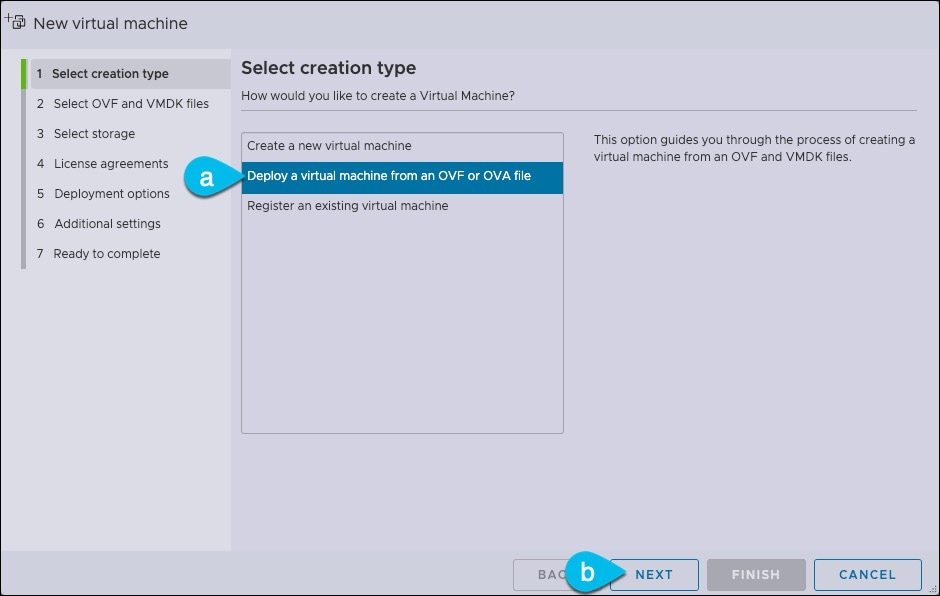

ノードを ESXi に直接展開するか、vCenter を使用して展開するかを選択できます。

vCenter を使用して展開する場合は、VMware vCenter を使用している Nexus ダッシュボードの展開 で説明されている手順に従います。

ESXi に直接展開する場合は、VMware ESXi での Nexus ダッシュボードの展開 で説明されている手順に従います。

(注)

OVA-App ノード プロファイルを使用して Nexus Dashboard Insights を展開する場合は、vCenter を使用して展開する必要があります。

Nexus Dashboard Insightsには、OVA-Appノード プロファイルのデフォルト値よりも大きなディスク サイズが必要です。OVA-App ノードプロファイルを使用して NDI を展開する場合は、VM の展開時に OVA-App ノードのデフォルトのディスク サイズを 500GB から 1.5TB に変更する必要があります。ディスク サイズのカスタマイズは、VMware vCenter を介して展開する場合にのみサポートされます。Insights の詳細な要件については、Nexus Dashboard Capacity Planningツールを参照してください。

フィードバック

フィードバック